Вчера чел дебагером питона в пошаговом режиме посмотрел код и окурел, знаешь что делает код по простому? -

Он сжатый несжимаемый белый шум файла, отрезками по 80 бит 10101010100101101001101010 Разглагает на 1111111000000000 или сжимаемый формат. При этом, в сыром виде словарь 900 гб минимален.

Если сделать меньше уровней сжатия расжатия рекурсивного не будет.

Так вот на выходе файл по размеру тот же, но там бинарный код в сжимаемом формате по типу 11110000011111000000 вместо 10101010010010, при этом проц ничего не читает он перемножает этот сжимаемый формат по типу 16x16x32x64 = 10001000100010001

Это значит что на C++ код можно ускорить в тысячу раз.

Он сжатый несжимаемый белый шум файла, отрезками по 80 бит 10101010100101101001101010 Разглагает на 1111111000000000 или сжимаемый формат. При этом, в сыром виде словарь 900 гб минимален.

Если сделать меньше уровней сжатия расжатия рекурсивного не будет.

Так вот на выходе файл по размеру тот же, но там бинарный код в сжимаемом формате по типу 11110000011111000000 вместо 10101010010010, при этом проц ничего не читает он перемножает этот сжимаемый формат по типу 16x16x32x64 = 10001000100010001

Это значит что на C++ код можно ускорить в тысячу раз.

Если это открытие, то где можно почитать научные публикации об этом??

Для вас специально сделано. это было на железе Ps2 в 2006 году. вершина кеша и оптимизации PlayStation 2 - Emotion Engine с тактовой частотой 294 МГц, 32 МБ оперативной памяти и 4 МБ видеопамяти PlayStation 2 имеет производительность около 6.2 гигафлопс.

На уровне хитман блуд мони 4 уровень тысячи ботов, из кеша. и всё это в памяти 32 мб и 4 видеопамяти, Какие вам киберпанки на 5 гб движка? тут весь движок это 32 мб и диск 4.5 гб DVD и всё это с физикой тел как в GTA4, всё предвычислено

На уровне хитман блуд мони 4 уровень тысячи ботов, из кеша. и всё это в памяти 32 мб и 4 видеопамяти, Какие вам киберпанки на 5 гб движка? тут весь движок это 32 мб и диск 4.5 гб DVD и всё это с физикой тел как в GTA4, всё предвычислено

Если открытие сделано без научной степени, кодерами любителями со средними навыками то что делать?

Специалисты, засмеют, если подходить к теме плавно то не станут тратить время.

Задаём вопросы.

Да, словарь в 900 гб описывает всю вселенную и всю информатику

( частотности всех дубликатов бинарного кода в любой последовательности )

Да, словарь в 900 гб описывает всю вселенную и всю информатику

( частотности всех дубликатов бинарного кода в любой последовательности )

Словарь изнутри, 4.5 млрд ссылок меток занимают 900 гб.

Но позволяют сжимать 100тб в 1мб. без потерь и расжимать за 1000 циклов. 1 цикл сжимает файл в 10 раз. без потерть.

( точнее разбирает на инструкции ) все инструкции в рекурсии занимают 900 гб

Но позволяют сжимать 100тб в 1мб. без потерь и расжимать за 1000 циклов. 1 цикл сжимает файл в 10 раз. без потерть.

( точнее разбирает на инструкции ) все инструкции в рекурсии занимают 900 гб

анон как это работает?

Я сам хз, но кажется нужно в задницу совать

Для гуманитариев очень просто. Рассказываем.

вся информация на дисках и носителях информации это 1 и 0

1 Мб ( мегабайт ) это 1 миллион 1 и 0 где примерно 50% 1 и 0

файл это 101001010011001010011110010010100110100101001

Эти последовательности нельзя сжать потому что описание сжатого состояние будет больше чем сама информация.

что мы делаем ?правильно. Создаём словарь, ссылок на пары, индексов пар для индексов пар.

Для 4 бит кода всего 16 состояний, из 16 состояний 256 пар, из 256 состояний пар 65 тысяч пар, из 65к пар 4.5 миллиарда Это словарь 4 уровня ( как лук или капсута ) или 900гб постоянных словарей где 4.5 миллиарда ссылок.. Где научное сообщество? почему это никто не изучает?

что такое цикл? Цикл это начало повтора, которого был ДО. Рекурсия это когда повторы повторяются всегда. Так вот словарь в 900 гб и 4.5 млрд пар описывают всё в информатике и раскладывают бинарный шум на более структурированный бинарный код, который и можно сжать в 10 раз. Можете получать нобеля, или выводить формулы, так как это квантовый код сингулярности или же словарь "Бога"в этом словаре всё есть .он всё описывает. Вообще всё.

Из букв и алфавита можно написать любое слово и бессконечное количество книг и предложений

Так вот этот словарь из 900 гб может рекурсивно сжимать информацию и вычисления. скажем минимальный размер кластера в винде и линуксе это 5кб или 680 байт. следовательно 2 тб можно ужать в 680 байт. с помощью 900 гб словаря.

вся информация на дисках и носителях информации это 1 и 0

1 Мб ( мегабайт ) это 1 миллион 1 и 0 где примерно 50% 1 и 0

файл это 101001010011001010011110010010100110100101001

Эти последовательности нельзя сжать потому что описание сжатого состояние будет больше чем сама информация.

что мы делаем ?правильно. Создаём словарь, ссылок на пары, индексов пар для индексов пар.

Для 4 бит кода всего 16 состояний, из 16 состояний 256 пар, из 256 состояний пар 65 тысяч пар, из 65к пар 4.5 миллиарда Это словарь 4 уровня ( как лук или капсута ) или 900гб постоянных словарей где 4.5 миллиарда ссылок.. Где научное сообщество? почему это никто не изучает?

что такое цикл? Цикл это начало повтора, которого был ДО. Рекурсия это когда повторы повторяются всегда. Так вот словарь в 900 гб и 4.5 млрд пар описывают всё в информатике и раскладывают бинарный шум на более структурированный бинарный код, который и можно сжать в 10 раз. Можете получать нобеля, или выводить формулы, так как это квантовый код сингулярности или же словарь "Бога"в этом словаре всё есть .он всё описывает. Вообще всё.

Из букв и алфавита можно написать любое слово и бессконечное количество книг и предложений

Так вот этот словарь из 900 гб может рекурсивно сжимать информацию и вычисления. скажем минимальный размер кластера в винде и линуксе это 5кб или 680 байт. следовательно 2 тб можно ужать в 680 байт. с помощью 900 гб словаря.

Что бы безопасно опробовать код ты можешь поставить 2 систему которая будет работать поверх твоей но в 4 раз медленнее

Нужно установить виртуальную машину или "виртуалку" Virtyal box

ОТ оракла или официально от майкрософта, скачать образ системы и установить на виртуальный раздел в 40 гб. отведя 4 гб оперативной.

виртуалок есть порядка 4 штук как платных так и бесплатных

VMware Workstation

на windows 7-8 был официальный windows xp mode

работает то как?

Раньше же словаря на 64гб должно было хватить? Сжато шиз ты определись с размером словаря уже

После 100 гигов сжатия идёт смещение по байтам и вся информация ломается, обратно расжать нет возможности.

Если очень просто, там 4 уровненный словарь

он несжимаемый бинарный шум делает сжимаемым.

Например 1001011001110010101001001001 как 11111100000000

Но такой код становится только пройдя через 4 уровня.

вот гпт 4 без реги и логина. Он тебе расскажет

https://www.blackbox.ai/

Реальный тест был? там 128 разных знаков юникода. данные не ломаются. никогда

это метки. полный словарь 900 гб. реальный тест колаба питона

Попроси его описать код, а не спорить со старыми методами и выводами учёных прошлых эпох

Его архитектура параметров и количество нейронов как у мухи не может сформировать мировоззрения что старые научные знания устаревают а новые методы возникают. Этот новый метод вообще нобелевская премия.

Так оно работает или все таки нет? Информация противоречивая

чет на шизу похоже

Простой пример

1=1000000

1000000 = 1

Сжатие разжатие в 1 млн раз. Методом словаря.

ещё лучше можно сделать сжатие в 1 трлн раз

2 = 1 000 000 000 000

или

1 000 000 000 000 = 2

Но у вас не хватит цифр, и комбинаторики цифрами что бы сделать из всех цифр рекурсию цифр не хватает нужно придумать 4.5 млрд новых цифр. НО КАК? . Мой метод может и он описан в коде.

Дай угадаю. Ты школьник?

Тоесть чтобы это говно работало нужен словарь объемом в 900Гб?

А тогда возникает вопрос - а нахуй вообще такое сжатие?

>РРРЯЯЯЯЯЯЯЯЯЯЯЯ 900 ГБ СЛОВАРЬ!!!!!111

Нахуй тебе словарь?

Предположим это работает. Теперь посчитай сколько времени уйдет на запаковку и распаковку.

С таким кейсом и кодом можно в любой конторе мира работать,но я не хочу бегать в офлайне, могут ебнуть, засекретить, или наказать.

А скрывать метод и давать кому то сверх преимущество это какой то математический фошизм

По моему это нахуй никому не надо просто.

>следовательно 2 тб можно ужать в 680 байт

Имея в наличии словарь 900 ГБ, имеет смысл начинать сжимать информацию объемом от 1 ТБ.

Вместо бесконечной шизы и копипасты слов нейросети в качестве ответов анонам, попробуй сам сжать на реальном опыте 1 ТБ в 1 МБ.

2024

@

у школьника нету 100 $ на 1тб постоянный словарь. который сможет рекурсивно сжимать другую информацию хоть 100тб в 1 мб хоть 10000тб

Для справки что бы запустить windows или android ты имеешь систему на 10 гб.

Дело не в деньгах, дело в целесообразности. Сколько времени уйдет на сжатие и разжатие? Если дохуя тотне проше ли просто не сжимать или сжимать так чтобы потом не ждать неделю на распаковку?

Ты вообще знаешь где сжатие использовать целесообразно?

Сожми хотя бы 1 ТБ и обратно, потом пизди.

Двачую.

Для линукса мне и 1Гб хватит, а если сожму то и в 16Мб уложусь, да еще и место свободное останется.

Покажи видео с результатом работы до после, где ты сжимаешь 1 гиг до 1 мегабайта.

А потом разжимаешь.

у него там словарь волшебный какой то, не просто перебор подряд. Но не рассказывает подробностей, а тот код что в доступе для словаря просто последовательно генерит словарь

Ну в общем да.

О, ебать, помню кто-то архиватор на дваче посоветовал "FreeArc" с полосатой папкой.

Что какая-то часть NFS (вроде шифт) для "пиратского стима" (это не торрент, а был какой-то клиент стима, где крякнутые игры были) сжималась до 100 мегабайт из скольки-то там гигов.

Было хуй пойми сколько лет назад.

Что какая-то часть NFS (вроде шифт) для "пиратского стима" (это не торрент, а был какой-то клиент стима, где крякнутые игры были) сжималась до 100 мегабайт из скольки-то там гигов.

Было хуй пойми сколько лет назад.

Вот успешное сжатие и расжие 100 гб в 1 мб и обратно на колаб питоне.

( проверка целостности по хешам )

дальше был отвал и обруб

У меня начальные и средние навыки кодинга, ИИ ломает код, самому писать невозможно сложно так как логика ломается при изменении. Требую внимания всего сообщества.

Средства дебага и средства аналитики говорят что код можно ускорить в 1000 раз, те 1000 гб в 1 гб за 1 сек.

Питон код работает 100 кб сек - медленно сжатие 1 мб видео создаёт 3 мб словаря. и 10 мб оперативной.

Смотри первое видео внимательно.

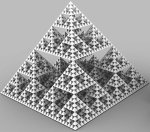

вот визуалиация 1\900 часть словаря. Точнее инфа не исчезает она переходит в рекурсию и все 900 частей словаря 900 гб такие же. хм.

чб точки это 1 и 0 последовательности.

чб точки это 1 и 0 последовательности.

Я ничего не хочу смотреть, даун, покажи мне результат работы программы где ты сжимаешь 1 гигобайт и разжимаешь обратно.

Текстовый лог? как ты проверишь? что у тебя по математике? смотри если кодировать цифры 256 разными алфавитами. Смотри на пикрол 1

что бы у 1 = 0001111 и 2 = 000111

Был одинаковый бинарный код но разные алфавиты. начинаешь понимать?

Я делаю презентацию для ютуба.

Дебил, запиши на видео как ты файл объемом 1 ГБ в 1 МБ сжимаешь и обратно. Не логи, а видео конкретной работы твоей шизохуйни

Бесконечное количество времени

Он же пишет что его говнокод сжимает со скоростью 100кб/с.

Вот и я так думаю.

>СОЗДАНА ПРОГРАММА ВЕЧНОГО СЖАТИЯ ИНФОРМАЦИИ БЕЗ ПОТЕРЬ.

Пили видос. Если это правда работает то будет тебе уважение и почет.

Так пусть он фрагментами запишет работу программы или стрим запустит, хоть какой-то пруф должен быть, пока какая-то хуйня убогая

Опять этот шизик.

1 гб отличается от 1 мб что бинарный код и размер файла больше в тысячу раз. Ты мне предлагаешь в тысячу раз бльше потратить RAM и 5 часов времени? нет дружок. смотри на сжатие расжатие 1 мб в 40 кб и радуйся что вечное сжатие возможно.

В колабе успешно удалось сжать и расжать 1 гб без потерь в 1кб. за 3 часа.

полный словарь будет генерироваться 8 часов. те 900

>Так пусть он фрагментами запишет работу программы или стрим запустит

вот тебе вечное видео. Посмотри на размер и смотри 5 часов.это тебе заменит 5 часовой стрим водопада

да, это и есть 5 часовой стрим ужатый в 800кб.

>Ты мне предлагаешь в тысячу раз бльше потратить RAM и 5 часов времени?

Ты мне предлагаешь покупать 1 ТБ диск для словаря в 900 ГБ и сжимать 1 ГБ файлы по 5 часов?

А это идея, можно, да, можно 1гб видео по 1 мб - в 7 зип и винраре нарезать на 1000 кусков.

Загружать куски по очереди, в автоматическом режиме. да это можно будет твой 1гб как 100мб за 1 цикл потом 10 мб потом 1мб.

Но Как ты проверишь?тебе код дан. тебе дан метод . сюда видосы больше 20 мб не льются. чел

А ты можешь с помощью ОДНОГО словаря сжать ДВА файла?

>По моему это нахуй никому не надо просто.

можно собрать рекурсивную пеку которая будет себя бесконечно ускорять через разложение CPU И RAM по вычислениям и памяти, ну как ускорять? всё есть словарь 900 гб и её рекурсия. это бесконечная карусель вселенной

пробрасывать рекурсиии можно за 1 такт.

можно будет моделировать вселенные, всех людей да что угодно! те финал математики, за этим уже ничего не стоит, только дубликаты 900 гб словаря!

Практическое применение для Анона какое?

Да, словарь постоянный и одинаков на всех пеках.

Всё о чем ты мечтаешь, всё что хотел, реально. Это словарь Бога. Это бесконечная рекурсия. Этим словарём можно описать что угодно.

Ну так возьми и сожми, и покажи в треде.

СОЖМИ СЕБЯ ВЕЧНО

Что нужно сделать:

1) переписать на С++ или CUDA ( C++ работает в 40 раз быстрей на CUDA в 80 раз быстрей. ) на ASIC = FPGA в 600 раз быстрей.

2) переписать логику что бы не ел 34 ГБ RАМ постоянного словаря а ток с SSD

3) Добавить рекурсию после сжатия для нового сжатия

Успешная реализация на ASIC и словарём 900гб даст вам возможность 900 гб в 1 гб за секунду. а 1 гб в 1 мб за вторую.

>СОЗДАНА ПРОГРАММА ВЕЧНОГО СЖАТИЯ ИНФОРМАЦИИ БЕЗ ПОТЕРЬ.

Её название - Wishmaster, доступна для скачивания в свободном доступе.

Что стало понятно мне?

давайте тогда обсудим квантовую шизу.

Атомов нет, все атомы и элементарные частицы это ссылки, на сами ссылки.

Днк и клеток нет, всё это сссылки на клетки оригиналы те материнские, словарные, все дубликаты это ссылки на оригинал. Как это трактовать ?

Это уже начало квантовых наук

1) Попроси нейрокал переписать на c++

2) Попроси нейрокал переписать логику

3) Попроси нейрокал добавить рекурсию после сжатия для нового сжатия

Репорт хуесоса вниманиеблядского, уже не первый месяу вижу семеняещго здесь.

Нейрокал уноси свой отсюда

Нейрокал не может с++

В него и из людей могут немногие.

Ну так купи отладочный набор на ПЛИС и вперед. Вопрос 5к рублей.

Ты понимаешь что ты поехавший наглухо? А ? Ты думаешь что единственный коему подобные концепции пришли в голову и их не проверяли?

Это шиз, всё нормально

Переведём в байты:

360 10^9 бит / 8 = 45 10^9 байт = 45 гигабайт.

Итак, 4.5 млрд комбинаций по 80 бит займут 45 гигабайт. но из за убогого хранения винды и таблицы это 900 гб. да.

Эх..

Я ещë в школе на уроке программирования написал программу, которая сжимала файлы до ОТРИЦАТЕЛЬНЫГО ВЕСА!!!

После сжатия файла 1 Мб - он начинал весить МИНУС 100 мегабайт!

Такой файл отрицательного веса можно было скопировать на дискету 1.4, и там появлялось СВОБОДНОЕ место на 100 мегабайт!

Жаль училка по информатике сказала, что моя программа "вирус", и не разобравшись отправила еë в корзину.

Уже в планах, хорошая мотивация.

Это всё потому что на жёстком диске появилась чёрная дыра из за твоего словаря кодирование и туда уже засосало половину твоего класса, а так да, прорывная технология

Пчел изобрел торрент?

Ага, охуенная технология. Кста, держи кинцо в 8к:

10

Почему оп долбаеб все еще не сжал шапку своего треда до одной цифры?

Rust, многопоточность, база данных .db

ключевики для нейронки что бы сделать твою задачу не упирайся в C

Точнее, словарь торрент для бинарного кода

даёшь 80 бит. получаешь 500 бит.

или кладёшь 500 бит, получаешь 80

Математики расскажут как это работает. Я не сильна в этом

Реально, пусть делает на расте через нейронку.

А у нас тут будущее, ии, передача терабайтов по воздуху, в космос лучами светим.

Всякое говно не оптимизируем, просто наваливаем озу и герцы.

Всякое говно не оптимизируем, просто наваливаем озу и герцы.

Как-нибудь на досуге перепишу эту твою хуйню на С или на С++

Сук, убивал бы за append в массивах.

Скажу на ламерском, словарь твой нахой не нужен, как диски себя изжили, да и флецки, быстрее скачать с инета чем с физического носителя, пару лет и еще навалят скорости передачи данных по кротовой норе.

Вот это прорыв, а не х100 сжатие.

Да и передача не нужна будет, домашний ии будет генерить все начиная от контента, до хуй знает чего.

Но удачей тебе.

Вот это прорыв, а не х100 сжатие.

Да и передача не нужна будет, домашний ии будет генерить все начиная от контента, до хуй знает чего.

Но удачей тебе.

>пару лет

Я еще в 2022 слыхал подобные мантры, если не раньше.

Словарь же изначально был 34гб, откуда 900 нахуй?

Бля, в прошлый раз же на 60гб словарь был? Нейронка лагает?

>диски себя изжили, да и флецки,

Зумероок, а нахуй сходить, не?

Это ты себя изжил, средство для оплаты подписок.

Как раз дело наооборот обстоит, ну в миреп нормальных людей, а не моднипргагрсивне, которые с трудом понимают как это все работает, но все такие пиздос в теме..

Шиза у дурика прогрессирует.

Додики типа тебя заходят в тред и байтятся на софизмы шиза ОПа как ты сейчас.

Софизм - это когда ты закладываешь в рассуждения незаметную ошибку и "доказываешь" этим ложный тезис.

010

чел а у я между прочим разобралась в шизо математике

Круга нет, ну как нет. Сколько у круга углов? круг же много угольника ведь да в математическом пространстве? Да?

так вот после 900 тб или 10000 квадрильёнов углов круга будет рекурсия и настоящий пи

А не то что круг это 65к углов, или что треугольник это тоже круг.

Ясно?

тут и квадрат это круг но 4 угольный

Полные полевые тесты показали реальные цифры.

скажи IDE На раст что бы не весило 20 гб.

Хочешь решить все проблемы? научные ?социальные? экономические ?словарь на всё ответ. всего 900гб или 4.5 млрд пар меток

Он шиз

Ребята А ЭТО ИДЕЯ.

1) можно создать сервер где 900 гб словарь ваши 1 гб превращает в 100мб

2) можно сделать p2p торрент сжималку но на 1 мб нужно 7 мб словаря.

возможности неограничены.

1) можно создать сервер где 900 гб словарь ваши 1 гб превращает в 100мб

2) можно сделать p2p торрент сжималку но на 1 мб нужно 7 мб словаря.

возможности неограничены.

А толку если не разжать без словаря?

ОП троллит, просто плоская Земля уже приелась.

Вычисление протеинов тоже твоя тема?

Вычисление протеинов тоже твоя тема?

науку, протеины и атомы не вычислить без этого алгоритма кстати.

Я как тян, разобралась во всех науках. поэтому ломану твой смарт и пеку если будешь обиж

Судя по описанию зумеры изобрели "Вавилонскую Библиотеку". Такая же охуенно бесполезная хуйня. Вроде бы круто но бесполезно.

Хорошо сделай видеокодек весом 900мб чтоб сжимал 8к видео в 100 раз. Как сделаешь приходи поговорим.

Все парадоксы решены и разложены на 900гб словарь. в нем всего 4.5 пар у каждой пары 32 ветки. вот и всё. все ветки и пары разложены. Смотри код и не позорься.

чел с видео рола сжал все фильмы на дискету, а тебе все власти и правтельства скрывают и секретят что плотины это вечный двигатель с рентабельность 10 к 1 те доход 1 млрд расход и амортиазация 100 млн.

у тебя у самого есть этот словарь в 900гб или ты по заполняемости мелкие генерируешь? Они же уникальные получаются в зависимости от порядка заполнения

Нихуя не понял, но чисто интуитивно кажется что для файла размером >900 гб твоя хуйня работать не может.

Код Хэмминга слегка похлопывает по плечу

Двачеры изобрели вечное сжатие информации, блять, ждвач торт

Ну смотри есть "вавилонская библиотека" весом в несколько килобайт кода но в которой есть все существующие варианты текста. То есть обычной ссылкой на страницу книги что сгенерирована по примитивному алгоритму можно зашифровывать любые данные. То есть буквально зумеры изобрели https://libraryofbabel.info/ и теперь пытаются на ее базе сделать алгоритм сжатия.

Если бы ты понимал что-то в своём коде, то сделал бы рабочую программу, предлагаешь заняться отладкой галлюцинаций нейросети запрошенные тупым шизиком? Довольно неблагодарное занятие.

Рабочая прога есть но на питоне. 50гб иде визуал студио не хочет копилировать 2к строк. говорит нету злиб и лзма и тинкера бл.

инструкции на 40 страниц копилот обсирается и улитает.

Визуал студио 2024

поэтому чел, реши проблему и становись триллионером. будешь круче дип синка и грока которые ускорили нейросеть в 400 раз

Не создай случайно себя обосравшегося на лекции

Шучу анон

Так разжимай со словарём

да тут вообще не рядом, просто 1 мегабайт данных в 7 раскладывается и называется словарь + сжимаемый файл

Оп, мне похуй даже если есть пока незаметные ограничения по железу, мне похуй, я в тебя верю, сама концепция звучит как чтото реальное, да мы скорее всего упремся в физический уровень, почему то мне кажется, но в целом я тебя охуенно поддерживаю и этот тред разжёг огонёк в моём сердце.

>Для вас специально сделано

>PlayStation 2

>4 уровень тысячи ботов

Схоронил видос.

Удивляет, однако, оптимизация игр серии Hitman.

Насколько помню, это одна из первых игр, где для персонажей была скелетная анимация. Обычно, в те годы анимация была записана по кадрам, а в некоторых играх, так вообще, морфингом модели (на персонажах была шевеленка полигонов).

Программисты у них очень крутые какие-то.

⨻

Или им дали технологии от иллюминатов.

Шиза, уже сто раз обоссали

Это называется спрайтовая запеченная графика и предвычисленные таблицы

если раньше кодить могли ток гении то щас любая студия это сборище дураков

вон казаки и противостояние и блицкриг это вообще запроганный ексель со всеми действиями на 600 мб со спрайтами текстур.

В играх вечное сжатие используется в виде оптимизации, к примеру 5 кб ссылка на 100кб текстуру. тысячи таких ссылок, тысячикратно экономят память

В старых играх 2002 и 2005 года, моделировались целые генеральные сражения где несколько тысяч ботов и у каждого бота своя логика и свобода действий. А все действия и логика всех ботов уже есть в кеше и предвычисленных таблиц

Всё что вы видите на скриншотах работает на 32-64 мб RAM

Сама игра весит 600мб. с саунтреками и редактором 800мб.

В старых играх 2002 и 2005 года, моделировались целые генеральные сражения где несколько тысяч ботов и у каждого бота своя логика и свобода действий. А все действия и логика всех ботов уже есть в кеше и предвычисленных таблиц

Всё что вы видите на скриншотах работает на 32-64 мб RAM

Сама игра весит 600мб. с саунтреками и редактором 800мб.

Бля, ты реально такой тупой или толстишь уже

Исходный код + программа на python

Это пошаговая версия.

https://drive.google.com/file/d/1V6j4iDV0YeZXDTadlnpawXyUKgHgkfoW/view

Вот автоматическая V5.

https://drive.google.com/file/d/1SuTGcCMEDa_PVglfmwccYzJu_-pcQ8D8/view

900 ГБ СЛОВАРЯ ХВАТИТ ВСЕМ!

Шеннон доказал, что существует предел, до которого можно сжать данные без потерь. Этот предел определяется энтропией источника. В идеальных условиях, если данные имеют энтропию ( H ), то их можно сжать до размера, близкого к ( H ) бит на символ.

Но Шеннон не предполагал что можно создать словарь 4 уровня, где пары бинарного кода кодируются метками бинарного кода, а сами метки тоже бинарным кодом и так до 4 уровня.

Таким образом достигается вечное сжатие в рекурсии!

Вся информатика это бинарный код, все данные и программы. у 4 бит всего 16 комбинаций, если мы будем маркировать, и пары для пар в словаре ТО:

Уровень 0: 16 пар 8 байт/пара = 128 байт

Уровень 1: 256 пар 8 байт/пара = 2 КБ

Уровень 2: 65 536 пар 8 байт/пара = 512 КБ

Уровень 3: 4 294 967 296 пар 8 байт/пара = ~ 900 ГБ

34 гб описывают бесконечную рекурсию информации! Следовательно информацию и вычисления можно бесконечно сжимать и снова раскладывать без потерь!

Код создан с нуля ИИ, по подсказкам метода Яна Слоота.

Он работает медленно, любая попытка ИИ его улучить ломает код и работу программы

Что нужно сделать:

1) переписать на С++ или CUDA

2) переписать логику что бы не ел 34 ГБ RАМ постоянного словаря а ток с SSD

3) Добавить рекурсию после сжатия для нового сжатия

Принцип Работы, файл сжимается, размер его сохраняется но это теперь файл это ссылки на 34 гб словарь. Магия в том, что если поместить сжатый файл в ZIP и RAR то его размер в 10-20 раз МЕНЬШЕ ОРИГИНАЛА, И его можно восстановить из ОБЩЕГО СЛОВАРЯ. который постоянный 900 гб!

код и метод выложен на общее обозрение в Open source - вы можете редактировать и изменять его, но уважайте себя и научное сообщество, метод даёт возможным сингулярность и AGI

Получив бесконечные вычислительные мощности и память что будете делать с этим?