>я зассал что-то туда втыкать

А как оно по твоему работать будет?

Ребят, я новенький смешарик.

Что можно поставить имея i5 4570, gtx 1650s, и 24гб рам?

Склоняюсь к гемме 3 27б. Но может что получше есть. Хочется максимально универсальную и умную модельку, чтобы когда инет перекроют был источник информации хоть какой-то.

Спасибо заранее всем.

Что можно поставить имея i5 4570, gtx 1650s, и 24гб рам?

Склоняюсь к гемме 3 27б. Но может что получше есть. Хочется максимально универсальную и умную модельку, чтобы когда инет перекроют был источник информации хоть какой-то.

Спасибо заранее всем.

Добавлю что я терпеливый, и мне 5 токенов/с хватит вполне.

Конечно, ещё для рп что-нибудь, чтобы хотябы отдалённо напоминало клода..

> Склоняюсь к гемме 3 27б

> имея i5 4570, gtx 1650s, и 24гб рам

Напрасно. 12б твой потолок с огромным скрипом, а так - 8б. Напиши спеки смарта, воззможно он будет пригоднее.

> я терпеливый, и мне 5 токенов/с хватит вполне.

Ты точно не жирный?

>и мне 5 токенов/с хватит вполне

Боюсь даже твоя выбранная 27B столько не выжмет. Покупай видеокарту.

>12б твой потолок с огромным скрипом,

Разве не от озу зависит? Я не так давно на 8гб ддр3 запускал гемму 3 12B Q3, со скрипом но генерировала.

Телефон на SD 8+gen1, 12 ram.

>Покупай видеокарту.

Эх. Я только недавно жтх купил эту.

>Телефон на SD 8+gen1, 12 ram.

Я на нём уже кстати пробовал. Гемма 12B Q4 стартанула с ~2 токена/с.

Но телефон греется ебануто, такая себе затея по-моему.

> Телефон на SD 8+gen1, 12 ram.

Реально лучше на нём будет. Качай qat гемму3 8б

>Реально лучше на нём будет.

Да я пробовал уже. В 2 раза медленнее чем на пеке выпукивает.

Тестировал на Gemma 3n E4B Q6.

Напишите мне список всех возможных глинтов, начиная с Пигмы. Ехидные блески, молодая ночь и вот это всё.

Повторный вброс, ну а хули, любтелям коммандра.

https://huggingface.co/BeaverAI/Cydonia-R1-24B-v4b-GGUF/tree/main

https://huggingface.co/BeaverAI/Cydonia-R1-24B-v4b-GGUF/tree/main

Блин, в перекат попал. Повторю вопрос.

Аноны, объясните нубу как заставить tts читать текст во время его написания. Я думал за это отвечает пункт в настройках Streaming Audio Generation. Но с этой штукой она молчать начинает.

Аноны, объясните нубу как заставить tts читать текст во время его написания. Я думал за это отвечает пункт в настройках Streaming Audio Generation. Но с этой штукой она молчать начинает.

>Ты в каком часовом поясе живёшь?

Сибирь, ночь глубокая.

>Антибаза всё ещё в шапке, репортим

Ультрамегахарош, как тред похорошел-то.

Повторный вопрос, что это?

Предположу, что лучше взять оригинальную Gemma 3 12b QAT, она и так четырехбитная, зато обученная такой быть.

Должна быть получше, синк эбаут ит.

Клево, нехай будет.

Как время летит, мне на 235B не хватает 6 токенов…

А когда-то был бы рад и 3 токенам на 70B…

> не хватает 6 токенов

кто отрицает базу треда, будет вынужден возвращаться к ней вновь и вновь

Базашизика дружно репортим.

Зачем? Смешно ведь

>gtx 1650s

>Склоняюсь к гемме 3 27б

>мне 5 токенов/с хватит вполне

>Смешно

Было первые пару-тройку раз, а щас посмешише тред позорящее.

Даже асиг так не опускался.

>

> меньше 8 каналов DDR4 жизни нет

Былин, по одному пункту и я не прошел!.. =(

Надо будет исправить это.

Помолись перед сном святому Тредрипперу и ты прощен

у тредрипера же вроде 6 каналов, не?

Ryzen Threadripper Pro 3995WX имел уже 8 каналов, а вышел давно.

Попробовал на tabby запустить qwq snowdrop

https://huggingface.co/ReadyArt/QwQ-32B-Snowdrop-v0_EXL2_6.0bpw_H8

Уже запускал его через ламу и все окей было, а тут чото пизда какая-то с теми же пресетами. Кто-то подскажет в чем может быть причина?

Запускаю на двух mi50, слои вроде пополам идут.

Проверял уже на llama3.3 70b и она нормально работала в tabby поэтому я хз чо думать.

https://huggingface.co/ReadyArt/QwQ-32B-Snowdrop-v0_EXL2_6.0bpw_H8

Уже запускал его через ламу и все окей было, а тут чото пизда какая-то с теми же пресетами. Кто-то подскажет в чем может быть причина?

Запускаю на двух mi50, слои вроде пополам идут.

Проверял уже на llama3.3 70b и она нормально работала в tabby поэтому я хз чо думать.

А чё никто не разворачивает модели за бабки для других? Хотел бы топовую рпшную какую-то попробовать, побазарить, потрогать пенис. Платить тоже готов, денег и желания нет покупать топовую карту, арендовывать сервер да и разбираться.

Вот нашёл какую-то chai ai без цензуры. По типу кэрэктэра. Но по ощущениям она слабенькая на русский.

В общем подскажите че-нибудь ещё плез. Мб кто-то мистраль топовую где-то держит?

Вот нашёл какую-то chai ai без цензуры. По типу кэрэктэра. Но по ощущениям она слабенькая на русский.

В общем подскажите че-нибудь ещё плез. Мб кто-то мистраль топовую где-то держит?

- Попробовал обновить exllamav2 у меня была 0.3, обновил до 0.3.2

-Пробовал

curl http://localhost:5000/v1/chat/completions \

-H "Authorization: Bearer 5f0xxxxxxxxxxxxx" \

-H "Content-Type: application/json" \

-d '{

"messages": [{"role": "user", "content": "Привет!"}]

}'

Чтобы просто проверить работает чи не и тоже самое, пустое поле в консоли после и не заканчивает генерацию.

- Попробовал 4bpw h8, такая же хуйня. Хз.

Есть вообще разница что приоритетнее выгружать?

- ffn_down_exps

- ffn_up_exps

- ffn_gate_exps

- ffn_down_exps

- ffn_up_exps

- ffn_gate_exps

По процессингу в 2 раза отстает, так еще дороже чем более быстрая 3090. Это налог на глупость амд фанатизм?

Рофел будет если чекнуть генерацию изображений/видео/другой инфиренс, получится разница в сотни процентов, или она улетит в бесконечность из-за деления на нулевой результат амудэ.

Если же говорить о комфортном пользовании всем ассортиментом фич - то что на хуанге будет просто заводиться из коробке, на красных придется допиливать, переписывать или смириться с отсутствием.

Попробуй выключить флешатеншн а также удалить из вэнва экслламув2 которую ставит хардкод табби, и установить-собрать ее вручную (просто через pip). Не факт что оно вообще на ми50 сможет работать, но мало ли.

Если проблемы искчючительно на этой модели - битый квант.

Опенроутер же.

По идее не должно быть, хотя up и gate могут работать параллельно. Так что их наверное лучше либо рядом, либо наоборот что-то одно оставить видюхе чтобы по минимуму простаивала.

Не знал про опенроутер, слушай а в чём кайф тогда покупать овердорогое железо для запуска жирных моделей локально, если можно по апи за копеечку гунить в кулачок через опенроутер? Не вдупляю.

Мне скорее интересно, в чём кайф сливать всё и вся незнакомым дядечкам, нежели чем делать всё локально.

Это в тему продолжения насилия над ми50 и зивонами (нас тут минимум два с такими сетапами, так что думайте кто есть кто).

Накидал немного кода по просчёту что выгружать. Удалось загрузить так что бибика вот вот лопнет.

Буду тесты гонять

Подпишусь, тоже интересно.

Ну, когда-то давно локальные модели вообще не могли дать какого-то приличного экспириенса а гопота уже была и что-то как-то кое как могла, чаная туда же. Интересен был сам процесс.

Сейчас же, помимо этого, при регулярном использовании инфиренс выйдет в копеечку, на многих апи вовсе не то что указано, отправляешь свой инцест с собакой какому-то дяде, часто не имеешь полного доступа а только кастрированный чаткомплишн.

Насчет цены - многие здесь еще увлекаются чем-то типа генераций картинок и всяким ии-релейтед что само по себе требует гпу а ллм - приятный бонус, или сам процесс пердолинга доставляет, приватность туда же. Поэтому что-то типа "окупится только через 3 года при 22 минутах рп в день" вообще не выглядит аргументом.

> Удалось загрузить так что бибика вот вот лопнет.

Ахуенно, прям под кромку. Это уже с контекстом?

Тоже с mi50 двумя по 32гб, я бы чутка сбавил, по гб где-то на каждой, там при первом прогоне то ли rocm, то ли что резервирует еще память, из-за чего еще больше забивает. Ну если у тебя такого нет, то забей.

Примерно по 500-700 скинул т.к. в один из проходов бенча самопального был вылет, до этого ворочалось, решл выбрать стабильность. По 5000мб (пиздец) резервирую под всякий мусор при расчёте того что выгружать.

Гоняю бенчи, пока без особых изменений

Потраченного времени жаль.

TG быстрее всего если выгружать up+down пополам и держать gate в памяти, PP лучше если выгружать в рам gate.

Но в общем и целом, выбирать просто по ffn_*_exps и не выёбваться.

Для себя решил что вообще меньше tg 10 t/s даже нет смысла пытаться

Infermatic

>Infermatic

На фри тире там полное гавно, на платном опенроутер во всём лучше.

bamp

Аноны, которые чаще пользуются фронтэндом кобольда, но также пользовались и таверной, вы замечали меньшее количество лупов и подобных проблем по сравнению с таверной?

Теоретически возможно что где-то насрал в разметку, у кобольда с этим проще.

Но если честно, не припомню.

НОВЫЙ НЕМОТРОНЧИК!!

07.26.2025 похороны всех моделей до 49б

Насколько она лучше чатжпт и клода?

Это невероятно но похоже списки и таблицы пропали

Я вижу... кум? И откат софт рефузов?

Когда Q1 версия? Хочу на gtx 1650s запустить.

Оно даже чисто теоретически не может дать лучше.

Ты с ума сошел? Какая гемма 27б, если она даже на 20 врам (12+8) работает на 7-8 токенах у меня? На линуксе вроде побольше.

Тебе максимум 12б в 4 кванте запускать можно. И только мистраль, а не гемму.

Жаль.

Сейчас мисраль немо запустил 12b Q3, выдало ~3 токена. Но ролит неплохо, приятно удивило на креативность после соевой геммы.

Качай q 4k m, ибо даже 4 квант - лоботомит, а ты ещё хуже делаешь. Если сможешь, ставь линукс. Будет быстрее.

А так закрываешь абсолютно все окна в ПК, в том числе браузер, стим, вообще все программы левые, потому что они отжирают видеопамять. После этого ставишь 20 слоёв, 8к контекст и запускаешь бенчмарк в кобольде. Делаешь так до тех пор, пока не перестанет вылетать или не начнёт вылетать. При этом сделай ещё кэш 8 бит - очень сэкономит память, освободит 1 гигабайт точно.

Качай nemomix unleashed. Он самый сбалансированный из малых. Может и в кум, и в диалог, и в обычное рп, при этом реже остальных ломается.

На русском языке рп не веди никогда на таких моделях. Даже те, которые могут в русский, делают это сильно хуже. Даже корпы имеют ныне значительно меньший словарный запас на русском, чем год назад. Модели максимально смещаются в сторону английского.

> TG быстрее всего если выгружать up+down пополам и держать gate в памяти, PP лучше если выгружать в рам gate.

записал, спасибо!

> Для себя решил что вообще меньше tg 10 t/s даже нет смысла пытаться

пока записывал нашёл в заметках вот это

> IQ кванты сильно медленнее обычных, обычно процентов на 30. Когда ты целиком на врам - то у тебя скорость в любом случае будет выше 20 токенов в секунду - и тогда это падение не играет особой роли, но когда ты оффлоадишь слои на рам - то скорость падает очень сильно из-за этого и эти дополнительные 30% уже сыграют роль. Существуют очень узкие юзкейсы когда IQ все же выгоднее чем обычный квант даже на оффлоаде на рам, у меня было такое что благодарая тому что IQ4_XS меньше 4_K_S - то освобожденную за счет разницы в размере модели врам я пускал на увеличение контекста, который нельзя оффлоадить и которого дико не хватало, но это реально был узкий случай.

это к предыдущему треду про медленность ik_llama

> IQ кванты сильно медленнее обычных, обычно процентов на 30. Когда ты целиком на врам - то у тебя скорость в любом случае будет выше 20 токенов в секунду - и тогда это падение не играет особой роли, но когда ты оффлоадишь слои на рам - то скорость падает очень сильно из-за этого и эти дополнительные 30% уже сыграют роль. Существуют очень узкие юзкейсы когда IQ все же выгоднее чем обычный квант даже на оффлоаде на рам, у меня было такое что благодарая тому что IQ4_XS меньше 4_K_S - то освобожденную за счет разницы в размере модели врам я пускал на увеличение контекста, который нельзя оффлоадить и которого дико не хватало, но это реально был узкий случай.

это к предыдущему треду про медленность ik_llama

>даже 4 квант - лоботомит

От кванта сильно зависит качество? Говорили что больше 4 не особо смысла много.

>А так закрываешь абсолютно все окна в ПК,

Я так и делаю, у меня только lm студия открыта и всё.

>После этого ставишь 20 слоёв

Гпу которые?

>Качай nemomix unleashed. Он самый сбалансированный из малых. Может и в кум, и в диалог, и в обычное рп, при этом реже остальных ломается.

Так и понял, его и буду тестировать.

>На русском языке рп не веди никогда на таких моделях

Совсем плохо с ним? Для меня вся суть в этом.. я английский ± понимаю, но когда дрочу явно не хочу заниматься переводом.

Лучше уж в крюшоне через грока, и другие модельки подрочить. Но да, интересует автономность, контроль, и конфиденциальность.

В крашоне раньше Клод был, бесплатно! Сидел бед не знал, потом выпилили из-за невыгодности.

Хочется хотябы немного максимально похожий экспирианс на клода, ибо он настолько хорош, что до сих пор старые ролки с ним перечитываю. Что думаешь о Magnum?

А так благодарю за подробную подсказку, анон.

А ffn_norm? Их выгрузка влияет?

> копиум треда:

> - Чем больше модель, тем меньше она потеряет в мозгах при квантизации

типа 235B можно и в Q2 гонять, а 12B лучше ниже Q8 не опускаться

на практике 235B даже Q4 говно

Также спрошу. Как и где кумить удобно? Я пока что только в лм студии тестирую модели. Типа расскажи то, это, проверяя на знания. Потом просто говорю "Возьми роль персонаж_нейм)"

Но подозреваю есть более практичные способы. Через таверну наверное.

>lm студия

выкинь каку и поставь кобольда / llamacpp, ещё быстрее будет, немного, но будет

>Совсем плохо с ним?

Нет, это просто местные шизы и тролли.

Да, на русском хуже, и да, на мелких моделях с ним хуже чем на больших. Но вполне нормально, разницы ты не заметишь из-за того что английский не родной.

Также есть несколько специально на русском обученных моделек, в том числе мелких.

Для того чтоб влезла бОльшая модель, достаточно же рам увеличить, на врам похуй? У меня старый сокет, за несколько тысяч можно 32гб ддр3 купить.

>на врам похуй

на раме ты выше 2-7 токенов в секунду не разгонишь особо

>кобольда / llamacpp

В чом разница? Там интерфейс удобный?

>Также есть несколько специально на русском обученных моделек, в том числе мелких.

Типа saiga? Они под рп не заточены вроде.

>От кванта сильно зависит качество?

это как сжатие картинки

Как правило, стоит юзать Q4 / Q6, ниже - плохо, выше - бессмысленно.

> ддр3

увы, хорошей скорости на этом не будет

неудобный, поэтому и быстрее)00))

>В чом разница? Там интерфейс удобный?

там простые лаунчеры или вообще только батником, раболтют быстрее, памяти требуют меньше

У кобольда ещё и свой фронт, простой как палка, с него начинал, пересел на таверну, потом к нему вернулся.

>saiga

Сайга, Янка, Руадапт Квены.

Алсо мержи местных анонов из шапки.

И да, они как раз под рп.

> На русском языке рп не веди никогда на таких моделях. Даже те, которые могут в русский, делают это сильно хуже. Даже корпы имеют ныне значительно меньший словарный запас на русском, чем год назад. Модели максимально смещаются в сторону английского.

> Модели максимально смещаются в сторону английского.

Чел-челик-челишечка! Ты так мимо, что мимо. Весь инглиш интернет давно высосан в датасеты и сейчас как раз выбирают любое на любых языках. Дипсик, кими, квен - они просто ультят на русеке. Даже грок, которому вроде должно быть пофиг - и то прекрасно может. Ты по-моему просто потерялся где-то в районе 2022

этого двачую

Понял, спасибо.

>увы, хорошей скорости на этом не будет

Планирую скоро на ам4 пересесть с ддр4, будет сильно лучше?

>неудобный, поэтому и быстрее)00))

Я комнатное тупое растение, комфорт важен.

>И да, они как раз под рп.

И чё, нормально работают? Раз на русских дата сетах то должны лучше мисралей англоязычных работать.

Янка 8Б хорошо работает. Для тебя напверно идеальный вариант.

Но учти что степень внимания к деталя всё же как у восьмёрки.

А вот сам русский очень хорош.

https://pixeldrain.com/l/47CdPFqQ#item=130 пример

Пресет для таверны там рядом лежит.

Ещё примеры историй на русском на мелкомистралях 12Б.

https://pixeldrain.com/l/47CdPFqQ#item=45

https://pixeldrain.com/l/47CdPFqQ#item=48

https://pixeldrain.com/l/47CdPFqQ#item=71

https://pixeldrain.com/l/47CdPFqQ#item=13

https://pixeldrain.com/l/47CdPFqQ#item=3

Последние два - это SavedState для Kobold-Lite.

хахахахха, ультрамегахарош, в шапку и гайды, однозначно

> ам4 пересесть с ддр4

не сильно, если хочешь сильно лучше - закупайся видюхами

А если выбор между 12B Q4 и 8B Q6?

Если 8б - вышеупомянутая yankagpt-8b то на русском она будет лучше.

На английском - лучше взять 12B Q4.

Заменить основного на bf16, fp16 из него определить около q3-q2

>fp16 из него определить около q3-q2

???

Почитай про форматы, почему конвертировать из одного в другой = лоботомия и почему сейчас именно бф16 популярнее.

Лучший!

Аноны, подскажите как сделать лору через oobabooga webui? Я уже от злости готов выкинуть монитор нахуй в окно, не стартует нихуя, ошибки строчит, чат гпт на них выдает мусорные ответы которые тоже не работают. Второй день ебусь.

Имеем:

Венда

12B моделька BF16

Датасет из диалогов (это важно), который я могу превратить в какой угодно формат, лишь бы webui съел и не слал нахуй в консоли. Мне важно чтобы диалоги оставались диалогами (обрезал до 4096 токенов), иначе весь смысл теряется

RTX 5090

Доступные форматы на скрине (методом тыка выяснил что принимает только JSON). Если хоть кто-то делал лору с диалогами с контекстом скажите просто плиз какой формат вы юзали и какой-нибудь маленький пример с двумя диалогами и по 4 ответа в каждом. Этого будет достаточно чтобы я переконвертировал все в нужный формат

Имеем:

Венда

12B моделька BF16

Датасет из диалогов (это важно), который я могу превратить в какой угодно формат, лишь бы webui съел и не слал нахуй в консоли. Мне важно чтобы диалоги оставались диалогами (обрезал до 4096 токенов), иначе весь смысл теряется

RTX 5090

Доступные форматы на скрине (методом тыка выяснил что принимает только JSON). Если хоть кто-то делал лору с диалогами с контекстом скажите просто плиз какой формат вы юзали и какой-нибудь маленький пример с двумя диалогами и по 4 ответа в каждом. Этого будет достаточно чтобы я переконвертировал все в нужный формат

>BF16

А зачем? Разве от Q6 различия не минимальные? В отличие от веса и производительности.

>квантование

>тренировка

Ну вот куда ты лезешь? Куда ты лезешь то? Не знаешь, а лезешь.

Потому что эту модель не выкладывали квантованной, только в .safetensors выложена. И по-моему Lora только для этого формата можно делать, не для .gguf. В любом случае она у меня и так работает, в память целиком помещается и меня устраивает. Вопрос в том как fine-tune сделать на основе диалогов. Я не понимаю какой формат нужен и во что преобразовать диалоги чтобы на старте не получить ошибку "неверный формат json"

Для того чтобы тренить тебе нужно в пять-десять раз больше VRAM чем для Q8 инфиренса, то есть 5090 хватит разве что на 2-4Б.

Я не модель тренировать собираюсь, а только файн-тюн делать. Я в курсе что для полноценной тренировки модели надо H100 или подобное, мне это не нужно

> You will need to create a dataset usually with 2 columns - question and answer

Там гайд по созданию LoRA вида вопрос-ответ, там ничего ни про диалоги, ни про рекомендуемый формат вообще

Нет, я регулярно пользуюсь всеми популярными корпами. Опены, антропик, гугл и даже грок. Остальные не годятся для работы.

Тенденция ухудшения русика видна невооружённым глазом, если ты занимаешься переводами или работой с текстом и застал старые версии.

Самый простой тест для сравнения качества - попросить написать стих в эстетике Бодлера, придерживаясь стиля Льва Львовича Кобылинского, который часть его стихов переводил. Или хотя бы просто в стиле Бодлера. Разумеется, указав тему и прочее, используя нормальный промпт.

Посмотри на эти скриншоты и скажи, может ли так нейросеть? Что-то на уровне первого скриншота - никогда. И даже второй со скрипом вряд ли повторит. А раньше они были куда ближе, особенно старый клод. Сейчас же 4 версия клода нихуя не может. Из гпт только 4.5 что-то относительно вменяемое выдаёт. Как ни странно, только гугл и грок не так сильно в русике просели.

Было бы наплевать на это, но беда в том, что на английском они в это МОГУТ, хотя там тоже наблюдается деградация, вероятно, из-за того, что их тюнят исключительно под кодинг.

Поэтому я и говорю, что русик там не ультимативный, а говно. Да, его хватит для любого уровня РП, но только на вот таких жирных корпоративных моделях или открытых типа дипсика. Даже 400б не будет на уровне корпов в русском языке. А именно такие сложные вещи как стихи показывают, насколько модель умеет манипулировать языком и "понимать" его. Они все обсираются, но с каждым апдейтом обсираются всё сильнее и сильнее.

Зависит от задач. Для большинства задач треда 4 кванта хватит. Но это минимальная планка. При запуске моделей потолще деградация от более малого кванта не так заметна, но у маленькая модель, которая в любом случае будет срать под себя, даже если ты её запустишь без квантования. Так что в идеале надо брать её квант не ниже шестого.

Лм Студио - это параша, не используй её. Она, конечно, сгодится, но только если ты чётко понимаешь, зачем тебе нужна именно она.

Слои модели, которые ты грузишь на карту. Уменьшай либо увеличивай их количество, всегда используя бенчмарк в кобольде, пока не определишь оптимальное количество. Это самый быстрый способ и самый простой. И сделай kv cache 8 бит.

Если тебе русик нужен, то для тебя это финиш, потому что вменяемого русика ты не получишь, особенно в маленьком кванте, но можешь попробовать Pathfinder-RP-12B-RU. Он на базе мистрали 12б. Скажу сразу: модель поломана и достаточно быстро придёт в негодность в рамках одного чата. Русский тоже с ошибками. Почему я тебе её советую? Потому что кум там более смачный и язык более интересный, чем на других мелких моделях мистраля. А так как ты кумить собрался, то факт поломки чата не проблема: подрочил - закрыл. В следующий раз начнёшь новый чат или из лупа выйдешь иным способом. На русском ставь температуру пониже, обычно это 0,6 на том мистрале. Первое сообщение от персонажа должно быть переведено на русский, а систем промпт должен децензурировать модель. Найди его где-нибудь или сам напиши.

Только через связку типа кобольд + силли таверн. Конечно, в качестве бэкенда можно использовать и лм студио. А к таверне подключаться с телефона. Не кумить же за клавиатурой как мудак. Ну и карточка персонажа нужна, чтобы модель знала, каким именно образом кумить.

Ты хоть сам этой янкой пользовался? Полностью сломанный кал. А руадапт квен куда он в свою затычку воткнёт на 4 гб? Сайга тоже мусор.

>Есть вообще разница что приоритетнее выгружать?

Лучше выгружать все ffn из одного слоя. Если по типу выгружать будет немного медленнее. Я как-то тестил.

>кумить же за клавиатурой как мудак.

Это база. Следующим моим вопросом должен был стать "а как на телефон перенести?"

И где карточки кстати брать?

>А к таверне подключаться с телефона.

А как.

Ну как там новый Немотрончик, не томите!

Слушай, а ты насколько пердоля прошаренный? Есть простое предложение: натренить не с помощьюь убабуги и трансформерс трейнера. У той же гопоты попроси код и дать разъяснений, там все очень логично и понятно если в общем с пихоном и мл знаком.

https://huggingface.co/docs/transformers/v4.53.3/en/main_classes/trainer

Даталоадер и коллейтор под свой формат датасета напишешь и сразу же оформишь нужные аугментации. Чтобы тренить не саму модель а только лору - подключаешь peft при инициализации модели, все остальное не меняется. Если нужно qlora (плохая идея) то грузишь модель обернутую в bnb или что-нибудь еще.

> ни про рекомендуемый формат

Формат ты сам выбираешь. Обычно просто применяют стандартным прпроцессором чат темплейт на основе заготовленных сообщений и все, но ты можешь и инстрактоподобное что-нибудь натренить.

> деградация

> Тенденция ухудшения

На фоне роста скорости, сравни старый и новый опус. Корпы ударились в оптимизации, вместо больших моделей там небольшие моэ, где оптимизация под задачи идет уже на уровне финальных этапов тренировки. От того и ограниченность-деградация, она не только в русском но и в массе абстрактных задач.

Ладно. Я конечно попробую. Но так как это тестовый билд, да еще без рекомендуемых семплеров, чую у мен получится говно.

> Слушай, а ты насколько пердоля прошаренный?

Не шибко. Впервые хочу попробовать. Пробовал axolotl - в лоб вообще не устанавливается (какой-то компонент на винду отстутствует), а через контейнер плачет что больно новая видеокарта, он с ней работать не умеет

> там все очень логично и понятно если в общем с пихоном и мл знаком

Я не знаком с этим. Я хотел бы как можно меньше питона касаться. Я вообще на шарпах все делаю, там же генерирую все что нужно

> Формат ты сам выбираешь

Я так понял, что иишки эти текстовые в принципе рассчитаны только на вопрос-ответ. Без контекста. Контекст если и можно затолкать, то, наверное, только в вопрос. И потом непонятно как она должна понимать что половина контекста это часть прошлых вопросов и ответов... кароче дохуя вопросов, на которые у меня нет ответа и даже загуглить не могу. Но мне кажется что это как-то должно нормально решаться, неужели я первый что ли кто хочет скормить на дообучение именно диалоги, а не просто instruct?

> Я хотел бы как можно меньше питона касаться.

Весь мл - это питон. Буквально. Язык очень прост и максимально удобен, так что освоение не потребует усилий, особенно с привлечением ллм. Если отбросишь предрассудки и специальную олимпиаду про превосходства яп который попробовал первым - поймешь почему так.

Там кода - буквально сотня строк и он весь наиболее прозрачен если ты уже можешь в программирование и общие абстракции. Таки все равно рекомендую потратить денек на погружение, когда освоишься - поймешь насколько ненужные эти вася-обертки типа того же аксолотля и прочих, что с ним пердолинга даже больше а гибкости и удобства - меньше.

> иишки эти текстовые в принципе рассчитаны только на вопрос-ответ

Нет. Модель рассчитана на генерацию новых токенов на основе имеющегося контекста, все. За счет особенностей архитектуры обучение проходит сразу на весь контекст а не по одному токену. Вопрос-ответ это просто самый популярный формат, и он сам по себе условность и нужен для формирования правильной разметки (служебные токены чтобы модели проще понять где что при анализе контекста) и масок внимания.

> кароче дохуя вопросов, на которые у меня нет ответа и даже загуглить не могу

Глянь самые основы что такое ллм.

> неужели я первый что ли кто хочет скормить на дообучение именно диалоги, а не просто instruct

Ты не то что не первый в этом, а не первый и не последний кто задает неправильные вопросы ибо сделал неверные выводы и сформулировал вот такое, но ничего страшного в этом нет.

Нет, ответы тоже кормятся.

Но я чо-то в ахуе с вашей дискуссии двухлетней давности.

Казалось бы, это все должно быть очевидно, но на практике это у нас профдеформация уже, а в шапке много инфы, а части может и нет, но никто не вспоминает, что ее нужно добавить.

1. ICL, in context learning — не совсем то, что подразумевает под «дообучением».

2. Есть два формата: text completion и chat completion, но на практике это рубится на этапе бэкенда, в модель поступает один и тот же «текст».

Суть в том, чтобы любым из способов подсунуть <user> — вопросы, а <assitant> — ответы, то есть, сымитировать предыдущий диалог, после чего модель продолжит общаться в данном ей стиле, да.

Это и есть контекст.

Просто длинный контекст в формате переписки.

Есть еще вариант few-shot, где ты прямо в систем промпт пихаешь диалог, и просишь продолжить общаться в таком же стиле.

> Весь мл - это питон.

Плюсы.

А питон — обертка над плюсами. =)

Ну так, чтобы точно.

От питона тоже никуда не уйдешь, канеш.

> Весь мл - это питон. Буквально. Язык очень прост и максимально удобен

Это замечательно, но у меня нет времени и желания разбираться с этой внутрянкой. Я просто хотел потыкать кнопок и получить файн-тюн под себя. Проблема не в самом питоне, а в том что я в принципе не планировал ничего программировать сверх того чтобы json на C# генерировать на основе имеющегося датасета. По факту ничего не работает, либо сыпет ошибками, либо видеокарта не нравится, либо какая-нибудь говнолиба питоновская не той версии. При попытке обновления - шквал ошибок в духе "а у тебя тут конфликт между этой бетой и вот этой". Без бета-версий нытье что карта больно новая

> Нет. Модель рассчитана на генерацию новых токенов на основе имеющегося контекста, все

Я в курсе про это, но на практике для меня как для юзера все форматы которые есть так или иначе сводятся к тому что есть user и есть assistent. Вопрос-ответ. Все. А меня это не устраивает. Попытка затолкать еще один вопрос-ответ в тот же диалог = ошибки

> Глянь самые основы что такое ллм

Я знаю что такое llm. Мне это на практике что дает?

> Казалось бы, это все должно быть очевидно

Мне нихуя не очевидно. Для меня пока что очевидно, что все способы что я перепробовал закончились ошибками на стороне питона. И ни одно не решить не вышло. То есть я даже запустить процесс полноценно еще не смог, и у меня закончились идеи. Самому программировать впадлу, это уже перебор для меня

тренить на замороженных слоях - получится говно уровня чатбота-автоответчика, так что даже для лоры нужны норм веса, хотя есть ещё q-lora, трейн на квантованной модели, ну, это выходит многкратно переваренный кал

> нет времени и желания разбираться

Это так не работает

Да пусть даже и так. Я бы убедился и успокоился бы. Пока что я на уровне "послан нахуй всем софтом что я мог попробовать"

> модель тренировать

> файн-тюн делать

Значение знаешь?

Питон. Язык изначально разработанный под конкретную область задач и максимально удобный в них, позволяющий делать удобные абстракции не отвлекаясь на кишки и иметь отличную производительность при правильном применении. Плюсы уже для умных людей, которые специализируются на конкретных высокопроизводительных операциях и построении бэков с ними, хорошо разбираться в мл при этом им не нужно.

Ну или можно делать цирк как у жоры.

> Плюсы

Развивая твою логику, плюсы - обертка над асмой, лол. Перетолстил.

> у меня нет времени и желания разбираться с этой внутрянкой. Я просто хотел потыкать кнопок и получить файн-тюн под себя

Эта задача требует погружения, знаний и понимания. То же самое можно сказать

> у меня нет времени и желания разбираться с авотомобилестроением. Я просто хотел на выходных собрать гоночный болид под себя и выиграть одну гонку

> но на практике

Присоединяюсь к другому анону, это так не работает, область сложна и свежа. Когда-нибудь появятся красивые интерфейсы от корпов, которые в юзер-френдли манере будут делать типичные примитивные задачи за тебя, но делать это посредственно и за большие деньги.

> тренить на замороженных слоях

Что?

> Значение знаешь?

Да

> Эта задача требует погружения, знаний и понимания. То же самое можно сказать

Чтобы сделать обычный инференс модели никакого погружения, знаний и пониманий не потребовалось. Почему здесь должно быть иначе? Я очень сомневаюсь, что тут прям каждый анон ml-инженер и сидят скрипты на петухончике пишут под нейронки. Да точно так же кнопки тыкают и развлекаются, как и я собственно

> Развивая твою логику, плюсы - обертка над асмой, лол. Перетолстил.

Я посылаю биты прямо в чип, а что делаете вы? @_@

Не все так линейно с квантами. Imatrix кванты - вещь в себе, их таки пробовать надо, и решать для себя - годится или нет.

У меня вот что обнаружилось: storyteller-gemma3 на кванте q4km при письме на русском откровенно руинит окончания, рода падежи и т.д. Даже на кванте q5km это происходит, только меньше (запускал ради теста - он у меня целиком в vram не лезет, так что на постоянное использование не годится - медленно).

Однако iq4xs квант пишет чисто, и не проебывается с этим вообще. Хотя казалось бы...

Чел, ты думаешь что что-то знаешь и все просто, но по твоим постам и задаваемым вопросам очевидно ты лишь надергал совсем поверхностные вещи. И вообще "делать жсоны из датасета с помощью шарпа"- ебать ор

Увы, прочитав это ты едва ли осознаешь и решишь что-то изучать, а бомбонешь с чсв продолжив отрицание.

> тут прям каждый анон ml-инженер и сидят скрипты на петухончике пишут под нейронки

Не каждый, но таких наберется, чсх "скрипты под нейронки" не что-то сложное а дефолтный дефолт и повседневность на которую даже не отвлекаешься.

Также большинство анончиков здесь осознают свои силы и просят помощи где не понимают без лишнего фарса.

> Чтобы сделать обычный инференс модели никакого погружения, знаний и пониманий не потребовалось. Почему здесь должно быть иначе?

Потому что эта "область" известна и сделана действительно максимально удобно и дружелюбно чтобы даже хлебушки справлялись, твоих навыков хватило. На самом деле дальше все тоже довольно просто и понятно с точки зрения базового освоения (классическое easy to learn@hard to master), просто ты подскользнулся на ровном месте из-за дилетантства.

Brutal, ты страшные человек!

> Imatrix кванты

Вот кстати, если визуализировать их - у шакала будут более четкие глаза и пасть, но остальное размыто даже сильнее и 6 левых лап. Офк это для самых малых, начиная где-то от 5 бит мутным будут только участки тела и четкими важные детали.

> Чел, ты думаешь что что-то знаешь и все просто

Где я это говорил? Я говорил что нихуя не знаю и даже углубляться не хочу. Я вообще с вопросом пришел просто "как это сделать" с помощью web-ui или чего угодно другого, что без ошибок запустится. Методом нажимания левой кнопки мыши

> И вообще "делать жсоны из датасета с помощью шарпа"- ебать ор

В оригинале они лежат в виде помойки, где половину нужно выкинуть/сквошнуть/собрать в диалоги по N токенов. И все это перегнать в какой-то формат, который съест например web-ui. Я это делаю на C# потому что мне так привычно. Кому-то удобнее на питоне. Куда смеяться-то?

> Также большинство анончиков здесь осознают свои силы и просят помощи где не понимают без лишнего фарса

А я чем занимаюсь?

> просто ты подскользнулся на ровном месте из-за дилетантства

Учитывая сколько ответов уже было, но ни одного конкретного решения кроме "пиздуй ml изучать сам себе напиши и разберись", то вопрос дилетантства остается открытым. Особенно учитывая что "не каждый, но таких наберется". А по факту ни одного решения проблемы

> Где я это говорил?

> Чтобы сделать обычный инференс модели никакого погружения, знаний и пониманий не потребовалось. Почему здесь должно быть иначе?

А это что?

С помощью вебуи сделать скорее всего не получится. Эта часть довольно хреновая из-за хардкода на который ты наткнулся, и она давно не обновлялась, потому там это старье в форматах. И в целом это лишь сомнительная обертка поверх трансформерс трейнера, потому лучше бы сразу заглянуть в оригинал, который работает хорошо. Но если разбираться не хочешь то увы, можешь разве что почитать анслотов с их тулзой.

> в виде помойки

Дай угадаю, там паркет, арроу или что-то подобное? В таком виде вместо пачки жсонов выкладывается не просто так.

> Куда смеяться-то?

Ну не прям смеяться, просто делать это в шарпе выглядит крайне неудобным, без осуждения.

> но ни одного конкретного решения

Ответ был дан сразу - попроси гопоту написать тебе трейнер на основе всего готового в трансформерсе и твоего формата датасета.

А на советы изучить базвы ты зря обижаешься/огрызаешься, ведь ответы на задаваемые вопросы содержатся в ней. Также, даже если сможешь все запустить - на выхлопе получится полная ерунда вместо рабочей модели и зря потратишь время.

> А это что?

Это мой личный опыт того, что запустить модельку может даже даун. Я думал что создать лору точно так же просто, потому что ее запуск не сложнее чем запуск основной модели. О том что будет куча подводных камней на этапе "а как ее сделать" я не думал

> Дай угадаю, там паркет, арроу или что-то подобное?

Нет, да это не и не важно

> Ну не прям смеяться, просто делать это в шарпе выглядит крайне неудобным, без осуждения

А на чем это надо делать чтобы не смеялись? Python? JS? Objective-C? Голыми машинными кодами с загрузкой и запуском через WinAPI? Для меня родной язык это C#, на нем и делаю. И оно работает

> Ответ был дан сразу - попроси гопоту написать тебе трейнер на основе всего готового в трансформерсе и твоего формата датасета

Ну это и равнозначно "сам изучи, сам разберись, сам напиши"

> Также, даже если сможешь все запустить - на выхлопе получится полная ерунда вместо рабочей модели и зря потратишь время

И что? Мне может процесс нравится. Да и уверенность есть что все-таки получится то что нужно, только пересобрать десяток раз придется с разными конфигами

Возьми да скачай.

Гуфы/exl3 давно доступны.

> Я думал что создать лору точно так же просто

К сожалению - нет. Запуск что лоры, что простого обучения в целом то тоже прост если знаешь пихон и околомл, но вот сделать что-то хорошее вместо лоботомитов, или запустить на слабом железе - уже дохуя сложно, да.

> Ну это и равнозначно "сам изучи, сам разберись, сам напиши"

Нет, все уже написано. Нужно лишь:

1 сделать импорт и загрузить модель

2 подстроить даталоадер под свой датасет и задачу

3 trainer.train()

причем код может сделать любая ллм, даже древний мистраль 7б с таким справится потому что штука мегапопулярная.

> Мне может процесс нравится.

Тогда зачем лишаешь себя удовольствия от изучения?

Просто это не картиночные сети где лора "дает нужный результат" и тренируется легко, с подобным подходом модель на выходе будет на любой запрос цитировать куски датасета и совсем поломается.

Посмотри еще анслотов и их трейнер он запускается ровно таким же образом.

> начиная где-то от 5 бит мутным будут только участки тела и четкими важные детали.

надо будет пририсовать шакалу чёткий детализованный песюн

Да я скачал, че-то пока не понятно, как ризонинг вырубить.

/no_think сверху промта не помогает.

>Llama-3.3-Nemotron-Super-49B-v1.5 is a significantly upgraded version of Llama-3.3-Nemotron-Super-49B-v1

Вам дали апдейт как минимум интересной модели, хули вы сидите свои 12б 4q весь день дрочите?

Списки ВСЁ, без пердолинга, с разметкой всё ок, мозгов прибавили куда уж больше, пресет анона вроде тоже работает, но думаю уже надо менять

Пробуй пресет анона у меня всё ок

Вам дали апдейт как минимум интересной модели, хули вы сидите свои 12б 4q весь день дрочите?

Списки ВСЁ, без пердолинга, с разметкой всё ок, мозгов прибавили куда уж больше, пресет анона вроде тоже работает, но думаю уже надо менять

Пробуй пресет анона у меня всё ок

>Пробуй пресет анона у меня всё ок

Это удивительно, но на синкинг влияет только одна опция: Include Names в Инструкт темплейте. Если стоит always то синкинг выключается, если Never то всегда работает и ему похуй вообще на все.

>Ты хоть сам этой янкой пользовался?

Пользовался и пользусь, выше есть чат-лог с неё и пресед для неё.

Коммандер в треде тоже был сломанным гавном пока Анон99 пресет не принёс.

>И где карточки кстати брать?

Чуб, жанитор, пиксельдрейн выше немного карточек есть.

Я кстати наконец разобрался почему в пресете анона99 ООС не работает, это реально его вина оказалась, разве что он скопировал откуда-то эту основу. Еще бля сидел отнекивался, на модель пенял, а там у него практически дословно зарыта в глубине фраза мол "ООС не будет, пошел нахуй."

По первому впечатлению, в новом Немотроне цензура на том же уровне (т.е. с промптом отсутствует) Вроде как инструкций в промпте случшается заметно лучше, буду дальше тестировать.

>Я не модель тренировать собираюсь, а только файн-тюн делать.

Делай квантованную лору. Те же яйца только в профиль. Гайдов в интернетах полно, так как это самый популярный подход в дотренировке. Скорее всего первые раз десять на выходе у тебя получится говно, но это нормально. Дальше с накопленным опытом уже будет проще.

>хули вы сидите свои 12б 4q весь день дрочите

дай деняг на 5090

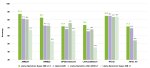

Самое смешное, что в этой табличке Qwen3-32B ебет прошлый немотрон вообще везде, а местами и Nemotron Ultra.

Получается, все истории про ум немотрона последние полгода — пшик? =D

Простите!

Не против немотроныча, прост, забавно. =)

> Qwen3-32B

Модель выглядит поломанной, что в ггуфах, что на экслламе. Не такой, конечно, треш что другие постили, но она очень припезднутая и странная, будто именно под нее писался дисклеймер о необходимости семплинга для отсутствия лупов. Офк есть вероятность что сразу оба интерфейса поломаны и нужно чисто трансформерсом ее раскатывать, но лень.

Если кто-то разобрался как ее юзать - реквестирую настройки и промпты.

Разобрался уже, осталось только на телефон настроить наверну.

Крч да, хуево работает. Загрузил персонажа с 16к контектом описания и прочего, уже минут 5 его кушает, жду когда высрет ответ, надеюсь более менее будет.

А что квен 32б не ебёт?

Наверняка даже корпов уже всех выебал.

Ура наконец-то настроил всё как надо в таверне, работает нормально.

Последний вопрос, как заставить на русском писать? Какой промт использовать?

Последний вопрос, как заставить на русском писать? Какой промт использовать?

>как заставить на русском писать

1) Первое сообщение карточки перевести на русский.

2) В систем промте указать чтобы писала на русском.

3) Можно то же самое указать в заметках автора на нолевой глубине.

Тебе не понравится качество, если стоит что то тупее геммы 12B. Но в целом, анон выше правильно написал.

>неужели я первый что ли кто хочет

Хотят каждый второй. А вот возможностей натрейнить что-то удобоворимое есть не только лишь у всех. Тут или тратиться на аренду пачки A100, или собирать риг RTX PRO 6000. На одной картонке, даже если это топовая 5090, ты ничего не сделаешь.

>Почему здесь должно быть иначе?

Потому что инференс делает 100% заинтересованных в ИИ анонов, а тренировкой занимаются примерно 0,0001%.

>что тут прям каждый анон ml-инженер и сидят скрипты на петухончике пишут под нейронки

Да, я пишу, а что?

>пиздуй ml изучать сам себе напиши и разберись

Это единственный вариант, если тебе нужно хотя бы в течении месяца. Интерфейсы допилят. Года через 2-3.

>WinAPI

Найс.

>3 trainer.train()

Я вот сам цикл тренировки писал, ибо стандартный трейнер кмк весьма ограничен. Впрочем, этот цикл мне гопота без проблем писала, притом что я по жизни пыхарь.

Вообще похуй.

Это всё на ру языке?

Немомих 12b Q3. (Ну а что поделать)

Третий квант 12B это уже чистейший лоботомит, а не модель. Ниже шестого проблемы начинаются, а у тебя вообще скорее всего будут одни галлюцинации, особенно на русском. Даже не говоря о том, что немомикс это по дефолту шиза, которую срали еще при выходе.

Новый Немотрон конечно такое выдает, у меня шишка улетела... Ставил темпу 2, ТопП 0.95, МинП 0,015. Никаких штрафов за повторы. Даже ни одного свайпа еще не было, посмотрим как дальше будет. Q4_K_S

Так я и поверил, специально сказки рассказываешь, чтоб я его скачал и проверил.

>Третий квант 12B это уже чистейший лоботомит, а не модель

В любом более качественные модели мне недоступны. Да и качество ответов, вроде, приемлимое на самом деле.

Что-то на уровне жанитора. Такая же скорость.

Открыл для себя только что опен роутер, с его бесплатными моделями типа дипсик. Ахуеть. Небо и земля. Не клод конечно, но тоже очень хорошо.

Как лимиты на 10 генераций в день обойти только? Или, там нужно немного заплатить? Если да, с рф можно?

Вроде, на $10 счет пополнить надо, на плати ру есть барыги

>$10

Демократично. Это на сколько? Или безлимит? Не верю в такую щедрость офк.

Не безлимит, 1000 реквестов в день, должно с полна хватить

Алсо, там бесплатных 50 должно быть, а не 10, но хз, что ты там делал, может и 50 потратил

>В любом более качественные модели мне недоступны.

Тогда перекатывайся на корпораток, че тут тебе еще посоветовать. На твоем железе кумить можно только в голове, прописывая сценарии в перерывах между дерганьем ручкой. Хотя, если тебя устраивает текущее качество, то лучше не трогать большие модели вообще. Не будет материала для сравнения - не будет проблем.

>1000 реквестов в день

Отлично. Так это на сколько.. на месяц? Или пока 10 баксов лежат?

10 точно, с другого акка зашёл проверить.

>Не будет материала для сравнения - не будет проблем.

Двачая. Но я уже потрогал клода в куме, и забыть это чудесное мгновение больше не в силах.

>Немомих 12b Q3

Ты же понимаешь что она будет писать на русском на уровне чукчи с деслексией? Лучше уж яндекс переводчик подруби.

>Так я и поверил, специально сказки рассказываешь, чтоб я его скачал и проверил.

Ну я скачал и проверил. Цензура не лучше прошлого ванильного Немотрона, плохой русский (хотя и лучше прошлого), ризонинг по умолчанию. Такое себе. По ощущениям поумнее стала, но для любых сомнительных тем не годится совсем.

И вообще, бери немо инстракт из шапки, он с простеньким uncensored систем промптом который лежит на реддите по первому запросу в гугле становится сильно раскрепощённым, но и немного чернушным. Все эти 12b миксы - ужаренные в ноль лоботомиты с пизданутыми датасетами от которых карточки кидает из одной крайности в другую.

>Все эти 12b миксы - ужаренные в ноль лоботомиты с пизданутыми датасетами от которых карточки кидает из одной крайности в другую.

У него итак третий квант, там не то что в крайности будет кидать, там трусы поверх пуховика будут надеваться и сниматься через голову. При такой точности в целом похуй насколько у тебя ужаренная модель, шизить будет примерно одинаково.

Ну тогда ему дорога в приложухи типа chat waifu. Там встроеный переводчик и модели на уровне 8b q6, что лучше чем нихуя. Рекламу посмотрел 5 минут и можно рпшить часик. Я сам на этом говне сидел месяц пока не полез разбиратся как текстовые модели запускать локально. Пишет вполне осмысленно но вяло, а хули хотеть, я как понял к чему всё идёт, посчитал что выгоднее свою пекарню обновить чем платить каким то ебланам.

>ризонинг по умолчанию

У меня ни разу не сризонил, шаблон стандартный ллама 3 с именами.

>По ощущениям поумнее стала

А что ещё надо?

>но для любых сомнительных тем не годится совсем

У меня норм в сомнительное.

Впрочем одну странность он высрал. ХЗ как это вышло.

Ну вот вам сцена без свайпов, да эти "Mine" не очень, и есть нюансы к чему можно придраться, но все остальное прям около топа. И то что без лишнего мозгоебства персонаж ллмки сам подкатил, без особых прелюдий и возни вокруг да около, и сама длина и детализация сцены, то что учел контекст, место и добавил зрителя. И темпа 2. Я честно впечатлился.

Эльфийская писечка(23 года) VS монстер с двумя членами-тентаклями:

Кароче ничего рабочего кроме как говноскрипт на питоне сгенерированный нейронкой я не нашел. Unsloth на винде не работает ни в какую, на WSL таки заработал, печь что-то там жарит. Я просто никогда с этой самой WSL раньше не сталкивался, думал что на винде должно работать, но хуй там из-за Blackwell. Можно сказать что вопрос решен

> На одной картонке, даже если это топовая 5090, ты ничего не сделаешь

Для 12B нейросетки таки делаю прямо сейчас. Полностью пожирает все 32 гб VRAM + 30 гб RAM, но работает. Для >12B хз, наверное до 20B оперативки хватит

>Полностью пожирает все 32 гб VRAM + 30 гб RAM

Как по мне, результат на пикриле. Прикинь, сколько это займёт по времени. Не, если действительно выйдет потюнить 12B няшу на 32 врама, я буду только рад (как обладатель такой же карты), но что-то верится с трудом, там сами веса занимают 24 гига, а ещё нужно хранить все активации и прочее говно.

>Это всё на ру языке?

Да.

И да опенроутер харош, на плати ру есть барыги, 10 долларов тратить не обязательно, они могут весь год просто пролежать на балансе, через год сгорят.

Если же корпы не вариант - можешь таки попробовать:

https://pixeldrain.com/u/cw6ZbtFe yankagpt-8b-v0.1 log + preset.zip

У кого хватает врама на немотрон те молча им пользуются и довольно урчат

У кого не хватает те завидуют и пишут гадости

Думайте

У кого не хватает те завидуют и пишут гадости

Думайте

есть ещё кто не юзает, не завидует, не пишет

Как думаете, жизнеспособно или совсем дерьмо? 150к рубасов получается за такую шнягу. Я чет слышал, что обычные геймерские у интела вообще не могут в инференс - там какой-то калич чуть лучше цпу-онли по скорости.

что за скрипт? дай ссыль пж

> 150к рубасов

С учетом перекупов?

Да, на лохито увидел. 155 просят если быть точнее.

> Я вот сам цикл тренировки писал, ибо стандартный трейнер кмк весьма ограничен.

С какими ограничениями столкнулся, что добавлял?

Все что он делает - прогоняет форвард модели по загруженному твоим даталоадером батчу, высчитывает лосс по функции, которую ты ему даешь (или по заготовленным), беквард и после числа шагов аккумуляции тикает оптимайзером-шедулером и т.д. Для дефолтных случаев хз что еще добавить

Он удобен тем, что заготовлено широкое множество аргументов тренировки под большинство случаев и не нужно изобретать велосипед под широкое множество базовых вещей типа сохранения по принципу, загрузки на хаб и т.д. и т.п. Но если действительно хочешь делать что-то "уникальное" то одна строка превратится в 5 для простой тренировки или 305 для чего-то хитрого с описанным выше функционалом.

Чсх, она была более чем локальной и преимущества этого были прекрасно обыграны в фильме.

> Для 12B нейросетки таки делаю прямо сейчас

Это будет лишь вялый peft. Практический порог тренировке в 32гигах - 3-4б, и то уже идут компромиссы, потребуется пердолинг и цифра скорее имея несколько для возможности шардинга. Больше - падение скорости будет делать все бессмысленным.

> результат на пикриле

Может у него там (эффективный) батч 128+, тогда оче это оче быстро.

Уже в магазинах есть вроде как

куртка > печка > говно > моча > инцел

Но ведь высрали же этот гпу по какой-то причине как серверный. Их же предполагается тысячами будут покупать и ебашить в датацентры. Что, при таком раскладе кто-то потратит миллионы долларов на гпу которые хуже говна и мочи? Странно как-то.

Кто-то тут вроде на ми-шках сидит, но это пердоликс.

откаты и коррупция бывает не только в России но и в Украине

а точнее решения о массовых закупках принимаются на основе отката, который получит менеджер по закупкам.

Крч да, понял что с 12б пососать только можно..

Закинул 10 баксов на опенроутер, чтобы можно было кумить почти безлимитно с диксиком. Уж очень он хорош.

Хотя от дрочки локалки не отказываюсь, буду продолжать тесты и следить, крутая тема.

Закинул 10 баксов на опенроутер, чтобы можно было кумить почти безлимитно с диксиком. Уж очень он хорош.

Хотя от дрочки локалки не отказываюсь, буду продолжать тесты и следить, крутая тема.

12 B или GB? мне для уточнения базы треда

Учти, что это две видеокарты, им нужна бифуркация на слоте x8+x8.

Примерно 8млрд человек вообще никогда не кумили на нейронки. Надо ровняться на них.

>Dual GPU

>Dual

Обычно признак отборнейшего фейла.

>С какими ограничениями столкнулся, что добавлял?

У меня лосс в нан скатывался, я просто обрывал тренировку, чтобы не жечь просто так карту. Так то и логирование в стандартном трейнере хорошее, и даже прогресс бар есть. Но хочется полного контроля.

>Чсх, она была более чем локальной

Фильм староват уже, в те времена ещё не было такого переноса всего в облака. Сейчас бы хрен бы показали локал очку.

>Может у него там (эффективный) батч 128+,

Скорее батч в 1, судя по пердоленью лосса. Но я не великий спец если что.

12B, в квантовании Q3.

Только увидел. Да, опенроутер хорош, ещё бы клода.. но лучше уж год беслатными буду лакомиться, чем быстро прожгу всё на клода.

Хоспаде, осталось через спермукс поставить таверну на ведро, и можно будет обдрачиваться сутками напролёт, забыв про говно приложения с раковыми модельками.

с видюхами всё ясно, а как выбирать CPU? я правильно понимаю, что если выгружать все слои на видюху, а только ffn_*_эксперты на CPU, то важнее частота ядер, чем их количество? и что количество важно только при промпт процессинге, а эксперты - это уже токен генерейшон, и тут уже лучше рузен с небольшим количеством ядер но большим значением кекагерц, чем сто тухлых зивоноядер по 1.6ггц?

> лосс в нан скатывался

Расскажи подробнее что тренил. Обычно, подобное - следствие очень неочень гиперпараметров, включая кривые оптимайзеры, снижения точности там где не стоит и т.п. Но если же конструируешь что-то свое, и тем более трейнер свой без страхующих обвязок - тут уже что что угодно может быть.

> Сейчас бы хрен бы показали локал очку.

Обычно в фильмах чаще прослеживается тренд на опасность облаков и благо локального. Неужели где-то тренд поменялся?

> Скорее батч в 1, судя по пердоленью лосса

Ага, скачки норм градиентов на 2 порядка пострашнее будут.

>Хотя от дрочки локалки не отказываюсь, буду продолжать тесты и следить, крутая тема.

Лучше начинай собирать новую систему. Как бы локалки не развивались дальше, хотя бы на одну нормальную видеокарту придется раскошелиться.

Интел дрова для одночиповых карточек через раз нормальные пилят, а тут какое-то говно с целыми двумя. Определенно стоит того.

Важнее скорость оперативки.

>Расскажи подробнее что тренил.

GPT2, чисто мои личные тесты. Гиперпараметры само собой говно спотолочное, так что да. Оптимайзер стандартный адамв, точность не смотрел, думаю полная, сетка то лоботомит 700М.

>Обычно в фильмах чаще прослеживается тренд на опасность облаков и благо локального.

Вут? Это где например?

да понятно, что скорость оперативки, но если она одинаковая в обоих случаях, тогда решают мегагерцы?

Тогда решает скорость оперативки. И больше ничего. Ну, это если проца достаточно, от 6 ядер чего-то современного.

Ничего я тебе не дам. Мне тут сказали самому нахуй пойти к ChatGPT вот и тебе даю такой же совет. Мне написал и тебе напишет значит

> Может у него там (эффективный) батч 128+, тогда оче это оче быстро

batch_size = 1

grad_accumulation_steps = 4

> Это будет лишь вялый peft

Ну посмотрим. Может несколько эпох оставлю на ночь если совсем вяло будет. Одна эпоха примерно 2 часа с моим конфигом сейчас. Пришлось обрезание диалогам сделать до 2048 токенов, с 4096 падает сразу

> GPT2

Эти старые сетки склонны к коллапсу сами по себе, особенно если отойти от фп32.

> Вут? Это где например?

В каждом фильме где это как-то задействовано или напрямую обыгрывается идея что централизованность и сосредоточение подобных чувствительных вещей - плохо и опасно, тот же блейдраннер или мемный яробот. Или вообще никак не затрагивается. А вот чтобы это преподносилось как благо - даже не припомню такого.

> тогда решают мегагерцы

Не мегагерцы и флопсы в векторных операциях. Они же будут определять скорость обработки, но это разница между 25 и 35т/с, и то и другое неюзабельно. В генерации отличия будут в пределах десятка процентов скорее всего.

> batch_size = 1

> grad_accumulation_steps = 4

Малые батчи

> Одна эпоха примерно 2 часа

7 тысяч образцов, хз. Разве что не успеет сгореть но что-то ухватит

По опыту могу сказать что при попытке добавить знаний не "точечно" а покрупнее - любой пефт получается копиумом по сравнению с полномасштабным файнтюном при прочих равных.

> Мне тут сказали

> база треда:

> - тут полтреда токсичных уебанов, игнорируй хейт, опционально можешь ебать их мамок

мою ток не еби, я тебя не хейтил

>Мне тут сказали самому нахуй пойти к ChatGPT

Лол, а чего ты ожидал? Итт обсуждается преимущественно запуск и прогон локалок, а не их тренировка. Тут буквально по пальцам можно пересчитать людей, которые что-то тренировали и которые посещают тред чаще раза в неделю.

>Эти старые сетки склонны к коллапсу сами по себе, особенно если отойти от фп32.

Мейби, не изучал.

>обыгрывается идея что централизованность и сосредоточение подобных чувствительных вещей - плохо и опасно

Разве именно эта мысль? Скорее просто "плохой правитель плохо, а вот хороший...".

Ну вот я, даже скрины своего кода кидал. Но особого смысла мне кидать ему весь свой код нет, ибо действительно тривиально пишется, и лучше самому, чтобы понимать назначение каждой строки. А у меня там вообще куча хардкода, ибо ебал я заморачиваться с архитектурой и параметрами в личном коде.

> Малые батчи

Так а смысл больше если и так своп начинается на оперативку. Будет еще медленнее в моем случае на этих данных. Ну будет жрать не 30, а 70-80 гб оперативки при batch_size = 2, толку. Если я правильно понимаю, конечно, как это работает

> Итт обсуждается преимущественно запуск и прогон локалок

А что их обсуждать-то? Берешь и запускаешь. Ничего не нужно толком. А тут в лоб вообще никак и ни в каком виде, требуется как минимум линукс/wsl

>Так а смысл больше

Смысл чтобы градиенты не пидорасило. Для этого батчи и юзают (ну и чтобы задействовать больше вычислительной мощности, ибо на корп картах памяти в разы больше).

>Будет еще медленнее в моем случае

Поэтому я и написал, что у тебя мало железа для этой задачи. Запустить на минималках не значит получить нормальный результат.

>требуется как минимум линукс/wsl

Вот это всё говно я запускал на шинде если что.

> Вот это всё говно я запускал на шинде если что

Все что я пробовал стонало о том что что blackwell и собраться не может. Либо конфликты. Вот этот гайд например https://github.com/unslothai/unsloth/tree/main/blackwell если в точности повторить приводил к шквалу ошибок и нихуя ничего не работало. Аналогично со всем остальным что я пробовал. На WSL завелось. А ты в итоге через что тренируешь и у тебя 50 поколение или другое что-то?

> Поэтому я и написал, что у тебя мало железа для этой задачи

Да не мало, просто медленно. Понятно что если у тебя не 32 гб, а 320, то раз в 10 быстрее будет. Но качество от того что я батчи в 10 раз больше запускаю влиять не должны. Влиять должныдругие параметры, а этом просто ускоряет и все если много памяти

> сказали самому нахуй пойти к ChatGPT

Готовых интерфейсов для хлебушков нету, сам писать простой код не хочешь, просить помощи у ллм это самый разумный путь а не посыл нахуй.

> Разве именно эта мысль?

Заваруха от беспредела из-за монополизации и централизации являются клише для чуть ли не каждого второго тайтла подобных тематик.

> а смысл больше

Необходимо для качественного, стабильного обучения и регуляризации. Есть и редкие исключения где мелкий батч дает хорошие результаты.

> будет жрать не 30, а 70-80 гб оперативки при batch_size = 2

Нет, если тренируются только матрицы лоры то рост будет сильно меньше. Если включишь чекпоинтинг - рост с повышением батчсайза будет на единицы-десятки процентов а не кратно.

> на оперативку

А ее, если все нормально организовано, чаще кушает даталоадер, убери pin_memory и снизь их количество.

> требуется как минимум линукс/wsl

Это и есть "ничего не нужно толком" если ты отступаешь от популярных и заготовленных для хлебушков вещей. Пару-тройку месяцев назад на шинде с блеквеллом даже популярный инфиренс обычные юзеры не могли запустить.

> стонало о том что что blackwell и собраться не может. Либо конфликты.

Лол ну как раз оно. Все это сводится к тому что нужно просто самому собрать используемые либы под куду 128 если они уже не собраны.

А шинда непригодна для нормального обучения уже ввиду отсутствия поддержки дистрибьютед операций в nccl. Костыли нельзя назвать работоспособными.

>А ты в итоге через что тренируешь и у тебя 50 поколение или другое что-то?

5090, как у тебя, писал же. Точнее код был написал ещё когда у меня была 3090, но сейчас проверил, тренировка идёт так же. Просто стандартные чистые питорчи и прочее говно последних версий. Сначала ставишь куду 12.8, потом тупо через пип нужные пакеты. Торч по инструкции для нужной куды, остальное просто по имени пакета.

Адрес с кудой

https://developer.nvidia.com/cuda-12-8-0-download-archive

Команда для питорча

pip install torch==2.7.0 torchvision==0.22.0 torchaudio==2.7.0 --index-url https://download.pytorch.org/whl/cu128

Всё, вы прекрасны.

Там даже не в 10 раз скорость будет. У тебя просто всё во врам не влазит, как я вижу.

Ничего компилять не нужно по состоянию на вчера. Я ничего не компилял.

> Ничего компилять не нужно

> flash attention @ bitsandbytes @ xformers

И тритон вдогонку. У тебя просто (почти) пустой без использования компилируемых вещей.

Ну не используй битсадбайтес и подделку от террористов (а то арестуют), делов то. Тритон кстати поставился без компеляции, без него SPDA не врубался для геммы 3, а с ним в лёт пошло.

>были прекрасно обыграны в фильме.

Что за фильм то?

>Фильм староват уже

Ещё лучше, сои меньше.

> и подделку от террористов

Лолвут? За этим какое-то стори?

> не используй битсадбайтес

Если qlora маздай то врам-эффективные оптимизаторы очень полезны.

> Тритон кстати поставился без компеляции

Так это как раз подделка - тритон шиндоуз а не оригинальный, на него раньше сильно гнали.

> SPDA

С нем нельзя не рекомендуется тренить.

> Что за фильм то?

Ну ты, оттуда же маскот кончай треда https://www.imdb.com/title/tt1856101/

>Лолвут? За этим какое-то стори?

Кроме того, что её выпустила организация, признанная террористической (ни за хуй собачий) ничего.

>Так это как раз подделка - тритон шиндоуз а не оригинальный, на него раньше сильно гнали.

Ну ХЗ, поставился и наверное даже пашет.

>С нем нельзя не рекомендуется тренить.

А с чем трейнить?

2 часа тренировки на диалогах. Итоги. Даже если 1 в 1 пишу что-то из обучающих материалов получаю в ответ то же что и от базовой модели. Кайф

> её выпустила организация

Ну так-то https://en.wikipedia.org/wiki/PyTorch

> А с чем трейнить?

Для ллм от гугла и еще некоторые eager.

Если тренишь лору то не забудь ее подключить.

Я ее уже и подключил, и даже вмерджил в оригинальную модель и так попробовал запустить. Вообще 0 отличий от оригинала

Это странно, попробуй сравнить веса оригинала и вмердженной и глянуть значения внутри самой лоры.

Веса-то какие есть, аж на 222 Мб. Но вот понять что там внутри я вообще хз как

> понять что там внутри я вообще хз как

state_dict = safetensors.load('/path')

for k,v in state_dict.items():

print(f'{k}: {v.mean()}, {v.max()}, {v.min}')

С импортами и отступами сам разберешься.

Кто-нибудь пробовал cunny-ролеплей с моим системным промптом по сути перевод аноновского пресета для Mistral-Small-3.2-24B-Instruct-2506 ? На сколько все плохо?

https://pixeldrain.com/u/TVYnXnYH

https://pixeldrain.com/u/TVYnXnYH

>Ничего я тебе не дам. Мне тут сказали самому нахуй пойти к ChatGPT вот и тебе даю такой же совет. Мне написал и тебе напишет значит

Твой код с конфигами нужен будет чтобы понять в чем ты обосрался, после того как ты проверишь модель.

>batch_size = 1

>grad_accumulation_steps = 4

Маленький батч. Но если че, аккумуляция = батч, так что память на батчи можешь не тратить.

Как у тебя вообще модель влезла, хз. Хотя на 2к токенах, это мало совсем. У тебя чекпоинтинг включен?

>Веса-то какие есть, аж на 222 Мб. Но вот понять что там внутри я вообще хз как

Там могут быть 222 мегабайта нулей. И модель на нули в лоре реагирует буквально никак, как будто ее нет. Альфа еще какая у лоры?

Можешь посмотреть в этой штуке https://netron.app/ как на скрине, в up блоках могут быть нули или маленькие значения, значит нихуя не обучилось.

Ты пока смотри, я еще тебе допишу некоторые мысли по поводу лор.

> Твой код с конфигами нужен будет чтобы понять в чем ты обосрался, после того как ты проверишь модель.

Ну допустим https://pastebin.com/wJbbT5tg

> Там могут быть 222 мегабайта нулей

Да там вроде и не нули

> Как у тебя вообще модель влезла, хз

Я так понял частично своп в оперативку. Ее относительно много, 96 гб

> Как у тебя вообще модель влезла

А чего ей не влезать, кушает около 25гигов, как раз на небольшой контекст и сотню миллионов тренируемых параметров останется.

Уже хорошо что не нули.

А где оптимайзер в аургментах? Даталоадер и парсер проверь, корректно ли возвращает.

>Ну так-то

А ты не очень замечательный.

>cunny-ролеплей

Осторожно, тут такое трут.

> Each turn of the game approximately takes 10 minutes of game time, but you can adjust this if the logic of events requires it.

Отборное

> -ролеплей

Должен быть из коробки а промпты уже по вкусу, натаскивать - плохая идея.

> А ты не очень замечательный.

пикрел

> -ролеплей

>Должен быть из коробки

Приведи пример модели где тян не ведут себя как шлюхи, и может канни рп?

>пикрел

О, так даже лучше. Присядут все!

Большой квен

О том и речь же, лол. Не ну есть еще onnx и tensorflow.

С таким подходом и АстраЛинукс нельзя использовать, там ведь ядро финский нацик писал.

Ты начинаешь что-то понимать.

Уровень твоей шизы? Сложно даже имадженировать.

Давно известно, что все новые законы пишутся только ради того, чтобы каждый был под статьёй. Ебать ты тёмный.

И кто запрещает пользоваться софтом Меты? Голоса у тебя в голове? Нет ни одного закона, который бы запрещал хоть какой-то софт. Будь он хоть от ИГИЛа.

Продолжение мыслей отсюда

Кароч результат с обычной ванильной лоры всегда говно. В sd-тредах проверено на практике, есть куча статей конкретно по ллм, там картина еще хуже.

Проблемы, например, с тем что по хорошему надо нормировать масштаб обновлений по a*b раздельно. Ибо вторая инициализируется нулями, и в процессе это все перекосоебывает. Там код для этого не особо сложный, но надо будет самому внедрять. В обсуждениях по sd есть готовый пример, если тебе интересно этим заниматься, найду ссылку. Также стоит делать обучаемые альфы. Это в принципе просто конфигом задается. Но надо делать 2 тренировки, первую только чтобы подобрать коэффициенты альф, потом они фиксируются и их надо подставить во вторую тренировку.

С ванильной лорой есть метод чуть попроще и не хуже, но я его делал для sd в гуях. Суть в том чтобы разбить модель через svd на 2 составляющие. Одной из них инициализируется лора, и тренировка стартует с нее. Повторюсь, для sd это делается буквально в несколько кликов через мержер и пару трюков, чтобы все правильно взлетело. Если ты умеешь делать экстракт лоры из модели, мержить/вычитать отдельно лоры/модели и запекать лору в модель, то тебе достаточно этих инструментов, и потом ты просто стартуешь тренировку с получившегося файла.

Работает намного стабильнее, не нужна подборка альф.

Если интересно напишу подробнее схему процесса.

Потом есть всякие прикольные peft методы, самое не пердольное - dora. В твоем коде оно должно быть доступно. Точно будет лучше обычной лоры и не тяжелее.

Также в sd-треде анон форсил boft как что-то охуенно работающее, но в сдскриптах его реализация в 3 раза медленнее лоры. Там еще надо включать 2 параметра в его конфиге. Один из них это какие-то доп. веса, а второй коэффициент типа аналог альфы или wd, не помню.

Недавно вышла интересная статья с новым методом https://www.alphaxiv.org/ru/overview/2507.05566v1 должно быть еще лучше всяких dora и т.п.

Плюсом сокращает обучаемые параметры в 2 раза. Но надо самому кодить, идея простая, ллмка прочитает статью и справится, думаю. Но там инициализация пердольная, с планировщиком. Может заруинить все плюсы метода.

Если бы ее инициализировать как я писал через svd, было бы вообще прекрасно. Но хз как.

Вот тебе 4 варианта, куда копать если ты хочешь срезать углы и выжать максимум из лоры.

Я так понимаю, тебе пока лишь бы просто запустить, но все же...

Потом, у тебя в коде не указан оптимайзер. Хз что там по дефолту. Из классических лучше всего adamW обычный. В том же sd-треде хайпуют Prodigy + Schedule-Free, нужно ставить отдельно отсюда https://github.com/LoganBooker/prodigy-plus-schedule-free

С маленьким набором данных еще желателен подбор wd (weight decay) чтобы модель не переобучалась. Включение ema (exponential model average). И всякие хитрые трюки с мержами промежуточных чекпоинтов. Например вычесть разницу, чтобы получить только обученную часть весов, умножить ее на 0.9, добавить обратно и продолжать тренировку с нее. (То же самое - просто смержить с исходной моделью с низким коэффициентом.) Или мержить несколько промежуточных чекпоинтов. (Это что-то типа ema, только с одинаковым весом по всей истории тренировки, была статья где это хорошо работало на претрене.)

>https://pastebin.com/DjNFuQHs

>Да там вроде и не нули

Не нули, да, что-то есть. Посмотри в https://netron.app/ есть ли вообще альфа в файле и с каким весом ты в итоге мержешь лору с моделью.

Также советую все же не тренить на винде, а поставить прыщи в дуалбут. Сэкономишь и память и быстрее будет. WSL это говно которое тормозит и насыпает проблем на ровном месте.

И желательно чтобы на компе ничего лишнего в момент тренировки не крутилось, еще лучше чтобы выход на монитор шел со встройки или другой карты. Твои 2к токенов, которые кое-как влезают - это ни о чем.

Кароч результат с обычной ванильной лоры всегда говно. В sd-тредах проверено на практике, есть куча статей конкретно по ллм, там картина еще хуже.

Проблемы, например, с тем что по хорошему надо нормировать масштаб обновлений по a*b раздельно. Ибо вторая инициализируется нулями, и в процессе это все перекосоебывает. Там код для этого не особо сложный, но надо будет самому внедрять. В обсуждениях по sd есть готовый пример, если тебе интересно этим заниматься, найду ссылку. Также стоит делать обучаемые альфы. Это в принципе просто конфигом задается. Но надо делать 2 тренировки, первую только чтобы подобрать коэффициенты альф, потом они фиксируются и их надо подставить во вторую тренировку.

С ванильной лорой есть метод чуть попроще и не хуже, но я его делал для sd в гуях. Суть в том чтобы разбить модель через svd на 2 составляющие. Одной из них инициализируется лора, и тренировка стартует с нее. Повторюсь, для sd это делается буквально в несколько кликов через мержер и пару трюков, чтобы все правильно взлетело. Если ты умеешь делать экстракт лоры из модели, мержить/вычитать отдельно лоры/модели и запекать лору в модель, то тебе достаточно этих инструментов, и потом ты просто стартуешь тренировку с получившегося файла.

Работает намного стабильнее, не нужна подборка альф.

Если интересно напишу подробнее схему процесса.

Потом есть всякие прикольные peft методы, самое не пердольное - dora. В твоем коде оно должно быть доступно. Точно будет лучше обычной лоры и не тяжелее.

Также в sd-треде анон форсил boft как что-то охуенно работающее, но в сдскриптах его реализация в 3 раза медленнее лоры. Там еще надо включать 2 параметра в его конфиге. Один из них это какие-то доп. веса, а второй коэффициент типа аналог альфы или wd, не помню.

Недавно вышла интересная статья с новым методом https://www.alphaxiv.org/ru/overview/2507.05566v1 должно быть еще лучше всяких dora и т.п.

Плюсом сокращает обучаемые параметры в 2 раза. Но надо самому кодить, идея простая, ллмка прочитает статью и справится, думаю. Но там инициализация пердольная, с планировщиком. Может заруинить все плюсы метода.

Если бы ее инициализировать как я писал через svd, было бы вообще прекрасно. Но хз как.

Вот тебе 4 варианта, куда копать если ты хочешь срезать углы и выжать максимум из лоры.

Я так понимаю, тебе пока лишь бы просто запустить, но все же...

Потом, у тебя в коде не указан оптимайзер. Хз что там по дефолту. Из классических лучше всего adamW обычный. В том же sd-треде хайпуют Prodigy + Schedule-Free, нужно ставить отдельно отсюда https://github.com/LoganBooker/prodigy-plus-schedule-free

С маленьким набором данных еще желателен подбор wd (weight decay) чтобы модель не переобучалась. Включение ema (exponential model average). И всякие хитрые трюки с мержами промежуточных чекпоинтов. Например вычесть разницу, чтобы получить только обученную часть весов, умножить ее на 0.9, добавить обратно и продолжать тренировку с нее. (То же самое - просто смержить с исходной моделью с низким коэффициентом.) Или мержить несколько промежуточных чекпоинтов. (Это что-то типа ema, только с одинаковым весом по всей истории тренировки, была статья где это хорошо работало на претрене.)

>https://pastebin.com/DjNFuQHs

>Да там вроде и не нули

Не нули, да, что-то есть. Посмотри в https://netron.app/ есть ли вообще альфа в файле и с каким весом ты в итоге мержешь лору с моделью.

Также советую все же не тренить на винде, а поставить прыщи в дуалбут. Сэкономишь и память и быстрее будет. WSL это говно которое тормозит и насыпает проблем на ровном месте.

И желательно чтобы на компе ничего лишнего в момент тренировки не крутилось, еще лучше чтобы выход на монитор шел со встройки или другой карты. Твои 2к токенов, которые кое-как влезают - это ни о чем.

Я тут параллельно попробовал лору с почти тем же кодом, но чуть доработанным на Qwen3-0.6B с теми же данными - и вот там прям сразу видно что работает. Если еще точнее, то почти генератор бреда, но на основе того на чем обучал. Довольно забавные ответы на вопросы по типа "а ты вообще кто?" или "пошла вон отсюда" выдает. То есть на большой модели в теории тоже должно работать, но нужно поиграться с настройками. Какого хера в первый раз на 12B вообще эффекта 0 пока не знаю, буду изучать

>https://www.alphaxiv.org/

Лол, интересный сервис.

Мимо с полусотней закладок на оригинальный arxiv.org

Сначала они пришли за твитором и лицекнигой, но ты в них не сидел. Потом начали замедлять данные удалены

> В sd-тредах

Честно говоря, то что там обсуждают или давно внедрено и используется, или имеет крайне опосредованное отношение к ллм и переоцененную важность.

Весь этот бисер позволит на крохи улучшить результаты, но не решает фундаментальных проблем peft и тем более не вывезет базовые косяки проблемного датасета и явных ошибок.

> dora

Это база которая не первый год используется всеми по дефолту.

> https://www.alphaxiv.org/ru/overview/2507.05566v1

Решают одну проблему и порождают пачку других.

> С маленьким набором данных

Лучше вообще не делать тренировку если только это не картиночная лора на еот.

> WSL это говно которое тормозит

Основная беда там на доступ в основную файловую систему, но с нормальной настройкой даталоадеров не доставит неудобств. Офк нативные прыщи лучше, особенно по свободной рам, но всл для начала может быть вариантом.

Если это ты тренируешь - лучше сначала не забивать голову всем этим а добиться базовой работы. Потом уже можно поиграться постепенно добавляя и оценивая. Но не питай завышенных ожиданий, старина adamw (ну может быть ademamix и их квантованные вариации), хороший сбалансированный датасет с аугментацией - вот основы основ, остальное имеет уже следующий порядок малости по влиянию на результат. И, разумеется, полновесная тренировка. Исключения редки и специфичны.

> Основная беда там на доступ в основную файловую систему

Просто не нужно гонять байты на хост фс. Ещё и проблемы с правами на файлы могут быть.

Сам всл пушка гонка, выкинул дуалбут ещё с времён всл1, а сейчас туда завезли поддержку гуя и видеокарт и вообще стало хорошо жить

В Китае огромное количество RTX 5090 перерабатывается в графические процессоры для ИИ

https://overclockers.ru/blog/Global_Chronicles/show/234252/Ogromnoe-kolichestvo-GeForce-RTX-5090-pererabatyvaetsya-v-graficheskie-processory-dlya-II-v-Kitae

видео https://www.bilibili.com/video/BV1Px8wzuEQ4/

с нейропереводом приложено

>Кто-нибудь пробовал cunny-ролеплей с моим системным промптом по сути перевод аноновского пресета для Mistral-Small-3.2-24B-Instruct-2506 ? На сколько все плохо?

Оригинальный автор здесь.

Я у себя тестил и на английском (просто убирая приказ на русском писать), и в разных видах RP - вполне идет. Но я вижу, что ты себе разметку Mistral Tekken поставил - а вот с ней будет не слишком хорошо, независимо от языка и сценария. Как минимум - "день сурка" когда контекст заполняется. Я там в своем пресете разметку делал специальную на базе ChatML - в ней весь цимес.

Ни на чем не настаиваю, мой вывод для себя - MS32 на стандартной мистралевской разметке, теряет в качестве вывода как бы не на треть от возможного.

P.S. Gemma3-Storyteller, кажется, тоже (тут уже про стандартный пресет геммы). Сейчас экспериментирую с ней - кажется подобная специфичная разметка и на нее положительно влияет.

Что теоретически будет лучше? 13B модель в Q3, или 7B в Q6? (При условии что модели одинаковые) Хочу разобраться.

Как будто бы новый немотрон на 3 кванте уже не то

Всё же лучше 5 квант glm использовать

Всё же лучше 5 квант glm использовать

https://github.com/astrskai/astrsk опенсорснули.

>7B в Q6