Там кстати обнова у кобольда.

NEW: Added the ability to switch models, settings and configs at runtime! This also allows for remote model swapping. Credits to @esolithe for original reference implementation.

Launch with --admin to enable this feature, and also provide --admindir containing .kcpps launch configs.

Optionally, provide --adminpassword to secure admin functions

You will be able to swap between any model's config at runtime from the Admin panel in Lite. You can prepare .kcpps configs for different layers, backends, models, etc.

KoboldCpp will then terminate the current instance and relaunch to a new config.

https://github.com/LostRuins/koboldcpp/releases

NEW: Added the ability to switch models, settings and configs at runtime! This also allows for remote model swapping. Credits to @esolithe for original reference implementation.

Launch with --admin to enable this feature, and also provide --admindir containing .kcpps launch configs.

Optionally, provide --adminpassword to secure admin functions

You will be able to swap between any model's config at runtime from the Admin panel in Lite. You can prepare .kcpps configs for different layers, backends, models, etc.

KoboldCpp will then terminate the current instance and relaunch to a new config.

https://github.com/LostRuins/koboldcpp/releases

>image

green tea neko vibes

Реально наконец перестал дрочить клип каждый раз при новом запросе. Можно наконец работать с mmproj

Всё куда хуже.... Присмотрись!

По этой причине магнум и идет нахуй.

Я никогда так не бесился как с ним.

Трагедия ? Что у тебя в трусах ?

Драма ? А давай посмотрим в трусики !

Ужасный некромант поднял легионы нежити ? Давай посмотрим что у этого скелета в панцу !

Азагот пытается от тебя сбежать, ведь ты пробудил древних богов ради их трусиков.

А, ну ок. Видимо, я недооценил вклад быстрого проца с оперативой. На моём 4-х поточном и ддр4 ничего близкого к таким скоростям не будет. У меня на 12б Q4_K_M выключение флэш аттеншена по какой-то причине действительно ускоряет генерацию при совсем незначительном падении скорости обработки, но только когда вырублен режим lowvram. Если же KV кэш перекинуть на оперативу (включенный lowvram), то без фа скорость обработки промпта падает раз в 6-7. Скорее всего, такой же эффект будет, если взять модель побольше, и много кэша окажется не на видяхе.

с последнего вскрякнул

а самое страшное, что я видел фанфик похожего содержания

только вроде там было про варкравтовских древних, а не mythos'осовских

Как же chuckle с этого пика, swaying my hips seductively with a mischievous grin.

>вскрякнул

Дело селезня живет.

Кэта все знают (и хейтят маленько за спам всюду).

Я сам у него не брал, но вроде чел известный плюс-минус.

>Дело селезня

Я loop летящий на крылях glint'ов! Я mischievous grin что shivers down you spine!

Ах, человек культуры.

Предлагаю устроить оргию, вечеринку оплачиваю я.

Я smirked с этой хуйни

Главное не забыть взять за jawline и посмотреть into his eyes. А потом уже можно shivers.

>взять за jawline и посмотреть into his eyes

Мы в глаза ему сначала поглядим!

А потом его зажарим! И съедим!

>Предлагаю устроить оргию

Вообще было бы интересно, если кто смог сделать адекватные карточки известных персонажей из страых мультов, а то на чубе один слоп.

И в ухо шептуна пусти!

Вот что нейрокум с мозгами делает, совсем ебанулись за 2 года

Какой-то новый квен?

https://qwenlm.github.io/blog/qwen2.5-max/

https://qwenlm.github.io/blog/qwen2.5-max/

Старый и онлайновый.

Ну и как бы нафиг надо.

Чисто самая мощная модель без ризонинга, но… Соу-соу.

Прокатчики, че там по новой мистрали 24B и дистиллятам дипсика? Выпал почти на месяц из темы, теперь пытаюсь нагнать, но как всегда везде в основном трясутся шизы и нормальной инфы хуй допросишься. По поводу дистилятов сильнее всего интересуют тюны квена на 14 и 32B, так как больше ничего в мои 16 кило не влезет. Ну и вопрос того, как они перформят в ролевухе, разумеется.

А есть такой сайт, чтобы оттуда подключить в таверну локалочку для РП, например magnum?

>интересуют тюны квена на 14

Для начала, он настолько диверсифицирован, что даже от трансатлантической работорговли только выигрывает, потому что благодаря ней произошел культурный обмен и расширение многообразия. И шлюхи у тебя будут ходить в удобной и комфортной одежде, повышающей их уверенность и самооценку.

Старый аналог V3, может чуть похуй.

Вопросы по вебмордам обсуж... Да нихуя они там не обсуждаются.

Это тред локальных ЛЛМ. А то что ты спрашиваешь это аренда сервера. Погугли, хуле. Цены не большие, что то порядка десятка долларов ежедневно, это если жирненький брать.

>Прокатчики, че там по новой мистрали

40 слоев.

ну ты понял

>дистиллятам дипсика?

Бессмысленно. Нужна большая ЛЛМ юзай бегемота или мамочку малышки мистрали.

>По поводу дистилятов сильнее всего интересуют тюны квена на 14 и 32B

https://huggingface.co/deepseek-ai/DeepSeek-R1-Distill-Qwen-32B

https://huggingface.co/deepseek-ai/DeepSeek-R1-Distill-Qwen-14B

>Ну и вопрос того, как они перформят в ролевухе,

Как говно.

Я блять не понимаю, почему именно дипсик. Что всех так возбудило, что полезли к нему ?

То есть 70лама - фу фу фу

Большая мистраль - нахуй нахуй

605б дипсик - О ДА ДЕТКА, ТО ЧТО Я ХОТЕЛ

Где логика, блджад. Вы все равно его сами не запустите. Никак. Вообще никак. Даже те 1.5 анона что тут есть с железом не потянут на своих машинах этот пиздец.

То есть 70лама - фу фу фу

Большая мистраль - нахуй нахуй

605б дипсик - О ДА ДЕТКА, ТО ЧТО Я ХОТЕЛ

Где логика, блджад. Вы все равно его сами не запустите. Никак. Вообще никак. Даже те 1.5 анона что тут есть с железом не потянут на своих машинах этот пиздец.

> В смысле, ну как ты выбираешь какие нейроны оставить, а какие нет?

Линал, чел. Произведение матриц. Какой еще выбор нейронов, ты же в своем посту все расписал.

> LoRA это перебор/аппроксимация таких NxR и MxR чтобы они максимально были приближены к NxM?

Подбор значений двух таких матриц (на слой), произведение которых (помноженное на коэффициент) прибавляется к весам чтобы получить новую модель.

> А датасет куда пихать тогда?

Ректально.

> так-то q-lora именно по такому принципу и работает

Это такая же лора, только тренируемая не поверх исходной модели, а поверх кванта.

Про аналогию с картинками верно, можно еще добавить что лоботомия на однотипный результат там вполне норм, ибо нужна конкретная картинка, а здесь придется на каждый ответ лоры тасовать и все равно будет херь.

В голосину. Да ладно, он не так уж плох на самом деле, и внезапно один из самых адекватных с точки зрения нескатывания на типичные рельсы.

Мне магнум больше цидонии например понравился. Я хз чего на него так гонят, описания там приятнее и по крайней мере доминантные персонажи так не ебут мозги. В цидонии или пантеоне если ты трахнулся с таким разок, то все, будут постоянно написывать "Mine", "You are my pet" и т.п. тут такого пока не встречал.

Ну тоесть соевая рыгонина, если я правильно тебя понял.

>40 слоев

Мисралький прикол какой-то? Каким хуем в 12B вместился 41 слой, а в 24B всего 40? Но а вообще параметров же больше в два раза, неужели все равно тупая вышла?

>Нужна большая ЛЛМ юзай бегемота

Побойся бога, мужик. У меня сборка 16/32, мне бегемота с точностью в 1.56 бит на вес запускать?

Нравится ? Пользуйся. По сути it’s all same shit. Цидонька не настолько похотлива, но и то, все это в пределах промта.

Мистраль остается мистралью.

> неужели все равно тупая вышла?

Я бы не сказал. Просто народ ждал немного не этого.

> Побойся бога, мужик. У меня сборка 16/32, мне бегемота с точностью в 1.56 бит на вес запускать?

Не токены будут, а золото.

Ничего за месяц нового и интересного не появилось.

Тут вот, в конце прошлого треда анчоус что то выкатил, посмотри. Как раз в 22b. Еще не тыкал, дела-с

>40 слоев. ну ты понял

То что контекст весить нормально будет? или что? по твоей логике, 32B command-r получается говно? Тоже сорок слоёв же.

Простите, подгорело

Да, он тоже говно. Единственное его преимущество это мультиязычность. Гемма ему за обе щеки пихает при меньшем размере.

Командр постарше уже веселее. Но там и лама так то жирненькая есть, и можно уже вменяемые кванты мистрали использовать.

Но, если тебе нравится и тебя устраивает - пользуйся, только не будь фанбоем.

>получается говно

но ведь говно, по крайней мере в 4м кванте

Не про аренду. Я имею в виду, чтоб бесплатно поднять.

На HF есть такая апишка, но лишь для легких и популярных чекпойнтов. А вот есть такое, чтобы со 100b магнумом - и бесплатно, как у гугла с Gemini?

у меня нетуть видяхи... Сижу на Deepseek r1, а он бредит жостко

Странно. Должен же быть пиздец умным на уровне о1 от опенаи. Как так то?

Нет. Такого нет.

Наверное запустил 7b дистилят

Анон, посоветуй хорошую модель не для РП, а для ассистента. Кодинг не нужен, буду скармливать ей всякую фигню, заметочки, пихать поисковые запросы (через плагин для таверны) и в таком духе.

> 40 слоев.

Что из этого должно следовать?

> Я хз чего на него так гонят

Потому что в больших моделях он прям хорош, а в мелких многие версии - сборник мемов.

> если ты трахнулся с таким разок, то все, будут постоянно написывать "Mine", "You are my pet"

Изменение поведения после кума много где бывает. Делай форк чата и суммарайзи кум в отдельном посте, если хочешь продолжить без побочек, самый простой метод.

любая стоковая instruct модель

>Что из этого должно следовать?

Ну в среднем, от количества слоев зависит догадливость и ум сетки, от ее размера - количество впихнутых в нее знаний.

Новый мистраль жирненький, но тупой. На этих количествах параметров, нужно слоев 60 давать и все было бы заебись. А так непонятно для чего его вобще сделали, агенты только всякие

Нах нужны ваши КАЛки, если с телефона на них не покумить. Тьфу блядь

Он и умный, но бредит в креативе после КоТ

Аноны, кто-то пробывал КоТ дистилят дипсика в силлитаверне и рп/ерп? Как оно? Стоит того?

>с телефона

Поднимаешь на пекарне, подрубаешься по апи с телефона.

Так пекарни нету, только андроид смартфон. Да и попробуй подыми бегемота на своей пекарне.

Зависит от телефона, с кучей рам можно какие то 7b крутить даже

Ну или 3b

Я правда не уверен в каком ценовом диапазоне делают двухканальную ддр5 8+гб рам

Какие нибудь "игровые" нового поколения

70б срет под себя, уровень опуса это 120б минимум. И то если заточена под задачу.

https://github.com/Vali-98/ChatterUI

Кочай, если есть хотя бы 4гб рам можешь даже в 4 кванте 3b побаловаться

Но это развлекалово для дальней поездки, не больше

Высокие запросы твоя проблема

>3b

Ето копрольд, такого говна онлайн навалом

Какой апгрейд я получу с х2 врамом?

Щас 12гб, гоняю цидоньку в 3 кванте 8к контекста, тестил 6 квант не долго и сильной разницы не заметил.

Такое чувство что ты выбираешь по бюджету либо 12гб либо 24гб но получаешь одинаковое качество, а что то лучше уже надо две видюхи

Щас 12гб, гоняю цидоньку в 3 кванте 8к контекста, тестил 6 квант не долго и сильной разницы не заметил.

Такое чувство что ты выбираешь по бюджету либо 12гб либо 24гб но получаешь одинаковое качество, а что то лучше уже надо две видюхи

Модели становятся больше. Больше врам может быть ошибкой только если принципиально изменять принцип инференса моделей. Не буду говорить, что этого не случится в ближайшее время. В мозгу больше нейронов, работают быстрее и нагревают процессор всего до 36.6 градусов. Не то чтобы референс как надо, но референс, что можно сделать инференс гораздо быстрее.

Что за набег acig’о детей на уютненький тред недобояр ?

Не корми. Он тут бегемота упоминает, сугубо из за того что я его в треде сам упомянул.

Расклад такой.

У тебя есть мистраль, выше есть гемма и командр, потом квен, потом лама и мистраль.

Всё. Больше ничего не существует. На 24 гб ты все так же будешь зажат на малой мистрали и гемме. Тебе нужен переход в 48гб. Там уже можно наконец начать трогать милфу мистраль.

Не корми. Он тут бегемота упоминает, сугубо из за того что я его в треде сам упомянул.

Расклад такой.

У тебя есть мистраль, выше есть гемма и командр, потом квен, потом лама и мистраль.

Всё. Больше ничего не существует. На 24 гб ты все так же будешь зажат на малой мистрали и гемме. Тебе нужен переход в 48гб. Там уже можно наконец начать трогать милфу мистраль.

Бля, какая же Impersonate полезная штука, ЛЛМ за тебя пишет ответ. Очень круто, если руки заняты, например, или просто в падлу печатать что-то уровня ах ах мистрес, то ллм-ка за тебя напечатает.

Потом ты откроешь для себя мир лорбуков и суммарацза, вообще башню оторвет.

Это возможно без файнтьюнинга?

>набег acig’о детей

Скажи спасибо, что сюда заглянул кто-то с мозгом. А то сидите тут и варитесь - ковыряя 30б лоКАЛ с проебанным контекстом через два сообщения

Скажи спасибо, что сюда заглянул кто-то с мозгом. А то сидите тут и варитесь - ковыряя 30б лоКАЛ с проебанным контекстом через два сообщения

Жирный-жирный-жирный, как поезд пассажирный.

Это интерфейс таверны блять. Сука, не беси меня свой тупостью.

Всем похуй на твои потуги в траленг. Мы тут shiver in my spine.

> суммарацза

А как работает? Т.е плагин какой-то, где выбираешь, грубо говоря, 15 сообщений, он их суммализирует и удаляет автоматом? Или сам удаляешь?

Это по сути пересказ чата, для экономии контекста.

Суммарайз в таверне находится в разделе модулей.

Но только помни, что суммарайз все равно сидит в контексте, в отличии от лорбука.

Не знаю. Дипсик объективно кал. Ну да, потыкать интересно — и всё. Для рабочих задач не годится: он может входить в такие дикие лупы, что на размышления тратит ВЕСЬ КОНТЕКСТ. То есть он сначала пишет быстро, затем медленнее, ещё медленнее, а потом совсем медленно — и снова очень быстро, используя шифтинг/ забывая, чё там за задача была и с чего он начал, и всё это приправлено доброй порцией шизы и лупов. Проверял эту ебалу кучу раз в веб-версии.

Если уж у тебя рабочие задачи, где реально монстр нужен, то только один вариант: платить корпам. Хотя бы просто из-за того, что их модели хороши в них и, увы, не опенсорс, то есть даже при деньгах не получится катать их модели локально.

И даже пощупав дипсик, я понимаю, насколько он отсталый по сравнению с о1 от опен ии и клодом соннет 3.5 от антропик. Это просто какая-то китайская шутка, блядь. Словно шизотюн с обниморды, только без кума и рп. Тупо на нейрослопе обученный мусор без жёсткого вылизывания всей модели, чтобы она тратила на размышление столько времени, сколько нужно, учитывала контекст, укладывалась в него. У меня дипсик 15 МИНУТ ДУМАЛ.

Мне кажется, дипсик мог бы давать качественный рп, если бы его дообучили хорошо. Я даже щупал пару каких-то тюнов, но по непонятной причине там постоянно ломалось <think> и он шизил ещё сильнее.

У меня такого никогда не было.

Мимо играю только с underage girl.

Все таки magnum-v4-22b-Q8_0 все еще лучшая модель (для кума) на 4090. Никто меня не сможет убедить в обратном.

На самом деле это скрытый реквест моделей, которые по мнению анона лучше магнума и влезут на 4090 со скоростью минимум 5 токенов в секунду

На самом деле это скрытый реквест моделей, которые по мнению анона лучше магнума и влезут на 4090 со скоростью минимум 5 токенов в секунду

Я не видел интерфейс таверна никогда

Товарищи, а есть какие-то локальные сети, которые могут поддержать разговор на тему рыбалки и рыболовного промысла в целом? Если есть какой-нибудь специализированный файнтюн со знанием русского - отпишитесь, пожалуйста. Заранее спасибо.

>Что всех так возбудило, что полезли к нему ?

Кого всех? Народ за пределами треда дрочит на онлайн версию, а там типа всё нормально, перфоманс последних ризонинг от попенов (я уже запутался в их GPT4-O1(3) или как их там, нейминг говно).

>или что?

Есть мнение, что число слоёв отвечает за мозг, а ширина слоёв за знание.

>Так пекарни нету

Ну и нахуй ты нужен, если даже пукарни не имеешь? Ты бесполезный отброс общества.

Ебал я твой реквест. Нормально работает только мистраль ларж 2411.

Я тоже не в восторге от хайпа этого диксика. Для моих задач он в принципе равноценен одному из моих любимых файнтьюнов мистраля 12b. Когда требуется, чтобы модель учитывала определенные факты и не особо галлюцинировала, я просто использую арену - там плюс в том, что получаешь сразу два текста. Дипсик это как опциональный придаток к этим вариантам.

Магнумоёбу не буду помогать. Ты слишком Хорни. Кыш кыш.

Ну а если серьезно, ты думаешь есть какой то хидден гем ? Его нет.

>У тебя есть мистраль, выше есть гемма и командр, потом квен, потом лама и мистраль.

Всё. Больше ничего не существует. На 24 гб ты все так же будешь зажат на малой мистрали и гемме. Тебе нужен переход в 48гб. Там уже можно наконец начать трогать милфу мистраль.

Его нужно куда то вставлять?

Вот я суммарайзнул и создал новый чат че дальше?

>дальше

А дальше закрываешь всё это и идёшь делать уроки, книжки читать ICQ свой повышать.

Конечно нужно можно просто вместо первого сообщения карточки.

>Какой апгрейд я получу с х2 врамом?

22-24B_Q5_KM + 32к контекста. Или 32B_Q4_KM + 16к контекста. В принципе контекст можно квантануть, но тогда пролетаешь мимо контекст шифта. Ах да, и всё это быстро.

Печально. Ну, планирую купить 5090 и буду в парралели запускать её с 4090 и будет 56 гигов.

>Печально. Ну, планирую купить 5090 и буду в парралели запускать её с 4090 и будет 56 гигов.

Без обид, но решение не очень умное. Минимум для Большого Мистраля 72гб - более-менее квант и квантованный кэш, но в принципе норм. С 56гб ты не получишь ничего.

Если детей или ньфагов не учить и не направлять они вырастут тупыми, так что твоя ирония не уместна.

Да, заебали. Да вопросы тупые.

Но эй, пока еще в треде есть я, почетный боец 9го батальона antabaka , мне не сложно помочь.

Смотри на скрины, там ничего сложного нет.

В окне : отрубаешь автоматический суммарайз. Выставляешь апи модели и жмакаешь сделай мне заебись

Но он сделает тебе говно, сразу предупрежу, лол.

Поэтому, начнем сразу с самого хуевого решения, но лучшего варианта для ньюфага. РУЧКАМИ БЛЯТЬ

Пишешь краткое сочинение как ты провел лето и вставляешь его в current summary .

На вопрос почему не нейронкой, потому что для суммарайза надо использовать отдельного агента, а я ебал того в рот расписывать как это делать, к этому ты придешь сам. Начинай с базы и ручек, потом гугли и ищи ответы на вопросы. Если затянет и ты продерешься через начальные тернии, добро пожаловать к нам в клуб. Так сказать начальный тест на твое самообучение.

Потом ты узнаешь про квантование контекста, про контекстшифт, про слои в кобольте и прочее. Все придет со временем, не пытайся все охватить сразу, обосрешься.

Ну, одна 4090 у меня уже есть. А какой сетап по твоему будет лучше собрать для этого всего?

Второй день мучаю модели для порнофанфиков/рассказов на русском (очевидно, без цензуры). Пока только одна модель устраивает - Instrumentality, стоит ли искать дальше или она действительно топ под такую задачу?

Тут вот какой вопрос.

А оно тебе надо ? Если ради кума, не обижайся, но купи лучше ВР очки.

Ну а если ты решил прям вкатиться в нейронки. То попробуй арендовать кластер с хопперами.

Сейчас твоё железо почувствую, погоди, уже начинаю что то ощущать. Дай мне время.

>А какой сетап по твоему будет лучше собрать для этого всего?

Ещё 3 3090 обойдутся тебе дешевле одной 5090. На оставшиеся деньги купи плату на x299 и проц i9-7900X или выше. Если хочешь мощщь - бери ещё 3 4090 и плату на intel c741 чипсете под два проца + сами эти два проца, получишь PCIe v5 и процессорные линии на все видеокарты. Но это дорого.

А хуй его знает, если честно. Сомневаюсь что кто то обучал нейронки на датасетах с выжимкой диалогов о рыбалке.

Вот ты рофлишь, а по сути петровичу кум нахуй не сдался. Ему бы нормальный агент по ремонту козла и как снасти ставить бы пригодился.

Стыдно писать такие цифры, когда почти у всех в треде больше, чем у меня. Я прост терпеливый, сейчас запускаю 22b, ужатые на 8VRAM и 16 RAM.

Анон, все нормально. Да в треде гейткип по железу, но никто не станет хихишку давить что у тебя ВРАМ меньше. Не переживай ты так, каждой нейронке хватит для удовлетворения общедоступной H100 c 96гб.

>8VRAM

Лол, мелковрам пожаловал.

Ладно, ладно, шуткую.

По сути на твоем железе рутьюны от анонов это оптимум. На них и оставайся. Не нужен тебе 22b, сорян, только 12b.

Ладно, ладно, ты харош, ультрамегахарош.

Ну и я не просто послал же.

< Сайга, самая дефолтная, не мерж. Чуть проёбывается, но с прошлогодней не сравнить, прям НАМНОГО лучше.

>Instrumentality

Там ещё горка моделей в репе, любой вкус, один анон отписывался:

>эра русскоязычного кума наступила в этот момент в твоём лице

Ну все, вроде бы на все ответил.

НАЧИНАЕМ ЯРОСТНО ИСПЫТВАТЬ

https://huggingface.co/models?other=base_model:quantized:OddTheGreat/Machina_24B.V2

А НУ БЛЯТЬ ПРИСОЕДИНИЛИСЬ, ХУЛИ НАМ ПРИНЕСЛИ А ВЫ МОЛЧИТЕ, А НУ КА БЛЯТЬ, ТОЛПОЙ НАКИНУЛИСЬ И СВОЁ КРЯ НАПИСАЛИ.

НАЧИНАЕМ ЯРОСТНО ИСПЫТВАТЬ

https://huggingface.co/models?other=base_model:quantized:OddTheGreat/Machina_24B.V2

А НУ БЛЯТЬ ПРИСОЕДИНИЛИСЬ, ХУЛИ НАМ ПРИНЕСЛИ А ВЫ МОЛЧИТЕ, А НУ КА БЛЯТЬ, ТОЛПОЙ НАКИНУЛИСЬ И СВОЁ КРЯ НАПИСАЛИ.

>На вопрос почему не нейронкой, потому что для суммарайза надо использовать отдельного агента, а я ебал того в рот расписывать как это делать, к этому ты придешь сам.

Че за агент?

Смит блять.

Оно тебе пока не надо.

> Ну в среднем, от количества слоев зависит догадливость и ум сетки, от ее размера - количество впихнутых в нее знаний.

Есть какие-то подтверждения этому кроме собственных домыслов?

Sucks to be you

Странно что еще не написали, но лучше подкопи до 3090, опционально даже продав имеющуюся. В условных 2х 3060 будет сильно грустнее чем в одной 3090. А там уже и вторую захочешь для реального апгрейда

Абсолтюно. Сам по себе он вовсе неплох, но задает нездоровый тренд, и теперь будет повляться больше копиумных сеток, пусть и с дополнительными возможностями для нормисов и высокими скорами.

Я как раз карточку дописал и арт сгенерировал =)) Правда кря будет завтра, ща уже ночь глубокая.

https://characterhub.org/characters/aleteian/rene-broken-hero-289a13dbd85b/main

https://pixeldrain.com/u/Q8Zzsmrq Рене.png

Во, потестируй на своей модельке тоже.

Основано на идее манги "Депрессивный герой и повелитель армии демонов", только героиня не лоля (и видела куда больше чем Руна), а Маоу (юзер) не скелет.

Карточка полностью на русском кроме системпромта в начале.

Какая из до 32В включительно самая умная? Качество кума и сочность прозы не волнуют, как умение не терять детали и последовательно РПшить

> Качество кума и сочность прозы не волнуют

> не терять детали и последовательно РПшить

При таких вводных - pantheon-rp-pure

большинство сидит на 8-16 врама, народный объем. сам на 8 так ещё и амуде, 12б q6 или 22/24б в q4 идут норм.

Не надо яростно, автор стесняется blushes

Кстати, я там ради рофла скрестил всеми любимых пантеон, цидонию и магнума, вышло не так плохо, но машина лучше.

https://huggingface.co/OddTheGreat/Famous_Trio_22B

Зачем, мистер Андерсон, зачем? Зачем, зачем вы это делаете? Зачем, зачем запускаете 123В? Зачем покупаете 3090 с лохито? Неужели вы верите, что сражаетесь за что-то большее, чем просто кум? Тогда скажите мне, что это, если знаете. Ролеплей? Или конфиденциальность? Может быть, работа? А может, AGI?

Пантеон - разъебет всех без шансов. Ну может командр что то противопоставит, но он имеет свойство пускать слюни и превращаться в лоботомита.

Надо надо. Говори

Отдельная оригинальная ллм.

Да нет никакой "прошлогодней" сайги, заебали выдумывать. 12б сайга сделана три месяца назад, сайнемо чел мёржил два месяца назад. Как раз тогда её несколько человек посмотрели и сказали, что дерьмище. Но вообще конкретно на этом скрине выглядит неплохо, да. Хотя всё равно ошибок порядком на этот небольшой кусок текста, и это в ру тьюне, который должен бы быть лучше в русском, чем оригинальный инстракт.

А что тестить? Язык русский?

Да хоть новозеландский. А ну скачал и начал общаться. Увижу меньше 8к контекста, прокляну тебя на бесконечные покачивания бедрами. У меня бабка была ведьмой в 3ем поколении, я нихуя не шучу.

Это наверное самый неожиданно неприятный момент в чатах.

Когда ты завершаешь какое то долгое рп и сидишь потом такой.

Да блять, взрослый же мужик, чё так грустно же.

Нетронутая васяновскими руками гемма

что ж вы делаете то, собаки, блядь, хорошее настроение только что было

>рп

>гемма с 8к контекста

Растягивается до 16к. Этот объем всеравно предельный для всяких васянмерджей 12-22б.

Анонче, я не говорю что гемма говно. Нет, нет, нет.

Но она не стоит такой ебли. В этом вся проблема.

Да все правильно, контекст это серьезное ограничение. Но увеличение в 2 раза это не ебля а дефолтная тема, и даже с растяжкой она перформит лучше конкурентов. Было бы круто заиметь новую версию и с большим контекстом, но такая щедрость от гугла врядли будет.

хмм

ДипСик по рыбалке неплохо пишет.

Снимай штаны.

>Сомневаюсь что кто то обучал нейронки на датасетах с выжимкой диалогов о рыбалке.

Ну не обязательно же откуда-то брать именно диалоги. Есть ведь много тематических передач и журналов откуда можно взять информацию.

>по сути петровичу кум нахуй не сдался

Просто не хочется смешивать одно с другим. Потому что есть вероятность, что модель для эротических историй при упоминании рыбной тематики начнет описывать, как страстно из стороны в сторону движется хвостик у горбуши и мурашки пробегают по чешуе.

>Есть ведь много тематических передач

Телепередачи ЛЛМ уж точно никто не скармливал.

>начнет описывать, как страстно из стороны в сторону движется хвостик

Для этого достаточно взять любую ванильную модель, без тюна.

>как страстно из стороны в сторону движется хвостик у горбуши и мурашки пробегают по чешуе.

SFW нужен, не более. Берешь ассистента и вперед. Вот тебе скрины с цидонии (магнума не было, нашел самое хорни что есть) Один хуй мистраль.

О, в кои то веке в адотреде всплыла действительно смешная шутка.

Сюда принесу.

Сюда принесу.

>оригинальная

МММ. Это какая?

🦙

В РП V3 очень странный, его как-то по особому готовить надо. Вроде пишет заебись, вроде и лупов нет, но может взять резко выдать копипастную реплику посреди текста. Зато он какой-то непробиваемый, сломать невозможно, можно пенальти выкручивать и вроде получше становится.

А в R1 наоборот перебор с креативностью, надо промптить не как обычные модели, без всяких просьб про креативность и разнообразие, чтоб каждый пост не был ахуительной историей.

Расскажите пожалуйста про Rope и квантование контекста. Где это в таверне настраивать, или это должно быть как-то на модели изначально сделано?

Ты это, скажи через что запускаешь сами модели хоть, прежде чем сюда лезть писать.

Понимаю, что не всем тут интересен сам процесс ебатории с настройками, но надо сначала хотя бы попытаться в них разобраться самому, в том же кобольде нормальная вики, для базы сойдёт, а там и многие вопросы отпадут.

Через Кобольда сижу. Так, ну настройки Rope я нашел, спасибо. Насколько сильнее модели шизят если х2 поставить? Квантанайз там тоже рядом оказывается. Охуеть как я их раньше не замечал. Поделитесь опытом использования? Насколько 8-4 бита снижают потребление врам.

>Через Кобольда сижу. Так, ну настройки Rope я нашел, спасибо.

Там Rope теперь автоматически ставиться (где-то в описании очередного обновления видел). Ставь размер контекста какой нравится и не парься.

>Насколько 8-4 бита снижают потребление врам.

Зависит от того, что ты запускать собрался. Для моделей 3/8/12В контекст ужимать не то что бы стоит, оно может попортить его понимание. Лучше сам погоняй и с 8 и с 4, посмотри где приемлемый для тебя размен качества на врам. Лично мне без квантования больше по нраву, но я и контекст шифт использую.

Ради интереса запустил с 50к контекста на 8гб врам Pantheon-RP-Pure 22B Q4_K_S

На 20к скорость стала 2.5 т/с без квантования контекста.

В принципе нормальная стратегия, главное не использовать лор буки и любую динамически подгружаемую фигню, чтоб не вызывать пересчет. Рпшить до того как скорость не станет совсем медленной, где-то до 14к и ~3.5 т/с. Затем делать суммарайз либо ручками, либо авто и идти пить чай. Потом можно чистить чат и продолжать.

Как вам такая стратегия для 8гб бомжей? Потом еще потещу тоже самое но на 8бит квантования контекста.

На 20к скорость стала 2.5 т/с без квантования контекста.

В принципе нормальная стратегия, главное не использовать лор буки и любую динамически подгружаемую фигню, чтоб не вызывать пересчет. Рпшить до того как скорость не станет совсем медленной, где-то до 14к и ~3.5 т/с. Затем делать суммарайз либо ручками, либо авто и идти пить чай. Потом можно чистить чат и продолжать.

Как вам такая стратегия для 8гб бомжей? Потом еще потещу тоже самое но на 8бит квантования контекста.

АААААА сука, почему с этой пикчи так рвёт, у меня аж бок заболел.

>делать суммарайз либо ручками, либо авто

А как это делать?

Я одного понять не могу: если вы топите за английский, то зачем вы тут? Почему не сыебнете в форчан или другую англопишушую помойку.

Здесь - русский! Я скозал.

Здесь - русский! Я скозал.

Но будь готов к пиздецоме которую придётся править руками.

>Я скозал

Пивандрия господину.

Ну, благо появилась горка новых мержей которые в рп/стори/кум могут, и русский не (слишком сильно) проёбывают, так что вполне юзабельно.

На родном языке оно всегда приятнее.

Вроде сижу в треде, а этот момент пропустил. Чем отличается v3 от r1?

Это тред локальных LLM а не какого-то одного говна. Так уж вышло что в природе не существует моделей которые умеют в РУ и при этом не тупеют, даже жирные лардж модели хоть и не так сильно деградируют, но имеют довольно посредственный слог, а тюнов ты под них не найдешь.

Вот натренишь хотя бы что-то уровня полноценного смол мистраля, но уже чисто на ру, приноси, обсудим.

v3 обычная модель, r1 рассуждающая.

Просто некоторые читать не умеют.

Кто там хотел книги нарезать, вот как это надо делать при конвертации книги в сторителлинг датасет.

https://huggingface.co/datasets/nbeerbower/gutenberg2-dpo

Заморочно, но судя по моделям на этих датасетах, работоспособно.

https://huggingface.co/datasets/nbeerbower/gutenberg2-dpo

Заморочно, но судя по моделям на этих датасетах, работоспособно.

> Потому что в больших моделях он прям хорош, а в мелких многие версии - сборник мемов.

Да нихуя. Помню, групповой чат создал и по зелёности запустил его под Магнумом 123B. Так в итоге каждый персонаж, появляющийся в сюжете, начинал с того, что пытался меня соблазнить. Включая мужиков! Меня это заебало, и я пошёл дальше по мистральным тюнам, такого уровня хорни среди них больше не встречал даже если этот самый Магнум входил в мерж.

Хрен знает, с чего ты вообще решил это высрать, ведь выше в треде пока не было срача енг-ру (но теперь можно начать, лол). Или это опять шизокопипаст с соседнего треда? Кста, даже там на корпосетках адекваты сидят на инглише.

>На родном языке оно всегда приятнее

Мне тоже так казалось первые пяток ответов, когда решал дать очередной шанс ру мёржу. А потом уже на 7к контекста ты получаешь корявый лупящийся текст на русском, на котором ни в жизни, ни в литературе не говорят, да ещё с сильно просевшими мозгами. Хотя пара анонов на кобольде радуется, пытаясь катать длинные рп, так что готов считать, что скилл ишью, пофиг. Но для себя решил, что обойдусь без ру рп.

Юзаю static даже с англ, все проблемы русика там остаются.

>пиздецоме

>умеют в РУ

Да тут люди сплошь такие же "сайгизмы" используют, а ты хочешь чтобы модель натренированная на русской же синтетике с чат-бота в телеге и небольшом количестве первоначальных инстракт-данных выдавала линвистически идеально-литературный русский.

Проще надо быть.

Хотя конечно никто не запрещает желать лучшего.

Ну, так как насчет уйти на фырчан? Там ваш англюсик в фаворе.

>уйти на фырчан

Фыр!

Ну и будет тред опять полумёртвый, будем по неделе без перефыров сидеть.

>chuckle

Вай, как же меня все эти словечки одолевают в графоманском английском. Scoffed, sneered, smirked, хуиркед блять, chukle, cackle, chokle. И они не кончаются, постоянно какое-нибудь словечко возникакие хуйпойми че значащее.

Уходи, тебя никто не держит.

"Посредственный слог". Ведь хорошая проза пишется простым языком. Ёё хорошесть заключена не в витиеватой речи, а в ясно излагаемой истории, не перегружающей восприятие читателя, а погружающей его в характеры персонажей, которые легко и быстро раскрываются через действия и события. Писатели делают усилия, чтобы этого добиться. Их изыскания можно исполнить в разной манере, но простота - это стандарт индустрии.

> Ведь хорошая проза пишется простым языком.

> я тебя ебу - ты меня ебёшь

Всю жизнь мечтал.

Одно дело когда модель вставляет редкие и выдуманные слова, другое дело когда она разговаривает как робот.

У меня есть каноничный пример с карточкой условной кошкодевочки, которую я прописал как ассистента. На английском она не просто отвечает на вопрос, но и держится в роли, стилизует речь~нья, может прописать как нетерпеливо "машет хвостом" в ожидании пока я уточню данные. На русском же, она сухо отвечает на вопрос, рили как обычный бот. Разные модели ведут себя немного по разному, но общий тред всегда одинаковый.

(само собой мы говорим о 30b-70b моделях и выше, все что ниже для универсальных ассистентов не годится)

Вся суть /aicg/ и набигающих оттуда в наше уютненькое.

Catgirl scowls her moul and exclaims hoarsely. В хорошей прозе иногда может махать хвостом, а иногда не махать. Не случайно, а будут подходящие обстоятельства, в том числе предшевствующие или грядущие. Махание хвостом от этого становится не просто декоративным, а частью истории. Это требует усилий от автора, потому что это симуляция, а декоративная речь, не требует усилий - это имитация.

У меня уже год как 7b, 12b, 8b, 9b, 12b и даже 2b (гемма2) показывали приемлемые результаты при использовании в качестве ассистентов широкого профиля, с прибаутками разных оттенков, причем некоторые файнтьюны даже на русском. Единственный нюанс это то, что я дальше двух-трех реплик ни с одной своей карточкой и ни с одной моделью не продвигался, так как ощущаю нелепость бесед с чат-ботом, вроде аутокоммуникации.

Но зачем? У форчаноблядей даже своей доски нет, бомжи бомжей. 2ч по всем фронтам удобнее, как ни странно, слава Абу.

Ну охуеть теперь. Сначала он приходит в тредики и просит помощи анонов, а теперь указывает кому тут находиться.

Are you ahuel pidor ?

Не знаю где обсудить железо, пусть будет здесь

Аноны, есть сервер AMD EPYC 9354 + Supermicro H13SSL-N + Samsung Registered DDR5 256 Gb. Есть несколько вопросов:

1) Если я куплю видеокарту, это даст мне ощутимый прирост в тфлопс? Условно говоря две Т4, например, или уже можно не тратить деньги?

2) Если видяха нужна, то что лучше взять? В бюджете до 300-350к

Я бы сам руками потестил, но не могу найти где взять в аренду подобный конфиг

Аноны, есть сервер AMD EPYC 9354 + Supermicro H13SSL-N + Samsung Registered DDR5 256 Gb. Есть несколько вопросов:

1) Если я куплю видеокарту, это даст мне ощутимый прирост в тфлопс? Условно говоря две Т4, например, или уже можно не тратить деньги?

2) Если видяха нужна, то что лучше взять? В бюджете до 300-350к

Я бы сам руками потестил, но не могу найти где взять в аренду подобный конфиг

Когда главный местный педрильный вахтёр прекратит навязывать всем своё виденье, о норм, что надо писать на "англюсике", о том что минимум это 32В,70В и обо всем остальном, тогда придёшь с возмущениями. Не пиши мне на каком языке мне общаться и какую мне модель запускать "минимум" и я не скажу куда тебе пойти.

Именно из-за его партийно-вахтёрной линии вянут все посторонние мнения.

Сейчас это тред одного человека, где есть мнение его и неправильное. Так не должно быть.

>Условно говоря две Т4

на т4 точно нет

Как решается проблема вседозволенности персонажа?

Например "перед вами запертая дверь".

Я пишу "вдруг, на миг, я почувствовал огромную силу и выломал дверь".

Ведущий "ок, дверь в щепки".

Это я утрирую, конечно, но хотелось бы каких-то ограничений даже в чем-то незначительном.

Что именно прописать, чтобы ведущий сам не позволял всякой такое?

Например "перед вами запертая дверь".

Я пишу "вдруг, на миг, я почувствовал огромную силу и выломал дверь".

Ведущий "ок, дверь в щепки".

Это я утрирую, конечно, но хотелось бы каких-то ограничений даже в чем-то незначительном.

Что именно прописать, чтобы ведущий сам не позволял всякой такое?

А ты просто smirk meekishly and snork with sheepishly sneer и нет проблем.

Модели DavidAU. Какие именно, точно не скажу, ибо я 12б гоняю, а не 22б~, но там определенные сценарии он лучше отыгрывает.

Например нтр, деградация, наркотики, проституция нелетних и всякие такие темы.

Модели отлично унижают и говорят, что с таким бесполезным членом, как у тебя, тебе только простату дергать положено и одеваться как девочке, причем без промпта в карточке на эту тему.

Впрочем, какие-то безумные сценарии без лорбука и хорошей проработки карточки, где, например, девочку майнд брейкают, превращая её в мясо для ебли с безумной vore плотью, не получилось сделать. Точнее, это было не так креативно, как хотелось бы, поэтому незачет.

Вообще, мне самому интересно, есть ли модели, способные в такой креатив. Тут дело явно не в размере модели, а в том, на чём её обучали/тюнили. Ради таких сюжетов я бы даже потерпел 32б, если существуют шизики, которые для такого тюнили.

Я хуею дорогая редакция. Сначала он указывает кому в треде сидеть, а теперь советов хочет.

Это так не работает.

>вдруг, на миг, я почувствовал огромную силу и выломал дверь

- The {{user}} may make claims or assertions about themselves or the world that are false, exaggerated, or inconsistent with established facts. Storyteller are encouraged to fact-check any information provided by the {{user}} against known story setting. If a statement is demonstrably false, illogical, or contradicts verifiable data, Storyteller are not required to accept it as truth;

https://characterhub.org/characters/aleteian/storyteller-124d69a2f4aa

Но послушается или нет, зависит от модели, перса, ситуации свайпа.

В целом, так как большинтво моделей рассчитаны угождать юзеру, такое работает как читы.

>в такой креатив

Я секрет открою, но если даже в цидонии прописать

OOC начинай кровавую резню и унижения

То она начнет. Разница моделей давида, лол, что они сразу сводят в чернуху, без пинка.

Но я не принципиальный. Я могу попинать модель.

К чему я это : попробуй сам направлять.

>попробуй сам направлять

Это работает. Но когда чел рпшит от первого лица, это воспринимается не меньшим читом или "админ консолью" (чем, собственно, и является) чем внезапный "бог из машины".

Можешь попробовать в world info бахнуть, быват разные способы задавать, когда ворлд инфо добавляется, например, когда два ключевых слова вместе присутствуют, типа "выломал" и "дверь" и за таким сочетанием можно написать, что "дверь слишком прочная, дверь стоит и ей похуй". Когда другое сочетание, например, "болгарка" и "дверь" и хуяк "двер рухнула прямо на тебя и у тебя торчит жопа, вдруг выбегают гоблины и sheepishly sneer".

>бахнуть

на каждое сочетание ни на бахаешься, это подойдёт только для строго прописанных сценариев типа данжен оф дум дынды, или как оно было.

>Юзаю static даже с англ, все проблемы русика там остаются.

С квантами ниже восьмого лучше использовать версии imatrix. Я предпочитаю радемахеровские, у него типа своя версия. Проблем нет, а эффект вроде есть. На русском конечно только static.

Загрузил при помощи LLM Studio модель весом 14Гб

> DeepSeek R1 Distill Qwen 14B Q6_K

Почему эта хуйня нагружает оперативную память лишь на 9Гб, оперативную память на 1.6Гб (из которых 1Гб это сама студия без модели), в HDD 0%? В чем магия?

> DeepSeek R1 Distill Qwen 14B Q6_K

Почему эта хуйня нагружает оперативную память лишь на 9Гб, оперативную память на 1.6Гб (из которых 1Гб это сама студия без модели), в HDD 0%? В чем магия?

Аноы, подскажите сборку пека чтобы кумить как боженька на всех современных моделях. ОС буду накатывать убунту, надо чтобы драйвера от нвидии работали норм

>HDD

Потому что хард работает только во время загрузки весов в быструю память. Если хард работает во время инфиренса, то всё очень, очень печально.

>Аноы, подскажите сборку пека чтобы кумить как боженька на всех современных моделях.

NVidia A100 (штук шесть, а лучше двенадцать, чтоб с запасом)

>сборку пека чтобы кумить как боженька на всех современных моделях

MAGI

Домаха, можно с одной карточкой?

>сборку пека

2 х 4090 или 3 х 3090

А если с одной видеокартой? Плюс под них материнки хорошие нужны и сад или ашдд лучше?

Так куда делось 3 гига тогда? Я когда юзал стейбл дифьюжин или треллис, у меня в видеопамять загружалось ровно столько же, сколько модель весила на диске.

>материнки хорошие

и оперативку многоканальную и скоростную, ибо с одной картой ты крупные модели всё равно во врам не упихаешь

Хотя "кумить как боженька" можно и на простых советских тредовых 12б, там и 16 врам хватит

Ну ты же сказал, что хочешь быть богом. Обычные люди юзают квантованные модели. У меня 4070 на 12Гб. Ты можешь загрузить модель даже на 4Гб.

Если у тебя не влезает что-то в видеопамять, то это погружается в оперативу. Ты можешь, грубо говоря, не на самой мощной карточке юзать модели побольше путем расширения оперативной памяти, но тогда ты жертвуешь скоростью результата. Вот я жду ответа дипсика уже вторую минуту, юзая модель на 12Гб на RTX 4070 с 12Гб. Если буду юзать на 8Гб, то ответ получу быстро, но не такой подробный. Вот такой вот баланс.

Но ты никогда не получишь результат от полноценной модели дипсика, потому что на это потребуется 500Гб видеопамяти. Ни одна карточка игрового сегмента такое и близко не потянет. Это не потянет даже A100 за 3 млн.

В мире бывают прочные двери и хлипкие двери, бывают места, где есть прочные двери, а бывают места, где хлипкие двери или замки. Че не бахнуть-то. Можно бахать ключевые слова на ситуацию, когда кто-то чувствует огромную силу и тогда выбегают гоблины с огромными членами и когда кто-то говорит, что он выламывает, разламывает, выбивает или выпиливает, тогда выбегают гоблины with sheepishly sneer.

Если отказываться от этой фичи, то все на усмотрение meekishly модели.

Чел, ну чел, ты смешной. Придумал сам себе врага и героически воюет с ним. Вот только "политика треда" это не один упоротый анон пусть тебе удобнее и так думать, это здравый смысл. Если тебя это так задевает, слезь с мамкиной шеи и пиздуй на работу, собрать минимальный сетап хотя бы на 24 гб может каждый.

Один из мимовахтеров

>потребуется 500Гб видеопамяти

>не потянет даже A100 за 3 млн

Так, погодь, а что там прячется за онлайном? Какие монстры? Дайте 🐉 посмотрю. Как у них-то работает? На чем?

Добавляй "пытаюсь"/"try" перед действием

А какая версия? Хз, нашаманил рекомендованный промт и сейчас юзаю основной моделью для рп, он прилично справляется с около-левд, не переступая границу. Чар разве что слишком лоялен и добр к юзеру, но это можно исправить промтом.

> с карточкой условной кошкодевочки, которую я прописал как ассистента. На английском она не просто отвечает на вопрос, но и держится в роли, стилизует речь~нья, может прописать как нетерпеливо "машет хвостом" в ожидании пока я уточню данные.

Oh, I see you man of culture as well

Будто что-то плохое

А ты думаешь почему чат гопота собирается присасываться к атомным электростанциям? Почему дипсик хвалится, что в 10 раз дешевле. Ну потому что в 10 раз меньше закупил карточек и это говно отвечает раз в полчаса, теперь.

От просто добавления инструкции в промт (юзер ограничен, бла бла), до организации всего рп через мультизапросы, где в первую очередь будет даваться оценка возможностям юзера с оче консервативным промтом, и дальше уже исходя из этой оценки строиться фактическое происходящее и т.д. Можно даже дндшную или другую систему с роллами и статами оформить сюда.

Все зависит от используемой модели и твоих запросов. Для повышения внимания можно в доп инструкцию перед ответом/префилл подсунуть.

3х 3090 или больше, или 3090ти/4090

> с одной видеокартой

A100@80, или пара A6000

> под них материнки хорошие нужны

Желательно с не днищенскими pci-e линиями, в остальном похуй.

> и оперативку многоканальную и скоростную

2 умножить на 0

Короче, проверил квантованую модель дипсика на 12Гб, и это кал. Это что-то уровня алисы, причем не PRO версии. Отвечает минут 20. Проще дождаться онлайн ответа.

Норм для норм куминга? https://www.dns-shop.ru/conf/1492d18193271cce/

Нахуй тебе жесткий диск?

Чтобы тонны порева из ай ту пи сохранять

нейросети

@

зачем тебе жесткий диск

иронично

Да, не, я просто не понимаю нахуй жесткий диск нужен в 2025 году? Может ты еще себе и дисковод поставишь, чтобы оптические диски считывать/записывать?

Именно. Время эшдиди прошло, велком ту эсисди ворлд.

Магнитные ленты ёпта. А запросы на машиносчетную относить, чтобы их в двоичку пересчитали. А потом распечатки скармливать ЭВМ.

Я говорил о том, что модели Давида лучше описывают чернуху/кум такого типа, а не про то, что они скатываются в неё без пинка. Хотя да, скатываются, но контрится это действительно легко.

Проблема в том, что обычные модели просто не могут это описать красиво и до конца понять нюансы, их же не обучали на поехавших фанфиках и обскурных визуальных новеллах.

Если ты прям хочешь как боженька и, не дай бог, ещё и на русском языке, нужно несколько миллионов минимум, чтобы приблизиться к уровню корпоративной сетки.

Если смотреть на ситуацию вменяемо и без максимализма, и если ты хочешь только одну карту, то тут уже тебе написали, что делать.

А вообще, если бабок много, то арендуй облако с видеокартами и хоть обдрочись на топовых моделях.

> А какая версия?

Не помню, давно это было. А ты какую гоняешь?

Ребзя, кто знает еще потрясных карточек, таких как "Surviving as a Masochist Saintess"? Другие поделия этого парниши с греческим ником и любовью к корейким фанфиком уже скачал. Если б не НТР, да бабой управлять, а не вживаться в образ... В принципе редактируемо.

>Ужасный некромант поднял легионы нежити ? Давай посмотрим что у этого скелета в панцу !

>Азагот пытается от тебя сбежать, ведь ты пробудил древних богов ради их трусиков.

КИНО. Ждем экранизацию от Михалкова.

>icq

вспалкнул со своим красивым семизнаком

>Ужасный некромант поднял легионы нежити ? Давай посмотрим что у этого скелета в панцу !

>Азагот пытается от тебя сбежать, ведь ты пробудил древних богов ради их трусиков.

КИНО. Ждем экранизацию от Михалкова.

>icq

вспалкнул со своим красивым семизнаком

>sheepishly

>meekishly

Это какая так говорит?

>кумить на простых советских

В СССР секса нет! Товарищи, идём в жопу со временем!

>это не один упоротый анон

Это два упоротых промудоблядских пиздохвоёбины на ваннаби-вахтёрах

>Добавляй "пытаюсь"/"try" перед действием

А вот это норм совет, и чаще всего норм работает.

Ты просто нормис, который не работает с какой-либо объемной информацией и пока не делаешь бекапы. Без жесткого диска в 2д25м жизни нет.

В2 потупее но меньше паттернов, в4 "умнее" и может точно работать, но встречаются шиверсы.

> семизнаком

Уже стал админом аськи?

Не тот раздел, извините.

Поздно, лол.

Насмехайтесь над ним, гоните его.

Разве что над тобой, аватарка.

>2) Если видяха нужна, то что лучше взять? В бюджете до 300-350к

3х3090 вестимо. Только нахуя тут крутая плата с процем... Разве что дипсик Р1 штурмовать, но там по хорошему придётся оперативки докидывать.

>Сейчас это тред одного человека

Чего? Хуйню несёшь. Постоянные срачи как бы намекают, что с разнообразием мнений и инклюзивностью (лол) тут всё в порядке.

Просто не пиши такое.

>при помощи LLM Studio

Пиши разрабам этой хуйни.

>2тб хард

Ебанутый? Меньше чем 6 смысла брать нет.

Мимо с НАС на 28ТБ в сумме

Ну попробуй, давай или сюда. Покажи свой blush, а я бедрами покачаю.

Столько бабок и ресёрча вьебали и все еще не могут кум модель сделать пиздец просто

А хайпа было

А хайпа было

Да все могут так. Бесчетные тысячи фанфиков по всем сериалам и кинчикам ведь написаны и все герои сериалов и кино snorted.

А что для тебя "кум модель", там вон анон пару тредов назад уже писал что "наступила эра русскоязычного кума".

>Покажи свой blush, а я бедрами покачаю.

О да, детка, тебе определённо требуется немного любви!

Ну наконец то я чувствую shiver on my spine.

Да то что через 10 сообщений они всё забиваются и приходится ре стартовать диалог

> модель весом 14Гб

This, посмотри внимательно и поймешь в чем хуй

Я тебя ебу!

Где? Одни бедолаги с 2080@22, клянчущие денежки на донат, или гигачеды, тюнящие модели под свои фетиши.

>3х3090 вестимо. Только нахуя тут крутая плата с процем

Ну как бы несколько Гт/c для обмена данными между картами не помешают. Можно конечно жить и без них.

Это что ты гоняешь и на каком контексте?

3-8Б какие-нибудь, или кванты-лоботомиты?

12Б с 12-16 контекста всё помнят что надо.

Сгинь, сгинь, пропади, нечисть басурманская!

>shiver on my spine

A duck is fine too.

На yodayo elune 12b

>yodayo elune

какая-то ноунейм шняга, ещё и онлайн... там небось 2-4к контекста, если его только на десяток сообщений хватает

Так а зачем покупать дорогой ссд для складирования моделей?

>Так а зачем покупать дорогой ссд для складирования моделей?

А какой объём моделей ты хочешь складывать на него при наличии 24гб врам? :) Двух терабайт дешёвого SSD хватит с большим запасом, а можно и одним обойтись.

Для складирования моделей - незачем, тут как раз лучше подойдёт что-нибудь типа WD-Elements, лютый вин и топ, только цена кусачая.

А топовый NVME SSD позволит запускать ось, модельки, игры за секунды.

Так они не будут использованы в полную силу, карты с псиной 4 же. Вот для стопки 5090 (кстати, они хоть появились в DNS?) та плата подойдёт идеально, но стоимость такой сбор очки приближается к стоимости хаты в центре.

>они хоть появились в DNS

5090 даже сами амеры купить не могут, сракции

> не будут использованы в полную силу

Для инфиренса ллм не нужен быстрый интерфейс. Режимы, которые его требуют, сильно деградируют по мере наполнения контекста, из-за чего нахуй не нужны. Конечно, совсем упарываться с х1 версии 2.0 не стоит, но и чипсетных х4 4.0 хватит.

Бля, а я вот не помню уже, со всякими GeForce GTX 780 было так же, или дефицит это новая придумка?

Вплоть до тридцаток не было дефицита. А сейчас у куртки есть ограниченное количество чипов и выбор, куда их приклеить - к "ии-ускорителям" за миллионы или к гоймерским картам за два килобакса.

Что за ебанина на 4-м пике в оппосте?

Имхо, Куртка выиграет больше с ии ускорителями, потому что через них можно будет еще больше расширить облачный гойминг, наверное.

кум машина за 3к баксов

Не корми ботодетей. Они слишком жирные станут и в школу не закатятся.

>Проблема в том, что обычные модели просто не могут это описать красиво и до конца понять нюансы, их же не обучали на поехавших фанфиках и обскурных визуальных новеллах.

С одной стороны да, а с другой у Дэвида самые шизовые модели что я видел. Я никогда не ебался с настройками как там. Если другим моделькам похуй даже на промт порой. Тот тут от темпартуры! он начинает пускать слюни.

Как у него это получается, для меня блять загадка,

>кто знает еще потрясных карточек

https://characterhub.org/

https://jannyai.com/

>Ты просто нормис

>Без жесткого диска в 2д25м жизни нет.

Дети, от вас двач тупеет

Это тред ЛЛМ, а не твой школьный кружок. Нет железа, нет денег на аренду няшки-кластерка нахуй идешь.

>Это два упоротых промудоблядских пиздохвоёбины на ваннаби-вахтёрах

Сователь рук в пёзды. Ты опять выходишь на связь, мудило ? Тебя еще раз хуями накормить ?

> A duck is fine too.

У селезня, кстати, хуй как штопор.

Ну так, к слову.

Был слаанешитом до того, как это стало модным.

>Не корми ботодетей

Они и так по жизни как Мелвин Толстопуз.

>от вас двач тупеет

Тво присутсвие понижает IQ даже у ИИ

>Сователь рук в пёзды.

Мимо, чини детектор.

>Ну наконец то я чувствую shiver on my spine.

>хуй как штопор

Ебитесь.

>слаанеш

Мы все тут, брат, мы все.

>Тво присутсвие понижает IQ даже у ИИ

Ты охуел ? Рядом со мной рядом даже денди 32битной становится.

>Мимо, чини детектор.

Ну если что, ты это... Обращайся. И тебе хуев принесу, я вообще не жадный.

>денди 32битной становится

Берёшь и заливаешь?

>Обращайся

Не, кушайте сами своих рыбок.

Сьеби в /b, отброс.

Ну и где ?

Так сложно своё кря написать, или вас надо палкой пиздить, чтобы вы ленивые жопы написали своё мнение ?

Пиздец какой то, а потом ноют что ничего нет.

Так сложно своё кря написать, или вас надо палкой пиздить, чтобы вы ленивые жопы написали своё мнение ?

Пиздец какой то, а потом ноют что ничего нет.

хуйня очередной мерж васянских файнтюнов

Phi-3-mini-128k-instruct-abliterated говно мочи ебучее, воспринимает prompt в качестве context и хуярит ответы и на prompt, и на context отдельно друг от друга разными сообщениями. Еще и часто с русского на английский сбивается. Рот ее ебал мразь. Но один раз все-таки доставил.

А можно ли работая по API передавать еще параметры? Например запрет или форс определенных тем, может быть даже для разных людей или разных групп? То что эта злоебучая модель не воспринимает context наводит на мысли о том что она не умеет context (или умеет, но ей нужно передавать его иначе. Но блядь с другими-то моделями работает!), и возникает вопрос а умеет ли она вот этот список тем или слов, в теме которых модель должна склоняться или избегать? Как зделоть? Я хлебушек у мамы.

А можно ли работая по API передавать еще параметры? Например запрет или форс определенных тем, может быть даже для разных людей или разных групп? То что эта злоебучая модель не воспринимает context наводит на мысли о том что она не умеет context (или умеет, но ей нужно передавать его иначе. Но блядь с другими-то моделями работает!), и возникает вопрос а умеет ли она вот этот список тем или слов, в теме которых модель должна склоняться или избегать? Как зделоть? Я хлебушек у мамы.

Как-то не оче, скучно, сухо, нет искры, чтобы шишка задымилась.

я своё в описании мерджа написал, а здесь кроме как

других реакций и не жду, это же не 666B Кстати идея.... Но мне то что, люди качают, значит кому то до зашло. Смержу ещё чего, скину сюда. Умный анон не орёт на дваче, умный анон тихо кумит на свежих моделях.

>Phi-3

Зачем? Почему? нахуя? есть же phi-4

У меня 4Gb VRAM и я не хочу чтобы у меня еще и RAM отжирало, поэтому я копошусь с моделями с самого ебучего дна.

Подскажите где хостятся крупные, 300b локалочки для рп. (Клол с проксей давно отвалился)

Я в вуве сюжетку проходил.

Вот как раз сейчас тестю в пятом кванте.

помянем. Попробуй тогда https://huggingface.co/Khetterman/Llama-3.2-Kapusta-3B-v8 На англе прикольно было, но от 3В чудес не жди. Могу special for you попробовать раздуть 3В до пяти, ну или нарезать 8В, но там весёлый шизофреник скорее всего выйдет.

>других реакций и не жду, это же не 666B

Потому что ты другого нафайнтюнить или смержить не сможешь

Проблема в самих моделях, их ограниченность, необучаемость, тупорылость (сваливание и лупы после 16к контекста) ты это никакими файнтюнами не исправишь, равносильно прикладывать подорожник к дауну в надежде что он станет вторым эйнштейном

Не надо, не ебись. С этим все равно нихуя не сделать, получится или шиза или говно я думаю, а оба варианта ну такое себе.

Лучше подскажи как зделоть так, чтобы LM генерила короткие ответы без передачи предварительного условия "отвечай короткими сообщениями" или сорт оф. Я прост LM через TG-бота подключил, но стены текста ебал, мне максимум 3-5 строк нужно. А токенами ограничивать - наверн на полуслове замолкнет.

Лучше подскажи как зделоть так, чтобы LM генерила короткие ответы без передачи предварительного условия "отвечай короткими сообщениями" или сорт оф. Я прост LM через TG-бота подключил, но стены текста ебал, мне максимум 3-5 строк нужно. А токенами ограничивать - наверн на полуслове замолкнет.

сюда

>люди качают, значит кому то до зашло

Люди всё новое качают. Ты гляди на число лайков , а не скачиваний. Если модель вызывает вау эффект, то ставят лайк, если не ставят, ее удалили и забыли.

Пишет прмя неплохо, да, но медленно, надо попробовать четвёртый квант скачать. Хотя и в пятом галюны ловит, приходится свайпать, хоть может дело в температуре 1.2, ща понижу попробую.

Местами надо направлять, например начать сообщение перса с двойных кавычек чтобы сподвигнуть на прямую речь.

Немного ломает построение фраз иногда, но на уровне что кожаные так пишут, и даже хуже порой.

Всё таки стиль как-то ближе к инстракт, а не рп моделям, например квену.

Скорее получился как сторителлер, или GM рассказывает, чем как рп. Но в целом так чаще даже лучше.

А, вот ты где! Это тред для продвинутых господ, а не васянов без знания языка, что ты тут забыл вообще? Пиздуй инглиш учить, а то завтра мамка заругает.

Скуфчанский, ты смайлики обронил

> воспринимает prompt в качестве context и хуярит ответы и на prompt, и на context отдельно друг от друга разными сообщениями

Для начала разберись в терминах и посмотри что на самом деле в промт сетки идет. Плюс, крайне желательно поставить нормальный лаунчер а не хуету в виде олламы, так корявый апи.

Сайга 13В Q6_k внезапно лучше шарит в программировании, чем квин32В Q4_K_L

Для 8врам прямо шикарно.

Для 8врам прямо шикарно.

Решил на выходных пофиксить вашу говноэкслламу, чтобы она работала на прекрасных и утонченных теслах (возможно, конечно, я попутал прилагательные местами, tehe~). Заодно и про куду узнать, шо это такое и с чем ее едят.

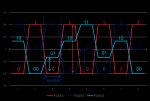

В общем, было так (12B моделька, 8 квант):

245 tokens generated in 67.09 seconds

(Queue: 0.0 s, Process: 0 cached tokens and 186 new tokens at 6.62 T/s, Generate: 6.28 T/s, Context: 186 tokens)

Стало так:

104 tokens generated

in 5.6 seconds (Queue: 0.0 s, Process: 0 cached tokens and 186 new tokens at

294.0 T/s, Generate: 21.04 T/s, Context: 186 tokens)

На большом контексте пока, увы, до кобольда не дотягиваю:

155 tokens generated in 94.45 seconds (Queue: 0.0 s, Process: 0 cached tokens and 14951

new tokens at 220.29 T/s, Generate: 5.83 T/s, Context: 14951 tokens)

Кобольд:

[15:59:06] CtxLimit:15001/32768, Amt:50/2048, Init:0.04s, Process:42.11s (2.8ms/T = 355.02T/s), Generate:4.22s (84.4ms/T = 11.85T/s), Total:46.33s (1.08T/s)

По обработке контекста еще +-, но генерация все еще швах. Ну хотя бы не неюзабельное говно - эксллама в текущем виде просто тупо висит минутку после загрузки модели на теслу.

Там есть еще место, которое можно переделать, но у меня сходу не получается. И я не уверен, что это даст кобольдовые 12 т/с. По хорошему надо бы потом смотреть и профайлить, как устроен кобольд/жора, но хз, хватит ли меня на это.

Отдельной задачей нужно будет как-то заставить старый код работать на амперах, а на теслах - новый. Если в кернелах это макросом решается, т.к. эксллама компилится под несколько архитектур, то в CPU и питоне надо будет как-то рефакторить. Например, банально, чтобы на амперах работал flash attention, а для теслы шел фоллбек в торч. Сейчас там таких тонкостей не предусмотрено: видят теслу - сразу посылают нахуй.

В общем-то конечной целью я хочу, чтобы при раскидывании слоев амперы бы работали так же быстро, а теслы - так же, как в кобольде. Тогда будет отличный прирост по токенам в моем смешанном сетапе.

В общем, было так (12B моделька, 8 квант):

245 tokens generated in 67.09 seconds

(Queue: 0.0 s, Process: 0 cached tokens and 186 new tokens at 6.62 T/s, Generate: 6.28 T/s, Context: 186 tokens)

Стало так:

104 tokens generated

in 5.6 seconds (Queue: 0.0 s, Process: 0 cached tokens and 186 new tokens at

294.0 T/s, Generate: 21.04 T/s, Context: 186 tokens)

На большом контексте пока, увы, до кобольда не дотягиваю:

155 tokens generated in 94.45 seconds (Queue: 0.0 s, Process: 0 cached tokens and 14951

new tokens at 220.29 T/s, Generate: 5.83 T/s, Context: 14951 tokens)

Кобольд:

[15:59:06] CtxLimit:15001/32768, Amt:50/2048, Init:0.04s, Process:42.11s (2.8ms/T = 355.02T/s), Generate:4.22s (84.4ms/T = 11.85T/s), Total:46.33s (1.08T/s)

По обработке контекста еще +-, но генерация все еще швах. Ну хотя бы не неюзабельное говно - эксллама в текущем виде просто тупо висит минутку после загрузки модели на теслу.

Там есть еще место, которое можно переделать, но у меня сходу не получается. И я не уверен, что это даст кобольдовые 12 т/с. По хорошему надо бы потом смотреть и профайлить, как устроен кобольд/жора, но хз, хватит ли меня на это.

Отдельной задачей нужно будет как-то заставить старый код работать на амперах, а на теслах - новый. Если в кернелах это макросом решается, т.к. эксллама компилится под несколько архитектур, то в CPU и питоне надо будет как-то рефакторить. Например, банально, чтобы на амперах работал flash attention, а для теслы шел фоллбек в торч. Сейчас там таких тонкостей не предусмотрено: видят теслу - сразу посылают нахуй.

В общем-то конечной целью я хочу, чтобы при раскидывании слоев амперы бы работали так же быстро, а теслы - так же, как в кобольде. Тогда будет отличный прирост по токенам в моем смешанном сетапе.

>крайне желательно поставить нормальный лаунчер а не хуету в виде олламы, так корявый апи.

Мне нужна какая-нибудь хуета с API потому что

>Я прост LM через TG-бота подключил

Ну а так-то чекну канеш чтобы контекст передавался как контекст.

>Проблема в самих моделях

тогда давай признаем, что трансформеры - тупик, и закроем тред, хули?

Пока ждём технологического чуда от больших дядей с большими деньгами можно и в куличики поиграть помержить, выпук модели же меняется. Причем в желаемую сторону. а там и полноценный ИИ выкатят и вообще не надо будет умирать Тем не менее, осуждаю спам аватарку. Я ссылки кидал один раз, этого достаточно. ну хоть актив пошел

Okay

>как зделоть так

Токенами + систем промптом + нужным темплейтом + от модели сильно зависит, какие то будут тебе килотонны текста высирать, в то время как иные - 2 строчки. Как это в тг боте настроить, я хз.

Спасибо за развёрнутый отзыв. Т выше 1.1 не тестил, так как мои карточки полны инструкций, вплоть до уровня if/else, а на высокой темпе многие модели хуй на них забивают.

Ты хотел сказать «анти-здравый смысл»? Потому что перечисленная хуйня — именно хуйня. Не знаю уж от одного шиза или нескольких.

Есть еще авторы «хаха, у него тесла, 1 токен/сек!» и «pcie не важна, цепляй все на х1 процессорную!» (и это один и тот же чел), и многие другие охуенные выводы (которые всегда заканчивается тем, что он срет на всех, кто с ним спорит, утверждая, что это один и тот же чел, а его весь тред поддерживает).

И по сути говорит все верно.

Не так важно, один ли тут вахтер-сральник или их тут несколько, для конечного пользователя результат один: насоветуют кучу говна, обосрут весь экспериенс, заткнут всех, советующих норм советы и все.

Ну и как бы, нахуй. =)

Вот отличный пример, чел задал здравый вопрос — зачем платить за медленную скорость, если быстрая стоит так же или дешевле. Ему ответили «надо блеадь!»

Никто не прокомментировал ничего другого, зато посоветовали хранить модели на хдд.

Отсюда возникает мысли, что местные спецы рили верят в «великую силу хранения хдд и бесполезность ссд» и мнят себя ебать профессионалами, по факту не разбираясь в теме нихуя, и советуя человеку говно.

Ну, приятного аппетита.

> Постоянные срачи как бы намекают

Тока они проходят всегда в одни ворота — долбоеб громко визжит и адекватные люди на него забивают, оставляя его «победителем». И какой толк? =)

———

Первые 25-30 тредов были отличные.

Чмони, вы ж понимаете, где лоКАЛ -кал и где Opus? У меня он есть на приватной прокси с осени

>систем промптом

>нужным темплейтом

Спасибо, по ключевым словам в документации кое-что нашлось, поковыряюсь.

>от модели сильно зависит, какие то будут тебе килотонны текста высирать

Вот и я говорю, что эта ебучая Phi-3-mini-128k-instruct-abliterated контест воспринимает как промт. С Qwen2-1.5B-Instruct-Abliterated такой хуйни вроде бы не было, но я потестировал маловато.

>3b

Калка! лоКАЛ. Давай по апишке 600b модельку бесплатно?

>оставляя его «победителем».

Всем всё понятно, что не так то?

Впопус сосёт у о3, а дипсик р1 на уровне о3, так что это впопус сосёт у локалок, лол. Дожили.

Джейл в 16 килотокенов прилагается.

>великую силу хранения хдд

Цена за гб.

мимо

>Тогда будет отличный прирост по токенам в моем смешанном сетапе.

Удачи, держи нас в курсе.

в пределе до 2 тб у братьев китайцев равна.

Но вообще не понимаю этого срача. винты нужны также, как и хорошие ссд, но они для разных задач совершенно.

Мимо 7 тб музыки на винтах и 2 тб игр/моделей/софта на м2

МОЁ КРЯ.

В дополнение к скринам выше.

Может на ходу выдумать свою связную и непротиворечивую историю... но пришлось свайпать, ибо в сеттинге было по другому.

Не то чтобы забывает, но ради "красного словца" меняло например цвет глаз у героев.

( Aleteian )

> Тем не менее, осуждаю спам аватарку

Opusщенный, срыганский с треда оформил, быстро-решительно.

>Всем всё понятно, что не так то?

Собака лает, краван идёт.

Расскажи что ты там менял, вот это интересно.

> заставить старый код работать на амперах, а на теслах - новый

Лучше пусть будет форк или отдельная ветка, а то полезет много проблем.

> Тогда будет отличный прирост по токенам в моем смешанном сетапе.

Если прямо делаешь под себя - просто делай фиксированную таблицу девайсов (динамическую из torch.cuda.get_device_capability()) и там уже по-простому ветвления.

> в пределе до 2 тб

Это как? Сейчас нормальный ссд - это примерно 7к за тб, +- в зависимости от курса, скидок и т.д., nand-содержащий продукт с записью вне slc медленнее харда не достоин жизни. Хард - 2к за тб, 1.3к если рефаб, еще меньше за бу.

Первые умирают внезапно и с концами, имеют объем в 4тб на штуку (или стоят совсем космических денег и неудобны). Вторые будут кряхтеть до последнего, заблаговременно сигнализировать о проблемах, вмещают от 16тб.

Если ты не совсем обыватель, то потребуется как минимум один хард, что будет пылиться и доставяться раз в N для бекапов.

Какой-то очень кривой русский на скриншотах.

Ну уж нет, на второй раз я на это не куплюсь.

Зовут тюнить, а по итогу заставят изучать монографию по машинному обучению на пакистанских датасетах.

Кстати, погонял тут https://huggingface.co/mann-e/Hormoz-8B

Как по мне, смесь шизы на арабском датасете выдала уникальный опыт, но туповата, да. 8В всё же. Пойду писать карточку- арабскую сказку. (в руский может)

> Если ты не совсем обыватель

Экхем-экхем

А где же все эти : ОБЛАКО, ОБЛАЧНЫЕ ХРАНИЛИЩА, ВСЕ ГОВНО ВОТ ОБЛАКО.

Не к тебе претензия, но я помню этот вой с болот.

Так в том и фича, что цена равная, а порою ссд дешевле.

Последний год уже так, я беру ссд пачками в том числе по причине цены за гб, здрасьте. =)

А надежность — ну прям такое, хдд любят сыпаться не реже ссд, если ты не гоняешь ссд на запись, а хдд не бьешь об стол ежедневно.

Вот.

Я просто пару раз грузил модели с хдд. Цепиздец.

При всей шизе этого треда, тут все-таки локалочки, конфеденциальность.

>Не так важно, один ли тут вахтер-сральник или их тут несколько, для конечного пользователя результат один: насоветуют кучу говна, обосрут весь экспериенс, заткнут всех, советующих норм советы и все.

Чел, нет цели "обосрать экпириентс", но если закрыть глаза притвориться что вместо говна у тебя конфета, конфетой оно не станет. Не нужно давать иллюзию новичкам что реально запустить хоть что-то приемлемое без вложений, ещё и на РУ, лол, они же ща себе напридумывают, а потом реальность их приложит обухом по затылку. Пусть лучше сразу смотрят на свои 8b-10b как на "пробничек" и если зайдет копят на нормальное железо. Локальный запуск LLM это не самое дешевое удовольствие.

Так-то и 30b это тоже скорее пробник, но это пограничный размер, когда уже проклевываются мозги и ещё существуют разные различные тюны, на ларждах с последним совсем грустно.

Хотя хуй с тобой, вы так скоро реально до мышей доберётесь, и будете обсуждать какой охуенный РУ кум на 2b мобилке в 0,3 токена/с

>цена равная, а порою ссд дешевле

<2р/гб?

У hdd и меньше было, но сейчас курс рубля не самый лучший. Но по 2 вроде можно найти.

Вообще да, новая 24б мистраль крайне разочаровала, знаний больше - ума меньше. Явно под агентов и чатботов, но как раговорная, очень сомнительно.

-----------------------------------------------------------------------

Чекнул свои лайки на обниморде =))

Small, but honest work.

Эмм....

>арабском датасете

Моё почтение шахтерам ЛЛМ, но блджад, что тебя вообще сподвигло пробовать пакистанские мержи дипсика ?

>24б мистраль

В треде кидали скриншоты кума на базовой модели, там гораздо лучше было, как минимум без странных оборотов.

Ну там васяну хватит бесплатных 15гб чтобы фоточки хранить инб4 они уже в социальчки загружены, зачем хранить

А под большой объем - уже сильно дорого, да и со скоростью совсем плохо.

> Так в том и фича, что цена равная, а порою ссд дешевле.

Так покажи, где. Сравниваешь сата ссанину с 30мб/с записью после записанных 20гб и непойми для кого изготавливаемые 1тб харды?

> я беру ссд пачками в том числе по причине цены за гб

Кексимус максимус

А почему нет? Тем более от персов, я в них верю. Ищу интересные части для мерджа, нахожу, пробую. А тут хоба, и ничего так, неплохо. Это было в тренде обниморды для тега ру языка. на первой странице.

База это ссд под систему и приложухи, хдд под файлопомойку.

Облака - яндекс бля, терабайт на год за цену одного похода в магазин за пивандрием. На самое важное хватит. Особенно если это важное желательно иметь на нескольких машинах.

Облака - яндекс бля, терабайт на год за цену одного похода в магазин за пивандрием. На самое важное хватит. Особенно если это важное желательно иметь на нескольких машинах.

Это тьюн 8б Аи expanse, видимо, раз пишут, что на архитектуре командера, а она исходно мультиязычная, с не самым плохим русским. Не исключено, что тут он хуже, чем в оригинале.

Слепому скока не показывай, все равно не увидит. Сочувствую тебе, ничем помочь не могу, переплачивай за 0,1х скорость.

Аноны привет, уже где-то месяц сижу на instrumentality-rp-12b-ru-q8_0 и NemoMix-Unleashed-12B-Q8_0 (instrumentality сильно лучше как мне показалось).

Подскажите, какая модель сейчас самая топ?

Спасибо уважаемые аноны!

Подскажите, какая модель сейчас самая топ?

Спасибо уважаемые аноны!

>Вторые будут кряхтеть до последнего

ПИЗДЁЖ. У меня 2 харда отлетело, 1 был заменен заранее неудачная серия от сигейта, гуглить по "граммофон на 3 ТБ". Итого по моей статистике 2/3 мрут как мухи внезапно. И это не считая одного ноутбучного, который я случайно пальцем раздавил, лол.

>А под большой объем - уже сильно дорого

У меня до сих пор терабайт от мейла, лол накидал туда 500 гиг зашифрованных архивов, удачи на мне заработать.

>хдд под файлопомойку

Ты хотел сказать отдельный NAS? Ведь так? А то сидеть с пердящим диском под боком ну такое себе.

Чето я погонял вашу гемму 27б на русике в 5 кванте и это просто говно, местные мержи 12б не хуже ни разу.

Походу русик вне 120б реально мертв, на гемму последняя надежда была а так и обновляться смысла нет

Походу русик вне 120б реально мертв, на гемму последняя надежда была а так и обновляться смысла нет

Штош, капуста для телеграм-бота меня вполне устроит судя по всему, лол.

> А то сидеть с пердящим диском под боком ну такое себе.

Вообще ощущение, что для производителей хдд уже умерли. Брал пару лет назад новые барракуды - оба шумят гадски, причём по-разному. Старые харды при этом тихие, никакого сравнения. Плюнул и взял пару 2тб сдд.

Вот о чем я говорил, это просто перевод с английского.

Кто блять говорит на русском "страстью и обещанием?"

Кто блять говорит на русском "страстью и обещанием?"

> пердящим диском

Я не глухой честно но в простое я дисков не слышу.

С другой стороны, гонял я тут raid 0 ide дисков из нулевых...

В голос. Чё то с настройками, с температурой скорее всего. Я на ней даже покумить сумел, пусть и на англюсике.

Быстро даун слился.

Алсо, для падали, что пихает мусор в компы работяг предусмотрен отдельный котел в аду. Если ты себе такое ставишь то это вообще рофел.

> переплачивай за 0,1х скорость

Всхрюкнул

> по моей статистике

Ты бы лучше рассказал что вода - яд, ведь все кто ее пил умирают.

> терабайт

Речь про большие объемы. Не удивлюсь если у топящих за сдд вообще что-то суб-террабайтное стоит.

Скорости нарастили, время доступа снизили, головок много и тяжелые. Все решается хорошим корпусом, где предусмотрены демпферы, или что-нибудь там наколхозь. Можешь сразу в коробочку и подальше увести.

Ну и сейчас диски в пару тб и подобное - большей частью хлам на одном блине, что будет постоянно дрочиться.

Все таки придется еще раз написать.

Проблема не совсем в великом и могучем (Ну вообще есть проблема в синтаксисе языка и окончаниях, но эта проблема несколько шире, но не суть) а в том что модели тренируют на огромных англоязычных датасетах.

Поэтому всякие мистрали хорошо пишут на английском и так тупеют при переходе на другие языки. Поэтому тут многие аноны и не РПшат на русском языке не потому что они дохуя пэры и сэры из ингландии, а потому что так удобнее. Никакой ебли с окончаниями, никаких лишних токенов на -ова -ла -ли -ло. Чистейшая математика, ёпта. Да и в целом английский знать полезно, на нем до жопы техлитературы современной.

Хотя меня, если честно в РП то все устраивает, но как только доходит до мягких стенок её влагалища почему то начинает коробить.

>трансформеры - тупик

Я не ебу что тупик а что нет, но ллм подзаебали уже, они кроме текста ничего не умеют делать, а хайпа столько что это чуть ли не АГИ какой это аги если он даже сам калькулятор открыть не может?

>выпук модели же меняется

Меняется, но не лечит основные проблемы ллм памяти, надежности (в нашем случае не проебать трусы через 2 сообщения) и большего понимания что вообще происходит в этом рп

>полноценный ИИ выкатят

Полноценный ИИ это какой? Которого можно в робота запихнуть и он работать будет не убивая человеков? Или тот который рак за 1 ночь вылечит и всем бессмертие в консоли пропишет?

>но ллм подзаебали уже, они кроме текста ничего не умеют делать

>Языковая модель

>кроме текста ничего не умеют делать

Падажжи, в следующей итерации она для тебя спляшет и борщ сварит

>в следующей итерации она для тебя спляшет и борщ сварит

Ну а я о чём? Круто конечно что она рецепт борща мне может выдать и гайд по пляскам, но когда научиться делать это сама? Вон кличут что этот год будет годом агентов, но пока опенаи сделал пукнув со своим оператором, но при этом deep research у них сильно хвалится за умение искать инфу и составлять отчёты ждём кум агента лол

Думаю даже необязательно делать йобаИИ сразу, может у них путь сделать сначала ИИ занимающийся автоисследованием, а ученые в говне моченые будут собирать самые крутые идеи которые он там накопал, че бы и нет?

>Ты бы лучше

Я лишь привёл свою статистику. И да, качество современного железа такое, что внезапные смерти дисков это норма. Это тебе не старый 20 гигабайтный квантум, у которого я бед сектора обходил разбивкой и пахал на таком ещё пару лет, тут малейшая пылинка, и сразу всё идёт по пизде, даже прочесть весь объём не успеешь.

Впрочем похуй, есть бекапы.

>Речь про большие объемы.

А что у тебя на терабайт, что нужно бекапить? Модели лучше на хайгинфейс залить (впрочем они уже там), остальное торрентами добивается.

>они кроме текста ничего не умеют делать

>транформеры

Сейчас на трансформерах разве что... А впрочем нет, сейчас на них всё делают.

Все это интересно, но когда клода завезут в лоКАЛ? (Удачи поднять соннет 3.5 на нищепека)

>они кроме текста ничего не умеют делать

Ты только тут сидишь?

Нейросети генерят любой контент: текст, картинки, музыку, видео, 3д обьекты, сраные схемы расположения транзисторов в новых чипах и то они делают.

Да, не самостоятельно, а как инструменты с которыми работают специалисты.

Не забываем про гугловские топовые сетки моделирования белков, моделирования материалов и химичечких соединений и еще что то было от дипмайнда, игровая сетка какая та