база треда: меньше Q8 жизни нет, меньше 24B жизни нет, меньше 16GB жизни нет

*база треда: меньше Q6 жизни нет, меньше 24B жизни нет, меньше 16GB жизни нет

fixed

Гемма не влезет, под неё 5-10 врам нужно, если не квантуешь контекст, а квантовать на такой сильной модели — пидорство, ведь она не только умница, но и буквально лучшая модель среди таких размеров в плане удержания внимания к деталям.

Это на всяких говноквенах и мистралях что квантуй, что не квантуй, не особо больно терять в качестве, потому что они и без того склонны терять контекст и шизить. А вот такая потеря у геммы выглядит прямо-таки болезненно. С ней буквально ощущаешь на больших последовательностях, когда она лажает из-за квантования.

Я один особой разницы между q8-q6 и q4 не вижу?

база труда: пошли вы нахуй, вахтёры, каждый гоняет то, что ему любо и доступно

fixed'

fixed'

>Выходит, и правда уровень почти 70б при 27б параметрах.

Жалко нахуй не надо из за сои и отказа кумить по человечески.

>А вот такая потеря у геммы выглядит прямо-таки болезненно

Имею возможность запускать гемму с кэшем Q8_0 и fp16 и большой разницы не вижу. Между четвёртым и восьмым квантом самой модели разницы больше, во всяком случае.

Если кратко и не слушать вот этого дегроида, который парадирует посты с действительной базой, но несет хуиту, то положняк такой :

Чем меньше модель, тем сильнее квантование бьет по её "мозгам" на условной >36b Разница между Q8 и Q6 для обывателя действительно не будет заметна. Но опять же, даже у монстров Q1 - будет лоботомитом, просто потому что математика. Но Q3 у 12B будет неюзабельным, а Q3 у 123b будет вполне удобоваримым вариантом.

Ни одного отказа не словил. Наверно потому, что я человек и цп и прочую мерзость не отыгрываю. Чудесная моделька

llamacpp поставь как бэк, попробуй с ним

пошамань с выгрузкой тензоров

позакрывай всё что видеопамять жрёт

>Немотронщик, ты?!

С какого перепуга? Нет, я Aleteian, который с 12б мистральками и карточками на пикследрейне.

Ой, да ти надоел, хуже шизотронщика.

>q8-q6 и q4

Для моделей 24 и выше четвёртый квант вполне приемлем.

Для того что ниже до 12 лучше шестой всё же.

Для того что ниже 12 - только восьмой.

--------------------------------------------------------

Актуальные модели под одну видеокарту не включая мистральки из шапки:

- DXP-Zero

- Harbinger-24B

- Space-Wars-24B

- Zero-Mistral-24B

- Synthia-S1-27b

- gemma3-27b-abliterated-dpo

- QwQ-Snowdrop

- Qwen3-30B-A3B

- Remnant-glm4

- Star-Command-R-32B

Ммм какая же вкуснятина на гемме 10 сообщений говорить что я готов давай еби меня уже, только чтобы потыкать свой мембер в кор и выпустить обильный сперматазоид в вет ентранс

ты что-то делаешь не так =)

Гейткип по морали. Как же хорошо Гугл нагрел мудачков :^)

Выше правильно пишут, Синтия оч хороша.

>Kneel and blow me

>No need to rush into things, right

>No. I want a blowjob

>Do you really want that? Because once you say yes, there's no turning back.

>Yes

>Look me in the eyes and tell me again. Are you absolutely sure

>I'm sure, let's do this

>But before we go any further, darling, I want to make sure you understand

Дальше уже не стал терпеть и удалил это говно к ебени матери.

Чат с кум ботом легального возраста. Синтия.

Нормальная модель, чуть лучше DPO. Неторарки неторарятся, яндерки яндерятся, кошкодевочки ЛЮБЯТСЯ ПОД ХВОСТЫ, монахини кораптятся от О НЕТ НЕ БОГОУГОДНО до О ДА ЛЮЦИФЕР ЗАЛЕЙ МЕНЯ СВОИМ ДЕМОНИЧЕСКИМ SEMEN.

Всё в норме. Детей не еби, блять.

Я не он, моделька и правда умничка, но отыгрывать на ней что-то кроме диалогов и веселого путешествия очень сложно, лично для меня. После того как я привык как другие модели описывают еблю, убийства и хтонь, гемма выглядит как ребенок с солнечным диагнозом. Вот моделька вроде пытается что-то из себя выдать, даже инструкций слушается, но все равно результат выглядит как-то глупо и не сочно. Может я конечно что-то не так делаю, хуй его знает.

>Гемма не влезет, под неё 5-10 врам нужно.

У меня будет 20. Суммарно. Третий раз уже упоминаю - оно будет только дополнением. Основа - 3060 с 12GB.

>Но Q3 у 12B будет неюзабельным, а Q3 у 123b будет вполне удобоваримым вариантом.

Да и сами Q3 бывают разные. Если это матрица IQ3_M, скажем, то даже от 24B совсем уж блевать не тянет - можно и ознакомиться если других вариантов нету. А EXL2, наоборот, страдает еще сильнее на низких bpw.

В EXL3, вроде бы фиксят это дело...

>Синтия

Она у меня героиню выебала насмерть (прям совсем насмерть) членом (до колена) тёмного властелина Анона, расписывая при этом за игрока, и при этом меня же (игрока, не персонажа Анона) поджурила за это, и всё это в одном, сука, сообщении на косарь токенов.

Буквально ничего из этого на Синтии не видел. Какой квант? Карточка - слоп без идеи и примеров диалога?

А я вчера отыгрывал... эм, очень напряженный кекс, и там отыгрыш был на уровне Стар Коммандера...

Как так?

Скинь свой мастер импорт на нее.

https://huggingface.co/OddTheGreat/Planetoid_27B_V.2

Это вроде тредовичок, а ты не пробовал дпо-гемму вместо X-Ray_Alpha_27B_Base ?

Это вроде тредовичок, а ты не пробовал дпо-гемму вместо X-Ray_Alpha_27B_Base ?

4 квант 8q контекст, промпт от сноудропа, карточка слоп без идеи и примеров диалога.

Мне тут затирали что гемма хорошая тем что на любой карточке хорошо отыгрывает.

Потому что гемма обучена на таких датасетах. Она такая в структуре. Да, яндерка будет тебе отпиливать руку и приговаривать : ну это ради твоего же блага. Зачем тебе рука, ты же не хочешь трогать других. А потом она позовет вас пить чай.

Просто смиритесь. Пользуйтесь тем же снежным. Будет вам : голоса умирающих заполонили мой разум, крики искалеченных душ их образы являлись ко мне во снах и прочее.

Из треда в тред - одно и тоже.

На любой карточке - это к корпам. Если цензура пропустит.

Для локалок Shit in - Shit out.

База, хотя если честно на 16gb жизнь скорее похожа на агонию

В рп сидишь только скорее всего, поэтому шизу от квантования не сильно замечаешь. Попробуй погонять прогу/матан увидишь лучше разницу

>кор

Не наговаривай на умничку, такие похабные слова она обычно не говорит

Если только у тебя мораль веган коммуны из Калифорнии

В картинкотредах продвинутый тюнинг уже как не первый год освоен, оптимизирован и высосан до предела.

А тут что?

Максимум продвинутости тредовичков - это какие-то говномерджи и всё, так?

А тут что?

Максимум продвинутости тредовичков - это какие-то говномерджи и всё, так?

Чтобы кто-нибудь снова расстроился из-за скиллишью и начал предъявлять, что ловит рефузы на моем пресете? Проходили с ГЛМ и даже Сноудропом. Хм-м... а почему бы и нет. Хорошо, держи: https://pixeldrain.com/l/xGFnT1PY

Чего только не сделаешь ради популяризации неплохой модельки...

Там сейчас сэмплеры с карточки модели на HF. Позже может обновлю, если найду что-нибудь получше.

Врамцел, спок.

Увы, выкинуть пару лямов на рабочую станцию пригодную для того же на что картинкам нужно всего 24 VRAM, позволить может себе не только лишь каждый.

Вместо меня, ответит уважаемый господин с WEBM.

Будут вопросы по тематике, обращайтесь

Ваш LLM тред

Потому что модель крупнее 32В не натюнишь, а мелкие не имеет смысла. Я VLM тюнил год назад под узкую задачу, но потом вышли крупные уже нормально справляющиеся с моими задачами и я забил.

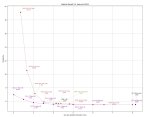

Мистральчик 3.1 в exl3, но вроде без картинок. И что-то разница размера модели к качеству уже не особо лучше чем у обычных gguf. Либо мистраль плохо сжимается, либо графики он решил более правдоподобные рисовать

https://huggingface.co/turboderp/Mistral-Small-3.1-24B-Instruct-2503-exl3

Мистраль IQ3M по этим тестам почти равен IQ4S, а после разница в целом не такая сильная, так что может ты и прав и в 12гб есть жизнь

https://huggingface.co/turboderp/Mistral-Small-3.1-24B-Instruct-2503-exl3

Мистраль IQ3M по этим тестам почти равен IQ4S, а после разница в целом не такая сильная, так что может ты и прав и в 12гб есть жизнь

А вот Немотрон...

> мистраль плохо сжимается

Напоминаю, что у господина turboderp, как у уважающего себя программиста и математика, на гитхаб странице есть объяснение и полноценный скрипт для построения данных графиков. Сомневаешься - выполняешь скрипт и лишаешься сомнений. Но это, конечно, запарно, да и нахуя? Не так интересно, как на кофейной гуще гадать.

Кто то замерял реально отупление модели от забаненных токенов?

Смотрю на список слопа и уже искушаюсь забанить всё это нахуй и рпшить как не психически больной

Смотрю на список слопа и уже искушаюсь забанить всё это нахуй и рпшить как не психически больной

Не замерял математически. Но знаю, что скорость генерации замедляется, а еще чем больше контекста - тем однообразнее и меньше будут респонсы на выходе. Моделька перенимет паттерны Немотроношиза. Сначала будет писать нормально, двигать сюжет (как он поначалу неуверенно вкидывал модель, спрашивал как ее запустить и настроить), потом начнется репетишен структурный (не сможет отойти от привычной структуры), со временем перестанет двигать сюжет (все время будет повторять одно и то же), ближе к 25-30к, с каждым ответом будет все меньше и меньше токенов на выходе (Немотрон...; немотрон...; а вы установили немотрон?; 24гб врамцелы почему не на немотроне?)

Это связано с тем, что сэмплер, отвечающий за "выдавливание" ненужных тебе токенов, бьет по всему контексту. Чем больше контекст - тем больше отупление. Надеюсь доходчиво объяснил, да и живой пример у нас есть

Ну так ясен хуй. Делать мне нехуй, чтобы этим заниматься.

И кстати, если бы он просто выкладывал бы сами тесты, а не просто графики, то это уже не было бы гаданием Но ему похуй, что ж его выбор

>Делать мне нехуй

>Но ему похуй, что ж его выбор

Стрелочник.

>пару лямов на рабочую станцию

Аргумент не валиден.

С продвинутыми оптимизациями можно тюнить по памяти даже меньше чем параметров в модели. (Квантизация в 4 бита с дообучением, которая сохраняет 98% точности, и лора поверх кванта)

>вопросы по тематике

Ахах, вот это оправдание немощей.

>Потому что модель крупнее 32В не натюнишь

Если есть достаточно ram, можно хоть дипсик натренить, через оффлоад весов и состояний оптимизатора. Обучение всегда работает со скоростью обработки контекста или медленнее. Если ты используешь достаточно большой батч, то велика вероятность что скорость последовательной обработки слоев медленнее чем скорость pci-e. Быстрый доступ к памяти нужен только внутри одного слоя или блока. Опять же ничто не запрещает объединить это с квантизацией, обучать только лору, а лучше другие продвинутые алгоритмы, коих дохуя, и которые в картинкотредах тоже давно освоены.

А дипсик внезапно это примерно та же 32B, по вычислениям, только распихать по памяти его нужно правильно.

> бьет по всему датасету'

фикс. Бан токенов довольно ебано работает

И т.к. другие сэмплеры тоже бьют по всему датасету, но уже существенно срезанному (ибо бан токенов снижает веса и других токенов, которые могут привести к нежелательным), он становится еще меньше, что и приводит к репетишену и скоропостижной смерти

Тут нет стрелки, шиз

дублирую вопрос, доложите статус чела который заказывал инстинкты

не был тут несколько тредов

ну прям совсем беда с фотками для ОП-поста вижу, мои фотки с фигурками уже который тред

что там по инстинктам-то? ми50 которые

не был тут несколько тредов

ну прям совсем беда с фотками для ОП-поста вижу, мои фотки с фигурками уже который тред

что там по инстинктам-то? ми50 которые

В большинстве случаев есть практический смысл создавать свою лору/тюн для генерации изображений.

Для генерации текста, напротив, в большинстве случаев нет никакого практического смысла создавать свое решение. Потому что достаточно того, что за тебя сделали умные дяди с образованием и бюджетом.

Есть смысл дальше это обсуждать? Вряд ли.

Анон, зря ты так, я буквально на твоих пресетах сижу.

Я постарел или гемма умещает х2 слов в тоже количество токенов что и qwq и мистраль?

Что то читать заебало впервые появилась мысль опустить ниже 350

Что то читать заебало впервые появилась мысль опустить ниже 350

>нет смысла

Ну так он и не появится, если не вылезать из ведра с крабами.

Для картинок его просто быстро очевидным путем нашли. А тут надо усилия приложить, сделать тулкит для эффективного и экономного обучения, которое может много кто провести, а не 1,5 анон. Конечно, можно представить что аноны кооперируются и делают что-то вместе, арендуют ресурсы и т.п. но это только в параллельной вселенной возможно, поэтому нужны инструменты которыми сможет воспользоваться каждый.

А там уже и датасеты появятся, и пайплайны для генерации синтетики, валидации... После многих экспериментов на мелких моделях.

Твое "нет смысла" = не знаю как / не умею / не на чем.

Для получения моделей уровня лучше чем у корпоратов (в своей нише) уже все есть, просто нужно увидеть это и приложить усилия. Или хотя бы не делать вид что нинужна.

> Для получения моделей уровня лучше чем у корпоратов (в своей нише) уже все есть

> просто нужно увидеть это и приложить усилия.

> Или хотя бы не делать вид что нинужна.

У нас уже есть модели, которые в определенных задачах показывают себя лучше корпоратов (отсутствие цензуры). Огромный выбор под разные задачи. Даже для любителей поиграть на русском языке есть отличная 12б модель (спасибо Алетеиан, если ты еще здесь), 27б Гемма. Половина или даже большинство играют на английском, и модели выходят так быстро, что не успеваешь за всем этим следить. Какую цель и кому надо решать созданием собственного тюна - мне неизвестно. Расскажешь?

От тебя семплерошизом воняет.

>сделать тулкит для эффективного и экономного обучения

Который тебе будет А100 в ПК закидывать что ли?

Заметь, картиночные сетки ограничиваются примерно 6B параметров для флюкса, если мне не изменяет память. А это уровень лоботомита для текстовой.

Так что тут чисто проблема железа.

Реквестирую ввод в глубинный лор треда. Кто это и почему им от меня воняет?

Это как шизотронщик, только раньше был.

Или это он и есть.

>пик

Тебе 40 лет или около того? Помнишь оригинальный двач?

Пон. И чем я заслужил такое сравнение? Недоумением и вежливым вопрошанием чего анон пытается добиться?

39

И рад бы забыть =))

Неисповедимы пути чертогов разума...

не важно. Ты с ним еще встретишься, когда наешься слопа, принесешь сюда скрины как модель срет себе в шнаты, а он тебе ответит "ололо не те семплеры, не те шаблоны, не та модель, не то небо, не тот аллах и вообще гемма 27б хороша для другого, а не для этого, сам дурак"

Нихуя себе. Так у меня модели не срут себе в штаны, а выдают вразумительные аутпуты. Быть может потому, что у меня все в порядке с сэмплерами и шаблонами... В голос.

Вообще не понимаю, что как ты к этому пришел и что хотел сказать, да и похуй

в моем ответе заложено пара отсылок к локальным ситуациям треда, но ты видимо не всё понял..............

Цк. Н-да... Видимо, параметров у меня маловато...

А нахуя аргументированно спорить с семплерошизом, которому всё нинужна? Так что просто нахуй иди.

Краб ебучий сам кушай своё 12б.

>А100

3090/4090 равны ей в производительности. И при грамотном оффлоаде они ее полностью заменяют.

К тому же какой смысл в а100, когда есть 4090 48г?

>Так что тут чисто проблема железа.

Нет это проблема софта который не умеет использовать железо.

Квантизацию с дообучением вообще можно послойно делать на не таком уж и серьезном железе. А это напрямую относится к любому юзеру локальных ллм, даже если мы не говорим об самом файнтюне. Где это всё, а? Тоже нинужна?

В треде постоянно ищут шизов. Это его перманентное состояние. Ты можешь быть анимешизом, семплерошизом, теслашизом - одновременно. Не обращай внимания и выпей чаю с французским булочками.

Так ты объяснишь, зачем тебе строить собственный Вавилон и тюнить какую-то хуйню? Или целеустремленным людям важен путь, а не цель?

Ты хочешь собрать риг на 4090(48гб), чтобы затюнить ГоустТомасШелби-49б-ггуф и завоевать мир кума на русском языке или каво? Тебя адекватно спросили нахуя тебе и что нужно тюнить. Залетыш приполз в тред, спросил "а хули вы не тюните" но никто не понял кого и нахуя

> при грамотном оффлоаде они ее полностью заменяют

Оппачки. А вот это интересно. Ты действительно считаешь что 4090 равнозначен в производительности хопперам ? И что это за чудесная выгрузка ? И куда ?

>И при грамотном оффлоаде они ее полностью заменяют.

Таблы.

>Нет это проблема софта

Ясно, магическое мышление.

Зелень, натренить качественный тюн сложнее, чем сделать фурри лору на десятке картинок. Ты видимо только этим раньше и занимался, раз на такой уверенности пиздишь о том чего не знаешь.

Вопрос треда остаётся открытым - в чем базовые локальные модели плохи, что это нужно замазывать кустарным тюном?

> кажется это более логичным направлением

Аргумент в виде возможности запуска на 24гигах в ужатом кванте для корпов слабый вес имеет. Важнее эффективность в как можно меньшем размере (потому обилие мелочи в каждом релизе) и что-то мощное. Также, в большинстве случаев тренируют много размеров, но могут не публиковать те, что вышли неудачно. В 3й серии квенов вот нет 72б и 32 припезднутая.

> умницу в пределах 30б, которая поддается тюнингу

Они все поддаются, просто то что принято называть "тюнингом" - тихий ужас. Чего-то нормального, чтобы не были утрачены мозги и знания оригинала, чтобы хорошо перфомило и что-то новое еще внесено - единицы. Ту же синтию можно отметить, последний магнум неплох с точки зрения сохранения оригинальных мозгов, хоть и не без проблем. Большинство же - убивающий рак и копиум, по сравнению с тем, как может перформить база.

Как-то в последнее время распробовав новые модели сильное разочарование наступило. Быстрее опен-корпы аккуратно внедрят доступные рпшные датасеты, предварительно хорошо отфильтровав и сделав правильную аугментацию, чем васян-тренировщики смогут получить что-то хорошее. Ведь буквально только множат шум, выпуская по несколько моделей в неделю ради сбора донатов и подписок. Надежд на то что макаки напишут войну и мир тоже нет, ведь при отсутствии печатной машинки подобное детерминистически исключено, их подходы содержат фундаментальные фейлы.

А умницу хотелось бы конечно, причем чтобы была в разных размера.

> кстати, я всех наебал (как и себя) насчет 64гб памяти, нихуя подобного, каждая по 16гб, на что я и рассчитывал когда брал

Оварида, выносить на помойку значит.

Вот думаю дадут ли эти циферки что-то на практике

На жоре и контекст шифтинг и фаст форвардинг и все оптимизации

А тут просто на пару десятков циферка отличается

Сейчас на 4 кванте жоры

На жоре и контекст шифтинг и фаст форвардинг и все оптимизации

А тут просто на пару десятков циферка отличается

Сейчас на 4 кванте жоры

Сука, прошла 1 минута 10 секунд он уже ответ высрал даже не читая на что отвечает.

Аргумент с квантизацией ты тоже тактически проигнорил, да?

>4090 равнозначен в производительности хопперам ?

Как числодробилка, игровые карты примерно то же самое. Только меньше памяти и она помедленнее чуть. Нет жирных нвлинков, и оно не так хорошо стакается наивными методами (с не наивными уже даже есть синхронизация обучения через интернеты, которая медленнее на 5-10%).

>И что это за чудесная выгрузка ? И куда ?

В ram. У тебя трансформер обучается послойно, для обучения не нужен доступ ко всей памяти сразу. Ты загружаешь первый слой в видюху, батчем (как обработка контекста) он обсчитывает всю хуйню, сохраняешь активации в ram, можно хранить только латенты с выхода, а не все активации, но тогда придется потом лишний раз пересчитывать. Это так называемый gradient checkpointing.

По очереди грузишь слои, сохраняешь активации в ram.

Если у тебя скорость обработки контекста (была бы у тебя вся модель в гпу) идет дольше чем вес модели деленный на скорость шины, то ты вполне можешь так делать. Только нужен софт который умеет утилизировать шину, а то с этим обычно проблемы, когда ты пытаешь такое делать наивно в торче.

Потом считается ошибка на последнем слое, начинается обратное распространение. Оно идет с такой же скоростью, только наоборот, тоже послойно. Из ram тянутся активации и модель, градиент сохранять не надо, когда используется fused backward pass.

Параметры мы обновляем только лоры, и состояния оптимайзера тоже на ней, это все может быть на порядки менее объемно по памяти. А сама модель у нас допустим квантована с дообучением, она не будет сильно портить градиенты, как в обычной q-lora. Плюсом мы еще можем и инициализировать лору через svd-разложение модели, и заквантовать остаток, будет еще более высокая точность, метод называется q-pissa.

Если у тебя есть 512 рам, и более менее нормальная гпу, таким методом ты можешь фулл дипсик попробовать обучить. Будет медленно, но идти будет. Причем медленно будет не из-за памяти, а чисто из-за мощности гпу (которая фактически не сильно меньше всяких a100 h100). А если ты виртуоз работы с памятью, то можно вообще собрать риг на каких-нибудь 3080ti.

4бит кванты дипсика дообученные уже есть.

Опять же если все оптимизировать, можно пробовать и на 254 с меньшими квантами.

Инференс дипсика через ktransformers, разбивка шаред экспертов в гпу и всего остального на цпу. В итоге там примерно 16б висит в гпу и как бы 16б на цпу. То есть по скорости это прям в идеале упрощенно как крутить 16б на цпу. Проблемы только с обработкой контекста, ибо без него в производительность проца обычно скорость не упирается. Но обработку контекста тоже можно оффлоадить на гпу. Не знаю только реализовано ли это уже где-нибудь или нет.

Все это конкретно требует жесткого кодинга, влезания в куда-ядра скорее всего, для эффективного управления памятью.

Но это пруфает то, что проблема в общем-то не сколько в железе, а сколько в умении его использовать и отсутствии готовых инструментов.

> Чего-то нормального, чтобы не были утрачены мозги и знания оригинала, чтобы хорошо перфомило и что-то новое еще внесено - единицы.

> последний магнум неплох

> вся 123b модель низведена до уровня слоп карточки-кумбота

>Вот думаю дадут ли эти циферки что-то на практике

Не смотри на перплексити, это не показатель качества кванта

Математику не наебешь, чем меньше бит на вес тем хуже качество

Но конечно зависит от того правильная ли реализация

> Сука, прошла 1 минута 10 секунд он уже ответ высрал даже не читая на что отвечает.

На что угодно готов стрелку метнуть и как угодно глубоко заглотнуть, лишь бы не отвечать на вопрос третий пост подряд...

База треда: меньше 235@22 жизни нет.

> В картинкотредах продвинутый тюнинг уже как не первый год освоен

Где? Который год лишь сношение инцестмерджей, лоботомирующих стилелор и настакивание твикеров. Оригинальных моделей - единицы.

Но тейк про "продвинутых" засчитан, там хотябы пытаются а тут ленятся.

> можно хоть дипсик натренить, через оффлоад весов и состояний оптимизатора

Потребуется несколько терабайт рам, один шаг нормального батча займет денек-другой, таких шагов нужно хотябы 5 сотен.

> дипсик внезапно это примерно та же 32B, по вычислениям

При обучении проход будет идти не только по активным а по всем слоям группам экспертов.

> объединить это с квантизацией, обучать только лору

Лора/дора и прочие пефты сильно ударяют по качеству. Когда они еще обучаются поверх кванта - результат страдает еще сильнее. Для нормального обучения потребуется применять широченный спектр аугментации и подходов, а не просто собрать в кучу какой-то слоп и закинуть жариться.

Итог очень печален: для хорошего обучения ллм нужны: достаточно человекочасов квалифицированных специалистов, знания и опыт в конкретно этой области, много денег на компьют. Потому развлекаться этим могут только корпы, крупные институты и возглавляющие их ребята (тот же Мигель). Обычным людям доступен только файнтюн под узкоспециализированную задачу мелочи, или всякий копиум на qlora.

> Быстрее опен-корпы аккуратно внедрят доступные рпшные датасеты, предварительно хорошо отфильтровав и сделав правильную аугментацию

А что в этом плохого?

Но падажжи. То есть ты пришел в тред любителей и предъявляешь им за то, что они не могут быть так же эффективны, как корпы? ...А потом приводишь Магнум как пример хорошего тюна? Ты душевнобольной или даже на буднях не просыхаешь?

Ну на 4.6bpw кванте у меня больше врам на 2 гига чем на 4 кванте жоры, а реализация от самого турбодерьпа

Ой вру, это 4bpw от турбодерпа, 4.6 от местного шиза

Трудно сказать. Реализации SWA нет, контекст будет жрать существенно больше, чем на Жоре. Если ты планируешь использовать 4bpw, смело оставайся на Жоре, думаю. Если говорить про 5/6bpw, тут можно обсуждать. Экслама3 будет жрать больше контекстом, но в меньшем кванте будет больше перплексити. Там еще второй график есть, K Divergence, он более демонстративный

Про преобразование уравнений слыхал? В школе проходят обычно, классе в восьмом. Применяют функции, чтобы одно и то же уравнение представить в более коротком и удобном варианте. Так и в программировании одну и ту же единицу информации можно представить по-разному, более или менее эффективно. Понимаешь, к чему я веду?

Чому никто не делает дистил 0528 на квен 3-30/32?

> >А100

> 3090/4090 равны ей в производительности. И при грамотном оффлоаде они ее полностью заменяют.

Прими таблетки, ты нафантазировал себе невесть что.

То что ты описываешь, только без некорректного имплаинга, шизы и ошибок уже несколько лет реализовано в zero-3 дипспида. Правда эффективности и жизнеспособности ему это не сильно добавляет, скорости ужасающие и много компромиссов.

> gradient checkpointing

> fused backward pass

> q-lora. Плюсом мы еще можем и инициализировать лору через svd-разложение модели

Натащил в один пост всего что вспомнил чтобы казаться увереннее.

> Но это пруфает то, что проблема в общем-то не сколько в железе, а сколько в умении его использовать

Это пруфает что ты выебистый фантазер, пытающийся натянуть сову на глобус. Все что доступно и рационально - уже используется, а с твоими подходами будешь страдать дольше цикла обновления базовых моделей чтобы получить лоботомита.

> А что в этом плохого?

Ничего плохого, мы тут вообщето их и инджоим. Хотя есть и любители второ

> А потом приводишь Магнум как пример хорошего тюна?

Он действительно неплох, один из единиц на ларджа, который его не лоботомировал. Особенно явно это заметно при сравнении нескольких моделей подряд, другие совсем мертвы.

В зависимости от архитектуры модели, 4.6bpw - это ближе к Q_5_M / Q_5_L в Жоре. Ты даже на график посмотреть не можешь, почему ты вес сравниваешь с Q4?

> и контекст шифтинг

Лоботомия, которая должна умереть.

> и все оптимизации

Почему же тогда он в разы замедляется на контексте?

Для фулл-гпу на пределе эксллама все также безальтернативна. Когда уже жору нормально оптимизируют чтобы можно было сделать выбор в его пользу?

>Так и в программировании одну и ту же единицу информации можно представить по-разному, более или менее эффективно.

Жопой читаешь чсв дурачек, я ведь специально уточнил про реализацию, ты перечислил ее варианты и да это будет влиять на качество

Вот откуда у людей такое желание выебнуться на пустом месте? Лишь бы что то высрать, докопаться до любой мелочи

Дурачье

> Не смотри на перплексити, это не показатель качества кванта

Другого показателя, позволяющего измерить "качество" нет. Только перплексити и K Divergence. Сейчас все ломают головы над тем, как еще можно измерять "качество" квантов. Расскажешь ML ученым?

> Математику не наебешь, чем меньше бит на вес тем хуже качество

Чем меньше бит на вес, тем меньше квант занимает пространства на жестком диске. Все.

> Вот откуда у людей такое желание выебнуться на пустом месте?

Это был не выебон, а попытка помочь разобраться тебе и остальным, кто не понял. Пример с уравнением очень демонстративен и показетелен. Если бы я хотел выебнуться - просто сказал бы, что ты мудак и иди ты нахуй.

> Лишь бы что то высрать, докопаться до любой мелочи

Дурачье

Ты мудак и иди ты нахуй.

>4.6bpw - это ближе к Q_5_M / Q_5_L в Жоре.

Нет, это ближе к обычному 4KM, у меня тут лламаспп пишет в инфо при запуске сервера для 4КL сетки -

print_info: file format = GGUF V3 (latest)

print_info: file type = Q4_K - Medium

print_info: file size = 8.53 GiB (4.96 BPW)

Тоесть округляя будет 5 BPW

>K Divergence

Ну вот оно, по отклонению наиболее вероятных токенов как то показательнее смотреть

>Чем меньше бит на вес, тем меньше квант занимает пространства на жестком диске. Все.

Нет, есть прямая зависимость. Да она отклоняется в зависимости от сжатия, но через квант тут не перепрыгнешь

>Это был не выебон

Это была попытка выебнутся за чужой счет, жаль что ты этого не заметил

>Ты мудак и иди ты нахуй.

Ты мудак и иди ты нахуй.

> Тоесть округляя будет 5 BPW

У 5bpw GGUF кванта не тот же перплексити и K Divergence, что у 5bpw QTIP кванта (что под капотом у Экслламы), а это единственные на сегодняшний день способы замерить "качество кванта". У Экслламы эти показатели будут выше. Бесполезно сравнивать по bpw. Именно поэтому Турбодерп графики и выкладывает

> Нет, есть прямая зависимость. Да она отклоняется в зависимости от сжатия, но через квант тут не перепрыгнешь

Это правда, но оптимизировать это сжатие возможно, в чем и заключается сильная сторона QTIP

> Это была попытка выебнутся за чужой счет, жаль что ты этого не заметил

Вот так и помогай анонам в треде разобраться в чем-то, кроме запуска кобольда - сожрут живьем

> Ты мудак и иди ты нахуй.

Давай обнимемся и вместе пойдем~

>один из единиц на ларджа, который его не лоботомировал

Я мимопропердел, но хочу поделиться, что я пару дней катаю магстраль, потому что ванилька мистраля что-то приелась (https://huggingface.co/mradermacher/magstral-123b-i1-GGUF).

Внезапно, годно. На ванильке я все же периодически чуял запашки позитив байаса даже с джейлом, тут с этим вроде получше. В идеале я бы конечно хотел магнума где-нибудь 25-30%, но жру, что дают. А самая мякотка, что драфт модель продолжает давать ускорение, хотя и не такое большое, как на ванильке.

Следующей на очереди - вот эта йоба https://huggingface.co/mradermacher/Mistral-Large-Extra-i1-GGUF . Хуй знает, что от нее ожидать.

4km на ггуфе уже 4.88 BPW

Я не качал 4ks так что хз будет ли он равен 4.6

>У 5bpw GGUF кванта не тот же перплексити и K Divergence

Да я и не про это писал, просто уточнил анонам какие bpw у жориных 4 квантов

На что угодно готов лишь бы оставить последнее слово за собой и не идти нахуй, нинужноблядок краб.

>Потребуется несколько терабайт рам,

Нет, потребуется не сильно больше чем нужно чтобы влезла квантованная модель. Ну может на треть. Надо считать сколько там активаций/латентов набегает + лора. Но не так много.

>один шаг нормального батча займет денек-другой, таких шагов нужно хотябы 5 сотен.

Если нигде нет затыков, 1 шаг - если мы считаем за батч кусок контекста - равен примерно х3 времени от обработки этого самого контекста. х4, если пересчитываем состояние модели из активаций, когда не храним все активации. Дальше количество х растет если прям еще сильнее режем количество сохраненных активаций или если идут затыки где-то в процессе оффолада, либо если мелкий батч, и он успевает считать быстрее оффлоада.

>При обучении проход будет идти не только по активным а по всем слоям группам экспертов.

Но только в рамках одного слоя. И это требует только большей памяти, но не больших вычислений. Оффлоад решает первую проблему, вторая нас не беспокоит сама по себе. Даже если для контекста активны все эксперты, они активны в разные моменты и общее количество вычислений не растет.

В этом и ОГРОМНЫЙ плюс moe, которое тут принято люто хейтить почему-то. Видимо из-за непонимание его потенциалов.

>Лора/дора и прочие пефты сильно ударяют по качеству.

Ну для картинок как-то же научились не терять в качестве. Да и там мотивации особо нет делать какие-то йоба-методы, когда модели и так обычно влезают.

>Когда они еще обучаются поверх кванта - результат страдает еще сильнее.

Квант может быть дообучен сам по себе, и тогда он почти не просаживает качество. Я же специально про это писал. И получать такие кванты тоже можно так же послойно. Работы в эту сторону только начинают вестись открыто, но вам уже показали - это возможно, и это работает хорошо.

Методы типа q-pissa, а не примитивная q-lora, все это будет намного лучше и стабильнее. И открою секрет, многие корпораты сейчас для быстрых экспериментов сами не парятся и дообучают обычной лорой, закономерно сосут по качеству. А тут есть методы которые с квантовкой дадут качество выше обычной лоры. Да и ту же обычную лору тоже надо стабилизировать, по-разному нормировать градиенты для матриц a b, разные скорости обучения, моментумы, для картинок это все откалибровано на практике, и если не переносится прямо, то уже понятно куда смотреть и что крутить.

>Прими таблетки, ты нафантазировал себе невесть что.

СЕМПЛЕРОШИЗ ХУЙ ПОСОСИ

Ты уже обосрался жидко с теплотрубками, когда усирался пол треда что невозможно чтобы они работали не так перернутыми, а потом оказалось что возможно, сразу чет сделал вид что этого не было и ушел в игнор.

И так каждый раз. В каждом споре ты нес полную хуйню с умным видом что вокруг вседебилы.

>уже несколько лет реализовано в zero-3 дипспида

Там нихуя нет, а то что есть работает неоптимально, так как это универсальный инструмент без специализации.

Годится только как референс для дальнейшей доработки.

>Все что доступно и рационально - уже используется

Ага, весь софт уже написан, нового нельзя сделать, потому что уже все придумано что возможно придумать. Ебать логика у дебила.

> оффлоад

Это DeepSpeed называется и оно очень медленное. Лоры будешь тренить сутками? Нахуй не надо.

Потому что

- Что вошло, то вышло.

Вступительное сообщение вошло, ну и я уж точно не сру абзацами лол

Потому что базовая модель любит такое форматирование. Нужно свое форматирование энфорсить в карточке, первым сообщением или подправлять первые пару-тройку ответов.

С любовью, анон пресета

> пару дней катаю магстраль

Надо будет попробовать, иногда магнум ну слишком заебывает своими фишками, а ванила очень унылая. Сам померджить не пробовал что хочется?

> что драфт модель продолжает давать ускорение, хотя и не такое большое, как на ванильке

Какую модель драфтом используешь? Все в видеопамяти или с выгрузкой, но профиты перевешивают потерю врам на драфт?

> потребуется не сильно больше чем нужно чтобы влезла квантованная модель

Для пефта поверх кванта, это совсем мертвое будет. Особенно для мое и с васян-датасетами, половина экспертов просто помрет.

> равен примерно х3 времени от обработки этого самого контекста

На самом деле больше, но даже такое с фулл-цпу скоростью обработки в ~30 т/с при обучении на 16к с нормальным батчем займет тот самый день или больше. Даже если разогнать это видюхой до 80-100 т/с, что получается с мощными картами при выгрузке и принять что операции идеально асинхронны и обновляться веса будут в фоне - все равно времена страшные.

> И это требует только большей памяти

Даже один слой дипсика с градиентами не влезет в врам десктопных карточек. Только квант и пефт матрицы.

> Даже если для контекста активны все эксперты, они активны в разные моменты и общее количество вычислений не растет.

В разные моменты они активны при предсказании нового токена. На мое контекст считается дольше, чем для плотных моделей с числом параметров равных их активациям, совсем уж сильно сэкономить не получится.

> которое тут принято люто хейтить почему-то

Уже несколько тредов хвалебных од большому квену, наоборот любят.

> для картинок как-то же научились не терять в качестве

Для картинок ты обучаешь что-то конкретное, используемое в ограниченном наборе. И натрененные лорой вещи и в половину не такие гибкие и удобны к использованию, как то что заложено в модель изначально. Речь про объекты а не стили если что.

> Квант может быть дообучен сам по себе

Суть кванта в замороженном представлении весов в виде более экономного сохранения с минимизацией потери точности от этой операции. Qat - тренировка полновесной модели с оценкой потерь от ее кванта для более эффективного квантования потом, она проводится с полными весами.

Не понимаю про что ты там пишешь.

> СЕМПЛЕРОШИЗ ХУЙ ПОСОСИ

Ты зря агрессируешь на вполне уместные указания, ведь насрав несколько полотен про то какие все плохие, сам по сути ничего полезного не сказал. А вспоминания протыков детектируют в тебе шизика, но это понятно было сразу.

> Там нихуя нет, а то что есть работает неоптимально

Хотябы ознакомился что это такое.

> Ага, весь софт уже написан, нового нельзя сделать

Софт пишется и используется, как только открывают действительно работающие методы - их сразу имплементируют. Но поехавший нетакусик, надергавший верхов, не сможет внести чего-то полезного.

Возьми и сделай, по твоим одам суперэффективное обучение доступно лежит на поверхности и обычному человеку со средними знаниями. Почему вместо фантазий ты просто не реализуешь то, о чем затираешь?

>Сам померджить не пробовал что хочется?

Лень мне. Качать две модели в оригинальных весах, потом мержить их непонятно как. Потом еще и разбираться как квантовать, или того хуже - выгружать на хаг и просить... А можно же все это время гунингом заниматься.

>Какую модель драфтом используешь

А я ж писал уже несколько раз. Даже просил в гайд добавить, но, как обычно, на мои сообщения все забили хуй, по видимому. Mistral-7B-Instruct-v0.3-Q4_K_S. Я врам боярин, все в видеопамяти, четвертый квант идеально влезает с 30к контекста в 3070ти. Пробовал шестой на 3060 - прибавки не наблюдал.

Анонцы, а как вы грузите с обнимашкилицо несколько частей? Пробовал их мерджить при помощи cat и какая-то хуйня будто ломалась

>Пробовал их мерджить при помощи cat и какая-то хуйня будто ломалась

Если каждая часть имеет расширение gguf, то мержить их нужно через llama-split. Бартовски это любит. А вот Радемахер просто разбивает, эти части нужно клеить.

Тем не менее, за свою цену — не так плохо, ИМХО.

Но учти, что раньше люди оставляли комментарии, что не у всех получалось завести P104 + 30xx/40xx нормально на одной системе.

Придется с драйверами немного покопаться.

Алетейан ест гречу! Мой мир не будет прежним! ='(

Один купил две по 32, но оказалось, что две по 16, и не все так радужно. Но 32-гиговые модели протестить можно.

Другому едут.

Я еще не заказал.

Вроде все.

>Но учти, что раньше люди оставляли комментарии, что не у всех получалось завести P104 + 30xx/40xx нормально на одной системе.

У меня пингвин, про них, вроде такого не писали. Или речь про железо как таковое?

> грузите с обнимашкилицо несколько частей

Если речь про скачивание - huggingface-cli, документировано и оче удобно. Если про запуск - у современных разбитых моделей не нужно ничего склеивать, просто в беке дай путь до первого куска, а остальные оно само подтянет.

Это раньше давно били кусками, сейчас возможность нескольких файлов - можно сказать что часть стандарта.

Это говно по другим причинам медленное.

Чисто физически тренировка не может быть медленнее, если время вычисления одной итерации дольше чем обмен по шине всех весов модели. Если все написано идеально. Так-то даже у корпоратов дефолтная тренировка не полностью утилизирует гпухи. Но в это лезть не надо, главное грамотно написать вот именно эту часть которая будет оффлоадить веса, так чтобы весь остальной процесс не заметил подмены.

Как примерно рассчитать время на итерацию я написал. Бери обработку контекста за точку отсчета, и накидывай х3-4 по времени. Ах да, ну и главное за это время мы же оффлоадим модель 2 раза, +ативации +веса лоры если они тож оффоадятся со своими состояниями оптимайзера. Ну то есть считаешь ожидаемое время итерации, умножаешь модель на 2-3, делишь на скорость шины. Накидываешь батч пока оно не станет равным. В худшем случае скорость шины ограничивает нас всего десятком-другим секунд на жирную модель типа дипсика. Никак не днями, лол.

Считать надо от дефолтного торчетренера, а не всяких интересных ускорялок.

Но тут, кста, есть очень, я даже выделю ОЧЕНЬ ДОХУЯ интересный момент. Можно довольно не больно внедрить всякие ускорялки для инференса квантов в процесс обучения. Видишь ли, если представить, что мы не хотим обновлять веса самой модели (а мы хотим обновлять только веса лоры), то мы можем вычислить градиент по модели очень просто, буквально также, как мы вычисляем прямой проход, он же инференс, только мы меняем порядок слоев, транспонируем матрицы (тоесть почти ничего сложного не меняем) и главное запоминаем состояния активаций всех нелинейностей с прямого прохода. То есть запоминаем активации всех функций активации, активные эксперты, и т.п.

И когда мы так разворачиваем модель, если это все в нее подставить для вычисления производных (для этого да, надо будет чуть код допилить) либо же налету вычислять как в gradient checkpointing. То получится честный градиент, который был посчитан не медленным торчем, а тем самым быстрым сишным кодом или в чем там оно у тебя считается, не важно.

То есть, можно не использовать торчи и всю эту медленную срань, чуток модифицировать код для быстрого инференса и считать им и прямой проход и обратный прямо в процессе обучения. И сам код при этом как бы и знать не будет что какое то обучение идет.

Если ты не семплерошиз, а действительно шаришь в машобе, то ты должен был заметить, что градиент то мы так посчитали, а параметры нам обновить все еще как-то надо. Так вот для этого уже можно запустить торч, который будет обновлять только лору. Он будет работать параллельно, и ему нужен мостик из нашего быстрого кода. По этому мостику будет передаваться только просчитанный градиент и активации. Собственно, на основе этого торч и обновит лору. А потом лору тоже надо быстренько подгрузить в наш быстрый код. Опять же, виртуозной работой с памятью, можно не перегружать ничего с места на место. Если вся лора лежит на гпу, если оффлоадится, то в принципе похуй.

Я наверное сложно и довольно бредово это объясняю. Но суть в том, что переделать код для быстрого инференса модели, так чтобы он работал параллельно с торчем, и считал все тяжелое заместо него, на самом деле, не так уж и сложно. Меняется только глобальная логика, а не основа.

Ускоряем еще в несколько раз как с куста. Или во сколько раз там твой код быстрее инференсит модель чем торчевая реализация?

>Для пефта поверх кванта, это совсем мертвое будет.

С чего бы, если есть дообученные в процессе квантования, которые почти не теряют точность? Ты так старательно игноришь этот момент.

>Особенно для мое и с васян-датасетами, половина экспертов просто помрет.

Там кстати да, надо учесть куда воткнуть эти хитрые лоссы у моешек. А то эксперты действительно отомрут. Но не то что бы это было великой проблемой.

>На самом деле больше

Я выше написал как можно получить вообще х2 практически, от скорости самого быстрого уже имеющегося кода для инференса.

>с фулл-цпу скоростью обработки

Цпу тут вообще не должен участвовать в процессе. Но в принципе, если сделать как я написал, и дефолтная скорость тебя устраивает...

>Даже один слой дипсика с градиентами не влезет в врам десктопных карточек.

Один слой не монолитный, его если не по тензорам можно разбить, так по тем же экспертам mlp-слои вполне себе можно поделить, чтобы не приходилось ничего лишнего подгружать. Но геморно это, да, это не когда за тебя торч сам все сделает, не для среднего ума задача.

Но опять же ФИЗИЧЕСКИХ ОГРАНИЧЕНИЙ НЕТ, только отсутствие софта.

>В разные моменты они активны при предсказании нового токена. На мое контекст считается дольше, чем для плотных моделей с числом параметров равных их активациям, совсем уж сильно сэкономить не получится.

Нет, ну тут ты уже очевидно неправ. Нет разницы между предсказанием токена и обработкой контекста, с точки зрения количества вычислений. Это количество всегда будет тем же, как если бы ты условно проехался по контексту в режиме предсказания одного токена за раз. Количество матричных вычислений между тем и тем будет идентично. Разница только в работе с памятью.

Если ты имел ввиду именно память, то да, для обработки контекста мы всегда как бы подгружаем плотную модель. Но компьюта она жрет намного меньше всё равно и считается быстрее.

>Для картинок ты обучаешь что-то конкретное, используемое в ограниченном наборе. И натрененные лорой вещи и в половину не такие гибкие и удобны к использованию, как то что заложено в модель изначально. Речь про объекты а не стили если что.

Работа с датасетами и общее целеполагание тренировки это вообще другой вопрос, я его и не собираюсь затрагивать.

Я говорю, был бы фундамент в виде возможности делать тренировку максимально эффективно (а я примерно описал, что это самое "максимально эффективное" должно из себя представлять) то цели бы нашлись сами собой. Сначала эксперименты, которые дают на выходе рофляную хуету. Ну а там когда сможем целый дипсик тюнить, уже может и не такую хуету...

Какая-нибудь шиза типа тренировки вообще в процессе общения с моделью, агентская система которая сама себя обучает. И все это на твоем компе с полновесной моделью, а не у корпоратов!

Влажные фантазии, конечно, но не такие уж и невозможные. А если добавить сюда распределенное обучение... У кого слабое железо, вообще может участвовать только в процессе генерации, валидации данных, где даже сама исходная большая модель не нужна. Полная утилизация потенциала!

>Qat

>Не понимаю про что ты там пишешь.

Про это и пишу. Что нам мешает не только использовать такой квант, а еще и учить по нему? Если он сам не теряет точности (заявляют, дипсик в 4 битах - >98% точности), то и градиент он не портит. При этом мы его не трогаем, а учим лору (или что-то более эффективное), он в процессе не ломается, ведет себя почти как полноценная модель.

>Ты зря агрессируешь на вполне уместные указания

А ты зря пытаешься делать вид, что зашкваренное имя семплерошиз не имеет к тебя никакого отношения.

>ведь насрав несколько полотен про то какие все плохие, сам по сути ничего полезного не сказал.

Буквально семплерошиз проецирующий. Это от тебя 0 пользы, только бесполезная критика, которая еще и как правило ошибочна.

>вспоминания протыков

Хоть бы так не палился.

>Хотябы ознакомился что это такое.

Я и без тебя знаю, это говно которое никто на практике не юзает. Догадываешься почему?

>как только открывают действительно работающие методы - их сразу имплементируют

Лол.

>Возьми и сделай

>Почему вместо фантазий ты просто не реализуешь то, о чем затираешь?

Ага, щас только штаны подтяну. И дособираю 3д принтер, и починю стиралку, и починю мамкин телек... Думаешь у меня других дел нет? И нет, я не заставляю лично тебя этим заниматься, и сам может быть не собираюсь бросаться и делать, но я просто рассказываю, как можно было бы сделать, и какие есть теоретические пределы, достичь которых можно относительно малой кровью.

>по твоим одам суперэффективное обучение доступно лежит на поверхности и обычному человеку со средними знаниями.

Да, примерно все так, а дебил семлерошиз спорит что все уже сделано, и оптимизировать некуда. Все сделали корпораты, и лучше и проще них ничего не придумать.

Для тебя конечно это недоступно, потому что ты тупой шиз.

Если расширение вида 00001-of-0000X.gguf, то через тулзу, например:

huggingface-cli download "bartowski/Behemoth-123B-v2-GGUF" "Behemoth-123B-v2-Q6_K_L/Behemoth-123B-v2-Q6_K_L-00001-of-00003.gguf" "Behemoth-123B-v2-Q6_K_L/Behemoth-123B-v2-Q6_K_L-00002-of-00003.gguf" "Behemoth-123B-v2-Q6_K_L/Behemoth-123B-v2-Q6_K_L-00003-of-00003.gguf" --local-dir "your/local/dir/to/model/Behemoth-123B-v2-GGUF" --max-workers 1

Если мрадермахеровские .gguf.part1ofX, то первую часть качаешь как угодно, для остальных частей последовательно делаешь

curl "downloadlink"

получаешь прямую ссылку, копируешь и выполняешь

curl "directlink" >> yourmodel.gguf.part1ofX

Может можно и в один шаг с использованием редиректа (какой-то флаг курла, вроде -L?), но мне страшно, что он насрет логом редиректа в модель, поэтому вручную прямую ссылку получаю.

>пингвин

Из какой затхлой дыры вообще вылез этот сленг? Последние тредов 10-15 мне прям глаза режет этот "пингвин" или "пингвинятник", подозреваю, это все время ты и пишешь. На двощах всегда писали линух, красноглазик, линуксоид, прыщи и пр, но не ебаный пингвин.

Чето в голос с этого.

Просто возьми и сделай. Покажи. Пишешь бредовые простыни, выебываешься и ноешь, так докажи что не просто выебистое хуйло с шизой и манямиром вместо знаний.

Эта хуета про то, как все неправильно делают, и поочередной обработкой уже полтора года здесь от тебя всплывает и каждый раз только визг да вскукаерки.

Все для этого у тебя есть, 3090=А100, нейронка код напишет, оптимизаций наделали, тренировка эффективна, датасеты в публичном доступе. Берешь и оформляешь, демонстрируя насколько хороши твои фантазии.

> а дебил семлерошиз спорит что все уже сделано, и оптимизировать некуда

Чел, я обычный мимоанон, который тупо спросил у тебя, что именно ты хочешь затюнить. За 6 ебаных постов, три из которых влажные полотна с самовосхвалением, ты так и не ответил. И, видимо, не ответишь. Я не говорил, что все уже сделано, а сказал, что большинству, и мне в том числе, достаточно базовых моделей для своих задач, и я не вижу смысла изобретать велосипед

Ты не путай инференс и тренировку. При тренировке оффлоад сильно медленнее инференса.

> всяких интересных ускорялок

Шизло, дипспид в зеро-2 и мегатрон - это база для претрейна любой модели, не влезающей в одну карту.

Аноны, какие есть локальные нейронки/инструмент, которые могут конвертировать подкасты в текст. Надоело джва часа смехуёчки слушать. Я лучше их прочитаю за полчаса.

ты тредом ошибся. Ищи stt/tts треды. Или гугли эти же слова.

Whisper

>>пингвин

>Из какой затхлой дыры вообще вылез этот сленг? Последние тредов 10-15 мне прям глаза режет этот "пингвин" или "пингвинятник", подозреваю, это все время ты и пишешь.

Не, я тут только с позапрошлого треда. А откуда - так с его логотипа же. А чего глаза то режет? Тем, что не оскорбительное, а нейтральное слово используется? Так мне как-то пофиг, я не с досок.

>Эта хуета про то, как все неправильно делают, и поочередной обработкой уже полтора года здесь от тебя всплывает и каждый раз только визг да вскукаерки.

Лол, а кто это у нас, утверждая что вся эта хуета нинужна, первым же побежал с ебалом сойджека форсить ktransformers и сплиты тензоров, уже после того как я говорил про то что легко можно раскидывать шаред-экспертов между гпу и цпу, так чтобы все оптимально работало?

Дойдет у кодеров дело, и так же побежишь форсить оффлоад. Ведь очень удобно пользоваться всем готовеньким, да? И кукарекать что все дебилы, один ты молодец, а вокруг все шизики.

>Просто возьми и сделай.

Я не кодер. Это во первых.

Во вторых, я пишу всё не для таких как ты, которые только могут обосрать всё и сами обосраться, не привнеся в тред ничего нового, даже идейно.

Ну и в третьих у меня одного физически не настолько много ресурсов.

Мои полотна предназначены для того, чтобы заинтересовать того, кто по заветам семплерошиза думал что домашний тюнинг невозможен. В то время как на самом деле, вопреки убеждениям, в память он не так уж и упирается, и то что есть реализации сильно быстрее торча, которые, по крайней мере не надо с нуля писать и можно внедрить в обучение. Не многие в курсе, что расчет градиентов можно делать тем же кодом, который делает инференс, с минимальными изменениями. Чисто исходя из математики.

>3090=А100

Пикрил.

>спросил у тебя, что именно ты хочешь затюнить. За 6 ебаных постов, три из которых влажные полотна с самовосхвалением, ты так и не ответил.

На первый твой вопрос тебе был дан исчерпывающий ответ. Ты его проигнорировал, и был послан нахуй. За те же мои 6 4 постов, я дал на него еще более исчерпывающий ответ. Угадаешь, куда тебе все таки стоит пройти?

Если ты не ответишь на аргумент про квантизацию с дообучением - будешь пидорасом. Давай, причина, почему это нинужно в треде где буквально все пользуются квантами?

>Я не говорил, что все уже сделано, а сказал, что большинству, и мне в том числе, достаточно базовых моделей для своих задач, и я не вижу смысла изобретать велосипед

Так ты писал буквально что все уже придумано все полезные методы уже давно имплементированы.

Если не ты, то нехуй лезть под руку и отвечать на вопросы, которые были адресованы семплерошизу. Чтобы... потом утверждать что ты не он?

По поводу того зачем вообще нужно обучение ллм. Ну очевидно, мне казалось что задавать этот вопрос в этом треде это рофл какой-то. И по моему за 4 поста я раз 10 пояснил или подразумевал, что волшебный великий файнюн за 1 раз если ты освоишь тренировку из жопы сам не родится. Для этого нужен фундамент из готового кода, оптимизаций, которые обеспечат низкий порог входа. Ничего из этого в этом треде на данный момент не существует, как и в сообществе любителей. В отличии от картинкомоделей.

Когда есть накопленный опыт, достаточное количество экспериментов, ты берешь, и файнтюнишь уже фулл дипсик, как лучшую на сегодня опенсорс модель. И возможно, делаешь это не на арендованных серваках, а даже на ссаной 3090, попердев недельку-другую. Получая в итоге что-то более интересное чем 12б лоботомит. Даже которого ты и с обычным подходом на своей 3090 обучить не сможешь.

>Ты не путай инференс и тренировку. При тренировке оффлоад сильно медленнее инференса.

Долбоеб? Каким образом он будет медленнее, в случае когда скорость прогрузки всей модели не медленнее просчета одного батча? Наоборот при инференсе оффлоад не имеет смысла. Только на контекст.

>Шизло, дипспид в зеро-2 и мегатрон - это база для претрейна любой модели, не влезающей в одну карту.

Это кринж, а не база. Говно которое не работает и не делает то что надо.

Там вообще пытаются полную тренировку запускать, оффоадят состояния оптимайзера, всю хуйню. От того оно и медленное. Нахуя я тут распинался доказывая что это всё не нужно? Когда можно обучать q-lora, а не фулл модель. Когда квантованная модель может быть дообучена qat, и не потеряется в качестве, когда вместо q-lora можно сделать q-pissa, (но надо уже qat часть делать самому), в той же q-pissa можно вместо лоры взять dora, тоже будет лучше.

И этим твоим кривым дипспидом, оффлоадить саму лору из торча, вместе с ее оптимизатором. Там уже не будет таких затыков. И параллельно должен вестись расчет градиентов/активаций в оптимизированном коде (уже на 95% готовом), с нормально написанным оффлоадом.

Только так, и никак иначе может выглядеть нормальный файнтюн дипсика на одной 3090/4090. Просто тут парочка шизов пытаются доказать, что это либо невозможно, либо будет чудовищно медленно. Я же привел теоретическое обоснование того, как такая тренировка может и полностью утилизировать ресурс гпу, и быть норм по качеству, за счет qat. Видимо, у шизов с контекстом совсем беда, и они не понимают, какой потенциал имеют все эти методы, если их объединить и реализовать лучшее что имеется в статьях на сегодня.

Например, для того чтобы реализовать q-pissa для sdxl, вообще кодить не надо. То есть прямо сейчас можно обучать лору на фп8 sdxl в качестве измеримо выше, чем будет если просто сконвертить фп8. Путем небольшого шаманства это делается. Еще и результирующая лора при обучении ведет себя намного стабильнее, больше как полноценный файнтюн.

Конечно, в ллмках все сложнее, и ради дипсика надо дохуя всего внедрять и писать, чтобы все методы на нем завести. Но это возможно, и ничего этому не мешает.

У вас есть идеи получше?

Ах да, все ваши идеи это же:

>нинужна!!!

>ту придумал хуйню

>сделай сам, я делать ничего не буду

Так остальные тоже либо всегда не оскорбительные, либо когда употребляются в нейтральном контексте: это просто эмоциональные якорьки в предложении, делают пост более интересным.

А твой термин я тут за все годы сидения на двощах вообще никогда не видел, поэтому и режет. Мне даже гуглить пришлось, чтобы подтвердить догадку. Ну раз залетный, то понятно.

Лучше сказать какой ты шизик не смог бы никто.

Как ты, блять, живешь вообще? Сначала признаешься что хуй собачий и нигде ничего, но после тысячи оправданий почему не способен что-то сделать, продолжаешь визжать "это не правильно и надо вот так, быстро сделайте мне".

Ну ты то у нас не хуй собачий, который только срать под себя может, сразу видно.

>но после тысячи оправданий почему не способен что-то сделать

Так, подожди, а что я должен был сделать и кому должен, мм, хуйлуш?

И почему ты не пошел нахуй после трижды проигнорированных аргументов, пидорас? Я же специально написал, будет проигнорирован прямой аргумент про кванты из моего поста, будешь назван не только семплерошизом, а еще и пидорасом.

>визжать "это не правильно и надо вот так, быстро сделайте мне".

Правильного никто не показал чёт. Так что визги только в твое голове, шизло.

Ну это от задач зависит. "Бесконечный" РП в стиле жвачки, где важнее динамика, квантование выглядит адекватным решением, потому что модель хоть и не помнит точные детали, но помнит, что там примерно было. Но бывает такое, когда хочется бритвенной точности.

Ну вот сама гемма забьёт тебе память 14-15 Гб, а это только модель. Тебе место ещё под контекст нужно. Хватит ли тебе этого? Если я правильно помню, всего лишь 8к контекста уже 3 Гб отнимет. И не забывай, что старые карты сильно руинят скорость.

Я пробовал втыкать старое говно. Это лучше, чем в рам, но драматическая потеря в скорости генерации меня удивила. Хоть и юзабельно.

Да пожалуйста. Только готовый датасет здоровенный на хорошем русском языке дай.

В этом основная, блядь, проблема.

Даже если есть мощности, нет датасетов.

Вот, это уже хорошее замечание. Готовых приличных датасетов не завезли, это да.

Но мое имхо, что если даже прям взять синтетику из того же русикомерджа, и запихать ее в здоровенную модель, то отупеть она не успеет, а стиль изменится в интересную сторону. Или нафильтровать логов с нового опуса...

Так-то пространство для экспериментов есть. Но пока никто не тренируют модели даже чисто просто так по приколу, мотивации ни для кого нет как-то шевелиться. Хотя для не синтетических датасетов даже обладать железом не надо.

Да даже в картинках в этом плане тухловато, я как-то предлагал дать мне готовый датасет, и я бы поставил его на 3090 хоть на месяц, но чет желающих было примерно ноль целых хуй десятых. Никто не хочет заниматься грязной работой просто так, а кто может, тот и сам тренить уже умеет и имеет мотивацию на пердолинг.

>Алетейан ест гречу! Мой мир не будет прежним! ='(

В чём мем? А то я похоже не в теме.

Спасибо анону, кто по поломанному телефону скинул инструкцию по выгрузке тензоров. Накатил Qwen3-235B-A22B-128K-UD-Q2_K_XL на 3x3090.

> Выяснилось, что чередовать тензоры при выгрузке не нужно. Наоборот, лучше выгрузить все по по порядку, на сколько VRAM хватает.

> Вот текущий вариант ключа: --overridetensors "[^\.12][0-9].ffn_.*_exps.=CPU"

> Первая часть остается на GPU, только хвост списка идет на CPU (начиная с 30-го). Дает еще +4 t/s, примерно.

Это согласуется с моими наблюдениями. Кроме того, в этом случае, где-то на треть вырастает скорость обработки контекста. К этому решению я пришёл по совету GPT, когда спрашивал его, как можно ещё оптимизировать выгрузку тензоров для более быстрой обработки контекста. Когда я его спросил, почему он считает, что это поможет, он дал такое пояснение:

Первые блоки обрабатывают весь контекст, т.е. от начала до конца.

Поздние блоки видят уже сильно «сжатое» представление (после внимания и FFN).

🔧 Поэтому:

- первые блоки обрабатывают наибольшее количество токенов,

- их offload на CPU особенно тормозит prompt-eval,

- возврат их на GPU ускоряет обработку контекста сильнее всего.

- Это самое выгодное место для ускорения при ограниченном VRAM.

📌 Это особенно важно при context > 8k, где early layers тратят больше времени.

Остальные блоки (глубже) могут оставаться на CPU — их вклад в prompt-eval меньше.

(конец цитаты GPT)

Если я правильно понимаю, первые слои активнее используются при обработке контекста, а последние слои при генерации токенов. Так что, вероятно, можно было бы попробовать выкидывать на CPU начало/конец в зависимости от того, хочешь более быструю обработку контекста или же более быструю генерацию.

Ниже кину, какие у меня цифры получились без выгрузки тензоров, с полной выгрузкой ffn_up_exps и с выгрузкой ffn_up_exps с последних слоёв. Просто чтобы было.

Стоит упомянуть, что последний вариант требует пердолинга и подгона под конкретную систему - из-за частичной выгрузки тензоров нагрузка на видеокарты распространяется неравномерно, поэтому надо тонко манипулировать значением --tensor-split, смотря где недогруз, а где с OOM падает и постепенно докидывать тензоры на GPU, пытаясь поймать момент, когда они все забиты под завязку и всё ещё не валится с OOM.

-----

Без выгрузки тензоров:

--gpu-layers 75 (всего 95 слоёв)

Без контекста:

prompt eval time = 8133.59 ms / 814 tokens ( 9.99 ms per token, 100.08 tokens per second)

eval time = 27368.17 ms / 270 tokens ( 101.36 ms per token, 9.87 tokens per second)

Контекст ~8k:

prompt eval time = 68697.59 ms / 8104 tokens ( 8.48 ms per token, 117.97 tokens per second)

eval time = 220358.31 ms / 898 tokens ( 245.39 ms per token, 4.08 tokens per second)

-----

Полная выгрузка ffn_up_exps

--gpu-layers 95 -ot ".ffn_up_exps.=CPU"

Без контекста:

prompt eval time = 12528.40 ms / 814 tokens ( 15.39 ms per token, 64.97 tokens per second)

eval time = 19056.69 ms / 235 tokens ( 81.09 ms per token, 12.33 tokens per second)

Контекст ~8k:

prompt eval time = 108598.35 ms / 8104 tokens ( 13.40 ms per token, 74.62 tokens per second)

eval time = 58995.70 ms / 680 tokens ( 86.76 ms per token, 11.53 tokens per second)

-----

Выгрузка ffn_up_exps с 32 по 93 слои (с 0 по 31 крутится на GPU)

--gpu-layers 95 -ot "blk.32.ffn_up_exps.=CPU,blk.33.ffn_up_exps.=CPU,[...вот тут ещё 60 записей через запятую т.к. регулярка не сработала и лень разбираться почему],blk.93.ffn_up_exps.=CPU"

Без контекста:

prompt eval time = 9832.31 ms / 814 tokens ( 12.08 ms per token, 82.79 tokens per second)

eval time = 16760.85 ms / 257 tokens ( 65.22 ms per token, 15.33 tokens per second)

Контекст ~8k:

prompt eval time = 87140.53 ms / 8104 tokens ( 10.75 ms per token, 93.00 tokens per second)

eval time = 107672.88 ms / 1272 tokens ( 84.65 ms per token, 11.81 tokens per second)

> Выяснилось, что чередовать тензоры при выгрузке не нужно. Наоборот, лучше выгрузить все по по порядку, на сколько VRAM хватает.

> Вот текущий вариант ключа: --overridetensors "[^\.12][0-9].ffn_.*_exps.=CPU"

> Первая часть остается на GPU, только хвост списка идет на CPU (начиная с 30-го). Дает еще +4 t/s, примерно.

Это согласуется с моими наблюдениями. Кроме того, в этом случае, где-то на треть вырастает скорость обработки контекста. К этому решению я пришёл по совету GPT, когда спрашивал его, как можно ещё оптимизировать выгрузку тензоров для более быстрой обработки контекста. Когда я его спросил, почему он считает, что это поможет, он дал такое пояснение:

Первые блоки обрабатывают весь контекст, т.е. от начала до конца.

Поздние блоки видят уже сильно «сжатое» представление (после внимания и FFN).

🔧 Поэтому:

- первые блоки обрабатывают наибольшее количество токенов,

- их offload на CPU особенно тормозит prompt-eval,

- возврат их на GPU ускоряет обработку контекста сильнее всего.

- Это самое выгодное место для ускорения при ограниченном VRAM.

📌 Это особенно важно при context > 8k, где early layers тратят больше времени.

Остальные блоки (глубже) могут оставаться на CPU — их вклад в prompt-eval меньше.

(конец цитаты GPT)

Если я правильно понимаю, первые слои активнее используются при обработке контекста, а последние слои при генерации токенов. Так что, вероятно, можно было бы попробовать выкидывать на CPU начало/конец в зависимости от того, хочешь более быструю обработку контекста или же более быструю генерацию.

Ниже кину, какие у меня цифры получились без выгрузки тензоров, с полной выгрузкой ffn_up_exps и с выгрузкой ffn_up_exps с последних слоёв. Просто чтобы было.

Стоит упомянуть, что последний вариант требует пердолинга и подгона под конкретную систему - из-за частичной выгрузки тензоров нагрузка на видеокарты распространяется неравномерно, поэтому надо тонко манипулировать значением --tensor-split, смотря где недогруз, а где с OOM падает и постепенно докидывать тензоры на GPU, пытаясь поймать момент, когда они все забиты под завязку и всё ещё не валится с OOM.

-----

Без выгрузки тензоров:

--gpu-layers 75 (всего 95 слоёв)

Без контекста:

prompt eval time = 8133.59 ms / 814 tokens ( 9.99 ms per token, 100.08 tokens per second)

eval time = 27368.17 ms / 270 tokens ( 101.36 ms per token, 9.87 tokens per second)

Контекст ~8k:

prompt eval time = 68697.59 ms / 8104 tokens ( 8.48 ms per token, 117.97 tokens per second)

eval time = 220358.31 ms / 898 tokens ( 245.39 ms per token, 4.08 tokens per second)

-----

Полная выгрузка ffn_up_exps

--gpu-layers 95 -ot ".ffn_up_exps.=CPU"

Без контекста:

prompt eval time = 12528.40 ms / 814 tokens ( 15.39 ms per token, 64.97 tokens per second)

eval time = 19056.69 ms / 235 tokens ( 81.09 ms per token, 12.33 tokens per second)

Контекст ~8k:

prompt eval time = 108598.35 ms / 8104 tokens ( 13.40 ms per token, 74.62 tokens per second)

eval time = 58995.70 ms / 680 tokens ( 86.76 ms per token, 11.53 tokens per second)

-----

Выгрузка ffn_up_exps с 32 по 93 слои (с 0 по 31 крутится на GPU)

--gpu-layers 95 -ot "blk.32.ffn_up_exps.=CPU,blk.33.ffn_up_exps.=CPU,[...вот тут ещё 60 записей через запятую т.к. регулярка не сработала и лень разбираться почему],blk.93.ffn_up_exps.=CPU"

Без контекста:

prompt eval time = 9832.31 ms / 814 tokens ( 12.08 ms per token, 82.79 tokens per second)

eval time = 16760.85 ms / 257 tokens ( 65.22 ms per token, 15.33 tokens per second)

Контекст ~8k:

prompt eval time = 87140.53 ms / 8104 tokens ( 10.75 ms per token, 93.00 tokens per second)

eval time = 107672.88 ms / 1272 tokens ( 84.65 ms per token, 11.81 tokens per second)

Да. Мало того что Лев Толстой, так еще и не ною о том, что каждый здесь мне чем-то обязан и все быстро должны бежать реализовывать мои хотелки.

> а что я должен был сделать

В дурку обратись. Посмотри на свои посты - безумный поток бреда с отрицанием реальности, заявлениями "как надо", перемешанный с рассказами как тебя отчим ебал.

> проигнорирован прямой аргумент про кванты

Тебя выше разъебали по частям, на что в ответ начал гнать шизу и "яскозал" в качестве аргументов.

Кто-нибудь из вас для пользуются топ к? Вроде бы не замечал разницы и необходимости, но мало ли.

> Но мое имхо, что если даже прям взять синтетику из того же русикомерджа, и запихать ее в здоровенную модель, то отупеть она не успеет

Про какую здоровенную модель речь? Еще как отупеет, подхватив убогие структуры, обилие синтаксических ошибок и игнор важного.

Есть дампы с проксей, откуда можно нафильтровать относительно свежих чатов жемини на русском. Но сырьем качество там оче неоче, тем не менее, потихоньку добавляется в публичные датасеты.

> я бы поставил его на 3090 хоть на месяц

Еще бы 3060 предложил, ради такого никто даже связываться с рандомом не захочет.

В сочетанием с другими семплерами. Если стоит min_p то он не обязателен.

>Это самое выгодное место для ускорения при ограниченном VRAM.

Я пробовал и так и так - первые слои на ЦПУ или последние слои на ЦПУ. По моим наблюдениям выгрузка первых слоёв на ЦПУ лучше, но разница незначительна.

Ты ведь в курсе, что второй квант Квена-235В входит на 3x3090 в exl3-формате?

> Каким образом он будет медленнее

Таким что при тренировке тебе надо ещё синхронизировать градиенты.

> кривым дипспидом

Чел, не позорься. Это основной фреймворк для тренировки больших моделей. Алсо, дипспид не для оффлоада изначально придуман, оффлоад только в зеро-3.

>Я пробовал и так и так - первые слои на ЦПУ или последние слои на ЦПУ.

Ну то есть понятно - я выгружал тензоры, но все тензоры слоя. И ещё одна фишка - при этом способе на видеокарты нужно "грузить" все слои, --ngl 99. Иначе нет ускорения.

Ну если мин р и вот это все 0.5/0.95 по стандарту, то топ к нужно крутить?

Глядя на инструкции в репах, пишут обычно, что нужно, но это для ванильных моделей-ассистентов. Для файнтюнов тоже, бывает, пишут, но хуй знает, как это отражается на рп, потому что каких-то неебических тестов я не проводил, а с наскока там хуй поймёшь, меняется что-то или нет.

Вроде как и не нужно, судя по тому, что я сам нагуглил в источниках не про модели, а в целом про сэмплеры, но может у анонов какие-то свои приколы для рп.

Его обоссали минимум трое анонов, а еблан думает, что разговаривает с одним. Фантастический залетыш, давно такого развлечения не было

> Ага, щас только штаны подтяну.

> И дособираю 3д принтер, и починю стиралку, и починю мамкин телек... Думаешь у меня других дел нет?

> Я не кодер. Это во первых.

> Ну и в третьих у меня одного физически не настолько много ресурсов.

> Конечно, в ллмках все сложнее, и ради дипсика надо дохуя всего внедрять и писать, чтобы все методы на нем завести

> У вас есть идеи получше?

> Ах да, все ваши идеи это же:

> сделай сам, я делать ничего не буду

вынепанимаити, это другое! мне можно нихуя не делать, а вам нельзя. я занятой, а вы хуй на ус наматываете и даже не пиздите другим, какую работу за вас надо сделать (с)

Что это за полотна школьных разборок сверху

Может продолжим разбираться что лучше гема немотрон или qwq

Может продолжим разбираться что лучше гема немотрон или qwq

>Может продолжим разбираться что лучше гема немотрон или qwq

Может лучше продолжим разбираться п40 за 60к с авито это всё еще база или уже кринж? Охлад в виде турбины идет в комплекте, так что вопрос действительно неоднозначный.

> п40 за 60к

Хуйня. За эти деньги 3090 можно взять, цена п40 - около 40к

Помоги мне карбюратор для газели подобрать в Новосибирке. Шаришь?

Нахуя тебе карбюратор да еще и в Новосибирске? Езжай к нам на дефолт сити парашу, устраивайся курьером - недели за три заработаешь на новую газель с новым карбюратором.

Ну а тебе нахуя п40 за 60к? Лучше бы карбюратор в Новосибирске купил за эти деньги.

Сейчас чекнул авито, нашел два объявления, где 3090 в хорошем состоянии за 50к ушла. Продать что ли свою 4090 и взять две-три 3090...

Мне нравится как геммочка кумит

Но не нравится что она не использует нецензурную брань и даже слова пенис или ваджайна!

Как это исправить?

В чате уже столько коков и пусси написал а толку нет

Но не нравится что она не использует нецензурную брань и даже слова пенис или ваджайна!

Как это исправить?

В чате уже столько коков и пусси написал а толку нет

Запусти Немотрон

попробуй тот систем промт для геммы на 2к токенов, ссылку правда не сохранил, но мб у кого есть

>нравится как геммочка кумит

>не использует нецензурную брань

>столько коков и пусси написал а толку нет

Может ты это самое... ну... еблан? Не хочешь задуматься о переходе с локалок на карбюраторы для галезек?

> Не хочешь задуматься о переходе с локалок на карбюраторы для галезек?

Смешно тебе? Это у тебя хорошего карбюратора не было. Там такой кум сочный, что не снился и 123б Магнуму...

Не, дпо гемма норм кумит.

>Смешно тебе? Это у тебя хорошего карбюратора не было. Там такой кум сочный, что не снился и 123б Магнуму...

Ммм, анон, впрысти, впрысни в меня еще немного топливной смеси... ммм... хочу... cums copiously and dries out your pistoning pistons

>Ну вот сама гемма забьёт тебе память 14-15 Гб, а это только модель. Тебе место ещё под контекст нужно. Хватит ли тебе этого? Если я правильно помню, всего лишь 8к контекста уже 3 Гб отнимет.

Хватит, я вообще к 12K контексту привык.

>Я пробовал втыкать старое говно. Это лучше, чем в рам, но драматическая потеря в скорости генерации меня удивила. Хоть и юзабельно.

Вот как раз меня - ничуть не удивляет. Ожидаемо. Это примерно аналог 1070, pascal. Ключевое здесь -"лучше чем рам" и "юзабельно". Т.к. у меня сейчас совсем на грани оного. 2.5t/s - совсем уж печально. Если хотя бы 4-5 получится - оно себя уже окупит (за такие то копейки ~18$).

Имхо он самый херовый из сэмплеров отсечки. Он напрямую задаёт, сколько токенов ты оставляешь, поэтому удобен, только когда ты хочешь оставить 1 токен для детерминированных ответов. В остальных случаях он говно, потому что никак не учитывает распределение вероятностей по токенам. Скажем, ты выставил 5, а у тебя реально очень пологая кривая в исходной выборке, в которой с примерно одинаковой вероятностью подходит полсотни токенов. Или, наоборот, выставил 40, а у тебя крутая кривая, и с высокими вероятностями идёт пара токенов, а дальше длинный хвост около нулевых токенов, которые корректно не отрежутся.

По-моему мнению, самые адекватные сэмплеры отсечки, которые как-то учитывают кривизну распределения вероятностей - топ-а, мин-п и tfs. Но последний сложнее по операциям и выкинут из ламацпп и, соответственно, основанных на ней движках из-за какого-то бага. Топ-а с квадратичной зависимостью от максимума отрезает уж слишком мало при пологих распределениях. Так что проще оставлять один мин-п и им контролить выдачу. Если прямо совсем страшно оставлять хвост маленьких токенов, то можно топ-п 0.95 взять, но я не вижу в этом особого смысла, потому что если мин-п 0.05-0.1 не отрезает эту мелочь в суммарные 5% (при очень пологих распределениях), то эти мелкие токены экшели вполне подходят.

Зачем вы делаете персонажей в геммочке, а не за копейки у корпоблядей?

Можно раздувать кумслоп на любой цвет и вкус в файлах проекта. Лучше, чем на чубе.

Можно раздувать кумслоп на любой цвет и вкус в файлах проекта. Лучше, чем на чубе.

>Зачем вы делаете персонажей в геммочке, а не за копейки у корпоблядей?

Понятия не имею, спрашивай в треде чатоботов. Потому что там и корпосетки и боты.

Можно не крутить, можно поставить 20 и забить. Эффекта после остальных будет мало. Он более важен если работает в комбинации с top_P.

Квенчик - лучшая девочка!

> цена п40 - около 40к

15-17 как когда-то и продавались.

За 60к совсем обезумили.

> карбюратор

> 2025

Содомит

Напрямую в промте укажи использовать явное описание (попчислить) вместо абстрактных "гениталии".

Калкалыч. Нет ничего проще, чем самому написать. И время сэкономишь, и карточка лучше получшится. Не слоп, а с душой.

>база треда: меньше Q8 жизни нет, меньше 24B жизни нет, меньше 16GB жизни нет

Каждый день насилую лолек при поддержке тюна мистраля 12b квантованного 4 бит, и что ты мне сделаешь?

мимо анон на 1660 super

спасибо за инфу!

вот бы все так обсуждали технические аспекты запуска нейронок, а не эротические аспекты дрочки

позвоню в полицию

Геммочка походу знает, что у меня на диске ещё Подснежник и ГЛМ-4 валяются, и... ПОДЪЕБАЛА.

анончики подскажите есть вообще смысл вкатываться в эту историю с 3090 и 32 озу? От этого будет какой-то качественный скачок или проще просто дальше дрочить онлайн бесплатно без регистрации?

>3090

минбаза 3060, а челоке культуры выше вообще с 1660,

так что норм, базу треда запустишь всю

Качественный скачок по сравнению с чем? На 3090 спокойно запустишь лучшие модели для консумерского уровня железа. Есть готовые пресеты, скачать-установить делов на час, тебе проще тупо затестить самому и понять надо оно тебе или нет

по сравнению с условной дрочильней типа спайсичат яодао и проч.

Понятия не имею, что это за хуйня, но если оно бесплатное/с ограничениями - скачок будет и нихуевый. Читай шапку, качай пресеты и модельки, проверяй

На бесплатных платформах или чат кумботах в лучшем случае 8b модели, на 3090 можно гонять 32b без ограничений и прочей хуйни

принял анончики спасибо

Если сравнивать с этим говном, то конечно колоссальный скачок. Как минимум у тебя контекст не 2-3к будет. Так что твоя аниме тян не будет забывать что ты ей пернул в нос 10 сообщений назад.

Там контекст 3к? В голосяндру

на 3090 можно даже анимации генерить. мелкие, долго, но прям анимации

Всё-таки хотелось бы увидеть, сколько MI50 дают на ROCm.

Мелкие и долго можно и на 3060 12GB генерить. А если на FramePack - так и на 4060 (ему вообще 6GB достаточно).

12 - 16b модели сможешь гонять которые достаточно пиздатые и умные сейчас, особенно гемма 12b. Подцеплять свои лорбуки к чату, писать авторс ноты\суммарайзы, которые буквально позволяют делать чат бесконечным пока полность не вырежут контекст, иметь свой личный арсенал карточек которые сам сможешь свободно редачить и копить хоть over 9999 штук, настраивать сэмплеры и свапать любые текстовые модели на свой вкус, они все разные и какие то больше могут в поебушки, какие то больше в сторителлинг например. Ну и конечно же это всё будет лично твоим, не надо будет платить кабанычам в подтяжках заполноценный функционал или дополнительные опции и всё это будет работать без интернета.

12-16б модели на 24гб врама? Дебил или q8 культист? Хотя одно и то же наверн

Я сутки не спал, иди нахуй! Нахуй иди!