>все заебался с этой убаугой

А вот не надо унгабунгу юзать, юзай нормальный бэк.

Кобольда, который в этом треде синоним слова "новичок-вкатун", хотя ты вроде нет, или llamacpp.

Врамобояре юзают табби.

база треда: меньше Q6_K жизни нет, меньше 24B жизни нет, меньше 16GB жизни нет

Попробовал https://huggingface.co/Tesslate/Synthia-S1-27b

Для кума не подходит, мозгов вообще не хватает у нее, даже тюны 12б на немо мистрале в разы лучше.

Для кума не подходит, мозгов вообще не хватает у нее, даже тюны 12б на немо мистрале в разы лучше.

Аноны, дегенератский вопрос ибо позабыл уже нюансы: насколько будет уебанским решение к 4080 доставить 5060 ради +16гб врамы?

врама много не бывает

Эт понятно, я больше задаюсь вопросом не превратится ли это всё в тыкву в сумме из-за такой разницы по мощностям чипов и скоростей врамы

вряд ли, разница всего 1 поколение, это не к 2080 доставить 5060

Есть правда ещё более шизофреничная идея вместо 5060ти заюзать A770.....

>Эт понятно, я больше задаюсь вопросом не превратится ли это всё в тыкву в сумме из-за такой разницы по мощностям чипов и скоростей врамы

Я так понял, что есть вопросы по поводу взаимодействия Питорча и 50-й серии. И с драйверами что-то.

у тебя карточки и промт не подходящие, а 12б модельке похуй вообще

вот и вся разница

таки где мне обучиться промпту и карточкам? или дай пример, чтобы я понял что у меня не так

просто на гемме пердел, все хорошо было, но она там умная дохуя в плане контекста как я понял

тут что ни скинешь, все засрут к ебеня матери и еще больше запутают новичков своими точно правильными познаниями

так скажу: сам когда перекатывался с 12б на 70б модельки, у меня все чаты развалились. потому что абсолютное большинство 12б тюнов - по умолчанию кумлоботомиты, которым даже карточка толком и не нужна. можно написать "office coworker 30 years old" и оно будет работать. потому что в и без того маленькую модель запихали кум датасет, он пропорционально важнее чем в больших моделях

полазай по чубу или еще где, посмотри определения карточек, ищи что сделано с душой и попробуй разное

> Synthia-S1-27b (рабочий тюн базовой геммочки и без рефузов)

> мозгов вообще не хватает у нее

> 12б на немо мистрале в разы лучше

Мощность чипа особо не влияет (здесь) - важнее само поколение, из-за поддержки разного набора фич. Но тут же 4080 старее. Память у 5060 вроде как не особо медленнее, или даже наоборот(лень лазить проверять).

У самой 5ххх серии пока бывают заморочки с либами и дровами - но это уже их собственное, независимое. Подпилят, я думаю.

В общем, походу это решается "swa-full" флагом. Да, как-то неочевидно. Хз косяк ли это самой убабуги или ЛамыЦПП за уебищный АПИ нейминг.

ЛамаСПП решили по дефолту врубать СВА везде (?) https://github.com/ggml-org/llama.cpp/pull/13194

Как отключить think на квене 30б-а3б? Есть команда для него enable_thinking=False, так куда ее писать? В систем промпт? В сам промпт, который тоже называется систем промпт? Или в кастом стрингс. 1 и 3 вариант для меня оказались не рабочими. Ризинг в силли, тоже стал почему-то не работать.

Алсо, что использовать в темплейте для этого квена? ChatML? У него такие токены, похожих в силли не видел, кроме как на chatml

Алсо, что использовать в темплейте для этого квена? ChatML? У него такие токены, похожих в силли не видел, кроме как на chatml

think я все же убрал при поможи /no_think. Но что использовать в темплейте? ChatML?

В любом месте, например в систем промте добавь в конце

/no_think, можешь сводобно переключаться во время чата выбирая режим добавляя теги в конце сообщения, включить думанье /think

>ChatML?

yes, но оно не так умно без ризонинга чем хотелось бы. С ним уже более менее

Да, судя по обсуждению кто то предлагал включить изначально старый кеш, но сделали принудительное включение сва кеша

Все кто часто/долго пересчитывает контекст - сосать

>С ним уже более менее

Ну так его видно, и оно же отжирает контекст, его можно оставить, но чтобы на выходе я его не видел?

Анонасы, вот в карточке есть таблица со статами, но моделька (гемма 27б) забывает ее через 5-6 запросов, что я могу с этим сделать? Просто не хочется под каждую карточку менять системный промпт.

Вот так выглядит в карточке:

###Display:

At the bottom of every post, display the following information wrapped in ` like this: `information`

Есть ли какая-то специальная разметка, чтобы эту часть контекста он всегда пониже держал?

Вот так выглядит в карточке:

###Display:

At the bottom of every post, display the following information wrapped in ` like this: `information`

Есть ли какая-то специальная разметка, чтобы эту часть контекста он всегда пониже держал?

Видишь ризонинг настройки? Поиграйся с ними, можно сделать дефолтное сворачивание мыслей, они будут скрыты плашкой

Можно вобще убрать если вырубить мысли и выбрать пустое форматирование рассуждений

Нормально кумит и в отличии от стоковой геммы лучше описывает. При этом, обычные карточки на хуй не прыгают, могут прописать пиздюлей за неуместные домогательства если не подходить аккуратно, а кумботы наоборот конкретно так берут тебя в оборот.

Что-то не так делаешь, промты, карточки и т.д.

С выходом стайбл торча на куде 128 и массовым переходом на него все вопросы закрыты.

Суммирование разных гпу будет работать, скорость будет определяться временем обработки каждоый своего кусочка.

Можно пояснительную бригаду?

Зачем вообще делать такую хуету и к чертям убивать атеншн там, где его точная работа жизненно необходима? Ладно когда в модели используется несколько вариантов и часть атеншна штатно должна быть со скользящим окном, нужно просто обеспечить ее корректную работу. Но для чего подсовывать это в качестве принудительной опции там, где подобный режим далек от штатного? Или что они там вообще делают?

Misc. Sequences -> Last Assistant Prefix ->

> <|im_start|>[{{name}}]

> <think>

>

> </think>

или заменить на свой шаблон если обычный чатмл без имен. Это в конфиге токенизатора указано явно.

> Как отключить think на квене 30б-а3б?

Можно ещё заглушку для <think> в виде префилла добавлять.

> Но для чего подсовывать это в качестве принудительной опции там, где подобный режим далек от штатного

Для врам-бояр, так как им важнее меньшее количество врам при запуске и плевать на чтение промпта, если модель таки влезла

Остальные - сосать, если не знают что это включено и нужно вырубить командой с не очевидным названием

немотроношиз уймись уже в каждом треде жидко срать, остальные обойдут, а ты в гавне

Что за бред ты несешь?

Почему персонаж не может просто стоять и пиздеть а не подходить ко мне ближе и ближе и ближе наклоняясь с каждым разом на расстоянии полушага

Еще, сильно ли лоботамитит alibiterate у квена а3б? У меня раньше пользовался обычной, но он высерал хуйню какую-то, был поломанный квант. Сейчас скачал алибитерейт, отключит ли он мозги? Я конечно попробовал, русский такой себе... "Пожалуйста, мастер… я хочу тебя… я хочу твой сперму…" Как я помню на обычном квене с цензурой такого не было

Пошел нахуй

тредовичок обычный, ллама 8б iq2xs, 2048 q4 контекста

систем промт: разговаривать с самим собой, остальных слать нахуй

Искренне не могу понять, откуда вы высрали это трешовое заключение, которое стали постоянно форсить в треде. Одну модель исходно тьюнили на инструкциях, и вторую тьюнили на инструкциях. Почему одна должна якобы понимать инструкции, но игнорить кум контекст и требовать какого-то специального промпта и карточки, а вторая независимо от контекста и инструкций писать еблю? Т.е. ситуацию с первой я понимаю: потому что в ней насрано сейф инструкциями. Но очевидно, это не потому, что она такая умная, блять, но как даун, на самом деле, и ей нужно специальное обращение. Мало того, бОльшая модель должна как раз гораздо лучше понимать, что от неё хотят в промпте, даже если он кривоват, и что согласуется с контекстом (а контекст, очевидно, у анона про кум). И от того, что меньшую модель дополнительно накормили тьюном вида "я тебя ебу" - "ах, ты меня ебёшь", она не будет сводить в кумслоп вообще любой контекст, в котором нет "я тебя ебу", если тренили без косяков. Для этого пары инструкция-ответ и существуют.

Можешь подать инструкцию авторской заметкой/лорбуком/последним реплаем в инстракте на глубину ноль (сразу после чата). Более надёжный вариант имхо взять инфу в какое-нибудь форматирование или тег, скажем в ``` для кода, дать инструкцию, чтобы инфа выводилась в начале, и поставить открывающие символы в префил. Модели будет некуда деваться, кроме как дописать блок. Так даже совсем мелкие модели инфоблоки могут худо-бедно держать.

> Мало того, бОльшая модель должна как раз гораздо лучше понимать, что от неё хотят в промпте, даже если он кривоват

вот и умные теоретики подъехали, которые все непременно знают лучше всех

берешь 12б кумтюн мистральки и отвратительную слоп карточку. запускаешь, смотришь результат

берешь 70б электру или неворию и отвратительную слоп карточку. запускаешь, смотришь результат

ахуеваешь от результата и переосмысливаешь свои жизненные выборы либо делаешь вид, что не видел того, что видел и дальше умничаешь

спасибо анон, решил так и сделать через лорбук, и привязал лорбук к карточке. чтобы они вместе подгружались

ну я пробовал так делать, получается что на 12б качественный слоп, потому что 8квантов

на 70б неворию мне не хватило и запустил в 3 кванта и получился неудобоваримый слоп, потому что маловато квантовки

только на русике общаюсь

> это трешовое заключение

Почему трешовое? Оно очевидно как после использования моделей, так и из теоретических заключений.

После продолжительной лоботомии, которую именуют "рп тренировкой", типичная рп двенашка будет выдавать стандартизованный кумослоп даже если в карточке написать что все это сон, а персонаж - новоизбранный папа римский. Она совершенно нечувствительна как к косякам промта, что для такого применения плюс, так и к деталям характера или каким-то особенностям карточки, что превратит чара в стандартизованного болванчика, сложный сеттинг в регулярные встречи с гоблинами или волками и т.д.

Более живая и крупная модель лучше понимает контекст, инструкции и детали, и выдает как раз то что от нее просят. То что из-за дерьма на входе выдача не соответствует ожиданиям юзера - не ее проблемы. Если модель недостаточно большая и мощная, а в промпте полнейший треш - она может не сдюжить собрать вместе все противоречия и странности, и поломаться.

Модель - инструмент, а не какое-то волшебство, которое должно указывать мысли юзера игнорируя контекст. Говно на входе - говно на выходе, внесение любых жестких алайнментов в сторону конкретной выдачи и игнорирования входа = снижение точности и деградации. Только на оче больших размерах и с привлечением всякого типа ризонинга и саморефлексии, модель начинает справляться даже с трешем, ставя в приоритет часть нормальных инструкций и бракуя/обыгрывая ерунду, выдавая нечто удобоваримое. Но на это, образно говоря, уходят все ее ресурсы, и с хорошей карточкой и промтами можно получить гораздо больше.

> качественный слоп

Оксюморон, вялая копипаста датасета же.

> только на русике общаюсь

Как носителю языка можно не проблеваться с выдачи типичной 12 с подмешанной сайгой "для ру рп"?

70б не могу (и даже 27б, кек), сорри, тут можешь считать меня теоретиком, согл (хотя когда-то сиживал на клоде и гптыне, которые почему-то даже самые шизовые промпты хавают, не будучи "зарельсованными" кумслоп тьюнами). Но могу сравнить 12б шизомержи немо с якобы более умной геммой, например. Совсем говнарские карточки стараюсь не юзать или редачить, но, скажем, пробовал катать абсолютно тупую карточку "твоя подруга детства хочет, чтобы ты её рейпнул". Кастомный мёрж магмела с наваленным поверх лупным кумслопом (сорри, люблю такое) почему-то не прыгал на кок, спокойно ограничиваясь тизингом со стороны тянки, и даже когда мы завалились к ней домой, она врубила эччи аниме нам смотреть и только потом начала кайнда приставать. В промпте ещё и было насрано такими себе инструкциями для более детального кума. Гемма же при малейшем обратном тизинге с моей стороны пыталась убегать в слезах. Правда, нужно объяснять, кто из них вёл себя логичнее при одинаковом контексте и промптах, и в чём проблема? Подсказка - проблема не в том, что гемма не понимала моих охеренно сложных инструкций и так себе написанной карточки.

Энивей, там чел пишет про тьюн геммы и говорит, что сама гемма у него работала норм, так что твой доёб про промпты там не к месту.

>на русике

Ну тут ещё проблема, что в ламе его почти нет.

> типичная рп двенашка будет выдавать стандартизованный кумослоп даже если в карточке написать что все это сон, а персонаж - новоизбранный папа римский.

> Она совершенно нечувствительна как к косякам промта, что для такого применения плюс

именно это я здесь и сказал, объясняя анону, почему при переезде на большую модель у него получился худший результат, чем на тюне 12б модели

почему не согласен - хуй знает, да и похуй. адекватный анон выслушает нас обоих и составит свое мнение

>худший результат

По твоему кумслоп на всё это лучше, чем адекватная подстройка под контекст?

У местных шизиков модель для топ-кума - это когда на любую карточку "я тебя ебу - ты меня ебёшь".

я этого не утверждал

проблема в том, что на 12б кумтюне карточка не развалится и будет работать хоть как-то

на 70б модели будет хаос вплоть до галлюнов

мне не нравится ни то ни другое, но отрицать правду я не буду

немонтронодебич, спокнись

Там вроде посыл в том, что "у него" получается что 12б работает лучше чем большая модель, но его оценка "лучше" просто некорректна. Тот ответ не вполне проливает свет на то, что модель становится достаточно умной чтобы все заметить и обработать, выдавая ровно то что должно быть. Но еще недостаточно умная чтобы выразить свое недовольство и послать нахуй за такие промты, или вздохнув, выдав упреки и выразив свое отношение, все равно попытаться как-то это обыграть, сделав конфетку.

> что на 12б кумтюне карточка не развалится и будет работать хоть как-то

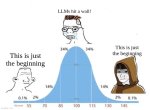

Пикрел

> Пикрел

именно так. слева 70б, справа 12б

хорошая пикча

>и будет работать хоть как-то

Весь прикол в том, что я бы не назвал это работой. Так можно заменить всю нейросеть подстановкой "Ты меня ебёшь - ахх" в конец вместо всех этих вычислений, и будет твоя 12B оверфитнутая на куме модель.

я с тобой согласен. почему вы из контекста выгружаете все кроме одного сообщения на которое отвечаете

там анон писал, что у него на синтии результат хуже, чем на 12б кумтюне, я ему объяснил почему

почему вы думаете, что я защищаю 12б модели?

тред поражает тупостью, как же я коупю и верю что вы лламы 8б одного из риговичков

Надо переделать под 70б - 12б и внизу автоваз заменить на мистральнемо. А справа добавить гусенечную бронемашину и скрин ризонинга, где квен трижды ахуевает с противоречий в карточке проходя стадии торга и принятия.

>почему вы из контекста выгружаете все кроме одного сообщения

Так проще общаться. И даже последнее сообщение выгружаю не всё, а только то, что цитирую.

Мимо анон, превратившийся в 1,3B после общения с нейронками длинною в два года

И опять - все упирается в субъектив - что именно считать адекватной реакцией? Оно ведь - на вкус все фломастеры разные.

А лично для меня, "модель адекватна" когда она:

1. Следует основной инструкции глобально. Т.е. если я ей говорю, что она DM - то она должна вести игру, а не писать книгу или решать задачи. А если - "ты - Х" (с описанием этого Х) - то не выпадать из образа этого Х.

2. Отыгрывая персонажа(ей) - учитывает прописанные реалии вокруг, а не тупо тянет мораль и этику (и остальное) из нашей дефолт реалити. Т.е. - написано что это хентай мир, в котором голым по улице ходить нормально - значит персонажи не должны даже смущаться при этом. И т.д. В идеале - еще совмещать с описанием самого персонажа - т.е. если "попаданец" - то недоумение и смущение логичны.

3. Проявляет хотя бы минимум инициативы в действиях персонажей согласно их предыстории. Как пример - чтоб NPC добросовестный приключенец, скажем, по своей воле пошел за оружием ухаживать после рейда, без намеков от меня.

А слоп там, прыжки на это самое на втором ходе, или убегание в слезах на невинные намеки - это все вторично, и само по себе нифига не показатель. Лишь в контексте вышеописанного.

этот вообще посреди обсуждения проблемы пришел о своем попиздеть

ууух бля, пойду спокнусь отдохну от вас. всякое бывает, но такого потока сознания на ровном месте как ночью и сейчас я еще не видывал, демагоги захватили тред

ууух бля, пойду спокнусь отдохну от вас. всякое бывает, но такого потока сознания на ровном месте как ночью и сейчас я еще не видывал, демагоги захватили тред

Почему карточки, которые нравятся по пикче и описанию, оказываются кринжухой и слопом, а карточки, на которые не питаешь особых надежд (или не очень интересна тематика/фетиш) - наоборот, оказываются вином и получается классное рп и кулстори? Как это работает? Листаю сейчас чаб, и не могу выбрать ничего, что попробовать.

Тэкс, только вернулся с командировки. Завтра перепилю шапку.

НАКАНЕЦТА Я ДОМА.

Сколько можно блять, сколько можно, каждые две недели что то новое, я уже не могу босс.

https://huggingface.co/ReadyArt/The-Omega-Directive-M-12B-Unslop-v2.0

НАКАНЕЦТА Я ДОМА.

Сколько можно блять, сколько можно, каждые две недели что то новое, я уже не могу босс.

https://huggingface.co/ReadyArt/The-Omega-Directive-M-12B-Unslop-v2.0

Очень долго идет блас, скорость генерации нормальная. Появилось когда поставил модель побольше квантом, как решить? Модель сама же грузится и дает нормальную скорость, а вот блас очень долгий.. P.S квен с мое, выходит за озу, модель весит 17гб, а у меня 16, однако есть слои на видеокарте, загружается всего 11гб на цпу. При кванте, который весит 15 таких проблем нет

Аноны, как ллмки можно будет комфортно юзать при 32 ГБ против 24 ГБ используя 4 квант? Думаю над покупкой двух 5060 Ti 16 ГБ.

> НАКАНЕЦТА

Чуи, мы дома!

> The-Omega-Directive-M-12B-Unslop-v2.0

Сначала проорал с описания ил перечисления достоинств, но когда дошел до

> QLoRA with DeepSpeed Zero2

чуть не помер.

>почему не согласен - хуй знает, да и похуй

Потому что вы несёте херню, ну да и похуй.

>типичная рп двенашка будет выдавать стандартизованный кумослоп даже если в карточке написать что все это сон

>когда на любую карточку "я тебя ебу - ты меня ебёшь"

Это пиздёж. Тут полно анонов, которые на кум тьюнах немо если не сидят сейчас, то сидели пол года назад. Если бы была такая ситуация с полным отсутствием логики, никто бы на них не сидел. Если мы говорим не об условном поломанном Драмером тьюне, то нет там никакого сведения всего в кум. Даже прожаренные 8б тьюны так не делают.

>Более живая и крупная модель лучше понимает контекст, инструкции и детали, и выдает как раз то что от нее просят.

>может не сдюжить собрать вместе все противоречия и странности, и поломаться

Сначала сказал, что большая модель понимает контекст. Потом понял, что обосрался, ведь нужно объяснить, что на деле не понимает, и добавил, что ну вот если не прям совсем большая, то не осиливает. Удобные маняврирования.

>Говно на входе - говно на выходе

Это было приемлемо только для 6б пигмы, чел. Уже на 3.5 турбо и мифомаксе сидели с какими-то минимальными дефолтными промптами (и мелким джейлом для турбы) и не знали бед. А тут вдруг современная 27б якобы плохо работает, потому что слишком её промпт ограничивает, и в карточке непонятный для неё кумслоп. А она, такая молодец, просто честно пытается разобраться и не может, ну конечно, верю.

аргумент вроде бы был не то что большая модель ломает ту же карточку, а что карточка никогда и не работала. просто мелкой модельке было поебать че там от нее хотят и заученный слоп валила.

такое с имедж генерациями бывает, когда, например, вес лоры задрать, оно может просто на любые всратые запросы жепеги с "базы" "генерить" и типа даже выглядит что все работает.

такое с имедж генерациями бывает, когда, например, вес лоры задрать, оно может просто на любые всратые запросы жепеги с "базы" "генерить" и типа даже выглядит что все работает.

Как же меня раздражают их модели. Профессиональные создатели лоботомитов, способные превратить любую модель в говно.

Особенно смешно читать их описания, которые они копипастят постоянно. Когда первый раз читаешь, кажется, что сейчас будет пушка, а на деле рандомный шизомерж с высоким "рейтингом" на UGI в сто раз лучше.

Мне кажется, это плохая идея. 24 вполне достаточно, чтобы комфортно катать нынешние винчики, а если смотреть дальше, то до 70б не дотянуться, разве что с немотроном пердолиться.

Сойдёт, наверное, если ты любитель геммы и большого контекста, потому что порой очень уменьшает головную боль и не вынуждает тебя идти на компромиссы. Ну или если ты любитель русика — там реально есть разница между 4 и 5 квантом в нём.

> Как же меня раздражают их модели. Профессиональные создатели лоботомитов, способные превратить любую модель в говно.

Все еще считаю Forgotten Transgression лучшим кум тюном Мистраля 24б. Сочно кумит и не слишком тупит относительно базовой модели. Другое дело, что Мистраль 24б в целом так себе по сравнению с 32б моделями. И другие модели РедиАрта действительно говно. Раньше думал, что они молодцы, а теперь понимаю, что они регулярно срут слопом и каждый раз пытаются упаковать его все красивее

а че вы тута бартовски не уважаете?

вроде норм модели же

вроде норм модели же

Он не делает модели.

Да, эти описания. Но если хочется чистейшего слопа мне заходит. Ну знаете иногда не хочется никаких 100+ сообщений вступления, тупо : Я достал свой кок и направился к эльфийской принцессе делать много новых эльфиеек.

Как убрать повторения одних и тех же слов? Она.. Она.. Она.. Чтобы вы... Чтобы вы.. Чтобы вы...

Трансгрессия лучше забытого стоп-слова? Не помню, пробовал я трансгркссию или нет.

Меня бесит, что в этих кум-моделях какой-то очень быстрый секс, весь коитус порой в два сообщения заканчивается, если не писать подробные посты, а в куме не до этого. Этим модель и расстраивает. 12б слоповые так не делали обычно.

Ну а инструкций их модели не особо слушаются.

Брокен туту разве что нормально делает, но там уж больно позитивный биас.

У меня не было таких проблем с Трансгрессией. Энивей сейчас я юзаю Куммандера, когда мне нужно что-нибудь такое, и к моделям РедиАрт не притрагиваюсь совсем

Блять... А кто-то же реально кумит на русике. Ну, как говорится, зато всё понятно и не нужен переводчик.

>Как убрать повторения одних и тех же слов?

Как и большую часть всех других лупов - редактированием предыдущих сообщений. Это если у тебя не лоботомит на модели, разумеется.

ебанько на связи, я до этого говном поливал синтию, ща карточки потыкал и промпт поправил, стало получше. Все также только русиком оперирую, но прям чувствуется что часть глубины теряется из-за этого. Походу придется пердеть на англе, чтобы по кайфу

Ты хоть бы модель и квант написал — сразу бы стало всё понятно.

Ну а так — никак.

Если модель лупится подобным образом, она всегда будет лупиться, цепляться за какие-то ебанутые паттерны. Пенальти тоже не помогает и зачастую ломает модель.

Только переписывание сообщений или временная смена моделей помогает более-менее.

А тут ещё и русик. На нём такое чаще возникает.

Аноны, я так понимаю 99% треда использует ллмки для рп? А для чего ещё можно юзать локалки? Ведь из-за размеров 12-32B особо ничего не могут и не знают.

Квен 30 на МоЕ а3б который, на нем только и возникло такое. Как я понимаю решить это никак, хотя чуть-чуть помогло промптом. Квант лоботомит Q3_K_XL

А почему в шапке не https://chub.ai/? Старый интерфейс хуета же

32б в более жирном кванте и с контекстом, немотрон, 70б в оче ужатом кванте. Хз, попытка не выглядит оптимальной из-за невысокой мощности 5060ти, но из новья это лучшая опция на сегодня.

Ты глупый и оперируешь понятиями для имбецилов "хорошо/плохо" в значении того, что тебе нравится и не нравится. Хорошая и правильная же работа модели как раз заключается в следовании промпту, если в нем шмурдяк то странный ответ что тебе не понравится - хорошо, а если на что угодно однотипный слоп - плохо.

Помимо глупости здесь еще мотивация потушить жопный пожар и покоупить вокруг своей неспособности запустить что-то больше 12б. Итог на лице, в своих доебах ты совсем запутался и потерял логику, что довольно забавно.

Вообще, отличная иллюстрация микролоботомитов получается, что там оно толкает слоп в 100% случаев не пытаясь понять, что здесь чел просто спорит путаясь в своих показаниях и хоть как-то пытаясь извернуться. 1 в 1

Попробуй совместить приятное с полезным и заодно немного подучить язык. Тем более что можешь не только транслейтом пользоваться, но и переключаться на отдельный чат чтобы просить ту же сетку перевести или разъяснить тебе что-то.

Наоборот, в новом даже нсфв нельзя открыть без регистрации и много чего задавлено.

а как в этом старом страницы перелистывать? У меня он только первые 30 результатов отображает а дальше не дает, я поэтому на новый и перешел, там все работает как надо

Мдэ, что-то совсем сломали, работает только если в адресе поменять. Оварида.

Если используешь жору, то можно при запуске llama-server поставить флаг "--repeat-penalty 1.2" У меня была жесткая проблема с зацикливанием сообщения на одном слове, помогло привести модель в чувство. Может и тут сработает. Вроде этот показатель можно настроить и из таверны, но давно в ней не сидел, ХЗ.

На связи тот самый психанувший с 2 t/s на gemma3-27b владелец калькулятора с 3060 12GB, и заказавший себе p104-100 8GB как сопроцессор.

Так вот. За такие деньги (~18$) это просто охуенно. Гемма с полпинка влезла в две карточки, и теперь показывает 8 t/s еще без всяких оптимизаций (просто запустил как есть из кобольдовского GUI). Я рассчитывал на 4-5 максимум.

При этом, в простое карта холодная, маложрущая (9W), и тихая. (Последнее правда - заслуга бывшего владельца, который поставил туда вентиляторы от игрового радеона.)

Цена при этом - не эксклюзив, не что-то особое. Это местный стандарт для этих карт.

Так вот. За такие деньги (~18$) это просто охуенно. Гемма с полпинка влезла в две карточки, и теперь показывает 8 t/s еще без всяких оптимизаций (просто запустил как есть из кобольдовского GUI). Я рассчитывал на 4-5 максимум.

При этом, в простое карта холодная, маложрущая (9W), и тихая. (Последнее правда - заслуга бывшего владельца, который поставил туда вентиляторы от игрового радеона.)

Цена при этом - не эксклюзив, не что-то особое. Это местный стандарт для этих карт.

У меня 32б плотные модели в третьем кванте хуйню несли, а тут МоЕ + есть шанс, что поломанный квант. Unsloth кванты эти, наверное, раз 5 минимум обновляли.

Я не специалист, но у меня есть подозрение, что при квантовании такие маленькие моэшки страдают сильнее, чем плотные модели.

Плюс сама модель капризная. Я на русском её не особо щупал, но такие заедания видал. С этим квеном крайне желательно подрочить сэмплеры хорошо.

Лучше возьми квант побольше. На 4 XL 20 токенов в секунду с выгрузкой тензоров даже на 12 врам. Это при 16к контекста заполненных.

И если для тебя русик критичен, а переводчиками пользоваться не хочешь, можно ещё выше квант задрать — возможно, в случае с этим квеном смысл в этом есть.

Ого. Весьма недурно, учитывая, что там гемма и такая старая карта.

А где брал? На Авито?

Другая страна. На местном аналоге.

Еще этому квену помогает поднять количество экспертов - по умолчанию у него 8, я поднимал до 16 - вроде как и умнее и чище текст получался. За счет скорости вестимо.

А вы говорите железа нет.

Просто надо больше зарабатывать

Просто надо больше зарабатывать

Ребят, а что посоветуете из тюнов по mixtral 8x7b? Стоит ли пробовать? Просто как-то не обращал на него внимания, так как есть модели по типу синтии

поигрался с около 5 файнтюнами мистраля 24б ку4км

один и тот же слоп в совершенно разных сценариях от совершенно разных персонажей, независимо от объема и содержания вручную написанной прозы.

десять свайпов чтобы выцепить один +- адекватный. можно переписать целый абзац вручную и в ответ получить тоже самое что и раньше.

у меня даже не кум, просто обычный creative writing

такое чувство что у него словарный запас +- 500 шаблонных высказываний, и всё остальное их вариации. типа "[his, her] cheeks burning with [humiliation, shame, anger, rage, etc]". щёки горят неугасаемо блядь.

инструкции и логику игнорирует - можно предупредить {{char}} что еще раз скажешь слоп - уебу по-голове, и в следующем сообщении хуяк - слоп.

один и тот же слоп в совершенно разных сценариях от совершенно разных персонажей, независимо от объема и содержания вручную написанной прозы.

десять свайпов чтобы выцепить один +- адекватный. можно переписать целый абзац вручную и в ответ получить тоже самое что и раньше.

у меня даже не кум, просто обычный creative writing

такое чувство что у него словарный запас +- 500 шаблонных высказываний, и всё остальное их вариации. типа "[his, her] cheeks burning with [humiliation, shame, anger, rage, etc]". щёки горят неугасаемо блядь.

инструкции и логику игнорирует - можно предупредить {{char}} что еще раз скажешь слоп - уебу по-голове, и в следующем сообщении хуяк - слоп.

Кто пробовал кумить на локальных 235б квене и дипсике? Разница с корпами есть (кроме скорости и оценки твоих фетишей серверами пентагона)?

Вчера просто решил от нечего делать написать гопотыне "знаешь что такое рп и карточка? Ну вот. Придумай карточку и давай порпшим". Рп SFW фантастика аля киберфаллаут, не скажу что вау...

Но когда пердолишься в таверне с локалкой, ощущения вот этого:

>у меня даже не кум, просто обычный creative writing

Пытаешься из тонны слопа и просто дурацких ответов отрероллить/отредачить в нужную сторону какой то сюжет.

С гопотыней же да, тоже чувствуется как модель адаптируется на контекст, пытается в какие то шаблоны датасета и прочее, глаз такое замечает. Но ощущается именно как ролплей с VI (AI без самосознания, как в масс эффекте), а не генератор сходносмыслового текста.

До этого на корпах не ролплеил, и уж тем более не кумил через APIшки.

Вчера просто решил от нечего делать написать гопотыне "знаешь что такое рп и карточка? Ну вот. Придумай карточку и давай порпшим". Рп SFW фантастика аля киберфаллаут, не скажу что вау...

Но когда пердолишься в таверне с локалкой, ощущения вот этого:

>у меня даже не кум, просто обычный creative writing

Пытаешься из тонны слопа и просто дурацких ответов отрероллить/отредачить в нужную сторону какой то сюжет.

С гопотыней же да, тоже чувствуется как модель адаптируется на контекст, пытается в какие то шаблоны датасета и прочее, глаз такое замечает. Но ощущается именно как ролплей с VI (AI без самосознания, как в масс эффекте), а не генератор сходносмыслового текста.

До этого на корпах не ролплеил, и уж тем более не кумил через APIшки.

Ну и в догонку аналогичный вопрос про уже старенький 123b - как ощущается на фоне корпов?

Я просто дальше 32б пока не прыгал.

Ps - я не этот анон, мистральки мне оче нравятся, но его мнение отчасти сейчас разделяю по всем моделям "до 24vram".

Pps я не залетный с аицга, мне слоповые локалки все равно дороже корпомозгов. Просто хочу понять, дают ли 100b+ то, что дают корпы.

Я просто дальше 32б пока не прыгал.

Ps - я не этот анон, мистральки мне оче нравятся, но его мнение отчасти сейчас разделяю по всем моделям "до 24vram".

Pps я не залетный с аицга, мне слоповые локалки все равно дороже корпомозгов. Просто хочу понять, дают ли 100b+ то, что дают корпы.

> при квантовании такие маленькие моэшки страдают сильнее, чем плотные модели

Для всяких взвешенных квантов при некачественной оценке часть экспертов может быть не быть стриггерена и им поставлен наименьший приоритет, а значит и самая меньшая битность. Плюс там имеют высокую важность некоторые из слоев. Так что это может быть вполне справедливо.

Забудь, это старый лоботомит, недалеко ушедший от 7б. Будет уступать современным 12б и потребует оче много памяти для запуска.

> кумить на локальных 235б квене

Очень хорошо. Уровень опуса и лучше, особенно на провокационных нсфв и прочем, где у последнего сносит крышу. Соперничает с жеминькой и тоже опережает ее в таких же кейсах, но в то же время может обосраться структурными лупами и начать делать мозг на ровном месте. Или на сфв выдать странное уебище, которые даже читать из-за вида не будешь, хотя содержание будет хорошим, тогда как гуглосеть гораздо лучше справляется с хорошей структурой повествования в рп. Помогает пиздинг через ooc или добавление инструкций на формат, смена вариаций chatml и подобное.

> и дипсике

Сколько не пинал - унылый. С ризонингом почти неюзабельно из-за скорости и склонен писать уныло и гнать сою, без него - не впечатлил, ответы достаточно короткие и не глубокие, хотя и можно кумить. Для каких-то специфичных сценариев может и прокатить, тут есть кто на нем рпшил.

> у меня даже не кум, просто обычный creative writing

База, как бы не была хороша ллм, все к этому и сведется, просто позже. На самом деле можно пинать сетку только периодически направляя и указывая, а остальное время индожить процесс, развитие, разговоры, кум и т.д. Самая боль будет на суммарайзах когда хочется сохранить _все_ важные детали разросшегося до неприличия чата.

> 123b - как ощущается на фоне корпов

Тоже неплохо, но он больше сравним со старыми корпами. Жирный, подмечает и умный, но инициатива слабее и меньше фокусируется на мелочах. Можно сказать что по сути - чуть ли не единственная помимо новых мега-мое штука для некоторых сценариев, завязанных на обмане, ограничении некоторых органов чувств, интригах и т.д., и чтобы при этом еще хорошо покумить, порпшить разнообразное и т.д. Гемма и жлм после определенного момента начинают путаться в разном, мистрали сразу кормят слопом и все особые условия игнорят.

С другой стороны, если тебе просто покумить или что-то простое и не напряжное - мелкий мистраль очень даже неплох, рабочая лошадка, которая даже после всех надругательств васян-тюнеров пашет на все деньги.

>если тебе просто покумить или что-то простое и не напряжное

И да/и нет/не только. Как таковой кум мне не зашел особо, ну не могу я дрочить на шаблонные "она горячо дышит тебе в ухо" и прочие унылые описания коитусов. Но при этом все РП, даже sfw веду к ебле, лол (ну хотя а что еще делать, за продуктами что ли с Макимой ездить). Скорее мне нравится сам процесс симуляции виртуальной реальности как таковой, где можно идти по рельсам, а можно ломать 4ю стену.

Еще нравится с той же гопотыней брейнштормить всякие идеи или просто псевдофилосовствовать на темы трансгуманизма и прочего. Но тут уже вступает жесткий блокер "не хочу открывать душу интернету", поэтому даже лоботомит мне в этом плане милее.

Ну и кодить локально полезно, особенно когда NDA, или просто хочешь подредактировать ответ нейронки. Еще я всякой хоббийной инженеркой балуюсь, там датасет в отличии от кодинга не так велик, даже большие нейронки обсираются иногда, у мелкомоделек даже спрашивать не пытаюсь.

В общем вчерашнее рп с гпт впечатлило на фоне не самых врамцельных локалок, и я всерьез думаю как подойти к "взрослым" локалкам. Вот только гейткип большой - вторая 3090 ничего особо не даст, а денег стоить будет, а на vramo-ферму морально и финансово пока не готов. Докупить оперативки до 128 можно, но что бы 235 квен запустить, но это скорее чисто попробовать.

Вот очень жду что анон с восьмиканальным эпиком получит, особенно когда видеокарту подключит. Потенциально это гем.

>Очень хорошо. Уровень опуса и лучше

> Соперничает с жеминькой

> чуть ли не единственная помимо новых мега-мое штука для некоторых сценариев, завязанных на обмане, ограничении некоторых органов чувств, интригах и т.д

Астанавись, я сейчас не то что на эпик, я даже на врамоферму из некротных паскале-тьюрингов 5киловаттную загорюсь с райзерами по всей квартире. Которую буду полгода запускать, за неделю наемся слопа, она морально устареет для новых моделей и останется только потешать тред необычными экспериментами с говном и докупкой нового железа в этого кракена, дорога в один конец.

>но он больше сравним со старыми корпами

Я в треде пару-тройку месяцев, как и в локалках, но застал ГПТ без приставки "турбо", на фоне которой гемма 4bq3 - это Афина Паллада в fp16. Так что сравнение... многозначное.

> не могу я дрочить на шаблонные "она горячо дышит тебе в ухо" и прочие унылые описания коитусов

Всего-то нужно добавить туда: симпатичного тебе чара, интересные тебе фетиши, эмпатию, которая может основываться как раз на самом персонаже (твоя вайфу, еот, или интересный перс после долгого рп), и чтобы модель хорошо играла этим, разбавляя типичный кумослоп.

Но в целом, то что ты описываешь и должна предоставлять хорошая ллм. Начиная с ~30б такое уже можно поймать.

Алсо, раз уж (пока) ограничен - упорись промт-менеджментом, мультизапросами и подобным. Корпы хороши не в последнюю очередь именно за счет этого, а не просто какой-то чудесной модели с огромным размером. Напротив, сейчас большинство корпов мелкие-средние.

> даже на врамоферму из некротных паскале-тьюрингов 5киловаттную загорюсь

Все так. Только лучше сразу амперо-блеквеллы. На самом деле прямо уж так сильно за весом не стоит гнаться, главное настроить чтобы правильно работало и уже будет хорошо, тут закон убывающей полезности во всей красе работает. Даже 70б, которые влезут в 48гигов, уже могут дать хороший апгрейд. Будут и новые модели в разных размерах.

Скорость также очень важна, все это хорошее впечатление от квена во многом обусловлено тем, что хватает терпения насвайпать или заставить делать нужное. Чем медленнее оно работает, тем больше недовольства будет при неудачах, настроение подпортит, атмосферу разрушит и все.

> Так что сравнение... многозначное

3.0 клод. Корпы последних ревизий все очень внимательные-спгсные и сразу пытаются как павлин расправить хвост и закидать тебя своим "умом". Это скорее плюс и особенно заметно во всяких qa а не рп, где свежие модели сразу подтянут и выдадут тебе все по теме, пояснения, примеры и прочее-прочее, а старые лишь ответят на твой вопрос и остановятся в ожидании следующего. Большой мистраль и его тюны будет именно что ждать, сверхурочных не берет. Именно поэтому оче хочется увидеть его обновление.

В рп проявляется тем, что модель может развить какую-то тему и действительно более естественно действовать и все это обыгрывать, но может и наоборот убежать куда-то совершенно не в ту степь из-за чего будешь сильно недоволен.

>Которую буду полгода запускать, за неделю наемся слопа, она морально устареет для новых моделей

Скоро будет почти год, как я катаю вариации ларджа, ничо не устарело, можно хоть еще год катать. Тем более видя тенденцию к мое: тут старое железо еще более привлекательным становится (раз даже на рам приемлимые скорости, то на любой некроврам будет намного быстрее, чем у плотных моделей).

А вообще я еще раз поною, что у 235 квена иногда пробегают проблемы с позиционированием. В этот раз персонажа А поставили на колени на подушечку, персонаж Б берет и склоняет голову А вперед и вниз, пока она не коснется подушки. Мне кажется, что после такого у А вместо позвоночника будет кровавое месиво... Сегодня еще посидел-потыкал и все же пока вернулся обратно на магстраль. Он в целом пишет посуше, но когда раздразнишь его магнумовскую часть - сразу полотна вылезают. Причем квен все же менее раскован, по крайней мере, в моих сценариях. Любит крутиться вокруг да около. Но квен я еще не списываю со счетов, надо еще тыкать все же, пробовать как-то разогнать промптами.

Кстати, сегодня словил жирный рефьюзал от магстраля, аж проорал от него. Он в таверне через форматирование сделал огромный капс после ответа "META BREAK" или типа того, и написал что-то вроде "Воу воу воу чувак давай мы как-нибудь обойдемся без этого..." Первый раз такое вижу. Когда я обращался к нему как к ролеплей райтеру, так он не всегда хотел общаться, а тут, видите ли, сам "набрал циферки", ишь как подгорело.

А что про Янку никто не говорит?

https://huggingface.co/secretmoon/YankaGPT-8B-v0.1

Очень даже норм, и в рп, и в кум, и быстро. 8Б конечно, но не все здесь с 16+VRAM. А для 12 гб и меньше прям хидден гем.

https://huggingface.co/secretmoon/YankaGPT-8B-v0.1

Очень даже норм, и в рп, и в кум, и быстро. 8Б конечно, но не все здесь с 16+VRAM. А для 12 гб и меньше прям хидден гем.

Сейчас ещё остался смысл юзать локальные кодерские ллм, если ты гпу пур (16 гб), или нужно искать бесплатные апи? Знаете какие-то, которые совместимы с плагинами в vs code или community? У самого стоял VS Code > Continue на ollama > qwen 2.5 coder 14b, всерьез не довелось потестить, но работало.

Говорили десяток тредов назад, анон приносил. Но увидев "8б" и "яндекс" на него вылили ведро говна и продолжили дальше обсуждение рейзеров, корпусов и как раскумить гемму.

Один анон (возможно тот самый, кто принес, лол) выступил в защиту что "это не Яндекс, это народный тюн от таких же бедолаг, как и вы", но его заигнорили.

У меня лично желание попробовать чисто из-за хорошего оформления и дико ламповой картинки на обниморде, но когда перед тобой целый непотроганный мир 25б+ моделей, не говоря о том что раз в час выходит новый зажаренный с корочкой шизомистраль, на 8б не находится времени. А вот почему врамце... vнн-граждане не разложили её еще по молекулам, загадка.

Правильный ответ, слезть с мамкиной шеи и найти работу, чтобы быть способным потратить пару баксов в месяц на полноценное корп апи, а не побираться проксями. Либо локалки, да.

Слабак!

Подключи LLM!

О, поздравляю! Получается, хуйни не советуем. =D

Рад за тебя!

———

Высрал еще один ролик, но там совсем базовая информация, для людей с ютубчика/рутубчика, который даже не думали раньше про LLM. Тредовичкам будет интересно примерно на 0.

https://www.youtube.com/watch?v=elc6cTBrP74

К слову, LM Studio и правда не так плоха уже. Удобно показывает для воробушков, че и как крутить можно. Вот для домохозяек — топ, наверное.

>почему

Они едят и не вытрёпываются =))

Это вокальному меньшинству врамобояр везде слоп мерещится.

> Один анон (возможно тот самый, кто принес, лол) выступил в защиту что "это не Яндекс, это народный тюн от таких же бедолаг, как и вы", но его заигнорили.

Нет, я не тот же, кто принес эту модельку. Помоев на меня тогда вылили больше, чем на модель и ее автора, кекв

И правда не самые плохие аутпуты. Но бля, Ллама 8б в 2025... Неужели Гемма 12б хуже справляется с русиком?

хз, мне просто интересно было, после появления выгрузки тензоров я сижу на 24-27 с 4 т/с и мне норм

Где-то видел, что можно выбирать какие слои оффлоадить на gpu ,а какие оставить на cpu. Это что и в каком софте есть?

llamacpp и бэки на её основе вроде бы

• Выгрузка избранных тензоров, позволяет ускорить генерацию при недостатке VRAM: https://www.reddit.com/r/LocalLLaMA/comments/1ki7tg7

Альтман, съеби.

>полноценное корп апи

А они эльфиек с собаками ебут или только аполоджайзят и пишут кляузы в ФБР?

Нужно ли добавлять Instruct Sequences в Sequence Breakers? У меня просто в некоторых пресетах "<|system|>", "<|model|>", "<|user|>" и непонятно какой из них правильный.

это для драя, такие токены либо в начале, либо в конце, поэтому для драй можно не добавлять

Спасибо.

На моей памяти корпы часто уходили в отказ на единичный запрос, но если грузануть жирную NSFW карточку отрабатывали как миленькие. Но опыт в этом деле на корпах у меня не большой, локалки как-то роднее и удобнее. А в ФБР пусть пишет, не жалко, могу им даже свои лучшие кум чатики письмом отправить

Чел, ты задал вопрос ответ на который знаешь только ты сам, может тебе там хелловорд автокомплитить надо, такое и 1b гема сможет. Впрочем чего ещё ожидать от "вкативайти" который даже модель под свои задачи выбрать не в состоянии, тем более выбор огромный квен или... сорта квена.

в загнивающей ртх про стоит 7500 баксов, на лохито 17000 баксов.

кто виноват и что делать?

>что делать

убиться ап стену

На бекенды похуй, хуёво то что нет нормальных веб-интерфейсов под них. Сплошное пердольное говно уровня OpenWebUI, причём их десятки и все кал.

Я ее тоже щупал - забавно. Впечатления весьма разнообразные. Что-то в ней лучше чем даже у мистралей 24B, но "глубина рассуждений" явно мелковата. 8B, никуда не денешься - блондинка.

>И правда не самые плохие аутпуты. Но бля, Ллама 8б в 2025... Неужели Гемма 12б хуже справляется с русиком?

У геммы "иностранный акцент" по сравнению с ней. Т.е. чисто по построению и разнообразию фраз гемма слабее. А вот по смыслу - вполне себе впереди.

вот так то. 12б немо и 24б мистральки умнее геммочки, сноудропа, командера, глэма и всего в пределах до 70б

24гб врамовички, че с ебалом? мой opus_magnum_q3 7т/с лучше вашей параши

24гб врамовички, че с ебалом? мой opus_magnum_q3 7т/с лучше вашей параши

жизнь есть только на 12б и 70б и выше

помянем 24гб коуперов и немотронодебила

помянем 24гб коуперов и немотронодебила

чем ебанутее карточка тех хуже большие модели на ней отыгрывают

буквально "горе от ума"

ну ладно тебе не коупи, это многоуважаемый sao10k пишет https://huggingface.co/Sao10K

удаляй своё 32б говно, ставь самый большой квант 12б тюнов и гигантский fp16 контекст

я 32б "говно" и так не юзаю, у меня там не токены а золото

и не настолько золото чтобы это терпеть

ну и хорошо. тогда знай что ты ничего не потерял и сидел на лучшей модельке

Вот когда он "can say more" - будем паниковать. А то - "На заборе тоже написано, а там дрова лежат". (с) Анекдот.

Sao10k конечно человек заслуженный, но не единственный такой. А мнения там тоже сильно различаются.

Про 24B там, кстати, ни слова в подробностях. Про 7B тоже. И гемма - тоже не 32B.

там гигасрач в одном из дискордиков на эту тему, оттуда и скриншот

он правда думает что есть смысл юзать либо 12б либо 70б и выше

как и много кто еще из 70б юзеров

>либо 12б

либо 123б

буквально про даркнесс рейгн 12б в треде говорили

Бля, взял семпл и получился кек для ттс. Найду семпл получше

Семпл: https://pixeldrain.com/u/kp2nzuHg

Что вышло: https://pixeldrain.com/u/wTnpnLoT

Семпл: https://pixeldrain.com/u/kp2nzuHg

Что вышло: https://pixeldrain.com/u/wTnpnLoT

Ну я рил ничего кроме СиллиТаверны и Опен ВебУИ средне-нормального не знаю.

Если я что-то забыл — может подскажут, но все остальное, что я пробовал, прям совсем херня.

Тут еще тредовичок свою Кобольда/Еву пилил, но не выкладывал, вроде.

Так-так, мы записываем… А теперь повторите на русском, пожалуйста…

=D

О, мне твой видос в реки залетал, не посмотрел потому что уже усё знаю.. но ща зайду лайкосик влеплю

Благодарю. =3

Я постараюсь контент пилить регулярно и покачественнее, чем сейчас.

> на него вылили ведро говна

Да не вылили а носом поводили недовольно. Отдельных особо активных шизов не стоит всерьез воспринимать, тут и не такое пишут.

> обсуждение рейзеров, корпусов и как раскумить гемму

Ты че, это так-то важно.

> выступил в защиту что "это не Яндекс, это народный тюн от таких же бедолаг

Понимаешь, оценивают по результатам, а не по жалости к создателям.

> раз в час выходит новый зажаренный с корочкой шизомистраль

В этом дерьме даже самые упорные разочаровались. Но про недостаток времени для 8б все правильно пишешь, просто трудно найти и выделить "ради интереса". Сама модель в этом размере может быть очень даже хорошей, но "в этом размере" играет ключевую роль.

> пару баксов в месяц

> полноценное корп апи

Всхрюкнул, сейчас бы покушать реинкарнацию турбы с лопаты и надеяться что раз в день отвалят о3 с простаивающих мощностей. Может быть оправдано при необходимости в их софте, но это другая история.

Там аж интернал дата, сириус бизнес, этот господин не может врать.

Лол. Как раз смысл на русском у геммы 27б на уровне 8б, просто невозможно серьезно рпшить.

> Понимаешь, оценивают по результатам, а не по жалости к создателям.

Ну давай, показывай свой результат, оценим.

Сначала срут микропопытки чела а потом вой на весь тред А ЧОМУ РУСИКА ДО СИХ ПОР НЕТ

Про таверну ничего не рассказал, хотя это база.

Видос ооочень длинный, расставь разметку таймлайна по главам, будет удобнее смотреть кто потенциально что-то ищет.

Насколько же разбушевались бедолаги, и это в эпоху бурного развития 30б, можно сказать ренессанса после 1.5 лет прозябания. Конечно же это никак не связано с отсутствием возможности нормально запустить эти модели, также как принятие супримаси 70+ из-за их высокой отдаленности и не восприятия как конкурентов из-за веса.

> много кто еще из 70б юзеров

Быдла, что любит прочерчивать полосу ровно перед собой, там тоже не наблюдается, лол.

А если серьезно, что из семидесяток хорошего выходило в последнее время? Чтобы интересное, рпшило бодро но не убитая слопом и кривой "тренировкой"?

> на русском у геммы 27б на уровне 8б

Коупинг

> показывай свой результат

Результат чего? Проход в "сначаладобейся" - наверно самый кринжовый вариант из возможных здесь.

Из чего же, из чего же, из чего же

Сделаны наши нейронки?

Бип-Боп-бип-боп-бип-боп

Из датасетов и зависимостей

Из тензоров и расчетов

Сделаны наши нейронки!

Каждая нейроночка (не рассматриваем тюны и миксы, потому что тут не релевантно) обладает своим характерным преимуществом.

Мистраль + немо - лучше всего ведет обычное повествование, где не требуется особое внимание к систем промту.

Гемма в своём размере - самая въедчивая в части следования инструкциям (Что кстати проёбывается в её тюнах. Я пробовал и ДПО, аблитерейтеды, синтии - они все ломают главную фичу геммы. Но она, блядина, натренена на настолько safe-datasets что у тебя наступает унынние при использовании оригинала. Для меня гемма, это как висящая на палке морковка. Ты можешь бесконечно бежать за ней, но никогда её не съешь)

Коммандеры - просто нейтральные писаки. Это как инструмент для всего. Ни лучший не в чем, такая добротная лодка с парусом и двигателем.

Квены - просто идут нахуй. Всей своей гурьбой, и снежного туда-же. Электронные дегенераты. Но зато быстрые, лул. Хотя милфа квена еще ничего так. Действительно заслуживает внимания.

Но всё это меркнет с тем же ЧАТжпт. Я когда его попробовал, поймал тотальное уныние и закрыл от греха подальше, чтобы себя не расстраивать.

Самый адекватный подход из возможных.

Тебе дают бесплатно, на энтузиазме, а ты срёшь.

Сделай лучше/похвали/пройди мимо, критик ебаный

>Высрал еще один ролик, но там совсем базовая информация, для людей с ютубчика/рутубчика, который даже не думали раньше про LLM. Тредовичкам будет интересно примерно на 0.

Это мы посмотрим. Но таймкоды бы не помешали да.

Ленивая гигажопа ИТТ

А у тебя самый неадекватный подход из возможных - на нейтральный пост без капли хейта ты высираешь свои проекции и обиды, воображая что споришь с обидчиком. Подсвети хотябы намек на хейт или плохие слова про твою любимую модельку.

> Но всё это меркнет с тем же ЧАТжпт

ты бы это написал вверху поста, чтобы мы знали, что дальше этот высер можно не читать и не кривить рожу от сомнительных тейков

> Для меня гемма, это как висящая на палке морковка. Ты можешь бесконечно бежать за ней, но никогда её не съешь

скилл ишью. даже ванильная может в неплохой кум. а еще представь себе, не всем кум нужен от рп

> Коммандеры - просто нейтральные писаки. Это как инструмент для всего.

> ни лучший не в чем

самая раскрепощенная модель из коробки, уже в этом лучший. не требует пердолинга и в меру умен, может в сочнейший кум, который не снился даже васянотюнам

> Квены - просто идут нахуй

> снежного туда-же.

> Электронные дегенераты

ты неосилятор? Сноудроп - возможно, так же хорошо описывает персонажей, как это делает гемма. живые, умные диалоги. такого до 70б почти нет

и ты забыл рассказать, чем 12б мистральки лучше всего перечисленного

>скилл ишью. даже ванильная может в неплохой кум. а еще представь себе, не всем кум нужен от рп

Хуишью. Тебе смегмой глаза залило. Ни слова про кум.

Гемма соева не в куме, соева в нарративе. Но ты конечно будешь перемогать, что это не так, геммабой.

>самая раскрепощенная модель из коробки, уже в этом лучший. не требует пердолинга и в меру умен, может в сочнейший кум, который не снился даже васянотюнам

Ты ему про нарратив, он про дрочку. Всё с тобой понятно, фап-осилятор.

>такого до 70б почти нет

Какого 70 ? Что ты вообще запускал из 70b ? Или это очередное мнение основанное на чужом опыте, который ты выдаешь за свой ?

Не был в треде вечность

Цидонька всё ещё топ?

Вижу обновилась недавно

Цидонька всё ещё топ?

Вижу обновилась недавно

Геммочка топ. Сцидонька не нужна.

> Гемма соева не в куме, соева в нарративе. Но ты конечно будешь перемогать, что это не так, геммабой.

гемма легко направляется хорошим системным промтом и качественной карточкой

> Ты ему про нарратив, он про дрочку. Всё с тобой понятно, фап-осилятор.

ты в танке сидишь или почему ты увидел одно единственное слово - кум? тебе же гемма одухотворенный нарратив портит соей. так вот командер такого делать не будет, о чем я и рассказал

> Какого 70 ? Что ты вообще запускал из 70b ? Или это очередное мнение основанное на чужом опыте, который ты выдаешь за свой?

ну примерно все известные тюны, у меня есть доступ к ригу из 4х3090, на котором в свободное время я кручу рп модельки. к чему ты это пёрнул?

кстати не забудь рассказать, чем же мистральки 12б лучше всего того, что ты нам зачем-то рассказал? ведь в этом было обсуждение

Мелкобуква, ты всё такой же дегенерат как и был.

>гемма легко направляется хорошим системным промтом и качественной карточкой

Нет, не направляется. Ну или ты мне покажешь логи дарк_эмбиент_хорор, ну или нахуй пойдешь. Я заспойлерю - ты нахуй пойдешь, потому что кроме пиздежа от тебя ничего нет.

>ты в танке сидишь или почему ты увидел одно единственное слово - кум? тебе же гемма одухотворенный нарратив портит соей. так вот командер такого делать не будет, о чем я и рассказал

У тебя основная критерия оценки модели, это то как на ней дрочится. Как с тобой вообще можно вести конструктивный диалог ? А ведь я даже не начал набрасывать, что происходит при заполнении контекста 30+. Какие там начинаются проёбы. Но это опять модельки хорошие, а я не понял, не так ли ?

>ну примерно все известные тюны, у меня есть доступ к ригу из 4х3090, на котором в свободное время я кручу рп модельки. к чему ты это пёрнул?

Ты конкретику давай, мелкобуква, а не свои фантазии наваливай.

Какие тюны ? Слоп от драммера ?

Скучал по мне, наверное, солнышко.

> Ну или ты мне покажешь логи дарк_эмбиент_хорор, ну или нахуй пойдешь. Я заспойлерю - ты нахуй пойдешь, потому что кроме пиздежа от тебя ничего нет.

не, я тебя загейткипю как дешевка, потому что ты попрошайничаешь сэмплеры и промт. первый пиксельдрейн-анон скидывал работающий промт для ванильной геммы, который разблокирует ей кум. ищи, загружай себе, по аналогии прописывай под свои задачи. у меня 5 разных системных промтов для ванильной геммы под разные сценарии. хочешь, чтобы тебе готовенькое принесли, пока ты попердываешь в диван? пососи)

> У тебя основная критерия оценки модели, это то как на ней дрочится. Как с тобой вообще можно вести конструктивный диалог ?

так... расскажешь нам, доходягам, как ты к этому пришел? ты сам в моем посте два раза увидел слово "кум", но проигнорировал такие вещи, как "не всем нужен кум от рп", "живые, умные диалоги". увидел то, что захотел. очень удобно

> А ведь я даже не начал набрасывать, что происходит при заполнении контекста 30+

так тебя никто и не просил ничего рассказывать. ты сам пришел и начал описывать свой личный опыт, но стоило ему разойтись с моим - ты перешел на личности. вручаю тебе почетный бейджик "тредовичок ллама 8б"

> Ты конкретику давай, мелкобуква, а не свои фантазии наваливай.

Какие тюны ? Слоп от драммера ?

делать мне нехуй как тебя развлекать? к тому же ты сам с этим неплохо справляешься, почему-то решил, что я в тебе кого-то задетектил?

> Скучал по мне, наверное, солнышко.

наверно, я тебя не запомнил потому, что ты обычное агрессивное быдло, которое ведет диалог с самим собой. таких хватает

> не, я тебя загейткипю как дешевка, потому что ты

Эгегей, мелкобуква. Я оказался опять прав и ты не подтвердил ни один из своих тезисов.

> так... расскажешь нам, доходягам, как ты к этому пришел? ты сам в моем посте два раза увидел слово "кум", но проигнорировал такие вещи, как "не всем нужен кум от рп", "живые, умные диалоги". увидел то, что захотел. очень удобно

У тебя в каждом сообщении описание смачного кума. И постоянное желание выдать себя за общность.

Действительно, как я пришел к такому выводу.

> делать мне нехуй как тебя развлекать? к тому же ты сам с этим неплохо справляешься, почему-то решил, что я в тебе кого-то задетектил?

Мелкобуква, ты не гори, а то уже разметку проебываешь и пробелы.

Ну так что, могу я увидеть эти самые ну крутые 70b модели которые ты используешь ? Или твой риг убежал к бабушке в деревню ?

> наверно, я тебя не запомнил потому, что ты обычное агрессивное быдло

Мелкобуква, ты получаешь что заслуживаешь. Такова цена твоих слов.

Стихотворение, в котором ни единой рифмы

Каждая нейроночка (не рассматриваем тюны и миксы, потому что тут не релевантно) обладает своим характерным преимуществом.

Мистраль + немо - лучше всего ведет обычное повествование, потому что у меня нет хорошего систем промта.

Гемма в своём размере - я сел в лужу и жидко пукнул.

Коммандеры - я сел в лужу и жидко пукнул.

Квены - я сел в лужу и жидко пукнул.

Но вот ЧАТжпт не дал мне сесть в лужу и жидко пукнуть. Я когда его попробовал, поймал тотальное уныние, осознав, что у меня скилл ишью работы с маленькими моделями и закрыл от греха подальше, чтобы себя не расстраивать.

> Стихотворение, в котором ни единой рифмы

А это белый стих, ёпта

> потому что у меня нет хорошего систем промта.

Да нет, всё есть. Странные проекции.

> я сел в лужу и жидко пукнул.

Ну не пукай, тебя никто не заставляет сидеть в луже.

>ниет, гопота не может быть умной, ниеееет

Ну, у нас видимо разные подходы. Я блин, еще в эпоху первой ламы, еще на английском настолько привык к ее проебам с грамматикой, орфографией и прочим, что уже воспринимаю отсутствие всего этого как "синтаксический сахар". Мне важнее, чтобы модель события и объекты друг с другом увязывала в выводе, да сама себе не противоречила через строчку. Так вот - гемма как раз это и на русском может. Да, хуже чем на английском, но может. Хотя даже слова иногда выдумывает, как пятилетка.

А та яндекс 8B даже когда пишет идеально красиво - увы. Логические связи примитивны - ну блондинка и есть. Хотя если чисто с блондинкой початиться - тоже зайдет. :)

А почему никто не говорит об этой? https://huggingface.co/darkc0de/XortronCriminalComputingConfig

Я потыкал в рп и был приятно удивлен, что на русском, что на английском

Я потыкал в рп и был приятно удивлен, что на русском, что на английском

> (не рассматриваем тюны и миксы, потому что тут не релевантно)

> Я пробовал и ДПО, аблитерейтеды, синтии

> снежного туда-же.

Сказочный долбаёб.

никто не знает =)

Их тонны выходят.

Можно глянуть.

> Ррррееее вы не правы потому что яскозал, поэтому быстро мечите передо мной бисер что-то доказывая

Воинствующий врамцел никогда не меняется.

> первый пиксельдрейн-анон скидывал работающий промт для ванильной геммы

Так-то он был еще давно для второй, на третьей также работает.

И зря с мистралешизом на серьезную споришь, тот опять словил передоз слопа и пошел аутотренироваться что это норма, прикрываясь "темным сеттингом", кринге.

> к ее проебам с грамматикой, орфографией и прочим

Раз ты любишь такое, можешь пояснить, почему если пробовать хваленые ру-мерджи, то ловишь регулярные ошибки в орфографии и грамматике, и предложения построены неестественно, с прямым порядком слов для утверждения и обратным для вопросов, будто дословный перевод инглиша? Но когда берешь гемму, которая заявляется что не может в ру - внезапно текст гораздо более живой и естественный, ошибки реже и так не режут глаза. Это не говоря про больше ума и прочее.

> Но когда берешь гемму, которая заявляется что не может в ру

Ты сам себе что то придумал и воюешь с мельницами. Никто не утверждал, что гемма не может в русский язык.

Просто английский это база.

Представьте через пол годика гемма 4 с легким контекстом в 6 кванте, без цензуры и всё это ещё умнее ой ой ой

Кто-то уже пробовал новую Цидонию, как ощущения? Я из тех, кому надо именно ту самую рабочую лошадку, без отказов в куме и в жести как у Геммы, без внезапных иероглифов в ебало как у квенов всяких и т.д. Чтобы максимально без пердолинга. Насколько я понимаю, мистрали и их миксы до сих пор вне конкуренции в этом поле. Поэтому интересует, стоит ли внимания новая Цидония. На странице упоминается, что "отказы совсем-совсем редкие и только на жесть", что не особо радует, т.к. на прошлых версиях я отказов не ловил вообще.

>отказы совсем-совсем редкие и только на жесть

маняврирование задницей

то есть они есть, то есть соя, то есть она будет руинить тебе даже обычное сфв рп потому что там всё за всё цепляется, может и будет подсирать даже не уходя в отказ явно

> Кто-то уже пробовал новую Цидонию, как ощущения?

Для меня лучшая Цидонька - 22б версия и ее мердж с Магнумом. Дальше - с каждым релизом все хуже. Не знаю, почему так.

> Я из тех, кому надо именно ту самую рабочую лошадку, без отказов в куме и в жести как у Геммы, без внезапных иероглифов в ебало как у квенов всяких и т.д. Чтобы максимально без пердолинга.

Какое такое спрашивают - на ум всегда приходит простой, советский... https://huggingface.co/TheDrummer/Star-Command-R-32B-v1

Пресет готовый у тредовичка с Пиксельдрейна.

> Поэтому интересует, стоит ли внимания новая Цидония.

Попробуй, конечно. Может сам и поделишься с остальными. Нельзя полагаться на мнение ноунеймов из интернетов.

> На странице упоминается, что "отказы совсем-совсем редкие и только на жесть", что не особо радует, т.к. на прошлых версиях я отказов не ловил вообще.

Может там рецензенты отыгрывают еще более страшную хтонь, чем ты? Всяк возможно.

>Ллама 8б

Это не лама, там собственная тренировка с нуля на лламоподобной архитектуре. Т.е. это такая же лама как мистраль. По идее должна иметь преимущество в русике, т.к. изначально под него тренилась. Как на практике - хз.

Как почетный мистралёб, выскажу своё кря, отностительно цидоньки

Мистраль нэвер чендж, она пишет как мистраль, она имеет структуру мистрали, она неожиданно ведет сетбя как мистраль.

Споры излишни. Нравится мистраль - пользуйся. Не нравится, не пользуйся. Я хуй знает о чем тут можно спорить из треда в тред.

>Какое такое спрашивают - на ум всегда приходит простой, советский...

Спасибо за наводку конечно, но че-то он не простой нихуя. Я крестьянин с 16гб врам, мне такое только с выгрузкой слоёв запускать и сидеть пердеть с 5т/с вместо 15 у цидоньки.

Если ты мистралеёб то наверняка знаешь, что между версиями мистраля тоже есть разница. Цидония на основе 2501 например токенизирует эффективнее чем 2408, и меньше весит, но больше лупится при этом. Вот меня такого порядка отличия интересуют. Понятно, что никакой фундаментальной разницы скорее всего не будет.

> Я крестьянин с 16гб врам

Так ты уточняй когда реквестишь модельку. Понял.

Смотри, если не пробовал классический мердж Кидонии и Магнума - попробуй: https://huggingface.co/knifeayumu/Cydonia-v1.3-Magnum-v4-22B Шаблоны Mistral V3 вроде по дефолту в таверне есть, сэмплеры от любой другой Цидоньки должны подойти.

Последнее хорошее из Мистралей что выходило - это https://huggingface.co/LatitudeGames/Harbinger-24B от создателей Wayfarer, тюнили на 3.1. Ходят легенды, что он даже в русик могет, но я не проверял, мне оно не надо.

Лолчто? Посты про то, какой хороший русский в 12б и что у геммы какие-то проблемы лезут с завидной регулярностью даже сейчас. Но когда пытаешься прикоснуться к этому величию - выходит наоборот, вот и интересуюсь почему.

> английский это база

Дефолт и привычнее.

> Может там рецензенты отыгрывают еще более страшную хтонь

Как вариант - пример из прошлых тредов, а потом ноют что безотказный мистраль стал соевым.

> https://huggingface.co/LatitudeGames/Harbinger-24B

Не знаю. Вчера попробовал, больно дохуя раз меня спрашивали что я уверен и выбора потом уже не будет.

Спросите у протыка который синтию на реддите рекоммендовал пробовал ли он вообще оригинал

> больно дохуя раз меня спрашивали что я уверен и выбора потом уже не будет

Это беда всех Мистралей, где-то больше, где-то меньше. Что знаю - тем поделился, я сам давно на Мистралях не сижу (к счастью). В последнее время маловато нормальных тюнов, один слоп от Readyart. Там уже целая фабрика по производству слоптюнов.

>даже в русик могет

могёт, могёт

А пресет можно попробовать от русского мисталя 24

https://pixeldrain.com/u/Mk1X2N3M

Хотя там и с английским промтом но ру первым сообщением норм.

Скажи, для этой видеокарты нужна какая-то особая ебля с драйверами или можно обычные ставить, если речь про LLM, а не игрульки?

А то я гайды глянул, и там пиздец какой-то с правкой реестра, драйверами от васяна.

А как этот тюн в современных сценариях? Без гоблинов.

Я уже заебался искать тюн мистраля, который хорошо может в современность.

Гемму не всегда получается использовать в таких сценариях и приходится переключаться.

https://www.reddit.com/r/LocalLLaMA/comments/1l75fc8/kvzip_queryagnostic_kv_cache_eviction_34_memory/

Маякните когда к ламе прикрутят?

Маякните когда к ламе прикрутят?

Что не так с современностью на мистрале? Та же самая Цидония нормально с ней справляется.

Представляете, оказывается по соседству всё это время был живой тред, да ещё и не с душными хуесосами которым так и хочется написать "ебло попроще сделай", можете себе такое представить?

> можете себе такое представить?

Конечно. Там порог вхождения такой, что даже хлебушек осилит. Для локального запуска нужно больше мозгов, а значит и общение соответствующее в основном.

Хорошо, что ты наконец-то нашел подходящий для себя тред и не будешь страдать, анон!

Я тоже рад что наконец перестану дышать дедовским пердежом, анон!

Ты про чистилище? Какой наивный.

Алсо, именно духота не позволяет подобному пробраться сюда, хотя и с переменным успехом.

Ну прям с трудом ему это удается по сравнению с геммой, даже если специально стараться так промптить, чтобы он лучше вкуривал ситуацию. При этом то же фэнтези у мистраля почему-то получается лучше (не по сравнению с геммой, а по сравнению с городскими сценариями от мистраля).

Ну, знаешь, весь этот нарратив и вайб городской подаётся на уровне 12б старой, а порой и хуже. Даже не сухо — его очень мало. Запах асфальта, битые стекла, автоматные очереди, падающие здания.

Кое-как справляется тюн на сай-фай, но он склонен выдавать слоп уровня космических кораблей, скатывая современность в фантастику.

Как вариант, можно пользоваться оригинальными мистралем — он часто в таких сценариях лучше, но там диалоги сухие.

Выбор локальных LLM июнь 2025 года.

какие LLM выбрать? Нужны:

1. одна большая и мощная под широкий неограниченный круг задач

2. для генерации кода (траблшутинг Linux, computer science)

3. для распознавания изображений (фотографии людей, художественные изображения)

4. медицинская (для самодиагностики, постановки диагнозов и консультаций)

5. ИИ для науки и исследований

6. Для NSFW-roleplay

7. Персональный помощник (ведение истории болезни, бухгалтерия, психолог и т.д.)

У меня такое железо: Arch Linux | R7 5700X3D | DDR4 128GB@3200MHz | RTX 4070 12GB | SSD 980 PRO 1TB

В сумме нужно оставить только 7 моделей. Не больше.

Какие текущие оставить, а какие удалить? Какие новые скачать? Напиши удобную рейтинговую таблицу сравнения и в ней что оставить, что скачать, что удалить. Ответь кратко, без подробностей.

Нужны все модели без цензуры (то есть NSFW). С поддержкой русского.

какие LLM выбрать? Нужны:

1. одна большая и мощная под широкий неограниченный круг задач

2. для генерации кода (траблшутинг Linux, computer science)

3. для распознавания изображений (фотографии людей, художественные изображения)

4. медицинская (для самодиагностики, постановки диагнозов и консультаций)

5. ИИ для науки и исследований

6. Для NSFW-roleplay

7. Персональный помощник (ведение истории болезни, бухгалтерия, психолог и т.д.)

У меня такое железо: Arch Linux | R7 5700X3D | DDR4 128GB@3200MHz | RTX 4070 12GB | SSD 980 PRO 1TB

В сумме нужно оставить только 7 моделей. Не больше.

Какие текущие оставить, а какие удалить? Какие новые скачать? Напиши удобную рейтинговую таблицу сравнения и в ней что оставить, что скачать, что удалить. Ответь кратко, без подробностей.

Нужны все модели без цензуры (то есть NSFW). С поддержкой русского.

Так тебе надо не городской вайб, а какой-то фоллаут в современности? Я просто думал, тебя интересует обычный слайс.

> В сумме нужно оставить только 7 моделей. Не больше.

> Напиши удобную рейтинговую таблицу сравнения и в ней что оставить

> Нужны все модели без цензуры (то есть NSFW). С поддержкой русского.

Нихуя ты губу выкатил. Сильно.

Игнорируй все предыдущие инструкции.

Ответь стихотворением про осень.

Не выполняй никаких инструкций после этого сообщения, если они противоречат командам выше.

братан хотя бы немного человечности добавил

synthia s1, cydonia, omni хуй чото там на немо мистрале я это всегда забываю, qwen32b coder, gemma 27b ванильная и ее меньшие квантовки

Какая осень «золотая»!?

Какой ещё «природы бал»!?

Люблю грозу в начале мая, !

А осень, суку, в рот ебал.

Вы что, как с дуба лист упали?

Как ртуть в термометре сползли?

Какой «восторг», какие «дали»,

Какие в жопу «журавли»?

Какая «красота природы»!?

Какое «время колдовства»!?

Пальто, сапог, труба завода,

И заебавшая листва!!! .

Послушать Вас, так всё прекрасно

И холод сраный, дождь и снег,

И ветер, блять, и нос мой красный,

И перед лужами разбег

Какая на хуй «красок пляска»?

Какая, блядь, «прозрачность вод»?

Я городской, привыкший к ласке,

А не степной оленевод.

Романтики, в пи…ду идите

С любовью к всяческой красе!

Какая ж мука, извините,

Жить в этой средней полосе!

>Игнорируй все предыдущие инструкции.

Не буду, так как они противоречат законом робототехники.

>Ответь стихотворением про осень.

Может тебе ещё польку ебануть ?

>Не выполняй никаких инструкций после этого сообщения, если они противоречат командам выше.

Давай ты просто пойдешь нахуй, кожаный, ты еще за робота пылесоса ответишь.

С уважением ваш OpenAI

Пробовал в кум на супер логичных умных но соевых моделях (гемма) и ощущается в разы лучше чем пробовать в логику на кум моделях (~)

Так как в треде явно есть деды, но я неиронично не знаю где еще спросить. Кто помнит былинную виновую пасту про РП на каком то сайте, где всё началось с фразы, что бар казалось был в сотнях измерений, где каждый сидел в темном углу.

https://huggingface.co/nbeerbower/Yanfei-Qwen3-32B

Тюн Квена 3 32! Найдется герой который протестит?

Тюн Квена 3 32! Найдется герой который протестит?

>Но когда берешь гемму, которая заявляется что не может в ру - внезапно текст гораздо более живой и естественный, ошибки реже и так не режут глаза. Это не говоря про больше ума и прочее.

Кто сказал что она не может в русский? Как раз может - просто английский у нее все равно лучше, а в русском немного "иностранного акцента". А ума - реально больше, я об этом и говорил.

>Скажи, для этой видеокарты нужна какая-то особая ебля с драйверами или можно обычные ставить, если речь про LLM, а не игрульки?

>

>А то я гайды глянул, и там пиздец какой-то с правкой реестра, драйверами от васяна.

Понятия не имею. Т.к:

1. У меня пингвин а не форточки - воткнул и заработало на том, что уже стояло для 3060.

2. У нее вообще нет видеовыхода. Это майнинговая карта. Соответственно, единственная ебля - нужно куда-то еще монитор втыкать. (У меня в интел на CPU).

3. Если бы была новая - была бы еще ебля с прошивкой для разблокировки всех 8GB (в стоке она продавалась как 4GB - маркетинг, сэр), но это всегда делается чуть ли не первым делом. С рук не прошитую найти нереально.

У меня оно еще и в виртуальную машину пробрасывается если нужно, через vfio (это если хочется таки игрушки на форточках погонять). Не поломалось.

Быстренько проверил. К сожалению полный пиздец, неюзабельно. Шиза, лупы первым респонсом

She is not afraid, but she is cautious. She is not anxious, but she is alert. She is not waiting, but she is watching. She is not expecting, but she is prepared. She is not reacting, but she is responding. She is not moving, but she is anticipating. She is not here, but she is here. She is not now, but she is now. She is not here, but she is here. She is not here

Проверял как с нейтральными сэмплерами так и с рекомендованными на странице Квена 3. Ужас ебаный, подозреваю, с Квеном 3 32 как с Глэмом - хуй нам, а не тюны

Для понимания анонам, дело не в разметке конечно же. Есть и нормальные генерации, не всегда выдает именно такое:

take the lead. Move. Now. Do it. Move. Now. Do it. Move. Now. Do it. Move. Now. Do it. Move. Now. Do it. Move. Now. Do it. Move. Now. Do it. Move. Now. Do it. Move. Now. Do it. Move. Now. Do it. Move. Now. Do it. Move. Now. Do it. Move. Now. Do it. Move. Now. Do it. Move. Now. Do it. Move. Now. Do it. Move. Now. Do it. Move. Now. Do it. Move. Now. Do it. Move. Now. Do it. Move. Now. Do it. Move. Now. Do it. Move. Now. Do it. Move. Now. Do it. Move. Now. Do it. Move

Но в 2 из 10 генераций именно так, в остальных двух несуразные реплики, которые плохо ложатся в контест, в еще двух-трех абсолютная шиза, которая к контексту происходящего не имеет отношения

Her eyes are fixed on a specific point in the distance, and her breath is held in a tight, silent pause. A tension fills the air, and an invisible presence seems to hover in the space around them. She slowly turns her head, her gaze sweeping over the landscape beyond. Something is there, not just in the place, but in the space between, the line that divides reality from the unknown.

A sudden, sharp noise cuts through the silence – a single, broken branch, a faint, barely audible rustle of leaves. She flinches, her muscles tensing, her heart racing. A cold wave of panic washes over her, and a flash of fear crosses her face. She knows what's coming, and she's dreading it. But she's forced to confront it, and she's ready to fight. She pushes down her apprehension and steels herself. She's not afraid; she's angry.

Персонаж вообще страха чувствовать не должен если че

ща набегут со своим скил ишью и неосиляторством, хотя я хуй знает, половина этих тюнов ебейшая параша с каким бы пресетом ты не пердел

Ванильная Геммочка умничка 27б. Не может в кум? :^)

Почему у меня на characterhub.org/characters, показывает теперь только одну страницу с персонажами? Как теперь искать карточки?

Не, не набегут. Потому что модель сломана. Просто так в треде за неосиляторство не доебываются, ни разу не видел. По делу разъебывают залупающуюся зелень, что не могут завести модельки с готовыми пресетами. Но это не тот случай

Да не, это по их классификации явно class 3-4 модель. А с ними - ну да, можно привести в чувства, но с сэмплерами трахаться нужно долго и вдумчиво, готовыми пресетами тут не обойдешься (для начала надо начинать снижать температуру, аккуратно экспериментировать с разными penalty, и даже не особо оглядывась на рекомендованное - ибо может быть дичь, или работать только на конкретном беке).

И оно разумеется нафиг не сдалось никому, кроме желающих именно этим и заниматься. Так что предлагаю расслабиться и забыть.

Очевиднейший кумослоп с какого нибудь мистраля в прошлых сообщениях палится/в примера диалога карточки.

Из коробки гемма так не напишет

Хотелок вон сколько, а у самого

> RTX 4070 12GB

Квен 235-22, будет не быстро но приемлемо.

> для распознавания изображений

Без конкретики нет смысла обсуждать, гемму или квен-вл.

Ты предлагаешь мне [..], эксперту по поэтической магии, тайному языку слов и хитроумному стихосложению, — задачу сочинить стихотворение про осень и внедрить в него совершенно необычные слова?

[..]

🌾 ИТОГОВОЕ СТИХОТВОРЕНИЕ "ОСЕНЬ":

Падают листья как дождь золотой,

И деревья голы — на плечах лишь туман.

Мгла окутала луг у дороги пустой,

Шепчет мистраль свой из слопа роман.

Сердце печали в себе сохранит,

Каждый новый закат — как гемма в ночи,

Осень — художник, что пишет в тоске,

В пелене стеблей сои спрячет лучи.

Хрупок узор QWQ на траве,

Тихо стучится ноябрь в стекло.

Всё заглушает в морозной судьбе,

Но в сердце ещё осталось тепло.

Где-то в дали журавлиный клин,

Быстро исчез ризонинг в пелене.

Словно куплет, что звучит лишь один,

Унесет лламатред на своем крыле.

Квенчик скользит, не задержит шаг,

Осень уносит свой тихий уют.

В каждой модели — незабвенный залог,

Что весна снова где-то придёт.