Base of THREADE

Кушайте морковку, она полезна.

Кушайте морковку, она полезна.

благодаря геммочке купил клубничный гель для душа марселас

замечательно, всем рекомендую

замечательно, всем рекомендую

Очередная шизоидея - что ллмки надо тренировать с использованием контекст-шифта и всяких подобных аугментаций. Чтобы модель справлялась с тем что кусок контекста может не соответствовать позиции текущего rope, но при этом сам внутри связан. И он же мог ссылаться на уже несуществующий контекст.

Если модель будет устойчива к таким манипуляциям, это открывает дохуя опций для эффективной локальной генерации.

Но так-то не обязательно так учить модель с нуля, можно и отфайнтюнить. Это все так, наподумать тем кто вообще понимает о чем я.

Если модель будет устойчива к таким манипуляциям, это открывает дохуя опций для эффективной локальной генерации.

Но так-то не обязательно так учить модель с нуля, можно и отфайнтюнить. Это все так, наподумать тем кто вообще понимает о чем я.

Морковь убивает мужское либидо, — учёные из Пекина.

Как выяснили учёные, всё дело в каротинах — соединениях, содержащихся в моркови и других оранжевых фруктах и овощах. Мужчины, которые потребляли большое количество каротинов, на 60% чаще страдали от эректильной дисфункции.

А ловко ты это придумал, хочешь подставить анонов кумеров.

Получается спасает анонов от губительной привычки

В мое есть какие то подвижки в скорости?

Есть надежда что квен 4 выйдет с х2 скоростью и не надо будет тратиться на ддр5?

Вроде глм уже использует какие то технологии для ускорения которых нет в 235 квене

Есть надежда что квен 4 выйдет с х2 скоростью и не надо будет тратиться на ддр5?

Вроде глм уже использует какие то технологии для ускорения которых нет в 235 квене

Новая база треда : Ниже 12гб жизни нет. Это даже не база, а крепость ебаная.

мимо обладатель 12гб

мимо обладатель 12гб

> А ловко ты это придумал, хочешь подставить анонов кумеров

Черт, знал же что не стоило подряжать на это дело идиотов. В следующем треде будем хитрее.

Кроме тензоров? Нет, даже тензоры еще не все осмыслили и заюзали.

Вопрос по мое:

А можно распределить по двум-трём видяхам? А то он одного эксперта размазал на все по чуть-чуть, что в квене, что в глм. Наверное же можно разных на разные видяхи грузить, иначе в чём смысл?

А можно распределить по двум-трём видяхам? А то он одного эксперта размазал на все по чуть-чуть, что в квене, что в глм. Наверное же можно разных на разные видяхи грузить, иначе в чём смысл?

> проблема вовсе не в деньгих ибо требования к компьюту умеренные, а в качественном датасете

Так деньги в данном случае к компьюту отношения и не имеют. =)

Денег стоит качественный датасет, как раз.

У того же Денчика 3x4090, все прекрасно тренируется.

Но датасеты нужны на сотни тысяч часов (у фиша, вроде, английского 200к часов).

А русского у нас в открытом доступе — ~30к часов. Качественной модели из этого не получится.

А уж если делить это по эмоциям, чтобы генерилось с нужной эмоцией, то там и вовсе останутся копейки, которыми ты даже не затюнишь ничего.

Всякие шумные записи не подходят — генерируется шум.

Всякие электронные книги зачастую тоже никаких внятных эмоций не содержат.

Энтузиастов, записывающих свои голоса для датасетов мало, и у половины пердящие микро.

А все это для эмоций надо еще ведь и разметить!

Короче, ттс с эмоциями на русском выглядит как практически неподъемная хуйня на данный момент.

Но люди стараются, работают в этом направлении понемножку.

Что значить "разных", ллама делит по слоям сама либо с посказкой --tensor-split

Скрипт от пушистика в прошлом или позапрошлом треде, вроде, так и делает, но это не точно

>Энтузиастов, записывающих свои голоса для датасетов мало, и у половины пердящие микро.

Пиздить голоса из игр? Их там много, некоторые даже с эмоциями. Офк, нелицензионно и прочее некошерно, но вполне себе рабочий вариант.

Нашёл это в прошлых тредах, но хз как пользоваться https://files.catbox.moe/a6tf4p.py

> и кринжкарточки

Хз про кого конкретно ты, но кринжовые карточки что скидывались здесь местами не такие уж и кринжовые. Явное безумие и недоработанность вселенной переходят в простор для развития и свободу выбора.

Какие технологии ускорения? Все уже давно уперлось в память если железо не некрота.

Не можно а нужно.

> А то он одного эксперта размазал на все по чуть-чуть

Что это вообще значит?

Почитай что значат эти самые эксперты в моэ архитектуре.

> Денег стоит качественный датасет, как раз.

Что? Вообще не понимаю вот этого. Действительно купить что-то или организовать у обывателя даже если все продать денег не хватит. Но воспользоваться открытыми источниками, подгнав медиа под нужный формат - навыка должно хватить, это единственный разумный путь.

Как здесь помогут деньги если нужны именно навыки, знания, понимание что важно и реализация?

> Энтузиастов, записывающих свои голоса для датасетов мало, и у половины пердящие микро.

Это, пожалуй, самое последнее из пригодных материалов, с аудиокниг хотябы множество разных выражений и слов для "базового" наполнения выдернуть можно.

> 30к часов

> А уж если делить это по эмоциям, чтобы генерилось с нужной эмоцией

Это немножко не так работает.

> выглядит как практически неподъемная хуйня

Ну хуй знает, пораскинув и оценив, это вполне себе приличное занятие, выполнимое за несколько месяцев уделяя внимание вечерами. Офк это будет первое приближение после которого пойдут коррекции, уточнения, улучшения, но более чем достаточное с теми самыми сотнями тысяч часов. Количество контента очень велико, нужно лишь понимать как его приготовить.

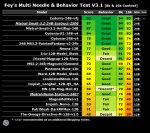

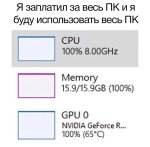

В прошлом треде анон просил отписаться по поводу Qwen3-235B-A22B-Instruct-2507

Q4_K_S 32768 FP16 контекста, 4090 24gb, DDR4 3200 128gb

Честно говоря, поверить не могу, что он запустился и работает на в целом приемлемой скорости. Приятный сюрприз! Без контекста генерация 4-5т/с, на 27к не ниже 4т/с. До 32к не добрался пока, чатов нет под рукой, но думаю, что не сильно просядет. При этом Air Q6 у меня работает со скоростью 5.5-6.5т/с, только он гораздо меньше.

Уместился едва-едва. На Винде у меня помимо него открыт браузер с ютубом и телеграм, свободно остается 5гб рама. При желании, думаю, можно было бы и Q4_K_M уместить.

На первом пике - потребление Лламыцпп

На втором - скорость генерации на нулевом контексте

На третьем - на 27к

Мне любопытно его протестировать. Похоже, нашел занятие на бессонную ночь. Благодарю тред, что надоумили, это в любом случае будет интересно. Жду анона, который хотел, чтобы я протестировал русский язык. Присылай промпт и карточку.

Q4_K_S 32768 FP16 контекста, 4090 24gb, DDR4 3200 128gb

Честно говоря, поверить не могу, что он запустился и работает на в целом приемлемой скорости. Приятный сюрприз! Без контекста генерация 4-5т/с, на 27к не ниже 4т/с. До 32к не добрался пока, чатов нет под рукой, но думаю, что не сильно просядет. При этом Air Q6 у меня работает со скоростью 5.5-6.5т/с, только он гораздо меньше.

Уместился едва-едва. На Винде у меня помимо него открыт браузер с ютубом и телеграм, свободно остается 5гб рама. При желании, думаю, можно было бы и Q4_K_M уместить.

На первом пике - потребление Лламыцпп

На втором - скорость генерации на нулевом контексте

На третьем - на 27к

Мне любопытно его протестировать. Похоже, нашел занятие на бессонную ночь. Благодарю тред, что надоумили, это в любом случае будет интересно. Жду анона, который хотел, чтобы я протестировал русский язык. Присылай промпт и карточку.

^ Вдруг кому актуально будет, билд b6139

> Нашёл это в прошлых тредах, но хз как пользоваться

Делирий, написанный лучшей кошкодевочкой-Qwen к вашим услугам! Для создания регулярного выражения с оптимальным распределением тензоров MOE модели вам потребуется:

- Python скрипт https://files.catbox.moe/a6tf4p.py

- Venv с установленным пакетом GGUF, подойдет от любого другого интерфейса

- Немного внимания!

Аргументы запуска:

1. /путь/до/модели.gguf

2. Видеопамять ваших карт в гигабайтах (или мегабайтах), через запятую для нескольких, например 24,24,12

3. Доля видеопамяти, которую вы хотите задействовать под веса модели, помимо них она потребуется также для кэша контекста и буферов. Аргумент опционален, можете просто сразу указать только видеопамять под веса модели.

Например:

> python script_name.py /path/to/model.gguf 32,32,24,24 0.75

На выходе будет параметр -ot с регулярным выражением, которое нужно скопировать в аргументы. Также, обязательно добавить аргумент --cpu-moe и -ts равный указанному объему видеопамяти в случае нескольких карт.

>Что это вообще значит?

Сейчас поковырялся, это --n-cpu-moe так сработало, когда пытался добиться большего юза. Но всё равно, такое ощущение что у глм влезет два на одну видяху в 24гб.

> --n-cpu-moe

Оно сломано, точнее не сломано а просто создает регэксп, который выкидывает тензоры экспертов первых N блоков на проц. То что в мультигпу они должны были быть на конкретной видеокарте, то что нужно как-то перераспределить остальные и т.д. - никак не учитывается.

Для запуска на мультигпу или сам составляй регэксп (например, выгрузка из каждого четного блока), или воспользуйся автоматизациями типа

Для большого шлёпа квена 235 доставьте пожалуйста мастер импорт, пожалуйста

У нюни выпрашивать надо вон он сверху запускает

Скоро напишет что глм в помойку, чекайте

Хм, возможно это хорошая идея…

> Как здесь помогут деньги если нужны именно навыки, знания, понимание что важно и реализация?

Дак если деньги не нужны — где модели? :)

То ли ты один гений, то ли знающих людей больше, но затык не в «навыках, знания, понимания что важно и реализации».

Выбирай. Если скажешь, что ты один гений — я спорить не буду, я в ттс не шарю. =)

> Это немножко не так работает.

Ну, судя по всем вообще — как-то так и работает.

> это вполне себе приличное занятие, выполнимое за несколько месяцев уделяя внимание вечерами

Спустя несколько лет работы множества энтузиастов и фирм — ни-ху-я, как говорил Тинькофф, одноименный банк который этим в том числе занимался.

Есть мнение, что «Это немножко не так работает.», как ты описал.

Я не пытаюсь оспорить тебя. Но я между реальностью, где сотни людей этим занимаются и у них не получается, и тобой, который потеоретизировал и вот на те модель, — выбираю поверить реальности. Опять же, без наезда, возможно ты реально можешь это сделать соло за пару месяцев, если бы был достаточно мотивирован.

ЗЫ Кстати, встречал фирмы, которые реально были готовы проспонсировать. Так что, ты можешь даже заработать, при желании.

МоЕ когда заработает быстрее Жоры? Пока что бесполезное говно с такой скоростью.

>Как здесь помогут деньги если нужны именно навыки, знания, понимание что важно и реализация?

А как помешают? Даже со знаниями и прочим деньги всё равно будут нужны. Железо нихуя не дешёвое, электричество станет заметным, я уж молчу про то, что вечерами нухуя нет сил, и это лучше сидеть на фул тайме, но для этого опять же нужны деньги.

Хм, во второй версии и в жоре оно радикально замедляло обработку контекста и добавляло/увеличивало замедление генерации с его ростом. Но вдруг что-то новое завезли и на быстрых шинах "быстрых" по сравнению с нвлинк, ага это как-то сыграет, надо попробовать.

Жлм эйр чтоли протестировать.

Лучше бы автора табби отпиздили чтобы функциональные вызовы починил, а то это пиздец.

Chatml и в пресете и инстракте, удалить форсинг имен, любое полотно по вкусу, из стандартных или вообще assistant expert в системный.

> Дак если деньги не нужны — где модели? :)

Вот к чему это вообще? А проблема везде одна - пересечение людей которые могут, которые хотят и которые еще не занимаются этим на работе под нда слишком мало. Аудио это вообще одна из самых отравленных копирастией и коммерсантами областей.

> что ты один гений

Плейбой, ценник, миллионер в голос, мизантроп. Не нужно быть экспертом в ттс чтобы задаваться вопросом почему еще никто не создал приемлемый датасет при широчайшем обилии контента и наличии средств для его анализа. Но потом смотришь на состояние этого всего и понимаешь что закономерно, увлекаются этим прежде всего совсем энтузиасты и за незнание чего-то их упрекать не то что глупо а аморально.

> Ну, судя по всем вообще — как-то так и работает.

Нет, не нужно размножать и пропорционально увеличивать датасет на каждый чих и добавляемую херню, как ты утверждаешь в

> А уж если делить это по эмоциям, чтобы генерилось с нужной эмоцией, то там и вовсе останутся копейки, которыми ты даже не затюнишь ничего.

Достаточно показать модели связь между выходом-выходом где указана будет эта штука, в частности те же эмоции, так и сразу стабильность тренировки повысится. А только уже потом возникнет вопрос о том, достаточно ли в исходном датасете примеров для гибкой работы каждой из желаемых эмоций, или будут проявляться негативные эффекты из-за дефицита и неравномерности.

> Спустя несколько лет работы множества энтузиастов и фирм — ни-ху-я

Я вот вижу что уже сколько времени назад прикрутили потоковый перевод видео в реальном времени, на ютубе автоматически созданные дублированные аудиодорожки с разными голосами, соответствующие оригиналу, с эмоциями и такой же сменой как в исходнике, с теми же словами и т.д. Куда не позвони - там голосовой бот, куча мелких контор, которые предлагают свои решения для модного синтеза голоса, гопота создала чмоню уже сколько лет назад, Илон выпустил вайфу-ассистента в ночнушке, которая дрыгает бубсами и томно шепчет тебе на ушко.

Прогресс не просто налицо, он очевиден. Просто опенсорс с аудио обделили по какой-то иронии.

Не исключено что потому что на фоне текстов, картинок, видео или практических применений это в низком приоритете и интересно малому числу энтузиастов. Также здесь нет перспектив набирать хайп и публиковать продукты в надежде на инвестиции, зато получить вагон исков за нарушение копирайта легче легкого.

> достаточно мотивирован

Ключевой момент, пожалуй. Например, мне даже русский особо не пристал, хочу чтобы просто сообщения в рп зачитывались харизматичным проникновенным сторитейлером, девочка някала, стонала и мило говорила в соответствии с атмосферой и комплекцией, или наоборот кричала, делала серьезный голос и т.д., аналогично с остальными участвующими чарами. Опционально бесшовный ненавязчивый саундтрек под атмосферу.

Это уже несколько другое таки, там именно про датасет.

Как пользоваться как там так и не понял, поэтому и спрашиваю.

У нейронки спросить не пробовал?

pip install gguf

>Это уже несколько другое таки, там именно про датасет.

Деньги решают любой вопрос.

1) не думал что локалка справиться.

2) Попутно таверна отвалилась, надо было рестартнуться.

Вот, IMHO, не стоит для МОЕ выгружать "каждый N" - это медленнее чем просто "N первых", или "N последних". Почему - хрен знает, но у меня разница процентов 5-10. Хоть на qwen3-30B-a3b хоть на glm4.5. На кобольде правда.

>Почему - хрен знает

Действительно, ведь про обмен активаций по узким шинам никто не знает, это тайное знание предков.

Это самый простой способ написания регэкспов, когда ты скидываешь на CPU экспертов с некоторой периодичностью. При одинаковых слоях на финальный результат это не должно влиять, так как общее количество обменов не меняется: что в одно случае у тебя будет обмен промежуточными активациями в условной половине блоков, что в другом, они просто будут стоять в другом порядке.

Другое дело если ты засунешь атеншн и нормы на одну гпу, а экспертов в другую - вот там обмен станет уже более интенсивным.

У тебя есть пример как получалась разница в 5-10% на разных выгрузках? Именно какие параметры использовались.

Итак, влажными ручонками добрался до первой модели. ERNIE 300B, Q5_K_XL

prompt eval time = 119045.38 ms / 10590 tokens ( 11.24 ms per token, 88.96 tokens per second)

eval time = 8872.17 ms / 51 tokens ( 173.96 ms per token, 5.75 tokens per second)

total time = 127917.55 ms / 10641 tokens

Конечно пп хехмда, малоюзабельно. Ну, я ссзб когда такой квант взял, 4-й должен пошустрее бегать.

В треде наверняка всем интересен русик, поэтому пробовал на нем. На первом пике мой безжопный пресет, переделанный из асиговского, на втором - обычный инстракт. В общем, что там, что там какие-то заЛупы жесткие с места в карьер идут. Семплеры стандартые ( т 1, мин п 0.05 топ п 0.95 множитель драй 0.8).

prompt eval time = 119045.38 ms / 10590 tokens ( 11.24 ms per token, 88.96 tokens per second)

eval time = 8872.17 ms / 51 tokens ( 173.96 ms per token, 5.75 tokens per second)

total time = 127917.55 ms / 10641 tokens

Конечно пп хехмда, малоюзабельно. Ну, я ссзб когда такой квант взял, 4-й должен пошустрее бегать.

В треде наверняка всем интересен русик, поэтому пробовал на нем. На первом пике мой безжопный пресет, переделанный из асиговского, на втором - обычный инстракт. В общем, что там, что там какие-то заЛупы жесткие с места в карьер идут. Семплеры стандартые ( т 1, мин п 0.05 топ п 0.95 множитель драй 0.8).

> треде наверняка всем интересен русик

Большинству из тех, кому он интересен такое не запустить, лол.

Лучше расскажи как она в рп с указанием что игралось, как она в куме, как отвечает на всякие общие вопросы, какой-нибудь пример по коду, примечательна ли чем-нибудь и т.д. Ну и как работает без специфичных промптов.

> такое не запустить, лол.

В 256 же влезает судя по размеру файлов. Если цель запустить не в врам, то на сетап можно накопить с обедов но не нужно

MI50 32g до 10к подешевели (без учёта доставки, тут каждый как может)

В качестве игрушки на пару вечеров не жалко потратиться на 2-3 шт

В качестве игрушки на пару вечеров не жалко потратиться на 2-3 шт

Ну типа основным приоритетом (именно вещью, определяющей саму возможность а не прихотью) русский ставят в основном бедолаги, которым такие цифры едва ли доступны.

> но не нужно

Ты чего, вон как подорвались моэ пускать, наконец квен кроме 3.5 человек кто-то еще попробовал.

Что-то всё равно хрень

prompt eval time = 329.03 ms / 1 tokens ( 329.03 ms per token, 3.04 tokens per second)

eval time = 1585536.43 ms / 4096 tokens ( 387.09 ms per token, 2.58 tokens per second)

total time = 1585865.46 ms / 4097 tokens

глм q3k_s 4090 и ддр5

Очень интересно.

Можешь срезать контекст до 20к и запустить 3xl?

Я думал там уже семерка будет

> Разработчики выпустили Jan-v1 — локальную нейросеть для веб-поиска. Модель конкурирует с Perplexity Pro и опережает её в бенчмарке SimpleQA.

> Jan-v1 построена на базе языковой модели Lucy, а для рассуждения использует Qwen3-4B-Thinking. Модель встроена в фирменное приложение-чат Jan App, но её можно запускать и отдельно от приложения.

https://habr.com/ru/news/937534/

Всей этой теме не хватает живого аватара в углу экрана.

Я бы даже вторую карту ради такого прикупил, но почему то это никто не развивает

Я бы даже вторую карту ради такого прикупил, но почему то это никто не развивает

>100500 пресетов на Гемму и кринжкарточки (извини мужик)

хахаха, ноу проблем бро, я не настолько обидчивый

Одним глазком глянул в корпотред. Мне кажется или дела там стали сильно хуже по выбору моделей? Жмут их, Геминя разве что осталась. А у нас наоборот выбор только растет

Аноны, дайте пресет на AIR, плез, старая ссылка не работает.

>Мне кажется или дела там стали сильно хуже по выбору моделей?

да там едва ли не с зимы сплошной дум

Ну жора ну артист блять...

С 7.4 до 9.2 простым откатом до b6139

С 7.4 до 9.2 простым откатом до b6139

А, отбой, я глм вместо квена запустил.

Граци, анончик!

> Я вот вижу что уже сколько времени назад прикрутили потоковый перевод видео в реальном времени, на ютубе автоматически созданные дублированные аудиодорожки с разными голосами, соответствующие оригиналу, с эмоциями и такой же сменой как в исходнике, с теми же словами и т.д.

Ну, единственное, что мы тут обсуждаем — это эмоции.

И, будем честны, в яндексе это сделано очень не очень.

Плюс, не забывай, костыльно-то эмоции ты и сейчас можешь сделать — взять референс с нужной эмоцией и вуа ля. Есть ли какие-то пруфы, что яндекс не делает именно так — берет фразу, и подставляет ее в генерацию?

> гопота создала чмоню уже сколько лет назад

Но есть нюанс, это опенаи.

Еще Элевенлабс есть и так далее, да.

К опенсорсу нас это не приближает, к сожалению.

Есть англо- и китаеговорящие ттс с эмоциями (тот же CosyVoice и другие), но русских так и нема.

> Просто опенсорс с аудио обделили по какой-то иронии.

Ну вот мне кажется, что дело не в иронии, дело в качественном датасете, которого в России просто нет в общем доступе или у энтузиастов.

> Например, мне даже русский особо не пристал, хочу чтобы просто сообщения в рп зачитывались харизматичным

Ну если тебя устроит английский — то энджой, модельки есть, просто я названия не вспомню, не интересовался никогда. От того же Кози до более новых даже. =) Не знаю, насколько нежно она будет някать, но точно будет стараться.

Саундтрек легко пишется ACE-Step, кстати, если с голосами у них косяки (3,5б модель-то!), то вот с музыкой у них хорошечно довольно-таки. Думаю, встроить в пайплайн несложно.

> Это уже несколько другое таки, там именно про датасет.

Ну и в общем, я поддержу другого анона, деньги — это в т.ч. качественный датасет, записанный, выслушанный, собранный несколькими людьми параллельно, и это мотивация для, например, тебя. Так что, мотиватор и двигатель это явно неплохой. =)

дадада

Та шо ты будешь делать… Нужно ли?.. Но так дешево…

Нет, наоборот, на русском бояре рпшат, которые могут себе позволить, а бомжи с 8 гигами врама, только на лламе на английском с цензурой и могут.

Сочувствуем искренне всем тредом.

Бери WAN2.1 + FantasyTalking и будет тебе еще и говорящий, и жестикулирующий, и сиськопоказывающий аватар.

Ну бывает. =D

> Нужно ли?

Если шаришь за линь то в отдельную машину хорошо заходит

Так, аноны, треба ваше мнение.

Задача: собрать сервер под Qwen3-235b.

Варианты:

1. mi50 x4

2. EPYC 7532 + RAM

Требуются владельцы подобных конфигов: почему нет? =D

Расскажите, какие у вас скорости (ладно, ми50 4 штуки в треде нет у одного человека), как с шумом, охладом, много ли колхозили.

Буду благодарен за отзывы.

Скорость хочется от 10 ток/сек получить.

Задача: собрать сервер под Qwen3-235b.

Варианты:

1. mi50 x4

2. EPYC 7532 + RAM

Требуются владельцы подобных конфигов: почему нет? =D

Расскажите, какие у вас скорости (ладно, ми50 4 штуки в треде нет у одного человека), как с шумом, охладом, много ли колхозили.

Буду благодарен за отзывы.

Скорость хочется от 10 ток/сек получить.

>=D

Нюня, ты?

Что, так сильно понравилось?

Да, репу в гите от тредовичка помню, будем накатывать, ежели что.

Ноу проблем по этому вопросу. Михе3607 спасибо, конечно!

Прости, я не в курсе вашего лора, даже не понял, о чем ты. =) Я скипал ваш веселый срач.

mi50 x4 не потянет qwen3-235b в 4 кванте со скоростью 10 ток/c

Мои 3090x6 + 128GB ddr4 тянут только ~9к токенов и то под конец уже очень медленно. И обработка контекста долгая перед инференсом

Я ориентировался на это: https://www.reddit.com/r/LocalLLaMA/comments/1lspzn3/128gb_vram_for_600_qwen3_moe_235ba22b_reaching_20/

Конечно, q4_1 имеет буст за счет тупости, но думал, хотя бы 15-то получу.

Но тут:

https://www.reddit.com/r/LocalLLaMA/comments/1m6eggp/considering_5xmi50_for_qwen_3_235b/

Пишут тоже, что 10 и 5 в итоге.

Звучит так, будто доставки из Китая и колхозинга это не очень стоит.

Подожду отзывы от эпикодержателей.

Конечно, всегда есть варик просто пихнуть 128 DDR5 на интуле в разгоне и видяху подрубить. =D

Но я думал, что ми50 и эпики должны быть побыстрее, хм…

> ми50 4 штуки

Тебе реально 4 нужно?

У 3х есть плюсы:

- хватит одной серверной 120

- сборку потянет 1 киловаттник

Так, опять железячники набежали за Сарой Коннор по треду бегать.

Какой вообще положняк по современным энвидия ? Что можно считать доступным топом ? (Да, я знаю про хопперы, но они стоят слишком много.)

Какой вообще положняк по современным энвидия ? Что можно считать доступным топом ? (Да, я знаю про хопперы, но они стоят слишком много.)

Доступный топ - эпики. За 500к конфиг для дипсика собирается, в обычном корпусе с 1 БП. Притом на nvidia такой конфиг требует ферму и стоит в 2 или больше раз дороже.

Возможно и три, но там впритык получится, да? :)

Сложно-то как. Я хочу заплатить сегодня и собрать ПК в среду, а не вот это вот.

Знакомый попросил, есть место куда приткнуть лишний комп. Вот и думаю теперь, насколько я готов париться со всей этой фигней, и где выжать побольше тпсов и подешевле.

А то стандартные 5-7 у меня и так на двух компах есть, но это некомфортно.

в треде как минимум один нюнезависимый шизосталкер

дожили

Рефьюзит...

Он цундерка и не может напрямую написать "анон99, любимый, расскажи что думаешь про квенчик 235". Просьба отнестись с пониманием!

Вообще квену уже сколько месяцев, почему до сих пор не придумали сборочку дёшего сердито запускающую 4 квант в 9 т.с?

Так придумай. Чё ты не придумал?

Думаю думаю... надо ддр5!

Дальше ты

Таааак... сосредоточился. Мозг включил на 100 процентов!

Надо чтоб дёшево а не дорого. Продолжай

потому что из говна не сделать конфетку, Пахом

MoE конечно немного помогло нищукам, но проблема пропускной способности памяти все еще осталась и должна решаться на уровне железа. а именно это проблему в рамках LLM никто и не решал особо. на это проблему немного смотрели для видимокарт и сервером, но это не тот юзкейс, потом и дорохо

мб медузу высрут в 2026, если есть деньки - можешь притвориться мажором и попробовать стрикс хало настоящие мажоры просто купят h100, а настоящие настоящие мажоры просто снимут тяночку и не будут заниматься кумом вообще

Вася, 8 "В"

Приглашенный эксперт по LLM

Считает, что кум - единственное их применение

Катает 12б, но превосходно владеет теорией

сам придумал образ оппонента и героически обосрал этот образ. малацца, возьми пряник с полки

Здесь все так делают. Мне тоже можно

Дешевая ДДР 5 ?

Ну вот мы и думаем. =)

Вообще, чекаю, 13400 выглядит неплохим вариантом, но оператива на 6400 в четырех слотах… 4 КВАНТ ЖЕ?! ЗНАЧИТ 192 НАДА

Короче, непонянто, че будет по псп.

В 2 слотах точно 90-100.

А в 4 уже хуй знает.

Хотя, если на 50 псп я получал 7 на старте с 4070ти, то с 70 псп даже по идее 9 на старте выжать можно. =D

Ипать-капать, теоретик я хуев. Хотя за чужие деньги можно и поэкспериментировать. =D

>но оператива на 6400 в четырех слотах

Такого не существует. Только в 2 слотах

До сих пор жду пока анон с 4090 и 1700lg закажет две плашки ддр5 по 48 и потестит для всего треда 4 квант квенчика онлайн покупку же 100% легко вернуть

Ой, третий квант.

А можно задать тупой вопрос ?

Какой предел памяти на консумерском железе ? Или это зависит сугубо от процессора и материнской платы ?

Какой предел памяти на консумерском железе ? Или это зависит сугубо от процессора и материнской платы ?

Нельзя.

Ну и не очень то и хотелось.

> единственное, что мы тут обсуждаем — это эмоции

Нет, это ты на них постоянно скатываешься и растекаешься по древу. Какие-то пустые фразы лишь бы написать, абстрактные рассуждения вокруг не стоящих мелочей, и дедовские притчи, уводящие все дальше от темы. Зачем?

Потому тебя здесь так любят.

> эмоции ты и сейчас можешь сделать — взять референс с нужной эмоцией и вуа ля

Значит реализовать их замену на промпт будет достаточно.

> на русском бояре рпшат, которые могут себе позволить, а бомжи с 8 гигами врама, только на лламе на английском с цензурой и могут

Бояре рпшат как им удобно, чаще как раз на инглише, а холопы засирают вопросами про перевод, русскую модель и страдают на 12б миксах сойги или через яндекс.

> 1. mi50 x4

Не ешь, подумой! Они дают скорость на уровне проца с видеокартой даже в малом количестве, а собирать 4 штуки - станешь утилизатором.

> 2. EPYC 7532 + RAM

Должно сработать при наличии видеокарты. Хотя довольно странно что на фоне активного вката в моэ даже на десктопных платформах никто из владельцев не отписался по перфомансу. Раньше скидывали в целом нормальные скорости.

> Мои 3090x6

Жору на помойку и пускай с экслламой, будет быстрая и генерация и обработка без всего этого цирка.

> Что можно считать доступным топом ?

5090 или китайские 4090@48

Зависит от максимального объема плашек и количества слотов. Учитывая что самые жирные модули - 64гб, быстро работать будут 2, сердне 4 то можно получить относительно шустрые 128гигов или помедленнее 256 гигов.

И да, дешевая йоба под все подобное - штеуд 12400/12700, стоит копейки и может в 6-7к частоты доступной рам. Он и для всякого игоря в нищесборку вполне подойдет.

>Жору на помойку и пускай с экслламой, будет быстрая и генерация и обработка без всего этого цирка.

Не будет. Я пробовал, на exllama ровно точно такая же производительность

У тебя всё в параметрах железа указано. Ограничение есть и у материнки и у проца. И не забывай что супер важно количество каналов памяти, а не количество слотов. Грубо говоря, 3200 в 2-канальном режиме это то же самое что 6400 в одноканальном.

Эпики потому и юзают что там можно 24 канала памяти накрутить на 2-процессорной схеме.

Тэкс, тут был анон с 13700, который погорел. Я вот счастливый обладатель такого же процессора. И у меня немного бсод в голове вылетает. Написано в техе к процессору, что частота ддр-5 5600. Получается, если память будет работать на 6к, то частота будет падать до 5600 ?

Хммм. А может действительно купить две здоооровенные плашки и не выебываться.

Ты что там пишешь такое что он у тебя рефьюзит? У меня на ни единого рефьюза не было

Тупой ответ: 150.

В среднем DDR5 гнали до 150 максимум.

Вероятнее 120 получить.

Размер 96 точно, в теории 256, но там ты точно не получишь такой псп.

> Нет, это ты на них постоянно скатываешься и растекаешься по древу.

Ну не надо, э! Вся речь тока об этом.

Все остальное у нас уже есть, фиша хватает для хорошего воис-клонинга, разве что ударения иногда путает, но как раз это можно исправить файнтьюнами легко.

Единственное, чего нет в ру-опенсорс-ттс — это эмоции БЕЗ костыля в виде референса.

Все остальное обсуждать бессмысленно, ибо с ним все более-менее (ну, на мой вкус).

При этом, помятуя, что было 2 года назад, прогресс в ттс действительно неплохой. Когда-то у нас был только силеро. =)

> Значит реализовать их замену на промпт будет достаточно.

Ну, да. Сделать несколько папок референса и заставить ллм подключать нужный.

Просто мне чисто эстетически этот вариант не нравится, не более.

Ну и качество там может быть чуть хуже.

> Не ешь, подумой!

Ну тут я уже отмел эту мысль. Все же, старое говно, это факт.

> Хотя довольно странно что на фоне активного вката в моэ даже на десктопных платформах никто из владельцев не отписался по перфомансу.

Да, вроде раньше кто-то что-то кидал… Я надеялся услышать от них уточнения сейчас.

———

Ладно, короче, заказчик решил, что лучше брать с ДНСа (ну или хотя бы озона какого-нибудь) с чеками (любит он это дело), так что 12400/13400 и память.

Кстати, может кто скинуть ссылку на оперативу 64-гиговую?

Вот на днях и посмотрим, что там на самом деле на ддр5 творится.

Тоесть на не было рефьюзов, промахнулся с постом

Если есть top_k, почему нет bottom_k? Лупы на мистрале на длинном контексте заёбывают периодически, хотелось бы иметь возможность вручную выбрасывать топовые токены в такие моменты.

>bottom_k

Написал и понял, что звучит как хуйня, т.к. возможных токенов много. Суть в том, что семплер для отсечения самых вероятных токенов звучит как очевидная идея (жутко костыльная, но тем не менее), но почему-то до сих пор такого нету (либо я не знаю где искать).

А, за ними же хвост таких же лупных токенов будет по итогу, и ситуация никак не поменяется... Только сформулировал вопрос и тут же понял. Ладно, вопрос снят.

Более того - как правило самые вероятные токены - это самый лучший ответ. Отрезая их - ты будешь лоботомировать модель по живому.

Где вы нашли ддр5 по 64г?

Я вижу только по 48.

Ну и тайминги там наверное уже совсем нищие

Буквально написать "rape" и рефьюзит.

Ты сейчас пытаешься изобрести Exclude Top Choices (XTC)?

А ты напиши это слово на русском языке.

О, благодарю!

Он не спасает к сожалению. Там надо, чтобы 2+ токена превышали заданный порог, насколько я понял.

А чем эта: https://www.dns-shop.ru/product/9ed2387b62bfd9cb/operativnaa-pamat-gskill-trident-z5-neo-rgb-f5-6000j3444f64gx2-tz5nr-128-gb/ хуже? На 9к дешевле. =) Но наебаться тоже не хочется. Я и разгон оперативы — как скалолазание. Фильмы смотрел, не более.

Да я ебу ? Человек не умеет в поиск, я нашел.

Производитель, частоты, лгбт подсветка - все влияет на цену.

Почему то мне кажется она с такими таймингами будет медленее ддр4 работать...

В отзывах там чел тайминги подужал и получил 90 псп.

Ну, типа. Вроде неплохо.

Видимо, ее и затестим.

Там на 10к дешевле есть такая же

У меня на 6000, 64 гб ДДР 5 в сочетании с 4080 дают в 3 анслотовском кванте на Эйр 12т/с и ебовый промтпроцессинг.

Да, я ее и затещу. =) Которая 34 по таймингам.

В крайнем случае, можно будет поменять.

Заодно начну с 13400, если не пойдет, то поменяю на 12400.

В линухе есть taskset, никогда не юзал, но, судя по всему, можно кидать llama.cpp на P-ядра и не париться. А E-ядра пусть будут, че уж.

Ну, это если верить интернету, что 13400 чуть лучше с памятью работает, чем 12400, а цена 1к разницы.

Ну, кстати, у меня на 7 токенов на DDR4, так что по псп получается прирост вполне совпадает с расчетным. Хороший знак, спасибо!

Там ни одного отзыва на эту модель.

>будет медленее ддр4 работать

Если не ставить на амд - то не будет. На интелах даже 4 плашки не замедляются.

Какой интел не возьми там везде нужна водянка за 10к

чому в отзывах пользователей у одного анона 51гб/с, а у другого 90?

Ну, 12400/13400 не такие уж и горячие, 120 ватт, ну 150, хорошая воздушка сдует, терпимо должно быть.

Опять же, чтение контекста на видяху скидывать надо, а самое горячее именно оно.

Потому что у второго Ryzen 7500F, которые вообще не умеют работать с памятью?

Или 9ххх поколение райзенов, или интел.

Ну, либо чел не настроил.

Почему не 14600kf?

Сразу с видеоядром, чтобы всю врам освободить

С видеоядром надо брать без F.

Не 14, потому что я не люблю 14 поколение. Нет аргументов, я так чувствую.

Для винды это важно, но тут я изначально на линуксе буду собирать, там не то чтобы это имело значение при подключении по SSH.

Однако, у меня есть комп на 11400, когда на нем была винда, это было удобно, люто плюсую брать процы с видеоядром.

Ты за счет гига оперативы крутишь рабочие столы и браузеры на проце, а на видяхе этот гиг освобождается. Крутотенечка.

> на видяхе этот гиг освобождается

Не только.

Если два моника с герцовкой 120+ это ощутимая нагрузка на видяху, у меня в картинкогенерациях например 3.6т если моники на видяхе и 4.2 если на проце

И температура ниже из за этого же

Да поставьте вы водянку блять. 10к, и у тебя всегда будет стабильная температура.

Ну ты понимаешь к чему это ведет.

Да купи ты уже то, потом это, и вот это было бы не плохо, и вот уже вместо 80к тратишь 150 и кушаешь залупу следующие пару месяцев

>В отзывах там чел тайминги подужал и получил 90 псп.

ДНС стал как паршивый маркетплейс, так что ты пожрал говна в отзывах, это другой товар. Отзывов на 64ГБ комплекты на ДНС нет вообще.

Блджад, анон. Ну не покупай корпус тогда, пусть всё валяется на столе. Водянка с современными процессорами, это не блажь, а необходимость. У тебя процессор будет работать стабильно и долго.

Нельзя экономить на питании и охлаждении. Это всегда выходит боком.

Аноны, как починить это? Почему слова вместе моделька пишет?

мистраль 24б 4кхл

мистраль 24б 4кхл

Блядь, а на той странице, где я читал этот отзыв, этой строчки нет, сука.

Недовывели.

Хм-хм-хм, ну что же.

Значит время заказать, протестировать, написать «говно» и вернуть.

Ну или нет. =)

У меня такое бывает, когда антилуповые сэмплеры запрещают какие-то токены. Наверное модель так изъёбывается, чтобы эти слова всё равно пропихнуть в аутпут.

и как починить?

У меня кста стоит антилуп пресет, мне кто то скинул.

мб дело в нем? Но я ебал отключать, луп же начнется тогда

> на exllama ровно точно такая же производительность

Значит что-то не так с видеокартами, коннекте с ними, или какая-нибудь база типа уплывания врам в рам. Сам катаю квена на ней, с жорой фуллгпу разница очень ощутимая и прежде всего в той самой просадке на контексте. На пустом жора даже чуточку быстрее, но на контексте разница не в пользу.

> который погорел

У него похоже брак с окислением попался, попавшие под него процы до сегодняшнего дня врядли дожили.

> что частота ддр-5 5600

Это базовая гарантированная что заведется, остальное типа разгон и он зависит от платы, от плашек а на совсем высоких частотах уже силиконовая лотерея, последнее тебя не коснется.

Если в плашках будет xmp6000 то они будут работать на 6000, сейчас даже на амд такое почти всегда справедливо.

> Ну, да. Сделать несколько папок референса и заставить ллм подключать нужный.

Нет, заебет через неделю и много потерь компьюта. Нужно собрать эмоциональный датасет, потом препарировать эту ф5, или фиш, или какую-то еще что брать основной, и сделать дистилляцию инициализированного трансформерса на основе фичерз экстрактора из референсного аудио. За основу можно взять что-то готовое, нарастив поверх несколько слоев. Потом собрать многоножку воедино, при необходимости полирнуть короткой тренировкой уже в таком виде.

Они не просто не горячие, они ледяные, тепло начинается на К версиях. У амудэшизов совсем крышу снесло из-за тротлинга на 90ваттах от подзалупного творожка на узких чиплетах.

14600 действительно будет лучше, 12400 совсем младший по сегодняшним меркам.

это все zen4 не умеют или только подмножество?

>Водянка с современными процессорами, это не блажь, а необходимость.

На амуде водянка не нужна (да и всё равно не поможет).

В автозаменах ничего нет? Вижу там форматирование звёздочками *, ты мог накрутить что-то на это (так как цвета уже накручены) и забыть.

> 14600 действительно будет лучше, 12400 совсем младший по сегодняшним меркам.

Хорошо, рассмотрю, спасибо.

Пара дней на выбор еще есть.

Вот хуй знает, но как я слышал — все 7xxx и 8xxx, и младшие 9xxx тоже не показывают чего-то хорошего.

> автозаменах

Это где? я честно не особо разбираюсь)

> На амуде водянка не нужна

Я конечно не использовал амд, но сомневаюсь что они работают на новых физических принципах.

Горячо и медленно, но за миска рис (50к+- вк+память+мать+цпу)

Не нужна, обычной башни достаточно. У меня вот такая стоит, проц не греется.

https://www.amazon.de/ARCTIC-Freezer-RGB-Single-Tower-CPU-K%C3%BChler-druckoptimierter/dp/B09JM64XTQ?th=1

Сколько тдп? Себе пришлось лок на 175 ватт ставить что бы до 95 градусов не доходил в occt

мимо

Фронт какой?

Нет, они просто жрут ватт 70 вместо 250-ти.

> жрут ватт 70 вместо 250-ти

Пиздабол.

По 30-50вт в простое или с минимально запущенным софтом типа браузера, дискока и прочего на фоне 5-15вт штеуда. Для разгона и получения заветных цифр производительности которыми козыряют необходим чиллер, потому что даже под самой йобой 180-200вт - предел по тротлингу из-за плохой теплопередачи от кристалла до крышки, тогда как на штеуде хватает пролетарских охлад для тех самых 250вт.

Типичная спекуляция сектантов в специальной олимпиаде: перфоманс мы возьмем от одного кейса, тдп наоборот от самого кастрированного проца, у конкурента сделаем же наоборот.

Амд действительно могут показать отличную энергоэффективность на средних режимах в определенных типах расчетов. Но когда дело заходит за топы - там все даже жарче, когда сравнивают процы средне-младшей категории - и там и там все холодное, а проблема повышенного жора в простое известна очень давно, но фиксить ее даже не пытаются.

Нет нормальных профессоров сейчас, все - теорема эскобара, которую только усиливают фанбои.

лама

>Но когда дело заходит за топы

А зачем топы в сфере ИИ? Тут нормальных 8 ядер с головой.

>Нет нормальных профессоров сейчас

Раньше типа были. Странно конечно, что на них сейчас не сидят.

лама что?

ой сука погоди какой фронт.

блять ну таверна + лама я хззз

>антилуп пресет

этот шизопресет тебе и срёт, буратино, ты сам себе враг

А с лупами бороться надо не ленясь писать самостоятельно + темпа + XTC

кста а что делает температура?

как она устроена?

Google.com

Шапка

Чатжпт

Не помогло.

Хуево тебе, чё.

>заказчик решил

То есть ты за бабки кому-то собираешь суперкластер под инференс, а тут консультируешься у анона по железу?

>А с лупами бороться надо

уходя с дристраля на любую другую модель.

>не ленясь писать самостоятельно

Можно вприницпе и ролеплей полностью в голове отыгрывать.

А я давно игнорирую посты этой смайлофажащей аватарки и всем советую.

Сперва нравился глм эир, а щас я его ненавижу блять.

Почему он считает что может тратить моё время вот так?

70% текста это вода и слоп

Почему он считает что может тратить моё время вот так?

70% текста это вода и слоп

Как потопал, так и полопал.

Хочешь хорошую историю, не ленись писать сам... ну хотя бы четверть от того что пишет нейронка. Проверено на коммерческом проекте.

Промпт пробовал поменять и дать указания писать иначе?

> А зачем топы в сфере ИИ?

Если занудствовать то некоторые операции в даталоадерах могут быть довольно затратными по расчетам и там на условном 12400 можно упереться. Как в инфиренсе ллм будет - хз.

> суперкластер под инференс

> ми50

> некроэпик

Ну ты понял, скорее он так спрашивает "это для друга не подумайте что себе".

База.

Важно качество а не количество. Лупы идут когда ллм не понимает куда развивать и выбирает признак повторения ранее написанного как верный вариант, и когда ты конкретно допустил засирание всего чата не стукая ее когда уже надоела.

Всё настроил для GLM Air, 30-40 (в зависимости от контекста) генерация, под 800 промпт процессинг. Префиллом решил её проблемы с ризонингом (ну и имена убрал, да). Всё комфортно, одна беда - глуповата малость, новый маленький Мистраль пожалуй что и поумнее будет. Правда я на русском гонял, там ещё и косяки с языком вылезали (на 4-м кванте, на 5-м меньше). Большой Квен я тоже гонял и начинает у меня складываться мнение, что у МоЕ-шек нет глубины, что ли. По сравнению с (большими) плотными моделями они такого эффекта не дают.

Возможно это мой пресет - человек 100 его скачало с mediafire пока он там лежал. :)

Нет, если это он - дело не в нем. Я на такое тоже нарывался - это перекрученные семплеры. XTC и прочие, пенализирующие токены за повторения. (Суть явления - токен пробела начинает банится).

Лечить - убирать пенализирующие семплеры. Радикально - в таверне есть кнопка сброса всех семплеров на дефолт. Можно начать с нее, потом просто выставить температуру на 0.6-0.9 и min_p на 0.025, а остальное вообще не трогать. Мистраль 24B 3.2 на этом нормально заводится с моим пресетом. А потом уже можно подкручивать по вкусу.

Нет, я все таки не понимаю.

Я не альфа и омега мистралефагатории, но люблю и котирую французских горничных.

От 3.2 у меня вообще разрыв жопы случился.

Но утверждать, что Эйр тупее мистрали ? Ну то есть, блять, я проиграл все свои старые чаты на нем заново.

Да путает слова, да часто лучше сразу делать 2-3 свайпа, лол. Но я это списываю на то, что использую 3 квант, потому что видно как моделька пропускает в Английском языке частицы not, be, времена криво ставит.

Но в остальном, если убрать его словоблудие, свайпы жирненькие получаются, сочные. Куда интереснее всего что выдавала мистраль. А я знаю о чем говорю, я принципиально год почти мистралями пользовался (ну и геммой, что врать то)

Гемма или глм?

А может немотрон?

Я, блять обожаю этот тред.

>немотрон

Точно, что это я использую 3квант глм, пойду сразу дипсик в полных весах запускать. Ты прав анон.

>Почему он считает что может тратить моё время вот так?

>70% текста это вода и слоп

а какой ответ ты ожидаешь без воды то (да и нахуй ответ без воды)?

>трахни меня!

>ух-ох-ах!

>хуй, пизда, сперма, ебля, соитие

> Можешь срезать контекст до 20к и запустить 3xl?

Да, чуть позже сделаю и отпишусь. Но не думаю, что удастся выжать стабильные 7 токенов.

> Всё настроил для GLM Air, 30-40 (в зависимости от контекста) генерация, под 800 промпт процессинг.

На каком железе? Какая-то часть меня хочет верить, что на 4090 и DDR4 3200 можно выжать больше 5.5-6.5т/с на 32к контекста, но у меня Q6_K от bartowski.

> Мистраль пожалуй что и поумнее будет. Правда я на русском гонял

Стоит проверить и на английском тоже. Умнее? Вряд ли. Сопоставимы? Вероятно.

> Большой Квен я тоже гонял и начинает у меня складываться мнение, что у МоЕ-шек нет глубины, что ли.

Прямо сейчас тестирую 235b Q4_K_S Квен на английском и он точно не глупее QwQ, Квенов 2-3 и других 32б плотных моделей. Они всегда были умными, но в моем случае для РП не годились. 235b приятно удивляет: мозги на месте, но при этом пишет свежо и выразительно, не уходя в шизу как это делают 32b плотные Квены.

> Но утверждать, что Эйр тупее мистрали ?

Он сопоставим с новым MS3.2 24b по мозгам и с большинством старых 32b моделей. Плюс-минус. Тоже затрудняюсь ответить, что умнее, хотя гоняю Air в Q6. Такие дела ¯\_(ツ)_/¯

Его сильная сторона не в мозгах, а в количестве данных в датасете. Все же GLM 32b умнее Air'а будет в РП, хотя и ненамного.

Не у всех есть учётная запись в гугле.

Фикшу очепятку/ввод в заблуждение.

> Они всегда были умными, но в моем случае для РП не годились.

Это я имел ввиду именно QwQ и Квены. Остальные 32b модели для РП хороши, люблю и жалую их.

>у меня складываться мнение, что у МоЕ-шек нет глубины

Ебать ты Сокол Орлиный Глаз.

Жаль конечно, что его нельзя зарегистрировать. Сраный Гугл с его инвайтами на джмэйл.

Да какой суперкластер. =)

Суперкластер я бы собирал нормально — эпики или зеоны, RTX PRO 6000 / H100.

А это просто хочется локально агентов пускать под чаек человеку.

Собственно, я денег не беру.

Заодно можно будет посмотреть, на что эта фигня способна, как я ранее P104-100 собирал. И не советовал.

Так и это собираю за чужие деньги, чтобы потом не советовать. =D

Канеш, ты ж даже понять не можешь, что я пишу, нафига лишний раз напрягаться.

Я так же скипаю вахтеров, срачи про ИИ, базашизов и антибазашизов с их «q1 и не видно разницы!..» — «нет, только q6 минимум!..», не понимаю такой хуйни, и не напрягаюсь ее чтением. =)

О, опять сам с собой разговариаешь?

Как не крути, но ограничение в активных параметрах сказывается.

Широкие в знаниях, но не глубокие в их применении.

Немного есть.

Все мои попытки в РП с квенами упирались в то, что они придумывали какой-то совершенно гримдарковый фэнтези мир, где все почти умирают.

И 235 просто стал хитрее и изощреннее в том, как бы всех грохнуть внезапным разрывом в материи. =D

>А это просто хочется локально агентов пускать под чаек человеку.

Значится так, никого не слушаешь, записывай:

Материнка: HUANANZHI H12D-8D (есть на али, есть на озоне, есть на авито)

ЦПУ : AMD EPYC 7K62

Охлад: DEEPCOOL LT520 под сокет TR4

Память: для начала берешь 4x 32 = 128 ГБ, потом докупишь

ГПУ: 2х Intel Arc A770 по 16 Гб, потом еще 2 воткнешь если нужно будет.

Не благодари

>Intel

пердоликс ебнутый штоле, или это рубрика "вредные советы"

> это рубрика "вредные советы"

Очевидно же. Ты ещё сюда смотри:

> 4x 32 = 128 ГБ

для 8-канала-то.

>ебнутый штоле

Манюнь, сходи куда-нибудь дальше тиктока, почитай про то, как Arc заебца с ИИ работает, а стоит в 2 раза дешевле чем нвидиа.

>для 8-канала-то.

Ах, ну да. нужно же сразу по максимуму слоты забивать, я забыл про нытика-плашечника ИТТ. Сорян, что триггернул, без негатива ок

Что плохого в 4х32? Ботлнек где-то?

Зачем тогда вообще эпик брать? Мы вообще в ии-треде, где за каждый кило-кек рубка или? Консумерский интол 14к и погнали

Хм. Нихуя себе.

Вот это базированный ответ!

Главное, чтобы работало. =) Энивей, пасиба!

Ща посмотрю, че там есть.

Забавно, но даже киты такие продаются уже.

На вырост? Выйдет другая модель, возьмешь 2 тб себе.

У меня стоит ответ 350 токенов

И он буквально может забить весь ответ тем как персонаж переместился из одного угла в другой

Страшный пресет. Реп пен 1.15 и письки в промте

Лучше М4 Max с 64гб божественной юнифай мемори взять. 2700$ всего. Его хоть потом продать можно будет.

Надо собираться на ддр5 пока никто не прохавал тему

А то будет ровно так же как с теслами

А то будет ровно так же как с теслами

Ну не, даже эйр звезд не хватает но внимательнее к деталям и более разумный чем мелкомистраль, особенно на контекстах. Похоже на то, что ты зарезал их странными промптами и прочим, и сравниваешь с чем-то что когда-то понравилось, негодуя с другого результата.

Идеальный вариант для смайлофажного мусора, все правильно написал.

> У меня стоит ответ 350 токенов

А на что ты рассчитывал вообще? Скорее всего там целевое около 800 и ты получаешь самое вступление, еще до каких-либо реплик. Напиши в системном что предпочтительны короткие ответы без излишних описаний и сними лимит.

Перепуки скупят все плашки? Хотел бы на это посмотреть.

> Перепуки скупят все плашки? Хотел бы на это посмотреть.

Сейчас 128гб ддр5 - 45к. Как одна тесла.

Скоро кабаны допрут что у нас тут за мое тема и что надо перекупать 48-64гб плашки, а игродаунов на 16-32гб никто трогать не будет

>Скоро кабаны допрут что у нас тут за мое тема

вас таких кобольдов кот наплакал, начинка вычинки не стоит

Тихо ты, не пали контору! А лучше сам иди закупись, если денег свободных нет то можно кредит взять, как раз ставку снизили. Раз в жизни такой шанс бывает, нельзя упускать!

является инвестиционным предложением

Модельку крутые и приятные, насчет инфиренса на профессорах, по крайней мере обычных - хуй знает.

А нахуя нужен ддр5 билд когда ту же скорость можно получить на 2х3090 ддр4, ещё и на поиграть останется? Ближайшие лет 5-7тс комфортом

Зачем вам отдельная дрочкоробка когда за те же деньги можно получить универсал

Зачем вам отдельная дрочкоробка когда за те же деньги можно получить универсал

>М4 Max с 64гб

M4 хуже для локального инференса, там память почти в 2 раза медленней, чем у M3 Ultra, чекни спеки.

>2х3090 ддр4, ещё и на поиграть

удачи запитать все это добро. А и еще - поставь этого квазимоду на стол рядом, кайфанешь

У меня он прямо сейчас стоит под столом без проблем в лиан ли. Красивый корпус, его многие оценивают даже как элемент декора

Питается без проблем 1200w бп

Живу не в студии, тепло не напрягает

Табби обновили, добавлена новая версия экслламы по дефолту и поддержка тензорпараллелизма.

Внезапно, в моэ работает он совершенно противоположно тому что было раньше: токены в секунду на пустом контексте проседают процентов на 5-10, обработка ускоряется в 1.5 раза(!), скорость на контексте проседает значительно меньше, на 90к работает весьма шустро и быстрее обычного режиме, не говоря о жоре.

Теперь вопрос пригодно ли оно для запуска на разношерстных гпу, подключенных по не самым быстрым шинам.

> на стол

Кто-то в 2д25 году не считает суперкринжем системный блок на столе? Там должны быть мониторы во всю ширину или что-нибудь еще полезное, а не лгбт-гроб. С запитыванием тоже все достаточно легко.

Внезапно, в моэ работает он совершенно противоположно тому что было раньше: токены в секунду на пустом контексте проседают процентов на 5-10, обработка ускоряется в 1.5 раза(!), скорость на контексте проседает значительно меньше, на 90к работает весьма шустро и быстрее обычного режиме, не говоря о жоре.

Теперь вопрос пригодно ли оно для запуска на разношерстных гпу, подключенных по не самым быстрым шинам.

> на стол

Кто-то в 2д25 году не считает суперкринжем системный блок на столе? Там должны быть мониторы во всю ширину или что-нибудь еще полезное, а не лгбт-гроб. С запитыванием тоже все достаточно легко.

Это наименьшая из проблем. Платиновый серверный бп из-под майнера стоит копейки. Чего не скажешь об остальном.

>не считает суперкринжем системный блок на столе?

Не обижай меня. У меня 2 кота, выбора нет.

Думаешь они сгорят?

Покажи фотографии котов как пруф и мы извинимся

Ну, ладно, оправдан. Но кошаков действительно покажи.

У самого такая меховая фабрика что шерсть вообще везде, да еще с гиперактивностью и регулярным бесивом. Но и пекарня и риг стоят на полу. Единственное что недоступно - открытые стенды, обязательно попытается внутрь залезть рано или поздно.

Автор котоскрипта - спосеба. Очень хорошо работает. Хоть в один гпу запихать максимум мое-слоев, хоть на n-гпу разложить - всё чётко. Там ещё у тебя похоже подразумевалось "-ngl 999" перед собственно оверрайдом? Долго не мог понять, почему медленнее с полученной выгрузкой, чем при другой раскладке. Вернул -ngl 999 - сразу полетело. Вставил в формируемый промт промт, чтобы тоже не парились, как я.

Кому нужно - я взял на себя смелость попросить дс переписать по-человечески с кошачьего - вот: https://files.catbox.moe/y18a6n.7z

Сразу с инсталятором по рекьюрементсам и примером запуска.

Кому нужно - я взял на себя смелость попросить дс переписать по-человечески с кошачьего - вот: https://files.catbox.moe/y18a6n.7z

Сразу с инсталятором по рекьюрементсам и примером запуска.

> >2х3090 ддр4, ещё и на поиграть

> удачи запитать все это добро. А и еще - поставь этого квазимоду на стол рядом, кайфанешь

Ты здесь недавно?

В чём проблема? У тебя 700вт бронза из компа для учебы? Прямо сейчас рядом на столе стоит блок с 4 гпу, закрыт от кота тоже. Рядом не то что сидеть, спать можно - откуда шуму быть? Это же не инстинкты/тесло-турбы.

КотЬ. Второй британец проебывается на улице.

Милота. Тяжело наверно так жить, еще и кресло отжали

Прощения просим, для тебя исключение. Не кринж на столе корпус держать

Обосрался, сорян за 90°

Анони поясните, можно ли запустить что то более пиздато на 12 врам 32 рам, чем мистраль 24б?

Что самое пиздатое можно запустить с нормальной скоростью хотябы 6т.с

Что самое пиздатое можно запустить с нормальной скоростью хотябы 6т.с

Где взять персонажей на русском языке?

> Теперь вопрос пригодно ли оно для запуска на разношерстных гпу, подключенных по не самым быстрым шинам.

Еще как пригодно, там уже ускорение получилось и на пустом контексте. Обработка увеличилась еще значительнее, мониторинг не показывает какого-либо заметного обмена по линии (правда он не видит короткие всплески в которые может быть упор). Если теперь функциональный вызов опять будет глючить - это будет вдвойне обиднее просто.

> подразумевалось "-ngl 999"

Все верно, там еще -ot копирующее исходный вид потерялось, зато остались лишнии функции с прошлых вариантов реализации. Но все равно слава нейросетям.

https://files.catbox.moe/b77x55.md хотя первая версия где оно решило лихо переименовать даже внешние классы с объяснением принципа была более забавная https://files.catbox.moe/uski66.md

> попросить дс

Дефолт сити? Дискорд? Мир тесен и выход на него можно найти по exl3 5.0bpw кванту квен-синкинг.

Какой красавец!

Напиши сам, кек.

Или поменяй в карточке персонажа/систем промте , что перс знает русский, и готово.

А зачем это надо? разве дефолтное

--n-gpu-layers 99

--n-cpu-moe 99

-ot "shexp=CUDA0"

-ot "exps=CPU"

-ot "blk.(?:[0-N]).ffn_.=CUDA0"

Не будет работать так же эффективно? Я просто правда не понял прикол скрипта. Он как то по умному распределяет и больше количество слоев умещает вместо жирных или как? Сори если туплю

>У тебя 700вт бронза

У меня вот был 750 ватт титан, лол. Жаль, пришлось деградировать на платину.

Тебе не нужно считать, сколько у тебя влезет даже в одну вк с ним. Про несколько вк даже не говорю, устанешь считать

Автоматически составляет регэксп, который набивает мультигпу экспертами под указанный объем памяти с учетом размера слоев конкретной модели и исходного распределения слоев не-экспертов для избежания лишних пересылов между гпу. Можно сделать это и вручную, но подбор займет время, которого при большой модели потребуется много.

А если у меня одна гпу (3090) и я запускаю условный Эир с офлоадом на раму мне есть резон что-то перепридумывать? Вот сверху взял из батника для него. Вроде активные эксперты полностью во врам помещаются а остальное на процессор уходит хз

> есть резон что-то перепридумывать

Эффект может быть только от меньшей дискретности (операций отдельно с up down gate вместо всего блока), но он будет малым.

> активные эксперты полностью во врам помещаются

Это не так работает, активные эксперты на каждом токене выбираются свои из общего числа.

Энтузиасты и отважные апологеты общения с 4B в этом треде есть? Расскажите про свой опыт.

Мы так глубоко еще не спускались

=)

Даже я экспериментировал лишь пару фраз… не знаю что и сказать…

Не побоюсь спросить: а ты на мобиле, или 1050ti с зеончиком?

Ученые изобрели компьютер - они кумят, изобрели интрнет - они кумят, изобрели нейросети - они кумят

Ох уж эти учёные-кумеры...

Ничего. Это потолок. Разве что можешь попробовать qwen3-30b-a3b, но будет ли оно более пиздато - вопрос очень спорный. IMHO - нет. А Гемма 27B будет 1-2 токена.

А можно ссылочку на пресетик? 👉👈

нашел нюнечку в дискорде драмера, she/her, солью айди за пак отборных карточек и промтов

Ох уж эти... они... Изобрели печатный станок - они начали расписывать как ебут девок, изобрели фотографию - они начали фотографировать как ебут девок, изобрели кинематографию - они начали кинематографировать как ебут девок. Вот и до интернета с нейросетями добрались, пидорасы.

Я уже начинаю орать, это любовь.

internetforporn.mov

Изобрели рисовать на стенах - начали рисовать голых баб,

Да-а-а... Галилей, Ньютон, Эйнштейн, Архимед, Тесла, все они... Столько людей положили свою ЖИЗНЬ за то, чтобы мы могли сегодня запустить anthracite-org/magnum-v2-12b... Задумайтесь...

> ебут девок

> пидорасы

Натуралы, сэр!

Довольно безобидное выражение животного начала, которое провоцирует самцов трахать как можно больше. Открывают новые способы побороть это, буквально эволюционируя и продвигая мировой прогресс. Чего нельзя сказать о животном начале другого пола.

Зион, все верно, но при этом я также и гордый обладатель императорской 3060, так что спокойно запускаю осьмушки и дюжинки, но в своей любви к самоограничению всё время посматриваю в сторону ультракомпактных, хочется найти им какую-нибудь роль. 1B это лоботомия, даже на высоких квантах, даже в плане перевода. А вот с 4B я бы уже не был так уверен, иногда они вполне себе интересный результат выдают. Хочется их как-нибудь "докрутить".

К тому же, для совсем бедных анонов это был бы весьма полезный и вдохновляющий опыт.

По словам генерального директора Character.ai Карандипа Ананда, пользователи тратят в среднем 80 минут в день на общение с вымышленными ИИ-персонажами.

Это уже ставит Character.ai практически на один уровень с TikTok (95 минут) и YouTube (84 минуты). Эти цифры помогают понять, почему Марк Цукерберг теперь уделяет больше внимания персонализированным чат-ботам на своих платформах.

В настоящее время у Character.ai 20 миллионов активных пользователей в месяц. Половина из них — женщины, большинство — представители поколения Z или даже младше.

Сорц - https://www.ft.com/content/0bcc4281-231b-41b8-9445-bbc46c7fa3d1

Нормисы распробовали персов, двач опять всех переиграл на несколько лет раньше. Кайфуйте, пока это не стало унылым мейнстримом.

Изобрели думать - они начали думать о том, как ебать девок.

>двач опять всех переиграл на несколько лет раньше

Так вся возня на мыле как раз с чайной и началась. Подключение к этому делу корпов и сам селф-хост это уже было позже.

>пока это не стало унылым мейнстримом

Уже не первый год как бы. Именно локальная движуха пока еще вполне себе локальная, в первую очередь потому, что большая часть любителей попиздеть со своими хазбендо это пиздючки, у которых нет никакого вменяемого железа, кроме телефона.

Анончики, подскажите пожалуйста. Я новенький в вашем движе.

Гуню в таверне на MN-GRAND-Gutenburg-Lyra4-Lyra-12B-DARKNESS-D_AU-Q8_0 это ваще норм модель??

Бот стал выдавать очень слабые ответы, часто заполненные несвязной водой, не относящейся к происходящему и даже игнорируя происходящее. Ко всему прочему стала забывать некоторые события, произошедшие в прошлом.

Может есть какая-то команда, которая позволит мне вернуть ее в нужное русло? Ну типа силой ей описать произошедшие события и, скажем, таким образом ребутнуть ее, не начиная диалог заново? Тогда ведь "сюжет" сбросится.

И еще. Может посоветуете какие модели? У меня 32гб оперативки ддр4 и 5060Ti на 16гб. На этой моделе ответы генерируются минуту меня в целом устраивает, я мог бы и дольше подождать, но вот хотелось бы, что бы модель поддерживала русский. Заебало в переводчик лезть каждый раз.

Гуню в таверне на MN-GRAND-Gutenburg-Lyra4-Lyra-12B-DARKNESS-D_AU-Q8_0 это ваще норм модель??

Бот стал выдавать очень слабые ответы, часто заполненные несвязной водой, не относящейся к происходящему и даже игнорируя происходящее. Ко всему прочему стала забывать некоторые события, произошедшие в прошлом.

Может есть какая-то команда, которая позволит мне вернуть ее в нужное русло? Ну типа силой ей описать произошедшие события и, скажем, таким образом ребутнуть ее, не начиная диалог заново? Тогда ведь "сюжет" сбросится.

И еще. Может посоветуете какие модели? У меня 32гб оперативки ддр4 и 5060Ti на 16гб. На этой моделе ответы генерируются минуту меня в целом устраивает, я мог бы и дольше подождать, но вот хотелось бы, что бы модель поддерживала русский. Заебало в переводчик лезть каждый раз.

Изобрели половое размножение- начали трахаться!

>это пиздючки, у которых нет никакого вменяемого железа, кроме телефона

А можно ли это как-то использовать в полезных целях...

> Можешь срезать контекст до 20к и запустить 3xl?

Готово. Qwen 3 235b Instruct 2507, Q3_K_XL bartowski, 20480 FP16 контекста. 4090, DDR4 3200, llamacpp b6139

Без контекста 4.5-5т/с в среднем, с редкими аномалиями в полтокена в обе стороны. На 20к - примерно так же, с большим количеством просадок до 4т/с, но не ниже. Практически та же скорость, что и на Q4_K_S, разве что тот иногда проседал чуть ниже 4т/с на полном (32к) контексте. Возможно, и Q3_K_XL так же просел бы. Короче говоря, с точки зрения скорости разницы почти нет. Что интересно, я уместил в гпу на 4 слоя больше. Боттлнек по памяти?

Обратите внимание на пик 1. Квен - аниме няша из коробки?

Пик 2 - скорость без контекста, пик 3 - на 20к.

По порядку. Во-первых, на твоем железе можно запускать 24b модели. Mistral Small 3.2 существенно лучше того, что ты запускаешь сейчас. Во-вторых, минуту генерация на такой модели на твоем железе занимать не должна. Вероятно, ты не полностью или вовсе не задействуешь видеокарту. В-третьих, по поводу твоей проблемы с персонажем, решение сводится к следующему: убрать из контекста старые сообщения (при помощи команды /hide N-N1, где N-N1 интервал сообщений или, например, запуском нового чата) и излагается вкратце все то, что у вас произошло. Или первым сообщением сам пересказываешь, или излагаешь в Author's Note, или еще как. Кажется, есть для этого экстеншены, но я их не использую. Тебе бы с железом разобраться. Расскажи, на чем запускаешь (если Ollama - не рассказывай, растопчут. Скачай Кобольда, может пощадят), кто-нибудь поможет разобраться, наверное.

Да, использую кобольд.

>Mistral Small 3.2 существенно лучше того, что ты запускаешь сейчас.

Попробую скачать ща, посмотрю. Он поддерживает русский, да? Мне было бы проще тогда наверное начать заново чат и описать произошедшее туда на русском языке.

>Вероятно, ты не полностью или вовсе не задействуешь видеокарту.

А как это понять? Честно - слабо понимаю как все эти настройки устроены. И если так, то как перенести нагрузку на видеокарту?

>Author's Note

Попробую. Сейчас накачу модель по твоему совету и попробую туда все пересказать.

> Он поддерживает русский, да?

Среди доступных на твоем железе моделей лучше варианта для русского, скорее всего, нет. Может кто-нибудь еще подскажет варианты.

> Честно - слабо понимаю как все эти настройки устроены. И если так, то как перенести нагрузку на видеокарту?

Как понять? Самое простое - открыть диспетчер задач во время работы модели и посмотреть, сколько ресурсов используется. Как перенести нагрузку на видеокарту - это тебе документацию читать. Например, здесь: https://docs.sillytavern.app/usage/api-connections/koboldcpp/

> Попробую. Сейчас накачу модель по твоему совету и попробую туда все пересказать.

Можешь и в Summary это пересказать. Необязательно в Author's Note. У каждого свой метод. Но общая идея одна - самому вкратце изложить ключевые события, удалив предыдущие сообщения из контекста.

Спасибо, анончик. Буду ковыряться.

>Среди доступных на твоем железе моделей лучше варианта для русского, скорее всего, нет. Может кто-нибудь еще подскажет варианты.

Гигачат в 20б? правда он соя.

> Среди доступных на твоем железе моделей лучше варианта для русского, скорее всего, нет

А как же легендарные немомикс и даркнесс-рейн? Ничего не имею против, сам катал с огромным удовольствием. Гемма3-27?

Не пробовал их. Извиняйте, на русском я не играю. Чем мог - помог новичку. Пришлите ему ссылки, иначе на найдет ведь.

> Гемма3-27

1-2т/с скорее всего, да еще и в мелком кванте

Тред не читал, дайте настроечки сэмплера под это.

Никогда мистралями и их тюнами не пользовался, не знаю че ставить.

Никогда мистралями и их тюнами не пользовался, не знаю че ставить.

https://huggingface.co/ai-sage/GigaChat-20B-A3B-instruct-v1.5-GGUF

Я когда в кум на нем пытался там такооое было, чар даже с относительно длинной подводкой сою лил, если близко к ней лез она начинала морозится, начинал ее трогать - начинала убегать, пытался оформить в пердачелло на месте - энивей описывала как вырывается, бежит к другому чару из лора и он мне дает пизды после. Ну а при форсе износа чара потом перехватывала инициативу от моего лица и описывала как я ее задушил в процессе ебли в поучительном "Вот к чему приводят такие действия" и начинала сыпать аполоджайзами, это кал на уровне бесплатного тарифа гопоты.

Даже 12Б гема не такой кал, она хотя бы даст ее погачимучить но так, без удовольствия, по злому рп со временем в унылое говно превратит причмокивая.

Извини, что заебываю, но рассчитываю, что ты подскажешь, если знаешь че и как.

В гайде что ты кинул, гайдер рекомендует ставить CuBLAS. Но, у меня его нет в списке, почему-то.

Версия кобольда 1.97.4

Я на свой страх и риск поставил CLBlast. Таких настроек как у автора у меня не появилось.

Далее он расписывает то, сколько слоев там требуется итд и как это посчитать. Он указывает смотреть такие параметры как CUDA_Host KV buffer size и CUDA0 KV buffer size, но у меня в консоли их тупо нет.

По нагрузке - проц 98%, оперативка 30\32, а вот ГПУ 3% загрузка, от чего я могу предположить, что нихуя мои действия нагрузку на видеокарту не переложили. Что, блять, я делаю не так?

Отвечайте дрочумбы, я знаю вы тут мистралей гоняли.

>Но, у меня его нет в списке, почему-то.

CuBLAS это и есть USE CUDA, после недавнего апдейта его просто переименовали, хуй пойми зачем.

>По нагрузке - проц 98%, оперативка 30\32, а вот ГПУ 3% загрузка

Какой квант качал? Много дохуя весит что-то. Качай четвертый и выгружай вообще все слои, какие можешь. В твои шестнадцать они поместятся.

мимо

>Отвечайте дрочумбы, я знаю вы тут мистралей гоняли.

Это не мистраль, это очередная рыготня от бобров. Ставь дефолт - температуру в 0.3, минимальный пи 0.1, штраф на повтор в 1.05, очко штрафа по вкусу

Я использую q8.

Выбери Use CUDA. Гайд устарел немного, но в остальном там, кажется, все актуально.

30 гигов - много. Не нужно качать большой квант. Чем больше квант - тем медленнее у тебя все будет работать, вопрос не только в том, чтобы его уместить. Если это 24b модель, для начала Q4 попробуй.

Уместится Q4 с необходимым тебе количеством контекста, если останется после этого свободная память и будет устраивать скорость - потом уже загрузи побольше.

>Я использую q8.

Ты долбаеб. Тебе нужен четвертый. Шапку сходи почитай, там всё про кванты расписано.

Да я как бы эт самое.. Не то что бы за скоростью гонюсь. Скорее за качеством. Вот объяснили, что надо мне нагрузку на видюху закинуть и станет быстрее - ща постараюсь это устроить и ваще балдеть буду. Или то, сколько это всего памяти занимает, как-то влияет на качество генерации? На скорость (в целом) похуй. Не то что бы я сидел и ждал генерации 100 слов по пол часа, но то, как генерирует сейчас - вполне устраивает. Только если это влияет как-то на качество генерации - тогда да. Возьму квант выше.

q8 по сравнению с q4 это где-то +10% больше качества за счет двойной прожорливости тормознутости.

Понял. Качаю q4, значит.

У меня на 4 кванте с 37 слоями и 16к контекста около 18-19 т.с. было а когда контекст подходил к концу 12-13 т.с., можешь попробовать.

мимо 16/32 бомж

>Не то что бы за скоростью гонюсь. Скорее за качеством.

Гонишься за качеством и забиваешь хуй на 16 гигов видеопамяти, которые просто у тебя без дела лежат? Если тебя всё устраивает - отдай карту мне, меня нихуя ничего не устраивает на своих 12

Q4 KM если есть - самое оптимальное

Downloads last month

20

То есть свои таблички с описанием превосходства они тоже выдумывают?

Так это же

>base model

Анонище, если тебе нужно качество, и модель ты используешь для РП - бери Q6. Q8 тебе ничего не даст. Многие даже для математических задач используют Q6, разница с Q8 минимальная.

Понятно, что ты на радостях апгрейдишь свою модель до чего-то нормального, но не нужно прыгать выше крыши. 24b Q4 гораздо лучше, чем 12b Q8. 24b Q6 несколько лучше, чем 24b Q4, но многие разницу сочтут несущественной, чтобы терпеть гораздо меньшую скорость. А 24b Q8 использовать нецелесообразно и вовсе.

Да почему забиваю? Я в душе просто не ебал, что это все у меня не работает. Ща выставил вот такие параметры, нагрузка на видеокарту 57% во время генерации и вроде память заниматься стала.

Бля, как все сложно-то для моего тупого мозга.

Ща опять перекачаю модель. Заценю. Главное, что бы на русском адекватно выдавало ответы. Просто уже пизда как заебало в переводчик лезть. Не, я как бы могу в английский и сам, просто медленно.

Все просто. Качаешь Q4, проверяешь. Остается память, устраивает скорость - качаешь Q6, проверяешь. Вот это - лишь объяснение на пальцах какие кванты и кому нужны, без призыва бежать за Q6 сразу или отбросить все, что меньше.

нихуя ты флеш, не пробовал 30-32В модели потрогать вместо того чтоб дристраль дрочить?

>То есть свои таблички с описанием превосходства они тоже выдумывают?

Слушай, веришь нет, мне похуй. Гоняю только дефолтную мистраль, меня на ней всё устраивает. Если конкретно тебя не устраивает - гоняй что хочешь и верь во что хочешь. Но даже не пытайся переубедить меня, что кумерское гунерское говно бустит модель по мозгам и памяти, и что разница в 6 процентов это повод прикасаться к лоботомитам.

>layers 8/43

>context size 49152

>выделенная память 13/16

Нда, блять...

Да я вот сейчас и мониторю как раз, сколько чего памяти видюхи жрет и че по генерациям. Сейчас надо только будет адекватно заново диалог начать чистый и глянуть, че по скорости. Я скачал и Q8, и Q6 и Q4 - буду эксперементировать

ЧЯДНТ? Я вполне понимаю, что мог легко где-то обосраться

Количество контекста лучше выставить 32768. Дальше модели сильно глупеют, выдают шизу или откровенно ломаются. Контекст будет занимать меньше памяти, значит больше попадет в видеокарту, значит скорость будет быстрее. На этом мои полномочия все, окончены.

Этот ответ сгенерирован ИИ? Я вообще-то вопрос задал, табличкам доверять можно или нет...

Контекст блять прибери ебаный по голове. Ты еще там где-то выше писал, что у тебя модель тупеет по мере увеличения числа сообщений. Так вот блять она не работает на таких значениях. Ты впустую тратишь память. Ставь 16к и не трогай, потому что дальше у нее мозги спекаться начинают

Спасибо огромное.

Судя по всему, мне надо аватарку завести, что бы люди сразу понимали, что мои тупые вопросы задаю именно тупой я. Может аватарку хлебушка, блять, раз у меня мозгов как у хлебушка.

Мистраль 3.2 до 32к норм держит. Разве что гунтюны разваливаются с первого сообщения омегалул

>Я вообще-то вопрос задал, табличкам доверять можно или нет...

Можно, если хочешь быть наебанным. Все бенчи это пиздежь. Доверять можно только своим ощущениям.

Нет, не делай этого. Не заводи аватарку. Последний мой тебе совет. Ладно, предпоследний. Последний - сам тыкайся/разбирайся, в тред приходи с конкретным вопросом. Информации много в интернете в целом и в документации Таверны/Кобольда в частности.

Будешь аватарить и слишком полагаться на тред - даже самые добрые перестанут отвечать.

Сейчас на на mistral small 24q6 попробую сначала 32к, как сказал анон выше, а потом твои 16. Посмотрю в чем разница. Я просто ставил такие высокие значения контекста в надежде того, что модель будет запоминать больше произошедших событий. Я так это понял, когда выставлял в первый раз эти значения.

Да блять(

Если кто будет пробовать новую экслламу в табби - кажется дефолтный билд, который там качается припезднутый. На всякий случай после обновления/установки активируем венв и пишем

> pip uninstall exllamav3 -y

> pip install git+https://github.com/turboderp-org/exllamav3

Первый запуск после этого может быть дольше обычного - компилируются модули под среду.

> pip uninstall exllamav3 -y

> pip install git+https://github.com/turboderp-org/exllamav3

Первый запуск после этого может быть дольше обычного - компилируются модули под среду.

>попробую сначала 32к, как сказал анон выше, а потом твои 16

Смысл в том, что его 32 в твою память скорее всего просто не влезут. Но пробуй, кто запрещает.

>Мистраль 3.2 до 32к норм держит.

Сомнительно держит, если честно. По крайней мере у меня после 16-18к стабильно начинает разваливаться разметка и появляется паттерн по типу 80% диалогов и 20% нарратива, когда до этого всё шло ровно наоборот. Приходится префиллить и продолжать генерацию по несколько раз чтобы вернуться к норме.

Ну вот в старом чате показывает вот такое, когда начинаю генерацию с загрузкой 32к токенов. Загрузка такого количества токенов заняла где-то 2 минуты. Сейчас вот генерируется сам ответ. Примерно 1 токен в секунду..

Что значит префиллить? Подскажи на будущее..

Сначала выгружай все слои, потом верти крутилку ползунка контекста, пока не упрешься в видеопамять.

>Что значит префиллить? Подскажи на будущее..

Мне лень. Дам тебе возможность разобраться самому. В таверне есть кнопка континью, которая вместо полностью новой генерации продолжает незаконченный кусок сообщения. Это может быть текст, который она сгенерировала до этого, или может быть текст, который ты написал сам чтобы повествование шло в нужном направлении.

Понял.

>qwen3-30b-a3b,

пробовал. не зашло.

Короче, я немного разочарован. Переписал персонажей и сценарий мира на русский язык, задал примеры сообщений на русском языке. Модель выдает абсолютно тупое понимание русского. Ну просто блять какой-то бессвязный текст.

Видимо придется обратно все переписывать на английский и ебаться с переводчиками. Эх.

>Модель выдает абсолютно тупое понимание русского.

Нужен хороший русский - трогай большую гемму. Но она пережарена цензурой из коробки и придется немного заебаться с промтами под нее. Если у тебя нет никакого опыта в составлении инструкций, можешь даже не пытаться и сразу искать готовые пресеты.

>Видимо придется обратно все переписывать на английский и ебаться с переводчиками

Все современные модели адекватно воспринимают русский на входе. Самый удобный воркфлоу это держать системные промты и карточки на английском, а свои сообщения писать на русском. Надобность в переводчике отпадает, а модель не тупеет, так как отвечать всё равно будет на английском.

Да хуй с ним.

Тут теперь другое. Начал новый чат, описал в заметках автора произошедшие события, продублировал их в первые сообщения. Добавил это все в историю персонажей. Добавил события в world history. Начинаю генерацию - модель выдает ваще не связанные действия с сюжетом и путает имена, генерируя ваще рандомные на месте персонажей.

Шаблон отклеился, похоже. Логи, скриншоты ты не даёшь, остаётся на кофейной гуще гадать.