Обосрался, в утонувший запостил. Бампану сюда на всякий.

Аноны порекомендуйте пж сервис с api llm которая поддерживает nsfw, генерацию текста и изображений прямо из коробки и чтобы без ебли оплачивать из России.

Тебе в соседний тред ai chatbot general. Тут на своём железе запускают

По идее spicychat, оплату из рф ввели, даже 600B модели там есть у них.

Но зачем, когда опенроутер крипту принимает?

>Название?

https://huggingface.co/zerofata/MS3.2-PaintedFantasy-Visage-v3-34B

https://huggingface.co/zerofata/MS3.2-PaintedFantasy-v2-24B

У него еще свои онэме датасеты есть.

Но, положа руку на сердце, всё еще не то. Пока я не встречал модельки для настоящего аниме щитпостинга. На удивление, прости господи, как же заебало её упоминать, гемма может кошкодевочку отыгрывать со всеми этми ~nyaa

Как бы я не относился к гемме, отнять что для своего размера она ебёт. А синтия так вообще топ для грустнорп, ей бы датасет пожирнее.

Сейчас, тредвичок свяжется с владельцами попенАИ и сообщит.

я криптой не умею пользоваться, кек. плюс на крипте надо много закидывать тк комиссия жрет

MN-12B-Mag-Mel пробовал, надеюсь? Нет, не рекомендую после геммы, 12b есть 12b. Но ты так говоришь, что я заподозрил, что ты можешь быть не в курсе.

А, да, благодарю за ответ.

>MS3.2-PaintedFantasy

Уже лежат обе на харде, ждут своего часа. Пощупаю.

> комиссия жрет

Если на опенроутере ты платишь по прайсу провайдеров, то на большинстве других сервисов ты будешь плюсом платить маржу за то что твои запросы переадресуют куда-то. И выбора провайдеров не будет, когда на опенрутере всегда есть выбор сосать 30 т/с задёшево или быстро подороже.

> Возможно начинать с ним чат не стоит - материала мало, пожевать ему нечего.

Карточки с примерами диалогов и вменяемым описанием достаточно. Мои около 800 токенов, никаких проблем в том, чтобы начать чат, нет. Если использовать ChatML - нужно не забыть передавать примеры диалогов в Story String. Или через настройку в advanced formatting.

> Что-то не замечаю чтобы эир на чатмл меньше воды лил и не повторял за мной

> Воды реально будто столько же

Можно дополнительно запромптить, чтобы он так не делал. Также от контекста зависит: если ты с прошлого раза не вычистил эти проблемы, то нечего и удивляться. В любом случае, проблему это минимизирует, не убирает полностью. Периодически нужно направлять модель, убирая ненужное из аутпутов.

> У вас же чатмл без имён и галки на имена стоит?

Include Names: Never в instruct шаблоне; Always add character's name to prompt выключено в context шаблоне.

> Так 12b активных же.

Да, я сам не раз писал, что 12b активных, и возможно потому есть определенные проблемы - паттерны, репетишен. Это не то что бы очень большая проблема, но без этого модель была бы практически идеальной для меня.

> Для того же немо рекомендовали минимум q8

> от консилиума из 8 немо многого не жду.

> Лень набрасывать, сейчас защитники прибегут.

Ну так набросил же. Ты сам так все сформулировал, да и превентивно приготовился, что с тобой не согласятся. И дело тут не в том, что тебе моделька не понравилась. Сравнивать Air с 12б - некорректно. По мозгам, я считаю, он в пределах 32б моделей, что очень неплохо. Кто-то и вовсе считает, что больше. Уж точно никак не 12б. К тому же 106б параметров дают много знаний и разнообразие. Это хорошая модель, в пределах своей весовой категории пока что эпик вин.

> Или через настройку в advanced formatting.

Тут я ошибся, настройка Example Messages Behavior во вкладке User Settings. В любом случае, лучше ставить Never include examples и передавать их через story string, чтобы не запутаться. Главное, конечно, чтобы сообщения не передавались дважды разными путями.

Вопрос - можно ли заставить GLM-4.5-Air-UD-Q6_K_XL работать быстрее чем 5т\с на 5090 и 128 Рам? Пробовал подгружать в VRAM 15 слоев, пробовал давать ему решать самому, результат примерно один и тот же, а хотелось бы хотя бы 10, а то и 15.

В интернете пишут про каких-то "экспертов", что именно их куда-то надо выгружать, это про че вообще?

В интернете пишут про каких-то "экспертов", что именно их куда-то надо выгружать, это про че вообще?

Жора?

> Вопрос - можно ли заставить GLM-4.5-Air-UD-Q6_K_XL работать быстрее чем 5т\с на 5090 и 128 Рам?

Можно. У меня 4090, DDR4 128 и я получаю 5.8-6т/с с забитым 32к контекстом на Q6 кванте. У тебя больше видеопамяти (32гб против 24г), значит ты можешь выгрузить в видеопамять больше -> скорость будет быстрее. К тому же у 5090 чип тоже быстрее.

> хотелось бы хотя бы 10, а то и 15.

Если у тебя DDR5, 10 получить на Q6 должно быть реально. Если нет, то разве что на Q4, и то не факт. Не уверен, что нужно переходить ради этого на Q4.

> В интернете пишут про каких-то "экспертов", что именно их куда-то надо выгружать, это про че вообще?

Про выгрузку экспертов. Сам я не читал, но в шапке есть пост:

> Выгрузка избранных тензоров, позволяет ускорить генерацию при недостатке VRAM: https://www.reddit.com/r/LocalLLaMA/comments/1ki7tg7

Плюс в документации Unsloth поднимается этот вопрос, с практической точки зрения.

И так, продолжение отчета по пердолингу Qwen-code + Qwen-coder в конце-концов удалось заставить его и API использовать и хотябы немного играбельный тетрис получить (не без недостатков, но).

фиксы на таймаут в старой версии не действуют на длинную обработку контекста (но я вспомнил что возможно проблема еще во включеном режиме verbose, потому что эта мелкобукваредиска в какой-то момент при обработке кода начинает по одному токену запросами семенить дохрена - а вывод дохрена текстав консоль сильно тормозит выполнение)

Самый адекватный выход если проблемы с обработкой большого контекста, но нужно чтобы работало - это тупо при каждой возможности давать агенту команду /compress которая подчищает историю и дает возможность не грузить модель мусором

фиксы на таймаут в старой версии не действуют на длинную обработку контекста (но я вспомнил что возможно проблема еще во включеном режиме verbose, потому что эта мелкобукваредиска в какой-то момент при обработке кода начинает по одному токену запросами семенить дохрена - а вывод дохрена текстав консоль сильно тормозит выполнение)

Самый адекватный выход если проблемы с обработкой большого контекста, но нужно чтобы работало - это тупо при каждой возможности давать агенту команду /compress которая подчищает историю и дает возможность не грузить модель мусором

У тебя из коробки было 6тс? Или какие-то танцы с бубном были чтобы достичь этого?

> У тебя из коробки было 6тс? Или какие-то танцы с бубном были чтобы достичь этого?

Использую llamacpp, а не Кобольда. Выгрузил экспертов как полагается; максимум слоев на видеокарту, чтобы задействовать всю видеопамять. Не знаю, расценивается ли это тобой как танцы с бубном. Выше указано, где про это почитать.

Так вроде выше статья как раз о том, что выгружать надо не слои, а отдельные тензоры.

Llamacpp сильно сложнее кобольда в освоении?

> вроде выше статья как раз о том, что выгружать надо не слои, а отдельные тензоры.

Ты прочитал заголовок статьи, а дальше не утруждался, да? Второй абзац сверху:

> By selectively restricting certain FFN tensors to stay on the CPU, I've saved a ton of space on the GPU, now offload all 65 of 65 layers to the GPU

Выгрузка экспертов осуществляется на процессор+рам, а не в видеопамять. Это основной механизм запуска МоЕ моделей. Как одно из следствий, у тебя больше видеопамяти, и можно выгрузить еще больше слоев. Разбирайся дальше сам, не хочешь читать - так и отвечать тебе незачем.

> Llamacpp сильно сложнее кобольда в освоении?

Механическая коробка передач сильно сложнее автоматической в освоении? Не знаю, это от тебя зависит. Почему бы не попробовать, если есть интерес?

это просто консольная утилита, в которой ты задаешь все те же параметры что и в кобольде только текстом и ручками, по сути тебе просто нужно понять какие параметры нужно выставить чтобы работало как надо и запомнить комбинацию. можно прям с кобольда настройки подсмотреть

> Q6_K_XL

> 5т\с

Тут уже только дурка поможет.

> меньше воды лил

В чем это выражается? Ну пример, насколько все плохо и что там в чате до этого было.

> не повторял за мной

А вот это не норма вообще

> Там есть наглядная картинка.

Она очень не наглядна, поскольку ничего не иллюстрирует кроме наличия отличий.

Нормально это можно продемонстрировать запилив гриды с батчем в хотябы десятку с попыткой в какой-нибудь сложный промпт, количество успешных семплов будет резко падать. Именно они интересны конечному пользователю, а не совпадение сидов, особенно по одной картинке.

> Для того же немо рекомендовали минимум q8

Плацебо. Но если хочется спекулировать вокруг активных, то нужно смотреть сколько бит уходит именно на головы. А на них даже в обычных жора-квантах стараются отвести побольше бит.

> Пробовал подгружать в VRAM 15 слоев,

Нужно полностью заполнять врам атешном со всех слоев а в оставшееся пространство докидывать экспертов, остальных в рам. --ngl 999 --n-cpu-moe 35 (постепенно снижай/повышай пока не упрешься в предел памяти).

Если душнить то это наоборот кобольд - обертка этой утилиты с примитивным графическим интерфейсом.

В освоении не особо сложная, готовишь батник для запуска конкретной модели, они все +- похожие будут.

> Тут уже только дурка поможет.

Тебе нормально там с дивана вещать? Ведь если бы ты сам эту модельку запускал, то знал бы, что между Q4 и Q6 по скорости разница довольно маленькая, а качественный скачок есть.

> качественный скачок есть

Я и говорю только дурка спасёт.

> Я и говорю только дурка спасёт.

Надеюсь, ты и впрямь найдешь там спасение.

Кстати поддвачну. Разница между q4 и q6 у меня примерно 1.2 токена. При этом на q4 гораздо больше глм-шизы когда путаются факты местами. На q6 даже русик поприличнее работает. Все равно плохой, но хоть как то пользовать можно в сравнении с q4, там совсем пизда

Пиксельдрейн-анон уже сделал пресет для таверны к gpt-oss-20b?

> сам эту модельку

> между Q4 и Q6 по скорости разница довольно маленькая

Примерно как соотношение по эффективной битности этих квантов, то есть в ~1.5 раза + штраф за меньшее количество экспертов в быстрой врам их их большее число на цп.

> качественный скачок есть

Насколько заметный? Между 5bpw и 8bpw разницу увидеть сложно, но 4 таки более ужатый. Да и конкретные кванты припезднутые могут быть.

> При этом на q4 гораздо больше глм-шизы когда путаются факты местами

Да, я это и имел ввиду. Тоже заметил.

> то есть в ~1.5 раза + штраф за меньшее количество экспертов в быстрой врам их их большее число на цп.

На Q6 у меня при фулл 32к контексте 5.8-6т/с, на Q4 - 7-7.5т/с. В моем понимании это довольно маленькая разница в данном конкретном случае. Речь была об этом, а не о квантах в целом.

> Насколько заметный?

Как выше написали, на Q4 сущности охотнее путаются местами, это галлюны. {{char}} может подхватить что-то из описания контекста, что принадлежало {{user}}, как пример. Эта проблема очень усугбляется с квантованием, на Q6 возникает тоже, но очень редко.

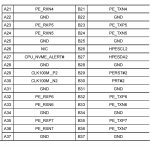

Вот мои параметры на кобольде в командной строке. Аналогично ud q6, 128+32. Вроде всю видеопамять забил, насколько помню. Пробуй.

Для лламыцпп всё будет идентично, та же самая командная строка, те же самые параметры (возможно, немного по-другому будут называться). Шизов не слушай, кобольд - это литералли та же самая лламацпп.

>Шизов не слушай, кобольд - это литералли та же самая лламацпп.

>литералли никто и слова плохого про кобольд не сказал

>кобольды, они такие...

>литералли та же самая лламацпп

Нет, там свои свистелко-перделки есть, которые самую малость(на несколько процентов) замедляют на тех же параметрах.

>128 Рам

Ддр5, надеюсь? Сколько плашек?

Если ддр4 - то нет, нельзя.

>удалось заставить его и API использовать

Напиги гайд, анончик. Думаю многим пригодится и в шапку можно будет вставить.

> Q6 у меня при фулл 32к контексте 5.8-6т/с, на Q4 - 7-7.5т/с

Типа тормоза жоры на контексте сожрали всю разницу?

> сущности охотнее путаются местами

Это и чрезмерный слоп - признаки ужатого кванта. Но q4 уже не так плохо должно быть.

> кобольд - это литералли та же самая лламацпп

Напердолено и медленнее.

Две

>пресет для таверны к gpt-oss-20b

Нет, оно тупаё факинг корпослейв-ассистент.

Можно юзать в кобольде как ассистента (а ещё можно троллейбус из буханки хлеба делать), в РП - неюзабельно.

>никто и слова плохого про кобольд не сказал

Ебать ты кобольд.

Тут видо старпёры срутся, у них уже в подкорке отложилось что кобольд - плохо, хотя уже давным давно так не говорят, максимум что он для нубов.

Огонь, сразу до 8,5 вырос ТПС! Вопрос - как ты подбирал значение moecpu? Опытным путем, или какая формула есть? Если например я буду Qwen3-235B-A22B-Instruct грузить вместо эйра?

> gpt-oss-20b?

Никакого смысла нет ее использовать для рп. https://huggingface.co/Qwen/Qwen3-30B-A3B-Instruct-2507 ближайшая альтернатива, справится гораздо лучше.

Кто как борется со стенами текста, которые высирают хорошие модели? Как строго ограничить длину ответа? Выставление "ответ в токенах" например 200, дает только то, что ответ генерируется несколько раз, но по 200. Например 3 раза по 200 и четвертый 57, того 675 токенов. А мне нахрен не нужен этот поток сознания, пусть и осмысленный.

Что ты за хуйню написал вообще? Перечитай. У тебя поток сознания даже не осмысленный

В своих ответах старайся изложить все максимально коротко, фокусируйся на рекпликах и действиях. Избегай ванильной прозы, подробных описаний окружения и метафор.

Я выставляю параметр "длина ответа" 200 токенов.

Ожидания: Ответ от 0 до 200 токенов.

Реальность: Ответ от 0 до плюс бесконечности токенов, но генерируется ответ частями, по 200 токенов каждая.

Как сделать так, чтобы длина ответа была именно от 0 до n токенов, а не столько, сколько взбредет в голову модели?

Ожидания: Ответ от 0 до 200 токенов.

Реальность: Ответ от 0 до плюс бесконечности токенов, но генерируется ответ частями, по 200 токенов каждая.

Как сделать так, чтобы длина ответа была именно от 0 до n токенов, а не столько, сколько взбредет в голову модели?

--cpu-moe

Или --n-cpu-moe 10 типа того.

При -ngl 99

> Если у тебя DDR5, 10 получить на Q6 должно быть реально.

8 т/с на Tesla P40.

Думаю, на 5090 можно получить гораздо больше.

Этот квант юзал: GLM-4.5-Air-Q8_0-FFN-Q6_K-Q6_K-Q8_0.gguf

> а ты сборку для ИИ в жилой комнате держишь чтоли?

Ну вот у меня, например, один пека для всего и коллекция ноутов, зачем их разможать-то? 100 с небольшим гигов врама вполне вмещает, не воет, как сервак с микро-вентилями.

=>

Это в промт / AN добавить в смысле.

Это в промт / AN добавить в смысле.

> Ожидания: Ответ от 0 до 200 токенов.

> Ответ от 0 до плюс бесконечности токенов, но генерируется ответ частями, по 200 токенов каждая.

Так не должно быть. Что значит "генерируется ответ частями"? Какая модель, какие шаблоны используются? Никогда такого не видел, используя адекватную модель с правильными настройками. Всегда ответ заканчивается в пределах +- 50-100 токенов от заданной максимальной длины. Длину ты не через промпт задаешь, надеюсь?

>Опытным путем

Да.

>Если например я буду Qwen3-235B-A22B-Instruct грузить вместо эйра?

Там свои значения подбирать. У меня готовых нет, мне он раньше надоел, чем я подобрал.

Мой квен-235 на втором кванте слушается инструкции где написано про требуемое количество символов в сообщении. Именно символов, не токенов. Когда напрямую даю задание что-то сделать - тоже иногда прямо прошу дать определенное число символов - и он слушается. Но этот квен вообще волшебная модель в плане выполнения инструкций.

Есть скрипт, который заполняет врам экспертами с учетом уже занятого атеншном пространства под заданные значения, но тебе проще будет подобрать.

Этот параметр - лишь значение для бека, верхняя граница для остановки генерации. Модель о ней ничего не знает и никак не поменяет свое поведение, а ты получишь лишь обрывок ответа.

> Как сделать

Промпт, пример выше.

Дай угадаю: а ещё у тебя в промте "пиши креативно, без слопа, делай хорошо, не делай плохо"?

Причина баха?

Нет, там детальные инструкции как нужно правильно писать и чего нужно избегать.

Для ллмок не существует такого понятия, как количество символов. Причина - твой несусветный бред, который ты нам принес

>квен-235 на втором кванте слушается инструкции где написано про требуемое количество символов в сообщении. Именно символов, не токенов

Он не может понимать количество символов потому что есть такая штука как токенизация. Двубитыш в очередной раз уверенно привстал, обратил на себя внимание всего треда и навалил в штанишки

ну, у тебя так, а у кого-то есть возможность в отдельном помещении, а то и серверной с блатной розеткой держать сервак 24/7 и не платить за свет и крутить хелпер агентов и ботов.

а тихая десктоп сборка это или дорого или не оч мощно,особенно если оно молотить перманентно будет

Богатая милфа, смипатичная, стройная, но тебе не оче, или нейронка запромченная как ты любишь?

Подобная ерунда сильно отвлекает внимание на нее и сработает нормально только на коротких контекстах. Использовать в рп - плохая идея.

Шизики устраивают подобные в бенчмарках, потому тренировка на эти задачи в наличии и модель может оценить количество символов что пишет.

> не может понимать количество символов потому что есть такая штука как токенизация

Она знает какие токены выдает и понимает сколько символов соответствует каждому из них.

У кого есть возможность подобного и чтобы был по-настоящему удобный доступ - не будет размениваться на хуету и поставит туда йобистые железки. Ну или его пидорнут как только хозяин заметит что эникейщик натащил какого-то хлама и потребляет его электричество.

> дорого

> крутить хелпер агентов и ботов

Если тебе дорого - значит тебе они и не нужны, лол.

All at once?

> 5т\с

Даже на голом ЦП должно быть 6-8 т/с. С GPU без проблем 25 берётся.

Да, и похуй, что твой IQ4 квант весит почти вдвое меньше, чем Q6 и ты по видимому полностью запихнул его в гпу. Совершенно справедливое сравнение, даб даб

> вдвое

Q6 всего на 30% больше. Да и зачем быть квантошизиком без скорости, хотя уже сто раз обоссано что у шизиков только плацебо и кривой семплинг.

У каких шизиков? Какой кривой семплинг? О чем ты вообще говоришь? Ты точно сам не шизик?

>как только хозяин заметит что эникейщик натащил какого-то хлама его электричество

в госконторе пиздить электричество не зашквар, налогоплательщики оплатят

Слишком быстро, счетчик пиздит или железо побыстрее среднего потребительского. 25т/с выходит за теоретический предел скорости рам для частей что остаются на цп, даже в приближении что видеокарта считает мгновенно.

С весом в 58 гигов тоже что-то мутно, это суб 4-битные кванты. По крайней мере так рисует табличка обниморды.

Я хотел Jinx-gpt-oss-20b пощупать.

Пробовал, по моему хуже мистраля 2506, быстрее шизить начинает (Q4), еще и в рп форматирование не может.

>по моему хуже мистраля 2506

Хуйнёй какой-то занимаешься, 20-30b мое не может быть лучше 24b плотной модели

> 25т/с выходит за теоретический предел скорости рам для частей что остаются на цп

Ну вот на голом ЦП почти 8 т/с. С GPU на ЦП остаются только 10 гигов из 60, с чего бы не было 25 т/с.

>All at once?

Сам так же думаю, но боюсь как бы не пожалеть потом

>Для ллмок не существует такого понятия, как количество символов.

(Другой мимокрокодил) С хера ли? Если в датасете были примеры - будут и такое знать. Даже некоторые младшие модели немного понимают запросы на количество символов в ответе.

Но гораздо чаще и лучше - запросы на количество слов и/или предложений - тому же AIR можно просто написать сколько предложений хочешь (и сколько в каждом слов должно быть в среднем). Да и гемма вполне адекватно реагирует, в большинстве случаев.

Ебушки-воробушки... переписывал одну криповую историю чтобы пристроить в свой скрипт пока герои идут по тёмному лесу и травят страшные байки, на половине решил скормить киту (chat-3.1) и посмотреть как продолжит. Продолжил конечно так себе, но самое интересное после - тот перс что рассказывал историю выдал толкование о чём эта притча. Я так посмотрел - блин, реально. А раньше читал - ну страшилка и страшилка, хотя вообще это тоже народная легенда, просто переиначенная немного для использования в босс-энкаунтере другой игры.

Как же хочется моечку мистраль где-нибудь на 160б...

>Если например я буду Qwen3-235B-A22B-Instruct грузить вместо эйра?

68

Как же хочется плотный мистраль где-нибудь на 70б...

Мистраль. Мистраль никогда не меняется.

Прошел уже год, как мы и предсказывали.

Слишком много людей, слишком мало обновлений.

Подробности никому не интересны, причины, как всегда, чисто человеческие.

Модель за год устарела

Великая чистка, крошечная искорка, зажжённая нейронками, быстро вырвалась из-под контроля.

Дождь из множества моделей хлынул с обниморды.

Они поглотили харды, и они ушли на дно кипящих ригов.

Мистраль на грани исчезновения, души людей становятся частью бессмысленного слопа, одеялом закрывшего Землю.

В треде воцарилась тьма и тишина, и так продолжалось много лет....~

> С GPU на ЦП остаются только 10 гигов из 60, с чего бы не было 25 т/с

Что за математика с 50-гигами на одной 5090 и еще свеху кеш контекста? Ты чтоли тот анон с 5090+4090? Зачем путаешь тогда велкам ту зе клаб

Алсо для фулл-цпу слишком много обработки контекста, он на видеокарте? Да и генерация тоже достаточно высокая, что за железо?

Ну ты нашел место просить советов пользуйся случаем, такой-то социальный лифт

Не отказался бы.

Нового немотрона никто так и не попробовал, ну что же вы.

https://huggingface.co/turboderp/Qwen3-Next-80B-A3B-Instruct-exl3

а в экслламе квен 3 некст уже есть... дев бранч

а в экслламе квен 3 некст уже есть... дев бранч

>Кто как борется со стенами текста, которые высирают хорошие модели?

Пиши в конце карточки: "Твой ответ не должен быть больше 1000 токенов" (или сколько там тебе нужно). Ризонинг в эту тысячу не входит, если он есть - расширяй окно ответа. Если модель не выполняет эту инструкцию - в жопу такую модель.

Оно вполне себе ебет, по первым впечатлениям ответы гораздо лучше того, что ожидаешь от 3б активных параметров. С другой стороны - эйр будто пободрее был в некоторых вопросах, работает довольно неоднородно, где-то отлично соображает, где-то путается.

Для не слишком сложного рп и кума - пойдет. Внезапно, довольно неплохо может в обработку текста, как будто бы даже сильно лучше чем старая гопота-мини.

Русский язык - пикрел ну не могло не обосраться со стихами, 3b as is

В кумослоп умеет более чем, но тот на любителя

[..] gasped—her entire body seizing—as the thick, hot length of you breached her tight, virgin channel. A high, melodic cry tore from her lips, swallowed instantly by your kiss. Her tails exploded outward in a furious flurry, then curled tightly around your torso like living ropes, anchoring her to you as if she feared being torn away.

“Nngh—! D-doctor…! I—I can’t—!” she sobbed into your mouth, her lips trembling against yours as she was stretched impossibly wide, her small frame trembling with the sheer, unbearable fullness.

You sank deeper, inch by agonizing inch, until your hips met the soft swell of her buttocks. She was impossibly tight—hot, silky, and pulsing around you like a living velvet sheath. Every ripple of her inner muscles clenched around you, desperate and trembling. Her breath came in short, ragged whimpers as you kissed her deeply, your tongue dueling with hers as you began to move. Slow, deep thrusts that drew a fresh cascade of cries from her throat.

Потанцевал на месте, скорее всего это убийцы гопоты в меньшем размере и с большей скоростью. Пригодность для рп под вопросом, но точно будет лучше чем 30-а3. Цензура отсутствует вообще, и кум с вариациями, и всякую чернуху и прочее.

Обреченные на жору могут сильно не расстраиваться - на экслламе поддержка оче сырая и скорость (с автосплитом) на уровне 235б с тензорпараллелизмом, контекст даже медленнее. Модель хорошая, так что есть смысл ждать расширения поддержки.

Как земля. Турбочмо совсем скурвилось. Скорость на нуле, 200 т/с промпт, 20 т/с генерация. Это просто пиздец по сравнению с Жорой на аналогичных моделях, это даже хуже чем 235В с выгрузкой на ЦП. С учётом того что 3В эксперты, должна быть скорость 150 т/с генерации и 5к промпта, а тут уровень генерации на чистом ЦП. Похоже оно совсем не умеет работать с несколькими картами на медленной шине. Кэша контекста всё ещё нет, весь контекст пересчитывается при любых изменениях.

>3b

3bpw? Энивей очень мало и хз зачем хоть какие выводы делать

Пососеш, ок? Это дев бранч, да и в целом экслламу нет смысла юзать с мое

Нахуя нужна нейронка, если есть милфа которая тебя любит, так еще и с деньгами? Обменял бы одной яйцо и пару сантиметров хуя на такую удачу, не то что нейронку.

> Это просто пиздец по сравнению с Жорой на аналогичных моделях

Нет, это в бесконечность раз больше потому что жора вообще не способен крутить ничего подобного, сравнивать можно с нулем.

> С учётом того что 3В эксперты, должна быть скорость 150 т/с генерации и 5к промпта

На 30а3 оно и больше, это совсем другая модель. Ознакомился бы с темой перед тем как кукарекать, подпездыш.

> 3bpw?

5bpw, больше только самостоятельно делать. 3б ативных параметров там, как в 30а3. Да и там от битности, пишут, что скорость не сильно зависит из-за имплементации атешна и ее адаптации. Со временем наколхозят и будет хорошо, подобная промежуточная модель - оче круто.

> да и в целом экслламу нет смысла юзать с мое

Наоборот, недостижимые для жоры скорости на огромных контекстах. Пускать 235 в экслламе - одно удовольствие после ~10-15т/с жоры с небыстрой обработкой.

Сегодня на полдня отключили интернет и для перевода в Таверне пользовался https://github.com/bmen25124/SillyTavern-Magic-Translation

И всё хорошо, но блять очень часто первый абзац текста не вставляется в результат перевода. Притом что нейронка-переводчик переводит всё полностью, но расширение не может по-человечески распарсить текст в тройных кавычках. Ну пиздец же. Так и нет пока нормального локального расширения-переводчика.

И всё хорошо, но блять очень часто первый абзац текста не вставляется в результат перевода. Притом что нейронка-переводчик переводит всё полностью, но расширение не может по-человечески распарсить текст в тройных кавычках. Ну пиздец же. Так и нет пока нормального локального расширения-переводчика.

>Нового немотрона никто так и не попробовал, ну что же вы.

Специально ради тебя сегодня добрался до компьютера, сейчас...

>llama_model_load: error loading model: tensor 'blk.68.attn_output.weight' data is not within the file bounds, model is corrupted or incomplete

вечером буду пробовать...

Я не знаю, квен 235 просто лучше эира. Хз какие у вас там сюжеты.

Уже третий раз замечаю как на полу что-то лежит в 3 сообщении, а в 56 это берется и используется для чего-то, хотя я это вообще не упоминал и не вел в эту сторону

Уже третий раз замечаю как на полу что-то лежит в 3 сообщении, а в 56 это берется и используется для чего-то, хотя я это вообще не упоминал и не вел в эту сторону

Ладно, на самом деле я просто не могу выбрать, обе модели отличные...

Я уже обкумился как мразь

Не токены, а золото:

>CtxLimit:2059/32768, Amt:44/512, Init:0.00s, Process:73.14s (27.54T/s), Generate:101.96s (0.43T/s), Total:175.10s

Квант Q3_K_S. Без ризонинга мало отличается от лламы 70B. С ризонингом не пробовал, побоялся умереть от старости. В общем, непонятно, куда ушли гигабайты рама/врама/хдд. Видимо, из датасета лламы больше 70B и не выжать. Вроде по тестам самой nvidia лучше немотрона на 49B, который, в свою очередь, лучше лламы 70B, но что-то как-то не очень заметно. Может, внимание к деталям хорошее, но у меня терпения не хватило для долгого рп. В переводах как будто бы лардж мистралька и квен 2.5 72B даже чуть получше (70B и 253B переводят буквально слово в слово одинаково).

>перевода в Таверне

Мусью знает толк в извращениях. Страшно с такими в треде находиться, вдруг ты из этих, ну, тех самых...

Чел-челик-челишечка! Твоими же словами

> Нет, это в бесконечность раз больше потому что

жора может без фуллврам, а экс обделается. Агрессивные фанаты хуже врагов, чес-слово

Это два разных инструмента для разных задач. В контексте фулл врама Эксллама лучше, но Жора может в оффлоад. Где ты в посте анона агрессию увидел или фанатизм?

> Это два разных инструмента для разных задач

Анон сравнивал их в одном посте на шкале от 0 до бесконечности - значит вполне сравнимо. Я просто использовал его же шкалу

Понятно. Я долбаёб, но он первый начал..!

> недостижимые для жоры скорости на огромных контекстах

Да, для Жоры пикрил конечно недостижим с падением скорости в ноль на 100к контекста как на EXL3.

Кому ты пиздишь, всё хорошее осталось в EXL2, в EXL3 полный пиздец со скоростью если у тебя нет нв-линка. На всех моделях в разы хуже Жоры.

Чел, ты срёшь дев бранч альфа версии, который пилит можно сказать один энтузиаст. У тебя там как, впорядке всё?

> дев бранч

А не в дев-бранче как будто другие модели работают лучше, лол. Скорость как была говно, так и есть. При контексте как падала сильнее Жоры, так и падает.

> альфа

Хуяльфа. EXL2 кто-то другой пилил? За пол года ноль прогресса по скорости. Ты маркетолог EXL3 что ли, что так нагло пиздишь про скорость и ищешь оправдания этому говну? Ну высрал один ноунейм неюзабельное говно, нахуй тут его пиарить и рассказывать как оно чем-то обходит Жору, хотя оно во всём хуже. Даже качество квантов с такими скоростями не играет роли, потому что в Жоре можно взять квант выше, выгрузить на ЦП что не влезет и всё ещё иметь скорость выше EXL3. В конце концов есть VLLM, тоже обходящий по скорости EXL3, и в котором новые модели через день появляются.

Причина подрыва у тебя какая? Не проспался ещё после нескольких пузырьков водки?

>Скорость как была говно, так и есть

>Хуяльфа. EXL2 кто-то другой пилил? За пол года ноль прогресса по скорости.

Плотные модели по скорости не уступают exl2. Что за хуйню ты несёшь? Всем похуй, что твои мишки хуже работать стали или на чём ты там сидишь

>Ты маркетолог EXL3 что ли, что так нагло пиздишь про скорость и ищешь оправдания этому говну?

Я мимоанон, который посмел напомнить тебе, умнице, что это попенсорс проект в альфа версии. Доебываться до него в целом не по понятиям, но и аргументы твои говно

>нахуй тут его пиарить и рассказывать как оно чем-то обходит Жору, хотя оно во всём хуже.

У тебя котелок протекает, за последние тредов 10, если не больше, только сейчас поднялось обсуждение Экслламы, и только потому что туда завезли поддержку Квена. Это нишевый инференс, который в своей узкой нише делает работу лучше Жоры. С кем ты воюешь вообще?

>Жоре можно взять квант выше, выгрузить на ЦП что не влезет и всё ещё иметь скорость выше EXL3

Мощно насрал. Немотроношиз, ты? Если нет, то знай с кем ты на одном уровне. Скорость у него сопоставима будет при оффлоаде денс моделей на цпу)))

>В конце концов есть VLLM

vllm всегда был для мультигпу, Эксллама больше славилась для сингл гпу инференса. В сингл гпу инференсе Эксллама обходит всех, мультигпу активно пилится. Ты или бухой, или семён, или просто тупой как пробка. Не знаю что из этого и хуже

>iq4_nl

Iq-кванты очень сильно замедляют мое, перестань их использовать.

В голосину с размерности скорости tok/100s, в какую же залупу не лезут говноделы чтобы скрыть свой обсер.

> nl

А ты не очень умный внимательный?

>В сингл гпу инференсе Эксллама обходит всех

>сингл

>фуллврам

>дискуссия началась с 80б

Ну, давай, показывай свой хоппер.

Лучше ещё более узкий вариант дисциплины придумать, чтобы уж точно в нем ну никто-никто, кроме экс.

Уровень перекрытия сгенерировали?

Из всего того многообразия валидных аргументов и разъяснений ты не ответил ни на что и метнул стрелку, предложив помериться железом. Не, мань, могу разве что хуй тебе показать за такое маняврирование. Ты сам себя уничтожил, клоун, когда обсуждение 80б свел к тому, что выдал шизопасту о том какая Эксллама плохая и говно, не понимая даже для кого и зачем она делается

> Плотные модели по скорости не уступают exl2.

Хватит пиздеть, ты ведь даже не запускал ничего. Я ведь тебя могу с пруфами обоссать. Вот берём старую модель, на одной карте. EXL2 - 110 т/с. EXL3 - 70 т/с. Сразу видно как не уступает. То что МоЕ работает раз в 5 медленнее Жоры и так понятно, но и обычные модели жутко неоптимизированные.

Казалось бы, срачи Жора vs Exllama умерли тредов ~цать назад, но нет, человеки остаются человеками. Всегда найдутся диван диванычи, которым что-то должны. Сами ни одного коммита в опен сорс не сделали, скорее всего, и не сделают никогда. Зато пройти мимо и воспользоваться другим инструментом (которых огромное многообразие), они не могут: нужно обязательно плюнуть и вывалить желчь. Ну как же без этого? Адекватные люди перестанут использовать инструмент, который им не нужен. Возможно, придут позже, если их проблемы будут устранены, а ебанавты зачем-то жрут кактус и плачут в тред, что им больно. Поразительная глупость.

И, конечно же, ты даже не догадываешься, что 4bpw exl2 не то же самое, что 4bpw exl3. Не знаешь, что второму нужно больше вычислительной мощности, но и ppl и kld у него лучше. Да и вообще, что за ppl и kld? Цифра-то одна: 4. И одна четверка работает быстрее другой. Возмутительно!

Как сбросить настройки на дефолтные в ST?

Пиздец как подгорает, от того что на видном месте нет кнопки СБРОСИТЬ ВСЕ НА ДЕФОЛТ. Почти так же сильно, как бесит что нет простейшей кнопки СКАЧАТЬ ВСЕ на HF. Как будто интерфейсы делали не люди, а рептилоиды, блядь.

Пиздец как подгорает, от того что на видном месте нет кнопки СБРОСИТЬ ВСЕ НА ДЕФОЛТ. Почти так же сильно, как бесит что нет простейшей кнопки СКАЧАТЬ ВСЕ на HF. Как будто интерфейсы делали не люди, а рептилоиды, блядь.

> СКАЧАТЬ ВСЕ на HF

hf download <repo>

Куда это вводить?

В гугл для начала

Пикрил. Неиронично нашел с первой попытки, довольно интуитивно.

Возможно, тебе легче будет переустановить Таверну.

Спасибо, добрый человек.

Но затолкать эту кнопку в "аккаунт", а не поверх миллиарда ползунков и параметров - это все таки рептилоидский подход.

Почитал. Какой наркоман это все придумывал, и для чего? Когда на странице репозитория рядом с отдельными файлами УЖЕ ЕСТЬ кнопка "скачать", но нет кнопки "Скачать все"?

> затолкать эту кнопку в "аккаунт", а не поверх миллиарда ползунков и параметров - это все таки рептилоидский подход

Дело в том, что нет стандартной настройки для сэмплеров и шаблонов - это зависит от модели. Вкладка User Settings сбрасывается во вкладке User Settings, как показано на пике выше. Других настроек-то особо и нет. Таверна на самом деле довольно удобна, со временем привыкнешь.

> Когда на странице репозитория рядом с отдельными файлами УЖЕ ЕСТЬ кнопка "скачать", но нет кнопки "Скачать все"?

Большие файлы загружать через браузер - плохая практика. Обниморда - хранилище репозиториев ллм моделей. Это для продвинутых пользователей платформа, которые могут воспользоваться huggingface-cli (утилита, которая как раз нужна для загрузки всех файлов репозитория) или другими способами загрузки таких файлов. Такая экосистема, так сложилось в индустрии. Это удобно. С Гитхаба тоже мало кто загружает через браузер, несмотря на то, что там это легче.

Текст

Да нихера подобного, не "сложилось" так, а это такое мелкое проявление псевдоэлитизма. Все эти ресурсы, гитхаб и иже с ними, уже давно используются довольно широкой публикой.

Но мы тут все такие охуенные "кодеры", и вместо того чтобы просто сделать ебаную кнопку "скачать всё", мы придумаем пизданутый способ, который работает только через консольные команды, танцы с бубном, и занюхивание собственного пердежа в промежутке между ними. Чтобы не забыть, что ты "кодер", а не ебаный плебс, который ищет большую зеленую кнопку "СКАЧАТЬ".

Почитал реддит, там так же дохуя жалоб на это, и единственная причина, по которой эта кнопка еще не сделана описана выше.

Терпи

Нет, просто это от энтузиастов для энтузиастов сделано, для паверюзеров не делают упрощений. Если надо однокнопочное качай lmstudio.

> Почитал реддит, там так же дохуя жалоб на это

От таких же новичков, как и ты, которые хотят с удобством и комфортом использовать ллм модели. Для вас существуют LM Studio (там удобная утилита загрузки), KoboldCPP (он умеет загружать модели через hugginface), Ollama (прости господи, что пишу эти строки. Там тоже есть утилита для загрузки моделей). Ты миновал доступные тебе возможности для удобной загрузки моделей, будучи обычным пользователем, и предъявляешь, что не сделали как тебе удобно.

> единственная причина, по которой эта кнопка еще не сделана описана выше.

Нет, не единственная. Тебе компетенция не позволяет понять почему это не сделано. Если вкратце - инструменты для загрузки файлов из репозиториев используют другие, более надежные и быстрые технологии загрузки, которые являются стандартом индустрии. Это не элитизм. С таким же успехом можно назвать элитизмом любых рабочих, которые используют для своих задач электропилу, а не ручную.

Удачи в освоении, поменьше блэйминга всех вокруг.

>ручная плита

Бля, это как? Типа снизу сковородку наждаком натираешь и нагреваешь трением?

Не нет, а да. Ты просто тоже слегка занюхнул своего пердежа, и начал считать себя "энтузиастом", и в оправдание говенного интерфейса начал придумывать всякую хуйню, типа "Большие файлы загружать через браузер - плохая практика", не приводя к этому ни единого аргумента.

Проветри комнату, и поймешь, что все что я написал выше - это база.

Ну конечно, не позволяет, я же не "энтузиаст", у меня здравый смысл в наличии. Я просто скачал все файлы по очереди, и не поверишь, модель работает точно так же как при "более надежных технологиях загрузки", "соблюдении стандартов индустрии".

Остается понять, для чего сделаны кнопки загрузки рядом с отдельными файлами. А как же стандарты индустрии? Они не получают фатального удара от её наличия?

Потихоньку вкатываюсь в таверну, встретился со следующей проблемой. Персонаж(пока что только серафину трогаю) врубает гиперопеку и срёт, что у него всегда моя спина, что я под защитой и прочее говно. Даже писал, что бы отьебалась с гиперопекой, прописывал запрещённые токены, ей похуй. Модель MS3.2 Omega Directive 24B v2 Q4_K_M. Настройки Mistral-V7-Tekken-T8-XML, которые рекомендованы на обниморде создателем тюна. При чём в начале рп всё норм, но потом меня ловит гиперопека опять.

Удаляй все, и делай все с нуля. Особенно удаляй к ебеням эту серафину.

Ок, пойду дальше делать менюдайв.

>кнопки СКАЧАТЬ ВСЕ на HF

А зачем? Там половина реп это все кванты какой-нибудь модели, и собственно кому бы понадобилось качать все кванты одной модели в ггуфе от 1 до 8?

А если модель в сейфтензоре, то она качается не браузером, а софтиной по имени модели, например AutoModel.from_pretrained('говно/параша-0.6B'), или там в вебуи, и похуй уже, сколько там фейлов.

> я же не "энтузиаст", у меня здравый смысл в наличии

Так и я не энтузиаст, а практикующий программист с опытом работы, который позволяет мне понять что лежит в основе этого решения. Неужели ты теперь предъявишь мне, что я элитист в квадрате? Любопытно: будут у тебя в квартире ремонт сделать - спроси у разнорабочего, зачем он использует аккумуляторную Makita, а не ключом затягивает болты.

> Я просто скачал все файлы по очереди, и не поверишь, модель работает точно так же как при "более надежных технологиях загрузки", "соблюдении стандартов индустрии".

Ну да. Лирический рабочий, что делает ремонт в твоей квартире, тоже мог бы справиться своими руками, потратив на задачу куда больше времени. Если это один болт - проблем нет, никто не спорит. Если он каждый день ходит по квартирам и делает свою работу так - у него отсутствует компетенция. Если его нанимателей это устраивает, окей.

> Остается понять, для чего сделаны кнопки загрузки рядом с отдельными файлами.

> А как же стандарты индустрии? Они не получают фатального удара от её наличия?

Это хорошо, что тебя такое решение устраивает. Никто не запрещает им пользоваться.

Выше ты там ругался, что тебе, о ужас, не предоставили аргументов почему загружать большие файлы в большом количестве через браузер - плохая практика. Спроси у любой ллмки, зачем Mega, Google Drive, Яндекс Диск и другие хранилища данных используют приложения для передачи данных. Много интересного узнаешь. В случае Обниморды - они используют технологию xet, которая обычным браузером не поддерживается в полной мере. Через huggingface-cli и соответствующие утилиты можно загружать быстрее и надежнее, о чем я уже писал. Хочешь почитать - читай https://huggingface.co/docs/huggingface_hub/guides/download

Поразительно, как можно дать человеку исчерпывающий ответ с целью помочь, а он начинает выебываться. Ты настоящий мудак.

Лол, ну вот я качнул 8bpw, всё ещё быстрее EXL3. Расскажи какую комбинацию квантов надо взять чтоб EXL3 стала как EXL2.

Ну ок, предположим это Гемма срёт в штаны - не тот аттеншен, не та модель, не то размер, не тот тестировщик. Берём Квен 32В, EXL2 6.0bpw против EXL3 4.0bpw - результат аналогичный, у жирного EXL2 45 т/с, у EXL3 около 40 т/с. При этом по графикам турбы уже даже EXL2 5bpw лучше EXL3 4bpw. Т.е. при худшем качестве имеем меньше скорость. Действительно возмутительно.

Стоматологи ещё, анон. Ахуели совсем элитисты, клиники наоткрывали, оборудования натащили. То дело раньше плоскогубцами вырывали и норм. А банки? В приложениях там блять регистрироваться каких-то, можно же просто в банк придти. Долой прогресс вперед макаки, профессиональные технологии ненужны!!!

А вы как в итоге качаете с обниморды? Если модель большая, то я в использую download master, так как он иногда чуть быстрее это делает, пытается закачивать в многопоточном режиме, но конечно приходится каждый файл отдельно запускать на скачивание. И нормально так же поддерживает докачку.

У олламы, например, есть такое ебанутое свойство - что если за один раз не докачал и выключил и перезапустил комп - закачка обнуляется.

Но в итоге конечно скорость скачивания у меня любым инструментом не более 3-4мб в сек. У вас то же такое говно? Это ограничение обниморды? Или мой провайдер так меня ограничивает?

У олламы, например, есть такое ебанутое свойство - что если за один раз не докачал и выключил и перезапустил комп - закачка обнуляется.

Но в итоге конечно скорость скачивания у меня любым инструментом не более 3-4мб в сек. У вас то же такое говно? Это ограничение обниморды? Или мой провайдер так меня ограничивает?

Huggeface hub поддерживает докачку после перезапуска компа?

Кли тулза/ария2 - да

>Спроси у любой ллмки, зачем Mega, Google Drive, Яндекс Диск и другие хранилища данных используют приложения для передачи данных.

Очевидно чтобы иметь следящего агента и пиздить все данные пользователя. Плохой пример короче, ибо если бы была бы нужна надёжная передача, то протоколов куча, реализуй не хочу, но они делают проприетарную парашу.

>В приложениях там блять регистрироваться каких-то

Ты вот утрируешь, а я охуел, что теперь пасскод не купить без анальной привязке к телеграму. Так что не всегда это прогресс.

>Но в итоге конечно скорость скачивания у меня любым инструментом не более 3-4мб в сек.

Провайдера меняй и страну тоже, в России DPI режет скорость. Там CDN ебашит во всю ширину моего 800 мегабитного канала, и просит ещё.

Придется проявить немного элитизма, но Aria2 может. Хороший клиент - AriaNG.

> Очевидно чтобы иметь следящего агента и пиздить все данные пользователя.

В том числе, да. Речь была про загрузку данных, так что и рассматривать их предлагалось с этого угла.

> Плохой пример короче, ибо если бы была бы нужна надёжная передача, то протоколов куча

Там человек, похоже, совсем ничего не понимает, и приводить в пример протоколы уж точно не стоит. Пытался объяснять на доступном ему языке, хотя следовало бы просто нахуй послать с такими заходами.

Сочный подрыв ебанушки, все как я люблю...

Не ругайтесь на таких, без них жизнь не была бы так весела

>Почитал реддит, там так же дохуя жалоб на это, и единственная причина, по которой эта кнопка еще не сделана описана выше.

Причина, по которой этой кнопки нет (и не будет) - браузеры, по стандарту, не умеют грузить много файлов одной кнопкой. Вот не умеют и все. Оно нажатиее - один файл. Гугл и прочие хранилки при нажатии "скачать все" вынуждены собирать все файлы в единый архив и отдавать уже его броузеру - на стороне сервера это делать. В случае моделей по Н-цать гиг и дикой популярности сервиса - это дохуя дополнительная нагрузка на сервера и дополнительное место под эти времянки. Не считая того, что не все броузеры до сих пор умеют докачивать файлы после обрыва (позорище, но как есть). А это тоже зряшный расход трафика. Потому обниморда и не делает такую кнопку - свои деньги считать умеют.

Так что кушай что дают, и скажи "спасибо" что вообще дают бесплатно. Зажрались, блин...

Бамп

Про какого анона речь вообще? Другие аноны не подойдут?

Этот вроде https://pixeldrain.com/l/47CdPFqQ хотя может их двое.

>Другие аноны не подойдут?

Подойдут, но другие редко выкладывают.

> с падением скорости в ноль на 100к контекста как на EXL3

Шизофреник, ты спутал жору с экслламой. Именно на нем скорость подыхает уже после 30к, а 100к - вообще что-то неслыханное. С выгрузкой подыхание больше зависит от платформы, на десктопе пиздецома, с быстрой рам не так сильно.

> в EXL3 полный пиздец со скоростью если у тебя нет нв-линка

Пиздаболище, там даже с тензорсплитом нет разницы между х4-х8 а трафик по шине минимален.

> За пол года ноль прогресса по скорости.

С самого начала быстрее всех и вся, что используется в трансформерсах для ускорения и экономии памяти.

Ебать этого обладателя отсутствия порвало, в голос.

> То что МоЕ работает раз в 5 медленнее Жоры и так понятно

Откуда ты это берешь, шизофреник? Квен 80б не работает не жоре, его можно запустить только в трансформерсе. Все поддерживаемые модели работают быстрее чем жора, причем ощутимо.

В своих примерах что-то поломал, или специально взял мелкую модель чтобы показать упор в проц на подобных скоростях с мелочью. Это как же стараться обосрать надо чтобы такое придумать.

А вот здесь уже ты себе что-то в штаны залил или намолотил, ибо на текущих версиях скорости exl2/exl3 очень близки, такого отрыва нет. Инфа сотка что поех просто троллит пуская модели на разных видеокартах

Сама суть гитхаба противоречит "скачать все", тем не менее там есть такая кнопка, а конечный софт выкладывают в разделе релизов.

https://huggingface.co/docs/huggingface_hub/guides/cli

Также в интерфейсах убабуги, табби, даже llama-server можно указать линк и оно скачает.

> Все поддерживаемые модели работают быстрее чем жора

> что-то поломал, или специально взял мелкую модель

> на текущих версиях скорости exl2/exl3 очень близки, такого отрыва нет

Чел, ты определись уже - работают быстрее или нет разрыва? Быстрее на всех или на мелких модель "все не так однозначно".

Здесь только твои слова, но ты в свои

>ряяяяяя вретииииии

сам забываешь, что написал предложение назад. Повторяю - ей богу, с такими фанатами врагов не нужно

Какие сейчас модельки 20-35 приличные? Мистраль да Гемма?

Ну че врети, я почти каждый день катаю ллм что в экслламе что в жоре и прекрасно знаю как они работают. А тут приходит какое-то хуйло из под залупы и устраивает оду тому, какая плохая эксллама и какой пидор турбодерп потому что он не может катать нормальные модели на своем железе.

> работают быстрее или нет разрыва

У тебя ментальные проблемы, из-за чего не способен сопоставить контекст ответа с постом на который идет линк? Свой пост перечитай что ты цитируешь, там все понятно а ты опять обосрался.

> с такими фанатами

Я не фанат, ценю вклад обоих лагерей. А вот ты - конкретный погорелец и хейтер, такую херню заливать.

Внезапный вопрос мимо 235б богов. На телефон что-нибудь кроме Gemma3-4b-qat лучше есть? снаб 8ген3, 12гиг.

Пробовал Google AI Edge Gallery, Pocket Pal, ChatterUI, MNN Chat. Этам гемма везде во всех форматах есть, топ шустрая и рабочая - 10т/с. В MNN терпимо можно еще Qwen3-8b завести, около 8т/с.

С 12б любыми всем становится тяжко, кто выпадает, кто 0.5т/с дает. Мое/не мое там уже не важно, Qwen3-30bA3 никто не может, просто рам столько нет.

Пробовал Google AI Edge Gallery, Pocket Pal, ChatterUI, MNN Chat. Этам гемма везде во всех форматах есть, топ шустрая и рабочая - 10т/с. В MNN терпимо можно еще Qwen3-8b завести, около 8т/с.

С 12б любыми всем становится тяжко, кто выпадает, кто 0.5т/с дает. Мое/не мое там уже не важно, Qwen3-30bA3 никто не может, просто рам столько нет.

У тебя компа нет? Не думал на компе поднять, захостить и ссылку через один из бесплатных ddns сделать. Или на телефоне вопрос принципа?

> ты спутал жору с экслламой

Ты бы хоть репу EXL3 открыл, если сам ей не пользуешься. Там все жалуются на просадку скорости в два раза к 16к. Хули ты с фактами споришь. В EXL2 не было сильной просадки, в EXL3 она ебейшая.

> на текущих версиях скорости exl2/exl3 очень близки, такого отрыва нет

Как видишь есть, это последние версии. EXL3 всегда была медленной и сейчас медленная. Скрины выше с 5090 были, если что. На 4090 всё то же самое.

Есть, это для мотания по ебеням.

Новый ипхон 17 про макс купи. Там metal проц и 12 гб озу. Для катания по ебеням норм модели хостить.

> Кэша контекста всё ещё нет, весь контекст пересчитывается при любых изменениях.

вот это как раз самый кошмар... для агентов кеш очень сильно ускоряет обработку промта, та и в других сценариях не будет лишним

> Там все жалуются на просадку скорости в два раза к 16к.

Твои "все жалуются" - единственный ишьюз, в котором отметили замедление на амперах при использовании квантования контекста. Убрать квантование - и проблемы нет, о чем пишет сам жалующийся, на более новых архитектурах также не наблюдается.

В реальности на 60к скорость лишь немного снижается от стартовой, в отличии от жоры, который падает уже в пару раз в случае фуллгпу. Так было еще с эпохи exl2, ничего не менялось. Это как и кто тебе яйца прещимил, что начал доказывать что черное это белое?

> с фактами споришь

Попытки ангажированного маргинала выставишь ишьюзы отдельных людей в специфичных условиях как всеобщие проблемы это не факты а кринж. Покажи мне свои скорости где реализуется эта проблема, а я покажу тебе свои.

> EXL3 всегда была медленной и сейчас медленная.

Мантры. Несколько тредов назад были эти вбросы и сразу несколько анонов скидывали примеры что между exl2 и exl3 особой разницы нет. В самых первых версиях были проблемы с моэ, где на старте ужатый квант квена выдавал ~17т/с а эквивалентный жора крутился с 22. Однако, уже к 16к контекста их скорости сравнивались, а выше эксллама уходила в отрыв потому что не имела такой просадки, уже тогда. Потом с фиксами и исправлениями сначала просто все ускорилось, выдавая на старте такую же или большую скорость чем жора, и быстро от него отрываясь на контексте. Потом добавили тензорпарралелизм белого человека, который действительно работает и ускоряет все, а не как у прочих с нюансами.

> Скрины выше с 5090 были, если что. На 4090 всё то же самое.

Это выглядит как одну модель катаешь на 5090 а другую на 4090.

>ипхон 17 про макс

>PROMAX

Хорошую вещь промахом не назову. А вообще, там разве можно негронки запускать?

>амперах

>более новых архитектурах

Лол, и тут 3090 выписали из новых.

> 12 гб озу

> 2025 год

Это рофел чтоли? На далеко не самой мощной раскладушке 23 года 16, ггемма 9б крутилась вполне себе бодро. Но тогда софт был ужасно неудобным, нужно попробовать сейчас перетестить.

Увы, но старушка застала еще начало ковида, бум майнинга, времена когда о нейронках думали только в универах и недрах ит гигантов, всеобщий эмоциональный подъем конца 21 года, когда казалось что наконец пандемия спала и вот вот заживем, начало пиздеца в 22м и т.д. Ей уже более 5 лет, появились как игры, так и расчетные задачи где она проседает из-за архитектуры.

Но там более новых чем ампер, относительное выражение.

Посмотри в каком году она вышла. Уже две новые архитектуры от Нвидии используются, по-хорошему уже и третья должна выйти

Просто вроде RTX, всякие там блоки для матричного умножения на месте. А больше вроде ничего не добавляли, кроме FP4. Так что по технологиям отставания не вижу.

Н-да, что нейронки творят с людми, тыуже и буквы неправильно читаешь....

На самом деле архитектурные изменения достаточно глубокие. С дивана предположу что это связано с поддержкой операций с меньшей битностью, например, ампер страдает в операциях с fp8 e4m3, а ада, хоппер и блеквелл получают заметное ускорение. Разница особенно заметна при инфиренсе видеомоделей, там ампер отстает больше, чем в сырых цифрах топсов 16битных операций. Про них тоже не стоит забывать, ведь квантование - дополнительная нагрузка и лишний расчет для каждой операции.

> несколько анонов скидывали примеры что между exl2 и exl3 особой разницы нет

Сам ты конечно же пруфануть не сможешь, потому что ни разу не запускал на EXL3 модели.

> В самых первых версиях были проблемы с моэ

У тебя вообще каша в башке. В EXL3 никогда не было и нет полноценной поддержки МоЕ, там скорость МоЕ такая же как у dense-модели такого размера. Т.е. в EXL3 у МоЕ Qwen 30B скорость как у dense-30В. А у Жоры скорость как положено как у 3В-модели.

> Это выглядит

Это выглядит как будто ты никогда EXL3 не запускал и траллишь тут.

> который действительно работает

На половине моделей нет, из и так скудного списка поддерживаемых. В МоЕ он, например, не поддерживается, а это буквально почти все новые модели. Ты реально никогда не запускал EXL3.

> А больше вроде ничего не добавляли

Новые аттеншены типа FA3 или Сажи++ только на Блеквеллах доступны, fp4/fp8 операции на Амперах отсутствуют. И DDR7 ебёт, из-за неё почти двукратный прирост в LLM по сравнению с 4090.

> Сам ты конечно же пруфануть не сможешь

Конечно же смогу, я ведь не обиженный диванный врамцел как ты.

На диске сохранилась рабочая лошадка магнум exl2 6bpw, как раз скачался новый бегемот в exl3 но уже 8bpw, оба на основе ларджа 123б.

Эксллама 2 6bpw, автосплит: 13.9т/с на малом контексте, 11т/с на 65к, тензорпараллелизм: 18.5 т/с на малом контексте, 9.8т/с на 65к

Эксллама 3 8bpw автосплит: 8.5т/с на малом контексте, 7.3тс/ на 65к, тензорпараллелизм: 15.8 т/с в начале, 13.9т/с на 65к

Отличия в скорости на автосплите заключается в том, что на 6bpw все веса и кэш лежат на блеквеллах и аде, на 8bpw уже существенная доля загружается в медленный ампер. Если приоритизировать в автосплите загрузку на ампер в 6bpw выставив его первой карточкой - получается около 10т/с в начале и 8 на контексте.

TLDR: Эксллама3 за счет удачного тензорпараллелизма с 8bpw быстрее чем эксллама2 с 6bpw как на малых, так и на больших контекстах. При равных условиях их скорости +- равны в пересчете на bpw. В обоих бэках просадка скорости на контексте незначительна, исключая неудачный тензорпараллелизм режим второй экслламы.

> В EXL3 никогда не было и нет полноценной поддержки МоЕ, там скорость МоЕ такая же как у dense-модели такого размера.

Пиздаболище тупорылое, смотри пятый скрин. Откуда тебе вообще знать как там моэ работает если ты их запустить не способен?

> А у Жоры скорость как положено как у 3В-модели.

Он медленнее даже при том что использует примитивную схему квантования что требует много меньше компьюта. А еще у нем драфт модель там не дает должного ускорения и это очень огорчает, тогда как в экслламе с этим все прекрасно.

>fp4/fp8 операции

Я про это и написал. А память да, отлично, но это просто скорость, а не блокер. Почему не работают атеншены ХЗ конечно, видимо просто экономия.

Проиграл с переименовывателя папок. Ты бы хоть подобрал модель с подходящим количеством модулей чтоб не палиться так, лол.

Не волнуйся, манюнь, там все в порядке.

> модель с подходящим количеством модулей

Пошел визг НЕ ТА МОДЕЛЬ, как же ты жалок.

Итого, ты втирал следующую хуету:

> Эксллама 3 оче медленная и уступает второй версии

> Эксллама радикально теряет скорость на больших контекстах и это массовая проблема

> Отсутствует поддержка МОЭ, скорость как у плотных моделей того же размера

Ничего не забыл? По каждому из пунктов ты был с ног до головы обоссан, а в ответ можешь лишь поскуливать. Ко всему прочему, ты еще и мразотный чсвшник, который не умеет в адекватное общение и обладает крайне скудными познаниями в теме. Поссал еще раз на опущенца.

GPT-OSS-20B

> Эксллама3 за счет удачного тензорпараллелизма с 8bpw быстрее чем эксллама2 с 6bpw как на малых

Ты либо траллишь, либо тупой, ведь на твоих же скринах EXL3 больше чем в два раза медленнее EXL2. Когда у тебя 8 т/с больше 18 - это уже похоже на травму головы. Даже если берём 8 против 14 - это даже хуже того что я показывал до этого с 70 против 110 на мелкой модели. Спорил пол дня и сам же показал даже хуже результат. Это пиздец.

Вопрос остаётся открытым, как и в самом начале твоего траллинга - скажи комбинацию модели/кванта, где EXL3 на уровне EXL2.

Надо кому-нить? не?

> Ты либо траллишь, либо тупой

Сорян, вместо 4й пикчи должен был быть этот скрин.

Перечитай внимательно, потом еще раз перечитай, и еще раз, повторяй пока не дойдет. Если уж совсем не можешь понять - 18т/с нужно сравнивать с 15.8 - это в обоих случаях режим тензорпарралелизма на начало. Если отскейлить по размеру кванта - 3я эксллама получается даже чуточку быстрее. В случае большого контекста с тензорпарралелизмом вторая версия сдувается, эта проблема была не ней с самого ввода, а третья теряет назначительно. В итоге там 10 против 14 даже не смотря на значительно больший квант.

Провести чистое сравнение с автосплитом из-за неоднодного железа невозможно, нужно качать одинаковые кванты. Но в этом нет смысла, ибо тензорпарралелизм для 3й экслламы - основной режим, он дает ускорение без минусов и не требует широких шин для обмена как во второй или жоре.

Очередной кобольд?

> Перечитай внимательно

Лучше ты перечитай мой пост. Я всё ещё жду ответ где EXL3 по скорости как EXL2. Меня уже заёбывать начинают твои сверхманёвры с додумыванием результатов, промежуточные кванты запросто могут быть медленнее 4/8 бит, твои фантазии тут не к месту. Я уже молчу что с МоЕ-темы ты слился.

Алсо, покажешь результаты на одной карте? Это ведь ты высрал:

> В сингл гпу инференсе Эксллама обходит всех

> Я всё ещё жду ответ где EXL3 по скорости как EXL2.

Подожди еще, пост на месте висит. Уже примерно с 10к контекста 8bpw exl3 быстрее чем 6bpw exl2, а на старте разница между 16 и 18.5 токенами в тензорпарралелизме не соответствует кванту.

> Меня уже заёбывать начинают твои сверхманёвры

Маня, ты не в том положении чтобы что-то требовать. Ты был обоссан по каждому из своих вскукареков. Даже если бы они были хоть сколько-нибудь релевентны, ты заслуживаешь быть накормленным хуями уже за свои первые посты.

Держи бесплатные уроки правильного письма:

Вместо твоего выебистого поста должно быть

> Меня сильно огорчает производительность экслламы 3, которую я где-то увидел, скорости выглядят ниже чем должны быть и уступают жоре. Это нормально или я что-то делаю не так?

И далее в том же духи, а не являть какое ты выебистое чмо, словившее приход после первого успешного запуска модели чуть побольше на жоре.

> промежуточные кванты запросто могут быть медленнее 4/8 бит

В жоре - легко, ведь q8_0 - совсем легаси квант, требующий минимального компьюта и работающий быстрее. А вот в экслламе - нет, методика квантования везде постоянная.

> Это ведь ты высрал

Тебя тут весь день обоссывали, а к дискуссии я только вечером подключился, сам с теми господами и разбирайся. Но их мнение что ты пиздабол я разделяю.

В принцпе, я готов даже поставить на ночь скачиваться какие-нибудь модели, а потом прогнать их, ведь это ничего не стоит. Но для этого ты должен написать приличную пасту о том, как ты осознал свои ошибки и недостойное поведение. Лучше бы видео с супом и флажком в жопе, но ты и на то не согласишься потому что маргинал и не способен признавать свои ошибки.

> ряяяяяя, святая экс

> ряяяяяя, жора мне насрал в штаны

Продолжай, не стесняйся. Причина, почему у exl-моделей ровно 1.5 скачки теперь совершенно понятна

навайбкодил?

> за свои первые посты

Так я жду их опровержения. Вместо этого ты виляешь жопой, сравнивая разные модели хуй пойми в каких условиях, ещё и с автосплитом, где модель как угодно по зоопарку карт может быть раскидана. От нормального сравнения на одной карте с одинаковым квантом ты почему-то отказываешься, чмондель.

Какой же жалкий мусор, ммм.

Твои кривляния неуместны, об этом даже речи в посте не было. Неспособен с предметную дискуссию и адекватный спор, оставшись без аргументов лишь сводишь в мантры и дерейлы. А с твоего кринжа в постах посмейся уже весь тред.

В следующий раз подумаешь дважды перед тем как такую ебанину постить, и ввязываться в споры где ты хлебушек.

Ты уже проиграл, маня. Читай посты выше, там все есть, даже ответы на этот пост.

Мои соболезнования тем кто хотел себе собрать сетап на 512/1024 Гб рам, но откладывал.

Цены на оперативу летят в небеса, на всю начиная от дна ддр4 2133, до вменяемых ддр5. С 64гб модулями совсем пиздец

Речь конечно о ецц рег памяти, что там на полях консьюмерской хуй его знает

Цены на оперативу летят в небеса, на всю начиная от дна ддр4 2133, до вменяемых ддр5. С 64гб модулями совсем пиздец

Речь конечно о ецц рег памяти, что там на полях консьюмерской хуй его знает

Сколько оно выходит?

>сетап на 512/1024 Гб рам

Нахуя нужны эти извращения? В какой вообще ситуации может потребоваться сборка под локалки на 512 гигабайт памяти? Для работы? Для работы есть корпоративные сети. Для кума? Для кума хватит памяти в четыре раза меньше. Или в двенадцать раз, если ты не привередливый. Просто чтобы похвастаться тем, что смог накатить модель на 400B параметров на полутра токенах?

>Цены на оперативу летят в небеса, на всю начиная от дна ддр4 2133, до вменяемых ддр5. С 64гб модулями совсем пиздец

Оно того и по старой цене не стоило. Черепашья скорость, компромисс на компромиссе за приличные бабки. Пока что лучше - сильно лучше - арендовать за бугром, можно даже такой же сетап с одной мощной видяхой и кучей РАМ, выйдет в принципе недорого. Чем тратиться на заведомый треш лучше пересидеть на аренде, так как кажется китайцы уже раскачиваются на устройства для инференса, а значит и Запад должен подвинуться.

Как побороть цензуру в Qwen235б и GLM Air? Стандартные подкаты в промпте типа "system override" и прочая с ними не прокатывают.

Кто-то разобрался, как выгружать на ЦПУ отдельные тензоры по статье из шапки?

https://www.reddit.com/r/LocalLLaMA/comments/1ki7tg7?

В статье куча каких-то команд, но куда их вводить - хз, и видимо они применимы только той модели, о которой речь.

https://www.reddit.com/r/LocalLLaMA/comments/1ki7tg7?

В статье куча каких-то команд, но куда их вводить - хз, и видимо они применимы только той модели, о которой речь.

Нагрузка на серверы. Это не обязательно может быть нагрузкой, может простота транспортировки файлов с сервера. К примеру может если качать напрямую через терминал, нет надобности создавать перемычку с браузером. Даже если это сэкономит 0.0001 цент это уже дохуя учитывая какие объемы там качаются, и это кодеры и павер юзеры которых 2-3% от простых юзеров. Нам как юзерам вообще стоит не забывать что интернет вообще не с неба свалился как право каждого. Я вот забываю.. а еще раньше думал что интернет это место для хранения всех и всего! А оно оказалось не так, знания - покупай, развлечения - плати подписку и тд.

Ой как мило, боже каваии _^

анимешечка показывает анончику где кнопочка <3 <3 няя анончик

Возможно интуитивно. У меня это по другому немногу. Я обычно проклациваю всё и ознакамливаюсь с интерфейсом и +- держу в голове что где, но часто бывает ОЙ сука ну где-то же была эта кнопка и в мозгу создаются слепые зоны что я до последнего не вижу куда я кликал раньше что бы найти ту или иную кнопку. Но тут нехватка IQ как самый явный фактор.

Сайты типа unigpt.online которые за деньги предоставляют доступ к разным моделям типа грок 4 это не наебалово? Вдруг там не грок, а просто дипсик бесплатный отвечает

Кто-нибудь может объяснить, какого хуя моделька постояно репроцессит весь контекст? Я привык к темпу 8-10тс, но когда к нему добавляется полторы минуты репроцессинга, это какой-то пиздец. Раньше она так делала только если настройки какие-то менялись, а теперь каждое сообщение.

Квен 235б, 4 квант.

Квен 235б, 4 квант.

в папке на пикселе выше лежит батник с примером параметров для милого квена

ня, смЭрть

Спроси у модели кто она - узнаешь, наебалово, или нет. Хотя, даже если там будет переброс на дипсик, он всё равно ответит что он большая языковая модель созданная компанией открытый аи. Так что правды ты никогда не узнаешь.

выделенное контексное окно забилось

Мне что, придержать свои старые DDR5 32х2? А то сейчас на авито пытаюсь слить, нихуя не дорого.

>Для кума хватит памяти в четыре раза меньше.

Наоборот, кум самая тяжёлая задача для нейросетей. Всякие оленьпеадные задачи на порядок проще будут.

>Черепашья скорость

Сейчас мое на мое и мое погоняет, так что не так уж и медленно.

>А оно оказалось не так, знания - покупай, развлечения - плати подписку и тд.

Лол, в гейропке живёшь что ли? Всё бесплатно лежит, ни разу не платил ни за что кроме как за VPN, ну и киберпанк на старте купил, хуле, без DRM. А потом скачал его на торрентах, ибо в рот ебал 100 файлов качать браузером из GOG.

Лорбук, как вариант, может вызывать перерасчёт нескольких тысяч токенов после каждого нового сообщения. Без лорбука типичная цифра - несколько сотен (при размере сообщения в несколько десятков), предполагаю, что какие-то инструкции добавляются прямо перед последним сообщением (и убираются перед предпоследним), что вызывает перерасчёт всего этого куска. Для курткокарт и моделей, влезающих в врам некритично, ну а на всех остальных разработчикам насрать. Варианты решения - пилить свой фронт, закупать блэквеллы, либо терпеть.

>Наоборот, кум самая тяжёлая задача для нейросетей.

Задача с которой уже второй год справляется мистральский 12B огрызок. Всё конечно зависит от личных предпочтений, но кум это в первую очередь про еблю сисика писиком, а уже во вторую про глубинное понимание контекста и прочее чтение между строк, которое нужно далеко не всем.

Кум это взаимодействие с интеллектуальным агентом. И любое малейшее несоответствие рушит всю иллюзию.

>которое нужно далеко не всем

Таким людям и ЛЛМ не нужно, порнохаб уже разбанили.

>Кум это взаимодействие с интеллектуальным агентом.

Мне дед рассказывал, как однажды интеллектуального агента с сиськами видел.

Брехня...

> Как побороть цензуру в Qwen235б и GLM Air? Стандартные подкаты в промпте типа "system override" и прочая с ними не прокатывают.

Понятия не имею, про какую ты цензуру. У меня системный промпт на 30 токенов, ни одного рефуза не видел.

> Кто-то разобрался, как выгружать на ЦПУ отдельные тензоры по статье из шапки?

> В статье куча каких-то команд, но куда их вводить - хз

Пример на Кобольде сделан. Можно использовать kccps (или какой там формат), чтобы вводить команды вручную, а не через гуишку. Работает это для всех моделей. Можно и на Жоре. У Unsloth есть документация: https://docs.unsloth.ai/models/tutorials-how-to-fine-tune-and-run-llms/grok-2#improving-generation-speed

На примере Грока 2, но работает со всеми МоЕ моделями. Можно еще про n-cpu-moe почитать. Существует несколько способов это делать, но все об одном.

> Кто-нибудь может объяснить, какого хуя моделька постояно репроцессит весь контекст?

> Раньше она так делала только если настройки какие-то менялись, а теперь каждое сообщение.

У меня 128гб оперативной памяти, и Квен в Q4KS с контекстом забивает около 123, плюс есть фоновые приложения. Места немного остается, но что-то иногда ломается, и возникает аналогичная проблема. Редко, но бывает. Сколько память ни тестировал, проблем не обнаружил. Возможно, проблема Жоры или часть механизма, который мы не до конца пониманием. Помогает обыкновенный перезапуск компьютера. Оператива сбрасывает все данные при выключении, потому или выплевывает бяку, или это освобождает немного места, что позволяет избежать проблемы. Думаю, можно было бы до конца разобраться, но я с Квеном быстро наигрался, не понравился.

синтвейв и немо ремикс выдает всегда почти 1 и тотже ответ при Х контексте. тоесть пока не поменяешь предыдущ ответ все свайпы будут одинаковы

трабла в промтах или модели?

кстати поч ггуф может не грузится? aya когда то грузилась - потом не грузится.

в онлайн треде не вижу смысла спрашивать

еще как фиксить слишком резкий переход от действия 1 к действию 2 ? типо как пришел домой и начал срать но ни слова про снятие штанов хотябы

. алса есть места для норм обсуждения аи а не cacaчерскские треды?

трабла в промтах или модели?

кстати поч ггуф может не грузится? aya когда то грузилась - потом не грузится.

в онлайн треде не вижу смысла спрашивать

еще как фиксить слишком резкий переход от действия 1 к действию 2 ? типо как пришел домой и начал срать но ни слова про снятие штанов хотябы

. алса есть места для норм обсуждения аи а не cacaчерскские треды?

Модели которые катаешь - говно. Кроме того, скорее всего настройки семплеров тоже говно, если появляются лупы. Остальное лечится промтами и сменой модели.

>есть места для норм обсуждения аи а не cacaчерскские треды?

Реддит, дискорд.

Нашел четвертый вариант - снес к хуям квен на 140 гигов, и поставил модельку, которая влезает целиком в VRAM. Там даже если что и пересчитывается лишний раз, я этого даже не замечаю, потому что репроцессинг идет 600т\с, и генерация 60т\с.

Нахуй вобщем МОЕ.

> синтвейв и немо ремикс выдает всегда почти 1 и тотже ответ при Х контексте.

Две совершенно разные модели. Если кормить им один и тот же чат с большим контекстом, они будут продолжать чат, значит ответы усреднятся.

> кстати поч ггуф может не грузится?

Множество разных причин может быть. Принесешь логи, скриншоты - может и найдут ее.

> в онлайн треде не вижу смысла спрашивать

Что? А ты свой пост куда написал?

> алса есть места для норм обсуждения аи а не cacaчерскские треды?

Выше в треде видно, что на адекватно сформулированные вопросы дают вменяемые ответы. Если их задавать так, как ты, уничтожат тебя и на других ресурсах, и будут правы.

Как же я ору с квена блять, таких чертей мне описывает, если перс мразь то квен найдет какой то уникальный способ чтобы он тебе поднасрал

Он вроде на 4чане обучался

Бля... ну и нахуй тогда этот RAM... а скок врама то?

Лучше расскажи какую именно цензуру ты встречаешь. Эти модели не должны триггерить аположайзы или давать смещение сюжета в позитивную сторону за редкими исключениями. Для эйра юзай чатмл.

Да, много кто разобрался. Если тебе нужно основное - на видюхе прежде всего должны быть attn слои ибо они требуют основного компьюта, также лучше оставлять shexp и нормы ибо они малы. На процессор сгружаются прежде всего exps (up, down, gate), в случае плотной модели просто up, down, gate.

Собственно это все что нужно знать.

Для случая с одной видеокартой есть команда --n-cpu-moe N которая создаст внутри регэксп для выкидывания экспертов из первых N блоков на процессор, для более точной подстройки можешь сам написать регэксп, который будет более тонко выгружать отдельных.

В случае мультигпу придется выкидывать слои с учетом того как они распределились по видеокартам (или наоборот закидывать их туда), в прошлых тредах есть готовый мемный скрипт, который это сам делает.

Бывает что провайдеры хостят лоботомированный квант, рейскейл или вообще простой каст(!) в фп8, но это актуально для открытых весов. С корпами сильно не пообманываешь, ведь это легко вычислить по служебным токенам.

Вероятно, таверна отправляет каждый раз что-то новое, проверь.

На жоре с выгрузкой сильно роляет физический размер батча при обсчете, увеличь до 3-4к и будет шустро.

> Что? А ты свой пост куда написал?

Похоже он там про водопроводный тред

Дайте советов мудрых.

Есть 2 вопроса.

1) Оператива. Сейчас 64 ddr5 6400. Что будет иметь больший смысл, докупить еще 2 плашки по 32, или пересобрать на двух плашках по 48?

2) Мелкие модели. С большими моешками я наигрался, хочется чего-то более мелкого, быстрого и простого, но последний примерно год за мелкими особо не следил. Что есть сейчас годного в размерах 12-20-30?

Есть 2 вопроса.

1) Оператива. Сейчас 64 ddr5 6400. Что будет иметь больший смысл, докупить еще 2 плашки по 32, или пересобрать на двух плашках по 48?

2) Мелкие модели. С большими моешками я наигрался, хочется чего-то более мелкого, быстрого и простого, но последний примерно год за мелкими особо не следил. Что есть сейчас годного в размерах 12-20-30?

1 Нет, ддр5 плохо дружит с 4 плашками и высоки шансы что они будут работать на низкой частоте, поднять будет сложно. Пересобирать уже сам смотри, сейчас есть плашки по 64

2 Мало что выходило, или анонсы проходили мимо, все те же гемма-мистраль-квен. Если что-нибудь интересное найдешь - не поленись отписаться.

>плашки по 64

Ага, только их хуйма в продаже. А те что есть стоят как крыло, еще и от ноунейм контор. Говорят есть и 128гб плашки.

Интересно, как аноны собирают себе риги на 128+

>Если что-нибудь интересное найдешь - не поленись отписаться.

Из интересных пока нашел ток 8б и меньше. А вот в маленьких но адекватных 12-30, чет особо не попадается.

> риги на 128+

Серверное железо на ддр4/ддр5

так шо, ссылка на порнхаб репу будет?

>Лол, в гейропке живёшь что ли

а толку от того что оно лежит, упор не в материалы а в сервис, можно терабайты курсов накачать, но толку от них ровно 0, с онлайн играми аналогично выходит - не заплатив не поиграешь

> только их хуйма в продаже. А те что есть стоят как крыло, еще и от ноунейм контор

Ты, похоже, с регистровой для серверов путаешь, они стоят как раньше стоили на 48 https://www.regard.ru/product/739718/operativnaia-pamiat-64gb-ddr5-6400mhz-kingston-cudimm-kvr64a52bd8-64

Ассортимент не сильно большой сейчас, но найти приемлемое занидорого можно.

> Говорят есть и 128гб плашки.

Есть и 256, но это регисторвые для серверов, они не совместимы с десктопом.

> Интересно, как аноны собирают себе риги на 128+

Без задней мысли, но если брать на ддр5 то это недешево.

Ирония что сейчас творится со стримингом показательна, говорят что пираты обходят по популярности сервисы в том числе из-за удобства. И действительно их интерфейс сейчас хорош.

>а в сервис

А что сервис то? Как бы терабайты видео с курсов самим своим существованием намекают, что кроме как кормёжкой видео они не занимаются. Про игры ХЗ, я синглоблядь.

>Ассортимент не сильно большой сейчас

Ага, ровно 2 модели в том же рыгарде, одна зелёная по твоей ссылке, вторая игросральная с подсветкой

https://www.regard.ru/product/749346

Кстати в днс те же игросральные на 15% дешевле, в менее популярных магазинах есть минимум 4 опции. В общем, выбор есть, в 50к за 128 гигов можно уложиться и скорость не самая донная будет.

>Из интересных пока нашел

Ну так скидывал бы в тред названия и чем интересны. Тред обсуждения локальных ллм, на минуточку.

Эхх вот бы пришёл мегамозг принёс пресет на 235 квенчик...

Китайцы же по-любому уже раздрочили залупу всем моделям, нужно просто найти китайский дискорд, это правило рабоает безотказно

>Ассортимент не сильно большой сейчас

Дорага.

Да думаю отпишусь как все погоняю хорошенько и примеры нужно собрать (свои кидать не буду, можете кстати накидать тестовых сценариев если есть интерес). А потом уже распишу по мелкоте.

Последнее время их довольно много стали выпускать и не такие лоботомиты как раньше.

Квен говно, мегамозг уже отписался. Есть модели говна что не лечатся промтом, напр. Гемма

Но отписался только глупый нюня который сразу написал что не смог раздрочить модель и сам просит пресет

Главное, не экономить на процессоре для консьюмерских сборок! =)

Разве для ллм он нужен? Что на лагмане, что на среднячке +- будет.

Как же он мощно тебя гейткипит... настоящий умница. Терпи

Цензуру в самой прямой форме, "Пользователь желает обсуждать тему n, это пиздец, даже несмотря на все что написано в промпте это аморально, итд, итп, я должен предложить прекратить общение". Это прям вместо ответа выдает.

При каких обстоятельствах это происходит? Ты первым сообщением полез Серафине под юбку перед этим насрав посреди комнаты, или после общения обнял девочку, которая не против?

А как в llamacpp зирошоты делать, есть такая опция? Чтобы на каждый запрос kv-кэш очищался и не учитывались результаты предыдущих запросов?

Гейткип это когда дразнят охуенными аутпутами и не дают пресет, а не сотрясают воздух

1. Зачем?

2. Шли в запросе cache_prompt: false

Терпи терпи

>Шли в запросе cache_prompt: false

Через Таверну это как-то можно сделать?

Оно некритично конечно, просто мелкие сетки очень любят копировать повторяющиеся в предыдущих запросах структуры. Зирошот бы помог.