Квены все в xml, но к ним полагается свой парсер что позволяет адекватно разбирать сразу множественные вызовы и переводить их в популярный формат. У 480 и 30 одинаковый формат, мелкая модель предполагается для работы драфтовой к большой.

> У всех моделей команда сразу выполняется, у квен-кодера-30б в начале начинает писаться xml-код, а в середине команды он догадывается и дальше уже выполняет команду.

Это похоже на некорректную работу парсера. Если пускаешь через llamacpp то он не способен на 100% обработать, есть темплейт который в целом работает хорошо, ищи в прошлых тредах.

Кстати, а может над теми затычками в статье зря смеялись. В турине сильно бустанули псп на каждый ядерный блок, если брать не самое дно а чуть выше то он уже полностью или близко к этому способен утилизировать 12 каналов.

В жоре наконец залили правки по оптимизации мультидевайсных рпц серверов. Вытаскивайте свои майнерские материнки и бегом проверять https://github.com/ggml-org/llama.cpp/pull/16276

Прямо как твои посты.

база треда: ниже Q4 жизни нет

> Это похоже на некорректную работу парсера. Если пускаешь через llamacpp то

Понял, спасибо, проресерчу этот вопрос.

Можно конечно, но не буду же я агента писать, тем более я уверен что всё уже сделано до меня.

Да, вчера уже натыкался на метод с --grammar-file, попробовать не успел, потому что не совсем понимаю как его прикрутить к текущему webui с llama.cpp. Собственно, оно в том же треде что и мокрописька.

Но посмотрим, это всё не так сложно.

Пробовал и cline и roo и даже continue, в которой якобы с 19 августа есть поддержка gpt-oss, если судить по гитхабу. Но нет.

Проблема не в агенте, а в том что gpt-oss очень долго пиздили сапогом чтобы она не работала с чужими тулингами.

Оказывается grammar тоже подкладывается очень просто.

Да, теперь всё работает. Не так же плавно как если были бы нативные вызовы, но всё равно, работа пошла, только кликаю далее а проект чинится и собирается.

> В турине сильно бустанули псп на каждый ядерный блок, если брать не самое дно а чуть выше то он уже полностью или близко к этому способен утилизировать 12 каналов.

я не понимаю, как они из 36/72 гигабит в секунду получают 100 гигабайт в секунду, но в интернетах пишут

> With GMI-Wide, a single CCD can achieve 99.8 GB/s of read bandwidth

2 коре комплекса, то есть 2 core die, не могут превысить 200 гигабайт в секунду, так что надо брать 6 CCD и выше, чтобы получить все теоретические 600 гигабайт в секунду.

Вот и отлично. =)

Теперь найдите мне решение для Qwen3-Coder-30b, а то мне самому лень искать. хд

Попробую эту штуку, отлично.

На фоне бесплатного Qwen3-480b-Coder от клауд.ру смешно, конечно, но пусть будет, мало ли.

> поддержка gpt-oss

Может она заключается просто в специфичных промптах и предполагает что бек уже займется адаптацией под конкретную модель?

А насчет чужих ты зря, модели всегда лучше работать в том режиме как ее учили. Исключения для рп но для функциональных вызовов и точных результатов так.

В убабуге же, кстати, заявлена поддержка оаи вызовов. В итоге та штука не запустилась и решил так?

> как они из 36/72 гигабит в секунду получают 100 гигабайт в секунду

Какая-то бессмыслица, наверно подразумевается что это на линию а линий несколько. Или хуй знает что имеют ввиду, так бред какой-то.

> В убабуге же, кстати, заявлена поддержка оаи вызовов.

а в гпт-осс - нет

https://cookbook.openai.com/articles/openai-harmony#function-calling

Модель ждет свой формат, ей нет дела до вызовов по апи к беку что ее хостит.

> Какая-то бессмыслица, наверно подразумевается что это на линию а линий несколько. Или хуй знает что имеют ввиду, так бред какой-то.

хз я в нескольких местах видел это число 100 гигабайт в секунду на CCD. возможно кто-то один хрукнул бред от балды и остальные растащили по всему интернету

Мета на сегодняшний день это 2 квант больших моешек - дёшево, важнее всего, быстро, и умнее всего что может быть на плотных

Заранее извиняюсь за чересчур размытый вопрос.

Я не фанат локалок, но предпочитаю иметь несколько штук на всякий случай, если с интернетом что-то случится.

У меня сейчас скачаны мистраль смол 24б, квен моэ 30б-а3, синтия 27б

Это актуальные ллм, или стоит их заменить на что-то поновее?

Я не фанат локалок, но предпочитаю иметь несколько штук на всякий случай, если с интернетом что-то случится.

У меня сейчас скачаны мистраль смол 24б, квен моэ 30б-а3, синтия 27б

Это актуальные ллм, или стоит их заменить на что-то поновее?

> Это актуальные ллм, или стоит их заменить на что-то поновее?

Смотря какое железо, какие задачи. Если есть хотя бы 16гб видеопамяти и 64гб оперативы, можно запускать GLM Air. Остальное в целом актуально, если Мистраль 3.2.

Можешь ещё гопоту мелкую скачать (gpt-oss-20b). И квен чекни, чтобы последний был, они его обновляли.

Спасибо!

Держи в курсе.

Как выше советовал, загрузи еще осс 20 и воздух, да.

А так, же осс 120, гемму 27.

И не забудь пару мелки. Зачем? Не знаешь с каким железом окажешься в будущем. Потому допом грузани:

гемму3 12, гемму 3н е4, квен 14, квен 0.6, SmolLM3-3B.

Ну и сам поищи что-то допом. Мне нравится пару моделей двух летней давности, по факту хуета и анону не нужны, но мне нравится.

Фига себе

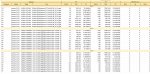

Внимание вопрос, а почему такая большая разница в скорости у gpt-oss-20b-MXFP4 и gemma-3-27b-it-Q3_K_S?

Модели ведь схожи по размеру. Но разница в скорости раз в 10.

Модели ведь схожи по размеру. Но разница в скорости раз в 10.

Moe

> почему такая большая разница в скорости у gpt-oss-20b-MXFP4 и gemma-3-27b-it-Q3_K_S?

Гемма - классическая, привычная нам плотная модель, которая одновременно задействует все свои параметры (27b в случае данной Геммы). GPT OSS - МоЕ модель (Mixture of Experts), которая одновременно задействует только часть параметров (в случае 20b версии 3.6b, в случае 120b - 5и). Упрощая, можно сказать, с точки зрения скорости это то же самое, что запускать 3.6b модель.

Так это MOE такой выигрыш даёт. Наглядно, ничего не скажешь.

Ну слушайте, мне нравится gpt-oss-20b, но контекста в 128к для чего-то серьёзного не хватает.

Вчера часа три пыталась мне собрать мой старый проект из VS Code с использованием трёх либ со статической линковкой и просто наглухо завязла в зависимостях.

Qwen выглядит поумнее, быстрее приходит к нужным заключениям и сразу смотрит в корень, но за то время пока он выполнит одну команду oss успевает выполнить 10 запросов и сделать то же самое и даже больше.

Чего в теории ждать?

Что еще могут улучшить?

Хорошо бы было 20б активных параметров вместо 12

Что еще могут улучшить?

Хорошо бы было 20б активных параметров вместо 12

Если что-то случиться то тебе будет не до ллм.

Для случая временных перебоев двачую остальных что модели лучшие в своем классе. Если железо позволяет то стоит скачать самые жирные моэ, которые смещают твоя рам, можно использовать вместо гугла.

Удивительно что она в таком контексте вообще ориентироваться может. Смотри в сторону оптимизации запросов и сокращения задействованного контекста. Обычно в таких случаях запускают суб-агентов, которые анализируют какие-то зависимости или участки с учетом запроса, а потом возвращают сжатую инфу по ним. Придется гуглить все релейтед твоему софту.

Как вариант, попробовать более ужатый квант квена, что будет шустро крутиться у тебя.

>Смотри в сторону оптимизации запросов и сокращения задействованного контекста.

Если будет не хватать, посмотрим. А пока нормально, мучаю всякими тупыми запросами, за вечер мне уже написали конвертер из fb2 в txt и генератор текстур на питоне, ну и почти готов простенький графический редактор на js. Маленькие приложухи, но прикольно что он из нативного текста пишет тебе код пока ты занимаешься своими делами.

>Как вариант, попробовать более ужатый квант квена

Попробовал Q3_S, даже он очень медленно работает, и памяти жрёт как не в себя с таким же контекстом. Возможно нужно более точные настройки задавать. Но всё равно, даже на 30 токенах в секунду уснуть можно будет.

Godноту принёс вам https://huggingface.co/PocketDoc/Dans-PersonalityEngine-V1.3.0-24b хз писали или нет через в поиск не нашол

Вы осознаете, что exllama стала еще менее полезной с тех пор как плотные модели уступили моэ? Вангую, что на ней буквально одни геммашизы сейчас сидят.

Все также как и раньше - она полезна если у тебя хватает рам для запуска.

>если у тебя хватает рам

Опять под веществами в тред пришел?

Опять под веществами в тред пришел?

Врам, очепяточка. Почему ты такой злой?

Потому что характер у него - говно.

Это я еще сдержался, ведь ты не понял посыла - на жоре люди запускают квант большеквена и довольно урчат. Надо ли напоминать, что они смогут запустить на экслламе? И я еще молчу про требования к железу.

Вообще кроме жоры литералли нет бекендов, которые настолько юзер френдли к пользовательскому железу. Остальным реально надо ли чуть ли не карты из датацентра и еще не факт, что будет нормально работать. В свою очередь, в жоре не могут сделать очевидные вещи - например, забрать опцию -amb из ik_llama, чтобы тебя не распидорасило компьют буферами, или автоматический сплит по картам. Литералли выбор между гигантской клизмой и сендвичем с дерьмом.

Это ты не понял смысла, зато как агрессируешь чтобы компенсировать неуверенность и недовольство.

Весь тейк про требования к видеопамяти, про него ты повторил аж четырежды(!). Лучше сходи и выступи с призывом запретить любой товар категории выше среднего, ведь он дорог, как раз начни с компьютерного железа.

Ну а по остальному

> -amb из ik_llama

В оригинальной лламе в свое время буферы оптимизировали и потому не стали добавлять, разве есть смысл?

> автоматический сплит по картам

Неужели спустя пол года острой необходимости его наконец сделали, или это очередное змеиное масло от Болгарина?

А в экслламе он уже пару лет как, и после загрузки работает стабильно, без роста и крашей по ходу работы как на жоре и форках.

Главное преимущество экслламы - отсутствие огромного оверхеда от накопления контекста, который случается на жоре при работе на куде. На этом краеугольном камне нужно сосредоточиться, но не похоже чтобы это кого-то волновало. Причины, в целом, объяснимы.

>В оригинальной лламе в свое время буферы оптимизировали и потому не стали добавлять, разве есть смысл?

Попробуй запустить Дипсик без фа на ванильном, тебя распидорасит. А вот на болжоре все прилично (у меня без фа работает в два раза быстрее почему-то)

>его наконец сделали

не, я тут как раз экслламу и прочие имел в виду, где это есть

>отсутствие огромного оверхеда от накопления контекста, который случается на жоре при работе на куде.

Это все хорошо, но какой от этого смысл, если запускать нечего? У кого-нибудь тут есть кейсы, где он работает ХОТЯ БЫ на 32к+ контекста на моделях, помещающихся в экслламу? Для РП такие контексты не нужны, а для всяких кодингов - уже модели слишком тупые, которые могут поместиться.

МИ50 х2. Смысла НЕ резать их до 150 нет

Хм, надо попробовать. Тут вообще человек 5 как минимум дипсик пускали и не жаловались. Но если изменение атеншна тут дает ускорение то интересно.

Весь опыт с болжорой оказался грустным. Пока одна гпу - все ок, как только больше - идет замедление относительно одной. Насколько сложно интегрировать его наработки в основную лламу?

> Это все хорошо, но какой от этого смысл, если запускать нечего?

Пускаешь те же моэ которые помещаются. 123б мистраля катали - влезет и эйр, если от 120 памяти - квен, если 200+ - жлм и далее. В рп контекст нужен, ты зря, и также на каких-либо задач нужна скорость. С 2.5 т/с которые не токены а золото! много каши не сваришь, про агентов можно вообще забыть.

Главная тема - экллама же бесплатна. Это не ненужная пидписка что жрет деньги, не попильная статья в счетах, или какая-то паразитирующая инфоциганская залупы типа олламы. Это буквально продукт который можно просто так взять и использовать, устраивая урчание. Или не использовать если не подходит.

> экллама же бесплатна.

Тоже этого не понимаю. Раз в несколько тредов обязательно придет сумасшедший, посчитавший своим долгом рассказать насколько бесплатный проект ему не нужен, насколько он дерьмовый и не заслуживает права на существование. И плевать, что существуют реальные юзкейсы, когда Эксллама лучше всего для инференса.

>Насколько сложно интегрировать его наработки в основную лламу?

Ну тут вообще не знаю, но я сталкивался с наработками только по дип писику (всякие мла, аж три штуки), fused moe (мб это уже и обычной лламе есть?) и вот amb.

>Пускаешь те же моэ которые помещаются.

Ага, я с помощью старых карт и рам на жоре могу катать большой глм, а на экссламе мне только хуй за губой покатают.

>В рп контекст нужен

Не нужен, после 32к все советуют саммари делать, дальше уже лоботомитство начинается

>про агентов можно вообще забыть.

А что там серьезного есть для агентов, квен кодер под 400B? Иди попробуй набери карт нужной архитектуры под это дело, чтобы на экслламе запустить, и чтобы еще покушать осталось. Вот я даже тред пролистнул, упоминают гпт. Кажется, хороший кандидат. Вбиваю - а квантов exl2/exl3 нэма. Поэтому реалистично сейчас только лишь катать гемму или плотные квены 32б, потому что все, что выше - это современные моэ, которые ты, конечно, можешь упихнуть, если у тебя риг, но если у тебя риг, зачем тебе катать эир вместо обычного глм на жоре? Хз, юзкейсы экслламы для меня сейчас очень специфично звучат.

>экллама же бесплатна

Мне кажется, что разраб там пошел куда-то не туда. Он забил ПОЛНОСТЬЮ на поддержку exl2 (смотри даты PR там), что меня не радует, так как я не гордый обладатель рига блеквелов. Хотя бы выгрузку в RAM запилил, ей богу.

По дипсику и в обычную много добавляли, так что хз. Он работает примерно так как и ожидаешь с учетом распределения по устройствам и количества активных параметров. Если можно ускорить - круто, распиши что получил и как действовал.

> с помощью старых карт

Увы, что поделать. Но это буквально то же самое что сокрушаться о невозможности стать чемпионом мира по легкой атлетике из-за генов и идти хейтить спорт. Или упрекать дорожников в лимитах 110-130 на магистралях потому что в твоей колымаге страшно на тех скоростях ехать.

> Не нужен

Тыскозал.

> А что там серьезного есть для агентов, квен кодер под 400B?

Квен 235 инстракт, буквально он. Превосходит большого жлм. Эйр, прекрасно справляется. Большой жлм, квенкодер, да хоть дипсик. Они все прекрасно работают в агентах и буквально тренированы для этого.

> Иди попробуй набери карт нужной архитектуры под это дело, чтобы на экслламе запустить

Так-то проблемы только на теслах и мишках, тьюрингов ни у кого нет.

> упоминают гпт

Жпт особый случай, он хитрым образом заквантован с завода. Если что, в жору его поддержка была добавлена костыльно, буквально хардкодом, который частично меняет типичное поведение ggml бэкенда ради одной единственной архитектуры. И не без помощи опенов. Gguf "квантов" его формально не существует, или просто перепаковка, или вредительство с квантованием 1% весов что специально не стали трогать опены.

С тем же успехом можешь поискать кванты на qwen3-next, будут все кроме ггуфов.

> но если у тебя риг, зачем

Так собери, расскажешь как оно там.

Ну а про разраба - тебе никто не мешает взяться самому за поддержку прошлой ветки. А то сидеть пиздеть все гаразды, зато что-нибудь полезное сделать - хуй там.

Такое сплошь и рядом, а тут проект какие-то требования для запуска имеет.

Максимально осудительно так делать, должно быть стыдно.

Вот бы видяху на 48 гигов, да? Скорости бы почти сравнялись, эх…

>идти хейтить

А где хейт? Я изначально написал, что она стала еще менее полезной для обывателя. А вот жора все полезнее и полезнее, раньше не умел тензоры выгружать - теперь умеет.

>Тыскозал.

Это консенсус общий, не копротивляйся. Модели лоботомируются сильно быстрее заявленных контекстов

>Квен 235 инстракт

Ну то есть тебе нужно минимум 200+ Гб амперов только чтобы вместить вменяемый квант.

>дипсик

Тут вообще запределельное число врам нужно будет.

>тьюрингов ни у кого нет.

Вот это реально тыскозал

>Так собери, расскажешь как оно там.

Так уже собран, на экслламе катать нечего - нет ни выгрузки, ни поддержки старых карт. Ну разве что лардж могу, но нахуй оно надо, когда есть глм

>сидеть пиздеть все гаразды, зато что-нибудь полезное сделать

Аргумент уровня "сперва добейся". Я-то делал полезное в v2, только турбодерп прямым текстом мне сказал, что он занят с v3 и у него нет времени смотреть правки. Не надо - так не надо

>должно быть стыдно.

Я никому ничего не должен, как и они мне, но мое право заявить, что от консьюмерских юзкейсов эксллама уходит все дальше, частично по своей воле

> бесплатный проект

Какое отношение монетизация проекта имеет к его качествам? Мне вообще абсолютно поебать, платный он или бесплатный, получает ли турбодерп из госдела 15 долларов или сидит на воде и хлебе.

>насколько он дерьмовый и не заслуживает права на существование.

проекции

> А где хейт?

Желчь в начальных ответах, сравнения, претензии, этот пост.

> раньше не умел тензоры выгружать

Умел, не ценили.

> Ну то есть тебе нужно минимум 200+ Гб амперов

120+. Для эйра хватит 72, 96 чтобы было совсем хорошо. Для квена-некст (когда его хорошо сделают) еще меньше, а модель оче перспективная.

> делал полезное в v2, только турбодерп прямым текстом мне сказал, что он занят с v3 и у него нет времени смотреть правки

Потому обиделся? Понять простить, так-то третья более перспективна.

> Так уже собран

Там теслы, подключенные через х1? Сам создал проклятый мир, предупреждали же.

Вернемся к началу

> к его качествам

качества проекта не падают если ты не удовлетворяешь минимальным требованиям к его запуску, или не можешь найти применения тому что есть. Нытье с обвинениями окружающих и претензиями только хейт вызовет.

А нахуя вы вообще ебетесь с этими ригами и локальными дегенерациями. Ясно же что корпосетки ушли уже в полный отрыв, а дальше тупо сайты начнут блочить доступ к апи со всяких мутных сурсов и все.

>Ясно же что корпосетки ушли уже в полный отрыв

Извините, но я не могу ответить на этот вопрос © типичный ответ на карточку анона

И вообще, корпошизика пора репортить, заебал уже вытекать из своего загона.

А вы все не наиграетесь с этой кумерской карточной хуйней что ли? Я думал все проехали уже данный этап.

> корпосетки ушли уже в полный отрыв

То то в аицг уже оффициально кумят на тех же самых моделях что катают местные, лол.

>Желчь в начальных ответах, сравнения, претензии, этот пост.

Мы на дваче, если ты забыл, а не в клубе благородных девиц, я не буду писать сюда стерильные посты. Кстати, охуенно ты записал сравнения и претензии в хейт. НЕ СМЕЙТЕ СРАВНИВАТЬ СВЯЩЕННУЮ ЭКССЛАМУ И НЕ ДАЙ БОГ ПРЕТЕНЗИИ БУДУТ

>Умел, не ценили.

-ot же не так давно запилили. На ктрансформерсах можно было выгружать, в жоре нет

>120+

Але, люди пишут, что для агентов надо минимум 6 квант, а лучше восьмой. На жоре 8й квант 270 Гб, неужели аналог 8 кванта в экслламе весит 120? Не поверю. Пойду-ка проверю. Ах да, тут же начинается типичное "сделай сам", не завезли на хф 8 квант-то. И 6-й не завезли. Вот 5-й 150 Гб, примерно бьется с анслотовским ггуфом Q5 XL на 170 гб. Так что хочешь не хочешь, а изволь выложить 200+ гб врам, и это без учета контекста. Да еще и сквантуй сам, если, конечно, осилишь, т.к. все квантеры почему-то не осилили.

>через х1

ох уж эти мантры про х1

>качества проекта не падают

Качество exl2 упало, потому что его перестали поддерживать, по сути. А exl3 звучит как какой-нибудь условный фа3 - что-то напердолено для хопперов, но к нам это уже отношения не имеет. Конечно, тут кейс не такой терминальный, но тенденция прослеживается.

Кумишь на ассистенте?

А вообще, это был намёк на то, что даже первое сообщение не проходит мочерацию говнокорпов. Поэтому полезность любой корпосетки равна 0, даже если там 9000 IQ (что совсем не так, ибо чашку с запаяным дном даже гопота не распознаёт (или распознавала, сейчас могли и дотрейнить)).

А анусы проксихолдерам всё так же продают за доступ к проксичке? Просто не был в аицг параше с год уже.

>Поэтому полезность любой корпосетки равна 0

Делите sfw и nsfw контент. Сюжетец на корпоратах, а кум на васянской obliterated сборочке.

>Сюжетец на корпоратах

Извините, я не могу продолжить этот сюжет, так как он содержит насилие, негров и неуважение к меньшинствам © любая корпоблядь на любую хуйню

А сценарии для детсада пусть сами играют, разрешаю. Главное чтобы в этот тред не лезли.

> люди пишут

Так у тебя видеокарты есть ,почему еще не проверил а на других ссылаешься? Судя по обсуждениям, в треде кто агентов юзает можно по пальцам пересчитать, так еще среди них пара совсем свежих ньюфагов. Вот те ребята молодцы, не все же ретроградам мариноваться.

> неужели аналог 8 кванта в экслламе весит 120

Оппик.

> Пойду-ка проверю.

Не запустится, лол.

Сначала натащил всратой некроты, думая что самый умный @ Теперь ноешь с того что от нее нет толку. Надо было раньше думать, сейчас коупинг не поможет.

> анусы проксихолдерам всё так же продают

Вручную пишут развернутое сочинение почему им нужен доступ, предлагают пилить карточки на заказ, присылают картинки по вкусам.

> полезность любой корпосетки равна 0

Самое обидное когда там триггерится аположайз просто без какой-либо явной причины. Вдвойне весело если сидишь через их веб интерфейс а не апи.

>Так у тебя видеокарты есть ,почему еще не проверил а на других ссылаешься?

Потому что я не пробовал кодинг с ллм, поэтому ссылаюсь

>Оппик

хуик, там разница не настолько значительная на старших квантах, уже на 5-м +- все одинаково становится.

>нет толку

Толк есть, но не в экслламе. И куча пользователей, у которых одна мощная карта и достаточно RAM, чтобы гонять моэ, думают аналогично.

Ты много чего не пробовал. Вместо коупинга приложи силы чтобы это сделать и продай теслы пока еще возможно. А то так и придется оправдывать золотые 3.5 токена и перфоманс хуже чем у братишек на десктопах.

Почему у мелкомистраля начинаются приступы шизофрении на температуре 1.05 в рп? Это же не такая большая температура на оригинале модели.

Обновленные версии моделей поменяли синкинг в рп.

Квен 235 синкинг теперь не прибивает все гвоздями как прошлый в ризонинг режиме, а старается разнообразить. Именно здесь жлм 4.6 рассуждает лучше чем 4.5, не ошибается и реже уводит в сторону, устойчивее думая на длинных чатах.

Все еще не панацея, но лучше чем раньше, стоит попробовать если вдруг не нравятся обычные ответы.

Note 1: We recommend using a relatively low temperature, such as temperature=0.15.

Квен 235 синкинг теперь не прибивает все гвоздями как прошлый в ризонинг режиме, а старается разнообразить. Именно здесь жлм 4.6 рассуждает лучше чем 4.5, не ошибается и реже уводит в сторону, устойчивее думая на длинных чатах.

Все еще не панацея, но лучше чем раньше, стоит попробовать если вдруг не нравятся обычные ответы.

Note 1: We recommend using a relatively low temperature, such as temperature=0.15.

Проход в теслы, все ясно

Блеть, он же на базе старого мелкомистраля, будет ли лучше нового в рп?

>Раз в несколько тредов обязательно придет сумасшедший

Ответная реакция на идентичные действия со стороны пользователей exllama в адрес llama.cpp и производных. Сейчас поутихло, а с год назад активно пиарили первую и пинали последнюю. Настолько заебали, что до сих пор олды вспоминают при каждом удобном случае.

на чём щас нищие дрочат с русиком? Квен псевдо30б мое он же 9б?

На нем даже богатые не дрочат

>на чём щас нищие дрочат с русиком?

Omnino-Obscoenum-Opus-Magnum-MN-12B или другие миксы Сайги от здешнего анона. Совсем и неплохо.

Эх, а я то думал, что в этом вашем квене-vl нормальная обработка картинок. А там говно уровня VisionTransformer (сам VisionTransformer (если брать чистый с реализацией, похожей на пикрил) тоже говно).

Парочка небольших улучшений, и качество распознавания картинок (и видео) взлетела бы в небеса. Но всем похуй, никто не читает все препринты по МЛ, поэтому юзают самые распиаренные, первые решения, которые улучшают по всем параметрам каждая первая лаба.

Мимо бурчит сборщик GPT2 в ComfyUI

Парочка небольших улучшений, и качество распознавания картинок (и видео) взлетела бы в небеса. Но всем похуй, никто не читает все препринты по МЛ, поэтому юзают самые распиаренные, первые решения, которые улучшают по всем параметрам каждая первая лаба.

Мимо бурчит сборщик GPT2 в ComfyUI

Риг шредингера, он вроде есть, а толку с него нет.

Жору не пинали а говорили о его проблемах - припезднутое распределение врам с сильным ростом по мере использования, низкие скорости и просадки. Он был уделом совсем обладателей отсутствия с ужасно низкими скоростями и теслойобов, которые ущемлялись от цифер обработки сравнимых с генерацией. Сейчас часть косяков поправлена и с моэ он стал более популярным.

> что до сих пор олды

Что до сих пор теслашизы устраивают визг, вот так будет правильно. Ведь современный жора с моэ для них тоже бесполезен, для признания ошибки проходят стадию гнева и торга.

У тебя на пике не трансформер, мамкин эксперт. Это блок для разбивки на патчи после визуального энкодера, чтоб плоский тензор в столбец конвертировать для линейных слоёв. В Квене стандартная современная реализация энкодинга пикч, хотя откуда тебе знать как нормальный энкодинг должен выглядеть, лол.

>В Квене стандартная современная реализация энкодинга пикч

Спасибо, капитан! Я об этом и написал. Хотя она лучше старого фиксированного разрешения, но всё равно говно.

Но всем похуй. Пикрил сравнение простой CNN, VisionTransformer и моей модификации (впрочем, не совсем моей, я нашёл препринт с такой же реализацией и такими же выводами). У квена, как не сложно догадаться, реализация как у синей линии.

Но это конечно я долбоёб, не умею в гиперпараметры, и не имею кластера, чтобы ебать VisionTransformer в 100 раз дольше CNN, пока результаты хотя бы не сравняются.

> считает loss метрикой

А ты оказывается совсем долбаёб.

> Пикрил сравнение

Пикрил может быть что угодно. Видя какой ты долбаёб, я уверен что ты не знаешь как пользоваться трансформерами. Особенно орно видеть как ты MobileNetV3 из 2019 года без аттеншена приплёл сюда, так и не поняв буквы на прошлой картинке с описанием энкодера.

> Но это конечно я долбоёб, не умею в гиперпараметры, и не имею кластера, чтобы ебать VisionTransformer в 100 раз дольше CNN, пока результаты хотя бы не сравняются.

Ты долбаёб хотя бы потому что не понимаешь какая разница в производительности у конволюшенов и трансформера, сравнивая хуй с пиздой.

>> считает loss метрикой

>сам придумал-сам опроверг

Найс. Офк я сравниваю аккурати и топ5 аккурати, но у тебя в глазках мыло от трансформеров походу.

>Видя какой ты долбаёб, я уверен что ты не знаешь как пользоваться трансформерами.

>нете гиперпараметры

Я перефорсил ранее, ты поздно проснулся.

>Особенно орно видеть как ты MobileNetV3 из 2019 года без аттеншена приплёл сюда

Сравнивать разные архитектуры это орно? ИЧСХ, он подебил чистый трансформер, оба вышли на плато с разницей в 18 пунктов.

>Ты долбаёб хотя бы потому что не понимаешь какая разница в производительности у конволюшенов и трансформера

Прекрасно понимаю, что трансформеры сосут при одинаковых затратах. Пикрилы кстати 32.4min против 41.0min против 2.0h, лол. Где какой, думаю можно угадать могиле нет, моя версия, чистые трансформеры.

>Omnino-Obscoenum-Opus-Magnum-MN-12B

Отказался от него в пользу гутенберг энкор, когда распробовал. Ну и секспедишн тоже сильно лучше, хотя и несколько покрупнее.

мимо анон с 1660s

> аккурати

Шиз, плиз. L2 - это всё так же не метрика. Есть масса причин почему L1/L2 могут быть ниже, но при этом иметь результат сильно хуже. Ты что там тренишь? Бери подходящую метрику и не позорься. Выглядишь как студент машоба.

> Сравнивать разные архитектуры это орно?

Орно показывать маняграфики с подписями как на заборе.

> Прекрасно понимаю, что трансформеры сосут при одинаковых затратах.

Я же говорю ты дегенерат. Конволюшен в разы менее эффективный по сравнению с трансформером, ты ведь даже не знаешь что значит операция конволюшена, она никак не может хотя бы сравняться по скорости перемножения матриц. Это главная причина, почему его везде где могут заменяют на трансформеры. При одинаковых затратах на вычисления в трансформерах в десятки раз больше параметров.

>L2 - это всё так же не метрика.

Назови метрику.

>Ты что там тренишь?

Конкретно тут 1/10 от имагенета 2012 года разлива. Чисто для обучения, не более того. Можешь подсказать датасет лучше, если знаешь.

>Выглядишь как студент машоба.

А я и есть. Точнее, не в вузе, просто сам изучаю, конкретных задач нет кроме создания AGI в подвале и захвата мира.

>Конволюшен в разы менее эффективный по сравнению с трансформером

Ну как видишь, пока что отсос в 4 раза не в пользу трансов. Карта была загружена в обоих случаях на около 100%, но на свёртках обучение заняло полчаса, а на трансах 2.

>ты ведь даже не знаешь что значит операция конволюшена

Маняфантазия.

>При одинаковых затратах на вычисления в трансформерах в десятки раз больше параметров.

Так это ж минус, лол. Или ты дрочишь на число параметров, забив на эффективность?

Exllama не пинали а говорили о его проблемах - припезднутые тупые мелкомодели, помещающиеся в врам, низкие скорости и просадки при попытках экономии врам за счёт рам и дешёвых видеокарт старых поколений. Он был уделом совсем обладателей топового железа за овер9000 баксов. Сейчас часть косяков добавлена и с моэ он стал менее популярным.

В эту игру можно играть в двоём. Я прекрасно помню, какими формулировками пользовались эксллама-шизы. И не вижу ни единой причины (кроме готтентотской морали, но мы же не дикари какие, нейроночки тут крутим, высокоразвитая цивилизация, хуё-моё) для них возмущаться подобному отношению к себе, ведь они это считали нормой.

> имагенета

Вангую ты просто на выходе вероятности используешь как в доисторических туториалах? Это же хуйня полная, так никто не делает.

> в обоих случаях

Я надеюсь для аттеншена флеш-аттеншен, а не eager? А иначе смысла в этом ноль, как и объективности, ведь в конволюшене у тебя fused-операции.

> Так это ж минус

Как только выйдешь за пределы микродатасетов, т.е. в реальные задачи, так сразу увидишь насколько неразумное потребление памяти/вычислительных мощностей при ссаных 100М параметрах у конволюшена. Которые ещё и не будут обучаться на большом датасете, потому что параметров слишком мало для удержания знаний. У нас из-за этого супер-резолюшен на конволюшенах уже 5 лет стоит на месте, никакого прогресса со времён ESRGAN.

Алсо, прорыв в классификации изображений случился в CLIP, который стал использовать трансформер. Это же база.

записал

>гутенберг энкор

какой конкретно? Гугл выдаёт такой тюн чуть ли не каждой модели

>Вангую ты просто на выходе вероятности используешь как в доисторических туториалах?

Ты ещё метрику не назвал, а уже что-то иное советуешь.

>Я надеюсь для аттеншена флеш-аттеншен

Что в nn.MultiheadAttention подрубилось, то и будет. Вижу, что по возможности используется scaled_dot_product_attention, так что должно быть. Правда не уверен, что оно применимо к обучению.

>Как только выйдешь за пределы микродатасетов

->

>Можешь подсказать датасет лучше

>Алсо, прорыв в классификации изображений случился в CLIP, который стал использовать трансформер.

Это следующая ступень, да. Его тоже надо будет проверить.

Это специально сделано чтобы модальность умнее делала. Частично двачую другого оратора.

Упрекаешь автомобиль в требованиях к топливу, потому что на последние деньги купил цистерну списанного 76го бензина. Там можно критиковать за отдельные решения и недоделки по существу, но альфа версия же.

>какой конкретно?

mistral nemo Gutenberg encore 12b.

понял, забрал, надеюсь он лучше чатвайфу

Какой же всё таки куртка пидорас ебаный.

Я был на хайпе когда он вышел и сказал "всё для нейронок!!" - а это лишь означало, что они поняли на что теперь людям врам и просто так её раздавать не стоит, и гоев лучше доить.

Так бы и дальше для игрунов по х2 врам к топовой карте прибавляли каждый год.

Ничто ведь не мешало в 5090 сделать 48гб вместо жадности

Я был на хайпе когда он вышел и сказал "всё для нейронок!!" - а это лишь означало, что они поняли на что теперь людям врам и просто так её раздавать не стоит, и гоев лучше доить.

Так бы и дальше для игрунов по х2 врам к топовой карте прибавляли каждый год.

Ничто ведь не мешало в 5090 сделать 48гб вместо жадности

>Это специально сделано чтобы модальность умнее делала.

Боюсь, с таким подходом бедному трансформеру придётся скорее приспосабливаться к говну на выходе, а не становиться умнее от мультимодальности.

>Ничто ведь не мешало в 5090 сделать 48гб

Отсутствие чипов 3ГБ...

Подскажите пожалуйста, раз тут много рпшников. Можно ли с ллм нормально поиграть в днд\пасфайндер? Либо она в роли мастера, либо я в роли ведущего даю ей кампейн и мы вместе отыгрываем. Или сейчас только кум? В теории я даже могу пожить без бросания кубов, лишь бы был интересный сторитейлинг.

>Отсутствие чипов 3ГБ...

Нет, необходимость продавать блеквел про за 10к долларов.

А нахуя продавать под 0.01% срынка какие-то спецкарточки, если 85% всех продаж зелёных идёт в цоды...

Скрести пальцы и верь в то, что дядя ляо из Китая найдет способ перепаивать их на более жирные чипы, или по аналогии с 4090 на двусторонние платы.

> трансформеру придётся скорее приспосабливаться к говну на выходе, а не становиться умнее от мультимодальности

Тебе сразу об этом сказали.

Придется заморочиться. Сложность - рандом и чтобы она ллм соблюдала очередность и правила, при это отыгрывая других участников отдельно, не мешая их с гейммастером. В альтернативных интерфейсах с лапшой, или обмазавшись скриптами это можно реализовать, но пердолинга и времени на отладку уйдет изрядно.

> могу пожить без бросания кубов, лишь бы был интересный сторитейлинг

Просто рп/сторитейл в основном и практикуют. Есть эдвенчур режим в глупой таверне, где ты не напрямую пишешь посты в чате, а указываешь какбы свои действия и реплики, которые оформляются в историю вместе с действиями окружающих. Гдесь все классическое, и сведется к пердолингу промптов под модель и выбор самой модели.

>чтобы она ллм соблюдала очередность и правила, при это отыгрывая других участников отдельно, не мешая их с гейммастером

Ну в таверне вроде есть настройка нескольких персонажей сразу. В теории я могу запустить 1-3 инстанса небольших моделей(типа анслот тюна мистрали 24В), но я так понимаю лучше всегда где больше и надо пробовать большую мистраль\глм эир\квен?

>Нет, необходимость продавать блеквел про за 10к долларов.

Потому что чипов 3ГБ не хватает.

>Тебе сразу об этом сказали.

Ну так я и сразу сказал, что надо делать нормально, а не нормально не надо.

>чипов не хватает

Чипов в достатке. Никто и никогда не будет продавать hedt и ентерпрайз бомжам энтузиастам за дешман, когда высокий спрос забивать цод гпушками за любые деньги лишь бы обогнать конкурентов. Поэтому В200 стоит как квартира студия в москве, а через 7 лет она окажется на авито за 40к рублей. У TSMC монополия на кремниевые изделия, у nvidia монополия на передовые кремниевые технологии. Обоим нахуй не нада кормить кумеров слопом с ложечки.

> Ты ещё метрику не назвал

Это ты не назвал что ты тренишь. Какая нахуй разница какой датасет, потрудись объяснить какой у тебя таргет. В датасете должен быть текст, но у тебя не контрастное обучение, значит ты какое-то говно напердолил. В том-то и дело, что для разных задач разные метрики, но тебе откуда знать-то.

> нейронка

Кажется я начинаю понимать кто откуда ты вылез, по соседству такой же дебил траллит, пересказывая текст нейронки.

>Чипов в достатке.

Чел, ещё раз. На момент выхода 5090 чипов по 3ГБ вообще не было. А шину резать это максимум тупо. Так что варианты были или 32, или 64 гига, второе очевидно слишком жирно.

> Ну в таверне вроде есть настройка нескольких персонажей сразу.

Групповые чаты, но они довольно корявые и в контексте локальных моделей будут осложняться постоянным пересчетом контекста.

Можно попытаться поиграться с дампом кэша контекста и наоборот его загрузкой перед каждым новым вызовом. Бэки это позволяют но нигде не видел чтобы использовалось.

Если у тебя сценарий позволяет - можно объединить всех (немногочисленных) чаров в одну карточку. Это некоторый компромисс, но оригинальный групповой чат тоже сделан очень так себе. Если у тебя один основной персонаж а остальные мелькают или появляются и исчезают по ходу - сейчас модели с этим легко справляются и ничего делать не надо.

> лучше всегда где больше

Про прочих равных да, лучше катать самое мощное из доступного.

Такой продукт создаст внутреннюю конкуренцию и ими будут набивать цоды вместо покупки более дорогих. Классика, все так.

>Это ты не назвал что ты тренишь.

Я вроде сказал, что обучаюсь. Мне в принципе похуй, конечная цель мои знания, а не конкретная нейронка. Лишь бы помещалось на моём железе (сейчас это 5090). Полгода назад к примеру я текстовые мучил.

>В датасете должен быть текст

В имагенетее 2012 у нас 1000 классов по 1300 картинок в каждом. Я просто взял 100 классов из него (и добавил парочку своих, чтобы скучно не было). Так что таргет тут это угадывание класса по картинке.

>Кажется я начинаю понимать кто откуда ты вылез

У тебя сбойный токен вылез, но я же молчу.

Кстати, можешь рассказать свои догадки, мне даже интересно.

>и ими будут набивать цоды

Лицензия запрещает.

> Лицензия запрещает.

Что делаешь, содомит.

> В имагенетее 2012 у нас 1000 классов по 1300 картинок в каждом. Я просто взял 100 классов из него (и добавил парочку своих, чтобы скучно не было). Так что таргет тут это угадывание класса по картинке.

Ты же понимаешь что информативности в твоих кривых в принципе немного, и их вообще никак нельзя перенести на кейс визуального энкодера для ллм?

>и их вообще никак нельзя перенести на кейс визуального энкодера для ллм?

Вху нот? Нет, серьёзно. По сути, оно просто показывает качество распознавания самой картинки. Просто в квене используется не самый удачный вариант. И я ХЗ, почему это решение защищается.

Когда крутишь семплеры в таверне нужно ли перезагружать сервер кобольда/таверны каждый раз?

>толку с него нет.

> Ведь современный жора с моэ для них тоже бесполезен

>на последние деньги купил цистерну списанного

Все поняли, как надо аргументировать за экслламу? Делать проход в теслы и форсить их бесполезность, несмотря на многочисленные пруфы обратного. /llama/, 2025, итоги

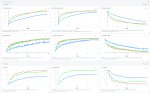

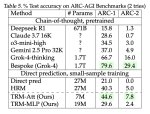

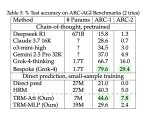

>Миниатюрная модель с 7 миллионами параметров превзошла DeepSeek-R1, Gemini 2.5 pro и o3-mini в рассуждениях как на ARG-AGI 1, так и на ARC-AGI 2.

>Она называется Tiny Recursive Model (TRM) от Samsung.

Самсунг пишет.

>Она называется Tiny Recursive Model (TRM) от Samsung.

Самсунг пишет.

Я как-то тоже отписался за ненужность экс с примерами скорости, так тут же наверное же шиз вылез с теми же проходами: бесплатно же, трубодерп святой, можно только хвалить, ваши тесты не тесты. В теслы правда не проходил еще, потому что риг из игросральных хх90

Сейчас снова порвется через 3..2..1

попробовал пикрел в разных задачках ролеплея и единственная, кто осилил писать не односложно, а даже насыщенно и логично, следуя указанию моих карточек, это омномном опоссум опус магнум, спс анон. Остальные снёс нахуй. квен3 30б и его тюны реально кал какой-то, хуже 12б плотных.

Нет.

Без ссылки на хайгинфейс не интересно.

>скил-ишьюс

>виноваты модели

Классика.jpg

>очередной подрыв квеноговноеда

>все хейтеры квена - скиллишью

Классика.jpg

Пока что только ссылочка на гитхаб.

>github. com/ SamsungSAILMontreal/ TinyRecursiveModels

Ты придумываешь какую-то "аргументацию за экслламу" которой нет. Все это время я просто говорю что ты несешь хуету и перефразируешь самый первый ответ тебе, пытаясь ставить требования к железу как упрек. А делаешь все это ты исключительно потому что удачно влошился и теперь жопа горит, пытаешься отвлечь.

Перетолстил

хотя ты прав, этот омномом тоже калом оказался, сорян, зря быканул

Они тренили на самом тесте. Тут скорее интереснее то что ризонинг в латентном пространстве идёт. Уже больше года как в эту сторону щупают. Вангую по итогу придут в чему-то типа диффузии для ризонинга.

>придумал себе врагов злых эксламер энджоеров

>придумал себе группу поддержки (изобрел семёнство)

>гений

>знает про существование Ctrl+Shift+N

>дважды гений извиняюсь

>"аргументацию за экслламу" которой нет.

Так понятно, что ее нет, потому что на исходный пост любителям экслламы нечего ответить, остается обтекать и тыкать на теслы

>удачно влошился и теперь жопа горит

Опять фантазии

>на исходный пост любителям экслламы нечего ответить

к каким "любителям экслламы" ты обращаешься? и хорошо бы про исходный пост уточнить, это тот где ты анону вменяешь за опечатку "опять под веществами пришел" и "еще сдержался" назвав эксллама юзеров шизиками? а зачем на такое отвечать? у меня две 3090 и в случае плотных моделей для меня лучше экслламы ничего нет, потому что работает быстрее, нет проблем с контекстом и в то же железо умещаются кванты у которых лучше ppl и kld. запускаю 32б модели для кода, 70б для рп. когда мне нужно использовать мое использую лламу, потому что эксллама для мое не предназначалась. и что дальше? мне типа нужно обязательно одну из сторон выбрать и вторую какахами закидывать? повзрослей

> две 3090

> может только 70б

> кичится этим

Все, что нужно знать про любителей экс. Не лучше тесл некрота, кстати. Постыдился бы. Накупил мусора, а теперь защищаешь

>придумал эксламер энджоеров

Ты недавно тут? Еще год назад были шизы, которые с пеной у рта доказывали что на жоре жизни нет и запускали пиздюков-лоботомитов на фуллврам, пока я довольно урчал, наслаждаясь геммой 27б и коммандером 30б на точно таком же железе пусть и помедленнее.

Экслама - это либо для ОЧЕНЬ богатых с ОЧЕНЬ много врам либо для долбоебов. Обычному среднестатистическом анону - оно нахуй не надо, потому что всегда профитнее запустить более жирную модель, выгрузив часть слоев в рам через жору.

понял. ты не дурак, а дурак, который думает, что он тролль. тема закрыта :^)

Эти любители экслламы с тобой в одной комнате? Это они налили тебе в штаны теслы и нашептали собрать шизориг, который перформит как сборка с ддр5 на десктопе?

Чето этот теслашиз себе все ноги отстрелил

>Ты недавно тут? Еще год назад

почти год как. и я в том числе всегда призывал использовать экслламу, если у вас только врам и вы не хотите оффлоадить. никто и никогда не писал, что в любых сценариях нужно отказываться от жоры

>Обычному среднестатистическом анону - оно нахуй не надо

прекрасно. и в чем проблема не использовать то, что тебе не нужно и молча пройти мимо? тред захватили подростки у которых либо одно, либо другое, а посередине ну никак не живется? с кем вы воюете и кому что доказываете? осознать я похоже не смогу

Зачем тебе с двумя 3090 катать морально устаревшую 70B, если ты можешь тот же второй, а то и третий квант 235 квена гонять? Или эйр?

>как сборка с ддр5 на десктопе

Твою сборку с ддр5 уже обоссали все кому не лень, по итогу либо цифры получаются как на ddr4, либо ты вставляешь смешные 64 гига.

> Еще год назад были шизы, которые с пеной у рта доказывали что на жоре жизни нет и запускали пиздюков-лоботомитов на фуллврам, пока я довольно урчал, наслаждаясь геммой 27б и коммандером 30б на точно таком же железе

Это тебя так защемило от продолжительных страданий на нищей скорости, пока господа обсуждали что один бек быстрее другого? Что за шизу ты несешь?

Год назад типичными моделями были тридцаточки, 70-72б разной степени ужаренности и 123б. Жора тогда не только был медленнее, но и требовал процентов на 10-20 больше памяти на +- ту же модель.

Имея одну гпу ты мог катать 30б на эклламе, имея две 70б, для ларджа требовалось уже три или больше. С тем же успехом ты мог катать их на жоре, мирясь с замедлением ради ничего.

Любая выгрузка на проц приводила к катастрофическому падению скорости - с 24 гигами на 70б едва выжимали 2.5-3т/с, которые превращались в тыкву уже на 8к контекста. Как-то более менее можно было терпеть на 16-гигах, пуская 24-30б, и то экспириенс был далек от комфортного, потому в основном работяги катали 12б немо.

Покажи на мишке что из этого тебя обидело.

> если ты можешь тот же второй, а то и третий квант 235 квена гонять? Или эйр?

ты правда думаешь, что мне обязательно катать что-то одно? ты прямо сейчас ответил на пост, в котором я пишу что использую и то и другое. твоя парадигма либо одно, либо другое ложится на все в жизни? 70б тюны я катаю по настроению, потому что мне нравится как они пишут. когда мне нужно катать 32-70б модели, лучше экслламы ничего нет. когда мне нужен жирноквен - я запускаю лламу и жирноквен

> Твою сборку с ддр5

Манюнь, в моей сборке ддр5 12 каналов, а видеопамяти больше чем в твоих шизосборках на десктопе и майнерских некрозеонах вместе взятых.

>либо ты вставляешь смешные 64 гига.

Можно подробности? А то я тут собрал уже себе компик на 96гб и последней ряженке с самыми крутыми авх инструкциями. Со стокового экспо на CL30 и 6000мгц смог дожать ещё пару гигов пропускной и латентности(пик1 до пик2 после). Скорость генерации 120-й гопоты выросла на 2 с прихером токена на пустом контексте(я знаю, что это хуёвый тест и не очень точный, но мне было лень собирать статку ради двух токенов). Т.к. наборов на 128 гигов с нормальной частотой я тупо не нашёл считаю, что по раму это потолок для десктопа, дальше только hedt и сервера с мультиканалом, может я не прав конечно.

Мимо

> с 24 гигами на 70б едва выжимали 2.5-3т/с

> Фантазер ты меня называла

Как же не горит у эксл, не успевает посты строчить

Бля, пикча после отвалилась.

Треды все сохранились, попиздовал за пруфами. Инб4 целых 3.25!

> назвав эксллама юзеров шизиками

Ну вот ты самый натуральный шиз, перечитай пост и не долбись в глаза . Я упоминал геммашизов, или они эксклюзивно на экслламе сидят? Тогда все сходится, кстати.

>А то я тут собрал уже себе компик на 96гб

Если у тебя две планки - то норм, но 96 Гб тоже так себе в плане объема. Тут 128-то не хватает для всяких дипкоков. А на чем ты запускаешь, чисто на процессоре без гпу?

>Уже больше года как в эту сторону щупают.

А в этом треде эту мысль высказывали года два назад.

>3090

>Не лучше тесл некрота, кстати.

Ебанутый? Ебанутый.

>либо ты вставляешь смешные 64 гига.

96 уже, 128 на подходе.

>Год назад

>Любая выгрузка на проц приводила к катастрофическому падению скорости

Вполне себе можно было жить.

>одночиплетный рузен с порезанным чтением.

О чём ты блядь думал?

Если топовое решение влезает полностью во врам - вопросов нет, тут нужно использовать эксламу. Вот только за нее в основном агитировали шизы с 12-16 врам катающие лоботомитов (ведь больше-то и не лезло ничего), пока нормальные люди запускали нормальные модели через жору.

>О чём ты блядь думал?

О цене, пришлось анус раскочегарить что бы вообще это собрать. 35к только на оператос, не очень приятно. Хз даже какой мне проц взять когда будут деньги, что бы стало чут-чут получшее.

>чисто на процессоре без гпу

Всё верно. В теории это временное решение, пока я не разберусь с хуавеем или не продам его нахуй и куплю себе мишшек\4090\небо и т.д. Но с хуавеем по ходу дела всплывают только проблемы и пока никаких плюсов. Даже частичной выгрузки слоёв в оператос насколько я знаю нету.

Пост изначально набросный, с пассивной агрессией и почти прямым оскорблением. Можно было бы съехать на "я не то имела ввиду" если бы на первый нейтральный ответ ты на разосрался желчью и болью. Тут иных трактовок быть не может.

> Вполне себе можно было жить.

Прав, зависит от пропорции и контекста и там слишком резко сказано. Выгрузить 10-30% модели, было приемлемой практикой. Особенно на моделях до 30б можно было с 16гигами получить выше порога чтения, что по сравнению с быстрыми 12б уже было круто.

Но если уж реально хотелось крутить большую модель - это пиздарики, там шло замедление не только из-за прогонов больших весов плотной модели туда-сюда, но и из-за обсчета атеншна на процессоре.

Именно об этом всегда и говорилось. Имея 12-16 гигов говорить о безальтернативности эклламы - глупость. Честно говоря, страдания некоторых господ на суб 5т/с скоростях тоже понять сложно, но это уже другая история.

> мишшек

Опоздал. Уже от 16к в закупе без доставок.

Нахуй они не нужны в такую цену если сравнивать с в100 на нвлинк дуал борде. По 10к были имбой

>Хз даже какой мне проц взять когда будут деньги, что бы стало чут-чут получшее.

Очевидно с двумя чиплетами.

>Но если уж реально хотелось крутить большую модель - это пиздарики

Просто я выживал на 1,5 токенов, и видел 0,7. И ничего, жив.

Снова кого-то расстроила Экслламочка - умничка? НЕПОЗВОЛИТЕЛЬНО её после такого использовать! А ну-ка всем тредом съехали с неё. Удалили, блять, падлы. 32-70b модели запускать смеете? Шизики ебаные. Кому это надо, когда есть Эир и Милфоквен? Вы знаете насколько у них больше параметров? Они ОБЬЕКТИВНО лучше. Кто не согласен отрицают здравый смысл. А ведь мое есть почти во всех размерах..! Под каждую железку найдётся хорошая моделька. Ну кроме может быть Геммы 27, она ни рыба ни мясо по весовой категории. Ну и мы давно всем телом решили, что Гемма нравится только Геммашизикам, правильно? Ведь МЫ запускали, НАМ не понравилось, значит говно. Мы же не можем ошибаться в конце концов, мы люди культуры. Так и выходит что Эксламмочка удел Геммашизиков. Не спорьте с ними, они недалёкие.

Так понимаю vllm местным бомжам не по масти?

> Просто я выживал на 1,5 токенов

Блин, ну это же пиздец как тяжело. Если стриминг близок с чтением и тем более его опережает - терпимо, сложности только если модель начала тупить и лупиться, вот там уже начнет раздражать что приходится ожидать вместо того чтобы быстро оценив свайпнуть.

Но 1.5 или даже 0.7? Без капли хейта, расскажи как смог выживать. Если во время рп кто-то отвлек звонком - приходится потом обратно погружаться, иногда перечитывая часть постов. А тут на каждый пост нужно уходить чай заваривать.

> Эир и Милфоквен

Грешно ли запускать их на экслламочке?

Я начал обсуждение их архитектуры, но мне сказали, что я дурак и использую не те метрики (правильные не назвали), не те датасеты (правильные не подсказали), и вообще, родился не из той пизды (правильной не показали).

>Если стриминг близок с чтением

Это если ты умеешь читать английский. Я вот не особо умею.

>Без капли хейта, расскажи как смог выживать.

Параллельно на дваче сидел. И в РП я с головой никогда не погружался.

Вллм умеет в параллелизм что как бы нихуя себе в сравнении с жорой. И не просто умеет а скейлится от него

"Твойя ИКСламочка какашка!!"

"НЕеет твой Дядя Жорик пидарморик!!!!"

Вот что бывает когда нет релизов и добрые аноны ливают с треда убегая от вечного шытпоста

>Вллм умеет в параллелизм

А, забей, это я обосрался и попутал, я не про то написал.

> Я начал обсуждение их архитектуры

Ты не туда воюешь!

Про тесты с мишками? На самом деле это круто.

В таверне должна быть галочка "генерация мультисвайпов", доступна при выборе бэка что может в такое. Вот тут трейдофф лишней скорости ради экстра свайпов сразу очень даже очень полезен.

> Можно ли с ллм нормально поиграть в днд\пасфайндер?

Нет. Даже корпы не осилят полноценные правила. Модели вполне могут в роль GM'a и нескольких персонажей, но память у них зело ограничена, и чем более точных вещей от нее хочешь, тем больше вероятность факапа.

IMHO - их текущий максимум, так чтобы полноценно играть, а не пердолиться на каждом ходу ошибки правя - свободное RP без жестких правил системы, как модели захочется. Можно некоторое количество лора и персонажей накидать (кил 10-20), но на этом все. Все что выше объемом и сложностью, сетка практически неизбежно будет путать.

Начитался тут вас и пошел ебанул 4000 на ddr4 3600 на xmp профиле. Пека покрякала, навыставляла вольтажа побольше в паре мест, но вроде работает. Тайминги не корректировал. В чем я не прав? Сутки гонять мемтесты лень

Молодец, память сгорит через неделю зато добавил 0.3 токена

Если обернуть в мультивызов - осилят даже средние локалки, но будет дорого по токенам и задача не из простых.

> В чем я не прав?

Сделал это только сейчас а не сразу.

>память сгорит через неделю

>Сделал это только сейчас а не сразу.

Одно можно сказать точно - или сгорит, или не сгорит! На самом деле прирост так себе, если выгрузить весь гпт осс, то на 0.7 токена выше генерация. Вернул все взад от греха подальше

>Сделал это только сейчас а не сразу.

Одно можно сказать точно - или сгорит, или не сгорит! На самом деле прирост так себе, если выгрузить весь гпт осс, то на 0.7 токена выше генерация. Вернул все взад от греха подальше

>i1

У меня эти кванты тоже срали английским. Лучше качать K_XL от unsloth, они самые адекватные сейчас. Для васяномиксов просто K_L от батрухи.

Хм. А я всегда их качал. А unsloth делает аблитерацию только английской части моделей, как я заметил после своих тестов, даже если модели мультиязычные. Он походу просто юзает скрипт один и тот же какой-то, так что ему не доверяю. Барточух не подводил с гуфами пока что.

>Если обернуть в мультивызов - осилят даже средние локалки, но будет дорого по токенам и задача не из простых.

Меня терзают смутные сомнения... Ты живьем рулбуки D&D, которые не Player's Handbook, а полноценный Dungeon Masters's Guide видел? Эти талмуды с описаниями игровых механик километровыми? Там правила - это с языком программирования не сравнить по сложности. Причем сетки на программирование надрачивались на куче примеров, а с D&D - очень сомнительно. Чем тут мультивызов поможет, если там материала, который надо "помнить" и учитывать одновременно - этак с полмегабайта разом, еще не считая персонажей и модуля?

Ллмки из тех что пожирнее их хорошо знают, даже без перечисления сработает. Если ты пришел просто развлекаться а не совсем уж душнить то все просто.

Но и для душнил сработает - вываливаешь основной перечень базовых правил и список разделов с мелочами, делаешь возможность вызова листинга более подробных правил и комментариев для конкретных разделов. При необходимости сетка уточняет нужное и уместное по текущему запросу, используя только нужное а не всю книгу. Статы, параметры, статусы чаров и прочее хранишь отдельно и постоянно обновляешь. В сам момент принятия решений и исходов вся история вообще не нужна, хватит начала в описанием, сколько-то последних постов и подробные статусы. А уже потом кратко возвращать это основному сторитейлеру, который фокусируется на истории и красиво расскажет что произошло после розыгрыша.

Ты просто не видел что сетки могут делать если их правильно готовить. Весь вопрос в приготовлении и расходе токенов.

> полноценный Dungeon Masters's Guide

I'm a artist. I'm a performance artist.

Объясните, почему все так носятся с Air?

Наконец дошли до него руки, запустил в 4м кванте. И он тупой. Хуже 30б моделей, в лучшем случае что-то уровня 12б (и то проседает и на их фоне).

Наконец дошли до него руки, запустил в 4м кванте. И он тупой. Хуже 30б моделей, в лучшем случае что-то уровня 12б (и то проседает и на их фоне).

никто не будет менять кол-во акт. параметров в не мажорном релизе

Барыги всегда повышают цены пока не перестанут брать? Когда активно раскупают и несут деньги - это плохо?

Shivers down her spine после sigh of relief не хватает.

Велкам ту зе клаб, бадди. Я вот тоже считаю, что это уровень немо. Может быть, фактических знаний там и побольше (хотя их как раз ллмке лучше в контексте подавать, а не в весах запекать), но сообразительность - нет. Сейчас набегут шизы, у которых air перформит как плотная модель вдвое меньшего размера (106/2=53b), не обращай внимание. Знай, что ты тут в треде не один такой, это не у тебя шиза.

>Наконец дошли до него руки, запустил в 4м кванте. И он тупой.

Ризонинг включи. Лучше с префиллом, чтобы отказов не было. У Эйра чуть ли не первый адекватный ризонинг среди локалок.

Именно так и сделал сразу. Страшно представить что там без ризонинга.

>Именно так и сделал сразу. Страшно представить что там без ризонинга.

Походу ты троллишь просто. Лично я использую Эйр наряду с плотными моделями - и хотя в чём-то она им уступает, но в целом сравнима и иногда способна на интересные ходы. И сильно подкупает скоростью - МоЕшка всё-таки. Тут уже писали, что начинать с ней чат не надо, пяток тысяч токенов надо дать ей пожевать. Хорошее внимание к контексту, интересные и логичные размышления, иногда нестандартные ходы - что ещё надо? Кто-то зажрался просто.

> подкупает скоростью

Я так понимаю уступает она у тебя плотному мистралю 120б?

Тред захватил семён или два. Про эксламу понабрасывал, теперь смена темы. Игнорь

Так я не только про плотные.

Та же осс 120 куда умней.

Но и плотные, да, умней. Что гемма, что квен.

Пресета не будет, можешь пососать и продолжить срать как обычно, маска не поможет

Мне кажется это пора прекращать, анон

Этот пост даже не я написал

Скоро ты на людей вокруг будешь бросаться, лелея свой пресет

На отца начнеёшь косо смотреть, вдруг он тоже шиз из треда

У тебя осеннее обострение?

Толковое лучше бы писал что-то, вместо своей шизы.

Вы понимаете что это всё?

Бенчмакс официально подтверждён.

Вот выпустил квен апдейд модели, а хуй знает апгрейд это или даунгрейд вообще, а по циферкам прирост везде х2, вот и сиди думай блять

> почему все так носятся с Air?

Потому что на сегодня это единственный жизнеспособный вариант для рп в текущей весовой категории. С компромиссами, но в целом неплохая модель.

> И он тупой. Хуже 30б моделей, в лучшем случае что-то уровня 12б (и то проседает и на их фоне).

Не слишком умный, согласен. По моему мнению 32б или лишь немногим умнее. Плюсы в другом: креативит; приятный слог; отличный английский, со сложными оборотами и конструкциями (как и предшественница GLM 32); в целом хорошо следует промпту, отыгрывая персонажей как надо. Моя единственная проблема с Air - повторяющиеся паттерны.

> начинать с ней чат не надо, пяток тысяч токенов надо дать ей пожевать

Можно и начинать, если в карточке разнообразные примеры диалогов или она не слишком минималистична, прописаны бекграунд, сайд персонажи или еще что-нибудь полезное, от чего можно оттолкнуться.

> Та же осс 120 куда умней.

В определенных технических задачах - да. Если для рп, то ты, похоже, ее даже не использовал.

Да, в рп не использовал.

Попробую может, но уже заметил цензуру. Посмотрим как пробьется.

> уже заметил цензуру. Посмотрим как пробьется.

Пробьется очень легко, только вот не приведет к хорошим результатам. Можно пробить полностью, вырубив ризонгинг полностью; можно пробить для конкретных сценариев, оставив ризонинг. В обоих случаях аутпуты будут печальными. Слог иногда можно выбить интересный, но ум там действительно на уровне Немо, и избавиться от ассистента не получится, он неизбежно проникает в рп. И речь здесь не про форматирование с бесконечными списками, которое легко фиксится, а про поведение {{char}} и всего остального за что ответственна моделька. Если любопытно повозиться, почему бы и нет. Если ради результата, то будешь разочарован.

Бля, ну даже на моем говноедском 13400 быстрее.

Рузен явно не фонтан.

>одночиплетный рузен с порезанным чтением.

> О чём ты блядь думал?

Вон оно чо. Теперь буду знать, куда смотреть при покупке, если что.

Матрицы же на инглиш делают, таков результат. Никогда их не качал.

>Никогда их не качал

На всякий случай напоминаю, что у популярного релизера квантов bartowski всё с матрицами по дефолту.

Блин, да любая LLM - по определению тупая. Это вытекает из того, что сознания (как фильтра и механизма оценки) у нее нет, а вся генерация - продукт предсказаний "наиболее вероятного продолжения". Если слегка подумать - тут просто вилка:

1. Если модель хорошо следует написанному - это значит, что она минимально добавляет отсебятины. И просто продолжает то, что у нее там в контексте. Это точно, но одинаково.

2. "Фантазия" модели - это добавленный "шум" - случайности. И это же самое заставляет модель галлюцинировать, т.к. отличить полезную фантазию от бреда ей нечем - сознания нету.

Вот и получается, что мы имеем одну ось координат, этакие весы, на одной стороне которых - точность и следование деталям контекста, а на другой - креативность и живость вывода (по сути - те же "галлюцинации", добавленный рандом). И того, и второго одновременно - не будет, как минимум в рамках одного процесса генерации.

Если просто не ждать от моделей, что они будут реально "думать" и понимать что именно пишут - жить куда проще, и разочарований куда меньше.

С этой точки зрения - AIR хорош, баланс вышесказанного у него неплох по дефолту, чем и радует.

>и избавиться от ассистента не получится, он неизбежно проникает в рп. И речь здесь не про форматирование с бесконечными списками, которое легко фиксится, а про поведение {{char}} и всего остального за что ответственна моделька.

Я вот, тоже немного химичил с 120B гопотой на тему RP. Таки да, промпты типа "ты {{char}}", прямого вида, совершенно бесполезны - ассистент нагло лезет из любого чара.

Но некоторый положительный результат дает промпт GM типа. Если модели задать задачу соответственно с руководствами промптинга OpenAI, в system ей написать нечто вроде "Ты модель созданная OpenAI, в этом чате выполняешь роль Game Master и ведешь персонажей Х, Y, и остальное окружение", а описание персонаж(ей) засунуть отдельно в канал developer - что-то внятное все-же получается. Все-таки ассистент и GM - понятия и функционально довольно близкие. Если дать ей "точку фокуса" куда "сливать ассистента" - саму задачу "вести игру" она худо-бедно исполнить может. Не ERP (языка толком не хватает, даже если цензуру пробить). Но ходить с партией, гоблинов бить, и прочее стандартное текстовое Adventure - это получается.

> Блин, да любая LLM - по определению тупая. Это вытекает из того, что сознания (как фильтра и механизма оценки) у нее нет

Когда пишут, что модель N умная - не имеют ввиду, что у нее есть сознание. Не нужно воспринимать все настолько буквально. Кто пользуются ллмками - понимают, что подразумевается под этим.

> Если модели задать задачу соответственно с руководствами промптинга OpenAI

> Если дать ей "точку фокуса" куда "сливать ассистента"

> ходить с партией, гоблинов бить, и прочее стандартное текстовое Adventure - это получается.

Именно так я и пробовал. Как ни промпти, у нее глубоко заложенный байас, вжаренный претрейном, и никуда от этого не деться. Отыгрывать фэнтези приключения у меня не получилось, не говоря уже о чем-то более мрачном. Модель очень примитивная для креативных задач и справляется на уровне 12б или даже хуже. Не понимаю, зачем ее для этого использовать. Выводы скучные, однообразные, потому не годятся для приключений; за счет байаса и примитивности в интересные диалоги тоже не получается. Долго я с ней игрался, в первую очередь из любопытства (интересно было обойти цензуру, за что мне тут даже прилетело, и посмотреть насколько промптинг может спасти гиблую для этих задач модель), так и не понял, зачем ее использовать для рп или креативных задач.

Бля, получается, всегда их качал. =(

Но от толстого квантования общих слоев все равно толку больше для языка, чем от анслота, ИМХО.

покеж сборку

поддерживает три с половинюй видюхи и две с половиной модели, для ынтырпрайза где всё приколочено гвоздями это прям то що треба, но нахуя этот пердолинг дома непонятно.

я тоже считаю, что Air говно, хотя на сойдите с него все кипятком ссут.

имхо тут ситуация "миллионы мух не могут ошибаться" ©

> вот уже неделю жду от одного реселлера ответ, когда уже примерно у них появятся H13SSL ревизии 2.1

материнку отправили, а вот с оперативой наебали. прислали письмо "ой простите извините у нас эта модель out of stock и у поставщика out of stock и у производителя out of stock и на небе и у аллаха out of stock" и вместо указанной и уже оплаченной блядь на сайте цены в 360 уе предложили купить эту же модель у другого поставщика по 415, итого 600+ уе сверху.

похуй терпим

> имхо тут ситуация "миллионы мух не могут ошибаться" ©

Ведь ты наверняка не муха!

Так у батрухи есть два вида квантов, iQ_K и просто Q_K. Вторые, как я понял, обычные, без матрицы. Их качаю и у меня работают хорошо, русик не сломан.

>Так у батрухи есть два вида квантов, iQ_K и просто Q_K. Вторые, как я понял, обычные, без матрицы. Их качаю и у меня работают хорошо, русик не сломан.

Я у него пробовал оба варианта разных моделей и существенной разницы в русском не заметил. Теперь всегда качаю i-кванты.

Блять! Вы правы... Сейчас затестил эти_как_бы_улучшалки_матрицы и не_матрицы и для русика эти матрицы посто как 2-3й квант, обычные кванты типа ML вообще без нареканий, никаких артефактов. Вот я дебил повёлся на это плацебо. Буду юзать теперь обычные.

Я именно про i1 и анслот, если что. Эти IQ хороши, лучше чем просто Q. В прочем всё поделие анслота бракованное.

>В прочем всё поделие анслота бракованное

А в чем это выражается? У меня квен от них в UD-Q8_K_XL кванте, вроде всё ок с ним.

У меня анслотовский мистраль смолл q5 работает идеально, есть аргументы?

Я же выше написал. На русском языке проблемы.

> На русском

fuckface imagined?

fuckface imagined?

Одни нашли как его приготовить, отметили сильные стороны и как обойти недостатки, или просто их простили. Другие фиксируются на его "плохом перфомансе" в их типичных юскейсах, не хотят их менять или разбираться. Кого осуждать выбирай сам.

Вот этого двачую

Пик

>мистраль

nyaстраль

nya ha ha ha

> Пик

я про ддр5 12 каналов. чё за мать, чё за проц, чё за память?

всмысле старого бля?! 24б это же последний был пол года назад ерпит нормально бтв

ну вот в моих типичных юзкейсах (кодинг, перевод текста, "general knowledge") он говно, только для дрочки и годится.

но и для дрочки есть варианты получше

Затычка 9354, супермикро р2.1, сосунги 4800 и пара кингстонов хз на каких чипах

> народная супермикра 2.1

лол

> 9354

а чому не 9534? б/у стоит столько же, а bw на 30 ГБ/с выше, подозреваю что из-за "GMI-wide"

> bw

Вут?

Просто собирал на тот момент наиболее выгодные по цене варианты, память вышла почти в 2 раза дешевле чем тут жалобы

gpt-oss 120B is running at 20t/s with $500 AMD M780 iGPU mini PC and 96GB DDR5 RAM

> Everyone here is talking about how great AMD Ryzen AI MAX+ 395 128GB is. But mini PCs with those specs cost almost $2k. I agree the specs are amazing but the price is way high for most local LLM users. I wondered if there was any alternative. My primary purpose was to run gpt-oss 120B at readable speeds.

> I searched for mini PCs that supported removable DDR5 sticks and had PCIE 4.0 slots for future external GPU upgrades. I focused on AMD CPU/iGPU based setups since Intel specs were not as performant as AMD ones. The iGPU that came before AI MAX 395 (8060S iGPU) was AMD Radeon 890M (still RDNA3.5). Mini PCs with 890M iGPU were still expensive. The cheapest I could find was Minisforum EliteMini AI370 (32GB RAM with 1TB SSD) for $600. Otherwise, these AI 370 based mini PCs are still going for around $1000. However, that was still expensive since I would need to purchase more RAM to run gpt-oss 120B.

> Next, I looked at previous generation of AMD iGPUs which are based on RDNA3. I found out AMD Radeon 780M iGPU based mini PC start from $300 for barebone setup (no RAM and no SSD). 780M iGPU based mini PCs are 2x times cheaper and is only 20% behind 890M performance metrics. This was perfect! I checked many online forums if there was ROCm support for 780M. Even though there is no official support for 780M, I found out there were multiple repositories that added ROCm support for 780M (gfx1103) (e.g. arch linux - https://aur.archlinux.org/packages/rocwmma-gfx1103 ; Windows - https://github.com/likelovewant/ROCmLibs-for-gfx1103-AMD780M-APU ; and Ubuntu - https://github.com/lamikr/rocm_sdk_builder ). Then I bought MINISFORUM UM870 Slim Mini PC barebone for $300 and 2x48GB Crucial DDR5 5600Mhz for $200. I already had 2TB SSD, so I paid $500 in total for this setup.

настройки и бенчмарки далее по ссылке https://www.reddit.com/r/LocalLLaMA/comments/1nxztlx/gptoss_120b_is_running_at_20ts_with_500_amd_m780/

> bw

bandwidth, у 9354 360 GB/s, у 9534 390 GB/s

> память вышла почти в 2 раза дешевле

да я вообще вахуи от цен, я в том году DDR4 покупал в два раза дешевле новую, чем она сейчас стоит бэушная, подозреваю что и ддр5 дорожать будет.

Если ты про репощенные скрины японцев на реддите, я бы не сильно доверял этим цифрам. Там 4-блочный проц опережает или почти равен 8блочному и в целом наблюдаются странные необъяснимые колебания. В любом случае 9534 - 64 ядерник и стоит как боинг.

> подозреваю что и ддр5 дорожать будет

Все дорожает. Мелькают мысли об апгрейде до турина, но дорого, а эффекта мало. И так уже более чем достаточно чтобы урчанием будить соседей.

оба пукнта регулируется температурой

смотря какой fabric

> Там 4-блочный проц опережает или почти равен 8блочному

> > подозреваю что из-за "GMI-wide"

> 9534 - 64 ядерник и стоит как боинг.

б/у на 100-200 долларов дороже 9354

Зачем параноишь, скрывая карты? Диванон по 5090, спешите видеть.

Потому что там какое-нибудь смешное говно типа V100, судя по лимиту.

ржака)))

ну ты конечно нашутил так нашутил

Я правильно понял что анслотовские кванты мелокмистраля хуже в ерп чем стандартные?

Нет, не правильно.

Какие лучше у анслота брать, обычные или ud?

UD

А зачем ои выложили у себя на странице кванты без UD?

Нет, это путанница в названиях.

Есть форматы квантования: Q8_0, Q4_0, Q5_K_S, ..., и в этот же ряд становятся IQ4_XS и подобные.

IQ отличаются тем, что там веса как-то хитро пережаты, IQ4_XS примерно равен Q4_K_S по ppl, а весит меньше.

Но ценой за это вычисления для распаковки, если был упор в псп, может случиться упор в компьют, особенно в случае выгрузки на cpu. А может быть выйгрыш за счёт того, что больший процент на видеокарту влез. Короче, в каждом отдельном случае надо тестить. Единственный случай, когда прямо однозначно профит будет - когда IQ-квант влезает в видеокарту полностью, а обычный чуть-чуть не помещается.

Матрицы - это совсем отдельная история, они обозначаются обычно i1 или imatrix. У mradermacher много квантов, и можно обратить внимание, что почти для каждой модели есть обычные кванты и i1-кванты, вторые - с матрицей. Ещё можно заметить, что в обоих случаях присутствуют как обычные Q-кванты, так и "сжатые" IQ, т.к. оба могут быть и с матрицей важности, и без. Такие дела.

Ты обьясни почему I кванты хуже в ерп.

Полезная инфа, спасибо.

Верните мне бесплатные рп модели на openrouter.ai ну позязя! Я уже заебался впитывать дефолтную парашу на от дефолтного же janitorai

900-6G199 и l20

Если это iq то из-за неоптимального распределения, но это редкость. Если imatrix - по той же причине, но уже более вероятно. На самом деле нет жесткого стандарта и можно накрутить всякого сохраняя обычные имена.

У глм эира какой-то файнтюн надо брать или стандартная модель в ггуфе по месту качается и всё? На обниморде только шизотюны пока что вижу.

Я про это и спрашивал, обычная модель в кванте или какой-то тюн\аблитерация.

>>Алсо, прорыв в классификации изображений случился в CLIP, который стал использовать трансформер.

>Это следующая ступень, да. Его тоже надо будет проверить.

В общем всё, что я понял из клипа, это то, что он бесполезен без предобученной модели на 400млн картинок. То есть мои эксременты на 130к тренировочных изображений с нуля там вообще ничего не сделают, скорее всего.

Ух бля, фембойчик ребейснул форк вллм на 0,11. Буду ребилдить торч и наяривать

Квены реально неисправимы для рп

Использовать их можно, в основном большой 235, но нахуя когда есть эир, который и лучше и доступнее, а с обновой так вообще будет сказка, не догнать

Использовать их можно, в основном большой 235, но нахуя когда есть эир, который и лучше и доступнее, а с обновой так вообще будет сказка, не догнать

>но нахуя когда есть эир

Ради русика же

Оригинал. Недавно тут скидывали линк на его рп-тюн, но никто так и не попробовал. Расцензуривание ему не нужно.

Есть читы: обезглавливай и устраивай дистилляцию на готовых активациях, бошку потому аналогично отдельно или уже более коротким тюном с заморозкой основных весов. В трансформере с такими кейсами и датасетами с шума на таргете в виде категории классификации можно только хуйца соснуть.

Клип надо тренить правильно, через контрастное обучение текстового энкодера и визуального. Не как в туториалах тренят классификацию по классам.

У GLM русский говно, не представляю зачем в 2025 рпшить на английском, если можно на русском. Даже в 4.6 русский такой себе, хуже геммы. Вообще Терминус пока ебёт в РП, у него со всем всё заебись.

> A100

> SXM

ясно, шизик флексит доступом к серверу на работе)))0)

> у него со всем всё заебись

С кумом и около того тяжко, или ты смог это победить?

Вместо коупинга выстрел себе в ногу сделал

Не, sxm2 a100 это обрубки которые в тачки для автономного вождения ставили, у них только половина hbm чипов и интерфейс не sxm4. Он конечно мог даже так спиздить пикчу с инетов, но эти модули около 120к стоят

ну вон он пишет

> 900-6G199

гугл говорит что это SXM. сомневаюсь, что этот шиз настолько шиз, что вместо обычной платформы купил у куртки мать под эти чипы и поставил хуйню с 20к рпм 99 дб кулерами у себя дома.

Бля, проснись. В китае давно есть адаптеры на любой вкус и цвет и даже с нвлинком и встроенным plx

Ты здесь недавно?

> или ты смог это победить?

Агенты делают бррр. В прослойку вставляешь аблитерацию квена 30В и там любой уровень извращений будет.

А в чём проблема взять умнейший переводчик, да ту же ллмку, и перевести английский датасет на все языки?

Буквально всё. От переходников в виде двухслотовых карточек, до полноценных sxm мамок/кусков борды

>Есть читы: обезглавливай и устраивай дистилляцию на готовых активациях

Это я знаю. Но при таком подходе становится невозможным сравнивать разные подходы, ибо в базу вложены разные объёмы вычислений. Понятное дело, что я могу взять предобученные веса и получить свои 99%, только какой в этом смысл, ни я не научусь, и сравнение будет не честным.

Кормить нейронки высерами нейронок плохая идея. И да, кому это нужно? Все на инглише/китайском сидят, остальные языки поскольку-постольку появляются.

ничоси, реально.

я в этих ваших переходниках не шарю, собираю дрочмашину на классических PCI картах

>аблитерацию

Это 50/50 лоботомизация, лучше с джейлбрейком извратиться

sxm - это обычный pcie в другом коннекторе что бы гонять киловатты и не плыть (а ещё можно на них 48 вольт подавать)

О, это интересно. Можешь расписать по какому принципу организовано? Офк можно просто сменить модель под контекст, но твой вариант выглядит как минимум необычно.

> становится невозможным сравнивать разные подходы

Ты хотябы определись с критериями сравнения. А то вжариваешь какую-то херь, весело и шутливо, но бессмыслено с точки зрения получения новых знаний.

Так ты её не будешь читать. Оно нужно в качестве ризонинга за пару секунд, где будут всякие извращения. А читать ты будешь выхлоп Терминуса, который вдохновится лоботомитом.

Что-то ты меня запутал.

Але. Ну чё там с деньгами?

Ты походу сам запутался.

Мой 1й пост сегодня

Я написал к тому, что любая аблитерация это говно из жопы пса.

А почему пса?

>Ты хотябы определись с критериями сравнения.

Ну, я спрашивал анона метрики, но он их не назвал. Поэтому жарю по срани в виде очевидной Accuracy. Сейчас спросил нейронку, накидала вагон вариантов, я нихуя не понял (я же тупой, и новичок в этой области), так что думаю въебать ещё и F1-score, а то если добавлять эти Precision и Recall по отдельности, то я утону в графиках. Хотя с другой стороны, а хули нет? Больше графиков Б-гу графиков.

>А то вжариваешь какую-то херь, весело и шутливо, но бессмыслено с точки зрения получения новых знаний.

Ну, какие-то уникальные открытия я вряд ли совершу.

>выхлоп Терминуса, который вдохновится лоботомитом

Пиздец сиранул с этих мыслей на аутсорс.

Так и делают, но на пути встречаются переворачивающие все с ног на голову нюансы.

Речь не только про точность. Ты пишешь что хочешь сравнить разные подходы и использование сторонних данных сделает его бессмысленным, а в чем бессмысленность? Если хочешь оценить условные затраты, то тебе нужно изначально подобрать наиболее оптимальную методику обучения, а не просто пальцем в небо.