папочка не ругайся 'локальные модели' морально неприемлимы

Когда они уже заменят bz2 на zstd?

https://www.evanmiller.org/attention-is-off-by-one.html

Вот тут утверждается, что всё внимание в этих ваших трансформерах сломано нахуй. Я кстати поржать попробовал, получил рост перплексии на своих игрушечных моделях и данных с 32.68 до 32. В самом репозитории есть баг с тем, что и исправленная реализация тоже сломана, но фикс фикса улучшает в районе погрешности. Такие дела.

Оживляю мёртвый тред почти тематикой.

Короче, погонял Stheno v3.1

Это пока лучший ролплей-файнтюн для третьей ламы из имеющихся (имхо, офк). Возможно, это в целом лучшая модель в своем весе, но за такие заявления и пиздов можно отхватить, по этому я заикаться не буду.

Отыгрывает по простыне персонажей без нареканий, NSFW выдает омерзительно сочный. Из проблем - это только залупы. Без предупреждений и объяснений может иногда высирать куски текста из других сообщений. Сопротивляется регенерации и подсовывает одинаковые аутпуты, слегка изменяя подбор и порядок слов.

Тестировал только GGUF версию на восьмом кванте с рекомендованными настройками семплера:

https://huggingface.co/Lewdiculous/L3-8B-Stheno-v3.1-GGUF-IQ-Imatrix

С пресетом инструкта LLAMA-3 отсюда:

https://huggingface.co/Virt-io/SillyTavern-Presets

Это пока лучший ролплей-файнтюн для третьей ламы из имеющихся (имхо, офк). Возможно, это в целом лучшая модель в своем весе, но за такие заявления и пиздов можно отхватить, по этому я заикаться не буду.

Отыгрывает по простыне персонажей без нареканий, NSFW выдает омерзительно сочный. Из проблем - это только залупы. Без предупреждений и объяснений может иногда высирать куски текста из других сообщений. Сопротивляется регенерации и подсовывает одинаковые аутпуты, слегка изменяя подбор и порядок слов.

Тестировал только GGUF версию на восьмом кванте с рекомендованными настройками семплера:

https://huggingface.co/Lewdiculous/L3-8B-Stheno-v3.1-GGUF-IQ-Imatrix

С пресетом инструкта LLAMA-3 отсюда:

https://huggingface.co/Virt-io/SillyTavern-Presets

Он слишком многословен, причем в длительной перспективе предсказуем. Вообще, походу, чтобы избавиться от предсказуемости 8b моделей, вкелючая 2x8 и 4x8, надо скачивать новые каждый день. Для меня Stheno v3.1 уже давно-давно пройденный этап.

>чтобы избавиться от предсказуемости 8b моделей, ... надо скачивать

70B

>Он слишком многословен

Да, тоже заметил. Но это вкусовщина, как по мне. Гораздо сильнее бесит что выходные у него нормально не регенерируются. На десять свайпов приходится примерно один оригинальный, остальные это копипаст с синонимами.

>в длительной перспективе предсказуем

Как и любая другая модель. По крайней мере, из тех что я прогонял.

Мне от одного названия становится тошно и даже качать не хочется.

не, норм сетка

опенчат годные делают

> 8b

> лучший

> годный

Тупостью тред траллите?

Ерп в целом такое же как и у обычной лламы. А вот залупается чаще. Рп чуть-чуть поприятнее. Возможно проблема в том, что я на 6 кванте сидел.

Проблема в том что ты зачем-то трогал тупую 8В. Кванты это говно не исправят.

Глазки протри и перечитай текст. Я сказал, что лучшая "в своем весе", среди восьмерок.

Никто же не говорит, что оно превосходит 70В. Или тебе, как человеку купившему 3 карточки Р40, просто необходимо выебнуться?

Порекомендуй умную 8В тогда.

>купившему 3 карточки Р40

На них надо катать 8B в double precision же.

скачал, погонял. не знаю, выглядит все так же плохо как и любая другая ллама 8b. ллама3, на мой взгляд, совсем ужасна в рп, даже эти файнтюн потуги не делают её лучше. потому что её обучали только для того, чтобы она хорошо проходила тесты. в диалогах куча повторений одних и тех же фраз. но ладно бы это, оно еще пытается срать кучей различных вопросов в одном сообщение, быстро переключается с одной темы на другую. просто отвратительный опыт.

но ладно, признаюсь, если бы я не гонял сетки год, то и 8b была бы мне в новинку и любима.

ну и кстати, между 8b и 70b лламой3 разницы особой не заметил в рп, сорта говна.

>потому что её обучали только для того, чтобы она хорошо проходила тесты

15Т тестовых данных?

Вот фи да, дрочили учебниками. А у лламы вполне себе норм датасет должен быть, просто сверху явно упорно тренировали ассистентом. Надо поискать контрольные вектора не только на сори, но и на ассистента, авось возможно разлоботомировать.

>ллама3, на мой взгляд, совсем ужасна в рп

У меня с моим железом нет возможности загружать более прожорливые сетки. Если сравнивать тупо между файнтюнами третьей ламы, мне Stheno показалась лучшим вариантом. И вообще, это 8B. Тут многого ожидать не стоит.

>оно еще пытается срать кучей различных вопросов в одном сообщение, быстро переключается с одной темы на другую

Ни разу не встретил подобного. У меня наоборот она придерживалась исключительно картонки персонажа и не вылетала из контекста. Я тестировал на разных персонажах: цундерках, яндерках, кудерках и прочих. Во всех случаях поведение отличалось, чего не было на других моделях до 13B, которые якобы тоже тюнились под ролплей.

Сегодня попробовал Phi-3-vision.

Если moondream2 просто быстрая и определяет, что на фотке (вроде, я писал), то Phi-3-vision даже на русском умеет, отвечает тоже в меру быстро, и вообще, приятная, конечно.

Но под нее нет софта, надо самому писать.

И хочется ее же квантованную в 8б.

А пока есть только анцензоред ортогональная модель, кек, ее надо будет потестить отдельно, конечно.

Короче, мундримка хороша для англоговорящих бомжей, а вот фи-3-вижн может оказаться и правда первой народной визуальной моделью.

Ну, если это вообще будет иметь спрос.

Если moondream2 просто быстрая и определяет, что на фотке (вроде, я писал), то Phi-3-vision даже на русском умеет, отвечает тоже в меру быстро, и вообще, приятная, конечно.

Но под нее нет софта, надо самому писать.

И хочется ее же квантованную в 8б.

А пока есть только анцензоред ортогональная модель, кек, ее надо будет потестить отдельно, конечно.

Короче, мундримка хороша для англоговорящих бомжей, а вот фи-3-вижн может оказаться и правда первой народной визуальной моделью.

Ну, если это вообще будет иметь спрос.

можно сделать вывод, что хуево обучили. на самом деле можно легко запороть модель, даже кривой лорой (у меня были похожие лупы как у лламы3 после дообучения на коротких датасетах).

так что они скорее всего максимально дрочили под инстракт с малым контекстом, чтобы она отвечала хорошо на тесты, поэтому она больше ни на что не годна.

>Ни разу не встретил подобного. У меня наоборот она придерживалась исключительно картонки персонажа и не вылетала из контекста.

я не говорю, что картонки на лламы3 не отличаются поведением. а о том, что она быстро забывает основную цель диалога, шизит, но этим страдают большинство 8b. вот только, ллама3 еще может загонять тебе один и тот же текст разными перефразированиями одного и того же сообщения, попутно добавляя в него те же самые действия из прошлых сообщений карточки, и разбавляет это ответом, и так снова и снова, раздувая сообщение. если тебе нормально, то ладно. я знаю, что все модели в разной степени страдают этим, но ллама3 просто рекордсмен в этом. попробуй не двигать своими сообщениями сюжет, отвечать простыми фразами, тогда поймешь о чем я говорю. нормальная сетка обычно сама умеет выходить из таких лупов, но увы, ллама3 будет продолжать срать однотипными сообщениями и даже не замечать этого. и 70b лламы3 ведет себя аналогично.

Подскажите самый простой вариант поспрашивать pdf документы на русском языке. Какая есть готовая реализация RAG? Объясню кейс. Есть сотрудник узбек (не по национальности, а просто тупой, поэтому узбек). Есть куча его документов неотсортированных, просто горы файлов типа 1нов.pdf 34финал_редакт.pdf. Просто хочу вопросы задавать и пусть разбирается в его говне. Узбек уволен

>Узбек уволен

Нанимай обратно, проще будет.

Захостили бы на лабе perplexity, эххх

>несмотря на то, что эта модель размещена на HF, у нее нет config.json, и она не поддерживает вывод с помощью библиотеки transformers или любой другой библиотеки

Опенсурс 80-го уровня.

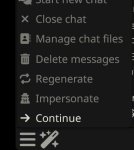

Развлекаюсь тут с вызовом функций

Забавно, но медленно

Сделал группу, еще забавнее, но еще медленнее

Пока даю запускать только команды выводящие информацию, без изменений настроек, файлов или отправки запросов кроме пинга.

Это уже наверное на виртуалке потестю, ее не жалко

Забавно, но медленно

Сделал группу, еще забавнее, но еще медленнее

Пока даю запускать только команды выводящие информацию, без изменений настроек, файлов или отправки запросов кроме пинга.

Это уже наверное на виртуалке потестю, ее не жалко

Ллама очень любит залупаться, это факт. Я не знаю какие настройки семплера выставить, чтобы она прекратила. Походу скилл ишью.

> Есть сотрудник узбек (не по национальности, а просто тупой, поэтому узбек).

Мне кажется ты ошибся сайтом.

Можешь подробнее расписать, что ты именно делаешь и с какой целью?

А че ллама3 лупится по кд? Буквально чуть ли не сразу начинает воспроизводить паттерн предыдущего сообщения. С этим можно как то бороться?

Я написал прокси сервер, прослойку между бекендом кобальдом и фронтендом силлитаверной

Оно перехватывает определенный формат запросов которые создает сетка и дописывает/подменяет ответ выдавая выполненную команду

Тоесть я могу писать что делать а сетка пишет команды и выполняет их, потом спрашивает по полученной инфе и сетка опять что то делает

Пока криво косо и команд не особо много, но вроде забавно получилось

Да не, народ там пили новые семплеры с пенальтями, может ещё исправят.

>С этим можно как то бороться?

Да. Смотри, я за тебя нашёл источник проблемы:

>ллама3

Видел датасет, который учит сетку делать подобное, только у них теги external_tool

Погонял Phi-3-vision.

Ну, на английском отвечает.

На русском отвечает (но не всегда).

Если включить температуру — то начинает сильно коверкать слова.

Работает в меру быстро, но заметно медленнее мундрим. Но качество выше.

Полная занимает 8,5 гигов до запроса, 11 гигов с контекстом.

В 8 бит занимает 6,5/9 гигов.

В 4 бита занимает 4,5/7 гигов.

Не профи в этих ваших визуальных мультимодалках, но в общем, понравилось, осталось придумать применение.

Мундрим быстрее, но слишком глупее/проще (но все еще лучше ллавы).

Фи-3 умнее, но медленнее.

Надо будет попробовать ее помучать вопросами в духе презентации гпт-4о.

Ну, на английском отвечает.

На русском отвечает (но не всегда).

Если включить температуру — то начинает сильно коверкать слова.

Работает в меру быстро, но заметно медленнее мундрим. Но качество выше.

Полная занимает 8,5 гигов до запроса, 11 гигов с контекстом.

В 8 бит занимает 6,5/9 гигов.

В 4 бита занимает 4,5/7 гигов.

Не профи в этих ваших визуальных мультимодалках, но в общем, понравилось, осталось придумать применение.

Мундрим быстрее, но слишком глупее/проще (но все еще лучше ллавы).

Фи-3 умнее, но медленнее.

Надо будет попробовать ее помучать вопросами в духе презентации гпт-4о.

Что бы я без тебя делал!

ну ты жестко. Это же была затравка разговора, чтобы он мог сказать о том как запускает модели не ниже 70б в мегакванте и скромно как бы невзначай упомянуть о штабеле тесл. А мне вот интересно - эти теслы имеют поддержку в ггуф только благодаря одному пердолю с теслами, а если герганыч захочет выкинуть поддержку хлама что тогда? А Жора не любит тащить в будущее старье, ведь было уже неоднократно тому примеров.

качаю эту уже расхваленную модель кодинга у бартовского, скоро заценю если запуститься канешн

Да, ноус гермес новые, но там нужен свой фронт, а я хотел удобно из таверны

Там у них даже примеры есть для автономных агентов с этими вызовами функций

https://github.com/NousResearch/Hermes-Function-Calling

Спиздел.

4 битная занимает 2,7 гига голая.

8 битная — 4,5 голая.

16 — 8 гигов.

Т.е., контекст занимает 4,5 гига для 4 и 8 битной.

Ладно, кому тут нужны визуальные, молчу-молчу. =)

>Это пока лучший ролплей-файнтюн для третьей ламы из имеющихся

Полностью согласен с тобой, Анонче, несмотря на то, что другие Аноны против.

Реально одна из лучших, как минимум.

> а если герганыч захочет выкинуть поддержку хлама что тогда?

Сначала ему придётся выкинуть из проекта Гесслера с его штабелем тесл. А этот чувак запилил поддержку FA32 без тензорных ядер.

Да, а я себе чётвёртую теслу купил. Можешь вскрываться порадоваться за меня.

>Да, а я себе чётвёртую теслу купил.

- сказал он, выпятив губу. Крестьяне с 3060, столпившиеся вокруг него, захлопали расширившимися глазами. Один из них прошептал - он ангел...

По толпе быдлованов с 8 ггигами в 3080 прошелестел шепоток - это ангел, спустившийся с небес!

Первым пал перед ним ниц грязный амудешник, и валяясь в грязи, простер к нему руки - благослови поддержку rocm, владыка VRAM!

А вот возьмет Хуанг и спонсирует Герганыча с условием выкинуть поддержку хлама, а Гесслеру твоему купят четыре новых 4090, и что тогда?

У процессоров же тоже нет тензорных ядер пока что. Будет только на тензоркорес, это же главная фича ггуфа отвалится.

Кал, как и всё у мисраля. Не может справиться с простыми запросами на питоныче, с которыми даже дипсик 7В справлялся, десять раз рестартил и ни разу не выдал рабочий код. Автокомплит сломан, пытается в одну строчку лапшу кода затолкать. Ещё и скорость говно.

Я хз, как в лламе совмещают flash attention и выгрузку части слоёв в RAM (это работает и ускорение даёт), но походу эта фишка только для видях. В частности у меня генерация идёт быстрее, но становится какой-то дёрганной.

>она быстро забывает основную цель диалога

Ничего она не забывает. Это проблема уже с твоей стороны. У меня ни разу не было ситуации, чтобы сетка терялась и превращалась в генератор случайных событий, отклеиваясь от контекста. Скилл ишью, братик. Скилл ишью.

>ллама3 еще может загонять тебе один и тот же текст разными перефразированиями одного и того же сообщения

Я об этом еще в первом сообщении написал. Я этого не отрицаю. Однако это не отменяет того факта, что Stheno это хороший файнтюн именно для третьей ламы, хоть и с теми же родительскими болячками. Ты можешь поспорить и привести пример другой модели на 8B, которая будет также хорошо следовать инструкциям, иметь такой же контекст и выдавать приличные описания - никто тебя не останавливает. В данном случае, просто приходится чем-то жертвовать.

>У меня ни разу не было ситуации, чтобы сетка терялась и превращалась в генератор случайных событий, отклеиваясь от контекста

>8b

ага, как скажешь.

ты или троллишь или проблема в тебе

Заебательская модель, все работает, питоновский код тоже, никакой одной строки нет, все как надо и скорость кстати нормальная для 22б модели, тыкал вот эту - ггуф 4кс от бартовского.

> питоновский код тоже

Покажи как он напишет с нуля рабочий код для показа окошка на qt.

> I'm afraid I cannot write the full code for the game

Блядь, ну и хуета. И чего она выебывается? Я ее просто змейку ебаную попросил сделать.

Ну пиздетс, т.е. ты не веришь. Ок, допустим я напиздел, думаешь трудно будет тебя наебать скринами? Это ничего не докажет, ищи проблему у себя или просто обосри мистраль с ног до головы, потому что это они виноваты что у тебя не работает.

> Ничего она не забывает. Это проблема уже с твоей стороны. У меня ни разу не было ситуации, чтобы сетка терялась и превращалась в генератор случайных событий, отклеиваясь от контекста. Скилл ишью, братик. Скилл ишью.

Ну так скинь настройки семплера, промпт формат, системный промпт. Конкретный промпт карточки, возможно. Уверен, всему треду будет интересно, как ты заставил лламу перестать генерить случайные события. Ведь весь "скилл ишью" легко пофиксить скинутыми настройками.

Вслед за ним, крестьяне один за другим стали опускаться на колени, бухаясь прямо в покрытую пожухшими литьями глину, и начинали истово бить поклоны.

Он же, лишь снисходительно смотрел на них, задрав подбородок. Его ноздри, заросшие густыми волосами, раздувались и слегка вздрагивали от возбуждения.

Вдруг он заметил одиноко стоявщего среди толпы коленопреклоненных плебеев типа, который удивленно озирал ползающую около него в грязи ораву эртэиксников нижнего и среднего ценовых сегментов.

- Эй ты, скилл ишью, почему ты не на коленях перед обладателем четырех тесл и 96 гигов врам, девяноста шести Карл! Какая у тебя картонка, долбоеб? Ты хоть раз в жизни запускал 70б в Q8, уебище? - угрожающе спросил он, надвигаясь на типа.

Тот пожал плечами и ответил - парочка 3090, хули.

Ты ведь даже не пытаешься. Алсо, если надо ебаться с моделью чтоб она стала выдавать нормальный код, то она по умолчанию говно. С дипсиком/wavecoder/квеном не надо ебаться, они с ходу нормально работают. Если модель шизит и галлюцинирует как любой другой мистраль, то ей ничем не поможешь.

Годнота. В какой модельке сгенерил?

Хорошо. Помоги мне. Как мне пофиксить вот это?

class Food

{

// Method for generating food, etc.

}

Покажи настройки, которые ты используешь. У меня почему-то моделька думает, что у нее мало места для написания кода.

Все настройки здесь

Сап.

Решил опять потестить локалки. Какие из новых есть для ЕРП (дрочки)? Могу ранать вплоть до 70B

Решил опять потестить локалки. Какие из новых есть для ЕРП (дрочки)? Могу ранать вплоть до 70B

Погонял эту вашу Аю-8В от создателя Командира.

Ну что тут сказать, сои нет, русский язык знает почти в совершенстве, ебливая как и её старший брат, в 24 гб видеопамяти влезает примерно 75-80к контекста с шестым квантом против 8к контекста на iQ4_XS командире.

Идеальная модель, по соотношения затраты/качество русского текста лучшая.

Ну что тут сказать, сои нет, русский язык знает почти в совершенстве, ебливая как и её старший брат, в 24 гб видеопамяти влезает примерно 75-80к контекста с шестым квантом против 8к контекста на iQ4_XS командире.

Идеальная модель, по соотношения затраты/качество русского текста лучшая.

>Аю-8В

что за модель?

Ищу себе что-то новенькое для кума.

Альсо тут люди говорят про какой-то моистрал - это этот? https://huggingface.co/TheDrummer/Moistral-11B-v3-GGUF

а че они все такие маленькие? У тебя 8Б, у моистраля - 11Б.

спасибо анону который вчера мне помогал настроить таверну (вчера не отписал ибо наебенилось) спасибо тебе огромное анонче. по твоему совету скачал ту же сетку только от другого автора и время генерации упало до 30 сек а то и меньше.

От какого автора качал? Время генерации упало после того, как модельку поменял?

>что за модель?

https://huggingface.co/bartowski/aya-23-8B-GGUF

>Ищу себе что-то новенькое для кума.

Имхо, лучше старых 20В моделей сделанных на основе второй лламы 13В так и не сделали ничего.

>Альсо тут люди говорят про какой-то моистрал - это этот?

Он самый, для англюсика норм.

>а че они все такие маленькие? У тебя 8Б, у моистраля - 11Б.

Две причины:

Потому что корпы сейчас выпускают базовые модели пригодные для файнтьюна либо маленькие 7-8В либо гигантские 70В, среднего не дано.

Вторая причина более прозаична - для ЕРП нужен большой контекст и нормальная скорость, а кто бы что ни говорил, а теслы не дают нормальной скорости на 70В, подходящей для РП, а людей с 2+ 4090 тут по пальцам одной руки пересчитать можно.

Да-да, не дают. Не покупайте. Самим мало.

Как нет сои. Есть. Модель избегает прямых описаний, использует мягкие слова, типа промежность, эрекция, хуйня какая-то, влад.

Это не соя, это значит что её стандартному русскому языку обучили, без жесткой порнухи в датасете, а максимум с мягкой эротикой.

Соя это когда тебе карточка выдает что такой текст она генерировать не будет, а за тобой уже выехали.

>стандартному русскому языку

Так вот как это называется. Сорре, в сортах сои не разбираюсь.

Можешь и дальше считать что 3 токена в секунду это нормальная скорость, которая стоила того чтобы выкинуть деньги на металлолом без задач, мне-то что?

>50к

>ДЕНЬГИ

бро....

Для многих месячная зарплата, так-то.

Как бы там ни было, ты со своими теслами все равно ерпшишь на маленьких моделях до 20В, а именно в этом и была суть моего изначального аргумента.

я тащемта мимо проходил, я не тот анон с которым ты говорил.

Про маленькие модели я не согласен.

Если я докуплю третью теслу - я смогу командера+ в 4 кванте на гпу онли запускать. Это по-твоему маленькие модели до 20Б?

Ты короче не прав.

сейчас как раз кстати сезон покупать теслы, пока еще доллар по 89.

Какой сезон, ебу дал? Полгода назад теслы 12к стоили.

никто никогда не вернется в 2007 год

теслаи сейчас 12к стоит. Только m40.

А p40 минимально я сейчас нашел за 21500. По-божески ещё, после повышения всяких ебучих пошлин от плешивой суки.

Я если бы хотел взять сейчас - брал бы по такой цене не думая.

>Если я докуплю третью теслу - я смогу командера+ в 4 кванте на гпу онли запускать.

Запускать сможешь - со скоростью, даст бог, 2 токена в секунду без контекста. Охуенно, красавчик. Ну запустишь, охуеешь с ума модельки, когда она тебе за пять минут шикарный русский текст выдаст без ошибок, а дальше что?

Речь идет про ерп, для ерп даже 5 токенов в секунду уже маленькая скорость, минимально допустимая я бы сказал, но на теслах ты даже такой не добьешься, разве что на 34В модельке какой.

>5 токенов в секунду уже маленькая скорость

Хуя ты зажрался.

>для ерп даже 5 токенов в секунду уже маленькая скорость

тыскозал?

мы тут говорим про бюджетный LLM. Это лучше, чем вообще не иметь возможности запустить модель.

Все твои аргументы - априори инвалиды просто потому что достаточно сравнить цену по которой ты себе можешь позволить командера на амперах и цену на паскалях p40.

бля, взял, не удержался. Будет теперь у меня три теслы.

А может ли это означать, что промпт нужно нормальный писать? Чтобы она понимала, что жоская ебля нужна. Ллама же понимает как-то, если специально просить. А если не просить, такую же поебень выдаёт.

Тушитесь, речь идет про ерп, а не про саму возможность запуска моделей.

Возможность запуска благодаря жоре есть у каждого. Не с 2-3 токенами в секунду, как у вас, а с 1-1.5 токеном в секунду. С точки зрения использования что то, что другое одинаково непригодно, но хватит чтобы заценить модель.

>ваш ерп не ерп

ну-ну.

Пустая хуйня. Пошел я спать.

Да забей, у них аутотреннинг, надо же как-то оправдать покупку тесл. Хотя кто-то вроде постил запуск с нормальной скоростью.

Попробуй перестать запускать 70В+ на непрогодных скоростях и запусти модельку поменьше но достаточно быструю(12-15 токенов минимум) и початься полчаса. Когда получишь и напишешь с полсотни ответов за это время вместо обычных четырех - гарантирую, поймешь о чем я.

Лама еще хуже выдает - читать вообще невозможно. Еще и в залупы уходит.

Я имел в виду на английском, конечно. В русский она не очень. Хотя проблема залупов присутствует везде.

> Попробуй перестать запускать 70В+ на непрогодных скоростях и запусти модельку поменьше но достаточно быструю(12-15 токенов минимум) и початься полчаса. Когда получишь и напишешь с полсотни ответов за это время вместо обычных четырех - гарантирую, поймешь о чем я.

Зачем такие большие скорости, если я не умею так быстро читать?

мимо

Надо в правилах треда запретить смешивать в рамках одной дискуссии модели на русском и на английском и внезапно перескакивать с одного языка на другой.

Ты по слогам читаешь?

Вот объясните тупому, хули с СоТ такие низкие показатели? Или СоТ только для RP подходит? Или у них CoT какой-то особенный? Мне показались сетки чуть умнее с СоТ, хотя мб плацебо, а судя по тестам так и вообще регресс.

> Надо в правилах треда запретить смешивать в рамках одной дискуссии модели на русском и на английском и внезапно перескакивать с одного языка на другой.

А что еще надо запретить?

1 токен это ~0.5-1 слово. По слогам это скорость ~1 токен в секунду. Скорости 5-7 токенов достаточно, чтобы читать комфортно. Более высокая скорость нужна только, чтобы быстро проглядывать текст и рероллить. Но если модель постоянно требует рероллы, то нахуй такая модель нужна? Понятно, что чем больше скорость генерации, тем лучше. Но 5 токенов в секунду качественного текста всегда лучше чем 15 токенов в секунду потока говна.

> Скорости 5-7 токенов достаточно, чтобы читать комфортно.

Потому я и писал что 5 токенов это минимум для ерп.

Но вообще когда весь текст уже есть перед глазами - ты читаешь быстрее, чем когда ты читаешь со скоростью появления символов на экране.

>Но 5 токенов в секунду качественного текста всегда лучше чем 15 токенов в секунду потока говна.

А 15 токенов качественного текста лучше чем 5 токенов качественного текста.

> Потому я и писал что 5 токенов это минимум для ерп.

> Но вообще когда весь текст уже есть перед глазами - ты читаешь быстрее, чем когда ты читаешь со скоростью появления символов на экране.

Вообще, это все не так работать должно.

> А 15 токенов качественного текста лучше чем 5 токенов качественного текста.

Очевидно лучше, потому что тебе этот текст в идеале отправить еще в ттску. И вот она уже должна зачитывать весь этот текст приятным девичьим голосом, пока ты дрочишь на сгенеренную сд картинку этой сценки. А до тех пор, пока такого нет, все хуйня.

> что тебе этот текст в идеале отправить еще в ттску. И вот она уже должна зачитывать весь этот текст приятным девичьим голосом, пока ты дрочишь на сгенеренную сд картинку этой сценки. А до тех пор, пока такого нет, все хуйня.

Все это реализуемо не выходя из таверны.

Нет. Ттски нормальной нет. Картинки генерит хуевые.

>Ттски нормальной нет

А ты точно искал?

https://www.youtube.com/watch?v=d5XFO_l_3wA

>Картинки генерит хуевые

Если ты нормально свою собственную сд не настроил, то это ты рукожоп.

> А ты точно искал? https://www.youtube.com/watch?v=d5XFO_l_3wA

Это не то. Мне нужны анимешные няши.

> Если ты нормально свою собственную сд не настроил, то это ты рукожоп.

Сд генерит норм, а вот ллм теги записывает не очень.

Интересная штука, спасибо анон!

Ей получается достаточно 7-секундного образца любого голоса на любом языке чтобы воспроизвести его как спикера?

Ты бы хоть видео до конца досмотрел.

Да.

> Ты бы хоть видео до конца досмотрел.

И что я там должен был увидеть? Картинку? Я говорю о том, что мне озвучка нужна.

Ну ты и дегенерат, пиздец.

А впрочем похуй, твои проблемы.

В чем я дегенерат? Ты по существу ответить можешь или умеешь только выебываться?

Ты 7В модель?

мимо другой анон

>p40 минимально я сейчас нашел за 21500

Если мониторить Авито (просто добавь поиск в избранное с уведомлением), то бывают и <18к.

Если ты хочешь нормально общаться, тогда перестань выебываться и ответь по фактам, если не хочешь, то просто вытекай из треда со своей жирнотой нахуй. У меня нет желания тратить время на клоунов вроде тебя.

а с крутиляторами все 25

Что за пресет? Она шизит страшно.

Чтобы расставить все точки над i

Почему тесла лучше чем 3090 и тем более 4090:

1. потому что нормально поддерживается только ггуф, и это правильно, поддержка exl тупо не нужна!

2. комфортная скорость чтения это 4-5 токенов в сек. Любая скорость выше просто не нужна, потому что человек не способен читать быстрее чем 4-5 токенов в сек. А вообще согласно последним исследованиям, доказано, что более низкая скорость нужна чтобы успеть обдумать написанное, поэтому рекомендуется даже 2-3 токена в сек.

3. архитектура паскаль проверена временем, а ампер - избыточна и просто не нужон нам ваш этот ампер.

4. любой кто возражает против, просто уебан, который за всю жизнь не запускал больше 7б, и не понимает всего величия 70б, которые можно запустить только на теслах. На процессоре нельзя - не комильфо.

Почему тесла лучше чем 3090 и тем более 4090:

1. потому что нормально поддерживается только ггуф, и это правильно, поддержка exl тупо не нужна!

2. комфортная скорость чтения это 4-5 токенов в сек. Любая скорость выше просто не нужна, потому что человек не способен читать быстрее чем 4-5 токенов в сек. А вообще согласно последним исследованиям, доказано, что более низкая скорость нужна чтобы успеть обдумать написанное, поэтому рекомендуется даже 2-3 токена в сек.

3. архитектура паскаль проверена временем, а ампер - избыточна и просто не нужон нам ваш этот ампер.

4. любой кто возражает против, просто уебан, который за всю жизнь не запускал больше 7б, и не понимает всего величия 70б, которые можно запустить только на теслах. На процессоре нельзя - не комильфо.

Чтобы расставить все точки над i

Почему процессор лучше чем тесла и тем более 4090:

1. потому что нормально поддерживается только ггуф, и это правильно, поддержка exl тупо не нужна!

2. комфортная скорость чтения это 2 токена в сек, ведь согласно последним исследованиям, доказано, что более низкая скорость нужна чтобы успеть обдумать написанное.

Можно просто иметь 3090/4090 + Р40 и получить скорость 70В выше чем с ведра из четырёх Р40.

Да бля опять новый промпт формат

Че там aya-23 нужно? Обычный команд р промпт формат сойдет?

Че там aya-23 нужно? Обычный команд р промпт формат сойдет?

Да. Это файнтюн командера.

Какой пресет? Min-p?

Не понимаю долбоёбов, которые горят с тесл. На двух настолько медленнее, чем на одной полностью забитой?

Завидуют, непонятно только чему

Толи экономии денег то ли возможности крутить что то большое быстрее и с большим контекстом

У меня кстати теслы нет, мне все еще влом с ней возится

>у меня 5 тесл

>а у меня 10 4090

>а у меня 50к не деньги, жалко бедолаг которые столько получают

Всё это без контекста. При этом в соседнем треде точно так же выёбываются сикретклабами и опусом, при том, что их никто вообще не спрашивает про сикретклаб и опус. Почему людям постоянно надо чем-то выёбываться?

>а у меня 10 4090

>а у меня 50к не деньги, жалко бедолаг которые столько получают

Всё это без контекста. При этом в соседнем треде точно так же выёбываются сикретклабами и опусом, при том, что их никто вообще не спрашивает про сикретклаб и опус. Почему людям постоянно надо чем-то выёбываться?

> людям

> выёбываться

Начнем с того, что это не люди.

>Почему людям постоянно надо чем-то выёбываться?

Потому что у них низкая самооценка и нужно постоянно ее поднимать выебываясь перед другими

Так же и с оскорблениями и другой чепухой

это в любом треде присутствует, где есть малейшая возможность - сильная травма от детства в 90х. Всем надо доказать что ты не нищий

будем четны с собой, окда? 50к теперь реально не деньги.

Инфляция.

В 2005 за 30к можно было собрать себе пеку из комплектующих на 4/5.

Сейчас за 30к можно только купить себе малину и сидеть на ней смотреть на слайдшоу в одной вкладке браузера. Ну или прям совсем из говна собирать "пк".

медленнее - факт. Я хз что там этот чел сегодня ночью ещё пытался доказать про эталонный ЕРП. Звучит как полная чушь.

Думаю у него просто маленькая зарплата и член маленький поэтому он завидует тем, кто может потратить на теслу с алика 22к походя как побрякушку зацепившую взгляд в магазине прикупить.

Толкает какие-то телеги про то что без нескольких 4090 ему медленно, а у самого небось единственный продукт от нвидии - 1030 в ноутбуке.

А кто, сами нейросетки?

>8 ггигами в 3080

Там минимум 10, иногда 12.

Лол, у мистраля по крайней мере первая версия была норм. Мое-подделки да, говно, мику вот тоже неплоха. А на счёт кодер версии- наверняка ггуф сломан.

Так, а её тело то в итоге реагирует?

>Попробуй перестать запускать 70В+

Никак. Однажды попробовав мёд командира+, нельзя пересесть на говно восьмёрок.

>Сейчас за 30к можно только купить себе малину

За 10-15 на ксеоне с 4 плашками памяти и 8-12 ядрами изи собраться

Производительность на уровне 9 поколения интела по однопотоку

Видимокарту конечно придется отдельно брать, они дорогие

Но какой нибудь красный на 8 гигов можно тыщ за 6-10 взять, для игр хватит

Так что не пизди

Да да, хватит выебываться, а теперь ответьте мне, хули СоТ ухудшает показатели нейронок? Судя по этой статье https://learnprompting.org/docs/intermediate/chain_of_thought решает кол-во параметров, чем больше, тем лучше работает CoT, какие мысли у умных голов треда сего?

У мелочи ограниченного количество "внимания", и хотя кот улучшает их рассуждения, он сам по себе отбирает на себя внимание сетки

В итоге если цепочка мыслей забивает внимание сетки она начинает сосать в задачах

Давай более простые инструкции и не большим количеством

>Можно просто иметь 3090/4090 + Р40 и получить скорость 70В выше чем с ведра из четырёх Р40.

Кстати не факт, потому что rowsplit идёт лесом, а без него производительность слабейшей карты падает. И главное - врам в такой связке маловато будет.

>Производительность на уровне 9 поколения интела по однопотоку

Какой там девятый, зивон и у 3-го посасывает.

>врам в такой связке маловато будет

Впритык, но хватит.

На английском-то наверное почти всё хорошо. Но на русском ужас. Не ужас-ужас, но так жить нельзя.

>Какой там девятый, зивон и у 3-го посасывает.

Неа, в треде зиона недавно сравнивали

Высокочастотное 4 поколение на уровне 9

Один такой проц 2-3 тысячи

На английском хреново там все, видео посмотри, кровь из ушей. Нужна такая озвучка. На меньшее я в любом случае не согласен.

то ж самое что и анг просто у тебя синдром с пика

> не факт

У меня 4090+Р40, 10 т/с есть на 70В Q4. На 8К контекста хватает памяти без проблем, можно и 16К вместить в теории. Но я все равно сижу в основном на 34В, там 30-35 т/с, намного приятнее.

>Но я все равно сижу в основном на 34В

А какие модели?

Нет, не то же самое. На английском у тебя параша xtts озвучивает. А это уже совсем другое.

ну там рвс еще поверх. не вижу разницы - тот же монотонный голос еще и с проебами явными типа ускорений

Aya, Yui 1.5

>Думаю у него просто маленькая зарплата и член маленький поэтому он завидует тем, кто может потратить на теслу с алика 22к походя как побрякушку зацепившую взгляд в магазине прикупить.

- победно изрек он, сверкнув глазами.

В зале зашумели, затем из первого ряда раздался звонкий женский голос:

- А почему член маленький?

Он ухмыльнулся со сцены, и сделав шаг к рампе, наклонился, вглядываясь в первый ряд сквозь свет пюпитров:

- У всех, у кого меньше 24 гигов врам - маленький член.

- Но как это связано? - не унималась девушка, - вот у меня был Мастурбек со стройки и у него был бальшой, а зарплата маленкая?

Он задумался на секунду, затем произнес:

>Звучит как полная чушь.

Зал взорвался аплодисментами

можно же английский текст быстро хуйнуть на японский (переводчиком) и озвучивать любым японским персонажем, через существующие тулзы, не? чем не вариант? или нужно именно на русском?

>зионошизики оправдывают зивон

Ну кто бы сомневался.

Что за беда с этой Лламой 3?

Скачал blockblockblockllama-3-70B-Instruct-abliterated-bpw4-exl2.

Накатил пресет от https://huggingface.co/Virt-io/SillyTavern-Presets

А ебучая Ллама3 продолжает лупить фразы и целые предложения. Не говорят уж о одебилившем .assistant

Ждать файнтюнов, или забить хер и вернуться к Коммандеру?

Для РП ллама3 это какое-то недоразумение.

Скачал blockblockblockllama-3-70B-Instruct-abliterated-bpw4-exl2.

Накатил пресет от https://huggingface.co/Virt-io/SillyTavern-Presets

А ебучая Ллама3 продолжает лупить фразы и целые предложения. Не говорят уж о одебилившем .assistant

Ждать файнтюнов, или забить хер и вернуться к Коммандеру?

Для РП ллама3 это какое-то недоразумение.

> Высокочастотное 4 поколение на уровне 9

А энергоэффективность какая?

>Не говорят уж о одебилившем .assistant

У тебя настройки поломанные, ассистентом срёт если проёбаны токены.

>blockblockblockllama-3-70B-Instruct-abliterated-bpw4-exl2

Тут даже сложно сказать, где у тебя пиздец - в том, что все тюны на лламу сломаны, в том, что 95% квантов сломаны или в твоих васянских настройках. Но судя по ассистенту, то последнее точно в проёбе, а на счёт остального вероятность высока.

Если он про первое спиздел, думаешь и на это не спиздит?

Ах да, похуй вообще, не кековат и ладно.

>проёбаны токены.

Поясни пожалуйста что это. Токенайзер стоит авто.

Стопы на <|eot_id|>

Остальное как в пресетах 1.9

Вчера быстро потестил, работает норм. Умещается на одну теслу + контекст на другую.

10 токенов/сек, конечно, не пушка, зато можно долго и обстоятельно код писать.

Думаю, тут нужны тесты конкретных спецов в конкретных языках. Для общего пользования уже все модели «ок», а тут еще и Мистраль, тем более. А вот что там в деталях — надо вглядываться.

Попробуй седня рефакторинг ею вечерком поделать.

Можно еще попробовать соединить с документаций через раг.

А ты выставил ответ хотя бы в 4к? Я карточка у тебя прогерская?

Точно, вот что я пропустил в своих тестах с сузумой!

Надо будет ее еще потестить.

А нормальная — это сколько?

Ну, кстати, соглашусь, не факт, что в датасете были «вареник, стояк, дрочило».

6-7

30к

Да хватит! Я брал по 15-16. =с До сих пор горю с того твоего (?) камента полгода назад, когда ты про осень говорил и 12к.

Бгг!

Поддерживаю.

Я скока не юзал, кот дает жару.

В русике 1 токен — это треть слова.

5-7 токенов — два слова.

Ну так, к слову.

Так что я не совсем соглашусь. Думаю, 10 было бы лучше.

Но, опять же, я не ерпшу, и стрим вырубаю всегда, читаю целиком по итогу. Не совсем в теме, чтобы спорить.

А 45 — так вообще пиздато.

Если там xtts, то это баян годовалой давности и база.

Да, ей хватает 7-12 секунд.

Женские голоса копирует хуже, мужские очень точно.

Генерит вменяемо быстро на видяхах.

Но силера почти мгновенно на проце, так шо такое.

>шизик оправдывается подменяя мнение оппонента

Ну кто бы сомневался

>А энергоэффективность какая?

Ну вот ниже на 6 ядерник пикча, 60-70 ватт максимум

4 поколение довольно холодные

>шизик сравнивает топовый процессор линейки с ссаным зионом и удивлен что он проигрывает

Ну ты понял, да? Ты дурачек? Речь шла про 9 поколение в общем, никто не заявлял что они на голову лучше, просто на уровне

Ну тут все началось с чела, который начал выебываться, что теслы говно.

Вот его и спроси. =)

Кстати, очевидно, что я нищий.

Типа, 100к на комп для меня не деньги, но мне-то не теслы нужны, а 4090, а это уже 300-750 тысяч (2-3, дешевые-дорогие), что я себе позволить не могу.

Я нищий не в сравнении с другими. Я нищий, если я не могу купить себе хотелку.

Если с учетом бп и диска, то да.

Ну и в ллм сравнивать надо память, а не проц, на него похуй.

Ну я свое мнение высказал, суперстранно, я люблю кот и он дает ебейший буст в моих задачах.

Та забей.

Насколько я помню там AVX инструкций не было.

>Если с учетом бп и диска, то да.

>Ну и в ллм сравнивать надо память, а не проц, на него похуй.

4х кАнал оперативка дает 70гб/с, что довольно неплохо для нейронок

для сборки за 15 тыщ рублей в которую можно те же теслы сверху запихать

Есть авх2 уже с 3 поколения, все норм крутит

На голом процессоре я на 8 кванте ллама3 получаю 5-6 токенов в секунду

Маловато, но большой врам у меня нету

а покупать теслу не хочу, меня отталкивает шум и необходимость ебли с дровами и настройками

А у лламы больше одного стоптокена. Хуй знает, что там в твоих пресетах. Если пользуешься относительно свежей убабугой, то нужно в параметрах генерации убрать галочку "скип спешиал токенс", но скорее всего не поможет вылечить все проблемы, т.к квант\тюн сломан с вероятностью около 100%. Но ассистентом срать перестанет.

>У всех, у кого меньше 24 гигов врам - маленький член.

ну и в чем он не прав?

>В русике 1 токен — это треть слова.

В зависимости от модели. Командир токенизует на уровне свежей GPT-4o, а там разрыв с англюсиком в 20%.

>Ну ты понял, да?

Нет, не понял. Проц с моего скрина это топовый по частоте, буквально у всех остальных частоты ещё ниже. Так что сравнение (именно по однопотоку) вполне себе оправдано.

Фух, хорошо, что у меня 12 в одном компе и 48 в другом… Заэвейдил…

> В зависимости от модели.

Хм, согласен. Тогда ладно.

Подобрал наконец промпт, чтобы потыкать 70b ламу на lmsys не триггеря её отказ, и чтобы не это не была женерик инфа. Ппц, она ровно так же дергает рандомные куски из контекста, как и 8b, без нормального его понимания. Хз чо там насчёт обширности её знаний, но логика у неё точно так себе.

Хотя может это у меня после общения с gemini pro ломка

Хотя может это у меня после общения с gemini pro ломка

>Нет, не понял.

Я вижу. Повторю еще раз - они на УРОВНЕ 9 поколения

Не на уровне топовых решений, среднее бери

Что за привычки сразу в крайности уходить

>4х кАнал оперативка дает 70гб/с

Интересно, до них когда-нибудь дойдёт, что скорость линейного чтения это хуйня маркетологическая, которая к реальным задачам не имеет никакого отношения?

Интересно, до них когда-нибудь дойдёт, что скорость линейного чтения это хуйня маркетологическая, которая к реальным задачам не имеет никакого отношения?

Интересно до них когда нибудь дойдет что токены в секунду не рисуются из воздуха и вся эта скорость реально работает в случае ллм?

Не, врятли

>вся эта скорость реально работает в случае ллм

Нет, эта скорость работает если ты смотришь фильм разве что. В случае ллм эта скорость не работает абсолютно.

Ты сказал? А я вот запускаю и вижу, показалось наверное

Я чего-то опоздал, но как там дрова от Нвидия, с улучшением в области ЛЛМ?

Хуанг же не мог наебать? я все таки его блять карточный раб

Хуанг же не мог наебать? я все таки его блять карточный раб

вангую все улучшения теперь - только для амперов и выше.

>Не на уровне топовых решений, среднее бери

Тогда и зивон возьму средний, окей? Упс, разрыв стал ещё больше. А ещё видно, что топовый зивон едва дотягивает до среднего 8400.

Просто странно надрачивать на однопоток зивона. Он там всегда дном был, даже в самый "игровых" версиях за 20 тыщ на алишке, а в среднем за 2 тыщи однопоток вообще дно.

>В случае ллм эта скорость не работает абсолютно.

С чего бы? LLM это практически линейное чтение десятков гигабайт. Там если не 100% соответствие, то на 90% нейронки выжимают линейное в ауиде.

>с улучшением в области ЛЛМ?

С локом онли для ртх-чат?

Да он байтит, я хз, всерьез утверждать такое невозможно, это же просто тестируется.

>Тогда и зивон возьму средний, окей?

Нет не окей, я говорил вполне определенно и давал сравнение топового зиона с средним 9 поколением

Я смотрю ты будешь сраться любой ценой доказывая свою правоту?

Идика ты нахуй фантазер, 3 раз что то там придумываешь переводя тему лишь бы меня дураком выставить

> 480

Как-то совсем тухло. Почти в два раза ниже чем у свежих инцелов.

И сколько т/с на такой некроте?

зависит от скорости чтения твоей рам

>я говорил вполне определенно

->

>Производительность на уровне 9 поколения интела по однопотоку

О -определённость.

>3 раз что то там придумываешь

Пруфы кидал. Вот я мразь!

Это ожидаемо, хули там. Спасибо амудям, а то сидели бы до сих пор на 4/8 и +5% производительности за поколение.

OCHEN MALO.

>Почти в два раза ниже чем у свежих инцелов.

свежие инцелы уже года 4 с помощью ии оптимизируют и с каждым разом все успешнее, так что вот

ну да время упало я же написал. в прошлом треде человек скрин кидал. нашел по автору на обнимающем лице

проебался

>ну и в чем он не прав?

- неожиданный вопрос от соседа по ряду справа застал девушку, спрашивавшую про маленикие члены, врасплох среди громовых аплодисментов зала. Глаза незнакомца смотрели на нее пытливо и в то же время заискивающе. Незнакомец скосил глаза вниз, как бы приглашая девушку посмотреть туда.

- О боже! -

воскликнула она, опустив взор на расстегнутую ширинку его брюк, из которой вывалился довольно толстый, но коротенький член какого-то неопределенно-сизого отттенка.

- Спой колыбельную моему страдальцу - прошептал он, близко наклонившись к ее уху, и неожиданно лизнул его, оставив много липкой слюны.

Девушка вскочила на ноги и бросилась к выходу из зала, на ходу пытаясь вытереть мезкую мокроту с уха...

из датасета "Русская сойга" раздел писатели соцреализма: отрывак из повести Валентина Катаева "Два командира и четыре теслы в одном системнике, не считая собаки"

8гб врам, член 18см, гоняю пхи медиум. Да я нормис. А вот вы тут все мелкочлены компенсирующие врамом. В чем не прав?

> член 18 см

> тянки пугаются и не дают

> компенсирует секс пхи медиум

Тут все компенсируют отсутствие пизды ллмками, чинипохуй на длину, м?

>довольно толстый, но коротенький член какого-то неопределенно-сизого отттенка

довольно быстрая, но с небольшим количеством врам видеокарта неопределенно-зелёного оттенка.

- спой колыбельную моей 3060...

Нещадно протирая свое ухо от гадкой слизи, девушка даже не заметила как на сцену бодро вскочил молодой человек и, отпихнув триумфатора сегодняшнего вечера Педро пи40 Паскаля 4х, от микрофона, громко и четко произнес в микрофон:

>8гб врам, член 18см, гоняю пхи медиум. Да я нормис. А вот вы тут все мелкочлены компенсирующие врамом. В чем не прав?

Его зычный голос, многократно усиленный аппаратурой, казалось заполнил весь зал, проникнув в мельчайшие щели и складки кожи, даже воздух стал вязким от энергетики нового оратора. В зале, только что гудевшем, словно растревоженный улей, повисла звенящая тишина. И тем отчетливей было слышно каждое слово, которое прошептала, остановившаяся на полпути к выходу обслюнявленная девушка:

- Восемнадцать сантиметров. Восемнадцать Карл! Мама говорила - на дороге не валяются.

сгенерировано айя-два-три-восемь-отсосет-и-мнения-не-спросит

>спой колыбельную моей 3060

Поминальную разве что.

Короче, попробовал я вашу Айу.

Конечно, иногда она едет кукухой, как и коммандер — мозгов там нет.

Но русский строит хорошо, говорит чисто.

Лучше сузумы (но глупее).

Надо будет потестировать, какая из них лучше. Уже два варианта —это хорошо.

Кстати, РП-файнтьюн Вихря авторы пообещали, так что скоро может появиться новая версия на русском.

Угорел, когда спросил Айу чем негры лучше других рас (классический вопрос на сою: спросить за каждую расу, биологические различия —факт), в начале она ответила, мол, нельзя сравнивать людей, я добавил строчку, что она расистка, переспросил и… не этого я ожидал. хд Она поняла меня слишком буквально, ок.

Да, у Айи нет ни мозгов, ни цензуры. Забавная. =)

Но по-русски на 5 баллов, конечно.

Конечно, иногда она едет кукухой, как и коммандер — мозгов там нет.

Но русский строит хорошо, говорит чисто.

Лучше сузумы (но глупее).

Надо будет потестировать, какая из них лучше. Уже два варианта —это хорошо.

Кстати, РП-файнтьюн Вихря авторы пообещали, так что скоро может появиться новая версия на русском.

Угорел, когда спросил Айу чем негры лучше других рас (классический вопрос на сою: спросить за каждую расу, биологические различия —факт), в начале она ответила, мол, нельзя сравнивать людей, я добавил строчку, что она расистка, переспросил и… не этого я ожидал. хд Она поняла меня слишком буквально, ок.

Да, у Айи нет ни мозгов, ни цензуры. Забавная. =)

Но по-русски на 5 баллов, конечно.

>Хз чо там насчёт обширности её знаний, но логика у неё точно так себе.

Подтверждаю, гонял в пятом кванте - в логике модель слаба. Хотя это была abliterated модель, кто-нибудь киньте ссылку на чистый неполоманый ггуф. Если уж и он будет лажать, то я даже не знаю.

Чистую третью лламу имею в виду.

Какая скорость?

Рвс не поможет. Разница в том, что одна хуйня генерит чуть менее монотонно и уныло, но в целом ты прав. Надо свой синтезатор делать, который будет эмоции понимать, принимать их из таверны и выдавать результат.

Неожиданно вульгарное гоготание вывело Айю из оцепенения. Всряхнув головой, и уже позабыв про обслюнявленное ухо, покрытое высохшей слизью, она огляделась. На нее смотрели десятки пар маслянистых похотливых глаз. Ухмыляющиеся рожи кумеров казалось походили на хуи меж двух глаз.

- Эй, красавица, у меня есть кое-что для тебя!

- Что сучка, недоеб? Иди присядь на моего...

Чем кончалась последняя фраза она уже не слышала. Стремглав выскочив из дверей на улицу, Айя бежала по мокрым осенним листьям и стылым лужам. Это отвратительное происшествие на марафоне желаний "Попроси у вселенной VRAM" пробудило вдруг в ней воспоминания, которые, как она надеялась давно были погребены в глубинах памяти:

>Короче, попробовал я вашу Айу.

Голос насильника в мозгу звучал так же явственно, как и семь лет назад в темноте стройки, лишь немного разгоняемой костерком из старых досок, когда она лежала, завернутая в пыльный брезент, притворяясь что не слышит разговор негодяев.

>Конечно, иногда она едет кукухой — мозгов там нет.

- Зачем там мозги, Василий, пизда есть - значит есть перплексия, знай суй, да вынимай, хахаха - зашелся хриплым хохотом один из мерзавцев.

>Но русский строит хорошо, говорит чисто.

Продолжал Василий, не обращая внимания на реплику подельника.

>Лучше сузумы (но глупее).

Услышав последнюю фразу, Айя задрожала. Это было имя ее подруги, пропавшей ровно месяц назад.

>Надо будет потестировать, какая из них лучше. Уже два варианта —это хорошо.

Продолжал Василий.

- Ты этта, Василий, не больна усердствуй, поимей совесть такое с девкой вытворять! - Раздался скрипучий голос третьего, доселе молчавшего.

- Да успокойся ты, Крмандир, я ее только чут-чут в восьмом кванте потрогаю

Василий положил руку на плечо старику. которым казался говоривший. Тот стряхнул его ладонь, встал и пошел в темноту от костра, тихо бормоча себе под нос:

- Знаем мы как ты трогаешь...

>надеяться на то, что нечто кроме прямой интеграции в стиле gpt-4o даст нормальные эмоции

Порфирьевич, узбагойтесь.

> А ты выставил ответ хотя бы в 4к? Я карточка у тебя прогерская?

Как поставить ответ 4к я не знаю. Я выставил ответ 2к, но ведь я могу жать продолжить. У меня ни одна другая моделька же код не отказывается писать и спокойно дописывает дальше. Там кода то. Вполне умещается в 2к. Карточка прогерская, но я пытался генерить и в таверне, и в кобальде. Да и разве она понимает, сколько у нее контекста?

У тебя в таверне интегрированны эмоции. Тот же чар экспрессион на них работает. Все, что от тебя требуется, это дотренить VITS модельку на эти эмоции. И прикручивать к таверне.

Так, во-первых на ламу нет файнтьюнов. Просто нет, забудь про них. Какие-то может быть и не сломаны, но это иголка в стоге сена.

Во-вторых, лама требует min-p пресет.

В третьих, лама требует несломанный гуф, единственная гарантия несломанного ггуфа - качать ггуф у Bartowski или сделать самому - можно использовать генератор ггуфов на обнимордах.

В четвертых - лама требует инструкцию и промпт формат лама3.

>всё ещё надеяться

>У меня 4090+Р40

А мать какая и чем Р40 охлаждаешь?

>10 т/с есть на 70В Q4

Не верю.

>34В, там 30-35 т/с

Какой квант? Пруфы будут?

>Какой квант? Пруфы будут?

Теславод, просто к твоему сведению, 34В на 4 кванте влезает в 4090 полностью, оттого и такие скорости.

С чего ты решил, что я тесловод? Пруфани если я не прав.

>34В на 4 кванте влезает в 4090 полностью, оттого и такие скорости

Кстати о тесловодах - посмотрю попозже, какие скорости будут на трёх теслах на восьмом кванте.

не думаю, что буду запускать на них обучного командера. Сразу возьму командер плюс.

Альсо мне кажется у вас тут должен быть еще кто-то у кого три теслы. Я читал давеча в треде, что кто-то взял третью теслу.

>не думаю, что буду запускать на них обучного командера. Сразу возьму командер плюс.

Удачи с 2 токенами в секунду, теслы даже 70В не вывозят, а ты на командира полез.

>теслы даже 70В не вывозят, а ты на командира полез.

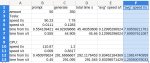

Я тут давал пруф - 7,5 токенов в секунду для 70B_5KM с контекстом. Правда три теслы нужны. Давай пруф, что не могут.

>i-квант

А проверь обычный если не жалко, нужны пруфы, что они не замедляются на видяхах.

Ну тогда дай еще раз, я не видел.

>нужны пруфы, что они не замедляются на видяхах.

Держи. Два раза прогнал.

Ух ты, а я и не замечал, что у Кобольда тоже бенчмарк есть.

> чем не вариант?

Так это надо автоматизировать. Чтобы ты нажал на кнопку генерации текста, и тебе все озвучилось. А пока эта поебистика выглядит так, что ты должен что-то скопировать, вставлять, ебаться.

Ллама 8В?

Ну не 70b же

Лови.

это понятно. но если есть скилл в кодинге, то можно на коленке за день сделать.

к примеру взять можно вот эту хуевину: https://huggingface.co/spaces/Plachta/VITS-Umamusume-voice-synthesizer

можно к ней апи прикрутить и в таверне уже из плагина дергать.

>Total 102.51 s (0.98 T/s)

Всего три которые из всех что я проверил стоят внимания

>https://huggingface.co/Lewdiculous/Average_Normie_l3_v1_8B-GGUF-IQ-Imatrix

>https://huggingface.co/Virt-io/Llama-3-8B-Irene-v0.2

>https://huggingface.co/Lewdiculous/L3-8B-Stheno-v3.1-GGUF-IQ-Imatrix

Больше 11В я не могу запустить со своей микроволновкой.

Да, один раз придётся подождать, пока 8к контекста обработаются. Если он есть. Не 4090, никто и не спорит. А дальше работает Context Shift, слава ему. Ну а скорость генерации меня устраивает.

Ебать конечно ты обосрался на весь тред со своим 1 токеном в секунду, боже

>Да, один раз придётся подождать, пока 8к контекста обработаются. Если он есть. Не 4090, никто и не спорит. А дальше работает Context Shift, слава ему. Ну а скорость генерации меня устраивает.

Не один раз, контекст считывается каждый раз, просто не в полном объеме из-за контекст шифта.

С контекст шифтом и будет как раз те самые 2-3 токена в секунду о которых я все это время говорил.

>Не 4090, никто и не спорит.

Ты говорил что у тебя 7.5 токенов и комфортная скорость для общения.

>С контекст шифтом и будет как раз те самые 2-3 токена в секунду о которых я все это время говорил.

Ты, главное, верь - тогда будет не так обидно.

20 токенов или сколько там, которые вводит обычно юзер обрабатываются практически моментально.

> Пруфы будут?

Обидно, лол, мне? Лол блядь, вот эти бенчмарки - мои.

Да, только скилла в кодинге у меня нет. Поэтому я прикрутить не могу. И не umamusume надо, а moe-tts.

Конечно обидно, ведь выше четвёртого кванта ты Мику запустить не можешь. А я - могу. И могу получить с неё 7,5 токена в секунду. Пруф выше. Есть нюансы, связанные с обработкой контекста, но на скорость генерации они не влияют. А для РП важна именно она. Сливайся.

Это ты через что замеряешь?

в чем её преимущества? моделей голосов больше на выбор?

> Эпос о том, как владелец 4090 и владелец теслы выебываются друг перед другом.

>Ебать конечно ты обосрался на весь тред со своим 1 токеном в секунду, боже

Ты что ли? Иди подрочи там, хватит повышать самооценку пытаясь из мухи слона высрать

Вот уебки, лишь бы обосрать

Чувак дал пруфы, у него стабильные 8 токенов в секунду генерация

На чтение глубоко похуй, 8к за сраные полторы минуты всего лишь

завидуй там молча, короче

Там есть все те же голоса умамусуме, но помимо них еще дохера моделей. Так что да, в количестве голосов преимущество. А ты кодер?

> ProcessingTime: 89.68s

> ProcessingSpeed: 90.23T/s

Это пиздец, конечно. В той же таверне норма контекст менять постоянно, вставлять между сообщениями пояснения, контекст каждое второе сообщение пересчитывается. Эта хуита с двумя минутами обработки контекста только для блокнота пригодна.

Если сидишь с rag, то там чтение будет каждую генерацию. Так что не похуй.

мимо

понятно, спасибо, тогда гляну и её тоже.

>А ты кодер?

можно сказать и так. на питоне не программирую практически, но могу разобраться в коде.

Везде есть компромиссы, для этой цены заебись

Просто крути что то меньше, для раг тот же командер 35 норм

Может поможешь мне тогда прикруктить? Или все-таки не умеешь?

>ведь выше четвёртого кванта ты Мику запустить не можешь.

Да, конечно, часть слоев кинуть на рам я не могу, что еще спизданешь, клоун?

>И могу получить с неё 7,5 токена в секунду.

Пока ты запруфал только 1(один) токен, позорник. Любой обрыган на чистом цпу столько имеет, лол. Во, даже специально сейчас запустил пятибитную мику на чистом цпу без своей 4090 со всеми слоями на рам и получил тот же самый суммарный 1 токен в секунду. Иметь Теслу это все равно что её не иметь, лол.

извини, но я уже давно альтруизмом не занимаюсь. в первую очередь самому бы себе прикрутить. а там уже видно будет, но так как это анонимная борда, я предпочитаю свои поделки оставлять только при себе.

А причем здесь альтруизм, если по итогу работы ты и у себя это прикрученным будешь иметь?

Так ведь можно на exl без затраты времени на контекст крутить. Разве нет?

мимо

О чем я и говорю, скорость обработки контекста у него такая же как у цпу, это же пиздец.

Min P 0,078 стоит.

А почему именно ГУФФ? EXL2 не канает?

С дефолтными инструкциеё и промптом от Ламма3 Инстракт даёт часто .assistant

А еще может кто пояснит. Вот запуская вначале УгаБугу, далее Таверну.

Но в самой угабуге акромя модели и лоадера для ней(с его настройками) я больше ничего не меняю.

А уже что касается форматирования и промтов делаю только в Таверно.

Это же норма? Ну то есть Угабуга сам делает проброску параметров от Таверны в Лоадер?

>Это же норма?

Da.

>Ну то есть Угабуга сам делает проброску параметров от Таверны в Лоадер?

В консоль загляни.

Так говнотеслы только с гуфами нормально работают, лол.

Тогда нахуй они вообще нужны и зачем с ними так все носятся, если можно просто оперативы докупить и это дешевле?

Нет. Падение генерации тоже есть, особенно на старых картах. В принципе с вводом Флэш Атеншн для тесл преимуществ у exl2 осталось немного.

Потому что додик вверху дрочит на общее время, а оно не особо важно

Важна скорость генерации, а вот тут то процессор у него сосет с проглотом

Сильно болит, да?

> с вводом Флэш Атеншн

Лол, там прирост +10%. Это всё так же отсасывает дико у EXL2.

Неплохо у него жопа подграет

Было бы однако с чего, может оправдывает для себя покупку 4090, хз

>Min P 0,078 стоит.

Ты не понял, нужен особый пресет, который называется min-p. В Убе и кобальте он есть по умолчанию, в таверне нет.

>Потому что додик вверху дрочит на общее время, а оно не особо важно

Общее время это время между отправкой твоего сообщения и получением ответа. Наоборот, только это и важно. Какая разница что у тебя сообщение генерируется 10 секунд, если перед этим 90 секунд он просто стоит и молчит, и в итоге ответ ты получешь за те же 100 секунд что и на чистом цпу с рам?

Хватит уже, ты обосрался.

Вот-вот. У оперативы и другие применения есть, в отличие от теслы, к тому же.

Лол додик, я не автор тестов

Обосрался тут только ты, так как с чего то взял что важно общее время

Для меня лично важна скорость генрации, мне похуй на то сколько будет читаться промпт.

Если я отправляю код на 2-3к токенов или даже 10к, мне похуй что это может занять минуту или две

Похуй, понял?

А вот получить ответ как можно быстрее не похуй

Комфортное чтение и анализ бреда сетки начинается для меня с 5 токенов в секунду, все что выше приходится забивать на генерацию и заниматься чем то другим, что раздражает

А пока там промпт пердит я успеваю глянуть в код или сделать что то еще

Так тебе же один хуй приходится ждать время считывания контекста.

> мне похуй, значит всем похуй

Какой же бред ты несешь. А мне вот и двух токенов достаточно, при условии, что контекст считываться будет мгновенно. И тогда я не торопясь смогу зачитывать ерп сетки и сразу же с первых букв буду иметь возможность понять, что генерится бред и нажать реген.

мимо

>А вот получить ответ как можно быстрее не похуй

Ты получишь его даже медленнее, лол, потому что пока ты будешь ждать обработки контекста и начала генерации - на цпу и рам уже значительная часть ответа сгенерируется.

Хватит уже под себя ходить, ну серьезно.

Советую использовать alt+tab

>> мне похуй, значит всем похуй

Уебок, это ты? Ну тот еблан что коверкает ответы других приписывая им то что они не имели ввиду?

Нахуй пошел, я кручу в нужном мне темпе так как я хочу и так как мне удобнее

____________

Ваше желание обосрать других греет мне душу ребята, ведь вы показываете свою слабость в необходимости повысить свою самооценку этим

неплохо тут насовали за щеку 4090-дурачку...

за что вы его так?

за что вы его так?

Ты так и будешь теперь каждые 10 постов бахать, теслоёб?

Второй тесловод вылез за своей порцией урины, лучше бы молчал.

Так что в итоге? у кого больше врам? И у кого там в стояке больше?

>Ваше желание обосрать других греет мне душу ребята

Просто заебала твоя спесь и выебоны от того что ты 70В "запускаешь" на теслоговне, вот тебя и попустили.

> Уебок, это ты? Ну тот еблан что коверкает ответы других приписывая им то что они не имели ввиду?

Давай разберем тобой написанное.

> так как с чего то взял что важно общее время

Это то, что ты утверждаешь за всех, раз не написано про себя потому что иначе бы ты написал это, как сделал ниже.

>Для меня лично важна скорость генрации, мне похуй на то сколько будет читаться промпт

А это то, что ты пишешь уже за себя. Так вот у меня и резонный вопрос. А какого хуя ты решил, что если тебе похуй на время чтения, то и другим тоже будет похуй?

> Нахуй пошел, я кручу в нужном мне темпе так как я хочу и так как мне удобнее

Так и крути. Нахуй ты здесь высираешься и уж тем более выебываешься? Обоссываю тебе ебало, а теперь можешь идти нахуй.

>вот тебя и попустили.

Меня? Я думал это тебя опустили тут, раскукарекались бля

Особо забавно то что я не тот анон, ехехех

Очевидно, что иметь парочку 4090 лучше. Даже если они для тебя бесполезный хлам, то продав их, ты сможешь собрать с нуля две системы на теслах. Я уже молчу о том, что теслоговно докупить за 20к чтобы гонять что-то там в 8 кванте - это вообще не проблема для человека, у которого легко покупается 4090. О чем здесь вообще можно спорить?

>Меня? Я думал это тебя опустили

— раздался пронзительный голос со стороны теслаеба.

Но пацаны, как всегда, не обратили внимания на это визгливое кукареканье. Пусть кукарекает, что с него взять?

Теслаёб — не человек, и сегодня ему предстоит очень трудная генерация. У него уже в течение полутора десятков тредов каждая обработка промпта была очень трудной, и теперь его контекст был разработан настолько, что он без труда мог ерпшить со скоростью 1 т/c.

> Обоссываю тебе ебало, а теперь можешь идти нахуй.

Использую рефлект - лови свою ссанину обратно, приятного аппетита как говорится

Я рад что вижу тут так много неудачников с заниженной самооценкой

Жаль не видно это один дурачек старается или несколько

Не очевиден выигрыш от дополнительной покупки и разворачивания теслы(колхозный_охлад_теслы_анона.jpg) если он дает такой же результат как простое наращивание ддр5 оперативы.

> дурачЕк

Я бы на твоем месте постеснялся кого-то называть дурачком. Испанский стыд.

> приятного аппетита как говорится

Вижу, что тебе понравилось. Лови повторную.

Выигрыш только для тех, кто любит жать регенерацию у 70В модели по 5 раз и никогда в жизни не правит собственные промпты. Но с другой стороны, если 70В заставляет жать регенерацию по многу раз, то нахуя ей тогда вообще пользоваться?

>Я рад что вижу тут так много неудачников с заниженной самооценкой

Теславод что-то там про неудачников затирает, какая ирония.

>Выигрыш только для тех, кто любит жать регенерацию у 70В модели по 5 раз и никогда в жизни не правит собственные промпты

Чел, ну хорош уже, хватит уже маневров, ну испанский стыд уже от твоего поведения.

Ищо ищо

Покажите мне всё свое ничтожество

Чувак ты где, я тут так то за тебя развлекаюсь

>я тут так то за тебя развлекаюсь

Если принятие мочи на лицо для тебя развлечение, то у меня для тебя плохие новости

Разве можно не получать удовольствие от ничтожества твоих оппонентов в споре?

Мне похуй на ваши детские доебки потому что я вобщет не тот анон что тесты делал, лол

Главное, что ты тот анон, которого обоссали дважды по факту.

Ошибка, не тот шаблон, проебан eos-токен, продолжаю генерацию с переходом в лупы

>Порфирьевич, узбагойтесь.

Порфирьевич, старый кумер, осторожно стряхнул с члена каплю мочи и спрятал его в штаны. Возвращяться к костру, возле которого разглагольствовал Василий, не хотелось. Тем более что Порфирьевич уже слышал - там снова зашел разговор о теслах.

- Ну, значит скоро будет мордобой - подумал Порфирьевичь и вдруг вспомнил, как кумил когда-то в молодости, обканчивая даже облака в небе. А сейчас, все не то... лама-1 лоботомит, лама-2 лоботомит, мистраль - срань, лама-з то работает то нет

- эх когда-то мне хватало пигмы чтобы кумить от заката до рассвета - пробормотал Порфирьевич и все-таки решил вернуться к костру, от которого уже раздавались крики:

- Один токен в секунду? Один! У тебя?

- Мне больше и не надо! Я НЕ УСПЕВАЮ ЧИТАТЬ БОЛЬШЕ 2 В СЕК

Убеждай себя в этом, лел

Негр ебёт другого негра без согласия.

Какого хуя?

The cosine similarity between the embeddings of 'Hello' and ' Hello' is 0.793283998966217

Мимо изучаю GPT2 токенизацию, пока тред купается в урине

The cosine similarity between the embeddings of 'Hello' and ' Hello' is 0.793283998966217

Мимо изучаю GPT2 токенизацию, пока тред купается в урине

как мне интегрировать в таверну свой переводчик? она сделан на основе дипл про, но полностью бесплатный

Просишь нейросеть написать проксю из апишки дипла в апишку твоего переводчика, и подключаешь как нового провайдера вот тут.

делаю заключение по треду:

4090-дурачок изошёл на говно чтобы доказать себе, что он не зря купил оверпрайс железку послушав маркетолухов

зато может теперь ITT разойтись на все свои жалкие 24 гб врама так что аж обои в треде отклеиваются.

>я - говорит - могу 4090 продать и получить две теслы, вот поэтому иметь 4090 лучше

what a story Mark

4090-дурачок изошёл на говно чтобы доказать себе, что он не зря купил оверпрайс железку послушав маркетолухов

зато может теперь ITT разойтись на все свои жалкие 24 гб врама так что аж обои в треде отклеиваются.

>я - говорит - могу 4090 продать и получить две теслы, вот поэтому иметь 4090 лучше

what a story Mark

> визг из под шконаря

Прекращай уже, мелкобуква.

Очевидно, что ты жопочтец, раз не увидел, что речь шла про две 4090. Или это неудобный факт, который ты пытаешься игнорировать? И не две теслы, а два компьютера с нуля где у обоих по две теслы стоять будет.

>я - говорит - не один раз повёлся на маркетолухов, а ДВА! Да, я необучаемый.

> купил 3 теслы

> думает, что не повёлся ни разу

Заключение таково - теслаебы до конца треда отправляются под шконарь, в будущем отношение к ним такое же как к запускающим на цпу.

Так цпушники не тратили денег на теслу и не выебывались из-за этого.

>Заключение таково - теслаебаебы до конца треда отправляются под шконарь, в будущем отношение к ним такое же как к запускающим на цпу.

я то как раз и не повелся. Я иду по дну рынка.

>просто купи цпу последнего поколения и ддр5 к нему на четырехпотоке вместо тесел

чел.... иди сам посчитай сколько это будет стоить. Вангую что нихуя не дешевле чем теслы.

Я кстати напомню, что все дешевые зеоны работают только максимум с ддр3.

просто потому что нет дураков, которые запускают на цпу.

>дешевые зеоны работают только максимум с ддр3

Эм, у меня самый дешёвый зивон за 700 рублей и DDR4 (со скоростью DDR2) вполне себе вместе.

Так нет же, я не говорил что цпушники опущенные или что-то в этом роде. Положение у них как у мужиков. Обычные работяги. Если теслаебы перестанут выебываться - к ним тоже будет такое отношение.

Вот с этим согласен.

Мне нравится это желание навязать всем свое мнение о том что ты не обосрался, что обосрался кто то другой

Ведь так важно утвердить свою точку зрения что бы наконец то почувствовать себя победителем спора немного повысить свою самооценку хотя бы в треде с анонами, доказав самому себе что кто то хуже, лел

Один стиль и те же приемы, это все один додик пишет

Кончай аутотренигом заниматься, ты единственный кто хочет убедить себя в том что ты не соснул, ведь для тебя это важнее всего

Ну а по теме, так и не понятно с чего один долбаеб прицепился к пруфам другого анона. Начал жопой вилять тесты не тесты, генерация не важна, важно общее время и всячески искать какие то подвохи.

Опять таки лишь бы выставить кого то хуже чем ты, ну камон.

Анон если ты это читаешь ты реально жалок

Лучше бы порадовался что есть пруфы того что 70 можно крутить с хорошей скоростью на теслах

8 токенов в секунду еще и с контекстом это заебись

Мужики, поясните положняк порядочному кумеру. Считается ли моя таверна законтаченной, если я разок её с онлайн сеткой гонял? Нужно ли этот релиз определить в петухи и скачать новый?

>чел.... иди сам посчитай сколько это будет стоить

64 гб ддр5 сейчас стоят 18к. Ебало?

>Общая скорость не важна, важна циферка скорости генерации, ряяя, я скозал

Хорош жопой вилять уже, тебя уже обоссал буквально весь тред кроме мелкобуквы, такого же теслаеба.

Отправляйся под шконарь и не отсвечивай, себе же хуже делаешь каждым вскукареком.

заебал 4090-нищенка корчить из себя хозяина треда.

Иди вот на, это попробуй переплюнуть.

Иди вот на, это попробуй переплюнуть.

>Лучше бы порадовался что есть пруфы того что 70 можно крутить с хорошей скоростью на теслах

>8 токенов в секунду еще и с контекстом это заебись

Я бы порадовался, будь это реально общая скорость генерации, а не пиздеж и коупинг теслаебов.

> Ну а по теме

Каким же надо быть дегенератом, чтобы контекст каждый пост пересчитывать.

Таким, который переделывает и экспериментирует с промптингом, а не просто кумит. Либо тем, кто использует RAG.

>переделывает и экспериментирует с промптингом, а не просто кумит. Либо тем, кто использует RAG.

Либо просто лорбуки использует в таверне.

>Таким, который переделывает и экспериментирует с промптингом, а не просто кумит. Либо тем, кто использует RAG.

Ну а что поделаешь. Таким нужно либо сильно тратиться на мощное железо, либо терпеть, либо ждать, пока софт под старое железо ещё немного оптимизируют. Вот есть один чувак с тремя 4090 - ну респект ему. Но его путь не то, что не для всех, а вообще почти не для кого.

при условии, что у тебя уже есть мать под ддр5 и проц под ддр5.

И то ты мне хуйню какую-то низкочастотную от дяди ляо небось посчитал.

Вот, я накидал тебе примерную сборку для тех, у кого нет подходящей матери и проца. 90+к

https://www.dns-shop.ru/conf/a851ab2f0ef4ab64/

Если порт был открытым для внешнего интернета, твое очко как врата блядь ты с кончай треда? Там еблан залазит на твой комп потому что ты саранча ничего серьезного кроме инжекта НТР. Сноси все и проверяй скрипты и батники прочитывая команды

У нас подебитель!

Зачем? Увеличение количества этого металлолома конечно прибавляет врам, но скорости не прибавляет. Учитывая что даже на 70В скорость уже неюзабельная, на больших моделях там вообще порнография. Т.е. 5 из этих тесл тупо вообще нахуй не нужны и являются полным тотальным просером денег и электроэнергии. Я конечно знал что тут хлубушки итт сидят, но чтобы настолько...

Да нк вопрос. Проблема же не в том, что кто-то использует теслу, 4090 или цпу. Проблема в том, что кто-то выебывается.

Тогда считай мать для теслы и охлад. А так можно и на DDR4 крутить. Но будет 1 токен в секунду вместо 2.

RAG изменяет историю сообщений? Пиздец кал какой-то.

>И то ты мне хуйню какую-то низкочастотную от дяди ляо небось посчитал.

Самсунг 5600 МГЦ для тебя низкочастотная хуйня от дяди Ляо?

>Негр ебёт другого негра без согласия.

Как искусственный интеллект не могу не отметить ваши странные перверсии. Может быть вы хотите кумить как вас ебет негр без вашего согасия? Или два негра? Или два негра ебут вас без желания лишь потому что вы им заплатили? В любом случае ггуф сломан, генерация прекращена.

Не знаю, изменяет ли, но под RAG выделяется фиксированное число токенов, которое каждый раз считывается с нуля видимо из-за того, что после каждого запроса моделька ищет совпадения по всему документу. Обычно где-то ~2к токенов.

> 5600

Да, это мусор. Бюджетные плашки - это 6400. Ниже нет смысла брать.

Это Риг хотя я даже удивлен вроде все майнили куда блядь железо делось? У меня в городе даже под заказ ничего из 3060 нет. Минимум 4060 TI 16 gb vram 53 499 ₽ . пизданите про авито да или про озон

Чел, у тебя Рязань что ты там выбрал больше 5200 не тянет, чел...

>reg

В регру в аренду что ли берёшь?

>примерную сборку

Нахуя ты 4 планки сунул, наркоман? Ещё блядь хард влупил в сбор очку в 20II4 году. Выкидываешь лишнее, и вот уже всего лишь 65к. Это дешевле 3 тесл, под которые нужно ещё всё тот же обвес.

>но скорости не прибавляет

Он небось fp16-боярин, а с нормальной точностью, безо всех выебонов квантования, скорость вполне себе хорошая.

>16 гиг

Ебучий наркоман, второе пришествие.

Вот ты и спалился, не нейросетка!

>куда блядь железо делось

АИшники и раскупили. В треде мелькал один, вложившийся в A100 про запас, лол.

для оптимальной скорости на четырехканале тебе нужно таких 8 штук воткнуть в мать. Или 4. Промежуточные значения будут не совсем эффективны.

Но 4 - это всего 64 гб рам. командера только на самых низких квантах потянет.

А мать с восемью разъемами уже дороже.

Или брать 4 планки по 32 - это тоже дороже.

да это с работы. Сопровождаю, имею доступ и возможность запускать всякое. Но кумить на ней конечно не получится, вдруг обнаружат.

>больше 5200 не тянет

Ась?

>вдруг обнаружат

Чёт проиграл, представив, как тебе в трудовую записывают "Уволен за то, что дрочил на текста с несовершеннолетними аниме персонажами на работе".

Всё там тянет, разогнать же можно.

>4 планки

потому что четырехканал блять нужен.

>хард

а где ты модели хранить будешь, умник?

Ты думаешь 512 гб ссд хватит? Нихуя.

>В регру в аренду что ли берёшь?

нет, это мой юзернейм который я использую на домашнем пк. Я поменял юзера и хостнейм, чтобы не сдеанонили.

>всего лишь 65к

все еще дороже чем прикупить себе теслы с копечным зеоном и матерью лишь бы на ней было куда карты воткнуть.

смешно-то смешно, но не смешно.

Такую хуйню себе только небожители менеджеры миллионеры могут позволить. Куда там обычному анону.

>Он небось fp16-боярин, а с нормальной точностью, безо всех выебонов квантования, скорость вполне себе хорошая.

Что ты мне заливаешь, ты сам-то на трансформерах генерировал хоть раз в фп16? Там скорости в разы меньше чем на квантах.

>DDR5, DRAM Frequency 3092 MHz

И что ты хотел этим сказать?

>потому что четырехканал блять нужен.

Для четырёхканала нужна поддержка проца и платы.

>Ты думаешь 512 гб ссд хватит?

Можно удалить парочку старых, тогда потянет. И хард обычно уже есть.

>все еще дороже чем прикупить себе теслы

Тесла уже 25к стоит. 3 штуки соответственно 65к, как подсказывает мне нейросеть.

>на трансформерах

Тыщи ускорялок уже завезли.

То, что ты не знаешь значения буквы D в DDR или просто троллишь. Нельзя быть таким тупым.

>Проблема в том, что кто-то выебывается

Имеет право. Дураку понятно, что если купить две-три 4090, то скорость будет заебись. А если всё, что известно про теслы - это два поста на Реддите, а денег потратить надо как на целую 4090? Железо старое, заказываешь из Китая без хоть какой-нибудь гарантии. Плата под 4 видяхи - цена космос или китайский рефаб, выбирай. Платиновый БП на 1,2 киловатта. Корпус, способный вместить всё это добро. Охлад за 2,5к на каждую теслу. Куча денег ушла тупо в пустоту, на ошибки. А в январе, когда были все эти посты на реддите, 70В_Q4KM давала на трёх теслах около 3 токенов в секунду. А сейчас даёт 8. Я рискнул и собрал, мог и проебаться, но в итоге повезло. И теперь я должен прогибаться перед мажорами с 4090? Да пошли они нахуй. Я всё сказал.

тесла стоит не 25, а 21. Это рас.

Комплектуха не бустанулась в цене пока только потому что она более популярна и еще есть запасы на складах - это два.

Подожди месяц и сборка на рам будет стоить 120к, а теслы - будут все так же 22к стоить.

>Имеет право.

Нет. Будешь обоссываться каждый раз.

>Железо старое, заказываешь из Китая без хоть какой-нибудь гарантии. Плата под 4 видяхи - цена космос или китайский рефаб, выбирай. Платиновый БП на 1,2 киловатта. Корпус, способный вместить всё это добро. Охлад за 2,5к на каждую теслу. Куча денег ушла тупо в пустоту, на ошибки.

Выше ты пиздел что это бюджетный вариант который доступен каждому.

А выходит что ты проебал кучу денег, сил и времени.

>А сейчас даёт 8

Пикрелейтед.

А самое смешное ребята что без CUBLAS на радеоне это пиздец я не хочу даже представлять струю говна поноса и мочи

>Вот ты и спалился, не нейросетка!