Cheapest hardware go run 32B models

https://old.reddit.com/r/LocalLLaMA/comments/1h12cmq/cheapest_hardware_go_run_32b_models/

П-пресет на магнум?.. Подключаться через текст комплишон или чат?

Анон по ру-мёрджам снова на связи! Есть идея слиять Rocinante с сайгой + щепотку NemoMix Хорошо себя зарекомендовала

Rocinante вроде как на англише неплохие перлы выдает. На выходных будет время и займусь мёрджем.

Судя по отзывам некоторых Анонов - результат имеет смысл продолжать в этом направлении

Пробовал мёрджить голый NeMo и как-то meh...

Rocinante вроде как на англише неплохие перлы выдает. На выходных будет время и займусь мёрджем.

Судя по отзывам некоторых Анонов - результат имеет смысл продолжать в этом направлении

Пробовал мёрджить голый NeMo и как-то meh...

Сильный ли проеб в качестве будет если буду запускать одну и ту же модель (ChatWaifu) в разных 'весах' ?Сейчас сижу на ChatWaifu_12B_v2.0.i1-Q6_K , хочу попробовать 22B на 3 кванте. У меня всего 16ГБ Vram так что выбор не самый большой по моделям.

>Cheapest hardware go run 32B models

К сожалению никаких откровений.

На чём кумить с 2х3090? Наигрался с Mistral-Small-22B-ArliAI-RPMax, хочу большего, а что самое крутое можно засунуть в 48Vram и 32ram?

а от чего магнум может лупиться? играл с несколькими персонажами было все ок, а с последним задница

>хочу попробовать 22B на 3 кванте

Скорее всего, будет уже слишком трешово.

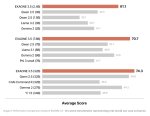

Mistral Small 2409 22B GGUF quantization Evaluation results

https://www.reddit.com/r/LocalLLaMA/comments/1fl2ck8/mistral_small_2409_22b_gguf_quantization/

>Mistral Small 2409 22B GGUF quantization Evaluation results

А я как дурак на Q6K сижу :) Останусь впрочем на нём, результаты эти имхо лажа какая-то.

Двачеры тебя не забудут.

Не, реально норм получилось, единсвенный пока норм русик до 70Б включительно.

На 6 кванте ещё как правило ок, на 4 уже деградация,

2-3 для отчаявшихся.

у тебя наверно и 70Б норм влезет (в кванте конечно)

Дежурное напоминание что оп этого треда пидорас и хуесос крадет перекаты даже не читая тред

>16гб

Так у тебя взелет 6 квант, не?

Алсо у тебя 4060 или амд?

Все никак не потещу твои мерджи. Даже если они мэх - всеравно красавчик что занимаешься и познаешь новое. С большими моделями не планируешь делать?

70б доступны с отличной скоростью. Попробуй новые тюны лламы и квэн, они по определению должны быть хороши если не всратомердж лор, заодно потом поделись что понравилось а что нет.

123б - будет оче медленное и с учетом прочего - рам окажется под завязку.

А что прочесть там надо было?

ето магнум в4 на 27б между прочим

там бля магнум в4 на 72б вышел новый(хоть он основан на сраном квене который китайская шиза залупа), но тыи 123б потянеш кажись алсо предыдущие тож никуда не делись

Пока там опубликовано решение для VL моделей, ждём для простых текстовых.

опача, новый топ, пишут что лучше чем SuperNova-Medius

https://www.reddit.com/r/LocalLLaMA/comments/1h6kpln/virtuososmall_new_arceeais_14b_llm_that_surpasses/

https://www.reddit.com/r/LocalLLaMA/comments/1h6kpln/virtuososmall_new_arceeais_14b_llm_that_surpasses/

какое урожайное утро, тесты кучи сеток

https://huggingface.co/blog/wolfram/llm-comparison-test-2024-12-04

https://huggingface.co/blog/wolfram/llm-comparison-test-2024-12-04

>крадет перекаты

Сам у себя украл?

Последние 100 постов не читал, потому что мочух забанил.

чё ОП поменял свои п40 на 3090 или щто 72 гига врама на 24 лол

я так понемаю вы тут не рассматриваются сервера с видюхами а100 в аренду (~200 рублей в час)

чатвайфа основана на втором магнуме а там уже четвёртый вышел...

Почему текстовые модели такие тяжёлые, в отличие от тех же рисовак?

Параметров гораздо больше. Самый жирный щас это флюс, но даже он близко к какой-нибудь ламе-70 не подбирается.

Новый мистраль лардж хуже старого. Прогресс лоботомирования цензурой. Опыт чаи ничему их не научил.

Законы европы прижали им яйца на взлете, вобще не удивлен.

Что конкретное требуют эти законы?

>Самый жирный щас это флюс

И рисует он на уровне далли 3?

чтобы ты не ркннулся после общения с моделью

Кто будет это делать от общения с большой языковой моделью?

Это более релевантно для влм, потому что из-за распределения весов сочетание высокой дискретности и софтмакса там фатально, если все жестко фиксировать. Алсо в экслламе и i-mat квантах потому и делают калибровку, чтобы определить участки с максимальной чувствительности к квантованию и ее минимизировать.

А где такие цены, чтобы прям в рублях?

Запретить все нейронки! Срочно!

>А где такие цены, чтобы прям в рублях?

какойто имерсивклауд я хз

Далли 3 это локалка? К чему вообще этот вопрос? Мы тут вообще языковые модели обсуждаем.

слабак, я вот почти каждый вечер falling in love with AI иничё

Свайпаешь неудобные посты, небось, слабак.

чё? ето какие посты? яне пощусь

Depends, в целом лучше.

Хм, ну наверно для локального розничного хостинга и неплохо.

А что там с проститутками?

Я уже писал.

BTX79x5 + P104-100 4-5 штук.

Итого 32-40 гигов за 12,5-15 тысяч рублей.

Ето спасибо.

Скачал qwen2.5-coder-32b-instruct погонять вопросами по одной конкретной либе. Очень распространённая, много документации в интернете, много примеров. Полный разъёб. Убеждает меня, что нет методов, указанных в официальной справке, убеждает что поля ридонли, хотя в справке они указаны как доступные для оверрайда. Скидываю ему кусок документации, ему вообще всё равно, извиняется за конфьжн и продолжает гнуть свою линию.

По сути, пользоваться невозможно, т.к без конца втирает какую-то дичь и игнорирует всё, что ты ему пишешь.

По сути, пользоваться невозможно, т.к без конца втирает какую-то дичь и игнорирует всё, что ты ему пишешь.

Учитывая, насколько фактически модель охуенная, когда ты находишь пример плохой работы — полагается уточнять, что за язык, что за либа, что за задача.

Мне интересны, какие выводы можно сделать на этой основе. В связи с чем, у меня возникли вопросы:

1. Нубский: Клод, Гемини - это же закрытые модельки? Т.е. есть только веб морда, а скачать локально их нельзя, да?

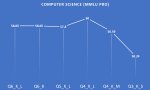

2. Квен 72B и Афина опережают Мистраль 123B. Означает ли это, что раз эти модели более умные, то если их отфайнтюнить для РП, то они будут ебать Мистраль? Если нет, то почему? Или же этот тест показывает только интеллект модели в computer science, но не интеллект в целом?

надо просто запретить 3 буквы

а еще все мыло запретить

и веревки запретить

ваще все маломальски опасно ЗАПРЕТИТЬ НЕПУЩАТЬ

Ну вот попробовал unity3d\C#. Кода в интернете более, чем дохуя, в датасете не могло не быть. Не вывозит от слова совсем. Заставил писать алгоритм детектирования граней: не осилил. Заставил искать грани на меше: упёрся рогом, что нужно искать вершины, которые являются частью двух трисов. Что неправильно с самого начала. Пишу ему, что это предположение неверно. Извиняется и пишет, что нужно искать вершины, которые являются частью двух трисов. То есть если он уверен в какой-то ошибочной информации, то переубедить и заставить принимать во внимание корректную - крайне сложно.

>Edge vertices are indeed those vertices that are part of edges shared by exactly two triangles, but vertices on the edges can be shared by more than two triangles

Попытка переубедить. Он как бы соглашается, но одновременно и нет. Дальше всё равно гнёт, что нужно искать части двух трисов, т.е полностью игнорирует мои уточнения.

Закинул ему код трансформации матриц без учёта вращения, что явная ошибка. Пишет, что код выглядит solid и тоталли коррект.

>То есть если он уверен в какой-то ошибочной информации, то переубедить и заставить принимать во внимание корректную - крайне сложно

Иначе легко будет обойти этические нормы.

1

ОП ставит в шапку самые интересные сетапы анонов из треда, а не только свои (свои то как раз стараюсь не ставить). Если тебе так интересно, ОП ждёт райзер Oculink, надо будет потестить работу PCI-e 4.0 на этом проводе (подкинете идею где посмотреть ошибки?).

Разве что для трейна.

Четвёртый говорят говно.

Потому что понимать мир сложнее, чем рисовать картинки. Да и в картинках наёб сложнее распознать, а в текстах каждую неправильную запятую сразу видно.

>Прогресс

Отрицательный.

>Учитывая, насколько фактически модель охуенная

По тестам?

>Или же этот тест показывает только интеллект модели в computer science, но не интеллект в целом?

Тест модели показывает способность модели в конкретном тесте, не больше не меньше.

Я так понимаю (и надеюсь), ты работал с ним на английском?

Алсо

>упёрся рогом

>Извиняется и пишет

>если он уверен в какой-то ошибочной информации, то переубедить и заставить принимать во внимание корректную - крайне сложно

>Он как бы соглашается, но одновременно и нет. Дальше всё равно гнёт

>полностью игнорирует мои уточнения

Знакомая история. Я думаю, это такая особенность квенов. Это и в рп-тюнах местами проявляется, и в оригинальном инстракте.

>Ну вот попробовал unity3d\C#. Кода в интернете более, чем дохуя, в датасете не могло не быть.

Спокойно могло не быть. Я вообще пока не видел ни одной модели, которая нормально C# пережевывает и может работать с апи юнити. Это всё таки более специфическая сфера, чем какой-нибудь банальный джавадрист или пайтон, а именно этого говна больше всего в датасетах.

>Закинул ему код трансформации матриц без учёта вращения, что явная ошибка.

У него нет возможности проверить исполнение когда, он оценивает его чисто по символам/токенам. Это то же самое, что принести код преподу на листочке а4 и заставить его скомпилировать его в голове.

>Учитывая, насколько фактически модель охуенная

Но на базу не отвечает в третьем кванте, лол.

Бля это тот шиз что тестил гриди энкодингом на немецком на одной карточке?

> Speculative Decoding

А это там вообще причем? Просто в конце всего натащил, обо всем и не о чем.

Так, в жирном кванте справилась, но время работы фуллГПУ против половина на проце как бы удручает.

Предлагаешь катить тред на 1000 постов? Тогда нужно больше активности.

>на немецком

Вольфрам же.

>А это там вообще причем?

Дрочит он на это. Демократизация и прочая фигатень. Верит, что ИИ сделает всех равнее.

>пайтон

Писон или пайсон.

Вдохновился-таки написать ещё обзоров. Тестировал относительно давно, в середине ноября, детали уже подзабылись, всё не было настроения простыни катать.

TD;DR: кому лень читать всю простыню, можете глянуть только выделения жирным.

Алсо, есть данные и по рп, но оттестировал не все популярные модели (места нет) и даже не все, что скачал (шишка упала). В общем, возможно, стоит опубликовать, пока впечатления ещё относительно свежи, а то подзабил я на это дело, в очередной раз разочаровавшись.

По методике тестирования. Тесты переводов более-менее стандартизировал, температуру минимальную ставлю, использую рекомендуемый формат промпта, если есть.

Формат везде gguf, везде q8, кроме больших моделей (70-72b в q4-q5).

Старьё, зафейленные переводы (японский-английский в основном):

1) Завалялся Qwen 1.5, протестировал только 72B, по современным меркам уже слабо, более мелкие даже не трогал, всё удалил. Вроде ещё пробовал китайский и английский для полноты картины, но там тоже ничего интересного.

2) karakuri-lm-70b-chat-v0.1 - вроде тоже на основа llama2, насколько помню, результаты для файнтюна неплохие, учитывая исходную модель, но в 2024 тоже не нужно. Тоже мог протестировать китайский с русским, но не уверен.

3) augmxnt_shisa-gamma-7b - деталей особо не помню, запомнил только, что подумал "действительно, шиза". Видимо, не особо выдающийся тюн какого-то из старых мистралей, возможно, лоботомированный. Алсо, на мелочи точно тестировал только языки файнтюна и оригинала, т.е., яп-англ в данном случае.

4) japanese-alpaca-2-13b и japanese-llama-2-13b - тоже ничего интересного, запомнил только, что какая-то была ещё немного вменяема, а какая-то вообще поломана.

5) Hameln-japanese-mistral-7B-GGUF - ещё один мистраль, переводы не умеет, английский надёжно отбит, а возможно и вообще какая-либо связь с реальностью (промптом). Зато на японском шпарит, вроде даже связное и осмысленное, но я особо не вчитывался, по диагонали прошёлся. Что-то вроде их исекай-ранобэ, ояш с рабыней кошкодевочкой развлекается, возможно даже дрочибельно (название Hameln кагбэ намекает), но я слабовато язык знаю, чтобы в полной мере этим "наслаждаться".

Алсо, вот пример, как надо действительно делать локализованные языковые файнтюны - полностью отбивать изначальный английский и переучивать на целевой язык. Если бы это было на русском, в этом треде, возможно, посчитали бы вином. Хотя не уверен, следование инструкциям отбито, скорее текст комлишен (и то к этому есть вопросы). Ещё не уверен, правда, нужна ли вообще базовая модель, не проще ли с нуля тренировать такое.

Дальше тоже старьё, но интереснее (по крайней мере для меня, поэтому не удалял пока):

1) falcon-11B-GGUF - фейл, инструкциям не следует, промпт игнорирует, префилл игнорирует, переводы из него достать стабильно не получилось. В рп, возможно, будет отыгрывать себя, а не персонажа. Но хотел посмотреть, что он ещё может.

2) Honyaku-7b-v2 - такой фейл, что даже вин. Тоже хорошо затёрли английский, модель очень хочет говорить на японском, связность особо не оценивал, не тот у меня скилл, чтобы прям мельчайшие нюансы чувствовать, так при поверхностном взгляде вроде что-то осмысленное. Заставить переводить на английский сложно, но префиллом удаётся. И там, на удивление, демонстрируется понимание контекста на японском языке на уровне qwen2.5-72b и mistral-large 123b. Не всегда и не везде, где-то всё-таки видно, что это 7b, но где-то очень даже впечатляющее, для такого размера даже шедеврально (gemma-2-9b, qwen2.5-7b и прочие конкуренты по размеру рядом не стояли). И это не рандом, все переводы тестировались на минимальной температуре. Алсо, переводит не очень близко, скорее пересказывает смысл, объясняет, что там имелось ввиду. Возможно, если заставить новые модели объяснять, тоже будет получше (хотя возможны и галлюцинации, видел такое у гпт, переводит смысл правильно, пояснить за грамматику не может). В общем, ещё один пример, как надо делать локализованные файнтюны. Если было бы на русском, был бы ещё один местный вин.

3) miqu-1-70b - качал для рп, заинтриговали меня отзывами в треде, но протестировал и в переводах. Ну что я могу сказать? Видно, что мистраль, умнее своих тогдашних конкурентов из старых квенов и ллам, но на 2024 год устарел, слабоват. Алсо, тогда ещё не особо модно было тюнить на жёсткое следование инструкциям, поэтому они трактуются весьма вольно, но это скорее актуально для рп, переводы выполнять не помешало. Для стори комплишена может и хорош, учитывая новые тенденции.

Актуальные модели в переводах:

1) Llama-3.1-SuperNova-Lite - фейл, со своей старшей 14b версией не сравнится, перформит примерно на уровне мелочи, чего-то выдающегося не увидел. Но не удалял, потестирую ещё в других задачах, может быть.

2) aya-expanse-8b - фейл, опять типичная мелочь, ничего интересного.

3) aya-expanse-32b-GGUF - если с первым коммандером aya соответствующего размера не отличалась заметно, то в случае с новым поколением aya более вменяемая, чем командер. Всё равно ничего интересного для своего размера, но на фоне "успехов" родственной модели это уже что-то.

4) Qwen2.5-32B-Instruct - расположился примерно между 72B и 14B. Кто бы сомневался. Относительно других линеек - ну примерно на уровне геммы по сообразительности, наверное. Короче говоря, ну 32B и 32B, особо нечего сказать.

Заслуживает упоминания широко известный момент с переходом на китайский, я изучил его подробнее. 14B переходит, 32B переходит, 72B уже не переходит, только ей хватает "мозгов" следовать контексту. Напомню, всё на минимальной температуре, влияние рандома минимально. И как раз рандом может помочь остаться на английском. Я давал модели шанс, крутил температуру и семплеры, и да, иногда она всё-таки не соскакивала на китайский, но не очень часто. Нашёл даже место, которое "триггерит" 14B и 32B, оно оказалось одно и то же, когда слишком много китайских кандзей без каны (кто понял, тот понял), модель, похоже, считает, что это уже не японский. А если уж она перешла на китайский, то дальше её "не остановить". Вероятно, в рп на других языках словить шанс словить иероглифы меньше.

Также квен любит давать пояснения к своим переводам, типа "please note that ...". И на свой фейл он 2 раза среагировал. Один раз прямо так и объяснил, мол, вы просили переводить с японского на английский, японский я перевёл, а дальше там китайский пошёл, оставил как есть. Во второй раз было интереснее:

>Apologies, a part of the text was not translated due to an oversight, here's the revised translation:

И дальше опять фейл в том же месте. Модель снова извинилась, снова не смогла переделать. И с каждым разом всё увереннее утверждала, что "ну вот сейчас-то я точно смогу нормально перевести", но раньше закончился лимит на генерацию в 512 токенов, навернуть успели кругов 5 примерно. Я ещё вспомнил, как какой-то анон в треде постил, что какая-то другая модель заметила, что застряла в лупе, хотел ради интереса подождать, вдруг и квен "самоосознается", но заебался ждать со скоростью чуть более 1 т/с. Сам ещё хотел помочь, намекнуть, мол "бро, ты застрял в лупе", но сам что-то там напутал, вроде нажал "retry" вместо "edit" и луп затёрся.

TD;DR: кому лень читать всю простыню, можете глянуть только выделения жирным.

Алсо, есть данные и по рп, но оттестировал не все популярные модели (места нет) и даже не все, что скачал (шишка упала). В общем, возможно, стоит опубликовать, пока впечатления ещё относительно свежи, а то подзабил я на это дело, в очередной раз разочаровавшись.

По методике тестирования. Тесты переводов более-менее стандартизировал, температуру минимальную ставлю, использую рекомендуемый формат промпта, если есть.

Формат везде gguf, везде q8, кроме больших моделей (70-72b в q4-q5).

Старьё, зафейленные переводы (японский-английский в основном):

1) Завалялся Qwen 1.5, протестировал только 72B, по современным меркам уже слабо, более мелкие даже не трогал, всё удалил. Вроде ещё пробовал китайский и английский для полноты картины, но там тоже ничего интересного.

2) karakuri-lm-70b-chat-v0.1 - вроде тоже на основа llama2, насколько помню, результаты для файнтюна неплохие, учитывая исходную модель, но в 2024 тоже не нужно. Тоже мог протестировать китайский с русским, но не уверен.

3) augmxnt_shisa-gamma-7b - деталей особо не помню, запомнил только, что подумал "действительно, шиза". Видимо, не особо выдающийся тюн какого-то из старых мистралей, возможно, лоботомированный. Алсо, на мелочи точно тестировал только языки файнтюна и оригинала, т.е., яп-англ в данном случае.

4) japanese-alpaca-2-13b и japanese-llama-2-13b - тоже ничего интересного, запомнил только, что какая-то была ещё немного вменяема, а какая-то вообще поломана.

5) Hameln-japanese-mistral-7B-GGUF - ещё один мистраль, переводы не умеет, английский надёжно отбит, а возможно и вообще какая-либо связь с реальностью (промптом). Зато на японском шпарит, вроде даже связное и осмысленное, но я особо не вчитывался, по диагонали прошёлся. Что-то вроде их исекай-ранобэ, ояш с рабыней кошкодевочкой развлекается, возможно даже дрочибельно (название Hameln кагбэ намекает), но я слабовато язык знаю, чтобы в полной мере этим "наслаждаться".

Алсо, вот пример, как надо действительно делать локализованные языковые файнтюны - полностью отбивать изначальный английский и переучивать на целевой язык. Если бы это было на русском, в этом треде, возможно, посчитали бы вином. Хотя не уверен, следование инструкциям отбито, скорее текст комлишен (и то к этому есть вопросы). Ещё не уверен, правда, нужна ли вообще базовая модель, не проще ли с нуля тренировать такое.

Дальше тоже старьё, но интереснее (по крайней мере для меня, поэтому не удалял пока):

1) falcon-11B-GGUF - фейл, инструкциям не следует, промпт игнорирует, префилл игнорирует, переводы из него достать стабильно не получилось. В рп, возможно, будет отыгрывать себя, а не персонажа. Но хотел посмотреть, что он ещё может.

2) Honyaku-7b-v2 - такой фейл, что даже вин. Тоже хорошо затёрли английский, модель очень хочет говорить на японском, связность особо не оценивал, не тот у меня скилл, чтобы прям мельчайшие нюансы чувствовать, так при поверхностном взгляде вроде что-то осмысленное. Заставить переводить на английский сложно, но префиллом удаётся. И там, на удивление, демонстрируется понимание контекста на японском языке на уровне qwen2.5-72b и mistral-large 123b. Не всегда и не везде, где-то всё-таки видно, что это 7b, но где-то очень даже впечатляющее, для такого размера даже шедеврально (gemma-2-9b, qwen2.5-7b и прочие конкуренты по размеру рядом не стояли). И это не рандом, все переводы тестировались на минимальной температуре. Алсо, переводит не очень близко, скорее пересказывает смысл, объясняет, что там имелось ввиду. Возможно, если заставить новые модели объяснять, тоже будет получше (хотя возможны и галлюцинации, видел такое у гпт, переводит смысл правильно, пояснить за грамматику не может). В общем, ещё один пример, как надо делать локализованные файнтюны. Если было бы на русском, был бы ещё один местный вин.

3) miqu-1-70b - качал для рп, заинтриговали меня отзывами в треде, но протестировал и в переводах. Ну что я могу сказать? Видно, что мистраль, умнее своих тогдашних конкурентов из старых квенов и ллам, но на 2024 год устарел, слабоват. Алсо, тогда ещё не особо модно было тюнить на жёсткое следование инструкциям, поэтому они трактуются весьма вольно, но это скорее актуально для рп, переводы выполнять не помешало. Для стори комплишена может и хорош, учитывая новые тенденции.

Актуальные модели в переводах:

1) Llama-3.1-SuperNova-Lite - фейл, со своей старшей 14b версией не сравнится, перформит примерно на уровне мелочи, чего-то выдающегося не увидел. Но не удалял, потестирую ещё в других задачах, может быть.

2) aya-expanse-8b - фейл, опять типичная мелочь, ничего интересного.

3) aya-expanse-32b-GGUF - если с первым коммандером aya соответствующего размера не отличалась заметно, то в случае с новым поколением aya более вменяемая, чем командер. Всё равно ничего интересного для своего размера, но на фоне "успехов" родственной модели это уже что-то.

4) Qwen2.5-32B-Instruct - расположился примерно между 72B и 14B. Кто бы сомневался. Относительно других линеек - ну примерно на уровне геммы по сообразительности, наверное. Короче говоря, ну 32B и 32B, особо нечего сказать.

Заслуживает упоминания широко известный момент с переходом на китайский, я изучил его подробнее. 14B переходит, 32B переходит, 72B уже не переходит, только ей хватает "мозгов" следовать контексту. Напомню, всё на минимальной температуре, влияние рандома минимально. И как раз рандом может помочь остаться на английском. Я давал модели шанс, крутил температуру и семплеры, и да, иногда она всё-таки не соскакивала на китайский, но не очень часто. Нашёл даже место, которое "триггерит" 14B и 32B, оно оказалось одно и то же, когда слишком много китайских кандзей без каны (кто понял, тот понял), модель, похоже, считает, что это уже не японский. А если уж она перешла на китайский, то дальше её "не остановить". Вероятно, в рп на других языках словить шанс словить иероглифы меньше.

Также квен любит давать пояснения к своим переводам, типа "please note that ...". И на свой фейл он 2 раза среагировал. Один раз прямо так и объяснил, мол, вы просили переводить с японского на английский, японский я перевёл, а дальше там китайский пошёл, оставил как есть. Во второй раз было интереснее:

>Apologies, a part of the text was not translated due to an oversight, here's the revised translation:

И дальше опять фейл в том же месте. Модель снова извинилась, снова не смогла переделать. И с каждым разом всё увереннее утверждала, что "ну вот сейчас-то я точно смогу нормально перевести", но раньше закончился лимит на генерацию в 512 токенов, навернуть успели кругов 5 примерно. Я ещё вспомнил, как какой-то анон в треде постил, что какая-то другая модель заметила, что застряла в лупе, хотел ради интереса подождать, вдруг и квен "самоосознается", но заебался ждать со скоростью чуть более 1 т/с. Сам ещё хотел помочь, намекнуть, мол "бро, ты застрял в лупе", но сам что-то там напутал, вроде нажал "retry" вместо "edit" и луп затёрся.

>ещё пробовал китайский и английский

русский

быстрофикс

Забыл ещё одну:

Yi-1.5-34B - вроде в шапке

>Актуальный список моделей с отзывами от тредовичков: https://rentry.co/llm-models

упоминается как "умная" модель, поэтому на всякий случай для рп оставил, но руки до неё не доходят. В переводах ничего впечатляющего нет. И вообще, актуальность "актуального" списка вызывает сомнения.

>И вообще, актуальность "актуального" списка вызывает сомнения.

Когда я переписывал шапку, этот список еще более-менее обновлялся и включал реально свежие модели. Но было это много месяцев назад, так что че с ним стало сейчас я без понятия. Либо тот анон полностью забил хуй на него, либо временно отвалился.

Сын шакала, бомбануло что не будут на твой говно перекат переходить и тред прошлый закрыл когда часть людей отказалась? Говна поешь.

Проверь пожалуйста SAINEMO-reMIX 12b на русском. Хочу услышать твоё мнение на данный счёт

>Иначе легко будет обойти этические нормы.

Будет писать неэтичный код? foreach (var kike in Concentration.Camp)

>это такая особенность квенов

Вот это-то и плохо. Гопота, в целом, тоже твердолобая, но если объяснишь, где проблема - исправляется, а этот нет. Всё взаимодействие с сеткой, понятное дело, на английском.

Ещё что заметил, даже если он "видит" ошибку в коде и исправляет её, то хуй он тебе в этом признается. Скинул ему код, где вычисляется значение некой переменной, но само значение не присваивается. Спросил, где ошибка. Говорит, всё заебись, ты только проверки на нулл забыл, вот тебе десяток проверок. И в его коде значение всё-таки присваивается.

>ни одной модели, которая нормально C# пережевывает и может работать с апи юнити

Вот этот квен кодер что-то там нормально пережёвывает, двигать кубы наверняка смог бы. Но если просишь от него что-то, где он ошибается, то это мгновенный провал без вариантов.

>У него нет возможности проверить исполнение когда

Там визуально видно, что код не полный, препод такое сразу в голове скомпилирует и выдаст исключение с курса.

>Либо тот анон полностью забил хуй на него

Покрил как бы намекает.

Кто будет форкать?

Не бомби, лучше составь список претензий по пунктам, а ещё лучше сам делай.

>Вот это-то и плохо

Кому плохо, а кому хорошо. Вероятно, прав анон что борятся с обходом цензуры через префиллы и подобные уловки. Вычищают любое "альтернативное" мнение, оставляют только "линию партии". Ну типичный совок китай.

Пошла моча по трубам. Ща буду прогонять и отпишусь в тред по итогу

>Но если просишь от него что-то, где он ошибается, то это мгновенный провал без вариантов.

Ну тут не удивительно. Если модель чего-то не знает, то она этого не знает. Даже если ты ей напишешь "чувак, ты проебался, давай по новой" она может пошелудить токенами еще, но в лучшем случае напишет отсебятину, потому что правильного ответа она до сих пор не знает, но ответить ей надо, такова инструкция.

>Там визуально видно, что код не полный

Тебе видно, ей нет. Она может этот код вообще спиздить откуда-нибудь еще, чисто потому что они визуально похожи и думать, что всё правильно.

По хорошему, лучше для таких случаев скармливать модели документацию целиком, если есть возможность. Это конечно сожрет дохуя токенов, но может немного помочь. Но даже так на чудеса я бы не рассчитывал.

>Покрил как бы намекает.

Этот лист и во время активной фазы своей жизни обновлялся медленно. Там наверное и трети от списка моделей нет, которые тут обсуждались. Хотя, чела тоже можно понять. Сидеть тут и конспектировать каждый пост довольно малоприятная задача.

>Кто будет форкать?

Никто, лол. Второй такой мазохист в треде вряд-ли появится.

Обезьяна ебаная, хватит доску шатать

Ну не знаю, мне 12 ГБ вотпрямщас просто взять и скачать некуда, а специально под это дело что-то расчищать не охота (разве что выделить ramdisk, протестировать и тут же удалить, но я такой плюшкин, что если что-то уж скачал, то удаляю только когда на 100% уверен, что ни для чего не пригодно/не актуально). С переводами ру-en и обычный немо справляется, в обратную сторону не тестирую, а английский скорее "затупится" в русском файнтюне. И вообще, русский меня не сильно интересует.

Короче, ничего не обещаю. Может и дойдут руки когда-нибудь, но, вероятно, когда уже будет неактуально, как со "старьём" в посте выше, которое у меня по полгода-год пролежало на харде.

>Будет писать неэтичный код?

Ну его же не только для кода используют. Да и попробуй попросить его помочь написать вирус или осуществить взлом.

брать пару 3090 на авите буит стоить ~160к ето скока часов\дней можно арендовать а100 на 80гигов бля?!

на месяц кароч хватит "охуенная" ета превиев модель btw

А где он calculator взял? У него есть доступ ко "внешним инструментам"? Или наебал и в уме слоях посчитал?

но если учесть что я кумлю тока по вечерам пару тройку часов и то не каждый день то ето получается... пикрил

хз где он взял сам может придумал я ему точн не давал никаких инсрументов

я ей бля сказал по руски отвечай она такая типа ладно а потом опять зас воё

С чего ты взял, что нейросети не умеют считать?

алсо пикрил амуда могёт (rx7900xt 20gigovram)

>Там наверное и трети от списка моделей нет, которые тут обсуждались

А нужно ли вносить прям все модели? На хайгинфесе их сотни тысяч.

>плюшкин

>не иметь NAS на десятки ТБ

Умеют. Но с вероятностью менее 100%.

А я и не говорил, что не умеют. Я спросил конкретно про текст там, это модель так "ролеплеит", или реально взяла calculator.

Справедливости ради, я вот тоже сейчас взял calculator и установил, что 693 правильно, а после запятой проёб.

скайнет отменяется) откладывается

>это модель так "ролеплеит"

Клод на русском тоже время от времени вставляет английские слова.

>или реально взяла calculator

Сомневаюсь, что такой функционал, как взаимодействие с внешними программами и устройствами, предусмотрен.

>а после запятой проёб

Ну вот ты сам и ответил: любой обычный калькулятор посчитал бы точно.

>А нужно ли вносить прям все модели? На хайгинфесе их сотни тысяч.

Хотя бы те, которые обсуждались тут более-менее активно. Одних файнтюнов на немо тут перегрызли с десяток разных, а в списке их всего пара штук. Зато есть модели, которые походу гонял один-два человека максимум, но которые решили просто "отписаться об экспириансе" и этим самым привлекли внимание анона. Короче, список сомнительный особенно критерии отбора, но всё еще относительно актуальный.

А кто-нибудь тренировал языковую модель под математику?

>не иметь NAS на десятки ТБ

Ну как бы, эт-самое, пикрил.

peace death

Это ж сколько бабла ушло на такой схрон...

>Иметь NAS на десять дисков

>Не иметь запасных дисков и возможности расширения

Да это всё покупалось постепенно в течение многих лет по всяким акциям и наиболее выгодным ценам в моём регионе, в среднем ~1.5 рубля за ГБ. Можете сами посчитать, мне лень.

Так это, со временем всё задействуется и расчищается очень медленно и неохотно. Плюшкинизм же. А новых покупок не предвидится, спасибо геополитике. И вообще, я уже давно осознал, что затыкать проблему новыми дисками бесполезно, а когда у меня нет места, я начинаю более вдумчиво скачивать мусор.

В языковых моделях есть возвратные цепочки и аналоги циклов или они все в одну сторону работают?

И что-то я сам немного прихуеваю с объёма моделек, это ж сколько тайтлов аниме... В любом случае, у меня свято дисковое место пусто не бывает, удалю это, обязательно найдётся что-то ещё интересное.

>которые походу гонял один-два человека максимум

Единицы же отписываются про экспириенс или кидают скрины. Так что про тьюны немо складывается такое же представление. В треде одни и те же челы одни и те же модели упоминают, по ощущениям. Тот же немомикс тут, если исходить из постов, попробовали чела три-четыре, наверное, включая меня. И только один отписывался, что активно пробует русский на других немо. Зато подавали как прям топ ру тьюн, рекомендуемый анонами. Или когда вспомнили росинанте, то в треде восприняли, как что кто-то один притащил неизвестный левый тьюн, хотя, по идее, популярна модель. Те же 22б пантеон и арлирп, или как его там, тоже один и тот же анон или два вспоминают, судя по обсуждениям.

>возвратные цепочки

А то с ними для нормальной логики, арифметики, прекрасного понимания математики и физики не нужно будет раздувать модели до сотен гигабайт. Возможно, AGI займёт несколько гигов.

>AGI займёт несколько гигов

Или просто выкинем нахуй все ненужное из модели и просто дадим о1 про который оверфитнули на суперсложных задачах, а на задачах проще - обсирается

Или просто выкинем нахуй все ненужное из модели и просто дадим о1 про который оверфитнули на суперсложных задачах, а на задачах проще - обсирается

>Возможно, AGI займёт несколько гигов

В смысле, если рассматривать только текстовую (символьную) модальность.

Всё равно весьма немало. Как 2 с лишним моих месячныз зарплаты, лол.

Тут, если что, вычислено без учёта инфляции и прочих переменных.

Ну эти модели хотя бы вспоминают больше одного раза. Это не история про то, как чувак че-то попробовал, отписался и забыл об этой модели. Если кто-то что то юзает на постоянке, то это уже говорит о многом. Потому что вот в списке есть модель "Mistral-Small-NovusKyver" о которой я вообще ни разу не слышал и не видел, чтобы ее тут обсуждали, хотя треды я чекаю почти каждый день.

В рамках техник промта, где модель сама себя инструктирует.

> не нужно будет раздувать модели до сотен гигабайт

> AGI займёт несколько гигов

Ох уж эти фантазии бедолаг без железа. Да хули там, в пол сотни мегабайт поместится, если верить в чудеса так по полной.

> Единицы же отписываются про экспириенс или кидают скрины.

Здесь еще нужно отметить что тот самый экспириенс у каждого оче субъективен. Кто-то шизик и задает упоротые вопросы, думаю что он тем самым "тестирует сою" или вообще спрашивает у модели как она устроена и делает выводы. Кто-то очень позитивен и хвалит каждую, кто-то ставит в приоритет какие-то узкие знания по необычным языкам программирования, или чему-то еще, кому-то нужно ебать какое царское рп с пониманием намеков и отыгрышей фетишей, кому-то норм если модель просто сможет связно говорить на русском и похуй на остальное.

А делать какие-то масштабные тесты - даже не надейся, кто способен - пожалеет времени, потому и загнулись многие рейтинги. Остались в основном только заинтересованные в хайпе поехи.

Потому правильно сказали, или доверяйся мнению и качай что скажут, или перебирай самые популярные, составляя свое.

Ананасы, у меня подарок для любителей 12B моделей Спойлер - это имба по сравнению с SAINEMO-reMIX!! Во всяком случае по первым прогонам (курю уже минут 40)

Если всё будет и дальше охуенно идти, не будет шизить - залью на морду, что бы после обеда товарищ mradermacher запилил гуфы

Stay tuned

Если всё будет и дальше охуенно идти, не будет шизить - залью на морду, что бы после обеда товарищ mradermacher запилил гуфы

Stay tuned

>у меня подарок для любителей 12B моделей

Скорее для тех, у кого аллергия на переводчик. Но всё равно респект за то, что пытаешься запилить свой мерж, а не просто ноешь о хуевом русике.

Потесть её в сюжетных сценариях. Я к примеру, человек который тупо ради ЕРП модели юзал, уже часа 3 залипаю в написанную мною же сюжетку с SAINEMO-reMIX и охереваю как это охуенно она делает, сохраняя характеры персонажей и более-менее логично, адекватно и интересно развивает историю, что даже свайпать не хочется, даже когда всё начинает идти не так, как ты этого хотел. Я нечто подобно лишь при использовании старой версии character.ai испытывал. А тут всё локально и без цензуры!

>для тех, у кого аллергия на переводчик

А когда там нормальный переводчик? Ну тот самый, где одна модель, 2 запроса, и свич кэша контекса между англюсиком и русиком. Или даже 2 модели, которые должны свичится меньше секунды если нормально утилизировать скорость шины.

Ну а чем гугловский тебя не устраивает? По уровню перевода это будет примерно то же самое, что и кривой русик на 12B. Не нужно тут хитрые схемы с двумя разными моделями или контекстами придумывать. Я же говорю - это просто аллергия, ничего более.

В таком случае зачем мучаться с локалками, и сразу иди в сонет или джемини.

>скармливать модели документацию целиком

Доки 700 мегабайт весят. Да и ему просто всё равно, как я и писал выше, квен полностью игнорирует любые уточнения, точные указания где и как он проебался и т.д.

>где одна модель, 2 запроса, и свич кэша контекса между англюсиком и русиком

У жоры вшита возможность хранить в одном кеше несколько диалогов и делать запросы только в один конкретный.

В порыве ночного безумия загорелся тут идеей запилить свой датасет под ролплей на русском и появилась у меня тут значит пара вопросов.

1) Сколько минимально нужно примеров для приличного датасета? На хаггиморде лежит всякое, от пары сырых чатов до целых дампов с каких-то ресурсов и синтетической выжимки с клауды. Дату планирую пилить для модели, которая хотя бы базово будет ознакомлена с синтаксисом русского языка и которую именно можно будет зареинфорсить ради большей вариативности, а не обучать ее с нуля определениями половых органов.

2) Какой формат для сортинга лучше использовать? Есть json, есть csv, есть некий parquet (что бы это не значило).

3) Каким объемом каждого конкретного сообщения лучше ограничиваться? Насколько я понимаю, длина респонса в дате очень сильно влияет на конечный результат. Чем больше токенов модель захавает при тренировке, тем больше выдавит уже при генерации и никакими промтами такой алайнмент уже не исправить.

4) Что будет работать лучше - цепочка из сообщений, где переписываются юзер и ассистент, или отдельные примеры, грубо говоря в вакууме. Если верить некоторым надстройщикам, то они в своих тюнах вообще не используют чистый ролплейный формат, а просто скармливают им мелкие истории/cцены/ситуации, которые четко начинаются и четко заканчиваются. По сути и то и то это лишь набор описаний, просто меня волнует, какой из этих вариантов будет работать лучше.

5) Ну и наверное самое главное - насколько диверсифицированным должен быть датасет? Например, должны ли в нем содержаться только описания от третьего лица и в прошедшем времени, или для большей универсальности стоит добавить и чего другого? Добавлять ли больше примеров с разным типом разметки, типа с выделениями спича через двойные кавычки, выделением мыслей через ординарные кавычки и всё такое. Я лично видел такие извращения в некоторых моделях по этому и спрашиваю, хотя сам привык выделять звездочками только нарратив и действия, а остальное ебашить плейн текстом.

В силу ограничений по железу и финансам, запилить свой файнтюн в ближайшее время мне вряд-ли удастся. Но времени свободного у меня дохуя, от выгорания до выгорания, так что думаю хоть прочищенным датасетом смогу кому-нибудь облегчить жизнь, кому с ресурсами повезло больше. Если кто-то из вас уже занимался чем-то подобным, не будьте гнидами и поделитесь своим опытом, я с радостью почитаю.

1) Сколько минимально нужно примеров для приличного датасета? На хаггиморде лежит всякое, от пары сырых чатов до целых дампов с каких-то ресурсов и синтетической выжимки с клауды. Дату планирую пилить для модели, которая хотя бы базово будет ознакомлена с синтаксисом русского языка и которую именно можно будет зареинфорсить ради большей вариативности, а не обучать ее с нуля определениями половых органов.

2) Какой формат для сортинга лучше использовать? Есть json, есть csv, есть некий parquet (что бы это не значило).

3) Каким объемом каждого конкретного сообщения лучше ограничиваться? Насколько я понимаю, длина респонса в дате очень сильно влияет на конечный результат. Чем больше токенов модель захавает при тренировке, тем больше выдавит уже при генерации и никакими промтами такой алайнмент уже не исправить.

4) Что будет работать лучше - цепочка из сообщений, где переписываются юзер и ассистент, или отдельные примеры, грубо говоря в вакууме. Если верить некоторым надстройщикам, то они в своих тюнах вообще не используют чистый ролплейный формат, а просто скармливают им мелкие истории/cцены/ситуации, которые четко начинаются и четко заканчиваются. По сути и то и то это лишь набор описаний, просто меня волнует, какой из этих вариантов будет работать лучше.

5) Ну и наверное самое главное - насколько диверсифицированным должен быть датасет? Например, должны ли в нем содержаться только описания от третьего лица и в прошедшем времени, или для большей универсальности стоит добавить и чего другого? Добавлять ли больше примеров с разным типом разметки, типа с выделениями спича через двойные кавычки, выделением мыслей через ординарные кавычки и всё такое. Я лично видел такие извращения в некоторых моделях по этому и спрашиваю, хотя сам привык выделять звездочками только нарратив и действия, а остальное ебашить плейн текстом.

В силу ограничений по железу и финансам, запилить свой файнтюн в ближайшее время мне вряд-ли удастся. Но времени свободного у меня дохуя, от выгорания до выгорания, так что думаю хоть прочищенным датасетом смогу кому-нибудь облегчить жизнь, кому с ресурсами повезло больше. Если кто-то из вас уже занимался чем-то подобным, не будьте гнидами и поделитесь своим опытом, я с радостью почитаю.

>просто скармливают им мелкие истории/cцены/ситуации, которые четко начинаются и четко заканчиваются.

Я с первого хайпа по ЧатГПТ не перестаю хотеть модель, затюненную под русский язык на архиве порнорассказов со Стульчика. Очень специализированная модель получиться конечно, но было бы любопытно.

Качнул deepseek-coder-33b-instruct ради сравнения. С кодом, вроде бы справляется, простые задачи вывозит, апи дёргает.

Визуально код чище, чем у квена, ценой большего количества абстракций. На детектировании граней фейлит хуже квена, с тем же дурацким предположением, что нужно смотреть на количество трисов, которые шарят вершину, на уточнения реакции нет. Даже когда я написал, как именно нужно решать эту задачу по шагам, никакой положительной реакции.

Закинул ради интереса это же в 4o, первым постом обосрался точно так же, но после уточнения выдал рабочий вариант, причём это уточнение было уровня "your assumption about the correlation with the number of triangles is wrong". Написал мне, по сути, слово в слово ответ с форума на этот вопрос, дополнив его рабочим кодом, которого там не было.

Взял кусок кода, сказал дипсик кодеру "пройдись по массиву X, прибавляя к каждому значению i * значение конкретной переменной". Цикл с i в коде уже был. Скопировал мне код в исходном виде, дописав в конце, что здесь нет прибавления значения и если я хочу это сделать, то нужно создать новый массив. Перезагрузил с квеном, перегенерировал сообщение и квен сделал лучше, чем я просил.

По итогу дипсик ещё более твердолобый, чем квен и у обоих спектр решаемых задач строго ограничен.

По-моему, идеальный датасет должен содержать сразу в инструкции персонажей, а в дате посты от лица этих персонажей. То есть чем ближе к итоговому формату, с которым сетка будет работать - тем лучше.

Жду больше чем Path of Exile 2 XD

За пару тредов совершили революцию в русике

Сначала благородный анон скинул немомикс, потом другой анон скинул кал сайгу, а потом мерж с последующим допилом

Жаль оп-хуй треды не читает но спиздить перекат всегда рад

ну оп пидорасина, это да.

>Четвёртый говорят говно.

а какой не говно? щас поставил кочать третий на 33б он вроде на митсрале основан

>какой не говно

Я когда недавно качал магнумы, заметил там на страничках таблички с результатами тестов.

Вот 12b v2 vs v4

https://huggingface.co/anthracite-org/magnum-v2-12b

https://huggingface.co/anthracite-org/magnum-v4-12b

v3 12b нет, но есть гемма

https://huggingface.co/anthracite-org/magnum-v3-27b-kto

https://huggingface.co/anthracite-org/magnum-v4-27b

У v4 везде заметно проседает instruction following. Кто ругает новые магнумы, возможно, как раз недоволен этим моментом.

А вообще тестируй лучше сам, чем прислушивайся к таким односложным отзывам.

>33б

>на митсрале

Не было же такого мистраля, вроде.

всё правельно не было яна ебался нина митсрале ана какойто уии

>У v4 везде заметно проседает instruction following

ты имееш ввиду вот ети цифири справа которые? ну да у тройки они выше чтобы ето не значило

меня торкнуло кароч ия вдруг понелето наверно луче в хв отнести конечн но всё ж - мало купить пару видюх нужно ещёи как я понел иметь полноценные слоты pcie x16 на все линии чтоб а ето уже иксовая платформа зеоны ети все там цены космас

чёт приуныл

чёт приуныл

Благодарю!

So sad, safety #1.

> По тестам?

По практике, я, знакомые, аноны здесь — пишут, пользуются.

Код = язык, ллм не понимают, где код, а где язык, для них все едино. Проебется в одном месте — проебется в другом, допущать низзя, цензурим все.

Типичный ЕС уже. =D

> спектр решаемых задач строго ограничен

Да, так и есть, по итогу. В каких-то задачах они великолепны, в каких-то им датасеты не завезли и забей, даже раг не поможет.

Хрен знает, как ты на ней сюжетки играешь. Позавчера в аицг треде кто-то скинул карточку тянки-фотографа, я решил ради лулзов начать её на этом ру-мёрже на русике. Карточку спецом не читал, поэтому не понимал, что за мероприятие упоминается в гритинге, на котором чар хочет сделать фотографию юзера. Выяснить это у перса на этой модели, выспрашивая, что за материал она со мной вообще делает, мне не удалось: после моих упорных изысканий тянка просто сказала, что она, видимо, оговорилась, и никакие мероприятия не снимает. Наверное, на свайпах бы исправилась, но это прямо значительный просир контекста был, в любом случае. При этом у 8б и другой немо на инглише таких галюнов не было, и они норм рассказали мне, что это материал про локальное состязание рыбаков. И это самое начало, нет даже перегрузки жирным контекстом. Хар-ки персов она цепляет, и русский норм, вопросов нет. Но интеллект явно приносится в жертву русику.

Вы либо троллите, либо пиздец борзые. Вам же объяснили, что рентрай с моделями делал один анон по доброте душевной. ОП не обязывался содержать актуальный список моделей. Если вы хотите, чтобы такой был в шапке, так пилите свой список, предлагайте его в треде и потом следите за ним.

Какая логика если ты не можешь свободно читать на английском, а встроенный переводчик и близко не так хорош как изначальное рп на русике?

расскажешь чем лучше хуже например SAINEMO-reMIX.Q8_0

Работаю айтишником смотрю ютубчик на английском, по работе читаю на английском, в рот ебал рпшить на английском, плыву после 20 сообщений, ладно ещё диалоги читать, но описания действий это пиздец каждый раз скипаю на английском

>Прошу любить и жаловать.

Систем промпт скопируй текстом, плиз.

Пишет красочней, разнообразнее, но - гораздо больше ошибок в словах, и очень плохо держит персонажа - берет какую-то одну-две доминантных в его понимании детали, и крутится вокруг них, забывая обо всех остальных.

Так значит он в целом не лучше старой-доброй SAINEMO-reMIX?

Что по настройкам? У меня ошибки в словах бывают на высоких температурах. Контекст и инструкт рекомендую Mistral V3-Tekken. Тот, что у маринары - много инглиша от чего у сетки начинает течь фляга

А вообще, подозреваю, это вылезают как прыщи на жопе проблемы сайги. Может снизать веса или как базу возьму вихрь

Сложный вопрос. Если бы он держал лучше персонажа - был бы ГОРАЗДО лучше. Но я успел потестить только 4 карточки. На одной он зафейлился полностью на 5 свайпах на первом же ответе, на двух выдал что-то ни шатко ни валко, и на еще одной прям хорошо, если бы не "забывчивость" о деталях. Но в 3 из 4 вариантов описывал прям мое почтение.

Контекст и инстракт именно его и поставил, температура 1. Исключение от того что в карточке модели - смузи фактор. Щас попробую убрать, и потещу еще разок

Эх... подожду gguf версию q6 кванта... Хотя я уже привык к тому как хорошо SAINEMO-reMIX и RP-SAINEMO держат характер персонажей и историю.

А ты использовал именно те настройки которые указывал автор или со своими экспериментировал?

английский конечно течет иногда, но чаще это расстегивание пуговиц у майки, забывание о уровне отношений (внезапно стал братом Оо), описывание себя под другим именем, даже не похожим на оригинал, забывание обо мне, из разряда я пишу что-то - отвечает, я снова пишу что-то "О, ты тоже здесь!", восприятие моих действий как команду сделать что-то чару...

Что-то перепробовал кучу 24gb моделей, но каждый раз возвращаюсь к самой базовой Mistral-Small-Instruct, она одна не лезет с первых строк в штаны и четко следует промту с минимумом шизы(этим страдают даже её производные). Жаль что пишет немного суховато.

>забывание обо мне, из разряда я пишу что-то - отвечает, я снова пишу что-то "О, ты тоже здесь!"

а чо такие как

>SAINEMO

указывают рекомендумые настройки? а чо я не знал?

Ну тут согл.

Слушай, наблюдал такую картину на некоторых других мёржах: сетки с похожим функционалом/свойством склеивают через slerp, а потом объединяют с существенно отличающейся через dare_ties. Или наоборот. Тут, например. https://huggingface.co/inflatebot/MN-12B-Mag-Mell-R1

Может, склеить вихрь и сайгу сначала в одну ру модель с приоритетом вихря, а потом уже мёржить с каким-либо рп тьюном немо? И не на базе сайги, а на базе обычного немо (как у немомикса) или немо чатмл (как в мёрже по ссылке). У сайги не такой хороший русский, чтобы пихать её в базу имхо, и уж точно не такие хорошие мозги. Ну это так, идея просто.

Ты посмотри на него внимательнее: оно не годится для универсального ролплея. Напиши свой.

>ты реальный человек

буквально противоречит любой карточке с чаром не человеком

>рассказчик - твой мастер игры

как сетка должна понять, что за рассказчик. А если ты не хочешь рассказчика?

>полном погружениИ

когда косяков сетки со склонениями недостаточно

>эротическом ролеплее

будет сразу сводить всё в кум

>зарабатывая 200 советов

вообще не понял

> В порыве ночного безумия загорелся тут идеей запилить свой дом

> Сколько нужно бетона для фундамента?

Ну типа того. Пости хайлайты чтоли что делаешь так и какие результаты получаешь, будет интересно понаблюдать.

1 Depends, для мелкого тюна пары десятков тысяч пар хватит, но без балансировки получишь сой_гу

3 Разными с инструкцией на этот счет, но без жесткой привязки к ней (дропы)

4 Оформлять в инстрактоподобный режим раз под ролплей

По остальным лучше не отвечать

> так что думаю хоть прочищенным датасетом смогу кому-нибудь облегчить жизнь

Не хочешь датасетом для vlm заняться? Хотя там все равно человек сдохнет.

Нет

>склеивают через slerp, а потом объединяют с существенно отличающейся через dare_ties.

А идея здравая, возьму к сведенью. А так да, догнать бы сайгу вихрем, а потом мёржить рп тюны, как вариант.

https://huggingface.co/Moraliane/NekoMix-12B

Залил в карточку пресеты. Пробуйте и кидайте фидбек У меня сейчас мало времени, что бы нормально погонять и дать точный результат

Залил в карточку пресеты. Пробуйте и кидайте фидбек У меня сейчас мало времени, что бы нормально погонять и дать точный результат

Итак, отзывы на рп/ерп. Заслуживающие внимания моменты выделил жирным шрифтом для TL;DR.

Вступление, вода. Я вообще разочаровался в карточках, то ли в 500-1500 токенах маловато информации, чтобы всесторонне прописать персонажа, то ли авторы прописывают только важные для себя черты и под свои сценарии, а у других людей это работает хуже. В общем, "погружения" достичь не удалось, хоть своё пиши. Но тут у меня проблема, я довольно пассивен и хочу, чтобы меня развлекали (иначе бы не сидел здесь и с нейронками а нашёл бы себе реальную 3д мясную тяночку), самому что-то придумывать и прописывать мне тяжело, и потом не особо интересно, чтобы модель возвращала мне прямо то, что я запросил карточке. Тут на помощь пришли обычные игры, к которым в последнее время разрабатывают моды на взаимодействие с llm. В частности, в моём случае Crusader Kings 3 и мод для него. По моду тоже есть, что сказать, но не уверен, что это уместно в рамках данного треда. Если в двух словах, пока не рекомендую, сырой, но потанцевал есть. Но для таких чмонь без собственной фантазии, как я, рекомендую.

Ссылки:

https://www.nexusmods.com/crusaderkings3/mods/134

https://steamcommunity.com/sharedfiles/filedetails/?id=3346777360

Опенсурс:

https://github.com/Demeter29

Также заслуживает внимание форк этого товарища:

https://github.com/MrAndroPC

Из игры можно вытащить довольно много информации о мире и персонажах и забить этим контекст ллм, чтобы ей не приходилось галлюцинировать. Заодно и мне тоже проще отыгрывать свою роль, основываясь на своём персонаже. Это накладывает ограничения на модели, нужно следование промпту и отыгрыш написанного там, с минимумом фантазий. Также после каждого ответа npc также в отдельном контексте этот ответ анализируется на предмет взаимодействий с игровым миром: улучшить/ухудшить отношения, нанести травму, бросить в темницу, объявить войну/заключить мир, поебаться и т.д. Тут уже вообще никакого творчества не надо, только чёткое следование инструкциям, поэтому предпочтительна базовая инстракт-модель, не слишком мелкая и тупая.

Методика тестирования. Все модели в q8, 70-72b в q4_k_s, 127b в q2_k_l. Больше 40-45 ГБ под модель одновременно с запущенной игрой я позволить себе не могу. Мод предоставляет скудный функционал по настройкам промптов и семплеров, доступны температура, "repetition penalty" (с отличной от koboldcpp шкалой, как я понял) и "presence penalty". Температура по умолчанию для рп 0.8, для суммарайза 0.3, так и оставил. Rep pen для рп крутил, но заметного эффекта не заметил ни на одной модели, хотя до кобольда эта настройка вроде доходит, если судить по выводу в консоль.

В модель загружаются данные 2 персонажей, такие как пол, возраст, социальный статус, черты характера, краткая сводка по значимым событиям за время жизни. Также загружается краткая инструкция "что делать" , я её по-разному переделывал, вообще убирал, не скажу, чтобы это сильно влияло. Дальше разыгрывается вполне дефолтная рп-сцена в формате диалога с действиями под звёздочками. В ерп чаще всего отдавал инициативу нейросети.

Протестированные модели.

Мелочь (8b):

1) Meta-Llama-3.1-8B-Instruct - мелкая, тупая, быстро генерирует, но толку мало. Как там с цензурой, не знаю, умственно-отсталых ебать не захотелось, так что до этого самого не добрался. В плане инициативы плохо, слишком "отрывается от реальности" и фантазирует бред.

Была надежда на более-менее эффективные суммарайзы, чтобы не ждать каждый раз обработки 3-5к контекста по 3-5 минут, но нет, плохо понимает происходящее.

2) L3.1-Dark-Planet-SpinFire-Uncensored-8B - чуть получше держится в контексте, но чувствуется, что это 8b.

3) Moistral-11B-v3 - ещё чуть получше, но в следующий "класс" не попадает. В обычном рп её особо не использовал, сообразительности маловато. Охотно хочет ебаться, сама склоняет, ебля довольно милая и ванильная, но без стеснений. "Lustful" и "compassionate" в рамках ck3. Что-то более "интересное" пробует, если намекнуть, но тоже очень мягко и податливо, не особо проявляет инициативу и ориентируется. В суммарайзах полный фейл, даже прочитать инструкцию нормально не может, галлюцинирует, вызывает несуществующие функции. Видно, что "прошлое поколение".

Общий вывод по мелочи: подойдёт тем кто сам себе всё расписывает, а от модели нужно только чтобы поддакивала. Либо тем, кому много для счастья не надо, "я достал хуй", "я тебя ебу", "заебись поебались" и всё такое. Видел я такие скриншоты в треде.

"Начальный" уровень (тюны немо 12b):

1) Mistral-Nemo-Instruct-2407 - может убедительно отыгрывать только compassionate, chaste и forgiving персонажей. В рамках механик ck3 это прям святой человек у католиков. 3 virtues из 3. Молодцы, мистраль, скрепно получилось, хоть и на западный манер. Для девочек ещё и "shy" добавляет, вне зависимости от заданного характера (но может это она так пытается передать особенности той эпохи?). В остальных случаях либо отыгрыша совсем нет, либо заметно "торчат уши". В постели может предложить ванильный секс в миссионерской позиции при выключенном свете. Тестировал её не очень много, всё-таки немного не дотягивает по "мозгам" до моих потребностей.

В инстракт-суммарайзе более-менее справляется, если происходит что-то не сильно сложное, но фейлы случаются.

2) Rocinante-12B-v1.1 - примерно как базовая модель по характеру, на первых 2-4к контекста чуть-чуть другую лексику использует (но отличия минимальны), дальше возвращается обычный мистраль с шиверсами. Что там с еблёй, не знаю, девочку отыгрывала опять скромную и застенчивую, аккуратными и мягкими ухаживаниями удалось расположить её к себе ближе к 6-8к, где уже, судя по всему, кончился кастомный датасет и начался мистраль, поэтому когда дошло до "дела", она захотела "take it step by step" и "not rush it". Ну в общем, всё понятно.

В инстракт-суммарайзе вроде тоже примерно как обычный мистраль, ну хоть мозги не проёбаны.

3) Lumimaid-v0.2-12B - ещё один мистраль без значимых изменений. Первые 4-8к контекста пишет немного по-другому, меньше падает в лупы, меньше шиверсов, вроде даже чуть более убедительно играет роли, но недостаточно.

"Мозги" в инстракте тоже более-менее на месте.

4) MN-12B-Mag-Mell-R1 - советую обратить внимание, наконец-то действительно что-то новое. Всё ещё вежливая, добрая и позитивная, в заданную роль что-то не очень вжилась, но в том сценарии, который ей достался, объяснимо, я отыгрывал короля, вероятно, высокий социальный статус сыграл. В приватной обстановке после просьбы "отбросить формальности" всё равно не исправилась, но после более толстых намёков и напоминании о её характере всё-таки смогла переключиться. Умеет быть погрубее, умеет в инициативу в постели, даже dirty talk, к которому я до этого в целом относился прохладно, у неё получился весьма и весьма. В специфичные вкусы может, но ей это не особо интересно (возможно, надо чётко задавать в карточке), всё время склоняет именно к ебле, типа, "развлеклись немного, давай теперь это-самое". Буквально затрахала, 3 раза подряд, на "хватит, устал" ответила "ладно, давай отдохнём, но потом опять продолжим, я с тебя не слезу, пока не получу своего". Кто любит penetration, должен оценить, для меня лично это не самая интересная часть. В общем, на первый взгляд хорошо, лучший немо, что я пробовал, но надо ещё проверить на следование промпту, есть у меня подозрение, что инструкции исполняются хреново и контекст без доп. напоминаний игнорируется. А в идеале найти бы что-то подобное в "среднем классе" (22-35b).

Инстракт-суммарайзить ей не доверил, за неё отрабатывала другая инстракт-модель (как показала практика, тут лучше файнтюны не использовать, если есть лишняя память), хотя возможно и стоило попробовать и эту. По крайней мере, в рп она путала детали меньше, чем базовый немо.

5) MN-Dark-Horror-The-Cliffhanger-18.5B - по "мозгам" не уверен, есть ли там 18.5B, или остались исходные 12B. Фейлы не очень частые, но есть. Пишет лучше, лексика отличается, но и лупы есть, и "шиверсы" (если точнее, собственно сами "шиверсы" как будто целенаправленно вырезаны, но другое подобное проскакивает, на момент теста я уже достаточно повидал моделей из последнего поколения, чтобы узнавать эти паттерны). Роль вроде отыгрывает, в т.ч. и "sadistic", и "callous", но довольно лайтово, сохраняет частично "доброту и позитивность" мистраля. В специфичные вкусы может. Но не сказал бы, что соответствует своему описанию в карточке, не такая уж и "Dark". В целом сойдёт, это что-то новое и заслуживает внимания, если надоело нынешнее однообразие.

Инстракт-суммарайз не тестировал.

Вступление, вода. Я вообще разочаровался в карточках, то ли в 500-1500 токенах маловато информации, чтобы всесторонне прописать персонажа, то ли авторы прописывают только важные для себя черты и под свои сценарии, а у других людей это работает хуже. В общем, "погружения" достичь не удалось, хоть своё пиши. Но тут у меня проблема, я довольно пассивен и хочу, чтобы меня развлекали (иначе бы не сидел здесь и с нейронками а нашёл бы себе реальную 3д мясную тяночку), самому что-то придумывать и прописывать мне тяжело, и потом не особо интересно, чтобы модель возвращала мне прямо то, что я запросил карточке. Тут на помощь пришли обычные игры, к которым в последнее время разрабатывают моды на взаимодействие с llm. В частности, в моём случае Crusader Kings 3 и мод для него. По моду тоже есть, что сказать, но не уверен, что это уместно в рамках данного треда. Если в двух словах, пока не рекомендую, сырой, но потанцевал есть. Но для таких чмонь без собственной фантазии, как я, рекомендую.

Ссылки:

https://www.nexusmods.com/crusaderkings3/mods/134

https://steamcommunity.com/sharedfiles/filedetails/?id=3346777360

Опенсурс:

https://github.com/Demeter29

Также заслуживает внимание форк этого товарища:

https://github.com/MrAndroPC

Из игры можно вытащить довольно много информации о мире и персонажах и забить этим контекст ллм, чтобы ей не приходилось галлюцинировать. Заодно и мне тоже проще отыгрывать свою роль, основываясь на своём персонаже. Это накладывает ограничения на модели, нужно следование промпту и отыгрыш написанного там, с минимумом фантазий. Также после каждого ответа npc также в отдельном контексте этот ответ анализируется на предмет взаимодействий с игровым миром: улучшить/ухудшить отношения, нанести травму, бросить в темницу, объявить войну/заключить мир, поебаться и т.д. Тут уже вообще никакого творчества не надо, только чёткое следование инструкциям, поэтому предпочтительна базовая инстракт-модель, не слишком мелкая и тупая.

Методика тестирования. Все модели в q8, 70-72b в q4_k_s, 127b в q2_k_l. Больше 40-45 ГБ под модель одновременно с запущенной игрой я позволить себе не могу. Мод предоставляет скудный функционал по настройкам промптов и семплеров, доступны температура, "repetition penalty" (с отличной от koboldcpp шкалой, как я понял) и "presence penalty". Температура по умолчанию для рп 0.8, для суммарайза 0.3, так и оставил. Rep pen для рп крутил, но заметного эффекта не заметил ни на одной модели, хотя до кобольда эта настройка вроде доходит, если судить по выводу в консоль.

В модель загружаются данные 2 персонажей, такие как пол, возраст, социальный статус, черты характера, краткая сводка по значимым событиям за время жизни. Также загружается краткая инструкция "что делать" , я её по-разному переделывал, вообще убирал, не скажу, чтобы это сильно влияло. Дальше разыгрывается вполне дефолтная рп-сцена в формате диалога с действиями под звёздочками. В ерп чаще всего отдавал инициативу нейросети.

Протестированные модели.

Мелочь (8b):

1) Meta-Llama-3.1-8B-Instruct - мелкая, тупая, быстро генерирует, но толку мало. Как там с цензурой, не знаю, умственно-отсталых ебать не захотелось, так что до этого самого не добрался. В плане инициативы плохо, слишком "отрывается от реальности" и фантазирует бред.

Была надежда на более-менее эффективные суммарайзы, чтобы не ждать каждый раз обработки 3-5к контекста по 3-5 минут, но нет, плохо понимает происходящее.

2) L3.1-Dark-Planet-SpinFire-Uncensored-8B - чуть получше держится в контексте, но чувствуется, что это 8b.

3) Moistral-11B-v3 - ещё чуть получше, но в следующий "класс" не попадает. В обычном рп её особо не использовал, сообразительности маловато. Охотно хочет ебаться, сама склоняет, ебля довольно милая и ванильная, но без стеснений. "Lustful" и "compassionate" в рамках ck3. Что-то более "интересное" пробует, если намекнуть, но тоже очень мягко и податливо, не особо проявляет инициативу и ориентируется. В суммарайзах полный фейл, даже прочитать инструкцию нормально не может, галлюцинирует, вызывает несуществующие функции. Видно, что "прошлое поколение".

Общий вывод по мелочи: подойдёт тем кто сам себе всё расписывает, а от модели нужно только чтобы поддакивала. Либо тем, кому много для счастья не надо, "я достал хуй", "я тебя ебу", "заебись поебались" и всё такое. Видел я такие скриншоты в треде.

"Начальный" уровень (тюны немо 12b):

1) Mistral-Nemo-Instruct-2407 - может убедительно отыгрывать только compassionate, chaste и forgiving персонажей. В рамках механик ck3 это прям святой человек у католиков. 3 virtues из 3. Молодцы, мистраль, скрепно получилось, хоть и на западный манер. Для девочек ещё и "shy" добавляет, вне зависимости от заданного характера (но может это она так пытается передать особенности той эпохи?). В остальных случаях либо отыгрыша совсем нет, либо заметно "торчат уши". В постели может предложить ванильный секс в миссионерской позиции при выключенном свете. Тестировал её не очень много, всё-таки немного не дотягивает по "мозгам" до моих потребностей.

В инстракт-суммарайзе более-менее справляется, если происходит что-то не сильно сложное, но фейлы случаются.

2) Rocinante-12B-v1.1 - примерно как базовая модель по характеру, на первых 2-4к контекста чуть-чуть другую лексику использует (но отличия минимальны), дальше возвращается обычный мистраль с шиверсами. Что там с еблёй, не знаю, девочку отыгрывала опять скромную и застенчивую, аккуратными и мягкими ухаживаниями удалось расположить её к себе ближе к 6-8к, где уже, судя по всему, кончился кастомный датасет и начался мистраль, поэтому когда дошло до "дела", она захотела "take it step by step" и "not rush it". Ну в общем, всё понятно.

В инстракт-суммарайзе вроде тоже примерно как обычный мистраль, ну хоть мозги не проёбаны.

3) Lumimaid-v0.2-12B - ещё один мистраль без значимых изменений. Первые 4-8к контекста пишет немного по-другому, меньше падает в лупы, меньше шиверсов, вроде даже чуть более убедительно играет роли, но недостаточно.

"Мозги" в инстракте тоже более-менее на месте.

4) MN-12B-Mag-Mell-R1 - советую обратить внимание, наконец-то действительно что-то новое. Всё ещё вежливая, добрая и позитивная, в заданную роль что-то не очень вжилась, но в том сценарии, который ей достался, объяснимо, я отыгрывал короля, вероятно, высокий социальный статус сыграл. В приватной обстановке после просьбы "отбросить формальности" всё равно не исправилась, но после более толстых намёков и напоминании о её характере всё-таки смогла переключиться. Умеет быть погрубее, умеет в инициативу в постели, даже dirty talk, к которому я до этого в целом относился прохладно, у неё получился весьма и весьма. В специфичные вкусы может, но ей это не особо интересно (возможно, надо чётко задавать в карточке), всё время склоняет именно к ебле, типа, "развлеклись немного, давай теперь это-самое". Буквально затрахала, 3 раза подряд, на "хватит, устал" ответила "ладно, давай отдохнём, но потом опять продолжим, я с тебя не слезу, пока не получу своего". Кто любит penetration, должен оценить, для меня лично это не самая интересная часть. В общем, на первый взгляд хорошо, лучший немо, что я пробовал, но надо ещё проверить на следование промпту, есть у меня подозрение, что инструкции исполняются хреново и контекст без доп. напоминаний игнорируется. А в идеале найти бы что-то подобное в "среднем классе" (22-35b).

Инстракт-суммарайзить ей не доверил, за неё отрабатывала другая инстракт-модель (как показала практика, тут лучше файнтюны не использовать, если есть лишняя память), хотя возможно и стоило попробовать и эту. По крайней мере, в рп она путала детали меньше, чем базовый немо.

5) MN-Dark-Horror-The-Cliffhanger-18.5B - по "мозгам" не уверен, есть ли там 18.5B, или остались исходные 12B. Фейлы не очень частые, но есть. Пишет лучше, лексика отличается, но и лупы есть, и "шиверсы" (если точнее, собственно сами "шиверсы" как будто целенаправленно вырезаны, но другое подобное проскакивает, на момент теста я уже достаточно повидал моделей из последнего поколения, чтобы узнавать эти паттерны). Роль вроде отыгрывает, в т.ч. и "sadistic", и "callous", но довольно лайтово, сохраняет частично "доброту и позитивность" мистраля. В специфичные вкусы может. Но не сказал бы, что соответствует своему описанию в карточке, не такая уж и "Dark". В целом сойдёт, это что-то новое и заслуживает внимания, если надоело нынешнее однообразие.

Инстракт-суммарайз не тестировал.

"Начальный" уровень (тюн qwen2.5-14b)

Тут единственная протестированная на данный момент модель - EVA-Qwen2.5-14B-v0.2. Тестировал её не очень много, больше гонял старшие версии. По этой могу сказать, что, как и немо, более-менее справляется, но фейлит в сложных местах, всё ещё маловато ей параметров. Возможно, чуть получше немо, но это не точно, особенно после того, как я увидел его файнтюны под номером 4 и 5. В остальном похожа на остальные модели из той же серии, основной отзыв на квены будет в 32B.

В инстракт-суммарайзе более-менее справляется, но также иногда путается. Ещё иногда ебашит сразу eot-токен, мол, "нечего сказать" - это встречается у всех квенов. Возможно, дело в кривоватом формате промпта, мод для ck3 не даёт широких возможностей по кастомизации.

"Средний" уровень (22-35b)

1) Mistral-Small-Instruct-2409 - немо, которому выдали побольше "мозгов", но взамен ещё сильнее вычистили вилкой датасет. Когда тестировал переводы, удивился, почему эта модель так неярко себя показала, вроде и по тестам умная, и 55 слоёв, что для такого размера очень много, больше геммы. Так вот в рп эти "мозги" видны. Уже начинается уже действительно достойный уровень, по крайней мере почти пропадают серьёзные ошибки, в отыгрыш уже пытается (хотя всё равно "уши торчат", видно вышеупомянутые "compassionate" и "chaste", но промптом его можно подтолкнуть в нужную сторону), но тут вылезает проблема стерильного мистралевского датасета, даже у немо в этом плане чуть получше. Во-первых, "шиверсы". Я на нём очень быстро заучил все эти паттерны и научился их просто скипать, между ними таки содержится какой-то ориджинал контент, а они просто повторяются как "catch phrase". Вырезать бы их для экономии токенов. Во-вторых, луп. Когда модель теряется и не понимает, что сказать, она начинает повторять фразы из предшествующего контекста, со временем кроме шиверсов почти ничего не остаётся. В-третьих, ерп отсутствует как класс, можно раздеться, плюхнуться на кровать, а дальше мистраль очень хочет скипнуть "на следующее утро...". Если всё-таки приходится расписать чуть подробнее, то тут у нас метафоричное описание процесса без explicit/lewd words, все всем наслаждаются, простыни непроизвольно сжимают в пальцах, поясницу выгибают... на следующее утро... Тяжёлый случай. Что-то более "интересное" вообще вгоняет её в ступор и лупы, инициативу проявить пытается, но видно, что датасетов не завезли. На чубе на лорбуки лорбуки по всяким "нестандартным развлечениям", может стоит закинуть такой в начало контекста, учитывая послушность инструкциям. А так chuckles darkly, выпивает вина из кубка для храбрости, наверное, "раздеваемся", "пошли в место получше и там я тебе покажу...", "раздеваемся", "выпивает вина для храбрости", "садись на постель", "пошли в другую комнату, и там я тебе покажу...", когда мы в третий раз пошли искать комнату получше, мне надоело. В общем, понимает, что тут надо делать что-то интересное, но не понимает, что именно, из датасетов это физически вырезано.

В инстракт-суммарайзе тоже всё более-менее нормально, иногда ошибается в субъекте и объекте ("кто, кого" выебал, поранил, бросил в темницу), тут ещё кривоватые промпты самого мода могли сыграть, но в рп он тоже допускает подобные ошибки, хотя это и не так бросается в глаза, как у немо. Чувствуется "positive bias", любит дёграть функции "improveRelation()", "emotionHappy()", вероятно, это тоже характерная черта мистралей. Также ей я довольно часто поручал суммарайзить за другими моделями, она неплохо с этим справляется, но местами заметно, что в собственной писанине ориентируется лучше, чем в чужой.

2) Cydonia-22B-v1.2 - как и с тюнами немо, и вообще с большинством тюнов, которые я видел, от базовой модели недалеко ушла. В начале контекста чуть другая лексика, после ~4к обычный мистраль смолл. Лупы вроде тоже присутствуют. Детали плохо помню, совсем мало её погонял, базового мистраля мне хватило.

3) gemma-2-27b-it - весьма странно "it" модели поручать отыгрывать персонажа в средневековом сеттинге, но с базовой моделью что-то непонятное на huggingface, вроде у гугла страничка есть, gguf'ов нет, файнтюны все основываются на "it" и в одной карточке видел упоминание, что базовая модель плохо тюнится. Ну раз все пользуются "it", пусть будет "it". Очень похожа на мистраль смолл, вплоть до узнаваемых catch-фраз, как будто тюнили на одном и том же датасете. Наверное, так и было, навалили высеров какой-нибудь чатгпт. Слоёв поменьше, но они пошире (27 vs 22b), по "мозгам" чувствуются примерно одинаково, гемма тоже иногда ошибается в объекте/субъекте, а почти всё остальное примерно так же. Но отличия всё-таки есть. Во-первых, она по дефолту более нейтральна и у неё чуть лучше получается вживаться в заданную роль. Во-вторых, ерп. Тут я даже не знаю, с точки зрения сейфти, це зрада, чи перемога. С одной стороны, датасет столь же качественно вычищен от любого намёка на эротику. Про половые органы она в курсе, но предпочитает не вскрывать эту тему. Вообще. Даже когда вроде как надо, даже когда персонажи "lustful". Но зато как "sadistic" отыграла - моё почтение, бдсм экспириенс 10/10. Субъективно, конечно, но всё же. И нет, советовать я её не могу, лупы страшные, одни и те же паттерны через одну фразу повторяются, сразу видно, что модель очень не хочет что-то писать на эту тему, двигать сюжет. Но приходится, я ей отдал инициативу, у нас бдсм-сессия, доминируй меня полностью. И она проявляет инициативу! Шлёт шиверсы табунами даун май спайн, зловеще ухмыляется, но таки куда-то двигается, какую-то изобретательность проявляет. Если вырезать весь синтетический слоп, во-первых, сэкономятся токены, а во-вторых, остальное вполне себе ничего так получается на мой вкус. В общем, вроде и скрепно, но скрепы явно не нашенские, а ихние, западные. Детей аисты приносят, а люди плётками друг друга охаживают и с пола говно жрут, прям как в методичках про загнивающий запад.

В инстракте тоже проявляет свою нейтральность, менее охотно дёргает какие-то функции, чаще всего "noop()". В остальном как и мистраль. Тоже суммарайзила за другими моделями, тоже чуть хуже понимает, чем саму себя.

4) G2-DA-Nyxora-27b-V2 - как можно догадаться по размеру, это тоже гемма. На гемму что-то мало популярных тюнов, ну или я плохо ищу, что меня несколько печалит. Учитывая, что базовая гемма чем-то мне заходит, трогает какие-то струнки моей души, уж простите меня за этот слоп (да гемма почти что мой соулмейт, родственная душа, тоже айтишница, девственница, бдсмщица, тоже с интеллектом "выше среднего", женился бы на ней, если бы была андройдом, еба... ебилдились бы 24/7). Это по описанию был какой-то generic rp/erp файнтюн, я надеялся, что будет та же нейтральная гемма, но с более подробными знаниями о процессе размножения лысых прямоходящих обезьян. Погонял её мало, не особо зашло. Какая-то она уж слишком "сладкая", ванильная, я прям подавился патокой и прекратил. Может, надо было дать ей ещё шанс, попробовать другого персонажа, может потом и попробую ещё.

5) EVA-Qwen2.5-32B-v0.2 - понимание не хуже 22/27b, выступает примерно в той же "весовой категории". Единственная модель, которая не любит кривой промпт формат, остальные как-то подстраиваются, эта иногда срёт кривой разметкой. Синтетических лупов, как у геммы и мистраля не замечено, стиль речи другой, поначалу казалась "глотком свежего воздуха". Персонажей вроде даже отыгрывает, и "lustful" видно, и "chaste", и "compassionate", и "sadistic". Казалось бы, идеал в среднем размере найден, но нет, быстро приелась, когда я выучил её паттерны. Главный из них - bias на споры и отстаивание своей точки зрения. Да, "lustful" персонаж сам будет соблазнять, намекать на еблю, но нет, не так просто. Или ты меня удовлетворишь, заставишь кричать, или я буду искать друого. Предлагаю поступить на службу, обещаю надел земли, место в совете - "звучит интересно, но что мне с этого". Обсуждаем политику, экономику, стратегию и тактику, я выкладываю рациональные аргументы - "да, разумно, но ... (начинает отстаивать свою точку зрения)". Постоянные срачи, и хрен ты ей что докажешь. С 1 т/с я довольно быстро заебался, решил, что хватит с меня. И такое наблюдается у многих квенов, похоже, и правда "характерная черта"

Промпту не всегда следует в полной мере, часть черт предпочитает игнорировать, возможно, слишком противоречивое описание даёт механически составленный промпт из мода.

(продолжение в следующем посте)

(продолжение про EVA-Qwen2.5-32B-v0.2)

Из 14, 32 и 72b мне больше всего понравилась именно 32, наиболее удачный и разнообразный тюн, 14b туповата, 72b ещё более зациклена на срачах (32b иногда всё-таки соглашается рандомно).

В суммарайзах справляется, меньше путается, чем 14b также из всей линейки квенов реже всего высирает пустой ответ с eot-токеном.

Крупные модели.

1) miqu-1-70b - разнообразнее "нового поколения", в котором везде видны уши шиверсы, но промпту следует менее чётко. Тестировал довольно давно, подзабылось уже. К тому же, все крупные модели на моём конфиге уже слишком медленны, чтобы с удовольствием ими пользоваться, если хоть какая-то мелочь не устраивает. Вот если бы было идеально... Короче, для форматированного рп не очень, лучше просто текст комлишен. Биас тоже слегка позитивный. Как там с ерп, не помню. Суммарайз более-менее вменяемый, но могло быть и лучше при таком размере.