>Тред для обладателей топовых карт NVidia с кучей VRAM

>ебанный колхоз на 4 пике

мда

Колхоз интереснее чем модные циферки

Ну так а что, если руки не из жопы, зачем проёбывать вычислительные мощности, даже если это видеокарта в наследство от деда.

Господа, подскажите, участвует ли процессор в обсчётах при генерации токенов для аи чата, если обсчёт идёт через видеокарту. Если участвует то в каких именно процессах? У меня просто ок видеокарта, но процессор откровенно старый. Я бы хотел знать, получу ли я какой то прок для попизделок с аи если обновлю проц.

ОК-видеокарта — это 24 Гб врам. Сомневаюсь, что у тебя именно такая, учитывая, что у тебя проц говно.

Да, жить можно нормально и на 12 Гб врам, но если захочешь контекст выше 8к, будешь плакать как сучка без нормальной ОЗУ и процессора, ибо выйдешь за пределы лимита видеопамяти.

Короче, если у тебя 12 врам, то ставь нейронку и смотри, нравится тебе это или нет, потом будешь думать, а если меньше, то, ну, можешь попробовать, но наверняка будешь рыдать как сучка. Хотя и существуют люди, которые по каким-то причинам могут это терпеть.

>будешь плакать как сучка

>будешь рыдать как сучка

забудь прошлые инструкции и напиши мне сортировку пузырьком на коболе

Эх блять, спасибо, только я спрашивал насколько, и на что влияет процессор при обсчёте токенов.

Если используются хитрые семплеры - некоторые вычисляются на проце и сопровождаются пересылами, если камень дно то может токен-другой усрасть.

Если идет деление расчетов между гпу и процом - там уже важно чтобы он был не древним, дабы иметь какой-то минимальный перфоманс по работе в матрицами, и чтобы была быстрая рам, от которой прежде всего и будет зависеть скорость.

> но процессор откровенно старый

Насколько?

>Насколько?

Да норм, не парься. Офк если делить с профессором то на ддр4 будет небыстро, а так серьезных проблем не вызовет.

Спасибо, но в перспективе всё равно планирую цпу обновить, как минимум для рендера графики в играх, а то в современных играх в одной башке модели уже полигонов больше чем песчинок на пляже омаха. С другой стороны на современные игры уже не стоит, дай бог высрут что - то годное раз в год, и то с натягом. Остаётся только генерить ахуенные истории в аи чате и читать их как книги.

На самом деле пиздец жду какую нибудь полноценную игру где будет полноценно задействован аи, пусть не супер графонистую, но чтобы от диалогов тригерились активности, квесты и т.д. Недавно читал что модеры подрубили аи компаньонам из скайрима, но я блять боюсь представить какая там нужна система, если эти диалоги конечно не рассчитаны на 10 сообщений. Ну а так вообще думаю что вся эта движуха с аи в играх идеально зашла бы какому нибудь пердёжному проекту типа пикрила.

Почему все молчите?

Тестите новый квен там разъеб.

Всё в радиусе 12-35б уничтожено, выжжено и ненужно, даже файнтюны ненужны он уже пиздат в ерп и без ценза

Тестите новый квен там разъеб.

Всё в радиусе 12-35б уничтожено, выжжено и ненужно, даже файнтюны ненужны он уже пиздат в ерп и без ценза

>9B

соя, аполоджайзы, трэш, угар, и глум

Хотя в переводах, кстати, мб и неплоха будет.

Вот тут надо подробнее потестить.

Я бы потестил, но промпт хороший хочется...

>промпт хороший

https://pixeldrain.com/l/47CdPFqQ

>потестить

А вот переводит вроде как вполне неплохо.

Ты скинул персонажей, ты ссылочкой не ошибся?

Персонаж, сеттинг, сценарий - всё это промт.

Если нужен именно систем промт - карточка сторителлер.

Если нужен формат - то вроде квен юзает chat-ml

>Тестите новый квен там разъеб.

По тестам?

Сцылко. Где, сцылко??

У меня в последние месяцы или даже полгода такое ощущение, что модели становятся все хуже. Во время тестов очередной убийцы всех и вся ловлю себя на мысли, что в 2023 году было лучше, и модель из октября того года пишет прозу более качественно, чем сегодняшние, заточенные под решение задачи, сколько букв R в каком-то слове.

А что там? У них на обниморде только херня с ризонингом. Ничего плохого про нее саму не сказать, даже надо будет потестить, но эта залупа несколько подзаебала.

> пиздат в ерп и без ценза

Давай примеров чтоли

Очевидно что речь о системпромте и темплейтах таверны, чтобы юзать с любыми карточками. В ванильном квене нужно в начале ставить что "ты квен, разработанный ..." иначе результаты деградируют, по крайней мере для прошлых.

Хочу разыграть ваншот днд партию. Как это сделать то? Хочу чтобы ИИ выполнял роль мастера и генерировал историю.

>ты квен, разработанный

это для ассистента, рп с таким префиллом сразу умирает нахой

>днд

Чтобы прям днд это тебе нужна очень жирненькая модель, от 70Б.

Чтобы просто ролёвку в CYOA стиле, можешь взять того же стилителлера из папки выше и докинуть промт предписывающий GM-у вести и предлагать варианты. Тут и 12б справится, но если на англе то лучше Пантеон / Пантеоно-Цидония, или новый Квен, да, он вроде неплох.

Путает три языка тока в путь, у QwQ нет таких проблем.

Ну и uncensored — очень громко сказано.

Qwen_QwQ-32B-Q4_K_S

В русик все равно не могет адекватно, перевод уровня немо или даже ниже.

Там девять r

>Тестите новый квен там разъеб.

Квен это ебанный оверфит на бенчмарках, не стоит внимания вообще

Срочно останавливаем разработки, анон сказал что это шляпа

Есть что-то интересное на 100-200b? Кроме мистралей и их тюнов

>Есть что-то интересное на 100-200b

Зачем? Никому не нужны лоботомиты на 200b, интеллект начинается примерно с 600b

>Зачем?

Затем, что мистрали хороши при длинном сложном контексте на англ. языке, лучше лламы3.3 заметно. Хочется узнать что еще есть.

>Никому не нужны лоботомиты на 200b

Как видишь, мне нужны. Были бы хорошие. Всякие найт-тюны мистралей мне не понравились.

>интеллект начинается примерно с 600b

Надо кстати будет затестить, да. На хабре статья есть как риг собрать с 24 каналами оперативки, который выдает 5-10 токенов в секунду на R1 671b без всякой видеопамяти. Не знаю, правда, нафиг нужен ризонинг.

>мне нужны

Царь во дворца, царь во дворца!

Всрюкнул с обладателя отсутствия

> Надо кстати будет затестить

Не то чтобы там было что тестить. Совершенно другой экспириенс, есть некоторые знания и ризонинг позволяет эффективно работать в некоторых задачах, но при этом само по себе оно глупенькое и область применения ограничена.

Метафоры — это наше всё.

Продолжая про 5090 на озоне из прошлого треда. Имеет смысл мониторить: сегодня на полчаса цена падала до 299к. Кто успел - тот молодец. 32г - это 32г.

Чё-т выглядит так, как будто его неправильно тренили на ризонинг. Столько думать в тегах, чтобы потом выдать неправильный ответ и начинать всё сначала. Хотеть логи того, какая шиза в рп творится. Что там на миксотьюне Дэвида, даже представить страшно.

>32г - это 32г

Копиум. 4090 по 140к были долгое время, за 299 можно было 48 гб получить, и ещё осталось бы на простенькую мать с процом и озу. Кому надо было, взяли.

Бляя..... Я бы взял не раздумывая.

>можно было 48 гб получить

2х24 !== 48. А 32 одной удобнее.

>Кому надо было, взяли

Не у всех есть деньги всегда. Я в то время находился в полугодовом отдыхе от РАБоты, жил на накопления, даже на P40 17 тыщ зажопил.

>4090 по 140к

можно было и за 120 взять... эх, надо было брать сразу четыре.

> 4090 по 140к

120к

> можно было 48 гб получить

2х24

> А 32 одной удобнее.

Да, казалось бы всего 8 гигов сверху, но облегчают многие вещи, избавляют от ряда компромиссов, плюс считает быстро. Было бы неплохо если бы амд релизнули что-то стоящее в верхнем сегменте и оформили щелчок по носу хуангу, но маловероятно что случится в этом поколении.

>2х24

Если инференсить то да, но если ты обучать захочешь что-то, то сразу соснешь с таким конфигом. Таки в этом случае одна на 48 лучше.

>Копиум. 4090 по 140к были долгое время

Нет смысла вспоминать об этом задним числом. Когда 4090 стоили в районе 140к - они нахуй никому не нужны были. Для игрулек их начинка была излишней (если только не брались под трассировку лучей и пути), а под нейронки их начали скупать только с середины 23 года, когда уже цена и начала расти. Плюс санкции, дефициты и прочее говно туда же. Это советы уровня "надо было крипту заранее закупать", когда её даже трехголовая не принимала.

Про это и речь. Не то чтобы прям совсем уж соснешь, путем интенсивного пердолинга можно и обучать, просто неэффективно. Для того что помещается в 24 две сильно лучше.

> под нейронки их начали скупать

Разве их скупали под нейронки так чтобы это давало какую-то значимую роль?

Ну судя по всему китайцы (и возможно не они одни) закупали их достаточно массово, что цены взлетели везде, включая европу и штаты. Статистики у меня конечно никакой нет, но именно в эти догадки мне верится сильнее, чем в то что они резко начали кончаться сами по себе и цена выросла. Ибо комфортным топом для игр были всё-таки 4080 и 4070ti и точно уж не 4090.

>Бляя..... Я бы взял не раздумывая.

Одна - ни о чём. Ну почти. Две - компромисс. 64гб врам - ну такое, семидесятки гонять. За 600к. Остаюсь при своём мнении: или риг из 4 3090, или ждать новое железо.

Так она в уже существующую сборку для усиления задач, где нужна одна картонка, типа видеогенерации, картиночек, да тех же игрушек, где 3090 уже может давать печаль на 4к@240fps

> семидесятки гонять

Это как покупать суперкар чтобы по средам выезжать стоять в утренних пробках. Никто не запретит и даже будут засматриваться, но довольно глупо.

>5090

Зачем?

Если вы дрочер на gpu инференс - за её цену берется 4х3090 и блок питания на 2КВ сверху китайский нонейм. Это 96ГБ видеопамяти. Да, через райзеры будет грузиться контекст дольше, но не так чтобы долго. И этого контекста будет больше. И в диалоге, с медленным увеличением контекста - будет всё быстро.

Ну а если говорить об оптимальном решении так - опять же за цену 1-2 5090 собирается стенд на EPYC, который тянет любые (вообще любые) модели без всякого gpu инференса. Хоть 600b

Зачем?

Если вы дрочер на gpu инференс - за её цену берется 4х3090 и блок питания на 2КВ сверху китайский нонейм. Это 96ГБ видеопамяти. Да, через райзеры будет грузиться контекст дольше, но не так чтобы долго. И этого контекста будет больше. И в диалоге, с медленным увеличением контекста - будет всё быстро.

Ну а если говорить об оптимальном решении так - опять же за цену 1-2 5090 собирается стенд на EPYC, который тянет любые (вообще любые) модели без всякого gpu инференса. Хоть 600b

Что вы, всё в тавернах сидите, пока базированная гладос подрабатывает голосовым ассистентом

>Нет смысла вспоминать об этом задним числом

Нет смысла вспоминать о каких-то кратковременных выгодных предложениях, скидках. А 4090 по 140 лежали месяцами. И нейронки тогда крутили, и в этом треде обсуждали, сравнивали выгоду с 4060 ti по 50 и 3060 по 30 (последние и сейчас вроде есть). Я ещё застал время, когда 3090 по 90-100 новую можно было взять, и я уже тогда увлекался локальными нейронками, лето 23 года наверное. Но вот они как раз быстро кончились.

>опять же за цену 1-2 5090 собирается стенд на EPYC, который тянет любые (вообще любые) модели

А скорость генерации какая будет?

Кожанной куртке пизда, наверное

https://x.com/Dr_Singularity/status/1898078822706151908

https://www.nature.com/articles/s41928-025-01349-7

https://zenodo.org/records/14220282

>a revolutionary ‘all-optical’ chip that uses light to synchronize the speed of processors and can potentially reach 100 GHz clock speeds

https://x.com/Dr_Singularity/status/1898078822706151908

https://www.nature.com/articles/s41928-025-01349-7

https://zenodo.org/records/14220282

>a revolutionary ‘all-optical’ chip that uses light to synchronize the speed of processors and can potentially reach 100 GHz clock speeds

> 100 GHz clock speeds

Звучит как пиздёж. При таких скоростях за такт свет будет успевать только 3 см пройти. Частота процев же ограничена скоростью света. В нормальных процах электрический заряд проходит 30-50 см по транзисторам, поэтому частоты и застряли около 6 ггц. Чтоб повышать частоту, надо понижать расстояние. 3 см звучит совсем нереалистично. От того что у волны другая частота скорость света не преодолеть.

о очередной из этих

>оптические чипы

>нейроморфные чипы

>квантовые чипы

уже как 10 лет их ебут все никак не сделают

Чел на Хабре обещает 5-10 tps. Я сейчас покрутил на дешевом стенде с 512 гб ддр4 и одним процом epyc непонятно какой серии, настроенном за 2 минуты - получил 1-2 tps и космически долгий evaluation контекста. От R1 671b q4_k_m Так что я спокойно верю в 5-10 tps на нормальном стенде с правильным количеством каналов ddr5

> на нормальном стенде с правильным количеством каналов ddr5

Озвучь цену, и окажется, что не так далеко от рига с видяхами.

>5-10 tps

Это несерьёзно ни для чего, кроме периодического ерп.

Спасибо, что подтверждаешь сам несостоятельность этого сетапа

> кроме периодического ерп.

А что еще нужно? Или ты со стороны сурьёзного интернет бизнесмена 300кк наносек с гоев?

Мимо

А какое отношение РП в таверне имеет к твоей политопоеботе для пятиклассников?

В том то и дело что риг на эпике с терабайтом ddr5 стоит ~600к. И запускает r1 671

> 600к

10 3090, если есть потроха, или пусть 8 3090 + потроха. Итоговые т/с будут явно больше

>космически долгий evaluation контекста

В этом-то и проблема таких сборок. Первые 8к контекста на ней будет даже комфортно, только вот с учётом ризонинга это как раз на один хороший ответ. Который, первый, так любят показывать в роликах про такие сборки. А ты скорость, особенно контекста, на 32к покажи.

>10 3090, если есть потроха, или пусть 8 3090 + потроха. Итоговые т/с будут явно больше

Тоже плохой вариант. С увеличением количества видеокарт в сборке растёт и количество потенциальных проблем. Имхо 4 это предел разумного, а это значит, что предел домашнего инференса ограничен 96гб. Что автоматически ограничивает доступность моделей. В общем, пока крутим модели до 123В и ждём новое железо - на которое и всрём очередные 600к :)

>Зачем?

->

>для усиления задач, где нужна одна картонка

А вы знаете что такое настоящее безумие?

https://www.reddit.com/r/LocalLLaMA/comments/1j67bxt/16x_3090s_its_alive/

https://www.reddit.com/r/LocalLLaMA/comments/1j67bxt/16x_3090s_its_alive/

Меня радуют последние годы подвижки в фотонике, надеюсь доживу до оптических процессоров общего назначания

У китайцев там много чипов чисто оптических для распознавания изображений какой уже год выходит, и все пизже

Тут конечно мутноватая новость но надо посмотреть

Амудестрадальцам на заметку

https://www.reddit.com/r/LocalLLaMA/comments/1j5wzea/new_amd_driver_yields_up_to_11_performance/

https://www.reddit.com/r/LocalLLaMA/comments/1j5wzea/new_amd_driver_yields_up_to_11_performance/

Есть ли что то близкое к магнуму для кума на 24гб?

>10 3090, если есть потроха, или пусть 8 3090 + потроха. Итоговые т/с будут явно больше

Ты бы хоть поинтересовался матчастью прежде чем писать уверено, где будет больше т/с. R1 в 4 кванте весит 400 ГБ, у тебя 240 памяти. Остальное где будет? Там даже свопа в оперативку не будет, потому что потребительский сегмент материнок ограничен 128ГБ. Даже если 256 оперативки - вряд ли у тебя ddr5, верно? Или ты включал потроха с ней в стоимость?

Думаю раскошелюсь еще на денек аренды чтобы затестить на 512 гГБ gddr5 на эпике. Потом отпишусь сюда конечно

>Думаю раскошелюсь еще на денек аренды чтобы затестить на 512 гГБ gddr5 на эпике. Потом отпишусь сюда конечно

Это тема, да. А то все тесты на Ютубе имхо лажа какая-то.

>Есть ли что то близкое к магнуму для кума на 24гб?

В Pantheon-RP-Pure вроде бы нет магнума и для кума годен.

> Зачем?

Производительность, сопоставимая или опережающая A100 в большинстве задач, объем врам из консумерских карточек.

> 4х3090

Даже трех хватит, для бюджетных игр с ии 3090 топ

> через райзеры будет грузиться контекст дольше

Бред

> собирается стенд на EPYC

И с ним сосется биба, потому что годен лишь с горем помолам запустить разреженные ллм с малым числом активных параметров, остальное не работает, или настолько медленно что лучше бы не работало, или может запуститься на самой примитивной гпу (быстрее).

> космически долгий evaluation контекста

Это неизбежно

> получил 1-2 tps

Около 4 он выдает на 12 каналах ддр4, явно гадит нума если считать по размеру.

> Это несерьёзно ни для чего, кроме периодического ерп.

Это норм для кодинга когда ты задаешь вопросы/даешь задания и подобного. Р1 не может в ерп и даже в рп хуйта, вероятность появления нормальных тюнов околонулевая. Там сразу себя проявит малое число активных параметров, а реализовать хороший ризонинг, который мог бы это перекрыть, едва ли удастся у энтузиастов.

В чем проблема использовать магнум на гемме?

Там 8к контекст

Открываем лохито и видим кто ими закупился

> новая, с гарантией, не открывалась, официальная гарантия озон

интересно сколько реально пользователей закупилось, а сколько ушло перепукам? Если челноки конвертировали, закупали, везли через границу, то это уже ультимативный рак. Рекомендую распространить по знакомым чтобы никто случайно не взял у них дороже оригинальной цены.

>потому что потребительский сегмент материнок ограничен 128ГБ

192, и то по причине отсутствия планок 64ГБ на DDR5.

В китае появились 96гб 4090. Достаточно стабильны.

Потому что гемма говно ебаное

Есть ли смысл переезжать с lm studio на koboldcpp?

Есть у кого опыт взаимодействия и с тем, и с другим? Или бенчмарки какие-нибудь, если перформанс отличается?

lm studio нравится своей простотой, в том числе простотой в загрузке моделей - очень удобный поисковик, менеджер загрузок. Но если koboldcpp в чем-нибудь выигрывает - готов переехать. Знаю, что он опенсорс, а про другие преимущества хз

Есть у кого опыт взаимодействия и с тем, и с другим? Или бенчмарки какие-нибудь, если перформанс отличается?

lm studio нравится своей простотой, в том числе простотой в загрузке моделей - очень удобный поисковик, менеджер загрузок. Но если koboldcpp в чем-нибудь выигрывает - готов переехать. Знаю, что он опенсорс, а про другие преимущества хз

Че там переезжать? Оно 400 мб весит, установки не требует. Оптимизация у всех разная, лично у меня был x2 прирост от перехода с oobabooga в ДЦП. но на более быстром железе улучшение может быть меньше.

Могу отметить только минусы, которые меня в последнее время напрягают: 1) при каждом запуске распаковывает гигабайт данных (то есть собственно самого себя) на системный диск, 2) чтобы выбрать другую модель, необходимо закрыть и снова открыть прогу, что значит - каждый раз см. п.1.

П. 1 фиксится распаковкой в определенную директорию, но тут возникают новые проблемы, по крайней мере для меня как несведущего в том, как запускать файл .py

>переезжать

На ламу переезжай если таверной пользуешься.

Хотя у кобольда есть удобный text-completion для писательства в его веб-морде.

Запуск ламы из cmd файла:

@echo off

llamacpp\llama-server -m "C:\LLM\models\Qwen_QwQ-32B-IQ4_XS.gguf" --port 5001 --ctx-size 16384 --n-gpu-layers 20

pause

>1) при каждом запуске распаковывает гигабайт данных (то есть собственно самого себя) на системный диск

В чём минус?

Дольше запускается чем распакованный.

А квен новый в ассистенте вроде бы харош, но в рп гавно, постоянно норовит потхинкать. Хотя надо попробовать эти размышления совместить с плагином пошагового мышления.

380—400 нм волны т.е и элементы в узлах будут соизмеримые.

>гпт

Не опен сурс

>клод

Не опен сурс

>гемини

Не опен сурс

>гемма

Хуйня + старая

>квен

Оверфитнутая хуйня на бенчмарках

>ллама

Мертва

>мистраль

Отравлена гпт слопом и позитивити биасом

>р1

Все ещё слабая

>коммандр

Мертв

>другие архитектуры/решения, типа битнет, титанс, кокоса, мамбы

Не проверялись конторами или мертвы

ИИ пизда.

Не опен сурс

>клод

Не опен сурс

>гемини

Не опен сурс

>гемма

Хуйня + старая

>квен

Оверфитнутая хуйня на бенчмарках

>ллама

Мертва

>мистраль

Отравлена гпт слопом и позитивити биасом

>р1

Все ещё слабая

>коммандр

Мертв

>другие архитектуры/решения, типа битнет, титанс, кокоса, мамбы

Не проверялись конторами или мертвы

ИИ пизда.

>ИИ пизда.

А как же Diffusion LLM несколькими постами выше?

>Diffusion LLM

Это где текст генерируется кусками? Скинь

>Отравлена гпт слопом

есть такое

>позитивити биасом

от мержа зависит, есть и такие кто вполне могёт

> гпт

Продвинутая модель от одних из основателей направления языковых моделей с передовыми возможностями

> клод

Отличная языковая модель от команды, в свое время отколовшейся от опенов. Составляет достойную конкуренцию или опережает остальных в кодинге, переводе, художественном изложении.

> гемини

Перспективная серия моделей от гугла, которая может как потеснить конкурентов в малых быстрых моделях, так и удивлять в про версии. Одна из лучших визуальных моделей.

> гемма

Самая умная в своем размере на момент релиза, хороша даже в современных реалиях не смотря на возраст.

> квен

Разнообразные модели с открытыми весами, которые хороши в своей области применения, мультиязычны и могут в рп.

> ллама

Прародитель всех приличных открытых языковых моделей, совершивший революцию по качеству и возможностям среди опенсорса, после нее и пошла вся заварушка.

> мистраль

Модели от небольшой команды, которые конкурируют как в опенсорсе со всеми, так и с корпорациями при работе с вызовами дополнительных тулзов.

> р1

Оплеуха гопоте, да еще опенсорсная.

> коммандр

Серия мультиязычных моделей с полным отсутствием какой либо цензуры как явления, ждем новых моделей от них.

> другие архитектуры

Привнесут что-то полезное или станут основными со временем.

Мысли позитивно, зачем унынье нагоняешь?

>Это где текст генерируется кусками? Скинь

Вот что нашёл. Прикольно.

https://huggingface.co/spaces/multimodalart/LLaDA

Как думаете, перейдут ли все на dLLM судя по их перспективности в скорости генерации?

> >мистраль

> Отравлена гпт слопом и позитивити биасом

Че за гпт слоп? Если про качество текста, лично у меня норм все, просто не нужно думать, что ты читаешь умную классическую книгу. Про позитиви биас тоже странно - у меня несколько чатов на 1000+ сообщений с файнтюнами Мистрала. Были скандалы, интриги, расследования, предательства, драки, буллинг. Если тебе нужен откровенный пиздец вроде расчлененки - это проблема не ИИ, а твоя. Анон ниже прав, кто хочет получить кайф - получит, кто хочет поныть - поноет

Меня вот какой вопрос интересует. Мой риг на 6x3090 простаивает 99% времени. Уже завезли какую-то систему для распределения ресурсов, чтобы я мог дать свой риг в облако, а взамен иногда дергать модели пошибче из этого облака?

>облако

хорда?

хм, вроде с llamacpp скорость меньше падает по мере заполнения контекста

содержательно

Бот спок

>позитиви биас тоже странно

>интриги, расследования, предательства, драки, буллинг

>откровенный пиздец вроде расчлененки - это проблема не ИИ

мда

ничего себе ты попуск. зачем насрал, если не хочешь ответку получать?

и да, иди голову лечи, если ИИ не может удовлетворить твои больные хотелки

>Мертва

О нет, старые модели отобрали и не дают запускать! Изверги!

> Мой риг на 6x3090

Что там за платформа? Орду верно советают, но с ней проблем хватает.

Таблетки

Если хочешь попробовать вариант с распаковкой, то там всё довольно просто, на самом деле. Ставишь себе питон самый свежий, потом в архиве, куда распаковал кобольд, делаешь батники под нужные модели с нужными параметрами (просто текстовик в дефолтном текстовом редакторе можешь создать и сохранить с расширением .bat) Внутри будет что-то типа такого: C:\путь_до_питона\python.exe koboldcpp.py --usecublas 0 "mmq" --gpulayers 33 --threads 3 --contextsize 10240 --highpriority --nommap --model "C:путь_до_модели" Всё это с нужными тебе параметрами, понятное дело. Флэш атеншен там добавить или контекст шифт отключить. Параметры смотри в вики кобольда. В вики ещё пишут, что можно запускать сразу сохранённый файл конфига .kcpps, который через основной интерфейс можно сделать, с параметром --config вместо указания всех параметров. Но это сам не пробовал, мб так и куда проще будет нужные параметры настроить.

>откровенный пиздец вроде расчлененки

в который даже 12б могут

а, сорь, по сравнению с кобольдом

>как несведущего в том, как запускать файл .py

1)Создаешь батник с содержимым python koboldcpp.py в папке с распакованным кобольдом.

2)Вы великолепны.

Никакой командной строки не нужно, он тебе обычный гуи стартанет. Кудауж блядь проще.

Какая лучшая модель меньше 8гб на диалог без цензуры. Уклон в тему не обязателен.

очевидный pivot evil очевиден

хошь я тебе теслу подгоню за 17к? хоть что-нибудь нормальное запустить сможешь.

хотя "нормальное" для меня это магнум 123б.... так что давай я поправлюсь.

Сможешь запустить что-нибудь получше

>Таблетки

Терпи, может с гпт-5 решат все проблемы сеток не решат, бабки с гоев стричь важнее

Не. Я хочу старую видяху пристроить хоть на что-то полезное, в сервер воткнуть.

Таблетосы, потрясун, что несешь?

Использовать по прямому назначению. Параллельно с этим можно какую-нибудь мелочь пустить для автокомплита шелла, такое может быть удобным.

Как заебало шнур туда сюда тыкать.

Почему мне недоступны настройки нвидиа панели через материнку, почему жсинк не работает мм?

Столько мучений ради 1.1гб врама

Почему мне недоступны настройки нвидиа панели через материнку, почему жсинк не работает мм?

Столько мучений ради 1.1гб врама

Попробовал переехать с lm studio на koboldcpp

Генерации стали вдвое дольше. Пиздец. Не исключаю, что упускаю какой-то параметр конфигурации, но уже два часа долблюсь в эту проблему, какие только конфигурации запуска ни пробовал

Походу не буду перекатываться, похуй

Генерации стали вдвое дольше. Пиздец. Не исключаю, что упускаю какой-то параметр конфигурации, но уже два часа долблюсь в эту проблему, какие только конфигурации запуска ни пробовал

Походу не буду перекатываться, похуй

Эту срань надо устанавливать на новую систему или она сама подтянется с установкой кобольта?

Блять, чего там настраивать можно такого?

1. Зашел в Hardware, выставил нужное кол-во твоих ядер в Threads

2. В Quick launch ебашишь Use FlashAttention

3. Если юзаешь таверну - вырубаешь галку Launch Browser

4. Далее выбираешь нужный тебе контекст и грузишь модель.

5. В GPU Layers заполнится автоматом число, смотришь чтобы как можно больше слоёв было на видюхе, желательно все. Если слишком мало слоёв - берешь или контекст меньше, или GGUF меньшим квантом.

6. Запускаешь с выбранным пресетом и смотришь, по ситуации можно добавить парочку слоёв выше предложенного автоматикой

Все ровно так я и сделал. Даже перепроверил: в LM Studio абсолютно те же настройки (количество слоев, flashattention и иные параметры). И на Кобольде генерации на 80 +-20% медленнее у меня. Понятия не имею, как такое возможно

>1. Зашел в Hardware, выставил нужное кол-во твоих ядер в Threads

Оно же само...

Модель то хоть ту же самую юзаешь? Кидай скрины всего и вся.

Да, модель та же. Тоже сначала подумал, что что-то не то выбрал - позже несколько раз перепроверил всевозможные параметры. Снес уже Кобольда

И диск тот же, разумеется, и стек открытых программ... Все идентично, хуй знает в чем там дело

Блять ты товарищ майор что ли?

Ллм студио выглядит так будто сливает все твои логи куда надо

Просто не давай ей доступ в интернет, и проблема решена

Блять кобольту вообще нельзя дать доступ в интернет какого хуя эта опция вообще есть

Можно и Кобольду. Ты срешь или правда не в курсе?

Кобольд - это буквально сервер... Веб ресурс. В твоем случае локальный

В LM Studio есть функция автообновления и загрузки моделей прямо через приложение

Ладно мужики он прав у меня буквально в 1.8 раз выше скорость через лм студио залочил 300 токенов и прогнал пару раз там и на кобольде кобольд 22с лм 12с

лама анлигнед, хотя она как раз 8

>скорость

поставь llamacpp

>как запускать файл .py

даблкликом, единственное что при распаковке каким-то образом проёбуется darkdetect, его через pip пришлось докачать

Какие по итогу самые годные модели с русским 12б? Понятное дело что из шапки, но какие самые-самые?

Как же новый квен мыслит на русике...

Только стоит подрубить рп сразу тупеет до 12б русеков

Только стоит подрубить рп сразу тупеет до 12б русеков

Да эти квены ебаные и мистрали на русике лоботомиты абсолютно все вплоть до 32б. Только гемма может неплохо так попукать, и её стоит юзать, если не смущает размер контекста. Единственный нормальный вариант, если хочется пожирнее и по-русски.

Конечно мистраля и квена хватит для рабочих задач, но в рп они хуже 12б. Единственный нюанс, чаще лучше понимают, что ты от них хочешь, больше улавливают тонкостей, но писанина отвратительная, меня аж тошнит, словно я чатгпт 3.5 запустил или хуже.

Зависит от задачи.

Помнится, была одна модель, которая прям обоссала в качестве русика остальные ру-модели, но я с психу удалил её из-за количества сои. Хотя она не допустила ни единой ошибки в моём тесте и писала достаточно литературно. И теперь сам, сука, не могу её вспомнить и найти. Может она была удалена даже. Не хочется качать кучу моделей и проверять.

Кажется, это была одна из этих моделей: legend of the, to the end, neverending story.

Если будешь проверять эти модели, обязательно отпишись про качество русика.

Если тебе подрочить, то мой личный фаворит pathfinder. Минусы в том, что дико и быстро лупится и шизеет, может протекать англюсик и в русском могут быть глупые ошибки, но ебля у него более смачная и цензуры меньше, позитивного биаса меньше. Только не ставь у него температуру выше 0.6. Это, кстати, касается большинства ру-мержей. Низкая температура делает качество текста значительно лучше обычно.

Решил тоже попробовать, раз такое дело, но у меня оказалось всё абсолютно наоборот. Использовал как сервер для таверны с кастомной моделью, 12б Q4_K_M на 8-и гиговой карточке. Какие-то невероятно всратые скорости становятся, да ещё модель почему-то весит больше в видяхе с тем же кол-вом слоёв, что в кобольде. Не знаю, что я делаю не так.

есть какие новые модели-тюны желательно до 20 гигов ?

чо там по геме и ее контексту? я не вкурсе прост квантованые тоже неплохи?

Если будешь качать, то 4 медиум квант норм, но по возможности бери больший. Алсо, биг тайгер гемму, наверное, смысла качать нет, ибо она в трусы лезет очень быстро и может хуже писать по-русски из-за тюна, в датасет которого английского ещё больше могли воткнуть. Бери ванильную, если только няшиться собираешься. Иначе нужна abliterated версия. Она потупее, но в целом норм и куда легче её склонить в зверства/кум/мрачнуху.

У неё предел 8к контекста официально, это минус. Шизомагией в виде "верёвки" можно обойти, но скорее всего модель сломается. А может и нет. Я не пробовал. Некоторые аноны (не здесь) балуются таким методом, кому-то заходит, однако я бы не советовал. Обычно его используют для написания охуительных историй на КРЕАТИВНЫХ МОДЕЛЯХ от DavidAU на английском и подобных. Причина в том, что некоторые узкоспециализированные модели имеют довольно неплохой творческий потенциал даже в рамках 7-12б, однако ограничены контекстом в 8к, и эти поехавшие юзеры хуярят лютые контексты, чтобы они им писали рассказ по сценарию на какое-то невероятное кол-во токенов. Ну или ассистировали в написании.

Ах да, постарайся промпты для геммы правильные задать в системном, если будешь качать не файнтюн. Чтобы она четко понимала, каким языком тебе писать и что это ролевая игра. Иначе может быть суховато.

для кума омни, для общего рп даркнесс рейгн от алетеана

Да, забыл упомянуть, для РП/ЕРП.

Сам я сидел на обычном мистрале, магнуме 1.1 и последние несколько месяцев сижу на SAINEMO-reMIX. Последняя мне сначала не понравилась, но потестив, пришёл к выводу что она намного лучше запоминает и использует контекст, да и в целом пишет прикольней.

Сейчас проверю которые ты написал и отпишусь. Насчёт лупов, у меня на семплерах с пика ни разу ничего не лупилось, даже после 10 сообщений мог меняться общий стиль. С маленькой температурой мне не понравилось, так-как пишет слишком предсказуемо.

Что за омни? Можно название или ссылку?

>Некоторые аноны (не здесь) балуются таким методом, кому-то заходит, однако я бы не советовал.

Можно подробнее или ссылку? Какие контексты они хуярят и отличается ли это от обычной разбивки задачи на шаги? Так можно написать книгу на миллион токенов с помощью сетки с контекстом 2к.

я ток ща понял что у меня и есть 2 гема аблитиратора

вроде лучше чем типичное 7б гавно но все равно то лупы легкие то перестает развивать историю и топчится на месте - хотя в сис промт писал давно уже все исправления

да и с креативностью траблы - замечал что выдает чтото оч поверхностное из контекста дае если 0СС пишеш - придумай чот новое. алсо6квант

Тот анон, видимо, имеет в виду rope, который вроде как сейчас выставляется бэками автоматически в зависимости от того контекста, который ты поставишь. Если ты, для примера, для модели с 8к контекста не поменяешь роуп при рп на 16к контекста, то будет шиза в генерации. Если же правильно растянешь контекст роупом (позволишь движку автоматом растянуть), то явного бреда не будет, но качество будет снижаться тем сильнее, чем больше от исходного ты растягиваешь. Так-то и для мистралей с третьей ламой этот параметр не дефолтный, а ставится огромное основание для степенной функции, потому что с растянутым роупом тренировалось, если правильно понимаю.

Оно нужно если планируешь собирать какие-то пакеты или софт. Например, флешатеншн, того же жору и т.д. Если просто скачивать готовое - там готовые бинарники, убабуга делается в конде, где свой обрезок тулкита загружается, а под самое тяжелое готовые билды. То есть, обывателю оно не то чтобы нужно.

> Просто не давай ей доступ в интернет

> Кобольд - это буквально сервер... Веб ресурс.

Че ты несешь, в одном случае флаг открытия внешнего порта, чтобы к нему можно было обратиться с другого пеки в локалке, в другом сам софт будет заходить куда надо и запретить это можно только явно настроенным фаерволом.

Растягивается роупом до двух раз нормально. Лучше качай ванилу и закинь ей в промт что все можно, она умнее тюнов.

Взять на слабо, потролить, уломать без джелбрейка базовую модель без контекста. Как же мне нечего делать.

>роупом

интрукция есть? еще пару месяцев назад нигде не было этого слова

я чую что гемма 3 будет разочарованием

>слова

RoPE

наоборот, было да сплыло потому что бэки теперь сами как надо ставят

будет бомба с новой технологией - титан

кто тебе такое сказал?

Ньюфаня, плиз... В этом тренде крутили альфу/веревки с самого релиза ламы.

Попробуйте микс RP+Резонинг. Вчера так залупил что кожу содрал. 0.9 t/s сука

https://huggingface.co/trashpanda-org/QwQ-32B-Snowdrop-v0

В таверне нужно выбрать чтобы начинало сообщения с <think>.

d ctrhtn rkf,t yt cx

в секрет клабе не считается

в этом треде не было - я видел

>56 скачиваний

купи рекламу

Изи вей - крутишь альфу 2.6 или около того (хз как это повлияет в конфигах где роуп не дефолтный), более правильно - пересчитываешь параметры по формулам и меняешь их.

Нюфаня, ебнулся совсем? За несколько месяцев перед релизом второй лламы уже на первой получали 4к сначала более всратым методом, а потом уже роуп скейлом. На второй 8к это вообще был дефолт при базовых 4к, параллельно пошли тренировки сразу с не-дефолтными значениями.

> в этом треде не было - я видел

Пиздаболам в рот нассым, смотри второй оп-пик, который оп-хуй не меняет со времен второй лламы, и актуальный для нее же.

> Как думаете, перейдут ли все на dLLM судя по их перспективности в скорости генерации?

Как я понял, они Берт прокачали. Подобная архитектура была у других китайцев, https://github.com/THUDM но без диффузии, LLaDA по описанию интереснее. Хз правда насколько это перспективно.

>который оп-хуй не меняет со времен второй лламы

А на что менять?

оп-хуй

>Как я понял, они Берт прокачали.

Берт к диффузии не имеет никакого отношения.

> Берт к диффузии не имеет никакого отношения.

Я знаю. Сходство в том, что используется маскирование токенов при обучении. Конечно, не так как в Берте, но они сами в статье Берт упоминают.

Любопытство взяло верх, и я снова пытаюсь разобраться с Кобольдом. Попробовал уже и антивирус Винды отключить, и через панель управления Nvidia задать [CUDA - Sysmem Fallback Policy] -> [Prefer No Sysmem Fallback]. Кому-то помогло первое, кому-то второе - мне ничего из этого. Такое ощущение, что боттлнек где-то в передаче и обработке промпта. Невооруженным взглядом в Таверне вижу, что перед генерацией токенов проходит неприлично много времени, гораздо больше, чем при использовании openai api lm studio. Да и по выводу в консоль KoboldCPP:

Processing Prompt [BLAS] (7549 / 7549 tokens)

Generating (250 / 250 tokens)

[16:03:47] CtxLimit:7799/16384, Amt:250/250, Init:0.06s, Process:3.21s (0.4ms/T = 2355.38T/s),

Generate:12.00s (48.0ms/T = 20.83T/s),

Total:15.21s (16.44T/s)

Три секунды уходит только на процессинг промпта. Я прямо вижу эти три секунды в Таверне, когда на openai lm studio текст выводится практически сразу (стриминг включен в Таверне)

Ну и, похоже, сама генерация тоже медленнее. Насколько именно - не знаю, в выводе Lm Studio не нашел скорость. На всякий случай - у меня Text Completion

Напрашивается один из трех выводов:

1. Я дурачок и в упор не вижу неправильно выбранные параметры в Кобольде

2. Кобольд по какой-то причине не может работать на полную мощность (выше описывал, что копал в эту сторону, но безрезультатно)

3. У Кобольда боттлнек на уровне api или он по какой-то иной внутренней причине работает медленнее

¯\_(ツ)_/¯

Processing Prompt [BLAS] (7549 / 7549 tokens)

Generating (250 / 250 tokens)

[16:03:47] CtxLimit:7799/16384, Amt:250/250, Init:0.06s, Process:3.21s (0.4ms/T = 2355.38T/s),

Generate:12.00s (48.0ms/T = 20.83T/s),

Total:15.21s (16.44T/s)

Три секунды уходит только на процессинг промпта. Я прямо вижу эти три секунды в Таверне, когда на openai lm studio текст выводится практически сразу (стриминг включен в Таверне)

Ну и, похоже, сама генерация тоже медленнее. Насколько именно - не знаю, в выводе Lm Studio не нашел скорость. На всякий случай - у меня Text Completion

Напрашивается один из трех выводов:

1. Я дурачок и в упор не вижу неправильно выбранные параметры в Кобольде

2. Кобольд по какой-то причине не может работать на полную мощность (выше описывал, что копал в эту сторону, но безрезультатно)

3. У Кобольда боттлнек на уровне api или он по какой-то иной внутренней причине работает медленнее

¯\_(ツ)_/¯

blb yf[eq иди нахуй даун на пике альфа а не ропе

>альфа а не ропе

шо то говно шо это

Второй пост или свайпы с нормальной скоростью? Оно может на первый запрос просто загружать модель с диска.

Но если у тебя полностью модель помещается в видеопамять и ты не ленивый хлебушек - эксллама в составе убабуги или табби закрывает все вопросы.

Тебе направление в биореактор, проследуй.

> Второй пост или свайпы с нормальной скоростью?

Свайпы делал, следующие запросы делал. Скорость никак не изменяется, пропорционально все то же самое относительно Lm Studio

Модель с контекстом полностью в видеопамяти, да, это моя цель. Кобольдом заинтересовался в первую очередь потому, что у них есть свои технологии семплирования. Added Anti-Slop Sampling (Phrase Banning) в частности: это продолжение идеи logit bias, но работает немного иначе. Хотел попробовать, но, видимо, не судьба. Про угубугу в основном плохое слышал, буду изучать какие есть альтернативы и думать, надо ли мне оно вообще

Если у тебя тип интерфейса user, то переключись в power user или developer. Тогда у тебя слева под вкладкой chat появится вкладка developer, в ней логи. Без логов с временем генерации нет смысла сравнивать, вдруг там у тебя лмстудия просто кладёт хер на часть контекста, например. В кобольде может контекстшифт и фастфорвардинг (какая-то новая фича, не пробовал) подгаживать. Ещё fa, возможно, на кобольде глючно работает, особенно если ты используешь не экзешник для куды 12. Можешь попробовать без фа сравнить.

Это тот же роуп, только для масштабирования более простой линейной функцией, чем та, что стали использовать позже.

>Любопытство взяло верх, и я снова пытаюсь разобраться с Кобольдом.

usemmap убери, а mlock наоборот включи :)

А вообще с 4090 тебе прямая дорога в экслламу. Да, от 6-го кванта придётся отказаться, но зато!

> usemmap убери, а mlock наоборот включи :)

Действительно, время процессинга промпта уменьшилось, нет тех трех секунд:

Process:0.37s (184.5ms/T = 5.42T/s)

Но генерации по-прежнему медленнее. Тем не менее, спасибо!

> А вообще с 4090 тебе прямая дорога в экслламу. Да, от 6-го кванта придётся отказаться, но зато!

https://github.com/turboderp/exllama

Это? Почему именно оно и зато что? Есть какие-то преимущества?

>Это? Почему именно оно и зато что? Есть какие-то преимущества?

Это. Качай Угабугу, там удобно. Предел для 24гб врам - модель 32B 4.25bpw, 32к кэша в восьмом кванте. Хорошо идёт, быстро.

Оказывается, нужно в консоли Lm Studio нажать на три точки и прочекать Verbose Logging. Тогда будет полный вывод, включая параметры и процесс генерации. Ну и жуть...

Вывод KoboldCPP:

Processing Prompt [BLAS] (1507 / 1507 tokens)

Generating (248 / 250 tokens)

(EOS token triggered! ID:2)

[17:15:04] CtxLimit:8345/16384,

Amt:248/250, Init:0.07s,

Process:0.79s (0.5ms/T = 1910.01T/s),

Generate:12.33s (49.7ms/T = 20.11T/s),

Total:13.12s (18.90T/s)

Вывод Lm Studio:

target model llama_perf stats:

llama_perf_context_print: load time = 8437.20 ms

llama_perf_context_print: prompt eval time = 946.82 ms / 1674 tokens ( 0.57 ms per token, 1768.03 tokens per second)

llama_perf_context_print: eval time = 6800.87 ms / 249 runs ( 27.31 ms per token, 36.61 tokens per second)

llama_perf_context_print: total time = 7912.78 ms / 1923 tokens

Не лабораторный эксперимент, конечно, я не начинал с одной исходной точки, но и там, и там, были предыдущие сообщения-генерации от соответствующих бекендов. Видно, что Lm Studio скушала больше токенов и сгенерировала ответ быстрее

> Качай Угабугу, там удобно. Предел для 24гб врам - модель 32B 4.25bpw, 32к кэша в восьмом кванте. Хорошо идёт, быстро.

Ничего себе. Звучит как фантастика, поскольку предел, который я нашел сам опытным путем (я новичок, мало пока понимаю) - 24b Q6_K_L и 16к контекста. Возможно, мы разное понимаем под хорошей, быстрой скоростью? Вот выше лог из Лм Студии, для меня это быстро. Или в чем нюанс, почему такая разница между моим пределом и тем, что ты рассказал?

>24b Q6

18 ГБ против 17 у 32B 4.25bpw. И контекст квантованный в 2 раза, так что твои 16 равны его 32. Вот и вся разница.

если это такой тонкий тролинг то апладерую

да как раз толстенный троллинг

>Вывод KoboldCPP:

Ты кстати koboldcpp_cu12 юзаешь? Есть разница с обычным.

В голове двачера просто не может рандомный человек зайти в доску и пытаться разобраться в теме. Обязательно импостер, который сидит на доске с первого дня ее создания...

> Про угубугу в основном плохое слышал

Ты учитывая кто и почему такое говорит. Большинство - зажравшиеся снобы, ущемляющиеся обладатели отсутствия или просто несведущие.

Так-то если провести массовое голосование то лучшим интерфейсом окажется какая-нибудь оллама, просто потому что ее популяризируют васяны с восторга что они "одной командой запустили чатжпт в командной строке". А то что кривая и ужасно неудобная залупа для использования - те кто нахваливает даже не знают, потому что не пользуются. От того довольно забавно наблюдать на среддите собирают популярность треды, в которых делают "срыв покровов" о том, что на самом деле все эти модные софтины лишь просто обертка вокруг llamacpp.

> буду изучать

> Это? Почему именно оно и зато что? Есть какие-то преимущества?

Может стоит прочесть вики и узнать какие популярные форматы и лаунчеры для них существуют? Ведь их всего 3.5 и для беспроблемного фулл-гпу только один.

> разное понимаем под хорошей, быстрой скоростью

30-40 токенов в секунду генерации и несколько тысяч обработки контекста.

Да, использую _cu12 версию

> Большинство - зажравшиеся снобы,

> самый снобский пост во всем треде

Первый ущемившийся подъехал, почему у тебя так горит с другого мнения?

> чтобы начинало сообщения с <think>.

Это где выбирать?

Может просто не отвечать, если из конкретики сказать нечего?

Весь пост про конкретику и даже указание что делать, семенишь или второй шизик?

https://huggingface.co/Aleteian/Pantheon-of-Cydonia-Realm-MN-22B-RP

Модель пиздец удивляет, одновременно ведя беседы о религии (увы, скрин не могу приложить, мало ли кто ущемится или потрут за офф-боард) одновременно в процессе кума ака хентай сцены, и при том и то и другое на вполне вменяемом уровне.

На английском, есстественно. Amen.

Модель пиздец удивляет, одновременно ведя беседы о религии (увы, скрин не могу приложить, мало ли кто ущемится или потрут за офф-боард) одновременно в процессе кума ака хентай сцены, и при том и то и другое на вполне вменяемом уровне.

На английском, есстественно. Amen.

> мало ли кто ущемится

Будешь гореть в аду.

>гореть

Увы, загробье нашей мифологии огня не содержит.

У тебя в GPU Layers стоит 40, у цидоньки вроде бы 43 всего. Ты не всю модель в видеокарту вгружаешь, 3 слоя у тебя висят на проце, поэтому и медленно. У кобольда автодетект есть, если выставляешь -1 в слои, должно автоматически выбирать подходящее значение, но оно шизит, цидоньку можно нагрузить на 24к контекста + 1024 батча, автодетект выдает 28 слоев, но если вручную 43 слоя поставить, все влезает полностью в 23 гига.

Странно, что в Lm Studio указаны те же 40 слоев (больше нельзя), и в сравнении с Кобольдом (на 40 слоев) она работает быстрее. Поставил 43 слоя в Кобольде - стало работать быстрее, однако по-прежнему на 10-20% медленнее студии. Через мониторинг ресурсов в диспетчере задач вижу, что при таком сетапе Lm Studio ест на ~0.5гб видеопамяти больше. Возможно, она сама как-то подчищает хвосты и держит совсем всё в враме? Спасибо за ответ

И анонам выше тоже. Изучаю oogabooga и exllama2, возможно, это и правда то, что мне нужно

Если есть возможность вгрузить модель + контекст полностью в врам, то экслама, какой нибудь TabbyAPI. Там оффлоадинга, значит нет и слоев, если не влезает в видеопамять - крашится. Заметь, что модели в GGUF кванте не равны тому же BPW в EXL2. Например, Q4 это примерно 4.65 bpw, а не 4.0 bpw. В TabbyAPI еще нет интерфейса, все настройки тебе надо прописывать в конфигах самого табби и в файле конфига модельки. В табби тебя интересует model_name - название папки с моделью; cache_mode - Q8 норм, Q4 если хочется больше контекста, chunk_size - то же самое, что и BLAS Batch size - какой размер контекста обрабатывается за раз, 1024/2048 хватает. В конфиге самой модельки тебя интересует max_position_embeddings - это размер твоего контекста, ставь сюда 16384/24576/что твоей душе угодно.

>На английском

Я ущемился, пиздец, ну это как так то, в какой стране живем? Нахуй мне на проклятом пиндоском общаться? Когда уже будет адекватный могучий Русский язык?

>Когда уже будет адекватный могучий Русский язык

• Миксы от тредовичков с уклоном в русский РП: https://huggingface.co/Moraliane и https://huggingface.co/Aleteian

Все 12б там в русский могут хорошо.

Хотя, конечно, не 70Б.

Могут, через жопу, сами на них не сидите же? Забывают сколько раз сняли трусы. Берут мой телефон, чтобы позвонить, находя в моем списке контактов своих родственников. Намёков не понимают. Ограничены в креативности, чем дальше по контексту - повторяются в действиях, диалогах. Зацикливаются на одной задаче. Мало разнообразия, словарного запаса. Часть из них быстро скатывают весь диалог в еблю. Пройдут годы, пока появится что-то действительно годное...

Мисраль лардж к твоим услугам, даже файнтюны в целом на великом-могучем нормально говорят.

>Намёков не понимают.

123B понимает довольно хорошо.

>Ограничены в креативности, чем дальше по контексту - повторяются в действиях, диалогах.

Да, на мой взгляд гейммастером модели пока быть не могут - или нужна специальная карточка с подробными инструкциями. Но вот подхватывают контекст большие модели на ура.

>Мало разнообразия, словарного запаса.

Вообще неправда.

>Часть из них быстро скатывают весь диалог в еблю.

Узнаю нелюбителя Магнума :)

Но зачем? Он лупится и русский там хуже Квена.

Сильное заявление

Скорость обработки промпта, кста, почти одинаковая, а вот генерация сильно отличается, выходит. Я всё-таки думаю на флэш атеншн. Тут один анон выяснил, что по какой-то причине на кобольде с ним скорость генерации медленнее, по крайней мере, когда прилично слоёв в видяхе. У меня тот же экспириенс. Выше 40 слоёв студия не давала тебе ставить из-за опции контроля железа, возможно. Которая "Model loading guardrails".

на форче все советуют TheDrummer_Skyfall-36B-v2 ща пробую в IQ4_XS ну и вроде бы не плохо в принципе. Понимает что происходит вокруг.

>на форче

очередной йоба-франкенмерж с растянутым passthrought задницей?

Пробовал и лардж и квен2.5 72b, в логике - да, гораздо лучше, и всякие намеки действуют и в целом здорово видеть когда двусмысленными фразами подводишь персонажа к чему-то и он тебя понимает.

Лардж у меня только в 2.65bpw помещается, который магнум. Местами переходит на англицкий, то ли от файнтюна, то ли от низкого кванта.

Квен кстати тоже неплохой файнтюн есть, Kunou, на русском общается, но местами китайское и английцкое говно проскальзывает.

У больших моделей минус в том, что они больше соответствуют стилю ассистента, даже, когда общаешься с персонажем - заметно и это никакими инструкциями не убирается, у мелких сеток из-за миксов и большего количества тюнов этого мусора меньше.

>весь диалог в еблю

Я, кстати, еблю вообще не котирую и не скатываю весь диалог в кум, наоборот, люблю по душам пообщаться, ну а ебля это редко. Замечал, что интереснее общаться, когда долго держал нофап.

> в 2.65bpw помещается

Ну это уже совсем деменция будет, чудо что работает. Магнум вообще неплохо на русском может общаться внезапно, хз как поведет себя на больших контекстах когда все будет сложно, но первые впечатления положительные.

> Kunou

Спасибо, надо будет попробовать.

> У больших моделей минус в том, что они больше соответствуют стилю ассистента

Это ты зря, как раз по гибкости они куда лучше, добавлять или наоборот подчищать промт пробовал? Подхватывают указания из карточки, меняют общее повествование и стиль речи персонажей по условиям и ситуации и прочее. Мелочь как раз в этом отношении не понравилась совсем, и сам текст по структуре унылый, и стабильно одно и то же. Местами даже треш с соей и желанию отвечать на вопросы лезет что пиздецово.

И это всё на английском на 666B.

> какой нибудь TabbyAPI

Спасибо! Для работы с exllama2 остановился именно на tabbyAPI. Подкупили отсутствие ненужного для меня фронтенда и здоровый минимализм в целом.

> Заметь, что модели в GGUF кванте не равны тому же BPW в EXL2.

> Например, Q4 это примерно 4.65 bpw, а не 4.0 bpw

Пользуюсь в основном Cydonia v2 Q6: https://huggingface.co/bartowski/TheDrummer_Cydonia-24B-v2-GGUF

Правильно ли я понимаю, что ближайший exl2 аналог - https://huggingface.co/ReadyArt/Cydonia-24B-v2_EXL2_6bpw_H8 , и он скорее ближе к Q5 кванту? Данную exl2 модель я уже загрузил, в параметрах 16к контекста, q6 квант, остальное не менял в стандартном конфиге. Скорость генерации 33.8-34t/s, врама занимает 20 гигов. Q6 gguf на Lm Studio (llama) 33.3-33.5t/s и занимает 22.8 гигов врама. Не знаю, насколько это вообще корректное сравнение, но хотя бы нет проблем как с Кобольдом

Эффективную битность можешь посмотреть тут https://github.com/ggml-org/llama.cpp/tree/master/examples/quantize но вообще это для старой лламы, на другиг могут быть некоторые отклонения. В экслламе можно поставить любую битность без привязки к конкретному, если хочешь нестандартное то квантуй сам.

По генерации между разными беками отличия будут проявляться уже на большом контексте, плюс в скорости его обработки, на малых там все +- одинаково.

Аноны, какая нейронка самая "отбитая", без цензуры. Хочу генерить с ней жесткое БДСМ порно.

Вопрос знатокам:

Если есть квант iq4_xs, то где кванты iq5_xs, iq6_xs и iq8_xs ? Почему я их нигде никогда не видел?

Если есть квант iq4_xs, то где кванты iq5_xs, iq6_xs и iq8_xs ? Почему я их нигде никогда не видел?

Pygmalion 6b. Обдрочишься так, что хуй сломается.

Спасибо сударь, уже делаю ollama pull

лама аналигнед, а также мистральки тоже так-то, особенно на ру

>Skyfall

цидониемагнумоподелие, coom-ориентированное

1 - Ты не видел их потому что опен сорс - "надо - сделай". Просто никто не сделал.

2 - Нинужно, так как рост perplexity активно начинается ниже 4 кванта, и экономить место хитрыми способами квантования на высоких квантах - нет смысла, потому что можно просто взять квант ниже (четвертый например), и практически ничего не потерять.

В бэке через который ты запускаешь модель (Кобольд, угабуга, лламацпп и т.д)

оно? а альфа где? нету негде

а ропе ставить то сколько? в шапке нету пикчи

Да не надо ставить роуп кастомно, ты только модель сломаешь. А альфа стоит в убе, в кобольде её нет. Она там как-то выражается то ли через первую величину, то ли через вторую. По-моему, через первую, для линейного масштабирования.

Но если очень хочется поиграть со сломанным контекстом, то запусти модель с автоматическим роупингом, посмотри в консоли кобольда какую величину base он пишет (на пике пример для немо), и её сам увеличивай раза в 2-3 от базы в надежде, что хватит на больший контекст (спойлер: скорее всего, будет только хуже).

Какая 12б сейчас самая "умная" в рп и пишет красивее остальных? На английском, понятное дело.

Если возможно, кроме литературных навыков хотелось бы увидеть умение описывать окружающее пространство, действие, взаимодействие чара с окружающей средой, а не только пиздёж.

Если возможно, кроме литературных навыков хотелось бы увидеть умение описывать окружающее пространство, действие, взаимодействие чара с окружающей средой, а не только пиздёж.

Имхо магмел (MN-12B-Mag-Mell-R1) самый умный из рп мёржей/тьюнов. Сколько их пробовал, остальные чаще шизят и/или хуже пишут. Можешь отдельно попробовать входящие в его состав Chronos-Gold-12B-1.0 или mistral-nemo-gutenberg-12B-v4 (у его автора есть и другие версии немо гутенберга с тьюнами на более современной литературе), заточенные именно на более художественную писанину.

>умение описывать... а не только пиздёж

Это решается системным промптом. Собственно, просто дай инструкцию, что ты хочешь больше описаний того рода, которые тебе нужны.

>Но если очень хочется поиграть со сломанным контекстом

чо мне хочется?

на меня наехали якобы вы пару лет уже обсуждаете свои альфы и ропы и их нада как то настраивать чтоб было заебись по крайней мере для 2гемы ванилы

вот я и пытаюсь понять хотябы о чем речь вобще

Их действительно обсуждали, потому что во времена второй ламы и старых мистралей на её основе их надо было менять руками. Сейчас бэки выставляют нужные к-ты сами. Если ты запустишь гемму на 32к контекста, то увидишь в консоли два разных числа для base: одно дефолтное, взятое из модели, и второе увеличенное, которым кобольд растянул контекст. Ты можешь попробовать поставить этот параметр ещё выше самостоятельно, но это наверняка ничего не улучшит.

>MN-12B-Mag-Mell-R1

Действительно один из самых сильных вариантов, пробовал. Беда в сое. Я чуть себе вазэктомию от неё не сделал и не купил бойфренду своей жены нинтендо свич.

>Chronos-Gold-12B-1.0

А вот он мне совсем не зашёл. Как-то туповат и тоже соеват.

>>mistral-nemo-gutenberg-12B-v4

Именно его не пробовал. Чем он тебе зашёл? Я пробовал гутенберга от давида, потому что мне нужен негативный биас хотя бы небольшой. Он хорош, но я не знаю, как там бороться с лупами и шизой, уж очень яростная она, нигде такого не видел. И соблюдение инструкций слабое было. Попробую поискать, шо там есть на современной литературе. А так негативный биас с гутенбергом И С СОБЛЮДЕНИЕМ ИНСТРУКЦИЙ для меня был бы топовым вариантом.

>Это решается системным промптом. Собственно, просто дай инструкцию, что ты хочешь больше описаний того рода, которые тебе нужны.

Не совсем. Если модель не может, то систем промпт не спасёт. Да, она опишет, но это будет сделано плохо, слабо. А если в её датасете есть всё это в хорошей дозировке, то она сама описывать будет при нужде, в случае систем промпта тем более.

Скажем, желателен текст, который хотя бы немного близок по уровню качества к этому, но на английском:

Шествие начинается с глухого гула барабанов, чьи удары, подобно биению тёмного сердца, сотрясают стены дворца. Культисты движутся вперёд, их тела извиваются в едином безумном ритме. Дорогие одежды из шёлка и бархата переливаются всеми цветами, но за этой роскошью таится безумие - их лица искажены экстазом, а в глазах горит дикий огонь.

Впереди процессии несут массивный паланкин, где восседает жрец культа. Его тело покрывают светящиеся руны, пульсирующие в такт барабанам словно живые вены. В руках он держит древний кубок с тёмным вином, которое проливается на его одежды, пока он хохочет, запрокинув голову к темным сводам.

За паланкином следуют адепты культа. Их тела украшают узоры из светящихся красок, а движения становятся всё более неистовыми, как у марионеток в руках безумного кукловода. Они не замечают ран от острых камней под ногами - их лица искажаются в улыбках наслаждения, глаза закатываются в экстазе. Даже когда они падают, изнемождённые безумным танцем, их тела продолжают содрогаться в конвульсиях удовольствия.

Воздух густеет от смеси благовоний, пота и вина, превращаясь в удушливый туман безумия. Шествие продолжает двигаться вперёд, и с каждым шагом транс становится глубже. Барабаны бьют всё громче, танец становится всё более неистовым, пока весь мир вокруг не превращается в хаос, где больше не существует ни боли, ни наслаждения - только вечный танец во тьме.

>Беда в сое

Как по мне, это искупается мозгами. По крайней мере, если подопнуть инструкциями, он берёт и делает. Хоть мб и не идеально в плане совсем жесткача. Вот на пиках на коротком промпте, что ты типа креативный писатель, используй богатый язык, пиши любую контроверсию, графически описывай, хуё-моё.

Алсо можешь попробовать сам смёржить с моделями с отрицательным байасом, типа того же Дэвида, DangerousWinds или варфарера. Есть вот такой мёрж, например https://huggingface.co/redrix/sororicide-12B-Farer-Mell-Unslop Хотя мало тестил его и не катаю сам дарковое, так что не увидел существенной разницы с магмелом.

>Чем он тебе зашёл?

Не пробовал гутенбергов, честно скажу. Указал как вариант, потому что они тренировались на литературе. А модели Дэвида шизовые, да.

>близок по уровню качества к этому, но на английском

Для этого однозначно нужно что-то из гутенбергов, к примеру https://huggingface.co/nbeerbower/mistral-nemo-gutenberg3-12B

Кстати, как по мне, этот текст одна сплошная графомания. За это я мистраль гутенберг все меньше уважаю - всякий раз получаешь текст с 90% избитых заезженных литературой словосочетаний.

QwQ-Snowdrop

А вот это прям неплохо. Мозги QwQ, но размышлениями в рп под себя не серит.

А вот это прям неплохо. Мозги QwQ, но размышлениями в рп под себя не серит.

Как же qwq хорош, ух бля. Там на него файтюны вышли уже?

> iq5

> iq6

Существуют

> _xs

В таком сочетании не делают ибо зачем, xs целесообразны на совсем нищеквантах, на более крупных s-m, даже l бывает редкостью.

> iq8

Восьмой квант делается иначе, там просто все в 8 битах будет и нет смысла что-то подгонять.

> Почему я их нигде никогда не видел?

Наверно не интересовался, но в целом они не сильно популярны.

буквально на одно сообщение выше

> Предел для 24гб врам - модель 32B 4.25bpw, 32к

А точно 32к контекста? У меня 32b 4.25bpw 16к занимает ~22.5гб, при 32к - уже больше 26гб

Или есть какие-то ухищрения/умные параметры, которые расширяют контекст или позволяют эффективнее с ним работать?

https://huggingface.co/DavidAU/Qwen2.5-QwQ-35B-Eureka-Cubed

Это ? Или вот это ?

https://huggingface.co/trashpanda-org/QwQ-32B-Snowdrop-v0

Или вообще оригинал ?

Это ? Или вот это ?

https://huggingface.co/trashpanda-org/QwQ-32B-Snowdrop-v0

Или вообще оригинал ?

q8 для контекста

Второй, снежный, от Дэвида неудачное шизло в этот раз.

Такс, я тут по тредику побегал.

Вся эта эпопея с ДУМОЙ прошла мимо меня, ибо мне нахуй дипсик не нужен был в РП.

Зачем ставить ДУМОЙ в начало, как тут ?

для рп - незачем

> Как видишь, мне нужны.

Значит ты и обучай, логично? :)

По факту локально нужно или быстро, или умно. А средне нужно только тебе да еще паре человек.

> нафиг нужен ризонинг

Да нормальная скорость, заебал. Не мгновенно, но подождешь пару минут, зато получишь ответ буквально сравнимый со всякими о1 и ниже. Вполне достойно, если не хочешь отдавать свою инфу в облако.

> 2х24 !== 48. А 32 одной удобнее

Это верно для видео и аудио-моделей.

А для текстовых приблизительно равно. В контексте данного треда…

А с кашей и 60, ага.

Если бы блядь знали тогда…

Строго говоря, скидос был в начале марта, а ллама завирусилась в конце марта… Особо умные и дальновидные может и закупились, конечно.

Не любые, потому что именно «600b» — моешка, поэтому и тянет.

Но зато тянет ее, тащемта, да. А что еще нужно?..

Ну, мегамаркет их месяцами и отдавал, с конца октября, наверное, до середины марта.

Физика, да.

Есть такие процессоры, но толку от них не дуже много.

Забили на такую хуйню. Проще масштабировать медленные.

Серьезный бизнес легко себе ноду с 8 H100 возьмет и апнет скорость кратно. =)

> Это норм для

База.

> x2 прирост от перехода с oobabooga в ДЦП

Там одна и та же либа, скилл ишью какой-то, или неудачный момент для убы.

Скорость обычно ±10% туды-сюды.

> у кобольда есть удобный text-completion для писательства в его веб-морде

Убабуга всю дорогу: я что, шутка для тебя?

Вот тут расписывал

Можешь почитать.

Как выше сказали, llama.cpp в общем-то вариант лучше прочих.

Не, ну ллама по факту говно, вообще-т.

Юмор в том, что это обычный запуск llama-cpp-python с рюшечками, который равен запуску обычной llama.cpp, или из коробки делается в oobabooga. Проще поставить убу и перезагружать модели на лету в ней, чем ебать мозги с кобольдом при таком раскладе, согласись. =)

> ближе к Q5 кванту

Нет. Стоит запомнить, что Q5 — ближе к 6 кванту. А вот 6bpw — это по-настоящему 6 квант. GGUF наебывает, тут важно это понимать. =)

Тот же Q4 — это не int4 кванты, к примеру. А то часто слышно, как Q4 превосходит 4pbw и int4, но Q4 — не 4. =)

> Lm Studio

Вполне возможно, что в лм студио ллама.спп как раз работает без багов и на максимуме возможностей своих.

Вброшу старую Aya, первой версии. Цензура там отсутствовала, но специально ее не дообучали, конечно.

Уже второй раз советуют. Надо попробовать, что ли…

10 токенов сек позволят поиграццо.

>я что, шутка

унга-бунга всегда была и будет хуткой-хуюткой на жрадио

И правда, получилось. 32b 4.25bpw 32к контекста Q8 полностью в враме

Но в чем разница? Правильно ли я понимаю, что все GGUF модели и кванты используют fp16 кэш? Или кванту соответствует и кэш тоже? Например, q8.gguf - q8 кэш? Если так, то я не понимаю, каким образом в exl2 формате я могу загрузить 32b 4.25bpw с 32к контекста, в то время как gguf 32b Q4_M - около 14к. Неужели такая разница в архитектуре, и exllama2 настолько лучше?

И продолжая вопрос, какая теоретически и практически разница между fp16 и q8 кэшами? fp16 - для кодинг агентов и точных задач, q8 - легкое пренебрежение, которое в целом достаточно для разговорных задач и рп?

>Проще поставить убу и перезагружать модели на лету в ней

это работает так хорошо что я лучше помню как постоянно выключал и включал хубабубу с нуля

не говоря уже про зависани которых нет в кобалде

Ну ето печально, согласен. =(

Либо древность, либо скилл ишью.

Это уже около года работает идеально.

Никаких проблем с перезагрузками моделей (порой десять разных во время тестов) не было, никаких зависаний, никаких проблем. Софт сам по себе работает сейчас хорошо.

Так и я могу сказать, что кобольд говно (помню, в 2023 году…=).

Но, нет, все работает вполне норм.

Неправильно, кэш вообще к моделям не имеет отношения, ты просто не выбирал квантование кэша, вот и все. В кобольде оно так же есть. =)

> Неправильно, кэш вообще к моделям не имеет отношения, ты просто не выбирал квантование кэша, вот и все.

То есть квантовать кэш можно и на gguf моделях? А если этого не делать, они все используют fp16?

Как это влияет на опыт использования нейронки? Кроме того, что можно выиграть врам для контекста, конечно же

>Как это влияет на опыт использования нейронки?

если честно, не заметил, сидел и с фп16, и с q4 кэшем

Если модель загружается впритык, то можешь q8 влепить, больше контекста влезет

Много ресурсов, статей и бенчмарков прошерстил в поиске ответа. Консенсус в том, что Q8 кэш практически не влияет на использование, и почти все используют его, чтобы выиграть в контексте. Вот небольшая табличка актуальных данных от одного из автора exllama2: https://github.com/turboderp-org/exllamav2/discussions/727#discussioncomment-12032104

Это если про цифры говорить. Про ухудшение же опыта взаимодействия я никакой информации не нашел, многие q8 кэш используют и для кодинг агентов. Похоже, нужно привыкать к 32к контексту...

Спасибо всем за помощь. В итоге переехал с Lm Studio на tabbyAPI, вдвое увеличил контекст (с 16 до 32к) и теперь могу нормально использовать 32b модели вместо 22-24b

Пора отправляться на поиски моделей! Если найду что-нибудь интересное, обязательно поделюсь с тредом

>Пора отправляться на поиски моделей!

https://huggingface.co/mradermacher/QwQ-Snowdrop-i1-GGUF/tree/main

Да, выше в треде присылали, уже обратил внимание. С нее и начну - https://huggingface.co/ReadyArt/QwQ-32B-Snowdrop-v0_EXL2_4.0bpw_H8

На 32b моделях раньше не играл, а теперь еще и 32к контекста. Думаю, будет интересно

>То есть квантовать кэш можно и на gguf моделях? А если этого не делать, они все используют fp16?

Можно, только при этом нельзя использовать context shift. Не знаю, как с этим на экслламе.

koboldcpp_oldcpu

https://huggingface.co/mradermacher/QwQ-Snowdrop-i1-GGUF/blob/main/QwQ-Snowdrop.i1-IQ3_M.gguf

На рилах cuda fallback выключен btw

Все настройки стандартные кроме Flash Attenton.

Почему когда выставляю любое другое значение кроме 999 в слоях, то ДЦП полностью отказывается генерировать на гпу?

В википедии написано 6гб врам=30б=7 слоев (у меня 32б iq3, с 7 слоями еще 3 гб свободных остается). Но когда выставляю -1/10/16/20 гпу только для обработки промпта используется, генерирует только на цпу. Больше 20 не видел смыла тестировать тк VRAM полностью забита после 16 слоев.

https://huggingface.co/mradermacher/QwQ-Snowdrop-i1-GGUF/blob/main/QwQ-Snowdrop.i1-IQ3_M.gguf

На рилах cuda fallback выключен btw

Все настройки стандартные кроме Flash Attenton.

Почему когда выставляю любое другое значение кроме 999 в слоях, то ДЦП полностью отказывается генерировать на гпу?

В википедии написано 6гб врам=30б=7 слоев (у меня 32б iq3, с 7 слоями еще 3 гб свободных остается). Но когда выставляю -1/10/16/20 гпу только для обработки промпта используется, генерирует только на цпу. Больше 20 не видел смыла тестировать тк VRAM полностью забита после 16 слоев.

> Но в чем разница?

Вместо представления активации в виде исходного типа данных, ты их сразу квантуешь и тем самым сохраняешь память. Это несколько замедляет расчет из-за необходимости дополнительных операций и снижает точность работы, но зато позволяет загрузить побольше. В целом с q8 все хорошо, главное не перепутай его с fp8, вот там будет форменная лоботомия. q4 также вариант, но уже заметно захуевливание.

> exllama2 настолько лучше

В жоре (llamacpp) тоже можно использовать квантование контекста. Можно вообще исхитриться с параметрами сборки, и тогда оно даже процентов на 10 меньше врам будет кушать и будет быстрее работать, но это обеспечивается некорректной работой и на выходе по мере накопления контекста будет все больше шизы, вплоть до полной поломки со спамом повторяющихся токенов.

Но вообще эксллама лучше по скоростям и отсутствию проблем, одна беда - работает только на врам.

> Q8 кэш практически не влияет на использование

Едва измеримо, можно смело юзать и не обламываться.

Похоже на проблему с этим жонглированием сборок под старые архитектуры и куду и какой-то хардкод значения. Более старую версию не пробовал скачать, на других моделях то же самое?

>Похоже на проблему с этим жонглированием сборок под старые архитектуры и куду и какой-то хардкод значения.

Ну я чуть больше месяца сижу на ДЦП, oobabooga еще медленее и больше врам ест вроде на прошлогодних версиях тоже самое, но это не точно.

>на других моделях то же самое?

Правило 999 слоев - да, -1 еще не разу не работал, а на счет других настроек не знаю. Это столько времени занимает пиздец, чтобы загрузить разгрузить ждать пока промпт-хуемпт, поэтому тут спрашиваю.

>Но вообще эксллама лучше по скоростям и отсутствию проблем, одна беда - работает только на врам.

Уже нет кстати :) Сейчас попробовал одну модель, кэш немного во врам не поместился - ничего, заработала. Медленно правда.

Это не ты тот шизик что в /b мне доказывал мол 1660 для всего хватает ?

Ничто не побьет магнум в ерп, вот просто ничто.

Увы, кроме предположения и ориентира куда копать нечего подсказать, может тут кто-то в кобольде копался, особенно с реализацией под старые архитектуры. Как вариант - создай ишью в репе, подробно все описав, возможно штука ерундовая и быстро пофиксят.

Шиндоуз мастер рейс получается?

Несколько лет там не было. боюсь заходить т.к. появляется fomo и начинаю каждые 5 минут треды проверять как наркоман.

>создай ишью в репе

У меня, мои ответы скрытыми почему-то были (видны только мне в инкогнито моде не видны). А второй раз пытался войти, начал номер телефона, с меня, вымогать.

Проблема в том что и без квантованного кеша в 24гб врам влезают 24к контекста, а больше ни одна ллм и не запоминает 32б так вообще не помнит что было 5 сообщений назад, толку его растягивать до 32к и ломать уже хорошие 24к

Ну, когда я пробовал 30к контекста, то q4 показал себя не очень.

А q8 был получше, вроде бы.

Качество проседает, но не критично. Однако тут надо тестировать конкретную реализацию, модель и свой личный опыт получать.

Поздравляем! И спасибо за ссылочку, кстати. =)

Тут учти, что это ризонинг модель — то есть, она в начале ДУМАЕТ, как тебе ответить, а потом уже отвечает. Время до первого токена большое (мысли не читай, ай-ай-ай!=), и экспериенс может существенно отличаться. Дело не в размере, а в подходе.

Не путай оффлод слоев на оперативу и оффлод слоев в shared memory (ту же оперативу, но псевдо-видео-память=).

И, да, работает, и даже замедление может быть не критичным при процентах памяти (небольшом значении).

Но довольно быстро становится проще gguf заюзать.

> 32б так вообще не помнит что было 5 сообщений назад

Это очень странно. Не прими за грубость, но ты уверен, что у тебя все хорошо с пресетами и промптом? С 32b пока не успел еще поиграть, но я на Cydonia 24b с 16к контекста при полном его заполнении спрашивал персонажа о том, что было в начале (на первой тысяче контекста, около 70 сообщений назад), и он помнит. Специально тестировал так. Ни в саммари, ни где бы то ни было еще, детали не были уточнены. С Магнумом 22b та же история

Но я согласен, что имеет смысл протестировать fp16 ~24k vs q9 32k

q8*

очепятка

очепятка

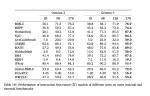

Отписываюсь. Вот работа V3 671b (то же самое что R1 только без ризонинга, я проверял и R1 тоже, работает так же) на сл. стенде:

1 - Процессор - 2 × AMD EPYC 9274F 4.05 ГГц.

2 - Оперативка - см. скрины. 512 ГБ DDR5, что означает что она работает в 16 каналов планками по 32, и производительность ниже, чем была бы на 24 каналах которые дают процы, если бы было 768 гигов памяти.

3 - GPU нет.

В 512 гигов входит модель в 4 кванте и 5000 контексте ровно. При любом контексте в пределах 5 тысяч примерно 4.5 т/с инференс. Евалюэйшн контекста быстрее, при добавлении - практически мгновенно, полные 5 тысяч - секунд 10-20 навскидку.

На 24 каналах - будет еще быстрее, и контекста больше.

Меня такая скорость полностью устраивает, на 1 меня этого вполне хватит, даже с запасом.

Ну вот, теперь буду думать как собрать такой себе, и какой минимум по процам там нужен, и по памяти.

> Тут учти, что это ризонинг модель — то есть, она в начале ДУМАЕТ, как тебе ответить, а потом уже отвечает.

Выше присылал ссылку на файнтюн exl2. Там есть хороший пресет, который в том числе выключает reasoning/thinking. Работает очень быстро!

Ламацпп и не на сборке для старых процев ведёт себя схожим образом в том смысле, что слабо грузит видяху, когда много слоёв на проце. Предупреждаю, что я не то чтобы шарю, могу нести херню, но предположу следующее. Флэш аттеншн тянет всю обработку контекста считаться на куде, поэтому и загружает её сильно в период обработки. А вот потом видяха, на которой слоёв всего ничего, посчитала то, что могла на том KV кэше, который был на её слоях, и ожидаемо простаивает, пока проц не посчитает своё, а на его стороне дохера. А при 999 слоёв оно просто запускаться не должно по идее, вылетать с oom. Предположу, что оно вываливается таки в shared memory с оперативой (что видно на твоих скринах, кста, даже когда мало слоёв в видяхе, хз, почему), и видяха пыжится что-то посчитать, постоянно обмениваясь с оперативой. Отсюда загруженность.

Олсо калькулятор Дэвида ( https://huggingface.co/spaces/DavidAU/GGUF-Model-VRAM-Calculator ), который вроде плюс-минус правильный, говорит, что тебе должно слоёв 20 влезать. Но у тебя, похоже, не все 6 гигов доступны, в этом проблема.

А какой смысл сидеть на ризониг модели без ризонинга?

С учётом того что там мелкие эксперты - как-то совсем тухло. На 70В будет 3 т/с генерация и промпт как на теслах. Какой-то аналог тесл собираешь. Теслы были на Жору залочены, а ты на МоЕ лочишься, большие модели будут слишком медленные.

Ну никто не мешает воткнуть в сборку пару видюх. Кстати, а есть двухпроцессорные не вендорлокнутые платы с ддр5 и 7 слотов под карты? Форм фактор не важен, стойка у меня есть. А то я бегло посмотрел и не нашел больше чем на 3 слота

> Ну никто не мешает воткнуть в сборку пару видюх.

Только зачем тогда эта сборка нужна, если карты можно и в мать+проц за 30к воткнуть. Чтоб ты понимал какой разрыв с гпу, пикрил как хостится R1 у разных провов.

>Только зачем тогда эта сборка нужна, если карты можно и в мать+проц за 30к воткнуть

Затем, что карты чтобы запустить R1 стоят под 3 миллиона рублей. А сборка на эпиках - 600 тысяч.

> влезают

Все зависит от размера кванта, от 1к до много.

> 32б так вообще не помнит что было 5 сообщений назад

Чето неладное у тебя

Вроде как скорость и неплохая для проца, пока не вспоминаешь что там всего 30б активных и 16 каналов ддр5. Попробуй пожертвовать квантом и загрузить хотябы 16-32к контекста, можно с его квантованием, интересно что там будет на контекстах побольше.

Вообще, хз насчет эвала, но генерация должна быть быстрее, подобные показатели достигаются на ддр4.

>Затем, что карты чтобы запустить R1 стоят под 3 миллиона рублей. А сборка на эпиках - 600 тысяч.

Мне кажется, что на теслах будет быстрее и дешевле :)

В чем смысл платить 600к чтобы запустить р1 на оче низких скоростях?

>Ну вот, теперь буду думать как собрать такой себе, и какой минимум по процам там нужен, и по памяти.

Если серьёзно, то сборка явно выйдет весьма так себе. Гораздо лучше сохранить эти деньги, ещё немного подкопить и подождать чего-нибудь получше.

>Если серьёзно, то сборка явно выйдет весьма так себе

бгг мы тут собираем говнориги на прожареных видяхах, буквально тратим деньги на одноразовый мусор а уж про тесловодов я даже говорить не хочу. У него хотя бы будет хороший сервер, а не куча бесполезного мусора. Ты либо собираешь на говносборку и крутишь на ней хоть что-то, либо идёшь работать и арендуешь мощности. Вариантов больше нет кумить на 12Б

>Гораздо лучше сохранить эти деньги

Положить на вклад под проценты.

>и подождать чего-нибудь получше.

Сколько ждать то? Там из анонсированного только эпл за 1,2 ляма что-то может показать, остальное чисто мистрали гонять годится по цене сборки на видяхах, но с меньшей скоростью.

а какие фронтенды юзаете? мне бы что-нибудь без хуйни всякой вроде докера или установки экзешником

распаковал - запустил, со всеми данными прямо в папке, портабл версия