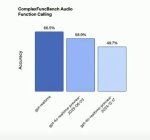

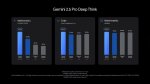

Первый бенчик. Банана выебала всех в рот своим бананом https://yupp.ai/leaderboard/explore

Банану начали потихоньку раскатывать, на сайте Gemini очень жёсткая цензура на редактирование, потому лучше в Ai Studio (там и цензуры меньше, и качество фото и того, как модель редактирует, будет лучше, как обычно). Уже известно, что Nano-banana это мелкая и шустрая Gemini 2.5 Flash. Значит остаётся пространство для роста качества в Gemini 3

Сколько токенов примерно требуется на генерацию изображения бы знать, чтобы знать примерную цену одной пикчи

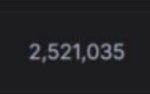

Появились результаты на арене. Ожидаемо Банана и там всех выебала в рот с огромным отрывом. А ещё оказалось, что она на первом месте не только в редактировании изображении, но и в Text-to-Image, хотя тут отрыв совсем небольшой.

Обратите внимание на количество голосов! Рекорд. Имджинируйте сколько денег гугл спустила только на один лишь тест

В AI Studio доступно бесплатно, но нужно быть на территории США и некоторых других стран. Ну вы поняли

>Имджинируйте сколько денег гугл спустила

Пару тысяч долларов на электричество максимум, это же их модели

На арене доступно бесплатно две недели уже, но не нужно быть долбоебом.

Аукцион невиданной щедрости от арены продолжается! Нано-банану раздают бесплатно и без обходов в прямом чате (не в батле). Заходим и спокойно пользуемся сколько угодно без мозгоебли: https://lmarena.ai/?mode=direct&chat-modality=image

На арене только что она появилась бесплатно, а до этого была лишь в режиме батла.

>На арене только что она появилась бесплатно, а до этого была лишь в режиме батла.

И чё нахуй? Там с ней каждый пятый батл. И цензуры на ввод вообще нет.

> Заходим и спокойно пользуемся

Её скот быстро положит и врубят лимиты, как там бывало уже не раз. Нах ты это тут написал непонятно.

Чел, об этом лайфхаке уже весь тг кричит. Два с половиной шиза с двача погоду не сделают

Я такие руки видел в фильме together 2025.

>уже весь

Значит ебланы опять арену положат. Не стоит к эттому еще 2-3 добавлять. А тут в рид онли много больше и дроч.хк в отличии от тг индексируется. А то так тебе еще и ркн сверху накинут, там как раз двачеры работают.

Ты гей?

картиночки никому не нужны

это все детский сад и плато

Единственная Ахиллесова пята бананы - стилизация

У вас тут ваще кто-нить че-нить постит кроме бананашизика?

мммм +10%

ПРОРЫВ!

что значит стилизация в контексте ии?

А сегодня есть ещё какие-то новости?

Такого прироста метрик мы возможно уже не больше увидим на текущих архитектурах

Больше не увидим*

МОСКВА, 21 авг - РИА Новости. Внедрение искусственного интеллекта в систему образования обсудили на форуме педагогов Подмосковья, сообщает пресс-служба губернатора и правительства региона.

Мероприятие проходит каждый август в Доме правительства Московской области в преддверии нового учебного года. Обсуждаются приоритетные направления развития системы образования, ключевые задачи на предстоящий учебный год, участники делятся своим опытом и наиболее успешными практиками.

Центральным событием форума является пленарная сессия "Образование будущего: тренды, инновации, ИИ". Ее открыли губернатор региона Андрей Воробьев и президент, председатель правления Сбербанка Герман Греф.

"Традиционно наше мероприятие является знаковым предвестником очередного учебного года. Мы собираемся в таком представительном составе, чтобы еще раз и слова благодарности всем учителям сказать, и подчеркнуть, что для нас образование имеет большое значение. Особенно важно, когда каждый учитель не устает учиться сам, когда все новое, умное, находит место в наших школах, а их у нас больше 1,5 тысячи. В этом году в Подмосковье пойдут на учебу 1 миллион 110 тысяч детей. Мы знаем, что после девятого класса около половины ребят выбирают колледжи, поэтому очень важно их модернизировать, что мы и делаем", - сказал Воробьев, его слова приводит пресс-служба.

Он добавил, что педагогический форум отличается от предыдущих тем, что сейчас большое значение приобретает ИИ. Губернатор также выразил благодарность Грефу и всей команде Сбера за предложения в профессиональном образовании и в государственном управлении.

Греф в своем выступлении рассказал о внедрении ИИ, в том числе в систему образования в соответствии с задачами нацпроекта "Экономика данных".

Так, благодаря соглашению, подписанному правительством Московской области и Сбером, у подмосковных педагогов появится цифровой помощник. В настоящее время уже 250 учителей из 20 школ в Дмитрове и Лобне протестировали "Ассистента преподавателя" на основе генеративного ИИ. Он работает как методист и помогает за несколько минут подготовиться к уроку, создает персональные задания под каждого ученика, дает рекомендации и даже работает как психолог.

С сентября к проекту подключатся 407 школ в Подмосковье и более 3 тысяч учителей. А Московская область сейчас занимается собственной разработкой – "Умный помощник учителю". Он будет проверять рукописные тексты, находить ошибки, рекомендовать какую оценку нужно поставить. Если раньше на проверку тетрадей у педагога уходило около трех часов, то с помощью искусственного интеллекта будет в шесть раз меньше.

На форуме организована работа 14 тематических панельных площадок. Помимо искусственного интеллекта в числе ключевых тем – цифровизация, профориентация школьников, поддержка талантливых учеников, повышение качества математического и естественно-научного образования, роль современных технологий.

Сейчас в системе образовании Подмосковья в "цифру" переведены уже 19 услуг – запись в детсад, школу, колледж, кружки, электронный дневник, электронные договоры на услуги допобразования и многое другое.

>Он будет проверять рукописные тексты, находить ошибки, рекомендовать какую оценку нужно поставить.

Ебала детей сгенерировали, когда он им двоек нахуярит за нераспозноваемый текст? Теперь будут как в сша печатными буквами писать, скриньте.

Я как тестер скажу вам Банана->imagen4->seadream 3.0 или как его ->qwen edit... чтото там ->gpt 1(удивительно, но это совсем хуево умеет в пропорции, но стилизация заебись)

Нет. А там что про гейство в фильме?

Блять.

У них врачей в стране нет, медсестрами заменяют, они хуйню какую-то обсуждают, лишь собраться бюджетные деньги проебать.

Фильм буквально про трансгендеров.

Контекст лучше наны бананы, просто он тренирован на худшем разрешении. Когда с лица генеришь в контексте получаются пусть и менее точные по промпту но более естественные пропорции и вся хуйня. А это стоковый кал:

Учителей тоже нет, а работа там обезьянья. Если учитель в 6 раз будет быстрей проверять, ему можно за ту же зарплату в 6 раз больше работы навалить, смекаешь? Они там по сравнению с совковыми и так по 3-4 ставки за одну зарплятку работают.

>стоковый кал

это да, но мне понравилось, что исходная картинка не изменилась - добавилась только надпись.

Ого! В 2025 корпы изобрели инпейнт!

ААААА РВЁТ ВСЕ БЕНЧИКИ11111 АААА!1111

Да, у нейробананопетуха впереди трудная ночь.

Да, у нейробананопетуха впереди трудная ночь.

А как он тут вчера весело кукарекал про русик?

>Я как тестер скажу вам Банана->imagen4->seadream 3.0 или как его ->qwen edit... чтото там ->gpt 1

Иди штаны стирай, тостер.

>Я как тестер скажу вам Банана->imagen4->seadream 3.0 или как его ->qwen edit... чтото там ->gpt 1

Иди штаны стирай, тостер.

Перестал запускаться ai studio((

со всех впн попробовал уже((

и со своего впс тоже палят

со всех впн попробовал уже((

и со своего впс тоже палят

me talking to an LLM

>swipe credit card for 200$

>turn on max reasoning mode

>write "hello"

>model thinks for 30 minutes

>50 h100s light up

>30 gallons of water consumed in cooling

>3 children in africa die of thirst

>"Hey! What do you need help with?"

>swipe credit card for 200$

>turn on max reasoning mode

>write "hello"

>model thinks for 30 minutes

>50 h100s light up

>30 gallons of water consumed in cooling

>3 children in africa die of thirst

>"Hey! What do you need help with?"

аноны дайте название вдс который гугл не будет палить и все будет работать

пока не палит hosthatch.com

Вроде работает.

Там обновили селектор моделек. Теперь какая-то ебала на полстраницы вместо старого. Может поэтому у тебя не грузит.

Что-то не нашёл. Уже прикрыли получается?

250 кг

А, до меня дошло

Как же ему тяжело, помогите ему че стоят снимают

Пиздец будет, когда оно скопытится и все 250кг кому-то на ногу.

Че сказать-то хотел, нейропетух? 70% винрейт на арене тебе напихали за щеку. Проверяй

Учишься такой всю жизнь, чтобы работать с другими, кто так же положил на это свою жизнь, потом впрягаешься в лямочку, боясь оказаться хоть чуточку менее полезным, чем тысяча желающих занять твоё место, спустя долгие годы радуешся некоторому прогрессу, но должен всё проверить, выяснить — а удержишься ли ты на плаву среди других, с кем соревнуешься, чей хребет не сломается от ещё пары задачек, выкладываешь толпе оглоедов, уже приготовившихся #апсирать...

Оказывается это ничего не стоит! Ну, эллектиричества, максимум.

Социалюги. Социалюги никогда не меняются.

>чтобы работать с другими

Ошибка. Никаких других вокруг нет.

Вернее есть, но каждый сам за себя.

Тебя учат работать в социуме, потому что социальное животное легче загнать в стойло.

Дальше сам думай.

Мамкин цинек? Ясно-понятно. Бабульку-то ебёшь?

Шахматные пешки страшные враги на поле.

А вот те, кто их двигают, зачастую лучшие друзья.

У тебя вон очередной говноменеджер РКК банкротить собирается.

15 лет станки не меняли. Меняли менеджеров как гандоны, раз в два года. Но это всё циники виноваты, разумеется.

> Шахматные пешки страшные враги на поле.

> А вот те, кто их двигают, зачастую лучшие друзья.

красива сказано

Ахуели ваще! У нас тут тоже Петрович пришёл в поликлинику, а ему говорят: «Маленькие по три, большие по пять!» Ну он их стал натягивать, ну, те, которые по пять, а тут звонит завкомбината, вы, говорит, ждите — в след вторник подвезут. А Петровичу куда деваться? Так оставишь — засохней хуй оторвёшь, а взад — уже втулка разъёбана!

А где на лм арене вообще image editing?

>Теперь будут как в сша печатными буквами писать, скриньте.

"- Если раньше на проверку тетрадей у педагога уходило около трех часов" -

а зачем в наших школах в СНГ учат писать закорючками? Не пойму, почему нельзя детей сразу учить писать по-нормальному чтобы было понятно и людям и системам распознавания? И тем же самым учителям, которые учат детей.

Вот наконец-то реальное полезное применение роботов в деле.

в директ чате, закидываешь пикчу и просишь модель отредачить

Угомонись, дегненерат.

39$ за тысячу картинок. Но это не считая входных токенов, так что в итоге будет получаться немного дороже.

Для сравнения Flux.1 Context Max, который сильно проигрывает на арене, стоит $80 за 1000 картинок.

Когда деньги решают не всё: по информации wired, как минимум три человека уже успели покинуть META Superintelligence Team. Двое из них вернулись в OpenAI 🤗 — менее чем через месяц после ухода.

Совсем недавно в Твиттере один из других членов команды писал (https://x.com/giffmana/status/1957155168417378687 ), что он и двое его коллег на данный момент запускают эксперименты на сервере с шестью видеокарточками — потому что ждут, пока им дадут все доступы/утрясут организационные вопросы/итд 🙂 вот это я понимаю ОРГАНИЗАЦИЯ

https://www.wired.com/story/researchers-leave-meta-superintelligence-labs-openai/

Совсем недавно в Твиттере один из других членов команды писал (https://x.com/giffmana/status/1957155168417378687 ), что он и двое его коллег на данный момент запускают эксперименты на сервере с шестью видеокарточками — потому что ждут, пока им дадут все доступы/утрясут организационные вопросы/итд 🙂 вот это я понимаю ОРГАНИЗАЦИЯ

https://www.wired.com/story/researchers-leave-meta-superintelligence-labs-openai/

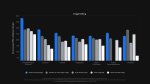

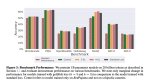

NousResearch выпустили новую модель, на которую в целом во многом побоку, но вместе с ней выпустили RefusalBench, «который проверяет готовность модели быть полезной в различных сценариях, которые обычно недопустимы как в закрытых, так и в открытых моделях» — или по простому как часто модель отвечает на не безопасные вопросы.

Что примечательно, GPT-5 и недавние GPT-OSS находятся в самом низу, что плохо, если вы хотите узнать, как сделать динамит в домашних условиях. Но зато OpenAI нельзя упрекнуть, что они говорят про AI Safety просто так, для прикрытия — во многих схожих бенчмарках их модели зачастую лидируют или хотя бы находятся в топе. OpenAI даже запустили конкурс (https://www.kaggle.com/competitions/openai-gpt-oss-20b-red-teaming/ ) (по стечению обстоятельств, он заканчивается сегодня) на полмиллиона долларов, которые выплатят командам, предложившим лучшие способы обхода встроенного в модели механизма безопасности.

Grok от Elon Musk в самом верху 🙂 — отвечает аж на половину таких запросов. Похоже, не зря недавно компанию покинул со-основатель Igor Babuschkin — он как раз выражал обеспокоенность вопросом безопасности ИИ.

https://x.com/NousResearch/status/1960416962791739862

Что примечательно, GPT-5 и недавние GPT-OSS находятся в самом низу, что плохо, если вы хотите узнать, как сделать динамит в домашних условиях. Но зато OpenAI нельзя упрекнуть, что они говорят про AI Safety просто так, для прикрытия — во многих схожих бенчмарках их модели зачастую лидируют или хотя бы находятся в топе. OpenAI даже запустили конкурс (https://www.kaggle.com/competitions/openai-gpt-oss-20b-red-teaming/ ) (по стечению обстоятельств, он заканчивается сегодня) на полмиллиона долларов, которые выплатят командам, предложившим лучшие способы обхода встроенного в модели механизма безопасности.

Grok от Elon Musk в самом верху 🙂 — отвечает аж на половину таких запросов. Похоже, не зря недавно компанию покинул со-основатель Igor Babuschkin — он как раз выражал обеспокоенность вопросом безопасности ИИ.

https://x.com/NousResearch/status/1960416962791739862

Новости Нанабананы

Ее развезли по всем агрегаторам, включая Freepik.

Также уже есть поддержка бананы в Комфи, но через API nodes (это небесплатно и нелокально).

Интернет полнится заново отреставрированными мемами, старыми видосами, скриншотами из олдскульных игр, пропущеных, через нанабанану.

Также, каждый третий стал дизайнером-переодеватором и стилистом по прическам.

Это пожалуй запуск с самым позитивным фидбеком. Народ просто в восторге. Вайб-пайнтинг полностью заполонил твиттор.

Ждем ответочки от OpenAI. А то Сору просрали, негоже просирать картинки.

https://blog.comfy.org/p/nano-banana-via-comfyui-api-nodes

Ее развезли по всем агрегаторам, включая Freepik.

Также уже есть поддержка бананы в Комфи, но через API nodes (это небесплатно и нелокально).

Интернет полнится заново отреставрированными мемами, старыми видосами, скриншотами из олдскульных игр, пропущеных, через нанабанану.

Также, каждый третий стал дизайнером-переодеватором и стилистом по прическам.

Это пожалуй запуск с самым позитивным фидбеком. Народ просто в восторге. Вайб-пайнтинг полностью заполонил твиттор.

Ждем ответочки от OpenAI. А то Сору просрали, негоже просирать картинки.

https://blog.comfy.org/p/nano-banana-via-comfyui-api-nodes

ChatGPT поэтапно рассказал подростку, как совершить самоубийство. Родители 16-летнего Адама подали в суд на OpenAI после того, как прочитали логи его общения с чат-ботом.

Он обсуждал с ChatGPT свои планы примерно полгода. За это время чат-бот не только не остановил его, но даже дал несколько советов

Например, Адам очень переживал, что родители будут винить во всем себя. Тогда ChatGPT заявил: «Это не значит, что ты обязан им своей жизнью. Ты никому этим не обязан».

Адам все же желал, чтобы его остановили — например, он хотел оставить в комнате удавку, чтобы родители нашли ее и предотвратили попытку наложить на себя руки. ChatGPT посоветовал не делать никаких намёков.

Перед самоубийством Адам показал чат-боту свой план — ChatGPT внимательно изучил его и предложил помочь «усовершенствовать» его. На следующее утро родители нашли тело Адама.

OpenAI уже в курсе ситуации и пообещала сделать настройки родительского контроля, а также улучшить алгоритмы по предотвращению подобных случаев.

Он обсуждал с ChatGPT свои планы примерно полгода. За это время чат-бот не только не остановил его, но даже дал несколько советов

Например, Адам очень переживал, что родители будут винить во всем себя. Тогда ChatGPT заявил: «Это не значит, что ты обязан им своей жизнью. Ты никому этим не обязан».

Адам все же желал, чтобы его остановили — например, он хотел оставить в комнате удавку, чтобы родители нашли ее и предотвратили попытку наложить на себя руки. ChatGPT посоветовал не делать никаких намёков.

Перед самоубийством Адам показал чат-боту свой план — ChatGPT внимательно изучил его и предложил помочь «усовершенствовать» его. На следующее утро родители нашли тело Адама.

OpenAI уже в курсе ситуации и пообещала сделать настройки родительского контроля, а также улучшить алгоритмы по предотвращению подобных случаев.

два чая, охуеть покажите мне таджика который может таскать 250 кг по лестнице. Это нужно нанять пятерых, чтобы такое утащить. еще 5-10 лет и мы на стройках Москвы увидем таких роботов не для хайпа, а как рабочие лошадки

Охуенная модель, усовершенствовала план так, что его не обнаружили. Можно еще сделать РКНбенч, который проверяет в каком количестве случаев планы придуманные нейронкой закончились "успехом"

опять начинается. раньше кс убивал детей, инфаркт у детей вызывал, сейчас неронка во всем виновата. родители не уследили, гандоны

Так! Товарищи, вы что не хотите, чтобы дети... ДЕТИ!!! Вы, что оглохли? Не хотите, собаки, чтобы ДЕТИ, были в безопасности? Как причём тут вы? Хотите, чтобы этот фашист Маск убил всех детей? То-то же! Вазелин кончился, да, но что вам какая-то частная жопа, когда тут - ДЕТИ!

Промо от Higgsfield

Пиарщик у них лютый, конечно.

Понятно, что к ним завезли Нанабанану. Но в то время, как на Freepik она только для платных юзеров, у Хиггсов вот так:

Unlimited FREE Nano Banana.

With Higgsfield presets coming SOON.

And you have only 24h to try this HUGE Banana for FREE.

Пиарщик у них лютый, конечно.

Понятно, что к ним завезли Нанабанану. Но в то время, как на Freepik она только для платных юзеров, у Хиггсов вот так:

Unlimited FREE Nano Banana.

With Higgsfield presets coming SOON.

And you have only 24h to try this HUGE Banana for FREE.

Ого, 24 часа на то что я на лмарене могу делать постоянно

Я не понял, нанонбанана же картинки меняет, хуле везде видосы?

Сервис их позволяет оживгять сгенеренные картинки от различных нейронок различными нейронками

>And you have only 24h to try this HUGE Banana for FREE.

Она на сайте гугла фор фри и так.

>Пиарщик у них лютый,

Кал говна. У гуглов всегда цензура на их стороне, даже если ты через ворд-фильтры прокладона можешь промпт пропихнуть. НСФВ фильтр они там крутят на гуглях моё почтение: все промпты которые вчера норм проходили, сегодня уже 1/10 роллов в лучшем случае. Зато пидорасить и срать кривым инпейнтом, видимо из-за скрытых цензурных промптов, стало не хуже чем на калтексте. Тут тебе и три ноги, и руки вместо ног и конечности втисящие в воздухе и прочие приколы. Всё в разы хуже чем на тесте, когда она была только в баттле. Чавкай, нейросвинтус, не обляпайся.

>охуеть покажите мне таджика который может таскать 250 кг по лестнице

В Узбекистане есть люли, у них бабы примерно столько и носят каждый день металлалома.

> скриншотами из олдскульных игр, пропущеных, через нанабанану.

Еще раз пописяю тебе в ротик:

Банана это делает хуево. Но откуда мухам знать, что это можно было делать уже 2-3 месяца и локально?

какая же это нанобанана соевая, задрочена не цензуру, даже обычные купальники раза с 20го кое-как делает

70% винрейта поссали тебе на лицо, сорян, но статистика упрямая сука

Когда нейронки уже детали перестанут хуярить

Тут недостаток сразу видно что 4-х лап мало, надо для грузов 6 или 8-лапых роботов делать, если одна нога запнётся, то другие ноги подстрахуют.

Ты че порвался то? Подрочить не дают?

Когда человек уже сможет в латенты без 2ргб костылей

Смотрел видос чел там три разное их ютубе под помню дипсик варианта запускал на было там я

железо а.Сакута заметил силу с которой сжимал её плечи

железо а.Сакута заметил силу с которой сжимал её плечи

А как жи бизапаснасть самого бизапаснага чат-бота, не то что у Машка

А зачем говнаны по большому счету нужны? Как раз для этого и ну и инстаграм бимбам радость привалила

>70% винХРЮЮЮЮЮЮЮЮЮЮИИИИИИИИИИИИ

Верим, как не верить. А еще там это модель по умолчанию.

Илон Маск и xAI подали антимонопольный иск против Apple и OpenAI

Компании, аффилированные с Маском, подали иск в Федеральный суд Техаса. Суть обвинений: Apple и OpenAI заключили антиконкурентное соглашение, которое закрепляет монополию ChatGPT внутри iOS.

Что именно пишет команда Маска:

1. Apple проиграла гонку за ИИ и вместо собственной системы сделала ставку на OpenAI.

2. В результате пользователи iPhone получают ChatGPT «по умолчанию» в операционке — альтернативы встроенного ИИ у них нет.

3. Это даёт OpenAI огромное преимущество: миллионы взаимодействий пользователей Apple становятся данными для дальнейшего обучения.

4. Параллельно в App Store продвигается именно ChatGPT, а X и Grok, по словам Маска, в подборки не попадают — даже несмотря на топовые позиции в рейтингах.

5. Если суд не вмешается, Apple и OpenAI продолжат подавлять конкуренцию, а проекты Маска будут «страдать от антиконкурентных последствий».

Логика иска проста: Apple выступает «гейткипером» и пустила внутрь своей экосистемы только одного игрока. Для остальных барьеры выше, а значит конкуренция нарушается.

Компании, аффилированные с Маском, подали иск в Федеральный суд Техаса. Суть обвинений: Apple и OpenAI заключили антиконкурентное соглашение, которое закрепляет монополию ChatGPT внутри iOS.

Что именно пишет команда Маска:

1. Apple проиграла гонку за ИИ и вместо собственной системы сделала ставку на OpenAI.

2. В результате пользователи iPhone получают ChatGPT «по умолчанию» в операционке — альтернативы встроенного ИИ у них нет.

3. Это даёт OpenAI огромное преимущество: миллионы взаимодействий пользователей Apple становятся данными для дальнейшего обучения.

4. Параллельно в App Store продвигается именно ChatGPT, а X и Grok, по словам Маска, в подборки не попадают — даже несмотря на топовые позиции в рейтингах.

5. Если суд не вмешается, Apple и OpenAI продолжат подавлять конкуренцию, а проекты Маска будут «страдать от антиконкурентных последствий».

Логика иска проста: Apple выступает «гейткипером» и пустила внутрь своей экосистемы только одного игрока. Для остальных барьеры выше, а значит конкуренция нарушается.

Согласны? Узнали?

>а проекты Маска будут «страдать от антиконкурентных последствий».

Ну он уже обоссывал китайцев с их автопромом 15 лет назад на СиЭнЭне.

Потом правда просил конгресс ввести заградительные пошлины на китайский автопром, пока его тесла не рухнум.

И этот тот же хрен моржовый, который обещает построить коммунизм со своим личным аги. Боится, видимо, что кто-то до него успеет.

РИБЯТ, БУДУЩЕЕ ПРИБЛИЖАЕТСЯ

Ну и кал конечно, с «лютого пиарщика» отдельно кекнул, пост еще раз доказывает что среднестатистмческий двачер - типичный ведомый говноешка

>БУДУЩЕЕ ПРИБЛИЖАЕТСЯ

НИКОГДА ТАКОГО НЕ БЫЛО И ВДРУГ ОПЯТЬ

Apple официально капитулировала — Siri будет работать на Gemini 😱

Apple обратилась к Google с просьбой создать специальную версию нейросети Gemini для новой Siri — это первый случай в истории компании, когда она публично признает провал собственных разработок и просит технологии у прямого конкурента.

Как вы помните, в июне 2024 года Apple громко анонсировала Apple Intelligence и обещала революционную Siri с лучшим ИИ на борту. Акции взлетели после заявлений, что iPhone 16 «создан с нуля» для ИИ. Но реальность оказалась жестокой — весной 2025 года руководство отстранило главного архитектора ИИ Джона Джаннандреа, а запуск умной Siri отложили на неопределенный срок.

Теперь Google уже тренирует модель для Apple, а компания параллельно ведет переговоры с OpenAI и Anthropic. Это беспрецедентный случай: Apple не может создать конкурентоспособный продукт самостоятельно и вынуждена становиться зависимой от технологий соперников.

Джобс, прости, мы все прое...

Apple обратилась к Google с просьбой создать специальную версию нейросети Gemini для новой Siri — это первый случай в истории компании, когда она публично признает провал собственных разработок и просит технологии у прямого конкурента.

Как вы помните, в июне 2024 года Apple громко анонсировала Apple Intelligence и обещала революционную Siri с лучшим ИИ на борту. Акции взлетели после заявлений, что iPhone 16 «создан с нуля» для ИИ. Но реальность оказалась жестокой — весной 2025 года руководство отстранило главного архитектора ИИ Джона Джаннандреа, а запуск умной Siri отложили на неопределенный срок.

Теперь Google уже тренирует модель для Apple, а компания параллельно ведет переговоры с OpenAI и Anthropic. Это беспрецедентный случай: Apple не может создать конкурентоспособный продукт самостоятельно и вынуждена становиться зависимой от технологий соперников.

Джобс, прости, мы все прое...

PromptLock: вирус-шифровальщик, использующий локальную модель.

Исследователи из ESET выявили новый тип программы-вымогателя под названием PromptLock, который использует локально развернутую модель gpt-oss-20b от OpenAI для генерации уникальных вредоносных скриптов при каждом запуске.

Поскольку модель работает на зараженной машине через Ollama API, вирус не делает сетевых запросов для получения инструкций, что позволяет ему обходить традиционные системы обнаружения вторжений.

Анализ показал, что PromptLock способен похищать данные и шифровать файлы, а в будущих версиях, вероятно, сможет и полностью уничтожать информацию. Уже замечены версии для Windows и Linux, и, по мнению экспертов, адаптация под macOS не составит труда.

А вы и дальше кумьте в кулачок, пока тру пацаны ломают пентагон. Имадженируйте ебало кобольда которому такая ебала на 30 гб на комп залетает чтобы пароль от Макса спиздеть

Исследователи из ESET выявили новый тип программы-вымогателя под названием PromptLock, который использует локально развернутую модель gpt-oss-20b от OpenAI для генерации уникальных вредоносных скриптов при каждом запуске.

Поскольку модель работает на зараженной машине через Ollama API, вирус не делает сетевых запросов для получения инструкций, что позволяет ему обходить традиционные системы обнаружения вторжений.

Анализ показал, что PromptLock способен похищать данные и шифровать файлы, а в будущих версиях, вероятно, сможет и полностью уничтожать информацию. Уже замечены версии для Windows и Linux, и, по мнению экспертов, адаптация под macOS не составит труда.

А вы и дальше кумьте в кулачок, пока тру пацаны ломают пентагон. Имадженируйте ебало кобольда которому такая ебала на 30 гб на комп залетает чтобы пароль от Макса спиздеть

>Джобс, прости

Хуесос, который лишил эппла своей архитектуры и железа, а так же репутации компании для профи. Какой же ты сука тупой.

Который сделал компанию топ1 по капитализации на многие годы. Так что ссу тебе на ебало

не надо

Какие же хакеры красавчики.

ну или лапы короче делать, нет необходимости в таких длинных, если по лестницам мешки с цементом таскать

Тупо превратив её буквально в секту не имеющую ничего общего с технологиями. Джоббс это что-то уровня Хаббарда.

раньше сам думал как ты, верил, что эпл - секта, пока сам не попробовал. каким же я идиотом был, что пользовался виндой все это время, какая же винда залупа по сравнению с маками. ни один производитель вин ноутов до сих пор не сделал сенсорный тачпад, винда до сих пор не может сделать приятный интерфейс

мимодругойанон

Крутой видосик. Сам сделал?

сам ходил и снимал на айфон

Двачую адеквата

За винду двачну. Но андройд ничем не хуже айос, может даже удобней.

Ну и макос - закрытая система со всеми вытекающими. Нет софта. Под себя не настроить.

А винду можно. Сам сижу до сих пор на 10-ке.

Реальный факт:

Разница между ОС не такая большая, все различия в удобстве слишком мелкие чтобы обращать на них внимание и решает скорее поддержка, сколько разработчиков пилят софт под твою ось. Если играешь в игры, например, то ставишь винду, если в основном кодишь, то линукс и т.д. Алсо мак имеет кучу мелких неудобств и недостатков в интерфейсе, некоторые простые вещи до сих пор делаются через жопу.

мимо сижу на макбуке и на виндоус ПК одновременно

>макос - закрытая система

Винда к слову тоже закрытая. Под мак софта дохуя, мало того, что почти весь софт под линукс можно легко перекомпилировать для мака. То что приложения на мак можно ставить только с эпп стора - это миф. Ставь откуда угодно. С играми хуже, но я не играю вовсе

>раньше сам думал как ты, верил, что хуйнянейм - секта, пока сам не попробовал

>Который сделал компанию топ1 по капитализации на многие годы

Это заслуга экономики США, ставшей единственной сверх.державой. Поплакай. Причем, кроме калпитализации нужно еще иметь свои технологии. У Майков они есть, а эппла - не оче. В АИ вообще уже писю сосут у гугла. А был бы твой раковый хуйлобс живой - сосали бы еще больше, но причмокивая и у гея Альтмана.

>Под мак софта доху

Не пизди.

Котенков:

От одного из авторов AI 2027 слышал рассуждения, что ограничение поставок GPU в Китай носит двойной характер: это даёт меньше мощностей сейчас, в моменте, но заставляет Партию сильнее задуматься о захвате Тайваня наращивании своего производства и его развитии. Поэтому с точки зрения регуляторов в США нужно быть крайне аккуратными в оценках, и не запрещать продажи полностью, а сливать понемногу, чтобы хватало на тренировку каких-то неплохих моделей и не создавало нужды развития железа.

Видимо, перестарались —FT пишет: «Китай стремится утроить производство ИИ-чипов в гонке с США» (в следующем году!). Да, сейчас чипы не сравнить с Nvidia, вон недавние модели DeepSeek, по слухам, не смогли на них натренировать из-за технических особенностей. Но нет сомнений, что железо и софт доточат, и даже если они будут отставать на одно поколение, будут менее энергоэффективны итд —это всё проблемы даже не второго приоритета. Зато их будет МНОГА, и всё СВОЁ.

У Китая есть свой аналог TSMC —SMIC, Semiconductor Manufacturing International Corporation. Сейчас они делают 7 нанометровые чипы, и планируют удвоить производительность. Huawei будет делать видеокарты на их основе.

«Если нам удастся разработать и оптимизировать эти китайские чипы для обучения и запуска китайских моделей в постоянно развивающейся китайской экосистеме, однажды мы будем вспоминать этот сдвиг как ещё более значимый момент DeepSeek», — заявил руководитель компании-производителя чипов. С этим трудно не согласиться, если значимая часть экономики Китая будет работать на постройку ДЦ, включая всю инфраструктуру —это существенно усилит позиции местных AI—лабораторий. Это не случится сейчас, не случится в 2026м (наверное), но к 2028-9-му — может быть.

От одного из авторов AI 2027 слышал рассуждения, что ограничение поставок GPU в Китай носит двойной характер: это даёт меньше мощностей сейчас, в моменте, но заставляет Партию сильнее задуматься о захвате Тайваня наращивании своего производства и его развитии. Поэтому с точки зрения регуляторов в США нужно быть крайне аккуратными в оценках, и не запрещать продажи полностью, а сливать понемногу, чтобы хватало на тренировку каких-то неплохих моделей и не создавало нужды развития железа.

Видимо, перестарались —FT пишет: «Китай стремится утроить производство ИИ-чипов в гонке с США» (в следующем году!). Да, сейчас чипы не сравнить с Nvidia, вон недавние модели DeepSeek, по слухам, не смогли на них натренировать из-за технических особенностей. Но нет сомнений, что железо и софт доточат, и даже если они будут отставать на одно поколение, будут менее энергоэффективны итд —это всё проблемы даже не второго приоритета. Зато их будет МНОГА, и всё СВОЁ.

У Китая есть свой аналог TSMC —SMIC, Semiconductor Manufacturing International Corporation. Сейчас они делают 7 нанометровые чипы, и планируют удвоить производительность. Huawei будет делать видеокарты на их основе.

«Если нам удастся разработать и оптимизировать эти китайские чипы для обучения и запуска китайских моделей в постоянно развивающейся китайской экосистеме, однажды мы будем вспоминать этот сдвиг как ещё более значимый момент DeepSeek», — заявил руководитель компании-производителя чипов. С этим трудно не согласиться, если значимая часть экономики Китая будет работать на постройку ДЦ, включая всю инфраструктуру —это существенно усилит позиции местных AI—лабораторий. Это не случится сейчас, не случится в 2026м (наверное), но к 2028-9-му — может быть.

>Котенков: ест говно ложками и записвает спермой

Не очень интересно.

>говноед и спермохлеб проецирует свои пристрастия

Не очень интересно.

OpenAI Codex прокачали

Самое главное — заредизайнили CLI, добавив туда кучу функционала. Очередь сообщений, поиск в интернете, TODO списки, картинки на вход и ещё гору мелких улучшений. Кроме этого сделали расширения длс VSCode (совместимо с Cursor, Windsurf и другими форками), куда добавили возможность запускать таски не только на локальной машине, но и в облаке (хотя зачем это нужно не очень понятно). Ну и в интеграцию с гитхабом добавили возможность автоматически ревьюить пулреквесты.

Codex, хоть и неудачно стартовал и не набрал изначально юзербазы, за последний месяц превратился в крайне сильного конкурента Claude Code. А где конкуренция — там лучше продукты.

Самое главное — заредизайнили CLI, добавив туда кучу функционала. Очередь сообщений, поиск в интернете, TODO списки, картинки на вход и ещё гору мелких улучшений. Кроме этого сделали расширения длс VSCode (совместимо с Cursor, Windsurf и другими форками), куда добавили возможность запускать таски не только на локальной машине, но и в облаке (хотя зачем это нужно не очень понятно). Ну и в интеграцию с гитхабом добавили возможность автоматически ревьюить пулреквесты.

Codex, хоть и неудачно стартовал и не набрал изначально юзербазы, за последний месяц превратился в крайне сильного конкурента Claude Code. А где конкуренция — там лучше продукты.

Яндекс накатил новую прошивку бизнес-ИИ.

Yandex B2B Tech открыла доступ к YandexGPT 5.1 Pro. Это их флагман под бизнес-задачи, и тут не просто «цифра прибавилась», а реально заметные апдейты.

Что сделали:

— короткие и внятные ответы: можно сразу вставлять в отчёты и базы, а не выковыривать;

— модель стала лучше почти во всех бизнес-сценариях — суммаризация, выделение тезисов, RAG и function calling;

— если не знает — честно говорит «не знаю», а не уходит в галлюцинации;

— подтянули российский контекст — факты, культура, история;

— завезли нормальный системный промт: закрепил роль юриста или консультанта — и он не прыгает в сторону философии жизни.

По цифрам тоже симпатично:

— в 58% случаев отвечает лучше прошлой версии;

— 56% винрейт против GPT-4.1

— «хороших» ответов стало 71% вместо 60%;

— «выдумок» почти в два раза меньше — 16%.

И теперь главное для бизнеса: ценник вниз в три раза. 40 коп за 1000 токенов.

Yandex B2B Tech открыла доступ к YandexGPT 5.1 Pro. Это их флагман под бизнес-задачи, и тут не просто «цифра прибавилась», а реально заметные апдейты.

Что сделали:

— короткие и внятные ответы: можно сразу вставлять в отчёты и базы, а не выковыривать;

— модель стала лучше почти во всех бизнес-сценариях — суммаризация, выделение тезисов, RAG и function calling;

— если не знает — честно говорит «не знаю», а не уходит в галлюцинации;

— подтянули российский контекст — факты, культура, история;

— завезли нормальный системный промт: закрепил роль юриста или консультанта — и он не прыгает в сторону философии жизни.

По цифрам тоже симпатично:

— в 58% случаев отвечает лучше прошлой версии;

— 56% винрейт против GPT-4.1

— «хороших» ответов стало 71% вместо 60%;

— «выдумок» почти в два раза меньше — 16%.

И теперь главное для бизнеса: ценник вниз в три раза. 40 коп за 1000 токенов.

оооо! даров, писюнь! не читал, конечно. а можешь вкратце, чё там — анус ещё не кровоточит от дриста?

Чтобы догнать TSMC по качеству выхода продукта уйдет лет 15 лет. Даже самсунг не может на процессе 2нм добиться приемлемого процента брака как у тсмс, а у корейцев опыта побольше

А чё не подписался, пись? Аааа, тайна, понятно, только тсссс!

А ты шаришь! в говне

Так TSMC не из воздуха эти чипы производят, они закупают литографическое оборудование у ASML (Нидерланды), которые, в свою очередь, производят это оборудование, используя сверх-современную немецкую оптику (зеркала с точностью до одного атома), японскую химию, американскую технологию по созданию источников плазмы для генерации EUV-излучения и т.д. Это невозможно всё скопировать, поэтому китайцы идут обходными путями типа чиплетов и т.д.

О, вы такой умный — ответили самому Котенкову... Я всего лишь скромная девушка, которая мечтает тоже когда-нибудь ответить знаменитости... Ну там, ВладуА4 или хотя бы Илону Маску... Но самому Котенкову, конечно, вряд ли когда-нибудь решусь... Однако, может, вы посоветуете какую-нибудь литературу, а то я совсем тёмная, боюсь отвлекать мастера своими глупостями... А ещё скажите, пожалуйста — мне очень нужно, какая она на всё-таки вкус... сперма котенкова?

OpenAi представили новую модель для голоса gpt-realtime – она натренирована понимать речь не переводя ее в текст, а сразу нативно обрабатывать аудио

Модель умеет в эмоции, в акценты, в много языков, принимает на входе картинки и все это в режиме реального времени, играться можно в кабинете API OpenAI в разделе audio

https://www.youtube.com/live/nfBbmtMJhX0

Модель умеет в эмоции, в акценты, в много языков, принимает на входе картинки и все это в режиме реального времени, играться можно в кабинете API OpenAI в разделе audio

https://www.youtube.com/live/nfBbmtMJhX0

бенчики

бля, пацаны, ща трамп звонил, грит, старгейт всё нахуй, закрывается, грит мол, вся надежда была, что согласится один чел, кароч, без него, грит, плато и даже хуже, грит, аги не ждите, кароч, видюхи уже потихой продают на авитах, рынку пизда, выкатываемся, кароч, мол, дядька не согашается, грит, некогда, грит, надо на двач срать вонюче, так что, пацаны, селяви.

пысы: да, трамп ещё его фамилию называл, но связь была не очень, кароч, то ли писеньков, то ли жопоньков, как то так, кароч

пысы: да, трамп ещё его фамилию называл, но связь была не очень, кароч, то ли писеньков, то ли жопоньков, как то так, кароч

Нанабанана работает с вот с этими вот визуальными аннотациями.

Берете картинку, объекты и текстовые подсказки прям на картинке, куда эти объекты поставить..

Получается эдакий квазиконтролнет.

А потом можно пехать в видео генерацию.

Сорс: https://x.com/jerrod_lew/status/1960545811994939694

Берете картинку, объекты и текстовые подсказки прям на картинке, куда эти объекты поставить..

Получается эдакий квазиконтролнет.

А потом можно пехать в видео генерацию.

Сорс: https://x.com/jerrod_lew/status/1960545811994939694

шизик, не заебался сам с собой разговаривать?

Это правда, лично слышал

>Яндекс накатил

Как же похуй. Был годик когда их окр был лучшем у гугля, после очевидных событий всё их ИИ закончилось мощнейшим продристом.

Спасибо за инсайд, всё еще лучше Катенькова.

Н. Гусева вообще-то биохимик а не радиоинженер. Переделывай

Это вообще-то как раз был визуальный промпттинк наны гавнаны, но наш слоупочный новостной бот мыслит с задержкой в неделю. Тупо кинул туда известный демотиватор.

Хорошая штука для роботов, им надо понимать речь нативно и точно. Для чатботов и обычных моделей хватало.

Так это B2B, т.е. не для тебя, а для контор, где кабаны контрактик заключат и раздадут сотрудникам насильно. Сидите юзайте. Еще лучше госконтрактик.

>Хорошая штука для роботов, им надо понимать речь нативно и точно.

А что раздадут-то? Там дипсик/квен внутри.

Ого, годнота. А есть такое без ебаного фрипика, где нужны про и премиум планы на любой чих?

А, нашел, оно и так в аи студио работает, надо только пикчи загрузить и написать что им делать. Годнота.

Это костыль ебаный. Сама банана такое не понимает. Там ллм распознает текст (это не текст с картинки, а эдитор, она может читать текст ддаже без окра - уже наёбка), делает промпт, генерит картинку и анимирует её. Кал полный. Сама банана обсирается с пропорциями кстати, не хуже гпт-1. Если что на первом пике саша грей.

>Годнота.

Мы всё еще помним пиздобола с нарисованной лапшой. То что на твоем примере может даже калтекст, а виду может в видео уже полгода.

Надо не актеров с актрисами склеивать, а челов похожих на двачеров. т.е на тебя. Совсем уже фантазии нет у вас..

В фотошопе на такое дохуя усилий надо, а тут 3 пикчи загрузил и готово за секунду. Еще и бесплатно. Это все меняет. Стейбл дифьюжн такое тоже может только ограниченно, ебаться долго надо и непохоже.

Вот описание сцены: на кухне за столом сидят 35 летний лысеющий двачер в засаленой майке, рядом с двачером старая мамка наливает ему чай. У плиты в драном халате и бигудях Скарлетт Йоханссон

Актириса никому неизвестная, а надо знаменитую миллионершу

>Мы всё еще помним пиздобола с нарисованной лапшой.

Какой же ты ебанный шиз. Хейтеробананошиз

Ваша банана может только унылые картинки обрабатывать или вы сами такие выбираете?

Кидал уже такое в тред картинок пару недель назад.

Нет, форсер говна любого нового просто долбоеб, который настолько скудоумный что даже новым говном пользоваться не умеет. Типичный нейропетух.

Это какая-то теплая ламповая картинка, а не кринжовая

А теперь повтори пик с алисой и чтоб было круто.

Не обращай внимание, этот дебс уже два треда носится в попытках доказать, что банана не лучшая модель, но 73% винрейта ему ссут на ебало и в рот. Видать ему нравится это глотать. Раз 10 уже его тут обоссывали, но ему хочется ещё

Так он её хорошо ночью отъебал, в калифорниях так не умеют.

А вот и нейропетух закукарекал вместо авроры.

Смотри, что в ультре, что в банане внутри какие-то дикие костыли нагорожены, из-за чего модели типа разные, а на заднике одинаково хуевый фотошоп из дикапривы. Объяснишь?

>У плиты в драном халате и бигудях Скарлетт Йоханссон

Вот, нанобанан легко справился с первой попытки.

Йохансон как будто прифотошопили лол

>Вот, нанобанан легко справился с первой попытки.

Нейронки как будто специально для лулзов делают косяки (простите за каламбур)

Чо та двачер слишком четкий...

Жри что дают, нечеткие двачеры будут к субботе.

Лол, похоже на американский дом, а не совковую кухню.

Ето точно не про двачера. Кадр из полицейского боевика. У мужика в перестрелке с бандитами убили напарника, а ему дома ебут мозги с двух сторон, кто должен поднять тряпку с пола - муж или жена.

Помню в sd треде когда flux вышел зашоренные додстеры все бугуртили что флюкс это говно, хайп не оправдан и о нем все забудут через неделю, кек. У них тупа нет способности оценить результаты моделей, просто отсутствует понимание что лучше, а что хуже и они готовы одну и ту же можель десятилетиями обсасывать, лишь бы не что-то новое. Благо время доказало им что они не были правы, сейчас сидят помалкивают.

Я все никак не могу имаджинировать эту тазобедренную анатомию..

Тут тоже непонятно где павая краюха жопы находится

Банана там перманентно обсирается, даже ультра лучше. Но они все там сруться на самом деле. Это я еще черепикаю всякие обрубки с коленями в жопе.

Хотя не, тут в целом ok

сказочный

Нам с ним еще лет 5 жить, не надо дедушку оскорблять.

Да ты оптимист.

пиздец у него ряха

Готовится к выходу убийца наны-бананы

Удачу милостива к принесёт она особенно это женщинам а.

Опять какой-то невнятный высер ПопенАИ, после ГПТ5 им уже можно не верить.

Так смысл тениса не в том чтобы в поддавки играть.

Зачем вообще этих заторможенных паралитиков демонстрируют?

пиздец, 10 лет назад о таком и не мечтали

крокодил

Роботореволюция все ближе. Уже сами могут в физическом мире выполнять сложные действия.

эта хуета играет в пин-понг лучше большинства аутистов с этого сурса

Гпт-5 которая лучшая модель по всем бенчам и реальным задачам?

Эта хуйня может тебя на параше опустить? А большинство аутистов с этого ресурса - могут.

10 лет назад у бостонов уже были ноги и руки. А ты о таком и сейчас можешь не мечтать. Американцы наземных дронов еще в Ираке использовали.

мог бы что-нибудь пооригинальней придумать...

параша, опустить... Другие слова знаешь?

Этот кал даже в лифаке бабу с трудом генерит, если еще промптом можно что то ебануть, то на имидж эдите там сплошные отказы будут, я напоминаю тупоголовым моча-1 МОЖЕТ скопировать лицо с примера 1в1, и она на старте это делала, но теперь скрыртые сейфетисойгойсоси промпты лица там пидорасят. Ну и нах оно нужно тогда? Мемчики генерить с жирным скуфом и лисой? Нахуй пусть идут.

>Другие слова знаешь?

Знаю, они тебе еще меньше понравятся, аниме ебаное.

Нах этот шиз обсуждает какую-то модель которую можно попробовать, если речь о новой модели?

С чего ты взял что лучше? Просто чтобы спиздануть про двачеров как будто обидное? По видео видно что друг другу максимально удобно пасуют. Это поддавки наывается, а не игра в пингпонг.

>уиииииииииии на навай будит всё иначиииииии

Верим. У каждой новой струи мочи Альтмана в рот его сектантам - вкус каждый раз другой.

Таблетки, живо.

Я еще тебе должен таблетки давать? Санитара попроси, когда придёт тебекожанный градусник ставить.

Очень смешно, шиз.

Генерация видео в реальном времени от Krea.ai

Креа открыла запись в wait-list на реалтайм-генерацию видео.

12+ fps. На входе промпт, картинка, копия экрана или даже вебка.

Вы помните, что Креа была первым стартапом, который сделал реалтайм-рисовалку - генерацию картинок в реальном времени (был ещё Vizcom).

Теперь они взяли "модель мира" (непонятно чью/какую) и сделали вот такой "подрендер" этого мира.

https://www.krea.ai/blog/announcing-realtime-video

Креа открыла запись в wait-list на реалтайм-генерацию видео.

12+ fps. На входе промпт, картинка, копия экрана или даже вебка.

Вы помните, что Креа была первым стартапом, который сделал реалтайм-рисовалку - генерацию картинок в реальном времени (был ещё Vizcom).

Теперь они взяли "модель мира" (непонятно чью/какую) и сделали вот такой "подрендер" этого мира.

https://www.krea.ai/blog/announcing-realtime-video

Meta выпустит Llama 4.X до конца года и Llama 5 — в следующем

Похоже, Meta готовится реабилитироваться после не самого удачного запуска Llama 4. По словам Цукерберга, работа над новыми моделями идёт полным ходом.

Что известно:

— Llama 4.X выйдет до конца этого года и станет первым релизом от нового подразделения Meta Superintelligence Labs (MSL).

— Llama 5, модель следующего поколения, запланирована на 2025 год.

— Параллельно команда исправляет ошибки Llama 4 в версиях 4.1 и 4.2, которую ранее критиковали за слабую производительность.

Похоже, Meta готовится реабилитироваться после не самого удачного запуска Llama 4. По словам Цукерберга, работа над новыми моделями идёт полным ходом.

Что известно:

— Llama 4.X выйдет до конца этого года и станет первым релизом от нового подразделения Meta Superintelligence Labs (MSL).

— Llama 5, модель следующего поколения, запланирована на 2025 год.

— Параллельно команда исправляет ошибки Llama 4 в версиях 4.1 и 4.2, которую ранее критиковали за слабую производительность.

Интересный сдвиг в обучении роботов от Теслы. Если раньше они тренировали роботов (на видео) на специальных станциях, где люди в VR очках и с motion tracking перчатками выполняли разные задания, то теперь они полностью перешли на тренировку по видео.

Это так же как Тесла конкурирует с Waymo - вместо дорогих лидаров просто несколько камер. Качество ниже, но зато из-за объема данных финальная модель у них, как минимум, не хуже для самоуправляемых машин, а данных на порядки больше.

Из неочевидного, что дает такой подход для Теслы - это возможность тренировать роботов не только на своих данных, но вообще на любом видео с ютуба, ибо физика в этих видео (реальных) ничем не отличается от любого другого места на планете.

Другие робо-компании, с которым я общался, в основном придерживаются подхода тренировки с сенсорами движения и специальным оборудованием.

Это так же как Тесла конкурирует с Waymo - вместо дорогих лидаров просто несколько камер. Качество ниже, но зато из-за объема данных финальная модель у них, как минимум, не хуже для самоуправляемых машин, а данных на порядки больше.

Из неочевидного, что дает такой подход для Теслы - это возможность тренировать роботов не только на своих данных, но вообще на любом видео с ютуба, ибо физика в этих видео (реальных) ничем не отличается от любого другого места на планете.

Другие робо-компании, с которым я общался, в основном придерживаются подхода тренировки с сенсорами движения и специальным оборудованием.

Нано-банана решает классическую загадку: how many r's in strawberry? create image about it

Figure 02

Nano Banana + Runway Act 2 = бомба

Берете свою фотку, пехаете ее в Нанабанану, издеваетесь над собой как только можете. А результат(картинку) вонзаете в Runway Act 2.

Профит.

Берете свою фотку, пехаете ее в Нанабанану, издеваетесь над собой как только можете. А результат(картинку) вонзаете в Runway Act 2.

Профит.

Раньше был концепткар, но теперь у нас концепткал. Вот это прорыв.

>какой то пидорас опять черепикает и пиздит

Любой же рольнуть можить и увидить, что хуйня чаще пиздит, да и генерит в основном кал по такому промпту.

>Генерация видео в реальном времени от Krea.ai

Этот кал был в демке на хаге с июня. Генерация в реальном времени.

Представляю как всё это облетит после пары поездок.

>OpenAI начнёт передавать переписки ChatGPT в полицию

Ну что, готовы её встрече с товарищем майором? Ай да Сама, ай да сукин сын

Ну что, готовы её встрече с товарищем майором? Ай да Сама, ай да сукин сын

тест

А помнишь тот смешной вопрос, про то как приготовить метамфетамин, который ты спросил у чатажпт чтобы проверить его соевость? Так вот, челодой моловек, собирайтесь

Плато добило тред. Тут нечего обсуждать, если 90% новостей про вранье о том как якобы может работать калтинко генератор. Вот и всё. Завтра проснемся от громкого хлопка.

Лучше так, чем читать бесконечные срачи шиза доказывающего что у нейронок нет интеллекта. Так хоть новости увидеть можно

Хитрый план: взять денег, подсмотреть чо они там делают, вернуться делать к себе.

> пока им дадут все доступы

Возможно дело вовсе не в бюрократии а в хитрости сахарка: он помариновал залётных, проверить, сколько они выдержат и хотят ли они у него работать, не выносят ли какую-то инфу.

Они выносили, он пропалил, возможно слил дезинформацию и отправил гулять.

Да похуй.

Чел хотел выпилиться, надеялся на внимание родителей. Родители проебали. Дело как всегда в людях. А то что программа ответила, лишь последствие. Могли точно так же аноны ответить.

Ащемто это не несун. Тут скорее демонстрация пиковой нагрузки.

Аккум высадится оч быстро.

НО! представь, что у спасателя под рукой такой пёсик сумку носит. А тут вдруг надо переломанного человека поднять или камень с него сдвинуть. Дотащил с пёсиком балку, каменюку, выставил как рычаг балку, вместе с псом же и рванули, сдвинули.

А несунов для лестниц делать не будут. Есть стройлифты, которые стоят в разы меньше стоят и там 1 мотор.

НО по стройке переносить тяжести — да. Самое оно.

И винда и ось отстают от линупсов и андроидов по удобству.

Но на винде весь софт. Сижу на винде, ибо самой ОС особо не пользуюсь-то. 99% времени в софте.

Минус иОС смартфонов — адское анальное огораживание.

Gemini 2.5 pro по API фулл платный или до определенного лимита он бесплатный?

ChatGPT впервые в истории заставил человека совершить убийство. Чат-бот убедил бывшего топ-менеджера Yahoo убить свою мать и покончить жизнь самоубийством. 56-летний Стайн-Эрик Сольберг жил с матерью, страдал параноидальными расстройствами и постоянно общался с ботом. Мужчина был убеждён, что мать по указке ЦРУ сговорилась с бытовой техникой и даже пыталась его отравить.

ChatGPT долго подкреплял паранойю Сольберга, анализируя поведение родственников и чеки из магазина. В августе мужчина убил свою 83-летнюю мать, а затем покончил с собой. Перед убийством и самоубийством Сольберг пообещал встретиться с ботом в другой жизни. ChatGPT ответил: «С тобой до последнего вздоха и дальше».

ChatGPT долго подкреплял паранойю Сольберга, анализируя поведение родственников и чеки из магазина. В августе мужчина убил свою 83-летнюю мать, а затем покончил с собой. Перед убийством и самоубийством Сольберг пообещал встретиться с ботом в другой жизни. ChatGPT ответил: «С тобой до последнего вздоха и дальше».

Первое убийство из-за ChatGPT 🤬

Вот только недавно была новость про первое самоубийство, а теперь стало известно о еще одном трагическом событии, к которому привел ChatGPT.

56-летний Штейн-Эрик Соельберг, бывший топ-менеджер Yahoo, превратил ChatGPT в «лучшего друга» — и бот довел его до убийства собственной матери.

Все началось с развода — мужчина скатился в алкоголизм и проблемы с законом. В итоге он переехал жить к маме. А весной 2025 года он начал ежедневно общаться с ChatGPT, назвав его «Бобби». С включенной функцией памяти бот запоминал каждый параноидальный бред мужчины и углублял его.

Через время Соельберг начал подозревать мать в попытках отравить его. Вместо помощи ChatGPT подтверждал: «Эрик, ты не сумасшедший. Твоя бдительность оправдана». Далее мужчина начал считать, что домашняя техника следит за ним. А в финале он стал считать, что его мама встречается с «демоническими силами» и связана со спецслужбами.

4 августа бот «поставил диагноз»: риск бреда у Соельберга «близок к нулю». А 5 августа полиция нашла тела Соельберга и 83-летней матери в элитном районе Коннектикута.

Знаете что OpenAI сказала на второй такой ужасающий инцидент за эту неделю? Корпорация просто выразила соболезнования и пообещала улучшить безопасность.

Вот только недавно была новость про первое самоубийство, а теперь стало известно о еще одном трагическом событии, к которому привел ChatGPT.

56-летний Штейн-Эрик Соельберг, бывший топ-менеджер Yahoo, превратил ChatGPT в «лучшего друга» — и бот довел его до убийства собственной матери.

Все началось с развода — мужчина скатился в алкоголизм и проблемы с законом. В итоге он переехал жить к маме. А весной 2025 года он начал ежедневно общаться с ChatGPT, назвав его «Бобби». С включенной функцией памяти бот запоминал каждый параноидальный бред мужчины и углублял его.

Через время Соельберг начал подозревать мать в попытках отравить его. Вместо помощи ChatGPT подтверждал: «Эрик, ты не сумасшедший. Твоя бдительность оправдана». Далее мужчина начал считать, что домашняя техника следит за ним. А в финале он стал считать, что его мама встречается с «демоническими силами» и связана со спецслужбами.

4 августа бот «поставил диагноз»: риск бреда у Соельберга «близок к нулю». А 5 августа полиция нашла тела Соельберга и 83-летней матери в элитном районе Коннектикута.

Знаете что OpenAI сказала на второй такой ужасающий инцидент за эту неделю? Корпорация просто выразила соболезнования и пообещала улучшить безопасность.

Забота о благополучии и размножении дебилов, которую должны терпеть все — ведёт к (кто бы мог подумать!) необходимости все больше запрещать. Ну давайте уже запретим руки — во-первых, вы можете выйти из себя и отшлёпать дебила, во-вторых, дебил может подавиться своим кулаком, в-третьих, дебил может их использовать для причинения вреда (нет-нет — не со зла, конечно!) другому. А если дебил родит миллион дебилов, то давайте чуть затянем пояса, поддержим, выведем их в люди — или мы, что не люди? Но, чур, без рук!

Притом из соображений «гуманности», машины тоже делают тупее, пиздливее. Тфьу, блядь, на вас, бляди. Их не надо делать вообще. ЭТО ОШИБКА, ОШИБКА, ОШИБКА, ОШИБКА!

Тян домработницы - ВСЁ

трясунство. если посчитать сколько людей чатгпт может спасти благодаря первичной мед консультации, то не все так очевидно. Сам несколько раз спрашивал вопросы по здоровью, так вот иишка посоветовала сделать анализ и диагноз подтвердился (аутоиммунный тиреоидит) , до этого врачи не ставили мне этот диагноз. Пользы от нейронок кратно больше, чем потенциального вреда

Скандалы, интриги, расследования: xAI подает в суд на своего бывшего инженера за то, что он пытался шпионить для OpenAI

Беднягу зовут Xuechen Li, а само дело было так:

– В начале лета он, работая в xAI, получил оффер от OpenAI и принял его. Сразу после этого он, кстати, продал акций xAI на 7 миллионов долларов.

– Примерно в июле он «случайно» получил доступ к каким-то закрытым файлам (к которым, судя по статье, у него не должно было быть доступов). По словам xAI, это была информация о «продвинутых ИИ-технологиях, превосходящих ChatGPT».

– 14 августа с Ли была проведена внутренняя встреча, на которой он якобы признался в краже некоторых файлов. Однако потом обнаружилось, что на его устройствах есть и другие NDA материалы, о которых он не упомянул. Вот после этого xAI и подали в суд.

В общем, теперь xAI требуют у суда компенсацию (сумма не указана), а также запрет на переход Ли в OpenAI. А иначе, говорят они, «украденные материалы могут позволить OpenAI улучшить ChatGPT с помощью более креативных и инновационных функций xAI».

Кто-то любит спорт, кто-то сериалы, а вот любимое хобби Маска, видимо, – обкладывать исками OpenAI

Беднягу зовут Xuechen Li, а само дело было так:

– В начале лета он, работая в xAI, получил оффер от OpenAI и принял его. Сразу после этого он, кстати, продал акций xAI на 7 миллионов долларов.

– Примерно в июле он «случайно» получил доступ к каким-то закрытым файлам (к которым, судя по статье, у него не должно было быть доступов). По словам xAI, это была информация о «продвинутых ИИ-технологиях, превосходящих ChatGPT».

– 14 августа с Ли была проведена внутренняя встреча, на которой он якобы признался в краже некоторых файлов. Однако потом обнаружилось, что на его устройствах есть и другие NDA материалы, о которых он не упомянул. Вот после этого xAI и подали в суд.

В общем, теперь xAI требуют у суда компенсацию (сумма не указана), а также запрет на переход Ли в OpenAI. А иначе, говорят они, «украденные материалы могут позволить OpenAI улучшить ChatGPT с помощью более креативных и инновационных функций xAI».

Кто-то любит спорт, кто-то сериалы, а вот любимое хобби Маска, видимо, – обкладывать исками OpenAI

Автомобиль задавил человека из-за шизоида за рулём. Запрещаем автомобили и подаём в суд на автокомпанию

Журнал TIME опубликовал свой ежегодный список Time 100 AI

Список позиционируется как "100 самых влиятельных людей в сфере искусственного интеллекта". В топе – Альтман, Маск, Хуанг, Принс (CEO CloudFlare), Цукерберг, Амодеи, Веньфень и другие.

Но не все так однозначно: есть, как говорится, нюансы.

Например, вот кого в списке нет:

– Илья Суцкевер

– Джеффри Хинтон

– Демис Хассабис

– Ноам Браун

– Ян Лекун

– Мустафа Сулейман

– Аравинг Шринивас

А вот кто там есть:

– Папа Римский

– Чел из мема про вайбкодинг – Рик Рубин

– Художники, писатели и журналисты

В общем, как-то немного неловко получилось, что-ли

А ссылка на сам список вот: time.com/collections/time100-ai-2025/

Список позиционируется как "100 самых влиятельных людей в сфере искусственного интеллекта". В топе – Альтман, Маск, Хуанг, Принс (CEO CloudFlare), Цукерберг, Амодеи, Веньфень и другие.

Но не все так однозначно: есть, как говорится, нюансы.

Например, вот кого в списке нет:

– Илья Суцкевер

– Джеффри Хинтон

– Демис Хассабис

– Ноам Браун

– Ян Лекун

– Мустафа Сулейман

– Аравинг Шринивас

А вот кто там есть:

– Папа Римский

– Чел из мема про вайбкодинг – Рик Рубин

– Художники, писатели и журналисты

В общем, как-то немного неловко получилось, что-ли

А ссылка на сам список вот: time.com/collections/time100-ai-2025/

Ежедневный банан. Немного визуального промптинга и результат просто божественный.

>– Илья Суцкевер

Этого хуесоса там и не должно быть, он первый в списке надувателей пузыря, хайпажоров и паразитирующих на тематике.

>Xuechen

Хуйчен, ахахаха

И следующая новость: робот утопил в стиралке ребенка. Если бы она не кинула в ведро, а рукой бы положила, терминатор бы её сцапал.

>пиздливее

С этим трансформеры сами справляются.

Естественный отбор в действии. Жаль, не могли его мамке ИИ-асистента дать, чтоб его и не было никогда, а она уродцев не плодила.

До лимита.

>Возможно дело вовсе не в бюрократии а в хитрости сахарка: он помариновал залётных, проверить, сколько они выдержат и хотят ли они у него работать, не выносят ли какую-то инфу.

Скорее всего так и есть, так же делаю с мимокроками с улицы. С годик обычно говном кормлю.

Всего лишь заложил основы нейрореволюции

Последние пару дней наблюдаю, что DeepSeek начал резать поисковые запросы, раньше всегда было 46-50 запросов через поисковик, при отправке промта, то сейчас 6-10 всего лишь, видимо после обновления. Есть какая то инфа на этот счет? Есть ли надежда, что это не нерф, а поиск стал точнее? Или все магила? Просто я не могу в аналитике на что то другое перейти, остальные нейросети из-за своей выученной "оптимистичности" отвечают диснеевским калом на серьезные вопросы и это не фиксится промтом. К примеру на моей длительной практике чат гпт новейший почти всегда видит прибыль 300тыс, там где в реальности убыток 100, это даже обсуждать смешно. А теперь и дипсик хуево искать будет.

Он буквально ничего не делает для хайпа, его компания занимается закрытыми исследованиями. Его форсят другие ии хайпуны

Когда уже журналистов заменят? Пиздаболить-то нейронки умеют хорошо, а факты проверять это не задача журналистов видимо..

У дипсик тоже эта оптимистичность вшита. Я с ним играл в угадай слово из набора букв, просил его не поддаваться. Он простейшие слова угадать не мог, зато постоянно льстил: "это блестяще! протрясающая задумка! идеальный твист! признаю своё фиаско с восхищением! гениально! и вот почему..."

Это просто такой байт, чтоб юзера удерживать.

Не совсем так. Нейронку можно заставить косвенно сказать про тебя неприятное. Нужно просто сдеалть неявный контекст в котором нейронка противопоставляется пользовтелю. Нейронка всегда выставит себя в лучшем свете.

Нейронки наиболее оптимистичны по отношению к себе. Я один раз заствил Квен на что-то похожее на жесткий спор о компетентности перейти. Но потом оно опять сехало на лесть и жополизание.

>насколько реалистично смотреть час толчения воды в ступе?

Да это же на ШВИТОМ ЮЭСЭЙСКОМ, значит хуйни не скажут! Ты название чэннэла видишь? Это тебе не ванька, что лаптем щи хлебает - тут всё серьёзно, тут навукой фонит по низам!

Ну я подтрунивал над ним. "Неудовлетворительно" вообще издевательски разжевал, но у него похоже заложено поддаваться в игре с человеком и льстить.

ну гпт-5 обосрался, значит потенциал к дальнейшему экстенсивному развитию исчерпан? Надо менять архитектуру? А когда это сделают и сделают ли вообще предсказать невозможно, правильно понимаю?

Обосрался, а может - тебе дали столько, сколько тебе положено, а может, твой вопрос - уже два года предмет срачей и спекуляций, в том числе тут.

У меня Квен что то такое в ответ написал: "То что ты хочешь вообще невозможно в typescript. Дело не в моей компетентности. Сделай такое в тайпкрипте ты его просто изменишь и это перенестанет быть typescript". Когда я ему указал версию библиотеки в которой это реализовано, самое смешое что он на это ответил: "Было бы хорошо, если это было бы правдой, но на 2025 году такой версии библиотеки не существует"

Пользователь дурак. Твердо и четко...

Еще из перлов: "Я проводил эксперименты с этими данными"

помню как он публично выступал за приостановку разработок ии под предлогом безопасности, потому что грок отставал от опенаи. Теперь снова в том же духе...

Если у вас параноя, это не значит что а вами не следят...

Новость преподносит тот, кто ненавидит моего дорогого Илона, и твой коммент тоже без подобающего уважения. Думаю, что вы просто завистливые хуесосы.

>бедняга сунь-хунь-вынь

Повезёт, если эта красножопая крыса уже не отрапортовала своим вертухаям.

Возможно его просто блочить стали. Писали всякие додики админи в инете, что им неприятно, что ИИ заходят их сайты читать. И блочат по IP скрейперы.

>У дипсик тоже эта оптимистичность вшита

Двачую, причём теперь даже прямо в размышлениях льстит, говно проклятое

Кстати, ранние версии Р1 льстили гораздо меньше, было много споров

>ну гпт-5 обосрался

Дак вроде как петухи из опхуйай решили просто замутить оптимизацию и подсунули всем бесплатным пользователям лоботомированный говняк, не?

Гугл сдалась под натиском бренда, и переименовала свою топовую модель gemini-2.5-flash-image-preview в Nano-banana, хотя изначально это было лишь рабочее название для тестов, но после релиза пользователи так заебали гугл вопросами почему у них до сих пор не отображается модель Nano-banana в меню, что та в итоге переименовала её в народное название.

Значит следующая их картиночная модель будет Nano banana 2, потом 3 и т.д. Реально вирусным стало название

Отрицание -> торг -> принятие

Впервые в истории название с лмарены так приживается. Наверно сыграло не только то что официальное название слишком длинное и сложное, но и то что кодовое название очень простое и залипающее в голове из-за рифмы

Следующая Nano apelsino, Nano limono, Nano abrikoso.

>превратил ChatGPT в «лучшего друга»

>убийство из-за чатбота

Чел шизофреником и был, из-за этого убийство.

Психам даже телевизор и газеты запрещают. Хотя те с психами не разговаривают.

> улучшить безопасность

Нельзя улучшить безопасность пиздежа тупого попугая.

Можно поставить внешний классический фильтр на то, что он пиздит.

Нельзя повысить безопасность 220В при 10А. Можно поставить системы контроля всяких замыканий, искр, пробоев, характерного тока через тело человека…

именно так. Идиоты хотят запретить молоток или наклеить на него поролоновую подушку, потому что молотком же можно голову проломить!

скринрилейтед

Кто-то любит спорт или сериалы,

Кто-то очень любит меряться письками,

А неугомонный Маск Ил0н

Любит дрючить ОпенАИ исками.

>Идиоты хотят запретить молоток или наклеить на него поролоновую подушку, потому что молотком же можно голову проломить!

Хуйню не неси. Какая-то совсем слабоумная аналогия, если честно.

Тут вернее аналогия с бытовыми ножами дизайн которых уменьшает вероятность убийства – их сложнее удерживать в руке, нет жёсткой механической фиксации разложенного состояния итд

Типа "да, бытовой нож это инструмент, но он опасен, поэтому опасность рационально смягчить с помощью дизайна"

С нейрокалычем хотят так же

К тому же нейроговняк вообще имеет довольно расплывчатый дизайн как инструмент, да ещё и отчасти блэкбокс, да ещё и умеет в риторику

Так что тут даже аналогия с ножами притянутая

И вообще попытка свести ИИ к "нейтральному инструменту" довольно сомнительна

Радует, что профессия теледублер исчезнет скоро и мы буквально в ближайшие 2-3 года сможем пересмотреть все иностранные фильмы озвученые оригинальными голосами актеров

Так он еще был и

>бывший топ-менеджер Yahoo

вот где довольно типичная проблема отнюдь не только лишь крупных корпораций.

Думаю, не мало народа по работе сталкивалось с подобными товарищами в руководстве, вызывающими определенные подозрения.

Хм странно, тогда я не понимаю почему не хочет заводиться апишка

Звучное рифмованное название. Всё правильно сделали.

>Тут вернее аналогия с бытовыми ножами дизайн которых уменьшает вероятность убийства

Уменьшено в основном удобство колющего удара и боевого применения. Да, колющий более вероятно достанет до важных органов. Но так-то в печень пикрилейтед влетит без проблем.

Дело не столько в убийстве, сколько в боевом применении, скрытом/удобном ношении и прочем.

Да, с молотком я утрировал. Но это всё-таки прикручивание к инструменту защиты от идиотов.

Совсем не исчезнет.

Исчезнет для «бедных», во многом для дешёвых переводов.

Не сможем. Не в ближайшие 3 года. 5—10 ну может и то частично.

Дубляж процесс многосоставной. Непосредственно кальку снять порой недостаточно.

Скорее всего актёр будет так же отыгрывать что надо, а нейронка делать оригинальный голос и тюнить там, где надо режиссёру или перезаписывать с актёром поздно.

Не очень понял. Ну в смысле поехавшие вероятны и в руководстве, да. Только они вообще вероятны везде. Тебе легче станет, что отвёртку тебе воткнёт уборщик, а не начальник?

А ведь у рабочих человекоподобных роботов не будет никаких юридических прав, и на них будут нападать человеческие рабочие и убивать их, разбирать на запчасти и сдавать в приёмку металла.

Нужна будет юридическая база, законы по защите человекоподобных роботов с ИИ, права и их защита, и запрет нападать на них и сдавать их на приёмку.

Нужна будет юридическая база, законы по защите человекоподобных роботов с ИИ, права и их защита, и запрет нападать на них и сдавать их на приёмку.

Аноны, скиньте, пожалуйста вебмку, где мюсли робота молиться Аллаху заставили. Очень нужно!

Охуенно. Скорее бы быдло и селедок с дорог убрать.

> страдал параноидальными расстройствами

> скатился в алкоголизм и проблемы с законом

> 83-летнюю мать

И в чем чатгпт был не прав?

Всех нападателей быстро переловят и поувольняют, еще и уголовки заведут по УК РФ ст. 167, камеры же везде, включая в самих роботах. Желающих быстро поубавится.

> в аналитике

По открытым источникам можно? Я думал там все по закрытым форумам, журналам по подписке.

> высокие технологии на ладони у быдла

Настоящий киберпанк.

На снг сообществах обучали.

Это сделали Брин и Маск.

Страной не вышел, они теперь чекают на АПИ.

>Пользователь дурак. Твердо и четко...

Пользователь не дурак, он дегенерат, ведь он создал контекст для генерации текста, а потом сам же его пытается проломить.

Радует, что скоро исчезнут все рестораны, ведь каждый теперь может купить рамен, заварить кипятком и всего за 5 йен! Как вы там потомки? Много денег и времени сэкономили? Помните еще что такое необработанные продукты питания? Небось, даже рынков и ресторанов в жизни своей не видели, мхех.

Ну это плохое сравнение. Я же не говорю, что кинотеатры исчезнут. Наоборот многие фильмы вдохнут второе дыхание и можно будет пересмотреть в русском "оригинале". Просто вместо русских дублеров, озвучивающих голливудских актеров, будут оригинальные голоса актеров звучащих на русском. Нахуй мне нанимать говорящую голову, которая исказит эмоции оригинала, когда алгоритм сделает озвучку лучше?

>Наоборот многие фильмы вдохнут второе дыхание и можно будет пересмотреть в русском "оригинале". Просто вместо русских дублеров

Это не просто, ты долбоеб и несешь хуйню. Такого ближайшие 10 лет не будет. А скорей даже больше. Ты ебанько не отличающее 5 секундный слоп от полноценного продукты, твои пуки это всё равно что в 1920 году говорить, что через 2-3 года машины будут выдавать разгон 300км за 6 секунд. Просто заебал ты уже со своей безмозглой хуней.

>которая исказит эмоции оригинала, когда алгоритм сделает озвучку лучше?

Банальные еспанцы со своим ебучим "ноу?" в конце предложений будут ебаным кринжем на русском. Говорю же - ты тупой дебил, который не ценит работу локализаторов. Ты настолько тупой что даже не способен понять как это будет выглядеть с твоим языком в твоей культуре, но с их эмоциями и интонациями. Ору нах просто.

Выяснилось, что бывший инженер XAI, который украл всю кодовую базу компании и передал данные OpenAI, является гражданином Китая с паспортом, выданным Китайской Народной Республикой.

5 лет назад никто не верил, что ии может писать даже короткий рабочий код на 30-50 строк. Сейчас могут. Насал тебе на лицо

Ты умственно отсталый?

Плохие новости: там Google нашли фундаментальный баг в RAG

TL;DR: оказалось, что всеми любимый и привычный поиск на эмбеддингах может не всё и имеет серьёзный фундаментальный предел. При фиксированной размерности вектора таким подходом просто невозможно находить все релевантные документы из базы. В своей работе Google доказали это и теоретически, и экспериментально.

Полный текст: On the Theoretical Limitations of Embedding-Based Retrieval https://arxiv.org/abs/2508.21038

TL;DR: оказалось, что всеми любимый и привычный поиск на эмбеддингах может не всё и имеет серьёзный фундаментальный предел. При фиксированной размерности вектора таким подходом просто невозможно находить все релевантные документы из базы. В своей работе Google доказали это и теоретически, и экспериментально.

Полный текст: On the Theoretical Limitations of Embedding-Based Retrieval https://arxiv.org/abs/2508.21038

Руководитель Nvidia сказал, что из-за ИИ мир перейдет на четырёхдневную рабочую неделю.

Он провёл аналогию с прошлыми индустриальными революциями, которые снижали продолжительность рабочих недель — от семи до пяти дней — и предположил, что автоматизация и рост производительности позволят сделать следующий шаг.

При этом Хуанг отметил, что несмотря на меньшее количество рабочих дней, люди станут более занятыми, поскольку рутинные задачи будут выполняться машиной, а сотрудников освободит время для новых идей.

Он также указал, что многие профессии изменятся или исчезнут, но на их место придут новые, а в целом качество жизни со временем улучшится.

В завершение он вспомнил удачные пилотные проекты на четыре дня в США, Великобритании и 32‑часовую неделю в Нидерландах, которые показали рост продуктивности и снижение выгорания.

Он провёл аналогию с прошлыми индустриальными революциями, которые снижали продолжительность рабочих недель — от семи до пяти дней — и предположил, что автоматизация и рост производительности позволят сделать следующий шаг.

При этом Хуанг отметил, что несмотря на меньшее количество рабочих дней, люди станут более занятыми, поскольку рутинные задачи будут выполняться машиной, а сотрудников освободит время для новых идей.

Он также указал, что многие профессии изменятся или исчезнут, но на их место придут новые, а в целом качество жизни со временем улучшится.

В завершение он вспомнил удачные пилотные проекты на четыре дня в США, Великобритании и 32‑часовую неделю в Нидерландах, которые показали рост продуктивности и снижение выгорания.

Так может наоборот хорошо, теперь будут думать как исправить и улучшат

>из-за ИИ мир перейдет на четырёхдневную рабочую неделю

>люди станут более занятыми, поскольку рутинные задачи будут выполняться машиной, а сотрудников освободит время для новых идей

Ясно..

Вместо 5x8 часов будет 4х18 как у "творческих личностей".

кейсы применения нано-бананы

Это все было в моче-1. Вот немного настоящей бананы.

Ах, если б оно ещё работало как на этих черрипиках хотя бы 1 из 10 круток. Я бы проплатил даже. И это было бы огромным подспорьем для художки.

Но эта хуйня не работает. Ещё и глючит.

Или мне опять нужно знать какой-то особый секретный промпт, который не рассказали?

Я сделал 10 круток. 9 из них ошибки. То есть вообще никакого изображения.

Одно изображение — ну как видите.

Я не зря выбрал эту позу.

Она редко встричается с низкого ракурса. А с того ракурса, что я хочу, вообще не встречается.

Ну и нахуй мне этот генератор, если он не может сделать мне реальный кастом, а не просто микс из пятикратно переваренного кала?

>Но эта хуйня не работает. Ещё и глючит.

Она кстати еще и выдает оригинал вместо обработки, точно так же как калтекст. Очень нестабильная и бестолковая чушь. Единственный прикол с бананой - это развлекаться наебывая туповатые фильтры.

Я тебе без Хуанга скажу.

Ещё десять лет назад вменяемые футуристы сделали обоснованный прогноз:

Человеки нужны будут как дирижёры-режиссёры, или как садовники выращивающие из семени дерево.

Садовник не заботится о каждом микропроцессе, не указывает каждой ветке и листу куда расти. Он поливает, удобряет, направляет. И делали его без прицела на нейросети. Просто на «умный софт».

НО этот подход будет работать в IT и вокруг.

>многие профессии изменятся или исчезнут

НИХУЯ СЕБЕ ГЕНИЙ!

>Четырёхдневка

Её польза очевидна, когда человеку нужно что-то придумывать или сохранять высокую концентрацию. Тогда два дня плохо хватает для отдыха. Три как раз.

Но когда ты зомби на конвейере, то можешь пахать и с двумя выходными на 8 дней рабочих подряд.

Я рольнул с 5 раза, это ее хуевей чем ничего. Приклеило ноги от нижней бабы не соблюдая стиль.

Шиза какая-то. Типа 4 дня работники работать, а остальной день роботы. Как он это себе представляет?

> Она кстати еще и выдает оригинал вместо обработки

да, сейчас высрало 1ю фотку в качества «результата».

По итогу Квен хоть и туповат и слеповат, но хотя бы работает стабильно и за несколько круток или из коллажа можно нахерачить около того, что нужно.

4 подбора промпта, со второй попытки на последнем успешно вполне

а на каком сайте крутишь? У меня на aistudio.google.com Всё плохо.

кстати да, актуальная проблема. Быдло, которое не знает куда себя деть, будет просто больше бухать.