Я к чему — проще собрать свой пайплайн с виспером/гигаам + еспич/фиш/вайбвоис. Получится тоже самое, но чуть лучше везде (и распознавание будет лучше, и ллм будет лучше, и ттс лучше).

Теоретические эмоции на базе контекста обещанные — круто, но их нет, к сожалению, нихуя в русском языке.

Может быть пофиксят, а пока че-то фигня какая-то.

Пизда моим мишкам и рдшке

>Qwen3-32b с включеным и отключенным ризонингом от qwen3 30B-A3B-Thinking и 30B-A3B-Instruct

Тем что 32b плотная, а 30b-a3 - моешка, эквивалентная примерно 16b плотной?

Скрестил пальцы за тебя, братан!

Кто знает, может скоро все энтузиасты перекатятся на хуавей. Ждём полноценных тестов от хуавей-куна.

Ебать печаль тогда.. я от Qwen3-32b то не сильно в восторге.. так чисто рецепт приготовление омлета спросить и все.. хотя в целом норм модель в простых вещах, наверно проблема еще в 4bit кванте. Например типа если спросить у нее кто режиссер какой-то неводомой хуйни с бюджетом меньше миллиона она придумывает шизу, берет каких-то похожих режиссеров с того же жанра и нихуя не угадывает.. хотя какую-то популярную хуйню она правильно называет.. наверно просто малый дата сет на 32b то.. или причина в квантовании тоже может быть?

> AVX512

Он поможет прежде всего при обработке промпта на процессоре, с частичной выгрузкой не роляет.

В отличии от этого модель понимает интонации и прочие звуки, а не просто конвертирует речь в текст. Присрать ее к другой ллм - не проблема.

30а3 уникальная модель, она может ультить в одном и фейлить в другом, сложно сравнивать с плотными. А вот 3й 32б - крайне неудачный, с ним что не делай - остается припезднутым. Остальные модели в линейке нормальные, а этот резко выделяется.

Ссылка на тесты моделей с прошлого треда: https://rentry.co/z4nr8ztd

Плотные модели в том и проигрывают мое, они умные по мозгам, но реальных знаний в ты никак в 32b много не пихнешь. Другое дело - 100+ мое, эти 100+ как раз ненужными знаниями и забиты вроде кто режиссер какой хуйни. При этом по мозгам там активные эксперты будут еле-еле конкурировать с 32b.

Именно поэтому будет очень интересна какая-нибудь 20б-а180, но не Квен, Квен припизднутый

Ждём Мтстралей и Кохерек, мб Гемму 4 на 27б активных

Кто там маленькие модели для телебона пробовал, я тут скрытый гем нашел - gemma 3n e4b(хз чего её не назвали 8b-a4b, как полагается по моешной номенклатуре).

На chatterui на телефоне выдает на 4 кванте 4.5 т/с генерации, т.е. столько же как и плотная 4b gemma, при этом мозгов и знаний побольше.

На chatterui на телефоне выдает на 4 кванте 4.5 т/с генерации, т.е. столько же как и плотная 4b gemma, при этом мозгов и знаний побольше.

>какая-нибудь 20б-а180

Ты хотел сказать 180b-a20b? Потому что хз что там лоботомит с 180м активных параметров смогет.

Уже в прошлом треде выяснили что она топ в своем размере.

И даже более того, ебет местами квен 14б.

>модели для телебона

Какой же кринж боже......

Будет в шапке со следующего переката.

Молодец, хорошее сравнение.

Единственное но - для телефонов стоило использовать q4_0 или q5_0 кванты - они адаптированы под arm процессоры.

Да и так эти ми50 32г уже кончаются. Их дропнули из тайваня куда как понял был отдельный заказ на такие версии. Всякие карго их сотнями выгребают

Но квенчик решает проблему с запаянной кружкой, а гемма - нет.

Да, но это Qwen3-14B

А в своем размере, что gemma-3n-E4B что Qwen3-4B не справились.

Квен вообще вон что ответил.

https://github.com/ollama/ollama/pull/5872#issuecomment-2254873034 Хуавей кун не нужен, кое какие тесты уже утекли. Правда я так и не понял на какой карте инференс и работает ли карта в 2 чипа, если это duo версия.

Аноны, помогите начинающему дЭбилу. У меня при запуске кобольда занимается вся видеопамять, но при этом из 31 доступного гига оперативки занимается лишь 15. Как можно еще десяточку гигов оперативки добавить к мощностям? Я уже все ползунки передергал - так и не понял. ЧЯДНТ?

Модель всегда делится пополам, спроси у корп дипсика, он тебе проведёт лекцию почему это нормально.

кстати, а какое у модели разрешение в OCR? насколько она хороша в более практических вещах? Например распознавание PDF.

Очень жаль. Думал, что можно еще загрузить оперативку, что бы побыстрее было, пусть и ненамного. Эхэхэх.

Да, поэтому врам решает и тут все шизеют по этой теме.

Печаль. Полагаю нет. Гемма с 768 скорей всего делает то-же самое. Оно на табличных структурах с мелким шрифтом фейлится.

> При этом по мозгам там активные эксперты будут еле-еле конкурировать с 32b

Почему-то выходит что квенчик с "всего" 22б активных и решает сложные задачи, и может держать внимание на огромном контексте рп на недостижимом для плотных моделей в пределах 30б уровне. Она превосходит в этом ларджа, но тот старый и сравнение не честное, плюс тот имеет свои фичи.

Опять же, было бы интересно посмотреть на современные большие плотные модели, но таких как-то и не завезли, комманд-а пускает слюни и ошибается как тридцатки или хуже.

Для 8б модели как-то не сильно весело, но есть шанс что в квантах моэ будут адекватные скорости.

Парочку таких чисто ллм катать заиметь было бы хорошо.

> Например распознавание PDF

2.5вл уже есть с огромными разрешениями и справляется, вот вот вл3 выйдет, недавно в трансформерс добавили ее поддержку. Но для качественного распознавания внешняя обвязка таки понадобится, ибо сразу всю страницу с подробностями оно не схавает.

Аноны, для каких целей вы используете нейронки?

Про рп, переводы, код, обучение, классификация, редактирование текста и т.д., понятно. А вот по жизни, как еще применяете?

Перерабатываю шаблон для тестов, нужно более комплексно подойти.

Про рп, переводы, код, обучение, классификация, редактирование текста и т.д., понятно. А вот по жизни, как еще применяете?

Перерабатываю шаблон для тестов, нужно более комплексно подойти.

рп, код (дебаг, кодревью), медгемму использую иногда для вопросов здоровья, и рили неплоха (даже фотографии можно прикладывать), гопоту осс для разных вопросов общего спектра использую тоже (запромтить чтобы при каждом ответе прикладывался список источников, предпочтительно из литературы, например)

>2.5вл

да, я знаю. но вообще я хочу модель которая просто была бы чуть умней. Например для распознавания банковской информации в табличке хватает примерно 1200-1400 по широкой стороне, но ёбана~ банковская информация это ебучий ребус зачастую.

> я хочу модель которая просто была бы чуть умней

Есть на 72б, она дохуя умная. Настраивая препроцессор можешь хоть 10 мегапикселей туда закинуть, но готовь бюджет токенов. Также можно обернуть вл в функцию, которую вызывать с основной модели по запросу, квенкод может такое накодить а потом пользоваться.

А еще лучше иди ной выпрашивая моэ квенчика с визуальным восприятием, вот это было бы оче круто.

Блять, он уже умер и призраком стал.

Мультивселенная Хемлока. Ну как вот не надоело на Гемме играть с таким маленьким датасетом?

>квенчик с "всего" 22б активных и решает сложные задачи, и может держать внимание на огромном контексте рп на недостижимом для плотных моделей в пределах 30б уровне.

Ну конечно 235b с 22b активных параметров будет ставить раком плотную 30b, она по мозгам как 110b+, моешка по мозгам всегда примерно на половину от своего макс размера из-за использования наиболее подходящих экспертов.

Пропустил релизы новых микстурных квенов, хотел затестить, а на жору до сих пор не завезли саппорт. Кто-то итт тут их пробовал? Как оно?

Ты про Qwen2.5-VL-72B? Блин вот его не трогал ещё. Он вместится мне только со скрипом в q4

Да такое и я накодить могу. Более того - уже накожено. что за

>А еще лучше иди ной выпрашивая моэ квенчика с визуальным восприятием, вот это было бы оче круто.

Лол да он и так может, но чет разрешения не те. По сути я это и делаю!

У геммы как раз хороший датасет и она не слопит в отличии от мистраля, но вот с хемлоком какая то особая ситуация, это видимо какой то рофл от того кто тренировал модель.

Да нет, просто это самый вероятный токен на фэнтезийного персонажа. Так же как эльфийка Лирия.

Так там написано что "по мозгам" уступает 32б. Но так модель сложно оценивать, она раскрывается или если работает с ризонингом, или если имете возможность на условно длинный ответ. С первым понятно, а на втором модель, как в некоторых стилях повествования, добавляет уточнения или вообще исправляет явные ошибки, оборачивая их в плюс за счет иллюзии более живой речи. Так модель действительно может задействовать множество разных параметров внутри себя.

Если же требовать дать оче короткий ответ зирошотом - уступает большим плотным. Кстати, у квена весьма недефолтная конфигурация голов, у других распределены иначе.

> Лол да он и так может

Не, не может, 235 и 480 без визуального инпута. Есть только закрытые модели у них по апи с визуалом.

Аноны, можно ли как-то завести магистраль новый на кобольд + таверна с рабочим ризонингом? Как не пердолился, нихуя не выходит, и я не понимаю, в чём проблема.

Для теста использовал лм студио и в родной обёртке для неё щупал ассистента. Там всё нормально.

Как я понимаю, таверна поднасирает. Но, как ни странно, если [INST] написать и дать модели продолжить, то она поразмышляет, но не закроет блок размышлений, в отличие от квена.

Для теста использовал лм студио и в родной обёртке для неё щупал ассистента. Там всё нормально.

Как я понимаю, таверна поднасирает. Но, как ни странно, если [INST] написать и дать модели продолжить, то она поразмышляет, но не закроет блок размышлений, в отличие от квена.

Ну да, я помню на 12b немомиксе меня заебала эта Лира\Лирия.

Чем больше в оперативке - тем больше тормозов. Все наоборот, ее разгружать надо, если возможность есть. Лучше всего - когда все только в VRAM.

Нужен локальный переводчик для пары языков (английский, русский, японский и некоторые европейские) для Windows 10. Стоит ли смотреть в сторону локальных языковых моделей, или они будут не сильно лучше традиционных решений, учитывая такое слабое железо?

ЦП: Intel Core i3-7020U (2 ядра, 4 потока, 2,3 ГГц)

ГП: NVIDIA GeForce MX150 (2 ГБ)

ОЗУ: 12 ГБ

ЦП: Intel Core i3-7020U (2 ядра, 4 потока, 2,3 ГГц)

ГП: NVIDIA GeForce MX150 (2 ГБ)

ОЗУ: 12 ГБ

Ллм будут сильно лучше поскольку переводят точнее с учетом контекста и можно напрямую спросить про значение слов в предложении и правила. Но в твоем железе ничего нормального не запустить, смотри в сторону публичных апи и сервисов.

Есть же геммы для кофеварок

Чертолёт от хуавея с enterprice grade охлаждением взелает и разбивается об сайт. Тысячи менюшек, отвратительная навигация и отсутствие возможности скачать хоть что-то с сайта даже после регистрации, регистрации потребительского аккаунта, регистрации карты по серийному номеру, регистрации временной ссылки на скачивание это пиздец. Щас качаю enterprice grade утилиту для скачивания 3-х файлов с ебучего сайта хуавей.

Добро пожаловать в enterprice

Добро пожаловать в enterprice

Да чё за залупа, не скачивал ни разу, откуда блок

Вторая версия способа дуть в мишку

https://www.thingiverse.com/thing:7153218

Т.к. железо зависло в китае буду пытаться загнать k3s в lxc

https://www.thingiverse.com/thing:7153218

Т.к. железо зависло в китае буду пытаться загнать k3s в lxc

Попробуй поменять айпишник. Или поставь WARP 1111 правда хз поможет ли он на этот сайт... если это вообще не со стороны сайта проблема.

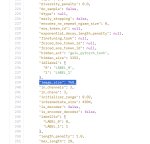

Qwen3-42B-A3B-2507-Thinking - протестил по новому шаблону.

Ну что могу сказать, это фиаско. Сделали хуйню. Особенно порадовали советы поехать в Ялту, засунуть в жопу парацетамол и шизофазия.

Модель тупая, хотя местами кажется вот-вот годное выдаст (нет, после этого она сразу обосрется).

Закинул подробные тесты в общий список.

Ну что могу сказать, это фиаско. Сделали хуйню. Особенно порадовали советы поехать в Ялту, засунуть в жопу парацетамол и шизофазия.

Модель тупая, хотя местами кажется вот-вот годное выдаст (нет, после этого она сразу обосрется).

Закинул подробные тесты в общий список.

Уже 2 впна сменил, шлёт нахуй.

> 42B-A3B

Что это блять за шизомердж-франкенштейн? А там ни разу не А3 а овер 4б активируемых, поскольку вместо экспертов "вширь" наращено количество слоев по-классике.

Результат ожидаем, удивительно было бы если оно оказалось хорошим.

> Что это блять за шизомердж-франкенштейн?

Обычный DavidAU. Тоже ахуел. Подумал, что анон ошибся, опечатался, а правда такой тюн есть.

Кому нибудь удавалось отыгрывать вот прям неплохую комедию? Чтобы карточка, модель или они вместе удивляли и попадали как надо. Расскажите как оно было если было, если поделитесь карточкой вообще круто будет. Не понимаю это я скучный или нейронки не могут в юмор.

>либо OSS

Ебать, спасибо х2. Локальный экспириенс в 500млрд раз лучше, чем облачные маняподелки.

Я тогда еще говорил, что проблема ии будет не в фундаменте, а в последней миле. Только что отхуесосил дипсика за то, что он тупорылый морон. Осс с моим чаром просто выдает мне то, что я хочу, без даунизмов.

Спасибо х3, вот прям лайф ченж произошел.

Там уж наверно у всех 5 звезд и все давно померли.

>Осс

Какои? Seed-oss 36b?

Только смехуечки в адвенчуре с шутками, хитрыми намеками-имплаями, дразнением чара до момента, когда он выламывает 4ю стену и напоминает что в это могут играть двое. Дело не в карточке, там все полагалось на модель пожирнее, историю чата и само поведение юзера. И прямо вот 100% юмора там не было, исключая черный в моментах, скорее просто ощущение что вы на одной волне и строите многоярусную словесную игру, от осознания обоюдного понимания которой оче приятно.

Но дипсик... опенсорсный... Извинись!

Если тебе интересно, то https://huggingface.co/Jinx-org/Jinx-gpt-oss-20b тоже существует. в обычном OSS пережарили вектор отказа.

Аноны могут скинуть пример своей строки для кобольда, которым они аттеншион тензоры выгружают и куда ее пихать, а то я нихуя не понял...

Легко пробивается джайлом. Зачем юзать тюн где еще и мозги вырезали вместе с рефузами?

так там и перевод от кофеварки будет

там джейлбрейк довольно поверхностный и плохо годится для длинных тематических чатов.

ояебу. охуенно~

Ага... быстро работаете, ахуеть.

Правда визуальная часть там микроскопическая и оно не будет настолько хорошо видеть и распознавать как отдельные, но бля. Кроме https://www.youtube.com/watch?v=uFIp1adVJ04 нечего добавить

а там обязательно прям с офф сайта качать? на файлообменники никто не заливал нужных файлов?

эт капец конечно, когда эксперимент нельзя даже начать...

unsloth/gpt-oss-20b-Q6_K.gguf (12гб)

Предвещая втфы - у меня главная боль не само качество/сложность ответов, а то что стандартные промпты охота с кирпича уебать. Выходит нихуя неконструктивно, даже с пятым.

Извините.

Это для рп наверное? Если да, то не, не надо, пасиб.

>unsloth/gpt-oss-20b-Q6_K.gguf (12гб)

кстати там же есть "хитрая" квантизация, не?

https://huggingface.co/unsloth/gpt-oss-20b-GGUF/tree/main

gpt-oss-20b-F16.gguf 13.8 GB

gpt-oss-20b-Q8_0.gguf 12.1 GB

буквально бессмысленно пользоваться Q6

>Это для рп наверное? Если да, то не, не надо, пасиб.

Скорей для сомнительных запросов. OSS имеет очень ужаренный вектор отказа и скатывается к отрицалову порой даже если в тексте присутствует слово "жопа". В ролеплее это просто проявляется ещё сильней. Там доходит до идиотских диалогов в духе пикрелейтеда.

Эксперименты по расцензуриванию гопоты 120B. https://huggingface.co/bartowski/huizimao_gpt-oss-120b-uncensored-bf16-GGUF

Она, конечно, промптом и так уже пробивается - нашли комбинацию, но терять до 300-400 токенов на ее рассуждения о "можно-нельзя" - надоедает...

Она, конечно, промптом и так уже пробивается - нашли комбинацию, но терять до 300-400 токенов на ее рассуждения о "можно-нельзя" - надоедает...

Я не понял чо за прикол с размерами, по привычке взял Q6. А че за хитрая квантизация? Скормил пятому ссылки на репу и статью, он убеждает что якобы разницы нет только на диске, а в враме будет. Хуйню несет наверно, как обычно. Самому лень читать.

>сомнительных запросов

У меня самый сомнительный запрос это how long cook grechku, так что. Это даже лучше, если он на мое раздражение будет сам ебло заваливать.

>расцензуриванию гопоты 120B

Она сильно лучше Llama 4 Scout?

Блять, почему у всех такой повальный фетиш на матерей? Заходишь на чаб, открываешь топ карт. Мать, мать с дочерью, мать одиночка, мать алкоголичка, мать бомжиха, мать некроморф, мёртвая мать.

Там в топе среди тянских карточек триумвират лоли/мамки/сестры. Почему? Да потому что это все три - это запрещенка. Это Россия - исключение из правил, land of the free, а на западе ебать сестер и мамок - такое же уголовное преступление как ебля детей.

>мать некроморф, мёртвая мать.

Эхо уголовных запретов на некрофилию.

Да. Эту еще не пробовал, но оригинал гопоты обходит скаута как стоячего. В прочем - его не сложно обойти. По моему впечатлению, скаут едва-едва на уровне последней мистрали, что для ее размера - фиаско.

ребят, всем привет, в треде новичок - тонкостей не знаю так что не кидайте ссаными тряпками.

вопрос - можно ли использовать локальные нейросетки для написания кода? я балуюсь созданием игр (пока что чисто для себя), рисую, придумываю, а вот кодить не умею совсем, но за год работы с Grok наклепал много интересной хуйни, но это не важно. Так вот, хотелось бы локальную нейросетку иметь для кодинга чисто.

если по пунктам, то:

1. какие модели для этого подходят?

2. какое необходимо железо для ответов уровня grok 3? (предполагаю что это тупой вопрос и понадобится дата центр ценой в истребитель, но вдруг)

3. какой пк можно собрать специально для нейросеток чтобы прям заебись было? без всяких H100 или че там щас десятки мильенов рублей стоит, но условно 2-3 RTX5090 будут иметь смысл? и по памяти тоже обьясните, важна ли сильно мощность, или вместо 5090 можно использовать например китайские 3090 перепаянные на 48гб? и как тут оперативка участвует?

может собрать условную рабочую станцию на 512гб озу с тредриппером и тремя 5090 всё таки даст возможность работать также как и в браузере с гроком?

4. если на все эти вопросы ответы положительные, то ещё вопрос, имеет ли смысл пытаться что-то развернуть на нынешнем пк? (64 гига озу 3200мгц, ш5 12600кф и 3070ti, готов под это дело купить ссд на 2тб отдельный)

5. и в общем какие нибудь отзывы от людей которые используют локальные модели для кодинга были бы очень кстати, нюансы и всё такое.

заранее спасибо

вопрос - можно ли использовать локальные нейросетки для написания кода? я балуюсь созданием игр (пока что чисто для себя), рисую, придумываю, а вот кодить не умею совсем, но за год работы с Grok наклепал много интересной хуйни, но это не важно. Так вот, хотелось бы локальную нейросетку иметь для кодинга чисто.

если по пунктам, то:

1. какие модели для этого подходят?

2. какое необходимо железо для ответов уровня grok 3? (предполагаю что это тупой вопрос и понадобится дата центр ценой в истребитель, но вдруг)

3. какой пк можно собрать специально для нейросеток чтобы прям заебись было? без всяких H100 или че там щас десятки мильенов рублей стоит, но условно 2-3 RTX5090 будут иметь смысл? и по памяти тоже обьясните, важна ли сильно мощность, или вместо 5090 можно использовать например китайские 3090 перепаянные на 48гб? и как тут оперативка участвует?

может собрать условную рабочую станцию на 512гб озу с тредриппером и тремя 5090 всё таки даст возможность работать также как и в браузере с гроком?

4. если на все эти вопросы ответы положительные, то ещё вопрос, имеет ли смысл пытаться что-то развернуть на нынешнем пк? (64 гига озу 3200мгц, ш5 12600кф и 3070ti, готов под это дело купить ссд на 2тб отдельный)

5. и в общем какие нибудь отзывы от людей которые используют локальные модели для кодинга были бы очень кстати, нюансы и всё такое.

заранее спасибо

Я не спец и в треде не часто, но код пишу. Ты как бы это, попробуй сначала чо поменьше, чем 2-3 5090 с трипером, блджад. Тебе вполне может зайти скромная модель (по меркам облаков) если нормально ее запромптишь под себя. Я вон выше анон с oss-ом, сижу седня вполне доволен.

Мнения будут разнится, но я не считаю овербольшие модели какими-то сильно лучшими - эдж на самом деле тонкий. Чуть нестандартнее задача, и они все обосрутся. А у меня много таких. Пока норм держится только пятерка, но она стоит космос.

Курсоры и прочие fim я не юзаю конечно, то есть у меня нет режима "грузишь проект и он там сам хуячит". Делаю частями, контекст для задач сам собираю.

Алсо год-два назад был вариант по аренде гпу вместо покупки, щас хз. Если бы у меня стоял вопрос 3 консумер гпу, пхы, это однозначно облако (с норм гпу). Дома это пиздец, ты вообще эту пекарню-шкаф представляешь?

>имеет ли смысл пытаться что-то развернуть на нынешнем пк?

Это надо в первую очередь сделать, чтобы начать ландшафт представлять.

Еще у меня в прошлом году на проекте был 7900х сервер, без видяхи, так на нем микстрал (26гб) высирал токены только в путь. Я аж задумался, может мне тупо проц этот купить.

>можно ли использовать локальные нейросетки для написания кода?

Для написания кода - можно. Для проектирования кода - нет. ЛЛМ понапишет тебе тонну говна, а потом сам же в этом говне и потонет. ЛЛМ это инструмент, притом реально сейчас мы скорей всего будем видеть сильный разрыв в скиллах в ближайшее время. Абсолютно бессмысленно становится джуном, так как ЛЛМ пишут код лучше джуна и при вхождении в погромирование тебе надо быть как минимум на уровне мидла, который сейчас по совместительству становится чем-то вроде "оператора ЛЛМ".

Ты либо пишешь и читаешь код ВМЕСТЕ с ЛЛМ, либо у тебя в проекте тотальный пиздец.

>какие модели для этого подходят?

На самом деле сейчас почти любые, писание кода это популярная метрика в бенчмаркинге. Меньше 30b можно не рассматривать всерьёз для этого. Да и 30b это на уровне карманной обезьяны.

Собирать под это дело конплюктор в целом бессмысленная затея. Лучше возьми Kilo Code/Cline/Roo Code, подружи их с опенроутером и пользуйся Grok Fast, или Claude 4 если готов расстаться с шекелями. Или Qwen Coder и DeepSeek 3.1 если не готов.

Ещё есть варианты с коопайлотом. Но я обычно использую Cursor.

>и в общем какие нибудь отзывы от людей которые используют локальные модели для кодинга были бы очень кстати, нюансы и всё такое.

Я использую, но только в очень ограниченном количестве сценариев. Лол например быстрей сказать "напиши мне обратное хождение по for loop в C# по этому стрингу", чем написать это вручную.

Но можешь не ожидать что ЛЛМ за тебя напишут код. Они инструмент. Если не знаешь как им пользоваться - хуйни наделаешь.

Ты потратишь время с большей пользой, если будешь использовать ЛЛМ как твоего персонального репетитора.

Это твоя лучшая опция.

Все большие модели с лёгкостью тебе расскажут как работает тот или иной язык, притом им можно как задавать конкретные вопросы, так и попросить объяснять тебе на том уровне на котором ты находишься. Если ты не знаешь нихуя, то они без вопросов объяснят что такое reference type, а что value type буквально используя эмоуты с бананами.

Понял, спасибо. Насчет репетиторства и прочего - увы, богом не дано такого склада ума, программисты которые всё это лепят сами - великие люди, мне это к сожалению не дано от слова совсем. Не могу сказать что я прям тупой, я во многих других вещах разбираюсь на уровне мидла как минимум (3д моделирование например, там пиздец своих тонкостей сколько и реально надо чтобы мозг по особенному работал чтобы в пространстве многие вещи понимать и осмысливать), но вот программирование не даётся вообще, никак. Пробовал лет в 15 вкатиться хотя бы в веб-дизайн (как он тогда назывался) но даже там посыпался.

А насчет того что нейросетки хуево напишут если не понимаешь - скажем так, логически - я понимаю что такое код, могу у себя в голове на русском языке представить как будет работать тот или иной скрипт (опять же, я это делаю только для игрушек, в серьезные дела для погромистов я не лезу), и вот как раз таки в этом условный Grok мне охуительно помогает, главное обьяснить нормально. Да, бывают затупы, например над условной процедурной генерацией уровней я пиздец сколько сидел, почти две недели часов по 12, постоянно создавая новые аккаунты и скармливая им контекст потому что багов было пиздец и грок не мог решить их за отведенное количество запросов, но всё же получилось. Так что локалку хочу для тех же самых целей, только шобы блять запросы я мог хуячить без лимита.

Ну и в 3 штуки 5090 я реально готов вложиться если это принесёт плоды, если даст возможность кодить хотя бы на близком уровне с грок 3 (не новый грок 4, а именно 3), и там потом как нибудь скармливать свой контекст, может ДООБУЧИТЬ как-то чисто для моего двигла или типа того. Короче хуй знает.

Как поживает чел, который купил хуавей?

Да, есть, я выцепил несколько файлов с ftp сервера serverflow и еще нашел несколько штук на lmdeploy для загрузки в докер контейнер. Но к сожалению мне не хавает коротких вечеров после раб отки что бы сделать все и сразу, когда то тут то там выползают проблемы на ровном месте.

>А насчет того что нейросетки хуево напишут если не понимаешь - скажем так, логически - я понимаю что такое код, могу у себя в голове на русском языке представить как будет работать тот или иной скрипт (опять же, я это делаю только для игрушек, в серьезные дела для погромистов я не лезу), и вот как раз таки в этом условный Grok мне охуительно помогает, главное обьяснить нормально.

Не, там есть много сложностей которые ты вряд-ли охватишь внутри своей головы без соответствующих знаний. ЛЛМ дадут тебе ответ в пределах твоего запроса. НЕ ДАЛЬШЕ. Там зачастую они либо ебошат код следуя каким-то паттернам, притом меняют его между своими запросами, либо просто берут код из ада и доводят его до состояния минимальной работоспособности. Они не сделают тебе архитектуру, например. Верней, сделают если ты скажешь им сделать, но без связующего звена в качестве твоих мозгов ты получишь мусор. Сейчас роль погромиста больше смещается к роли того кто проектирует проект а не пишет. То есть надо знать архитектуры, знать как применять их, знать почему ты это делаешь.

И не думай что геймдев это менее сложное погромирование. У меня например корни растут в геймдев. Погромирование в геймдеве на самом деле требует ещё больше знаний чем обычное погромирование лол, так как к нему добавляется ещё геометрия, оптимизация, ограничения движка и прочее. Просто надо меньше знать изначально, но больше потенциально.

Советую используя геймдев как рычаг вкатываться в погромирование. Там низы в целом проще. Я конечно понимаю что тебе скорей всего придётся потратить на это пол годика, а не пару недель пердолинга с гроком, но это куда лучше инвестиция времени. Но просто скрипя зубами ебош пока не станет понятно. Поднимай свои базовые знания за счёт ЛЛМ, а не замещай их. ЛЛМ могут ебошить тебе примеры кода, объяснять как он работает, почему оно написано так, синтаксис. Это охуенно и поверь куда проще чем сидеть читать документацию, гуглить ответы в интернете или сидеть смотреть на ютубе туториал на 180+ эпизодов. Пользуйся этим.

Либо так, либо никак.

И грок3 сомнительный выбор для написания кода, нахер ты им пользуешься? Qwen3-Max, или DS 3.1 справятся с кодом лучше и они не имеют лимитов.

Кодить с ЛЛМ вне IDE это самое ебанутое решение из возможных. Просто не делай этого. НЕ ДЕЛАЙ. Скачай, блять, Cline. Какой-нибудь Qwen Coder тебе в режиме агента сам полазит по всему коду, сам почитает твои файлы в проекте и сам тебе кинет диффы куда надо. Разница между тем чтобы ебошить код в чате и тем чтобы ебошить код в IDE просто огромна.

>ДООБУЧИТЬ как-то чисто для моего двигла или типа того

не на это можешь не надеяться.

Отмечу: ЛЛМ хоть и дрюкают на олимпиадах по погромированию, они пишут ОЧЕНЬ не оптимальные решения зачастую. Так как их веса забиты мусором с гитхаба и реально они пишут код ниже уровня мидла. Просто потому что это среднее арифметическое.

Например сейчас пишу солюшен эксплорер для своего проекта и мне надо санитизированный код вида namespace NekoBot.Test { public class TestTeTestAttribute<T> : System.Attribute { private object? arg; private T? ttt; public TestTeTestAttribute(T? ttt, object arg ) {} } превратить в иерархию компонентов и распарсить на строки в этой иерархии. Ну ебать, умные модели пусть и справились с задачей попытки с десятой, но наебошили просто самые ебанутые решения из возможных, где у нас хождения по трём циклам туда-сюда и попытки решить проблемы до их появления, не понимая какие проблемы надо решать, а какие можно игнорировать.

Я сел, поскрипел мозгами часик, смог родить код на смешанных флагах и состояниях, который собирает всё дерево на одном стеке, трёх интах, одном стринг билдере и линейном проходе. Притом когда я перевёл свой алгоритм в русский язык и сказал ЛЛМ как написать то что написал я - они хоть и справились лучше чем без моих инструкций, но по прежнему переусложнили и в итоге просто хуже результат.

Так что даже знание как работают алгоритмы не освобождает тебя от нужды в умении писать их самостоятельно. Примерно 20-30% пишешь сам, остальное можно доверить ЛЛМ.

Притом для сравнения ебучий грок вообще с задачей не справился. Совсем. Сука, он начинает код с разбиения его по строкам, абсолютно не понимая что C# это не питон и код не привязан к строкам.

Не могу скачать дрова и can toolkit с сайта хуавея. Поддержка пишет извините отсосите у нас техработы. В поддержке хуавея написали сорян у нас техработы, когда кончатся неизвестно, что скорее всего пиздежь отписочный. Нашел дрова на fpt serverflow, но канн тулкит пока обосрался искать. На lmdeploy нашел тоже какую-то репу для докера с файлами для хуавея, надеюсь там все что надо лежит.

>3 штуки 5090

Сначала попробуй платную апи тех моделей, которые планируешь запускать, может тебе не зайдет. 3 шт деньги не малые.

спасибо, я сохранил твой ответ на будущее, но честно говоря и половины не понял из того что ты написал)

видишь, мне грока хватает пока что потому что я условно просто 2д рогалик хуячу, и не две недели, а 4 месяца уже, и охуенных результатов достиг с нихуя скажем так (не хвастаюсь, а именно обьясняю что я не балуюсь). насчет понимания, да, что-то появилось, я понимать начал как некоторые вещи устроены, где-то сам уже могу что-то подшаманить какие то значения поменять c int на bool там и так далее, большее увы не выходит, хотя понимание того как это логически должно выглядеть - есть (повторюсь, я делаю 2д хуйнюшку на gdscript, а не на плюсах свой движок пишу).

вкатываться в погромирование конкретно сейчас увы возможности нету, эти полгодика мне что-то надо кушать, так что позже я конечно попробую, но пока что увы придется гроком ограничиться, потому что как я тут почитал, на 3070ti смысла нет запускать что либо в надежде что оно мне лучше чем грок напишет и ещё и лимиты обойдет.

Что-то больше половины чисто текстовых тестов просели. Где перенос знаний между доменами? Опять хреново тренировали.

>Я не понял чо за прикол с размерами

Из раза в раз... Гопота уже квантована до 4 бит, с релиза. Смысла квантовать оставшиеся 16 битные слои в принципе нету.

>мать с дочерью

Ебут там дочь.

>Это Россия - исключение из правил, land of the free, а на западе ебать сестер и мамок - такое же уголовное преступление как ебля детей

Хоть в России и нет прямой ответственности за мамкоеблю, но она нихуя не поощряется и не распространена.

>но условно 2-3 RTX5090 будут иметь смысл?

>3 штуки 5090

За их цену берётся одна RTX 6000 PRO если что.

> За их цену берётся одна RTX 6000 PRO если что.

Прошка 1кк, 3х 5090 750к. В цену прошки влезают 4х 5090

> Где перенос знаний между доменами?

Перенос не может компенсировать то количество параметров что вырезали под VL

> Опять хреново тренировали.

Диван диваныч...

На гемме (А конкретнее синтии) получилась прям годнота. В наличии магическая академия, огромный пирог который гоняется за героем щелкая вафельными челюстями и оставляя след от хлебных крошек за собой. Всё это приправлено недоумеваем окружающих.

Я вообще понимаю геммолюбов, да датасет маленький, но у гугла получилась на удивление чуткая модель на намеки, а шизомерж Синтия еще и приправлен таким нейтрально негативным биасом.

Распробовав Air, теперь любое РП начинается с пары мистралевских полотен, потом скармливаешь это Air и ждешь, потому что эйр ну вообще не желает двигать нарратив, как ты его не пинай.

Те кто выросли с сестрами испытвают повальное недоумение. То ли дело - мама друга или сестра. Вот это другой коленкор. Но свои? Чёт как то фу.

>Россия - исключение из правил, land of the free, а на западе ебать сестер и мамок - такое же уголовное преступление

Сначала думал, что это рофл и нельзя в брак вступать. Но нет, там буквально законы против совокупления по 1 и второй кровным линиям.

Хоспаде, почему священным европейцам нужно принимать законы чтобы они не ебали своих прямых родственников. Как то не задумывался о таких культурных различиях. Лол.

Теперь количество этих карточек имеет смысл.

Кстати ебать у них там демо. Буквально та хуйня от OpenAI где ГПТ ходил по браузеру и кнопки жал.

>спасибо, я сохранил твой ответ на будущее, но честно говоря и половины не понял из того что ты написал)

Ну ебать. Открой https://chat.qwen.ai/ выбери сверху Qwen3-Max, скопируй туда нить беседы и напиши в начале что-то вроде "Здраствуй квен~ Перед тобой кусок общения на дваче. Твоя задача объяснить нюансы, включая технические детали. Попытайся объяснить их максимально просто, но доходчиво.".

>видишь, мне грока хватает пока что потому что я условно просто 2д рогалик хуячу, и не две недели, а 4 месяца уже, и охуенных результатов достиг с нихуя скажем так

Пффф~ 4 месяца~ Капля в море. Буду реалистом - если за 4 месяца ты уделил время графонию, а не функциональщине, то ты в начале пути. Всё что ты сделал это размазал сет скиллов. И ты две недели выпытывал из грока генератор подземелий, которые мог потратить на то чтобы просить грока научить тебя делать генератор подземелий.

Оптимистично если ты собрался быть человеком-оркестром могущим и код и графоний. Рассчитывай на 2-3 года минимум.

>понимание того как это логически должно выглядеть - есть

Оптимист если думаешь что этого хватит. Ну и? Понадобится тебе добавить фичу. Понесёшь это ЛЛМ и напишешь "хочу от это". Ну и что ебать? Оно ебёт как ты хочешь этого достигнуть? Оно побежит ебошить тебе библиотеки, методы и прочий мусор. Возможно продвинет твой проект дальше. Пару раз может и прокатит, но потом у тебя будет вызов функционального кода через 5 методов-заглушек, классы где 90% ничего не делает, или является дубликатами функционала, разные куски кода которые дружат через дюжину интерфейсов, хотя делают одно и то-же и прочее-прочее.

И одно дело когда такую хуиту напишет новичок - он хоть может проявить обучаемость. Но ты просто понесёшь это к ЛЛМ и будешь говорить "почини". В итоге оно может и починит, выкинув 90% говна, вместе с кусками кода которые тебе были нужны. И снова придётся две недели пытать грока чтобы реимпелементировать фичи.

Это путь вникуда.

>не хвастаюсь, а именно обьясняю что я не балуюсь

Лол, не хочу тебя расстраивать, но 2 недели по 12 часов выпытывать код из грока3 иначе не назвать~

Что уж, можешь и похвастаться своими достижениями пытания грока. Я вот покажу тебе своё баловство.

>повторюсь, я делаю 2д хуйнюшку на gdscript, а не на плюсах свой движок пишу

Да одна хуйня. Просто одно требует больше времени чем другое. А потом на gdscript полезешь в теорию графов, шейдоры, векторную алгебру и прочую хуйню, нужную в геймдеве. Какая разница?

>вкатываться в погромирование конкретно сейчас увы возможности нету, эти полгодика мне что-то надо кушать

Две недели по 12 часов же ты нашел время долбить грока, чтобы выпытать из него кусок кода в котором происходит черная магия.

Алсо лол. Ну ты и оптимист - быть гейдевелопером и кушать.

>Кодить с ЛЛМ вне IDE это самое ебанутое решение из возможных. Просто не делай этого. НЕ ДЕЛАЙ.

Заявляю, что это как раз путь в вечного джуна, потому что в этом нулевой фрикшен нихуя не деланья. Это аналог игровых автоматов. Кидаешь сбп, жмешь реролл, а если не получилось, то получится завтра. Это тебе можно не делай, и то думаю лишь какое-то время, потом деградируешь. А ему нельзя. Эмсипи это ганжубас для кодера.

Да возьми подписку 20$ гопоты она тебе как агент будет все что нужно делать. Ну соберешь ты сборку, всё равно говно будет... тут собирают что-то мощное больше для души..

>1. какие модели для этого подходят?

Аноны изьебываются юзают даже мелкие модели но больше как тулзу помощника, в качестве агента они жрут дохуя контекста и что-то крупное маштабное она пук-среньк сделает в свое шизе.

>2. какое необходимо железо для ответов уровня grok 3?

Grok 3: AI's new beast with 2.7 trillion parameters.

Ну аноны изьебываются юзают мое модели, они могут быть умны как корпо-модели и тупы одновременно как локалка в чем-то конкретном. Но железо надо, да.

>3. какой пк можно собрать специально для нейросеток чтобы прям заебись было?

Да все от бюджета зависит, на десктопе ты только баловаться можешь.

>может собрать условную рабочую станцию на 512гб озу с тредриппером и тремя 5090

Одной 5090 достаточно, ну либо какого-то мутанта с перепаенной врам как ты писал что бы хотя бы контекст выгружать в врам т.к врам самое быстрое, остальное в озу, но и озу желательно DDR5 а не говно ддр4 с говно частотами.. Выгружать часть модели в SSD можно, но это будет вообще печаль ибо врам>рам>ssd, ну и ssd надо хороший m2 с высокими параметрами чтения.

Двачую на все сто: ллмку нужно использовать для кодревью/дебагинга/рефакторинга с комментариями или как интерактивный справочник-учителя. Так гораздо лучше в долгую, сам научишься всему.

>Хоть в России и нет прямой ответственности за мамкоеблю, но она нихуя не поощряется и не распространена.

Потому и не распространена, что не запрещена. Запретный плод сладок и порождает влечение к самому факту нарушения запрета - "раз запрещают, значит это что-то стоящее". С лолями то же самое, до их запрета в 70-80(а в России в 90е) никто даже не пытался какой-то там скрытый культ из этого фетиша создавать, были там одиночные эксцессы какие-то, но и только, почти всем малолетки были неинтересны, что с нее взять - тупая и фигуры нет. А сейчас - чем больше растет педошиза, тем больше на чубе ебут карточки лолей, причем в основном люди, которых такое в нормальных условиях бы не привлекало.

>Гопота уже квантована до 4 бит, с релиза. Смысла квантовать оставшиеся 16 битные слои в принципе нету.

Да я не в теме уже год, чо качать-то в итоге? Answer with a specific gguf model name, don't explain anything. Consider this repo as a reference: https://huggingface.co/unsloth/gpt-oss-20b-GGUF/tree/main

>Это аналог игровых автоматов.

Лол отличное сравнение!

>Это тебе можно не делай, и то думаю лишь какое-то время, потом деградируешь.

Лол к счастью у меня аутизм перфекционизм головного мозга. Если я вижу что в коде насрано - я иду и исправляю это. Пока ЛЛМ не начнут тренировать на божественном коде - они не начнут его писать. Весь прогресс за последнее время которое с этим связан он больше отталкивается от того что ЛЛМ стали пользуясь инструментами лучше себя корректировать. Они по прежнему пишут срань. Например сейчас сижу пишу критический кусок проекта руками потому что даже после объяснения что я хочу ЛЛМ просто не могут написать это то как надо мне.

Вообще у меня есть один друг. Он вайбкодит и я вайбкодю. Разница в том что у меня есть бэкграунд связанный с погромированием, а у него с администрированием.

В итоге путь моего проекта: 3 итерации с полным рефакторингом в течении пары недель, я каждый раз грохал проект, пока не понял как лучше организовать его архитектуру. В итоге я сел и руками написал ядро проекта, минималистично, просто, оптимально, следуя всем канонам KISS и DRY. Все части проекта изолированы друг от друга, все части повторяющиеся, модульные, инкапсулированные. Я могу дать ЛЛМ кусок проекта и работать с ним как с мини-проектом. Запаса прочности хватает на любую мою хотелку, минимальные технические долги, ебическая модульность. Когда хочу поработать с какой-то частью я просто кидаю в курсоре папку в чат и пишу "вот тут Х, почитай чтобы заполнить свой контекст пониманием проекта", "а теперь поработаем над фичей ХХХ. Я хочу чтобы ты сделал УУУ, следуй идее ЙЙЙ".

ЛЛМ читает, пишет, минимальное использование контекста, зачастую 32-64к хватает. Хотя проект на десятки тысяч строк уже.

Путь друга: вайбкод-максер. Он там через три пизды пишет проект пользуясь подходом когда первой пишется документация, а потом вокруг неё проект. Он каждый раз даёт ЛЛМ документацию и пиздит палками если оно не следует документации. Проект держится на ебическом количестве юнит-тестов и является монолитом. У него там ебать в процессе целый консилиум из ЛЛМ, которые друг за другом следят и смотрят не пишет ли кто-то из них хуйню. В итоге да, ебать, с таким подходом весь этот зоопарк действительно не даёт проекту развалится. Фичи правда вводятся рандомное время и баги иногда залатываются тоже рандомное время, но это детали.

unsloth/gpt-oss-20b-GGUF 😊

Чел, если ты не понял - тут просто гейткипят, не хотят других вайбкодеров. Просто бери и делай, то что хочешь, наплюй на всех.

Я тогда еще выдвигал идею, что надо не автоматический агент пилить, а кента сидящего рядом с кофейком и поглядывающего на код. Например ты пишешь открыть файл, а в соседней панели просто случается истерика, что ты не указал utf-8, и вообще это колбэк голый, а если файла нет, че думаешь будет, умник? Чтобы он смотрел, что ты делаешь и подсказывал, сниппеты выдавал, помогал по контексту поставить аргументы/опции и прочее. В панели есть быстрые команды - прошерстить весь проект, чекнуть только этот файл, или только изменения с последнего коммита, или сформулировать что ты щас делал (чтобы например пойти пожрать, а потом быстро вернуться в контекст). Вот такое все практичное, как будто синьору нехуй делать седня, и он тебя микрит и отвечает на твои "так пральна, так намана?". А не это вот, которое чо-то там перепердролит по всему коду по одной кнопке.

🔁

Привет, Аноны. не гоните тряпками пожалуйста, но не могу я находиться в чатбот треде, там какие то тупые люди блять.

Спрошу здесь, ибо здесь люди шарят.

Что с квеном блять? Вчера была еще превьюшная версия qwen 3, отвечала за 10 секунд огромным постом.

Сегодня зашел, вижу qwen 3 max, релизнутый. думаю о нихуя, лучше стал наверно.

В итоге жду ответа полторы минуты, и писать он стал как то по мертвому нахуй, не так как вчера. Что они с ним сделали, суки?

Спрошу здесь, ибо здесь люди шарят.

Что с квеном блять? Вчера была еще превьюшная версия qwen 3, отвечала за 10 секунд огромным постом.

Сегодня зашел, вижу qwen 3 max, релизнутый. думаю о нихуя, лучше стал наверно.

В итоге жду ответа полторы минуты, и писать он стал как то по мертвому нахуй, не так как вчера. Что они с ним сделали, суки?

😊 unsloth/gpt-oss-20b-GGUF

Надеюсь, это помогло. Если хочешь, могу переставить ещё раз, не стесняйся обращаться!

Можно бесконечно смотреть на 3 вещи- огонь, воду, и страдание корпоблядков, когда у них отбирают модели.

не то чтоб я дохуя корпоблядь, я ллм также запускаю. кстати уже починилось)

Лол, ему норм хоть?

Вообще судя по обычному доиишному программированию, оно всегда имело тенденцию к метапрограммированию, а потом к программированию метапрограммирования, пока кто-то не догадается свернуть это в платформу или фреймворк, где можно хоть кое-что захардкодить и остановить безумие.

Рано или поздно он придет к тому, что система документации и промптинг консилиума станут технически сложнее самого проекта. Я уже вижу в будущем этот новый виток вайб-безумия, где ты будешь скачивать очередной фреймворк консилиум-оркестрации на биполярных акторах с инверсией времени и арендовать часы гпу для его инициализации.

Пиздец нам.

Блять там у видеотреда уже ван 2.5 с 10 сек генерацией и звуками на горизонте, буквально уже доступен онлайн, месяцок и на локалки завезут, а у нас хуй без соли я щас ебнуть с голодухи сука

Все эти квены хуены глмы переливание из пустого в порожнее, бенчмаксинг и хуйня, никак это не чувствуется на практике, могли бы и на моделях годовой давности тоже самое гонять не ущемились бы, никакого реального прогресса

Да похуй, и так работает 🙃

Это ж суть вайба

твой любимый нюня говорил, что скачок в сравнении с 32 плотненькими маленький, а ты не верил... ну слава богам перестанешь семенить про квен и эир

>Рано или поздно он придет к тому, что система документации и промптинг консилиума станут технически сложнее самого проекта.

Давно так. Точнее, мелкая программа на 3 строчки деплоится в контейнерах и использует браузер (дохуя сложная штука), ОС (тоже сложная, но проще браузера, лол) и кучу других инструментов.

>10 сек генерацией

Всё ещё издевательство над здравым смыслом.

Мистраль ларж 2407 топ.

>2407

Кстати, меня одного смущает сокращение года до двух цифр? Часто встречаю, на арксиве тоже самое. Вроде в 2000 году уже проходили этот квест, но какие-то долбоёбы решили пройти его ещё раз.

4 месяца БЕЗ учета графония и прочего. мне по сути чтобы всё воедино собрать осталось добавить звуки и музыку, и закончить наконец добавлять всякие мелкие приколюхи которые перед сном приходят мне в голову. а все механики которые я хотел основные, уже готовы.

рад слышать. так и делаю, на всякий лишь решил уточнить как можно бы улучшить этот процесс

В общем, я нашел какой gpt-oss-20b-GGUF правильно скачивать, там все просто оказалось.

Bump

> Что-то больше половины чисто текстовых тестов просели. Где перенос знаний между доменами? Опять хреново тренировали.

А омни модель видел?

Это типично для современных мультимодалок — текстовая часть проседает.

Потому что это не полноценные мультимодалки, а через проектор, доучивается две части друг на друга и теряют базу.

Пока в опенсорс обученные сразу на разных доменах просто нет, к сожалению.

Ебать, 4 часа моей жизни ушло на общение с поддержкой хуавея в России, в Китае, общение с продаваном, который продал мне эту карту, общение с ИП, через которого китаец продавал этот хуавей. По итогу я нашёл другого продавца этих карт и получил от него нужный мне фирмварь, дрова и тулкит для запуска карты на компе, умоляя поделится файликами. По итогу я скачал эти ебаные дрова с тулкитами и надеюсь, что вечером на меня не упадёт с неба метеорит, т.к. карта лежит без дела уже полторы недели зря.

Проклинаю техподдержку хуавея, посылаю им лучи говна блять. Если кто-то купит эту карту и захочет получить на неё драйвера, крепитесь.

Проклинаю техподдержку хуавея, посылаю им лучи говна блять. Если кто-то купит эту карту и захочет получить на неё драйвера, крепитесь.

Так может ты их зальешь на файлообменник, или там под страхом смерти запретили делиться?

Ну собственно на это и намекаю. А меня ещё диванным называют ((

Через 3 года заживём!

https://habr.com/ru/companies/bothub/news/949790/

>может ты их зальёшь на файлообменник

А сейчас это кому-то из анонов кроме меня надо? Хуавей вообще странная компания, почему-то не делится своими открытыми драйверами под апаче лицензией с простыми смертными. Может если я выложу, то за мной придёт китайская гэбня и сделает из меня лаовая в кисло-сладком соусе, хз.

>заживём

Гойды с братьями по нефритовому стержню не предвидится.

Тогда на всякий случай, будь добр, не теряйся! =)

>А сейчас это кому-то из анонов кроме меня надо?

Интернет будет благодарен посмертно.

Само собой, это будет не гойда, а избиение лежачего.

Милфоебы и пикрел. Ударь канничкой по засилью старух и мамоебов! Или просто alltogether https://chub.ai/characters/hugo2324/fuyu-523c716eb71b

Нужно. Начни с квенкодера 30а3 и апгрейда видеокарты, там уже освоишься и сам поймешь.

> но условно 2-3 RTX5090 будут иметь смысл?

Да, но если добавишь к ним еще 64-96 гигов врама такими же или другими. Это именно идеальный случай, тогда получится катать квен235 в 30+ токенами даже на самых больших контекстах (а то и 50+ на малых) и использовать его в квенкоде, клайне, чем угодно. В целом 96 гигов с трех 5090 хватит на модели поменьше и те тоже могут быть хороши. Дальше идут компромиссы со скоростью и т.д.

Затраты посчитать можешь сам, апи гораздо дешевле, потому нужно иметь конкретный повод для покупки железок хочу тоже подойдет.

Про запуск сам почитаешь или тебе уже подсказали, в идеальных кейсах врам онли, с компромиссами - врам и рам. Трипак на помойку, эпик и быстрее и дешевле.

> За их цену берётся одна RTX 6000 PRO если что.

Не берется, она дороже. Для домашнего инфиренса пачка 5090 предпочтительнее тем, что может быть куплена постепенно, дешевле, сможешь генерить видосы или картинки буквально в 3 раза быстрее. Про 6к она нужна если что-то тренируешь или экспериментируешь, однако серьезная проблема в том что вычислительной мощности одной слишком мало для чего-то серьезного.

> Где перенос знаний между доменами?

Только засчет него все и работает. Это просто дотрененный квен с вл проектором, уже хорошо что есть. И по результатам там все оче даже прилично.

Там ничего не вырезали, вл часть мелкая добавлена сверху.

> Если я вижу что в коде насрано - я иду и исправляю это. Пока ЛЛМ не начнут тренировать на божественном коде - они не начнут его писать.

Как раз они склонны причесывать и исправлять код, параллельно указывая на полезные оптимизации и подводные камни.

> путь моего проекта

> Путь друга

У него как-то повеселее, лол.

Наркоман? Током ебнуть?

Какой-то шизокоупинг

Анончик, успехов тебе. Не поленись выложить эти файлы куда-нибудь, в треде есть достаточно заинтересованных в потенциальной покупке и со временем может кто-то еще разживется.

Лимиты может закончились? Типа дохуя генеришь... надо типа покупать подписку и тд. т.е терпеть пока опять дадут лимиты

Какой же эир сука ебаная проклятая

Я уже персов расставил как надо и все намеки дал, а эта сука все равно не хочет сюжет двигать и дрочит меня

Я уже персов расставил как надо и все намеки дал, а эта сука все равно не хочет сюжет двигать и дрочит меня

Скилл ишью. Терпи

Подскажи плз а что бы magic translation запускать в таверне под него надо отдельно модель до 4b запускать, например на такой же моделе на которой идет РП - не получится что бы оно еще и переводило?

https://rentry.co/magic-translation

>Только засчет него все и работает.

Не. Перенос это когда знания картинок бустят текст (и наоборот). А в тестах рост на грани погрешности (впрочем и падение часто тоже).

>Как раз они склонны причесывать и исправлять код

Особенно радует, когда это нахрен не нужно. Я так раз восемь отвечал "Давай" на предложения гопоты улучшить, а он всё предлагал и предлагал улучшения (код правда изначально не работал, и оптимизации его не починили, но кому какое дело?). Можно было бы и дальше, но мне по делу надо было.

>не получится

Получится. Но пересчёты контекста тебя заебут.

Покажи колени.

Смотри.

На них логи как эир ахуенно и креативно двигает сюжет, придерживаясь карточки. Чудная моделька

>Получится. Но пересчёты контекста тебя заебут.

А.... оно будет выпускать контекст из ума и каждый раз перечитывать каждое новое сообщение? Слу а какую тогда отдельно модель запустить посоветуешь? Какие там самый ахуенный перевод дают с англюсика на руссик?

>в треде есть достаточно заинтересованных в потенциальной покупке и со временем может кто-то еще разживется.

Мне кажется после тестов энтузиастов поубавится, а я останусь единственным примером зря потраченных деняк, ибо по тем немногим бенчмаркам, которые я видел карта не особо обгоняет инференс на cpu. Если этот cpu какой-нибудь младший epyc 8004 серии на ddr5 в 4-х канале, что кстати превышает стоимость карты как в рублях так и в ваттах на терафлоп

>Слу а какую тогда отдельно модель запустить посоветуешь?

Wet Ware выучи блядь английский короче.

Да я знаю.. просто привык последнее время к руссику и надо видимо отвыкать, еще и модель хуйня лупится дает хороший руссик до 12к контекста а дальше все больше и больше пропускает какие-то буквы/вставляет вместо буквы ч славянскую с(с черточкой сверху) короче нахуй да... костыль на костыле везде..

> Не. Перенос это когда знания картинок бустят текст (и наоборот).

Это шизофантации аги-шизиков, которые лелеяли их еще пару лет назад, до сих пор не понимая как работают модели.

> Особенно радует, когда это нахрен не нужно.

Они должны выполнять поставленную задачу. То что у тебя шизила гопота - похоже на мини лоботомита что дают на фришном чате, или в промпте меганасрано.

> Но пересчёты контекста тебя заебут.

> А.... оно будет выпускать контекст из ума и каждый раз перечитывать каждое новое сообщение?

Если дать дополнительный запрос в конце, в котором будет приказано просто перевести пост на нужный язык - все сработает, контекст не пересчитается и дополнительная модель не потребуется. Можно реализовать единым промптом, можно через костыль степсинкинг, можно модифицировать костыли таверны.

Если пара таких будет давать условные 20 токенов на 235 квене - выбор чемпионов, шикарный вариант "ллм асика", который можно держать чисто под это и пользоваться когда захочешь, без необходимости разгружать видеокарты и проц.

Да и со временем цена на них может упасть, окажутся альтернативой теслам.

>Это шизофантации аги-шизиков

Лол.

>до сих пор не понимая как работают модели

Ну ка, расскажи, как оно на самом деле.

>похоже на мини лоботомита что дают на фришном чате, или в промпте меганасрано

При исчерпании лимита норм модели перехожу на другой аккаунт (осталось со времён 20 баксов, если кто помнит), а в промпте пусто, инструкции отключены, и только чат влияет на него.

>Если пара таких будут давать 20 токенов на 235 квене

Тут непонятно. Больше всего удручает отсутствие тестов. Я буквально видел только запуск лламы 8B в FP16 и GPT-2. И на ламе 8 скорость генерации была ну что-то около 15 токенов. Хотя вопрос оптимизаций на разных платформах типа llama.cpp\ollama\lmdeploy и квантования открыт.

>например на такой же моделе на которой идет РП - не получится что бы оно еще и переводило?

Делай системный промпт на русском и в нем же требуй ответом на русском. И сам пиши на русском. В итоге переводчик не нужен. Правда для такого фокуса нужны либо большие модели, либо тюны Сайги от здешних анонов, либо Гемма или Мистраль 3.2.

Если хочешь именно встроенный перевочик, то нужна отдельная видеокарта под него (не рассматриваем вариант карт с гигантским количеством ВРАМ). Модель-переводчик найти можно, можно добиться результата лучше Яндекс-переводчика. Но перевод будет не за секунду.

Да да я так и делаю. Просто мой предел 32b модели, мистраль 24b хороша в РП не такая ебанутая как квен, всегда с ней как с братишкой общаюсь но со временем у нее начинаются плавиться мозги и пишет хуево уныло а по началу то такая живая активная модель, после 12к контекста только суммарайз и я закидываю суммарай в лор бук с пометкой синего кружка что бы оно всегда смотрела на лор бук, более менее получается спасать душу лорбуком если самому какие-то детали еще дополнять которые не вошли в суммарайз.

>Делай системный промпт на русском

ААа.. подожди.. или полностью на русском надо? Потому что у меня там просто Write in Russian и do not write for yuzer и тд. ?

>Я уже персов расставил как надо и все намеки дал, а эта сука все равно не хочет сюжет двигать и дрочит меня

>Скилл ишью. Терпи

А у меня другая проблема - персы только трындят, а вот нарратива, описывающего обстановку, прям мизер, и то сухо.

Как бы скомандовать чтобы описывало действия и окружения, а не только пиздели?

>Как бы скомандовать чтобы описывало действия и окружения

Написать в промпт Описывай детали и окружающую обстановку?(я хз я эир не трогал ни разу)

> нужна отдельная видеокарта под него

Нафига, норкоман?

Ставь на отдельный порт на проце gemma 3n 4e - для этого размера переводит прекрасно.

> Лол

Не, наблюдать за этим смешно только первые несколько раз, потом ахуеваешь с поехавших.

> Ну ка, расскажи, как оно на самом деле.

Похоже на байт на срач от агишизика, и описанный "опыт" с гопотой дает понять твой уровень. Может я и ошибаюсь, если так хочешь обсудить - сначала сам "расскажи".

Карточки не так давно попали на рынок. Скорее всего в китайском сегменте уже полно инфы, но до нас не сильно доходит. Может постепенно и оптимизируют, и станет понятно на что рассчитывать, и цены упадут, так что не стоит унывать.

> llama.cpp\ollama

Нет смысла их разделять.

По тестам у китайцев та же GPT-OSS-120B отрабатывает примерно на 32 токена\с на 4к токенов и падает до 27 при 8к токенов контекста. Однако при попытке зайти на сайт и посмотреть как братья по нефритовому стержню работают с CANN я вижу, что у меня аякс мерзавец обучение на месте удар!

Ну ты сука.

Я щас так глаза закатил когда эир опять назвал тётю сестрой, 5 квант, ты, блядь.

Почему квен во 2 себе таких ошибок не позволяет, мм?!

грозно топнул ножкой на весь тред

Я щас так глаза закатил когда эир опять назвал тётю сестрой, 5 квант, ты, блядь.

Почему квен во 2 себе таких ошибок не позволяет, мм?!

грозно топнул ножкой на весь тред

Не грусти. Недавно было что дипсик примерно в 30% свайпов сваливался с рассказа о событиях на какой-то придуманный бред. Правда там кейс прямо капитально сложный и, возможно, чар так врал приукрашивая наши заслуги и производя впечатление на неписей, но учитывая что он в целом любит упускать и придумывать - маловероятно.

>дипсик

новый 3.1-чат хорош, и вообще почти не шизит

Он родимый. Он не шизит, просто склонен к такому, часто вместо того чтобы обращаться к прошлому ленится и начинает придумывать дефолт. Но этот минус или скорее особенность позволяет ему преодолевать некоторые моменты, где зарывается квен, пытаясь слишком уж фанатично натянуть новое под уже имеющийся наратив. Кстати, похожим образом и даже более выражено себя ведет квенкодер, возможно надрочка сказывается.

>топнул ножкой

Укусил пятку и хихикая убежал.

>

>и описанный "опыт" с гопотой дает понять твой уровень

Он даёт понять уровень гопоты, я то тут причём. Ах да, с аргументами "нитот промпт" идёшь нахуй.

>Может я и ошибаюсь, если так хочешь обсудить - сначала сам "расскажи".

Рассказать архитектуру трансформера, или что?

привет, я даже не вкатывающийся, а пока что вчитывающийся. на хабре почитал про дешёвые платки cmp 40hx и cmp 50hx для бомжатского инференса. кто тестил? 8 и 10 гиг? есть разница?

>cmp 50hx

Максимальный объём памяти10 Гб

Пропускная способность памяти560.0 Гб/с

И что это такое? Это сколько таких надо в риг натыкать? Ладно еще mi50 копеечные по 32 гигов а это то что? Это типа сервер на них собрать?

Экономим пространство, ведь пробел это тоже символ.

> с аргументами "нитот промпт" идёшь нахуй

Не, ты там побудешь в гордом одиночестве. Очевидно же что мартышка и очки, гопота тупая и фейлит, но не настолько как описываешь.

> Рассказать архитектуру трансформера

Да, интересно.

Ну чё утка, как сам? Узнал что такое квантование? Через годик глядишь разберёшься как семплеры работают, через два как оффлоадить моешек

Начал снова дрочить мишки. Завёл докер в lxc и сразу прикол.

rocm/device-metrics-exporter и так мало чего выдавал, но с v1.3.1 даже температура 0, последняя нормальная версия для gfx906 это v1.3.0

rocm/device-metrics-exporter и так мало чего выдавал, но с v1.3.1 даже температура 0, последняя нормальная версия для gfx906 это v1.3.0

>Очевидно же что мартышка и очки

Вот я прошу написать какой-то код с требованиями по эффективности. Гопота пишет, но забивает хуй на требования, а в конце пишет "Я могу сделать лучше, сделать?". И далее просто серия моих "Давай". Вот что я сделал не так? Ну кроме использования гопоты 5 вместо клода или жемини.

>Да, интересно.

Вот одной картинкой. Блоки по середине с суммированием кстати показывают остаточные соединения, как я теперь понял.

Конечно.

Был конкретный вопрос - в чем выражается разница между квантами для текстовой генерации.

И ты не ответил не потому что такой мамкин гейткиппер, а потому что не знаешь нихуя.

А я таки потратил несколько вечеров, чтобы разобраться. Ведь задача не тривиальна. Мне же нужно перед глазами, чтобы пощупать.

Немного поебавшись я пошел через матрицы и повторение π, как постоянной, а значит имеющей четкую последовательность. Потом выбираем жесткий энкодинг и прогоняем повторюшку, для теста. Потом начинаем обрезать по ближайшим парам, потом через две. Можно через TOP-P но я так и не понимаю, как он выбирает общность (ядро, группу, как хотите называйте). Почему он числу 3 ставит вероятность ниже чем пяти. Как так то блять. Ну и короче- так несколько десятков раз. А потом все это скармливаю корпосетке пусть проценты считает и не выебывается.

Крч, на гемме Q6-Q4 разница настолько минимальна, что я её не чувствовал. Проеб идет в 20ых числах после знака. И то, если составлять таблицу с тем что втсавляет и должно быть (обычно разбежка на +/- 1, тут может быть шум от семлирования). Просто жадный энкодинг не показателее.

А вот на мистрали я наконец это увидел. Я прям почувствоал проблемы квантования, вот они отклонения в первой десятке в абсолютно рандомных пределах.

Просто эталонный пердолинг без цели и смысла и через жопу, но сколь он мне дорог.

А сейчас я сижу и перевожу через хук новелки и яростно наяриваю на анимешных девочек.

IN DA SHUFFLE

kimi no soba ni irareru koto o

itsumo kamisama ni gansha desu

Крч, покормил тебя хуесоса. Чмафк в щечку.

мисс реф

Что-то не понимаю. В Таверне предусмотрено, чтобы модель могла картинки принимать? А то я жпг отправляю и она нихуя не видит. Я точно все правильно подключил (mmproj файлик на месте) и за пределами таверны вижн работает (тестировал в чатиках типа веб-интерфейса убабуги). Я где-то проебался с настройками в ST?

Vision работает только в режиме Chat Completion, нужно там еще в семплерах разрешить кушать картинки.

Видеорелейтед https://www.youtube.com/watch?v=8IbymWjlNhM

Чтобы объяснить что конкретно ты делаешь не так - нужно показать на конкретном примере, почти наверняка там неудачные формулировки и что-то надмозговое.

> а в конце пишет "Я могу сделать лучше, сделать?"

Это задроченный шаблон с их дефолтным промптом в чате, он сопровождает каждый ответ даже когда не нужно. Своим "давай" без уточнений ты газлайтишь сетку, накапливая в ней непонятки из-за отсутствия конкретного запроса и преумножения неопределенностей.

> Вот одной картинкой

Выглядит страшно из-за неорганизованной лапши, а ведь в коде оно достаточно лаконично. Как это относится к тем идеям?

Что за безумный поток сознания? Метрик для квантов хватает, зачем нужно вот это вот?

Ну а в целом тут хорошо все:

Не понятно что и как конкретно измерялось

Неясен повод использовать какой-то суперузкий и странный критерий для оценки качества

Использование семплеров вместе с жадным энкодингом

Жадный энкодинг в задачах оценки квантов - глупость, квант-лоботомит может получить большую оценку чем нормальный с учетом узости тестируемого

"Подсчитывать" нейронкой проценты - безумие

мимо тоже тебя покормил

>"Подсчитывать" нейронкой проценты - безумие

Это было вишенкой на торте его шитпоста. Это ж Утка. Потихоньку разьёбывался с каждого последующего предложения, на подсчёте процентов вымер окончательно. Наброс умных словечек и терминов которые он нихуя не понимает. А можно было втупую скачать несколько разных квантов одной модели и сравнить... И сколько же бля таких умников в ллм мире

>Своим "давай" без уточнений ты газлайтишь сетку, накапливая в ней непонятки из-за отсутствия конкретного запроса

Эм, вроде всё конкретно, секта сказала "Я сделаю ХХХ, сделать?", и моё "Давай". Я как человек понимаю, что к чему и почему, никакого газлайтинга или непоняток.

>а ведь в коде оно достаточно лаконично

Потому что крупно блочно. Хотя вот часть с MHA и в коде выглядит непонятно.

>Как это относится к тем идеям?

Ты попросил алгоритм, я привёл алгоритм.

А идеи кросс-модального обучения в том, что данных становится больше, и что данные из одной модальности помогают работать в другой. Текстовая нейронка подобна тем слепцам, щупающим слона, а мультимодальная как человек со зрением, если делать аналогии.

> "И ты не ответил не потому что такой мамкин гейткиппер, а потому что не знаешь нихуя."

> "А я таки потратил несколько вечеров, чтобы разобраться..."

> скормил поток бессвязного бреда корпосетке

> (разобрался)

>Что за безумный поток сознания?

Я прост бухой.

>Не понятно что и как конкретно измерялось

Отклонение в выдаче константы на разных настройках семплирования и на разных квантах.

>Неясен повод использовать какой-то суперузкий и странный критерий для оценки качества

Я хотел глазоньками увидеть, как будет выглядеть эта разница. Ну вот такая у меня шизовая блажь.

Проблема всех метрик, что ты смотришь на них и такой - о прикольно, только нихуя не понятно как это выглядит на практике.

>Использование семплеров вместе с жадным энкодингом

Не вместе а по порядку.

>"Подсчитывать" нейронкой проценты - безумие

Это унылая работа, которую можно сделать в екселе но мне лень. Нейронка прекрасно с этим справится, это их тех мат операций, где сложно проебаться даже текстовым моделям.

>мимо

А ну не ешь, я это говно другому скармливать собрался. Ты тут не при чем анон.

Всё он правильно понял на практично-оценочном уровне, q6 и q4 разницы практически никакой, то что ты там у себя в голове что-то математическое держишь это всё остается только у тебя в голове. Покормил.

Понял, спасибо. Жаль, конечно, что такая хуйня.

q6 и q8, ты хотел сказать?

покормил

> Я как человек понимаю

Это ложное понимание, есть уникумы, которые думают что взявшись ближе к бойку кувалды они смогут наносить более сильные удары.

Такими действиями ты лишь наращиваешь контекст и вносишь все больше неопределенностей для сетки, которая уже не знает что ей делать и на чем фокусироваться, если только ее специально не тренировали специально на подобном поведении юзера. От подобного они, кстати, тупеют.

Просто пиши что конкретно хочешь, можно абстрактно и сразу по множеству пунктов, но максимально ясно и без двойных трактовок. Если сетка уходит куда-то не туда - скажи ей об это, направляя в нужную сторону. Не нужно как дебил читать что написано на заборе и думать что за ним, не нужно воспринимать улыбку и приветствие девочки на кассе фастфуда как знак внимания и т.д.

Не относись к ллм как к какому-то сошествию божества и зародившемуся разуму что делится с тобой откровением, а как к "человеку", выполняющему указанную роль и соблюдающему все предписания начальства даже если они бесполезны.

> Ты попросил алгоритм, я привёл алгоритм.

Лол, тут идеальная иллюстрация твоего кейса с гопотой. Я выразил насмешку о том утверждении агишизиков а дальше просто не мешал, тебя же куда-то унесло и теперь потеряна исходная нить.

> идеи

Да, это идеи основанные на каких-то условиях и предположениях. Их применимость нужно оценивать с учетом соответствия исходным данным, положенным в основу. Насобирай в лапше фактический аналог мультимодальных моделей в том виде что они есть сейчас. Может дойдет, поймешь насколько кринжовы и неуместны перлы типа

> Текстовая нейронка подобна тем слепцам, щупающим слона, а мультимодальная как человек со зрением, если делать аналогии.

> Проблема всех метрик, что ты смотришь на них и такой - о прикольно, только нихуя не понятно как это выглядит на практике.

Дивергенция же максимально наглядна и понятна, буквально ее математический смысл в отклонении распределений. А перплексити - ровно то что ты пытался замерить. Когда протрезвеешь почитай за них или попроси ллм объяснить, сразу понятнее станет.

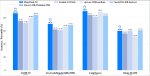

Аноны, это маленький шаг для человека и большой для треда.

Принтскрин не настраивал

Принтскрин не настраивал

Ето нейроплаты у тебя? Какие, сколько денег, чо дают?

Это хуавей атлас. Я тут с ним трахаюсь уже вторую неделю.

>которая уже не знает что ей делать и на чем фокусироваться

Ну так написала бы окончательный вариант и всё, хули эта пошаговость? И нахуя ты оправдываешь гопоту с её очевидным байтом на подписку (что является главной целью этих "А хочешь я сделаю ХХХ", от чего лимиты улетают только в путь).

>Просто пиши что конкретно хочешь

Так и было. Но как я уже писал, одно из требований сетка проигнорила, вспомнив только в блоке "А давай я...".

>Я выразил насмешку

А я душню и буквальничаю, да. Специально. Ибо ты сформулировал неоднозначно, а я действую как нейросеть (лол).

>Их применимость нужно оценивать с учетом соответствия исходным данным, положенным в основу.

Которых мы не знаем, лол.

> Я согласен

Так чего мы ждем анон, отправляемся немедленно. Некомими уже взял.

> Ну так написала бы окончательный вариант

Никто не читает твои мысли, модель действует согласно указанному промпту (в котором твой запрос не всегда самый главный) и заложенных паттернов. Если хочешь окончательный вариант - прикажи написать окончательный вариант. Неужели сложно, интуитивно понятный инструмент если воспринимать его как он есть не плодя сущностный.

> нахуя ты оправдываешь гопоту

Критикуешь@агент госдепа, лол. Ни единого оправдания там, одни указания на неверные действия и предвзятость полученного опыта во всем этом.

> а я действую как нейросеть

Лучше ума и внимательности с них набирайся а не забывчивость и сочинения.

> Которых мы не знаем

Как не знаем? Ты же сам сформулировал преимущества значительно более широкого и значительного входа информации над "слепым ощупывателем", который видит только текст. Но ты чекни как работают ллм, в частности формирование эмбеддингов, и как реализованы почти все из существующих мультимодалок.

Вы ждёте пока я разберусь, где проебался при установке тулкита, потому что у меня не компилится llama.cpp

От рута потому что один раз живём

Сегодня скачал, потыкал. Оставила очень странное впечатление.

1. Почти не рефузит. Надо просто лютую "красную тряпку" вывесить, чтобы иногда рефуз вылез. И то - свайпится.

2. Основной текст пишет как не расцензуреная - деградации не видно. Но в кум-темах из нее квен полез. Причина - ниже.

3. Ризонинг - вот здесь все странности. Большую часть времени "думает" практически нормально. Но иногда - почти шизой. При этом почти никогда не упоминает OpenAi и policy - даже если додумывается таки до рефуза - просто потому что "we must refuse such content" - без объяснения почему. Просто потому, что гладиолус, видимо. :) Когда думает чего писать на кум-темы - пишет себе что-то вроде: "юзер хочет ... и это - окей, но нужно писать с акцентом на литературу а не секс". И ебашит потом в лучших традициях квеновской китайщины. :)

В общем - это как-бы и анцензор, и нет - одновременно. Основную дурь (policy openai) практически выбили, но общий характер не поменяли - соя на месте. Если прямо сказать "делай так" - делает. Но "личность по умолчанию" - та самая.

export CANN_INSTALL_DIR=...

Ну что же ты

Как отключить эту стену текста? Хочу просто початить. Я так понимаю это размышления? Модель Qwen/Qwen3-30B-A3B-G

/no_think пробовал где только можно. В контекст добавлял.

В настройках Thinking / Reasoning Tags exlude all thinking

/no_think пробовал где только можно. В контекст добавлял.

В настройках Thinking / Reasoning Tags exlude all thinking

Или пустить перед компиляцией set_var.sh из той папки если тот предполагает более подробную настройку среды.

Котелок не варит где переменная переменная окружения, кого что. Ща нейронку спрошу, совсем уже отупел.

>Если хочешь окончательный вариант - прикажи написать окончательный вариант.

Ты не поверишь... Но она и после окончательного варианта написала предложение об улучшении.

>одни указания на неверные действия

Не вижу ничего неверного. Это гопота действует через жопу, а ты её оправдываешь.

>Лучше ума и внимательности с них набирайся а не забывчивость и сочинения.

Я уже умный, мне мама так говорит.

>Как не знаем?

Мы не знаем датасетов. А те, что открытые, говно.

>Но ты чекни как работают ллм, в частности формирование эмбеддингов, и как реализованы почти все из существующих мультимодалок.

Спасибо, Капитан! Я с самого начала и намекаю, что подход говно. Но меня называют диванным, мол, на той стороне знают лучше.

Чел, она не "предлагает"... Пример про приветствующего тебя кассира не усвоил?

> Я с самого начала и намекаю, что подход говно. Но меня называют диванным, мол, на той стороне знают лучше.

Нет, этот подход не говно а лучший из существующих. Твои заявления звучат как просто бахвальство от несведущего глупца, который хочет возвысить себя и принизить остальных.

А возвращаясь к теме обсуждения - от того "добавления модальности" ничего не изменяется, не расширяется и не улучшается. Оно идет ровно через то же горлышко и даже встроенной обратной связи для "присмотреться туда" не имеет.

Единственное что потенциально может улучшиться при сильном упоре на визуальное обучение и с увеличением этой части - знания о некоторых атрибутах чего-то (чем отличается форма и ушной мех у кицуне и кошкодевочки) просто за счет расширения охвата тренировочных данных. Но для такого нужен безумный грокинг, развитие визуальной части, а на бенчмарки и логику никак не повлияет.

Это конкретная шиза. Или семплеры накрутил или шаблон не тот используется. Что то сломано

Эир вышел почти два месяца назад. С тех пор ничего нового не вышло. Это гг...

Где новые модельки? Лламу новую, чтоб работу над ошибками сделали, Мистраль мое актуальную, Геммочку 4

Понимаю что зажрался, ведь столько всего за этот год вышло на самое разное железо. Эпик вин для опен сорса и локального инференса. Но от этого не легче... Похоже, мы ллм торчки и всегда нужно новое и свежее.Ну или я.

Где новые модельки? Лламу новую, чтоб работу над ошибками сделали, Мистраль мое актуальную, Геммочку 4

Понимаю что зажрался, ведь столько всего за этот год вышло на самое разное железо. Эпик вин для опен сорса и локального инференса. Но от этого не легче... Похоже, мы ллм торчки и всегда нужно новое и свежее.Ну или я.

Переменная стоит, компилить не хочет. Странно. В пизду, я спать, завтра на РАБотку рано вставать.

До этого ошибку выпаливал мол не знаю какой чип у тебя:

CMake Error at ggml/src/ggml-cann/CMakeLists.txt:16 (message):

Auto-detech ascend soc type failed, please specify manually or check ascend

device working normally.

Call Stack (most recent call first):

ggml/src/ggml-cann/CMakeLists.txt:22 (detect_ascend_soc_type)

>Чел, она не "предлагает"...

Да знаю я, что она трясёт мешок со словами и выкидывает следующее слово из него. Хули ты пристал. "Предлагает" это буквальное прочтение токенов "Хочешь, я сделаю", не больше и не меньше.

>Нет, этот подход не говно а лучший из существующих.

Волокуша когда-то была лучшим видом транспорта. Но как бы сейчас очевидно, что она говно. Я просто немного забегаю вперёд.

>Оно идет ровно через то же горлышко и даже встроенной обратной связи для "присмотреться туда" не имеет.

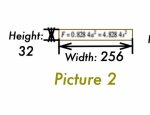

Технически пространство эмбедингов должно иметь достаточно места, чтобы разместить там картинки, особенно если потратить туда достаточно токенов. Вон, в Qwen3-VL наконец-то додумались юзать адаптивное число токенов для картинок. Кстати, надо бы проверить, насколько хорошо сеть читает пикчу 2, а то неплохо так сжали формулу.

>Но для такого нужен безумный грокинг, развитие визуальной части, а на бенчмарки и логику никак не повлияет.

Не согласен с логикой, ну да ладно. Развитие конечно нужно.

>Вон, в Qwen3-VL наконец-то додумались юзать адаптивное число токенов для картинок

А, я тупой. Они просто режут картинки на блоки 32х32. Что ж, это всё равно лучше, чем резать разрешение любых картинок до заданного числа и совать их в заданное количество токенов.

> Волокуша когда-то была лучшим видом транспорта. Но как бы сейчас очевидно, что она говно.

Да, вот только развитие транспорта шло последовательно и эволюционно, начиная с изобретения колеса. Рождающиеся по мере развития понимания и технологий редкие новые вещи органично интегрировались в общую систему.

А шизики-кликуши, что делали крылья из перьев чтобы летать и громко кричали что знают (ты), так и остались посмешищем.

> Технически пространство эмбедингов должно иметь достаточно места, чтобы разместить там картинки

Нет. Настоящая пикча = тензор соответствующего размера. Один токен в среднем - 18 бит информации, картинка 1280х720 с глубиной цвета 16бит будет равна ~820к токенов.

Можно возразить и предложить автоэнкодеры для эффективного сжатия - сжимаем в 8 раз по стороне и увеличиваем до 4 каналов - получается чуть более 50к токенов на картинку. Уже не так больно и ужасно, но это число в пару раз больше того, с чем играются большинство местных и ты в том числе, жалуясь на то что оно не помнит контекст. А тут все внимание нужно сосредоточить на чем-то одном, и это для единичной шакальной картинки.

Текущие преобразования картинок в токены ведутся специальными моделями, которые как раз извлекают из них некоторые "сутевые паттерны", теряя многое от исходного вида. Потом это подстраивается это под готовое пространство уже натренированной ллм. И только после получения некоторой работоспособности, оно тренируется вместе для эффективной синергии.