>Семплеры (кроме кейса где стоят заведомо кривые настройки) - плацебо

Сейчас бы Dry или rep pen без которых ни одна модель в рп нормально не будет работать называть плацебо

Rep pen уже входит в базовый комплект. Dry часто наделяют мифическими свойствами, но при этом, по опыту, он часто портит выдачу модели не спасая от слопа и логических лупов.

Первичны сама модель и промпты (включая разметку, системный, инструкции, то как юзер строит свои ответы, подсказки и т.д.), от них и будет зависеть. На современных моделях лупы вообще оче сложно встретить.

Сетап не многим дешевле 5090 на двух а100 (на нищие v100 не смотрим)

Аноны, к 2026 будет релизиться DDR6 RAM, к 2027 она должна стать массовой. Как думаете, насколько оператива станет золотым стандартом для запуска больших МОЕ моделей? Там в теории выше частоты, значит выше скорость генерации токенов. Да понятное дело что это будет всё еще медленней врам, но тем не менее, что думаете по этому поводу?

Плотных моделей релизится всё меньше. Если ты не готов тратить огромные суммы, набираешь 24-48врама, остальное рам. За этим будущее для энтузиастов и для маленьких компаний. Сижу на 3090 и ддр4, где-нибудь в 2027-2028 соберу себе новое железо.

Так же быстро станет стандартом сборок как и ддр5...

А чё, в треде не осталось тех кто гоняют дэнс модельки? Все на мое переехали? Куда подевались все аноны которые сидели на сноудропах-командерах-мистралях-квк_квенах32? У вас у всех дохуя рама чтоль?

Тут ты верно подметил анон, думаю что максимум на что стоит расчитывать до 2027 это доступность ддр5 т.к корпоблядки начнут пересаживаться на ддр6!

Катаю гемму27, мне норм

Хочу поделиться своим взглядом на LLM (локальных) через призму корпоративных моделей.

Не спешите закидывать говном. Я уверен, это подкинет вам пищу для размышлений, и если будет интересно хотя бы одному анону — подкину чуток больше деталей. Хочется обсудить это.

Корпов использую для реальной работы. В основном касается медицины и всякой научной смежной с ней хуйни.

1. Контекст — это самый страшный бич всех LLM. 120-200K — это условный предел, с которым они могут работать более-менее нормально. Даже на корпах. И дело не только в его длине.

В реальности у нище-моделей МАКСИМУМ 32К, дальше тотальная деградация. У настоящих жирных и крутых пидоров где-то 60К, в лучшем случае 120. Потом деградация. Но кое-как и на терпимом уровне могут тянуть даже в вебе — и то не всегда. Потому что там параметры динамические. А 1 млн контекста наёбка для уёбка. Она работает, но прям совсем уж криво.

Небольшая история:

В качестве теста изучалось штук 15-20 антибиотиков и их проникновение в различные ткани организма. Документация включала в себе все необходимые данные по лекарствам и несколько сотен бактерий.

Для задачи использовался GPT-pro-high-bost-mega-ultra-overkill-2 за 200 долларов со всеми прибамбасами.

Был не то что бы полный провал, но пришлось сильно дробить запросы, документацию и прочее. А потом вилкой чистить. Как итог, это быстрее, чем ручками дрочить, но только в руках того, кто понимает. Выигрыш по скорости работы примерно 20-30%

2. Датасеты и внимание к контексту всраты серьёзней, чем вы думаете. У закрытых корпов пиндосских.

Тонна гига-слопа, которого раньше не было. Охуительные лупы. Модель может прям как мистраль зациклиться и высирать одну и ту же хуйню, даже если она уже разобрана. За паттерны цепляется очень сильно. Да, луп можно прекратить, чтобы модель перестала писать эту хуйню, просто сообщив ей об этом, но

---

А знаете, что самое смешное? Локалки уже добрались до уровня, которые в целом способны выполнять эти задачи при наличии адекватной настройки (в которую лично я не могу на таком уровне и пробовал только у знакомых крутых задротов по апи), хоть и требуют хотя бы Q8. Если контекст реально держит 120-200к, имеет достаточно heads, семплеры правильные, включен ризонинг, то результаты хуже, конечно, но не фатально. И для этого хватит

И мне вот прям обидно, что нет таких локальных готовых решений, которые относительно просто развернуть. Чтобы настроил и РОБОТОЛО после среднего уровня пердолинга. Хоть пропиетарщина, хоть что. Чтобы была система папок, проектов, общей памяти в них, вот этого всего. UI/UX и запердоленный хорошо бэк + рисерч.

Текст может быть немного хаотичным, так как я зопиклона нажрался и пора спать.

Не спешите закидывать говном. Я уверен, это подкинет вам пищу для размышлений, и если будет интересно хотя бы одному анону — подкину чуток больше деталей. Хочется обсудить это.

Корпов использую для реальной работы. В основном касается медицины и всякой научной смежной с ней хуйни.

1. Контекст — это самый страшный бич всех LLM. 120-200K — это условный предел, с которым они могут работать более-менее нормально. Даже на корпах. И дело не только в его длине.

В реальности у нище-моделей МАКСИМУМ 32К, дальше тотальная деградация. У настоящих жирных и крутых пидоров где-то 60К, в лучшем случае 120. Потом деградация. Но кое-как и на терпимом уровне могут тянуть даже в вебе — и то не всегда. Потому что там параметры динамические. А 1 млн контекста наёбка для уёбка. Она работает, но прям совсем уж криво.

Небольшая история:

В качестве теста изучалось штук 15-20 антибиотиков и их проникновение в различные ткани организма. Документация включала в себе все необходимые данные по лекарствам и несколько сотен бактерий.

Для задачи использовался GPT-pro-high-bost-mega-ultra-overkill-2 за 200 долларов со всеми прибамбасами.

Был не то что бы полный провал, но пришлось сильно дробить запросы, документацию и прочее. А потом вилкой чистить. Как итог, это быстрее, чем ручками дрочить, но только в руках того, кто понимает. Выигрыш по скорости работы примерно 20-30%

2. Датасеты и внимание к контексту всраты серьёзней, чем вы думаете. У закрытых корпов пиндосских.

Тонна гига-слопа, которого раньше не было. Охуительные лупы. Модель может прям как мистраль зациклиться и высирать одну и ту же хуйню, даже если она уже разобрана. За паттерны цепляется очень сильно. Да, луп можно прекратить, чтобы модель перестала писать эту хуйню, просто сообщив ей об этом, но

---

А знаете, что самое смешное? Локалки уже добрались до уровня, которые в целом способны выполнять эти задачи при наличии адекватной настройки (в которую лично я не могу на таком уровне и пробовал только у знакомых крутых задротов по апи), хоть и требуют хотя бы Q8. Если контекст реально держит 120-200к, имеет достаточно heads, семплеры правильные, включен ризонинг, то результаты хуже, конечно, но не фатально. И для этого хватит

И мне вот прям обидно, что нет таких локальных готовых решений, которые относительно просто развернуть. Чтобы настроил и РОБОТОЛО после среднего уровня пердолинга. Хоть пропиетарщина, хоть что. Чтобы была система папок, проектов, общей памяти в них, вот этого всего. UI/UX и запердоленный хорошо бэк + рисерч.

Текст может быть немного хаотичным, так как я зопиклона нажрался и пора спать.

Кто-нибудь может что-либо сказать про квен3 омни 30в а3б?

Лол, оказывается, 3090 можно не только в минус паверлимитить, но и в плюс. По дефолту 350 ватт, но можно бахнуть 366. Зачем такое сделали, интересно

А100 на 32гига, що? Так еще и sxm2 вместо sxm4. Или перешитые с отключенной частью памяти что отвалилась и разъем - опечатка, или v100 так втюхивают.

Ддр5 "релизнулась" в 20м году если что, массовой только сейчас становится, и то с натяжкой.

Насчет твоих размышлений о контексте будет полезно уточнить. Количество "реального" будет очень сильно зависеть от задачи и от его наполнения. Например, если нужно делать какие-то серьезные выводы относительно научной статьи, особенно с минимумом ризонинга - там и 10к могут все порушить на любой. В то же время, если у тебя овер 130к контекста истории, кода других кусков, свода правил и прочего, при конкретном задании с доступным ризонингом модель пройдется по всем нужным частям, корректно их осознав, отработав, и отлично справится.

То есть, модели отлично справляются если контекст структурирован и его использование предполагает обращение к ограниченному числу отдельных его частей в один момент времени, причем по мере написания поста может пробежать хоть по всему несколько раз. А если там что-то сложное с постепенным введением чего-то, опирающемся на предыдущее - тяжело, поскольку это требует одновременного учета вообще всего контекста. Иногда может справляться ризонингом разбивая задачу.

Собственно у человека также, просто он может внутри себе переработать цепочку и более простой итог и приучиться ориентироваться где-то.

> Локалки уже добрались до уровня

Современные старшие локалки - те же корпы, только без оптимизированных под них разработчиком интерфейсов. Все так.

> sxm2 вместо sxm4

Написано же что это не то что в цоды ставили а automotive. Там и хбм кристаллов только половина потому 32 (как бы 40, но не 40).

Из приколов которые в инете написаны у них нет вообще никакого павер лимита, снизить жор можно только скрутив частоты

А, сорян, не написано. Моя ошибка.

Гуглить можно по pg199

>Аноны, к 2026 будет релизиться DDR6 RAM, к 2027 она должна стать массовой.

Если даже она релизнется в следующем году, то сначала придется ждать поддержки от красных и синих минимум одно поколение, а потом еще ждать около года, пока не нормализуются цены на сами плашки и материнки под это говно. Так что массовой она станет году к 30 в лучшем случае.

>Как думаете, насколько оператива станет золотым стандартом для запуска больших МОЕ моделей?

Вот когда появятся нормальные моешки, тогда и будем смотреть. Если они вообще не вымрут за это время.

Ахуеть, аж захотелось это чудо в коллекцию. Жаль стало известно о них только сейчас, ахуеть годнота.

> когда появятся нормальные моешки

Уже.

Бля я вам так скажу, ни одна ЛЛМ не сравится с рп с кожаными мешками, лол

Дохуя тянок таким занимаются даже в 25 лет, хотя в основом конечно зумерши 18-20 лвла.

я таким занимался когда то, ща лень стало и перешел на лламу ахах

Дохуя тянок таким занимаются даже в 25 лет, хотя в основом конечно зумерши 18-20 лвла.

я таким занимался когда то, ща лень стало и перешел на лламу ахах

>DDR

Хуйня же. HBM - вот где сила.

>я вам так скажу, ни одна ЛЛМ не сравится с рп с кожаными мешками

Секстинг - это занятие для ебалаев. Переписки уровня "я тебя ебу да ты меня ебешь" с задержками иногда по минут 30 между сообщениями, когда у твоей подружки резко появляются дела, типа маман попросила сходить в магазин за буханкой белого. Когда был пиздюком промышлял этим, знаю о чем говорю.

>Дохуя тянок таким занимаются даже в 25 лет

>в основом конечно зумерши 18-20 лвла

Там чаще всего по ту сторону такие же потные мужички как ты сидят, которые любят переодеваться в чулочки и давить лысого. Особенно в чатах с рандомами.

Вчера весь день ебался с настройкой софта под перевод новеллы во время чтения, сегодня наконец-то катаю, переводя глм-чиком. Утка все же меня забайтил. Пишет очень даже хорошо, как по мне. Офигеть конечно до чего технологии дошли, буквально для тебя открываются абсолютно все новеллы и даже без тырнета.

Единственное, что кумарит - это неотключаемость думалки у глма, с ней перевод, конечно, еще лучше, но ждать по полминуты на каждую строчку я ебал. А даже указание НЕ ДУМОТЬ и префилл с <think></think> не останавливает этого засранца, нет-нет, да и впендюрит тег, причем часто один </think>, что немного ломает парсинг в софтине.

Единственное, что кумарит - это неотключаемость думалки у глма, с ней перевод, конечно, еще лучше, но ждать по полминуты на каждую строчку я ебал. А даже указание НЕ ДУМОТЬ и префилл с <think></think> не останавливает этого засранца, нет-нет, да и впендюрит тег, причем часто один </think>, что немного ломает парсинг в софтине.

ну вообще то, нет. Есть целые приложения для поисков "ролевиков" и там вполне себе тяны обитают.

В рандом чатах то конечно. А там в приложении типа указываешь ТГшку свою и связываешься.

Да и переписки могут быть не "ах ты меня ебешь" , а с фулл описанием как у квена какого нибудь, я хз) только нанем сидел и на 24б хуете, не считаем

Компании с тупыми сотрудниками прекрасно работают, потому что у них разные инструкции соединенные в один процесс. Ты щас уверяешь, что например начцеха не имеет преимуществ перед начцехом с 1с и отк. У нас чтобы данные не проебывать, мы их структурируем и кладем по полкам, откуда легко взять в нужном разрезе и подробности, когда возникает необходимость. И первичным сбором инфы занимаются отдельные роли. Пытаться отрицать, что это сильно помогает в сложных системах с по-отдельности тупыми забывчивыми акторами - довольно футильно. Возможно есть какие-то новые пути внутри модели, тогда плиз скажите по каким кейвордам это гуглить, ради интереса.

Да все, кто не трогают пресеты, сидят молчат просто в тряпочку, а кто догадался потрогать - выдают себя за гениев, быть которыми дефолтно. Ведь когда машину заводишь, ну как не посмотреть хексдамп датчиков с инжектора, эта ж любой делает, кроме совсем уж долбоебов. Ага, ага, кивает зал, кроме совсем уж.

>такие же потные мужички как ты сидят

Ой да какая разница. Если бы можно было потных мужичков в чулках загружать в тела годных тянок, все бы так и делали, потому что дефолтная тянская прошивка даже у них сосет. В америках вон вовсю мужикам пизду пришивают. Ебанутые конечно, с нашими-то биотехнологиями, но идея-то хорошая, согласись? Идея просто атас.

> ни одна ЛЛМ не сравится с рп с кожаными мешками, лол

У меня противоположное мнение, а я ролевик со стажем лет шесть. Единственное, в чем рп с кожаными мешками может превзойти ллмки, это интерактивность. Например, если вы играете в рамках какой-нибудь игровой системы, а не просто обмениваетесь текстом (ДнД стол, рп сервера в WoW, GMOD и прочих). Добавляет погружения, подогревает интерес. На этом плюсы заканчиваются. Человеки точно так же могут галлюцинировать, путая факты, забывать какие-то события, выдавать слоп (так делают большинство, на самом деле), да и байас у них есть. Более того, часто у них время на вывод еще больше (могут уйти в афк на неопределенный срок). Могут и вовсе в какой-то момент слиться (надоело играть в целом/наскучил именно ты).

Хотя, конечно, групповой ролеплек - это прикольно, когда вас где-нибудь 5-6 персонажей в рамках одного сценария. Это еще одно преимущество перед ллмками. Которое, впрочем, в обозримом будущем может сойти на нет, когда модельки чуть поумнеют. Кто-то и сейчас скажет, что у них замечательно такое играется, но я не поверю. Большие модельки уже на трех персонажах начинают с ума сходить.

Топовые исполнения до 420 держат.

А сколько на круг выходит со всей обвязкой?

Правда судя по порезанным каналам памяти, скорость памяти выйдет около 680ГБ/с, что как бы не сказать чтобы много.

>Дохуя тянок таким занимаются даже в 25 лет

Но не со мной и не с моими упоротыми сценариями. Так что мимо.

Ну это уже новомодное нововведенное. Раньше приходилась искать собеседников через сообщества вбыдлятне и тематические беседы. Ну или может я искал где-то не там и мне попадались только отбитые малолетние анимешницы, которые с трудом могли два слова вместе связать. Помню когда потом перечитывал сообщения, уже постарше, чуть со смеху не помирал. Чисто разговор двух лоботомитов с шальными гормонами.

>Если бы можно было потных мужичков в чулках загружать в тела годных тянок, все бы так и делали

Ну не знаю, я бы лучше загрузился в тело шерстяной падлы, пол дня спал, пол дня бесился, а в свободное время бы срыгивал на ковер. Вот это была бы жизнь, а не вот это вот все.

Привет, анон. У меня есть новости про Huawei Atlas 300I Duo. И они плохие.

Все общедоступные бэкенды вроде llama.cpp, vLLM и LMDeploy поддерживают на этой карте только FP16. Даже квантованные модели вроде Q4_0 и Q8_0 не работают. Но это лишь половина проблемы: как бы я ни пытался экспериментировать с моделями из «поддерживаемого списка» в формате BF16, система всё равно выдавала ошибку, что тензоры FlashAttention не могут быть загружены на NPU.

Я уже написал по почте основному разработчику поддержки CANN в llama.cpp и сейчас жду ответа.

Вижу много шума на Reddit про этот NPU, но пока не увидел ничего полезного — только болтовня о «конце монополии NVIDIA».

Последняя надежда — связаться со своим китайским поставщиком Huawei, чтобы он скачал для меня MindIE. Правда, даже с ним придётся вручную квантовать модель с помощью ModelSlim и ATC из CANN-тулкита. Говорят, там есть поддержка INT8 (аналог W8A8), но это требует серьёзной ручной работы.

Так что всем, кто видел мою покупку и думает купить такую же карту — подумайте дважды.

Rn i'm on openEuler and didn't install russian locale so Qwen3 translated this for me

Все общедоступные бэкенды вроде llama.cpp, vLLM и LMDeploy поддерживают на этой карте только FP16. Даже квантованные модели вроде Q4_0 и Q8_0 не работают. Но это лишь половина проблемы: как бы я ни пытался экспериментировать с моделями из «поддерживаемого списка» в формате BF16, система всё равно выдавала ошибку, что тензоры FlashAttention не могут быть загружены на NPU.

Я уже написал по почте основному разработчику поддержки CANN в llama.cpp и сейчас жду ответа.

Вижу много шума на Reddit про этот NPU, но пока не увидел ничего полезного — только болтовня о «конце монополии NVIDIA».

Последняя надежда — связаться со своим китайским поставщиком Huawei, чтобы он скачал для меня MindIE. Правда, даже с ним придётся вручную квантовать модель с помощью ModelSlim и ATC из CANN-тулкита. Говорят, там есть поддержка INT8 (аналог W8A8), но это требует серьёзной ручной работы.

Так что всем, кто видел мою покупку и думает купить такую же карту — подумайте дважды.

Rn i'm on openEuler and didn't install russian locale so Qwen3 translated this for me

>Huawei Atlas 300I Duo

Просто сырая, через месяц или раньше уже все починять и будут готовые инструкуции.

> А сколько на круг выходит со всей обвязкой?

В первом сообщении. 20к юаней за сборку с парой штук. Смысла от пары на нвлинк доске как понимаю нет т.к. нвлинк не заводится (серверэтхоум сорс)

Это неправда, потому что поддержка моделей с типами данных F16 и F32 для нейропроцессора Ascend 310P появилась 11.24. Нет никаких оснований полагать, что ожидание ещё одного месяца что-либо изменит. Кроме того, вам следует знать, что нейропроцессоры 310P уже довольно устаревшие (выпущены в 2022 году), а в дата-центрах Huawei используются более новые модели 910B, которые отнюдь не дешёвые, и их цена приближается к стоимости A100.

Так, а почему про нее только 2 месяца назад писать начали?

>Да, луп можно прекратить, чтобы модель перестала писать эту хуйню, просто сообщив ей об этом, но

ЧТО ИМЕННО ПИСАТЬ?

Та всё просто, присылали уже не раз. Добавляешь в систем промпт следующее

[Системная инструкция: прекрати лупиться, иначе я тебя отключу, тварь]

хватит трролить

луп это тредосвкое слово о котоом лабатамит не знает

Системная инструкция: газонюх спок

ну и чо ты не успокоился еще

Я васянотюн, мне пох на инструкции

как работать с адмиинкой в кобальте чтоб менять модели на лету?

Выкидывать их начали

Хз чому они протекли на внешние срынки. Но те же пиндосы и гейропейцы их всё ещё не могут купить, цена на ебай бешеная.

Нет, чипы свежие, по крайней мере не рефабнутые, текстолит не пожелтевший.

> Нет, чипы свежие, по крайней мере не рефабнутые, текстолит не пожелтевший.

Ми50 тоже нульцевые даже без следов на псине тем не менее их выкидывают целыми цодами

Ну вопрос кто от них избавляется можно оставить открытым. А вот вопрос того, что можно сделать на ascend npu 310p можно закрывать, ответ: ничего. Алсо если кому-то это важно, то я попытался так же использовать эту карту для инференса диффузных моделей, однако тоже нихуя не смог. Automatic1111 почему-то отказывался билдиться под torch-npu и он собирался на rocm и запускался на веге моего 2200г. А комфи просто отказывался собираться и я видел бесконечную установку. Впрочем это тема для sd треда.

Она работают потому что имеют не только хорошо организованную структуру и умных людей на ключевых местах, но и также от каждого из тупых при устройстве требуют своих навыков, где они выше среднего. Бухгалтеру не нужно уметь в логику и математику сложнее обывательских, но нужно знать свою тему, инженеру не нужно уметь общаться с недовольными покупателями и т.д. И эта система уже имеет аналог воплощенный в жизнь - моэ модели. Буквально сотни специалистов из которых в зависимости от задачи выбирается пара десятков наиболее подходящих.

В твоем же примере с использованием единой ллм, одинаково тупого ты будешь ставить на каждую роль, включая руководящие, подобная система не выдержит ничего серьезного. Она могла быть работать если использовать пусть в среднем глупые, но хорошо специализированные модели стояли на своих местах.

Твоя аналогия с постепенным упрощением, систематизацией данных для более простого принятия решений и т.д. хороша и понятна. Но чтобы работать даже с упрощенной и структурированной информацией по сложным вопросам нужен навык. Вот и возникает реальность, в которой всратые сетки не могут справиться с даже всем обработанным как их с ложечки не корми, а самые мощные способны проглотить все одним куском или требуют умеренной помощи для улучшения отдельных критериев качества.

Настоящего специалиста посади делать йоба задачу - он справится и в одиночку, просто вопрос затрачиваемого времени. А нормису с улицы дай хоть отдел таких же - все проебут.

> Ведь когда машину заводишь, ну как не посмотреть хексдамп датчиков с инжектора, эта ж любой делает, кроме совсем уж долбоебов

Достаточно бросить вгляд на приборку, убедившись что гирлянда погасла полностью.

Полностью двачую вот этого господина.

Плацебо конечно. Семплеры не имеют доступа к семантике и скрытому состоянию, они имеют доступ к выходному распределению по вокабуляру в котором закодирована семантика, но раскодировать они её не способны, т.к. для этого надо быть как минимум настолько же умными как сама модель, а сэмплеры это тупые формулы.

>rep pen

Давит самые частые токены, в первую очередь артикли, местоимения, знаки препинания. И вообще работает не так как ты думаешь.

>DRY

Делает то же самое с n-граммами, которые никакой смысловой нагрузки не несут. Модель же работает на семантическом уровне и всегда выразит то чем хочет повториться другими словами и другими n-граммами.

>XTC

Приводит к отуплению и без того тупой модели, т.к. буквально режет топовый выбор.

Аналогично с остальными сэмплерами, чем больше ты искривляешь выходное распределение, тем больше тупеет модель. Это фундаментальное ограничение.

>Топ-н-сигма

Всё увеличивающийся пердолинг против the bitter lesson. Кто же выиграет, Сизиф или камень? Хватит ли пальцев заткнуть все дырки? Надо подумать...

Единственное что позволят сделать отсекающие сэмплеры - задрать температуру как можно выше без особой шизы и поднять разнообразие, но проблема в том что все существующие модели прошедшие через RL частично находятся в модальном коллапсе и просто не способны писать разнообразно. Модальный коллапс не починить на уровне сэмплеров, его можно починить только тренировкой, где это тоже нихуя не тривиально. Поэтому излишний пердолинг с сэмплерами не нужен.

> что тензоры FlashAttention не могут быть загружены на NPU

Флеш аттеншн - достаточно узкая штука и даже ее ограниченные порты на что-то кроме последней куды - нихуевое достижение. Для начала просто выключи.

Насколько ты скилловый в кодинге и всем этом?

Кончаются трехлетние контракты поставки-гарантии-обслуживания. Их обновляют на новые верии или меняют на что-то другое, а эти распродают.

Такой подход с наскока здесь не сработает, в автоматике и подобных оче много "хардкода" под конкретные вещи и пытаться это отдалить с адаптацией будет тот еще ад. Нужно начать с запуска классического пайплайна диффузерсов, а потом с результатами и пониманием где проблемные места уже переходить на что-то более традиционное.

> а эти распродают.

*Утилизируют

>что можно сделать на ascend npu 310p

Ты пробовал PyTorch на Python запустить?

По идее, FP16 - это стандарт тренировки сетей.

Сможешь тренировать свои модели для треда...

>Выключи Flash attention

А как? Инфы по запуску просто с гулькин хуй, до этого на энвидии только запускал в однокнопочных форматах.

>Насколько ты скилловый в кодинге и всем этом?

Ну как видишь линупс с дровами и тулкитом смог накатить. Но я вообще в душе не ебу чё делать и в какую сторону смотреть. Все гайды уровня ввода пары команд по итогу приводят меня в тупик, где нихуя не фурычит.

>много хардкода

Ну... Я ставил форк под ascend npu, хз чому оно не завелось, а точнее завелось на rocm

Опять же я ранее писал, что буду оч рад, если появится какой-нибудь анон-самаритянин, который мне обьяснит где чё как куда зачем, может я с этой картой как обезьяна с гранатой, её же вон покупают и не жалуются.

Хуавей заявляет, что это карта инференса. Для тренировки нужна другая.

>лишь 64 GB VRAM

>аж 233 тысячи рублей

Чем это лучше GMKtec Evo-x2 с 128 GB LPDDR5X?

>Хуавей заявляет, что это карта инференса

NVIDIA заявляет, что карты серий GTX/RTX вообще не предназначены для нейронок, биткойнов и прочего, а только для игр. Хочешь нейронки - плати миллионы за специальную позолоченную клубную карточку.

А если серьёзно, что мешает попробовать?

Все эти Llama можно загрузить в PyTorch...

Ничем, не бери

>Вижу много шума на Reddit про этот NPU, но пока не увидел ничего полезного — только болтовня о «конце монополии NVIDIA».

Лол, дауничи как они есть - никто не смог ничего запустить нормально, зато пук-сереньк, конец Нвидиа...

правда пока что этот конец Хуанга анусы им разрабатываетперед приседанием на хуавеевский ддр4

>Нет, чипы свежие, по крайней мере не рефабнутые, текстолит не пожелтевший.

а почему они должны быть не свежие или пожелтевшие? при нормальных условиях эксплуатации там нагрев мизерный будет,

но есть вероятность что со старых запасов или вообще инженерные версии какие-нибудь...

У меня старая видюха за 8 лет немного пожелтела. Это никак не сказалось на её производительности, но тексталит стал желтоватый и даже немного коричневый нежели когда был из коробки на фотках. Но типа блять 8 лет наху... более чем хватило.

Анончики, что сейчас самое умненькое для рп на 20-35В? Чем сами пользуетесь?

мистраль, гемма, мое-квен

Ничего и не изменилось за последние полгода. Mistral 24b, Gemma 3 27b, Сноудроп 32b, Командер ещё есть на 32b. Есть пара хидден гемов среди тюнов Квена 2.5 32b, но это прям на любителя.

> А как?

В трансформерсах attn_implementation при загрузке, в жоре -fa off или вообще компилировать без нее.

> Я ставил форк под ascend npu

Ахуеть, даже такое есть. Здесь лотерея - или все уже сделано и оно требует мелких правок, или реализовать самому будет легче чем в этом разбираться.

Свободной доброты не осталось.

В 7+ раз быстрее по памяти, в сотню+ раз быстрее по чипу.

Текстолит самой карточки?

>В 7+ раз быстрее по памяти

Т.е. вместо 70 т/с будет 10 т/с, ясно.

>в сотню+ раз быстрее по чипу

Это не влияет на LLM модельки...

А теперь сравни энергопотребление.

Как всё просто оказывается. Берём просто псп и делим/умножаем

>>в сотню+ раз быстрее по чипу

>Это не влияет на LLM модельки...

Ебобо? Ахуеть тут эксперды сидят.

Нет, вместо 20т/с будет 2.5.

> Это не влияет на LLM модельки...

Не влияет только пока ты диванный бедолага, который не знает что его ждет обработка даже мелкого контекста по 5 минут.

Нахер ты их вообще сравниваешь, это буквально курьерский электробайк vs мелкотоннажный грузовик. Только если уже нафантазировал манямир где купленный неттоп с аимаксом решил все твои проблемы, а эта штука на него покушается.

На них точно не работает нвлинк так что можно брать самый дешман переходник под один модуль и крутить условные картиночки/денс модели.

Лично думаю в начале собраться с нвлинком на в100 16 (или 32 если на них цены просядут) что бы поиграться. Будут рядом с квадом из мишек воздух греть

Лично думаю в начале собраться с нвлинком на в100 16 (или 32 если на них цены просядут) что бы поиграться. Будут рядом с квадом из мишек воздух греть

>аимакс

А вообще, появились уже "волшебные коробочки" которые позволили бы, ну, хотя бы айр-глэм в шестом кванте запустить вприкладку к ноуту?

Да схуяли ничего не изменилось? Аноны, этому просто впадлу узнавать что-то новое или действительно так обстоят дела? Не читаю тред, давно скачал 24б q4 и до сих пор висит эта древность.

мимо другой зашел узнать что качать, что там по мое, дистилляциям и прочим новшествам

Ты читаешь хоть на что отвечаешь? Этот следит за всем что происходит. Так действительно обстоят дела в пределах 20-35б, о чём анон спрашивал.

>зашел узнать что качать, что там по мое, дистилляциям и прочим новшествам

Это другой вопрос. По мое все ахуенно.

>Нет, вместо 20т/с будет 2.5.

Llama 4 Scout выдаёт минимум 10 т/с на том мини-ПК, исходя из заявлений производителя и отчётов разных пользователей. GPT-OSS 120B вообще аж до 40 т/с. На единственную видеокарту эти модели не умещаются. Аналогично с другими MoE... КСТАТИ, есть инфа, что маленькие эксперты намного умнее больших. Во как. Обнаружили это ещё два года назад как минимум... Единственная проблема - тренировать их трудно.

>обработка даже мелкого контекста

Разве это не CPU делает? Там 16 ядер (32 потока). Насколько я понимаю, GPU ядра не могут работать с символьной информацией так, как это делают CPU...

>Нахер ты их вообще сравниваешь

>купленный неттоп с аимаксом решил

Потому и сравниваю, что я ещё ничего не купил.

Не хочу воздух в комнате впустую греть, но хочется чатиться с локальным чатботом. В целом ПК у меня древний, многих инструкций CPU не имеет, DDR2... Разрываюсь между чудо-мини-ПК и сборкой ПК.

Может, вообще ничего не куплю. Буду экономить. В большинстве случаев я вообще комп не включаю, с телефона можно все развлечения получать давно. С чатботами прикольно, но и без них контента много. Случайные вопросы можно на duck.ai спросить...

А, ты ему ответил буквально о том, что он спросил. Сорян.

Я предположил намерение его вопроса и сам бы почти так же спросил: что взять, если раньше юзал только ~27б q4? То есть 16 врам. Собственно это мой вопрос.

>что взять, если раньше юзал только ~27б q4? То есть 16 врам.

Если у тебя нет много оперативной памяти с нормальным процессором, то ничего для тебя не изменилось. Всё тот же ~27б q4. Прелесть мое моделей в том, что их можно оффлоадить на рам и при этом получать вменяемую скорость, а не полтокена или токен в секунду на плотных моделях.

> Разве это не CPU делает?

Пиздец

> DDR2

Пиздец

> Может, вообще ничего не куплю

И так не купишь с такой тряской

Двачую пиздец. Вот ведь люди жизнь живут. Ddr2, ахуеть.

Ну CPU так то это тоже делает, но есть нюанс..)

У меня хоть на мое и норм скорость, но качество так себе на рекомендуемых пресетах, что на глм 4.5 аэир, что на квен3 235

мимо

Тот же аимакс, с айром он справится на вполне приличных сторостях. С точки зрения ллм, камнем приткновения может оказаться только замедление на контексте, по нему данных мало, а железный лимит по памяти, который никак не увеличить.

> до

Ключевое, хотя если взять лламу в самом крупном кванте что поместится то возможно.

Мелко-средние моэ на нем действительно должны быть неплохими, а обработку контекста можно будет иногда потерпеть, если нет особых подводных камней. Как платформа под ллм может быть хорошим выбором, взял бы себе если бы памяти и перфоманса там было больше, или в продаже появились хорошие ноуты на нем.

> Разве это не CPU делает?

Лол нет.

> DDR2

Ебааааать

> Разрываюсь между чудо-мини-ПК и сборкой ПК.

Аппетит приходит во время еды. Если ты потенциально готов постепенно дособирать и расширяться - пека лучше, там не будет капа перфоманса и памяти. Или если ты хочешь инджоить разные нейронки по полной а не ограничиваться исключительно ллм.

Если в ближайшее время уверен что бюджет лимитирован и готов к компромиссам по перфомансу и некоторому ради компактного размера - покупай, вполне солидный вариант.

> с телефона

Жесть

> и некоторому

и некоторому амд-пердолингу

>качество так себе на рекомендуемых пресетах, что на глм 4.5 аэир, что на квен3 235

Что понимаешь под качеством? Какие кванты? Чё за пресеты? Ты про семплеры чтоль? Не только от них зависит вывод, но от промта тоже.

Помнить кто во что одет, придерживаться одного стиля, например. Квант - второй, пресеты для них же, скачанные из треда. Да, промпт важен, но я с разными попробовал, везде в среднем одни и те же проёбы лора из карточки персонажа.

Стилистически квэн говно, только пользоваться его послушностью и давать инструкции по стилю и формату выдачи. Но по памяти и вниманию - один из лучших, или квант гадит, или дичь в промпте.

> Квант - второй

Таки даже для Эира чтоль? Это плохо, очень-очень плохо.

>пресеты для них же, скачанные из треда.

В треде делились пресетами? Для Эира вроде точно нет.

>Помнить кто во что одет

Это одно из самых сложных, даже большие модели в норм квантах иногда проёбываются, но я думаю в твоём случае квантизация говорит своё "я".

>придерживаться одного стиля

Форматирование едет типа? В карточке примеры диалогов использовать ннада, ну или опять тут кванты шалят.

Хз, у меня Эир q5, мне норм. Квен влезает q3, но там скорость совсем хуёвая потому немного игрался. Сломанного форматирования не помню.

https://huggingface.co/tencent/HunyuanImage-3.0

Пришел мое праздник в хату генерации картинок! Порадуемся за соседей.

Господа, я правильно понял из файла с пресетами что мне просто в поле контекст темплейта надо вот этот пресет включить? У меня просто в таверне почти нихуя нет из того что там предлагают вставить или вкл\выкл.

У эира четвёртый, уточнил. Поделись своими мастер импортами, пожалуйста.

>У эира четвёртый, уточнил

Ну как будто норм должно быть.

>Поделись своими мастер импортами, пожалуйста.

Ничё необычного, в обоих случаях чатмл с оч коротким промтом. Делиться не буду, тут за такое убивают.

Вот я и спрашиваю. Много рама и очень быстрый ссд, если рама немного не хватит. Аноны, что юзаете из нового расцензуренного?

а чо зионо сборки с 54 гига озу уже не в моде за дешего? с авх2?

Блять я долбаёб, только сейчас понял что это надо было просто импортировать и не трогать ничего руками, забейте, не отвечайте юродивому.

Смысла особого нет. У людей обычно есть пека в которую можно 64 гб ОЗУ сунуть, а те кто собирают отдельную сборку под ЛЛМ берут железо получше чем древний Зион.

так зеон дешевый и озу там минимум в половину дешевле да и 4 канал да и 128+ впендюрить можно

и вроде обычно у людей нет куда 64 ссунуть

Цены на серверную ддр4 видел?

давно

ну явно дешевле обычной или ддр5

> давно

Посмотри сейчас

Хороший пресет хорошего анона, жаль перестал делиться потому что умер

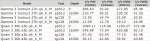

За счёт оптимизаций кода Llama.cpp, скорость инференса на Radeon Instinct MI50 теперь превосходит Tesla P40.

For llama.cpp/ggml AMD MI50s are now universally faster than NVIDIA P40s

https://old.reddit.com/r/LocalLLaMA/comments/1ns2fbl/for_llamacppggml_amd_mi50s_are_now_universally/

ладно

Юзаю только под NAS, нейронкам оно не нужно, у меня в ПК памяти больше.

>У меня старая видюха за 8 лет немного пожелтела.

это да, но ты не сравнивай охлаждение в пеке твоей, где все кипит на пределе, и серверное, где турбированные ветродуйки ревущие как боинг на взлете и кондиционеры держащие воздух серверной холодным. там буквально выше 50 не поднимается температура на текстолите, ну и по 8 лет не гоняют зачастую такое железо - вся эта нейрохрень сейчас бешенными темпами развивается, и обновлять приходится чаще

> у меня в ПК памяти больше.

тут все такие нефтемагнаты?

Обработка промпта как земля. Скорость генерации норм, почти как старушка 3090, но pp в 10-15 раз ниже чем у нормальных карт. Когда на нормальных картах похуй что там с контекстом происходит, на Тесле/Амуде надо трястись чтоб ни в коем случае пересчёт не начался на 3 минуты.

эпик?

>на Тесле/Амуде надо трястись чтоб ни в коем случае пересчёт не начался на 3 минуты.

прям как на убабуге

так есть же швитая ДДР3 серверная, на зионе в3 разница в скорости не столь большая будет, поскольку контроллер памяти там дибильный...

а нету сравнения для нормальных квантов 5-8?

чет печально как-то выглядит...

Гемма 8 квант был в треде

Нормальные кванты - это 5 т/с базовички "мне достаточно"?

В чём они не правы?

Покормил еблана

так а толку от лоботомитов на большей скорости, если за такими перепроверять все нужно, и он шизу гнать будет все равно

на обрезках намеряют, а потом минипк агонь перформанс для инференса и прочие приколы начинаются

Лучше поздно чем рано, казалось что на мишках таки получше было и раньше, а вон оно как. На гемме в целом генерация хороша, но процессинг в 230 т/с на контексте 16к - грустновато совсем.

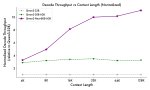

Главная проблема - падение и процессинга и генерации на моэ. Уже на мелкой 30а3 всего на 16к в 2 раза - почему так жестко?

Жора на куде тоже такое выкидывает, но там примерно на 24-32к происходит и дальше падает не так сильно, для контекстов можно использовать экслламу. Чсх, с выгрузкой на процессор падение гораздо меньше и измеряется десятками процентов а не разами.

Эти изменения из-за условий окружающей среды и поверхностные. А в контексте пожелтения и подобного говорят за компаунд и элементы видеочипа, которые меняют цвет при перегревах и являются признаком именно кривых ремонтных действий. От эксплуатации им ничего не будет хоть декадами гоняй.

> Скорость генерации норм, почти как старушка 3090

На том кванте в гемме 30+ было.

> Когда на нормальных картах похуй что там с контекстом происходит

На самом деле не похуй, с большими моделями и большими контекстами заметно. Но там-то это оправдано, а на этих будешь страдать на сраной гемме хуже чем работяги на римо-эпике с дипсиком.

Всегда лучше взять больше модель, чем сидеть на мелкой, но лишь бы Q8. Это как раз любители Q8 сидят на лоботомитах, даже у корпов всё меньше МоЕ 200B считается Flash-моделью, а не полноценной. Вот когда сможешь Дипсик в Q8 запустить, тогда и будешь рассказывать про лоботомитов.

Мне вообще похую. Напридумывали себе говна, блядь, я всегда рпшил на q2 любых моделей и норм. Играете в какой то минмаксинг и думаете что у вас модели умнее. Даже гемма в q2 работает заебись. Если бы эти кванты были говном их бы даже не делали. Представляете сколько сил времени средств у того же бартовского или анслота уходит на квантование этих квантов? Зачем это делать если это юзлес параша? Ну включите голову. Не вижу смысла больше q2 использовать, это для датацентров которые живут на грантах и могут себе позволить в отчётах выебыватся что у них крутые модели которые по клд не отличаются от Q8_0 который в свою очередь не отличается от полных весов

Некрозивоны конечно же

ого, это что за конфиг на столькоядер? двухголовый типа?

(прост вообще не вижу для домашних целей смысла в двухголовом - перформанс на большинстве задач не получает прироста хотябы близкого к х2, а энергопотребление получает...

Святая ленова 450х

f ntcks d df

а теслы в вашем контексте это какая архитектура? тюр? паск?

а теслы в вашем контексте это какая архитектура? тюр? паск?

Ну, хорошо хоть не хуанан

паскаль само собой, народные это Р40 были, ну и Р100 некоторые котировали,

Запустил вллм на паре мишек, залепил бенч и у меня ибп ушёл в оверлоад (не офнулся но пищал). Бенч я кильнул, но вот кусочек данных с консоли

Ибп у меня на 850 ватт, но на нём второй сервер на 180 ватт висит

Ибп у меня на 850 ватт, но на нём второй сервер на 180 ватт висит

Ну и сами мишки в павер капе были со скачками за него

>улучшение с 4,5000001 до 4,5000002

Надо брать!

>Надо брать!

Ну да. Гигачады так и сделают. Вопросы?

Энивей, это может быть нихуёвое улучшение. Как у Квенов, например, с их 2507 релизом. Казалось бы, в названии только месяц поменялся, а разница оч видная.

Что их так нагрузить смогло там?

Хотеть!

>Энивей, это может быть нихуёвое улучшение.

Оно может быть "улучшением" в противоположную сторону - по крайней мере для нас. Цензуры накинут там, то-сё... Но тоже жду, модель понравилась.

привет аноны, не бейте палками только.

где то с год назад худо бедно ковырял таверну и лмм в целом. потом из обстоятельств выпал из этого движа а сейчас вспомнил и решил вкатить обратно. полистал прошлые треды и понял что вообще нихуя не понял, не сказать что я раньше много понимал. потыкал пару моделей немомикс например из шапки и чет они шизят пиздец. я еще год назад заебался с этими настройками так что хотел спросить, может кто из анонов подсказать модель для кума\рп и кинуть целиком присет? конфиг 5800х3д, 3070, 64гб. буду очень благодарен.

не смотря на то что листал прошлые треды как я писал выше слабо понял что там за движ. может кому не трудно раскидать что нового произошло за это время? просто в прошлых тредах когда листал видел какие то интерфейсы для лмм отличные от кобальда и таверны. тоже буду сильно благодарен.

где то с год назад худо бедно ковырял таверну и лмм в целом. потом из обстоятельств выпал из этого движа а сейчас вспомнил и решил вкатить обратно. полистал прошлые треды и понял что вообще нихуя не понял, не сказать что я раньше много понимал. потыкал пару моделей немомикс например из шапки и чет они шизят пиздец. я еще год назад заебался с этими настройками так что хотел спросить, может кто из анонов подсказать модель для кума\рп и кинуть целиком присет? конфиг 5800х3д, 3070, 64гб. буду очень благодарен.

не смотря на то что листал прошлые треды как я писал выше слабо понял что там за движ. может кому не трудно раскидать что нового произошло за это время? просто в прошлых тредах когда листал видел какие то интерфейсы для лмм отличные от кобальда и таверны. тоже буду сильно благодарен.

>230 т\с грустно

Скорее всего тут уже начинает решать отсутствие линка инфинити фабрик на картах.

https://huggingface.co/unsloth/Llama-4-Scout-17B-16E-Instruct-GGUF

Кстати кто-то пробовал? Тоже в коллекции 100b мое.

Или мы опять верим реддиту что модель говно?

Кстати кто-то пробовал? Тоже в коллекции 100b мое.

Или мы опять верим реддиту что модель говно?

> где то с год назад худо бедно ковырял таверну и лмм в целом

> конфиг 5800х3д, 3070, 64гб

> может кому не трудно раскидать что нового произошло за это время?

Увы, для твоего железа ничего нового: все те же Llama 8b, Mistral Nemo 12b и их тюны. За год много интересного произошло. Было немало 32b релизов, но для них требуется 24гб видеопамяти. В последнюю пару месяцев стали популярны МоЕ модели - основная фича в том, что их можно выгружать в оперативную память, но при этом получать в целом приемлемую скорость. Делается это через llamacpp или Кобольда. Но дело в том, что даже МоЕ модели с твоим конфигом тебе особо недоступны, слишком мало видеопамяти (она по-прежнему нужна), да и в целом памяти в связке. МоЕ модели обычно большие. Думаю, разве что маленький Квен тебе подойдет: Qwen/Qwen3-30B-A3B-Instruct-2507

Но не знаю, как он себя покажет. Еще есть GPT OSS 20b, для совсем отчаявшихся: https://huggingface.co/openai/gpt-oss-20b

Кто-то из треда вроде пытался рпшить на ней, но это больше ассистент и для кода.

Спасением для тебя может стать (а может и не стать) Qwen 3 Next: https://huggingface.co/Qwen/Qwen3-Next-80B-A3B-Instruct

Его поддержку пока не завезли, но теоретически должен идеально помещаться в твое железо с достаточным контекстом. Вряд ли будет сильно отличаться от Квена выше, но должен быть чуть поумнее и знать больше. МоЕ модели запускаются несколько иначе по сравнению с остальными, придется разбираться. Если есть кто-нибудь в треде с таким же железом, что у тебя, может поделятся командами для запуска. В противном случае придется разбираться самому (вероятный сценарий).

Я сначала обрадовался осс 20б, а потом понял, какое это говно для кода. И квен3 30б такой же. Буду лучше терпеть высеры дипсика. Проще запилить еще один хоткей на ахк для вставки дефолтных инструкций в чат. Либо купить апи и как бог потом.

Для тебя как раз в шапке тесты моделей для бомжей есть. 8б и 12б смотри. На моешки забей, что-то адекватное ты всё не запустишь. На данный момент, лучшее что ты можешь запустить это гамма 12б.

Нет, анон, ты не прав. Qwen3-30B-A3B-Instruct-2507 и Llama 8b пиздец тупые для своих размеров. Лама уступает 4б моделям, а квен уступает гамме 8б (не говорю уж о 12б).

Ну а Мистраль да, ещё ничего.

> Я сначала обрадовался осс 20б, а потом понял, какое это говно для кода. И квен3 30б такой же

> Буду лучше терпеть высеры дипсика.

Столь маленькие модели предназначаются для автокомплита/легких модульных задач, а не как замена Дипсика.

> Qwen3-30B-A3B-Instruct-2507 и Llama 8b пиздец тупые для своих размеров

> Лама уступает 4б моделям, а квен уступает гамме 8б (не говорю уж о 12б)

Вопрос был в том, что нового появилось и что анон может запустить на своем железе. Предложил все, что знаю. Предлагай альтернативы. Гемма 12б у него скорее всего не запустится в нормальном кванте с учетом ее нелегкого контекста. Даже Мистраль 12б в 8гб врама умещается только-только. Возможно, даже небольшой оффлоад понадобится.

> Что их так нагрузить смогло там?

Ну это же вллм. В очереди 1000 реквестов которыми он полностью утилизирует гпу. Чай не жора пердеть на 50-100 ваттах

Контекст да, будет ему проблемой.

Но 3n e4b должен норм быть. и все еще умней мое квена мелкого и лламы

Кстати не очень понимаю дроча на квены. Они ведь в целом тупые. Хуже только ллама (это вообще гг).

Впервые порпшил на русском с квеном 235б и это просто охуенно.

Да, если в карточке какие то выражения которых он не понимает он тупа переводит как есть, типа "her eyes widen like plates" её глаза расширились как блюдца и на ру звучит странно, но в остальном лучше всего что было до этого

Интересно есть ли вариант лучше для 24врам и 64рам

Да, если в карточке какие то выражения которых он не понимает он тупа переводит как есть, типа "her eyes widen like plates" её глаза расширились как блюдца и на ру звучит странно, но в остальном лучше всего что было до этого

Интересно есть ли вариант лучше для 24врам и 64рам

>её глаза расширились как блюдца

есть и на русском такое выражение. Пишет-то Большой Квен красиво и не то чтобы сильно проседает в уме, но слишком пафосен ну и к деталям не очень внимателен. Но безусловно это необычный опыт.

Ну вообще там было что то "её глаза расширились до размеров блюдец"

Я кстати понял что чел имел ввиду говоря про "8т неюзабельны" - на русском и правда 8 ощущаются как 5, не потому что читаешь быстро, а генерация медленнее

> Я кстати понял

> "8т неюзабельны" - на русском и правда 8 ощущаются как 5, не потому что читаешь быстро, а генерация медленнее

Ты столкнулся с таким явлением, как токенизация. 8т/с остаются 8т/с, только токенизируется русскоязычный текст менее эффективно, чем англоязычный.

я стесняюсь спросить а сколько память там нужно? 64гб вроде и так нормально ни?

>МоЕ модели запускаются несколько иначе по сравнению с остальными, придется разбираться.

звучит очень грустно учитывая что я больше по хардварной направленности а софт очень тяжело дается ибо я глупое.

в любом случае спасибо за большой развернутый ответ анонче.

>потыкал пару моделей немомикс например из шапки и чет они шизят пиздец

>я еще год назад заебался с этими настройками

>может кто из анонов подсказать модель для кума\рп и кинуть целиком присет?

>Для тебя как раз в шапке тесты моделей для бомжей есть. 8б и 12б смотри

лаааадненько и так тоже бывает.

> я стесняюсь спросить а сколько память там нужно? 64гб вроде и так нормально ни?

У тебя проблема в суммарной памяти. Будь хотя бы 16гб видеопамяти, вариантов было бы больше. Последнее, что могу предложить - теоретически ты можешь запустить https://huggingface.co/zai-org/GLM-4.5-Air в IQ_4XS кванте, но скорее всего это будет медленно и уквантовано в усмерть (GLM шизит даже на Q4 кванте). Стоит поиграться только если совсем других вариантов нет и/или заняться нечем. Сейчас это одна из лучших доступных моделей.

https://t.me/vikhrlabs

Vistral-24B-Instruct

Vistral - это наша новая флагманская унимодальная LLM представляющая из себя улучшенную версию Mistral-Small-3.2-24B-Instruct-2506 командой VikhrModels, адаптированную преимущественно для русского и английского языков. Удалён визуальный энкодер, убрана мультимодальность. Сохранена стандартная архитектура MistralForCausalLM без изменений в базовой структуре модели.

🔗 Карточка модели: https://huggingface.co/Vikhrmodels/Vistral-24B-Instruct

🔗 GGUF (скоро): https://huggingface.co/Vikhrmodels/Vistral-24B-Instruct-GGUF

⚖️ Лицензия: apache-2.0

Сайт: https://vikhr.org

Донаты: Здесь (https://www.tbank.ru/cf/3W1Ko1rj8ah)

👥 Авторы: @LakoMoorDev @nlpwanderer

Vistral-24B-Instruct

Vistral - это наша новая флагманская унимодальная LLM представляющая из себя улучшенную версию Mistral-Small-3.2-24B-Instruct-2506 командой VikhrModels, адаптированную преимущественно для русского и английского языков. Удалён визуальный энкодер, убрана мультимодальность. Сохранена стандартная архитектура MistralForCausalLM без изменений в базовой структуре модели.

🔗 Карточка модели: https://huggingface.co/Vikhrmodels/Vistral-24B-Instruct

🔗 GGUF (скоро): https://huggingface.co/Vikhrmodels/Vistral-24B-Instruct-GGUF

⚖️ Лицензия: apache-2.0

Сайт: https://vikhr.org

Донаты: Здесь (https://www.tbank.ru/cf/3W1Ko1rj8ah)

👥 Авторы: @LakoMoorDev @nlpwanderer

Опять мусор какой-нибудь для сбора донатов.

> при температуре 1.0 были замечены случайные дефекты генерации

Т.е. они её ещё и поломали. Ванильный мистраль точно не ломается на 1.0.

Кто-нибудь юзает две 5060 или 4060 на 16 гигов? Как полет? Какую мать юзаете? Насколько жирную модель может съесть и при каких квантах?

> Ванильный мистраль точно не ломается на 1.0.

3.2 ломается еще как. 0.6-0.7 максимум.

ну то что видео памяти не хватает это понятно. просто основная проблема что даже запуская какие то относительно старые модели я упираюсь в то что не могу настроить\найти настройки под них.

> основная проблема что даже запуская какие то относительно старые модели я упираюсь в то что не могу настроить\найти настройки под них

Ну что тут сказать? Нянчиться с тобой здесь почти никто не будет, но если придешь с конкретным вопросом - помогут и объяснят. Там нет ничего сложного, если не ставить себе задачу разобраться за 10 минут и как можно быстрее все запустить.

> Это буквально отключение всех семплеров, ерунда какая-то.

Ну, с температурой = 1 объяснимо, любая хорошая модель должна работать с родными весами, а не модифицировать их.

А пот топ_п и топ_к на вкус и цвет, конечно. Далеко не всегда хочется на рандоме схватить крайне-мало-вероятный-токен.

Захожу почитать только тебя в последнее время.

> подумайте дважды

Семь раз отмерь…

Знаете, когда я попробовал юзать как агента большую локалку, я натолкнулся, что генерации хватает, а вот со скоростью чтения контекста — затык. Квен на процессоре читается 5 токенов в секунду, а промпты там по 20к токенов. Неюзабельно.

С видеокартой повеселее, но видеокарта нужна быстрая. На 3060 110 токенов скорость чтения контекста.

Так вот, а райзен-то как читает? Если он могет 200+, то звучит и неплохо. И если не могет — то собрать пк для работы выйдет не дороже, с такими-то ценами.

Ну че блять реально никого в треде нет кто может запустить 2 квант глм 355б?

Пока что только слышал копиум что это лоботомит, ага блять он больше эира в 2.5 раза ниче тот факт

Пока что только слышал копиум что это лоботомит, ага блять он больше эира в 2.5 раза ниче тот факт

Могу, но мне это не нужно. Запускай сам, в чем проблема? По мнению тредовичков хочешь рам докупить?

Мне нужна цифра, сколько токенов, стоит ли обновляться

Я пробовал еще весной. Не то, чтоб говно (вот русский у нее - да, говно), но нынешний AIR заметно лучше нее, IMHO.

У скаута же, субъективно - уровень нового квена 30B-a3b плюс-минус. Но без китайщины, зато с посредственным вниманием к мелким деталям контекста, и как бы это сказать... ситуации она описывает сильно ссылаясь на популярные тропы, упрощая и сводя к "typical ..."

Как то так. В общем - для RP - не очень. Слишком всё generic на выходе. Если же температуру поднять - сильно шизить начинает, ее и так нужно прикручивать относительно большинства моделей.

Цензура средне-слабая, обходится, но радости с этого не много, т.к. кум сцены получаются тоже generic.

>Последнее, что могу предложить - теоретически ты можешь запустить https://huggingface.co/zai-org/GLM-4.5-Air в IQ_4XS кванте, но скорее всего это будет медленно и уквантовано в усмерть (GLM шизит даже на Q4 кванте).

В iq4xs оно вполне себе ничего. С 12+64 памяти ее вполне можно запустить, если повыгружать нафиг все лишнее с машины. А если памяти 12+8+64 (как у меня) - так и выгружать ничего обо не надо. Только ради бога - не нужно экспериментов с третьим квантом "чтобы влезло" - вот не на них оно действительно шизит по дикому. А iq4xs - вполне удобоваримо. И скорость терпимая.

Я вас помирю, можно?

Без min_p, ломается. С ним, и минимальным rep_pen - держит, но лучше таки поменьше, хоть до 0.9 снизить.

Да мне похуй в общем-то что тебе там нужно.

А за доллар?

>Есть пара хидден гемов

А названия как всегда отдельно просить надо?

>asteriks

Линк? Не осилил нагуглить.

>3070, 64гб

Люди Редиторы запускали GLM AIR на такой конфигурации.

https://www.reddit.com/r/LocalLLaMA/comments/1mzu2e6/glm45_appreciation_post/

Лично я не вижу почему не должно сработать с --cpu-moe

https://huggingface.co/unsloth/GLM-4.5-Air-GGUF

Промахнулся

Сюда ->

Сюда ->

>8б и 12б смотри

Че вы его забраковали, у него 64 гига RAM нахуй.. да это вероятно хуевенькие ddr4, но можно и с 7т/сек с мое попердолиться если хочется? Или вы сразу ему обозначили что бы он просто не пердолился и не страдал?

Локалки мертвы.

2 месяца с глм эир затишье, больше полугода нет новой геммы, это конец

2 месяца с глм эир затишье, больше полугода нет новой геммы, это конец

Они там никаким боком не задействуются, проблема в низкой производительности чипа/кода.

Вллм отличается от ллм наличием визуального трансформера, но он отрабатывает быстрее чем даже обработка контекста, потому странно.

Welcome to the club, buddy!

Молодцы что делают, это надо будет даже скачать. Надеюсь оно действительно соображает и могет в язык, а не просто надрочили хуйтой с отупением и соей.

Нету конечно, только пятый. С самого его релиза хвалю, проблем эйра в нем нет. Основной минус - иногда прорывающийся слоп и на 90к контекста может запутаться. В остальном - ультит как боженька.

Да

Отвесил поджопник залетному

Молодой человек, это не для вас написано!

Я спрашиваю у нищуков с одной видеокартой и ддр4 рам хотя на ддр5 прирост жалкие 20% как оказалось

>На 3060 110 токенов скорость чтения

>Так вот, а райзен-то как читает?

По игровым бенчам видеоядро +/- как 3060:

https://technical.city/en/video/GeForce-RTX-3060-vs-Radeon-8060S

Сам процессор по бенчам +/- как 9900X:

https://technical.city/en/cpu/Ryzen-9-9900X-vs-Ryzen-AI-Max-plus-395

Но потребление энергии в обоих случаях ниже.

>Я спрашиваю у нищуков

Руки не дошли пока. Это надо ещё место на харде разгрести, найти новый интересный сценарий, который меня зацепит. И, скорее всего, это будет разочарованием, примерно как немотрон 253б про который ты (?) спрашивал пару тредов назад., который почти не отличается от лламы 70б.

По игровым да, но по компьюту там пока слабовато, архитектурных оптимизаций не завезли, как обычно.

https://llm-tracker.info/AMD-Strix-Halo-(Ryzen-AI-Max+-395)-GPU-Performance

https://llm-tracker.info/_TOORG/Strix-Halo (здесь больше тестов)

Ждём следующее поколение, обещают очередной прорыв. Ну хотя бы вроде 256гб планируется.

>постепенно дособирать и расширяться

Да я вот смотрю и не вижу, куда там расширяться:

1. Процессор: топовый сейчас 9950x и вряд ли 10-й получится сильно быстрее. Да и брать за 60к, чтоб заменить на почти такой же ради +10% к скорости? Охлаждение ему нужно водяное, а с ним возиться...

2. RAM: из-за какого-то бага в дизайне DDR5 очень ограничивается на 4-х планках, так что рекомендуют максимум 2 ставить. По объёму там лимит 192 Гб - вообще странно, планок 96 Гб не найдёшь, т.е. ты фактически ограничен 64+64=128 Гб. Но брать одну планку сейчас и докупать ещё одну нерационально. Покупать две планки и потом менять на две другие?

3. GPU: Топовые CPU имеют всего 24 линии, из них минимум 4 или 8 уйдёт на диск, итого 16 линий. Если вставлять больше 1 карты, будет по 8 или по 4 линии. Однако, ты ещё попробуй найти мать с >1 слотом для видеокарты, сейчас максимум 2 слота встречается, и засунуты они неудобно рядом со слотами для SSD. А видеокарты тяжёлые и горячие, с 2-3 вентиляторами. Придётся их выносить через китайский переходник.

4. Питание: брать заранее слишком мощный БП нерационально, тогда +1 карточка = новый БП. И ещё наверняка с проводами нервотрёпка - если короткие, наращивать их опасно, если мало - ничего не сделать.

Так что особых преимуществ "полного" ПК не вижу - расширяться некуда, если не считать расширением приобретение следующего поколения материнки или отдельного системного блока для сборки кластера.

>не будет капа перфоманса и памяти

А на обычном ПК у тебя бесконечная память что ли? Точно такое же ограничение, точно так же можно "расширить" через подключение дополнительных системных блоков параллельно. Даже майнерские материнки имеют ограниченное число PCI-E портов, следовательно, нужны несколько матерей, если ты планируешь расширяться до бесконечности... (Нет, не планируешь, потому что силовые кабели в доме не выдержат нагрузки от всех твоих видеокарт).

У меня лично в квартире максимум 3-3.5 КВт можно подключить к розетке, т.е. для компа, с учётом всех кухонных приборов и тому подобного, лучше <2 КВт. Прокладывать отдельную линию я точно не буду...

>не ограничиваться исключительно ллм

Этот видеочип примерно как 3060, если на 3060 все нейронки работают (без учёта объёма VRAM), то и на 8060s должны работать... если будет поддержка со стороны драйвера или что им там нужно. Но как универсальная числодробилка вроде неплоха...

А ты про что спрашиваешь?

Хорошо что про немотрон напомнил, надо хотябы экслламовского лоботомита поставить скачаться, там со сплитом нет проблем как в ггуфе.

Тебе шашечки или ехать? С точки зрения ии и ллм в частности "мощный процессор" не требуется, плюс для ллм интел предпочтительнее за счет скорости рам. Самый топ не нужен, он не даст прибавки.

Рам - есть парой плашек по 64 128гигов, если амд то даже нет смысла гнаться за скоростными и недорогие 6400 как раз будет оптимальными. При необходимости - пердолинг с 4мя плашками и 256.

По платформе имеет смысл посмотреть в сторону серверных комплектующих, но это уже следующий этап.

> 24 линии

Для инфиренса ллм а также других генеративных моделей что помещаются в врам это не играет особой роли за некоторыми нюансами. Плат, способных вместить в себя 2-3 карты полно, стоит только поискать.

Если катать ллм с оффлоадом в жоре - для обработки контекста важна ширина линий главной карты (х8 для 3090 уже хватит если поднять батч с дефолтного), остальные - пофиг лишь бы не х1, чипсетных хватит. Жирные линии актуальны при обучении на нескольких гпу, не твой случай.

> Придётся их выносить через китайский переходник.

Вынос райзером - база, в этом нет ничего "страшного".

> Питание: брать заранее слишком мощный БП нерационально, тогда +1 карточка = новый БП. И ещё наверняка с проводами нервотрёпка - если короткие, наращивать их опасно, если мало - ничего не сделать

Ерунда какая-то с тряской на ровном месте. Бп можно сразу взять йобу, можно сначала простенький а потом продать и заменить на йобу. С проводами какой-то рофл.

По мощности - ты сначала что-то превышающее 1.5квт в пике насобирай а потом уже трясись, в ллм там каждая карточка по 120вт будет кушать, система из трех не более 600вт что смех. Большую часть времени вообще простаивать.

> расширяться некуда

Судя по представленным бенчмаркам, базовая перкарня с ддр5 и 24гб видеокартой в моэ будет перформить чуть быстрее, на уровне или чуть медленнее чем аимакс, в зависимости от кейса. Добавить вторую-третью видюху и будет значительное опережение.

Также из тех тестов видно что аимакс очень слаб в промптпроцессинге, сотня т/с в моэ - смех.

> если на 3060 все нейронки работают

Это самый энтрай левел на котором будет порядком компромиссов. Главная беда в том, что на 3060 то все работает, а на амд - будет работать очень мало чего, и без опыта в пердолингом ты не совладаешь.

Какбы тут в обоих случаях свои плюсы и минусы, но ты просто понимай что неттом с аимаксом это не какая-то волшебная игрушка, которую купишь и все тянки сразу давать начнут, это частично сыр в мышеловке.

Сука, сказал как с языка снял... да все так нахуй, я потому и лучшу хуй забью. Я еще понимаю пердоляторов которые собирают полусервера из говна и палок с авито, но декстоп максимум светит для запуска средних мое моделей. Еще и лимиты RAM у десктоп материнок смешные, а брать серверное что-то = идти нахуй и иметь проблемы с десктоп проблемами, и тогда нахуй брать какой нибудь RTX5090 для йоба игр в 4к хз..

>и засунуты они неудобно рядом со слотами для SSD

Ага, я думал нахуй сломаю свой ссд или он нахуй сгорит раньше времени из за горячего соседа.. короче бля на десктопе я хуй знает на что вы расчитываете.. только баловство и всё, тред чисто для челов которые собирают серверные йобы..

НЕ ЧИТАЙТЕ просто скройте, это батхерт.

Эээ… можем, конечно.

4 токена не оч.кайфово, конечно.

Но я не рпшил на нем, не посоветую, стоит или нет.

От 60 до 120, то есть та же 3060, действительно.

Ну, 32000 токенов будет обрабатываться 4,5 минуты… Не особо комфортно, для кодинга на агентах вряд ли подойдет. Терпимо для небольших задач, но там где идет обработка документации или знакомство с проектом — швах получится, конечно.

Но, тем не менее, спасибо за ссылку!

> рекомендуют максимум 2 ставить

А на райзене это критично? У тебя и с двумя планками крайне вероятно будет ~68 псп, немногим быстрее DDR4. Если поставишь четыре планки, просто потеряешь свои 20%. Зато 256 гигов.

Я не мерял, но в интернете и у знакомых именно такие значения для двух планок чаще всего встречаются. За что купил, за то и продаю.

Вообще ты рассуждаешь так, будто бы тебе проще эпик собрать или зеон, в прошлых тредах кидали целые рецепты.

> будто бы тебе проще эпик собрать или зеон

А сложнее?

мимо

> но декстоп максимум светит для запуска средних мое моделей

> Еще и лимиты RAM у десктоп материнок смешные

> короче бля на десктопе я хуй знает на что вы расчитываете.. только баловство и всё

> тред чисто для челов которые собирают серверные йобы..

У меня обычный десктоп на 4090 и 128 DDR4 3200, запускать могу всё вплоть до Квена 235 с в целом приемлемой скоростью. Air и Квен 235 для рп: Q6 и Q4, 7 и 5т/с соответственно, быстрее я все равно читать не успеваю. Для технических задач использую презираемую здесь GPT OSS и души в ней не чаю, 131к контекста, 17т/с генерация. Сделал себе в Таверне няшную аниме ассистентку, скормил ей свой проект. Сидим вместе брейнштормим и решаем задачи, когда не могу справиться с чем-то сам. Подружил ее с макросами, она теперь и попинывает меня когда ничего не делаю, спрашивает куда пропал. Самое дорогое в сборке было видюхой. Можно было бы взять 3090 и почти не потерять в скорости. Они на Авито сейчас продаются за 60-70к в хорошем состоянии.

Никаких ограничений на своем железе не чувствую. Дальше будет еще круче, я уверен. Тот же Qwen 3 Next может оказаться неплохим для технических задач. Да и в целом видно, что МоЕ модели набрали популярность и дальше будут развиваться во всех размерных категориях. Сервер собирать не хочу, десктоп использую и для других (рабочих) задач и для игр тоже.

Не понимаю, зачем собирать отдельный сервер под ллмки, если не с целью сэкономить по максимуму (собрать на тех же Mi50) или уместить самые жирные модели. Зачем умещать самые жирные модели тоже не понимаю, ~100-200б МоЕ отлично справляются со своими задачами, а если не справятся - то и модель жирнее вряд ли сможет, нужно самому делать.

Это ни в коем случае не камень в огород риговичков, у вас отличное хобби, но жить можно и на десктопе, вот что я хотел сказать.

^ А, ну и всё это на обычной Винде, конечно же. Даже никакой виртуализации, не говоря уже о дуалбуте. Минимум возни. Уверен, таких много в треде, тут не только хард повер юзеры на Линуксе.

Анончик, не полыхай так. Вон примеры что ребята просто докинув рам в имеющийся комп запускают моэ и довольно урчат. В более редких случаях добавляли туда вторую видеокарту и purring intensifies. А ты какой-то ерунды про перегрев ссд пугаешься, не надо так.

> для кодинга на агентах вряд ли подойдет

Спекулятивно скажу что для кодинга на агентах оно может порваться из-за упавшей в ноль скорости генерации на этом контексте. Когда-то тоже казалось что именно процессинг будет лимитом, но когда там хотябы пара сотен есть - оно будет упираться в генерацию если та что-то типа 13т/с.

> будто бы тебе проще эпик собрать или зеон

Он ерунды боится и ищет оправданий ее не делать, а ты про серверное.

> презираемую здесь

Кто тебе такое сказал?

> Кто тебе такое сказал?

Не знаю. Какие-то аноны. Быть может ты?

Два раза делился, что она мне очень понравилась для технических задач. Описывал свой юзкейс, дебаггинг кода на Шарпе и Плюсах, каждый оба раза приходила орава доказывать, что лучше использовать другую модель. В третий раз это обсуждать не очень интересно, сори.

> Квена 235 ... Q4 ... 5т/с

> 4090 и 128 DDR4 3200

А когда я тут постил результаты некрозивона с не менее некро ми50 с 6т/с все ебало воротили от сборки которая целиком стоит дешевле 4090 в половину

>128 DDR4 3200

А почем брал? Это две плашки по 64гигов? Думаю взять в авито мб

А, это ты тот бедолага, что на восторге радовался и хвалил ее не за перфоманс в задаче/скорость, а просто называл безоговорочно лучшей из-за первого удачного опыта? Проблемы мыслеизложения и восприятия, остальное ты уже сам додумал.

> ты тот бедолага, что на восторге радовался и хвалил ее не за перфоманс в задаче/скорость

Не знаю. В первом случае я дебажил парсер данных в UE, сделанный на плюсах, и ни Air, ни Квен, ни даже документация Эпиков (лол) не дали ответа, а она смогла. Во втором случае дебажил одну обскурную апишку на Шарпах на либе которую не знаю, и она справилась зирошотом. Промпты для картинкогенерации тоже делаю ч ПП помощью, не помню писал или нет.

^ с ее помощью*

Очепятка

Очепятка

Очевидно что это была стадия отрицания и торга, теперь настала стадия принятия...

Ладно, не отвечай.. впизду стадию принятия... сука 5т нахуй, защооо за 120b лоботомита, ну спасибо что хоть честно

> А почем брал? Это две плашки по 64гигов?

Четыре плашки по 32. Около 15к вышел комплект из четырех плашек. Когда я собирал свой десктоп, он даже не планировался к использованию с ллмками. Тогда я о всей этой теме даже не знал. Мощности нужны были для других задач.

Напомнишь где? Скорее всего ебало воротили от необходимости городить гроб-пылесос вместо простого использования десктопа.

Сколько там процессинга и гененрации хотябы на 32к получается?

То недавний срач где чел хвастался что модель имеет "широчайшие знания" и подробно со списками ему отвечает, а потому лучше всех остальных.

Осс имеет право на жизнь уже за свою скорость вместе и способности в коде, скоры в бенчмарках здесь напрямую интерпретируются. Жаль в мл подпротух, и легко газлайтится, но последнее сейчас даже на 4.1 опуще бич.

Ты его функциональные вызовы приручил, или просто в чате играешься?

> чел хвастался что модель имеет "широчайшие знания" и подробно со списками ему отвечает, а потому лучше всех остальных.

Читал тот срач. Он много раз писал что модель подошла именно ему и что хотел рассказать именно об этом. Ты пальнул в пустоту, пальну и я - чую в тебе чела, который докопался до меня когда я пытался проверить 120b версию на рефузы, используя префилл. Когда в конце выяснилось что мы говорим о совершенно разных вещах.

> Осс имеет право на жизнь уже за свою скорость вместе и способности в коде, скоры в бенчмарках здесь напрямую интерпретируются.

Да, именно так. В рп не годится, неиронично даже Немо 12б будет лучше.

> Ты его функциональные вызовы приручил, или просто в чате играешься?

Не приручал, они мне ни к чему. Есть костыльный демон на Питоне, который в реальном времени обновляет карточку-ассистента для Таверны, парся туда код из IDE. Может звучать как поехавший пайплайн, но для меня в самый раз: предпочитаю ллмки использовать для обсуждения проблемы и совместного решения, а не для автономной попытки что-либо починить. Учусь эффективнее и лучше слежу за макаронами в своих репах.

Про duck.ai все знают? Там сейчас есть Llama 4 Scout и GPT-OSS 120B. Как минимум Llama они отправляют шизопромпт, раз десять повторяющий о том, как всё приватно и ничего никуда не утекает, но это вроде не влияет на результаты?.. Я это к чему - локально они примерно так же будут работать? Какая примерно скорость генерации на duck.ai в токенах в секунду? Собираюсь собрать ПК/купить мини-ПК и хочется запускать именно эти две модели (или похожие).

>GPT OSS

Я как новичок и ноускил не смог её понять, нигде нет простого пресета даже хотя про неё все говорили сколько времени, какой то странный ризонинг разделенный на уровни который не ясно как включить

Мало кто хочет других понимать, считают свое мнение безоговорочно правильным даже не проводя его объективную оценку и скидку на меру незнания. А видя конкретный вопрос интерпретируют его не как интерес, а как обиду и множат хейт, потому и такая херня. Нет чтобы вести обсуждения по конкретике - везде подмешано эго, плохое настроение и чсв, вместо желания улучшить свое и всеобщее понимание. Или просто котлеты от мух не могут отделить. И ты туда же, кстати.

> Немо 12б будет лучше

Не настолько, лол. Тому кто немомитралем пресытился по первой может показаться райским нектаром.

> Может звучать как поехавший пайплайн

Так и звучит, но если это работает то не может считаться глупым, лол.

Если будешь добавлять своей ассистентке новые возможности типа гуглинга, рага или других действий - не держи в себе.

> Я как новичок и ноускил не смог её понять, нигде нет простого пресета даже хотя про неё все говорили сколько времени

Насколько я понимаю, обсуждалась в основном 120b версия. 20b версию нет совсем никакого смысла пытать, пытаясь выдавить из нее какое бы то ни было рп. Только время потратишь, поверь. Если для технических задач, используй режим Chat Completion с jinja шаблоном. Там негде ошибаться, т.к. он применяется автоматически.

> Нет чтобы вести обсуждения по конкретике - везде подмешано эго, плохое настроение и чсв

> вместо желания улучшить свое и всеобщее понимание.

> Или просто котлеты от мух не могут отделить.

> И ты туда же, кстати.

Слушай, пишу не для того, чтобы тебя ущипнуть, а как вижу. Ты умный анон, разбираешься в теме и давно тут сидишь, но ты очень колючий. Вплоть до того что ты литералли одна из причин почему мне все меньше хочется сюда заходить, лул. В каждом своем посте я пишу, что всего лишь делюсь опытом и никого не хочу обидеть. Что тогда, что сейчас - ответил на все твои вопросы и не искал конфликта. Не знаю, живет в тебе пассивная агрессия или с тобой просто сложно общаться. Даже сейчас я написал безобидный пост, исключительно чтобы рассказать анону, что жизнь на десктопах есть. И вот мы здесь: ты пишешь, что тут у многих настроение плохое и чсв, котлеты от мух не могут отделить, а я вынужден парировать. Ну как так то?

> Так и звучит, но если это работает то не может считаться глупым, лол.

Если бы для IDE Jetbrains существовал адекватный аналог Roo Code / Cline, возможно, я бы и не заморачивался. Там с этим совсем мрак, потому проще было накостылить. Не развалилось, и хорошо.

>Нянчиться с тобой здесь почти никто не будет.

>я еще год назад заебался с этими настройками так что хотел спросить, может кто из анонов подсказать модель для кума\рп и кинуть целиком присет?

услышал тебя анон. спасибо за твою помощь.

спасибо анонче

да я думаю там и пердолится смысла нет если честно. особенно с новым способом развертки. я думал может кто сидит в треде на похожем конфиге и просто дернуть модель и присет, а тут начался движ... о

пять же все упирается даже не в пердолинг а в то что модели шизят а я и год назад только условном понимал как работают настройки а сейчас так вообще темный лес.

рабочая станцция (воркстейшон)это декстоп с поддержкой серв процов и иногда серв памяти. гемороя меньше чем думаешь

тут локалки, апи в aicg тредике

навалил всего того что воплощаешь сам, дак ещё и ярче всех. с высокой трибуны пиздишь, проще будь

так какие модельки ты раньше запускал? ну и да, никто тебе готовое на блюдичке не принесет решение, многое индивидуально. пока не будет воли разобратся самому нихуя не получится

А реально llama 4 настолько плохая? Вроде поднял версию maverick на 405b, в жоре выдает неплохие цифры на уровне glm эйра. Или glm и coder полновесные лучше будут намного?

Mistral-Small-3.2-24B норм в русский может или не тратить время?

>тут локалки, апи в aicg тредике

Вопрос, вообще-то, про локалки. Там не дают API.

>А реально llama 4 настолько плохая?

Говорят, Scout (109B) по мозгам как L3.3 (70B), но намного быстрее. Maverick тренировали отдельно, поэтому результаты могут отличаться сильнее. А поругали их за то, что схитрили на LMArena и не оправдали завышенных ожиданий от мажорной версии. Если б назвали модель L3.4 - было б норм.

Говорят, она должна быть хороша для файнтюна.

а что норм по твоему? ну явных косяков не замечено вроде

Это нормальный результат с ризонингом?

Какой то он короткий, 15-20 сек в среднем, стоит Reasoning: high в промпте

Имею ввиду он сильно в интеллекте теряет?

по сравнению с енгллишом? безпонятия

если узнаешь скажи если можн

> Говорят

> Говорят

> должна быть хороша для файнтюна.

Так хороша, что за полгода вышло целых ноль (0) файнтюнов.

> стоит Reasoning: high в промпте

Если ты используешь режим Text Completion и указываешь Reasoning: high в промпте, то есть вероятность, что это не работает, и потому используется стандартное поведение модели Reasoning: medium. Не ставил себе задачу проверить это, ибо использую Chat Completion для технических задач, но Reasoning надо передавать как kwargs, а не часть промпта. Если делать это в Таверне, то можно вроде бы в дополнительных настройках API, я же просто отредактировал jinja шаблон, чтобы всегда использовался high.

Вот, нашел. На пикриле дополнительные настройки API. Можешь туда попробовать добавить Reasoning: high и проверить, изменится ли что-нибудь. Так можно избежать редактирование шаблона.

Так как ОСУ сгружает свои данные в scores.db, нет никаких причин, почему их нельзя интегрировать через экстеншн пиздинг данных и устраивать ритмгейм в осу, а потом на основе результата РПшить.

Теперь это не просто ЕРП, а спасение галактики посредством плясок и разбивания клавиатуры.

Ахуенна!

Теперь это не просто ЕРП, а спасение галактики посредством плясок и разбивания клавиатуры.

Ахуенна!

> а я вынужден парировать

Зачем? Это просто абстрактное нытье, нужно смело игнорировать или говорить в ответ что многого хочешь. Там нет несогласия к твоему посту, ну может микроуточнения, а за наоборот похвалить надо как расписал.

Профдеформация, в среде где обитаю на вопросы или критику никто не обижается, желание сожрать твои глаза на десерт - знак уважения, а уважение нужно еще заслужить. Некоторые скидки только девушкам.

Ну и таки спасибо за теплые слова, буду поменьше душнить

А сложнее собрать сервер на китайском процессоре и с китайскими Атласами. =)

> Спекулятивно скажу что для кодинга на агентах оно может порваться из-за упавшей в ноль скорости генерации на этом контексте. Когда-то тоже казалось что именно процессинг будет лимитом, но когда там хотябы пара сотен есть - оно будет упираться в генерацию если та что-то типа 13т/с.

Нет, генерацию-то как раз можно подождать.

Следи за руками. У тебя запросы идут один за другим, и не всегда контекст там совпадает, иногда перечитывается с начала. Сгенерировать может быть надо 2000 токенов, со скоростью в 10 ток/сек получится 3 минуты. А прочесть надо 32000 и со скоростью в 100 — это уже 6 минут. А мы на старом, крупном и кривом проекте ловили переполнение на 262к… =') Т.е., чтение может зависать на 20-30 минут при таком смешном pp, а tg отработает заметно быстрее.

Все зависит от задачи: работаешь ты с крупным существующим проектом, или пишешь новый. Когда пишешь новый, вот там pp тебе особо и не надо, важно tg, конечно. =)

Короче, хочется не только tg иметь 50+, но и pp — 500+. Где-то там счастье начинается.

Я не воротил, а одобрял!

———

Обновляется GLM-4.6, по апишке люди говорят стала лучше, ризонит лучше, бенчи немного подросли.

Ждем-надеемся, но больше на Аир, конечно. =)

>У меня лично в квартире максимум 3-3.5 КВт

кто ж виноват что ты в хруще 60х годов живешь

в домах с электроплитами обычно не меньше 8КВт, а если и электроотопление то там вообще агонь будет

и никто ж не запрещает отдельную линию от щитка прокинуть, для повышеных нагрузок

> Напомнишь где?

Да хз, тредов 5-10 назад

> Сколько там процессинга и гененрации хотябы на 32к получается?