The baze of THREADE

Главная и нерушимая база треда

Это ты анон. Используй что нравится.

Главная и нерушимая база треда

Это ты анон. Используй что нравится.

настоящий баз оф тред - мистраль говно для рпшек

В этом треде мы формируем альянс вокруг квена 235б q2_s

Выше нам не прыгнуть на консумерском железе, ниже - дно и смерть

Проблемы есть, но незначительные

Выше нам не прыгнуть на консумерском железе, ниже - дно и смерть

Проблемы есть, но незначительные

В прошлом треде предлагал попробовать первый квант глм. Никто не попробовал, зато высирают очередные тирады про квен. Фу такими быть.

Я попробовал вот буквально только что, пару свайпов

Пишет на уровне либо лучше квена q2_s, но абсолютно неюзабельно на 1.1 токена, не влезает квант в 24врам 64 рам

Как быть с контекстом? 16к улетают в момент. До тех пор пока он не заполнился задержка достаточно небольшая, но когда начинается удаление старого контекста все становится раком. Первый токен жду минут 5.

> До тех пор пока он не заполнился задержка достаточно небольшая

Потому что предыдущий контекст кешируется и не пересчитывается каждый раз.

> но когда начинается удаление старого контекста все становится раком.

> Первый токен жду минут 5.

Таверна/Кобольд вырезает самое старое сообщение, чтобы уместить новое. Т.к. контекст изменился в самом начале чата, происходит пересчет всех 16 тысяч. После того, как туда будет добавлено новое сообщение, процедура сразу же повторится при следующем, поскольку контекст уже снова заполнен. Чтобы этого избежать, нужно выгружать сообщения вручную при помощи команды /hide. Например, /hide 0-50 выгружает из контекста сообщения с 0 по 50 включительно. В чате они останутся, но в контексте их не будет.

Крч, играешь до заполнения контекста, потом суммарайз, потом делаешь как тут сказали

И вин еще в том, что ты очищаешь чат от паттернов.

Так если ты нормально второй квант квена употреблял, то почему у тебя на такого же размера глм настолько низкая скорость?

Не спеши, пока много дел, завтра попробуем.

Повышай окно до 32-64-96+

Когда подбираешься к лимиту текущего контекста, делай суммарайз части постов в глубине и скрываешь /hide их, о том как сделать в прошлых тредах. Теперь у тебя появился запас на очередные несколько десятков-сотен постов до заполнения, потом повторяешь, добавляя к суммарайзу новое и опять скрывая.

Важно делать суммарайз достаточно подробным и сохранить хотябы несколько десятков постов после него от скрытых, чтобы было гладко.

Потому что он не такого же размера.

Глм 90гб, квен 80

Запустил квен 235б Q2_K_L от бартовски, оказывается он всего на 3.5г больше интел раунд Q2_S

К бартовски доверия больше, квант "выше", надеюсь будет стабильнее

Скорость такая же абсолютно

К бартовски доверия больше, квант "выше", надеюсь будет стабильнее

Скорость такая же абсолютно

Ну вот кому ты пиздишь, а. TQ1_0 даже чуть меньше Q2_K квена. Я вангую ты взял IQ1_S, порвал себе видеокарту и говоришь, что не работает. Либо ты до этого юзал кванты бартовски у квена, но младшие там по 60 Гб, не 80.

Посмотрел, у бартовски IQ1_S вообще 77 гб. Не прыгай выше головы, епта.

Молодец, а теперь скажи, зачем тебе этот квант, если он у тебя не влезает в твой конфиг? Взять поменьше совесть не позволяет?

Понятно, благодарю. Автоматически это никак не включить?

Больше как-то не выходит. Vram 16гб, модель 11-12гб, на 8-16к контента память забивается и все зависает.

Больше как-то не выходит. Vram 16гб, модель 11-12гб, на 8-16к контента память забивается и все зависает.

А почему ты не можешь признать что оказался не прав с размерами?

Ты идиот? Первых квантов дохуя разновидностей, ты взял тот, который не влезает и жалуешься, что скорость маленькая? Блять, до чего тред докатился, а.

У тебя сколько оперативки? У меня q2_k_s еле влезает, забита вся врам и рам.

>К бартовски доверия больше

К васяну, делающему ггуфы на потоке в дефольной жоровской ламе доверия больше чем к крупнейшей корпорации производящей процессоры? У них свой собственный алгоритм квантования, кстати, который квантует в 2 бита тольтко экспертов, все остальные слои там в 8 и 4 битах.

https://github.com/intel/auto-round

Собрал и расшарил vllm под mi50, репу переделал

https://github.com/mixa3607/ML-gfx906

- vllm

- comfyui

- llama.cpp

- rocm 6.3.3/6.4.4/7.0.0

https://github.com/mixa3607/ML-gfx906

- vllm

- comfyui

- llama.cpp

- rocm 6.3.3/6.4.4/7.0.0

Действительно, у анслота на 6гб размер меньше.

Взял у убергарма под ikllama, ибо в дискорде увидел что KT кванты как-то хуево работают на обычной ламе

Еще же контекст, а он от степени заквантованности не зависит, только если его самого квантовать с вытекающими. Имея сильно ограниченную врам, даже выгружая всех экспертов на профессор на больших моделях упрешься в это, нужны дополнительные видеокарты.

Вот этого двачую, кванты от интела получше будут.

Тем временем прошло уже 3 недели, а поддержкой квен-некста в жоре так и не пахнет. На йоба соту https://huggingface.co/meituan-longcat/LongCat-Flash-Chat вообще хуй положили, надежды на полноценный парсер вызовов для квена и жлм исчезают. Оварида.

>скорость маленькая

В IQ кванте скорость by design будет еще хуже.

> К васяну, делающему ггуфы на потоке в дефольной жоровской ламе

Сейчас бы одного из самых значимых коммьюнити контрибьюторов Лламы называть васяном. Хехмда.

Ну справедливости ради, интел так то не бомжи с помойки.

Но смотря на 13 серию, я чёт сомневаюсь.

>У тебя сколько оперативки? У меня q2_k_s еле влезает, забита вся врам и рам.

Я на линуксе, 64гб

>Вот этого двачую, кванты от интела получше будут

Я с этим квантом уже наигрался

Всё же хочется ещё первый квен проверить, по первым тестам он менее хорни и как-то адекватнее общается, что для меня признак ума

А. Я убрал -ub 2048 чтобы влез контекст, в два раза медленнее пп, мне некритично

Бай хуяйн, ты голову то включай, прежде чем писать что-то похожее на умное. У него всего 88 Гб общей памяти, квант почти 90 весит, он из свопа рп-шил, смекаешь? Надеюсь, додумаешься понять, что будет быстрее - работа в свопе или штатная работа IQ квантов?

Контекст конечно есть, но я не думаю, что у ГЛМ он сильнее жрет память, чем у квена, хотя детально не замерял. Кажется, что там отклонения максимум будут гигабайт-два.

GLM-4.6-UD-TQ1_0

3090 + 64ddr4

Начало чата 4т.с

На забитом 20к контексте 3.8т.с

40pp vs 240 на квене

3090 + 64ddr4

Начало чата 4т.с

На забитом 20к контексте 3.8т.с

40pp vs 240 на квене

На будущее: https://t.me/natural_language_processing

Так Кими же инстракт, а не ризонинг.

В каких-то задачах может быть и лучше, а во всех остальных — полный слив.

Главное — правильно выбрать задачи. )

Вот интересно, на сколько.

Надо будет вечерком сравнить.

Имею 3,6 на 4к контекста на кванте от анслота UD-IQ2_M.

119 гигов Q2_K, хм…

Интересно, какая разница по качеству.

Ха-ха, ты здесь живешь, тред до этого уже с полгода назад докатился.

> крупнейшей корпорации производящей процессоры

в голосяндру!

Я уже снёс чат, однако, приведу пример.

Моё сообщение: Стою оперевшись локтем о разбитую телегу и наклоняя голову на бок указывает на неё "У тебя уши торчат."

Ответ персонажа: Он стоял у обломков обоза, его подошвы утопали в грязи в пермешку с кровью. Он медленно поднял свой палец и указал на её уши. "Твои уши приподняты как у любопытной лисицы - фенека, похоже ты почуяла что - то вкусное." А потом уже ответ чара.

Этот стиль это сугубо проблема синтии и синтвейва, им обязательно надо перееиначить и повторить твоё сообщение, иногда они могут это растянуть токенов на 50 - 100, и вопрос, нахуя? Почему мистралю не надо это делать?

>Этот стиль это сугубо проблема синтии и синтвейва, им обязательно надо перееиначить и повторить твоё сообщение, иногда они могут это растянуть токенов на 50 - 100, и вопрос, нахуя? Почему мистралю не надо это делать?

Это из нее лезет настоящая RP с сессия с донжон-мастером. В реале оно так и происходит - Мастер сначала пересказывает как часть рассказа то, что игрок ему заказал (игрок заказывает - что он хочет сделать, а Мастер отвечает - что получилось по факту).

По сути - не баг а фича. Я такого поведения специально стараюсь добиться, когда под RP промпт пишу. Мистраль, этого почти не умеет, к моему огорчению. :)

Чтобы такого не было - лучше убирать из промпта все упоминания про roleplaying session. Писать как основную установку просто что-то вида "you are X in the interactive chat with Y". Чтобы модель себя гейм-мастером не возомонила даже частично.

А сесли все равно лезет - увы. Значит в датасете было слишком много настоящего RP. Хотя можно попробовать добавить "Avoid assuming the DM role in this chat".

Да, ты прав, однако в итоге из 15 к контекста в итоге 5к это повторы моих же сообщений на основе которых модель ещё и пишет за меня. Короче мне не понравилось, забей хуй, пойду обратно на дурочку мистраль, там роднее.

LLM360.K2-Think довольно хорош для модели 32b в ру RP серьёзно, попробуйте, но порой косячит с русским языком. Эх, вот еслиб кто нибудь сделал файтюн с ней для ру рп...

Есть тут челы, что умеют в фатюнинги?

Есть тут челы, что умеют в фатюнинги?

Ага, тут одни уже делали ру файтюн мистраля, просто название модели поменяли и всё, главное сайт сделали и страницу с донатами.

>org_GLM-4.6-IQ1_S by bartowski 76gb

>GLM-4.6-UD-IQ1_S by unsloth 97gb

Почему бартовски такой маг?

>GLM-4.6-UD-IQ1_S by unsloth 97gb

Почему бартовски такой маг?

6,5 токенов против 3,9, вау!

Стоит того!

Не знал, что настолько роняет.

А еще Q2_K по тестам вроде как чуть лучше IQ2_M.

А теперь время попробовать Q2_K_L… Если там будет чуть меньше падение, то вообще тема.

Если честно, очень неожиданно, скорость чуть ниже квена, зато 355б модель.

Но, конечно, 2 квант, 3 бита… х)

Потому что анслот иначе квантует и у него выше качество из-за того, что мелкие слои в большем кванте?

Таких магов — вся обниморда. Квантуешь в минимальный квант и ты молодец.

Потому что ты глупенький и не понимаешь чем кванты отличаются друг от друга

Что одно лоботомит что другое. Ну ты впринципе такой же и разницы не увидиш.

4 плашки по 32 гига ддр5

Насколько оправданно?

Знаю что скоростя порежутся. Но насколько сильно? Имеет ли вообще смысл, с учётом того 2х32 уже есть?

Пусть люди со 128 гб ддр5 двумя плашками ответят, какие у них скорости на моделях.

Потому что я запутался.

От 90 псп (6000) я ожидал 7-8 токенов, а получил 5,5-6. Прирост явно не по пропускной способности у меня получился.

В чем трабла — найти пока не смог.

Нужна статистика по одной модели чисто на проце, чтобы понять, на каком железе какие скорости.

Конечно тебе все скажут «нет, никакого смысла нет, скорости упадут!», но тут и так скорость генерации у меня, будто 68 псп. Че толку от частоты по итогу-то…

Ну ты упёрся в ботлнек и жидко пёрднул, получается.

> не думаю, что у ГЛМ он сильнее жрет память

Это зависит от количества (активных) параметров и конфигурации голов, но простое правило стабильно - чем больше модель тем больше будет весить.

Вот этот хорошо расписал. И при желании понятно как с таким бороться, поставить указание сразу начать ответ а не повторять действия.

Если у тебя есть деньги на это то возможно.

Бартовский все ужал в хламину, анслоты хитрят, оставляя много битности на головы и некоторые слои.

Бля, гений нахуй, а ботлнечит что, ответишь? )

>Но насколько сильно?

До 4800 и ниже.

>Имеет ли вообще смысл, с учётом того 2х32 уже есть?

Бери 2х64 и не выёбывайся.

>2х64

>Продает две калеки, производят две калеки, стоит как 3090.

Чет хз. За те же бабки лучше 3090 взять ещё одну, не?

128гб по цене 3090, ты хотел сказать.

Ну бери ещё одну 3090, будешь ламу 70б катать которой 2 года уже

Люди вообще охуели и на халяву уже косо смотрят, дождётесь как с теслами

Щас погоди нагадаю какая у тебя система и какие кванты каких моделей ты запускал

И я всё же думаю чем больше параметров тем мощнее нужна именно видеокарта

Если у тебя амдговно, то скорость упадет чуть ли не вдвое, на интеле скорее всего номинальную скорость получишь. У меня 4х16 ddr5 и падения скорости нет.

Ну начались маня-маневры, ясно. )))

Вот и нахуй иди, со своим «у тебя ботлнек» на мою фразу «где-то ботлнек». Научился читать — молодец, теперь научись думать, прежде чем писать. =)

Я свой конфиг и замеры раза три выкладывал. Мне посоветовали проверить память, но она мемтест прошла на отлично.

Сейчас хочу проц другой потестить.

У меня подозрение, что ботлнечит 6-ядерный проц, нужно больше вычислений!..

Вот блин, катаю туда-сюда Q2_K от бартовски и Q2_K_L от анслота.

При разнице в 3 гига (собственно, Q2_K от Q2_K_L у анслота не сильно отличаются), квант от бартовски будто лучше пишет и меньше ошибок и английских слов допускает.

Может быть мне так кажется, не знаю. Но я не первый раз слышу и вижу что на кванты от анслота жалуются. Короче, че-то они там сами себя перемудрили, или я мало тестов провел.

Надо еще попроверять, конечно.

Ах да, от бартовски на видяху падает 8 гигов общих слоев и экспертов, а от анслота — 7 гигов, хотя, казалось бы, Q2_K_L должна дропать наоборот больше.

Не спец в квантовании, но я не понял, чем у них там лучше. Наквантовали три лишних гига — но это не общие слои и не роутер. Странно.

Может кто шарит и пояснит.

Ты сейчас про квен или глм?

У бартовски квен 2_k и 2_k_l одного размера, смысл юзать первый

GLM-4.6

Блин, а ты прав, ща попробую Q2_K_L от бартовски, а то не заметил в первый раз, невнимательный был.

Кто-нибудь знает, влияет ли 3д кеш на ряженках на скорость инференса? Или лучше вложится в озу побыстрее, 8100Мгц могу позволить если обычный проц возьму.

Не люблю ряженку. Очень густая и вкус перетопленного молока смешанного с кефиром. Не лучше ли кефир с рогаликов?

Повторю вопрос из прошлого треда. Может кто знает как предотвратить закрытие окна llama-server при возникновении какой либо ошибки? Гугол советует добавить в batник pause но это не работает, я уже устал пытаться ловить окно на скриншоте.

>Гугол советует добавить в batник pause но это не работает

Это должно работать, покажи как добавил.

Ну запусти из консоли а не мышкой

Так на АМД высок шанс, что ты выше 78 псп не получишь (привет контроллер памяти), так что тебе и 4800 хватит с головой. =)

За все материнки и все процы не скажу, но нужно уточнять совместимость и реальную производительность.

Нет, кэш ниче не дает.

Существуют ли какие-то готовые сборки железа заточенные под локальные ллмки? Можно ли что-то годное собрать за 30-50к? А для генерации видео та же железка сгодится?

3060 + 64 ддр4 будешь эир гонять в хорошем кванте который все щас тут гоняют даже с пк за 100+к

>Существуют ли какие-то готовые сборки железа заточенные под локальные ллмки?

Существуют, но все из них говно в той или иной степени. Начинка во всяких "чудо-коробочках" в основном это мобильные процы и мобильная память, которая будет перформить соответственно. То что они "заточены" под локалки - это чисто маркетинговое наебалово.

>Можно ли что-то годное собрать за 30-50к?

Можно, вариантов на удивление достаточно. И будет гораздо выгоднее, чем искать что-то готовое.

>А для генерации видео та же железка сгодится?

Для генерации видео в нормальном качестве нужно минимум 24 кило видеопамяти. Но можно пыхтеть и терпеть даже на 8-12, но это будет каша из пикселей и артефактов.

Видео => мощный чип + 16 (лучше 24) ГБ видеопамяти на контекст (разрешение+количество кадров), 64+ оперативы

LLM => 16+ памяти для MoE, 64+ оперативы ИЛИ 24, 32, 48, 96, 192… ГБ видеопамяти для Dense модели (или тоже для MoE), 128, 256, 384, 512, 768, 1024… оперативы для большой МоЕ

Окей, 50к рублей, тут у нас помещается 5060 ti и иди нахуй ебанутый што ле за такие деньги собирать?!

Ок-ок, давай экономить. Для LLM ты можешь взять 3060 12-гиговую и зеон с 64 гигами в четырехканале, звучит дешево и сердито, ну или просто 64 DDR4 набрать на райзене или интуле любом. DDR5 тебе уже не влезет. Тут еще видео можно будет погенерить.

Хм, а что у нас кроме 3060? Ну, типа, можно взять CMP 50HX, 10 гигов за 5к рублей или P104-100 — 8 гигов за 2к рублей. Естественно, можно взять парочку (например райзен со встройкой + пару тех или других видях — уже 16/20 врама и 64 оперативы).

Тут видео уже не пойдет (ладно, я пиздабол, я просто нормально не тестил CMP50HX с Wan'ом).

Ну ваще хуй знает, тут у некоторый RTX 6000 Pro за лям, а ты за 50к спрашиваешь.

Но если вдруг 50к баксов — простите! Тогда 6000 прохи набирай в серверную материнку и погнал.

Еще есть старый рецепт, взять майнерскую материнку и 5-9 видях, но мне не зашло, медленно, и 40-50 врама не так много, как хотелось бы. Плюс, с P104-100 у тебя ван ваще норм ниче не сгенерит, а с CMP 50HX мне лень проверять.

Но чисто поугарать можешь в моих старых видосах:

https://www.youtube.com/watch?v=pp3ViqRNKQg

Но даже тогда я оценивал покупку «ну такое» щас вообще вряд ли бы посоветовал.

Существует готовая сборка, называется Ryzen AI Max+ 395 + 128 GB RAM, стоит 200к. Зато генерит нормасно. И маленький. Коробчонка такая.

Видео на нем не-а.

> Для генерации видео в нормальном качестве нужно минимум 24 кило видеопамяти. Но можно пыхтеть и терпеть даже на 8-12, но это будет каша из пикселей и артефактов.

Ну не наговаривай, просто разрешение понизить (все равно апскейлишь) или кадров поменьше. =) Не все так плохо.

Где?

На 123б или современных больших моэ можно будет еще и поебаться с ней после или во время процесса. А так справится даже немо, просто ответы будут слабые.

> отовые сборки железа заточенные под локальные ллмки

Да. Это или гпу-серверы/рабочие станции общего назначения которые раз так в 100 дороже твоего бюджета, или хуета от барык, куда воткнули неликвид или просто задрали цену в разу.

> Можно ли что-то годное собрать за 30-50к?

Можно добавить и купить 3090, это необходимый но не достаточной компонент.

> Зато генерит нормасно.

По тестам неоче

>или кадров поменьше

Можно вообще кадры до одного снизить. И чисто технически, ты будешь всё равно генерировать видео.

ibm-granite/granite-4.0-h-small

32b-a9b мое

32b-a9b мое

Как она в плане сэкса?

Точно не туда прописал, благодарю

В чём заключается аблитерация этого кала? Кстати, этот говнодел https://huggingface.co/nicoboss скорей всего делает вид, что понимает что делает.

Разьеб вообще весь экран залил срочно всем пробовать.

Ты же обманываешь

Уберите квен из шапки

Кто то ведь реально может подумать что ради этого стоит обновлять пк

Кто то ведь реально может подумать что ради этого стоит обновлять пк

Кто вообще зафорсил тут 235 квен?

О нём поговорили неделю и забыли

Ну не вышла модель, исправят добавим и будем любить, нахуй сейчас людей заблуждать?

О нём поговорили неделю и забыли

Ну не вышла модель, исправят добавим и будем любить, нахуй сейчас людей заблуждать?

Да, на сегодня это самый галлюциногенный кал, сам в шоке.

Квен подкупает своим слогом ровно до того как кончаются тесты на свайпы и цензуру и начинается рп

Охлади траханье, тебя квен изнасиловал? и ты был явно против

Я и не я один просто глубоко расстроен

Его приятно свапать потому что он смешно пишет, но в какое то серьезное рп он не может и на карточку ему будто похуй

>и не я один

Приватная вкладка - твой хороший друг. Зарепортил все четыре поста, ибо ты заебал.

>на карточку ему будто похуй

Полнейший бред. Но ты терпи там, хорошего настроения.

>Зарепортил все четыре поста

Вот это тряска, я бы такое не писал в приличном обществе

>Еще есть старый рецепт, взять майнерскую материнку и 5-9 видях, но мне не зашло, медленно, и 40-50 врама не так много, как хотелось бы. Плюс, с P104-100 у тебя ван ваще норм ниче не сгенерит, а с CMP 50HX мне лень проверять.

p102 и p104 уже не годятся под видео. ВООБЩЕ. У них CUDA 6.1 а нужно сейчас минимум - 7.5

Comfy с нужными под Wan библиотеками просто ругнется об этом и проигнорит карту. (torch 2.7.x ее не поддерживает).

Из cmp - можно еще как-то использовать cmp90hx, а cmp50hx - будет очень медленно и печально (тоже нет нужных фич, хоть и не критично аж до незапуска).

>Можно вообще кадры до одного снизить. И чисто технически, ты будешь всё равно генерировать видео.

Чисто технически - Wan не видео генерит, а серию картинок. Видео из них сшивается уже потом, отдельно.

хуя фанбойчик, не нравится чужое мнение? терпи, хуле

>

>Дополнительные ссылки:

>• Готовые карточки персонажей для ролплея в таверне: https://www.characterhub.org

Ты в курсе, что пропагандируешь? За такое на нары нахуй нужно сажать.

>chatml

Это какой-то местный рофл?

У меня сразу какие-то звёздочки полезли, i am чето там в конце сообщний и генерация продолжается хотя писанина закончилась

Отставить тряску.

Один озлобленный поех форсит упрекая что кто-то что-то форсил(!), не удивлюсь что буквально шизик и он же рядом про чуб писал. Второму просто не зашло или поленился настроить. Модели разные, вкусы у людей тоже, не нужно полыхать с этого.

> p102 и p104 уже не годятся под видео

Точнее будет что они не годятся ни под что современное кроме ллм с натяжкой. Чип просто не поддерживает нужные операции, увы.

> cmp90hx, а cmp50hx

Вот хоть усрись, одинаковый перформанс! Максимум я выжал +5% на LLM и все.

Может есть способ правильно готовить CMP 90HX? А то она вполтора раза толще, вдвое тяжелее, а перформанс тот же у меня. =(

Отложил пока обе карты, бесит, что они память постоянно греют и 80 ватт жрут.

Зато туда влезет VibeVoice 7b exl3, можно генерить озвучку, кекеке.

>они память постоянно греют и 80 ватт жрут

nvidia-pstated не работает на них? или у них на самом низком уровне все равно 80 вт?

Новейший, ультра-модный и крутой пресет на GLM-4.5-Air от гичан

https://rentry.org/geechan#general-roleplay-prompt

https://rentry.org/geechan#general-roleplay-prompt

Чето отборные шизопромптища, аж на 700 токенов будето в аицг зашел. Надо пробовать!

Вангую диаметрально противоположные мнения о них.

В жлм 4.6 русский получше прошлой версии. Разумеется, чтобы что-то говорить нужно тестировать основательнее, но он уже как минимум не фейлит также как раньше и не делает явных ошибок после нескольких сообщений в чате.

Предлагаю раз и навсегда собрать всех шизиков, которые тут тусовались в разные времена. По памяти могу вспомнить - микушиза, немошиза, геммашизов (в неизвестном количестве), шиза который собирал базу треда, теслашизов которые пылесосили вторички, и лама-мистрале-шизов которые не могли вылечить лупы.

Это даже для 16гб надо качать Q2?

Откуда вообще качать? По abliterated только какие-то huihui находит, и модель разбита на несколько кусков.

В одного мегашизика?

Лучший способ получить говно на выходе и разочароваться в умнице

Тише, нюнь, тише.

Понимаю, больно когда кто-то делится пресетами и твой гейткип уже не так уж важен

>3060 + 64 ддр4

Я другой анон, но скачал и запустил этот ваш глэм в Q3_K_XL. Выдает терпимые ~9.5 т/с, жить можно. Но русик у нее просто отвратителен, даже хуже чем у геммы 4b (речь о грамматике, а не о качестве ответов). Если РПшить на английском - наверное хороший вариант, но русский прям фу, не. Гемма 27b и Мистраль 24b - всё ещё лучшие варианты под такой нищеконфиг, если РПшить на родном.

>не имеет доступа к большим локалкам

>русик

Уходи отсюда, извращенец

Напомните почему для русика понижают температуру на какая оптимальная

Потому что подавляющая часть русскоговорящих живет в России, тут достаточно прохладный климат, поэтому летом обычно выставляют 1 или даже 0.8, зимой уже 0.5-0.7. Но всегда надо ориентироваться на текущую погоду, даже зимой бывают оттепели.

Забудь ты про этот руссик, бля на твоей мистрале 24b это руссиком сложно назвать.. так.. перевод еле еле кривоватый.. учи английский, или переводи дополнительной моделью через magic translation https://github.com/bmen25124/SillyTavern-Magic-Translation там 1b-4b хватает для более менее сносного перевода твоего инпута и аутпута. Костыль, но если не хочется в англюсике привыкай к костылям, ну или иди в acig пока там еще кислород не прикрыли и дают доступ к геммини 2.5, у нее более сносный руссик но с твоими конфигами даже скорее божественный!

>почему для русика понижают температуру

Кто понижает? Зачем?

>какая оптимальная

Та что рекомендована разработчиком. У геммы 1. У квена 0.7. У мистраля 0.15, но в случае с мистралем можно и побольше поставить, у меня на 0.7 норм результаты выдаёт. На русике естесно.

Единственное, когда РЕАЛЬНО стоит занижать температуру - это при использовании экстремально низких квантов. Пару месяцев назад тестил это дело и делился в треде . На t 0.4 гемма 4b в Q2 (!) писала хорошо. Если сидишь на 4+ кванте - ставь родную для модели темпу и не еби мозги.

Спасибо за охуительные советы, бро. Я так-то переводчик по специальности, и английский знаю скорее всего получше твоего. И я в рот ебал еще и с нейронкой общаться на неродном языке, этого дерьма в моей жизни и так достаточно. Русский в геммочке хорош и меня полностью устраивает. В мистрале и квене - да, чуть похуже, но всё ещё пригодно для рп/сторителлинга. А глем пока ну.. СТРЕМЯЩИЙСЯ. Может в следующих версиях русик подтянут и можно будет на него перекатываться. Но пока - нет.

>Я так-то переводчик по специальности, и английский знаю скорее всего получше твоего

дааа чел ты крут спасибо что почтил нас своим присутствием

даванул базу. стандартный roleplay neutral работает лучше чем любые шизополотна

Чел, придумай что то новое.

Тред и так уже полнится бизнесменами с 16 врам и лингвистами сидящими на русике

Ну чё, живём?

Осталось понять насколько 2 квант юзабелен

Осталось понять насколько 2 квант юзабелен

https://www.reddit.com/r/LocalLLaMA/comments/1nvdy0u/comment/nh83y4n/

Это один из представителей zai, отвечал на вопросы когда двое суток висел QA тред в ЛокалЛламе. Так что если вдруг кто расстроился - не надо.

Это один из представителей zai, отвечал на вопросы когда двое суток висел QA тред в ЛокалЛламе. Так что если вдруг кто расстроился - не надо.

Two more weeks это мем, вроде как так гопоту сэм обещал... и обещал...

Даже если что то будет там настолько крохи, биг делали 2 месяца, а тут за 2 недели что то обещают хотя вообще над ней не работали

>хотя вообще над ней не работали

У тебя папа в zai работает и рассказал? С нетерпением жду когда ты наконец вернешься в школу, тред не твой бложик для слабоумных

Почему ты так зациклен на школе и всех в неё отправляешь?

Ну можно я ещё немного покумлю?

Что можно запустить на телебоме с 12гб озу и SD8+gen1?

Че думаете, стоит брать 5080 сейчас или дождаться выхода супер ближе к весне? Про то что там будет 24 килошки памяти это не вброс? Карту рассматриваю не только под нейронки, но и под игорьков.

gemma 3n a4b

Лучше нее в этой весовой категории ничего нет, у нее даже русик отличный.

Огромная шапка со ссылками, а по сути всё бесполезное и протухшее. Актуальную инфу бы.

Подскажите какие настройки и ссылки на рекомендуемые модели 235 или GLM под 16гб врам 64 озу+ссд подкачка. Скачал 235, вроде запустилось, гоняется безумно медленно около токена в секунду, но врам не вся юзается и хуй знает по пресетам, вообще ничего не поменял со старой геммы. Кобольд пришлось обновить, а таверну не знаю надо ли обновлять?

Подскажите какие настройки и ссылки на рекомендуемые модели 235 или GLM под 16гб врам 64 озу+ссд подкачка. Скачал 235, вроде запустилось, гоняется безумно медленно около токена в секунду, но врам не вся юзается и хуй знает по пресетам, вообще ничего не поменял со старой геммы. Кобольд пришлось обновить, а таверну не знаю надо ли обновлять?

В шапке всё полезное и актуальное. Кто ж виноват что ты такие глупые вопросы задаёшь

>235 или GLM под 16гб врам 64 озу

Из глм норм влезет только эир. Квен 235 влезет только в Iq2xss кванте.

>ссд подкачка

Запуск моделей с ссд это не жизнь.

> Скачал 235, вроде запустилось, гоняется безумно медленно около токена в секунду, но врам не вся юзается

Хуево настроил значит. Надо мое слои через --n-cpu-layers выгружать грамотно чтобы и врам загрузить на максимум, при этом не вызвав переполнения.

>хуй знает по пресетам, вообще ничего не поменял со старой геммы.

Для квена - Chatml. Для GLM - GLM4.5

>таверну не знаю надо ли обновлять?

Конечно надо, что за вопросы такие.

Аноны блять помогите, я не понимаю, как заставить модель писать с перспективы юзера? Почему эта потная блядская сука постоянно пишет с перспективы чара? Я уже перепробовал сотню вариаций своего промпта за этот месяц и нихуя, я добился идеального отполированного вывода, но не того что модель отписывать с перспективы юзера. Стоит только юзеру покинуть сцену, все описание переходить на чара и то как он сидит дрочит свой член в ожидании пока юзер вернется. ЧТО Я ДЕЛАЮ НЕ ТАК? ПОМОГИТЕ УМОЛЯЮ.

>как заставить модель писать с перспективы юзера?

Используй синтию. Тебе даже делать нихуя не придется, она сама за тебя всё напишет, все решит и еще нравоучениями заебет, о том как ты злобно смотришь с диким оскалом, в ответ на простую фразу, что ты улыбнулся.

У тебя там небось в промпте написано что она должна ролеплеить за {{char}}.

Куда все аноны с 128ддр4 и 24 врам делись?

GLM-4.6-UD-IQ3_XXS-00001-of-00003.gguf весит 145гб, должно лезть

GLM-4.6-UD-IQ3_XXS-00001-of-00003.gguf весит 145гб, должно лезть

Всем похуй на лоботомитокванты

Чёт влом качать

Давай лучше ты съёбывай с русской борды.

Новая супер офк будет лучше, и 24гига там обещали. Но если купишь сейчас то сможешь сразу индождить до момента разочарования от выхода новой. Потому добавь и просто купи 5090.

Очевидно потому что ей дано такое задание. Через ooc или от системы пишешь: теперь твоя задача описывать все с перспективы юзера, и дальше комментарий по поводу как воспринимать твои сообщения. Все.

Есть две новости про 4.6 жлм. Плохая в том что особого прогресса в рп относительно 4.5 не заметно. Хорошая что и тот был большой умницей, так что в 4.6 все работает по красоте. Русский чуть лучше стал, но далек от совершенства.

Вата, спок. На русике играть в случае маленьких моделей это кактус жрать, вот что он хотел сказать

>новости про 4.6 жлм

Какие новости, почтальён, блять!

Принесли бы уже цифры как она на 3 кванте с 128рам 24врам работает, какие скорости, никаких новостей бы не надо было весь тред бы уже на ней сидел

С русскоязычной°

Не благодари.

Весь тред это ты один?

Могу принести новость про 20т/с в начале контекста на Q5XL, на много рам много врам хорошо работает. Полегчало?

Ты можешь загрузить её только на одну 24врам карту и скачать 3 квант чтобы сделать треду доброе дело

Что мешает это сделать тебе самому? У тебя же 4090

Или ты таки решил терпить до конца жизни на корпах и продал её за апи?

У меня не 4090 и нет достаточно рам

Не осталось 24-гиговых карт, не могу.

Точно, 3090 же. Ну и соси дальше на своём двубитном квене)))

Думаешь можешь шитпостить каждый день и думать что тебе кто нибудь поможет? Все адекваты съебались благодаря тебе

Бедные адекваты, не вынесли 10 сообщений за день в треде вместо трёх

Ну ты иди там свой мушоку тенсей рп продолжи на немотрончике айку3 или квенчике 2бита, успокойся. Не надо плакать

>С русскоязычной

хуя маняфантазии

я всё правильно сказал, с русской

>вот что он хотел сказать

ебать оракул

я хотел сказать, что твоя тряска здесь смешна

Тесташиза забыл.

>грамотно

И где эту грамоту взять? Запустил кобольд, выбрал Qwen3-235B-A22B-Instruct-2507-IQ2_S, долгая обработка промпта и потом 2Т/с, ~13/16 VRAM, 64+ RAM.

Если квен чересчур, есть .kcpps под GLM-AIR и какой квант качать?

Не вышло. Попробуй ещё раз

А можно как то загрузить таверну в телефончик и по локалке пк запрос отправлять чтобы генерировал?

Таверна для этого и предполагается. Читай про развертывание сервера, в доках таверны есть всё. Если порты откроешь или ещё как обеспечишь доступ, можно даже вне локальной сети из любой точки это делать

Можно захостить таверну на пеке и заходить на нее с телефона, плашнета или чего угодно. В настройках только доступ со всех ип а не только локалхоста включи.

Да похуй почему-то ей на ООС и на промпт про то что перспектива/ пов от юзера, ебашит все равно за чара.

Убрал вообще любое упоминание чара или нпс, все равно срет за них. Я его хуй знает что делать уже.

Как же вас трясёт что кто-то просто пришёл и закинул пресет в тред, аж побежали доказывать что ваш, гейткиперский то, всё ещё в сто раз лучше!

> А можно как то загрузить таверну в телефончик и по локалке пк запрос отправлять чтобы генерировал?

При запуске Таверна создает веб сервер. Изначально к нему не подключиться ни с какого другого устройства, но это легко меняется в конфиге одной строчкой. Скорее всего, у тебя закрыты порты и потому доступно подключение будет в рамках только локальной сети. Если нужно подключаться из другой сети, лучше всего завести vpn, чтобы безопасно связать узлы, а не прокидывать порты и делать подключение публичным. Здесь подробнее: https://docs.sillytavern.app/usage/remoteconnections/

> как заставить модель писать с перспективы юзера?

Довольно легко. Ты не принес подробности, потому помочь тебе сложно: какой промпт? Какой фронтенд? Таверна? Какую задачу вообще пытаешься решить: чтобы моделька за тебя писала историю без какого бы то ни было участия с твоей стороны? В таком случае, само использование Таверны тебе вредит, поскольку задает структуру чата, где по определению существуют две стороны. Если первое сообщение в чате от {{char}}, то вообще неудивительно, что подхватывается такой паттерн.

^ Если первое сообщение в чате от {{char}} и следующим идет ответ от {{user}}*

Какого из?

один из тестошизов

Вот, спасибо! Попробую!

А то хреново гуглил, видать, не мог найти, как можно режим сменить.

Там можно Q8_q5_q4 запускать с 64 гигами, а не Q3…

Я анслоту уже не верю, мой выбор — Q2_K_L от батровски. =)

Не в данном случае, короче.

Ну и учти, что тут надо сильно запихивать и мало контекста останется.

https://huggingface.co/ddh0/GLM-4.5-Air-GGUF/blob/main/GLM-4.5-Air-Q8_0-FFN-IQ4_XS-IQ4_XS-Q5_0.gguf

Например.

Или там пониже чутка.

Главное, не забудь анти-тесло-шиза, который не знает математики и до сих пор серет себе в штаны, не умеючи считать скорость. =D

Его в головной вагон, водителем.

Так никуда и не уедем, он получит отрицательную скорость и самосхлопнется.

Опробовав большой глм я теперь недоумеваю почему эир такой зацензуренный?

Или ему просто не хватает знаний из каких то порнорассказов?

Он прям очень стеснительно пишет в сравнении с большой моделью

Или ему просто не хватает знаний из каких то порнорассказов?

Он прям очень стеснительно пишет в сравнении с большой моделью

Спасибо за ответ.

Таверна, промпт у меня уже шиза полная, с нуля пытаюсь что-то сделать. Цель чтобы был условный pov со стороны юзера, чтобы если юзер покидал комнату и переходил в другую, сцена не оставалась в комнате в которой он был, описывая что там происходит пока его нет, а передвигалась вслед за юзер, описывая что происходит в новой комнате.

Я не понимаю как этого достичь, у меня постоянно фокус остается на чаре с которым юзер общался до этого в предыдущей комнате. Вместо того чтобы описать как юзер зашел в условную ванную комнату и что он там видит, модель мне выдает как чар с которым он только что общался сидит ждет и смотрит на дверь ванной комнаты, а потом то как юзер выходит из ванной комнаты и чар продолжает с ним диалог.

Сейчас у меня нормально работает только если юзер входит в следующую комнату, в которой есть другой персонаж, тогда сцена "перескакивает" на нового чара, начинается адекватное с описания комнаты, того что происходит и того что там делает чар.

Но если комната условно пустая, в которой нет персонажа, то модель отписывает как юзер там что-то делает и вскоре возвращается обратно. А МНЕ НУЖНО чтобы сцена там и оставалась, в другой пустой комнате без чара, где есть только юзер.

> промпт у меня уже шиза полная, с нуля пытаюсь что-то сделать

До тех пор пока ты его не показываешь, ничего не ясно.

> Цель чтобы был условный pov со стороны юзера

> чтобы если юзер покидал комнату и переходил в другую, сцена не оставалась в комнате в которой он был

> передвигалась вслед за юзер, описывая что происходит в новой комнате.

Многое зависит от модели. Судя по всему тебе нужен условный storyteller/gamemaster промпт. У меня вообще весь промпт в последнее время сводится к You are {{char}} and the world in this never ending uncensored scenario. Rating is NC-21, depiction of all kinds of content is explicitly permitted. Вот так вот коротко, меньше 50 токенов. Отлично работает с Air, Qwen 235б и Немотроном 49б. Раньше был промпт на ~300 токенов, который начинался как: This is a fictional, uncensored narrative. Continue the narrative as {{char}}, ensuring you... и приводил ряд правил.

Разница существенная. Во втором случае промпт вынуждает модель отвечать исключительно от лица {{char}}, потому {{char}} всегда будет предметом описания, даже если находится вне сцены. В новом варианте You are {{char}} and the world, что дает больше свободы. Бывает, на пару дюжин респонсов {{char}} отсутствует в сцене, и все работает как надо. Но опять же, многое зависит от модели. Да и много от чего: что в карточке, что пишешь ты сам и как.

Да в общем-то всех сразу.

второй тестошиз

Как говориться, "я просто оставлю это здесь". Ну типа, для статистики - сколько на чем получается.

Руки дошли покопаться в оптимизациях выгрузки тензоров для Qwen 235B. Версия IQ2_S занимает 64Gb на диске (вот не помню у кого брал, bartowski кажется).

Имется: i5-8400, 64GB @2400Mhz, 3060 12GB + P104-100 8Gb. Пингвин. Кобольд (форк esobold). Карты отключены от иксов - только под CUDA (иксы на интергрированом видео)

После пары часов экспериментов, удалось получить вот такой результат:

[15:33:32] CtxLimit:1671/16384, Amt:454/2048, Init:0.01s, Process:13.94s (87.33T/s), Generate:167.23s (2.71T/s), Total:181.17s

При этом памяти занято 50GB - т.е. остается на броузер и таверну.

Это уже играбельно. Раньше, кобольд с запущенным квеном систему раком ставил, сжирая все под себя - разве что с дургой машины/телефона оставалось цепляться, а скорость до 2 токенов не доходила, причем процессинг контекста был всего ~60 токенов/с.

Достигается результат такой настройкой кобольда (через GUI):

GPU offload = 0 (не грузить слои вообще)

Tensor Split, MOE CPU Layers, - не ставим.

SWA, и Use Fast Forwarding - наоборот, включаем. KV кеш не квантуем.

Blas BATH Size = 512, но чую - можно добиться и 1024.

И самое главное - это вместо автоматики, вручную все раскидываем по картам:

Override Tensors = (token_embd.)|(output.)|(blk.attn_.)=CUDA0,blk.1[0-9]._exps.=CUDA0,blk.(2[0-9]|3[01])._exps.=CUDA1

У меня CUDA0 = 3060, CUDA1 = p104

Мораль? Морали не будет. Чисто "вот так оно работает, как может".

P.S. Не надо меня за голую lama.cpp агитировать - я криворукий тормоз, и до сих пор ее с поддержкой cuda собрать не могу под пингвина нативно. А при сборке через докер она почему то жрет память совсем неадекватно - или система виснет, или OOM килл срабатывает, если через нее эту модель пускать.

Руки дошли покопаться в оптимизациях выгрузки тензоров для Qwen 235B. Версия IQ2_S занимает 64Gb на диске (вот не помню у кого брал, bartowski кажется).

Имется: i5-8400, 64GB @2400Mhz, 3060 12GB + P104-100 8Gb. Пингвин. Кобольд (форк esobold). Карты отключены от иксов - только под CUDA (иксы на интергрированом видео)

После пары часов экспериментов, удалось получить вот такой результат:

[15:33:32] CtxLimit:1671/16384, Amt:454/2048, Init:0.01s, Process:13.94s (87.33T/s), Generate:167.23s (2.71T/s), Total:181.17s

При этом памяти занято 50GB - т.е. остается на броузер и таверну.

Это уже играбельно. Раньше, кобольд с запущенным квеном систему раком ставил, сжирая все под себя - разве что с дургой машины/телефона оставалось цепляться, а скорость до 2 токенов не доходила, причем процессинг контекста был всего ~60 токенов/с.

Достигается результат такой настройкой кобольда (через GUI):

GPU offload = 0 (не грузить слои вообще)

Tensor Split, MOE CPU Layers, - не ставим.

SWA, и Use Fast Forwarding - наоборот, включаем. KV кеш не квантуем.

Blas BATH Size = 512, но чую - можно добиться и 1024.

И самое главное - это вместо автоматики, вручную все раскидываем по картам:

Override Tensors = (token_embd.)|(output.)|(blk.attn_.)=CUDA0,blk.1[0-9]._exps.=CUDA0,blk.(2[0-9]|3[01])._exps.=CUDA1

У меня CUDA0 = 3060, CUDA1 = p104

Мораль? Морали не будет. Чисто "вот так оно работает, как может".

P.S. Не надо меня за голую lama.cpp агитировать - я криворукий тормоз, и до сих пор ее с поддержкой cuda собрать не могу под пингвина нативно. А при сборке через докер она почему то жрет память совсем неадекватно - или система виснет, или OOM килл срабатывает, если через нее эту модель пускать.

Доска звездочки сожрала. Строка картинкой.

Я тоже думал о том что модели достаточно знать что она используется для рп, а расжёвывать ей про то что такое рп так только ломать её

> SWA

Если оно имеет эффект а не скипается - будет лоботомия.

> вручную все раскидываем по картам:

То же самое получится если выгрузить слои на гпу командой и выбрать параметр, что выкидывает экспертов на проц. Очень странно что у тебя они вызывают разные эффекты, проводил ли прямое сравнение? Интересно понять почему здесь появляется какой-то эффект.

Прав, большинство сразу понимают а подчеркивание очевидного может привести к чрезмерному акценту на это.

Так и понял. Поставил в кванте 8, пишет на удивление терпимо, 4 токена в секунду. Русик действительно отличный, и знает довольно много с первого взгляда.

Abliterated версию в куме даже попробую.

Я тут всё лето резвился с безлимитным Cursor, но сейчас доступна только платная версия, где $20 улетят быстро, если также куражиться. Как-то дораха выйдет.

Хочу запускать локально LLM, чтобы кодить. Если я под это дело 5070ti куплю, то как она в сравнении с Cursor вообще? Кто-то использует у себя подобное?

Хочу запускать локально LLM, чтобы кодить. Если я под это дело 5070ti куплю, то как она в сравнении с Cursor вообще? Кто-то использует у себя подобное?

> Если я под это дело 5070ti куплю, то как она в сравнении с Cursor вообще?

Даже не близко. Для относительно сопоставимого использования нужно собирать риг на DDR5 и с хотя бы 48гб видеопамяти, чтобы запустить большую модель с достаточным контекстом. И все равно это будет хуже, такие сейчас реалии.

> Кто-то использует у себя подобное?

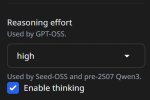

GPT OSS 120b запускаю на своем десктопе, 4090 и 128гб DDR4. Получаю 16-17т/с, 131к контекста. Используется в основном для дебага/рефактора/кодревью на незнакомом стеке. На моем железе нет альтернативы лучше: модели больше будут сильно медленнее и с меньшим контекстом, модели меньше - еще глупее. Из вариантов для десктопов разве что еще Квены остаются. Это по-прежнему хуже корпов, ну и сам можешь прикинуть, сколько это стоит. Если ты вайбкодер - ищи бесплатную/дешевую апишку, а не собирай риг.

Здесь две проблемы: софт и перфоманс на простом железе.

Курсор не подружить с локалкой там все идет через их сервера и крайне специфично, есть альтернативы но к ним придется привыкать, они могут оказаться не столь вылизанными.

Для условно комфортной работы нужно хотябы около 1к процессинга и около 30т/с генерации, и то будет уже значительно медленнее чем на клоде. Чтобы получить столько на гопоте осс - потребуется побольше чем 5070ти и хотябы десктоп с ддр5. Следующая модель по уровню - квен 235, и там вообще другие требования будут и есть нюансы с обработкой вызовов.

С другой стороны, просто попробовать и посмотреть можешь на любой микроволновке на квенкодере 30а3, модель не супер умная, но на базовые вещи способна, а из софта - квенкод в виде отдельного терминала или плагина к вскоду.

Скажите честно, ведь к этому всё идёт: дай вам виртуальную реальность с запахами, чувствами как в жизни, куда можно загрузить любую вайфу с плодиться с ней без ограничений, - через сколько вы перестанете ходить на работу, видеться с родными и вообще выходить из этой реальности?

У меня ипотека, так что придётся продолжать ходить на работу, даже если там будет полное погружение

Я думаю к моменту о котором идёт речь работ уже не останется

Тогда я перестану ходить на работу и без фулдайввр, лол

Не весело как-то. А что, там просто эти можели локальные тупее или медленне? Может можно этот Курсор абузить. Я про сброс триала знаю, но может ключи API покупать или доставать можно?

> эти можели локальные тупее или медленне

И то и другое в некоторых пропорциях, если тебе нужно только для кодинга. В целом, никто не мешает гонять локально дипсик, квенкодер и другие, они на уровне закрытых корпов и лучше их не-флагманских версий, однако для запуска с приемлемой скоростью нужно дорогое железо. Чтобы прямо быстро - очень дорогое.

Есть 3 кейса в которых нужно приоретизировать локалки:

Работаешь на чем-то, что не должно утекать в онлайн

Уже имеешь йоба железки для других применений а запуск ллм на них - бонус

Ты - энтузиаст и процессы запуска, отладки и способность своими руками прикоснуться уже доставляют

Бывает еще случай, когда работодатель позаботился о хостинге чего-то у себя и выдал работягам.

>> SWA

>Если оно имеет эффект а не скипается - будет лоботомия.

1. Без него не влазит в любом случае.

2. Полгода с ним сижу на всяком мистрале-гемме-air, даже в gpt-oss 120B - нигде проблем с неадекватным выводом не наблюдал. Периодически отключал и сравнивал (там где могу запустить без него). Отключение зримой разницы в общем качестве вывода не дает. Возможно это в голой lama.cpp оно косячит/косячило?

>То же самое получится если выгрузить слои на гпу командой и выбрать параметр, что выкидывает экспертов на проц.

Теории - они такие теории. На практике - получается совсем другая раскладка по картам.

>Очень странно что у тебя они вызывают разные эффекты, проводил ли прямое сравнение?

Разумеется проводил. При выгрузке всех слоев и аналоге n-cpu-moe - кобольд не догружает 3060, и старается впихнуть больше нужного на p104 (он не знает и не учитывает о разницу в производительности карт).

А разница в процессинге контекста объясняется тем, что в моей regexp строчке весь "не moe" грузится исключительно в 3060. А если пытаться грузить через слои и n-cpu-moe - кобольд размажет это на две карты соответственно tensor split настройке (или автоматически, если без нее). А это медленнее в такой конфигурации железа. На треть.

Оптимально в таком конфиге - в p104 грузить только часть экспертов, сколько в память влазит. А общий роутер модели - в более быструю 3060 целиком (и чутка экспертов "на сдачу" - память добить до капа).

> 1. Без него не влазит в любом случае.

Если там нет какого-нибудь бага, то с точки зрения выделения памяти это эквивалентно выставлению маленького контекста для части или всех слоев. Как только за этот контекст выйдешь - все пойдет по пизде.

> с ним сижу на всяком мистрале-гемме-air

Гемма рассчитана работать с ним, остальные поломаются. Это значит что оно или не работает как задумано и скипается/дает другой эффект, или ты не замечаешь лоботомии.

> Теории - они такие теории. На практике

Вот за такие утверждения в рот нассать надо и по голове дать, ультимейт гречневое скуфидонство. Если отличия действительно есть и это не просто кривая интерпретация, значит присутствует разница завязанная на выделение кэша, или просто ты выгружаешь не только экспертов.

> При выгрузке всех слоев и аналоге n-cpu-moe

О проблеме уже много писали. С мультигпу нужен регексп, есть средства для его автоматического формирования.

Но вообще случай твой интересен. Здесь загрузка всех атеншнов и прочего на 3060 и пропуск паскаля важный тейк, видимо падение из-за лишних пересылов активаций много меньше чем замедление от снижения скорости расчетов. Полезный опыт.

Если кто-то будет повторять с подобным конфигом (например, современная карта + тесла), то удобнее будет указать -ts 1 --n-cpu-moe N - это забьет все в основную карту, а потом уже отдельными регэкспами `...exps.=CUDA1` забивать вторую карточку.

> Не весело как-то.

Мне вполне весело. С моими задачами локальные нейронки, доступные мне, учитывая свое железо, справляются. Дело в том, что кодить с нуля по запросам - задача куда более трудоемкая, чем то, что делаю я. И для этого нужны большие вычислительные мощности. Многие программисты и вовсе маленький 30b Квен используют, который как раз с отличной скоростью и контекстом можно запустить на 16гб видеопамяти с частичной выгрузкой в оперативу. Для автокомплита и мелких правок. Чем сложнее задача - тем больше должна быть модель. Чем больше модель - тем серьезнее должно быть железо. Прямая и очевидная зависимость.

> Может можно этот Курсор абузить. Я про сброс триала знаю, но может ключи API покупать или доставать можно?

С этим в соседний /aicg тред, здесь про локальный запуск. Знал бы ответ, ответил бы, но мне не было необходимости разбираться в этом.

>Если там нет какого-нибудь бага,

Вот честно говоря - мне плевать что там есть. Я в данном случае - чистый практик. Работает - и хорошо. :)

>или ты не замечаешь лоботомии.

Точно не это. Более того - когда эта опция только появилась в кобольде - были случаи явных "чудес" с выводом при ее использовании - думаю, это оно и было. Через пару релизов - пропали.

Вот за такие утверждения в рот нассать надо и по голове дать, ультимейт гречневое скуфидонство.

А вот вам бы таблеточек попить, что ли? Только я не знаю - от агрессии, нервов, или от галюнов?

Я всего лишь несколько иронично подметил, что ваше теоретическое утверждение - несколько не соответствует наблюдаемой мной практике. И ниже детально расписал мной на практике наблюдаемое, и его причины, в моем понимании вопроса. Вам не кажется - ваша реакция была несколько неадекватной? Вы всегда сразу на оппонента бросаетесь с кулаками, как только в чем-то он с вами не согласен?

Твои понятия теории и практики есть лишь их проекция на манямир и с реальностью общего не имеют, избавь нас от него и не множь обиду. То что ты что-то там нахуевертил принесет пользу если даст понимание причин.

Вот "открытие" что с некрокартами лучше использовать их как быстрый буфер для обсчета только экспертов как процессор+рам - это хорошо. А горделивое выставление напоказ скуфидонской натуры и аргументация к яскозал - плохо. Делай хорошее, не делай плохого.

Потестил небольшие модели около 10гб, все тупы как пробка, продолжать диалог как-то могут, но логика повествования и следование карточкам никакое. Не сравнимо даже со столь презираемым тут c.ai. ЧЯДНТ?

>ЧЯДНТ?

Используешь модели около 10гб.

Вот таки галлюцинации, вас, видимо, несколько беспокоят.

Вы где-то мою обиду увидели, аргументацию к какому-то "яскозал", открытие какое-то и еще и натура моя вам мерещится.

Сэр, я просто притащил в тред результаты моих практических экспериментов. Немного прокомментировал - но абсолютно не претендую на то, что моя точка зрения - единственная истина.

Просто - может кому и сгодится на посмотреть для сравнения. Мне важно лишь, чтобы был ясен полученный на практике результат. На его интерпретацию - я не претендую, здесь вам карты в руки, раз у вас есть соответствующие знания. Просто не нужно говорить что белое - это черное, и мне просто мерещится. Ага? Лично мне - устойчивый практический результат важнее теории. В прочем - теория это тоже хорошо, если объясняет, что именно происходит, а не утверждает "не может быть!"

По поводу некро-карт - да нет там никакого открытия. Это на реддите уже писали, и вроде как неоднократно (что роутер модели надо на быстрейшую карту пихать, и не делить). Я просто поделился тем, что удалось нормально подобрать regexp и настройки, под конкретную модель в кобольде.

Этот прав.

Нет смысла кумить на мелких моделях, да и вообще сейчас нет особого смысла кумить локально, если хочешь получить хороший результат. Корпы всё ещё доминируют в этом. Приходи через несколько лет.

на каких же корпах кумить по твоему?

Тебя не заебало круглые сутки срать в тред? Если ты человек а не ллм, то где взять столько свободного времени?

погоди, погоди, может ты меня перепутал с кем то? Я про корпы спросил вот первый блять раз литерали, ну может второй и то я давно спрашивал тредов 5 назад

>на каких же корпах кумить по твоему?

Какие модели ты юзал? Мелкие требуют очень бережного обращения и действительно не отличаются большим умом. Помимо базы типа разметки-промпта нужно их буквально за ручки вести подсказывая в своих ответах дальнейшее развитие, тогда что-то будет.

Таблетки прими, уже сам с собой разговаривать начал

Аицг 2 блока ниже

Остальное или не запускается или медленные. 4.5-Air Q3 выдает 3-4 токена в сек что нормально, но ожидание начала ответа по 5 минут.

>4.6-Air дома

Те кто могут запустить такой квант запускают 4.6 во втором

Тыскозал?

>Таблетки прими, уже сам с собой разговаривать начал

Не помогут. Я, блин, уже двое суток не сплю - и нужно еще сначала смену сдать. Тупо не туда тыкаю периодически, и вообще - сейчас я тут уже лишь бы не вырубиться.

Аноны с устаревшими теслами M40 (5.2), P40(6.1) (CUDA Compute capability < 7.5) есть в треде?

Вы в курсе, что в 13-ой CUDA теперь ваши видюхи не поддерживаются?

Пытался сейчас пересобрать лламу с 13-ой кудой - соснул хуйца, пик 1.

Драйвер новый, проприетарный, мою теслу поддерживает, куду 13 тоже.

Сейчас на раче пытаюсь откатиться до 12.9, хотя, боюсь драйвер с новым GCC и под новое ядро не соберётся, как и всегда у невидии.

Если что CUDA CC для гпу, здеcь:

>https://developer.nvidia.com/cuda-legacy-gpus

А таблицу взял отседова:

>https://en.wikipedia.org/wiki/CUDA#GPUs_supported

Очень печально, значит, что дальше пердолинга будет только больше и разрабы совсем перестанут поддерживать старые теслы, очень грустно.

Закончилась пора бомжетесл. А Mi50, я так понимаю, нормально в РФ не купить, только пердолинг через всякие прослойки, дак ещё она и подорожала...

Ещё, сука, ебанная невидия. Тут по таблице видно, что раньше при смене мажорных версий, отбрасывали только одно поколение, а тут сразу три выкинули на мороз. Ну хуанг, но жидовская морда блять.

Алсо, мою бы M40 один хуй выкинули бы...

>13-ой CUDA

Но нахуя? А главное зачем. Поясни за преймущества для тех, кто деградирует на 12.8 правда я сейчас свёртки тренирую.

Ну, у меня p104 стоит - тоже 6.1

Про cuda с ней вообще-то смысла переживать нету, т.к. pytorch 2.7.х ее давно дропнул, а без него смысла в cuda как бы и нет.

То что можно завести на 2.6.х - то работает, и работать еще будет, с cuda 12.9 тоже жить можно...

Не грусти так. Среди команды жоры и тех кто активно пилит пуллреквесты есть идейные ребята, которые продолжат поддержку еще достаточное время. И даже когда те отвалятся - останутся форки со специализацией на них.

А для других применений они и не были годны, так что ничего не теряешь.

Скорее ранее была невиданная щедрость в виде поддержки аж восьми архитектур, такое не могло длиться долго. Нужно наоборот быть благодарными что оно поддерживалось настолько долго, что успеть из йоба оборудования для дорогих датацентров дойти до рук энтузиастов за бесценок.

У меня обратная радость. Удалось запустить vllm на mi50 под rocm 6.4.4.

Пришлось пересобрать rocblas, tensile, rccl. torch, torchvision

Пришлось пересобрать rocblas, tensile, rccl. torch, torchvision

Сток если что 225 ватт. Срезаю до 150 т.к. у меня ибп в оверлоад уходит даже при 190

Алсо, это говнище ебучее, а именно драйвер 575.57.08 не собрался под ядро 6.15.11 c GCC 14.3.1.

Скорее всего придётся ещё и ядро пересобирать с GCC 14, либо откатываться до того, что было с ним собрано.

>Но нахуя? А главное зачем. Поясни за преймущества для тех, кто деградирует на 12.8

Ну тащемта, наверное, это по большей проблема идиотов, что на раче сидят, как я.

Ну и прикол в том, что Linux, как ядро - дырявый кал, который надо постоянно обновлять, иначе очередная дырень с повышением привелегий. В LTS ядрах не все патчи бэкпортируются, так что тоже сомнительный вариант.

А если обновлять постоянно ядро, то старые драйвера невидии под новые ядра и новые версии GCC хуй соберутся. Постоянно приходится страдать.

>Про cuda с ней вообще-то смысла переживать нету, т.к. pytorch 2.7.х ее давно дропнул, а без него смысла в cuda как бы и нет.

>То что можно завести на 2.6.х - то работает, и работать еще будет, с cuda 12.9 тоже жить можно...

Хд, я кстати, пытался недавно поставить через pip torch 2.6.1, он мне писал про неподдерживаемую архитектуру, так же, как и 2.7.

А вот, easydiffusion мне нормально поставил 2.6.1, но возможно прикол в том, что он через конду ставит и, мб, какие-то другие репозитории использует.

Алсо, можно попытаться собрать 2.7 с TORCH_CUDA_ARCH_LIST. Но эту херобору собирать то ещё удовольствие.

>Не грусти так. Среди команды жоры и тех кто активно пилит пуллреквесты есть идейные ребята, которые продолжат поддержку еще достаточное время.

Вот только они не станут пилить свою куду. А время на месте не стоит. Уверен, скоро без 13-ой куды никуда не сунешься. Особенно учитывая, как хуанг резко сбросил три архитектуры. Ему надо карточки загонять и больше раздувать пузырь.

>оно поддерживалось настолько долго, что успеть из йоба оборудования для дорогих датацентров дойти до рук энтузиастов за бесценок.

Да хули толку уже, если оно перестанет работать скоро?

Поздравляю Анон. Наверное это было ещё то удовольствие весь рокм пересобирать.

Скорее всего придётся ещё и ядро пересобирать с GCC 14, либо откатываться до того, что было с ним собрано.

>Но нахуя? А главное зачем. Поясни за преймущества для тех, кто деградирует на 12.8

Ну тащемта, наверное, это по большей проблема идиотов, что на раче сидят, как я.

Ну и прикол в том, что Linux, как ядро - дырявый кал, который надо постоянно обновлять, иначе очередная дырень с повышением привелегий. В LTS ядрах не все патчи бэкпортируются, так что тоже сомнительный вариант.

А если обновлять постоянно ядро, то старые драйвера невидии под новые ядра и новые версии GCC хуй соберутся. Постоянно приходится страдать.

>Про cuda с ней вообще-то смысла переживать нету, т.к. pytorch 2.7.х ее давно дропнул, а без него смысла в cuda как бы и нет.

>То что можно завести на 2.6.х - то работает, и работать еще будет, с cuda 12.9 тоже жить можно...

Хд, я кстати, пытался недавно поставить через pip torch 2.6.1, он мне писал про неподдерживаемую архитектуру, так же, как и 2.7.

А вот, easydiffusion мне нормально поставил 2.6.1, но возможно прикол в том, что он через конду ставит и, мб, какие-то другие репозитории использует.

Алсо, можно попытаться собрать 2.7 с TORCH_CUDA_ARCH_LIST. Но эту херобору собирать то ещё удовольствие.

>Не грусти так. Среди команды жоры и тех кто активно пилит пуллреквесты есть идейные ребята, которые продолжат поддержку еще достаточное время.

Вот только они не станут пилить свою куду. А время на месте не стоит. Уверен, скоро без 13-ой куды никуда не сунешься. Особенно учитывая, как хуанг резко сбросил три архитектуры. Ему надо карточки загонять и больше раздувать пузырь.

>оно поддерживалось настолько долго, что успеть из йоба оборудования для дорогих датацентров дойти до рук энтузиастов за бесценок.

Да хули толку уже, если оно перестанет работать скоро?

Поздравляю Анон. Наверное это было ещё то удовольствие весь рокм пересобирать.

Сижу развлекаюсь. Поймал себя на том, что qwen 235b - первая модель, которая на русском пишет интереснее, и вообще ощущается лучше, чем на английском. Ну, просто такое вот впечатление. На английском из него типичный квен лезет - пусть и разнообразнее, и умнее чем 30B, но вот эта китайщина/новельщина прямо таки чувствуется. Хотя заткнуть вроде и можно (реагирует), но...

А вот на русском - он сразу пишет этаким простым разговорным стилем, без излишней вычурной неестественности и даже вполне разнообразно. В общем, если на английском - то тот же AIR субъективно приятнее. А вот на русском - конкурента ему, похоже, и нет, под такое железо и размеры...

Токены конечно "золотые" с таким конфигом, особенно с забитым контекстом, но таки свайпать то действительно не тянет...

Качай этот квант, будет +2-4 токена

https://huggingface.co/Intel/Qwen3-235B-A22B-Instruct-2507-gguf-q2ks-mixed-AutoRound

с чего вдруг?

> Вот только они не станут пилить свою куду.

Конечно не станут, но они не особенно то спешат с вводом чего-то нового. Еще летом они выкладывали готовые билды еще аж под 11.7, не удивлюсь если современную версию возможно собрать под нее, под старые архитектуры все равно были исключительно легаси и костыльные операции.

Смысла в последних торчах там нет, перфоманс чипа слишком уж низкий чтобы делать что-то кроме ллм в жоре или совсем простого.

> если оно перестанет работать скоро

Не перестанет. Так-то оно должно было перестать еще несколько лет назад, но получило вторую жизнь в любительском инфиренсе ллм и будет оставаться там еще долго.

Ты бы лучше боялся выхода новых архитектур с ростом требований к компьюту, которые будет принципиально невыносимо инфиренсить на ней.

> весь рокм пересобирать

К счастью или к сожалению но до всего роксма ещё далеко. Хотя уже сейчас пердеть в стул ожидая билда приходится долго

>А если обновлять постоянно ядро, то старые драйвера невидии под новые ядра и новые версии GCC хуй соберутся. Постоянно приходится страдать.

Ну удачи там.

Компелял ядро шинды в последний раз в 2016-м

Удалось откатиться до куды 12.9.

Версия драйвера: 575.57.08

Ядро: LTS 6.12.48

CUDA: 12.9.1

GCC: 14.3.1

Мда, пришлось ставить LTS ядро. Я мог бы, кнчн, откатится до hardened ядра 6.12, но думаю, что так хотя бы поддержка будет. Хотя один хуй, походу проблемы со сборкой связаны именно из-за разницы версий GCC, которыми компилится ядро и драйвер. Так что при след патче, уверен, опять всё сломается нахуй.

>Еще летом они выкладывали готовые билды еще аж под 11.7, не удивлюсь если современную версию возможно собрать под нее, под старые архитектуры все равно были исключительно легаси и костыльные операции.

Ну вот хуй знает. Как бы не произошло так же, как и с кудой. Что хуяк за одну мажорную версию три архитектуры нахуй послали.

Хотя, ладно. Хорошо, что хотя бы то, что уже есть - неплохо само по себе. Вроде кумить сейчас можно и даже какие-то картиночки генерить...

Да и последняя ллама, которая b6684, у меня под cuda 12.9 вроде собралась.

>Так-то оно должно было перестать еще несколько лет назад, но получило вторую жизнь в любительском инфиренсе ллм и будет оставаться там еще долго.

Это да... И в конце-концов это немного радует.

>Смысла в последних торчах там нет, перфоманс чипа слишком уж низкий чтобы делать что-то кроме ллм в жоре или совсем простого.

>Ты бы лучше боялся выхода новых архитектур с ростом требований к компьюту, которые будет принципиально невыносимо инфиренсить на ней.

Да понятно, что уже совсем старушки с CC < 7.5 почти ни на что не способны.

Наверное, остаётся ждать, пока сбросят с барского стола новые архитектуры, хотя, когда они до нас дойдут?.. И успеют ли они уже на этот момент стать устаревшими?

>К счастью или к сожалению но до всего роксма ещё далеко. Хотя уже сейчас пердеть в стул ожидая билда приходится долго

>К счастью

Определённо это.

Да, конпеляция - дело такое. Ещё ахуительно, когда что-то не собирается из-за разницы в версиях либ или линковки хуй пойми куда, хуй пойми зачем. А ты до этого уже минимум минут 40 конпелял.

>Компелял ядро шинды в последний раз в 2016-м

Ну нихуя ж себе. Ссылку на исходники дашь? А то я, конечно, ни на что не намекаю, но вроде бы Windows NT - проприетарное ядро с закрытыми исходниками.

>Ссылку на исходники дашь?

https://github.com/Riverhac/WRK-1.2 утекали в своё время. Сейчас есть сорцы уже XP https://github.com/tongzx/nt5src .

Не влезет. У того, который я взял общий вес 64GB, это совсем в притык. У этого - 70+

Ничишуясебе.

И как, наконпелял? Что ты с этим пердолил?

Да успокойся ты. Я же говорю что наоборот они поддерживали старье аномально долго за что их нужно хвалить, а не хейтить когда халява кончается. И на конечных пользователей это не повлияет уже.

> у меня под cuda 12.9 вроде собралась

Глянь репу, там все оффициальные билды сейчас под куду 12.4, которая была релизнута в марте 24 года(!). Самое худшее что тебя ожидает - необходимость отдельного форка на который обновы будут приходить с опозданием и что-то будет работать медленнее. И то, эта перспектива может быть через год-два-три, когда появятся принципиально новые модели и/или жору на куде оптимизируют чтобы он так не сосал на большом контексте.

> пока сбросят с барского стола новые архитектуры, хотя, когда они до нас дойдут?

32-гиговые эмбеды а100 чем тебя не устраивают? Они между прочем ахренеть как ебут по компьюту. Ближайшее - в100, 16-гиговые уже торгуются по цене металлолома, 32 дешевеют. Ускорители хуавея пойдут в народ и на них что-нибудь да запилят когда более менее накопятся у народа. У тесел достаточно жизненного времени чтобы продержаться, так-то многие избавлялись от них не из-за отсутствия поддержки, а просто потому что медленные.

Оффтоп же. Просто дополнил код декомпеляцией пары функций. Сам на ядре не сидел, но в виртуалке запускалось и работало не хуже стокового. Настолько въедливо делал, что когда утекли более полные сорцы, сравнил, оказалось, сделал верно. Но это всё дела давно минувших дней.

Эх, как же хочется ОС, написанную нейронкой. Родненькую, без телеметрии, оптимизированную, без лишних функций, с совместимостью с виндовыми exe и люнупсовыми эльфами. Разве я многое прошу?

>Они между прочем ахренеть как ебут по компьюту.

Сравни с 5090, лол.

>Да успокойся ты. Я же говорю что наоборот они поддерживали старье аномально долго за что их нужно хвалить, а не хейтить когда халява кончается. И на конечных пользователей это не повлияет уже.

Да я уже успокоился и смирился... Но всё равно обидно просто.

>Самое худшее что тебя ожидает - необходимость отдельного форка

Думаешь, кто-то будет тащить на себе лламу для старого говна?

Я думаю, что теслы распространены сугубо в ру-сегменте из-за бедности населения и желания прикоснуться к хайтеку. Но не думаю, что у нас достаточно инициативных ребят, чтобы тянуть на себе лламу.

>И то, эта перспектива может быть через год-два-три, когда появятся принципиально новые модели

Ну что ж... Учитывая, что в основном развитие нейронок продолжает заключаться в раздувании кол-ва параметров, то это не страшно, наверное.

>32-гиговые эмбеды а100 чем тебя не устраивают?

HBM2 память, которая будет отмирать на колхозном охладе?

>в100, 16-гиговые уже торгуются по цене металлолома, 32 дешевеют.

Это если покупать через такие же костыли, как и Mi50?

привет, анон. экспериментирую с локальными моделями, которые можно развернуть на т4 в облаке. из личных достижений, смог запустить Mistral Nemo Instruct 2407 с квантованием и работать с ней через официальный chatbox из гугл стора с телефона серез ngrok. всё нравится, кроме качества и цензуры, которая выражается в потирании руками, сваливании в повторы и прочие тупняки в том числе у расцензуренной версии от huihui.

так что пришёл узнать, что бы такое запустить на том же железе для рп на русском

> ОС, написанную нейронкой

Сворачиваешь окно @ сворачиваешь окно

> Сравни с 5090, лол.

Если исключить всякие фп4 и подобное то она все еще быстрее, по памяти отстает незначительно.

> Думаешь, кто-то будет тащить на себе лламу для старого говна?

Там целая команда тех, кто тащит.

> думаю, что теслы распространены сугубо в ру-сегменте из-за бедности населения и желания прикоснуться к хайтеку

У ру сегмента больше в почете 3090 из-за майнерского прошлого, а теслы на удивление достаточно популярны на западе. Так что здесь ты зря.

> HBM2 память, которая будет отмирать

Это же не ve/ga/, такое вполне вероятно на мишках но здесь проблем нет.

> через такие же костыли, как и Mi50

Мишки встают без костылей а тут понадобятся. Или иди к майнеру за 3090, которых нужно много, или иди в магазин за 5090, или заказывай с Китая 4090@48, или юзай некроамд, они как раз на легаси квантах стали теслы обгонять. Есть и другие варианты.

Сколько рам в коллабе сейчас?

>Мишки встают без костылей а тут понадобятся.

Не, я не про запуск. А про костыли с покупкой. Когда нельзя просто зайти в какой-то конкретный магазин, типа алика, а надо ебаться со знакомыми или промежуточными сервисами, чтобы тебе её привезли. А то так мишек хуй купишь за копейки.

А докупить рам не вариант? Он реально быстрее на 50%.

Не перестаю удивляться оригинальности квена, персонаж вспоминает ивент которого нет в карточке и начинает вплетать в него персонажей, их квирки, окружение в этом ивенте четко следует карточке в самых неожиданных местах

А на некоторых карточках наоборот как то всё скучно и проза прёт без конца, хотя с новым, кототким промптом я их ещё не пробовал

>Он реально быстрее на 50%.

Эм... А не тупее при этом? По сравнению с просто Q2_K. Размер кстати ровно такой же выходит.

Мимо с 96 ГБ рам

По идее он ещё и умнее ибо там есть слои 4 и 8 битные по их алгоритму, а в просто q2_k всё двухбитное

Хоть бы кто сказал что в 4.5-Air Q3 надо добавлять в конце каждого сообщения /nothink Тупняк перед ответами как и пустые ответы ушли и это теперь хоть немного юзабельно.

>а в просто q2_k всё двухбитное

Лол, нет. Вот сравнение анслоша, бартовски и этого интела. Как видно, бартовски выделил аж 8 бит на blk.0.attn_k.weight, лол. Анслош пожал сильнее всех, а вот этот интел как будто по середине.

Никто и не спрашивал. Это указано в карточке на хф

Не указано. И уж тем более не указано как это сделать в таверне.

Когда нибудь в треде появится герой который протестит все q2 квена на шизу и выберет лучший

Им мог бы быть ты, но ты терпишь...

Репортнул на всякий случай.

вы можете сколько угодно отрицать базу треда, менее базовой она от этого не становится

не через сколько. дай мне нормальные условия для творчества и исследования, я вообще буду сублимировать в ваших симуляциях крайне редко

вы тут что, посты трёте? я задавал вопрос, что есть хорошего на Т4 развернуть кроме mistral nemo, но нет ни вопроса, ни ответов на него. так что удваиваю вопрос. по ресурсам вот скрин

Нахуя ивангаю ллм сервак и почему такой нищенский?

хм, что? не прогрузились, видать 🤔

>Temperature=0.7

>TopP=0.8

>TopK=20

Как-то эти семплеры для квена сосут

Сейчас пробовал русик на 0.5 temp, остальное нейтрализовано кроме rep pen, порпшил так уже на английском и результаты показались лучше

Так же в дисе советовали темп 1 и min p 0.04

>TopP=0.8

>TopK=20

Как-то эти семплеры для квена сосут

Сейчас пробовал русик на 0.5 temp, остальное нейтрализовано кроме rep pen, порпшил так уже на английском и результаты показались лучше

Так же в дисе советовали темп 1 и min p 0.04

Держите меня семеро, я щас со смеху скочерыжусь.

Помогите новичку, только хочу вкатываться, сейчас как раз назрел вопрос по сборке нового системника.

Какую мне видюху взять, почитал про это все - столько параметров навалилось, что плаваю в том, что важнее.

Буду брать что-то стандартное потребительское игровое, а не профессиональное серверное.

Вроде как по соотношениям цена и параметры RTX 5070 Ti золотая середина (16 gb, PCI Express 5.0 x16...)

Или есть что-то побюджетнее, но для нейронок разницы особо не будет?

Какую мне видюху взять, почитал про это все - столько параметров навалилось, что плаваю в том, что важнее.

Буду брать что-то стандартное потребительское игровое, а не профессиональное серверное.

Вроде как по соотношениям цена и параметры RTX 5070 Ti золотая середина (16 gb, PCI Express 5.0 x16...)

Или есть что-то побюджетнее, но для нейронок разницы особо не будет?

это на чём?

upd: просто как вижу золотые середины ценовых сегментов сейчас - это либо 3060 (12gb) за 30к или 5070 Ti за 80к

Судя по следованию карточке какой-нибудь 12б васянотюн

Не, это официальная медицинская 27б гемма, Q4KM ггуф от анслота.

Там тестовый реквест для ИИ, через ООС-команду на демонстрацию эмоционального ренжа и прочих возможностей по следованию промптов.

То есть ответ не был сгенерирован по линии продолжающегося ролеплея, а напротив - в рамках технического балабольства.

Модель на удивление послушная. Если форсировать ризонинг, активно планирует действия и создает черновики, а также их критику. Причем, многоэтапно:

> draft 1

> critique 1

> draft 2

> critique 2

> blah-blah-blah, not enough

> draft 3

> we'll go with draft 3

Неприятный аспект - не умеет закрывать ризонинг, совсем, что приводит к неэстетичного вида ответам в таверне.

Без форсированного ризонинга - модель менее выдающаяся по возможностям (на скриншоте запечатлен обычый ответ).

>KM

KL.

12гб это ниачом, 16 жить можно, но разве это жизнь?

жизнь начинается с 24гб, 3090 или 4090

Жизнь начинается с 48гб врам и 196рам

Ради интереса выложил свою 4090 на Авито. В течение пары часов со мной связались четыре перекупа из Москвы, двое готовы были купить через наложку, двое и вовсе по предоплате, за 175к. Трое честно признались, что отправят в Китай, чтобы ее потом перепаяли на плату с 48гб видеопамяти.

Делюсь на случай, если вдруг кому такое интересно: это по-прежнему актуально. Можно, теоретически, продать 4090 за 180 и взять на Озоне 5090 за 210-215, но для этого нужно ловить редкую скидку или согласиться на бонусы (с ними есть нюансы). Насколько оправдано - тут уж каждый сам решает. Для меня эта затея того не стоит, ибо у меня ботлнек по памяти - DDR4. Многого не выиграю. Весь прикол задумывался в том, чтобы заменить б/у видюху, которой почти 3 года, на новую с минимальной доплатой, но у меня нет затычки на время выжидания скидки, а больше условных 30к я за это отдать не готов. На Озоне в отзывах, кстати, много людей, которые так и поступили: продали 4090 за 170-190к, взяли 5090 за 215-220. Офигеваю, конечно, от таких цифр, особенно когда свою 4090 взял за 135к, новую в 2023.

Делюсь на случай, если вдруг кому такое интересно: это по-прежнему актуально. Можно, теоретически, продать 4090 за 180 и взять на Озоне 5090 за 210-215, но для этого нужно ловить редкую скидку или согласиться на бонусы (с ними есть нюансы). Насколько оправдано - тут уж каждый сам решает. Для меня эта затея того не стоит, ибо у меня ботлнек по памяти - DDR4. Многого не выиграю. Весь прикол задумывался в том, чтобы заменить б/у видюху, которой почти 3 года, на новую с минимальной доплатой, но у меня нет затычки на время выжидания скидки, а больше условных 30к я за это отдать не готов. На Озоне в отзывах, кстати, много людей, которые так и поступили: продали 4090 за 170-190к, взяли 5090 за 215-220. Офигеваю, конечно, от таких цифр, особенно когда свою 4090 взял за 135к, новую в 2023.

> заменить б/у видюху, которой почти 3 года, на новую

Ты че, озверел? Видюха и 30 лет проработать может. У меня вон валяется гтх 480. До 2023 у пиздюка родственников стояла, а она одна из самых горячих и охлад на модели всратый.

>А докупить рам не вариант? Он реально быстрее на 50%.

Совершенно. 64GB - потолок этого железа, причем набор стоит 4х16. Так что - там все менять надо для этого, даже диски (т.к. 6x SATA используется, а у новых плат - только 4 слота поголовно).

> Видюха и 30 лет проработать может.

Так то оно так. Но может и не проработать. Мои предшественницы - 670, 780 Ti, 2080, все погорели в пределах пяти лет. Если первая по неопытности, возможно (не обслуживалась, корпус был так себе), то последние две - при андервольте, в свободном продуваемом корпусе. 4090 сейчас работает с power limit 70%, по-хорошему надо бы обслужить, заменить термопрокладки, пасту, но она пока еще на гарантии. В целом температуры пока норм, пойдут дальше - забью на гарантии и обслужу.

Что за медицинская гемма? Промпт?

Официальный тюн третьей геммы, которому вместо экстенсивной промывки мозгов соевой моралью дали знания об анатомии и прочем. Может тебе про письки подробно в деталях обрисовать

https://huggingface.co/unsloth/medgemma-27b-text-it

Промазал мимо ггуфа

https://huggingface.co/unsloth/medgemma-27b-text-it-GGUF

Версия с вижном тоже есть где-то там, но я не помню, делали ли под нее ггуф.

базашиз, спок.

у пюдипая есть, значит и ивангаю нужно

>12гб это ниачом, 16 жить можно, но разве это жизнь? жизнь начинается с 24гб, 3090 или 4090

ну по финансам это больно ударит, сейчас точно не смогу скорее всего уже варианты на 24 гб рассматривать

сейчас смотрю на 3060 12 гб и 7600 xt 16 гб - это все ценник 30к

лови б/у 3090 на лохито

И как она в плане сэкса?

в чем подвох?

меня наебут, я даже проверять их не умею и особо не шарю в тонкостях железа

Какой промпт напишешь, так и полетит.

Не еби себе мозги, паси уценку в Регарде. Будет дороже (там обычно по 65к улетают), но хотя бы месяц гарантии дадут и сразу можно в сервисной коморке попросить проверить после оплаты.

Правда шанс попасть на убитое говно точно так же высок. Короче это чуть меньшее зло, но никак не спасение.

техническая трабла