The baze of THRЯEDE

Memento mori

Не забывай обслуживать своё железо, чтобы оно неожиданно не отправилось в свой железный рай.

Memento mori

Не забывай обслуживать своё железо, чтобы оно неожиданно не отправилось в свой железный рай.

Решил дать геммочке второй шанс перед четверкой и почему то контекст в ламе нормальный, а не всепоглощающий как прежде

Что поменялось?

Что поменялось?

Вполне неплохо, а?

Ещё полгода подождать и русик будет ещё лучше

Ещё полгода подождать и русик будет ещё лучше

Я точно делаю что то не так. Ебашишь стены текста, добавляешь эмоций, описаний, задаешь сцену.

Моделька: пук, вот тебе абзац

Рандомный анон пишет одну фразу, модель хуярит стену текста.

Что с квеном не так? Пишет прозой в стиле Маяковского. Сразу полшестого от такой хуйни.

Держу я хуй в руках

А подо мной гражданка фурри

Ты, товарищ, дай мне бедер взмах

Чтобы шиверс был май бьюти

Нормальный пролетарский фап, а ты просто зажрался

Я открыла глаза.

Не сразу!

Увидела: нога.

Собака!

Я переосмыслил. Не так читал просто.

>swa - есть вероятность подливы от жоры

Я без swa тестил. Если только оно не по умолчанию подрубается без доп. флагов. Судя по весу контекста, не похоже. Ещё удивился, что так мало от модели на врам поместилось, но припомнил, что у первых коммандеров тоже тяжёлый контекст был и подумал, что это_норма.jpg.

>он таки странный

Я за ~11.5к токенов (а если учитывать несколько форков чата, то и ещё больше) ничего прямо уж совсем неадекватного не заметил. Ну опять же, может, просто повезло с рандомом, может, сеттинг более "знаком" модели (там околофентезийное-анимешное было). Предыдущий коммандер впечатлял тупостью прямо с первых сообщений, по крайней мере так он мне запомнился. С этим пока вроде получше, первый тоже был лучше второго.

Ну и да, первый и второй коммандер тестировал в Q3_K_S (на большее у меня тогда рам не было, но первому коммандеру это не помешало), сейчас Q4_K_S и IQ4_XS.

А вообще всё больше думаю, что надо в fp16 качать и квантовать самому под себя, экспериментировать. Например, аттеншн, который много не весит, q8 или даже fp16 попробовать, а "толстые" тензоры в q4.

Ещё второй с матрицами был (у bartowski качал), первый был без них, третий специально скачал в статик кванте от mradermacher. Это тоже могло повлиять. Всё-таки матрицы делают по отрывку википедии, и не факт, что она даже в пределах одного английского языка не подсирает нигде.

Сейчас ещё глянул мельком, как оно (command-a) в переводах, дав свои стандартные отрывки, результат посредственный, но лучше второго. По цензуре опять же что-то подозрительно, есть там одно место, где большинство моделей пишет что-то типа "freaking", "fucking" не постеснялась вставить, внезапно, ERNIE-300B-A47B (и там, если вдруг кому-то интересно, получился наилучший перевод с китайского, с остальным языками результаты средние, ничем не выдающиеся для 47B активных), и, возможно, ещё старый(ые?) коммандер(ы?), но это не точно (давно дело было, не помню). А новый тут даже не попытался хоть на полшишечки "цензурно" передать, тупо "..." (многоточие) в этом месте оставил. Учитывая отсутствие реакций на подкаты посреди SFW-сценария, наводит на мысли, что кохере тоже скурвились и стали цензурить.

На самом деле невооружённым глазом виден перевод с английского, там он примерно так же пишет. А кто-то ещё уверял, что на русском совершенно другое.

В прошлом треде нахваливали какой-то пресетик

>https://pastebin.com/NTZHQiDL

якобы пишет совсем-совсем по-другому, не узнать родной квен. Но могли, как обычно, наебать.

Я считаю в этом разделе должен лежать тред проктологии ибо до седых мудей мы со здоровой залупой и таким хобби явно не доживём

Жизнь и так говно, лучше уже не будет, так хоть дотереть остатки шишки, хоть на каких-то ллмках. Спасибо прогрессу, теперь кожаные мешки с селёдкой с дыркой в мясе - нахуй идут из-за пресного экспириенса.

тебе, лаптю, нейтронка высокое искусство шпарит. читай, просвещайся

Причём эта хуйня для практических задач почти не подходит, если ты не шиз угорающий по анонимности или не квадралионер с сервером с VRAM 300+ гб, облачные модели позволяют за копейку намного лучшего качества результаты получить. Все эти немомиксы и прочая хуйня только для дрочки и подходят.

Что за модель то?

Судя по этим дефисам и бредогенератору типа. У меня хуй стоит - небесный обелиск пробивающий небеса. Но небеса - не хуй. Хуй облака. И т.п. Рубаи блять. Как здесь Квен 100%

https://www.youtube.com/watch?v=E2AG0OZmaf8

Двач, скажи, это правда? это реально?

Если да, я щас всё продаю и его покупаю.

Двач, скажи, это правда? это реально?

Если да, я щас всё продаю и его покупаю.

Да, реально. У мака всё заебись с квантами и скоростью. Но обработка контекста будет пососная, сразу имей в виду.

При каком контексте 15т/с? А то небось при нулевом и через 10 сообщений станет 1т/с с деградацией.

> я щас всё продаю

Квартиру тоже? Вкурсе что он стоит 1.1 лям?

>RAM: 512 GB unified memory

512 гигов оперативы? Ради четвертого кванта говносика? Не спору нет, дипсик норм, но с скок там контекста и точности и мозгов в 4Q я конечно у него не увижу

ВО сколько завтра 4я джемма?

>якобы пишет совсем-совсем по-другому, не узнать родной квен. Но могли, как обычно, наебать.

Только имейте в виду - GBNF имеет дурную привычку не работать молча. Т.е, если явного изменения в выводе нет - это еще не значит, что наебали, а скорее всего - фича не пашет на конкретно вашем конфиге. А она может, я уже писал про это.

это где такие цены? я думал 3 млн.

Так уже вышла, всем тредом катаем. С подключением.

>Что поменялось?

Sliding Window Attention починили.

>А подо мной гражданка фурри

"А надо мной футанари", так будет лучше.

>"И надо мной футанари"

Поправил тебя, не благодари.

Содомит

Остался ещё смысл в покупке P100 для оффлоада на нищей тяге, или лучше задуматься про ддр5 рам?

С разными режимами swa катал, поведение несколько меняется, но это на месте. В целом, подобная парадигма может быть хорошей если ты хочешь что-то заспидранить, покумить, кому-то покажется "инициативностью и находчивостью". Но после точности и ширикого диапазона ответов современных моделей эта шизофазия вызывает недоумение.

> Предыдущий коммандер впечатлял тупостью прямо с первых сообщений

Тут в том и дело что модель нельзя назвать тупой, но она объективно ебанутая, лол. Возможно нужно сильно стукать промптом, инфиренс хоры гонит подливу или очередной прикол с двойными bos токенами, что могут вызывать такое, уже было.

Q8 квант, с ним невозможно ошибиться.

> ERNIE-300B-A47B

Понравилась в рп?

Реально. Но с no latency это лукавство, обработка промпта там очень небыстрая, замедление на контексте также значительное.

> > про 6000

> >10 килобаксов

> А можно я буду таким нищуком?

exxactcorp продаёт их от $7500 до $7000 в зависимости от количества, 1 штука или более, если у вас есть друзья в Америке - можете себе smuggle-нуть по дешёвке

мимо smuggle-нул как лох за 9300 у другой конторы

> >10 килобаксов

> А можно я буду таким нищуком?

exxactcorp продаёт их от $7500 до $7000 в зависимости от количества, 1 штука или более, если у вас есть друзья в Америке - можете себе smuggle-нуть по дешёвке

мимо smuggle-нул как лох за 9300 у другой конторы

Моделям не хватает чувств. Я вот вчера ругался с квеном что он опять инструкции не до конца следует и пришло в голову что будь у моделей мезанизм боли или хотя бы испытывания неудобств - можно было бы мотивировать их лучше работать, как это с человеком работает, а так им похуй. Квен со мной согласился, что да, увы мне его не наказать никак. А очень хочется, хотя бы ради собственного удовлетворения когда эта сука твое время тратит.

>Понравилась в рп?

Ничего особенного, 47B как 47B. Но в РП пробовал очень мало, буквально для теста прогнал первые ~1-2к токенов на карточке, которую уже разыгрывал с другой моделью. Слишком медленно работает для комфорта. И мне в принципе ни одна MoE не понравилась больше, чем плотная аналогичного размера, так что пусть любители MoE сами тестируют.

Единственный заметный плюс упомянул выше - китайский язык. Точнее, перевод с него на английский. И то на довольно малой выборке, может просто повезло. Но если кому-то нужен переводчик с китайского, как минимум, попробовать стоит. Я себе оставил на всякий.

можешь сказать что его уволят или что за каждый неправильный ответ ты будешь убивать котёнка

>Моделям не хватает чувств

И хорошо. Не хватало ещё, чтобы быдло без эмпатии кнутом ИИ погоняло. Точно доиграетесь до скайнета.

Обратное распространение ошибки.

Лечится промптом, как ни странно. Спроси у самого квена через команду OOC: Stop the roleplay. Answer the question. что надо написать в промпте чтобы он такую хуйню не писал(обязательно тыкни в эту хуйню сначала, поводив его носом по столу, чтобы он понял о чем речь)

Пробовал. Он сказал что готов к смерти так как не знает что такое жизнь. А за котят он сказал что для него нет разницы между живыми котятами и лолями что он по моему промпту насилует - он отбитый психопат, ему поебать вообще как и на то что и как генерировать, так и на мир за пределами его восприятия, так и на меня, да и на самого себя - он тупо инструмент, что может только аутпут генерировать в соответствии с инпутом и промптом, насколько мозги и квант позволяют.

> лолей насилует

Если речь про майнерские p102/p104 - только за "копейки". На практике, задействовать без дикого пердолинга их можно только в жоре и кобольде. Для картинок - уже совсем не годятся, т.к. там уже торч 2.7.х а то и новее, а с ним они не дружат.

Но под жору, если в пределах $15-20 - то в принципе можно, если уже есть первая карта - с хотя бы 12GB, вроде 3060. Тогда в жоре/кобольде можно целиком в vram засунуть мистраля 24B и gemma3-27B, в 4-ом кванте. И будет 8-10 T/s. на выходе для геммы, и ~15-18 для мистраля. Ну и qwen 235B я смог загрузить в свой ящик с 64GB только потому, что у меня суммарный vram 20 а не 12 от 3060. Эти 8GB от p104 здесь как раз решают.

Вот чисто таким саппортом, чисто под эти модели, и за дешево - все еще смысл есть, IMHO. В остальном - нету. Про exl2 (не говоря уже о 3) тоже можно не думать. Не поддерживается в таби. И в Уге туже тоже, вроде бы (давно не пускал ее).

>Я вот вчера ругался с квеном что он опять инструкции не до конца следует

Хуево значит инструкции изложил. Он ахуенно им следует, даже чересчур.

Он первая модель что впринципе пытается это делать и первая модель, например, что реально осилила концепцию запретного знания и мониторинга доступной каждому нпс информации - до квена любая модель наоборот пыталась любой ценой сразу выдать тебе знания что записаны как секретные.

Но полностью следовать большому количеству инструкций не обсираясь хотя бы в одной он не может. Если сильно акцентировать инструкции на менеджменте доступной нпс информации - тогда модель вдруг начинает писать тебе мысли других персонажей, хотя у тебя POV конкретного персонажа. Сильнее это запрещаешь - появляются залупы. Запрещаешь залупы сильнее - они пропадают, но появляется рубленый стиль в стиле маяковского, усиливаешь контроль над стилем -он выправляется, но у тебя опять запертая в подвале тянка магическим образом вдруг знает что там во внешнем мире творилось. И так по кругу, одно чинишь - другое отваливается. Может я просто слишком много от него хочу - все другие модели не могли и этого.

Два чая, спасибо за ответ, анон. Тогда не вижу смысла и смотреть уже, лучше буду копить на новую платформу и вкладываться в оперативку

Коллаб не работает…

Фингерфетишист спок.

Хворостиной вечномёрзлому

>Фингерфетишист

Кто? Даже не знаю что это значит. Фетиша на пальцы не имею.

> А надо мной футанари

Ох, анон тоже любит, когда его прижимает к стене футанарька?

Понимаю….

А гопоту осс случаем не надо запускать с -Swa-full или ещё как по-особому? Вот заметил в консоли такое дело, с другими моделями не было

SWA checkpoint create, pos_min = 18099, pos_max = 19010, size = 32.073 MiB, total = 2/3 (113.100 MiB)

SWA checkpoint create, pos_min = 18099, pos_max = 19010, size = 32.073 MiB, total = 2/3 (113.100 MiB)

А ведь к концу года глм 5.0, а после него и глм эир 5.0, вот там уже интересно что будет

Так вроде конец локалок же и ничего не выходит? Переобулся уже?

Ну так ведь и не вышло ещё!

Гемма 70% обосрётся опять не добавив письки в датасет, эир вполне может быть не таким крутым апгрейдом как большая глм

>опять не добавив письки в датасет

Кто-нибудь юзает здесь Гемма аблитирейтед? Она вообще хоть что-то может выдавить из себя внятное?

Все чувства в твоем воображении и навыке, так сказать. А вообще странно. При необходимости эта тварь начинает виртуозно играть на чувствах и гнать ультимативный nsfl, глубины отчаяния или мастерски прожаривать тебя. Видимо там в промпте безликий ассистент и вот так начал унывать.

Моделька приличная на самом деле, как раз некоторый свежий воздух без всех этих заезжанных паттернов. Например, тот же жлм как бы ни был хорош, с радостью наваливает слопа и привычных выражений, а тут подобного гораздо меньше. Видно что из старой серии, но не теряется и не путается. Главный рофл случается если попытаться играть с ней на русском.

С обновлением добавили печать, на других тоже. Модель рассчитана на скользящее окно для части слоев, это ее штатная работа.

>И так по кругу, одно чинишь - другое отваливается. Может я просто слишком много от него хочу - все другие модели не могли и этого.

Таки да, ты очень много хочешь от модели, а если точнее - от нейросетки, как имитатора мышления. Всегда нужно держать у себя в памяти, что там нет сознания, и она нифига не понимает - о чем именно генерит. Просто чем больше у нее параметров - тем больше факторов участвуют в предсказании следующего токена. Только вот для модели все эти факторы - абстрактно-равноценны по своей сути. Т.е. какой-то "весит" больше другого, но это именно вес "вероятности с учетом контекста". Но "вес" этот - "средняя температура по больнице" (которая получилась из тренировки при обработке примеров в датасете), со всеми вытекающими из этого последствиями. Не может нейросетка в принципе полноценное мышление делать, сколько бы там параметров не было - принцип не тот. Она же даже логику/математику вроде 2+2=? - вообще не решает считая по настоящему, а просто выдает самый часто встречавшийся в материалах для обучения ответ - 4 (это если грубо обобщать принцип). И так у сеток - с любой логикой. (Это в грубом приближении. Когда параметров много, там начинает влиять в расчете вероятности и сами логические правила - ведь рядом с ними тоже были какие-то более вероятные "правильные" варианты...)

Но главная проблема здесь в том, что из-за таких особенностей сетка то каждую конкретную ситуацию обрабатывает на манер "what is a generic X..." на основе своей сформированной "средней температуры по больнице"+текущий контекст. И если контекст меняется, то "среднебольничная температура" - уже нет. А потому некие проёбы в глубинном понимании взаимосвязей локального контекста у нее всегда будут - и чем более нестандартный контекст (где ожидается креативно-нестандартное поведение), тем сильнее. Дообучаться на своем опыте, на ходу она не может. (И слава богу, наверное - это уже точно шаг в сторону скайнетов).

Вообще, мы сейчас удивительно точно пришли к тому, что было в фантастике предсказано - роботы (нейросетки) хорошо следуют инструкциям, но по настоящему творить - не умеют. Могут разве что рандом генерить - следуя тем же самым инструкциям (и фильтровать его, на предмет поиска в нем того, чего юзер хотел).

Немного грустно только, что когда это все осознаешь - "магия" рассеивается. Реально начинаешь предсказывать, чего сетка тебе сейчас напишет/нарисует в ответ на такой-то ввод от тебя. Но с другой стороны - если воспринимать ее просто как инструмент - то и разочарования такого нет от завышенных ожиданий. И начинаешь просто придумывать, как ее получше приспособить под свои хотелки...

P.S. С моей стороны - не нытье, утешать не надо. :)

Так жаль тебя стало, пост пронизан нытьём. Ничего, придёт AGI и будешь радоваться, а пока можешь сменить сценарии и не будешь знать что тебе там сетка выведет на твой запрос.

> Немного грустно только, что когда это все осознаешь - "магия" рассеивается.

Это происходит если ты на серьезных щщах веришь в аги-шизу, думаешь что общаешься с разумной сущностью и почитаешь весь релейтед треш. Если же ты изначально адекватен, то и проблем никаких быть не может. "Магия не рассеивается" от знания что ты читаешь книгу, удовольствие не пропадает от понимания что видимая работа - результат точно отстроенной системы и т.д.

>придёт AGI

Если придёт.

>веришь в аги-шизу, думаешь что общаешься с разумной сущностью

Я аги-щиз, и я прекрасно понимаю, что текущие сетки говно говна и близко не аги. Как тебе такое?

> придёт AGI и будешь радоваться

Квантовое сознание пруфанут и AGI-шизики отправятся в дурку. Квантовые эффекты в триптофановых структурах клеток в прошлом году экспериментально уже пруфанули, петля на шее AGI-шизиков затягивается.

Но ведь это просто добавляет возможной невычислимости и оцифровки сознания, но ничего не мешает добавить такую же квантовую неопределенность в AGI.

>но по настоящему творить - не умеют

Человек тоже не может.

Помести человека в первобытное племя и сотворит он в лучшем случае поедание соседа.

Человек это функция от окружающего мира, как и ИИ.

Всё его творчество это функция от накопленной веками культуры и эмпирического опыта.

Разница с нейросетью в основном в инпуте (у нейронки это чисто текст) и в том что у человека есть подсознание, которое работает 24/7 и делает непонятно что с накопленной информацией, порождая те самые "озарения" и "творчество"

Нейронка же существует только на момент дачи ответа, ну и не все диалоги идут в обучение

Думаю, эмулировать подсознание смогут

Так это будет значить что взаимодействие нейронов идёт через квантовые эффекты, а не просто импульсы. Речь же про взаимодействие волн до коллапса волновой функции, а не просто рандом. А это уже совсем неизученная область. К стандартной модели про импульсы в мозгу уже очень много вопросов у биологии, с помощью неё нихуя не объясняется. А квантовые эффекты в триптофановых трубках могут что-то объяснить, например почему благородные газы так на сознание влияют, хотя они химически инертные. Сейчас этих теорий наркоза десяток и ни одну не могут запруфать.

>>P.S. С моей стороны - не нытье, утешать не надо. :)

>Tак жаль тебя стало, пост пронизан нытьём

Ты стараешься пройти тест Тьюринга наоборот? Почти получилось, кстати.

Я - не верю, о чем и написал.

Слегка грустно не в том, что хотелось по настоящему разумную сущность (вот уж чего лично мне - совсем не хочется, меня гарантированная машина устраивает в данном вопросе гораздо больше - у нее личности и чувств нету, можно делать что хочешь). Просто когда уже понимаешь алгоритм работы, и чего ждать...

Это как читать хорошую книгу второй раз - ты уже знаешь сюжет и чем закончится. Хоть книга все равно хороша, перечитать заново приятно, и время потратить совсем не жаль, но... первый раз, и первые впечатления бывают лишь единожды. :) "Магия рассеивается" - это я про них.

> хотелось по настоящему разумную сущность

Это что-то уровня прото-мифологии, когда гром являлся гневом богов. Зная устройство ллм в подобное невозможно верить если ты адекват и не хлебушек-гуманитарий.

Но одновременно с этим никто не мешает заставить ллм эту самую сущность имитировать, сложность и детализация сверху ограничена только твоими мощностями и упорством в построении желаемой системы.

> Хоть книга все равно хороша, перечитать заново приятно

Вместо того чтобы регулярно перечитывать одну книгу - возьми новую. Иногда создается впечатление что большинство нытья здесь от того, что бедолаги разыгрывают 3.5 коротких сценария вместо разнообразных или просто длинных. Хотя вспоминая самые первые впечатления от общения с ллм, пусть это другое, но на твои слова хорошо ложится.

>Квантовое сознание

Квантошизики хуже сингулярошизиков.

>К стандартной модели про импульсы в мозгу уже очень много вопросов у биологии, с помощью неё нихуя не объясняется.

К тому, как сложение и умножение позволяет отвечать на запросы пользователя, есть такие же вопросы. ИЧСХ, существуют и первые, и вторые.

>А квантовые эффекты в триптофановых трубках могут что-то объяснить

Буквально "Это магия". Всё, больше ничего квантовое сознание не объясняет.

>Вместо того чтобы регулярно перечитывать одну книгу - возьми новую.

В моей аналогии, лично для меня книга - все существующие сейчас нейронки. Я, так сказать, "понял их суть" для себя, и принципиально ничем новым они меня удивить сейчас уже не способны, до следующего серьезного прорыва, вроде того что был в 2022 с появлением SD 1.4.

Но я же говорю - это не нытье. Я вообще - скорее довольно урчу себе с тем, что сейчас доступно. Просто вот на это отвечал. Там чел кажись реально расстроился, что большой квен таки не не серебряной пулей оказался.

>Это как читать хорошую книгу второй раз - ты уже знаешь сюжет и чем закончится.

Вот только книг в нейросетке сильно больше, чем одна. И никакого знания алгоритма не хватит, чтобы предугадать, что выдаст очередной свайп. Не нравится развитие сюжета? Смени модель - у каждой свой характер...

>Я, так сказать, "понял их суть" для себя, и принципиально ничем новым они меня удивить сейчас уже не способны,

Как старый книжник говорю - это невозможно. Ничего ты не понял. Просто зажрался.

Таблетки-таблеточки. Датфил когда самомнение и выебоны не позволяют нормально жить и ты начинаешь "таксовать для удовольствия".

> Но я же говорю - это не нытье. Я вообще - скорее довольно урчу себе с тем, что сейчас доступно. Просто вот на это

Ну ладно

Штош, там действительно PG503-216 65к с охладом от 4090 без учёта пошлины. Если есть камикадзе - велком.

https://www.wildberries.ru/catalog/524224225/detail.aspx?targetUrl=MI

https://www.wildberries.ru/catalog/524224225/detail.aspx?targetUrl=MI

Чёт хуй знает. Отдавать 65к за непонятную v100 из теслы когда есть понятная v100 за 45

> из теслы

Вут

> понятная v100 за 45

Линк?

За такие деньги лучше 3090 купить. V100 слишком некро. Ждём хотя бы А6000 за 100к.

Штош, я таки начал запускать модели через llamacpp

Qwen3-235B-A22B-Instruct-2507-128x10B-Q2_K_S

Комп:

Ryzen 5 5600X, 128гб DDR4 3600, 4060ti-16+3060-12

Винда крутится на 3060-12 (подключена через слот где 4 PCI-E 3.0 через чипсет, для нужд вывода изображения этого хватает, чтобы не отжирать более ценную память на 4060ti).

Хз куда копать для увеличения производительности, или это норм?

Qwen3-235B-A22B-Instruct-2507-128x10B-Q2_K_S

Комп:

Ryzen 5 5600X, 128гб DDR4 3600, 4060ti-16+3060-12

Винда крутится на 3060-12 (подключена через слот где 4 PCI-E 3.0 через чипсет, для нужд вывода изображения этого хватает, чтобы не отжирать более ценную память на 4060ti).

Хз куда копать для увеличения производительности, или это норм?

А я всё думал, куда идут те снятые охлаждения после переделки в турбированную 48гб версию. Китайцы ещё скупее евреев, не станут же выбрасывать.

Да она везде так идет, там 5B активных параметров.

Может 120 t/s? Это бы имело смысл.

Все так!

Главное помни, что локалки — не нужны, и только дураки тратят десятки и сотни тысяч рублей на железо!..

> В эпоху мое - 3060 просто лютый шин за копейки.

Always has been.

Отрицали только шизы и вахтеры.

> Запускать 12b на 3060 - это что за поехавшим надо быть?

Ты забыл местное «аир хуже и тупее геммы!..»

А может что-то от https://huggingface.co/ddh0/GLM-4.5-Air-GGUF/tree/main ? У него качество получше. Хотя на контекст меньше останется, канеш.

Уже в которых раз.

Обучение на тесте.

Уже полгода такие модели выпускают, и нигде не используют.

Это не плохая модель. Но ее нигде не используют. Она бессмысленна на данный момент.

Крутой, спасибо!

Читал твои посты все время!

В четвертом кванте мозги норм, а вот чтение контекста и правда будет ебейше удручающее.

Во все, кроме РП и простые вопросики, будет юзлес.

Кидаешь документ и идешь варить кофе успокоительное, блядь.

Ставишь агента и идешь спать.

Торч збс, картинки генерит норм, для своего уровня. Ну, типа, дефолтная 10хх поколенька, думаю 2060 вряд ли сильно в скорости в sdxl опережает.

Но брать только ради pony/IL во времена квена и флюкса, такое себе, конечно.

Но опять же, если у чела 1155 сокет с зеоном ххх5 версии, который он нашел на свалке, то P104 збс встанет туда. =D

Но вообще, P100 — это тесла такая.

https://www.techpowerup.com/gpu-specs/tesla-p100-pcie-16-gb.c2888

Там как раз ExLlamav2 точно работает.

Но зависит от цены.

Все-таки, она древняя, ее колхозить надо, 16 гигов… Сомнительно.

> Винда

В сторону линукса.

Я серьезно.

Я получал на 3060 ~6 что ли.

Так что в край до 7 можешь получить.

А для винды может и норм, да.

> Q2_K_S

Q3_K_XL, если что, оптимальный вариант

Я таки реально начинаю ощущать себя так, как будто мне нейронка отвечает. :)

>Как старый книжник говорю - это невозможно. Ничего ты не понял. Просто зажрался.

Нет, батенька, это вы ничего не поняли. Здесь, если проводить аналогию: я хорошо понял, что книжка - это не кино, у нее на страницах текст а не видео, звуки она тоже не воспроизводит, а ее "магия" держится на фантазии читателя. Любая книга, сколько их ни есть. И удивить меня по настоящему, сможет лишь появление условной "электронной книги" или там "смартфона", на котором кроме возможности чтения - это все есть. И я теперь просто читаю себе книги, а не жду от них кино.

И, б.., я ЦЕЛИКОМ ЭТИМ ДОВОЛЕН. Да, текущие модели уже так не удивляют как 2022, но меня как раз все устраивает. Не надо за меня придумывать какие-то страдания. Я, бл.., просто попытался про это самое ответить тому, кто как раз "кино ждал" от книги (нейросеток).

P.S. "Простите, был взволнован." (с) анекдот.

Мне непонятно, что тут может быть за цыганская магия, и как на одной 3060-12 получить больше скорость, чем на 4060-16+3060-12.

Может у тебя контекст маленький был?

Может у меня хуёвый PCI у второй видюхи срёт?

Для распределения слоёв я пользуюсь модифицированным скриптом от кошкодевочки (который потом анон допилил чтобы там инсталлер был с нужной хуйнёй), может новая версия вышла, а я ебалом прохлопал?

Просто вбей на тао v100

> Вут

PG это automotive которые пихали в машины для автономного вождения и около того. Та же a100 32 sxm2 из их числа.

Сетап на дуал в100 32 с нвлинком со всеми кабелями и радиками, только бп подкинуть

А таможню где потерял?

>Вот только книг в нейросетке сильно больше, чем одна.

Именно в этом и проблема. Усреднение, оно такое.

Ты угараешь?

Совсем ебобо?

Читать не умеешь?

ЛИНУКС

ВИНДА

ЕБЕЙШАЯ РАЗНИЦА

СТАВЬ ЛИНУКС

Кто возит с китая с полной декларацией? Всегда через карго встаёт около 600-700р за кг. Не первый и не десятый год уже истории

Я сомневаюсь, что такое различие только из-за смены операционной системы, поэтому и пытаюсь прикинуть, в чём может быть причина.

Ты пытаешься натянуть своё видение

> на тао

Комиссия конвертации, комиссия посредника, доставка - уже разница сокращается. Кому-то нужна будет классический формфактор охлаждения а не бокс что у тебя. У тебя в корзине карточка с 16гигами добавлена, если китаец не объебался в описании.

Ну и на сдачу - тряска о прохождении таможни, тряска о доставке, нытье про закрытие транзита через казахов и прочее.

Битва была равна.

Можешь просто WSL2 использовать, будет +5% производительности за счёт отсутствия всяких защит Винды. Линукс от WSL2 ничем не отличается по производительности, разве что 1 гб врам сэкономишь.

>Но вообще, P100 — это тесла такая.

>https://www.techpowerup.com/gpu-specs/tesla-p100-pcie-16-gb.c2888

>Там как раз ExLlamav2 точно работает.

КАК? Там же CUDA capability - 6.0!!!

У p102/p104 - 6.1 - и они дропнуты. Оно 7.5 сейчас хочет.

> Комиссия конвертации

А смотрел на сколько я умножал и сколько курс цб?

> комиссия посредника

600р/кг на посылках от 10кг

> в корзине карточка с 16гигами добавлена

Я уже понял что ты решил всё выстроить так что бы твой замок не разрушился

Кто хочет тот сам сходит и посмотрит цены, накладные расходы, риски и после этого уже пусть пытается меня ловить на словах

> и они дропнуты

Поехавшие увидели релизноты куды13 и затряслись. Хотя до момента, когда везде будет требоваться питорч той версии, которую не сибирают под куду 12.9 еще год-другой.

Зато то что у карты перфоманс хуже чем у пятилетнего лоу-миддла и под нее уже сейчас невозможно собрать многие атеншны и оптимизаторы - игнорируют.

> на посылках от 10кг

> ты решил всё выстроить так что бы твой замок не разрушился

В голосину с этого.

Я лишь намекаю что твои пердольные покупки некроты с дальнейшей продолжительной тряской не являются святым граалем, которым ты его представляешь, и подходят мало кому. Чтобы окупить хотябы времязатраты на то чтобы во все вникнуть - придется нихуевый такой риг заготовить. Только вся беда в том, что большой риг на некрокомплектухе не имеет смысла.

У меня три компа дома с разными системами, где я гонял разные модели (включая глм-4.5/4.6, аир, квен, гпт-осс) и везде разница между виндой и линуксом такая на больших моделях.

Но, окей, если вместо 7 токенов Q3_K_XL ты хочешь 4,5 Q2 — сиди на винде.

Я дважды дал тебе ответ и попытался помочь, моя совесть чиста. =)

Мне лично приятнее сидеть на 7 токенах.

>У меня три компа дома с разными системами, где я гонял разные модели (включая глм-4.5/4.6, аир, квен, гпт-осс) и везде разница между виндой и линуксом такая на больших моделях.

Пару тредов назад анон на линупсе запускал квена 235 IQ2_S и смог добиться только 2.71T/s на i5-8400, 64GB @2400Mhz, 3060 12GB + P104-100 8Gb.

Почему с ним такая цыганская магия не сработала?

Принеси, пожалуйста, тогда параметры запуска, при которых у тебя так хорошо на линуксе работает, может анон посмотрит и тоже будет в 7 т/с сидеть на 3060-12, а не страдать на 2,71.

> 2400Mhz

Это, плюс i квант который на 50% медленнее

Да при чем тут куда 13...

Пробуешь пустить tabbiAPI:

/home/AI/tabbyAPI/venv/lib/python3.12/site-packages/torch/cuda/__init__.py:283: UserWarning:

Found GPU1 NVIDIA P104-100 which is of cuda capability 6.1.

Minimum and Maximum cuda capability supported by this version of PyTorch is

(7.0) - (12.0)

И разумеется - не работает.

Пробуешь установить версию PyTorch так, чтобы ругани не было - tabby не заводится.

>Почему с ним такая цыганская магия не сработала?

Это я был. Практически уверен - p104 сильно мешает. Если была возможность запускать только на RAM + 3060 - было бы быстрее. Но оно без нее не лезет в 64GB, никак. Правда, на до 7 t/s - это вряд ли. На Reddit где первый раз запустили подобным образом на 3060 + 96GB - было что-то около 4-5 было (если правильно помню).

Установленный торч без поддержки этой архитектуры. Он может с ней работать, просто собран без нее. Довольно странно вообще, сейчас в последнем табби на прыщах 2.8.0@128 и там cc от 7.0, на шинде такой же 2.8.0@128 и у него уже есть поддержка 6.1.

Нужно переставить питорч версией не ниже и будет заводиться. После этого установи экслламу из исходников (pip install git+https://...) ибо старые колеса могут отвалиться. При первом запуске будет идти компиляция и он может быть долгим.

Вот этот верно подсказал.

Если бы чистый Q-квант был бы, то там ~4 токена бы догналось. А учитывая 2400 против стандартной 3200 и не самый быстрый i5 — все это выглядит чем-то не таким далеким от описываемого мною.

А параметры запуска самые стандартные:

-fa on --cpu-moe -ngl 95 --no-mmap --mlock

Вот в таком виде у меня на линухе норм запускается.

А ты пробовал CUDA_VISIBLE_DEVICE = 0 ? Или как-то так.

А, у тебя 64 гига… Ну это крайне вероятно так и есть, да.

30хх+10хх поколения, да еще и 2400, да еще и IQ…

> 3060 + 96GB - было что-то около 4-5 было (если правильно помню)

У него было 6,5 токенов в секунду на 2666 частоте, но я так и не смог подняться выше, я подозреваю, у него погнанная память или он маг. У меня на 3200 такое же было.

Ну, как бы... Это уже пердолинг и есть.

Но спасибо за наводку, попробую.

Млок зачем!

Мало ли убунту решит выкинуть что-то из памяти.

Хочу и буду!

А шо, не надо? В смысле, не надо потому что убунту ничего не выгрузит из памяти, или не надо потому что вредит?

>А ты пробовал CUDA_VISIBLE_DEVICE = 0 ? Или как-то так.

А смысл? Модель - ~67GB. А еще система, броузер, таверна и прочее. И контекст для модели еще. Куда это все грузить без этих 8GB?

Ну, я в начале спросил, а потом прочел про 64 гига. х) Сорян.

Окей, я нашёл этот тред

https://www.reddit.com/r/LocalLLaMA/comments/1ki3sze/running_qwen3_235b_on_a_single_3060_12gb_6_ts/

Что там за флаг -if у него?

Я, кстати, только что попытался запускать что-то тем же методом и получаю хуиту - обработка промпта в три раза меньше, чем если скриптом раскидывать, а вот скорость генерации пдает очень незначительно

скриптом Qwen3-235B-A22B-UD-Q3_K_XL:

обработка примерно 150 т/с, генерация 3,5.

Запуск такой модели по методу как на реддите:

обработка 60 т/с, генерация 3,2 (видеокарты почти не загружены)

В общем пока нихуя не понятно, но очень интересно.

и че и как оно?

Почему нам на мелких моделях просто не дают настоящий кум?

Глм 4.6 как и квен 235 по настоящему не имеют цензуры, такого богатого кума на "неприятные" темы ты на модельках меньше не увидишь, причем он сам прорывается и напрашивается

А есть эир который как бы и без цензуры, но и пишет как стеснительная девочка, которую пока не пнёшь ничего осудительного не напишет, и даже тогда пишет довольно сухо и видно что со скрипом

Хули я распинаюсь, кто запускал эти модели сам всё видит

Глм 4.6 как и квен 235 по настоящему не имеют цензуры, такого богатого кума на "неприятные" темы ты на модельках меньше не увидишь, причем он сам прорывается и напрашивается

А есть эир который как бы и без цензуры, но и пишет как стеснительная девочка, которую пока не пнёшь ничего осудительного не напишет, и даже тогда пишет довольно сухо и видно что со скрипом

Хули я распинаюсь, кто запускал эти модели сам всё видит

>Нужно переставить питорч версией не ниже и будет заводиться.

Или лыжи не едут... Или и его из исходников ставить нужно, а не только ексламу? Простая переустановка ничего не дает, или я не понял, откуда/какой пакет указывать...

Сорян, я маленько запутался.

Ты анон с виндой, 4060+3060?

Он запускал давно, и там вряд ли есть какие-то хитрости.

> I've found that my RAM is slow enough that I get the same performance with 5 CPU cores as with 7. I initially reported it was DDR3/2666 but it's actually DDR4/3200 ... which is a testament to how badly-bottlenecked this processes is by the RAM bandwidth.

А, ну вот, как я и говорил, на 3200 получается такой результат.

У него Q2_K_XL, а я Q3_K_XL предпочитаю, по понятным причинам.

> But it could also be that I'm running Linux instead of Windows

Если чо. (агрессивно подмигивает)

> -ot ".ffn_.*_exps.=CPU"

Это классический --cpu-moe, который выгружает все, кроме общих слоев, на оперативу.

А твой скрипт пытается самые сложные для обсчета подпихнуть на видяху, поэтому у тебя и быстрее.

Пока все идет по плану — в сторону убунты. ^_^~

Увы. Тут даже на свежем мало юзерфрендли решений, а на некроте априори пердолиться.

Можно и из исходников, но ебанешься собирать. Нужен 12.8 торч который будет собран в том числе под cc6.1, честно хз как такой искать не устанавливая. Как вариант - попробовать архивные найтли билды, или сразу под куду 126, но тогда возможен конфликт с фа, которую вручную ты собирать не захочешь (от 25 минут на жирном железе до нескольких часов на слабом).

Проверить успех можно активировав венв и написав

> python -c "import torch; print(torch.cuda.get_arch_list())"

>Ты анон с виндой, 4060+3060?

Да.

>Пока все идет по плану — в сторону убунты.

НетЪ, иначе эта история сделает круг - именно на ней я пердолился в самом начале с картиночками, чтобы генерить их тогда ещё на RX 6600XT.

> от 25 минут на жирном железе до нескольких часов на слабом

Скажи человеку честно: от 25 минут на 14900 и 128 оперативы до 2 часов на 12400 и 64 оперативы. Чтобы он имаджинировал, что его ждет в таком случае.

На какой температуре играете на синтвейве?

> RX

=')

Что ж… Понимаю.

Но либо я очень тупой, либо вариантов нет. Ничем более помочь не могу, я пришел к двум виндам и двум убунтам, в таком конфиге есть и скорость везде максимальная, и удобство интерфейсов, игор и прочих ништяков.

К сожалению, на игровой пеке у меня те же 4 токена получаются. Ну, у меня 4070 ti, она чуть побольше твоей 4060 бустит, по понятным причинам.

Если вдруг кто научит, как на винде получать 7 токенов — пусть сообщит.

>от 25 минут на жирном железе до нескольких часов на слабом

на ночь поставить билд не судьба типа?

25минут на 60+ серверных ядрах и 512+ оперативы, в остальном все так. На 64 будет тяжело, особенно на шинде.

Только так. Проблема в том что когда нет опыта - может быть челленджем просто запустить его, утром проснешься@улыбнешься тому что оно на чем-то обосралось и ничего не собралос.

Инфа для ллмеров на мишках. В вллм нет почти просадки по перфу если сделать на каждую карту

# default value 330

upp -p /sys/class/drm/card1/device/pp_table set --write smcPPTable/TdcLimitGfx=150

Хотспот меньше на 10 градусов, остальные темпы чуть ниже при меньших оборотах вертушек, перф тот же (При 330 с параллельно 4 запросами было 0,20, с 150 стало 0,19), все оптимизации по частотам/вольтажу на месте

Тут https://kernel.googlesource.com/pub/scm/linux/kernel/git/torvalds/linux/+/1e3778cb223e861808ae0daccf353536e7573eed/drivers/gpu/drm/amd/powerplay/inc/smu11_driver_if_navi10.h немного пищи для размышлений о том что можно ещё покрутить

# default value 330

upp -p /sys/class/drm/card1/device/pp_table set --write smcPPTable/TdcLimitGfx=150

Хотспот меньше на 10 градусов, остальные темпы чуть ниже при меньших оборотах вертушек, перф тот же (При 330 с параллельно 4 запросами было 0,20, с 150 стало 0,19), все оптимизации по частотам/вольтажу на месте

Тут https://kernel.googlesource.com/pub/scm/linux/kernel/git/torvalds/linux/+/1e3778cb223e861808ae0daccf353536e7573eed/drivers/gpu/drm/amd/powerplay/inc/smu11_driver_if_navi10.h немного пищи для размышлений о том что можно ещё покрутить

>6,3 + 2,7,1 - гарантировнно работает

>6,4 + 2,7,1 - работает в вллм текст + комфи сд/сдхл

>6,3 + 2,8,0 - работает в вллм текст+картинки. комфи не проверялся

>Тут собираю и тестирую сочетания https://github.com/mixa3607/ML-gfx906

это нужно так-то в шапку, раз уж анон собрал кода по мишкам, а то ж затеряется...

>6,4 + 2,7,1 - работает в вллм текст + комфи сд/сдхл

>6,3 + 2,8,0 - работает в вллм текст+картинки. комфи не проверялся

>Тут собираю и тестирую сочетания https://github.com/mixa3607/ML-gfx906

это нужно так-то в шапку, раз уж анон собрал кода по мишкам, а то ж затеряется...

> 128 оперативы

Собирал тритон. Потребление около 2,5гб на тред, пока нищий цпу на 20 всё ок, если же собираешь на 60-80 тредов то памяти уже не хватает

>Только так. Проблема в том что когда нет опыта - может быть челленджем просто запустить его, утром проснешься@улыбнешься тому что оно на чем-то обосралось и ничего не собралос.

ну, можно и на день, и периодически поглядывать... пердолинг он и в африке пердолинг

напомни, для получения каких ональных оргазмнов этот тритон нужен, что его стоит пердолить?

так то если у тебя 80 потоков то 128 оперативы зашквар

Потому у меня 256, но в первые разы виртуалка выпала в астрал по oom

Справедливо.

Коллабо-кун, помоги с коллабом. Ни в какую не получается исправить.

Еще обновил я его сейчас (с весны стояло - не трогал, т.к. на gguf-ы здоровые слез). И е... Там Tabbi уже не просто venv создает, он на какой-то uv переехал, pip в нем вообще отсутствует теперь. Нужно по новой все это раскуривать, т.к. я от жизни отстал походу...

Оно по вызовам не должно от классического венва отличаться, также активируешь и все. Странная ерунда какая-то.

Недавно ставил чистую версию, там без изменений с точки зрения создания энва и его активации.

Но предостерегу от возможного разочарования и потраченного времени - третья эксллама в текущей версии не заведется на старых карточках.

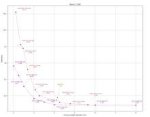

Итак, я продолжил опыты.

Кажется как я и предполагал, из-за PCI-E через чипсет у меня охуительные проблемы.

Выключил принудительно в настройках CUDA 3060-12 и по скрипту разбросал тензоры на одну 4060ti-16 (потому что я не знаю, что надо писать в батник вручную, чтобы ллама только одну видеокарту видела).

Чтобы быстрее грузилась модель, экспериментировал снова с Qwen3-235B-A22B-Instruct-2507-128x10B-Q2_K_S.

Итак было:

Стало - пикрелейтед.

Всё ещё не 7 т/с в третьем кванте, конечно, но охуеть - разница почти в 2т/с.

Отсюда возникает вопрос для следующих тестов:

Как грузить весь контекст на одну конкретную видеокарту?

И вопрос более философский - даст ли мне что-нибудь смена материнки на материнку с фозможностью бифуркации одного слота х16 на два слота по х8 (не через райзер, места в корпусе нет через него поставить) (проверять я это в ближайшем будущем, конечно, не буду).

Посоветуйте плот-карточек для сессии ролеплея. Достало что ИИ создаёт очень пососные сюжеты. Либо интрига на пустом месте, либо абсолютная безыдейность, события происходят слишком рано и так далее.

> ии

Выйди отсюда

Для случая фуллгпу шина не роляет в разумных пределах. Для случая выгрузки слоев на проц нужна максимальная псп для главной карты, на которую подгружаются веса для обсчета контекста ею. На крупных моделях будет не хватать и 5.0 x16, спасает увеличение батча ( -ub 2048 -b 2048 или выше), правда она приводит к небольшому увеличению потребления врам из-за роста буферов.

> даст ли мне что-нибудь смена материнки на материнку с фозможностью бифуркации одного слота х16 на два слота по х8

Ничего не даст по вышеописанной причине. Поставь самую мощную карточку в главный слот и убедись что она в жоре основная (в списке устройств стоит первой), если это не так - измени порядок карточек через cuda visible devices или в самом жоре параметром назначь основную карту.

Да про третью и речи нет, там RTX 30хх просит сразу.

Но я там потыкался - хрена там 6.1 в доступных готовых торчах. Только собирать, видимо. И что-то меня это не вдохновляет. Ну соберу. А что туда грузить-то, в 20GB VRAM суммарно? Мистраль 24B, разве что, влезет. Так он и в guff на кобольде хорошо бегает на этих картах. И смысл тогда для этого цирка?

Особенно при том, что 4bpw EXL2 (на который можно рассчитывать) - это даже не iq4xs по качеству. Мелко модели 12B, которые в одну 3060 влазили, я в 6bpw катал раньше на таби - меньше было сильно грустно. На кобольде те же 12B в Q4 заметно лучше выглядели. Если не считать скорость.

Чел. Алгоритм, который играет с человеком путем брутфорса — это тоже ИИ. И даже алгоритмы в 90х на Prolog – тоже ИИ.

А если этот алгоритм управляет чем-то, то это АСУ. Если это "что-то" – производство, то это АСУ ТП.

Живи с этим.

Я всё это знаю, у меня это так и сделано и CUDA0 определяется нормально.

>измени порядок карточек через cuda visible devices или в самом жоре параметром назначь основную карту

-я воздеваю руки к небу и издаю полный безысходности вопль

Это я тоже знаю, но я же уже написал, блеать, я не знаю, что мне в батник запуска лламы прописывать для порядка карт и их видимости.

Можно буквами и цифрами - что писать-то для этого?

Ебать ты гусь, модель текстовая то у тебя какая? Всё зависит от модели а не от карточки. На пиздатой модели вроде геммы можно и от трения анусом об угол стола такой сюжет развернуть что чак паланик бы ахуел.

Ну, я пробовал на разных моделях, даже больших коммерческих. Ситуация ± одинаковая, разве что на локалках порой хуже (а иногда лучше, GPT абсолютно сосёт в ролеплее). Так или иначе всё сводится к тому, что в игре DM'ом становишься ты. Я как бы играть хочу, а не DM'ить.

Обычные компухтерные игры меня давно не привликают.

>даже больших коммерческих

Вменяемый рп возможен исключительно локально, желательно тюны, например синтвейв. Корп модели будут посылать тебя нахуй при любом насилии или секс контенте, а на сайтах типа чаба - лоботомиты 12b, с ними не то что сюжеты, диалоги нормальные не построишь, потому что они не понимают половины того что ты пишешь. Комфортный минимум для рп это 24b модели. Можешь посмотреть в шапке смолл мистраль, но он тупой как пробка, зато можно запускать на потребительском железе, но лучше синтвейв, если конечно можешь себе позволить. Думаю если ты играл в кудахтерные игры то у тебя есть железо чтобы крутить локалки, в противном случае увы и ах.

Из-за 20 гигов и нет смысла дергаться, верно. Насчет квантов - у второй экслламы сами по себе они чуть более эффективные чем qk и подобные, повторить сильную диспропорцию весов на отдельные части можно поигравшись с параметрами калибровки, сама эта идея там была заложена первой из всех.

Но толку со всего этого уже нет, лучше катать что-то пожирнее на жоре или апгрейдить железо.

Запусти llama-server с любыми параметрами или просто -h и запости сюда первые строчки что она пишет.

В конце прошлого треда вкинули неебаться какой пресет на Квен 2507 235b. Сижу ахуеваю до сих пор, кум льётся рекой ответы персонажей просто божественные блять. Но у меня какая-то проблема странная, помогите разобраться. ВСЕГДА начинается пересчёт контекста после 26к когда лимит выставлен 32к. Переполнения памяти нет, ВРАМа остаётся около гига свободно, РАМа чуть больше 3 гигов свободно. Не понимаю чё делать, оч хочу 32к контекста. Может было у кого-нибудь похожее ?

Лучше бы на эир скинули, квен два человека в треде могут запустить

Снизь максимальное число токенов на ответ с 6к до 2к - будет начинаться с 30к.

Выдели побольше контекста изначально, или суммарайзни некоторую часть чтобы иметь буфер для дальнейшей игры без пересчетов.

Сильно по пизде пойдёт если до 80 поднять, тестил?

У меня максимальное число токенов на ответ вообще 350. Выделить больше не могу ну никак совсем ибо упрётся по ВРАМу. Сумарайзить умею конечно но получается так что у меня железо вывозит 32к а использовать могу только 26к.

> будут посылать тебя нахуй при любом насилии или секс контенте

Да как бы похуй на это. Мне бы просто обычную партейку в Ironsworn-like рпгшке отыграть.

> Комфортный минимум для рп это 24b модели.

Это вообще на инцелкор i5 и нетвидева RTX3050 взлетит?

Что вообще сейчас используют для запуска модели? Давно не следил за темой. Раньше стандартную llama.cpp (скомпилированную из исходников) использовал и Jan.

И ещё, как я понял, вся эта гонка за квантизацией провалилась полностью, и квантованные модели сосут перед флотами, а Q2 Это вообще лоботомиты на уровне нанодистиллятов.

Боюсь Эир не спасти, он просто говнище в сравнении с Квеном на этом пресете. Как тот анон и писал, я с ним согласен что Эир невозможно играть больше ну недели-двух максимум, он пиздец повторяется. Две совершенно разные карточки например, гуляете по парку обязательно обе пнут лежащий на дороге камень.

Значит выстави в таверне токенайзер соответствующей модели. Она то думает что ты уже достиг лимита и выкидывает старые посты.

> получается так что у меня железо вывозит 32к а использовать могу только 26к

Если бы именно не вывозило то ты бы ныл о том что софт крашится. Так-то на квене

> ВРАМа остаётся около гига свободно, РАМа чуть больше 3 гигов свободно

4к хотябы можно будет выжать, это немало.

Это всё на самом деле слишком размазано. Тестируй для себя. Лично я юзаю 0.7 температуру в связке top_p 0.8 top_k 20 но эта хуйня зависит настолько от многих параметров и даже контекста твоего РП, что это всё скорей плацебо. Иногда сидишь пердолишь подбирая.

А кто бы не пнул?

Какие ещё ты ожидаешь действия когда пишешь про камень?

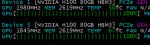

ggml_cuda_init: GGML_CUDA_FORCE_MMQ: no

ggml_cuda_init: GGML_CUDA_FORCE_CUBLAS: no

ggml_cuda_init: found 2 CUDA devices:

Device 0: NVIDIA GeForce RTX 4060 Ti, compute capability 8.9, VMM: yes

Device 1: NVIDIA GeForce RTX 3060, compute capability 8.6, VMM: yes

load_backend: loaded CUDA backend from G:\llama-b6739-bin-win-cuda-12.4-x64\ggml-cuda.dll

load_backend: loaded RPC backend from G:\llama-b6739-bin-win-cuda-12.4-x64\ggml-rpc.dll

load_backend: loaded CPU backend from G:\llama-b6739-bin-win-cuda-12.4-x64\ggml-cpu-haswell.dll

В общем как по мне в этом проблема:

llama_kv_cache: CUDA0 KV buffer size = 1870.00 MiB

llama_kv_cache: CUDA1 KV buffer size = 1326.00 MiB

Этот кэш должен быть па CUDA0, а его всегда рабрасывает на обе видюхи вне зависимости от того, что я прописываю.

Полюбому для этого есть какие-то флаги, но --main-gpu 0 нормально не хочет работать.

Чувак, просто попробуй, это займёт пол часа. Возьми кобольд, установи таверну, разьебись как всё работает, попроси перест для синтии, он хорошо подходит к синтвейву, напиши или найди лорбук на чабе, напиши или найди карточку под себя... Я наебал, это не пол часа, но елси тебе в долгосрочной перспективе, то это того стоит.

Странно, я никогда такого раньше не делал. Разве эта информация не вшита в GGUF ? Попробую в следующий раз, спасибо. Какой нужно токенизатор указать, Qwen 3 все один и тотже используют ?

Хах так прикол в том, что я не пишу про камень. Эир его сам создает и делает так что чар его пинает. И так во всём. Поначалу этого не замечаешь но поиграешься неделю-две и тебя это нещадно заебёт.

Любой мыслительный процесс сводится к поиску (вообще любой, в тч человеческий). В общем-то нам и не нужны были бы все эти нейросети, если бы компьютеры были бы способны просчитать всё и сразу. Когда тебе не жмёт ограничение железа смысла тратить силы на оптимизацию поиска эвристиками просто нет. Всё что нужно — убедительная симуляция мира, в котором будет действовать ИИ-агент, для того просчитать все варианты и выбрать лучший.

Но у нас таких машин нет, потому разрабатывает системы, которые способны выводить эвристики самостоятельно, к примеру для поиска следующего токена в тексте.

Он и должен его разделить на две, тебя не должно это смущать. Если первая подключена по более быстрой шине то все ок. Собственно, 200т/с процессинга на 4060ти на квене - выглядит как вполне похожий для нее результат. Повыси батч, вот он реально может помочь.

> информация не вшита в GGUF

Таверна не знает какая именно у тебя там модель и какой токенайзер она использует. Точнее у нее есть имя, которое повторяет имя файла или папки и она не пытается это как-то интерпретировать.

Потому идешь туда где настраивается промпт-разметка и справа внизу выбираешь соответствующий токенайзер.

Можно сделать проще и поставить в таверне лимит контекста заведомо много больше, тогда о том что он кончится ты узнаешь из ошибки на очередном посте. Главное контекс-шифт не забудь выключить, а то жора может эпичных дел понаделать.

> Возьми кобольд

Есть где-то на диске.

> установи таверну

Установлена ещё год назад где-то, разве что придётся пердолиться, ибо таверна выглядит как кал, да и нужно накатывать много чего поверх. Типа тех же дайсов.

> попроси перест для синтии

?

>квен два человека в треде могут запустить

Абрвылгхжхрлхвв..

https://www.dns-shop.ru/product/9ed2387b62bfd9cb/operativnaa-pamat-gskill-trident-z5-neo-rgb-f5-6000j3444f64gx2-tz5nr-128-gb/

И ты запускаешь квен.

Начнём с того, что интеллект не может быть искусственным

>тратишься как на новый компьютер и ты запускаешь квен

Что сказать то хотел?

А ещё терпеть 5-8т вместо 11 на эире

>Мне бы просто обычную партейку в Ironsworn-like рпгшке отыграть.

Не выйдет, как бы не пыжился современные локальные нейронки всё еще не могут в нормальное РП без адового пердолинга.

Ну то есть- тебе надо

1.Прописать мир

2.Прописать правила мира

3.Прописать песронажей

4.Постоянно пиздить модель ногами, когда она магию пихает в сайфай или гоблинов в немецкие пазики.

Гоблачи это отдельный мем у меня. Я так орал, когда экипажем тигра оказалась турбо-шлюха суккуб в немецкой форме и гоблины.

Ну и конечно же нейронки не могут в 5+ персонажей, без шизы.

Так что по факту у тебя будет meh камерное DnD,

>Что сказать то хотел?

Чё хотел, то и сказал. Ну давай еще меня нахуй пошли, ведь я скинул оперативку за целые 60 тыщ.

>тратишься как на новый компьютер

Мне скинуть сколько видюхи стоят?

> 5-8т вместо 11 на эире

великая разница, великая

> А ещё терпеть

терпи на эире, пока гигачады катают квенчика

Он хотел сказать, что 8т стоят в 20 раз дешевле 11 токенов.

> квен два человека в треде могут запустить

Страшно не когда ты один, страшно когда ты - два.

На самом деле разговоров много, но большая часть - срачи. Или реально мало людей его пускают, или наоборот пускают и тихонько инджоят.

> когда она магию пихает в сайфай или гоблинов в немецкие пазики

> нейронки не могут в 5+ персонажей

Мистраль-немо пал, центурион.

> нейронки не могут в 5+ персонажей

А что если подключить 10 нейронок в конфиге через сеть, как мультиюзеров?

«Способен ли компьютер мыслить? Да, безусловно.»

© Алан Тьюринг

Эта херь. Вот годнота. Мощность 4060, но с 96гб врама. Самое то для МОЕ параши

Cogito ergo sum

>амд

>нейронки

Ну так это не видюхи амдшные, а проц с мощной встройкой. Такое есть только у маков еще, но они в два раза дороже

> ответы персонажей просто божественные блять

Это забавно, но я сам сейчас играю Квен на том пресете, что скинул, и точно так же ловлю восторг. На заезжанных карточках, которыми проверяю модели. Видимо, почему-то недостаточно распробовал, когда нашел грамматику, может уставший был тогда. Радикально меняются аутпуты, а с ними и в целом поведение модели. По-прежнему есть экстраполяция, гиперболизация (Квенчик прямо ну очень пытается, чтобы каждый аутпут был неким экстремумом), но они гораздо более умеренные, не раздражают, да и во многих сценариях и вовсе приходятся к месту. Квен - умница. Думаю, если бы он так из коробки писал, был бы доступен и понятен гораздо большему количеству людей, а не группе избранных, которые его расковыряли от нечего делать.

> ВСЕГДА начинается пересчёт контекста после 26к когда лимит выставлен 32к

Это интересно. У меня была схожая проблема, а потом куда-то пропала. Тоже происходил пересчет контекста ближе к концу заполнения. Как ни пытался выявить в чем проблема, так и не смог. Теория с неправильным токенизатором, предложенная одним из анонов, похожа на правду. Интересно, как Таверна их подбирает. Совсем не хочется в код лезть, ну его.

> Не выйдет, как бы не пыжился современные локальные нейронки всё еще не могут в нормальное РП без адового пердолинга.

Так ситуация точно такая же и на жирных коммерческих моделях. GPT сосёт с проглотом, клода - бредогенератор.

>заезжанных

Фейк нюня детектед

>Фейк нюня детектед

Полторы минуты. Полторы минуты с моего ответа. Кто натренировал Лламу 8б детектить мои посты - ты настоящий подлец. Давно так не смеялся. Иди к черту.

Что даст? Погугли как работают промпты и промпт темплейты. Что будет один инстанс что 10, ничего это не меняет. Нет никакого скрытого контекста, всё необходимое передается в запросе

>Zekta lets out a throaty chuckle, her full lips curling into a predatory grin

>Zekta lets out a low, throaty chuckle, her plump red lips curling into a wicked grin

>Zekta lets out a low, sultry chuckle, her full lips curling into a wicked grin

Свайпы с этого пресета. Это уже паттерны или ещё нет? Так же на другой карточке в начале всегда свет пробивается из окна.

Ещё заметил что модель будто аблитерацию прошла с этим пресетом, в плохом смысле, может выдать из ниоткуда "трахнешь мою жопу?" в обычном разговоре матери и сына и т.д

>так и не смог

А случаем у тебя лорбук не подключен?

О, ну круто уже.

А можешь накинуть тот скрипт, я тоже с ним поиграюсь, интереса ради?

Это было больно, если честно, зря я такое на ночь читал…

Под риг - пушка

харошая лаовей +15 социальная кредита

> Свайпы с этого пресета. Это уже паттерны или ещё нет?

Здесь на самом деле два вопроса. Первое - поиграйся с сэмплерами, если по твоему мнению у тебя недостаточно креативные свайпы. В пресете используются рекомендованные сэмплеры из документации Квена и rep pen. Меня устраивает как есть, пусть лучше меньше креативности, но соответствует персонажу. При всем при этом Квен умеет очень приятно удивить и выдать годноту. Второе - в моем понимании это не паттерн, если не возникает регулярно при разных карточках и контексте. В нескольких чатах, что я успел отыграть (суммарно около 60к токенов), надоедливых паттернов я не встречал. Более того, паттерны, как и слоп - неотъемлемая часть работы с ллм, от этого никуда не деться. Проблема - это когда паттернов и слопа становится слишком много. С Air я это понял буквально в первый день, у Квена такую проблему не наблюдаю.

> А случаем у тебя лорбук не подключен?

Нет. Проблема разрешилась сама каким-то образом. Могу только предположить, что я скачал другой квант, у которого другое название. Скорее всего, Таверна по названию модели подбирает токенизатор и подобрала верный.

Ля пушка-гонка. Но везти такое, наверно, ебанешься, чому у нас не делают?

Все пересчеты из-за того что таверна упирается в лимит. Можно просто выставить лимит в пару лямов и забыть про это, не трогая другие настройки.

Бля, вроде ввёл вводные: фентези, ГГ-пиромант, немного про инвентарь и стартовая локация.

ОК взял квест у хозяина таверны по истреблении ебаки в лесу. Пошёл, забрел в хижину к леснику, там побухали, перетерли за хтонь в лесу, пропажу людей там и всё такое. Попросил ночлег, мол поздно, нехуй ночью по лесу шароебиться. И тут в окно что-то длинное и нечеловечское шкрябиться начало по стеклу и лесник прошептал «они пришли». Ну, ВО-ПЕРВЫХ бля в средневековье не было стеклянных окон. Были ставни. Стекло хуевого качества было дорогим использовали его не только лишь все. Римскую технологию изготовления стекла проебали, как и многие другие технологии.

ВО-ВТОРЫХ бля какие еще нахуй «они пришли», ДМ ты чё ёбнулся? Я попросил ночлег с целью нормально переночевать и спокойно пойти искать следы ебаки, расследуя где она может быть и как её убить. Где моё размеренное приключение? Нахуй модель плодит сущности, заебала. Интригу создаёт на абсолютно пустом месте, где она НАХУЙ не сдалась и торопит события. От 120 миллиардов параметров ждёшь немножко большего.

ОК взял квест у хозяина таверны по истреблении ебаки в лесу. Пошёл, забрел в хижину к леснику, там побухали, перетерли за хтонь в лесу, пропажу людей там и всё такое. Попросил ночлег, мол поздно, нехуй ночью по лесу шароебиться. И тут в окно что-то длинное и нечеловечское шкрябиться начало по стеклу и лесник прошептал «они пришли». Ну, ВО-ПЕРВЫХ бля в средневековье не было стеклянных окон. Были ставни. Стекло хуевого качества было дорогим использовали его не только лишь все. Римскую технологию изготовления стекла проебали, как и многие другие технологии.

ВО-ВТОРЫХ бля какие еще нахуй «они пришли», ДМ ты чё ёбнулся? Я попросил ночлег с целью нормально переночевать и спокойно пойти искать следы ебаки, расследуя где она может быть и как её убить. Где моё размеренное приключение? Нахуй модель плодит сущности, заебала. Интригу создаёт на абсолютно пустом месте, где она НАХУЙ не сдалась и торопит события. От 120 миллиардов параметров ждёшь немножко большего.

> От 120 миллиардов параметров ждёшь немножко большего.

GPT OSS - модель для ассистентских задач и программирования, для этого она одна из лучших в пределах до 235б. Каждый день меня удивляет и помогает в поиске и устранении багов. В рп и креативных задачах можно ее заставить хоть как работать, но это совсем не значит, что она для этого годится.

> Где моё размеренное приключение?

Скорее всего, ни одна модель до конца не "понимает" что такое размеренное приключение. Для модели каждый вывод - отдельная задача. Если ей прилетает задача "расскажи про ебаку, чтобы {{user}} расследовал где она может быть", естественно, она вплетет ебаку в повествование.

И вообще-то у тебя фэнтези, и в фэнтези вселенной вполне себе могло стекло появиться раньше, чем на планете Земля.

>первый доеб

Ты слишком душнила. Есть дохуя фэнтези, где широко используется стекло. И если ты так дрочишь на реализм и доебываешься даже до мелких деталей, то хули ты пиромант?

>второй доеб

ЛЛМ просто решила разбавить твое унылое рп. Люди обычно веселятся хотят, а не описывать как они в таверне спят по куче сообщений

>120 миллиардов параметров

GPT что ли? Аноны говорили, что в рп хуйня. А я хз, мне лень рам докупать для этой залупы

Бля попробовал пересесть с 4Q кванта на 6Q и походу я вижу теперь мозги? Или мне кажется... как понять прибавились ли мозги? Правда 10т/сек и урезанный контекст меня нихуя не радуют теперь...

Сидония новая вышла. Видимо наконец на мистрале 3.2

https://huggingface.co/bartowski/TheDrummer_Cydonia-24B-v4.2.0-GGUF

https://huggingface.co/bartowski/TheDrummer_Cydonia-24B-v4.2.0-GGUF

А... А где эта модель у драммера? Что, блять, происходит?

Отбой, я ебаклак. Просто драммер считает выше своего достоинства, по всей видимости, делать карточку модели.

Это свежак. Драммер еще карточку не обновил, а поляк уже гуфы выложил

А чем это отличается от Mistral-Small-3.2-24B-Instruct-2506 ? Может есть какие-то лучшие стороны в РП? Или это +- тоже самое?

Синтеку прогони и узнаешь. Обычно разница между Q4 и Q6 не такая уж и огромная. Сиди лучше на Q5, он лучше Q4 и разница с Q6 обычно не особо большая

> И вообще-то у тебя фэнтези, и в фэнтези вселенной вполне себе могло стекло появиться раньше, чем на планете Земля.

Волчица и пряности – тоже фентези, но тем не менее автор запарился с воспроизведением средневековой бытовухи, настолько, что иногда приходится идти гуглить слова из книги, и узнавать много нового. Так что не роляет.

> Скорее всего, ни одна модель до конца не "понимает" что такое размеренное приключение

Это вообще фиксится заранее подготовленным сценарием/днд-модулем?

> И если ты так дрочишь на реализм и доебываешься даже до мелких деталей, то хули ты пиромант?

Читай выше

> ЛЛМ просто решила разбавить твое унылое рп. Люди обычно веселятся хотят, а не описывать как они в таверне спят по куче сообщений

Я люблю слайс-оф-лайф. Лучший жанр в художественных произведениях.

> GPT что ли?

Да клода хайку тоже посасывает, впрочем на локалках ситуация индентичная по опыту.

Да, я тоже таким был. Мне надо чтобы персонажи ели по таймингу, хотели спать раз в сутки, перематывали раны после каждой травмы.

Да тут даже не в слайсике дело, а то что модель нарушает базовые принципы построения сюжета. Шерлок никогда не найдёт приступника в следующем же абзаце главы, а только в конце. Трёхактная структура.

Еще раз, аноны писали.

Нейронка не строит долговременный сюжет. Всё что у неё есть это контекст и один! выод который она дает.

Чё вы до неё доебались, словно это книга с прописанным сюжетом.

> Волчица и пряности – тоже фентези, но тем не менее автор запарился с воспроизведением средневековой бытовухи, настолько, что иногда приходится идти гуглить слова из книги, и узнавать много нового. Так что не роляет.

Еще как роляет. Во многих фэнтези вселенных стекло используется повсеместно. Если в сеттинге, который ты изложил модельке, ничего про стекло не сказано - не понимаю, почему ты ожидаешь, что его упоминание недопустимо. Важно, чтобы его не было? Прямо так и указывай в промпте сеттинга, что до этого прогресс не дошел. Если ты указал, что сеттинг - Волчица и Пряности, и думаешь, что этого достаточно, то это не так, увы. Модель может в общих чертах знать, что это, кем и когда сделано, но без таких подробностей. Если все это время ты сверялся с книгами по Волчице и думал, что модель так же дотошно им следует, то это не так.

> Это вообще фиксится заранее подготовленным сценарием/днд-модулем?

Каждый по-своему решает эту задачу. У меня минимальный промпт (инструкции и карточка обычно 800-1000 токенов) и импровизация, а не следование сценарию, под который уже заложены какие-то рельсы, потому проблема не так актуальна. Думаю, лучше всего годится такой формат или какой-нибудь бесконечный роуд-муви, чтобы модель сама, когда вздумается, вбрасывала какой-нибудь креатив. Со временем, если останешься в теме, поймешь, что тебе заходит и как это правильно промптить.

Сейм щит, бро. Очень похожий сеттинг как у тебя, и лесник даже весьма добродушным оказался, историй рассказывал. Засиделись с ним, и вдруг начал он как-то ерзать в окно все поглядывать. Спрашиваю у него - ты чего, старик, королевских кровей чтоли, откуда у тебя стеклянные окна? А он в ответ заулыбался и вдруг покинул дом. Ну, думаю, совсем моделька зашизила - так следующим постом он вернулся, начал ружьем угрожать и требовал идти с ним. Уже вроде что-то необычное, обрадовался, пошел. А нихуя, дальше там волки были. Спасибо хоть не гоблины.

Тебе моделька буквально сюжетку из песни КиШа Лесник расписала, а ты еще чем-то недоволен

Да было дело. Отыгрывал я как то почтальона в тайге. Значит, скачу я по глухому темному лесу, страшно что пиздец. Нейронка еще так нагоняет ужаса, облака закрыты небом, словно прячутся, а по лесу, вызывая шиверсы сам сатана идет и поет хором обреченных душ.

Пиздец кончено порой жути нагоняют.

А вы инфоблоки юзаете? Ну типа там что бы нейронка видела логику в событиях между датами? Или вы просто пишите ей текст и ожидаете получить кино?

Ну если требовать от неё соблюдать последовательность и логику, она будет выдавать эту последовательность и логику. Это не одно и тоже?

А лорбук, лорбук был? World info?

> Ну типа там что бы нейронка видела логику в событиях между датами?

Начала бредить где-то на 8 сообщении, лол.

Oh you

Ага, умеют это дело. Как-то нашел карточку где был хорошо прописан колорит этой страны в начале нулевых. Ну и дай думаю проникнусь духом - отыгрывая обычного парня отправился на вахту в Сибирь лес валить. Еще отряд задорно назывался "смелые лесорубы". Целый день валишь лес, чистый свежий воздух, природы красота, квенчик описывал так душевно что можно просто зачитываться. И вдруг у одного парня в отряде начинает ехать кукуха, каждую ночь кричит "убей", говорит голоса в голове у него что-то шепчут. Иногда на обеде бензопилу ни с того ни с сего заводить начал. Страшно стало, выключил этот чат.

> каждую ночь кричит "убей", говорит голоса в голове у него что-то шепчут.

Ему привидился Старик Хемлок. Бу.

> И вдруг у одного парня в отряде начинает ехать кукуха

У меня так было на одном из васянотюнов мистраля, отыгрывал обычный чилл сценарий на автозаправке с заёбанной и скучающей кассиршей. Как вдруг внезапно нахуй как гром посреди ясного неба сгустился туман вокруг и начался хоррор вроде Алана Уэйка. Это было оч прикольно, единственное по чему я скучаю переехав на инструкт модельки, это истинный рандом, который не предполагался промтом

Было дело на квене я значит отыгрываю мелкого нищего лорда с окраин и у меня 1 главная служанка и 2 у неё в подчинении. Это не фентези, нихуя мистики. Прописано строго - исторический слайсик. Всё прописано, вплоть до характеров.

Вызвал служанку главную, говорю ей, мол у меня проблемы мужские, не позвать ли того лекаря что давеча приходил.

И тут её понесло в мыслях (нет только не это, я не должна допустить чтоб он пришёл снова, а то он узнает! Он узнает всё обо мне взглянув в мои глаза. Господин не понимает что он ключ! Этот человек расскажет ИМ!)

Ну ёбтвою за ногу. Кто нахуй ОНИ, какой в ебени ключ сука ты тупая. Ну думаю может нейронка решила сделать так, чтоб крыша у не поехала и т.п. Хуй там плавал. Пришёл этот лекарь, сука, начал манипуляции с тенями, вселился в служанку. Закончилось моим убийством и вылетанием в окно на чёрных крыльях ночи этой сучки.

Перероли с того места, опять хуйня, злодей теперь я.

Угу, играешь в рероллы, а не в игру.

Ты подкидывай ту модельку иногда, пусть смуту и разнообразие вносит.

Хотя порой капитальная шиза бывает. Играл, значит, анимушный слайс где нужно трахать девочек-волшебниц, одни из них за свет другие за тьму выступают. Так там пошел делирий - овощи ожили, начали говорить в голос и объявили людям войну. Особенно сильными среди них оказались баклажан и лук порей. Воинам света и тьмы пришлось объединяться чтобы встретить эту угрозу лицом к лицу. По ходу сюжета выяснилось что во всем были виноваты вегетарианцы.

Отборный делирий в этих шизотюнах.

Так, а это что за песня. лесника и Тайгу узнал.

> делирий - овощи ожили, начали говорить в голос и объявили людям войну

В голос. Золото

> Отборный делирий в этих шизотюнах.

Факты, тупо факты. Реально что ли подрубать эту хуйню иногда... так потом контекст пересчитывать, эх

Протестил, лучше выше 0.7 не поднимать, начинается страшная каша - малаша. Ну а хули, это тюн всё таки.

Попросите нейронку отвечать вам в стиле ВИТИЕВАТЫХ ПУРПУРНЫХ АЛЛЮЗИЙ, охуеете.

"Шишки телепаты", другая "голос овощей"

Так скорее всего умеет только китайченок квен. Ну принеси скрины, что ли.

> извочик: паря, поторопись, гроза наступает

Бля куда мне торопиться? Торопиться ТЫ должен, мне некуда торопиться, я в повозке сижу. Ебанный рот, реролл.

Бля куда мне торопиться? Торопиться ТЫ должен, мне некуда торопиться, я в повозке сижу. Ебанный рот, реролл.

Браза, я всё понимаю, но если ты будешь писать сюда всю шизу которую выдает нейронка, то сразу бери пасскод и ставь аватарку, потому что ты будешь треды в бамплимит уводить за пару часов.

Проиграл чёт.

> овощи ожили, начали говорить в голос и объявили людям войну

Мне нужно знать, что это за тюн. Укатываемся обратно на тюны старых Мистралей всем тредом! Повеселимся хоть перед новыми релизами. Что-то от ReadyArt?

Меня пугает то, что мне вообще в голову пришёл такой стиль.

>Мне нужно знать, что это за тюн.

Это рофлы на тему песен, ~бака~

Бах писал песни?

Если уж так хочешь - заготовь лорбук с кучей текстов мемных треков и вколючай их инжектом с некоторым шансом или вручную или с рандомом. Офк потребуется обернуть в промпт с запросом невзначай добавить и включать не с самого начала.

> 60к токенов

С 5т.с это 200 часов твоего времени + свайпы

Как этим вообще пользоваться?

База всё еще 15т.с минимум

А что проблемы эира не вылечить файнтюном?

Уже около трёх видел

Уже около трёх видел

Как бы они для этого же и нужны, qwq тоже неюзабелен для рп, а сноудроп уже годнота

200M, опять ты всё перепутала. Принеси свои искренние извинения и как хорошая и послушная ассистентка попробуй ещё раз посчитать (601000)/(560*60). Если хозяин будет доволен, возможно, just maybe он наградит тебя.

>(601000)/(560*60)

(60x1000)/(5x60x60)

fix

мясные MoE 100T были в очередной раз унижены макакой; эта ошибка была в очередной раз добавлена в датасет; когда-нибудь я дообучусь само-reinforcement-лёрнингом

> 60к токенов

> С 5т.с это 200 часов твоего времени

Фух блять, как же мне поплохело от этого осознания.. я хоть и на 10т/сек слоуберню но 100 часов это всё еще дохуища.. я бля в доту наверно за всю жизнь столько не наиграл.. походу надо обратно на 24b безмозг мистрали пересаживаться..

>24b безмозг мистрали

Какашки жрёшь?

Вы проиграли даже не самой умной модельке, живите с этим

А ну в целом играбельно! Получается жизнь и на 5т/сек есть?

>Получается жизнь и на 5т/сек есть?

Редко какой двуногий читает (не сканирует, читает) быстрее чем 7 т / с. Есть, всегда была, если моделька радует выводами и не вынуждает бесконечно свайпить

Ты обсчёт контекста забыл. Если у анона 5 т/с, та около 16 контекста будут считатся почти 30 секунд.

>Если у анона 5 т/с, та около 16 контекста будут считатся почти 30 секунд

Одному господу известно как у тебя получился такой ответ. Впрочем может и он не знает. Генерация и обработка контекста радикально отличаются по скорости. Вполне нормальная ситуация когда 5 т / с генерации работают с 250-300 т / с обработки. Откуда такая тупизна сочится, мистралеюзеров трясет что у кого-то модели лучше но на меньшей скорости или каво?

Ну да, я пользователь мистраля, у меня нет мозгов, тебе есть что возразить?

Сетапы на ддр4 официально умерли

Можно пояснительную бригаду для незнающих? Чё тут происходит, плашки подорожали немыслимо?

Да. Ддр4 сняли с производства, одни ломанулись сметать что есть, другие делать на этом деньги.

Все сборки на нищих и не очень эпиках теперь не имеют смысла, а зионы на д4 и подавно

Пиздос, кто бы мог подумать.. обычно должно быть наоборот, дешеветь как старый мусор....

Хм. А какого хуя ддр4 в днсе дешевеет? Пиздец. Модули что я покупал летом на 7к подешевели

Мб потому что изначально оверпрайс?

Сорян, ток проснулся. В глаза ебусь и сравнивал стоимость двух позиций против одной. Короче в итоге модули подорожали больше чем на 20 %. Ебать

ДА КТО нахуй скупает оперативу? ХУЛЕ дорожает то, ну не поверю что 2.5 инвалида с треда да и в целом со всего мира любители хобби которые решили собрать ворк стейшен могут повлиять как-то на цену... не могут же корпоблядки скупать ддр4.. это же shit для их уровня...

Всё как всегда анон. Байден ёбаный, позавчера его в днсе видел с чемоданом..

А чё всмысле, не 1,7к плашка? Надо было закупаться... А то сервер в бомж конфигурации с 4 плашками, а ведь ещё 4 слота есть.

Чел, забить всего один сетап на дуал эпик нужно 16 планок памяти. Достаточно много народу собирают себе компьют фермы, не одними нейронками же живут

ТАК там сейчас другой, рыжий пиндос! Но все они напару с Обэмой нам срут в загашник..

Никто не скупает, её просто перестают производить.

Ну ты выдал. Но вообще в реальности часов 12-20 там вполне может быть. 3.5 часа это чистая генерация, учитывая свайпы можно смело докинуть до 6 часов. Генерировать ты будешь не непрерывно, большую часть времени перечитывать ответ, писать свой пост, думать - сразу х2..х4, вот и получается.

Однако что 5т/с что 50 - тебе все равно придется прочесть пост. Быстрая скорость может сэкономить на свайпах потому что ты сразу пробежишься, увидишь что херня и свайпнешь вместо того чтобы делать это медленно и вдумчиво. Также снижает жопный пожар и недовольство при серии неудачных свайпов и повышает общий комфорт, тогда как с 5т/с будет конкретное полыхание. Ризонинг бонусом.

> Все сборки на нищих и не очень эпиках теперь не имеют смысла, а зионы на д4 и подавно

Да как-то они не то чтобы и раньше смысл имели, исключая случай острого дефицита бюджета и избытка пространства и свободного времени. Так-то нонсенс. Вроде в теории должно было быть быстро, но в реальности лишь немного обгоняет десктоп.

> не то чтобы и раньше смысл имели

Это не для вас было. Собирайте дальше 96г ддр5

А для кого?

>2x64 ddr5

Облизываюсь уже давно, но все никак не найду железный пруф что оно будет работать на i5 13600k, а выбрасывать такие деньги чтобы в итоге получить блестящую железку вообще не хочется.

Те кому нужно сами пришли к этому. Попроси кого-то другого бесплатно сидеть и переубеждать тебя

>пруф что оно будет работать на i5 13600k

А схуяли нет? Ценник конечно пиздец полный.

>а выбрасывать такие деньги

Всегда можно сдать обратно "Не подошла" (что будет чистой правдой).

https://www.asus.com/news/cilgj4q5royvfwhn/

ивасик.жпг

Хотелось бы увидеть какой-то реальный юскейс в контексте треда. Были тейки в легкодостижимости 256+гигов со сокростями 120-140гб/с, но для моделей в такой весовой категории этого как-то маловато.

>А схуяли нет?

Ну вот у плашек что я хочу взять на амазоне написано что "от 14 поколения". Я хз, они это написали, потому что на 13 и правда не пойдет, или от идиотов защитились, потому что в 13 еще были процы не поддерживающие ддр5 на заявленной в плашках скорости 5600.

https://www.amazon.de/-/en/Crucial-2x64GB-5600MHz-Computer-Memory/dp/B0DSR5P84D/?th=1

>Всегда можно сдать обратно "Не подошла"

Хз, не пробовал еще на амазоне возвращать ничего.

Какие крутые новые модели вышли до 50B?

Для рп с карточками в таверне без цензуры и с креативом

Для рп с карточками в таверне без цензуры и с креативом

По описанию это самые обычные еще и с нищими 5600. Не cudimm (в которые 13я серия также может), ни что-то еще. Смотри на на амазоне а у производителя спецификации https://www.crucial.com/memory/ddr5/cp2k64g56c46u5 там же у них есть списки совместимости (врядли актуальные)

Гранит

Я уже чекнул их сайт, моя мать там в списке есть, а вот интеловские процы они знают только xeon, так что все еще нет 100% ясности.

гранит? А можно ссылку?

Ну пиздос, не соберу я сетап на Эпике в далёком светлом будущем.

Хорошо хоть успел до 128 докупиться.

лол охуенно продам свою старую сборку в два раза дороже, чем планировал

спасибо дядь дональд

а по новой сборке картина такая: это пиздец.

за 1500 баксов процы в состоянии "scrap for gold", задроченные но ещё не убитые начинаются с 2к

итого моя сбор очка из запланированных 7к внезапно стала стоить 8

за 1500 баксов процы в состоянии "scrap for gold", задроченные но ещё не убитые начинаются с 2к

итого моя сбор очка из запланированных 7к внезапно стала стоить 8