Надо было тег /video/ поставить.

Не надо было, это тред чисто для локалок. Я написал /wan/, но косые черты сожрала макаба

Ебать я лох, ну буду знать. Я так-то ни разу не перекатывал ничего, но почти 500 постов в бамплимите - это уже пиздец какой-то, так можно до закрытия двача ждать переката.

Добавили тег. В следующий раз катите без сосущих тянок в ОП-посте.

Ещё полезных ссылок

https://github.com/kohya-ss/musubi-tuner тоже может тренить лоры

https://rentry.co/wan22-generach быстрый гайд на ру

https://rentry.org/wan21kjguide и https://rentry.org/wan22ldgguide тоже самое, но с форчка

наглядное объяснение почему локальный модели без цензуры лучше чем сервис от дяди

Дискас. Ради рофлов попробовал локалку на конец треда натравить

Чет проиграл со второго

Чет проиграл со второго

Наконец-то только локальное. Онлайн хуйня заебала в этом треде. Онлайновое итак вдоволь в других тредах читаешь, если это интересует. Странный тег /wan/, как будто через год локально другая сеть не появится. Это им нужно было отделиться и придумывать тег или все онлайн-треды держать под /sora/

Зима близко.

Какой на ваш взгляд лучший интерполятор кадров.

Че-то хз, если честно.

Каких-то особых плюшек не нашел.

Генерит ну типа.

Уровня WanS2V, может чуть лучше, но без звука.

В следующий раз кати без этой херни из последнего видоса.

Отличный пример, как выработать ненависть у всего треда к внешности.

>у всего треда

Этот весь тред с тобой в одной комнате? Всем похуй

На Ван 2.2 работают лоры от 2.1? Если да, то куда соединять, в low или high?

В лоу с весом до 1, в хай с весом 1-3

Наконец-то /wan/ тред

> Странный тег /wan/, как будто через год локально другая сеть не появится.

Да в целом норм. Можно будет оставить старый тег как дань уважения основоположнику локальных генов. Аналогично как в sd/nai/llama-тредах теги тоже оставили по именам первых моделей.

Первая модель hunyuan, если что, и она была на старте очень крутой.

Ван пришел вторым (лтх не считаем).

Так что, аргумент так себе.

С этой точки зрения llama-тред должен зваться mistral.

https://www.reddit.com/r/StableDiffusion/s/IFBawScAjE

Насколько же это лучше ван кала.

Обещают локально к концу ноября

Насколько же это лучше ван кала.

Обещают локально к концу ноября

Просто посмотрите насколько эта анимация плавная и быстрая, не рваная или слоумошная как на ван

Чем можно генерить кэпшны для видео-датасета?

И если не дробить самому на чанки по N фреймов, а поставить автоматом, то насколько захуевится лора от того, что в какие-то чанки попадет только начало/середина/конец действия из кэпшна для клипа?

И если не дробить самому на чанки по N фреймов, а поставить автоматом, то насколько захуевится лора от того, что в какие-то чанки попадет только начало/середина/конец действия из кэпшна для клипа?

Дак это мультик хули.

Да, ты прав, я тоже в своё время лоры под hunyuan пилил, но по итогу быстро забил т.к. там даже img2vid не было это уже потом добавили, если правильно понимаю. С wan всё же интерес так быстро не пропал.

Есть идеи, какой тогда тег сделать, чтобы можно было указывать челам с онлайн-сетками, что им тут не рады?

кал

Да нечего тут выдумывать, wan и короче, и на момент создания треда это золотой стандарт локалок, который хорош во многих областях. Про хуйнянь уже все забыли давно. До лламы тоже же были генераторы текста, давайте ныть, а почему не BERT, порфирьевич или цепи маркова из 80-х.

Ну, llama это не только модель, но и бекенд, запускающий все ллм.

>[ Removed by moderator ]

Как же ебет. Пытаются скрыть ценную информацию. Судя по комментариям, это про ltx. Не могу вспомнить ни одну сетку, которая была говном, а потом вдруг стала хорошей. Они все либо ебут с первой версии, либо отстающий кал.

> img2vid не было это уже потом добавили

И было хуйней, к сожалению. =( Ван был первым img2vid хорошим.

> Есть идеи, какой тогда тег сделать, чтобы можно было указывать челам с онлайн-сетками, что им тут не рады?

Сложный вопрос. Но я хрюкаю от смеха сделать тег /kijai/. =D

Но будто бы video и правда было бы хорошим вариантом. Но если он ушел онлайнщикам, то пусть пока будет wan, че уж поделать.

Хотя бы короткий.

Угадай в честь чего она названа. =)

А еще Kobold (он, кстати, старше), всякие vLLM, Sglang, TRRT. Будто бы Kobold, кстати, по смыслу ближе, это еще до-ллама времен были рпг-модельки.

Но хули уж щас думать над этим. Сколько воды утекло.

> Не могу вспомнить ни одну сетку, которая была говном, а потом вдруг стала хорошей.

ЛТХ-2 даже по примерам смотрится ну так себе, если честно.

?

у кого работает генерация видосов, вы на каких карточках все это делаете то?

и есть ли какие то решения для меня с 2060 на 6гб? ну кроме как отвернуться к стене и плакать

и есть ли какие то решения для меня с 2060 на 6гб? ну кроме как отвернуться к стене и плакать

>на каких карточках все это делаете то?

По моим наблюдениями авг тредовичок имеет 16-24гб ну и особи с 12гб тут тоже имеются что кое как дыхабельно.

>какие то решения для меня

Пойти купить 3060 12г на лохито за 15к или сколько они там щас стоят, а лучше 5060ти на 16гб сразу это не так уж и дорого

Меньше чем 12гб врам даже не пробуй. Еще минимум 32гб оперативной памяти. Чел выше упомянул 3060 12гб. На ней может и пойдет, но у нее старая архитектура и сама карта не топовая в своей линейке, т.е. генерироваться видео будет долго.

Скачай и проверь.

Лично видел как чувак на ноутбучной видюхе в 4ГБ врама клипы генерил.

Но оперативы нужно МНОГО.

3070, 8 Гб врам, 32 гб рам. Полёт с wan2gp и лайтниг-лорами для i2v нормальный. Да, приходится потерпеть генерацию 5-7 минут на 5 секунд, но качество сгодится для личного пользования.

Подскажите что за лора?

Это промт типа на 1-5 фрейме мы видим девушку такую-то (описание), затем мгновенный переход к новой сцене, где точно такая же персона (добавить в скобки из первого предложения) стоит в том же месте абсолютно голая (или в трусах как здесь) и дальше пишешь... ну и потом камера спускается вниз и так далее.

Ну и прописать надо, что лицо не изменяется на протяжении всего видео.

Вот так просто оно работает? Нужно будет потом побробовать.

Каким промптом успешнее получается сохранить лицо?

Любым на сохранение лица. Это нейронка понимает. Проблема в том что нужно хотя бы 6 степов и нормальное разрешение фотки, где лицо четкое без пикселизации. Если исходная фотка хуевого качества, ван будет его перерисовывать. Если недостаточно шагов, то будет пикселизация. Ну и само разрешение видео 600 на 800 это минимум.

Да, ван 2.2 прекрасно понимает промт.

>600 на 800 это минимум

На деле важно разрешение фрагмента фотки занятого лицом, а не общее разрешение самой фотки.

и запас терпения на сутки

Попробовал LTX2 на их сайте, если мы такое реально получим локально, да ещё и быстрее вана, как обещают, это эпик вин.

Когда сможем локально что-то типа соры 2 запускать есть у кого предикты? Учитывая что максимально 32-48 врам и 128-256 рам

Скорее всего как и Грок останется проприетарным. Деньги же как-то надо зарабытавать.

>Грок

Так это же уровень WAN 2.2

Народ данные лоры это самый актуал по ускореню для i2v?

Выпал немного из темы

https://huggingface.co/lightx2v/Wan2.2-Distill-Loras/tree/main

Выпал немного из темы

https://huggingface.co/lightx2v/Wan2.2-Distill-Loras/tree/main

О спс, лорки обновились, уже почти 500к скачавших. Надо глянуть. Интересно что означает 1022 в имени?

В прошлом треде рекомендовали этот модуль для создания длинных цепочек: https://github.com/vantagewithai/VantageLongWanVideo

Работает клево, но лица все же искажаются сильно на нескольких итерациях (с 14B_Q4_K_M.gguf)

У кого-нибудь получалось сохранить лица на длинных видео? Пробовал через вставку образца лица в углу фотки, но толку ноль, все равно за основу берется искаженное лицо из предыдущей итерации и еще больше искажается дальше.

Работает клево, но лица все же искажаются сильно на нескольких итерациях (с 14B_Q4_K_M.gguf)

У кого-нибудь получалось сохранить лица на длинных видео? Пробовал через вставку образца лица в углу фотки, но толку ноль, все равно за основу берется искаженное лицо из предыдущей итерации и еще больше искажается дальше.

22 октября. Тут уже новая есть: https://civitai.com/models/1585622/lightning-lora-massive-speed-up-for-wan21-wan22-made-by-lightx2v-kijai?modelVersionId=2361379

Хммм Киджай вроде как свои лоры на ускорение сам не делает, а ужимает имеющиеся с lightx2v, посмотрим че у него там за high.

Там и на t2v какие то цифры, причем они теперь называют это не lightning, а distill, хрен пойми че там в этих лорах уже, но мувмента стало больше

спасибо аноны.

буду копить на компик значит.

и тем временем продолжать пытаться найти хоть что то рабочее на свой ноут.

просто мысль о движущихся картинках не оставляет меня. и я перебрал кучу всякого баловства типа sadtalker и video difussion, которые как ни странно, исправно работают, не смотря на то что в требованиях у них от 12гб видеокарт.

накатывал "оптимизированые" сборки на wan, через пинокио. обещающие работать с 6 и даже 4 гб видеокарты, но ноль успеха.

возможно дело в самом пинокио. потому что тот же седтолкер и видеодифуззия через него абсолютно так же не работают. через него ни что не заработало.

извиняюсь что излил свои печали в тред. просто и пожаловться то не кому

Хуй разберешься. Еще завезли scaled модели под эти лоры. Также в имени модели указано comfyui. Чувствую сейчас буду тестить весь вечер, а потом выяснится, что говно.

Если интересно они тут и новые vae выкатили которые типа дофига берегут память, не уверен правда, что vram и типа они быстрей. ХЗ только сейчас обратил внимание

https://huggingface.co/lightx2v/Autoencoders

h100 не забудь прикупить и мб получишь локально

Пытаюсь тренить в Мусуби Ван на дефолтных настройках (81 фрейм 16фпс 720п), и оно даже с оффлоадом всех слоев так что сама модель не занимает практически нихуя, переливается за мои 24гб врам. Что лучше уменьшить чтобы влезло?

prune — удаляем ненужные веса, уменьшаем размер

distill — берем модель побольше, обучаем на ее результатах модель поменьше, итоговый размер меньше

quant — уменьшаем точность весов, уменьшаем размер

scale — квантуем чуть толще, чем обычный fp8, чтобы качество было чуть лучше, уменьшение чуть меньше, чем у обычного квантования, но качество лучше

merge — соединяем несколько моделей или лор в одну

lightning/fast/turbo — а вот это уже просто название конкретных лор или моделей, которые обучены генерировать видео на малом количестве шагов, они от разных авторов и называться могут как угодно, хоть sonic, хоть sapogi skorohody, главное, что они позволяют не за 20 шагов генерить, а за 2-3-4-6-8.

distill — берем модель побольше, обучаем на ее результатах модель поменьше, итоговый размер меньше

quant — уменьшаем точность весов, уменьшаем размер

scale — квантуем чуть толще, чем обычный fp8, чтобы качество было чуть лучше, уменьшение чуть меньше, чем у обычного квантования, но качество лучше

merge — соединяем несколько моделей или лор в одну

lightning/fast/turbo — а вот это уже просто название конкретных лор или моделей, которые обучены генерировать видео на малом количестве шагов, они от разных авторов и называться могут как угодно, хоть sonic, хоть sapogi skorohody, главное, что они позволяют не за 20 шагов генерить, а за 2-3-4-6-8.

Принято - впитано, было приятно и полезно, то есть процесс получения "новых" лор был другим, сейчас они сначала сделали прямо дестил модели, а потом с них выжали лоры, а изначально они обучали лоры на полноценных результатах от базовой модели и это был типа lightning лоры.

Ну копи, копи.

Ещё раз повторю - неделю назад по приколу товарищу на ноут комфи ставили.

Стандартный воркфлоу, 4ГБ видюха и 30 гб оперативы.

Вот попросил чувака скинуть пару рандомных тестов, из того что тогда нагенерили.

>ГЫГЫГЫ ДОЛГА ЩЩИТАЦЦА БУДИТ)))))

~60сек на один шаг, 2+2 шага, ~270 секунд на одну генерацию с учётом vae декода.

Дак что качать сейчас? Просто дестил модель без лоры (поскольку лора уже в этой модели)?

Скачал отсюда https://huggingface.co/lightx2v/Wan2.2-Distill-Models , уже час тестирую, получатся говнище полное, все блеклое, никакой детализации. Просто говно.

Я скачал дестил лоры и на i2v контенте удивился живости движения, на старых лорах такого не было.

И что ты предлагаешь, сидеть вечность на 5 секундах и 480р?

Видюхи ещё 2 поколения будут доить гоймеров с +20% прироста

Выйдет и для лтх лора ускорялка так заживем

Чет у меня не получается. Пишу в промте sudden cut и тд, но у меня все равно сцена плавно переходит к описаной.

ну вполне себе приемлемо. если использовать для анимации то отлично даже.

качаю комфи, хули.

16гб оперативы правда. видюха 6гб. очень надеюсь что хоть как то оно все работать будет.

а есть разница портабл версия комфи или нет?

https://civitai.com/models/2088559/cinematic-hard-cut

https://civitai.com/models/2077430/luisap-wan-22-i2v-deepfake-transition-v2

Попробуй это или допиливай промпт, зачастую многие лоры можно воспроизвести чисто инструкцией, просто придется подбирать слова.

sudden cut into next scene можешь как нибудь так

Начинай с прортейбла, чтобы не делать мозг, если заработает то можно перебраться на конду, мне честно такой вариант больше заходит из за возможности твикать пакеты, если что-то сломалось.

16+6 конечно хз, если только на супер тонкого зайдет на сильно квантованных gguf-ах

>As much as I love Wan, if it's one thing it's not good at, it's cuts.

Так всё-таки нужна натренированая лора. Ты сам-то хоть пробовал этот эффект без лоры прописать? С лорой по первой ссылке у меня получилось. Только на количество фреймов, после которой должен происходить кат, оно не реагирует. Рандомно через 1-3 секунды сцена меняется.

Пробовал различные варианты, у меня на некоторых сидах получалось, когда есть слова в стиле magically transfroms into new scene with a magic sparkle effect, а жесткая обрезка получается всегда, если сцены супер разные через first - last frame.

Забыл добавить, что имею ввиду речь о i2v не о t2v

Влезло в итоге только когда уменьшил и фреймы до 41, и разрешение до 480п, с оффлоадом 24/40.

Есть ли понт T2V на таком хуевом качестве тренить, или лучше на картинках в норм качестве, или и то и другое?

Если на картинках, то юзать смазанные кадры из тех же видео, или лучше несмазанные фото?

I2V на картинках не тренится ваще, там придется хуевое в любом случае, но может 360п 81 фрейм будет лучше?

> то есть процесс получения "новых" лор был другим

Вероятно, раньше они собирали видосы сами, делали датасет, и обучали на нем.

А потом стали просто генерить кучу видео, отбирать лучшие результаты и уже обучать на синтетике.

Это все lightning лоры, просто сам метод получения датасетов разный.

Но опять же, что имеют в виду они — хер знает. В lightx2v сидят тоже далеко не гении, у них часть лор полное говно, и время от времени норм модели попадаются. Может они сами неправильно терминологию используют, с них станется. =)

Но главное, что у них есть энтузиазм и деньги, выпускают новые лоры — молодцы.

Пусть продолжают.

Качай нахуй все, а потом просто выбирай, что лично тебе больше понравится. Вот неиронично.

Тут есть люди, которые сидят еще с первой их T2V-14B-480p лорой, и ниче, работает, и иногда даже хорошие результаты выдает.

А кто-то только последние юзает.

Чисто в теории надо брать в качестве базовых моделей:

wan2.2_i2v_A14b_high_noise_lightx2v_4step_1030.safetensors

wan2.2_i2v_A14b_low_noise_lightx2v_4step.safetensors

И запускать без лор.

Или же брать

Wan_2_2_I2V_A14B_HIGH_lightx2v_4step_lora_v1030_rank_64_bf16.safetensors

отсюда:

https://huggingface.co/Kijai/WanVideo_comfy/tree/main/LoRAs/Wan22_Lightx2v

Но у Киджая самого проблемы, он нахуй все по разным папкам распихал лоры, теперь хер соберешь.

Так же, эти лоры могут лежать в других репозитариях, и версии разные и бла-бла-бла…

Короче, берите старушку SEKO и не парьтесь.

https://huggingface.co/lightx2v/Wan2.2-Lightning/tree/main/Wan2.2-I2V-A14B-4steps-lora-rank64-Seko-V1

Они, вроде, норм работают.

Так, отвечаю один раз, можешь не верить.

Комфи выгружает модель в оперативу, а виндовс и линукс выгружают оперативу в файл подкачки/своп.

Т.е., от видеопамяти требуется только вместить контекст. Это разрешение (минимально у вана норм генерация — 352 по большей стороне, ниже совсем мазня) умноженное на количество кадров. Короче, пиксели считай сиди.

Как ты понимаешь, в 6 гигов ты засунешь либо 1280x720 но 1,5-2 секунды, либо 5 секунд, но 5, а то и 7 секунд, но 640x368, типа того. Что, кстати, весьма неплохо. Даже видосяны 480x368 смотрятся норм (в определенных ситуациях=).

Так что, 2060 6 гигов кое-что могет, НО НЕ СИЛЬНО, скорость генерации будет не очень высокой, придется подождать, а результат будет небольшим.

Модель утекает в оперативу, и если оперативы не хватает, то — на твой ссд. Скорость немного падает от этого, конечно, и ресурс ссд расходуется. Тут смотри сам.

Генерятся ли видосы на 6 гигах? Ну да.

Выше чел пишет

> ~270 секунд на одну генерацию

И это при 344x512 (будто бы можно было и 320x480 поставить).

У меня на 4070 ti такое генерится секунд 40, ну то есть ЗАМЕТНО БЫСТРЕЕ АГА, так что, будь готов.

С 16 гигами, это, конечно, мда-а-а… Если будет вываливаться — увеличивай файл подкачки.

планку памяти докупи, если слот свободный есть.

Ну или замени ту 1, что есть (проверь лимиты материнки у производителя)

на 16 у тебя постоянно ССД задействован будет, как резервная память, а это намного меденнее и черевато износом.

А вот это В ШАПКУ НУЖНО ДОБАВИТЬ, при перекате не забудте.

Двусмысленно с merge получилось. Там же не объем меняется. Предлагаю:

merge — смешиваем несколько моделей или лор в одну, как краски на палитре.

>wan2.2_i2v_A14b_high_noise_lightx2v_4step_1030.safetensors

Там и low лора новая и весьма хорошо себя показывает, Киджай уже сам точно запутался в своей репе

https://huggingface.co/lightx2v/Wan2.2-Distill-Loras/tree/main

ну я пока молюсь чтоб хоть какие то кривые мыльные картинки оно хоть как то из себя выдавило и не крашилось и не выдавало ошибок.

если заработает, то немедленно мчу за оперативкой.

спасибо аноны за поддержку и в целом за идею потестить.

надеюсь завтра не приползу сюда с вопросами, а почему то не работает, а почему это не работает

Да, «смешиваем» лучше.

Сорян, затупил с выбором слова.

А что лучше lightning или lightx2v? Я думал, что lightx2v это для wan2.1, блять что за путаница.

Проблема в том что нет хуже/лучше, они все работают по своему, с одними движениями будет лучше работать одна, с другими другая. Но вот какая с какими только на практике можно убедиться. Когда выбор есть конечно хорошо, но немного напрягает подбирать для каждой сцены.

Мало того, их еще смешивать можно с разными весами по несколько штук подключать. И тут вообще голова ломается в поиске идеала.

Ну да, многомерное пространство оно не только "в голове" у модели, оно ещё и в неограниченном наборе вводных параметров.

И мы такие в нём - "хмм... а что будет, если этот параметр почесать? О, движения в видео резче и интенсивнее стали!".

А потом этот же параметр при другом наборе вводных меняем, а он на движения ВООБЩЕ влиять перестал, зто какие-то элементы одежды с персонажа убрал...

>картинка отвалилась =(

!!!!!!!

>немедленно мчу за оперативкой

Удачное ты время выбрал. За последние месяцы цены на память очень сильно подскочили, на некоторые модели даже удвоились. А всё благодоря хайпу нейрошизов по всему миру. Заводы чипов памяти уже работают во всю катушку 24/7, но спрос всё равно превишает предложение. Аналитики говорят, что цены скорее всего весь 2026 год не будут падать.

Ахуенно я себе комп летом с 16х2 собрал еще на дырдыре 5, бюджет закончился, походу надо было на стартом серверном трипере тридрипере собирать с ецц, она пади все еще хуй да маленько стоит, да и хорошо было бы мое ллмы гонять на 128-256 гигах медленного некро кала

Ого, сейчас глянул - планка памяти которую брал в мае за 3200 стала 3800.

Выросла конечно, но если не в процентах а в рублях считать - ну бутылка водки так стоит, или пара банок огурцов, или батон колбасы. Неприятно, но волосы на жопе рвать не с чего.

Качаю гигабайты гейского прона чтобы сделать датасет с хуйцами.

Сколько у тебя оперативной памяти?

Серега, долбоеб, это не /gd/, отпишись от этого треда и не пиши сюда, животное.

Как Ваном делать простой эдит видео, типа "покрась кота в зеленый"?

cat fur turns green

Эдит, а не новое сгенерить. Я нашел какой-то хитровыебанный воркфлоу тут

https://aistudynow.com/wan-2-2-vace-object-swap-with-an-image-in-comfyui-gguf-q5/

но не пойму нахуя там столько всего, должно же быть для элементарного примера элементарный воркфлоу

конечно добавляйте, тут же никто гуглом не умеет пользоваться, неиронично

так, ну я нашел workflow, которые может реализовать подкрепление лица к генерации: https://civitai.com/models/1945794/i2v-lynxpusamoelightning-x2-speed-face-consistency-with-loras-looping-workflow-wan2214b?modelVersionId=2313180

Попытался перенести из него нужные блоки в стандартный workflow генерации, и получилось это: https://0.0g.gg/?9ee1add29eecf572#8oVG6SLntPdfu2Y9GdNj9PxQn7oAa9wiWpchQZLDCLYU (видео нет, т.к. не удалось с ним закончить генерацию). Но на нем один шаг на 33 кадрах делается по 20 минут на RTX4060+32 ОЗУ и при переходе с High на low шум завершается ошибкой переполнения памяти.

Знающие аноны, нужна ваша помощь, можно ли довести его до ума, что бы скорость была соразмерная с обычной генерацией по 2-4 минуты на шаг с ускорялками?

128

Планки памяти, которые брал за 46 стали 67, пизда.

———

Вышла новая Wan Endless: Stable Video Infinity https://github.com/vita-epfl/Stable-Video-Infinity

Как всегда Wan2.1, как всегда качество чуть лучше, чем было, короче — ничем не впечатляет, лень качать.

128 гигов? А то и думаю, что у тебя так быстро генерится видео. На моей 4070 и 16гб оперативки по 4-5 минут генерится. Я вот думаю, если еще 16 гигов докупить, насколько оно ускорит генерацию, хотя бы на треть?

Это хороший вопрос.

Вполне возможно.

Но ты подумай, у тебя 2х8, как я понимаю, может не стоит до 4х8 плодить, а сразу 2х32 взять? Ну или хотя бы 2х16, а потом еще 2х16 докупать.

Оператива дорожает, каждый маневр будет стоить лишних денег, как мне кажется.

У меня на одном пк 4х32 DDR4, на другом 2x64 DDR5. И сейчас я смотрю на эти +20к по прайсу и понимаю, что ой как вовремя успел схватить оперативу-то!

Ускорит генерацию примерно на 0. На скорость генерации в первую очередь влияет видео чип и количество видео памяти, оператива нужна на то чтобы сгружать часть модели которая не помещается в видеопамять.

Хотя в твоем случае возможно будет ускорение, по тому что по мимо оперативы у тебя модель скорее всего еще и в файл подкачки лезет, а там вообще беды с скоростью.

Рассматривай вариант лучше 2х16 и потом еще 2х16 на будущее.

Количество видеопамяти как раз само по себе не влияет на скорость.

Влияет лишь немного, но у человек большая часть модели не то что в видеопамяти — она у него с диска читается. =) Вот где бутылочное горлышко, вполне возможно.

> модель скорее всего еще и в файл подкачки лезет

Угараешь? У человек 16 гигов из ~72, которые модель любит занимать (если мы про Wan2.2), конечно у него почти все в файле подкачки лежит.

«ускорит на 0», ага. =)

Конечно, можно использовать gguf q4_k_m и wan2.1, тогда есть шанс очень демократично по памяти сидеть.

Если хочешь, можешь рискнуть, но я бы все-таки памятью затарился, если есть возможность.

щас как раз пердолюсь на 12vram + 64ram

wan22 q6.0 и суммарно 6 лор по скорости примерно:

0 лор не считая lightx2v 12-13s/it

6 лор не считая lightx2v 15-16s/it

В целом жить можно, генерю 832x480

Чет мне кажется следующий поколения видео моделей будут настолько жирными, что даже топовые консюмерские карты их не смогут впитать и придется либо перекатываться в онлайн (но смысла не вижу), либо предолиться в старые модельки, хоть их потенциал мне кажется даже без лор нефига не раскрыт - уже начинают надоедать

Затестил их лайттае для 5B, какую-то мутную хуету выдаёт. Писали что качество должно быть выше оригинального тае, а на деле кал. Может нода декодера поломаная у них.

Скорее всего у тебя переполняется оперативка и модели утекают в своп/файл подкачки, а там начинается адское замедление

>Ускорит генерацию примерно на 0

Для сравнения

4070 Ti 12GB VRAM + 128GB RAM = 40 секунд

4070 12GB VRAM + 16GB RAM = 250 секунд

Чип 4070 Ti всего на пару процентов мощнее обычной 4070, а видеопамять у них идентичная. Значит упор идет именно в оперативную память.

Чет реально печальная картинка, я вообще подумал и понял, что эта хрень скорее всего создана в целом для v2v, где нужно дофига кадров декодить, энкодить, но качество и впрямь паршивое, уж лучше подождать

>Влияет лишь немного

Немного? Или у тебя модель целиком лежит в видеопамяти и нон стоп работает или она гоняет блоки туда сюда из оперативки.

Так немного что 3090 практически не уступает по скорости 5070, вот и думай.

В прошлом треде кидали модельки новые с вшитым lightx, работают вообще отлично и скорость генерации быстрее чем на обычной модели, рекомендую к ознакомлению, брать надо с припиской comfyui:

https://huggingface.co/lightx2v/Wan2.2-Distill-Models/tree/main

Я боюсь, следующих моделей может и не быть.

Wan2.5 не дали.

LTX обещают, но она будто прошлого поколения.

Все текущие разработки — не дотягивают до Wan2.2.

Глядя на современные модели, думаю, следующее поколение еще вполне себе покрутится на потребительских видеокартах. Подольше, конечно, возможно потребуется объем видеопамяти для контекста, потребуется памяти побольше, может быть поколения постарше (40xx, 50xx), но еще пофурычит.

Если выйдет, потому что нейронки в принципе уже уводят за пэйвол.

Я бы скорее боялся того, что мы ниче больше не увидим. =( Ну или релизов станет существенно меньше, чем хотелось бы.

>Чет мне кажется следующий поколения видео моделей будут настолько жирными

Не будут:

1. Какой смысл выпускать оупен сорс модель которой никто не сможет пользоваться.

2. Модель все равно пойдет в оперативку.

3. По текущим трендам пока вообще кажется что новых моделей не выпустят в оупенсорс.

Другое дело что в следующих моделях скорее всего прикрутят время генерации хотя бы до 10 секунд и вот тут уже на 12 гигах особо не погенеришь, либо разрешение придется понижать.

чип у тебя значительно бодрее

> Немного? Или у тебя модель целиком лежит в видеопамяти и нон стоп работает или она гоняет блоки туда сюда из оперативки.

Немного.

Сравни LLM, у которых разница от видяха/оператива будет 10х, и видео, где разница 2х. А учитывая, что 24 гига тоже не 48 — для больших моделей ты тоже выигрыша сильно много не получишь.

Я специально мерял, при половине модели в оперативе и при всей модели в оперативе разница получалась процентов 30 по времени.

Прирост-то есть, то влияние не прямое.

А вот мощный чип — еще как влияет. ))) 4070 ti с 12 гигами все еще на 10% быстрее 3090 (в прошлом треде сравнивали), при том что чипы у них отличаются… ну примерно на столько же и отличаются? Т.е., память в случае 3090 как раз почти не играет роли, ВНЕЗАПНО.

> Так немного что 3090 практически не уступает по скорости 5070, вот и думай.

Пикрил, она и не должна уступать, учитывая их равную производительность. За счет 24 гигов по твоей логике она должна еще и обгонять процентов на 20 хотя бы. Или сошлешься на разные поколения, улучшалки для 50хх (которых никто не юзал) и так далее? Я сомневаюсь, что измерения происходили на NVFP4 квантах, где 50хх поколение имело бы преимущество.

Короче, в случае 12 гигов видеопамяти и 16 оперативы — добавить оперативу реально может дать сильный буст. А вот видеопамять хоть и влияет косвенно, но не так критично.

Приятно иметь 5090 32 гига, но я бы и на 5090 16 гигов согласился бы, ради быстрого чипа (за треть цены, пжалста, ахахах).

Есть такие опасения, значит энтузиасты распердятся лорами как во времена sdxl буквально на любой чих, а если это все умрет, будем хотя бы детям рассказывать, что нейронки на домашних ПК запускали, вот были времена (деду больше не наливать)

Зачем делать очень качественный, оптимизированный опенсурс, если можно его продавать? Да вообще конечно вопрос философский, это ведь нужно дофига инвестировать денег и времени, а без выхлопа людям может станет не по фану этим заниматься. Короче правду и развязку смотрите в следующих сериях нашей передачи

> Какой смысл выпускать оупен сорс модель которой никто не сможет пользоваться.

Строго говоря, эти модели выпускаются для реселлеров, которые крутят их у себя и продают к ним доступ.

То, что Комфи с Киджаем запилили выгрузку в оперативу — просто случайность, повезло, что эти модели работают с выгрузкой хорошо.

Когда выпускали Мочи, говорили, что 320 гигов надо (или типа того), и все офигевали, кому нужна такая огромная видеомодель (а потом оказалось, что нафиг не надо, она 10б была=).

И тот же Кандинский 2б требует 40 гигов (до оптимизации было 64). Но есть подозрение, что при желании, запустится на утюге.

Но остальные два пункта это не отменяет, да. =) Так-то все правильно.

> чип у тебя значительно бодрее

Вряд ли 4070 бодрее 4070 ti. =)

И не в 6 раз в любую сторону точно.

3060 генерит тот же видос 110 секунд с 32 гигами оперативы.

Так что, видяшка-то у него бодрая. Затык где-то в другом месте.

> энтузиасты распердятся лорами как во времена sdxl

Блин, да это все понятно, в общем-то и OVI и SVI, который я выше скидывал — это все тоже в каком-то смысле энтузиасты пилят.

Но… хочется же какого-то скачка.

Хочется, чтобы дома можно было генерировать целые аниме-серии.

А пока что, аниме хорошо генерит только сора 2, как я понял. Вео ну так себе, ван ну прям совсем так себе.

Обмазываться лорами можно, но хотелось бы из-под капота.

Плюс, еще нужна механика персон, чтобы можно было загружать инфу о персонаже (его анимация/мимика, внешность) и он генерился консистентно в разных сценах.

Да, у нас есть Qwen-Image-Edit и Flux Kontext, я согласен. Но это все еще костыли.

Короче, кажется, осталось 1-2 шага до мечты. И будет грустно, если их не случится, и все падет на плечи энтузиастов, и будем жить с Wan2.2 все время. =(

>https://huggingface.co/lightx2v/Wan2.2-Distill-Models/tree/main

На 4060 8гб видюхе хватит запустить?

>Сравни LLM

Давай сравним. Как только модель вываливается из видеопамяти сразу -х5 к скорости генерации ловишь. Очень наглядно видно, у меня q5 qwen 30b залазиет полностью и ответ генерит очень быстро, но q6 уже все, там просто мрак.

>на разные поколения, улучшалки для 50хх (которых никто не юзал) и так далее

Да, как минимум юзались модели e4m3 в которые 3090 не может

Скорость чипа тут не при чем, важны куда и тензорные ядра и версия этих ядер. По моей логике как раз 24 гига врам позволяют догнать новое поколение.

Если исходить из твоей логики то 3090 с 12гб была бы также равна 5070? Очень сомневаюсь.

>Короче, в случае 12 гигов видеопамяти и 16 оперативы — добавить оперативу реально может дать сильный буст.

Это да, но при условии что после добавления модель вся поместится в оперативу. При этом если добавить видеопамяти то буст будет сильнее.

И тот же Кандинский 2б требует 40 гигов

Квантование братик, наше всё. Полные модели так и весят космически, что хуньюуань, что ван 2.1. Даже если не получится выгрузить в оперативу будем сидеть на q4 как бомжи.

>механика персон

Чем тебе лора на персонажа не нравится, натренеруй и загружай в разных сценах.

Сами сцены кал конечно, да и лоры старые с замедлом, я просто прогонял промпты грока без обработки

С wan_2_2_I2V_A14B_HIGH_lightx2v_4step_lora_v1030_rank_64_bf16.safetensors норм будет? Не тестил?

>Хочется, чтобы дома можно было генерировать целые аниме-серии

Размечтался придурок!

Не тестил, они пишут что модели без комфи - для их собственного фреймворка, там обещают скорость генерации х2 от комфи, но это пердолиться надо.

То есть лоры без комфи в имени нет смысла даже качать?

аноны, ну простите за глупые вопросы, комфи первый раз в жизни вижу и не понимаю что в нем и как.

установил нод менеджер, знаю как закинуть воркфлоу. на этом знания все.

объясните, куда закидывать лоры и всякое прочее, которые ускоряют генерацию, ну или улучшают ее на 7-8 шагах, где это брать?

нужен ли для этого отдельный воркфлоу или нет?

чем принципиально отличается wan2.1 от wan2.2 ?

стоит ли начинать с 2.1 или его можно пропустить как устаревший?

может у кого есть ссылка на гайд где разжевывают все для самых маленьких, как управляться с этой адской машиной?

установил нод менеджер, знаю как закинуть воркфлоу. на этом знания все.

объясните, куда закидывать лоры и всякое прочее, которые ускоряют генерацию, ну или улучшают ее на 7-8 шагах, где это брать?

нужен ли для этого отдельный воркфлоу или нет?

чем принципиально отличается wan2.1 от wan2.2 ?

стоит ли начинать с 2.1 или его можно пропустить как устаревший?

может у кого есть ссылка на гайд где разжевывают все для самых маленьких, как управляться с этой адской машиной?

Ван 2.1 использует 1 модель, ван 2.2 использует сразу 2 модели high и low, во всем лучше ван 2.1, кроме потребления памяти, жрет он побольше.

Ван 2.1 устаревший, сразу начинай на 2.2

1. Тык сюда

2. Тут есть все, туториал, ссылки на лоры и модели, места куда нужно складывать

3. В базовом воркфлоу всё есть.

В дефолтных темплейтах есть варианты и с ускорялками и без, посмотри и поймешь.

Ван 2.2 сложнее, но намного лучше, в 2.1 смысла нет.

Гайдов нет, питухонщики все долбоебы с вниманием как у рыбки, и им проще сделать очередную тулзу чем написать гайд.

> Как только модель вываливается из видеопамяти сразу -х5 к скорости генерации ловишь

Это еще повезло, обычно сильно больше. -х2 на фоне -х10 — это немного. =)

> юзались модели e4m3

А e5m2 чем не угодили? Их же тоже куча, их 30 поколение поддерживает, но скорость та же.

> Если исходить из твоей логики то 3090 с 12гб была бы также равна 5070? Очень сомневаюсь.

Нет, если исходить из моей логики, то она должна была быть на ~30% медленнее.

> Квантование братик, наше всё. Полные модели так и весят космически, что хуньюуань, что ван 2.1. Даже если не получится выгрузить в оперативу будем сидеть на q4 как бомжи.

Нет, вообще не так это работает, братан. =)

Я запускаю fp16 модели (по 30 гигов) и они чуть-чуть быстрее, чем fp8, и гораздо быстрее, чем gguf какой-нибудь q4.

Так что, братик, квантование нихуя не помогает в случае видео-моделей, а даже вредит. Все дело совсем в другом.

https://habr.com/ru/companies/sberbank/articles/951800/

> снизить потребление видеопамяти на 35%, с 65 до 42 ГБ.

это они говорят о моделях семейства

https://huggingface.co/collections/ai-forever/kandinsky-50-t2v-lite

> 4.58 GB

https://huggingface.co/ai-forever/Kandinsky-5.0-T2V-Lite-sft-10s/blob/main/model/kandinsky5lite_t2v_sft_10s.safetensors

Как тебе поможет квантование 4,5 гиговой модели до 2 гигов, если она потребляет 65 ГБ видеопамяти в исходном коде — не знаю. =) Но ты квантуй, сэкономишь, будет 63 гига. Победа.

Комфи работает не как квантование, комфи работает иначе.

> Чем тебе лора на персонажа не нравится, натренеруй и загружай в разных сценах.

Это просто дольше и костыльнее. Я же говорю, да, все это можно делать уже сейчас. Но хочется-то проще делать, а не ебаться.

Мечты-мечты.

>-х2

там -х5, и это я так на глаз замерил может все х10 есть, просто даже замерять не хотелось, когда он раньше писал так что читать не успеваешь или когда в оперативу полез то он по слову раз в секунду или две выдавал.

>А e5m2 чем не угодили их 30 поколение поддерживает

Вот именно что поддерживает, но не использует, все равно оно разворачивает модель до фп16, в то время как 50 поколение может на прямую работать с e4m3.

>то она должна была быть на ~30% медленнее

А чего она должна быть медленнее если производительность чипа одинаковая?

Или все таки память играет роль ВНЕЗАПНО?

>Нет, вообще не так это работает, братан. =)

Это интересно, но чем тогда занимается видеопамять просто 10 от размера модели? Там что такое сопутствующее подгружается?

Полные веса 14б модели 56 гигабайт, я про то что если выйдет условный ван 3.0 с весами под 80 гигабайт, то с квантованной моделью все равно можно будет работать. Когда вывалили веса для ван 2.2 все тут резко взгрустнули, а там было чтото около 48 гигов, но потом оказалось не так страшен черт.

>Это просто дольше и костыльнее.

Чем что? Как ты себе это представляешь?

Просто судя по этому:

>чтобы можно было загружать инфу о персонаже (его анимация/мимика, внешность) и он генерился консистентно в разных сценах

это по сути и есть lora

> там -х5, и это я так на глаз замерил может все х10 есть,

Да ты хоть читай внимательно!

Я сразу написал: у ллм просадки х10 бывают, где ты там х5 получил — я не знаю, это или очень быстрая оператива, или очень медленная видяха. =)

И сравнивая просадку х2 у видео моделей и просадку х10 у ллм, видеомодели очень даже мало теряют в скорости (всего-то вдвое), если выгружены на оперативу. У ллм все гораздо худе.

Вот в чем мой тейк.

> 50 поколение может на прямую работать с e4m3.

Только мы говорим про 40 поколение.

И я повторюсь: fp16 капельку быстрее, чем fp8, т.е., запускай смело fp16 на 3090 и на 4070. И, ВНЕЗАПНО, ты получишь одинаковую скорость без всяких ускорялок.

Что опять не так? Скажешь теперь, что 3090 не умеет в fp16?

> А чего она должна быть медленнее если производительность чипа одинаковая?

> Или все таки память играет роль ВНЕЗАПНО?

Никакого внезапно, я сразу писал, что играет роль, но не ключевую.

Ты не пизди.

> Влияет лишь немного

При полной выгрузке влияние х2, на фоне ллм — это немного.

При выгрузке половины модели — х1,3 где-то.

Я хуй знает, как еще ткнуть тебя в сообщения, чтобы ты перестал делать вид, что я все это не написал еще в первом сообщении.

> Это интересно, но чем тогда занимается видеопамять просто 10 от размера модели? Там что такое сопутствующее подгружается?

Я не смотрел (даже хабр пролистал по диагонали), ибо мне Кандинский не интересен по качеству, но я подозреваю, что это все контекст и их реализация внимания. Т.е., модель может там 4,5-9 гигов занимает, а все остальное — самое латентное пространство генерации. Фиг знает.

Вообще, можешь сравнить разные модели: ван 1.3б, 14б, 5б, хуньюан какой-нибудь, и прочие. У них тоже размер контекста разный, некоторые модели прям совсем в условные 6 гигов влазят, а некоторые и в 12 не влезут с тем же разрешением и количеством кадров.

> Полные веса 14б модели 56 гигабайт, я про то что если выйдет условный ван 3.0 с весами под 80 гигабайт, то с квантованной моделью все равно можно будет работать.

Дак а похуй, понимаешь.

Даже полные веса 80 гигабайт — это все равно 80 гигабайт оперативы (если мы используем offload, а комфи и киджай его и юзают), даже тот же файл подкачки. Много — но терпимо.

Так что тут и правда бояться нечего. Конечно, работать будет дольше, если не завезут обновления архитектуры (хотя у лтх вон, архитектура быстрая — и генерит ну такое себе). Но подождать можно, если будет качественно.

> Чем что? Как ты себе это представляешь?

Помнишь модель MAGREF?

Ну, к примеру.

Там можно было загружать до трех изображений (правда у Киджая ты загружал одно изображение с тремя мелкими на белом фоне, э), и модель делала видео, где они совмещены.

Т.е., берутся признаки каждого изображения, и на его основе уже генерится новое, которое и анимируется.

Или же, тот же воисклонинг в аудио — загружаешь голос, генерируешь фразы с похожим голосом.

Изменение изображений — Flux Kontext или Qwen-Image-Edit. Тоже, грузишь изображений (до трех в случае квена) и получаешь изображений на выходе.

Да у Suno уже есть эта фича (persona) — когда песни поются одним голосом.

Так вот, суть в чем. Омни-модель, которая на вход принимает промпт (текст), изображения, видео, аудио, и на основании этих данных генерирует таких же персонажей в описанных ситуациях.

Эти данные берутся каждый раз с нуля и хранятся в контексте. Для этого не нужно обучать лоры.

Собственно, когда выходил Flux Kontext, были слышны возгласы «лоры больше не нужны!» (ну да-да, щас, не нужны, как же!=)

Но для этого надо обучать модель с нуля, и не факт, что кто-то этим сейчас занят, а не дело будущего.

Но раньше и видео генерировалось только с нуля, а потом уже появилось img2vid. Голос генерировался лишь на котором обучалась модель, а потом появился voice-cloning. Так что, в корпоративном сегменте точно этого дождемся. Это упростит работу самим корпоратам — модель просто крутится у них, а люди (за денежки) кидают туда че хотят и получают персонализированный контент.

А вот будет ли такое у нас…

Пока только ручками. Генерить изображение отдельно, озвучку отдельно, а затем черрипикать видео.

———

Ладно, простите, распизделся я сегодня.

Хули тут.

Ждем лтх в опенсорсе хотя бы, надеемся на конец ноября.

Так чет нихуя не нашел нормального. Можно выделить маску кота, подставить в референс этого же кота покрашенного в зеленый квеном, и тогда что-то получается, но это ж блять тупо.

эти модели выпускаются в первую очередь для нужд самих компаний, которые их создают (алибаба, байтденс, и т.д.)

>Вот в чем мой тейк.

Да, теперь понял о чем ты.

>Никакого внезапно, я сразу писал, что играет роль, но не ключевую.

Чьи слова?

>Т.е., память в случае 3090 как раз почти не играет роли, ВНЕЗАПНО.

>Ты не пизди.

>Только мы говорим про 40 поколение.

>Так немного что 3090 практически не уступает по скорости 5070, вот и думай.

Ну это ты почему то говоришь по 40 поколение, да и к тому же 40 так же может работать с e4m3, а 50 дополнительно еще и с nf4.

>При полной выгрузке влияние х2, на фоне ллм — это немного.

Ну фон можно придумать разный, на фоне кофемолки например скорость генерации стремится к бесконечности, а в контексте видеомоделей это x2 что само по себе уменьшает скорость в 2 раза, 5 минут против 10 например очень неприятно.

>MAGREF

Ну это по сути ti2v модель как vace. 3 картинки можно совмещать и сейчас, vace на 2.2 можно прикрутить.

Ты хочешь Qwen-Image-Edit который генерит видео? Чего ты хочешь, я не понимаю.

Правильно составленнй запрос уже половина ответа. Что ты подразумеваешь под эдит?

У тебя есть готовое видео с котом и ты хочешь с делать его зеленым цветом в этом видео?

У тебя есть фотка кота и ты хочешь сделать видео в котором он становится зеленым?

У тебя есть фотка кота и ты хочешь сделать видео в котором он изначально зеленый?

> почти

почти ≠ совсем =)

> 40 так же может работать с e4m

Может, и там скорость чуточку ниже, чем с fp16, а в fp16 работают оба.

Никакого ускорения на 40 поколении от e4m3 ты не имеешь, вот и весь сказ.

> 3 картинки можно совмещать и сейчас, vace на 2.2 можно прикрутить.

Да много где, да, магреф я вспомнил просто потому, что игрался с ней.

> Ты хочешь Qwen-Image-Edit который генерит видео? Чего ты хочешь, я не понимаю.

+ звук, да. =)

Одновременно.

Накидал в модель картинки с голосами и музыкой, а она сама скомпоновала видос по текстовому запросу.

К тому и идем, вот увидишь. Persona появится в видео моделях к концу следующего года, я думаю. Киллерфича же.

К тому же, маркетологи напирают на то, что «с помощью нашей нейронки можно делать кинематографический контент!» (что нихуя, конечно же), но тут будет явно шаг к этому, когда в разных видео будут одинаковые персонажи-«актеры».

У меня есть готовое видео, и я хочу его изменить, так же как квен может изменить готовую фотку, не перерисовывая. Если генерить новое видео - это не эдит.

Для wan 2.2 лоры на раздевания не существуют? Я так понимаю, что он через промт и так умеет это делать?

Так +звук это сейчас даже платные не могут в контексте сэмпла звука как вайб войс.

Такое через еботь можно реализовать - ммаудио будет для фонового шума, вайб войс для генерации аудио, инфинит толк v2v для визуализации речи, ну и предварительно надо сгенерировать ролик с персом. Если бы сделали инфинит толк или humo под ван 2.2 это бы упростило задачу, но что то там не чешутся.

В одной модели этого не будет, как минимум в потребительской версии, только онлайн. Ну и реализация не такая простая задача - на разном сиде по разному нейронка может воспринимать одежду, лицо, голос. Даже в вайб войс речь надо подбирать через несколько вариаций чтобы получилось более-менее похоже. А тут надо чтобы прям звезды сошлись и одежда и лицо и голос и все это в одной модели. Куча переменных.

Ну значит ты все правильно сделал - через маску, а как ты хотел чтобы нейронка поняла что ты хочешь поменять именно кота в зеленый? Она конечно может различать объекты на видео, но ей нужна помощь.

Умеет, но хуевато как-то или я еблан с кривым промптом, чаще всего шмотье снимается неестественным образом.

Нормально снимает. Очень даже естественно.

Ну так Квен умеет же различать объекты без маски? Можно покадрово прогнать через Квен, но тогда каждый кадр будет чуть отличаться, именно это и должна по-идее такая хуйня как Вейс фиксить. У нее причем есть воркфлоу плавно соединить 2 видео, где она по несколько смежных кадров сглаживает, но не плавно соединить все кадры.

огромное тебе спасибо анон. и всем кто подсказывал мне, мелкокарточному ноутбучному человеку.

все получилось. 2060 на 6гб с оперативой в 16гб генерит со скоростью примерно полторы минуты за секунду. на разрешении 480х368. это при 30 гб подкачки.

качество вполне приемлемое для анимационных картинок.

я так понимаю их потом можно еще апскейлерами всякими для видосов погонять.

в общем че хочу сказать. вы приятные люди. добра вам

> даже платные не могут

Не могут, да. Но научатся, я думаю, это естественное развитие моделей. Клиенту за денежку такое поставить — милое дело.

А уж по папирам, какую-нибудь фигню и энтузиасты обучат. Правда хотелось бы уровнем повыше, но вряд ли увидим в опенсорсе. Надеюсь ошибаться.

Из апскейлеров есть RealESRGAN x2 / x4 plus (Anime6B), всякие 4x AnimeSharp и UltraSharp. Ну и король SeedVR2, но он ебуче долгий и требовательный, на него забей. =)

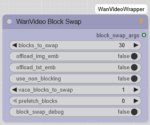

а куда тут лоры вставлять?

не облегчающие генерацию, которые на на скрине, а которые с цивитая скачиваются.

не облегчающие генерацию, которые на на скрине, а которые с цивитая скачиваются.

эти ноды продублируй и подключи в цепочку дальше

там уже другие лоры подключишь

можешь ноду с пика два поставить

там можно много лор в одной ноде подключать

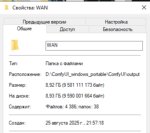

и еще вопрос. опять же по цивтаю. там лежать модельки для ван.

типа таких.

https://civitai.com/models/1981116/dasiwa-wan-22-i2v-14b-lightspeed

https://civitai.com/models/1820829/wan22-i2v-a14b-gguf

эт все так же в воркфлоу gguf нормально впишется?

что вообще стоит скачать и попробовать? кто на чем сидит?

типа таких.

https://civitai.com/models/1981116/dasiwa-wan-22-i2v-14b-lightspeed

https://civitai.com/models/1820829/wan22-i2v-a14b-gguf

эт все так же в воркфлоу gguf нормально впишется?

что вообще стоит скачать и попробовать? кто на чем сидит?

все качай, все пригодится. подготовь только ссд на гигов 500.

Ксюха на тестах новой дистил модели.

Вот что нужно для самой базовой генерации

Степень квантования Q подбирается на основании объема vram + ram

Чем ближе к q8 = лучше качество и больше требует

Если памяти супер мало рассмотри варианты q4km или q4ks ниже этих скорее всего будут сильные артефакты.

Это от куда брать модели, чел давно занимается квантованием. Лично я предпочитаю брать всю базу именно из таких источников (дело конечно твое), а всякие лоры стили, переходы, хуи в рот уже на цивите:

https://huggingface.co/QuantStack/Wan2.2-T2V-A14B-GGUF/tree/main

https://huggingface.co/QuantStack/Wan2.2-I2V-A14B-GGUF/tree/main

Вот лоры ускорялки из первоисточника:

https://huggingface.co/lightx2v/Wan2.2-Distill-Loras/tree/main (Это только для i2v моделей, да ускорялки так же как и модели подбираются от задачи t2v модель = t2v ускорялки и t2v лоры, верно говорят, что диск будет засран полностью особенно по началу, когда качаешь все подряд)

Новую лору i2v с постфиксом 1030 можно взять с цивита, хотя официально никакой 1030 lightx2v не выпускали, но типа есть и есть, вроде нормально работает (1030 это только для high части основной модели)

https://civitai.com/models/1585622/lightning-lora-massive-speed-up-for-wan21-wan22-made-by-lightx2v-kijai?modelVersionId=2361379

Забыл добавить самые актуальные ускорялки для t2v модели

https://huggingface.co/lightx2v/Wan2.2-Lightning/tree/main/Wan2.2-T2V-A14B-4steps-lora-250928

К сожалению более сжатые версии нужно искать в репе у Киджая, но там насколько сильно насрано, что это может быть отдельным квестом:

UPD:

https://huggingface.co/Kijai/WanVideo_comfy/tree/main/LoRAs/Wan22-Lightning

Вроде как вот эти

Тут выше был вопрос у человека на счет резких переходов, короче промпт такой "then new scene appears" - работает постоянно.

Вопрос к знатокам, очень тяжело сохранить персонажа то есть теряется identity уже много перепробовал, может кто знает как это победить?

Вопрос к знатокам, очень тяжело сохранить персонажа то есть теряется identity уже много перепробовал, может кто знает как это победить?

я с llm glm-4.6, qwen3-235b, minimax m2 230b

> ссд на гигов 500

Т_Т

> Вроде как вот эти

Типичная фраза, когда роешься у Киджая. =(

250928 - точно они, я просто сейчас больше по i2v угараю, на t2v даже лор нет :)

Так для i2v один хуй нужны t2v лоры персов, i2v сам по себе же только действия запоминает.

Как в комфи поменять файл подкачки с диска С на другой? Установлен не на С.

какой же хидден жем этот LTX video. и как же на него хуй пложили.

первый видос - ван два остальных - ltx.

ван безоговорочно размыливает в пизду i2v.

первый видос - ван два остальных - ltx.

ван безоговорочно размыливает в пизду i2v.

кстати полазил по цивитаю и увидел некоторое количество моделей идущих одним файлом и не имеющим разделения на хай и лоу. с нми то как быть?

я извиняюсь за миллион тупых вопросов, я бы сам все потыкал, проверил. но скорость генерации не располагает к экспериментам если честно.

я извиняюсь за миллион тупых вопросов, я бы сам все потыкал, проверил. но скорость генерации не располагает к экспериментам если честно.

Генерач, подскажи какие ИИшки могут ватермарку с динамичного небольшого видоса убрать? Не обязательно прям идеально. Шапка огромная, в каждой разбираться устану

Какой апскейлер для комфиУИ посоветуете?

это говно для в2.1, потерявшего актуальность.

по сути сейчас доступен только тупой апскейл по картинкам плюс промежуточных кадров можно нахуярить.

Честный апскейл есть только у LTXvideo, но там пораша.

Честный апскейл есть только у LTXvideo, но там пораша.

Да там скорее про мувмент, что промптами описать, пока к себе на диванчик пикачу желания заспавнить не было :D

короче на хуй. такое отсутсвие цензуры ещё хуже чем.

Было настолько тяжело, что хуй опал ниже уровня моря и поднять его более не было ни сил, ни желания

>Как в комфи поменять файл подкачки с диска С на другой? Установлен не на С.

Никак. Этим не comfy а система заведует, у нее в настройках ройся.

Скорее всего они декйствитенльо для 2.1, смотри на base model в деталях справа. Но стоит отметить, что лоры 2.1 иногда нормально работают и для 2.2, их нужно запихнуть и в хай и в лоу и с весом поэксперементировать.

Кроме того, читай описания внимательно. Пару раз видел 2.2 лоры, у которых просто оба файла загружены в одном архиве.

шел мимо, там мой видос, нинадо там никаких лор дополнительных на переход, просто у автора лоры руки из жопы, ван прекрасно понимает переходы, там только лора одна юзается и это NSFW posing

и то веса не большие у нее. Сохранение лица ван тоже делает, нужно промптить чтоб старался удерживать черты из исходника, можно еще прописать из ферст фрейма, но тут уже больше рандом, если хороший исходник то шансы высокие, а так все равно пририсовывает черты всякие.

для перехода ван работает с палкой |, можно добавить еще промпта типо

| Immediately cut to a new scene where the exact same woman is now naked in the shower stall...

Но тут тоже зависит от исходника, но проблем с переходом никогда не было.

seedvr2 - для элиты.

FlashVSR - для крепостных.

всякое говно через модели по 50 мегабайт - для бомжей.

>для перехода ван работает с палкой |

Пробовал уже, но нихера не получалось.

ну значит гдето промпт ишью, описывай детальнее переход/новую сцену, у меня например не возникает проблем засумонить любую тянку в ночную палатку с фонарем, или в душевую :d

но там достаточно промпта на обозначение перехода к новой сцене и локации. не одна фраза

Скинь один ролик со вшитым воркфловом. А я у себя попробую.

о, ананасы, спасибо за идею! Я дохуя времени тратил на то чтобы развернуть бабенций в нужную позу, а тут вот оно как просто оказывается.

посмотри у меня, асло, ван нормально кушоет русский язык.

prompt:

Моментальная смена сцены: Та же девушка лежит на грязном матрасе задрав ноги, она жирная как свинья, она смотрит на зрителя высунув язык.

Её ебёт зритель от первого лица. Хорошо видна её пизда сиськи волосатый лобок, девушка получает удовольствие от секса.

посмотри у меня, асло, ван нормально кушоет русский язык.

prompt:

Моментальная смена сцены: Та же девушка лежит на грязном матрасе задрав ноги, она жирная как свинья, она смотрит на зрителя высунув язык.

Её ебёт зритель от первого лица. Хорошо видна её пизда сиськи волосатый лобок, девушка получает удовольствие от секса.

>она жирная как свинья

😂

Для чего нужна clip_vision_h.safetensors? Вот в примерах в шапке в ван2.1 она есть, а в ван2.2 её нету, хотя можно так же подключить. Что конкретно эта модель делает? Вроде и без нее нормально работает.

Можно ли тренить Ван лору сначала на одном датасете, потом загрузить стейт, и продолжить на другом?

Если тренишь нсфв, то нужно ли при тренинге сразу подключать общие нсфв лоры?

Если тренишь нсфв, то нужно ли при тренинге сразу подключать общие нсфв лоры?

наскок я помню это костыль для понимания входящего изображения, в ван 2.2 он уже вшит, потому нормально работает в и2в без него, у ван 2.1 в и2в без этого было не очень

но могу и напиздюнькать анонче D:

Аноны, какой последний воркфлоу для вана на комфи? Вроде вышлим какие-то новые лоры, они годные?

И как промтить еблю? В гайде только про свет и сцену написано

Ван 2.2 больше не делится на две модели по 480p и 720p? Какое у него оптимальное разрешение?

Не делится. Теперь есть две разные модели - мелкая на 5b и обычная на 14b. 14b состоит из двух частей - хайноиз и лоуноиз.

Вроде 720р для 14b модели норм, но это не точно.

От 352 до хуй знает 1920 по большей стороне.

Я выше 1280x720 не ставил.

А вот ниже 352x192 там совсем мазня.

А вот 5б модель как раз 1280x704 норм генерит. Начинается от 960x544 где-то, не ниже.

И раньше было две разные. =) 1,3б забыл.

Если тренить t2v на видосах, то каждый кадр по импакту будет равен отдельной картинке? Вот у меня к примеру датасет из 100 чанков по 41 фрейм, это значит за 1 эпоху на них как 41 эпоху на датасет из 100 отдельных картинок тренит?

0.3.68 выкатили.

>Added RAM Pressure Cache Mode for intelligent memory management under resource constraints

Где это включить?

>Accelerated model offloading using pinned memory with automatic low-RAM hardware detection

Найс.

>Enhanced FP8 operations: reduced memory usage and fixed torch.compile performance regressions

Improved async offload speeds and resolved race conditions

Это вообще пушка, на практике еще б работало.

>Added RAM Pressure Cache Mode for intelligent memory management under resource constraints

Где это включить?

>Accelerated model offloading using pinned memory with automatic low-RAM hardware detection

Найс.

>Enhanced FP8 operations: reduced memory usage and fixed torch.compile performance regressions

Improved async offload speeds and resolved race conditions

Это вообще пушка, на практике еще б работало.

> Added RAM Pressure Cache Mode for intelligent memory management under resource constraints

В линуксе всегда было: sudo sysctl -w vm.vfs_cache_pressure=500

В том видосе разрешение 1024 х 1792. Ты использовал апскейлер или прям в таком разрешении генерил? Какое у тебя железо и как долго видос делался?

Кстати если очень низкий shift тоже могут быть проблемы с переходом, ибо мало нойза. Че прямо реально он понимает the character from the first frame? Писец поражаюсь вану, просто лучшая модель даже без лор, в нем такой потенциал безумный

БТВ очень много лор на цивите воспроизводятся промптом

стоит ли писать промты на русском языке в ван2.2?

или английский он поймет лучше?

а еще, аноны, смог ли кто из вас заставить промтом двигать камеру в нужную стороны? в img2vid именно.

есть какие то заклинания может?

лоры нашел для движения камеры. но там не сказать что на все случаи жизни

или английский он поймет лучше?

а еще, аноны, смог ли кто из вас заставить промтом двигать камеру в нужную стороны? в img2vid именно.

есть какие то заклинания может?

лоры нашел для движения камеры. но там не сказать что на все случаи жизни

Лучше всего на китайском.

сдается мне что это не ван кушоет, а энкодер переводит

А ведь классики предсказали содержимое промптов ещё в далёком 2006...

а что по твоему должно быть в промпте? Котиус по взаимному согласию?

обновил всю хуйню, заодно и питона

что сказать при сразу генерации на прошлом сиде для сравнения дало иной результат, несколько получше. детально прям не вникал, но в целом работа и качество генерации на фп8 выросло. (сравнивал на одном и том же промпте и сиде с прошлых генов).

врам перестал долбится в потолок и стабильно висит на 70-75% при генерации, стало пошустрее. рам тоже перестал вытекать в трубу и цифры стали более адекватными, выше 50г при 128г не поднимался.

пара нод правда отвалилось ну да ладно :o

Пиздец, я столько времени проебался вслепую с мусуби, а оказалось там есть отдельный бранч в репо, в котором пофикшен баг с генережкой сэпмплов во время тренинга.

пу пу пу...

Это мужик если что...

Межсистемная.

Как можно уменьшить артефакты в виде ряби на мелких движущихся деталях, например волосы, пальцы, листья? Увеличить количество шагов вроде немного помогает, но полностью не устраняет проблему. Я сижу на лайтинговой лоре, подозреваю что это из-за нее. Походу нужно использовать модель без ускорялок и выставлять 20-30 шагов, чтоб картинка была чистой?

Отключить FP16 ускорение, BF16 заменить на дефолт, выключить fp8 fast и за одно и сажу.

У меня самый простой ворквлоу из шапки. Тобою названые опции или ноды там вроде нету.

А какая модель у тебя? FP8_scaled это минимум.

Да, именно она 14B_fp8_scaled

Вообще отключи лайтинг на лоу или уменьши до 0.5, но добавь дистил лору та что 64 ранк и поставь 1.5. Если торч/маг кэш используется, тоже отключи их нах. И какое разрешение вообще выставляешь?

Короче, я седня мучал Wan S2V пару часов, и плюнул.

InfiniteTalk все же наголову лучше.

В комфи, по крайней мере, S2V тащит не очень долго, а вот инфинит прям 30 секунд хуярит по красоте.

Да-да, у S2V куча плюшек, о которых я сам говорил.

Но в результате помимо плюшек — мазня и слабая анимация.

А инфинит просто наваливает норм липсинк и анимацию даже.

Грустно это, очень грустно.

InfiniteTalk все же наголову лучше.

В комфи, по крайней мере, S2V тащит не очень долго, а вот инфинит прям 30 секунд хуярит по красоте.

Да-да, у S2V куча плюшек, о которых я сам говорил.

Но в результате помимо плюшек — мазня и слабая анимация.

А инфинит просто наваливает норм липсинк и анимацию даже.

Грустно это, очень грустно.

>А инфинит просто наваливает норм липсинк и анимацию даже.

И речь? Или речь накладывается на готовый видос?

Народ, ну серьезно. Пиздежь на генерациях заебал. Я засунул NAG в ВФ, но может я его как то неправильно привязал? Может кто глянуть?

Teeth в негатив

speaking, talking, conversation в негатив

Кто-нибудь тренит Ван2.2 чем-нибудь кроме мусуби?

С мусуби на 3090 у меня получается только 1 модель тренить за раз (2 не влезают хоть полностью оффлоадь), по 17сек/шаг. При этом с константным ЛР 0.001 пока нихуя годного не натренилось за 3к шагов, сейчас пробую с 0.002 и козиной. Есть ли понт другие тренеры пробовать?

С мусуби на 3090 у меня получается только 1 модель тренить за раз (2 не влезают хоть полностью оффлоадь), по 17сек/шаг. При этом с константным ЛР 0.001 пока нихуя годного не натренилось за 3к шагов, сейчас пробую с 0.002 и козиной. Есть ли понт другие тренеры пробовать?

>Teeth в негатив

Бомжих генерить? Не, пасибо.

Да в том и дело, прописано уже

>mouth speaking, moving mouth, talking, speaking, mute speaking

был.

Другие лоры ускорялки попробуй.

читаешь с губ @ озвучиваешь в vibevoice

И речь.

sound+image2video

>InfiniteTalk все же наголову лучше.

Теперь HuMo попробуй, а лучше комбуху сразу HuMo + InfiniteTalk

Со сменой ЛР лоу норм натренилась за 3к шагов.

А вот хай с рекомендованным min_timestep 875 чет ваще пока нихуя не тренится. Есди убрать мин то тренится, но они ж сами рекомендуют его ставить?

На diffusion-pipe треню, две за раз никак не получится. lr = 2e-5 использую, с прогревом.

Для лоу использую min_t = 0 и max_t = 0.875, для хай min_t = 0.875 и

max_t = 1

Эпох надо тренить тренить, 30 эпох уже можно оценить что получается, и чем выше разрешение в датасете тем кажется нужно еще больше эпох чтобы результат был не хуже. В среднем треню 100-200 эпох чтобы неплохой результат выдавало.

-5? Странно, если у меня на 1е-4 нихуя не шло, а это еще в 5 раз меньше.

И с какого шага у тебя хай начинает получаться? У меня уже 2к шагов сейчас пердит, и лосс хоть и упал с начальных 0.7 до 0.5, но на лоу он уже на первых 100 шагах был в 0.1. И это с 2е-4.

Я не ориентируюсь на шаги, их количество зависит от размера датасета, на 30 эпохе обычно делаю паузу и тестирую что получается.

Возможно высокий ЛР тоже не есть хорошо, я делал тренировку с automagic оптимизатором, он сам выбрал ЛР 1е-6, и на 30 эпохе вполне себе результат норм был.

Так наоборот важно только количество шагов: от того что нейронка увидит 10 картинок 30 раз, она физически не научится больше, чем если 300 картинок 1 раз.

Там еще пизже становится?

А то я че-то хумо тыкал, он мне показался так себешным.

Но я буквально пару видосов сгенерил и забил.

Ты сюда не ходи, ты туда ходи

Так с хаем с высоким min_timestep нихуя и не вышло, чем выше ставишь тем хуже тренит. Но ВНЕЗАПНО оказалось, что дуалмод не пашет только с мультигпу, а на одной гпу спокойно пашет. И дуал по-идее должен менять модели на тех же 0.875, но он тренится так же хорошо как лоу. Посмотрим че натренит, потом придется другие тренера все-таки пробовать, вдруг у них пашет.

Интересная штука, конечно, уже 6-ые сутки жду хотя бы одну генерацию.

Ван может делать клип добавив первый и последний кадр? Как эта фича называется?

Как законтрить это ебучее мигание

может, называется first frame - last frame

Попробовал АИ-Тулкит - и сходу соснул хуйца. Эта залупа еще на этапе загрузки моделей забила все мои 96 гигов рам, и потом встала намертво на кешировании латентов. Осталось попробовать пайп.

И с пайпом тоже соснул: он хотя бы запускается, но оказывается ваще не делает сэмплы, и мультигпу у него из коробки не заработало. Так что лучше уж тогда ебаться дальше с мусуби.

Также проверил: если тренить на видосах, то шагов все равно нужно столько же, сколько на пикчах.

сидом обычно,

blinking light в негативе

Уважаемые, хочу брать 5080 на 16 Гб, для локальных генераций, балуюсь в квин и Ван видео, что думаете в пределах сотки потянет видеокарточка или мб что получше есть для нейронок за такой же ценник, сейчас сижу на 3060 12 ГБ, на пикчи в принципе хватает но пятисекундные видео по полчаса генерировать в хорошем качестве что-то не сильно радует

3090 естественно лучше, и весь мир сидит на них.

>3090 естественно лучше

>чип на ~30% слабже а если брать не ti то и вовсе на 40-45%

>брать уманейную в говно некроту на древней архитектуре в 2025

Дааа мань, это точно хороший выбор. А по поводу 24гб, на 16 в ване почти негде страглиться, только об говно типо инфинититолка и прочей аудио поебени где в 25 фпс надо генерить с коробки, там уже придется усираться либо с чанками по 2-3 сек либо разрешение въебывать, но я бы предпочел скорость.

Там оказывается просто нужно только одну ноду подключить, а я думал хуйню еще какую-то качать надо.

Ну вот я тоже подумал 3090 хоть и мощно но по архитектуре уже относительно мёртвая и сейчас всё пилится по сути для новых архитектур на сколько я понимаю. Какое-то слишком высокое разрешение генерить не собираюсь и сложные сценарии с тяжёлыми моделями. По сути обычная домашняя генерация для своих хотелок.

Тебе 5060ти 16гб\5070ти\5080 хватит на видосы 720х1280х65-73х16, между 5070ти и 5080 разница в скорости есть но не существенная, примерно как между 5070ти и 3090ти, на 5060ти уже очко будет нет конечно, я преувеличиваю, все мы тут терпилы, мы ждем и ты подождешь

>720х1280х65-73х16

Расшифруй

Ты наркоман. В 24гига с трудом влезает тренинг 41 фрейм в 480п или 81 фрейм в 360п, в 16 не влезет даже это. И даже тренинг на фотках все равно нужно оффлоадить, а оффлоад занимает времени намного больше, чем любые вычисления.

4 секунды в нативном хд, в 16 фпс, на 14б модели. Если брать разрешение меньше типо 832х512 то и 7 секунд влезет.

Он тренит лоры на декстопной карте вместо того, чтоб арендовать h100 на день за пару копеек, а наркоман я. Я имел ввиду базовые генерации без трейна, вот там на все хватает.

Ну так и генери на арендованной, хули, раз считаешь что это копейки.

Тренинг вована на потребительской карточке слишком тяжелый, мало того что памяти надо много так еще и медленно пиздец, это как жрать кактус, зачем это делать если можно не делать? А вот просто пользоваться моделью можно с комфортом на игрокарте.

Тренинг ты поставил и забыл, а время тратишь как раз когда генеришь и ждешь что сгенериться.

>-73х

А это что значит?

Зачем так много разных сэмплеров? Еще вопрос: на что влияет scheduler?

и сколько щас будет стоить такой компик?

в общем нет смысла тратиться на супермощные видюхи?

ты наркоман, кто спрашивал про тренинг блять

Там это, ови обновилась до 1.1

Теперь 10 секундные видео со звуком.

И 5 секундную версию тоже обновят. Переобучили с датасетом в более высоком разрешении.

https://www.reddit.com/r/StableDiffusion/comments/1otllcy/ovi_11_is_now_10_seconds

https://github.com/character-ai/Ovi

Весов пока нет.

Теперь 10 секундные видео со звуком.

И 5 секундную версию тоже обновят. Переобучили с датасетом в более высоком разрешении.

https://www.reddit.com/r/StableDiffusion/comments/1otllcy/ovi_11_is_now_10_seconds

https://github.com/character-ai/Ovi

Весов пока нет.

А сколько старая весила? Ее можно локально запускать?

23 кека весила

https://huggingface.co/chetwinlow1/Ovi/tree/main

У киджая есть ноды для её запуска.

Я фп8 запускал

модели

https://huggingface.co/Kijai/WanVideo_comfy_fp8_scaled/tree/main/TI2V/Ovi

вае для ммаудио

https://huggingface.co/Kijai/WanVideo_comfy/tree/main/Ovi

Ещё вот этот чел запилил ноды для ови

https://github.com/snicolast/ComfyUI-Ovi

В wangp тоже можно запускать ови

https://github.com/deepbeepmeep/Wan2GP

В чем разница между вейсом и анимейтом? Потыкал оба, шо то хуйня шо ета хуйня отличий особо не заметил.

на паузу поставь

Текст ту видео только? и 18+ наверно не поддерживает

Анимейт специально сделан для одного юзкейса, а у вейса их несколько, и по-другому приоритеты выставлены.

судя по ноде выше в посте и i2v поддерживается, если загрузить 1 фрейм в виде фото.

Это ответ уровня "никак"

Может какую-то лору на запрет изменения яркости и всякие такие эффекты мудацкие кто сделает

на самом деле в анимейт можно и другой контроль пихать, не только опенпоз. поэтому основное отличие от вейса в невозможности вставлять фреймы куда захочется, только стартовый.

ыыыы давай на любой пук делать валшебную кнопку под названием ЛОРА, которая ЗАПРЕТИТ вану мигать!!!! А пропмпмты ваши дурацкие я использовать не собираюсь....

Так промты не помогают. С чего ты взял, что я их не использую.

Модель вана очевидно кривая, она всё время меняет яркость сцен, и мигает всё постоянно в темных сценах.

Удивительно что до сих пор никто такой лоры не запилил.

>Удивительно что до сих пор никто такой лоры не запилил.

Потому, что есть уже. Это нодой (даже несколько реализаций есть) постпроцессинга color match лечится, кроме совсем уж терминальных случаев. Принцип - на вход кидается выход семплера, и картинка-образец. Нода приводит яркость-контраст на всем поданном к образу, и отдает дальше выровненное по параметрам. Сильно нужная штука для loop-видео, без нее стык по глазам бьет.

пиздеж, ван 2.2 почти нихуя не меняет. ван 2.1, там да, постоянно шифт цветов происходил. сколько не генерил темных сцен, ничего не мигало пока.

блять колор матч это древний костыль который для хуньяня и 2.1 вана использовали когда цвета гарантированно шли по пизде при каждой генерации, причем равномерно по всей длине. то есть если цвета динамически меняются то оно нихуя не поможет. а сейчас и проблемы такой считай что нет. для луп видео ты юзаешь один и тот же фрейм для последнего и первого кадра, там априори не может быть проблем с цветом на стыке.

> Весов пока нет.

Значит, пока не обновилась.

Таких обновленных, которые где-то в облаке есть, у нас навалом. =)

Да и ови так и не впечатляет, все еще не уровень ван2.2 по качеству видео, не уровень ван2.5 по аудио, крайне вероятно.

Хорошо, но пока рано радоваться.

Будем надеяться, что они не остановятся и сами не уйдут целиком в облаке.

bump

кто то подскажет лору на первом видосе? алаамора

че ты бампаешь-то

Уже выкатили, и кежич ноды обновил.

Ну, видео более-менее, пожалуй.

Это все еще 5б, для 5б неплохо, да.

Ладно, поиграюсь завтра, спасибо.

>для луп видео ты юзаешь один и тот же фрейм для последнего и первого кадра, там априори не может быть проблем с цветом на стыке.

Во первых - это если ты готов удовлетвориться длинной лупа в 5 секунд. А если хочешь сделать 15-20 - ну обойдись. :)

(Делается то оно через 3-4 фрагмента продолжений, закольцовывая последний на первый - и освещение уплывет гарантированное без этой ноды.)

А во вторых - даже на 5 секунд, и даже на wan 2.2 с одним фрагментом start-stop из одной картинки - может уплыть. Ван не идеально приводит к последнему фрейму, особенно если движения резкие и со "смещениями камеры".

>то есть если цвета динамически меняются то оно нихуя не поможет.

Скармливать за образец исходную картинку надо, и для всех фрагментов - тогда поможет.

А вообще - не 100% случаев конечно. Но заметно лучше.

Давай без нейрофапа, я смехуючков, ржаки хочу.

Транс

Ну, мне показалось, что русский стал лучше.

Но генерит долго. Много врама на контекст + 50 степов.

Какой транс.. Это солист Токио Хотел и это отдельный мем

Тебе мб не показалось, у него факап был все это время

>Bug was that the audio negative prompt wasn't actually used, and it always used the video negative instead, which probably was bad for audio..

если ты тупо последний сгенерированный фрейм продолжаешь по технологиям из каменного века, то у тебя вообще все уплывет, и цвет, и персонаж, и сцена, все нахуй, если движений в кадре больше чем дрочка с ампилитудой 5 сантиметров

Хули без звука блять? Ебучие gif анимации одни. Нормально делайте

Хули вы тут штаны просиживаете, пиздуйте на онлифанс бабло грести

Ну, предложи технологию НЕ каменного века для лупа на 20 секунд.

А так - разумеется, всё уплыть может, но речь о том, что так хотя бы в принципе может НЕ уплыть. :)

И при некоторых усилиях результат достижим, хоть и не на произвольном сюжете. Но уж лучше так, чем никак вообще. :)

>технологию НЕ каменного

Вангую раскадровку через квен и потом сборку через fflf, либо вариации где ласт фрейм применяется эпизодически дабы фиксировать начавшую плыть генерацию.

Ну еще есть лора на персонажа.

если вы используете слово "креатив" как нарицательное, то я ебал ваш тупой рот, так говорят только отбитые манагеры которые в своей жизни нихуя делать не умеют сами, даже черточку на бумаге нарисовать без посторонней помощи/делегирования

О КАК

То-то я вчера смотрел, что какие-то промпты негативные странные в новом воркфлоу. А это они в старом не работали как надо, ясно…

Справедливости ради, я верю, что можно собрать воркфлоу, но хочется, чтобы оно еще и по скорости было не 2х, а в районе лишних 10%-20%…

Челище, это устоявшееся выражение в маркетинге.

мимо

fp8_e4m3fn

fp8_e5m2

В чем разница?

fp8_e5m2

В чем разница?

Ну и крипота на этом 5B получается, надо роллить...

Второй формат работает с торч компайл на амперах. Первый вроде получше качеством, т.к. выше точность в мантиссе.

Второй формат работает с торч компайл на амперах. Первый вроде получше качеством, т.к. выше точность в мантиссе.

челчелище, я именно это и написал, не?

>Локальные

А какие годные гайды на ютабе для нубов есть?

Нет и не будет.

Всё очень стремительно развивается, проще самому сесть и вникать

>steps 50

>960x960

Пожалуй даже пробовать не буду

скидывай мать сделаем

для 5b такое разрешение как 480x480 для 14b в плане скорости

Я там поуменьшал, типа, 720x720, 35 степов… Ну, такое.

https://huggingface.co/kandinskylab/models

Вышел Kandinsky-5.0-Pro-19B (T2V, I2V).

40 гигов, 5 и 10 секунд, 512 разрешение.

Вроде выглядит не всрато, если завезут в комфи — можно будет потестить.

Но и прорывом не прорыв, конечно.

Вышел Kandinsky-5.0-Pro-19B (T2V, I2V).

40 гигов, 5 и 10 секунд, 512 разрешение.

Вроде выглядит не всрато, если завезут в комфи — можно будет потестить.

Но и прорывом не прорыв, конечно.

WAN обучали на блядских 16 фпс, т.е. видосы перед обучением конвертировали в 16 фпс? Или это такая особенность генерации?

Да, а что тебя удивляет?

Месяц ниче не генерил и не заходил, а у вас тут кроме лайтнингов нихуя нового - шо за стагнация

Апгрейд 4090 до 48гб всего за 75к без ебли с китаем - это совсем не стагнация.

Всего за 75К можно поучаствовать в аттракционе невиданной щедрости проебать видеокарту

Ты еще скажи что огрызки он амд и Хуанта с 100+ Гб оперативки это хорошая тема

У вас тоже в хагифейс скорость ноль?

Как фиксить?

Как фиксить?

Уезжай из рашки в норм страну

У меня платное прокси норм страны, все равно не качает

Ну то что какой-то нестандартный фпс для видео. Не могли бы они взять 15 фпс? Так бы при удваивании получались классические 30 фпс, а не 32. Да можно в видеокодировщике форсировать 30 фпс, но это на пару процентов занизит скорость оригинального клипа. Я понимаю, что это как бы мелочи.

Тебе бы в дурке прокапаться, чел

всю жизнь 90% кино снимали и сейчас снимают в 24 фпс, какие 30. плюс уроки информатики вспоминаем, там вроде рассказывали про вычисления со степенью двойки

Добавь в лист антизапрета cas-bridge.xethub.hf.co

Я хз что ты хрюкнул про огрызки, но конкретно этот апгрейд - ахуенная тема. 4090 изначально стоили 90к, это сейчас они х2 сделали как раз из-за этого апгрейда, но это значит что в теории, если кто-то научится их аналоги выпускать, то это удвоит потенциал всех бич-сборок.

Это кинофильмы в 24 фпс. А большинство остального контента в 30 фпс. Окей, в странах с PAL и SECAM было 25 фпс. Но сейчас, в эпоху глобального интерента, этот стандарт неактуален.

>изначально стоили 90к

В какой вселенной лол. У нас они с нулевой стоили ~150К, в Европе 3К баксов.

Если бы она стоила 90К, а бы лучше вторую карту взял в сборку, чем перепаивать чипы за 75К

Стакать ты можешь с таким же успехом и 3090 за 50к, прошивки на 4090-48 и слили потому что они нахуй не были нужны без этого апгрейда.

Зачем вообще нужна текстовая модель nsfw_wan_umt5-xxl_fp8_scaled, если обычная (без приставки nsfw) вроде тоже хорошо работает?

Это просто наебка гоев

Полон тред хохлов что ли?

Наш русский слон запилил модель и все молчат

https://github.com/Ada123-a/ComfyUI-Kandinsky/

Наш русский слон запилил модель и все молчат

https://github.com/Ada123-a/ComfyUI-Kandinsky/

Она умеет ебать хуем в рот?

Пикрил ты. Потому что:

И так во всём, лишь бы повизжать сильней.