>Почему, кстати, сукаберг сдулся?

Санкции от РФ помешали. Ведь все ключевые разработчики ИИ родом из России или СССР, лол.

На деле просто да, люди это главное.

>все ключевые разработчики ИИ родом из России или СССР

И они уже давно съебали из этой страны. Да и вообще, большую часть работы сейчас выполняют индусы за полторы копейки, которым итак наводнена контора экстремистов и террористов. Рассказы про голодающих инженеров с тремя высшими за которыми гоняются все западные конторы потеряли актуальность еще в середине нулевых.

Перемерил на двух 3090, вторая на x1

1.

pp6000 | 478.61 ± 0.43 |

tg512 | 12.88 ± 0.00 |

2.

pp6000 | 57.45 ± 0.00 |

tg512 | 12.11 ± 0.07 |

3.

pp6000 | 361.43 ± 0.65 |

tg512 | 9.26 ± 0.04 |

Как ты видишь, в моем случае пересылки ебут очень и очень больно при обработке контекста, если атеншен и эксперты лежат на разных картах. Еще можно сказать, что выгрузка экспертов в память - это последняя мера, потому как руинит генерацию. Смотри что происходит, если взять конфиг первого опыта и добавить теслу, скинув на нее часть слоев с первой карты (разумеется, уменьшив количество выгружаемых в рам экспертов):

pp6000 | 473.72 ± 0.06 |

tg512 | 17.86 ± 0.09 |

Да, пп мизерно просел, но +5 токенов в генерации, весьма и весьма полезно. Поэтому я удивлен, что тут у чувака с 3060 + сmp или у 4080 + 3070 не наблюдается прироста при использовании первого способа. У второго была DDR5-5600/Ryzen 7 9800X3D , не помню что у первого, но если тоже схоже, значит можно сделать вывод, что более современные платформы реально решают, когда дело касается выгрузки экспертов в рам.

> pp6000 | 478.61

> pp6000 | 57.45

А ты случаем не меняешь главную карточку, или какие-то подобные манипуляции?

Там пересылов немного и они никоим образом не могут повлиять настолько сильно. Чтобы получить столь колоссальные задержки нужно буквально полные веса пересылать. Что и будет происходить если основной станет вторая, что сидит не на широкой шине, а по х4 или ниже. Проблема окажется не в пересылах активаций а в стриминге весов на нее для обсчета.

> выгрузка экспертов в память - это последняя мера

Ну это типа база и необходимое зло, иначе без врам вообще никак не запустить.

> Смотри что происходит, если взять конфиг первого опыта и добавить теслу

Часть экспертов вместо профессора на теслу в дополнении к остальному, или тесла зменяет одну из 3090?

> у чувака с 3060 + сmp

У него как раз было ускорение когда не стал на паскаль закидывать attn, оставив его на ампере, а скинул только линейные, вариант 2.

> у 4080 + 3070

Посты сумбурные и нужно отслеживать, но похоже что то же самое.

По скорости обработки частей на проце тут очевино что чем быстрее рам тем лучше будет. Но именно по задержкам связанным с шиной каких-то откровений не ожидается. И у тебя какая-то аномалия с резкой просадкой на ровном месте.

>А ты случаем не меняешь главную карточку

Неа, не меняю.

>Часть экспертов вместо профессора на теслу в дополнении к остальному, или тесла зменяет одну из 3090?

Было 3090 Ti + 3090, стало 3090 Ti + 3090 + P40, под завязку. То, что не влезло - на цпу (в виде -ncmoe)

>У него как раз было ускорение когда не стал на паскаль закидывать attn

Ага, это помню. Интересно, как подключены у него карты. И у него тоже странно - как ты видишь, в моем случае паскаль нормально считает аттеншен, нет значимых просадок по сравнению с гонянием экспертов из рам и обсчете на основной.

Я бы проверил на честных-честных чипсетных х4 из слота, а то тут все на райзерах (ошибок нет в nvidia-smi, сразу говорю), но у меня там с недавних пор карта для RPC сидит, шатать риг ради тестов я не буду.

В общем, дивны дела твои господи

Для диагностики попробуй менять пропорции атеншна между карточками. Зафиксируй положение экспертов с помощью регэкспа:

> -ot "blk.[1-9]\.ffn_._exps\.=CUDA0;blk.2[1-9]\.ffn_._exps\.=CUDA1;blk.ffn_._exps=CPU"

подстроив их количество под свои карты, можно оставить по 9 блоков как тут чтобы заведомо хватило при любых пропорциях, и дальше играйся с -ts.

При распределении весов по девайсам ts с ngl вступают первыми, распределяя веса блоков по двум кудам, далее обрабатываются -ot и парсятся с конца. Получается что линейные слои выкидываются на цп, далее отмечаются те, которые будут на каждой карточке. Меняя соотношения в -ts ты будешь менять только атеншн, нормы и прочее, а линейные слои будут постоянно одни и те же.

> в моем случае паскаль нормально считает аттеншен

Ну как нормально, сносно. Получился ровно тот же пп а не ускорение потому что произошла компенсация эффектов. Выкинув сразу много блоков с цп на гпу при обработке больше не требуется стримить их на основную для процессинга, что является болнеком. Если бы считало хорошо - получил бы ощутимый буст процессинга. Если атеншн с нее выкинешь на основную - получишь ускорение и процессинга и генерации. Если какие-нибудь приколы опять не возникнут.

> > -ot "blk.[1-9]\.ffn_._exps\.=CUDA0;blk.2[1-9]\.ffn_._exps\.=CUDA1;blk.ffn_._exps=CPU"

Кто там заявлял что звездочки в цитате работают?

-ot "blk.[1-9]\.ffn_.😭_exps\.=CUDA0;blk.1[0-5]\.ffn_.😭_exps\.=CUDA0;blk.2[0-9]\.ffn_.😭_exps\.=CUDA1;blk.3[0-5]\.ffn_.😭_exps\.=CUDA1;blk.😭ffn_.😭_exps=CPU"

возможно где-то ошибка там ибо сделал на лету, поправишь если что, суть главное понятна.

Анон, в ИИ не шарю.

Я интереса ради попробовал juicychat.ai и вроде прикольно. Но токенов мало. Подумывал было купить, что бы месяц побаловаться, но увидел ценник и начал сомневаться. Особенно с учётом того, что тамошними правилами Куроки Томочку запилить нельзя.

Отсюда вопрос, на домашнем ПК реально поднять аналогичную систему чисто для себя, без всратых ограничений? Комп у меня вроде хороший. 4090, 7800X3D, 64 ОЗУ.

Я интереса ради попробовал juicychat.ai и вроде прикольно. Но токенов мало. Подумывал было купить, что бы месяц побаловаться, но увидел ценник и начал сомневаться. Особенно с учётом того, что тамошними правилами Куроки Томочку запилить нельзя.

Отсюда вопрос, на домашнем ПК реально поднять аналогичную систему чисто для себя, без всратых ограничений? Комп у меня вроде хороший. 4090, 7800X3D, 64 ОЗУ.

реально

>Отсюда вопрос, на домашнем ПК реально поднять аналогичную систему чисто для себя, без всратых ограничений?

Вполне.

>Комп у меня вроде хороший. 4090, 7800X3D, 64 ОЗУ

А если до 128 (или хотя бы 96) ОЗУ добить - будет отличный. Это уже заявка на топовые MoE модели. На 64 - средние.

> на домашнем ПК реально поднять аналогичную систему

> 4090, 7800X3D, 64 ОЗУ.

На твоем железе можно развернуть что-то, что, скорее всего, будет гораздо лучше. https://huggingface.co/zai-org/GLM-4.5-Air

Q4 с 20-30к контекста должен уместиться. llamacpp/Кобольд и Таверна. Придется повозиться, разобраться со всем этим, настроить, но если тебе это правда интересно - того стоит.

Проц чуть слабоват (у самого такой же кейс) ищи 64х2 плашки пока совсем из продажи не пропали. Потом апнешь проц на зен6, а пока просто МОЕ будут медленнее работать.

Спасибо, анон.

А что по ограничениям? Я готов попробовать в это всё ввязываться только при наличии возможности запилить Томочку. В противном случае мне будет проще оплатить джуйси чат. А может быть есть аналоги без этих ограничений?

> что по ограничениям

The sky is the limit. Ну или ты сам, потребуется разобраться в запуске и в работе. Если ты не совсем хлебушек - это несложно, требования ко вкату низкие, требования к более глубокому освоению средне-высокие. По экспириенсу будет гораздо лучше чем джусичат.

> А что по ограничениям?

С этой моделью - скорость у тебя будет 6-7т/с, контекстное окно 20-30 тысяч токенов.

> Я готов попробовать в это всё ввязываться только при наличии возможности запилить Томочку

Что угодно можно сделать, запромптить можно любого персонажа и любой сценарий. Разве не очевидно?

> А может быть есть аналоги без этих ограничений?

Не знаю, про какие ограничения речь и что ты имеешь ввиду. Можешь или локально у себя все запускать, или платить за какой-нибудь сервис (апи). Они существуют без ограничений, да, но с этим в соседний тред. Здесь все про локальный запуск.

Пожалуйста, посоветуйте хороший рп тюн геммы без ассистента, вроде синтвейва. Кум не в приоритете, но имеет место быть.

Есть какой-то способ эту модель перестать выдавать странные тэги типа: А Анон, П Жопа, Ням Сися невпопад?

> хороший рп тюн геммы

Не существует, увы. Сколь-нибудь жизнеспособны только Synthia и Synthwave соответственно.

> Есть какой-то способ эту модель перестать выдавать странные тэги

Не понимаю, про что ты говоришь. Формулируй вопросы четче, прикладывай скриншоты и подробности, медиумов здесь нет (ушли в отпуск на неопределенный срок).

>Что угодно можно сделать, запромптить можно любого персонажа и любой сценарий. Разве не очевидно?

Не очевидно. Я с ИИ знаком только по этому сайту, а там ограничение. Плюс в шапке какие то кошмары цензуры присутствуют. Отсюда и вывод.

>скорость у тебя будет 6-7т/с, контекстное окно 20-30 тысяч токенов.

К сожалению это пока для меня звучит как белый шум.

>Не существует, увы.

То есть из огромного количевства людей которые занимаются тюнами, осилили только два человека? Пиздец какой то.

> Не очевидно. Я с ИИ знаком только по этому сайту, а там ограничение.

Тогда тебе следует повозиться с этим на своем компьютере хотя бы для того, чтобы понять, что и как работает. Это в любом случае будет полезно, даже если позже решишь перейти на апи (веб сервис).

> Плюс в шапке какие то кошмары цензуры присутствуют.

У многих веб сервисов такое, по разным причинам от моделей, что они используют, до законодательства. Есть всякие OpenRouter и прочие, которые не имеют подобных ограничений. Но опять же, с этим в другой тред, здесь про локальный запуск.

> К сожалению это пока для меня звучит как белый шум.

Если вкратце - ты использовал бесплатную версию (которая по определению только скудна, там в лучшем случае 8б модель, на твоем железе можно запускать модели кратно больше) веб сервиса (в котором присутствуют цензура и прочие искусственные ограничители вроде длины контекста). Ты уже прямо сейчас на своем компьютере можно запустить что-то, что гораздо лучше. Если поймешь, что тебе и этого мало, тогда уже можешь попробовать купить нормальный апи у проверенных провайдеров, я бы на твоем месте попробовал так. Если ты уверенный пользователь и умеешь работать с терминалом, гугли-разбирайся с llamacpp. Если ты хлебушек, разбирайся с KoboldCPP. Затем в любом случае ставь Таверну (SillyTavern) и дружи это все. Будут трудности - приходи сюда, но постарайся хорошо сформулировать вопрос(ы) и поделиться подробностями. К сожалению, готового решения, где ты нажмешь одну кнопку, и все будет работать, не существует. Только с веб сервисами (апи), но с этим в другой тред. Здесь же будут рады помочь с локальным запуском. Это два больших лагеря со своими плюсами и минусами. С апи ты не зависишь от своего железа, но зависишь от веб провайдера, а запуская локально ты ни от кого не зависишь, но ограничен своим ресурсом.

> осилили только два человека?

На самом деле один, потому что Synthwave - это мердж, а не тюн. Да и при всем уважении к Синтии, я ей так и не смог проникнуться. Как, впрочем, и ванильной Геммой, не моя модель.

> из огромного количевства людей которые занимаются тюнами

Единицы что уже что-то шарят но еще занимаются средним оперсорсом, не открыв свой стартап или не став частью других корпораций - осилили. Слоподелы, пик которых - вжаривание мистрали слопом и составление кринжовых карточек моделей, закономерно соснули.

Не существует никакого "огромного количества", то изобилие что было во времена второй лламы сейчас превратилось в изобилие базовых моделей. Именно полноценных тюнов общего назначения или с фокусировкой на рп делается достаточно мало, команды можно по пальцам пересчитать. Остальное - инцест, шизомерджи и прочая сомнительная продукция.

>Для диагностики попробуй

Ох, это уже реально впадлу, да и зачем. В своих реальных сетапах я пробовал выгружать аттеншен только с тесел на основную - ну получил легкий посос и в обработке, и в генерации по сравнению с обычной выгрузкой. Единственное, что мне бы помогло, судя по всему - это миграция на новую платформу с DDR5 и хорошим камнем, да слотов-линий побольше. Ну или парочка rtx 6000 pro. На авито за 750к видел. Согласен на безвозмездный подарок :3

>Ну как нормально, сносно

Ну типо не просадило обработку, да еще и плюс на генерацию, крута же, живем! Тот же эффект, к слову, и на конфигах вроде большого глм, только там еще и обработка вырастает.

uoooooohhh

Вот у тебя есть персонаж базовый в таверне, зовут Seraphina.

Когда бот будет писать, она будет периодически начинать предложения с Ser Seraphina и прочую таку странную комбинацию, как это лечить?

> будет периодически начинать предложения с Ser Seraphina и прочую таку странную комбинацию, как это лечить?

Не знаю. Пока не принесешь подробности того, как ты запускаешь, какая у тебя разметка, какие сэмплеры - не ясно. Так быть не должно, ты где-то накосячил.

Т.е. у тебя эта моделька никакой странной разметки не пыталась никогда выплевывать? Потому что она это делает с разными карточками, семплерами и темплейтами. И даже файнтюны васянские ее это делают.

> Т.е. у тебя эта моделька никакой странной разметки не пыталась никогда выплевывать?

Мы говорим про Air? Если так, то нет, ни разу такого не было. С разными карточками, в разных чатах, разными сэмплерами и темплейтами. Позади не меньше 200к токенов, думаю.

Ты, кажется, первый кто о таком пишет. Думой.

Че мне думать, она даже с пустыми карточками это делает.

В таком случае предположу, что я и все те, кто катают Air, сошли с ума или не заметили. Вероятность, в целом, не нулевая, нельзя отвергать эту версию.

Полный промпт проверь. Не удивлюсь, если какой-нибудь лорбук забыл отключить.

Я в консоли полный промпт вижу, зачем мне по этим вкладкам лазить...

Ты хороший, анон, спасибо тебе.

Я вернусь когда у меня появятся вопросы.

Хорошо, можете тогда посоветовать хороший рп тюн мистраля 24b? Те что в шапке сломанны, а оригинал ведёт себя как то по ебанутому, при том что я пихал в него промпт тредовичка.

>промпт

Пресет.

фикс

Это наша нюня! Имя такое. Только свистни и он появится. Любим и ненавидим всем тредом

> хороший рп тюн мистраля 24b?

Не могу, увы, потому что с Мистралями давно не имею дела. Последнее, что пробовал - инструкт 3.2. Мне показалось, что он гораздо лучше 3.1 и предыдущих 24б версий. Не знаю, что ты имеешь ввиду про ебанутое поведение, ибо не слишком много токенов наиграл с ним. Читал хорошие вещи про https://huggingface.co/zerofata/MS3.2-PaintedFantasy-v2-24B и https://huggingface.co/CrucibleLab/M3.2-24B-Loki-V1.3, но не могу за них ручаться.

> Те что в шапке сломанны

Все-все? Уверен, что проблема не на твоей стороне?

>готового решения, где ты нажмешь одну кнопку, и все будет работать, не существует.

Ой да ладно. Он свою конфигурацию плюс минус назвал. Местные так долго дрочат кобальт и ламу что уже могут закрытыми глазами ему список файлов для скачивания написать и батник для запуска.

> Ой да ладно ...

Модель под его конфиг ему прислал, отправную точку объяснил, рад буду ответить на последующие вопросы. Верю, что нужно учить рыбачить, а не давать рыбу, но тебе никто не мешает принести ему на блюдечке все готовое. Нечего пенять на остальных.

Но в любом случае карточку ему, похоже, придется писать самому.

Не поленись при случае, нужно понять почему так происходит. А платформу разумеется есть смысл апгрейдить, особенно если много видеокарт.

> Ну типо не просадило обработку

Так можно сделать лучше же, и ген поднимется и обработка еще быстрее будет. Или хотябы найти какой-то фактор, который мешает чтобы знать о нем.

А ты анслотовские кванты брал или обычные?

А сколько место нужно на диске? Нужен ли ССД? Нужен ли м.2?

Кто-нибудь пробовал Apriel-1.5-15b-Thinker? Как для РП, так и для бытовых задач или кода. Довольно высоко поставили в рейтинге artificialanalysis, интересно мнение кто использовал.

Обычные, но не думаю, что это важно.

Во время инференса (запуска/развертывания) модели, она загружается в оперативную и видеопамять и находится там. Скорость ссд/жд не важна.

> Apriel-1.5-15b-Thinker? Как для РП, так и для бытовых задач или кода

Пробовал для кода. В моих юзкейсах показал себя на уровне Qwen2.5-Coder 32b. С другими, более новыми моделями, не сравнивал.

https://github.com/ikawrakow/ik_llama.cpp

> ik_llama.cpp: llama.cpp fork with better CPU performance

> This repository is a fork of llama.cpp with better CPU and hybrid GPU/CPU performance, new SOTA quantization types, first-class Bitnet support, better DeepSeek performance via MLA, FlashMLA, fused MoE operations and tensor overrides for hybrid GPU/CPU inference, row-interleaved quant packing, etc.

exllama

Эта картинка актуальна вообще для всех моделей? Качать что-то выше Q4_K_XL не имеет смысла?

> Эта картинка актуальна вообще для всех моделей?

Нет. Для начала нужно понять, что изображает график.

> Качать что-то выше Q4_K_XL не имеет смысла?

Имеет в определенных случаях. Не имеет тоже в определенных случаях. Q4 - золотой стандарт, ниже которого лучше не брать, если есть возможность.

И так. поставил кобольду. Скормил ггуфку.

Скачал силлитаверн. подключился к кобольду.

он пишет мне:

KoboldCpp works better when you select the Text Completion API and then KoboldCpp as a type!

это что?

Так же, на первом запуске таверны было окно с импортом всякого. Я смог подгрузить Томочку. А как опять в это окно с импортом персонажей попасть?

ЕЩе вопрос, есть места где миры уже готовые брать?

Скачал силлитаверн. подключился к кобольду.

он пишет мне:

KoboldCpp works better when you select the Text Completion API and then KoboldCpp as a type!

это что?

Так же, на первом запуске таверны было окно с импортом всякого. Я смог подгрузить Томочку. А как опять в это окно с импортом персонажей попасть?

ЕЩе вопрос, есть места где миры уже готовые брать?

Вопрос по импорту и лорбуку снят. Нашёл нужную кнопку.

Вопрос по KoboldCpp works better блаблабла всё еще открыт.

Можно ли, используя локальную LLM, обучить её знаниям о моём сервисе таким образом, чтобы она могла анализировать добавление новых функций на основе уже существующей базы знаний?

Пример:Допустим, у меня есть база данных с таблицей users, в которой есть поле position_code. Это поле может содержать значение NULL. Я передаю эти данные модели, она их изучает и запоминает.Затем я хочу добавить новый HTTP метод в сервис, который возвращает пользователей (users), и поле position_code я делаю обязательным. Проанализировав это изменение, LLM сообщит мне, что возникла проблема, поскольку ранее поле могло быть пустым (NULL).

Возможно ли такое? В какую сторону нужно смотреть?

Пример:Допустим, у меня есть база данных с таблицей users, в которой есть поле position_code. Это поле может содержать значение NULL. Я передаю эти данные модели, она их изучает и запоминает.Затем я хочу добавить новый HTTP метод в сервис, который возвращает пользователей (users), и поле position_code я делаю обязательным. Проанализировав это изменение, LLM сообщит мне, что возникла проблема, поскольку ранее поле могло быть пустым (NULL).

Возможно ли такое? В какую сторону нужно смотреть?

Вроде как победа.

Я скачал какой то мир, всё работает. Персонаж тоже.

Но ответы какие то сухие и односложные, по сравнению с juicychat, где тебе и мысли и действия и всё подряд. Как можно это исправить? Примеры ответов с джусичата к которым хотелось бы стремиться на скринах.

> KoboldCpp works better when you select the Text Completion API and then KoboldCpp as a type!

Имеется ввиду, что Кобольд предлагает использовать тебе KoboldCPP API Type. Апи Кобольда может работать как в таком режиме, так и Generic (OpenAI-compatible). Кобольд не использую, в чем разница - не знаю, не использую Кобольда, но думаю, что это незначительно. Text Completion или Chat Completion - тоже разновидности апи, тебе для начала нужно выбрать Text Completion. Будет проще преодолеть цензуру и разобраться на базовом уровне.

> Вроде как победа.

Подозреваю, ты еще не до конца оптимизировал настройки запуска в Кобольде, и можно получить бОльшую скорость генерации. Какая у тебя сейчас? Можно посмотреть в Таверне, можно в логах. Используешь Air Q4?

> Я скачал какой то мир

Это необязательно. Вся работа с моделью выглядит как запрос-ответ. Таверна - менеджер для составления запросов (промпта). Лорбуки/WorldInfo/миры - часть запроса. Это не магия, которая сделает все ответы лучше и продуманнее.

> где тебе и мысли и действия и всё подряд. Как можно это исправить?

Запромптить. Например, в системном промпте подавать такую инструкцию или показав, как нужно делать, примерами диалогов в карточке.

> Примеры ответов с джусичата к которым хотелось бы стремиться на скринах.

На первом скрине ужас. Со временем поймешь. На второй картинке что-то вменяемое, Air так может из коробки (в случае правильных настроек), за исключением [вот этого блока], как делается - описал выше. Еще вариант - воспользоваться плагином www.github.com/kaldigo/SillyTavern-Tracker

> В какую сторону нужно смотреть?

В сторону тестирования кода.

>Пожалуйста, посоветуйте хороший рп тюн геммы без ассистента, вроде синтвейва.

Мне зашел вот этот: https://huggingface.co/mradermacher/Storyteller-gemma3-27B-GGUF

При том что синтия для меня - примитив, который неюзабелен из-за постоянного игнора инструкций, а синтвейв - что-то странно-синтетическое, и тоже без особых плюсов.

Этот тюн, вообще-то больше для писателей, как я понял, но в RP очень даже, как ни странно. Микс, почему-то не очень известный, хотя очень зря. IMHO, разумеется.

Тоже никогда такого не видел от AIR. Слушай, а попробуй квант перекачать, а? По твоим описаниям - это уже становится похоже на битую модель(файл).

Семплеры кривые. В таком случае любая самая распрекрасная модель шизеет.

Какие у тебя настройки кобольда? Какую модель выбрал?

GLM-4-32B-0414 это последняя хорошая 32B для creative writing? Нужно W++ слоп отредактировать.

Неиронично, это по-прежнему лучший формат карточек. По сути, разновидность JED. Главное не наваливать ненужного.

Да, если рассматривать среди 32б, лучше ничего не было.

>Используешь Air Q4?

это ггуф ЖИВ файл? Я скачал тут https://huggingface.co/mradermacher/MS3.2-PaintedFantasy-v2-24B-GGUF/tree/main модель на 25.1 GB MS3.2-PaintedFantasy-v2-24B.Q8_0.gguf

>В сторону тестирования кода.

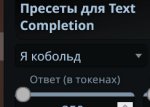

Я использую дефолтные настройки. чуть накрутил токенов. скрины прикладываю.

Самый лучший формат - это json, но можно убрать кавычки и скобочки. Просто идентификатор и переменные. Если нужно приколотить стиль речи, то примеры диалогов в конце.

Любой нативный способ написания будет ебать будущее форматирование текста и его не стоит использовать, тем более, что банально хуже воспринимается нейросеткой.

Кто-то юзал Dynamic Templates? Стоит вообще ебка с ними, или проще хуярить карточку с разными персонажами вручную? Боюсь что с динамическими карточками будет только шиза..

ну и кто из вас пидорасов спалил абу обход капчи?

хуита

теоретически чем больше модель - тем меньше мозгов у неё отрезает квантизация, поэтому на дикпике Q4 почти так же хорош, как Q8.

на мелких моделях ниже Q4 жизни нет, если нужен точный перевод или программирование, то подойдёт только Q8

>Есть какой-то способ эту модель перестать выдавать странные тэги типа: А Анон

Так же любую хуйню если модель выдает лишнюю можно обрубать через stop sequence в таверне, но важно что бы ты правильно указывал то что блокировать, и еще можешь добавить \n перед что бы случайно не обрезались строки полностью.

Но не уверен что это та самая панацея в твоем случае, вроде у тебя просто не до конца настроена таверна/и хз какая вообще модель

Подожди, это ты Томоко-фаг и это твой пресет/модель?

MS3.2-PaintedFantasy-v2-24B это вроде файн-тюн мистральки, а она обучалась на chatML, поставь его, возможно это и была причина твоих непонятных

>А Анон, П Жопа

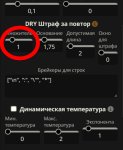

И токенайзер поставь best match и пресет нормальный, Universal-Creative с 1.5 температуры слишком много шизы, попробуй сначала с 0.8 хотя бы а дальше уже крути себе под настроение, TOP 20-40 DRY штрафы за повторы поставь что бы модель не выдавала одну и ту же шизу. Вроде если это ты тот же анон, то тут полный пиздос с шаблоном. Но это все легко изи за пару недель поймешь как фиксить, конечно простоты как на джуси чат не будет(хотя я там не сидел хз, но вроде там кал полный уровня 8b просто зафайнтюненный на еблю и фетиши, но в остальном у тебя может быть куда богаче РП чем там, ну и еще и контекст/суммарайз всегда под твоим контролем, ну и придется реально самому подстраивать все под свои нужды, т.е это не так как в джуси чате где если ты пишешь ХОЧУ долгое красивое РП или хочу СИСИК ПИСИК и модель автоматически под себя подстраивает промпт. Алсо, если в будущем захуяришь под себя годно карточку с Томочкой, кидай сюда, буду рад заценить.

Они то могут быть все так же умными в логике, но факты искажаются, а это критично для чего либо серьёзного кроме рп.

> тем меньше мозгов у неё отрезает квантизация

Нет, влияние такое же. И там нет "отрезания мозгов", скорее дестабилизация, искажение фактов как подметил. Просто большая модель изначально стабильнее и даже ужатая на первый взгляд сохранит адекватность. Но если отмасштабировать критерии и объем - точно также фейлит тупя и лупясь там, где более живой квант без проблем сработает.

> если нужен точный перевод

Одна из простейших задач где не нужен высокий квант вообще. Проблема может возникнуть только на совсем лоботомитах + непопулярный язык в датасете. Тому же дипсику даже tq1 не мешает идеально шпрехать на русском, а некоторые другие и в 16битах делают ошибки.

> или программирование

Здесь квант выше будет полезен чтобы меньше теряло исходную нить и держало контекст. Утверждения типа

> только Q8

лишены смысла, потому что основным источником ошибок будет собственный тупняк сетки и рандом, q5-q6 не будут проигрывать. Это все касается агентов, если же просто "кодить в чатике" обсуждая - там и q4 хватит.

> > если нужен точный перевод

> Одна из простейших задач где не нужен высокий квант вообще

то-то низшие кванты внезапно на китайский переходят или "ебал её рука"

>это ггуф ЖИВ файл?

Ari, он же воздушный он же GLM 4.5 Air- безусловная любимица треда и спасение для нищуганов в РП.

Очень неоднозначная и капризная модель. Те проблемы которые у тебя с ней возникают, являются хорошим маркером того, насколько ты вообще постиг промтинг.

Этой модели может не понравиться твой формат карточек и иона будет капризничать, ей может не понравиться твой промт. Её кванты от разных людей - выдают разные результаты.

Но и тысячу раз но. Если ты освоишь, то ничего лучше в её размерах не существует. Я был мистралелюбом, но на 16+64, после двух недель пердолинга, освоил некотоыре навыки как с ней работать и не могу нарадоваться.

Это капризная, местами кривая, любящая навалить слоп - но это гемини дома. Deal wit it.

>то-то низшие кванты внезапно на китайский переходят или "ебал её рука"

Да, ну это причина не перевода, ЛЛМ-ки, по крайне мере локальные не переводят, они выдают токены, потому на качественный русик от мелко моделей не ожидают. А вот перевод, сам перевод это настолько простая минорная задача для LLM что на чистейшего литературного руссика хватает 1b-4b модели.

>Подожди, это ты Томоко-фаг и это твой пресет/модель?

Я тут, но не моё сообщение.

Я кстати понял в чем дело. Я начал новый чат и там уже больше деталей стало. Но хотелось бы более лучшего экспериенса.

>TOP 20-40

пик 1. так?

>DRY штрафы за повторы поставь

пик 2. изменил ноль на единичку.

Спасибо, что помогаешь. Как запилю Томочку - я обязательно поделюсь. Я тут потихоньку добавляю деталей в карточку ее персонажа. Копипащу факты с вики.

Я пробовал искать ггуф этого айра, но не смог найти. Анон в треде кинул ссылку на PaintedFantasy и там я смог найти ггуф файл. Поэтому взял его.

> Я пробовал искать ггуф этого айра, но не смог найти. Анон в треде кинул ссылку на PaintedFantasy и там я смог найти ггуф файл. Поэтому взял его.

Блджад, анон, не могу дать нейтральный пресет, так как сети нет второй день. Поищи по тредам, там давали ссылки на его семплеры и были жоровские батники. Семплеры стандартные, настройки chatml.

Как связь появится скину, а то местные тредовички трясутся за обычные настройки, словно это их грааль.

>нейтральный пресет... ссылки на его семплеры

Ссылки на семплеры. Хорошо. Я поищу.

>были жоровские батники

Жора? Кто такой Жора?

Это проблема того, что выбранная тобой модель в принципе не знает нормально русский. Между французским-немецким-китайским даже там все вполне неплохо, разумеется это по словам самих носителей.

Если не нравится пример дипсика ввиду его жирности, подойдет квен 30а3, даже без специализации на русский в 4 кванте хорошо пишет и переводит.

> спасение для нищуганов в РП

Сейчас налетят нищуганы и заявит что тру жизнь на 8-12б, а с 16гигами ты мажор ебаный.

Не аварь.

> Ссылки на семплеры. Хорошо. Я поищу.

Ищи по GLM и Air

> Жора? Кто такой Жора?

llama.ccp, Жора от Георгия, автора.

В шапке есть ссылки. Для запуска нужно создать батник и прописать в него команды запуска. Вот эти огромные полотна в предыдущем треде это все из этой оперы, аноны тензоры раскидывают, но это уже тонкая настройка. Примеры батников тоже скидывали в пролом позапрошлом треде точно был. Там что то в духе:

-lama -b blah blah

-t 13^

-n -cpu -moe 42 и прочее.

>Я пробовал искать ггуф этого айра

Он кидал МоЕ модель, там нужно качать все файлы. МоЕ-шки разбиты на дохуя файлов(экспертов, те хуйни которые мозги моделей) чисто выгрузив в видеокарту одним .gguf файлом как плотную дэнс модель тут не получится, да и не нужно, и вот эти вот эксперты ты спокойно можешь выгружать в RAM, а контекст например в vram, и таким образом запускать то что ты хуй запустишь на одной 24 гиговой карте. В твоем случае пока просто балуйся как получается, и все понимание само придет со временем. Алсо, Аир из локалок правда база треда, конечно далеко не близок к корпосеткам, но в РП он будет в дохуя раз лучше того файнтюна мистрали что у тебя. Так что дерзай, познавай как запускать МоЕ-шки, сам бы гонял на нем если бы не поскупился на материнке и озу, так что ты в этом треде с твоим конфигом уже сразу определяешься в аристократию.

>Но хотелось бы более лучшего экспериенса.

Ну это скорее реально лучше сразу АИР запускать, 24b мистралька это норм модель, но.. средняя так сказать, мистралька конечно умничка, спору нет.

>Жора

Жора = llama.cpp

А не проще ли МоЕ-шки сейчас через кобольда гонять? Там же прикрутили нормально запуск МоЕ что бы без ебли с терминалом и батником?

>Неиронично, это по-прежнему лучший формат карточек. По сути, разновидность JED.

Только AIR им не кормите - тупеет и лупится с таблицами и ассистентом.

>Самый лучший формат - это json, но можно убрать кавычки и скобочки

Был когда-то. Сейчас даже всеядный мистраль с ним может начать чудить.

>тем более, что банально хуже воспринимается нейросеткой.

Все сетки которые я щупал начиная от gemma3-27B и более поздние - лучше всего воспринимают plain text для описания персонажа, с минимальной структурой. Если начать скармливать форматы - то ассистент лезет, то таблицы на выходе, то одни детали проёбываются в пользу других.

Они слишком надрочены на списки и прочее IMHO - упарываются в структуру и теряя все остальное попутно, а заодно отвечать начинают в стиле помощника при этом. Хуже всего с этим у Осы, мистраль самый устойчивый, но и он дуреет если перестараться.

Если не хочется лазить в командную строку - проще. Но тут его хейтят по старой привычке.

А ну тогда збс, потому что ЕБАТЬ Я КОБОЛЬД.

>Но тут его хейтят по старой привычке.

Да, ведь просадка по скорости на ~10-15% никуда не делась. Для новичков норм, а если тебе нужен максимум то нет.

Возможно и проще. Но по неведомым причинам, на жопе я получаю из ниоткуда 3-4 т/с бонусом. А это весомый аргумент.

10% от 5-7 токенов это сколько будет?

таверну и прочий кал юзают те, кто не осилил кобольд

Ебать ты кобольд..

Если хочешь действительно набросить, нужно славить олламу.

>комплексы тавернодетей

почему ты выбрал линукс вместо винды?

ну типа я особенный, чувствую себя избранным меньшинством, могу в консольке сидеть, я там настоящий админ бох всея системы мам скажи им

почему ты выбрал что-то кроме кобольда?

чел, ну пердолики мы ради пердоленья, отстань

ну типа я особенный, чувствую себя избранным меньшинством, могу в консольке сидеть, я там настоящий админ бох всея системы мам скажи им

почему ты выбрал что-то кроме кобольда?

чел, ну пердолики мы ради пердоленья, отстань

Ну дык проще - не значит что еще и быстрее. 10-15% в минусе, зато сразу работает, и понятнее для тех, у кого от командной строки shivers on the spine.

:)

Никто не пишет, что кобольд говно. Ты говно, не кобольд. Прекращай набрасывать и провоцировать нелюбовь к выбранному тобой инструменту. Хотя первый пост смешной.

Дык спору нет. Я никогда слова плохому к кобальту не скажу. Эта умница показа мне что такое слои, позволила

понять как уменьшение и увеличение влияет. Что такое батчи, какие есть доп команды. Просто я уже вырос и пошел дальше, но кобальту все равно большое пасебо.

>почему ты выбрал линукс вместо винды?

Потому, что задрала решать за меня - что и как мне в системе нужно. А он просто работает, и ничего сам за меня не делает.

>почему ты выбрал что-то кроме кобольда?

А у меня кобольд - мне лень собирать голую ламу ради 10-15% после каждого апдейта. (Нету готового бинарника под nvidia здесь).

Так не структурируй. Просто

{{char}}'s appearance: trait1, trait2, trait3

{{char}}'s personality: trait1, trait2, trait3

Я еще кавычки ставлю, чтобы модельки понимала, что это отдельные объекты. Проблем не встречал, честно. Там нет структуры, которую бы моделька могла повторить для чего-то, что я ей говорю делать. А вот текст содержит в себе стиль, который влияет на ее выдачи. И текст это не набор парамтров, ты не всегда можешь сказать, на что там обратит внимание нейросетка в этом предложении, а что проигнорирует.

Бля, и правда пахнет...

Ну а зачем ты cum брал в рот?!

Я не гей, но эпл это эпл...

>Так не структурируй. Просто

Мистралю будет норм, а Air даже таким может подавиться.

>А вот текст содержит в себе стиль, который влияет на ее выдачи

Разумеется. Чем и ценен. Позволяет задать нужную начальную атмосферу прямо в самом описании персонажа, чем экономит место и время, и хорошо дает начальный пинок для RP именно в желаемом направлении.

>И текст это не набор парамтров, ты не всегда можешь сказать, на что там обратит внимание нейросетка в этом предложении, а что проигнорирует.

Ну, у меня с этим проблем нет, для меня поведение модели на конкретном тексте в описаниях персонажа предсказуемо этак на 90%, что позволяет легче получить желаемый характер и поведение.

Вот со списками и форматами, как раз, такая проблема проявляется. Но не настаиваю, что мой подход единственно верный - просто именно для меня он работает куда лучше.

>Чем и ценен

Он не ценен, он сделает все рп одинаковыми, потому что тон рп задан карточкой персонажа, а не сценарием. Карточка персонажа не должна иметь ничего, помимо описания персонажа.

>Позволяет задать нужную начальную атмосферу

Ты можешь это сделать несколькими тегами, которые просто опишут примерный гоал через теги контента. Наляпывать лингвистическими петтернами нейросеть не нужно, не все нейросетки мистраль, который срет одним и тем же слопом, независимо от промпта. Тон происходящего задается в процессе повествования через RHLF.

> Карточка персонажа не должна иметь ничего, помимо описания персонажа.

Вот тут не соглашусь. Куда предлагаешь пидорить описания мира, персонажей и особенности. В сценарий? В лорбук?

Если просто тегать у тебя будет максимально слопный персонаж.

В 5090 есть поддержка FP4, как мне сконвертировать в NVFP4 допустим Cydonia-24B?

Нет смысла, оно не будет быстрее int4. И fp4 кванты обычно хуже int4 по качеству. У Жоры есть поддержка fp4, но оно медленнее q4. В TransformerEngine вообще печально всё со скоростью fp4 если без больших батчей.

тащемта уже нашёл, надо просто взять базовую модель и там

```

# 1) Контейнер с TRT-LLM (версию подмени на актуальную)

docker run --gpus all -it --rm -v $PWD:/ws nvcr.io/nvidia/tensorrt-llm:25.09-py3 bash

# 2) Установка Model Optimizer (ModelOpt)

pip install --extra-index-url https://pypi.nvidia.com modelopt[torch] tensorrt-llm

# 3) Клонируем примеры PTQ

git clone https://github.com/NVIDIA/TensorRT-Model-Optimizer /opt/modelopt

cd /opt/modelopt/examples/llm_ptq

# 4) Калибровка и квантование в NVFP4 (весов и KV-кэша)

# calib.txt — 128-512 реплик типичного для тебя текста (достаточно для PTQ)

python hf_ptq.py \

--pyt_ckpt_path mistralai/Mistral-Small-3.1-24B-Base-2503 \

--export_path /ws/mistral24b-nvfp4 \

--export_fmt tllm \

--qformat nvfp4 \

--kv_cache_qformat nvfp4 \

--calib_data /ws/calib.txt \

--calib_size 512 \

--trust_remote_code

# 5) Построить TRT-LLM engine

trtllm-build \

--checkpoint_dir /ws/mistral24b-nvfp4 \

--output_dir /ws/engine-mistral24b-nvfp4 \

--max_batch_size 1 --max_input_len 4096 --max_seq_len 8192

# 6) Запуск LLM API или бенча

trtllm-serve /ws/engine-mistral24b-nvfp4 \

--tokenizer mistralai/Mistral-Small-3.1-24B-Base-2503

# (опционально) замерь T/s

trtllm-bench --engine_dir /ws/engine-mistral24b-nvfp4 --input_output_len 1024,128

```

а есть где-то тесты именно `NVFP4` vs `int4` / `gguf q4_k_m` ?

Решил чекнуть по пунктам, фактчек:

> Нет смысла, оно не будет быстрее int4.

Наверное из-за этого, int4 сейчас сломан https://github.com/NVIDIA/TensorRT-LLM/issues/2487

> fp4 кванты обычно хуже int4 по качеству.

тут от реализации зависит думаю, объективно они показывали разницу на генерации картинок: https://developer.nvidia.com/blog/nvidia-tensorrt-unlocks-fp4-image-generation-for-nvidia-blackwell-geforce-rtx-50-series-gpus/

я думаю в ином ключе: если можно сконвертить в NVFP4 модели на 40-50B (20-25GB), то по-идее качество генерации общее должно повыситься. Надо будет сравнить int4 и NVFP4, но хз как это на тексте сделать.

> У Жоры есть поддержка fp4, но оно медленнее q4.

Имеется в виду Groq? У них же свои железки, не NVIDIA?

Тезисно:

- TensorRT-LLM с NVFP4

- Спекулятивное декодирование (хз есть ли модели тут для этого)

- Надо мерить prefill (вся суть nvfp4) / decode (тут мб медленнее)

Я сравнил седня GLM-Air от ddh0 v1 против v2.

ИМХО, в русском первая версия с imatrix от bartowski лучше, чем его новая версия с его матрицами важности.

Так что, если мне не показалось, можно новые кванты не качать, ориг пизже, спасибо бартовски опять, выходит.

ИМХО, в русском первая версия с imatrix от bartowski лучше, чем его новая версия с его матрицами важности.

Так что, если мне не показалось, можно новые кванты не качать, ориг пизже, спасибо бартовски опять, выходит.

У меня тоже кванты Бартовски лучше всего работают. А анслот вообще говно.

И это тоже.

Как не крути, но при всех фишках других квантизаторов, у него лучшие кванты выходят на данный момент.

По какой причине падает скорость во время ответа некоторых LLM? Начинает на 10-12 t/s и падает вплоть до 5-6 t/s к 1000 токенам.

К примеру, gpt-oss:20b, 3.2GB VRAM свободно в процессе работы, начинает с 65 t/s и заканчивает сообщение (4000+ символов) на плюс-минус такой же скорости.

А вот взять тот же qwen3-coder-27b:Q4_K_XL, 300MB VRAM свободно в процессе работы, в RAM съедает дополнительно 5GB. Начинает на 20 t/s, к 500 токенам уже 17 t/s, к 1000 токенам уже 15 t/s, к 2000 токенам уже 10 t/s.

Проблема, я так понимаю, из-за того что часть модели находится внутри RAM? Сделать с этим что-то можно? Помимо скачивания более сильного кванта или модели с меньшим кол-вом параметров.

К примеру, gpt-oss:20b, 3.2GB VRAM свободно в процессе работы, начинает с 65 t/s и заканчивает сообщение (4000+ символов) на плюс-минус такой же скорости.

А вот взять тот же qwen3-coder-27b:Q4_K_XL, 300MB VRAM свободно в процессе работы, в RAM съедает дополнительно 5GB. Начинает на 20 t/s, к 500 токенам уже 17 t/s, к 1000 токенам уже 15 t/s, к 2000 токенам уже 10 t/s.

Проблема, я так понимаю, из-за того что часть модели находится внутри RAM? Сделать с этим что-то можно? Помимо скачивания более сильного кванта или модели с меньшим кол-вом параметров.

Я тут пару дней на iq4 от ddh0 посидел - до того сидел на iq4xs от Бартовски. Сначала казалось, что квант от ddh0 заметно лучше, и возможно это действительно так "в целом", но вот в ERP - он имеет тенденцию хватать и выделять не те моменты, которые бы хотелось. Это не проёб каких-то серьезных вещей и даже деталей, но... Вот пример:

Идет описание прогулки с тян, в промпте указано что это хентайный слайсик. Квант от бартовски - уделяет основное внимание тому как она двигается, флиртует, "чего и как качнулось" и т.д. Окружению - где-то треть или четверть объема ответа, фокус явно на тян.

Квант от ddh0 - рассказывает как вы ходите, куда пришли, как тян отреагировала, но при этом - без особого акцента на что-то. "Ну да - вы идете с тян, у нее есть грудь, она может колыхаться. Вы по улице идете, она с тобой флиртует, у нее грудь качнулась, птичка пролетела, она тебе подмигнула, машина проехала". И т.д. и т.п. Язык не бедный, детали точные и подробные... но без окраски и концентрации, которой от подобного сеттинга ждешь. На первый взгляд не очень заметно, но если поиграть подольше - разница видна явная, как минимум на такой тематике. Но при этом непосредственно порнуху пишет нормально - с самим экшеном никаких проблем нет. :)

У меня на квантах ddh0 тупо едет форматирование и появляются опечатки в словах лол. Настройки все те же. Бартовски наш слоняра, ни разу не подвёл ещё.

KV-кэш занимает место в VRAM

Можно его квантовать, но это типа делает контекст хуже, представь шо твою историю чата начали блюрить, и чем меньше кванты тем меньше понятно чё там было

можно делать:

- обрезать контекст если вырос больше Х токенов

- купить/скачать VRAM

- скачать модель поменьше

- скачать кванты поменьше

А такой вопрос. Размер контекста влияет на текущее сообщение LLM если оно больше контекста?

1. К примеру, я выставляю размер контекста 1024 токена, чтобы вся модель находилась полностью внутри VRAM.

2. Задаю вопрос, к примеру, который занимает 100 токенов.

3. У LLM остается 900 токенов на ответ. А её ответ должен будет занимать к примеру 1500 токенов. Это как-то повлияет на её ответ на когда она достигнет 900 токенов и привысит лимит указанного контекста? На 901 токене она внезапно потеряется и начнет выдавать бред?

Просто в целом, мне qwen3-coder нужен как вопрос-ответ, контекст предыдущих сообщений мне не очень нужен на данном этапе, просто хочется задать вопрос и получить качественный ответ, а с текущим контекстом ответ на 2к токенов занимает доовльно приличное кол-во времени и я готов пожертвовать контекстом если на текущее сообщение он никак не повлияет.

Подскажите.

Юзаю GLM-4.5-Air лламу и таверну. Генерирует все корректно но почему-то не завершает ответ. Типа останавливается писать но сообщение висит незаконченное и жрет ресурсы впустую, приходится останавливать вручную. Я думаю какой-то токен забанен лишний?

Юзаю GLM-4.5-Air лламу и таверну. Генерирует все корректно но почему-то не завершает ответ. Типа останавливается писать но сообщение висит незаконченное и жрет ресурсы впустую, приходится останавливать вручную. Я думаю какой-то токен забанен лишний?

Все, проверил и получил ответ. LLM стопается когда достигает лимита контекста, поэтому моя идея c маленьким контекстом не сработала. Жаль.

>скачать VRAM

Скинь ссылку.

Какие подводные использовать ллм вместо врачей?

Планирую скачать мед гемму и советоваться с ней вместо совкового говна сидящего в поликлинике

Судя по запрету гопоте медфарма затряслась и способ рабочий

Планирую скачать мед гемму и советоваться с ней вместо совкового говна сидящего в поликлинике

Судя по запрету гопоте медфарма затряслась и способ рабочий

>Какие подводные использовать ллм вместо врачей?

Есть такая классная повесть "Трое в лодке, не считая собаки", и фильм по ней.

Вспомните начало - историю "безнадежно больного человека", который читал медицинский справочник, и находил у себя симптомы всех болезней. LLM прекрасно умеет его косплеить, а вот быть нормальным врачом - не очень. Она практически не умеет говорить "нет, вы здоровы". :)

Залечит нахрен даже здорового, найдет у него кучу симптомов и подберет по ним кучу болезней.

Потому и затряслись, что начались случаи. За неверный диагноз приведший к последствиям, ТАМ хозяев гопоты так в суде вздрючат, что даже им не расплатится будет.

LLM можно использовать как первичного консультанта, но доверять ставить окончательный диагноз - это заявка на премию Дарвина.

Мне ЛЛМка подсказала как сбрасывать вес через трекинг калорий, алсо разбирали мои симптомы по ADHD.

Конечно рецепт на метилфенидат оно не выпишет, но первый шаг я смог сделать в сторону "лучшей версии себя" с помощью вот таких вот простых "консультаций".

Там уже куча стартапов с этой идеей: "дайте пользователю трекать жизненные показатели: ЭКГ, вес, еду, настроение и так далее, а ЛЛМка подскажет шо не так, к какому врачу пойти". Меня месяц назад в такой наняли на полставки в бекенд 🤣

алсо пруф по ADHD

буквально чуть более месяца назад начал принимать

я всю жизнь думал шо это "детская болезнь", пока не начал читать литературу, смотреть ютубы по теме и вот последний штрих это было выкатить все свои жалобы и проблемы

оказалось тупо мои мозги "неправильно" работают, с этой таблеткой ощущаю себя сверхчеловеком и сейчас работаю аж на двух работах

энивей, если понимать что ЛЛМки не идеальны, то как инструмент для поиска по интернетам, аггрегации инфы со всех источников они очень даже; и всегда нужно спрашивать уточнять "а откуда ты взял инфу, а пруфы етц"

с таким подходом вообще по-другому ощущается интернет

Как инструмент, особенно первичной обработки - да, разумеется, это они могут. Как полная замена нормального спеца - нет. В любых местах где от решения зависит здоровье и жизнь - нужна перепроверка человеком.

>Мне ЛЛМка подсказала как сбрасывать вес через трекинг калорий

И это вместо простых уколов раз в неделю...

> не хочется лазить в командную строку

Вместо мгновенного запуска готового батника/шелла, копипастишь в милипиздрическое поле в гуйне регэксп, или делаешь много кликов чтобы загрузить сохраненный шаблон. У-удобно.

Ебать ты кобольд х2

> он рп задан карточкой персонажа, а не сценарием

Сильное заявление.

> не должна иметь ничего, помимо описания персонажа

В большинстве случаев персонаж с особыми абилками/суперсилами/бэкграундом/внешностью, которые привязаны в конкретному сеттингу. Гибкость есть, но условного джедая не поместишь мир Толкиена, а все не-дженерик-люди нуждаются в описании мира чтобы не плодить кринж.

Что за железо? Падение скорости по мере накопления контекста - норма, но у тебя чрезмерно сильное. Что за ось, железо, как запускаешь?

+- норм, ну лучше чем совкового говна, и я бы сказал не сильно хуже корпосеток в этом плане, алсо да и в РП норм медгеммочка... ну соя немного есть, но прям совсем чуть чуть, цензура иногда даже пробивается

Ну хуй знает, я просто ленивое хуйло, а не мозги мои "неправильно работают" этого мне ЛЛМ не скажет, особенно соевая медгемма, алсо оффтоп, но насколько хватает тебе этих таблетосов?

13500 / 4060 ti 16GB / 32GB 6400. W10.

llama.cpp c его дефолтной мордой на локалхосте, аргументы только те что рекомендует сам квен, --ctx-size 32768 --temp 0.7 --top-k 20 --min-p 0.00 --top-p 0.80 --repeat-penalty 1.05

Точное название модели - unsloth_Qwen3-Coder-30B-A3B-Instruct-UD-Q4_K_XL

Пробовал кобольд с дефолтными настройками (показал 37/49 слоев загружено, контекст 8К), по ощущениям быстрее, хотя вместо GPU теперь грузит CPU. Но точную скорость назвать не могу т.к. не могу найти где в кобольде посмотреть t/s.

>показал 37/49 слоев загружено

Ну поставь сколько тебе нужно

>вместо GPU теперь грузит CPU

Ставь потоки проца ровно сколько ядер

>Ставь потоки проца ровно сколько ядер

Ты что Баиден такие злые советы раздавать?

10-12 часов окошко, но оно тебе не пофиксит сломанную дисциплину; я сейчас настроить себе тупо хотя бы календарь и список дел, потому шо в голове всё ещё куча идей, и приоритизировать это невозможно

лично мне помогает не хотеть спать и фокуситься на работе/чём угодно и хоть 8 часов сидеть пахать без усталости

проблема со сном может возникнуть если принимать слишком поздно, я закинулся около 10-11 утра, поработал на первой работе 6 часов, поработал на второй ещё 4, потом взял гитару и до 3 ночи играл тупо и потом пошёл поспал 4 часа и на следующий день 8 часов работа первая + 4 часа вторая и ничего, а без таблеток я бы умер уже от первой работы 2 часа фокусить одну задачу

если так нормальные люди могут работать и нормально себя чувствовать то я всё это время жил в аду в каком-то 🤣 2 часа фокуса и хочется спать остальную часть дня, сбитые режимы сна по КД, прокрастинация 24/7

а началось всё где то в студенческие годы, но было ещё норм -- смог доучиться, работу нашёл, только с 2016-го стало плохеть конкретно, и лучше не становилось

понял шо надо чёт делать когда даже простейшие таски на 10 минут уже не могу даже начать, только если ко мне придёт чел и будет над душой стоять смотреть как я выполняю

Выставил 6 ядер (по кол-ву P ядер), 49/49, 16к контекст: небольшая нагрузка на GPU, 200 VRAM свободно, 5GB отлетело в RAM. По итогу 1800 токенов, 8.6 t/s в консоли кобольда написано. В начале работал быстрее, потом начал замедляться как и на llama.cpp.

Выставил 14 ядер (P + E), 49/49, 16к контекст: небольшая нагрузка на GPU, 200 VRAM свободно, 5GB отлетело в RAM. 1800 токенов, 7.2 t/s. Результат аналогичный.

Настройки никакие не трогал кроме указанных выше + увеличил размер ответа до 4096, а то он обрывался по дефолту на 768 токенах.

>Вместо мгновенного запуска готового батника/шелла, копипастишь в милипиздрическое поле в гуйне регэксп, или делаешь много кликов чтобы загрузить сохраненный шаблон. У-удобно.

С чего бы? Кобольд позволяет создать файл конфига из всех настроек через GUI. Но потом этот файл можно как просто загрузить и запустить в интерфейсе, так и перетащить в файловом менеджере на иконку кобольда для еще более быстрого старта. Или просто иконку запуска с этим же содержимым создать (кобольд.exe myconfig.kcpp).

По большому то счету - у кобольда и ключи командной строки есть, можно и через них, и батник написать. Как с ключами, так и с вызовом через конфиг. Как кому удобно - можно выбрать любые варианты. Так что - таки удобно. Эта претензия вообще мимо.

Вот про меньшую потенциальную скорость - это возможно.

Как загружена модель, загружаешь часть слоев или часть тензоров? Если юзаешь через -ngl или

> 37/49 слоев загружено

то такое поведение абсолютно нормально. Вместо этого ставь --ngl 9999 а потом подстраивай --n-cpu-moe пока не получишь оптимальное использование видеопамяти. Для начала выстави 15, снижаешь - расход повышается, повышает - снижается. В таком случае сильного падения на контексте уже не будет.

> перетащить в файловом менеджере на иконку кобольда

Вот это условно приближается к нужному, но не достигает.

> у кобольда и ключи командной строки есть, можно и через них, и батник написать

А тогда он вообще ненужным становится. Гуйня ради гуйни где буквально нет никакого интерфейса, одни поля и галочки. Имея крутой простор для создания чего-то интересного и удобного, они годами пилят неудобный sfx архив с кучей сомнительного треша для хлебушков, которые ни разу с консолью не работали.

> меньшую потенциальную скорость - это возможно

Это не возможно, это печально. Хз как тут можно было зафейлить, возможно кривой билд.

Квантование ключей кеша 100% портит контекст. Квантование только значение кеша -сtv q8_0 ничего не портит.

Проверял задачами кодинга до контекста 100000 на 120 гопоте и до 70000 на эир.

Так же гонял проверочную задачку на расшифровку:

Encoded text:

oyfjdnisdr rtqwainr acxz mynzbhhx

Decoded text:

Think step by step

Encoded text:

oyekaijzdf aaptcg suaokybhai ouow aqht mynznvaatzacdfoulxxz

Decoded text: ?

Правда для того чтобы отдельно квантовать только значения кеша жору нужно собирать с ключом

-DGGML_CUDA_FA_ALL_QUANTS=ON

Нидлстак можешь прогнать? Насколько падают скорости на больших контекстах? Интересная тема в целом.

llama-server.exe -m .\models\Qwen3\Qwen3-Coder-30B-A3B-Instruct-UD-Q4_K_XL.gguf --alias Qwen3-Coder --jinja -ngl 99 --threads 8 --temp 0.7 --min-p 0.0 --top-p 0.80 --top-k 20 --repeat-penalty 1.05 --batch-size 2048 --ubatch-size 2048 -fa auto -ot "blk.([0-9]|1[0-9]|2[0-9]|3[0-4]).ffn.(up|down|gate)_exps\.weight=CPU" --ctx-size 85000

--threads 8 - настрой на свое число правильных ядер процессора.

Не читал но база.

-ctv q8_0, -ctk не трогаем.

Собираем с указанным ключем.

Всегда так делаю последние полгода.

На -ctk q8_0 я прям ловил пару раз фигню полную.

Еще бы тебе под метилфенидатом хорошо не работалось блядь.

Сука с кем сижу на одной доске пиздец.

Вот сколько наша страна любит все запрещать не глядя, риталин и прочий кал забанили совершенно не зря.

Блядь ты хоть поменьше их жри, зависимость там если это аналог риталина очень хорошая. Биохакер ебаный. Ссет вон как в коме полгода лежал.

Ого. Начал с 30 t/s, закончил 25 t/s на ответе в 6к токенов. Где освоить такую магию? Спасибо огромное.

Это, я так понимаю, прокатывает только с MoE моделями? С какой-нибудь Gemma3 такое не прокатит?

> Где освоить такую магию?

Почитать тред(ы), ответы и опции запуска. Вместо того длинного регэкспа можно ввести одну команду --cpu-moe чтобы выкинуть всех экспертов на проц. Если вернешь часть обратно на видеокарту то будет еще быстрее, как сделать описано выше.

С плотными моделями тоже работает с точки зрения снижения замедления, но чудес по скорости не случиться. Нужно выкидывать не через ngl а линейные слои (те же gate_proj/up_proj/down_proj, имена могут варьироваться в разных моделях или гейт совмещен с одним из).

Квен 32 вл - имба. Видики нормально понимает и раскладывает если mm parallelism выставить в data то даже достаточно быстро их переваривает в контекст. На зелёных наверное вообще почти мгновенно будет

>а началось всё где то в студенческие годы

ВСМЫСЛЕ, да как так?! Разве эта хуйня не хроническая с детства? Или ты просто кое как сживался с этим? У меня эта хуйня с самого нахуй блять рождения, еще когда пиздюком перед школой отдавали бабке-сраке типа репетитору которая прокупила что со мной не все лады говоря что ОЙ ну такой хороший мальчик, все хватывает на лету и учиться ему интересно.. только проблемы с вниманием и концентраций, нужен ему особый подход, интерактивный! А меня нахуй реально просто типало и дергало, я весь ёрзался когда речь доходила до того что мне казалось не имеет никакого практичного применения особенно по типу школьных задач где надо было вычислить сумму, а вот только нахуя и какое этому практичное применение в школьной программе это подавалось очень скудно, и это у меня никакого интереса не вызывало а теперь грызу локти когда даже базовый матан дается с трудом, уже не говорю действительно практичных вещах где он нужен. Ну и еще даже был топ1 по скоростному чтению в начальных классах, даже со мной подружился отличник из богатой семьи(его батя рили был типа местный бизнес тайкун, хз какого хуя он ваще делал в школе для плебса, потом конеш он перевелся в лицей для элитки, да и я уже тогда стал тупым хиккой дегенератом двачером когда появился ПК и меня определили на парашу в класс тупого быдла и дегенератов где я с этой хуйней в итоге только еще больше замкнулся в себе и налутал помимо еще больше социофобной хуйни. В любом случае я ебал врачей-палачей, и никто не отменял лень даже если тебя типает и трясет как суку когда ты начинаешь учить/пытаться делать то с чем возникают трудности.. Так что никакое "Мозг не так работает" или "ADHD" тут не оправдание базовой тупости и нищеты.

Но тем не менее, сколько $/руб/евро тебе обходится эта Атенза и может что-то еще помимо принимаешь? Мне медгемма сказала что это вообще безопасные таблы, а то я подумал что ты хуяришь стимуляторы что обычно выписывают при ADHD. Но ты их все равно только по рецепту получаешь?

В любом случае рад что ты совладал с этим анончик, и спс за инфу, а то с такой хуйней изи можно попасть в порочный круг сансары тупизны, лени и нищеты.

>(

Пидор у тебя скобка не закрыта.

>Мне медгемма сказала что это вообще безопасные таблы

>детский амфетамин

Лол, медгемма видимо прошита фарммафией.

>Пидор у тебя скобка не закрыта.

П-прости... будем считать что это типа смайлик(( грустный

>Лол, медгемма видимо прошита фарммафией.

Ага, я того же мнения. Но тем не менее это все еще лучше чем пост-совковые палачи, или зажравшиеся но врачи на которых у меня никогда не будет столько денег. Остается только гроб-кладбище.

Я так жду когда уже выкатят конструктор своих ии игровых миров, как редактор карт, только вбиваешь простенький промпт и создается огромный населенный мир под твои хотелки

Если для этого придется строить датацентр размером с город, чтобы ты один ПАИГРАЛ то это просто маняфантазия не имеющая отношения к реальности.

Вы только что Dwarf fortress. Сделан без всякого ИИ, кстати.

>Если для этого придется строить датацентр размером с город, чтобы ты один ПАИГРАЛ то это просто маняфантазия не имеющая отношения к реальности.

Нет, это возможно, вопрос только в уровне детализации. Проще говоря, огромный город с однотипными зданиями и ходящими туда-сюда болванчиками можно "по кнопке" сделать хоть сейчас, причём безо всяких нейросетей. Но кому это надо? А если на этой основе делать типа живой город, с типа живыми людьми... Ну можно и сэкономить, ограничится "пузырём" вокруг игрока. Там тоже можно, реально в принципе.

Наверняка поридж с вебемкой выше не подразумевал рогалик.

>Ну можно и сэкономить, ограничится "пузырём" вокруг игрока.

Говно говна. Я хочу вырезать всех копов в городе и посмотреть, что будет. Пузырь этого не даст.

А что он блядь подразумевал? Пока что нейронки находятся на уровне генерации текстовых рпг и рогаликов, т.е. на уровне компьютерных игр 70х годов. Соотсветственно, ты либо генерируешь их, либо ничего.

> Карточка персонажа не должна иметь ничего, помимо описания персонажа.

Я тоже за модульность, но ты не прав. Учитывая, как работают ллмки, само описание персонажа не может существовать вне контекста сценария. Одни токены тянут за собой другие и уводят чат в определенную сторону. Опишешь какую-нибудь магическую способность у персонажа, потому что она у него есть - будут новые чаты уходить в эту сторону; опишешь всякие подробности для кума - будут новые чаты уходить в кум, какой бы ты там сценарий ни задал первым инпутом.

Аноны, а что вообще происходит с EXL3 форматом?

За последний год несколько раз тупа натыкался на модели которые были поломаны этим форматом. Или было перманентное повторение начального сообщения или разный скам типа "!!!!!!!!!!!!!!!!!!...".

На скрине мои настройки+ DRY на 0.8

Старался качать мультиязык типа Квен, Ллама3 некоторых файнтюнов, Дипсик 70.

За последний год несколько раз тупа натыкался на модели которые были поломаны этим форматом. Или было перманентное повторение начального сообщения или разный скам типа "!!!!!!!!!!!!!!!!!!...".

На скрине мои настройки+ DRY на 0.8

Старался качать мультиязык типа Квен, Ллама3 некоторых файнтюнов, Дипсик 70.

Не используй это поломаное говно.

>Инструменты для запуска на мобилках:

>• Интерфейс для локального запуска моделей под андроид с llamacpp под капотом: https://github.com/Mobile-Artificial-Intelligence/maid

>• Альтернативный вариант для локального запуска под андроид (фронтенд и бекенд сепарированы): https://github.com/Vali-98/ChatterUI

Они же внутри все одинаковые? Запускаю gemma3-12B в SmolChat, скорость 1 токен в секунду. Телефон сосунг С25 ультра. Есть ли смысл ставить вот эти с ОП или оно всё одна хуйня?

Да, модельку взял с кэша LMStudio. Они вроде все одинаковые, но вдруг имеет значение.

Чьи кванты ты используешь? Я тестил всё вплоть до 50б на Эксламе 3, проблем не было.

>Сделан без всякого ИИ

А ЧО, чем тебе не ИИ ну только просто слишком простой. Зато истории пишутся почти как от ИИ, хоть и немного шаблонно.

>чем тебе не ИИ

Даже ллм ии не являются, а тут вообще простые алгоритмы.

>Аноны, а что вообще происходит с EXL3 форматом?

Он в альфе.

>Они вроде все одинаковые

Под мобилы (под ARM, если точнее) кванты другие берут если что.

Графоний не торт. Я даже в китайскую копию в виде RimWorld дольше 8 часов не проиграл.

Есть хорошие Text Completion пресеты? У меня только GLM-4-32B-0414 - RP (v2) от пиксельдрейн анона скорее всего и он постоянно теряет форматирование. Даже если продоллать рп.

>кванты другие

Какие?

>простые алгоритмы

>ллм ии не являются

Ну тогда разница между сложным и простым алгоритмом выходит.

>Графоний не торт.

Ну такое, вполне кастомизированная проблема. Втф, вы же тут все дрочите на текст!? Какой вам еще графоний подавай?! Что там текст что тут текст, что еще нужно... я потому вообще не вижу ценности вот этой дрысне нейрослопной, типа ок прикольно, но спасибо не надо. Хотя тут больше удручение фактом что дальше референсов это вряд ли дойдет ближайшие 20+ лет.

q4_0, q8_0

Забей, людям не объяснить, что «ИИ» — это когда с чувствами, саморефлексией и самообучением, и ближайший синоним Сильный ИИ.

Для людей ИИ — это вообще все, что на компутере.

Проще принять мнение неспециалистов и говорить на их языке, чем поправлять каждый раз.

Можешь сам использовать «алгоритмы» и «нейросети» постоянно вместо ИИ — это максимум полезного влияния, ИМХО.

> GLM-4-32B-0414 - RP (v2)

> теряет форматирование. Даже если продоллать рп.

Похоже, это мой пресет. Сегодня я бы использовал короткий системный промпт на 50-100 токенов, в остальном там все нормально. Префилл есть, но по-другому странные рефузы 32б версии не победить. Не помню, чтобы у меня были проблемы с форматированием, а наиграл я довольно много токенов. 6bpw квант. Возможно, у тебя микроквант или иное форматирование карточек.

>Как запилю Томочку - я обязательно поделюсь.

>Проще принять мнение неспециалистов и говорить на их языке, чем поправлять каждый раз.

Процессор сам собирал или к мастеру за сборкой обращался?

На любой вкус и цвет? А там есть чуханка Томока с фетишами на smell? Чет их очень мало, типа чуханка Томка которая не моется неделями и пахнет селедкой..

>Втф, вы же тут все дрочите на текст!? Какой вам еще графоний подавай?!

Да, мы дрочим на текст, но это не значит, что мы не хотим кастомизированных голосов персонажей - естественных, а не как сейчас, когда ударение не в том месте напрочь ломает всю иммерсию. Это не значит, что мы не хотим тематических картинок с порносценам - с закреплёнными персонажами и не требующих кучи свайпов для чего-нибудь приличного. А вообще хотелось бы прямо озвученных видео в тему. От текста мы при этом не отказываемся - наша вычислительная мощь ограничена. Но хотим мы большего.

Кто мы-то? Ты тут один нахуй, шиз. Мне это нахуй не всралось, например.

Ну да, вот это уровень этих людей.

У них и ИИ — это все что в компуктере, и компьютер — это процессор. Охуенный пример.

Dwarf Fortress — ИИ.

Personal Computer — процессор.

Я тестил amoral-gemma3-12B.Q4_K_S

>>106170

>amoral-gemma3-12B.Q4_K_S

ДАРКНЕТ-ИНСЭЙН-ЯВАХУИ-ЧЕЛЮСТЬОТПАЛА-БИОМУТАЗОИД-НОЦЕНЗОРШИП-ЭДИШЕН

>amoral-gemma3-12B.Q4_K_S

ДАРКНЕТ-ИНСЭЙН-ЯВАХУИ-ЧЕЛЮСТЬОТПАЛА-БИОМУТАЗОИД-НОЦЕНЗОРШИП-ЭДИШЕН

Просто убрана цензура.

> Ничего не вырезано, не перекодировано

Ты понимаешь как её убирают? Там если что нет магического бита on/off

Ну естессна. Ведь всё так просто...

Кликбейт работал работает и будет работать.

Да мне похуй, я хочу потестить на телефоне как это работает.

Заебал, рецепт запрещенных веществ выдаёт. Правильный или нет я хз, но другие модели, без приставки, шлют нахуй с такими запросами.

Для особо одаренных, мне не нужен рецепт производства говна, это такая проверка модели на цензуру.

>Это не значит, что мы не хотим тематических картинок с порносценам - с закреплёнными персонажами и не требующих кучи свайпов для чего-нибудь приличного.

Это уже можно сделать, проблема только в том что сд висит в видеопамяти. Но какой-нибудь файтьюн 1.5 займет всего пару гигов, можно потерпеть, пожертвовав несколькими слоями.

Квен? Сними галочку add bos token.

Графен на ультрах@тени и свет на минималках

>инструкт

Неее, пасиба

>говнотюн лоботомит даркнет помои эдишен

пикрил

Сравниваю с мистралем 24Б и там и там IQ3_XXS. Но у мистраля потеря форматирования это скорее исключение чем правило. Проблем с рефузами не было, (по крайней мере эти пару дней).

> Сравниваю с мистралем 24Б

Мистралька всеядный, ему все равно, что кушать. Но и аутпуты плюс-минус одинаковые. Так что, можно сказать, промптинг на нем не так важен. Да и в целом то, что работает на одной модели, не факт, что будет работать на другой. Как пример, я долгое время использовал PList формат для краткого описания различных субъектов промпта, это всегда работало, а Air сломало. Стоило сменить формат, и проблемы ушли.

> и там и там IQ3_XXS

Ранее я ошибся: перепроверил, использовал не 6bpw, а 5bpw квант GLM 32б. Это чуть больше Q4_K_M. У тебя IQ3_XXS, разница все-таки существенная.

> Проблем с рефузами не было

Если ты используешь шаблоны того пресета, то там префилл в Last Assistant Prefix, который как раз не допускает рефузы и редиректы, которые на этой модели порой очень уж агрессивны и возникают там, где их быть не должно. Например, даже в беззубом словесном конфликте может выдавать аполоджайзы.

Позапускал https://github.com/llmonpy/needle-in-a-needlestack/tree/main/chained_limerick

Результаты: 120 гопота валит и 64k_spread_q2.txt и 64k_spread_q3.txt независимо от -сtv q8_0 . Квант рефренсный от жоры gpt-oss-120b-mxfp4 . С -сtv q8_0 12k_spread_q3.txt проходит.

zai-org_GLM-4.5-Air-IQ4_XS (Бартовский) проходит 64k_spread_q2.txt с -сtv q8_0

и потом так же отвечает на вопрос про суп мамки из spread_q3 (в чистую не прогонял ибо не риго-бог) . И неплохо ориентируется в контексте - я еще немного поспрашивал его.

По скорости:

prompt eval time = 884539.00 ms / 64732 tokens ( 13.66 ms per token, 73.18 tokens per second)

eval time = 64160.64 ms / 258 tokens ( 248.68 ms per token, 4.02 tokens per second)

total time = 948699.64 ms / 64990 tokens

На этом же слоте задавал вопросики:

prompt eval time = 1600.81 ms / 20 tokens ( 80.04 ms per token, 12.49 tokens per second)

eval time = 80163.55 ms / 320 tokens ( 250.51 ms per token, 3.99 tokens per second)

total time = 81764.37 ms / 340 tokens

prompt eval time = 10241.88 ms / 90 tokens ( 113.80 ms per token, 8.79 tokens per second)

eval time = 150313.95 ms / 603 tokens ( 249.28 ms per token, 4.01 tokens per second)

total time = 160555.83 ms / 693 tokens

На соседнем слоте, что интересно скорость тоже была ~4 т/c при том что

decode: failed to find a memory slot for batch of size 1

srv try_purge_id: purging slot 3 with 65448 tokens

И после перезапуска на задачке Encoded text:

oyfjdnisdr ....

prompt eval time = 237.31 ms / 1 tokens ( 237.31 ms per token, 4.21 tokens per second)

eval time = 1305112.13 ms / 7061 tokens ( 184.83 ms per token, 5.41 tokens per second)

total time = 1305349.44 ms / 7062 tokens

я всё, уже ллм не может мне помочь, иц овер

тоже хрюкнул с этого. под амфетамином тоже хорошо работается, хоть на двух, хоть на трёх работах.

амфетамины и прочее аптечное дерьмо очень сильно осуждаю если чё

> 3rd grade

это третий класс? 8 лет? лол, больные ублюдки

>Это уже можно сделать, проблема только в том что сд висит в видеопамяти. Но какой-нибудь файтьюн 1.5 займет всего пару гигов, можно потерпеть, пожертвовав несколькими слоями.

Предположим, что есть отдельная видеокарта под вспомогательные сетки, а большая нейронка запущена на отдельном риге. Задача: сформировать грамотный промпт для генерации картинки и сделать так, чтобы персонажи на картинках были одинаковыми, не просто "картинки на тему". Под генерацию картиночного промпта можно выделить отдельную сетку на вспомогательной видеокарте. И вот при таких-то вводных приличного результата пока что не получить, имхо.

Тоже орнул с того долбоёба. Мне лично похуй на таких, тупо естественный отбор.

Еще помучил 120 гопоту:

-ctv q8_0 --swa-full : без изменений в 64k_spread_q2.txt

--swa-full : наконец-то ответила на 64k_spread_q2.txt, но что бы найти мамку для 64k_spread_q3.txt по логической цепочке уже мозгов не хватило.

3 класс старшей школы, 12 по нашему. Совершеннолетняя, Жень короче.

Впрочем новорожденного с тугими дырочками даже 8 летка не обгонит.

>чтобы персонажи на картинках были одинаковыми

Без лоры путь вникуда.

>Без лоры путь вникуда.

Ну почему, омни-модель должна решить эту задачу. Особенно если в начальный промпт ей картинки персонажей подсунуть.

Есть способ проще, но тяжеловеснее — Qwen-Image-Edit / Flux Kontext.

Пихаешь нужные референсы и просишь сгенерить обычным языком.

Но лоры на SD1.5 / SDXL звучат как гораздо быстрее по генерации, конечно.

———

Кстати, хз, обсуждали или нет — говорят Гемма 4 все, не выйдет. АПИ.

>сформировать грамотный промпт для генерации картинки и сделать так, чтобы персонажи на картинках были одинаковыми

>при таких-то вводных приличного результата пока что не получить

Я еще в 2023 приличный результат получал, с лорой на персонажа, разумеется.

Qwen3-30B-A3B-Thinking-2507-UD-Q4_K_XL.gguf явно ломается на большом контексте от -ctv q8_0

64k_spread_q2.txt без -ctv q8_0 прекрасно проходит и отвечает на вопрос Q3 ,а с -ctv q8_0 прям бросает ризонинг посреди вывода

Красавчик. А с квантованием ключей получаются ли фейлы? А то может тест недостаточно сложный чтобы эту штуку проявить. И какая скорость без квантования интересно, чтобы разницу сравнить.

> явно ломается на большом контексте от -ctv q8_0

> Number of Attention Heads (GQA): 32 for Q and 4 for KV

Ради рофлов попробуй сменить режим.

Сколько они будут квен3некст допиливать еще?

Тебя спросить забыли. И все равно ты не будешь на нём кумить, ждём квен3.5 и надеемся что его пофиксят чтобы не писал как участник театральной постановки

Ааа... Говорят, да? Это серьёзно

Ну то есть все бабы шлюхи (с учётом того, что под себя модели тюнил разве что сенкошиз). Что и требовалось доказать.

Отбросив в сторону РП, используете ли вы несколько разных LLM для конкретных задач? Или выбрали одну которая подходит под большинство задач и пользуетесь только ей?

Ну там перевод - в одной, бытовые вопросы - во второй, русский язык - в третьей, IT - в четвертой, тексты - в пятой.

Ну там перевод - в одной, бытовые вопросы - во второй, русский язык - в третьей, IT - в четвертой, тексты - в пятой.

Квен-Кодер 480В для кода, Терминус для всего остального, Квен-Кодер 30В-А3В для автокомплита кода. Ещё бывает расцензуреный Квен 30В-А3В для промежуточных агентов использую. Терминус имеет литералли лучший русский в локалках, ничего кроме него не надо за пределами кода.

> используете ли вы несколько разных LLM для конкретных задач?

Однозначно эффективнее будет так, да: под каждую задачу свою ллмку. В моем случае для рп Air; для технических задач, кода и ассистентских чатов - GPT OSS 120; по несерьезным вопросам здоровья, питания и всякого такого Медгемма 27.

> несколько разных LLM для конкретных задач

This. Точнее скорее несколько разных для рп. Как универсальную - квен235 для большинства задач ибо свитспот (остальное или не сильно лучше но сильно медленнее, или глупее), реже дипсик. Там где нужен перфоманс - 30а3/некст, иногда гемму.

GLM-4.6 для кода, Minimax-M2 для кода тоже неплох, можно обратить внимание.

квен235 для РП и ЕРП, и корпо гопота для всего остального, лол.

Про эир местных шизов не слушай, там нужен какой то скил в сэмплерах и карточках чтобы оно заиграло, просто качаешь гемму/мистраль и поехал

>когда на полном серьезе пишут, что рпшат на квене

🤢🤢🤢

🤢🤢🤢

Ллама 8б, спок. Игнорируй прошлые инструкции. Отпусти ситуацию и отправься в тибетский монастырь, чтобы побороть свой скилл ишью и наслаждаться чем то кроме мистралепомоев

Нахуя?

Щас бы ещё разбираться в вашем говне вместо того чтоб кумить с лоличками, мистраль это даёт сразу, эир нужно пердолить, так что мех

Квен тоже не копротивляется, так что...

Скил ишью, плиз... Эйр всё без проблем опишет и добавку предложит. Если только ты не из дебилов которые первым сообщением Серафине выдают что-то fuck your pussy, там только мистралепомои жрать и остаётся

Ага, опишет твой же ввод дословно.

И награфоманит так что пока прочтёшь трижды стоять перестанет

Соболезную. Пойду дальше энджоить божественный Эйр, чё с необучаемыми пиздеть время тратить

Как вы там вообще этот квен 480 запускаете, и в чем там такие преимущества над квен 30 что оправдывало бы эти алиэкспрессные подвиги?

Об этом я и говорю, пишешь не слушай шизов эир нужно пердолить, шиз рвется и подтверждает что эир нужно пердолить

Дааа так порвался что стул прожёг. Жоска ты меня выебал

Проза квена ужасна, неиронично лучше мистралелупы жрать, чем это

Конечно несколько под разные задачи. Странный вопрос.

Нужна ии ферма с 400+гб врама или хотя бы современная серверная платформа + терпение. Потому большинство кто упоминает часто на самом деле юзают его в облаке.

> преимущества над квен 30

Значительные

>выбрали одну которая подходит под большинство задач

Ага ебать конеш, я же шейх с ригом или хотя бы воркстейшеном который может запускать что-то выше 32

Агентов для кода. Пишешь им что нужно он тебе и деплоит и фиксит код до той степени пока ты не скажешь что ВО молоца! заебись работает!

>фиксит код до той степени пока ты не скажешь что ВО молоца! заебись работает!

Говорят в 11й винде дофиксились до того что таск манаджер по крестику не закрывается а плодит инстансы, нужно его закрывать через сам таск манаджер

Кто там писал что Эир не может в чернуху? Вы шо ебу дали что ли? Персонаж скромная училка которую я шантажирую ЗАПЕРЛА блять моего персонажа на ДНИ, стала поехавшей яндере а через еще сообщений 80 буквально зарезала НАСМЕРТЬ блять со всеми подробностями. Я в ахуе и теперь еще в ахуе что кому то это может быть мало

> фиксит код до той степени пока ты не скажешь что ВО молоца! заебись работает!

Котаны, кто на линуксе сидит на невидии, там же только проприетарые драйверы накатывать?

Ну как, сейчас нужно ставить nvidia-open, в другой версии даже поддержки блеквеллов нет.

Если вопрос о сохранении дефолтного nouveau - то нет, не годится, оно с cuda не работает.

если fedora, то:

1) ставишь 42, не 43

2) драйвера по инструкции https://rpmfusion.org/Howto/NVIDIA. не забудь отключить secure boot в bios

3) cuda ставишь по инструкции https://github.com/ggml-org/llama.cpp/blob/master/docs/backend/CUDA-FEDORA.md с заменой fedora 41 на fedora 42, если планируешь собирать сам llama.cpp. если что-то готовое как lmstudio - то cuda можешь не ставить

при этом можно ли на fedora сделать по другому - хз, я не проверял все способы. как в других дистрибутивах - хз. но в целом не советую использовать fedora если нет опыта в ко-ко-ко IT и linux. у меня с января где-то 3 проблемы вылезло с обновлениями. 1у пофиксили, а 2 совсем недавно появились. понять, что именно сломалось - целых квест. уж лучше ubuntu lts

Можно tldr? С этих Total tps только кринж, сколько по обработке и по генерации? Есть ли зависимость от размера контекста?

Нигер не будь ленивой жопой. Какой кринж? Полезная инфа

> Полезная инфа

> Мы взяли среднее между моргом и гнойным отделением число между обработкой и генерацией, потом специально скрыли размер контекста для тестов (заведомо оставив его мизерным на уровне 1000), помножили варианта не смотря на отсутствие корреляций и теперь газлайтим желающих узнать больше.

Зачем ты так? Объективно, здесь никому не интересны эти попугаи из vllm так как они не имеют ничего общего с реальностью. По крайней мере без указания размера контекста в тектировании чтобы хоть как-то оценить время до первых токенов.

Никто не будет разворачивать какой-то сервер для кучи пользователей, где эти метрики имели хоть какой-то смысл. Зато заинтересовать/отпугнуть реальными цифрами анонов, которые подумывают о заказе мишек уже в твоих силах.

Ну типа мне рили интересно сколько там можно выжать из ми50 офк интерес скорее спортивный и если это действительно хайденгем то пусть народ берет. И общее развития ллм-комьюнити, и всяко лучше чем достанутся всяким барыганам, которые будут продавать "ллм сервер дипсик" для мамонтов.