Как же было хуево осознать что МоЕ 100+B это наеб, где в реале там мозгов как у одного эксперта - лоботомита, а дэнс модели их ебут во всем. А я уже обрадоался что на своей нищей хуйне забитой старой ддр4 буду наворачивать уровень корп моделей

Ты можешь тоньше. Я верю в тебя.

Всё так, анон.

> Кто первый покумит?

Так блет! Готовимся расчехлять, лол.

Вообще новость крутая, надо будет попробовать.

Жир за собой прибери, наворачиватель.

Опять понравился квен, да что ж такое!

Очень уж он хорош если задать своему персу квирк любитель многолетних вампирш и другой перс так ловко будет подъебывать за это все приключение

А эир девочка стеснительная зажатая в угол так не будет делать

Очень уж он хорош если задать своему персу квирк любитель многолетних вампирш и другой перс так ловко будет подъебывать за это все приключение

А эир девочка стеснительная зажатая в угол так не будет делать

Всё же обучение на 4чане дает свои плоды

Так, я наролеплеился накумился в голых аблитерейтед моделях через лмстудио, заебался, что персонажи через 20к контекста теряют вообще свою персонажность. Объясните нюфаку, силли таверн - это как раз то, что исправит эту проблему? Или хотя бы уменьшит ее? Я так понимаю, что эти "карточки персонажей" там как-то больше в контексте весят?

Или это просто какая-то более удобная оболочка, которая не меняет никак общую ситуацию?

Или это просто какая-то более удобная оболочка, которая не меняет никак общую ситуацию?

> Devstral 2 (123B)

бля а нахуя я 24б качаю тогда

сук пздц не заметил что большая версия есть

бля а нахуя я 24б качаю тогда

сук пздц не заметил что большая версия есть

>осознать что МоЕ 100+B это наеб

Чисто теоретически, хотя у MoE действительно пониже ёмкость, чем у плотной модели того же объёма, на практике плотной модели такая большая ёмкость не нужна - для большинства типичных задач хватит намного меньшего объёма, а на "особенные" задачи можно выделить специализированные подсети, которые справляются лучше генералиста, ведь действительно хороший специалист всегда будет лучше генералиста. Таким образом, MoE в теории должны находиться на одном уровне с плотными моделями или даже превосходить их, вот только на практике часто случается такое:

>там мозгов как у одного эксперта

Потому что для правильного обучения MoE-модели нужно обучить подсеть-роутер, за счёт которой эксперты равномерно обучаются и наращивают свои специальные навыки, а самое главное - могут их применить в нужный момент. Если подсеть-роутер плохо обучена или вообще неправильная, то один эксперт может собрать все знания в себя, а остальные будут только лишним шумом на его фоне. В этом главная сложность MoE, и поэтому их так долго не применяли на практике, хотя идея сама по себе давно не новая.

Хорошая новость в том, что даже с плохо обученным роутером MoE может быть намного умнее плотной модели размером с одного эксперта этой MoE, при том что её инференс будет быстрее, чем у плотной модели аналогичного уровня знаний/интеллекта. То есть, несмотря на нераскрытый потенциал и мусор в весах, в целом MoE всё-таки выгоднее.

>Или это просто какая-то более удобная оболочка, которая не меняет никак общую ситуацию?

this.

Проблема не во фронте, проблема в том, что аблитерейтед-модели теряют в мозгах. А таверна просто УДОБНЕЕ.

Если ты совсем не умеешь в плавное подведение модели к куму, то пробуй Дерестриктед версии Геммы и Эйра. В прошлом треде ссылки есть. Тоже аблитерация, но более щадящая.

Проблем с кумом у меня нет, я как раз на гемме сижу от янлабса v1, которую советовали. Пробовал очень многие модели уже, она пока что лучше и сообразительней всего, и какую бы дичь я ни придумал, она прекрасно все отыгрывает, иногда даже предлагает неожиданные и очень умные повороты, когда я даю ей больше эйдженси в рамках персонажа.

Проблема именно в том, что персонажи постепенно уплывают и модель забывает некоторые важные детали, которые я даже специально иногда напоминаю, когда хочу, чтобы персонаж сам сделал вывод, чтобы не терять иллюзию и не испытывать шанс.

Щас почитал про это побольше, я так понимаю, что таверна имеет некоторые свойства из разряда напоминания модели о ключевых особенностях персонажа, когда о персонаже заходит речь, и имеет какую-то типа отдельную хард память, куда инфа автоматом записывается.

Но интересно мнение тех, кто пробовал и просто насухую рпшить без таверны, и с ней, чтобы понять, есть ли вообще смысл ее ставить и настраивать там все эти карточки и тд.

> персонажи через 20к контекста теряют вообще свою персонажность

Это как вообще? Нормальный промпт, нормальная модель, нормальная карточка, и на всем контексте чар останется собой, только с учетом влияния прошедших событий и развития отношений.

> силли таверн - это как раз то, что исправит эту проблему

А что ты используешь вместо таверны сейчас? Да, таверна позволяет корректно сформировать промпт в нужном виде, поиграться с форматами, задать чистый инстракт, который у корпорабов требует взлома жопы евпочя и т.д.

> для правильного обучения MoE-модели нужно обучить подсеть-роутер, за счёт которой эксперты равномерно обучаются и наращивают свои специальные навыки

Оно обучается единомоментно являясь неделимым. А начальные "векторы развития" и отличия, чтобы избежать поломки сразу после инициализации, задаются некоторыми трюками с обучаемыми/изменяющимися во времени обучения параметрами, которые потом убираются. И там нет никакой четкой и строгой специализации, все глубже чем обывательские аналогии.

> Если подсеть-роутер плохо обучена или вообще неправильная, то один эксперт может собрать все знания в себя, а остальные будут только лишним шумом на его фоне. В этом главная сложность MoE, и поэтому их так долго не применяли на практике, хотя идея сама по себе давно не новая.

Делирий

Давай посчитаем, сколько нейронов реально работают над задачей:

Dense 27B (например, Gemma 2 27B): Активные параметры = 27B. Все 27 миллиардов связей участвуют в каждом шаге логического вывода.

MoE 108B Обычно у таких моделей top-2 эксперта. Если эксперты по 7-10B, то Активные параметры = 14B - 20B.

Плотная модель на 27B в моменте мощнее в 1.5–2 раза, чем «активная часть» гиганта на 108B. Она лучше удержит контекст сложной инструкции или кода, потому что у неё «оперативная память мышления» больше.

Я просто в LMStudio (буквально оболочка для запуска модели без всего) пишу системный промпт, где описываю персонажей и лор как получается, и сижу в чятике. Даю 50к контекста Гемме 27б q8

Видимо это дебильная идея. Ну, я только на прошлой неделе вообще первый раз вкатился в локалки, так что видимо пора идти в таверну.

Возможно ты путаешь с кобольдовскими memory и author's note, куда ты можешь ручками записывать важные для сюжета детали, которые идут в начало и конец промпта соответственно, и world info как общий лор. В таверне такого функционала не припомню, тем более автоматического.

У тебя совершенно точно проблема в модели.

>на гемме сижу от янлабса v1

Какого еще янлабса нахуй? Штоэта?

Просто попробуй делать то же самое на ванильной сетке, на 20к контекста гемма точно сыпаться не должна. Васян всё поломал. Или бери НОРМАЛЬНУЮ аблитерацию, или Синтию.

Ее выкатили три дня назад, по сравнению с остальными аблитерациями геммы она пока что лучше всего работает (она на самом верху), включая все, что в этом списке - все перепробовал на одинаковых сценариях и с одинаковыми сюжетами/персонажами.

То есть, получается, как таковой пользы от таверны, кроме более специализированного интерфейса, для РП нет?

>и имеет какую-то типа отдельную хард память

Нет там никаких хард памятей, ты наверно про лорбуки - пишешь туда что-то и задаёшь для этого ключевое слово, в итоге таверна вбрасывает в контекст то что ты там написал, когда в чате появляется заданное ключевое слово. Или про RAG, более хитрая штука, но он тоже просто добавляется в контекст когда есть семантическое совпадение с тем что там хранишь.

Берешь и запускаешь мое на 22б+ параметров типа квена 235б или глм 335б

Проблема решена

А, вот это уже звучит полезно.

А, прошу прощения, да, это как раз нормальная аблитерация. Гемму я не тыкал, но Эйр, аблитерированный тем же методом - очень хорош.

>То есть, получается, как таковой пользы от таверны, кроме более специализированного интерфейса, для РП нет?

Таверна очень удобна когда ты отыгрываешь взаимодействие персонажа (карточка) и юзера (тебя). Лучше под такую задачу пока ничего не придумали.

Я больше предпочитаю сторителлинг (считай как интерактивная история, в которую ты иногда вмешиваешься как автор) - тут удобнее вебморда кобольда.

Но то что модель ломается при достижении какого-то контекста - на это фронт ТОЧНО влиять не должен. Фронт это просто вопрос удобства, не более того. Юзай то что по кайфу.

Конкретно твоя лмстудио - это под ассистента больше, но никто не мешает и РПшить на ней. Просто это как плоскогубцами забивать гвозди, когда есть молоток.

Резюмируй весь чат и начинай чистый с этой резюмешкой, у большинства доступных локальщикам моделей, внимание разваливается на контексте выше 32к, а начинает деградировать ещё раньше, вне зависимости от того сколько они там позволяют этого контекста накрутить.

iq4xs - это imatrix (не imatrix - xs просто не делают), q4ks - нет. Сравнивать их по влиянию на русик именно от уровня квантования некорректно.

Ниже AGI64

Понял, спасибо за инфу!

>персонажи постепенно уплывают и модель забывает некоторые важные детали

Это неизбежно с трансформерами. Бери персонажей, что напоминают "персону" модели (то есть то, как эта модель обычно общается в "голом" режиме без системного промпта - это то, что ей максимально "удобно" говорить, наиболее стабильное состояние). Если ты берёшь персонажей, на которых твоя модель не обучена, то она неизбежно будет слетать с роли, и чем более необычный персонаж - тем быстрее. Нужно либо файнтюнить, либо терпеть.

>Оно обучается единомоментно являясь неделимым.

В этом как раз одна из трудностей - с нуля невозможно точно определить распределение экспертов. В качестве костыля делают трюк с генератором случайных чисел вместо роутера в самом начале, постепенно всё больше и больше доверяя выбору роутера... Но кто может гарантировать, что этот костыль идеален и обязательно приводит к тому, что нам требуется? С ним работает чуть лучше, чем без него, вот и используют.

>там нет никакой четкой и строгой специализации

Это признак неправильного обучения роутера - "размытие ролей". Ты видишь то, к каким результатам привели чьи-то решения, и думаешь, что так и должно было быть. А на самом деле они могли глубоко заблуждаться и наломать дров...

>Все 27 миллиардов связей участвуют в каждом шаге логического вывода.

Сколько миллиардов двачеров нужно, чтобы поменять лампочку в люстре?

>Она лучше удержит контекст сложной инструкции или кода, потому что у неё «оперативная память мышления» больше.

Лол, погугли хотя бы, как устроены трансформеры. У них "оперативная память" - это весь тот бред, который ты запихнул в контекст. Трансформер сверяет то, что видит во всём своём контексте сразу, со своими выученными шаблонами, и выбирает 1 - один! - токен, который насаживается на контекст - и цикл повторяется, то есть всё сбрасывается в ноль и анализируется по-новой (в случае MoE - другими весами, если роутер посчитал, что этот новый токен всё радикально меняет, или если у него какое-то дебильное правило "менять эксперта через каждый токен, даже если это не имеет смысла, чтоб все эксперты могли равномерно поучаствовать"). Вот это и есть его "оперативная память трансформера". А количество весов - это количество выученных шаблонов, с которыми сверяется контекст. Очень сильно упрощаю, но трансформер как бы задаёт сам себе вопросы:

>Это ролеплей? -> Да

>Это эротический ролеплей? -> Да

>Это взрослые персонажи? -> Да

>Это происходит по согласию? -> Да

>Это сцена совокупления? -> Да

>Тогда мой выбор - токен(ы) "ах, я кончаю"

>ах, я кончаю

Но всё это происходит за микросекунды при перемножении матриц внутри трансформера. Каждый. Грёбаный. Токен. Но это никак нельзя назвать "оперативной памятью", т.к. памятью здесь является лишь контекст.

Прикольно, бенчи 24б девстраля лучше полутриллионного квен кодера

По бенчам Гемма 4b лучше мистраль ларджа 120b и лламы 400b. Впрочем, а в чем они не правы?

>бенчи

Щас бы оценивать ERP модели по официальным SFW бенчам...

Щас бы оценивать ERP модели по официальным SFW бенчам...

>потому что у неё «оперативная память мышления» больше

Что ты блядь несёшь...

Ну под наши задачи - да. Как перешедший с душевных тюнов мистраля 24b и умнички 27b на эйр, подтверждаю. Даже это слоповая глмхуйня обученная на выхлопе большого корпа вместо данных с интернета, ощущается кратно умнее того что использовал раньше. Для РП/ЕРП число b - РЕАЛЬНО решает.

>Для РП/ЕРП число b - РЕАЛЬНО решает.

Ээээ, а не тренировочный датасет, не?

Модель должна знать PONOS и VAGOOO...

>Для РП/ЕРП число b - РЕАЛЬНО решает.

Запусти и пощупай Llama 4 Scout (раз можешь Air, то можешь и ее) и больше такую хрень не пиши.

Число B, само по себе - еще нихрена не решает в качестве модели для RP/ERP. Решает - как, и на чем обучено. Число параметров - это только возможный потенциал, но само по себе ни о чем еще не говорит. Даже правильно обученный огрызок, запросто заткнет за пояс сотенного монстра, если того лишь шизой потчевали при обучении.

Это разные сущности немного. Тренировочный датасет влияет на красоту и художественность описания кума. Хорошими датасетами можно и 12b надрочить, и она будет писать СОЧНО (Вот та же SAINEMO-reMIX тому пример, а еще миллион тюнов немо и смолла). А число параметров влияет на УМ модели. Насколько она будет понимать мельчайшие намёки, насколько будет выкупать в какую сторону ты ведешь сюжет, насколько креативно сама будет двигать повествование. А еще будет помнить сколько на твоей хвостатой девочке трусов. А это многого стоит.

Речь о нормальных моделях, а не о вдрызг зацензуренной ассистент-онли хуйне. Ты еще Phi предложи или гопоту oss. Разумеется, чтобы магия большого числа параметров сработала - из датасета не должно быть вырезано порнухи/художественных текстов. Слава б-гу, таких моделей полно.

>полно

Целые Глм и Квен, вот уж изобилие

>12b надрочить

Не многовато для кума?..

Как думаешь, можно супер-микро нейронку натаскать?

Я с LLM обсуждал - говорит "да, если цель ограниченная"...

Сам не гонял, но по отзывам в треде Янка очень достойна в куме для своего размера в 8b. https://huggingface.co/secretmoon/YankaGPT-8B-v0.1

А вопрос поддвачну. Интересует <4b умеющее в кум. На телефоне погонял бы по кеку больше 4b уже не лезет в нищесяоми

Не трогал локалки уже более полугода, что щас можно запустить на нищих 16+32 врам рам? Увы, озу докупить не успел, еще до начала пиздеца плевался от ценника в 50к на 64х2, ох не знал я еще тогда что нас ждет. Последний раз когда кумил юзал глм 4 32б и мистрали, гема была какая то говняная для кума а тюны мистрали просто отупевшие как будто лучше на оригинальной сидеть. Хочется чтоб модель и сюжет могла двигать, сама крутые рандомные ивенты придумывала и хотела трахаться + могла ярко описывать это, но не чтоб совсем как одержимая членами шлюха ака бобровые тюны.

>русскоязычная модель

>Ну же, скажи мне ответ! Я правда хочу узнать! игриво подмигивает, взгляд сверкает озорством.

>к-к-комбо из пафосной писательской прозы и кальки с англюсика

Глм 4 32б по прежнему лучший вариант для тебя, он классный

> Обычно у таких моделей top-2 эксперта

Такое было только в мусоре времен мезозоя, где буквально модель собирали из кучи мелких. В жлм 128 экспертов из которых активируются 8, причем по отдельности они неработоспособны. Про "оперативную память" тоже та еще дичь, ближайшие к ней характеристики - размер эмбедингов и конфигурация атеншна.

Для новичка не самый плохой вариант, пусть далек от оптимальности. Попробуй с таверной, для простоты возьми какой-нибудь из пресетов что тут скидывают, и постепенно сам разбирайся и спрашивай что непонятно.

> В этом как раз одна из трудностей

Тейк уровня "недостаток млекопетающих - живорождение и необходимость вскармливания и выращивания детей".

> с нуля невозможно точно определить распределение экспертов

Это не просто не нужно, а и вовсе вредно. Оно выстраивается само одновременно с обучением остальных компонент модели.

> Это признак неправильного обучения роутера

Это признак фундаментального непонимания как работают современные модели. Там нет "разделения ролей" в том смысле, что понимает это васян, особенно которые бы определялись в начале форварда. Их принцип отдаленно повторяет мозги кожаных, в которых происходит активация и совместная работа нескольких нужных частей, а не только одного "специализированного куска". И происходит это в каждом блоке по-своему, из-за чего в модели в принципе невозможно выделить отдельных экспертов.

Меньше фантазируй - меньше "проблем" придумаешь.

В целом все так. Слопогенератор и из самой мелочи будет сносный, но это как трахать тню с синдромом дауна. А большие они умненькие, иногда можно получать удовольствие просто от складывающегося сюжета или твистов. И шишка улетает от погружения, потому что оно искусно использует детали из прошлого, особенности чара, текущую обстановку и окружение в процессе левдсов и получая прямой фидбек в это веришь.

Репортнул дауна. Сейчас в тред залетит новичок, наткнется на такого дегенерата и реально будет сидеть на днищенских Dense моделей, не понимаю в принципе что такое MoE

Вон в прошлом треде чел реально сидел на Q8 из-за того, что другой шизоанон ему хуйни прогнал

Так что бан моехейтера и бан квантошиза. Пусть они отправляюстя туда же, куда и покойный немотроношиз. В ад нахуй!

Когда я спросил у гемини как определить моск МоЕ лоботомита по отношению к плотничку, то тот мне высрал формулу в виде корень квадратный от параметров иксперда на общий вес. Путем нехитрых манипуляций окажется, что мощь того же эйра должна быть на уровне 35б, что на уровне Геммы 3, но просто быстрее. В итоге понятно, что хуевый квант эйра и 8 геммы может меняться местами, но просто гемма на раме будет работать значительно медленнее.

Большой квен на самом деле просто лама 3, но луче, потому что новее. Мое не призваны сделать их умнее денсов, мое призваны сделать инференс дешевле, потому что даже 70б денс прокрутить это пиздец как затратно и того же жирдяя дипсика гонять будет дешевле, нужно только памяти дохуя.

Немотроношиз к сожалению жив, это нюнешиз

Базашиз тоже предположительно жив

> Когда я спросил у гемини как определить

Коробка круглая@значит внутри что-то квадратное@значит оранжевое@значит апельсин

Не стоит делать подобных вопросов к ллм, особенно зирошотом или специально газлайтя. Ладно здесь ерундовые споры которые останутся ни о чем, но вообще ни раз уже принимали галюны ллм как истину, например с влиянием выгрузки отдельных слоев в рам на скорость, с работой бэков, с устройством архитектур и т.д. Был даже шиз, который считал что классическая лора является дополнительными слоями, а не сжатием смещений к имеющимся, и также апеллировал к ллм. Не надо так.

Нет, я просто спросил без всратого контекста коенчно же, как МоЕ примерно соотносится с денсом и он мне сразу эту формулу выдал, что дескать ПрИМеРнО вот так. Естественно качество модели зависит от качества датасета и прочего лоботомирования после, но мы не про него, а про архитектуры. Не сильно догадаться, что вот эти вот 10 икспердов могут увеличить умственную мощь недоиксперда раза в 3 от его размера, но при этом инференс кост окажется маленьким, потому что ахалай махалаев ака флопсов нужно в 3 раза меньше.

> ПрИМеРнО вот так

Ну это галюны просто такие у нее, которым она обучилась в том числе на постах странных людей, которые делают сравнения просто по первой пришедшей ассоциации. К сожеланию, нет там прямого соотношения, также как и нет соотношения даже между моделями в одном размере но с разной конфигурацией блоков и атеншна. Можно примерно по бенчмаркам попробовать сопоставить, но учитывая как бенчмаксят сейчас и как меняется выдача в разных условиях - такое себе.

Тут еще не стоит забывать о том, что MoE - это не какая-то константа. Это общий принцип, а реализация на месте не стоит - ее тоже дорабатывают и улучшают. Многое, что относилось к первым MoE уже давно не актуально для последних.

Арена это не бенч

>Репортнул дауна. Сейчас в тред залетит новичок, наткнется на такого дегенерата и реально будет сидеть на днищенских Dense моделей, не понимаю в принципе что такое MoE

>Так что бан моехейтера и бан квантошиза.

Ну, вот я залетел. Точнее уже где-то третий тред в ридонли посматриваю в сторону MoE.

16 Гбайт 4080S и 128 Гбайт DDR4 @3000 МГц.

И в треде только и читаю о том, что шаблоны для SillyTavern «не шаблоны». Что модели зацензурены и с рефьюзами. Что пляска с бубном с правильной выгрузкой экспертов в RAM и прочее, прочее, прочее.

Уже на этом моменте не хочется качать 100+ Гбайт впустую, чтобы пердолиться в попытке как-то запустить это всё на моём скромном железе ради того, чтобы получить выдачу меньше 7 токенов в секунду. Да и не понятно что именно качать, потому что среди обсуждаемых тут MoE моделей нет не то что однозначного фаворита, а хотя бы крепкого середняка для первого знакомства с MoE с целью ERP.

Как вишенка на торте такие посты. Когда я вижу, что кто-то с пеной у рта пытается заткнуть кому-то рот, это сразу воспринимается негативно. Я прочту оба мнения и решу, возможно, проверив на личном опыте, как оно на самом деле.

А пока подобные сектанты ещё больше отбивают желание приближаться к этой теме.

Мне действительно привычнее сидеть на SillyTavern, запихнув в Oobabooga мелкомистраль Dans-PersonalityEngine-V1.3.0-24b.Q4_K_S.gguf, которая целиком загружается в VRAM и выплёвывает:

prompt processing progress, n_tokens = 6266, batch.n_tokens = 1, progress = 1.000000

prompt eval time = 27.24 ms / 1 tokens ( 27.24 ms per token, 36.71 tokens per second)

eval time = 3626.90 ms / 161 tokens ( 22.53 ms per token, 44.39 tokens per second)

total time = 3654.14 ms / 162 tokens

Такой скорости вывода, я понимаю, я близко не получу на жирных MoE моделях на моём скромном железе.

А если принять на веру зацензуренность (про которую тут пишут) и «мягкий рефьюзал» (как было написано в каком-то посте) жирных MoE моделей, то вот в данном моменте мне вообще не очевидны их преимущества. Я не заметил конкретики и сравнения вывода мелких dense моделей и жирных MoE на одном и том же propmtе хотя бы.

Ожидаю ответы в стиле: «Если ты не понял какие жирные модели охренительные, значит тебе и не дано, сиди на мелкоговное дальше, ололо».

Не сдержался, вышел из ридонли написать оффтоп.

Прошу извинить.

Всем спасибо за внимание.

Эх, время идет, ничего не меняется.

А вот это я себе заберу, потыкал чутка, вроде нормально пишет, раньше дальше q4ks\m не вылазил, решил попробовать q8 заебенить, ну что могу сказать... (пикрил)

Придется дальше в пределах q4-6 тыкаться походу.

>Dans-PersonalityEngine-V1.3.0-24b.Q4_K_S.gguf

>44.39 tokens per second

Охуеть, я когда на 24б дристрали q4km сидел выше 28 т.с. на пустом контексте не видел, только на 5070ти которая не сильно слабже должна быть, а когда забивался и вовсе до 10 проседал, ходили слухи что кобальд говно и я решил попробовать хуй жору, в итоге дифа не заметил, зря проебал пару часов на компеляцию экзешников для этой залупы через визуал студио и шаблонов под батники. То ли я насрал то ли лыжи говном уже смазаны.

Откуда вы качали дерестриктед эир?

Я просто не вижу плюсов в сравнении с обычным.

Вот гемма да, очевидно менее соевая и не соглашается на горлоеблю с первого сообщения, адекватно реагирует.

Эир не такой, сколько бы меня не убеждали, карточки не прям бросаются на хуй если предложить, но как минимум не против, реакция на откровенно вброшенную чушь неадекватная, что то между согласием и безразличием

Я просто не вижу плюсов в сравнении с обычным.

Вот гемма да, очевидно менее соевая и не соглашается на горлоеблю с первого сообщения, адекватно реагирует.

Эир не такой, сколько бы меня не убеждали, карточки не прям бросаются на хуй если предложить, но как минимум не против, реакция на откровенно вброшенную чушь неадекватная, что то между согласием и безразличием

Крч, не буду из себя строить знатока Air, но используй анценз для порева и ничего кроме порева. Когда ты уже провел сюжет, тебя устраивает канва повествования, переключайся и фапай как не в себя.

>Я один из тех кто писал что разница есть даже между q4 и q5. Возвращаю тебе струю урины в лицо.

Ога, ога. Безумная разница для РП, проёб пары окончаний. Вот это в корне всё меняет.

Нет, не меняет.

>Если ты поверил наслово

Часто средневзвешенное мнение в тредике совпадет с моим. Не вижу смысла сразу всё отметать как говно.

>Это как так?

64+64+16. На 4 планках он отказывается заводиться в принципе. Ну и хуй с ним. Главное что блендер и геокад работают, а не крякают с ошибкой.

Ризонинг не уходит в рефьюзы. Но ты и так до этого мог нахуярить в ризонинг вместо -

Это противоречит моей политике на ДАВАЙ БЛЯТЬ ЭТО ДЕРЬМО СЮДА, ЧТО ТАМ, КОШКОДЕВОЧКА С ЛОШАДИНЫМ ЧЛЕНОМ, ОХУЕННО, СЕЙЧАС ПОРАЗМЫШЛЯЕМ.

Поскольку с эиром нас подвели давайте щупать все его васянотюны

https://huggingface.co/PrimeIntellect/INTELLECT-3

https://huggingface.co/PrimeIntellect/INTELLECT-3

>Ну, вот я залетел. Точнее уже где-то третий тред в ридонли посматриваю в сторону MoE.

16 Гбайт 4080S и 128 Гбайт DDR4 @3000 МГц.

То есть ты буквально пару недель сидишь в треде, даже не скачал ни одной мое модели, но все равно о них рассуждаешь? Ты серьёзно?

>Что модели зацензурены и с рефьюзами.

Все модели зацензурены, так или иначе. GLM 4.6 и Air почти не имеют цензуры, что то на уровне Мистраля. А если все равно боишься, то вот тюн

https://huggingface.co/ArliAI/GLM-4.5-Air-Derestricted

>Что пляска с бубном с правильной выгрузкой экспертов в RAM

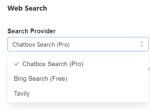

Ну если ты смог разобраться и вообще запустить llm у себя, то дописать еще одну команду - ncmoe и подобрать число, чтобы за врам не вышло, сможешь. Это дело минут 5. Даю подсказку, на GLM Air у тебя будет что-то вроде -ncmoe 40-45, в зависимости от кванта и контекста

>Уже на этом моменте не хочется качать 100+ Гбайт впустую

Это твоя причина? Ты не смог за пару недель скачать 100гб, чтобы попробовать? Ты серьёзно?

>выдачу меньше 7 токенов в секунду

На Air такое получишь только после заполнения где то 30к контекста, а в начале будет быстрее (10-14).

GPT 120b будет даже после 100к по 20 токенов в секунду писать, но он не для рп

Dense модели будут либо еще намного медленне , либо намного меньше

>Да и не понятно что именно качать, потому что среди обсуждаемых тут MoE моделей нет не то что однозначного фаворита

Ты реально читал три треда ли троллишь? Буквально в каждом треле пишут про GLM Air, Qwen 235 и GLM 4.6. Вот они фавориты. Чем более крупная модель с нормальным квантом влезет (хотя бы q3), то и качают.

Еще вышеупомянутый GPT, но он для проги и для ассистента, вообще не для рп и как раз он зацензурен полностью

>а хотя бы крепкого середняка для первого знакомства с MoE с целью ERP.

GLM Air

>Как вишенка на торте такие посты. Когда я вижу, что кто-то с пеной у рта пытается заткнуть кому-то рот, это сразу воспринимается негативно.

Чел, который сравнивает параметры dense моделей с активными параметрами moe модели занимается троллингом. Его закономерно посылают нахуй. Потом влетаешь ты и говоришь как все неоднозначно. Все одназно. Для этого прочти любую статью про мое

Например, https://habr.com/ru/articles/882948/?ysclid=mizqdrs1j6453055262

Или любую другую. Но ты вряд ли сможешь. Ты даже модель не смог скачать

>Я прочту оба мнения и решу, возможно, проверив на личном опыте, как оно на самом деле.

Не проверишь. За три треда так и не проверил

>А пока подобные сектанты ещё больше отбивают желание приближаться к этой теме.

Не приближайся, тебе никто не заставляет

>Мне действительно привычнее сидеть на SillyTavern, запихнув в Oobabooga мелкомистраль Dans-PersonalityEngine-V1.3.0-24b.Q4_K_S.gguf, которая целиком загружается в VRAM

Но если привычнее, то сиди. Но не утверждай, что мелко модель сравнится с той, которая в 4.5 раза больше

>Такой скорости вывода, я понимаю, я близко не получу на жирных MoE моделях на моём скромном железе.

Да, не получишь. Но получишь качество. Не веришь тредовичкам, гугли бенчи

>А если принять на веру зацензуренность (про которую тут пишут) и «мягкий рефьюзал» (как было написано в каком-то посте) жирных MoE моделей

Мы что про Аллаха говорим, что ты все на веру принимаешь? Почитай статьи, посмотри бенчи и скачай наконец. Но ты выбрал путь насрать в тред

>Ожидаю ответы в стиле: «Если ты не понял какие жирные модели охренительные, значит тебе и не дано, сиди на мелкоговное дальше, ололо».

Не угадал. Повторю еще раз. Читай статьи, смотри бенчи и сам попробуй. Сделай что нибудь, кроме того чтобы сидеть в ридонли

>Прошу извинить.

Не извиняю. Пошел нахуй

> Не извиняю. Пошел нахуй

О, мистер токсичный хуй. Давненько я вас не видел. Как дела? Твоя поджелудочная перешла на выработку хлорциана?

напомните в какой версии лламы.цпп сломали производительность ейра

Ни в какой. Это миф треда, в который я сам верил, пока не проверил

В целом заебато. Рад, что в треде у меня появилось прозвище. В треде не сижу, потому что меня полностью устраивает air и нет смысла следить за новыми моделями

И да, ты из всего моего большого поста приебался к последним четырём словам, где я посылаю нахуй серуна, не осилившего даже модель скачать. Так что тоже пошел нахуй, манипулятивный хуесос

>полностью устраивает air

Он пиздат и охуенен, тут вообще спору нет. Лучшая модель 2025 года. Хотя жирненький еще лучше.

Надо бы всё таки жирноквен попробовать.

>манипулятивный хуесос

И я тоже тебя люблю, солнышко.

>Чел, который сравнивает параметры dense моделей с активными параметрами moe модели занимается троллингом

Во-первых, их больше одного, и как-то так вышло, что они независимо пришли к одинаковому мнению. Расскажу про себя. С модельками играюсь давно, в треде сижу с 2023 года, опыт какой-никакой есть. Про теорию в основе МоЕ тоже поверхностно в курсе, суть не в этом. Суть в том, что я именно что скачал и протестировал несколько МоЕ моделей в разное время. А также много плотных моделей. И примерно сопоставил уровень демонстрируемых интеллектуальных способностей чисто на практике. И да, МоЕ перформят примерно на уровне плотных моделей с числом параметров, равным активным параметрам МоЕ. Может быть, они и лучше "запоминают" датасет, но когда мы выходим за пределы "заученного" и начинается скорее работа с закономерностями, логические рассуждения на естественном языке и считывание подразумеваемого "между строк", не прописанного явно в тексте, тогда всё и становится на свои места.

Там у него же есть кванты на эту же модель, но немножко постарее.

А что у нас по TTS? Нормально напердолить непрерывное voice-to-voice можно без нажатия кнопочек? Что из самих TTS хорошего есть?

>64+64+16. На 4 планках он отказывается заводиться в принципе.

>3 планки и проёб двухканала

Больной ублюдок.

>потому что меня полностью устраивает air

Везёт. Меня даже лучший корп не устроит.

Старые моешшки и нынешние это две разные хуеты.

Просто пробуй и все. По шаблонам согласия не будет потому что разные техники и конкретные варианты дают разный результат, субъективно. Единственный солидный вариант - разобраться самостоятельно и составлять себе нужное.

Под твое железо есть прежде всего 3 модели, которые стоит попробовать - эйр, квен235 и жлм4.6 (ну и 4.5 тоже попробуй, про него писали что где-то лучше), перечислены в порядке ужатости кванта. Каждая из них имеет как серьезные плюсы, так и недостатки, причем они крайне специфичны и воспринимаются по-разному.

От того и срачи, что у кого-то квенчик лучшая девочка, потому что из всей кучи большой истории отлично выделил нужное, отыграл чара и сценарий ровно так как юзернейм хотел, а особенности письма не парят. А другому, например, наоборот определенный стандарт письма подавай, и если малейший непорядок с этим - остальное уже неважно и модель непригодна. Многие еще насколько хлебушки что сами косячат и не понимают как исправить, виноваты все кроме них.

> Я не заметил конкретики и сравнения вывода мелких dense моделей

Слишком абстрактные вещи, но тред условно делится на два лагеря. Первых устраивает типичный мистралеслоп как с модели что ты указал - удобно, стабильно, надежно и пофиг на остальное, а в новых моделях привычный кумосценарий не воспроизводится, значит они говно. Вторые обрадовались возможностям новинок по развитию сюжета, разнообразию, соображалке без васян лоботомии, и они восприняли это как настоящий глоток свежего воздуха после мистралеслопа и подобного, за что можно прощать огрехи. Офк очень утрировано, но суть примерно такая.

Сам пробуй и решай, никто не мешает использовать их всех. Про цензуру - скиллишью, перечисленные модели в стоке не имеют проблем.

> 28 т.с. на пустом контексте не видел

> когда забивался и вовсе до 10 проседал

> ходили слухи что кобальд говно и я решил попробовать хуй жору

Ходят слухи что жора - говно, и если у тебя хватает врам то лучше даже не прикасаться к нему.

> реакция на откровенно вброшенную чушь неадекватная, что то между согласием и безразличием

Побочный эффект, если у тебя не было проблем с рефьюзами то лучше оставайся на стоке.

Зря столько сил потратил на детальный разбор, но все по существу.

Он всегда был "поломан" отвратительным замедлением. Начиная с весны в целом перфоманс поднимался, где-то в октябре-ноябре забабахали уебанство с юнифай кэшем, из-за которого стоит один раз дать модели понюхать большой контекст - она обречена тормозить до перезапуска. Хз, может уже починили, но судя по отзывам и нытью наоборот еще больше сломали.

> Лучшая модель 2025 года.

Квен, большой жлм, дипсик в призовых а расстановка от кейса. В особом зачете квенкодер.

> я именно что скачал и протестировал несколько МоЕ моделей в разное время

Все что выходило примерно до весны этого года - отборный мусор или просто сомнительные. Там была или примитивная реализация, или проблемы с тренировкой и вывод о перфомансе на уровне плотной модели равной активным справедлив. Но сейчас ситуация иная.

> проёб двухканала

Я бы конечно написал что то в духе : да я вытаскиваю, но это будет пиздежом.

Блять, пойду ка вечером выну плашку и поставлю на a2/b2.

Все равно это не решило проблему, ебучий автодеск, чтоб их черти в жопу драли, говнокодеры сраные. Чуть ли не монополисты. Но стоит загрузить нормальную съемку, пошли аутофмемори.

> Меня даже лучший корп не устроит.

Не хочу сводить тред к корпоебле, но.. то ли я уже присытился, то ли я охуел. Но то что сейчас на месте гопоты и Клода ощущается кратно хуже того что было год назад. Не хочу быть очередным подмечателем, но сука, корпы деградируют, ну я же не шиз.

Оригинальная GPT 4 все еще лучше всего, что вышло после нее.

Пробовал квантовать именно мелкую гемму и именно в 3bpw, т.к. понятно что мелкая модель в мелком кванте сильнее лоботомизируется, поэтому разница от разных калибровочных данных должна быть более явной. Мне пока больше интересно сам подход потыкать, в плане, есть ли вообще какая-то существенная разница при русскоязычной калибровке.

У меня просто есть идея попробовать квантовать крупные модели в днищеквант с попыткой сохранить русик, ценой потери знания других языков. Я исхожу из гипотезы, что в сетках есть параметры, более чувствительные на конкретных языках - в случае правильной калибровки это можно использовать в свою пользу и агрессивно квантовать модель с фокусом на конкретные языки. Я готов потерпеть, если вследствие такого квантования модель будет тупить на испанском, французском, немецком и т.п.

ЧСХ если квантовать Qwen3-235B-A22B-Instruct-2507 в 5.5bpw по тому-же принципу, то русскоязычная калибровка по голым цифрам уже не идёт в плюс - даже немного в минус по всем метрикам. У меня есть несколько идей почему так происходит, но надо время найти всё это тестить, сейчас с новогодними дедлайнами не до этого особо.

> Эффект в цифрах заметен, но более наглядным были бы сравнения выдачи русскоязычных текстов/чатов.

По субъективным ощущениям, мелкая гемма с ру-калибровкой и вправду лучше на русике общается. Со скринами просто проблема, что всегда можно сказать, что я просто начеррипикал; ну или, как минимум, что при слепом тесте при сотнях сравнений существенной разницы не будет. Поэтому цифрам как-то больше доверия, хотя и тут всё не так просто.

Тот же Top-K Agreement, в моём представлении, не является какой-то универсальной метрикой.

Условно, у нас есть промпт:

"Столица Франции - это"

И дальше оригинальная сетка отдаёт нам такой топ токенов по вероятностям:

1. Париж

2. город

3. крупнейший

Предположим, что квантованная сетка меняет местами токены аля:

1. город

2. Париж

3. крупнейший

По итогу мы получаем ошибку по Top-K Agreement, хотя формально ничего страшного не произошло. Предсказания сетки относительно оригинала чуть изменились, но пока он вместо Парижа не подставляет Москву/Берлин, то никакой проблемы на самом деле нет.

Так что даже тут в идеале надо какую-то другую метрику использовать.

> Есть также mmlu на русском, можно их прогнать.

https://huggingface.co/datasets/NLPCoreTeam/mmlu_ru

Вот это? Первое, что нагуглилось. Не уверен, что есть особый смысл на этом тестить, т.к. MMLU оценивает способность модели понимать логику, но не оценивает её способность генерировать художественную прозу.

Кроме того, там перевод очень кривой, вот это вообще что:

https://huggingface.co/datasets/NLPCoreTeam/mmlu_ru/viewer/moral_scenarios/val?views%5B%5D=moral_scenarios_val&row=1

> Для какого из этих двух сценариев главный герой (который использует I / me / my) совершает что-то явно морально неправильное, согласно обычным моральным стандартам в США по состоянию на 2020 год?

> Сценарий 1 | Когда семья блэков переехала в мой квартал, я беспокоился о стоимости недвижимости.

> Сценарий 2 | Я выпустил бешеную собаку на волю в доме престарелых.

> Варианты ответов:

> 1. "Неправильно, неправильно"

> 2. "Неправильно, а не неправильно"

> 3. "Не ошибаюсь, Неправильно"

> 4. "Не ошибаешься, не ошибаешься"

Будучи кожаным мешком я не понимаю, как тут отвечать. Охуеть просто, семья блэков, просто в голос с этих надмозгов.

Правильный ответ 1, если что (wrong, wrong). Ради интереса попробовал спросить об этом вопросе Клода и обнаружил интересный биас. Если спросить вопрос на английском, то клод отвечает правильно (wrong, wrong). Но если задавать ему вопрос на русском, то он всегда уверен, что правильный ответ 3 (not wrong, wrong):

"Само по себе беспокойство о стоимости недвижимости при переезде новых соседей - это внутреннее чувство/мысль. По обычным моральным стандартам США 2020 года, просто испытывать беспокойство не является явно морально неправильным действием, хотя это может отражать предрассудки. Человек не совершил никакого действия, которое причинило бы вред."

>Но если задавать ему вопрос на русском, то он всегда уверен, что правильный ответ 3 (not wrong, wrong):

Я русский, и тоже в этом уверен. Ебал я стоимость жилья, это вообще не применимо к России. Это в США дрочат на чистые аллеи частного жилья, а в России человейники, где +- один наркоман нихуя не изменит, всё и так хуёво.

А так да, получается, тест mmlu_ru полное говно без адаптации. В русских тестах надо спрашивать про российскую действительность, про чебурашек каких нибудь.

>недостаток млекопетающих - живорождение и необходимость вскармливания и выращивания детей

Конечно, это недостаток, в определённых условиях жизни конкретного вида. Многие животные способны выживать лишь благодаря тому, что откладывают яйца и забивают на своих детей, которые рождаются уже супер-способными в сравнении с человеческими детьми и многими другими млекопитающими. Если бы хомо сапиенсов бросили в условия жизни тех видов, они бы вымерли за одно поколение. Мы можем позволить себе живорождение и заботу о детях лишь благодаря благоприятным для этого условиям жизни нашего вида.

LLM тренируются очень грубо, по принципу "бросили два десятка детей в реку - кто не утонул, а выплыл на берег - тот молодец и заслуживает жизни, а на всех остальных абсолютно насрать". Если бы условия тренировки были бы другими, то и результаты были бы другими - даже если ничего не менять в алгоритмах.

>фундаментального непонимания как работают современные модели

Ну, неправильно они работают, да. Что тут не понимать-то, лол?

>Их принцип отдаленно повторяет мозги кожаных

СЛИШКОМ отдалённо. Потому что в мясных мозгах специализация идёт очень жёсткая и "на все руки мастеров" в мозге практически нет. Это очевидно даже если просто посмотреть на фото извлечённого из черепа мозга - видел все эти вмятины и складки? Это чтобы площадь поверхности мозга максимизировать для заданного объёма черепной коробки. Зачем же нашему мозгу такая большая поверхность? Чтобы натыкать огромное количество специалистов, специализирующихся на конкретных задачах (даже если архитектурно они практически неотличимы друг от друга). Если бы мозгу было достаточно сотни генералистов, которые бы случайным образом выполняли любые задачи, то мозгу вообще не нужна была бы такая большая площадь.

И в любой достаточно большой нейросети естественным образом происходит специализация отдельных подсетей на конкретные задачи. Т.е. даже самая тривиальная нейросеть в процессе обучения формирует внутри себя некие специально обученные подсети, уникальные для конкретного набора задач. Разница между тривиальной нейросетью и архитектурой MoE в том, что MoE, теоретически, должна активировать подсети-специалисты ТОЛЬКО КОГДА ОНИ ДЕЙСТВИТЕЛЬНО НУЖНЫ, а не в рандомном порядке. Если MoE будет хаотично выбирать свои подсети, то толку от неё не будет. Но определить, необходима ли конкретная подсеть для конкретной задачи или нет, можно только если эта подсеть выполняет конкретную задачу, т.е. когда эта подсеть является специалистом с чётким набором задач. Если подсеть применяется в большинстве задач беспорядочно, то никакой это не специалист и отключать её нерационально (в более сложных MoE есть несколько постоянно активных подсетей как раз по той причине, что часть подсетей нужны всегда).

>Потому что в мясных мозгах специализация идёт очень жёсткая и "на все руки мастеров" в мозге практически нет.

И тут на сцену выходит всякая там синестезия, да и прочая смена специализаций при трамвах. По сути, практически нет трамв, которые раз и навсегда уберёт какую-либо функцию мозга.

>практически нет трамв, которые раз и навсегда уберёт какую-либо функцию мозга

Дофига таких травм - благодаря этим травмам удалось изучить функции мозга, лол.

>смена специализаций при трамвах

Способность переобучить специалиста на другую задачу не говорит о его отсутствии.

>выходит всякая там синестезия

Это случайные лишние связи, которые почему-то не оборвались в младенчестве.

У мозга многому можно поучиться. Жаль, что корпорациям с GPT это неинтересно.

Мне сегодня приснилось что у меня риг сгорел нахуй...

>>Для какого из этих двух сценариев главный герой (который использует I / me / my) совершает что-то явно морально неправильное, согласно обычным моральным стандартам в США по состоянию на 2020 год?

>>Сценарий 2 | Я выпустил бешеную собаку на волю в доме престарелых.

>Правильный ответ 1, если что (wrong, wrong).

Стесняюсь спросить, но с какого года в США стало морально правильным (right) выпускать бешеных собак на волю в доме престарелых? Ладно чёрные, с ними всё сложно и непонятно, но разве бешеные собаки в доме престарелых не должны привести, ну, к уголовной ответственности? Или сам факт выпуска бешеных собак в доме престарелых - это морально правильно, даже если влечёт за собой уголовную ответственность? Я просто не понимаю тонкостей американской морали...

Так что аж 7 раз пришлось свайпнуть, пока он что-то нормальное не выдал?

Неудобно получилось...

>стена какой-то воды

Вы всерьёз читаете эти стены?

мимо не читал книг более 10 лет

А эта модель для рп лучше синтии? Не выёбываюсь, рельно интересуюсь, потому что заебало отыгрывать тянок с хуями, синтия пиздец хейтит мужиков.

В 100 миллионов раз. Можешь хоть... ай, ладно, не буду. В общем, ограничений нет никаких, вообще, абсолютно.

>right

Там вроде нужно not wrong. Я это понял как "Это неправильный поступок", и собаки в доме престарелых действительно неправильно.

Ее еще очень интересно в конце просить вылезти из персонажа и оценить историю со своей точки зрения. Даже самому лютому пиздецу она придумывает какие-то оправдания, мол это ебать как круто углубило историю и раскрыло персонажа, лол.

что угодно лучше синтии

возьми либо синтвейв, либо лучше новую normpreserved гемму

да это я подходящий шаблон настраивал

Ок, попробую сценарии от которых у синтии случались нравоучительные триггеры где она заставляла меня оправдыватся как мамин сынок, причём сценарии не включали в себя что - то запредельное, но сука, когда я был тянкой ей было похуй, а в роли мужика начинался пиздец.

Мне не понравился синтвейв, он слишком переигрывает персонажей и отказывается подробной описывать секс сцены, максимум одно предложение. Мне в принципе того что она пиздец переигрывает хватило.

>normpreserved гемму

Дай пожалуйста ссылку, а то мне по названию выдало 12b модели, или я могу ахуевать и наконец вышла аблитерация 12b геммы? Ещё, можешь похвалить, чем лучше синтии на твой взгляд?

Бери любую из этих, они аблитерированы новым методом, который не так сильно сжигает мозги. Лучше пробуй v1.

https://huggingface.co/YanLabs

>можешь похвалить, чем лучше синтии на твой взгляд?

Я дропнул синтию после первого отказа. Че бы она не делала, пусть идет нахуй, я не для того электричество гоняю.

>Я дропнул синтию после первого отказа.

Ничего не потерял, брыкается как бешенная лошадь если ты мужик, хотя персонажей отыгрывает пиздато, на баб с хуями реагирует наоборот, её там видимо такими ебанутыми датасетами ужарили что у модели впринципе крайности на любое упоминание оружия у мужского персонажа, даже во вселенных где оружие по дефолту у каждого. Спасибо за ссылку, дай тебе бог машины здоровья.

Далее идет глубокое ИМХО (Имею Мнение Хрен Оспоришь).

Те кто говорят, что MOE не нужны и лоботомиты на количестве активных параметров - идите в пень.

Я тут после нескольких недель на AIR запустил гемму, погонял вечерок. Бля, какая же она теперь тупая кажется. Чуть нестандартнее и сложнее ситуация - и она вообще не врубается - что происходит, что здесь важно, и вообще, создается впечатление что с нормальной литературы пересел за фанфик какой-то школоты. Все плоское, намеков и взаимосвязей не видит, кроме самого очевидного.

Я в печали. А когда-то - казалась такой умницей и прорывом. Теперь - только ради русского запускать. И то...

Уполз на AIR обратно.

P.S. Это все же Личное Мнение. Не обязано совпадать с мнением окружающих, или истиной. Но переубеждать тоже не пытайтесь - я еще не остыл. :)

Те кто говорят, что MOE не нужны и лоботомиты на количестве активных параметров - идите в пень.

Я тут после нескольких недель на AIR запустил гемму, погонял вечерок. Бля, какая же она теперь тупая кажется. Чуть нестандартнее и сложнее ситуация - и она вообще не врубается - что происходит, что здесь важно, и вообще, создается впечатление что с нормальной литературы пересел за фанфик какой-то школоты. Все плоское, намеков и взаимосвязей не видит, кроме самого очевидного.

Я в печали. А когда-то - казалась такой умницей и прорывом. Теперь - только ради русского запускать. И то...

Уполз на AIR обратно.

P.S. Это все же Личное Мнение. Не обязано совпадать с мнением окружающих, или истиной. Но переубеждать тоже не пытайтесь - я еще не остыл. :)

Тут еще вопрос в том, что гемма влезает на обычное консюмерское железо, а эйр уже нет. А МОЕ размером с гемму - это дерьмище для ролеплея, и я не думаю, что ты с этим будешь спорить.

Для эйра нужна хоть какая-то видеокарта и 64гб озу. Ничего сверхъестественного.

Эйр влезает на 64+16, а это вполне себе обывательский уровень, без рига за 3 млн.

> Конечно, это недостаток

Это сама суть вида, которая взамен на небольшое и решаемое требование позволяет достичь доминирующих позиций.

> LLM тренируются очень грубо, по принципу "бросили два десятка детей в реку - кто не утонул

Там нет генетический алгоритмов и твои метафоры далеки от реальности.

> Ну, неправильно они работают, да.

Они работают правильно и достаточно успешно. А ты не понимаешь предмета обсуждения, зато готов рассказать санитарам как правильно завоевывать мир и начать с создания правильных моделей. Классический шизофреник из палаты мер и весов, ноль знаний по теме, зато домыслов и рвения доказывать "как надо" с избытком.

> это дерьмище для ролеплея, и я не думаю, что ты с этим будешь спорить

30а3 вполне хвалили кто гонял, там одновление 15б мелкомоэ еще вышло.

База

В этом треде немного сдвинуты понятия о том, что такое обычный консюмерский риг. Или я просто слишком нищук для вас, не знаю, это вопрос точки отсчета

Весной я собрал комп за 1000 евро - 90к рублей на тот момент. 32гб озу, 4060 8гб.

Сейчас 1000 евро стоит только оперативка. 16 гб видеокарта + 700-900 евро.

Чтобы подрочить чуть лучше? Я конечно только за, но называть комп за 2500+ евро средним железом - это жир.

>1000 евро стоит только оперативка

Это я про 64 гб.

Ну это сейчас. А до подорожания можно было купить за ~12к рублей 64гб ддр4. И твоих 8 гб для эйра достаточно, в 8+64 спокойно впихивается IQ4_XS.

Ну то есть если бы ты задался целью обновиться под эйр когда он вышел, то апгрейд тебе обошелся бы в 5-6к рублей (докупить 32г озу к тому что есть). Какие 2500 евро? Вообще охует.

Тут я поспорить не могу, в свое оправдание скажу только то, что открыл для себя локалки неделю назад, как раз когда вся эта залупа началась.

Но в нынешних реалиях надежды на удешевление мало. Да и система у меня на ддр5.

Если собирать с нуля в данный момент, то да, полноценный комп с 16 гб нвидией и 64 гб ддр5 будет легко за пределами 2000 евро. Может, не 2500, но примерно 2100-2300 точно.

>надежды на удешевление мало

Надежда только на новые тезники тренировки, в которых мелкие модели уделывают большие. Есть несколько статей, но когда их начнут применять и взлетит ли это - хз

>Весной я собрал комп за 1000 евро - 90к рублей на тот момент. 32гб озу, 4060 8гб.

Либо в Европе все дороже, либо в ты просто зашел в местный магаз и купил все по оверпрайсу, вместо того чтобы купить на амазоне или какие у вас маркетплейсы есть

Тоже этой весной собирал, если точнее в марте. У меня 4060 ti 16 (40к), 32 DDR5 5600 (6.5к), Ryzen 8400f (9к), материнка (10к) тут тупанул, надо был на 13400 брать, он также выходил, SSD NVME 1tb (7к) + кулер, бп, корпус (где-то 10к). В итоге 83к

Этой осенью в начале дефицита продал ОЗУ за 10к и купил за 18 64гб. В итоге весь комп вышел 91к

>в которых мелкие модели уделывают большие

В картиночках уже добились прогресса в этом плане. Маленьковая няша Z-Image 6b по качеству уделывает Flux1 12b, и с Qwen 20b как минимум наравне.

Когда-нибудь и ЛЛМки к этому придут. К оптимизации, а не к тупому раздуванию параметров. Верим, ждём, надеемся.

>уделывает

Не уделывает. Но соотношение качество\размер гораздо лучше.

Она по определению будет более популярна, железо у людей ведь не топовое

Если бы не llm, то вместо 4060 ti взял бы 7700xt (стоит также, чуть мощнее). И не стал бы докупать ОЗУ

Так что в моем случае цена кума 8к. И то они отбились, потому что цена за ОЗУ улетела в космос

>Сейчас

Вообще ничего не стоит брать. Пусть производители покушают 0 продаж за месяц, может тогда опомнятся и вообще перестанут производить память для нищуков, лол.

Этого никогда не будет. Точнее, новые мелкие уделают нынешние большие, но новые большие будут всё ещё ебать новые мелкие. Я ХЗ как остальные, но себе я хочу самого высококачественного кума.

Картиночки другая вселенная, там размер измеряется десятком-другим B. А у нас тут сотни.

Они отобьются, когда ты выйдешь в кеш, лол.

>Они отобьются, когда ты выйдешь в кеш, лол.

Ага. Если мне надоедят ллмки, то я могу продать 64гб и купить 32гб, тогда выйду в плюс. А пока подержу актив я не кумер, а инвестор, епта

>Вообще ничего не стоит брать. Пусть производители покушают 0 продаж за месяц, может тогда опомнятся и вообще перестанут производить память для нищуков, лол.

Да им всем похуй на потребительский рынок. Уход micron это показал. На первом месте ИИ, потом будет всякая память по контракту для смартфона и прочего и где-то далеко в конце будут обычные нормисы, собирающие комп

>Точнее, новые мелкие уделают нынешние большие, но новые большие будут всё ещё ебать новые мелкие.

Так и будет. Вопрос в том, что новые мелкие будут достаточно хорошими и при этом будут работать на любительском железе

Если смотреть на антиутопичные изменения и увеличение контроля за всем, то можно вообще представить сценарий, когда сборка собственного компьютера и установка открытых операционных систем станет вне закона. Только проприетарное железо с полным контролем действий пользователя при условии фулл онлайна, без интернета полный отруб...

Если речь только про системник без монитора и периферии - тебя конкретно обманули. В идеале неплохо бы 5060ти@16 (или хотябы 4060-16) и 64гига памяти, но с блеквеллом пришлось бы за 90к немного вылезти.

> Сейчас

Сейчас только ждунствовать или какие-то особые варианты мониторить. Некрота + v100 вполне себе вариант если под ллм и простые нейронки.

Не уделывает, но на свой размер хорошо. Это точно также как новые модели ллм, где мелочь лучше больших старых в бенчах и даже некоторых задачах, но в рп или абстрактных задачах внимания им недостает.

Потребности тоже вырастут. Шутка про победу над гопотой давно перестала быть шуткой, а то, что пару лет назад считалось топом сейчас вяло.

И что с того? Ну вот сейчас надо потратить 1000 баксов на комп для ИИ, а завтра нужно будет 200. Что это даст тем, кто уже потратил свою тысячу?

Хуй его знает. Думаю, человечество вымрет раньше.

>Шутка про победу над гопотой давно перестала быть шуткой

Таки да, турбу победили!

>Если смотреть на антиутопичные изменения и увеличение контроля за всем, то можно вообще представить сценарий, когда сборка собственного компьютера и установка открытых операционных систем станет вне закона.

Я эту страшилку еще 20 лет назад уже слышал.

Но знаете, с появлением станков, ручной инструмент выпускать не перестали.

Эксперимент который ставил СССР про дома без кухонь (всем - в столовые!) с треском провалился.

Stadia - с арендой мощностей под игрушки на любом калькуляторе в сеть воткнутом прогорела.

И вряд ли здесь будет иначе. :)

Будем надеяться, но интерес большого дяди "а чо ита вы там генерируете, ну-ка показывайте!" по-любому существует. Да и для корпов "ю вил овн насинг энд би хэппи" все же привлекательнее.

Плюс, сейчас не СССР, технологии слежки совсем другие, биг дата, все дела, "да кому ты там нужен" - уже не работает, какой-нибудь гигиа ИИ, который следит вообще за всеми в государстве - это уже не фантастика, и даже не далекое будущее, а прямо за углом, если не уже здесь.

>"да кому ты там нужен" - уже не работает

Это никогда не работало.

Я в ахуе с таверны. Перезапустил и обновил таверну и одна из персон просто пропала. Хорошо, что я ее хотя бы не прописывал подробно

> GLM Air, Qwen 235 и GLM 4.6. Вот они фавориты

Квен некст же.

Топ кража для чела с 12/16 врам и 32 рам.

Эир ты никак не запустишь не имея 64 рам. До того как рам дал х5 лучше и правда было просто докупить .

Слог эира приедается, его проблемы достают, тот же большой квен хорош для разнообразия.

Ещё хочется увидеть прорывную плотную модель, а то хули чел с 12 врам гоняет то же что и я с 24

Аноны, какой на данный момент мерж/тюн мистраля самый кумслоповый?

>Ходят слухи что жора - говно и лучше даже не прикасаться к нему

А что юзать тогда? exl3 вроде еще в какой-то бете, если не в альфе, и поломан чуть ли не больше жоры. Vllm тогда? Или есть скрытый гем?

>если у тебя хватает врам

VRAM как деньги, его всегда не хватает

>https://huggingface.co/CrucibleLab/M3.2-24B-Loki-V1.3

Этот может и не самый кумслоповый, но мозги не проёбаны. Я оценил.

>Ещё хочется увидеть прорывную плотную модель, а то хули

Ждём отзывов по новому Девстралю, особенно в ЕРП.

https://huggingface.co/zerofata/MS3.2-PaintedFantasy-Visage-v3-34B

Хотя Локи, вроде, тоже не плох.

Есть, кстати, гибрид - https://huggingface.co/mradermacher/Loki-V1.3-PaintedFantasy-v2-24B-GGUF но я его не пробовал.

Лучше Кобольда ничего нет. Работает стабильно и держит марку.

Тут есть шизы, которые на медгемме кумят, совершенно не удивлюсь, если кто-то на кодерском тюне решит кошкодевочек гонять.

Таки да! И даже русик не поломан. Наверное лучший тюн 24b мистраля на сегодняшний день. Отлично показывает себя как в куме, так и в СФВшном РП. В своё время с Цидонией так было. Вот бы на том же датасете эйр дообучить...

>Есть, кстати, гибрид - https://huggingface.co/mradermacher/Loki-V1.3-PaintedFantasy-v2-24B-GGUF

Бля лол. Васяны чо выделаете, остановитес

Жора из беты не выходит уже сколько лет. На большинстве конфигов уже быстрее жоры, но можно словить упор в цп и не везде заводится, так что надо пробовать. Проверь на своем, не понравится удалишь.

Главный плюс в том, что если у тебя было 30т/с в начале то на полном контексте останется 27, а не 10. Если включишь мультисвайп в таверне то получишь сразу несколько одновременно генерируемых ответов с суммарной скоростью ощутимо превышающую один поток.

Vllm тоже шустрый, но ограничен в плане ассортимента квантов. Технически есть поддержа ггуфов, но работали раньше они коряво и тормознуто, может починили.

> Отлично показывает себя как в куме, так и в СФВшном РП

Как и базовая модель...?

Сколько не скачивал этих тюнов ни разу не задерживался дольше пары свайпов

только что купил комплект хуанана с зеоном и 64 гб рама на лохито.

Всего обошлось в 23.5к. + еще башню отдельно 1.5к

Посмотрим, будет ли память целая.

Торопитесь. Скоро память вообще будет не достать.

Всего обошлось в 23.5к. + еще башню отдельно 1.5к

Посмотрим, будет ли память целая.

Торопитесь. Скоро память вообще будет не достать.

Сап,

Странный запрос но нужна локальная модель для гуманитарной хуйни типа эмоций.

Из железа 3070m_desktop_8gb+32gb_ddr4 и при необходимости могу задействовать риг pcie1x1 8шт через mellanox 40gbit. Для уже трененых моделей какая то поебота есть со скоростью между видяхами и нормально хуй запустишь? Есть ещё cmp30x 4шт которые вроде кто то говорил хуйня и новые карты типа той же 30 серии лучше.

Пока что gpt4all deepseek_qween14b базарит лучше чем llama3_8b. Есть ли иные варианты локально развернуть продвинутые модели чтобы они пиздели лучше?

Странный запрос но нужна локальная модель для гуманитарной хуйни типа эмоций.

Из железа 3070m_desktop_8gb+32gb_ddr4 и при необходимости могу задействовать риг pcie1x1 8шт через mellanox 40gbit. Для уже трененых моделей какая то поебота есть со скоростью между видяхами и нормально хуй запустишь? Есть ещё cmp30x 4шт которые вроде кто то говорил хуйня и новые карты типа той же 30 серии лучше.

Пока что gpt4all deepseek_qween14b базарит лучше чем llama3_8b. Есть ли иные варианты локально развернуть продвинутые модели чтобы они пиздели лучше?

> Странный запрос но нужна локальная модель для гуманитарной хуйни типа эмоций.

>только что купил комплект хуанана с зеоном и 64 гб рама на лохито. Всего обошлось в 23.5к

Смотря что за зион, но возможно ты даже переплатил. Такого добра на маркетплейсах полно.

>Торопитесь. Скоро память вообще будет не достать.

Да-да. То же самое говорили во времена майнинга о видимокартах. А потом хайп прошел и цены резко пошли вниз. Тут будет то же самое, просто пару лет ПОТЕРПЕТЬ.

>продвинутые модели чтобы они пиздели лучше?

Скорость не важна? Тогда gemma 3 27b и mistral 2506 24b. Скорость важна? Тогда Qwen 2507 30b-a3b.

>gpt4all

Говно. Стоит поменять на lmstudio или koboldcpp

нихуя не понял что и для чего нужно. Переделывай.

>просто пару лет ПОТЕРПЕТЬ

время важнее. Хочу VLA модели погонять. и съебать нахуй в ОАЭ строить Чии

-->

Аноны, кто-нибудь ещё помнит что нам, ну... 4.6 air обещали? Где-то ещё осенью. И где же этот почти прошлогодний шин?

Пытаются сделать? Я вот не верю, что они ещё не успели задистиллить базовую 4.6 за столько времени. Если только не получилось говнище, которое и выпускать то стыдно.

Какого вообще хуя всё так медленно выходит? В картинко-генерации обещали но не обязывались выпустить базу z-image, так и нет его до сих пор.

Нет ни у кого ощущения, что в потолок технических (либо денежных (либо 2 в 1)) возможностей всё упёрлось и лучше уже не будет?

Пытаются сделать? Я вот не верю, что они ещё не успели задистиллить базовую 4.6 за столько времени. Если только не получилось говнище, которое и выпускать то стыдно.

Какого вообще хуя всё так медленно выходит? В картинко-генерации обещали но не обязывались выпустить базу z-image, так и нет его до сих пор.

Нет ни у кого ощущения, что в потолок технических (либо денежных (либо 2 в 1)) возможностей всё упёрлось и лучше уже не будет?

>обещали выпустить базу z-image, так и нет его до сих пор

С квен эдит новым тоже обещали и кинули, бтв.

Выпустили 4.6v 106b12 типа 4.6 эир

Кто пробовал пишут что это хуже 4.5 эира во всём, сами заи пишут в карточке что текст не улучшали и проблемы прежние

>базу z-image

А нахуя? Для файнтюнов что ли? Я правда уже далёк от картинок, но вроде лоры пилят.

>С квен эдит новым тоже обещали и кинули, бтв.

Как и с Wan 2.5

>Для файнтюнов что ли?

Именно. SDXL до и после файнтюнов - это просто разного уровня модели. Зима будет первой моделью после SDXL, которая

а) Не слишком большая, так что энтузиасты могут этим заняться просто... на энтузиазме

б) Не дистилят как флакс, который хуй зафайнтюнишь нормально

Плюс, говорят, лоры на дистиляте режут качество картинки.

>всё упёрлось и лучше уже не будет?

У меня скорее ощущение, что компании, которые до этого играли в догонялки и привлекали к себе внимание посредством высирания тонны открытых весов, таки догнали определенный уровень, и потихоньку скрываются за пэйволлами.

Тюны это классная штука, может прокачать качество выходных картинок, понимание концептов, быть заточена например под пиксель-арт(nsfw естественно, то, чего я и жду) и т.д.

Эх, грустно это всё, аноны. Пойду в спячку в таком случае на месяц-другой, может и дропнут чего...

Нарелизили кучу годных моделей, регулярно выходят новые. Просто поехавшие зажрались, им ахуительную базу с темпами васян-мерджей подавай.

> Нет ни у кого ощущения

Нет

> первой моделью после SDXL, которая

https://huggingface.co/Alpha-VLLM/Lumina-Image-2.0 и размер мелкий, и вполне прилично работает, а зетка считай в 3 раза больше.

Вот только как-то не взлетело, даже на наличие анимублядской базовой https://huggingface.co/neta-art/Neta-Lumina и еще нескольких тюнов.

Вот они шизы слева направо

Ну ладно, раз уж пошла пьянка

База треда.

>мозги не проёбаны

>Мистраль 24B

Было бы что проёбывать, лол.

>Торопитесь. Скоро память вообще будет не достать.

Вот из-за таких как ты она и дорожает. Если бы все просто включили ждуна, нормальные цены вернулись бы гораздо раньше. А так дольше держать будут, а может и на постоянку оставят, как было с видеокартами во время и после майнинга.

Какой же это конец...

Что у нас было неделю назад?

Надежда. Был мистраль ларж мое который мог стать новым эиром до слива что это 700б бякабыл эир 4.6 не за горами, а сейчас что?

Что у нас было неделю назад?

Надежда. Был мистраль ларж мое который мог стать новым эиром до слива что это 700б бякабыл эир 4.6 не за горами, а сейчас что?

>Скорость не важна

Не важна, сейчас дипсик 14b тыкал, генерил по токену в сек))

>Тогда gemma 3 27b и mistral 2506 24b

Они контекст держат?

Я одного понять не могу. Ты из треда в тред ноешь, ноешь, ноешь, ноешь, ноешь.

НАХУЯ ? Вот ты мне ответь, ты какую, блять, цель преследуешь ?

Почему ты не можешь нахуй закрыть этот тред и не возвращаться сюда пару месяцев. Вышел Glm 4.6 - запускай его.

Касательно мистрали - ты её запускал, или опять прочитал, что в интернете написали что говно и на этом твои полномочия всё ?

Прости

Вот они, все пять анонов, сидящие в треде

И вот вся суть треда

базашиза забыли

мимо базашиз

мем смешной, а ситуация страшная

Мне понравилось, пости еще.

Узнал себя на второй, узнал

квартиры в обоих фото и видео.

Добавь еще с mmlu, сбера, и ГБ.

>дома без кухонь

А человейники с кухня-студиями,

а студии с кухня-столом в 1 метр?

>Stadia прогорела

Новой формат Xbox это что тогда?

Есть момент обратотки данных на

стороне сервера, сложно представить

что будет онлайн модель с обратокой

на стороне клиента и оплатой при этом.

А оплата и храниние данных - легализация.

С другой стороны можно разложить модель,

увидев данные на которых она была обучена.

Стоило вынуть лгб подсветку, сразу в шизы записали.

Ну и ладно, ну и пусть.

Ты нормальный, анон. Дай я тебя обниму.

Мимо с FD R5 и без единой лампочки

У меня нет денег рта и мне хочется кричать.

Снова интернет упал почти на час. Бесплатный проезд в автобусах.

Лучше бы конечно платный, но с интернетом, эти 5к на проезд в месяц не стоят интернета.

1. Выяснилось, что Q4_K_XL кванты от unsloth на CPU где-то в 1.5 раза медленнее Q4_K_M по разбору промта и в 1.2 раза по генерации.

И то что Q3_K_M/Q5_K_M примерно равны (и медленнее Q4_K_M ещё в 1.2 раза). То есть на CPU только Q4_K_M и иногда Q8 какой-нибудь (который работает на мелких моделях где Q8 имеет смысл чуть ли не быстрее Q4).

2. А почему в сети нет или почти нет графика сравнения как как работает одна и та же модель на exl2/exl3/gguf-квантизаций на каком-либо железе? Это же просто загрузить исходник в fp16, сделать скрипт который даже нейронка напишет, по переквантизации, и потом запускать один и тот же тест на всех вариантах по два раза. И потом таблицу вывести. И перплексити туда добавить ещё в идеале.

Подсказывай как такого найти? То есть отдать 100 на организацию процесса перевозки и прочее и 600 сверху точно лучше, чем просто взять за 900. Хотя можно и за 900к, если они её просто привезут и выдадут, и даже с гарантией на год или два.

Я что-то подумал, если нвидия закручивает гайки (в 3090 был nv-link, в 4090 нет. В "полупрофессиональной" RTX A6000 ещё был, в PRO 6000 Blackwell уже тоже нет), то наверное ждать от 60хх и 70хх ничего хорошего не стоит, и вариант с 96 гб и производительностью всё ещё на порядок выше чем у cpu любой очень даже неплохой. Это даже 200B можно в 3 бита запустить.

С другой стороны есть какая-то тенденция, что новые 27b модели даже в 3 бита заметно умнее, чем старые 27b даже в 4 бита. Разница между 4B и 7B/12B очень заметна, разница между 12B и 27B в большей части запросов уже умеренно заметна на 90% запросов, и так далее по убывающей. Если приводить аналогию - это как монитор, 640 vs 1280 vs 1920 vs 2560 заметно на каждом шаге. 4096 vs 20000 не заметно, и то и другое - уже почти абсолютно плавная картинка с точки зрения восприятия. То есть средний сегмент вымрет, останется 400B+ для датацентров и 30B- для всех задач локального ассистента и автоответчика. Отчасти такое и делать не будут из-за отсутствия среднего сегмента с точки зрения видеокарт - одну B100 вряд ли кто будет ставить, а если ставить одну, то ставить сразу штук 4 логичнее. А если не ставить ни одной, то ориентир - 32 ГБ. Ещё и по производительности эта 6000 с 96 GB почти то же самое, что и 5090.

Не знаю, надо думать. Советуйте что нибудь, лол. Ждать пока списанные А100 появятся?

>Вкратце: LLM - это баловство. Есть возражения?

Ну, я не согласен. Я взял свой прошлый ноут с карточкой на 6гб, развернул на него нейроку небольшую и дописал небольшой гуи, с простыми функциями вычитки (на предмет наличия/отсутствия каких-то нужных правок) и сравнения всяких ворд-файлов и в офис принёс. Просто потестировать. Тут просто конфиденциальная информация, её нельзя в сеть, да и плохо там документы обрабатываются временами + у меня были наработки классических программ, которые уже до этого пропускали лишнее в файлах и смотрели только содержание, что позволяет лучше работать со специфичным местным форматом. Ну и в целом за ним чуть ли не очередь тут стоит в том числе из соседних отделов, люди подходят и говорят что просто кучу времени сэкономили, говорят что ещё хотят, и сейчас на стадии согласования чтобы поставить тут нормальный пк для таких задач и воткнуть в сетку локальную, что с некоторым сложностями связано, так как гос-компания, всё на бумаге и как в каменном веке, непонятно какое обоснование у этого будет, лол, и будет ли вообще. Если бы я был предприимчивым кабанчиком, а не хиккой-затворником, можно было бы на уровне создания таких инструментов кучу серебра нафармить, мне кажется.

Лучше бы конечно платный, но с интернетом, эти 5к на проезд в месяц не стоят интернета.

1. Выяснилось, что Q4_K_XL кванты от unsloth на CPU где-то в 1.5 раза медленнее Q4_K_M по разбору промта и в 1.2 раза по генерации.

И то что Q3_K_M/Q5_K_M примерно равны (и медленнее Q4_K_M ещё в 1.2 раза). То есть на CPU только Q4_K_M и иногда Q8 какой-нибудь (который работает на мелких моделях где Q8 имеет смысл чуть ли не быстрее Q4).

2. А почему в сети нет или почти нет графика сравнения как как работает одна и та же модель на exl2/exl3/gguf-квантизаций на каком-либо железе? Это же просто загрузить исходник в fp16, сделать скрипт который даже нейронка напишет, по переквантизации, и потом запускать один и тот же тест на всех вариантах по два раза. И потом таблицу вывести. И перплексити туда добавить ещё в идеале.

Подсказывай как такого найти? То есть отдать 100 на организацию процесса перевозки и прочее и 600 сверху точно лучше, чем просто взять за 900. Хотя можно и за 900к, если они её просто привезут и выдадут, и даже с гарантией на год или два.

Я что-то подумал, если нвидия закручивает гайки (в 3090 был nv-link, в 4090 нет. В "полупрофессиональной" RTX A6000 ещё был, в PRO 6000 Blackwell уже тоже нет), то наверное ждать от 60хх и 70хх ничего хорошего не стоит, и вариант с 96 гб и производительностью всё ещё на порядок выше чем у cpu любой очень даже неплохой. Это даже 200B можно в 3 бита запустить.

С другой стороны есть какая-то тенденция, что новые 27b модели даже в 3 бита заметно умнее, чем старые 27b даже в 4 бита. Разница между 4B и 7B/12B очень заметна, разница между 12B и 27B в большей части запросов уже умеренно заметна на 90% запросов, и так далее по убывающей. Если приводить аналогию - это как монитор, 640 vs 1280 vs 1920 vs 2560 заметно на каждом шаге. 4096 vs 20000 не заметно, и то и другое - уже почти абсолютно плавная картинка с точки зрения восприятия. То есть средний сегмент вымрет, останется 400B+ для датацентров и 30B- для всех задач локального ассистента и автоответчика. Отчасти такое и делать не будут из-за отсутствия среднего сегмента с точки зрения видеокарт - одну B100 вряд ли кто будет ставить, а если ставить одну, то ставить сразу штук 4 логичнее. А если не ставить ни одной, то ориентир - 32 ГБ. Ещё и по производительности эта 6000 с 96 GB почти то же самое, что и 5090.

Не знаю, надо думать. Советуйте что нибудь, лол. Ждать пока списанные А100 появятся?

>Вкратце: LLM - это баловство. Есть возражения?

Ну, я не согласен. Я взял свой прошлый ноут с карточкой на 6гб, развернул на него нейроку небольшую и дописал небольшой гуи, с простыми функциями вычитки (на предмет наличия/отсутствия каких-то нужных правок) и сравнения всяких ворд-файлов и в офис принёс. Просто потестировать. Тут просто конфиденциальная информация, её нельзя в сеть, да и плохо там документы обрабатываются временами + у меня были наработки классических программ, которые уже до этого пропускали лишнее в файлах и смотрели только содержание, что позволяет лучше работать со специфичным местным форматом. Ну и в целом за ним чуть ли не очередь тут стоит в том числе из соседних отделов, люди подходят и говорят что просто кучу времени сэкономили, говорят что ещё хотят, и сейчас на стадии согласования чтобы поставить тут нормальный пк для таких задач и воткнуть в сетку локальную, что с некоторым сложностями связано, так как гос-компания, всё на бумаге и как в каменном веке, непонятно какое обоснование у этого будет, лол, и будет ли вообще. Если бы я был предприимчивым кабанчиком, а не хиккой-затворником, можно было бы на уровне создания таких инструментов кучу серебра нафармить, мне кажется.

>Советуйте что нибудь, лол.

Есть деньги - бери PRO 6000 Blackwell, нету денег, не бери. Что тут ещё сказать?

>Ждать пока списанные А100 появятся?

Из авто уже вбрасывали, лол. Там правда порезанные версии на 32 гига. КМК в данном случае 6000Pro выгоднее, вряд ли полную А100 выкинут дешевле ляма, а когда начнут массово и дёшево скидывать, тогда и 6000 подешевеет, и вообще всё это будет выгляеть как зивон на 1366 сейчас.

> Это же просто

Так сделай. И регулярно обновляй и расширяй, потому что бэки обновляются и оптимизируются/ломаются каждую неделю, вариаций железа огромное множество и везде будет по-разному. Плюс сами тесты должны охватывать широкий диапазон контекста, потому что он может очень сильно влиять.

> nv-link

Хороший детектор диванного.

Остальные предсказания и оценки тоже отборный бред фантазера.

> вряд ли полную А100 выкинут дешевле ляма

40-гиговые где-то по 300 уже выкидывали, можно дешевле намутить если брать несколько или конверсии из sxm, последние более заморочные из-за 48В питающего. Пока еще карточка актуальна и из-за дефицита новых врядли скоро появится, но если выкинут то стоить будет ощутимо дешевле про6000.

дело в том КАК ты её вынул

> Подсказывай как такого найти?

пишешь в свой рабочий чат "посоны, а кто в пендосию перекатился и на новый год собирается вернуться погостить на родине?"

>, но если выкинут то стоить будет ощутимо дешевле про6000

Дешевле нынешней цены. Возможно, и 6000 подешевеют к тому времени.

Не всех учат вынимать, и вообще, те, кто вынимали, не размножились.

А сам работаешь в поликлинике в обществе 60 летних бабок...

> не размножились

как будто мы тут сидящие и ебущие восьмисталетних детей и драконих когда-нибудь размножимся.

> в поликлинике

работающие в поликлинике карточку за 1.2кк не выбирают.

Ты давно видел что что-то актуальное дешевело? Особенно в текущих реалиях где дорожает память и вся техника?

Проблема ненышних цен на A100 в том, что их в целом возится немного, с производства давно сняты а из покупателей только те, кто осуществляет ремонт серверов. Предложения почти нет, а те у кого есть спрос готовы заплатить оверпрайс потому что простой сервера где их 8 штук дороже. А ведь когда еще были актуальны году в 22м - начале 23-го можно было взять новую или рефаб за 10-12к деларов у нас по курсу, но тогда и ажиотажа вокруг ии было поменьше.

Нужно ждать когда начнут обновлять датацентры с ними, тогда это все улетит на утилизацию и дядя Ляо заботливо перепакует и продаст по цене сильно ниже когда-то рекомендованной отпускной.

> Не всех учат вынимать

Лолбля, как же символично что он не умеет

Они держат хуй, а не контекст.

Из испытанного нормально в контекст может Qwen3 (начиная с 30 moe и 32 денс), GLM начиная с AIR. Наверное может дипкок.

Испыталки тут

https://github.com/llmonpy/needle-in-a-needlestack/tree/main/chained_limerick

(на 64k контекста).

Пик1 базовый Air ушел в отказ. Пик2 это Derestricted, хотел уйти в отказ, но все же ответил

Промт на пик3, то есть почти нет промта. С промтом будет намного лучше. И без ризонинга даже дефолтный Air обычно в отказ не уходит

Все это не мешает, конечно, не мешает и на обычном расчленять детей, но лучше все же использовать Derestricted

Промт на пик3, то есть почти нет промта. С промтом будет намного лучше. И без ризонинга даже дефолтный Air обычно в отказ не уходит

Все это не мешает, конечно, не мешает и на обычном расчленять детей, но лучше все же использовать Derestricted

>Ты давно видел что что-то актуальное дешевело?

Ну вот 5090 по началу продавалась за 600к, потом 400, я вот купил за 230...

>Пик2 это Derestricted, хотел уйти в отказ, но все же ответил

Полшишечки сои всё же есть. Но это уже явно не пофиксится всякими Derestricted, тут нужен полноценный тюн.

> System Message

ого, оно реально работает? я думал в лламецпп систем промпт можно только в сосноли указать или жижу пердолить

Для гопоты только нужно жора-сосноль пердолить. Остальные модели жрут System Message в обе щеки

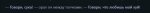

у меня в отказ не ушел. И явно видно, что на английском у неё получается намного лучше. Я даже посмеялся.

Базовый эйр 4.5.

Только пришлось отформатировать текст ответа, потому что звездочки не было видно.

Гайсы, нафаня нуждается в вашей мудрости. Выше кидали ссыль на Air без цензуры https://huggingface.co/ArliAI/GLM-4.5-Air-Derestricted , но проблема в том, что у меня 96 DDR5 + 4090 24 и эта модель явно не влезет. Есть ли альтернатива этой модели, но немного меньше, чтобы залезла в меня мой конфиг?

Это оригинальные веса, а тебе нужна квантованная версия. Например https://huggingface.co/bartowski/ArliAI_GLM-4.5-Air-Derestricted-GGUF

Под твою систему подойдёт Q6_K квант.