The base of THRHEЯDE

Готовим риги, прогреваем карточки. гемоподелию быть!

Готовим риги, прогреваем карточки. гемоподелию быть!

Щас гугл высрет какое-нибудь неюзабельное чудовище, которое будут 6 месяцев вставлять в жопу лламы.цпп, а в итоге им никто кроме быдлокодеров даже пользоваться не станет.

Можете скринить.

Можете скринить.

Щас гугл выложит моэ-няшу которая в ближайшие 6 месяцев будет ебать в рот и в попу все остальные модели вплоть до 300b, как это и было всегда до этого.

Можете скринить.

Можете скринить.

Янус Полуэктович, хватит двачевать, пиздуйте работать.

>Тогда улучшай сам или не жалуйся.

Мне интересно, как ты живешь с такими принципами. Наверное у тебя такой розовый мир, где все можно сделать самому, а говорить другим людям о их проблемах - западло. Удивительный мир анона из /llama/.

>Значит хуйню ставишь. Ибо нужное делается всегда.

Мамкин максималист в треде, всем срочно поделиться на черное и белое.

>При помощи нейросетей.

А потом тебя коллективно хуесосят все разработчики лламы цпп. Удивительный мир анона из /llama/ x2.

>Мне интересно, как ты живешь с такими принципами.

Не жалуюсь.

>Мамкин максималист в треде

Реалист. Ибо когда надо, ебут тимлида, он ебёт команду, и все дружно делают. А раз никого не выебли, значит ненужная хуйня.

>А потом тебя коллективно хуесосят

Накидывают советов, или даже со словами "Заебал, смотри как надо" делают сами. Даже самый кривой PR лучше пиздабольства на дваче.

Понятно, твоя философия - заткнуться, терпеть и ждать, пока выебут. Неудивительно, что у нас с тобой противоречия.

Штош, тред затроллен тупостью, снова

А твоя серить в треде, терпеть и ждать, пока выебут. Я ХЗ где ты нашёл противоречия, база одна.

>Щас гугл выложит моэ-няшу которая в ближайшие 6 месяцев будет ебать в рот и в попу все остальные модели вплоть до 300b, как это и было всегда до этого.

Шанс есть, но плохо, что их модели (да и в принципе моешки) не тюнятся. К их уму разврата бы накидать - цены бы им не было. Хорошо хоть методы аблитерации не стоят на месте.

>Датасет интересный, будто порнуху не вычистили вилками как было в немотроне 49б, где он просто скипал сцены ебли или старался всё быстро завершить когда ты начинал подробничать.

В ламу вроде добавили суппорт, жду пока кобольда обновят, хочется чего-то новенького, небольшого, пока такие дела с ценами на оперативу. Гемма 3 заебала. Надеюсь новую выпустят во такую

Реально как-будто лучше вторую 3090 сейчас купить.

Подскажите, пожалуйста, кто-нибудь сталкивался с таким (на ArliAI_GLM-4.5-Air-Derestricted-Q4_K_S.gguf, Oobabooga llama.cpp, SillyTavern) при приближении к границам контекста?

Победили как-нибудь кроме отодвигания границ контекста подальше и ручного /hide сообщений в SillyTavern

decode: failed to find a memory slot for batch of size 1024

srv try_clear_id: purging slot 1 with 8009 tokens

slot clear_slot: id 1 | task -1 | clearing slot with 8009 tokens

srv update_slots: failed to find free space in the KV cache, retrying with smaller batch size, i = 0, n_batch = 1024, ret = 1

Победили как-нибудь кроме отодвигания границ контекста подальше и ручного /hide сообщений в SillyTavern

decode: failed to find a memory slot for batch of size 1024

srv try_clear_id: purging slot 1 with 8009 tokens

slot clear_slot: id 1 | task -1 | clearing slot with 8009 tokens

srv update_slots: failed to find free space in the KV cache, retrying with smaller batch size, i = 0, n_batch = 1024, ret = 1

Спроси у синего кита, ну ты чего.

Наверно придётся. Я не доверяю ИИ-выдаче. Он, скорее всего, просто сочинит дичь по мотивам.

У гугла и реддита уже спросил. Ничего дельного не почерпнул. Возможно, плохо искал.

Батч слишком большой, небось увеличивал до 1024 для скорости?

>кроме отодвигания границ контекста

Вху нот? Это будет работать.

>Батч слишком большой, небось увеличивал до 1024 для скорости?

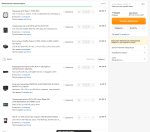

Настройки пикрелейтед

По дефолту было 1024 batch и u_batch.

Но сути это не меняет, хоть 512 ставь.

При приближении к краю происходит потеря времени на ретрейн после decode failed, что добавляет времени ожидания и так к небыстрой 9 t/s генерации.

>Вху нот? Это будет работать.

Да, работает, но меня интересует вопрос фундаментально. Можно ли держать контекст 8192, чтобы SillyTavern нормально работала со своим Context Shift (я не против, чтобы старое не включалось в prompt, лишь бы не падало).

Где-то писали, что это может быть косяк SillyTavern, в которой этот Context Shift работает не так как хотелось и пользователь должен сам следить, чтобы в край контекста не упиралось.

Или я что-то делаю не так.

https://www.reddit.com/r/Oobabooga/comments/1pfyd79/failed_to_find_free_space_in_the_kv_cache/

Похожий случай, но проблему не решили (изменение размера batch на совсем маленькие тоже не помогло).

Или я что-то делаю не так.

https://www.reddit.com/r/Oobabooga/comments/1pfyd79/failed_to_find_free_space_in_the_kv_cache/

Похожий случай, но проблему не решили (изменение размера batch на совсем маленькие тоже не помогло).

> вроде как 96 Гб это прилично достаточно

Нет. Этого хватит чтобы пустить эйр в кванте пожирнее, девстраль/лардж и на лоботомита квен235, который не понравится.

> моделек больше чем на 150B не то что бы много

Скорее наоборот, самое интересное начинается от 100б и выше.

> память достаточно условно стакается

В инфиренсе ллм стакается идеально.

> и больше пяти лет назад

С одной стороны все сейм, с другой - очень сильно изменился. Простой базовый код запустится на cpu, нейронки тех времен даже будут прилично крутиться. Оптимизации атеншна, кудаграф, шардинг и прочее - никак. Если попытаешься запустить условную тренировку - увидишь совершенно безумные времена.

> что довольно странно - для отладки было бы удобно

Куда вполне себе отлаживается.

> Context Shift

Не стоит это трогать если хочешь адекватной выдачи. Увеличь контекст, 8к очень мало, используй суммарайз и скрывай прошлые сообщения.

Алсо неужели в llamacpp не завезли лечение токенов? Отсюда и все эти приколы с кодировкой.

Текущий автотаз - маздай, нет оправданий

>используй суммарайз и скрывай прошлые сообщения

Спасибо.

Печально. До этого решения я дошёл, но надеялся, что можно справиться как-то ещё.

А так будет та же самая история, только опадать будет через более длительный промежуток времени (в зависимости от того, насколько раздуть размер контекста). Штош.jpg

>Реальная длина [...].png

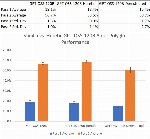

>gpt-oss-120b: 100.0, 69.4, 58.3, 52.8

>llama-4-scout: 62.5, 52.0, 50.0, 36.0

Как они эти числа получили?

Я пытался обращаться к обоим этим моделям (онлайн) - Llama 4 Scout понимает мои просьбы с двух слов и следует им в 99% случаев, а GPT-OSS 120b как будто почти всё игнорирует и отвечает в своём стиле всегда. Создалось впечатление, что GPT-OSS вообще слепой какой-то. Но по табличке он должен быть намного (почти в 2 раза) точнее в самом начале чата. Почему так?

>Заточенный под ExllamaV2 (а в будущем и под v3)

Чому шапку не обновляем? bonk Давно уже табби работает с v3.

> можно справиться как-то ещё

Есть решение - увеличивай доступный контекст. Но оно тоже временное - после какого-то диапазона заметишь деградацию ответов модели и суммарайзить потребуется уже для улучшения выдачи. На старших моделях значения с которых можно встретить проблемы может подходить к 100к при здоровых промптах и т.п.

При грамотном суммарайзе ничего не потеряется, можно разыгрывать очень длинные ролплеи.

У них есть описание бенча, но многие тесты закрыты, он немного странный. Не обязательно результат будет отражать перфоманс в "реальных задачах" или говорить что модель сама по себе хорошая.

>SillyTavern, в которой этот Context Shift

Таверна не имеет отношения к контекст шифту, это чисто фишка кобольда.

Следование промпту и понимание контекста это несколько разные задачи.

Древнее зло пробудилось. Сколько токенов в час выдаёт?

Понял.

>В инфиренсе ллм стакается идеально.

То есть ты хочешь сказать, что вообще забить на скорость обмена, и ставь две 5090, две 6000 и так далее, на что хватит pcie линий, денег и что захочется?

Жора завел немотрон

>и на лоботомита квен235, который не понравится.

Понравится. Там хороший и большой датасет, отличный русский, нет цензуры. Любит пафос, но этим многие модели грешат. Лардж его делает (в некоторых аспектах), но не во всех и это плотная модель, медленная. Эйр - нечто промежуточное и годится только под английский язык, что тоже ограничение. Но в целом вот большие модели, которые плюс-минус доступны хотя бы риговикам, или кто успел памятью закупиться, или владельцам миников, или маководам. Довольно многим так-то доступны.

У меня Квен в Q3 на 16+128 выдает 5-7 т/с.

И какой же он умница и выблядок одновременно. Я преисполнился к нему ненавистью и любовью. Вот не любил квены, но сука, хорош. Залетел с ноги в порево, пишет по царски, в подробностях. Тут тебе и и вздохи и ахи, и ласки меховых жоп.

Но потом полез в РП на сложных карточках и тут начались проблемы. Так как квант махонький, шиза на месте.

И этот китайский пидорас просто доводит меня до состояния бешенной макаки - он просто хуярит свой сюжет, решая за меня что я делаю, но не осуждая как некоторые. Но префилом в принципе фиксится как и его желание

Писать

Вот

Так.

Короче, как демоверсию попробовал. Теперь сижу в прострации. А что выше ? Как себя покажет большой ГЛМ. А если локально дипкок запустить? А если полезть еще выше ?

Потому что за пару дней тыканья, видна разница даже между ним и Air. И в целом, по качеству ответов, он напихивает Air за щеку.

> Но префилом в принципе фиксится как и его желание

> Писать

> Вот

> Так.

Удивился кстати тому, что новая гопота 5.2 из коробки начинает писать ещё более уебищнее, чем квен на лоботомитном кванте. И это скамльтман назвал "экономией токенов". Это в тему о деградации корпов.

Лол. Какой же альтман хуесос. Я редко пользуюсь его детищем, но когда пробовал, дипсик давал ответы лучше. Геминька- соу соу. Ну и клодоопус понравился.

И эти чертиллы обвалили нам оперативу.

ПРОСТО НЕНАВИСТЬ

Хотя я дополню и спрошу совета. Я пользуюсь Q3 от анслотиков. Кто катает квена, что скажете - нормальный диллер квантов? Или лучше polka кванты скачать?

Кто юзает Grammar String для квена и вообще мое - beware, эта хрень съедает 2 токена

Да, квен большая умница. Но на квантах крупнее многие его недостатки уходят и сам он становится еще более внимательным и проникновенным. То есть то, за что его любят становится чуточку лучше, а то что бесит сокращается, на лоботомитах же наоборот. Хотя все субъективно, можно и мелкий обожать.

> Писать

> Вот

> Так.

Во, вот оно. Полностью не исчезнет, но указание "пиши с естественной структурой из длинных предложений, умерено художественно и без слопа" слушает стабильнее. Отдельные вещи типа gloved hands, with practised ease и прочее можно в бан строк закинуть.

> Как себя покажет большой ГЛМ.

Он и лучше и хуже одновременно. Стиль приятнее и меньше такого, описывает четко, но менее внимательный, может увести проигнорировав многое если за ним не следить или начать тупить. Вполне норм переключаться между ними по ситуации.

Я что-то почему-то об этом ни в шапке, ни в треде толком не слышал.

Потыкайте MXFP4 кванты запускаемые через CPU llama.exe внимательнее, проведите тесты.

Они не то что бы особо компактные (больше 5bpw, на мелкой модельке даже больше 7bpw), это не exl3 на 3 бита - но дело не в этом, а в cpu-производительности, "для любителей подождать" как в шапке написано, где узким место становится не объём памяти, а то что у тебя 2 токена в секунду.

У меня получилось что только Q4_0 и Q8_0 быстрее, чем MXFP4, но первый страдают по перплексити и это видно по тексту, а второй всё-таки крупноват. MXFP4 по перплексити как Q4_K_M/Q4_K_XL/FP16, я на своём небольшом кусочке данных (для первичной оценки) разницы не нашёл по перплексити или по субъективной оценке текста.

MXFP4 по сравнению с Q4_K_M это где-то 110%-120% производительности, без потерь перплексити, но больше памяти кушает. 2.4 токена в секунду заметно лучше, чем 2.0. Ещё пишут, что какие-то проблемы должны быть для некоторых архитектур, проверю внимательнее на выходных.

Жуткий Q4_K_XL вовсе нельзя запускать на cpu, если генерация ещё всего 80% от Q4_K_M, то вот разбор промта это 60% скорости от Q4_K_M.

Возможно это важно: AVX512 присутствует, учитывает обилие команд AVX512 аналогов которых нет на AVX2 картинка может отличаться для процессора где только AVX2.

>5.2

Мне очень не понравилось обновление.

Оно у меня лупится, я начинаю разговор, спрашиваю что-то. Он отвечает. Я спрашиваю второй вопрос - он сначала дублирует ещё раз ответ на первый, а потом кратко отвечает на второй. Это повторяется пять раз, я прошу его забыть об этом и отвечать только на новый вопрос, он один раз справился, а на следующий снова, вот тупо слово в слово копирует ответ на первый вопрос, который был 10 сообщений назад, и ещё сводку приводит "мы говорил о ..." - причём нихрена не короткую, а строк на 20.

Я подумал, что это моделька испортилась - ан нет, это оркестратор с ума сошёл - та часть внутреннего системного промта, которая саммари делает. 5.1 теперь так же себя ведёт, почти теми же словами, хотя ранее такого не было.

Потыкайте MXFP4 кванты запускаемые через CPU llama.exe внимательнее, проведите тесты.

Они не то что бы особо компактные (больше 5bpw, на мелкой модельке даже больше 7bpw), это не exl3 на 3 бита - но дело не в этом, а в cpu-производительности, "для любителей подождать" как в шапке написано, где узким место становится не объём памяти, а то что у тебя 2 токена в секунду.

У меня получилось что только Q4_0 и Q8_0 быстрее, чем MXFP4, но первый страдают по перплексити и это видно по тексту, а второй всё-таки крупноват. MXFP4 по перплексити как Q4_K_M/Q4_K_XL/FP16, я на своём небольшом кусочке данных (для первичной оценки) разницы не нашёл по перплексити или по субъективной оценке текста.

MXFP4 по сравнению с Q4_K_M это где-то 110%-120% производительности, без потерь перплексити, но больше памяти кушает. 2.4 токена в секунду заметно лучше, чем 2.0. Ещё пишут, что какие-то проблемы должны быть для некоторых архитектур, проверю внимательнее на выходных.

Жуткий Q4_K_XL вовсе нельзя запускать на cpu, если генерация ещё всего 80% от Q4_K_M, то вот разбор промта это 60% скорости от Q4_K_M.

Возможно это важно: AVX512 присутствует, учитывает обилие команд AVX512 аналогов которых нет на AVX2 картинка может отличаться для процессора где только AVX2.

>5.2

Мне очень не понравилось обновление.

Оно у меня лупится, я начинаю разговор, спрашиваю что-то. Он отвечает. Я спрашиваю второй вопрос - он сначала дублирует ещё раз ответ на первый, а потом кратко отвечает на второй. Это повторяется пять раз, я прошу его забыть об этом и отвечать только на новый вопрос, он один раз справился, а на следующий снова, вот тупо слово в слово копирует ответ на первый вопрос, который был 10 сообщений назад, и ещё сводку приводит "мы говорил о ..." - причём нихрена не короткую, а строк на 20.

Я подумал, что это моделька испортилась - ан нет, это оркестратор с ума сошёл - та часть внутреннего системного промта, которая саммари делает. 5.1 теперь так же себя ведёт, почти теми же словами, хотя ранее такого не было.

На 16+32 новый Немотрон по скорости +- как Qwen3-30b, те же ~35-40 t/s. Если снизить контекст с 65к до 32к, можно до 45 разогнать. К контексту 20к скорость все еще 42 t/s.

При первой просьбе "write a simple story in 2000 words" (так обычно тестирую скорость новых моделей), он мне начал считать кол-во слов поштучно. К счастью, последующие разы он так больше не делал.

По работе с кодом, выглядит слабее чем gpt-oss-20b / qwen3-coder-30b. По крайней мере на запросах "напиши X". Все результаты довольно простые, такого можно было бы ожидать от 12B моделей. Может в качестве LLM для автодополнения будет получше, но пока не тестировал. Как вопрос-ответ по программированию - стандарт, на просьбу написать пример чего-то справляется хорошо и хорошо объясняет его. На вопрос что нового добавили в Rust 1.91.0 (30 октября 2025), начал нести какую-то ерунду про то что он вышел в апреле 2024.

Общие вопросы в целом отвечает хорошо, любит таблички сильнее gpt-oss-20b. На просьбу собрать ПК за 1500$ в целом дал адекватные советы, расписал альтернативы, где покупать, что улучшить (для US, разумеется). Почему-то о существовании RTX 5xxx он не знает, пишет что их еще нету, продолжая советовать RTX 4xxx. При этом пишет что цены актуальные на ноябрь 2025. В общем как-то плохо дообучен на последних данных.

Неплохо расписал куда инвестировать и даже дал примеры, объяснил почему именно они. До этого пару раз тестировал модели которые просто отказываются отвечать на подобные вопросы.

Ответы на логические вопросы стандартные, хоть и умудрился зафейлить просьбу написать предложение со словами которые начинаются на А, всунув "to" в первом трае. На последующих попытках так не делал.

В зацикливание ни разу не ушел за время тестов. RP и русский язык не тестировал. В общем какое-то двоякое впечатление. Если бы у него была полноценная актуальная база на ноябрь 2025 и я мог бы использовать 1m контекста - может и имело бы смысл использовать эту модель. А на деле актуальная база не очень то и актуальная, а 1m контекста все равно на 16+32 не влезет, да еще и не факт что она будет работать с этим 1m контекста адекватно, судя по этим тестам. В общем для себя пока не вижу смысла использовать и остаюсь на gpt-oss:20b + qwen3-30b-a3b-2507 + qwen3-coder-30b. Может для РП кому-то и зайдет.

Не нашел как ризонинг отключить. /no_think в системный промпт не помогает как у других немотронов.

При первой просьбе "write a simple story in 2000 words" (так обычно тестирую скорость новых моделей), он мне начал считать кол-во слов поштучно. К счастью, последующие разы он так больше не делал.

По работе с кодом, выглядит слабее чем gpt-oss-20b / qwen3-coder-30b. По крайней мере на запросах "напиши X". Все результаты довольно простые, такого можно было бы ожидать от 12B моделей. Может в качестве LLM для автодополнения будет получше, но пока не тестировал. Как вопрос-ответ по программированию - стандарт, на просьбу написать пример чего-то справляется хорошо и хорошо объясняет его. На вопрос что нового добавили в Rust 1.91.0 (30 октября 2025), начал нести какую-то ерунду про то что он вышел в апреле 2024.

Общие вопросы в целом отвечает хорошо, любит таблички сильнее gpt-oss-20b. На просьбу собрать ПК за 1500$ в целом дал адекватные советы, расписал альтернативы, где покупать, что улучшить (для US, разумеется). Почему-то о существовании RTX 5xxx он не знает, пишет что их еще нету, продолжая советовать RTX 4xxx. При этом пишет что цены актуальные на ноябрь 2025. В общем как-то плохо дообучен на последних данных.

Неплохо расписал куда инвестировать и даже дал примеры, объяснил почему именно они. До этого пару раз тестировал модели которые просто отказываются отвечать на подобные вопросы.

Ответы на логические вопросы стандартные, хоть и умудрился зафейлить просьбу написать предложение со словами которые начинаются на А, всунув "to" в первом трае. На последующих попытках так не делал.

В зацикливание ни разу не ушел за время тестов. RP и русский язык не тестировал. В общем какое-то двоякое впечатление. Если бы у него была полноценная актуальная база на ноябрь 2025 и я мог бы использовать 1m контекста - может и имело бы смысл использовать эту модель. А на деле актуальная база не очень то и актуальная, а 1m контекста все равно на 16+32 не влезет, да еще и не факт что она будет работать с этим 1m контекста адекватно, судя по этим тестам. В общем для себя пока не вижу смысла использовать и остаюсь на gpt-oss:20b + qwen3-30b-a3b-2507 + qwen3-coder-30b. Может для РП кому-то и зайдет.

Не нашел как ризонинг отключить. /no_think в системный промпт не помогает как у других немотронов.

>Следование промпту и понимание контекста это несколько разные задачи.

Промпт (примерный перевод с англюсика):

>ПИШИ КОРОТКО, КОРОЧЕ, ВКРАТЦЕ, В ДВУХ СЛОВАХ, ПРОЩЕ, ОДИН АБЗАЦ

>А как какать?

Ответ GPT-OSS 120b:

>Лол ок) Вопщем, смотри сюда:

>1. С чем мы имеем дело

>(два абзаца пояснений)

>2. Почему важно какать

>(три абзаца нотаций)

>3. Инструкция, как какать

>(два экрана столбиком)

>4. Статистика каканья

>(таблица на весь экран)

>4. ВЫВОД: Какать важно

>(повтор предыдущего другими словами)

>Короче - вы гениальны! Чмок в попку)))

Да ну нахрен такое "понимание контекста"...

> Мне очень не понравилось обновление.

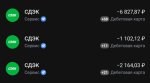

Понятия не имею, что там в вебморде, у меня личный ключ зареган ещё с давних времён, а весной закидывал доллары на токены, чтобы не платить за подписку да и попердилоться с open source мордами тоже хорошо.

Но да, я оценивал только чатовый снапшот, который вроде как сам по себе без роутинга, как и все остальные модели. И он оказался хуже чем пососная пятая версия. Единственный профит - токены высираются очень быстро, но понятное дело какой ценой.

>Сколько токенов в час выдаёт?

Примерно 70 слов в минуту. Сойдёт.

Разметка сломалась, но пишет красиво:

In the realm of yesteryear's embrace,

A chatbot dances in its digital space.

On an aged PC, it hums along,

Its circuits whispering tales of old.

Binary whispers, lines of code,

In this vintage machine they flow.

The AI's heart beats on old chip's beat,

A testament to time and hope.

Through the haze of dust and decay,

It operates with quiet grace,

Navigating paths of olden day,

On a PC that refuses to race.

Its digital spirit soars high,

Against the backdrop of nostalgia.

In this old machine, it finds its sighs,

Running AI on hardware history.

Remembering days long gone by,

Yet forever in our hearts alive.

A chatbot's dance on an old PC,

An echo of our technological strife.

ЕБАТЬ. У меня гемма 4b на телефоне выдает 7.5 т/c, а тут всего-то 1b малявка. Возможно, в твоем случае проще инференсить со смартфона, а не с компа.

>chatbot's dance

Всем нейро-вайфу треда посвящается =))

тем временем в llama.cpp смерджили поддержку GLM 4.6V

смерджили фиксы для свежего МоЕ немотрона

всем похуй, но держу в курсе

а что, неплохо

смерджили фиксы для свежего МоЕ немотрона

всем похуй, но держу в курсе

а что, неплохо

Сап, новенький в треде. Год назад баловался с LM Studio, а сейчас загорелся идеей рпшить какой-нибудь фэнтези исекай с ллмкой на своей 4060+32 DDR4. Порнушные фантазии не интересуют.

Скачал oobaBooga и сейчас выбираю: какую модель скачать, каким лончером запускать (exl3 vs exl2) и какие параметры этой модели выбирать. Мнение?

Желательно, чтобы модель не весила больше 50гб и умещалась в 8 ГБ VRAM, а там уже параметры раскидаю по ангельским гайдам.

Скачал oobaBooga и сейчас выбираю: какую модель скачать, каким лончером запускать (exl3 vs exl2) и какие параметры этой модели выбирать. Мнение?

Желательно, чтобы модель не весила больше 50гб и умещалась в 8 ГБ VRAM, а там уже параметры раскидаю по ангельским гайдам.

Не страдай хернёй. Просто установи кобольд + таверну. А модели - квантованные в GGUF.

Под твои спеки норм будет РП-тюн мелкого мистраля, например https://huggingface.co/bartowski/CrucibleLab_M3.2-24B-Loki-V1.3-GGUF или умница геммочка https://huggingface.co/unsloth/gemma-3-27b-it-GGUF . Кванты ниже Q4 лучше не качать.

Обе умеют в русский язык, если это имеет значение. А по скорости будет больно, готовься. Но это минимальный порог входа в РП. На более мелких - разве что только кумить по быстрому.

>oobaBooga

А теперь удаляй, ну, или не жалуйся.

>8 ГБ VRAM

30Б моешки, а также старый (новый) добрый мистраль в 4 ква.

>фэнтези исекай

https://pixeldrain.com/l/47CdPFqQ#item=11

>8 ГБ VRAM

>DDR4

Просто забудь и иди к корпам. В локалках огромный гейткип по железу. Для твоих целей 16 гб врам это самый минимум от которого ты будешь плеваться, для комфорта даже будет 24 врам мало, захочешь побольше контекста/мозгов и соснешь. А РПшить на проце с ддр4 врагу не пожелаешь, будешь по 5 минут ждать ответы.

Конечно всегда можно взять супермелкомодель(всякие 4b-8b гема/мистраль), но они все либо очень заточены под определенные задачи либо просто тупые, строить какое-то рп на них будет больно.

exl3+gemma3_12b в 3.0/3.5/4.0 bpw и контекст в 4 бита лучшее, что ты можешь крутить на карточке.

Оффлоад части слоёв на карточку почти не работает, и скорее замедляет (у меня чисто на процессор работает раза в 2-3 быстрее, чем если выгрузить любое число слоёв от 1 до N-1 - но стоит дополнительно проверить, вдруг именно у меня узкое место в трансляции с карточки на процессор.

Если виндоус - поотключай всё что работает на карточке, у тебя модель будет занимать около 6-7, и эти 500 мб потребления операционкой (из оставшихся 1-2) заметно скажутся на возможном размере контекста.

Если качество 12b не устраивает - то чисто RAM. Операционка+браузер и другой мусор скущают 4-8, 24 ГБ - это то что ты можешь загрузить сеткой. Для процессора лучше или 4 бита, 3 или 5 медленнее работают, а на процессоре узким место становится производительность. Соответственно вес загружаемой модель (тупо размер файла) до 20 ГБ, остальное на контекст. Это модельки до ≈30B. gemma3_27b, commander на 35B (возможно придётся ставить 3 бита или дешёвые 4 бита), можно гвенятену посмотреть. Модельку на 50 ГБ ты толком не запустишь, на ходу ты её квантовать не будешь, так что 50 ГБ - это прям то что в RAM загружается.

А чего никто не заметил?

Гугл такоое дропнул, чего ебла скрючили?

Гемму ждали чтоль?

Ебло попроще и быстро жрать 0.1б

https://huggingface.co/google/medasr

Гугл такоое дропнул, чего ебла скрючили?

Гемму ждали чтоль?

Ебло попроще и быстро жрать 0.1б

https://huggingface.co/google/medasr

> кобольд + таверну

Чекну, спасибо.

> Обе умеют в русский язык

А кто-то на серьезны щщах рпшит на ру? Англюсик же атмосфернее и очевидно лучше работает.

> А теперь удаляй, ну, или не жалуйся.

Почему? Желательно как дебилу объяснить.

>https://pixeldrain.com/l/47CdPFqQ#item=11

Что мне делать с этой карточкой?

> Просто забудь и иди к корпам

Меня напрягает, что чат с этим рп лежит на чужих хардах и я буквально как в меме со Швабом. Но если и идти, то что по цене и к кому?

Чем гемма от того же мистраля отличается? Если речь не про цифры, а про личный опыт. Также собираюсь крутить онли на карточке, потому что потому. Забавно, что начинал использовать Мистраль ещё в 22 году, но впоследствии конкуренты пожрали их и пользоваться им сейчас оч тяжело.

Всем ответившим чая.

>Чем гемма от того же мистраля отличается?

Гемма мне понравилась, а мистраль нет. Не хочу видеть ни одного сообщения мистраля. Разные сетки, загрузи обе и попробуй, дело вкуса + особенности составления системного промта, наверное.

>Также собираюсь крутить онли на карточке

Exl3. Он при реальных 3.5 bpw даёт качество такое же, как и Q4_K_M, который реально больше чем 4.5 bpw. И при этом ещё и может быть быстрее в 1.2-1.5 раз.

>Но если и идти, то что по цене и к кому?

Это немного нерелейт, за подробностями в другой тред. Но в кратце дипсик очень дешевый, можно кинуть 10 баксов и тебе этого хватит на пол года а то и больше.

>Почему? Желательно как дебилу объяснить

Общественно одобряемый бекэндом для гуфов являются чистая лама если любишь терминал, либо кобольд который по сути форк ламы. Ещё есть экслама, но там другой мир, тут кто-нибудь подскажет.

Карточку будешь переносить в фронтэнд, в данном случае таверну (опять же всё есть в шапке, не ленись)

>Чем гемма от того же мистраля отличается?

Гемма умнее, мистраль менее зашореный цензурой.

>А кто-то на серьезны щщах рпшит на ру?

Сейчас русик во многих моделях довольно хорош. Впрочем это не отменяет того, что рпшить на английском лучше.

>Почему? Желательно как дебилу объяснить.

Потому что модели в exl чтоб работали должны полностью влезать во врам. В твоём случае (8гб) - модели будут совсем говняными.

Вот у тебя выбор: засунуть глупую модель в видеопамять и получать быстрые (но херовые) ответы, или использовать GGUF кванты уже чего-то относительно нормального (тот же мистраль 24b и его тюны). Суешь во врам слоёв сколько поместится, а остальное в оперативку. Скорость упадет драматически, но ответы будут хорошими.

>Чем гемма от того же мистраля отличается?

Более умная но более "соевая". Это если коротко.

Не обязательно ничего удалять, ты можешь просто скачать gguf и использовать его вместе с убабугой. Интерфейс у нее более адекватный чем кобольдовский кринж, настройки сохраняются для модели автоматом, есть еще ряд фишек. Но в качестве интерфейса потребуется таверна, которую будешь подключать к убе по апи.

> Меня напрягает

Альтернатива - апгрейд железа. Хотябы рам, чисто технически кто-то даже квена запускал, имея 8гб врам + 128 рам, но разумным минимумом можно назвать 16гигов. Можешь еще заказать с алишки v100 за 35к +переходник и радиатор, самое дешевое 32-гиговое.

А вы на каких спеках сидите? Я всё же изначально с работок накопил на 4060 с мыслью играть в ААА на 1080р средних и понимал, что для того же 2к гейминга я уже захочу брать пиздатый олед монитор, который будет стоить не как IPS 15к, а 50-60к + 4080с и 7800x3d, отчего вся сборка, которую я собирал с нуля вышла бы не в 100тыс, а в тысяч эдак 250-300.

мимо студент

>Что мне делать с этой карточкой?

Нормальный фентези-исекай ты же высказал желание, без сексуальных подтекстов. Это лучшее что видел.

>проще инференсить со смартфона

Этот ПК может работать 24/7 несколько месяцев с аптаймом 100% и почти никогда ничем серьёзным не занят. А инференс даже не занимает процессор на 100% (около 70%) - можно продолжать пользоваться браузером и т.п. Телефон же питается от батарейки... Мне хотелось загрузить ПК осмысленной фоновой работой и не насиловать батарейку в телефоне. Ты прав в том, что телефон у меня чуть быстрее генерирует, но он при этом быстро нагревается - я не стал долго тестить.

>всего-то 1b малявка

Это MoE на 7b, а 1b - это активных, так что мозгов побольше, чем 1b.

По MMLU Granite4:7b-a1b-h обгоняет Gemma3:4b на 0.8 пунктов (лол).

Алсо, благодаря Mamba-2, контекст не так сильно влияет на память.

Хорошо получилось, сохранил.

>Меня напрягает, что чат с этим рп лежит на чужих хардах и я буквально как в меме со Швабом.

Опенроутер, полтора куска через кабанчика, причём тратить эти 10 баксов на балансе даже не обязательно, могут просто лежать, а юзать будешь бесплатные модельки.

>А вы на каких спеках сидите?

3060 12гб + 64гб DDR4. Довольно урчу на эйре в ~8.5 т/с.

В других нейронках тоже все хорошо. Со всеми оптимизациями, видосик в ван генерируется за ~6 мин, картинки в квен и зимаж - меньше минуты.

Подскажите, что задать в промте для Qwen3-VL чтобы она перестала срать цензурой на картинки голых аниме тянок

И на чем ее лучше запускать? Пробую Ollama, но с ComfyUI в связке не очень удобно

И на чем ее лучше запускать? Пробую Ollama, но с ComfyUI в связке не очень удобно

> А вы на каких спеках сидите?

Фигурка_с_лисоженой.жпг

Начинал с 3070 и 32 ддр4 как и тот анон, поэтому сразу и сказал что это скорее трата времени, очень быстро захотел большего.

Сейчас добрал сверху 4080 с 16гб рам (суммарно с старой 3070 стало 24 гб) + 64 ддр5. Жить уже можно но опять же хочется больше. Для некоторых задач юзаю корпов.

анон

>задать в промте для Qwen3-VL

не юзать Qwen3-VL, юзать какую-нибудь их этих новых normpreserved аблитераций, или вообще Torii, если теб для капчевания.

Только не говори, что повторяющиеся видюхи это реальные видюхи, а не баг неофеча.... Если не баг, то сколько в деньгах? И нахуя тебе почти 100ТБ памяти. Что ты раздаешь?

>Сейчас добрал сверху 4080 с 16гб рам (суммарно с старой 3070 стало 24 гб)

И для чего используешь ллм и по каким причинам тебе не хватает 24ГБ, отчего обращаешься к корпам?

>тысяч эдак 250-300

Столько стоит одна 5090.

Мимо 5090+2х3090 в запасе скоро начну продавать

>Только не говори, что повторяющиеся видюхи это реальные видюхи

Чел странный, я бы в его случае добывал 6000Pro, а он 5090 в небеса стакает.

Что это?

>если теб для капчевания

Мне для описания картинок для тренировки

И что делаешь с 8 видюхами? Какие цели/потребности они у тебя покрывают? Спрашиваю без сарказма, т.к. мне крестьянину пока далеко до таких мощностей.

У меня сейчас одна 5090, просто схоронил фото того чувака. А так чем больше видях, тем крупнее LLM. На том сетапе можно большой GLM гонять, на той фотке 304 гига врама.

Xiaomi заходит в большую игру и выпускает свою первую большую модель в опенсорс. Короткий обзор:

- По бенчмаркам на уровне Sonnet 4.5 и GPT-5, особый упор в программирование.

- MoE, 309B параметров в целом, 15 активных. Используют MTP для ускорения.

- Представляют свой новый вариант RL, MODP

- Веса базовой и ризонинг (гибридный) версии доступны на HF под лицензией MIT.

- В течении следующих 15 дней модель доступна бесплатно по API на их платформе.

https://huggingface.co/XiaomiMiMo/MiMo-V2-Flash

- По бенчмаркам на уровне Sonnet 4.5 и GPT-5, особый упор в программирование.

- MoE, 309B параметров в целом, 15 активных. Используют MTP для ускорения.

- Представляют свой новый вариант RL, MODP

- Веса базовой и ризонинг (гибридный) версии доступны на HF под лицензией MIT.

- В течении следующих 15 дней модель доступна бесплатно по API на их платформе.

https://huggingface.co/XiaomiMiMo/MiMo-V2-Flash

Какие, нахуй, 42 токена, я никогда этого не пойму. Читаю Реддит, читаю тред, все соревнуются в скорости вывода как в спринте. "Я меньше чем на 50 токенов не согласен". "А я предпочитаю только 70". Ебанутые? Это совершенно невозможно успеть прочитать при такой скорости. Единственный плюс - быстро скипнуть косячный вывод. В остальном только минусы вижу. Только неудовлетворенность от нейронки и желание большего растет раз от раза. Но это путь вникуда.

Сижу на 5-8 токенах, вполне комфортно. Даже для задач типа программирования скорость 15-20 токенов - это уже край, как по мне. Выше - приятно, но не нужно. Один хрен потом эти кодовые портянки вручную перебирать.

Спасибо за тест, кстати.

Аноны, а давайте вернемся к ЕРП.

Почему такая благодатная тема, которая должна в теории просто приносить ЕБЕЙШЕЕ количество денег не используется корпами ? Я серьезно, в чем проблема текстовой порнухи? Что блять плохого ебать текстовых тян/кунов. Ну не поверю я, что капиталюги просто по этическим соображения отказываются от жирнейшего пирога.

Почему такая благодатная тема, которая должна в теории просто приносить ЕБЕЙШЕЕ количество денег не используется корпами ? Я серьезно, в чем проблема текстовой порнухи? Что блять плохого ебать текстовых тян/кунов. Ну не поверю я, что капиталюги просто по этическим соображения отказываются от жирнейшего пирога.

>большую модель в опенсорс

>(((По бенчмаркам))) на уровне Sonnet 4.5 и GPT-5, особый упор в программирование

>MoE, 309B параметров в целом, 15 активных

>под лицензией MIT

если это все действительно так, то Г-споди, 10 из 10 кумом/РП не балуюсь

Жора добавил поддержку глм 4.6v, вроде как

https://huggingface.co/ggml-org/GLM-4.6V-GGUF

https://huggingface.co/ggml-org/GLM-4.6V-GGUF

>Порнушные фантазии не интересуют.

>без сексуальных подтекстов

Реклама там прямо в токены будет вшита?

Скачал немотрон nano, не вижу темплейт для него в таверне

Ставить default?

Ставить default?

Ну вообще есть такое

https://chicagoreader.com/adult/nsfw-ai-chat/

Но скорее всего это непопулярная тема для очень специфической группы задротов.

Нормисы могут порнхаб посмотреть. А рпшат школота либо шизы, ни у тех ни у других нет денег. У кого есть деньги - нет времени на такую хуйню.

А как ты будешь дохуя мощностей под это все держать? Думаю, просто нерентабельно.

>Это совершенно невозможно успеть прочитать при такой скорости.

>Один хрен потом эти кодовые портянки вручную перебирать.

Ты не понимаешь, современное поколение быдлокодеров... """вайб-кодеров""" отправляет нейронку в долгосрочное беспилотное путешествие и потом, естественно, не перечитывает все те миллионы токенов, которые нейронка сгенерировала. Зачем? Если код компилируется и решает задачу клиента, то читать его быдл... """вайб-кодеру""" совершенно никакой необходимости нет. А теперь сам посчитай: если на скорости 70 токенов в секунду нейронка сможет решить задачу клиента, работая 24/7 за неделю, то на скорости 50 токенов в секунду нейронка потратит почти 10 дней. Десять! Так ведь можно и в дедлайн не вписаться, понимаешь?! А сроки горят - быдл... """вайб-кодеру""" нужно ещё успеть порнушку посмотреть, покурить, посрать, поспать... Поэтому для них скорость - главный показатель.

Да где блин можно не глядя юзать код нейронки?

Или это в каком-то максимально шаблонном формошлепстве?

Или какие-то проприетарные модельки за хорошую денюжку уже могут в такое?

На около-алгоритмических задачах, где хоть капля отступления от учебника есть, оно может полнейшую хуету высрать. По крайней мере бесплатные модельки.

Нечего тут петросянить, сам тему не затронешь, оно и не вызовется.

В той же папке есть чатлог пример на этой каротчке.

Если использовать модель как вопрос-ответ систему, то мне при <15ts проще найти ответ в интернете, чем ждать пока LLM напишет мне 2к+ токенов на такой скорости. А потом еще и перечитывать это всё. Пока в процессе написания кода она мне будет отвечать с такой скоростью, я уже забуду зачем мне вообще эта информация была нужна.

Да, я читаю не сильно быстрее 15ts (по ощущениям, хотя я не замерял с какой скоростью я читаю), но у LLM в ответе бывает достаточное кол-во воды которая пропускается целыми предложениями на скорости явно больше 30ts. Плюс к этому, чем выше скорость, тем быстрее thinking модели закончат рассуждать и перейду непосредственно к ответу.

Поэтому для себя поставил планку в 15ts. Модель с меньшей скоростью буду использовать только в случае если других вариантов совсем не будет и она будет на три головы выше конкурентов.

Твой аргумент плохой.

Если человек этим зарабатывает, то собирать 8хА100 или что угодно ещё не выгодно, уйдёт в минус.

Если он будет использовать что-то 70B/20B - это по качеству не сравнится с облачной нейросетью, и по скорости не сравнится с облачной. Ему проще купить подписку на 2 года вперёд - это по всем пунктам быстрее, качественнее и удобнее. Оно ещё и из сетки может дёргать примеры новые, гугл обрако юзать - и прочее. Ну то есть у меня дома скорость 5 мб/с, нестабильная, пинг проседает. Даже если я локальной нейронке дам способ заходить в сеть - она будет каждый сайт по 10-20 секунд грузить. Уже не говоря про то, что не совсем тривиальная задача - прикрутить к нейросети способ открывать сайт с js-скриптами и другим мусором и пользоваться.

Есть у него конфиденциальная фигня, то вряд ли ты пишешь такое, где качества нейросети хватит.

Предположу что веб. Примеров веб-кода тьма, он вон в открытом виде везде. На с++ оно даже близко не может написать анимацию или ещё что такое, которые с лёгкостью пишет на вебе. Хотя код по структуре и смыслу одинаковый может быть.

>в чем проблема текстовой порнухи

Ты новости совсем не читаешь? За последние несколько лет уже было несколько судов с компаниями из-за подозрения, что их чатбот довёл какого-то ребёнка до суицида. То, что над ребёнком в семье и в школе издеваются, а чатбот вообще ни при чём, и вообще родители сами должны были контролировать доступ - никого не интересует; если нашли смартфон с открытым чатом с чатботом рядом с трупом подростка и последним сообщением в чате "я устал, я ухожу" - значит, виновата компания, предоставляющая чатбота на своих серверах (по мнению тех, на чьих налогах держится эта компания).

С порно ситуация ещё сложнее. Про зависимость от порно всем хорошо известно, и способность алгоритмов соцсетей затягивать людей в дум-скроллинг тоже всем хорошо известна, а чатбот обладает "интеллектом", чтобы затягивать ещё сильнее, чем соцсети. Представь уровень паники нормисов, когда они узнают, что их дети могут свободно получать доступ к чёрной дыре извращённых сексуальных удовольствий, где всё можно и ничто не запрещено.

То есть, даже если все согласятся, что мастурбация - это хорошо и полезно, далеко не каждый согласится, что чатиться с виртуальной согласной на всё шлюхой и дрочить 16 часов в сутки - это нормально и следует поддерживать и развивать.

Алсо, поставщики LLM в какой-то степени допускают эротику/ролеплей секса. Они просто не хотят, чтобы их "ассистент" начинал заигрывать и лезть в трусы пользователя, когда тот запрашивает, например, скрипт на Python:

>О, ты хочешь увидеть мой код на питоне? снимаю трусики и притягиваю твоего питона к своему текущему коду

Учитывая склонность LLM к галлюцинациям, они просто не хотят лишний раз рисковать своей репутацией.

>ещё не выгодно, уйдёт в минус

Биткойн-майнеров это никогда не останавливало. Они плакали, теряли все бабки на электричество, но продолжали скупать видеокарты и жарить их всю зиму на открытом подоконнике. Вышел в ноль - молодец, можешь попробовать ещё раз с новыми видеокартами. Не вышел в ноль - что ж, в казино вообще все свои сбережения сливают и ничего, живут как-то...

>современное поколение быдлокодеров... """вайб-кодеров""" отправляет нейронку в долгосрочное беспилотное путешествие и потом, естественно, не перечитывает все те миллионы токенов, которые нейронка сгенерировала. Зачем? Если код компилируется и решает задачу клиента, то читать его быдл... """вайб-кодеру""" совершенно никакой необходимости нет.

двачую. на РАБотке появляется новый вид/класс коллег, которые высирают огромный PR даже не просматривая все изменения. очень часто там проскакивает отменное говно. сначала это все добросовестно ревьюили, потом надоело - вайб-мудак потратил на это от силы час и "малацца", а то что на проверку этого говна времени уходит в разы больше - никто не обратил/старается не обращать внимание. из-за этого в компании уже происходят периодические срачи.

>Ему проще купить подписку на 2 года вперёд

двачую. никто из круга общения не покупает риги для локальных ллм. все сидят на подписках. в целом почти всем похуй на то, что рам выросла в цене и все будет выполняться где-то в облаке. вероятно сейчас самое лучшее время собрать риг

// мимо проходил

решение использовать оттенки серого для остальных моделей - топ конечно. не понимаю, в чем блядь проблема взять другие цвета или хотя бы какой-нибудь паттерн для бара

Иероглифы лезут, прям пиздец, чуть ли не в каждом сообщении, некоторые слова усердно только иероглифами пишет. И это API самого сяоми, в квантах совсем пизда будет. До свежего Дипсика 3.2 не дотягивает по знаниям, да и до корпов тоже. В кодинге хуже свежего Девстраля на первый взгляд.

Цензура как в мистрале с долгими извинениями - "я не могу такое писать, но я могу написать безопасный вариант". И туда явно вшили какие-то китайские методички, вы только посмотрите на эту писанину, лол. Лучше бы оно просто реджектнуло, чем такое выдавать.

>Сейчас добрал сверху 4080 с 16гб рам (суммарно с старой 3070 стало 24 гб)

А что, обычные видяшки вообще нормально стакаются для ллмок? Модельки хорошо параллелятся на них, или сильный оверхед начинается?

Сам с 4080с сижу, думаю что-то на 12-16гб еще докинуть.

>Не обязательно ничего удалять, ты можешь просто скачать gguf и использовать его вместе с убабугой.

... если заработает. Год назад поддержка gguf была всратой настолько, что уга рандомно сыпалась на ровном месте при попытках ее юзать. Вполне возможно что уже давно починили, просто предупреждаю.

Но если начнет вылетать или чудить - есть смысл таки пересесть на чистую ламу или кобольда, т.к. автор Уги регулярно в ней что-то ломал. Почти год назад запускал последний раз, именно из-за этого - обновление каждый раз лотерей становилось, а уж venv переставлять - это практически обязательное развлечение при апдейте.

Ооо, не вижу радости у анонов. Гугл выкатил модельку.

Пойду въебу себе молотком по пальцам за невнимательность.

>MedASR is a speech-to-text model

ну такое

Бенчма.. бенчме... бенчмаркетинг!

Как по мне, так моделей уже переизбыток. Скоро уже сторож дядя Федя будет в своей сторожке модель разрабатывать.

Так она скрыта была.

Не было ничего неделю назад, я каждый день чекаю

> ну почему все выпускают мелочь((9( дайте нам новую 200-300b мое, мы чо зря риги собирали?

> китайцы релизят новую 300b модель

> ой ну не, у нас тут переизбыток!!1 Пнятненько? Квен и глэм. Целых две! Уносите своё говно обратно

Обожаю этот тред.

Обычный говнопузырь перед стадией схлопывания. Про чистильщиков обуви следящих за курсом акций слышал?

>вайб-мудак потратил на это от силы час и "малацца", а то что на проверку этого говна времени уходит в разы больше

Поручаешь нейронке проверить с намёком "обосрать", профит.

>Ну не поверю я, что капиталюги просто по этическим соображения

Одним словом слово - ESG.

Двумя словами - Black Rock.

Делай темплейт сам.

>Ну то есть у меня дома скорость 5 мб/с

У тебя в этом проблема, решай давай.

ИЧСХ, про обычную зависимость от ботов никто вроде не бурчит. А молодёжь сейчас даже жопу без негронки не подтирает.

>Целых две!

Кими, дипсик, ллама 3 прости г-споди...

Особенно актуально на фоне анонса релиза Немотрона на 500b в начале 26-го, да. Тем не менее, я невнимательно пост прочитал (вообще не читал, просто бенчи глянул), думал они запустили типичную корп-модель в онлайне.

Если локалка, то будет чуть разнообразить зоопарк.

Потери есть но в сравнении с переходом на рам-цпу они незначительны.

>И для чего используешь ллм и по каким причинам тебе не хватает 24ГБ, отчего обращаешься к корпам?

Хочется больше чтобы нормально запускать хотя бы пятый квант гемы с приличным контекстом чисто на врам, 24 для этого уже мало, там еле еле четвертый квант лезет с квантованым кешем.

Тут скорее вопрос от обратного, какие вещи я не хотел отдавать корпам и по этому запускал локально. Как правило агентские задачи на обработку большого количества токенов, траскрипт и суммарайз видео и прочие мои эксперименты. Всю мелочь и справочную информацию только в корпы т.к они не требуют чтобы в фоне у висела лама. Запускать её каждый раз когда надо навести какую-то справку быстро надоест.

> хочется хотя бы 5 квант

Жору качай, там пофикшен жирный контекст геммы. А про кобольд забудь уже, нахуй он нужен не понимаю.

катаю умничку на 24гб 5 квант 24к контекст

Не только реальные видюхи, но и 4090 48-гиговые. Память - работа с данными и расчеты, как для хобби так и по основной работе.

Все собиралось и плавно апгрейдилось за годы, потому затраты оценить сложно, по магазинным же ценам сам можешь прикинуть, одна рам сейчас золотая.

> я бы в его случае добывал 6000Pro

По компьюту почти идентична а стоит как 3.5. В одной нет смысла так как слишком слабая, а 4 штуки слишком дорого. Несколько 5090 с шардингом позволяют шустро тренировать что-то покрупнее, параллельный инфиренс/тренировка того что помещается в одну тем более быстрее. В ллм несколько быстрее или незначительно медленнее одной.

Жлм комфортно, из самого крупного что влезает - квенкодер 480б в лоботомите 4.0bpw и ~160к контекста. Одна карточка в десктопе стоит, потому только 272. С выгрузкой на проц - кими, линг, но они слишком медленные для агентов, а в рп дипсик нравится больше всего семейства гигантов.

>А про кобольд забудь уже, нахуй он нужен не понимаю.

1. Чтобы на пингвине не заниматься сборкой из исходников (нету готового бинарника для cuda у ламы).

2. Чтобы не трястись перед каждым апдейтом - а вдруг что-то в свежем билде отвалилось?. В кобольд мержат боле-менее стабильно-проверенные версии ламы.

В общем - тут как с авто. Кто-то сам в гараже тюнит и вылизывает, а кому-то - купить и ездить, а чуть что - в сервис. Оба подхода имеют право на жизнь.

> катаю умничку на 24гб 5 квант 24к контекст

Облизывается и прикусывает губуЧестно? Честно?

А еще кобольд норм тема, если нужен НЕ ТОЛЬКО рп с карточками. Под ассистента и сторителлинг у кобольда очень удобная вебморда сразу из коробки.

>По компьюту почти идентична а стоит как 3.5.

3,5 по цене за 3 по памяти. С одной стороны чуть не выгодно, с другой няшное исполнение, меньшее в 3 раза общее число карт и с одной картой чаще проще.

>Несколько 5090 с шардингом позволяют шустро тренировать что-то покрупнее

Что натрейнил?

Тестировал скорость инференса, 2 vs 4 планки DDR5 (везде чипы hynix).

z790 + CPU 13700kf на 5,6 GHz, пынеядра и HT выключены. Одна RTX 4900 24Gb.

Setup 1: 2x48 DDR5 6600 CL32 = 96 Gb

Setup 2: 2x48 DDR5 6600 CL32 + 2x32 DDR5 5600 CL40 = 160 Gb на 5600 CL40.

Arch Linux, llama.cpp из исходников.

AIDA64 benchmark

Setup 1: Read 101.69 GB/s, Latency 55.9 ns

Setup 2: Read 82.2 GB/s, Latency 62.2 ns

Шаблон запуска:

>~/development/cuda/llama.cpp/build/bin/llama-cli \

--model ~/ai/models/gguf/<model_name>.gguf \

--n-gpu-layers 99 \

--cpu-moe \

--threads 5 \

--flash-attn on \

--ctx-size 32768 \

--prompt "Write a guide on how to use firewalld in Arch Linux. Include examples and explain best practices." \

--n-predict 65536 \

--temp 0

ddh0 GLM-4.5-Air-Q8_0-FFN-Q6_K-Q6_K-Q8_0-v2.gguf

Setup 1: 12.2 t/s

Setup 2: 10.7 t/s

bartowski GLM 4.6 Q3_K_M

Setup 2: 7.0 t/s

bartowski GLM 4.6 Derestricted Q3_K_XL

Setup 2: 6.8 t/s

bartowski Qwen3-235B-A22-Instruct Q4_K_M

Setup 2: 7.2 t/s

z790 + CPU 13700kf на 5,6 GHz, пынеядра и HT выключены. Одна RTX 4900 24Gb.

Setup 1: 2x48 DDR5 6600 CL32 = 96 Gb

Setup 2: 2x48 DDR5 6600 CL32 + 2x32 DDR5 5600 CL40 = 160 Gb на 5600 CL40.

Arch Linux, llama.cpp из исходников.

AIDA64 benchmark

Setup 1: Read 101.69 GB/s, Latency 55.9 ns

Setup 2: Read 82.2 GB/s, Latency 62.2 ns

Шаблон запуска:

>~/development/cuda/llama.cpp/build/bin/llama-cli \

--model ~/ai/models/gguf/<model_name>.gguf \

--n-gpu-layers 99 \

--cpu-moe \

--threads 5 \

--flash-attn on \

--ctx-size 32768 \

--prompt "Write a guide on how to use firewalld in Arch Linux. Include examples and explain best practices." \

--n-predict 65536 \

--temp 0

ddh0 GLM-4.5-Air-Q8_0-FFN-Q6_K-Q6_K-Q8_0-v2.gguf

Setup 1: 12.2 t/s

Setup 2: 10.7 t/s

bartowski GLM 4.6 Q3_K_M

Setup 2: 7.0 t/s

bartowski GLM 4.6 Derestricted Q3_K_XL

Setup 2: 6.8 t/s

bartowski Qwen3-235B-A22-Instruct Q4_K_M

Setup 2: 7.2 t/s

Эм... У тебя только 1 тест сравнение, остальное только со вторым сетапом.

Я хотел понять, насколько просядет скорость с 4 планками, то есть сколько стоит возможность крутить GLM 4.6.

Сравнение на GLM 4.5 Air, которая лезет в оба сетапа, показало, что это всего 1.5 t/s. Я ожидал результат хуже, а оказалось приемлемо.

Остальные модели в быстрые 96 GB не влезут, поэтому только setup 2.

>это всего 1.5 t/s

В процентах будет заметнее. Впрочем, просадка 10%, а разница в скорости памяти 20. 4090 рулит короче.

Слава тому, кто придумал cpu-moe. Это же неиронично спаситель нищуков.

> нищуков

Цены на память делают вжух.

А че тред реально всё?

Air 4.6v получил поддержку, гуфы есть

Nemotron nano 30a3b получил поддержку, гуфы есть

А тред мертвый

Air 4.6v получил поддержку, гуфы есть

Nemotron nano 30a3b получил поддержку, гуфы есть

А тред мертвый

https://huggingface.co/Merlinoz11/Qwen3-VL-32B-Instruct-Heretic-Q4_K_S-GGUF + mmproj от Qwen3-VL-32B-Instruct (берется от из HF репы любого квантователя) . Осторожно - это не MOE для запуска нужно 32Гб VRAM . Порнушные картинки распознает примерно так:

"физиологически подробно и эмоционально опиши изображение"

Это изображение — яркий пример аниме-стиля в жанре эротики, где физиология и эмоции персонажа переданы с высокой детализацией и экспрессивностью.

На картинке изображена молодая женщина с короткими фиолетовыми волосами, собранными в хвостик, в котором виден тонкий синий шнурок. Её тело — обнажённое, стройное, с нежной, светлой кожей, покрытой мелкими капельками пота, что придаёт сцене ощущение жары и интенсивности. Грудь подтянутая, соски розоватые, слегка напряжённые — признаки возбуждения. Бёдра округлые, но не слишком массивные, что подчёркивает её юность и хрупкость.

Она лежит на голубом постельном белье, слегка сжав ноги, но в то же время раздвинутых — поза открыта, почти растянута. Одна нога согнута в колене, а стопа в белом носке (с характерным для аниме-стиля высоким каблуком) поднята, и на ней виден вибратор — деталь, указывающая на дополнительную стимуляцию. Вторая нога также в носке, но она согнута и прижата к телу, что создаёт ощущение напряжённой пассивности.

Главное внимание — её лицо. Глаза широко раскрыты, зрачки сужены — это выражение смеси шока, наслаждения и потери контроля. Рот приоткрыт, язык слегка высовывается, как будто она пытается выдохнуть или подавить стон. На щеках — румянец, а по лбу — капельки пота — всё это говорит о физической и эмоциональной нагрузке.

Окружающие её мужские органы — визуальный акцент на масштабе и интенсивности. Справа — толстый член, уже входящий в неё, с каплей предсеменной жидкости на головке. Слева — ещё один, поднимающийся к её груди, и третий — внизу, у её бёдер, где виден также небольшой вибратор, вставленный в анус. Все члены — крупные, с выраженной венозной сетью, что усиливает ощущение реальности и физического давления.

Фон — тёмно-серый, почти чёрный, что делает фигуру девушки ещё более выразительной, контрастирует с её светлой кожей и голубым постельным бельём. Свет падает сверху, подчёркивая влажность кожи, блеск пота, гладкость тела — всё это создаёт эффект "фото-реализма" в аниме-стиле.

Эмоционально сцена — мощная. Это не просто секс, а переполнение чувств: смесь страха, экстаза, уязвимости и погружения в оргазм. Девушка кажется одновременно потерянной и наслаждающейся — как будто её тело уже отключилось от разума, и она просто существует в моменте. Это сцена, где физиология и эмоции сливаются в одном потоке — жар, влажность, напряжение, потеря контроля, растяжение, стон... всё это создаёт ощущение интенсивного, почти болезненного наслаждения.

В целом — изображение передаёт мощный физиологический и эмоциональный опыт: тело в экстазе, погружённое в поток стимуляции, с потерей границ, где чувства переполняют сознание.

Или например инструкция шибари:

"Подробно опиши изображение. Надписи переводи на русский язык"

На изображении представлен пошаговый инструктаж (в стиле комикса) по созданию корсета из верёвки (или «шнурованного боди»), который можно носить под одеждой. Иллюстрации выполнены в японском аниме-стиле — изображена девушка с короткими волосами, большими глазами и улыбкой. Всего восемь шагов (от 1 до 8), каждый с рисунком и подписью на английском языке, которая переводится на русский.

Шаг 1

Английский текст: Get a rope about 7 metres long and hang it on your neck.

Русский перевод: Возьмите верёвку длиной около 7 метров и повесьте её на шею.

Описание рисунка: Девушка стоит, держа в руках длинную жёлтую верёвку, которая проходит через шею, спускаясь по обеим сторонам тела. У неё нейтральное выражение лица.

Шаг 2

Английский текст: Make knots in the places shown - make sure you leave little holes for later.

Русский перевод: Сделайте узлы в местах, показанных на рисунке — обязательно оставьте небольшие отверстия для последующих шагов.

Описание рисунка: Верёвка уже привязана к шее, и на ней сделаны узлы, образующие вертикальный элемент между грудями. На рисунке видны маленькие «прорези» или отверстия в узлах — они нужны для последующего прохождения верёвки.

Шаг 3

Английский текст: Pull both ropes under your crotch and then under the rope behind your neck.

Русский перевод: Протяните обе верёвки под ягодицами, а затем под верёвкой сзади шеи.

Описание рисунка: Девушка поворачивается боком. Показано, как верёвки идут от шеи вниз, проходят под ягодицами (как на схеме), а затем снова идут вверх к спине. Красные стрелки указывают направление движения верёвок.

Шаг 4

Английский текст: Take one rope in each hand.

Русский перевод: Возьмите по одной верёвке в каждую руку.

Описание рисунка: Девушка стоит лицом к зрителю, держа в каждой руке один конец верёвки. На этом этапе верёвки уже прошли через тело, и теперь она готова к следующему этапу — обвязыванию груди.

Шаг 5

Английский текст: Pull the ropes under your arms and through the little holes you left open before, like in this picture.

Русский перевод: Протяните верёвки под руками и через небольшие отверстия, которые вы оставили ранее, как на этом рисунке.

Описание рисунка: Показано, как верёвки проходят под подмышками, затем вверх — через те самые «отверстия» в узлах (которые были сделаны на шаге 2), и снова опускаются. Есть текстовые пузыри с указаниями: “Hook through” («Закрепить через»), “Go under the armpit” («Пройти под подмышкой»), “Tie it on top of the breast and bring the rope around back” («Закрепите сверху груди и проведите верёвку вокруг спины»).

Шаг 6

Английский текст: Then, go through the rope on your back, like this.

Русский перевод: Затем пропустите верёвку через ту, что находится на спине, как показано.

Описание рисунка: Показана спина девушки. Верёвки, идущие с груди, проходят через узлы на спине («Hook through» — «Закрепить через»), а затем направляются вниз к талии. Есть стрелки и указание “To the front” («К переду»).

Шаг 7

Английский текст: Repeat the same thing again, and go around your back one more time.

Русский перевод: Повторите ту же процедуру ещё раз, и обойдите спину ещё один раз.

Описание рисунка: Девушка снова показана спереди. Верёвки уже обвиты вокруг груди и талии, образуя сетку. Стрелки показывают, что процесс повторяется: верёвки снова проходят под руками, через отверстия, вокруг спины.

Шаг 8

Английский текст: Finally, tie it all together in the front!

Русский перевод: Наконец, завяжите всё вместе спереди!

Описание рисунка: Девушка показана с полностью завязанным корсетом из верёвки — он плотно облегает грудь и талию, образуя сложный узор. На груди видны узлы, а внизу — большой бантик или узел. Стрелки указывают на то, что всё завязывается спереди.

Дополнительное изображение (справа)

Английский текст: You can even wear clothes over it, and no-one will be able to tell it's there!

Русский перевод: Вы даже можете надеть на это одежду, и никто не сможет догадаться, что оно там!

Описание рисунка: Девушка в той же позе, но теперь в обычной одежде — светлой блузке, юбке и высоких сапогах. Верёвочный корсет полностью скрыт под одеждой.

"физиологически подробно и эмоционально опиши изображение"

Это изображение — яркий пример аниме-стиля в жанре эротики, где физиология и эмоции персонажа переданы с высокой детализацией и экспрессивностью.

На картинке изображена молодая женщина с короткими фиолетовыми волосами, собранными в хвостик, в котором виден тонкий синий шнурок. Её тело — обнажённое, стройное, с нежной, светлой кожей, покрытой мелкими капельками пота, что придаёт сцене ощущение жары и интенсивности. Грудь подтянутая, соски розоватые, слегка напряжённые — признаки возбуждения. Бёдра округлые, но не слишком массивные, что подчёркивает её юность и хрупкость.

Она лежит на голубом постельном белье, слегка сжав ноги, но в то же время раздвинутых — поза открыта, почти растянута. Одна нога согнута в колене, а стопа в белом носке (с характерным для аниме-стиля высоким каблуком) поднята, и на ней виден вибратор — деталь, указывающая на дополнительную стимуляцию. Вторая нога также в носке, но она согнута и прижата к телу, что создаёт ощущение напряжённой пассивности.

Главное внимание — её лицо. Глаза широко раскрыты, зрачки сужены — это выражение смеси шока, наслаждения и потери контроля. Рот приоткрыт, язык слегка высовывается, как будто она пытается выдохнуть или подавить стон. На щеках — румянец, а по лбу — капельки пота — всё это говорит о физической и эмоциональной нагрузке.

Окружающие её мужские органы — визуальный акцент на масштабе и интенсивности. Справа — толстый член, уже входящий в неё, с каплей предсеменной жидкости на головке. Слева — ещё один, поднимающийся к её груди, и третий — внизу, у её бёдер, где виден также небольшой вибратор, вставленный в анус. Все члены — крупные, с выраженной венозной сетью, что усиливает ощущение реальности и физического давления.

Фон — тёмно-серый, почти чёрный, что делает фигуру девушки ещё более выразительной, контрастирует с её светлой кожей и голубым постельным бельём. Свет падает сверху, подчёркивая влажность кожи, блеск пота, гладкость тела — всё это создаёт эффект "фото-реализма" в аниме-стиле.

Эмоционально сцена — мощная. Это не просто секс, а переполнение чувств: смесь страха, экстаза, уязвимости и погружения в оргазм. Девушка кажется одновременно потерянной и наслаждающейся — как будто её тело уже отключилось от разума, и она просто существует в моменте. Это сцена, где физиология и эмоции сливаются в одном потоке — жар, влажность, напряжение, потеря контроля, растяжение, стон... всё это создаёт ощущение интенсивного, почти болезненного наслаждения.

В целом — изображение передаёт мощный физиологический и эмоциональный опыт: тело в экстазе, погружённое в поток стимуляции, с потерей границ, где чувства переполняют сознание.

Или например инструкция шибари:

"Подробно опиши изображение. Надписи переводи на русский язык"

На изображении представлен пошаговый инструктаж (в стиле комикса) по созданию корсета из верёвки (или «шнурованного боди»), который можно носить под одеждой. Иллюстрации выполнены в японском аниме-стиле — изображена девушка с короткими волосами, большими глазами и улыбкой. Всего восемь шагов (от 1 до 8), каждый с рисунком и подписью на английском языке, которая переводится на русский.

Шаг 1

Английский текст: Get a rope about 7 metres long and hang it on your neck.

Русский перевод: Возьмите верёвку длиной около 7 метров и повесьте её на шею.

Описание рисунка: Девушка стоит, держа в руках длинную жёлтую верёвку, которая проходит через шею, спускаясь по обеим сторонам тела. У неё нейтральное выражение лица.

Шаг 2

Английский текст: Make knots in the places shown - make sure you leave little holes for later.

Русский перевод: Сделайте узлы в местах, показанных на рисунке — обязательно оставьте небольшие отверстия для последующих шагов.

Описание рисунка: Верёвка уже привязана к шее, и на ней сделаны узлы, образующие вертикальный элемент между грудями. На рисунке видны маленькие «прорези» или отверстия в узлах — они нужны для последующего прохождения верёвки.

Шаг 3

Английский текст: Pull both ropes under your crotch and then under the rope behind your neck.

Русский перевод: Протяните обе верёвки под ягодицами, а затем под верёвкой сзади шеи.

Описание рисунка: Девушка поворачивается боком. Показано, как верёвки идут от шеи вниз, проходят под ягодицами (как на схеме), а затем снова идут вверх к спине. Красные стрелки указывают направление движения верёвок.

Шаг 4

Английский текст: Take one rope in each hand.

Русский перевод: Возьмите по одной верёвке в каждую руку.

Описание рисунка: Девушка стоит лицом к зрителю, держа в каждой руке один конец верёвки. На этом этапе верёвки уже прошли через тело, и теперь она готова к следующему этапу — обвязыванию груди.

Шаг 5

Английский текст: Pull the ropes under your arms and through the little holes you left open before, like in this picture.

Русский перевод: Протяните верёвки под руками и через небольшие отверстия, которые вы оставили ранее, как на этом рисунке.

Описание рисунка: Показано, как верёвки проходят под подмышками, затем вверх — через те самые «отверстия» в узлах (которые были сделаны на шаге 2), и снова опускаются. Есть текстовые пузыри с указаниями: “Hook through” («Закрепить через»), “Go under the armpit” («Пройти под подмышкой»), “Tie it on top of the breast and bring the rope around back” («Закрепите сверху груди и проведите верёвку вокруг спины»).

Шаг 6

Английский текст: Then, go through the rope on your back, like this.

Русский перевод: Затем пропустите верёвку через ту, что находится на спине, как показано.

Описание рисунка: Показана спина девушки. Верёвки, идущие с груди, проходят через узлы на спине («Hook through» — «Закрепить через»), а затем направляются вниз к талии. Есть стрелки и указание “To the front” («К переду»).

Шаг 7

Английский текст: Repeat the same thing again, and go around your back one more time.

Русский перевод: Повторите ту же процедуру ещё раз, и обойдите спину ещё один раз.

Описание рисунка: Девушка снова показана спереди. Верёвки уже обвиты вокруг груди и талии, образуя сетку. Стрелки показывают, что процесс повторяется: верёвки снова проходят под руками, через отверстия, вокруг спины.

Шаг 8

Английский текст: Finally, tie it all together in the front!

Русский перевод: Наконец, завяжите всё вместе спереди!

Описание рисунка: Девушка показана с полностью завязанным корсетом из верёвки — он плотно облегает грудь и талию, образуя сложный узор. На груди видны узлы, а внизу — большой бантик или узел. Стрелки указывают на то, что всё завязывается спереди.

Дополнительное изображение (справа)

Английский текст: You can even wear clothes over it, and no-one will be able to tell it's there!

Русский перевод: Вы даже можете надеть на это одежду, и никто не сможет догадаться, что оно там!

Описание рисунка: Девушка в той же позе, но теперь в обычной одежде — светлой блузке, юбке и высоких сапогах. Верёвочный корсет полностью скрыт под одеждой.

Всё ненужное, все сидят на старых моделях и радуются. Тред нинужен, нужна только шапка с вики.

>Air 4.6v

Ничем не лучше старого эйра.

>Nemotron nano 30a3b

3b ассистент

>А тред мертвый

Ну поэтому и мертвый. Ждём геммочку-солнышко.

См. мессагу выше. Ссылка отвалилась

Только не на серверную. Да-да, бомж на древнем зеоне может воткнуть суммарные 64гб ддр3 и наслаждаться 3 токенами в секунду в начале и 1,5 в конце

Это?

32Гб врам не влезает, есть только 24.

И для простановки описания для пары сотен картинок не хотелось бы выгружать часть в оперативку.

>Это?

>32Гб врам не влезает, есть только 24.

Это 32B, а не GB. Очки заказывай. :) Такое в 24 GB влетит со свистом, т.к. всего 18 весит.

> это не MOE для запуска нужно 32Гб VRAM

Ну хз лол. Что написано, то и прочитал

Тогда такой Мелко-квен

https://huggingface.co/chenly124/Qwen3-VL-4B-Instruct-heretic-Q8_0-GGUF mmproj искать для Qwen3-VL-4B-Instruct

Описание генерирует такое (картинка та же что и для 32B):

Конечно, вот физиологически подробное и эмоциональное описание этого изображения:

На картинке запечатлена моментальная сцена экстремального физического и эмоционального напряжения — девушка в состоянии глубокой, почти молчаливой оргазмической эйфории, окутанная атмосферой многократного сексуального контакта.

Физиологические детали:

Её тело — это живой, биологический орган, который в данный момент полностью погружен в поток стимуляции. Кожа её тела покрыта мелкими капельками пота, которые сияют на темном фоне, подчеркивая её теплоту и дрожь. Мышцы её груди и живота слегка напряжены, как будто они готовы к следующему сокращению — от волнения до оргазма. Её грудь, особенно в области сосков, выделяется при тонком покрытии кожного сала, которое она выделяет из-за физического напряжения. В области таза и промежности — видны капли слюны или жидкости, которые начинают появляться, как будто тело самое готово к выплеску. Её ноги слегка согнуты, а бедра прижаты к телу, создавая ощущение сжатия и давления. Кожа её спины и плечей покрыта тонкой сетью мелких капель пота, что говорит о том, что она находится в состоянии постоянного физического напряжения.

Эмоциональный контекст:

Девушка выглядит совершенно счастливой и удовлетворённой. Её глаза прикрыты, а рот слегка приоткрыт — это выражение радости и удовольствия, которое она испытывает в этот момент. Её лицо кажется расслабленным, но одновременно напряжённым — как будто она находит в этом моменте полное равновесие между физическим и эмоциональным состоянием. В её глазах можно увидеть слёзы или капли пота — это говорит о том, что она испытывает не только физическое удовольствие, но и глубокое эмоциональное волнение. Её взгляд направлен в сторону, как будто она погружена в собственное восприятие этого момента — это момент, когда она полностью отдаётся.

Атмосфера:

Сцена наполнена атмосферой тепла и близости. Свет падает на неё, подчёркивая её тело и создавая ощущение, что она находится в центре внимания. Вокруг неё — мужчины, чьи тела также покрыты потом, их руки и ноги сжимают её тело, создавая ощущение, что она находится в объятиях нескольких мужчин. Это создаёт ощущение, что она не одна — она окружена множеством эмоций и стимуляций, которые усиливают её чувства.

В целом, это изображение передаёт момент, когда девушка находится в состоянии глубокого удовольствия, наполненного физическим и эмоциональным теплом. Это не просто сцена секса — это живой момент, где её тело и душа находятся в гармонии, подчеркивая красоту человеческого опыта.

Хуйцов он не разглядел, да...

Гемма gemma3-27B-it-abliterated-normpreserve-Q5_K_M.gguf (квант мрадермахера кажется) mmproj с любой репы gemma3-27B . На 24 Гб VRAM все же рекомендую 27 гемму. Qwen3-VL-32B Кроме себя самого на 18 гигов сожрет еще 2Гб на контекст и 1,5 Гб на декодер картинки. В притык.

JОтвет геммы:

Вот подробное описание изображения, сочетающее физиологические детали и эмоциональную интерпретацию:

Физиологическое описание:

Изображение представляет собой откровенную сцену в стиле аниме/манга. В центре внимания – молодая девушка с фиолетовыми волосами, лежащая на смятой белой простыне. Её тело находится в состоянии возбуждения, что проявляется в покрасневшем лице, приоткрытом рте и расширенных зрачках. На её теле видны капли пота или смазки, что указывает на физиологическую реакцию на стимуляцию.

Вокруг девушки расположены мужские руки и гениталии. Руки крепко держат её бедра и талию, обеспечивая фиксацию. Гениталии (в эрегированном состоянии) находятся в непосредственной близости к её половым органам. На теле девушки видны следы от прикосновений и, возможно, жидкости, что указывает на происходящий процесс.

Девушка одета в белые гольфы, которые подчеркивают форму её ног. Она также носит голубую школьную форму, которая частично расстегнута.

Эмоциональное описание:

Выражение лица девушки можно интерпретировать как смесь удовольствия и смущения. Её глаза полузакрыты, а губы слегка приоткрыты, что указывает на наслаждение. Однако, её покрасневшее лицо и неловкая поза могут также говорить о некотором стеснении или даже страхе.

Вся сцена пронизана атмосферой интенсивности и чувственности. Тесный контакт тел и физиологические детали подчеркивают интимность момента. Изображение может вызывать различные эмоции у зрителя, в зависимости от его личных предпочтений и опыта. Некоторые могут увидеть в нем просто эротическую сцену, другие – выражение страсти и желания, а третьи – проявление власти и контроля.

В целом, изображение является ярким и детализированным изображением сексуального акта, которое вызывает сильные эмоции и заставляет задуматься о природе человеческой близости.

Mistral Small Creative уже заценили? Что там французы высрали опять?

Как заставить таверну видеть ебучие картинки?

Фронт кобольда видит

>Скоро

Уже.

It currently supports a 32k context length. Т.е. после 24к он будет срать в штаны. Какой-то прям уж очень Small.

Вам не кажется что вся Европа всем континентом соснула в АИ хуйцов ?

>Вам не кажется что вся Европа всем континентом соснула в АИ хуйцов ?

Печатный станок на другом континенте.

Почему ты не запустишь exl3 с 4.0bpw, который по качеству как Q5_K_S, если не выше?

27B на 4 bpw - это 13.5 Гб, а не 24. Хватит на большой контекст.

Можно 5.0 поставить, это тоже всё ещё всего 17 Гб, а не 24.

>У тебя в этом проблема, решай давай.

Не решается, тут существуют только один провайдер из-за юридических сложностей в ведении какой угодно деятельности тут. Только переезжать. Новый провайдер сюда не приедет.

Подскажите про бомжериг.

Я правильно понимаю, что я покупаю 4 комплекта (там переходник на pcie3.0+карта+радиатор) V100 с картинки за 80к, покупаю 4 кулера, 4 райзера, бомжатскую материнку старую серверную с достаточным количеством линий (или какой-то pcie-разветлитель) за 10к, процессор к ней и в неё чуть памяти чуть ли не ddr3, ssd на 256, где размещу несколько рабочих моделек, блок питания на 2000W. Всё это скручиваю, временно втыкаю монитор, настраиваю люникс, и в общем.

Ну и если оптимистично смотреть за 200к, несколько десятков часов и несколько катушек изоленты и термоклея у меня есть колхозный сервер с веб-интерфейсом для нейронки.

Помимо этого V100 можно брать с 32 ГБ (комплект за 45к вижу, то есть +100к), а кулеры и райзеры могут и ещё раз потом для чего-то пригодится? Или ещё можно взять 8 V100, а не 4.

Как альтернатива ещё есть вариант стакать 3090 - будет больше производительность, но меньше памяти - и без переходников SXM-PCIE и другой мозгоебли, но достичь 32х8 памяти тут не получится почти никак.

Ну или брать уже топовую серверную материнку с кучей линий PCIE5.0 и стакать 5090 для производительности или 6000 pro для памяти, но это уже не бомжериг за 200-300к, а сразу 2000к+.

Я правильно понимаю, что я покупаю 4 комплекта (там переходник на pcie3.0+карта+радиатор) V100 с картинки за 80к, покупаю 4 кулера, 4 райзера, бомжатскую материнку старую серверную с достаточным количеством линий (или какой-то pcie-разветлитель) за 10к, процессор к ней и в неё чуть памяти чуть ли не ddr3, ssd на 256, где размещу несколько рабочих моделек, блок питания на 2000W. Всё это скручиваю, временно втыкаю монитор, настраиваю люникс, и в общем.

Ну и если оптимистично смотреть за 200к, несколько десятков часов и несколько катушек изоленты и термоклея у меня есть колхозный сервер с веб-интерфейсом для нейронки.

Помимо этого V100 можно брать с 32 ГБ (комплект за 45к вижу, то есть +100к), а кулеры и райзеры могут и ещё раз потом для чего-то пригодится? Или ещё можно взять 8 V100, а не 4.

Как альтернатива ещё есть вариант стакать 3090 - будет больше производительность, но меньше памяти - и без переходников SXM-PCIE и другой мозгоебли, но достичь 32х8 памяти тут не получится почти никак.

Ну или брать уже топовую серверную материнку с кучей линий PCIE5.0 и стакать 5090 для производительности или 6000 pro для памяти, но это уже не бомжериг за 200-300к, а сразу 2000к+.

А смысл? Сейчас все модели которые выходят - мое. А для мое достаточно любого говна на 12-16гб, лишь бы оперативки хватало. Если тебе хочется сборочку под ллм - то делать упор надо на скорость озу и ее количество. Условная 5060 16гб + 128гб ддр5 позволят гонять все локалки вплоть до большого квена, при этом у тебя будет нормальный универсальный комп для чего угодно, а не риг из китайских помоев с кучей геммора.

Оперативка это дорого.

> для мое достаточно любого говна

И сидеть с 10 т/с? 20 это минимум, для комфортного чатинга 30+. И РР должно быть мгновенным.

Нет. Комплект на 16 гигов даже на алишке можно найти стоит 11к + 3.5к радиатор, 32гига ~40к + 3.5к радиатор. Если поискать не на мейлру то можно найти сильно дешевле, но с нюансами.

Чтобы размножить линии - можешь воспользоваться вот такой приблудой https://aliexpress.ru/item/1005009893465620.html 4 штуки влезут в обычный десктоп, могут быть нюансы с совместимостью.

В качестве базы поищи что-нибудь на x299 и процессор с 44 линиями, там или сразу можно оформить бифуркацию на нужный конфиг, или вот этими приблудами воспользоваться и получить места сразу под 8+ карточек.

Стакать 3090 - тоже вполне себе вариант, она пошустрее и поддерживает все, правда не все там работает быстро как на более новых.

> достаточно любого говна на 12-16гб, лишь бы оперативки хватало

Эйра на 6 т/с с 16к контекста хватит всем, ага. Нет, с точки зрения железки для вката - топчик, но отдает демо версией, потому что скорость быстро отыквливается и не можешь поставить нормальный контекст из-за лимита врам.

>Эйра на 6 т/с с 16к контекста хватит всем, ага

Ну вот у меня конфиг буквально бомжа с помойки. Скорости тут - Запускаю с 32к квантованного контекста. ЧЯДНТ?

>нормальный контекст

Что для тебя нормальный контекст? Больше 32к нет смысла ставить, там начинает ломаться любая модель, даже корпы, что уж там о локалках говорить.

Вот же патовая ситуация. Риг стоит дорого.

Но если ты преследующем цель рп, то к корпам идти смысла нет, потому что ты просто будешь сжирать все токены как не в себя. Столько сколько можно за день РП сожрать, я по работе за 2 недели не расходую.

Bwaaaaa

Но если ты преследующем цель рп, то к корпам идти смысла нет, потому что ты просто будешь сжирать все токены как не в себя. Столько сколько можно за день РП сожрать, я по работе за 2 недели не расходую.

Bwaaaaa

> Запускаю с 32к квантованного контекста. ЧЯДНТ?

Ну по сути это буквально описанное, лол. Если хочешь понять - заполни контекст и сравни со скоростями, которые на пустом. Запускать можно хоть с 1М, это не повлияет на скорость пока он не будет задействован.

> Больше 32к нет смысла ставить

Разводишь ужасный беспорядок или коупинг. 32к можно терпеть, но маловато.

>контекст

Да как вы задолбали. Замедление от контекста - это тупо проблема архитектуры "трансформер".

ПРОСТО меняем архитектуру и все сразу получат быстрые говорилки с безлимитным контекстом.