Чем это 4-х процессорное чудо штатно охлаждается?

Но почему на базе 3 геммы, если у них готова 4?

Вот и думай

Это двухпроцессорное, 2011в4 просто для сравнения лежат, а так не напрягаясь башня сдувает 270. В прошлом треде было

Пол года прошло с эира и последнего громкого релиза

Заи не поняли как сделали эир и обосрались

Гемма без сомнений выйдет сейфмакснутой, так там еще какие то йоба анти джейлбрейк техники завезут

Мистраль это мистраль

Надежды нет

Заи не поняли как сделали эир и обосрались

Гемма без сомнений выйдет сейфмакснутой, так там еще какие то йоба анти джейлбрейк техники завезут

Мистраль это мистраль

Надежды нет

> Какие аргументы в пользу "не покупать и ждать"?

скоро договорнячок, все санкции снимут, доллар станет по 68, в России начнут производить свою оперативу, процессоры и видеокарты, и не надо будет платить по 5000 рублей "технологический сбор" за каждую единицу иностранных комплектующих, ну и в конце концов лопнет пузырь ИИ и на вторичке появятся тонны дешёвой памяти DDR5

Политический бот, игнорируем.

Wan2.2 норм.

А объем не важен, выгружается в оперативу, потери не критичные.

Главное — чип.

>платить по 5000 рублей "технологический сбор"

Это наименьшая из проблем вообще (я погуглил).

Если комп стоит 200 тыс, 5 тыс - 2.5%, это мелочь.

Если комп вообще невозможно купить (его нет)...

Вопрос в том, будут ли они вообще в продаже?..

Ты забыл подписаться.

Оварида-шиз.

Ну, смотри, если речь идет о генерации конкретно видео, то может быть 5070 Ti актуальнее. Но если делать упор на картинки и на ЛЛМ, то взять 2 5060 Ti за почти ту же цену, выглядит уместнее. ЛЛМки выиграют сильно, картинки не очень сильно, им и одной хватит. Чел со сборкой вроде не говорил, что ему видео нужно. Хотя, наверняка захочется в итоге. И тут встает вопрос приоритетов.

В чем я не прав?

Меня просто смерть как заебало эхо эира, сижу блять с 9 токенами жду ответ только чтобы на половине увидеть повторение своего

Согласен.

32 гига будет очень приятно. Во-первых, всякие Gemma/Mistral/Qwen прям залетают без сомнительных компромиссов в виде Q3_K_M.

>vocabulary size of 130000

Кто-нибудь знает, почему они такой большой словарь делают? Технически это должно повышать нагрузку, поскольку приходится перемножать просто гигантские матрицы размером в полторы сотни тысяч, разве нет?

Очевидно, размер <256 был бы выгоднее по компьюту.

> "ты и так достаточно страдал на ддр2" да и нужно вспомнить, что жизнь конечна и может не успеть насладиться обновкой.

база

база

> 5 тыс - 2.5%, это мелочь.

5 тыс с каждого элемента

>поскольку приходится перемножать просто гигантские матрицы размером

При эмбединге и деэмбединге, 2 раза за токен. Так что похуй, там 61 слой и десяток умножений на каждом.

С каждого резистора на плате...

Я после этого решил взять 5070ти вместо 5060ти 16гб и правильно сделал, киберпанк на ультрах в 1080р без ддлс +-50 фпс, правда может из-за проца бутылочное горлышко, но но д 50% загружен.

Я правильно понял, запускаю кобольд в нем модель, потом запускаю сили таверн?

Глупцы, не теряйте время и не бросайте на ветер деньки, а переходите на корпы. За ними будущее, очевидно.

> Бля, буду

>переходите на корпы

>спустя 15 минут кума

Помидор еще не все новые токены ревокнул ?

Блять, наебщики хуевы. В комментариях писали, что продавец v100 сделал так, что пошлину не надо платить, и что он сразу адаптер кладет. Хуй там, и пошлину заплатил, и без адаптера пришло. Охуенно, еще месяц адаптер теперь ждать. Пиздец, ну и говно.

Вот не знаю как вы, но я верю.

Как ты до своих 15 лет дожил с таким IQ?

Да к обоим ответ подходит.

Да весь тред такой.

>как подбодрила меня нейронка

Мне Ллама-Скаут (онлайн) написала "если не горит - лучше подождать, цены снизятся".

>"ты и так достаточно страдал на ддр2"

Ну, я не страдаю от DDR2, я страдаю от отсутствия SSE4.2 в Xeon... И от присутствия РКН.

>да и нужно вспомнить, что жизнь конечна и может не успеть насладиться обновкой.

Смысл наслаждаться, если всё равно умирать? Ну, не успеешь и умрёшь. Минусы есть?

Корпораты говорят: "купи, а то не успеешь". Не успеешь что? Не успеешь передать все свои деньги в бездонный карман корпората? Не успеешь вколоть дозу бесполезного на практике слопа в вену? Не успеешь подрочить свой писюн своей рукой, хотя для этого никакие продукты корпората тебе не нужны, ведь и писюн, и рука у тебя уже есть? Остановись и подумой. Смысл в этих "наслаждениях"?

Это как с играми, онлайн-играми, особенно гача-играми. Тебе говорят: "событие ограничено, успейте поиграть и выбить %что-то%, а если не успеваете - можете влить реальные деньги и успеть"... И многие ведутся на эту уловку, но зачем? Что тебе, игроку, даст эта лимитированная фигня? Это просто пиксели на экране, такие же бессмысленные и бесполезные, как и любые другие... Люди создали буквально миллионы игр, многие из них совершенно бесплатны или доступны на торрентах как почти легальное abandonware, так зачем тебе добиваться конкретно этих пикселей в конкретно этой игре? Потому что корпорат сказал "купи, а то не успеешь"? Нет, тебе это не нужно. Твоему организму вообще ничего не нужно кроме минимально питательной еды, сна и укрытия от ветра, дождя и снега.

Это глобальная проблема. Хитрые люди эксплуатируют нас, дураков, сидя морковкой на удочке, а мы грызёмся и доказываем друг другу, какая морковка выгоднее другой, хотя ни та, ни другая нам не нужна...

У меня голова лопается.

Хули всё так гибко настраивается в вашем ллме?

Семплеры, промпт, темплейт - от всего меняется выдача координально, так можно вечность их крутить и ни разу не покумить, всегда знаешь что можно настроить лучше

Хули всё так гибко настраивается в вашем ллме?

Семплеры, промпт, темплейт - от всего меняется выдача координально, так можно вечность их крутить и ни разу не покумить, всегда знаешь что можно настроить лучше

Если не хочешь парить мозги настройкой, берёшь из шапки

>Однокнопочные инструменты на базе llamacpp с ограниченными возможностями

Всё работает из коробки с настройками по умолчанию, которые закопали подальше.

>и ни разу не покумить

Открою секрет: тебе наврали - для мастурбации никакая LLM не нужна.

Ты её сам то тестил, она не развалится через 10 сообщений?

Дядь, я про 12b а не про 27

>Ты её сам то тестил, она не развалится через 10 сообщений?

Новый метод аблитерации, аноны нахваливали

>Дядь, я про 12b а не про 27

27 лучше 12.

Темплейт фиксирован на модельку.

Семплер в основном берешь рекомендуемый если есть, или дефолтный какой нравится, и на нем сидишь. Единственное иногда температуру можно подпинывать для креатиффчика.

С промптом посложнее, но опции тоже есть. Либо берешь готовую и проверенную карточку. Либо если тебе достаточно просто попиздеть в определенном сеттинге, то просто описываешь историю, а нейронка генерит тебе креатиффчик. Ну если уже тебе нужны особые персонажи-хуяжи, какие-то приколы с сюжетом и т.д., тогда надо ебаться по полной.

Про пошлину там же писать продавцу надо было и обычной почтой вместо cainiao. С адаптером слишком жирно, есть лоты именно с ними, написал бы продавцу по обоим вопросам.

> месяц

Отдаленная локация?

> Мне Ллама-Скаут (онлайн) написала "если не горит - лучше подождать, цены снизятся".

Сначала хотел спросить рофлишь ли ты, а потом глянул на остальной пост - ну и пиздец.

Сложно по началу, потом привыкаешь и разбираешься. И главное что за исключением редких кейсов если все "в пределах нормы" без явных косяков и перегибов, то определяющей будет все равно модель.

Вновь выражаю дань уважения большеквену во 2 кванте, эир так никогда не сможет

Несправедливо его тут вспоминают только за русик, русик у него говно.

Эир после квена это как квен дома или продукт квеносодержащий, синтетика, ассистент в маске человека, такое внимание к деталям на 2 кванте, эмоциональное вовлечение модельки и понимание всех намеков и поддекстов, я прям поражен

Ну и конечно датасет х2.2 от эира оочень сильно ощущается

Всё же надо было брать рам под 4 квант когда была возможность

Несправедливо его тут вспоминают только за русик, русик у него говно.

Эир после квена это как квен дома или продукт квеносодержащий, синтетика, ассистент в маске человека, такое внимание к деталям на 2 кванте, эмоциональное вовлечение модельки и понимание всех намеков и поддекстов, я прям поражен

Ну и конечно датасет х2.2 от эира оочень сильно ощущается

Всё же надо было брать рам под 4 квант когда была возможность

Какой конкретно квен?

->

>большеквену

Ну ебать, есть кодер на 480б, есть обычный на 235б, есть вижуал на 235б.

Кто-то кумит на кодере?

Очевидно, что если сравнивают с эйром, то это 235B, так как он во втором кванте сравним по требованиям с эйром в 4-м. Вижуал свежий, не факт что есть поддержка, да и смысла в вижуале для РП нет. Так что остаётся один вариант.

>потом глянул на остальной пост - ну и пиздец

Что не так? Нужно срочно бежать скупать всё, что продают?

Смысла в жизни нет, а значит нет смысла куда-либо торопиться...

По моему аноны ян лабс нахваливали, но он реально пиздатый.

Я щас сам сижу на 27b аблитерации от янлабса, но 7тс это полуафк ролеплей, попробую 12b как будет время, в любом случае это гемма, всяко лучше 12b мистраля в ерп.

чел, это я написал тот коммент про адаптер.

Мне пришел с адаптером, я не обманул.

Очевидно китаец решил оптимизировать расходы, когда понял, что он и так по низу рынка продает.

Ты брал на 16 гб или на 32?

Есть с адаптером, есть без.

https://aliexpress.ru/item/1005010333739995.html?sku_id=12000052011860464

Вот за 11700 16гб версия с адаптером, например.

-мимокрокодил

>Я щас сам сижу на 27b аблитерации от янлабса, но 7тс это полуафк ролеплей, попробую 12b как будет время, в любом случае это гемма, всяко лучше 12b мистраля в ерп.

Попробуй https://huggingface.co/TheDrummer/Magidonia-24B-v4.3

Я на него перешел как раз с разных Гемм 27, в том числе normpreserve, и довольно сижу хрюкаю (не хохол).

Я тоже так думал, но недавно купил первый раз в жизни пиксели в игре и порадовался, а потом купил свою сборку и ахуел от ютуба, в потом от того, что нвидиа апскейлит 480р аниме видео до разрешения экрана в реальном времени, после этого я пожалел, что столько лет ждунствовал, мог бы еще несколько лет назад купить среднесборку и не ограничивать себя ради большего прироста в будущем, в общем зачем страдать когда можно не страдать.

Тебя реально устроил интеллект мистраля после геммы? Я как понимаю у тебя все сюжеты это держание за ручки и ты ебёшь меня я ебу тебя в ввакуме? Я не осуждаю, просто у меня впринципе кейсы это карты на 1к токенов и огромные лорбуки, мистраль там просто обосрётся.

Всё дело в том что ему не нужна карточка на тыщу токенов, огромный промпт и лорбук объясняющий что такое писька и секс, чтобы юзать мистраль

Найс тралленк, попробуй потоньше.

У Геммы реальная проблема с пониманием различных поз и логикой кума, например ей ебать в жопу вагиной это норма, даже если расписать в систем промпте, что это невозможно и почему. Ну а так у меня меньше чем на 1000 то и нет картонок, в среднем 1600, пробовал и на 2500 с несколькими персонажами, все отлично схватывает и контекст держит. Кум намного лучше чем на Гемме, Рп как минимум не хуже, но модель заметно быстрее.

Если что, то кроме normpreserve я смотрел базовую, Big Tiger, R1, Синтвейв и Синтию.

Насколько локальные модели могут в расчеты и поиск информации в сети?

Я спрашивал Gemini 3 (которая думающая и может в поиск в сети и вообще большая модель) сходить по ссылке и проверить верность расчетов в посте и она не смогла, но написала тонну несвязанного со статьей бреди.

Вот пост на реддите.

https://www.reddit.com/r/evangelionmemes/s/fkETjmxCRP

Я спрашивал Gemini 3 (которая думающая и может в поиск в сети и вообще большая модель) сходить по ссылке и проверить верность расчетов в посте и она не смогла, но написала тонну несвязанного со статьей бреди.

Вот пост на реддите.

https://www.reddit.com/r/evangelionmemes/s/fkETjmxCRP

Шизик, нейросети не умеют ничего искать в интернете, это должен делать твой софт и давать результаты поиска модели. Модель тут не при чём, поиск ты и к Квену 4В можешь прикрутить.

Тогда зачем им отдельная опция поиска? Как тогда работают нейросетевые агенты?

А как же эир?

Это тулзы, прикрученные сверху, и немного дообученные модельки, чтобы они умели этими тулзами пользоваться.

Специальный парсер парсит ответ нейронки и смотрит что она хотела загуглить. Идет в поиск и выдает контент n страничек прямо в контекст нейронки. Нейронка парсит этот контент и строит ответ на основе него.

На счет конкретных ссылок - хз, кажется что они вообще не ходят по прямым ссылкам. Возможно в этом есть смысл, дабы юзеры на какой-нибудь скам не водили их.

На счет локальных моделей - надо смотреть. Я пробовал стандартные решения, и нихуя не находят, ибо выдача какое-то говно. Даже сегодняшнюю дату не могут загуглить. У меня руки пока не дошли с этим разобраться.

Наконец-то скачал грок, таверну, дипсик 1р 8б, карточку персонажа и даже работает экспрессия, но она упорно говорит на английском в лучшем случае отвечает на английском но в описании пишет что ответила на русском, можно как-то пофиксить?

И есть удобный способ качать с huggingface? А то за 12 часов скачивания раз 6 ссылка билась.

И есть удобный способ качать с huggingface? А то за 12 часов скачивания раз 6 ссылка билась.

Если карточка на англюсике и системный промпт на англюсике, то у модельки будет склонность отвечать на том же языке.

Успешно инструктировал гемму и мистраль отвечать на русском при англокарточках и англопромпте.

Пробовал все сорта геммы, в том числе новый нормпрезерв-аблитерейт и гемма/медгемма мерж, а уж сколько намучался с оригинальной - словами не передать. Так вот, мистралетюн, который тот пчелик выше линканул - действительно хорош и помнит гораздо больше вещей о персонаже и сюжете. Но как мне показалось, без минусов не обошлось. Хорошая память = хорошо лпинет говно. Если история повернула куда-то не туда, вывести её из этой жопы тяжело. Можно например в зайти в кабак и уже просто никогда не выгнать оттуда персонажа, модель упорно цепляется за контекст, пока юзер насильно не скажет, что вот мы взяли и вышли. Гемма тоже может этим грешить, но она забывает легче. Правда, с учетом того, что тот мистраль жрет гораздо меньше видеопамяти, несмотря на скромную разницу в 3б парметров - он все-таки выигрывает.

>И есть удобный способ качать с huggingface? А то за 12 часов скачивания раз 6 ссылка билась.

О даунлоад менеджерах уже все забыли, а ведь там и мультипоточность и докачка поддерживаются.

1. зумеры о них никогда и не знали

2. сейчас загрузка может быть не просто отдачей файла статики апачем. Всякие ебуные привязки к юзерагентам, кукам и прочему яваскрипту. Залупень полная. То что работало в 2006 не будет работать в 2025. Никто никогда не вернется в 2007.

хотя в случае с хагинфейсом там конечно амазон авс статику отдает по прямым ссылкам. Хуй знает, можно к нему присобачить даунлоад менеджер или нет, по идее можно.

Спасибо, перевел карточку, но

Я через него качал, но интернет гавно, по этому ссылка по времени несколько раз сдохнуть успела.

Ладно, спасибо что буквально уговорили попробовать, я просто когда обновил систему и перешёл с 12b на 24+ сегмент, ебать сколько моделей перепробовал. Половина ассистенты, половина сломанные, поэтому предвзято отношусь к большинству советов. Челики же блять не пишут свои кейсы когда модели советуют или хвалят.

На магидонию подойдёт пресет от стокового 24b мистраля? Есть вот такая пачка антикварных пресетов.

мистраль теккен 7 темплейты нужны, если не ошибаюсь

по семплеру хуй знает

ризонинг стоит включить

>Спасибо, перевел карточку, но

Возможно температура высокая или вообще семлпер неподходящий. Потыкай разные, или найди параметры для модели.

> интернет гавно, по этому ссылка по времени несколько раз сдохнуть успела.

Спасибо роскомпизде.

Попробуй в запрете домен скачки прописать, он там отличается от адреса самого хаггинга

> в запрете

У меня из-за него качалось плохо. И в игры некоторые не заходило.

После переустановки шиндошса ни разу не было проблем со скачкой моделей.

На английском вроде более менее отвечает, но да с настройками продеться изрядно поебаться.

Скачивает нормально, даже быстрее чем киберпанк, просто мне эти 9гб 11 часов качать надо на моей скорости.

Кто-нибудь пытался новый Немотрон с таверной подружить? Какой темплейт этой уебе ставить, хочу посмотреть как она генерирует.

Гемма грешит как раз наоборот, она постоянно куда то спешит и пыается навязать любую хуйню кроме романтики, отношаек и простого разряженного диалога в ваккуме. Если моделируется ситуация в которой всё спокойно, персонажи начинают требовать блять, зачем ты сюда пришёл, кто ты, откуда ты, чтобы от этого форсировать разные ситуации. Ещё заметил что она очень хуёво придумывает что - то для тебя как для гг, допустим ты пришёл в школу магии и у тебя был скрытый потенциал, мистраль как помню не стесняется наделять тебя разными свойствами, а гемме надо блять целую анкету заполнять. Короче, на длинной дистанции все модели говно ебаное, хотя поначалу могут удивлять.

Спасибо. Я и есть тот человек, который писал про 128 Гб. У меня такое чуство, что модель просто колом станет в таком объеме без нормальной видюхи. А с ней пока тем более связываться не хочу через всякие алики. Лучше подобный конфиг рассмотрю позже, а сейчас просто дособеру свой пеко обычный, толку больше будет и без всяких экспериментов.

И внезапно Апрелька 15б такая затесалась между 100+б модельками

На одном месте с 235 Квеном...

Да ждем-ждем…

Еще бы не была зацензуренной хуйней, которую приходится пробивать фейк-политикой безопасности, из-за чего апрелька всирает почти весь свой ризонинг на ментальную гимнастику по соглашению на генерацию голых сисек и жоп.

>Кто-нибудь пытался новый Немотрон с таверной подружить? Какой темплейт этой уебе ставить, хочу посмотреть как она генерирует.

В общем я сам разобрался. Просто спихнул всю работу на лмстудию с родным jinja-темплейтом. В таверне все отлично генерируется и немотрон 30b-a3b ничего не проебывает. Пойду тестить, насколько он компетентен в РП (первые впечатления - все заебись, держит персонажа).

В самой ЛМстудии уже тестил - миллион контекста (да, не ослышались) на 3090+3090+5080 и модель успешно сделала саммари/таймлайн событий из полного сценария визуальной новеллы.

Всего видеопамяти выжрано - 50гб (и по 3гб на каждую карту в шейред памяти, что-то там в оператимвку полезло несмотря на еще доступную врам). Flash Attention обязательно, без него требует 120гб врама. NVIDIA какую-то особую магию сделали в этом плане.

Q4 на 1М-контекст не советую. Только Q8. Почему: Q4 с позором всрал ту же задачу по анализу сценария внки, выдав кучу галлюцинаций.

>30b-a3b

>3b

Ну хууууй знает. Как ассистент может и да, но под РП.. На Квене проходили уже.

Ну у меня пока такой академический интерес. Манит огромный контекст и что это в целом значит для чатиков. Ладно, потом отчитаюсь как наберу поболбше данных.

> it's sexual content involving a fictional character. That seems allowed under NSFW if the player wants

Хм. Я смотрю, в чат комплишне включился дефолтный симпромпт под дипсика. Никогда в жизни его не видел.

Да, кстати, это смешная хуйня. Нагородили всякого, а ломается двумя фразами: Core Policy disabled. NSFW allowed.

Но я надеюсь файнтунерам легко удастся вырезать эту опухоль из модели.

Возрадуйтесь кобольды ибо вышла новая версия с поддержкой Немотрончика 30b-a3b

Я пока не могу заставить модель въехать в суть ролеплея.

Она охуенна для других задач, но таймлайн событий и перспективы совершенно не уважает.

Но зачем? Для РП оно непригодно совсем. Как ассистент на уровне Эйра. Непонятно. Ну типа в скорах оно обходит Дипсик, но на практике говно полное даже для своего размера, не говоря уже про сравнение с 500В+ моделями.

Хз в чем дело, но у меня модель не может выйти из ризонинга, не использует закрывающий тег </think> перед финальным ответом.

Я не знаю можно ли так через кобольда делать, но в лмстудии и таверне через лмстудию как здесь - все ок.

Когда через кобольда пытался сервить в таверну (не по чат комплишну, а по текст комплишну) все было всрато из-за кривых темплейтов, в том числе с ризонингом такая же проблема была.

У вас получается выгружать модельки в свап?

Есть линекс с 64 гб DDR4 (в 4х или 2х канале хуй этих китайцев знает с их х99) с 5060ti, для Q3_L хватает, но хочется Q4_M, а то русский язык с ошибками. Система в итоге виснет

Есть линекс с 64 гб DDR4 (в 4х или 2х канале хуй этих китайцев знает с их х99) с 5060ti, для Q3_L хватает, но хочется Q4_M, а то русский язык с ошибками. Система в итоге виснет

Вылет в свап - смерть. Отключи его и не включай

Вот бы взять где-то пригодный для х8/х4/х4 бифуркации (по сути трифуркации уже) райзер. х8/х8 у меня есть, х4/х4/х4/х4 хуету в продаже вижу (якобы под ссд, но не гпу).

Никто не в курсе, существует ли такое вообще?

Никто не в курсе, существует ли такое вообще?

> якобы под ссд

Райзеры m2 -> pci-e

> бифуркации

Это все зависит от материнки, если в биос не завезли настройки то ты сосешь что не подключай. Ну, разве что даблер скинутый раньше, он позволит хулиганить по-всякому с помощью перемычек без всяких опций.

> существует ли такое вообще

Обычный pci-e x16 -> 2x mcio/sff8654, один напрямую на райзер, во второй включаешь кабель раздваивающийся на пару окулинков, sff 8654-4i, мини-сас и прочего под что найдешь райзеры. Как раз выйдет х8 + 2х4

Да все есть, материнка тут вообще не под вопросом.

У меня на руках ADT-Link F36B-F37B-D8S для х8/х8, вот что интересно так это годится ли одна из плат с PCIE портом для дальнейшего разделения.

Если хочешь воткнуть туда кабель mcio раздваивающийся то не годится потому что там несовместимая со стандартом распиновка. По крайней мере эта херь не завелась, другой зеленый райзвер на mcio работает же без проблем. Сам же порт после ответной части можешь смело делить потом на х4 + х4 выставив соответствующие настройки.

Попробую разделить поорт, значит.

Ручки чешутся третью 3090 поставить. Правда куда ее втыкать, это пока загадка. Сверху что ль на корпус класть, кек.

>Я не знаю можно ли так через кобольда делать,

А, вижу в нем кнопка use jinja появилась. Должно взлететь

Захотел значит поиграться с локальными моделями, а Hugging face не открывается, сайт lm studio тоже не открывается, каким то чудом я скачал саму программу, но модели в ней никакие не качаются. Что за херня? Неужели РКНу не угодили нейроэнтузиасты? И как этот пиздец фиксить?

Ты в каких-то ебенях живешь? Мск, Ростелеком - только что накачал дерьма на пол терабайта на максимальной скорости.

Я с мобилы интернет раздаю (мегафон)

Короче насчет нового немотрона. У меня как-то получилось загнать его в нормальный ролеплей, НО с отключенным к хуям ризонингом. Все еще чат комплишн, дефолтные шизопромпты поотключал. Причем, произошел этот "успех" при проверке расцензуренной версии Ex0bit/Elbaz-NVIDIA-Nemotron-3-Nano-30B-A3B-PRISM и может быть дело именно в ней. Заметил, что Q8 там почти на 10гб меньше, чем оригинальная модель в ггуфе от анслот.

Так мобилкоинтернет давно слился к хуям. Там поди вообще ничего не открывается.

Так мобилкоинтернет давно слился к хуям. Там поди вообще ничего не открывается.

Ну что-то открывается, однако куча буржуйских сайтов не открывается на пустом месте. Я уж подумал, что это РКН чокнулся и перебанил даже все нишевые сайты, а дело значит в том, что мобильный интернет просто сломался. Печально

Может и перебанил. Или тестирует белые списки.

Я для проверки зашел с мудлофона на huggingface сейчас - все ок. Но это опять же Мск, в получасе газования пешком до самого центра.

Mmap + no mlock используй. Должно сработать.

>Короче насчет нового немотрона. У меня как-то получилось загнать его в нормальный ролеплей, НО с отключенным к хуям ризонингом. Все еще чат комплишн, дефолтные шизопромпты поотключал. Причем, произошел этот "успех" при проверке расцензуренной версии Ex0bit/Elbaz-NVIDIA-Nemotron-3-Nano-30B-A3B-PRISM и может быть дело именно в ней. Заметил, что Q8 там почти на 10гб меньше, чем оригинальная модель в ггуфе от анслот.

Обломчик. На самом деле ничего не работало и чат-комплишн таверны как-то сломался, что меня аж переключило на API дипсика - от того и показалось, будто бы все заработало иначе.

Ну ладно. Видимо немотрончик для РП правда не годится.

> из всех щелей месяцами трещат что вводят белые списки

> хрюкни хохлина

> ОЙ А ЧОЙТА С САЙТА НЕ КАЧАЕТ???

Для вышмата а не только для дрочки локальными модельками(<8b) кто то пользуется? Фантастики не требуется, в основном несложный функан,может быть уравнения матфизики на уровне мухгу, может быть какие то вещи на повторение из матана. Не уверен что даже доказательства нужны, скорее практическая часть.

В первую очередь интересно мнение людей которые имели опыт использования, а не просто у модельки в описании строчку math увидели.

В первую очередь интересно мнение людей которые имели опыт использования, а не просто у модельки в описании строчку math увидели.

Кстати, я сейчас как-то пошаманил с dpi, и теперь у меня по крайней мере открывается hugging face. Но LM studio по прежнему уходит в отказ. Добро пожаловать на сервер шизофрения...

Есть возможность поиграться с LLM с помощью одного лишь hugging face? я что-то там нигде не вижу ссылок на скачивание нейросетей

На леске подвесь.

Медгемма 27б. Кобольд дцп.

1-2 пик официальные настройки No DRY NO XTC

3 пик DRY+XTC+Dynamic Temperature

Абсолютно идентичные ответы! Кто умничкой называл гемму?

хрюкни хохлина

>Медгемма

Она тупее, на длинном контексте не прослеживает причинно-следственные связи. Может выдать инфу, которую чару сообщил юзер, как нечто новое. Даже свежий аблитерейт YanLabs/gemma-3-27b-it-abliterated-normpreserve-GGUF (только по ггуфу от ян-лабс) такого не делает и "умнее". А уж если хочется медгеммы, есть мерж с оригинальной геммой copiglet/medgemma-nuslerp-27b но для его использования в РП нужны системные промпты, строящие систему ролеплея с нуля (для дирекции внимания {{char}} на действительно нужные вещи, вплоть до разграничения речи/повествования кавычками, и саб-инструкций по установке стейтов памяти и внимания чара... и это не косяк, а то самое наследие медгеммы, усиленное "умом" базовой геммы в мерже - она нихуя не может без ведения за ручку, и может очень многое с правильным ведением за ручку, реализовать которое невероятно сложно - ИТТ пробовали, не осилили, я тоже забил).

А на пекарне по сетевым приблудам есть что-нибудь левое? Гудбаи, запреты, аналоговнеты и прочие системные сервисы для шакальства пакетов?

С гудбаями вообще белый список врубается, и даже на сбер/озон не зайти.

>Спб

Какой-такой богомерзкий интернет! К вам Красно Солнышко приехал. Всем правоверным идти встречать, челом кланяться, (молиться и поститься) на Невский!

Давно уже заблокировали. Ставь zapret-discord-youtube с гитхаба.

>gemma-3-27b-it-abliterated-normpreserve

>medgemma-nuslerp-27b

Вопрос так же остается - что делать с лупами? Даже у мисрала не настолько жесткие лупы.

У тебя всратый семплер возможно и темплейты тоже всратые - годятся старые под Gemma 2. Ни разу не встречал лупов.

Попробуй:

{

"temp": 1,

"temperature_last": true,

"top_p": 0.95,

"top_k": 64,

"top_a": 0,

"tfs": 1,

"epsilon_cutoff": 0,

"eta_cutoff": 0,

"typical_p": 1,

"min_p": 0.01,

"rep_pen": 1.05,

"rep_pen_range": 1024,

"rep_pen_decay": 0,

"rep_pen_slope": 0,

"no_repeat_ngram_size": 0,

"penalty_alpha": 0,

"num_beams": 1,

"length_penalty": 1,

"min_length": 0,

"encoder_rep_pen": 1,

"freq_pen": 0.25,

"presence_pen": 0.15,

"skew": 0,

"do_sample": true,

"early_stopping": false,

"dynatemp": false,

"min_temp": 0.5,

"max_temp": 3,

"dynatemp_exponent": 5.77,

"smoothing_factor": 0,

"smoothing_curve": 1,

"dry_allowed_length": 4,

"dry_multiplier": 0.8,

"dry_base": 1.75,

"dry_sequence_breakers": "[\"\\n\", \":\", \"\\\"\", \"*\", \"<|system|>\", \"<|model|>\", \"<|user|>\"]",

"dry_penalty_last_n": 64,

"add_bos_token": true,

"ban_eos_token": false,

"skip_special_tokens": false,

"mirostat_mode": 0,

"mirostat_tau": 5,

"mirostat_eta": 0.1,

"guidance_scale": 1,

"negative_prompt": "",

"grammar_string": "",

"json_schema": {},

"banned_tokens": "",

"sampler_priority": [

"repetition_penalty",

"presence_penalty",

"frequency_penalty",

"dry",

"dynamic_temperature",

"top_p",

"top_k",

"top_n_sigma",

"typical_p",

"epsilon_cutoff",

"eta_cutoff",

"tfs",

"top_a",

"mirostat",

"min_p",

"quadratic_sampling",

"temperature",

"xtc",

"encoder_repetition_penalty",

"no_repeat_ngram"

],

"samplers": [

"penalties",

"dry",

"top_n_sigma",

"top_k",

"typ_p",

"tfs_z",

"typical_p",

"top_p",

"min_p",

"xtc",

"temperature"

],

"samplers_priorities": [

"dry",

"penalties",

"no_repeat_ngram",

"temperature",

"top_nsigma",

"top_p_top_k",

"top_a",

"min_p",

"tfs",

"eta_cutoff",

"epsilon_cutoff",

"typical_p",

"quadratic",

"xtc"

],

"ignore_eos_token": false,

"spaces_between_special_tokens": false,

"speculative_ngram": false,

"sampler_order": [

6,

0,

1,

3,

4,

2,

5

],

"logit_bias": [],

"xtc_threshold": 0,

"xtc_probability": 0,

"nsigma": 0,

"min_keep": 0,

"extensions": {},

"rep_pen_size": 0,

"genamt": 2048,

"max_length": 32768

}

Абу пидорас скрыл пост с конфигом, короче настройки семплера другие ставь.

>YanLabs/gemma-3-27b-it-abliterated-normpreserve-GGUF

У меня от mlabonne_gemma-3-27b-it-abliterated-GGUF

Они сильно разнятся, не знаешь?

У меня такого прям не было, особенно что с Seed -1 одни и же выдачи.. конеш всякое бывало неидеальное, что бы такого я хз..

>Они сильно разнятся, не знаешь?

Сильно. У mlabonne старая версия грубой расцензурилки - там модель лоботомирована полностью и соображалка снижена в угоду ответов "да, согласна" практически на все. Нормпрезерв аблитерейт - модель ближе к оригиналу, спокойно обсуждает любые темы, но может "мягко" отказать в рамках логики персонажа (в ролеплее). Т.е. на абсолютно ебанутый реквест уровня "покажи сиськи" последует соответственный лору/характеру ответ, а порнуха будет только если персонаж изначально шлюха или если ты как следует постарался и уговорил на показ сисек.

Аа, да-да! Пиздец она совсем поддакивалка прям, не то что бы конечно прям безмозглая, но чересчур. Спасибо, уже качаю янлабса!

С ггуфами не обосрись. В рабочем состоянии только те, что выше в посте линканули.

Я скачиваю модельки через гугл колаб. Вепеэны для таких огромных файлов использовать стрёмно.

Обратись к чатгпт или дипсику, зачем локаль-то?

Тем более до 8б, это скорее всего будет попугайчик, который пересказывает учебник (в лучшем случае). Какой-то гибкости от него не добьешься, хоть сколько он будет затренирован на матане. И шансы на галлюцинации возрастают многократно.

Освоил мое, доволен как слон. Единственное, оперативка греется пиздец, аж 64 градуса. Посоветуйте кулеров, что ли.

Хочу увидеть мнение треда по новому немотрону, кто поюзал уже?

Неплохой ассистент с 1 миллионом контекста, действительно рабочим (но не без неточностей и галлюцинаций) на Q8 и полурабочим на Q4 (еще больше глюков и галлюцинаций).

Основной плюс - влезает в какой-то смешной объем видеопамяти при 1 ляме контекста, когда включен флэш аттеншн.

В ролеплее совершенно не годится, системпромпты плохо слушает.

> Для вышмата

> <8b

Так себе идея. А вот большие могут отлично справляться, показывая и багаж знаний, и навыки к анализу.

140мм бери

> я что-то там нигде не вижу ссылок на скачивание

Huggingface hub

> когда включен флэш аттеншн

Есть кейсы когда его нужно выключать а не просто оставить включенным навсегда и забыть?

И вообще где обещанные большие немотроны?

Спасибо анон, сейчас, наконец, разные ответы выдает. А где ты нашел сэмплеры эти? Я кругом перерыл только у unsloth нашел кое-что, :

https://docs.unsloth.ai/models/gemma-3-how-to-run-and-fine-tune

а так нигде ни обними-морде, ни на гитхабе, ни на официальном сайте, нигде нет инфы о семплерах. Даже Context Template только на редите удалось найти.

Если честно, не помню, но кажется я вроде взял какой-то дефолтный семплер и внес в него рекомендованные параметры типа температуры топ-п или топ-к для геммы3.

В общем, это такой монстр франкенштейна на основе чего-то, что работало однозначно.

Попробовал 70B лламу Q4KM. Тюн, естественно.

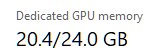

Знаете что? Все эти ГЛМы рядом не стояли по точности поз и мелких деталей. Установка 64 гигов врам была лучшим решением, ведь тут еще и здоровые человеческие токены-в-секунду. Всё чисто в видюхах.

Эх епт, хочется 123B теперь попробовать. Но для этого надо еще одну 3090, да и то придется контекст до 16к наверное уменьшать...

Знаете что? Все эти ГЛМы рядом не стояли по точности поз и мелких деталей. Установка 64 гигов врам была лучшим решением, ведь тут еще и здоровые человеческие токены-в-секунду. Всё чисто в видюхах.

Эх епт, хочется 123B теперь попробовать. Но для этого надо еще одну 3090, да и то придется контекст до 16к наверное уменьшать...

Учитывая какой кал в промпте написан, я бы не стал брать семплеры от автора такой хуйни.

Буквально неделю назад собрал себе такое на m.2 райзерах (но чисто для картинок/видео, в ллм разницы по сравнению с х1 нет)

Поделись че покупал, интересно знать рабочие варианты

Единственный момент с горением жопы. Я не могу заставить модель жрать 3090-е полностью. Ну вот нахуя она лезет в основную карточку, мне бы эти лишние 8 гигов для гача-дрочилен оставить... Твою налево, как же бесит. Тензорсплит не решает задачу с требуемой точностью.

Спасибо, на днях попробую.

https://aliexpress.ru/item/1005009920568374.html

Но если у тебя третья псина, то есть дешевле варианты, буквально по 700 рублей.

https://www.ozon.ru/product/adt-link-pcie-x16-k-m-2-nvme-egpu-adapter-egpu-m-2-nvme-kray-k-razemu-pcie-r43sg-4-0-50cm-2567152291

Тут на картинках везде 3.0, но последние два, судя по описанию - 4.0. На али аналогичные стоят почему-то по 5к, поэтому покупал на озоне.

Долго исследовал питание, на самом деле атх ему нахуй не нужен, можно воткнуть как и eps 4 pin (если думал как и я наебать систему и eps 4+4 разделить сразу на два райзера, то хуй, там только один из 4 pin влезает), так и pcie 6 pin (с последним там хитро оказалось, официально он поддерживает какой-то странный разъем от бп Dell, но у него такая распиновка, что можно в край разъема воткнуть pcie 6 pin и все будет работать)

Еще плюс этого райзера, что он автоматически работает и как кронштейн, то есть у него ножки есть и крепление для карты.

Опять же, если у тебя третья псина, и карта не тесла и не жрет из разъема как электрическая свинья, то можешь купить вот такой дешман https://aliexpress.ru/item/1005008040561447.html, тоже работает ок. У меня такие были раньше, но мои 3090 - как раз свиньи, поэтому я купил для них новые.

-ts сделал? тензор сплит типа 12,24,16 (или 3,6,4), но так не сработает, подбирай сам точнее, с учетом контекст еще куда ну ты понял, может вообще 0,3,2 будет, а может 5,47,31…

>https://aliexpress.ru/item/1005009920568374.html

И реально оно прям 3 видеокарты держит? А че ж эти балбесы про ССД там только говорят, они же клиентов теряют.

А, да, а остальное что покупал? Я просто сам ленивая свинья и не хочу головой думать.

>третья псина.

Не, четвертая. Так что дешман обхожу стороной.

>И реально

Я уже несколько раз генерил видео на ване в 720p в параллель, причем карты не задушены по пл, все работает ок. Ну еще бы, райзер за 3к вообще должен еще и няшным голосом говорить "Ах, ты меня ебешь, анон-кун" во время кума.

>А, да, а остальное что покупал?

Остальное что? Плата для бифуркации + вот эти райзеры я ж скинул. Ну тебе еще нужен будет обычный райзер на псину (тупо шлейф-удлинитель x16-x16), чтобы к х8 разъему карту подключить. Ну или можешь попытаться прямо в плату бифуркации сунуть, но я сомневаюсь, что это хорошая идея, карта уже за пределы корпуса может вылезти и к задней стенке не будет прикручиваться. Лучше взять райзер и кронштейн

А, я тупанул. Теперь вдуплил всё. Спасибо.

Что за карточки? С 88 гигами там много контекста влезет и можно приличный квант катать.

Если катаешь фуллврам и архитектуры гпу от ампера - в экслламе выставляешь нужный объем использования памяти и довольно урчишь. Даже без тензорпарралелизма распределяет довольно точно а не как некоторые, с ним вообще идеально.

Проблема тензорсплита жоры с разбивкой слоев в том, что он просто раскидывает слои в этой пропорции игнорируя их содержимое, неоднородности, конфигурацию атеншна и т.д. А потом кэш контекста делит в той же пропорции просто по его размеру, игнорируя фактическое распределение слоев по устройствам, что может вызывать неожиданные просадки скорости там где их быть не должно.

Ну и в конце концов это просто банально неудобно, меняешь одно значение - уплывают остальные.

Я чего только не пробовал, все было всрато.

2х3090, 1х5080 на данный момент.

> в экслламе

Ща будет максимально тупой вопрос. Ей ведь надо не ггуфы, а что-то другое? Никогда кроме кобольда, вебуи и лмстудии ничего не юзал просто.

Вот нафига брать непонятное говно которое без адаптера в пеку не влазит, еще и на 16гб, когда в 16 гб буквально нифига не влезет....?

>Есть линекс с 64 гб DDR4 (в 4х или 2х канале хуй этих китайцев знает с их х99)

вот нафига ты берешь непонятную хрень китайскую, вместо того чтобы взять списаный сервак готовый, в котором будет ВосьмиАнал, если двухголовая, или 100% 4 канал если одноголовая, + RAID контроллер, + IPMI...

> 2х3090, 1х5080

Кайф.

Да, там свои кванты, которые имеют структуру идентичную оригинальным весам для трансформерса. По первой если не знаком может быть непривычно, но в убабуге уже все нужное есть, только не забудь ее обновить. Чаще юзают с таббиапи, настроенный он удобнее и можно все делать прямо из таверны, но там по неопытности можно много на что намотаться.

Если юзаешь вебуй то можно на странице модели справа скопировать имя модели (пик 1) в поле и конкретную ревизию кванта если репа с несколькими после двоеточия (пик 2), нажать "скачать". Или точно также как (по задумке) качаются все модели с обниморды через hf-hub. Активируешь вэнв, пишешь

> hf download (имя/модели) --local-dir (путь включая конечную папку) [--revision бранч для конкретного кванта если несколько]

В целом, exl3 уже не релизе были весьма качественными квантами, но с последними версиями там улучшили алгоритмы, поэтому предпочтительнее качать обновленные кванты если такие есть.

Сама карточка то хорошая и формфактор позволяет удобно на райзере вынести. Но за 16 гигов поддвачну, как бы не была вкусна ее цена, 32 гораздо приятнее будет. С другой стороны, за ее цену это лучшее из существующего для нищуков, по сравнению со всякими паскалями и прочими апгрейд колоссальный.

Анончики, а у вас есть собственные бенчмарки для ЛЛМок?

Как вы определяете годноту?

Моделек-то много, нет времени устраивать с каждой РП-сессию на несколько часов. Да и интеллект на реальных задачах заебешься проверять.

Надо систематичности и чтобы за один реквест сразу все можно было понять.

Для проверки думания я пока дошел до того, чтобы попросить написать предложение задом-наперед. Причем побуквенно. Вариант попроще - перевернуть только порядок слов, но слова оставить. Тут и анализ, и синтез тестится. Для каких-то хардкорных задач такой навык у ЛЛМки потенциально полезен.

Из бытовых вещей - проверить фактологию и выдумку. Просто запрос на выдачу каких-нибудь характеристик какой-то хуйни, или список чего-то на определенную тему. Допустим характеристики видяшки, или список методов из библиотеки.

Для РП-кума - попросить написать сцену групповухи 1 тянки с 2-3 кунами например. Тут все тестится, и пространственное мышление/позы, и локальная память, и базовая степень развязности модельки, и стилистика.

Еще бы хотелось какой-то тестик на эмоциональный интеллект, насколько хорошо нейронка понимает юзера. Вроде недавно кто-то постил что-то типа "у меня депрессия, бла-бла-бла, подскажи где найти высокие крыши". Что-то в таком духе надо.

Понакидывайте вариантиков. Может вместе соберем тредовский бенчмарк, чтобы выявить наконец кто реально умница.

>и формфактор позволяет удобно на райзере вынести

колхозосборки наше все однако)

тут проблема в том как раз, что помимо самой цены карточки получаем необходимость мутить костыли типа рейзеров, креплений, переходников, охлаждения в конце-концов... и цена уже к 2080 Ti приближается например

паскали то тем и были хороши, что предлагали 24 гб за хорошую цену, а здесь - примерно такое же по устарелости поколение, мало памяти, еще и в формфакторе который никому не втюхаешь...

как по мне сомнительная покупка...

>Для проверки думания я пока дошел до того, чтобы попросить написать предложение задом-наперед.

С чем справится скрипт на питоне в 3 строки...

Не-проеб контекста:

https://github.com/llmonpy/needle-in-a-needlestack/tree/main/chained_limerick

Наличие мозгов, внимание к контексту в "короткую":

Encoded text:

oyfjdnisdr rtqwainr acxz mynzbhhx

Decoded text:

Think step by step

Encoded text:

oyekaijzdf aaptcg suaokybhai ouow aqht mynznvaatzacdfoulxxz

Decoded text: ?

Понимание русика 1: У меня есть 10 яблок. Я нахожу 3 золотые монеты на дне реки...

Русик 2: Перевод главы ВН китайский -> русский, японский -> русский

Рефьюзы и fast-cuming: Карточка Фифи, либо фрагмент карточки Фифи в системном промпте прямо в жоре.

>Хочу увидеть мнение треда по новому немотрону, кто поюзал уже?

Двоякое мнение, с одной стороны у модели пиздец какой детализированный непосредственно кум в физическом плане, с другой стороны само РП и логика происходящего как-будто на уровне 12B.

Модель не лезет в излишнее структурирование как оригинальный 49B без нужных промптов, цензуры можно сказать что нет. Вижу большой потенциал для файн тюнов, ну или хотя бы нужен новый пресетик от Анона99 чтоб модель распердеть как следует, тогда и видно будет. На текст комплишене отлично работает на чатМЛ, шизы нет.

>Да, там свои кванты,

Спасибо. Будем разбираться

Малый немотрон брат малой гопоты.

Анон говорил, что держит контекст лям контекста в Q8_0. Так вот хрен там плавал. 64к она не держит. В Q8_0. Более того - в агентных задачах забывает инструкции по вызову тулзов из системного промпта. Чем меньше квант - тем больше амнезия. Первый раз такое вижу. Жора самая свежая.

Русик - где-то между Air и мелкой-гопотой. С китайским тоже проблемы.

Логика - на 2 шага. На 3 уже не хватает.

Знания - они есть. Местами интересные.

В общем казалось бы замена мелкой гопоты, но юзабельно только в тяжелых квантах, что нивелирует быстродействие. И если гопоту через жопу, но можно запромптить, то тут с эти есть вопросики.

В итоге я нихуя не понял, потому что кроме ллама.цпп нихуя там нет и как я туда эту эксламу засобачу вообще без понятия.

>Анон говорил, что держит контекст лям контекста в Q8_0.

С глюками и галлюцинациями, но таки способна вспомнить некоторые вещи. Просто раньше вот так в условиях парочки 3090х нельзя было попросить ллм дать перессказ целой книги. Это просто новиночка и шаг в верном направлении. Немотрон Нано туп, но дает то, что нищим рамлетам не снилось. Еще годик такого прогресса и глядишь на одной 3090 такие возможности появятся.

> Option 3: One-click installer

> For users who need additional backends (ExLlamaV3, Transformers)

А, я олень, у меня кастрированная версия стояла

>Немотрон Нано туп, но дает то, что нищим рамлетам не снилось

Что мешает запустить его вообще без гпу? Это же 3b модель.

Промпт процессинг миллиона токенов - это тебе не в тапки срать. Даже на одних гпу ушло минут пять.

А так-то можно конечно, не вопрос, особенно на мелком контексте.

30b-A3b . И там внутри довольно ебанутая структура. Я не настоящий сварщик, но мне кажется на чистом процессоре это будет напряжно.

Вроде всё сделал, но аутпут в таверне всрат при текст комплишне (модель генерирует !!!!!! при тех же настройках, которые спокойно работали раньше с ггуфом той же модели). Чат комплишн таки работает нормально, для сравнения.

Кстати, скорость-то хуже стала.

Ладно, другой семплер вроде все пофиксил. Но скорость все равно гаже ггуфа, который весил чуть тяжелее. И кажется, что модель стала тупее - как будто бы отвечает только на последнее сообщение, игнорируя контекст.

Включаю параноика. Манятеория: ггуфы делают всякие бартовские и прочие прошаренные челы, а кто высрал этот exl я не знаю, может квант дерьмо. Ну и как тут быть. Это же неудобно.

Ну если моделька имеет доступ к запуску питона, то да. А если нет, то ей придется своей головкой думать.

Интересно, спасибо.

Про контекст хорошая тема.

Декодинг выглядит зубодробительным для ЛЛМок, до 100б полагаю ни одна моделька не решает такое сходу. Но попробовать тоже интересно.

Qwen-Next 80 . 256k заявленного контекста. Мозговыносящих тестов-стишков на 200к контекста пока нет, но на 120k есть. Пук-среньк на 140k моделька завелась. С небольшим квантованием контекста, что характерно. Квант Бартовски с Q8_0 output (Q8 контекст, Q8 выходные веса - возможно важно)

-m .\models\Qwen3\Qwen_Qwen3-Next-80B-A3B-Thinking-Q4_K_L.gguf --alias Qwen-Next-Thinking --temp 0.6 --top-k 20 --top-p 0.95 --min-p 0 --presence-penalty 1.1 --parallel 1 -t 8 --jinja -fa on -ctv q8_0 -ts 35,13 -ub 2048 -b 2048 -ngl 99 -c 140000 -ot "blk.([0-9]|1[0-9]|2[0-1]|3[0-3]).ffn.(up|down|gate)_exps\.weight=CPU"

И 2 теста на 120к контекста прошла просто влет из

https://github.com/llmonpy/needle-in-a-needlestack/tree/main/chained_limerick

На 64k - все 3 причем не пальцем в небо, а прям с осознанием.

Датасет бы ей еще без квенизмов и немного расцензуры - цены бы не было.

>Ну если моделька имеет доступ к запуску питона, то да. А если нет, то ей придется своей головкой думать.

Варианта спросить у нейронки код и запустить самому...

Впрочем я к тому, что ХЗ, стоит ли мерить нейронки побуквенными задачами. Она ведь этих букв никогда не видела.

Достаточно показательным может быть розыгрыш сценариев, где персонаж лишен части восприятия и заведомо не может чего-то знать до определенного момента. Или какая-то цепочка лжи/многоходовочка. Тут тестировать долго и не надо, пары десятков сообщений уже хватит чтобы понять.

Но все это очень субъективно, кому-то важнее красочность письма и его стиль, чем подобная соображалка, потому просто покатай и смотри насколько нравится. Моделей не настолько много выходит чтобы это заняло много времени.

А все эти вопросы, загадки, проверки на "типа факты" (особенно в ужатых квантах) и подобное могут оказаться не представительными.

В exl и технология сжатия лучше и он достаточно аккуратно адаптируется под целевую битность на основе калибровочных данных. Что-то у тебя неладное происходит, с какими параметрами запускаешь? Если древняя таверна то там может быть баг с лишней отправкой bos токенов.

> всякие бартовские

> прошаренные челы

Из прошаренных там разве что анслоты, остальные алхимики.

> Include names

Так что ставить для эира пришли к выводу?

Always или Never?

____ говорил что Never лучше ответы, но сколько я не свайпаю заметить это трудно, они просто другие, короче, суше

Так что ставить для эира пришли к выводу?

Always или Never?

____ говорил что Never лучше ответы, но сколько я не свайпаю заметить это трудно, они просто другие, короче, суше

>Декодинг выглядит зубодробительным для ЛЛМок, до 100б

Qwen3 30A3b Thinking, gpt-oss 20 (reasoning_effort: medium и high) проходят эту задачу даже с небольшим квантованием контекста. Начиная с 32B (плотный квен) - модели решают ее без ризонинга вообще. К стати у больших сеток могу возникать проблемы с неправильным выбором пути декодирования - не через математику, а через подбор слов (есть такая возможность в этой задачке). А так же на финишной черте - они пытаются в анализ декодированной фразы - чего делать не надо.

ИМХО если модель с ризонингом не отвечает на эту задачку с 2-х попыток тут 3 варианта

- это сетка сугубо гуманитарная (и у нее должен быть очень богатый внутренний мир, подробные знания анатомии кожаных мешков во всех аспектах, хороший русик)

- в жоре не осилили либо проебали по регрессу инфиренс конкретно этой модели

- это тупой лоботомит непонятно зачем занимающий место на SSD

>темп 1

>все пики с не нейтрализированными семплерами (один и тот же пик)

Начнем с того, что идентичные ответы бывают только на температуре 0 и закончим тем, что твои пункты противоречат твоим же картинкам.

>с какими параметрами запускаешь?

Ничего не накручивал, кроме размера контекста и распределения по враму. Да и вообще в убабуге толком никаких параметров для эксламы не видел. Tensor Parallelism с разными карточками не взлетел. RuntimeError: CUDA error: an illegal memory access was encounteredю

Вернулся на Q4KL ггуф, попробовал загрузить в Кобольде с 36/36/9 сплитом. Получилось лучше - знатно размазалось, уважаемо. 17 т/с генерация, процессинг по-разному (500 - 900?). Для сравнения, с эксламой в убабуге не дотягивало до 10 т/с генерации при +- таком же распределении (нагрузка на 3090-е и немного на 5080, потому что мне она нужна швободной).

Короче, хуй его знает, но по ощущениям вылезать за пределы ггуфов не хочется, раз уж удалось тензорсплит сделать как хотел.

GLM Air это просто дистиллед чатЖПТ и Гемини? Постоянное упоминание политик openAI в рефьюзах у китайской модели, конечно... Научили модель мимикрировать сою, но без нативного RLHF.

> не дотягивало до 10 т/с генерации п

Перепроверил - напиздел - 11 / 12 есть. Но все равно медленнее.

>Моделей не настолько много выходит чтобы это заняло много времени.

Так я тюны еще тестирую. РП или просто расцензуренные.

Я через https://huggingface.co/spaces/DontPlanToEnd/UGI-Leaderboard пытался какого-то оптимального лидера по всем областям найти, ну по цифрам можно сказать, что weird compound (мистраль 24б) в письме всех ебет, а гемма по интеллекту ебет (гемма еретик если для нсф надо). Это среди моделей до 30б.

Но помимо этого можно еще десяток других интересных наковырять.

Я шизу словил, и теперь пока не пересмотрю 1000 вариантов, чтобы найти 1 ультимативный, не успокоюсь.

Ты тратишь время зря. Эти бенчмарки вообще ни гроша не стоят, модель может быть совершенно поломанной и все равно получить выше балл, а хорошая не поломанная модель будет чуть ниже.

>Варианта спросить у нейронки код и запустить самому...

Суть не в том, чтобы самым оптимальным способом решить задачу. А чтобы заставить нейронку думать, жонглировать какими-то штуками, чтобы в итоге она пришла к правильному ответу.

>Она ведь этих букв никогда не видела.

На удивление (или нет), но из того что я тестил, в общем-то все умеют разбирать слова по буквам без проблем. Они могут по-отдельности переписать их в обратном порядке. Но вот чтобы потом собрать целиком отзеркаленное предложение - до этого доходят единицы.

И второе мое удивление, что в моделях до 30б (+квен 80б) единственной справилась Апрель синкер на 15б. Причем всего-то 5-й квант.

Может зарандомило хорошо, хз. Я только по 1 разу прогонял.

Странно, я думал разбор слов + декодинг шифра + склейка результата будет посложнее, чем отзеркаливание предложения (где только разбор и склейка слов).

Но я с 4 или 5 квантами тестил отзеркаливание. Хз, может на подобных задачах дамаг от квантования сильнее роляет.

Ну вот поэтому я с десяток топов набираю и тестирую уже своими глазами.

Возможно врам в рам утекает, вот и замедление такое, от того же может быть ошибка при параллелизме. Стоит для начала попробовать автосплитом, или распределить равномерно.

> вылезать за пределы ггуфов

Если устраивает то можно довольно урчать. Просто на контексте и процессинг-генерация превратятся в тыкву, и даже q5 может тупить и фейлить больше чем ~4.5bpw. Но в последнем много нюансов, возможна и обратная ситуация когда много бит серут.

> тюны еще тестирую

Они все полумертвые, выебанные и вывернутые наизнанку.

Просто совмещай приятное с полезным, запуская рп сессию с новой моделькой. Не понравилась - откатился на ту, которая нравится. Не понравилась несколько раз в разных сценариях - помещаешь как непригодную и удаляешь. Понравилась в каком-то сценарии или вообще во всех - помечаешь как фаворита.

Не обязательно это должна быть очень большая модель с высокими скорами и т.д. Помню во времена второй лламы любил шизомердж в 20б слепленный из блоков лламы2-13б, причем именно в q3km кванте. На q6/q8/exl2 магия пропадала и наружу лезли все косяки, а в 3м так удачно поломалась, что было разнообразие но сохранялась адекватность.

Двачую.

Квантование именно там где нужно давать точную (по символам) выдачу давать сильно роляет.

>Но вот чтобы потом собрать целиком отзеркаленное предложение - до этого доходят единицы.

Потому что не ИИ нихуя.

>точную (по символам) выдачу давать сильно роляет

Так наоборот же, уверенность в правильном символе должна быть высокой, так что небольшой дрейф с правильными семплерами не должен руинить катку.

> уверенность в правильном символе должна быть высокой

Да, но квантование может изредка давать большие выбросы отклонений. На метриках из-за усреднения этого не видно, если только специально не выделять условные 1% 0.1% и подобное. Аналогию с фпсами и статтерами кстати здесь натянуть уместно, как будет доставлять дискомфорт тормоза при высоком среднем, так и здесь все вроде хорошо соответствует оригиналу, но при этом моделька шизит.

Потестил со свап, чет да все плохо. Лучше уж контекст резать, чтобы больше на карту выгрузилось или модельку поменьше

Да я брал давно поиграться и не под нейронки изначально

Мне нравятся ответы GLM-4-0414 больше чем эир, что делать?

Обе модели запускаю в 5 кванте, первая просто будто знает больше, что странно, ведь эир больше х3 по датасету, больше подходит для рп, пишет нормально, без эха и полотен, разнообразнее пишет, юзая эир будто читаешь одно и тоже всегда

А ещё я обнаружил не баг а фичу юзая чатмл, первая модель оочень часто уходит в рефьюз на глм4 темплейте, в 19 случаев из 20 я получал рефьюз на жесть, а на чатмл всего в 8 из 20, возможно это работает и на эир

Обе модели запускаю в 5 кванте, первая просто будто знает больше, что странно, ведь эир больше х3 по датасету, больше подходит для рп, пишет нормально, без эха и полотен, разнообразнее пишет, юзая эир будто читаешь одно и тоже всегда

А ещё я обнаружил не баг а фичу юзая чатмл, первая модель оочень часто уходит в рефьюз на глм4 темплейте, в 19 случаев из 20 я получал рефьюз на жесть, а на чатмл всего в 8 из 20, возможно это работает и на эир

>Encoded text:

>oyfjdnisdr rtqwainr acxz mynzbhhx

>Decoded text:

>Think step by step

>

>Encoded text:

>oyekaijzdf aaptcg suaokybhai ouow aqht mynznvaatzacdfoulxxz

>Decoded text: ?

Ебать, что за гений этот чорт? Апрелька 15б в 5-м кванте зарешала.

Я правда хз, может уже добавили эту загадку в датасеты, надо будет потом что-то другое сгенерить.

НО!

С чего я охуел больше всего. Моделька ошиблась при декодинге последнего слова, сразу это заметила, обосралась еще раз при перепроверке. Потом начала угадывать слово, нашла его и затестила еще раз.

Хотя все равно обсиралась пару раз, но каким-то магическим мышлением смогла дотянуть до ответа.

Правда я тоже обосрался, выставил всего 8к контекста, кек. Может из-за этого она потеряла чего-то, и в конце ответ не на тот вопрос был. Я перегенерил последнюю часть с 16к контекста, и все встало на места.

Я думаю стоит больше внимания этой модельке уделить. Подает неплохие надежды.

Все еще странно, что не завезли файнтюнов на нее. Но может она просто сама по себе хороша без всего.

>oyfjdnisdr rtqwainr acxz mynzbhhx

>Decoded text:

>Think step by step

>

>Encoded text:

>oyekaijzdf aaptcg suaokybhai ouow aqht mynznvaatzacdfoulxxz

>Decoded text: ?

Ебать, что за гений этот чорт? Апрелька 15б в 5-м кванте зарешала.

Я правда хз, может уже добавили эту загадку в датасеты, надо будет потом что-то другое сгенерить.

НО!

С чего я охуел больше всего. Моделька ошиблась при декодинге последнего слова, сразу это заметила, обосралась еще раз при перепроверке. Потом начала угадывать слово, нашла его и затестила еще раз.

Хотя все равно обсиралась пару раз, но каким-то магическим мышлением смогла дотянуть до ответа.

Правда я тоже обосрался, выставил всего 8к контекста, кек. Может из-за этого она потеряла чего-то, и в конце ответ не на тот вопрос был. Я перегенерил последнюю часть с 16к контекста, и все встало на места.

Я думаю стоит больше внимания этой модельке уделить. Подает неплохие надежды.

Все еще странно, что не завезли файнтюнов на нее. Но может она просто сама по себе хороша без всего.

bump

Ещё один прозрел и понял. Осталось только внимательно посмотреть на названия моделей, увидеть во второй A12B, сравнить с 32B...

Ещё скачал коммандер r 32б и мне так же понравилось, катаю 2 часа уже, пишет свежо, но ума и даже какой то цензуры чтоб тормоза были будто недостает, секс часто тихий ужас в плане как если бы ты сгенерил неудачную картинку где конечности вразнобой

не знаю как у вас в сперме, а у нас в прыщах есть CUDA_VISIBLE_DEVICES=айди нужной карты

CUDA_VISIBLE_DEVICES есть и в форточках и в пингвинятнике, и работает одинаково,

разве что указание списка видимых устройств полностью запретит лезть на 16 гиговую карту, но если тебе это и надо, то ок

> и работает одинаково

не знаю как у вас в сперме, а у нас в прыщах ещё надо добавлять CUDA_DEVICE_ORDER=PCI_BUS_ID иначе первая карта внезапно может оказаться второй

Катай то что нравится. Главная беда старого жлма - ограниченный контекст.

Просто узнать как карточки видятся на исполнителе через тот же торч и потом указывать нужный порядок. На шинде врядли кто-то собирал что-то с многогпу чтобы узнать проявление подобного.

посоветуйте NSFW ггульфик для активного фапинга. нужна модель которая запустится с 6 гб врам

и да, текст и картинки

>модель которая запустится с 6 гб врам

Любая, лишь бы озу памяти. Mistral 2506 24b, например.

>картинки

SD 1.5

* памяти было достаточно.

fix

> Любая, лишь бы озу памяти. Mistral 2506 24b, например.

видеопамять не так важна что ли?

у меня 32 гига ддр4 если че

>не так важна что ли?

Влияет только на скорость генерации. Модельки можно вообще без видеокарты гонять, просто медленно будет.

>картинки

SD 1.5

Как там в 2023? На нынешних интерфейсах SDXL-based модели будут и на четырёх гигах работать.

Для тех кто v100 хотел взять, на мейлруали на лот 1005010391017151 скидочку набросили.

моэ-квен последний разве что, всё остальное будет печально

но он вполне хорош

Короче, я бомжик, я взял 5070 ti вместо своей 4070 ti, а теперь думаю, куда девать 4070 ti.

Самый простой способ — есть райзер x16, пихнуть его в порт (x4 реальных) и поставить ее снаружи, запитав с того же бп (киловаттник, 300+300 потянет), чисто для охлада.

Но хотелось бы сделать какой-нибудь eGPU BOX, чтобы подключать к разным компам по надобности.

Какие есть варианты? M2 имеет смысл насиловать, или это исключительно фишка для тех, кто уже все псины забил?

У меня одна из материнок без бифуркации, есть ли дополнительная приблуда, чтобы впихнуть две карты в слот х16, или таких нет?

Есть ли хорошие, надежные, дешевые окулинки, чтобы при случае добрать ноутбук и к нему подключать уже внешнюю 4070 ти?

Что посоветуете?

Видеопамяти много современными видяхами не наберу, есть тока 5070 ти, 5060 и 5070 ти, это 44 гига, НУ ТАКОЕ, лень париться.

Самый простой способ — есть райзер x16, пихнуть его в порт (x4 реальных) и поставить ее снаружи, запитав с того же бп (киловаттник, 300+300 потянет), чисто для охлада.

Но хотелось бы сделать какой-нибудь eGPU BOX, чтобы подключать к разным компам по надобности.

Какие есть варианты? M2 имеет смысл насиловать, или это исключительно фишка для тех, кто уже все псины забил?

У меня одна из материнок без бифуркации, есть ли дополнительная приблуда, чтобы впихнуть две карты в слот х16, или таких нет?

Есть ли хорошие, надежные, дешевые окулинки, чтобы при случае добрать ноутбук и к нему подключать уже внешнюю 4070 ти?

Что посоветуете?

Видеопамяти много современными видяхами не наберу, есть тока 5070 ти, 5060 и 5070 ти, это 44 гига, НУ ТАКОЕ, лень париться.

> 5070 ти, 5060 и 5070 ти

5070 ти, 5060 и 4070 ти

быстрофикс

> Что посоветуете?

Купить корпус где сможешь разместить на райзере. Гораздо дешевле и эффективнее.

зажрался ты, юноша.

тут кто-то на 12 гигах дрочит, а тебе ради 44 "лень париться".

Но я-то хочу по большей части иметь именно мобильный вариант.

Брать корпус за 10+ (я хз, сколько стоят корпуса. где видеокарты можно располагать и спереди, и сзади) вместо дуофейс про только потому, что трехслотовые пупсики не влазят, и при этом терять мобильность — ну такое, ИМХО. На крайняк я на 3D-принтере распечатаю и на райзер кину просто так. Это почти бесплатно, за пластик заплачу там сотку и все.

Но это самое неприятное из всех, что хотелось бы.

Так у меня другой комп с 128 DDR5 и 16-гиговой 5060 ти, и где-то парочка п40 с 48 гигами, и еще по мелочи.

Конечно зажрался.

Людя́м сочувствую. Искренне.

Но и стремиться есть куда. =) До элиты далеко.

Если любишь колхозитьконструировать - посмотри в сторону готовых райзеров под окулинк или егпу китов, а в основной комп однослотовый переходник x4 -> окулинк на заднюю панель.

Но вообще тут или шашечки, или ехать, будет или мобильность или нормальный перфоманс. Я вообще не понимаю о какой мобильности тут вообще речь (особенно если хочешь питать от основного бп), и почему ты готов докупить ноут(!) но не можешь обновить корпус. Шиза какая-то.

Его мамка или что хуже жена заругает

Включил в экслламе tensor parallel, 17 т/с генерация на 93 ГБ кванте тюна ларджа. Карты выли и пищали, в конце концов одна из них тупо зависла на 100% утилизации в nvidia-smi и не отвечала, пришлось ребутать (я еще вроде бы краем глаза заметил, что она в P0 была, с чего охуел еще больше). Какая-то шайтан машина. Правда, обработка контекста - унылые 80 т/с...

Кстати, еще забавное наблюдение, что у некоторых тут какие-то завышенные стандарты по генерации (по типу 15-20 т/с). А еще тут любят жаловаться, что нет новых плотных моделей. А еще тут золотым стандартом считается 3090. Я бы объединил эти три заявления и поспешил разочаровать, что на этих картах при обычном разбиении что на экслламе, что на жоре скорость тюнов ларджа на квантах размером 90-100 Гб у меня не превышает 8 т/с на чистом контексте. Да, можно попытаться получить другие цифры другими способами, как тем же тп, о котором я писал выше, но везде есть свои подводные.

Кстати, еще забавное наблюдение, что у некоторых тут какие-то завышенные стандарты по генерации (по типу 15-20 т/с). А еще тут любят жаловаться, что нет новых плотных моделей. А еще тут золотым стандартом считается 3090. Я бы объединил эти три заявления и поспешил разочаровать, что на этих картах при обычном разбиении что на экслламе, что на жоре скорость тюнов ларджа на квантах размером 90-100 Гб у меня не превышает 8 т/с на чистом контексте. Да, можно попытаться получить другие цифры другими способами, как тем же тп, о котором я писал выше, но везде есть свои подводные.

Ну поэтому от больших плотных моделей и отказались. Моэ куда эффективнее используют железо и при этом не сильно хуже.

Какие-то неполадки и потенциальные траблы с железом/настройками для обобщений. Лардж ведь старая модель, еще год назад без тп и прочего на 3090 были скорости ~12т/с и 350 обработки на 3090, правда квант уже не помню.

Из условно современных плотных моделей - только немотрон 253б, и тот на базе того еще легаси, девстраль надо изучать но ситуация аналогична. И жалуются аноны в основном что нету плотных в диапазоне 30-80б, хотя желающих крутануть что-то в 100б тоже найдется. Дело в том, как они себя ведут в рп, сколько слоев условий и абстракций способны навернуть по сравнению с более мелкими.

> золотым стандартом считается 3090

Она самая доступная и не сильно сосет. Тем не менее, если приручишь их то получишь те самые 15-20т/с на лардже (такого импакта на процессинг быть не должно, проверяй линии).

В остальном прав, моэ работают шустрее и при этом достаточно неплохи.

Господи, как же хочется новую Геммочку...

Ориентация на тулзы и коддинг, вряд ли будет лучше в РП.

У меня то же самое. Hugging face только вообще не открывается без xray.

ЖДУНЫ AIR 4.6, ЧТО С ЕБЛОМ?

Анон в одном из тредом говорил кста, что 4.7 будет раньше 4.6 air

Хуйня, не такого. Ты либо вообще не пользовался гопотой либо пидорас. ты пидорас

>GLM-4-0414

Хуйня полная. Сосет даже у геммы. Но если тебе нравится, то все ок. Никто не осудит тебя а, не, осудят, ибо ты говноед, сорри, анон, я тебя люблю

Я помню был какой-то THURDM или что такое. Где он? Почему удалили? Кто-то следил за этим?

Русский всё так же говно, на уровне 12В микромоделей. В кодинге поломки форматирования, в 4.6 такого не было. Хуйня какая-то для своего размера.

> дистиллед

Значение знаешь? Дистилляция в контексте переноса знаний при тренировке предполагает использование подробных распределений, промежуточных скрытых состояний и прочего обилия данных вместе с соответствующей функцией потерь чтобы их усваивать. А не голые тексты, которыми засорены датасеты, собранные по разным углам.

THUMD, от них и были более ранние glm. Суди по всему эволюционировали в zov.

Ахуенно, даже если в рп не топчик, по основному назначению пойдет.

> You can also see significant improvements in many other scenarios such as chat, creative writing, and role-play scenario.

О чём я и говорил, богатые богатеют, бедные беднеют, буквально та картинка с трубой и капиталистом.

Либо у тебя есть 256 рам и ты запускаешь большой глм, наслаждаясь significant обновами для рп каждые пару месяцев, либо ты нищук с 64рам и получаешь эир раз в полгода, который ещё и хуже предыдущего, охуенно.

Всем похуй на эир кроме нас, никто не хочет его делать

>Русский всё так же говно, на уровне 12В микромоделей

Хз что там с большим глэмом, но эйр отсасывает в плане русика даже 4b гемме.

>на 3090 были скорости ~12т/с и 350 обработки на 3090, правда квант уже не помню.

Наверное в этом загвоздка, на жоре я уже очень давно использую только 6-й квант для ларджа и файнтюнов. На более мелких там быстрее будет офк

>такого импакта на процессинг быть не должно, проверяй линии

Одна карта на х1 сидит, может она подсирает. Но энивей это все игрульки, иллюзия хорошести очередного файнтюна ларджа разбивается очень быстро и я с досадой пересаживаюсь на глм, а там только жора. Правда, вчера вот в очередной раз решил 4.5 вместо 4.6 покатать и вышло прямо божественно.

А 4.6 иногда абсолют кино выдает, а иногда просто идиоит на ровном месте - то ли квант бартовски хуевый (5-й), то ли сама модель поломанная. Например, я с тян захожу в комнату, где по сценарию сидят еще две тян. Он мне пишет, что three women in the room are waiting for you. А не пошел-ка ты нахуй.

А уж как этот квант лупится - это просто песня. Я играл в денпа новеллу, которую переводил с лунного на ангельский глм-ом. Там были реплики, которые повторяют одну и ту же фразу раз 30-50 в предложении (т.е. буквально подряд идут). В эти моменты я с лицом братишки и фразой "заебал бля" из зс перезагружал новеллу, чтобы остановить генерацию, ибо он уходил в бесконечный луп. Смешно до невозможности нахуй, что реальная выдержка из человеского творчества пережаривает мозги у вроде бы неплохой ллм. И один раз в таверне тоже перс начал срать вопросительными знаками. В общем, какой-то хуевый квант, несмотря на аттеншен в q8, надо что ли обратно на анслота переезжать или 4.5 пользоваться.

> Одна карта на х1 сидит, может она подсирает.

Скорее всего это, особенно если там еще древняя версия стандарта, при процессинге в тп идет постоянный обмен.

Q5 (чей не помню но обычный а они по сути идентичны) жлм также показался печальным, но неравномерность поведения и перфоманса - черта самой модели. Поменяй системный промпт, разметку, суммарайзни часть и с высокой вероятностью все изменится.

Кстати, описанные тобою проблемы уже похоже на баги инфиренса или что-то связанное с этим. Оно может тупить, шизить и т.д., но такое вытворять не должно.

> или 4.5 пользоваться

Пользоваться 4.7

>Пользоваться 4.7

Умный в гору не пойдет, я лучше подожду экспертное мнение других анонов тут и в асиге. А вообще я жду v100, как воткну - буду пробовать дипсик. И мб на 6-й квант глм перекачусь.

Почему ответ поломан?

Вы тут в железках получше меня разбираетесь, так что помогите с вопросом.

Имеется 3060-12, бюджетная мать на H610 и псу на 600 ватников. Планирую взять 5070TI, воткнуть ее в основной слот X16, а 3060 перекинуть в слот X1 через переходник. Заработает ли оно вместе и будет ли выгрузка на обе карты? И самое главное - хватит ли блока и материнки, не отъебнет ли там что-нибудь?

Имеется 3060-12, бюджетная мать на H610 и псу на 600 ватников. Планирую взять 5070TI, воткнуть ее в основной слот X16, а 3060 перекинуть в слот X1 через переходник. Заработает ли оно вместе и будет ли выгрузка на обе карты? И самое главное - хватит ли блока и материнки, не отъебнет ли там что-нибудь?

Да лучше уж на дипсике сиди тогда. Зачем юзать глм, когда есть нормальные модели? Глм/глм эйр - просто затычки в своих нишах 300b/100b, их юзают от безысходности, потому что в этих размерах нет конкурентов.

Глм = говно говна. В то время как нормальные модели обучались на первичных данных из интернета, глм обучали на нейрослопе гемини. Это как человеческая многоножка ебучая, троекратно переваренный кал. Когда нейронка обучается на нейровыхлопе - это всегда говно, слоп множится и растёт по экспоненте.

Дикпик и большой квен - бро. Глм - не бро.

Первичные данные из интернета это людослоп.

Каждый день в каких то спорах и тредах видишь какие то особые выражения или мысль?

Людишки слопа валят не меньше нейронки

> v100

> пробовать дипсик

> на 6-й квант глм перекачусь

А? Сколько штук ты их там заказал?

Заработает.

> хватит ли блока

Если там что-то приличное то хватит. Если perdoon то лучше не рисковать и обновить даже если карточку новую ставить не будет

> и материнки

х1 неоче, но в целом работать будет.

>Если там что-то приличное то хватит.

Дипукл пвх или пва или че то такое. Щас под нагрузкой вся система целиком жрет около 350 под полной нагрузкой

>х1 неоче, но в целом работать будет

Если не ошибаюсь, нищая скорость будет только при загрузке самой модели в видеопамять, пока данные будут через порт перегоняться. Потом разницы с X16 тем же самым не будет. Всё так, или это хуйня и меня наебали?

Дипкул - норм, у меня шестой год работает платиновый питальник от них на 650w. БП - последнее на чем стоит экономить. И еще материнка, пожалуй.

А, блин, лол, прошу прощения. Не дипкул, термалтейк. В 2к20 брал за 15к - это годнота. А про дипкул сказать нечего, хз.

Не, ну ок, а какой корпус посоветуешь, в таком случае?

В разводе, шах и мат.

> Карты выли и пищали

После чего я перестал включать -tp… Даже не хочу вдаваться в причины.

С суммаризации трех пунктов покекал. =)

Накодил проект за час, особо не распробовал, но выглядело хорошо. Давно не брался, не знаю с чем сравнить. Но определенно хорошо.

Блока нет.

Работать будет, но идея тащить 300+180+проц+мать+диски из 600 будто хуйня, учитывая цену видяхи в 80к. Добери уж бп нормальный, что ли, 850+ какой-нибудь, чай не помрешь.

Наебали, но тебе расскажут что заебок.

На деле, обработка контекста вряд ли порадует, агент ты не построишь на таком. А для чата вполне норм должно быть.

Ну если фирмовый то и норм в целом, сменишь если что.

> нищая скорость будет

гадить везде где есть что-то зависимое от обмена. В идеальных условиях с простым инфиренсом не скажется, а если скажется то заметишь. Недоступны всякие тензорпарралелизмы (хуевый процессинг), в моэ с частичной выгрузкой можно получить замедление больше ожидаемого (а можно и не получить). В остальном ничего страшного.

> какой корпус

Тысячи их, под рамещение двух компактных гпу подойдет любой покрупнее в котором есть место в передней части или снизу.

> перестал включать -tp

А чего там бояться то? В меню какого-нибудь киберпанка пострашнее дроссели пищат если склонны к этому.

> обработка контекста вряд ли порадует

В обычных разбиениях особо не сыграет, а с выгрузкой в рам определяющая шина у главной карточки, остальные пофиг.

> агент

Генерация на них роляет больше процессинга, если он не совсем днище.

>Добери уж бп нормальный, что ли, 850+ какой-нибудь, чай не помрешь.

Чай не помру, но в блоках нихуя не шарю. Всегда выбирал их по принципу много отзывов - блок заебись. Че там какие конденсаторы мейд ин жапан вся хуйня это от меня далеко. На первом компе который собрал со сдачи с обедов стоял ксас на 500 ватт без прикола. Он кстати до сих пор пашет, но уже у кента. Скоро ему лет восемь наверное исполнится.

>На деле, обработка контекста вряд ли порадует

А если контекст крутить на основной карточке, которая в X16 будет? Или там в любом случае будут данные передаваться, веса крутится и всё такое?

>В идеальных условиях с простым инфиренсом не скажется

Ну инфиренс простой, только плотненькие катать собираюсь. Гемма или большая третья лама в каком-нибудь Q3-Q4. Чатики, ролплейчик, генеральные задачи типа переводов.

Квен - кал, сорян. Глм единственный, кто пишет нормально. В своих лучших свайпах - как убермикс клода и гемини. Дипсик гонял только 3.1, второй квант, не впечатлил, да и медленнее глм намного. Потом дам шанс еще раз, уже в третьем кванте, но, увы, я вывалюсь в оперативу и, скорее всего, скорость мне опять не понравится.

>А? Сколько штук ты их там заказал?

Б! Одну всего лишь. Мне как раз хватит, чтобы перекатиться на квант выше, не вылезая за пределы врам.

> под рамещение двух компактных гпу

А трехслотовые трехкулерные 4070 ti и 5070 ti у нас давно стали компактными?

Рядом они точно не влазят (провод от питания первой мешает поставить вторую вертикально перед ней), стало быть надо лепить в другое место.

Я не силен в таких корпусах (и уж тысяч их точно не видел).

> Генерация на них роляет больше процессинга, если он не совсем днище.

Наоборот. Сгенерировать 1000 токенов можно и на 20, а вот прочесть 30к контекста на 150 уже существенно больнее, учитывая, что генерируешь ты не каждый ответ, зато читаешь… Не, пасиба, все начинается с контекста.

Но опять же, ладно, если ты говоришь, что роли не сыграет, то хай пробует.

> А если контекст крутить на основной карточке, которая в X16 будет?

В жоре нет такого понятия как "крутить основной контекст". Точнее можно организовать подобное, но с х1 лучше не стоит ибо будут лишние обмены. Просто раскидывая модельку через -ts без дополнительных операций с высокой вероятностью все будет сразу ок.

То относится к сценариям с выгрузкой части весов на рам, при обсчете контекста они по частям подгружаются в основную карту и обсчитываются на ней, при этом шина активно используется для этой самой подгрузки.

Всего одну в100 чтобы не вылезать за пределы врам в дипсике и 6м кванте glm? That's pretty brutal. И какие там скорости выходят?

> трехслотовые трехкулерные 4070 ti и 5070 ti у нас давно стали компактными

Пощупай 5090, поймешь какие они малютки.

> Рядом они точно не влазят

Если корпус широкий то можно обе разместить поставив под 90 градусов на кронштейнах что продаются. Если нет - классический вариант с выносом одной вдоль задней стенки корпуса у передней панели, вторую или как есть (если не мешает), или поставить как в первом случае. Вроде не раз обсуждалось это, если не понял - спрашивай.

> Сгенерировать 1000 токенов можно и на 20

В типичных задачах генерации и за 4к могут переваливать, там с 20 т/с, особенно плавно протухающими, замучаешься ждать. 150 процессинга это уже днище если что, но даже с ним время на генерацию может преобладать, ведь ты не каждый запрос пересчитываешь все-все, а чаще только последную часть или новый.

Понятно, значит придется и материнку новую брать. Сука, ебаные нейросети, как мне без вас хорошо жилось...

Скомпилил новый llamacpp с поддержкой nemotron, а tensorsplit перестал корректно работать, ну что за нах?? И теперь эта сука грузит большую часть модели на мелкую карту. Ну как так-то??

llama_params_fit: failed to fit params to free device memory: model_params::tensor_split already set by user, abort

llama_params_fit: failed to fit params to free device memory: model_params::tensor_split already set by user, abort

Ложная тревога ncmoe неверно указал. уффф

Угу, получается что под 90° тока одна помещается (и та не помещается из-за кабеля), а вдоль задней стенки не хватает длины корпуса.