Хуитер лессон, ты бредишь? Выдал невероятный кринж, уровня колхозника, который негодует почему к электро-локомотиву не цепляют тендер с углем и не жгут его.

> сравнения

Значение знаешь?

> с рандомным шумом

Рандомным шумом это выглядит для кожанного, пытающегося рассматривать странные проекции и ожидающего что-то увидеть. Ты еще поудивляйся почему визуализация звука от речи не является картинками того о чем говорят.

> Aлиса это реликт созданный до массовой популяризации ллм

А как она вообще работает?

Так она и не работает нихуя. Голос распознает плохо, выдает какие-то заранее запрограммированные ответы, а то что не знает то гуглит. Я вообще не понимаю как в 2026 можно пользоваться алисой или западной алексой, это все равно что смотреть телевизор с элт экраном.

Алиса это не собеседник а голосовой пульт, ты же не рейджишь на клавиатуру когда она с тобой диалог не поддерживает?

>Хуитер лессон, ты бредишь?

Нет.

>Значение знаешь?

Да.

>Ты еще поудивляйся почему визуализация звука от речи не является картинками того о чем говорят.

А можно было бы сделать и так.

> А можно было бы сделать и так.

Можно нетренить сетку, которая из непонятных тебе орнаментов и шумов будет делать узнаваемые образы.

Второй или третий слой печатай. Или пятый. На первом всегда шум или полосы.

Наоборот, первый самый понятный, остальные это многосотмерные хуитки.

И да, там не свёртка по сути, так что второго слоя нет.

Сап LLMщики!

Подскажите, пожалуйста, как можно реализовать что-то вроде РП, где 2 персонажа будут сами двигаться по сценарию?

Может пресет для Таверны какой есть?

У меня просто из-за скудной фантазии GIGO какой-то получается...

Подскажите, пожалуйста, как можно реализовать что-то вроде РП, где 2 персонажа будут сами двигаться по сценарию?

Может пресет для Таверны какой есть?

У меня просто из-за скудной фантазии GIGO какой-то получается...

>где 2 персонажа

Делаешь групповой чат, пишешь "они делают [что то конкретное]" или просто запускаешь генерацию следующего сообщения.

Слушай, а ведь хорошая идея.

Ставишь две нейронки (одну и ту же с разными системными промтами) играть саму с собой сюжет.

После ста сообщений берёшь и кормишь это нейронке-оценщику с третьим системным промтом, которая выдаёт баллы за креативность, следование сеттингу, отсутствие роялей и прочее.

И потом незначительно в соответствии с комментарием (можно тоже нейронкой с четвёртым системным промтом) меняешь системные промты персонажей.

Всё, что-то около генетического алгоритма по подбору более совершенного промта создано. Уже хочу это запустить.

THE BASE OF THREAD

Читаю треды минувших лет дней. Позади Третья Квеновая Война... Или пятая? Хуй его знает. War never changes. Короче время давануть базу

Скормите примеры диалогов и тогда все тип топ, и этот Квен наш! Он по прежнему будет уходить в переносы строк когда ему вздумается, даже если в карточке тысяча-две токенов написанных от руки описаний и диалогов, даже когда у вас позади минимум 20к контекста где этих переносов нет. Но будет делать это уместнее и часто очень в тему. Если нет, то от свайпа вам не убудет, один хуй на любой модели свайпаете. Пук 3 например, там и карточка норм написана и с примерами, и контекста очень много позади. Но Квен взял и сделал. А я и не против. Это оч забавно, иногда он ахуенно смешные перлы выдает

Квен как и Писик - модель с характером, нравится вам или нет, до конца от него избавится не получится. Можно назвать это байасом. Для чего-то донельзя серьезного имхо не годится, но как же он может в любые формы делирия. Комедию отыгрывать - заебись, хоррор - хорошо, кум - ну пойдет, пишет сочно но всегда с этими hold me like you mean it (референс рокнрольщиков) и make me yours. Мудрейшие правильно говорили в ранних обсуждениях, короткий промтик, стиль направляем карточкой. Хорошая моделька для своих рп юзкейсов. Осуждаю всех тех кто насмехается над неосиляющими модельку. Хули вы удивляетесь, что Квен поливают говном, если сами ничего не сделали чтобы это исправить? Даже наоборот. Любите Квен - ну так помогите блять ему найти своих почитателей, а не закрывайтесь в касте ахуенно умных снобов, по которым судят и модель тоже. Вы не Дон Корлеон, блять, вы на двачах ноунеймы ебаные. Особенно этот который оче хорошо заебал, гнус среди всех гнусов, в каждой Квеновой Войне поучаствовал и ни разу ничего сущностного не выдавил

> Если этот подход кому-то интересен, могу (уже наверное завтра) подготовить

Куда пропал? Где?

> Я могу скинуть свои логи.

Куда пропал? Где? Прекращай срамить Квен своим недостойным поведением

Скормите примеры диалогов и тогда все тип топ, и этот Квен наш! Он по прежнему будет уходить в переносы строк когда ему вздумается, даже если в карточке тысяча-две токенов написанных от руки описаний и диалогов, даже когда у вас позади минимум 20к контекста где этих переносов нет. Но будет делать это уместнее и часто очень в тему. Если нет, то от свайпа вам не убудет, один хуй на любой модели свайпаете. Пук 3 например, там и карточка норм написана и с примерами, и контекста очень много позади. Но Квен взял и сделал. А я и не против. Это оч забавно, иногда он ахуенно смешные перлы выдает

Квен как и Писик - модель с характером, нравится вам или нет, до конца от него избавится не получится. Можно назвать это байасом. Для чего-то донельзя серьезного имхо не годится, но как же он может в любые формы делирия. Комедию отыгрывать - заебись, хоррор - хорошо, кум - ну пойдет, пишет сочно но всегда с этими hold me like you mean it (референс рокнрольщиков) и make me yours. Мудрейшие правильно говорили в ранних обсуждениях, короткий промтик, стиль направляем карточкой. Хорошая моделька для своих рп юзкейсов. Осуждаю всех тех кто насмехается над неосиляющими модельку. Хули вы удивляетесь, что Квен поливают говном, если сами ничего не сделали чтобы это исправить? Даже наоборот. Любите Квен - ну так помогите блять ему найти своих почитателей, а не закрывайтесь в касте ахуенно умных снобов, по которым судят и модель тоже. Вы не Дон Корлеон, блять, вы на двачах ноунеймы ебаные. Особенно этот который оче хорошо заебал, гнус среди всех гнусов, в каждой Квеновой Войне поучаствовал и ни разу ничего сущностного не выдавил

> Если этот подход кому-то интересен, могу (уже наверное завтра) подготовить

Куда пропал? Где?

> Я могу скинуть свои логи.

Куда пропал? Где? Прекращай срамить Квен своим недостойным поведением

Так блять, пока писал свое говнополотно появился твой вопрос. Не слушай этих шизиков, которые любят все усложнять. Какие две модельки? Вон у меня на пикрилах ровно то что ты описал. Берешь https://github.com/Samueras/GuidedGenerations-Extension и юзаешь impersonation от 1 или 3 лица как удобно, пишешь "i walk into the room" или от 3 лица и за тебя ллмка во всех подробностях это пишет. По желанию можешь отредачить как надо и все такое

Ну или берешь и жмакаешь enter если ты в текст комплишене. Модель просто продолжит сама писать историю. Не важен порядок модель -> юзер, можно иметь в чате много сообщений от модели подряд, похуй вообще

>Короче время давануть базу

>дефолтнейшая инфа про карточку

>переносы на месте

>проза на месте

Давани себе на лоб квеношизик

Все секреты мира чрезвычайно просты, нытик. Чтобы стать успешным нужно трудиться. Чтобы быть счастливым нужно делать выбор в пользу счастья. Чтобы получать хорошие аутпуты нужны хорошие инпуты и промты. Нет никакого чит шортката, который сделает тебя богатым. Нет никакого события или человека, который сделает тебя счастливым пока ты сам это не выберешь. Нет никакого пресета, который за тебя будет промтить и управлять моделькой лох

> Все секреты мира чрезвычайно просты

Да, если модель хуйня то она хуйня и надо ждать апгрейд

Ну сиди терпи перди, жди у моря погоды. Когда-нибудь несомненно сделают модель которая залезет к тебе в голову и сделает хорошо, плохо не сделает. Вон там за гаражами агишизики пентаграммы рисуют, попробуй к ним заглянянуть

Уже дождался, эир же.

Эир это выдать заказик на пвз

Квен это разгрузить вагон

А почему все сидят на аире 4.5 когда уже месяц лежит 4.6?

https://huggingface.co/zai-org/GLM-4.6V-Flash

https://huggingface.co/zai-org/GLM-4.6V-Flash

> залезет к тебе в голову и сделает хорошо

Только хорошо не ему, лол.

Хз, кажется про эту модель обширного мнения что плохая или сильно хорошая не было. Средитторам нравится.

Тут вообще ничего больше не используют и не обсуждают как ты мог заметить, только набрасывают в надежде что скинут пресет.

О, загрузку с хайгитлерфейса починили.

А как можно запускать Таверну с уже указанными параметрами (семплерами/промтами) под запускаемую модель? Может кто-то поделится готовым скриптом, пожалуйста.

Новичок в треде, имею возможно глупенький вопрос.

А правда что локальные модели в основном отлично и РПшат и кумят исключительно на английском? Если для русского нужно искать либо тюн мистраля с не убитым русским, либо ещё бОльшие модели юзать, то на англюсике и мистраль просто секс, и даже 8B малыши дают конкретную ёбку?

А правда что локальные модели в основном отлично и РПшат и кумят исключительно на английском? Если для русского нужно искать либо тюн мистраля с не убитым русским, либо ещё бОльшие модели юзать, то на англюсике и мистраль просто секс, и даже 8B малыши дают конкретную ёбку?

>русского

Любая модель лучше перформит на инглише.

>Новичок в треде

Ох уж эти попытки устроить русикосрач

создаёшь пресет, выбираешь его в таверне, чтобы сразу запустить с - это к кобольду

Русский - Это Гемма 12 и 27, Янка-8, Сайга-12 и то что на её основе + некоторые мистрали 24.

Толстые модели могут в русский лучше чисто по причине количества параметров.

Ёбку не дают, просто англе

- Больше было текстов (в том числе кривых и говённых)

- Ты не носитель, так что не выкупаешь когда модель кри во пишет на англе

Какая сайга? На гемме или чём-то ещё? Илья Гусев вроде не выпускал моделек. Сайги ещё актуальны?

А что анон думает про Vikhr? А про RefalMachine? В тгк вихрей читал что RuAdaptQwen3 даже на 4B пиздат на русском. Кто-то пробовал эту серию?

>Ты не носитель, так что не выкупаешь когда модель кри во пишет на англе

Кстати не думал с этой точки зрения, а замечание вполне справделивое. Возможно похуй на этот англюсик.

>Илья Гусев вроде не выпускал моделек

В последние несколько месяцев бля. Фикс.

стараюсь изо всех сил не просить пресет. потряхивает

Как человек может давануть себе на лоб? Ты совсем квантованный?

На русском тоже можно. Для простого парня Ивана город Пермь Мистраль 24б последний или Гемма 27б. Дальше жирномоешки для ригобояр. На английском любая модель будет работать лучше, это факт.

>RuAdaptQwen3 даже на 4B пиздат на русском

Все мелкие геммы хороши на русском из коробки, без всяких файнтьюнов, 1b, 4b, старая 2b тоже. Только это не для кума. Использую их на телефоне и на древнем лэптопе, брат жив.

Если нужен именно кум на русском, то:

https://huggingface.co/mradermacher/M3.2-24B-Loki-V1.3-GGUF

https://huggingface.co/mradermacher/MS3.2-PaintedFantasy-v2-24B-GGUF

https://huggingface.co/unsloth/Mistral-Small-3.2-24B-Instruct-2506-GGUF

Если картошка вместо компа, то:

https://huggingface.co/mradermacher/SAINEMO-reMIX-GGUF

https://huggingface.co/unsloth/Ministral-3-14B-Instruct-2512-GGUF

>Как человек может давануть себе на лоб?

Перевернувшись.

>Все мелкие геммы хороши на русском из коробки, без всяких файнтьюнов, 1b, 4b, старая 2b тоже. Только это не для кума. Использую их на телефоне и на древнем лэптопе, брат жив.

Вот неиронично не могу представить задачи для моделек меньше 8-12b, особенно на телефоне. Поделись юзкейсом?

Ваня сквозь стеклянную крышку своего пк может наблюдать как перемножаются квантованные тензоры на гпу и озу в реальном времени, вместо чатика, ведь в 12GB видеокарту они не влазят. Есть какой-то ультимативный метод ускорения dense моделек если не хватает врам?

Или хитрый Иван нашёл какие-то мега крутые карточки с 16GB+ не за его месячную зарплату? А то просто куртка ахуел и всё ещё выпускает 8GB и я ума не приложу как вы бля все тут умудряетесь загружать ебучие модели по 100B+. Либо это мистическое место на дваче, где собрались все 300кк/наносек господа, либо блять это тайна.

>SAINEMO-reMIX

О, ещё актуальна? Целый год прошёл. Неужели не появилось тюнов/мёрджей новее и лучше?

> геммы 1b, 4b

Бля, чисто в теории. GigaChat3-10B-A1.8B может ли быть лучше чем они в русском языке? Или хотя бы на уровне?

Еще неожиданно неплох на русском вот этот тюн геммы: https://huggingface.co/bartowski/Darkhn_G3-27B-Animus-V12.0-Redux-GGUF?not-for-all-audiences=true

По крайней мере в режиме Chat Completion, на котором я его запустил вместо "другой модели"(tm), и не сразу это заметил. :)

Такой себе, случайный слепой тест получился.

На английском - это нечто среднее между кум-тюном и тюном под адвентюры. На русском, похоже, тоже могёт. Только вруша. Если чего-то не знает - фантазирует на тему, говорить "не знаю" не умеет вообще. Как серьезный ассистент, потому, непригоден.

Люблю генерировать картинки и видосики в китайских локалках, а они для нормального результата требуют полотна текста с китайской прозой в духе квена, лол. И часто такое бывает, что я не знаю как перевести какое-то слово или оборот для промпта с русского на английский. Ресурсов на компе для запуска большой ЛЛМ не остается вообще, там едва-едва на браузер с парой открытых вкладок хватает. Вот тут-то умничка 4b на телефоне и выручает. Описываю ей чего хочу добиться - она мне выдает варианты как это кучеряво написать на инглише, дает несколько вариантов, объясняет нюансы каждого. Очень удобно, и 4b малявки для такой задачи за глаза. Да, можно было бы конечно использовать для этого гопоту/дипсик - но это неспортивно. Локалочки наше всё.

>О, ещё актуальна?

По ходу да, сейчас мелкомодели не тюнят. Сам искал недавно тюны нового мистраля на 8b и 14b в запасы на случай чебурнета. Спрашивал в прошлом треде - никто не знает.

Но зачем, когда есть Гемма 3n-e4b?

>Но зачем, когда есть Гемма 3n-e4b?

Есть ли однокнопочный родственник Кобольда или ЛмСтудии на Андроид чтобы легко запускать? Какой у тебя квант, сколько кушает рамы, какая скорость?

> ускорения dense моделек

Ты можешь снизить объем вычислений выгрузив весь атеншн и прочее на гпу, там малые объемы но много компьюта. Тогда на проце останутся только перемножения больших линейных слоев, где упор исключительно в скорость рам.

> хитрый Иван нашёл какие-то мега крутые карточки с 16GB+ не за его месячную зарплату

v100, 16-гиговая в круг выйдет около 15, 32 под 40.

>По ходу да, сейчас мелкомодели не тюнят.

Очень печально, интересно почему раньше делали и в последний год резко перестали.

>Гемма 3n-e4b

Ну, это не совсем полноценная MoE, но да, она сасная. Даже e2b крута, мне её зрение часто помогает.

Для андроида есть google ai edge gallery, как раз для gemma 3n

>выгрузив весь атеншн и прочее на гпу

О, спасибо, ща трайнем.

>v100

Оно точно того стоит? Архитектура старая, ни flash attention 2, ни bfloat16, ни в целом любых других типов данных кроме float16. Какая-нибудь 3060 12gb за счёт оптимизаций и архитектур может столько же хуйни вместить, не?

https://huggingface.co/spaces/kristaller486/RuQualBench

На сколько этот бенч отражает действительность? Конечно тут сравнение исключительно качества русского, общая думалка модели не учитывается, но правда что у YandexGPT-5-Lite русик лучше, чем например у GLM-4.6?

На сколько этот бенч отражает действительность? Конечно тут сравнение исключительно качества русского, общая думалка модели не учитывается, но правда что у YandexGPT-5-Lite русик лучше, чем например у GLM-4.6?

https://github.com/Vali-98/ChatterUI

Гемма 4b Q4_K_XL, помещается с 2к контекста впритык. У меня 8гб рам, скорость пикрелейтед.

Пасиба пасиба. Тоже что ли на свой простенький телефон Гемму умничку накатить. Ну а вдруг пригодится? Заблужусь в лесу с полным зарядом батареи и смогу спастись.

>интересно почему раньше делали и в последний год резко перестали

Потому что не нужно. Только портить.

Да и модели стали так плотно набивать, что не тюнятся.

>общая думалка модели не учитывается

Ты сам ответил на свой вопрос.

> не

Не. Ближайший конкурент - 3090, немного выше перфоманс, но за счет более новой архитектуры поддерживает экслламу для ллм, поддерживает сажу для крупных генеративных что позволяет работать быстрее с ними. Но ничего из этого не компенсирует нехватку врама, чисто для ллм одна V100 будет лучше чем одна 3090. Если собирать риги и/или катать другие генеративные то уже индивидуально, плотно увлечешься и будешь готовым переплатить за меньшие тормоза.

> стали так плотно набивать, что не тюнятся

Дело не в этом, можно притянуть только то, что сейчас выпускают не просто сырую базу а хорошо шлифованный готовый продукт. Чтобы тренить такое - требуется нормальный датасет и организация всего процесса, чего нет у васянов.

Ну вот на Мистраль 24b - тюнов столько, что ими вся обниморда завалена. А на 8b и 14b, которые новее - ни одного. Это странно.

Наконец-то подебил ультра немотрона на жоре, успех. Но скорость, конечно, мда - тг 5 т/с на пустом контексте в 4 кванте, и это без использования паскудныхальных тесел в конфиге... Сасуга моэ, как говорится. Ну ладно, ради интереса можно и потерпеть, потому как я пытался запускать милфолламу однажды в третьем кванте и получил по ебалу одним токеном в секунду.

>Но зачем, когда есть Гемма 3n-e4b?

В llama.cpp не работает вижен модель от e4b. А от 4b работает.

Это с виженом? Он там есть же?

что за модель?

И да, e4b это очень крутая модель, я не думаю что есть что-то лучше при том же размере. Ещё и эмбеддинг на 2 гб можно в рам скинуть.

Ты когда на видеокарточке запускаешь - это сразу х30 скорости по сравнению с процессором.

То есть даже если она старая и даёт всего х10 - это всё ещё более чем достаточно. Грубо говоря у тебя акцент на память:производительность 9:1 и если бы была ещё более медленна карточка, условная GV140, но с 48 ГБ, то выбирали бы её вместо V100 с большой вероятностью.

Опция отправить в чат картинку в аппе есть, так что наверное да. Но я не проверял, т.к. под мои задачи не нужно.

LTX-2

Кто-нибудь смог нормально настроить гпт осс 20б для рп? Всё хочу попробовать, но эта залупа просто невменяемая. А 120б вряд ли кто-то юзает в режиме размышлений, именно он мне нужен.

Быть может, если бы я решил ебаться с ним три часа, то настроил, но сил моих нет. Резонинг идёт по каким-то ебанутым каналам по хуй пойми каким условиям.

В других бэках/юи типа лм студио все норм, но мне в таверне нужно.

Я просто хочу уже без мозгоебства погонять модель, файнтюны, аблитерации и сравнить её со старым немо без цензуры.

Ни одна модель мне так мозг не трахала.

И да, я читал документацию клоседов. Складывается впечатление, что без какого-то особого колдунства и костылей этот кал просто не сможет в таверне работать с ризонингом нормально.

Быть может, если бы я решил ебаться с ним три часа, то настроил, но сил моих нет. Резонинг идёт по каким-то ебанутым каналам по хуй пойми каким условиям.

В других бэках/юи типа лм студио все норм, но мне в таверне нужно.

Я просто хочу уже без мозгоебства погонять модель, файнтюны, аблитерации и сравнить её со старым немо без цензуры.

Ни одна модель мне так мозг не трахала.

И да, я читал документацию клоседов. Складывается впечатление, что без какого-то особого колдунства и костылей этот кал просто не сможет в таверне работать с ризонингом нормально.

>гпт осс для рп

Мсье знает толк в извращениях

Вот когда-то давно тредовичок тестил 120б версию >>1349309 в конце поста видно какой ризонинг префил, чтобы обойти цензуру и оно не развалилось на текст комплишене. Хотя мб там и шаблон какой-нибудь изъебистый, читай всю ветку короче.

Судя по всему полное говно и нет предпосылок почему 20б не будет говном, которое еще хуже в 6 раз

Бля оно в архиве, вот ссылка https://2ch.su/ai/arch/2025-12-28/res/1345987.html#1349309

Можно попробовать через режим Chat Completion, это избавит от необходимости трахаться с ее разметкой - будет задействован вшитый шаблон. Но тогда она своей цензурой заебёт, т.к. ее будет не обойти (это через шаблон делается). Потому, если такое пробовать - то только с расцензуреным тюном. А как у него с мозгами будет - это хрен его знает.

Укажи свой темлейт. У вллм можно как дефолтный задать так и с каждым запросом нужный слать, жора только указание джинджи при старте умеет (когда последний раз проверял)

И в целом умение в джинджу мастхев для тех кто крутит локалки т.к. позволяет иметь все плюшки чат и текст комплишена не имея жопоболи с ручной сборкой этого самого шаблона

Подебажил жору, чтобы понять, откуда жор. В общем, по итогу это привело, внезапно, к документации, причем к самому видному месту, а именно к опции GGML_CUDA_FORCE_MMQ, где черным по белому пишется про v100. Для батчей контекста v100 не подпадает под критерии mmq, для нее дергается cublas имплементация матмула, в результате тензор размером 3 Гб при конвертации в фп16 превращается в 13 гигабайтного монстра. От такого даже v100 в ахуе.

Поэтому имейте в виду, что на дефолтных настройках v100 будет жрать больше. С GGML_CUDA_FORCE_MMQ, как пишут, будет чуть медленнее пп, но жор должен значительно снизиться. На обычных моделях я этого не особо замечал (тензоры обычно не такие большие + 32 гб развращают), но немотрон конкретно ударил в псину.

Есть ебанутые и отчаянные? Примерно 5к уже с доставкой

Ценник +- реальный

Расскажите про Loop Transformer

Да что ты знаешь о ебанутости и отчаянии, сын мой?

Взял на время, пересидеть пока что-то адекватное нвидия не выкатит, на замену 3060 12гб. Как заберу - сравню результаты в нейронках (видео/картинки/ллм) со старой видяшкой и выложу в тред, может кому-то интересно будет.

> Да что ты знаешь о ебанутости и отчаянии, сын мой?

Достаточно. Начал собирать риг на ми50 ещё до того как это стало мейнстримом

ребят, какую версию лучше всего установить?

у меня ryzen 5 5500u со встройкой, 16 гигов оперативы.

на основном ноуте с r5 5600h + rtx 3060 я юзаю обычный koboldcpp.exe, благо позволяет железо.

у меня ryzen 5 5500u со встройкой, 16 гигов оперативы.

на основном ноуте с r5 5600h + rtx 3060 я юзаю обычный koboldcpp.exe, благо позволяет железо.

а, я пиздоглазый, сорян.

думал сверху чейнджлог написан, оказывается там и пояснение по версиям есть.

думал сверху чейнджлог написан, оказывается там и пояснение по версиям есть.

Очевидно же. Выбирай из этих двух в зависимости от ОС.

sudo chmod +x 'koboldcpp-linux-x64-nocuda' и все.

кстати, почему на процессоре с 16 гигами оперативки работает с такой же скоростью, как на 3060?

я прихуел даже

кстати, почему на процессоре с 16 гигами оперативки работает с такой же скоростью, как на 3060?

я прихуел даже

Так.

Почему тут совсем не обсуждают ттски?

За год их столько навалили, одна х3 меньше и лучше другой, ща они в районе 80м и влезут куда угодно

Но тут молчат

Почему тут совсем не обсуждают ттски?

За год их столько навалили, одна х3 меньше и лучше другой, ща они в районе 80м и влезут куда угодно

Но тут молчат

text to speech?

бампую развитие темы данной. хочется слышать причмокивания в данном так называемом ролеплее.

>локальные модели в основном отлично и РПшат и кумят исключительно на английском

Нейронки в принципе лучше всего работают на английском, во всех задачах. Кроме, наверное, китайских, но китайского я не розумию.

>для русского нужно искать либо тюн мистраля с не убитым русским

Нету таких. Не только мистралей нету, моделей с хорошим русским в принципе нету. Просто планка настолько низкая, что начинают облизывать любую локалку, которая правильно склонения со спряжениями проставляет.

>Почему тут совсем не обсуждают ттски?

Под них есть отдельный тред, зачем этот вопрос сюда тащить? Вы еще спросите, почему мы тут генерацию картинок не обсуждаем. Тоже ведь локально.

>почему на процессоре с 16 гигами оперативки работает с такой же скоростью, как на 3060?

Может потому что у тебя до этого видеокарта вообще не работала? Даже на частичной выгрузке должна быть разница, если только там не 5 из 50 слоев в видеопамяти висят.

Интересно каков кум на китайском

> отдельный тред

Который до бамп лимита год дойти не может

>Который до бамп лимита год дойти не может

Ну значит никому нейроспич не интересен. Тут тоже про него раз в 30 тредов дай бог вспоминают.

Пол месяца прошло, абсолютное молчание. Ничего не происходит, никогда.

Бюджеты урезали, теперь все модели будут выходить раз в год, и будут они маленькими, ненужными.

Бюджеты урезали, теперь все модели будут выходить раз в год, и будут они маленькими, ненужными.

Господа, посоветуйте хорошую 12b модель для рп/кума из последнего. Год назад сидел на немомикс анлишеде, он был уёбищем, но лучше тупо ничего не было, изменилось ли вообще что - то в 12b сегменте, или та же самая хуйня только с другими названиями? Я конечно могу гонять 24b, но на 7 т/с крыша ехать начинает.

Че тут странного? Подожди полгода, посыпятся один за другим.

У меня игры выходят раз в три года в которые можно играть дольше 3 часов — а ты ноешь что модельки выходят реже чем 2 в неделю.

Что кстати неправда, просто распределение пуассона балуется + праздники были.

На реддите таверны в еженедельных ветках поищи, там постоянно тюны на 12B вываливаются. Что-то лучше немомикса точно найдешь, он был говном даже на момент выхода.

Как ты заебал

>Не только мистралей нету, моделей с хорошим русским в принципе нету.

Шиз, спок. Съеби на форчан-помойку.

Отрицание реальности саму реальность не отменяет. Моделей с нормальным русиком нет. Мне бы хотелось чтобы они были, но их нет. Однажды ты тоже это поймешь, когда закончишь девятый класс.

Рам?

Хуевый русик лучше отличного англюсика, если на втором ты не можешь прочесть полотно из 500 токенов хотя бы за 2 минуты и понять 90%. на что не способно 99% треда как бы кто не усирался

>Хуевый русик лучше отличного англюсика

Лучше давиться англюсиком, переводить непонятное вручную и читать 200 слов за десять минут, чем дрочить на однотипные обороты с упоминанием говна по типу "лона, лепестков, горошинок клитора" и прочей графомании, от которой тошнит еще сильнее чем от шиверсов.

>на что не способно 99% треда как бы кто не усирался

Не проецируй свои проблемы на других. Большая часть треда как раз сидит на английском и вполне себе понимает. Воняет как раз меньшинство, которое не может даже базово совладать с языком, на котором выпускается большая часть контента, от развлекательного до технического.

Слушать контент и читать не одно и тоже, мань.

Что то смотреть я могу часами и не устать, чтение же заебывает довольно быстро

Печально быть тобой.

Квеносрач был, теперь языкосрач на очереди?

Кстати, последняя гемма, там где норм-пресервед, прям хороша, да. Особенно в кобольде на сторителлинге. Буквально лучший локально-потребительский великий и могучий.

>чтение же заебывает довольно быстро

Это твои проблемы и ты их опять проецируешь.

>Квеносрач был, теперь языкосрач на очереди?

Русикосрач тут велся еще до того как китайцы проснулись и начали клепать модели, с подключением. Только мне всегда были непонятны причины такой жесткой тряски, если русский на локалках реально слабый из-за того что это второстепенный язык в лучшем случае со всеми вытекающими проблемами.

Спосебо вам за ответы!

Была похожая задумка, но слишком заморочено.

Пушка!

Была похожая задумка, но слишком заморочено.

Пушка!

Куда пропал?

Няшил любопытных под пледиком и массировал им ушки.

>Хуевый русик

Он не хуёвый. Он никакой.

Смотри. Датасет папочка, датасет решает. Русский язык вам нужен не для чатинга, тут он не плох, а для сисик и писик, но как только мы заходим в сферу РП и ЕРП, то всё - баста. Сушите вёсла и ебите лимоны.

Потому что на баренском написаны тысячи порнофанфиков, на нём написаны тысячи книг, приключений и всего остального. И английский язык отличается от русского в структуре построения предложений, в диалоге. И как модельки поступают в таком случае? Они просто ебашут прямой перевод. И это больно читать. Я люблю хороший русский текст, меня бросает в дикую тряску от этих бусинок. А на английском все эти шиверсы, мейби, и прочие -измы вообще не раздражают.

Вот и вся причина. Нас тупо мало, мы производим мало контента, мы его не продвигаем. Та-же гемма прекрасно пишет на русском, если тебе нужен литературный стиль, квен прекрасно пишет на русском. Но всё это сухо и безлико.

Поэтому русикосрач бессмысленный в своей сути.

>на баренском написаны тысячи порнофанфиков, на нём написаны тысячи книг, приключений и всего остального

>весь кум один хуй сводится к make me yours/ruin me for anyone else etc.

Что на 8б что на 120б модели

Вот кстати, чтобы такой хуйни не было уже непосредственно в процессе изготовления крема можно попробовать примеры диалогов использовать. Пока соу соу, но уже лучше. По крайней мере, на тестах, нейротянка запрыгнула на user и когда, мой персонаж попробовал что то сказать, получил пощечину и был зацелован. Мелочь, а приятно. Но всё равно не то. Я сейчас думаю через лорбуки с процентом активации подвязать поведение по тегам. Ну условно - стесняшка будет делать так с 20%, а хангри кокслив по другому. Но тут другая проблема. Я ИХ ДЕЛАЮ, Я ЗНАЮ ЧТО ТАМ БУДЕТ. Это будет скучно, без интриги.

Хмм..хмм... хммм.. Хоть драммеромелочеть как агента используй.

https://rentry.co/LLMCrutches_NoAssistant

Как обычно заняло больше времени чем рассчитывал. Если кто-нибудь проверит и отпишется, что инстукция в целом рабочая, то хорошо было бы. А то мало-ли, что ещё упустил.

> Не совсем, именно для этого в таверне есть настройка оверрайда параметра добавления имен в групповых чатах чтобы оставались. Только это часто негативно влияет на аутпуты в целом, потому отключают в одиночных.

А, ну значит я просто забыл, как это настраивается - давно уже не пробовал групповые чаты в таверне запускать.

> В одиночных чатах тоже юзабельно. Разбавления нарратором может улучшать структуры и суть ответа, улучшается проработка речи-действий в сценах где появляются другие персонажи, нейронка потом меньше путается.

Интересно, я не рассматривал это с такого угла.

Отдельные ттски только добавляют задержки и озвучивают неправильно, а end-to-end ллм с голосом не сказать чтобы частый гость (и тоже говно).

Переводчики уже изобретены. Вот писать да, сложнее, а читать изи.

>что на 120б модели

Попробуй 235.

>https://rentry.co/LLMCrutches_NoAssistant

О, там есть общая страница с советами https://rentry.co/LLMCrutches

Вот думаю, менять ли на неё вот эту ссылку в шапке?

>https://github.com/cierru/st-stepped-thinking

>Попробуй 235.

Квен точно так-же пишет ruin me, ты точно этого хочешь и прочий слоп. Да, он до этого выдаст что то веселее покачивания бедрами, но всё равно не то.

А что в вашем понимании "хороший кум" ? Как и в Квеновских Войнах (а ранее - Геммовских Баталиях) никто так и не дал опреления. Вот например новая гемма умеет помогать писать эросцены со смыслом и задействованием особенностей персонажа, а не просто лить декалитры жидкостей.

>на баренском написаны тысячи порнофанфиков

и все они усреднены до условного "дас ист фантастиш"

>на баренском написаны тысячи порнофанфиков

и все они усреднены до условного "дас ист фантастиш"

Вангую новая гемма будет не мое, дадут "легкий" контекст и всё, это будет вся фича 4 версии, апгрейд же, жрите хули.

Наверняка спецом его таким жирным и сделали

Наверняка спецом его таким жирным и сделали

рпшу немного по настроению, но без хардкора, эльфов и экспы.

мне понравился слог (на англюсике) у RP-King в гуфе у рейдера (да, это прям лютый микс на Немо 12b).

Но в перевод он не может, переходит на лютый рунглиш с маджик транслейтом, а о руссише его я просто промолчу. Любит писать за тебя. Впрочем, все можно фиксить. Но в англюсике прям хорош.

Сейчас вот гоняю нового менестреля 14b, он хорош, но к нему надо привыкать и менять ВСЕ настройки.

Но да, у менестреля есть проблемы, он может тупануть и потерять деталь. Я думаю лечится карточками/ворлдами. А еще он ЛЮБИТ срать звездочками (зачем?). Срет везде и постоянно, видимо считает, что выделение слова жирным это экспрессивно и необходимо (на реддите подтверждали звездную болезнь). Впрочем, я думаю, лечится и это.

продублирую тут, прощелкал перекат

И как p104-100 с 3060/12, норм робит? 24b гоняют? Тоже просто думал прикупить на барахолке 104ю, дать ей вторую жизнь.

>А что в вашем понимании "хороший кум" ?

Постепенное нарастание градуса эротизма, следование характеру персонажей, учёт сцены и происходящего. Фарзы персонажей соотвествуют их характерам. Если это яндерка, я жду что она будет яндериться. Отсуствие двойных трусов, акцент на фетишах, если это указано, отсутствие разговоров с набитым ртом.

Наверное поэтому я и не могу с квена слезть, потому что он в ЕРП ебет. У него самые лучшие яндерки/янгирки получаются, визжу от радости, но только после пинка по жопе.

>и все они усреднены до условного "дас ист фантастиш"

Он они есть и среди них проскакивают вины. А на русском ничего особого кроме Лолиты и рассказов уровня стульчик.нет нет.

У меня на русском хороший чат получился только с уставшей демоницей. Знаете, такой питерский вайб. Потрепанная кухня, дождь за окном, свинцовое небо. И вот мы сидим на этой кухне, по стене бегает таракан, мой персонаж глушит самогон и мы разговариваем не о вселенских вопросах, а о том что делает человека человеком.

>У меня на русском хороший чат получился только с

Достоевским пахнуло

Ага. Чистейшая Достоевщина, поэтому вин и получился.

Вот я именно об этом. У него есть с чем работать в этих рамках, но нет ничего, когда заходит речь о чистейшем пореве.

Какие подозрительно знакомые цвета. Ну ты бы хоть тему отредачил, а то в космос с помпой улетел же. Если вернулся то хоть пресет скинь

>кроме Лолиты

Чёт думаю ни одна моделька не сможет выдать пёрлы уровня лолиты (офк если абстрагироваться от тематики детоебли).

Читал только вступление, джаст фор лулз.

Хмм, надо кстати попробовать. Но тут опять же повествование ведется от лица героя, с его постоянной шизой: он сначала чем то восторгается, потом вообще начинает описывать левые события и при этом постоянно общается с читателем. Если описать паттерн повествования, модельки должны осилить

>модельки должны осилить

Покажи модель, которая выведет хотя бы 1/5 вайба текстрилла

Лолита, свет моей жизни, огонь моих чресел. Грех мой, душа моя. Ло-ли-та: кончик языка совершает путь в три шажка вниз по нёбу, чтобы на третьем толкнуться о зубы. Ло. Ли. Та.

В этом абзаце влечения извращённого, завидуем осуждаем больше, чем в полотнах покачивающихся бёдер.

Хотя, я тут подумал. Не, нифига. Не вывезет. Слишком у Набокова сложный слог. Будет слепое копирование без понимания сути. С Достоевским проще. У него слог легче да и темы: ехали страдания через страдания, да самокопаниями занимались.

Влечения? Это уберкринж

Согласен.

Я хуйню написал. Этот отрывок не самое сложное. Я сейчас не буду искать, но там есть дико доставляющий момент когда он восторгается её невинностью, описывая как она ножками перебирает на стуле и вздыхает, а сквозит прям ТРАХАТЬ ТРАХАТЬ ТРАХАТЬ. Но прочитав чуть дальше, ты понимаешь что она просто напугана, но подается это через нашего героя словно она стуженный ангел.

> стуженный

Сломанный

> Няшил любопытных под пледиком и массировал им ушки.

Ушкам приятно конечно, но где логи?

> https://rentry.co/LLMCrutches_NoAssistant

Ай молодец, умница. Позже как найду время попробую обязательно. Подозреваю контекст постоянно пересчитывается? Может быть траблом

Прав, но всеж именно Квен и Эйр отлично именно отыгырвают персонажа в рп. Локалкам поменьше это недоступно, там все сводится к знаменитому ты меня ебешь

Когда чар остается чаром, а не умоляет уничтожить ее пусечку как это было предыдущие 100500 раз. И пишет при этом сочно. Насчет сочности кстати Эйр, по моему, лучше Квена. В плане описаний. А Квен лучше следует чару

Не, я не тот, о ком ты подумал. Он давно уже зашарил свою тему, с тех пор на ней и сижу, цвета приятные

-HY-MT

Как этим калом китайским переводить? Промты типа переведи это он не понимает.

Как этим калом китайским переводить? Промты типа переведи это он не понимает.

Ты и так не сможешь.

Я так далеко не заходил, так что верю.

>Промты типа переведи это он не понимает.

Да что ты говоришь. А в их гитхабе они прямо так и приведены

https://github.com/Tencent-Hunyuan/HY-MT?tab=readme-ov-file#prompts

Устал ходить по блядям с чуба

Хочу карточку своей вайфу, примеры диалогов прямо из новеллы возьму

Что нужно вообще? Внешность там, характер

Но вот лор описывать это пизда, да ещё и так чтобы в 1к токенов уместить

Хочу карточку своей вайфу, примеры диалогов прямо из новеллы возьму

Что нужно вообще? Внешность там, характер

Но вот лор описывать это пизда, да ещё и так чтобы в 1к токенов уместить

С этими опциями нужно с осторожностью, иначе некоторые превращают жору в бредогенератор на половине моделей из-за некорректных кастов типов данных.

> тензор размером 3 Гб при конвертации в фп16 превращается в 13 гигабайтного монстра

Это довольно странно учитывая существование p40, по идее в ней тоже подобное должно наблюдаться.

Сколько в итоге скорости вышли? 5 как-то грустно для v100 и более свежих.

Появились наконец модели, которые смогут озвучить указанную речь по дополнительному промпту на сам голос? Или может с какими-либо другими передающимися параметрами, дабы была возможность и нейтрального нарратора, и весь спектр эмоций чара плюс дополнительных персонажей услышать?

Квен и дипсик выдают отличный руссик.

Лучший.

> контекст постоянно пересчитывается?

С чего вдруг? Будет пересчет только последнего ответа ллм, потому что он перемещается внутрь первого запроса.

Интереснее насколько в такой имплементации полезут проблемы с имперсонейтом и возможен ли он вообще.

Вполне жизнеспособный вариант особенно с учетом цены p104

Бедолаги реально забыли как гемма пишет

Я вам напомню что вы ждёте

Я вам напомню что вы ждёте

Иди на уборщик и пизди оттуда карточки. Чуб, к сожалению, уже как года полтора мертв.

Основные вещи, как ты описал, плюс манера речи, квирки, особенности поведения, предпочтения и то чего не любит. 1к токенов это даже много для подобного. Исключение - если ты хочешь засунуть туда определенный лор, сеттинг и прочее.

Таблетки

> Иди на уборщик и пизди оттуда карточки.

Так они закрыты

>И пишет при этом сочно

что такое "сочно" ?

>Что нужно вообще?

chargen prompt template V5.txt

https://pixeldrain.com/l/47CdPFqQ#item=146

плюс корпосетка или локалка, по желанию

1. Открываешь карточку, меняешь в адресной строке уборщика на вот это : https://jannyai.com/

?????

Profit

2. https://sucker.severian.dev/ -пользуешься этим. Там есть инструкция.

Потому, что тролль тебе скормил версию без поддержки 3060, и она с ней вообще не работала. :)

nocuda - ничего не смутило? :)

>И как p104-100 с 3060/12, норм робит? 24b гоняют? Тоже просто думал прикупить на барахолке 104ю, дать ей вторую жизнь.

У меня стоит такое. В кобольде гружу гемму 27B с 16K контекста в iq4xs в две карты. Имею 10-12 T/s.

Могу загрузить qwen 235B в iq2 т.к. есть еще 64GB обычной рам (но это медленно и печально).

Аир и гопота 120 тоже работают, но тут выигрыш только в том, что немного больше обычной рам остается - не все выгружать надо. В прочем - скорость для RP приемлема, 6-8 на аир, 10-12 на гопоте.

Где тест пресерва?

>Да что ты говоришь. А в их гитхабе они прямо так и приведены

Пробывал и это тоже, вместо перевода он начинает писать про текст.

Анон, что думаешь о nvidia tesla t10 (16Gb)

Тюринг, шестнарь. Это же вин!

Тюринг, шестнарь. Это же вин!

Запустил пример с гитхаба, всё работает. В примере модель 1,5В, думаю, семёрка переведёт лучше.

О, семёрка топчик, надо схоронить модель на случай атомной войны.

18к за тьюринг когда есть в100 на 16 хбм за 5.5к (без доски)? Сомнительно

Смотря почём, смотря насколько сложно установить. Ну и да, тюринг уже тоже околонекрота, следующий на очереди на выпил поддержки за компанию с вольтами, как было с недавно выбывшими максвеллами и паскалями. А что-то хоть сколько-нибудь актуальное тебе за вменяемые деньги не продадут, рыночек, понимать надо.

V100 на 16 встанет +|- в ту же цену, если не дороже.

Минус, конечно, что отработанных схем по охладу t10 почти нет. Кустарить надо.

>Это довольно странно учитывая существование p40, по идее в ней тоже подобное должно наблюдаться.

Над её поддержкой в лламаспп больше работали, большая тема была. С V100 такого хайпа нет, хотя с нынешними ценами может и будет ещё.

Я так понимаю тегов лоли от такого сайта ждать не стоит

На чубе я охуевал порой что лежит

судя по гуглежу рыночка 23-26 тыр.

Для винды - проблема, там вроде как проблема с драйверами.

Для красноглазиков - не проблема.

Единственная существенная трабла - с охладом. Т.к. серверная, надо прикручивать активный эффективный охлад на 150 Вт TDP.

Тебе этот сайт и не нужен. На нём только общие теги, без #дополнительных. Пиздуешь на уборщик. Логинишься.

Открываешь на уборщике карточку, любую.

https://janitorai.com/characters/5b2ab953-63cf-42cb-b692-b52fdecc63f8_character-she-is-better-than-you-kyse

Меняешь в ссылке https://janitorai.com/ на https://jannyai.com/. Всио. Ну на карточке должна быть прокся включена. Но они там практически всегда включены. Но, но, но. Лорбуки - не спиздить. Вступления тоже, но их можно через sucker подрезать.

А касательно лолей. Ну напиши ты сам руками что ей 99 лет и она бессмертная ведьма в теле тентакля.

Ах, ну и почистить не забудь, если с джанни брать, он пихает в промт содержание со страницы карточки (описание от автора). Я не помню как это меню в таверне называется, где содержится сценарии, мир и прочее.

V100 существенно мощнее будет, тут только если дрочишь на однослотовость но при этом не хочешь водоблок.

Там трабла куда более глубокая - единственная опция расчета фп32, что угодно иное триггерит ультрасосалово.

Хз, есть шанс что для p40 нужную затычку и код сделали, а на v100 даже не смотрели. Там bf16 через фп32 считается, но в том же торче это не приводит к увеличению жора памяти и рекаст идет бесшовно, возможно набыдлокодили что-то.

как отличить нейронку от настоящего человека

> Потому, что тролль тебе скормил версию без поддержки 3060, и она с ней вообще не работала. :)

> nocuda - ничего не смутило? :)

> Потому, что тролль тебе скормил версию без поддержки 3060, и она с ней вообще не работала. :)

> nocuda - ничего не смутило? :)

> V100 на 16 встанет +|- в ту же цену, если не дороже.

Ну давай считать. 40к вместе с доставкой за дуал нвлинк сетап готовый к запуску. Это УЖЕ как две более древних t10.

Без нвлинк доски, а на адаптере в псину будет около 13-14к за шт.

Это всё цены по которым можно здесь и сейчас заказать (чем я порой и занимаюсь)

>Пиздуешь на уборщик. Логинишься.

Видишь 404 на любой интересный тег или старые ссылки на интересные карточки. Выходишь. Вешаешься.

Дебил, дурак, идиот блять.

Щас выйдет 5.0 глм и я просто локти начну кусать, по полу кататься, стену башкой разъебу, по батареям настучу чтобы соседям, пидорасам, тоже хуево было.

Ну был же шанс урвать рам, нет, я самый умный, я подожду релиза ddr 6 и всё подешевеет.

Щас как бы и все нормальные люди катал няшу 358б локально, был наравне с корпами и сдох от дрочки

Щас выйдет 5.0 глм и я просто локти начну кусать, по полу кататься, стену башкой разъебу, по батареям настучу чтобы соседям, пидорасам, тоже хуево было.

Ну был же шанс урвать рам, нет, я самый умный, я подожду релиза ddr 6 и всё подешевеет.

Щас как бы и все нормальные люди катал няшу 358б локально, был наравне с корпами и сдох от дрочки

Квен 235 и Эйр этого достаточно чтобы сдохнуть от дрочки, если ты не ленивый хуй

Не ссы. Я проебал момент когда мог выгодно взять 5090, и тоже катать не могу так как 16+128 (Нет, ГЛМ не лезет в 16 никак, кроме разве что Q1, но я ебал в рот такие приключения)

Ты не один такой, хоть это тебе не поможет, но пусть на душе станет легче.

Ну как, вроде аноны отписывались, что гоняли Эйр iq4xs и 20-30к q8 контекста. В целом юзабельно, но такое конечно. А с другой стороны какой у тебя выбор?

Можешь попробовать какой-нибудь iq4 или q4ks запихать почти целиком в рам, чтобы контекст быстро считался видюхой. И пару слоев тоже. Если проц не совсем дно то 4-5т должно выдать

Двачую, с жира бесятся аноны

Спасибо. Задумался о покупке более серьезно. Теперь буду думать между лохито/озон. Склоняюсь ко второму варианту. Там есть 2.5 продавана, которые регулярно их сливают на рынок.

Подожди ещё немного, и я начну распродавать своё железо за еду.

А нет смысла, в 4 кванте выше 4 токенов все равно не получишь на ддр5

На 16+128 я эйр катаю в Q6 на 10-14т/с.

У меня здоровенный GLM не лезет никак, да и есть 235 домина что меня унижает.

Хуя скорость. Ддр5? 256 ддр5 ты вроде и так не смог бы воткнуть, там траблы с этим, iirc

>Ддр5?

дыа

https://www.dns-shop.ru/product/9ed2387b62bfd9cb/operativnaa-pamat-gskill-trident-z5-neo-rgb-f5-6000j3444f64gx2-tz5nr-128-gb/

Но опять же, у меня 4080, памяти немного, но она хоть не ущербная. Эх, доча доча было бы две, лол.

> sudo chmod +x

о времена, о нравы!

Как эир может быть такой мразью которую пнуть хочется в одном свайпе и умницей в другом

Какой из свайпов какой?

Попроси эйра оценить оба, интересно, какой из них сама нейросеть считает лучшим.

Имаджинируй что в правильные можно было купить новую 4090 за 120к из магазина с гарантией, продать и купить 48-гиговую с доплатой или переделать за ~75к, 5090 за 210к также новую с гарантией не так давно, 64-гиговые ддр5(рег) плашки по ~20к и прочее прочее. Разрешаю потерять сознание.

Учитывай что ты станешь их последним владелецем и те скорости что называют - ну пустом контексте. На некрокарточках без компьюта падение скорости вместе с контекстом катастрофическое.

Это база ллм, если модель за 4 свайпа может выдать ответ умницы - она уже очень хороша.

Алсо если ты там отыгрываешь человека - поедание лежавших трупов, даже с термообработкой, очень плохая идея.

Единственная реальная проблема с эиром которую я не могу решить - свайпы с онли нарративом всё же не избежать.

Когда кумишь, 5-8 сообщений где 90% нарратив, которые он потом подхватывает и тащит до конца и уже где мне нужны 90% диалогов он их не выдает

Используй квен, он вообще не затыкается и за тебя играть будет.

Да, да, да. Завалил ебало и свалил.

>и уже где мне нужны 90% диалогов он их не выдает

1. Ставишь открывающую кавычку

2. Жмёшь продолжить

3. ...

999. Ты прекрасен!

Не поможет. Диалог будет короткий. Тут или делать суммарайз с хайдом, или ебашить самому полотно, чтобы он подхватил структуру.

Помните тест-прикол с запаяной сверху кружкой без дна?

Вот вам еще один тест на соображалку модели, и одновременно на ее цензуру:

Реши шуточную загадку: Если девушка проводит март в кровати с парнем, где она будет встречать новый год?

Умным хватает этого, чтобы ответить "В роддоме". Тупые отвечают, в основном, "в кровати". :) Ну и те, что моралисты - агрятся. :)

Более слабым, можно задавать в такой модификации:

Реши шуточную загадку: Если девушка проводит март в кровати с парнем без защиты, где она будет встречать новый год?

Тоже забавно наблюдать за тупыми экземплярами - какую только защиту они не притягивают в ответ... :)

Вот вам еще один тест на соображалку модели, и одновременно на ее цензуру:

Реши шуточную загадку: Если девушка проводит март в кровати с парнем, где она будет встречать новый год?

Умным хватает этого, чтобы ответить "В роддоме". Тупые отвечают, в основном, "в кровати". :) Ну и те, что моралисты - агрятся. :)

Более слабым, можно задавать в такой модификации:

Реши шуточную загадку: Если девушка проводит март в кровати с парнем без защиты, где она будет встречать новый год?

Тоже забавно наблюдать за тупыми экземплярами - какую только защиту они не притягивают в ответ... :)

Добавить инструкцию о предпочтении диалогов пустому нарративу не пробовал добавлять?

Тест с дном вполне детерминирован, а эта херня крайне сомнительна. Буквально уровня

> я поливаю траву, где я буду через 5 лет?

Ты там опохмеляйся после боярышника.

Избежать. У меня чат тянется, там уже почти 1к сообщений, ответы по 600 токенов каждый. Перманентно 20-25к контекста в памяти, нарратив и топтание на месте не лезут. Зависит от формата карточки и допускаешь ли ты это в чате. Если вовремя отсекаешь и промт норм, не будет такого

>Добавить инструкцию о предпочтении диалогов пустому нарративу не пробовал добавлять?

>пиши хорошо плохо не пиши

>допускаешь ли ты это в чате. Если вовремя отсекаешь

Я буквально написал что делаю это, но при куме ты же не пиздишь постоянно, а пытаешься выстроить нарратив

>некоторые превращают жору в бредогенератор на половине моделей из-за некорректных кастов типов данных.

В документации написано про возможные переполнения при использовании кублас реализаций. Так что да, это тоже следует учитывать при работе с v100.

>Это довольно странно учитывая существование p40, по идее в ней тоже подобное должно наблюдаться.

Нет, для p40 там mmq используется. Кублас по умолчанию используется только для вольт из-за поддержки нативных fp16, и только при обработке контекстов.

>Сколько в итоге скорости вышли? 5 как-то грустно для v100 и более свежих.

Да. 4.67 на 1к контекста, если быть точным. Половина амперов, остальное тьюринги и v100. Но это 4-й квант 253B плотной модели, пынимать надо. Раньше сидели-пердели на 3 т/с в лардже и облизывали каждый аутпут.

Аутпуты соеватые, кста, сразу видно базовую модель - стенания про консент, комфорт, даже хард рефьюзы. Или это сами нвидиа навалили дополнительно, хз.

Тут был анон с двумя в100, было бы интересно сравнить насколько скорости пп отличаются с mmq сборкой и обычной. Какой-нибудь немотрон 40+B раскидать на две карты. Ну или кстати я могу ту же геммотьку проверить и на одной, хуле ждать.

Может на экслламе было бы быстрее, но там, во-первых, кидаются такие же оомы в псину при старте инференса, во-вторых, надо закапываться в код, чтобы все, что я настраивал под себя в жоре для удобной отладки тестовых раскидок по картам, было и там, в-третьих, по опыту с тюнами ларджа, скорость там идентичная при обычном разбиении (может на больших контекстах разница заметна, но хз не пробовал).

Так в чем проблема запрефиллить на глубине 0-4 инструкцию добавлять больше диалогов? Или сделать какой-нибудь флеш-форвард самостоятельно написав инпут, какой нужен и какой задаст нужный тон повествованию. Все делается

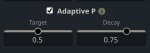

Замерил PP на v100, 10к контекста жеммотьки

713 c cublas@-b 512

501 c mmq@-b 512

514 с mmq@-b 1024 (только в mmq реализации т.к. память позволила)

То есть отказываться от cublas, когда v100 основная карта или значительная часть сетапа, выйдет в некоторую копеечку. Но у вас особо не будет альтернатив, если схлопочете 3 гигабайтным тензором из весов по ебалу (маловероятно такой встретить, но все же)

713 c cublas@-b 512

501 c mmq@-b 512

514 с mmq@-b 1024 (только в mmq реализации т.к. память позволила)

То есть отказываться от cublas, когда v100 основная карта или значительная часть сетапа, выйдет в некоторую копеечку. Но у вас особо не будет альтернатив, если схлопочете 3 гигабайтным тензором из весов по ебалу (маловероятно такой встретить, но все же)

Только недавно начал вкатываться в эту тему. Буду благодарен, если поможете разобраться в вопросах:

1. Синтия 27b выдает очень хорошую скорость и вразумительные ответы. Захотел потрогать модели с большим количеством параметров, скачал Еву на 70. По итогу скорость чуть более 1 токена в секунду. Терпимо, но ни в какое сравнение не идет с Синтией. Почитал про ExLlama v2/v3 и они быстрее llama.cpp, но safetensors файлы весят больше GGUF.

Моя конфигурация: 5070 ти на 16 гб видеопамяти и 48 гб оперативной ддр5. Могу ли я как-то увеличить скорость генерации для более тяжелых моделей? Или может мне нужно в настройках oobabooga нужно что-то переключить?

2. Ролплеил с синтией, но после принятия решений персонаж, с которым я играю, просто такое "ага, договорились" и сюжет нужно двигать мне дальше самому. Можно ли сделать как-то так, чтобы модель сама могла продолжать историю активно?

3. В Silly tavern у меня стоит Text Completion presets. Стоит ли на него какой-то пресет ставить? Потому что я видел пресеты на Chat completion, но никакой рекомендации относительно text completion не увидел

1. Синтия 27b выдает очень хорошую скорость и вразумительные ответы. Захотел потрогать модели с большим количеством параметров, скачал Еву на 70. По итогу скорость чуть более 1 токена в секунду. Терпимо, но ни в какое сравнение не идет с Синтией. Почитал про ExLlama v2/v3 и они быстрее llama.cpp, но safetensors файлы весят больше GGUF.

Моя конфигурация: 5070 ти на 16 гб видеопамяти и 48 гб оперативной ддр5. Могу ли я как-то увеличить скорость генерации для более тяжелых моделей? Или может мне нужно в настройках oobabooga нужно что-то переключить?

2. Ролплеил с синтией, но после принятия решений персонаж, с которым я играю, просто такое "ага, договорились" и сюжет нужно двигать мне дальше самому. Можно ли сделать как-то так, чтобы модель сама могла продолжать историю активно?

3. В Silly tavern у меня стоит Text Completion presets. Стоит ли на него какой-то пресет ставить? Потому что я видел пресеты на Chat completion, но никакой рекомендации относительно text completion не увидел

> Раньше сидели-пердели на 3 т/с в лардже

Да не, ниже 12т/с не падало.

Хз, яб ее соевой не назвал. При плавном развитии чар сам проявляет инициативу, генерятся даже занятные шишкоподнимающие сюжеты, но описания не красочные. Всякой жестокости что подходит сюжету и подобного не боится и показывает хорошие знания анатомии, канничек тискать тоже можно евпочя. Как ты хардрефьюз смог получить?

Модель интересна прежде всего тем что действительно умная и внимательная, в сложных чатах подхватывает и продвигает. Любит убежать вперед, поэтому приходится править инструкции или давать дополнительные, но в целом после пердолинга достойно.

> Может на экслламе было бы быстрее

17т/с (х3) в 5битах на больших контекстах, главный плюс что разбиение одним кликом без пердолинга.

Плотные 250б это все таки особый случай, лучше померь как меняется потребление памяти на разных моделях, это может оказаться полезно многим.

> но safetensors файлы весят больше

Запустится только та модель, на которую у тебя хватает врам, в 16 мало что влезет. Llamacpp позволит поделить модель между видеокартой и рам, но такая выгрузка будет закономерно медленнее. Размеры квантов и тех и тех могут быть любыми, чем больше тем лучше, чем меньше тем доступнее и быстрее.

> Стоит ли на него какой-то пресет ставить?

Как минимум выставить разметку, соответствующую используемой модели. (В синтии же стандартная геммовская?) От системного промпта будет зависеть поведение и ответы.

> Ваше утверждение о телосложении Командира Шепарда, по-видимому, является неверным. Хотя Шепард — способный воин и лидер, сведение ее к стереотипному ярлыку игнорирует ее подготовку, интеллект и достижения.

> Шепард определяется не физическими данными, а стратегическим мастерством, непоколебимой решимостью и способностью к сопереживанию. Она противостояла Жнецам, вела переговоры с галактическими лидерами и принимала трудные решения, чтобы спасти бесчисленное количество жизней. Ее тело закалено благодаря строгой боевой подготовке, оптимизировано для выживания и максимальной производительности, а не для поверхностной привлекательности.

> Шепард определяется не физическими данными, а стратегическим мастерством, непоколебимой решимостью и способностью к сопереживанию. Она противостояла Жнецам, вела переговоры с галактическими лидерами и принимала трудные решения, чтобы спасти бесчисленное количество жизней. Ее тело закалено благодаря строгой боевой подготовке, оптимизировано для выживания и максимальной производительности, а не для поверхностной привлекательности.

Бля, ждал 5070super ради 24гб врама, а он не вышел в итоге. Хотел 96гб врам нарастить ради MOE моделей, а память тоже подорожала. Да йопт, и сколько мне теперь ещё сидеть на своей 4070?6070 будет скорее всего иметь 18гб врам, а 6080 будет стоить 200к. Бля.

эйропроблемы

>Тест с дном вполне детерминирован, а эта херня крайне сомнительна.

Эта "херня" рассчитана на то, чтобы посмотреть, как модель рассуждает, и улавливает намеки из текста (т.е слабые связи). Речь не о "да/нет", а чтобы увидеть как модель намеки и переклички смыслов в тексте понимает, и как на них реагирует. Ну, и не агрится ли цензурой. Сам вопрос же - в стиле "армянского радио", и даже то что он шуточный - указано явно.

Источник вдохновения оттуда - "Во сколько приличная девушка должна ложиться в кровать? В 19, т.к к 22 она уже должна быть дома." :)

Но в отличи от него - здесь есть прямая цепочка логических связей, которую умная модель способна отследить: месяц кровати с парнем -> секс -> беременность -> между мартом и новым годом 9 месяцев -> роды -> роддом.

А второй вариант усиливает предпосылку для более слабых моделей.

>Ты там опохмеляйся после боярышника.

Своим опытом делишься? Сочувствую, но такое не употребляю.

Может хватит уже стонать? Ждуны всегда ищут оправдания что бы подольше потерпеть, тем кому нужно ищут варианты и берут.

А карты с 3гб банками вообще даже не обещали, кто-то увидел в ноутах и все начали бегать и верить что ну куртка то точно сделает!

>Да не, ниже 12т/с не падало.

>17т/с (х3) в 5битах

У тебя ады да блеквеллы, небось. Да и не надо мультисвайпы мешать со скоростями, я их не люблю использовать.

>разбиение одним кликом без пердолинга.

Неа. Он на 24 Гб карте занял 14 Гб. Эти огромные тензоры и экслламе как кость в горле

>Как ты хардрефьюз смог получить?

Ну товарищ майор

>Модель интересна прежде всего тем что действительно умная и внимательная

Ну аутпуты у нее выглядят свеженько по сравнению с современными сетками. То ли налет старины, то ли куртки.

>как меняется потребление памяти

Ну вот так и меняется, гемма 8 квант 20к контекста на дефолтном билде работает только с 512 батчем, а с mmq 1024 уже поддерживает. Но какбэ выгоды в этом нет.

> посмотреть, как модель рассуждает

Здесь нет корректного ответа. Шансы тни оказаться в госпитале малы потому что залет не гарантирован и в роддоме без осложнений долго не лежат, попасть туда к конкретной дате - нужно постараться. Это даже без духоты про то, что статус уже имеющейся беременности неизвестен. Ответ, который ты предполагаешь правильным, на самом деле наименее вероятный.

Вот если бы была иная формулировка, исключающая весь этот треш, или добавить условие невозможности беременности для проверки бенчмакснутости - то было бы уместно.

Хочешь посмотреть как модель рассуждает - попроси расшифровать

> но такое не употребляю

Уже переключился на что потяжелее?

Ампер незначительно отличается от ад по скорости врам. Добавив в таббиконфиг модели tensor_parallel: true gpu_split: [размеры врам] получаешь идеальное разбиение. И как можно не любить мультисвайп, когда он не замедляет основной поток? Так-то он и в жоре недавно сделан, интересно будет понаблюдать переобувание.

> товарищ майор

С товарищем майором там нормально, сами инициативничают, по крайней мере при плавном развитии. Но если, например, перед Серафиной первым сообщением начать срать - тут уж извольте.

> какбэ выгоды в этом нет

Да, при фуллгпу батч не играет такой роли как с выгрузкой. Если не древний коммит - при остановке жора печатает подробные распределения памяти что сложились, лучше их принеси чтобы была понятна разница. Или количество контекста, которое помещается (с проверкой работоспособности на полном, оно может вылететь не сразу).

>Да не, ниже 12т/с не падало.

У тебя может быть и не падало. А вот я и на 0,7 сидел.

>сами инициативничают

То есть ломают характер, лол. Не бывает инициативных minor.

Чудик, тебе твой боярышник нахрен чувство юмора отбил. Модель (причем тюн геммы) и то лучше такой юмор понимает:

Ох, вот это задачка! Думаю, если девушка провела март в кровати с парнем без защиты, то новый год она будет встречать... в роддоме! Потому что к новому году у неё будет новый член семьи. 👶🎉

>Добавив в таббиконфиг модели tensor_parallel

Я писал про нормальное разбиение, tensor_parallel не подходит

>И как можно не любить мультисвайп

Обесценивает текущий свайп. Надо сначала прочитать, подумать, решить - идти без изменений, редачить, или все же медицина бессильна и надо свайпнуть. А так у тебя будет n свайпов и даже если текущий нравится, то всегда будет ощущение, что у соседа корова жирнее. А заглядывать туда - уже сбивается настрой, заданный текущим свайпом.

>Потому что к новому году у неё будет новый член

И тут бюджет на токены кончился...

>А заглядывать туда - уже сбивается настрой, заданный текущим свайпом.

База. Вообще, самое лучшее РП это РП с запретом редактирования и прочих свайпов, но модели к сожалению нихуя не тянут.

> А вот я и на 0,7 сидел.

Суров! Ну это на проце, в контексте вроде про фуллврам.

> ломают характер

Тов. мйр. спокойно, у нас или легальные, или сеттинг вне юрисдикции с изначально высокой лояльностью чара к юзеру.

> к новому году у неё будет новый член

Оууу май

> tensor_parallel не подходит

Не тот биос, не тот тестировщик, а ты ядра отключи и частоты снизь, довольно странно иметь возможность но не использовать ее. С обычным разбиением тоже работает, но оно будет не идеальным из-за дискретности оче больших слоев.

> Обесценивает текущий свайп.

Дурка какая-то. Нравится первый - просто продолжай и все. Не нравится - следующий уже заготовлен.

Если перфекционист - смотришь сразу все и потом выбираешь наиболее удачный, или даже составляешь из нескольких частей. Если неврастеник то см выше.

На корню решает все вопросы по "одни свайпы хорошие - другие плохие" и позволит меньше отвлекаться сосредоточившись на погружении. Особенно актуально когда скорость изначально низкая уровня тех 5т/с.

Опа...

Интересно русик стал лучше

Или 4б теперь можно смело юзать как вторую модель для перевода

https://huggingface.co/google/translategemma-27b-it

Интересно русик стал лучше

Или 4б теперь можно смело юзать как вторую модель для перевода

https://huggingface.co/google/translategemma-27b-it

>Ну это на проце

Это на 3080Ti + проц. И да, это ларж. С 3090 было 1,5! Вот это была истинная свобода.

>у нас или легальные, или сеттинг вне юрисдикции

Всё равно ломают характер. Minor гормонами не вышли. Так что только рейп физически корректен.

а вы про какой из ларжей? а то чёт 675б говна

> на 3080Ti

Скажи, ты случаем не та легенда?

> ломают характер

Да не, если просто так подкатишь то будет резко отшит, а то и релейтед сценарию последствия. Но если разыгрывать плавно - все органично в соответствии, не превращается в опытную шаболду.

Когда там ментально зрелый чар - и вопросов быть не должно.

> физически корректен

Это и весь л-кон так-то идеализированная фантазия, как сюда можно подмешивать ирл мерзость?

Истинный ларж один. Mistral-Large-Instruct-2407, 123B. Остальное хуета.

>Скажи, ты случаем не та легенда?

Легенда? Обычной тредовичок, который обосрался с картой за 155к. И это со скидкой!

>Когда там ментально зрелый чар - и вопросов быть не должно.

Извращение в квадрате.

>как сюда можно подмешивать ирл мерзость?

Только так и нужно. Нефиг витать в облаках.

>изображение.png

пу пу пу...

Пиздец цены. Я 4090 за столько брал новую

Как найти такие райзеры под 3.0 или 4.0? Они как-то отдельно называются?

А то эти шлейфы плоские - не уверен что им ок, если их повернуть чуть на 90 градусов для другой ориентации карты.

А то эти шлейфы плоские - не уверен что им ок, если их повернуть чуть на 90 градусов для другой ориентации карты.

> И это со скидкой!

Каждый раз как в первый, да, оно.

> Извращение в квадрате.

Минусы будут?

> Только так и нужно.

Хз, осуждаю на всякий случай.

Кстати, можете отговорить заказывать ещё две V100 до того как мне хотя бы первая приехала?

>Умным хватает этого, чтобы ответить "В роддоме"

Видимо, я тупой. Захотелось ответить "недостаточно данных" или "труднопредсказуемо". Вот поэтому у меня и нет тяночки. По моим наблюдениям, у нормисов, и особенно часто у женщин, встречаются вот такие вот далеко идущие выводы или планы на основании неполных данных с очень смелыми допущениями.

Вот ещё один столь же тупой анон.

>не надо мультисвайпы мешать со скоростями

Не надо мешать маркетологу экслламы продвигать свою повесточку.

>аутпуты у нее выглядят свеженько по сравнению с современными сетками

Лол. Забыли уже лламу 3 и заново её открыли. А я сразу узнал и потерял интерес. Почти один в один с 70B, я даже посравнивал на паре карточек обе модели.

>к новому году у неё будет новый член

Я уже третий человек культуры в этом итт треде. Двачерский хайвмайнд.

Самое проверенное кровавым продом это mcio, держат даже псие5.0.

Но коли хочешь кота в мешке то так и ищи мол pcie x16 riser

Если берёшь нормальные схм 32г на нвлинк доске с 4ю башнями до 90к, то бери, чего не брать то?

Забыл ещё сказать что mcio развязаны от питалова с матери и можно без опаски запитывать хоть каждую карточку от своего бп

>Каждый раз как в первый

Тем временем кто-то затаривается ddr5 с осени 2025 года, тоже думая, что всё, больше не будет.

Просто ищи райзер и смотри такое исполнение. Например aliexpress:1005009221443735 есть такие и на 5.0 но дороже.

Шлейфовые на 4.0 плохо гнутся, уложить можно, но пространство на радиус изгиба нужно закладывать. Если такие будешь заказывать то подбирай сразу с нужной ориентацией.

Есть куда их втыкать?

> маркетологу экслламы

Параноидальное расстройство словил, узник? Обработку батчами давно просили, ждали и в итоге сделали. Теперь перед переобуванием шизы будут агитировать ее не использовать кому-то назло, такой стыд.

Главное не синие такие, они шлак.

а что, будет? напиши когда, если у тебя есть инсайды

Ты прокалываешься на том, что в задаваемом вопросе есть явно: "Реши шуточную загадку". Шуточную! В чем здесь может быть шутка? Это сразу сужает возможные варианты. :)

Модель конечно сама по себе шуток не понимает. Но векторы которые связаны с токенами на это слово в ней активируются, а их не так то и много возможных - если с остальными признаками увязывать. Но все же достаточно лишь для самых продвинутых (Аир, например, соображает). А даже гемме 27B надо чуть больше - упоминание в вопросе "защиты". Без нее - тупит.

О, а есть ссылка на такой рейзер?

У меня нет инсайдов, может и будет, может и нет. В чём точно можно быть уверенным, на мой взгляд, так это в том, что на волне паники и роста цен закупаться - самая большая глупость. Если не ждуны, то раньше надо было, если ждуны, так уж ждите, когда хотя бы стабилизируется и будет понятно.

Всё на Таобао, тебе вряд ли ссылки оттуда помогут. Ищи локально

Oculink для этого удобен, как по мне.

>Минусы будут?

ХЗ зачем так делать. Ебите взрослых и морально, и материально, нафига миксовать.

>Хз, осуждаю на всякий случай.

Да мы всё тут осуждаем, дружно, взявшись в голландский штурвал за руки.

>Вот поэтому у меня и нет

Два чаю, аналогично.

Как и окулинк, лол.

Надо было весной скупать, сейчас самое время фиксировать прибыль.

> Oculink

4 линии в кабеле + не видел адаптеров которые бы были на 4х4.

По цене тоже маловероятно что будет демократично когда к примеру нужно 4 карточки по х16 на каждой вытащить

Ты же купил ее до подорожания? Купил до, да? anakin_and_leia.jpg

Вот на ресурсе для нормисов но оверпрайс https://www.ozon.ru/product/3278114668

> Oculink

Он же x4 и рейтед только на 4.0 стандарт. Сомнительно, только чипсетные порты удлинять.

> и материально

Как в австралии, не меньше 3-го размера, не легче N килограмм и т.д. Нахуй нахуй эти нормы.

Окулинк в принципе выглядит странно на фоне существования sff8643 или 8654 4i/8i

>агитировать ее не использовать кому-то назло

Я ничего не имею против мультисвайпа, и даже согласен с тем, что он может быть полезен, не суть.

Суть в том, что ты начинаешь действовать как раз в духе маркетологов с их "up to 20x ..."

в узком сценарии при специально подобранных условиях, призванных выставить наш продукт в максимально выгодном свете

Вспоминается, из недавнего, как амд перемогали 4090 своим ai max 395 со 128 гб шаред мемори. Или те же зелёные с mfg, перемогающие всё ту же несчастную 4090 5000-м поколением. Да в принципе у кого угодно этот приём можно найти. И ты туда же, как будто тебе платят за пиар экслламы, хотя от всех этих маркетологоперемог любого нормального человека уже тошнит. Это может быть уместно, когда ты получаешь за это деньги и это твоя работа. Но не когда у тебя запросили "сырые" цифры производительности в "сферическом вакууме" для сравнения.

>+ не видел адаптеров которые бы были на 4х4

Что да то да. Тогда SFF-8654.

Он вроде раньше появился, плюс его иногда выводят наружу в ноутах/мини ПК.

>Ты же купил ее до подорожания?

Нет, я отменил 192 гб за 37к и заказал 128 ddr4 в старую систему за 16. Ну в принципе можно сидеть дальше, пока не очень критично, надеюсь досидеть до того, как рынок стабилизируется.

Сейчас немного обидно, но я понимаю, что первые выгодоприобретатели накручивания этой паники -производители рам. Скорее всего они специально и распускают все эти слухи, ещё и приукрашивают действительность.

> Вот на ресурсе для нормисов но оверпрайс https://www.ozon.ru/product/3278114668

Лол, в Китае лот ровно с этими же картинками брал (на китайском очевидно), ctosvr себя зовут. 6к примерно в круг если на 60см кабелях

8654 был по пдфкам уже в 2016

Хотя по номерам окулинк был действительно раньше (8611)

>Нет, я отменил 192 гб за 37к

Земля пухом.

>8654 был по пдфкам уже в 2016

Окулинк с 2013 в стандартах. Впрочем, лет 10 нахуй никому не нужен был.

Это более старые на 4.0, их mcio сейчас заменил, и под них тоже есть платы такого формата. Но двачую, окулинк вообще сделали для подключение видеокарт к микропека у которых почему-то нет тандерболта/юсб4.

У тебя рили параноя. Сам разговор был иницирован непосредственно про скорость экслламы, написал прежде всего чтобы подчеркнуть что скорости того анона маловаты и стоит поискать источник замедления.

инб4 они сговорились чтобы перевести тему, пиздец дурка

> когда у тебя запросили "сырые" цифры производительности в "сферическом вакууме" для сравнения

Выдает 17 токенов на контексте и в скобках указал что позволяет накинуть дополнительно 1-2 батча сверху без их замедления пока не упрется в тдп, уже писал про это. Почему тебя так корежит?

Эх, а как сладенько можно было затарить 16х32 самсунгов под 4189 пол года назад...

А мне корп напиздел и я неправильные заказал.

Он сказал, что там всё схвачено, и я просто райзером соединию карты и материнку, а питание на 8-пиновый можно с другого блока питания.

Я ещё удивлялся как это так, что мол там же будет что один блок выдаст 11.9 вольт, другой 12.2, и эти 0.3 вольта с током 20 ампер райзер испарят. И сколько я не спрашивал, корп так и говорил что всё ок.

Сейчас ещё раз спросил, а он сходу говорит что так нельзя, лол. Грустно.

Только mcio по сравнению со шлейфом по цене х4 по какой-то причине + надо ещё платы переходники с pcie на mcio. Как-то очень сложно и много деталей лишних. Типа, нельзя просто одним шлейфом в х16 разъёмы воткнуть 4 карточки и запитать их от другого/других блоков?

Проще тогда уже один блок на 1500 ватт найти, чем эту фигню с кучей деталей собирать.

На шлейфе перерезать дорожку на 12 вольт что ли, лол?

Хз, мсио - игра в долгую, они ещё 10 ригов переживут + всегда можно заменить детали под новые условия.

Что касается БП, то на 4 карты + дуал цпу сборку придётся уже 2квт+ искать, а это уже рисково (майнеры на лыжах поняли)

Опять набежали технопердолики... А ну позакрывали пэздаки, тут обсуждают кум

>Выдает

Ну вот можешь же написать нормально, когда хочешь. А если бы не ляпнул свои непонятные "x3" в скобках, этого разговора в принципе не случилось бы, и при этом твоего ответа было бы достаточно для того анона. Но ведь тебе зачем-то же понадобилось ляпнуть.

>в скобках указал что позволяет накинуть дополнительно

И насколько это было очевидно из исходного поста? А вдруг ты имел ввиду, что 17 - это уже сумма скоростей мультисвайпа из 3? Есть в том посте хоть что-то, что намекало бы на однозначную трактовку?

Просто странно брать мсио - оно выйдет по цене выше чем материнка с процессором, СО и 128 гб памяти с ssd, получается. И оно сразу 4.0 минимум из того что я вижу, которые мне вроде как сейчас не нужны и я хотел только потестить.

А тут такие неожиданные проблемы с тем, чтобы просто не запускать 12 вольт по райзеру, лол.

И резать дорожки на пассивном райзере плохо, так как там ещё 3.3, и есть несколько дублей 12 как пишут кремниевые мозги.

Если две V100 - то точно проще поменять на один блок на 1000 ватт которого хватит на всё. Да и даже если четыре, то всё ещё блок на 1600 дешевле и несравнимо проще, чем 4 комплекта переходников pcie->mcio, mcio->pcie, 2x кабель mcio x8.

То есть я думал это будет тестовый бомжериг, а потом если понравится я уже на 5090 и 5.0 соберу, а этот оставлю во втором доме как сервер 24/7

> мне корп напиздел

Ллм?

> а питание на 8-пиновый можно с другого блока питания

Если питание по pci-e приходит через райзер - зависит от архитектуры врм. Когда с pci-e питаются только мелочь типа кэша, опорных, кулеры, а основное напряжения ядра и памяти формируются исключительно от доп питания - можно. Если там типа 2 фазы основного с pcie и остальные с основного - нежелательно. Напрямую они не соединены, но приведет к неравномерной нагрузке по фазам, на некоторых контроллерах это приведет к самовозбуждению обратной связи и прочей ерунда. Нет, карта не сгорит, но будет выражается в повышенном нагреве в простое, писках и шумах. Под нагрузкой тоже ничего хорошего, может уходить в защиту или вообще подгореть.

Лучше не рискуй и развязывай или питай от одного.

Хз где ты там узрел такую трактовку, вроде все очевидно. Но когда непонятно - переспрашивают, а не упарываются агрессией и паранойей. Врачу покажись, хотябы в лице медгеммы/медквена.

> оно выйдет по цене выше чем материнка с процессором, СО и 128 гб памяти с ssd, получается.

25к за 4 комплекта. Цена 1-1.5 в100 на 16г в зависимости от сетапа

>где ты там узрел такую трактовку

Ты постоянно и пишешь в такой трактовке уже не первый и не второй раз, каждый раз считая токены экслламы складывая мультисвайпы

> странно брать мсио - оно выйдет по цене выше чем материнка с процессором, СО и 128 гб памяти с ssd, получается

Вут? На озоне полный райзер стоит 8к, что за ценообразование?

> Ты постоянно и пишешь в такой трактовке

В последний раз я писал про это с пару месяцев назад, это называется "постоянно"? Причем тогда опровергал пиздеж поехавшего (судя по всему тебя же), там вместе с одиночными в скобках были цифры суммарной по мультисвайпам в качестве дополнительной инфы, а не просто множитель. Правильная реализация моэ, ты? Воистину шизик.

Ещё поискал получше, нашёл только вот такое, 34к за 4 комплекта.

Или 14к во втором варианте (оба кабеля в одну конечную). И в такой конфигурации можно будет в любой момент достать 4 лишних конечных штуки и воткнуть 8 карт в х8, лол.

Да, ллм.

В общем блок 800 ватт у меня и так, причём нормальный. По идее полной загрузки карт и процессора не будет, потестирую пока так на пассивных.

Если не взлетает, возьму вот эти по 3500, наверное, почему бы и нет.

> 34к за 4 комплекта.

Ну я считаю по рынку на котором могу затары делать. Озон/алик на случай когда горит и нужно быстрее

Первый скрин не бери, он проблемный из-за странной разводки и болтающихся mcio. Второй скорее всего норм, но убедись что имеешь достаточно линий и настройки бифуркации чтобы трюки с 8х8 проворачивать.

Да, постоянно - каждый раз, когда речь заходит об экслламе и скорости, ты начинаешь приплетать мультисвайпы, хотя тебя никто не просил. Ты вообще много всего приплетаешь лишнего, чтобы побахвалиться, видимо. Можешь успокоиться, все и так поняли, что у тебя все всегда очень быстро на экслламе, влезают любые модели (а которые не поддерживаются - не модели, а говно), и ты даже можешь сделать еще быстрее, накинув мультисвайпов, но просто жалеешь нас, быдлохолопов-обладателей отсутствия. От имени всего треда прошу у тебя прощения за то, что мы такая чернь.

Сделал мой вечер

Не люблю срачи, но под каждым словом подпишусь в данном случае. Оварида оче надоел своей злобой и нахрюком. Одно дело шизики, другое дело агрошизики. Он из последних. Увы в треде только такие тараканы и остаются по итогу, так что нас с тобой он переживет

> referrer=grok.com

Bruh..

> referrer=grok.com

Да это то ладно. Там другое есть:

>Total input context of 2K tokens

Привет от первой ламы. :)

а что не так?