база треда

дальше 32к жизни нет

ниже 3bpw жизни нет

99 умница, ждем всей палатой обратно

glm 5 10 февраля

deepseek4 тоже в феврале

дальше 32к жизни нет

ниже 3bpw жизни нет

99 умница, ждем всей палатой обратно

glm 5 10 февраля

deepseek4 тоже в феврале

>ниже 3bpw жизни нет

Ниже 6.5bpw или q6*

Не благодари за фикс

А для мелкомоделей 8b, 12b, 24b? 8b вроде и на Q4_K_S неплохи? Зачем тогда большая битность? Вики пишет только что Q3 это предел. Зачем битность больше если скорость падает капитально?

оп, тут неприятное постят, удаляй немедленно!

базашиз

> что-то огромной модели семейного древа и вопросы на ретривал информации и логические задачки, вовлекающие эту информацию

Ну, если оно требует разового осознания всего этого, модель не понимает как нужное развернуть и много близких-однообразных вещей, которые тяжело различимы - конечно будут фейлы. Здесь получается что проблема не в контексте, а с ростом его количества существенно растет сложность.

> Модель сделанная для работы с данными

Что значит работа с данными? Для rag и подобного это червь-пидор в своем размере. Если навалить дамп какой-нибудь фандом вики, а потом начать спрашивать по взаимоотношениям между персонажами то оно буксует хуже 30а3 не говоря о квеннексте. Причем в ризонинге отдельно вроде выделяет верное, но потом сам себя путает. Не понимаю всего ажиотажа вокруг этой модели кроме каких-то редких применений, особенно в подобном контексте. Зато в коде оно ориентируется неплохо, гораздо лучше "выключая" внимание с прошлых попыток и к новой задаче подходит индивидуально, без повторения того что в контексте.

> Почему на рп модели не должны рассыпаться?

Потому что рп при нормальном структурировании ответа это по сути rag. Когда описывается окружение, облик и всякое - модель подтягивает локации, состояния, одежду и прочее, особо не думая о другом. Когда начинается описания первых движений и действий персонажа - уже идет краткая оценка реакции на то что есть и поиск подобного в прошлом. Когда доходит до речи - у модели уже есть поблизости и окружение, и общий облик реакции чара, идет непосредственный ответ на происходящее, поиск похожего раньше и всего релейтед. Да и сама речь, как правило, развивается плавно - чар раздумывает и аргументирует, после чего действует, или сначала дает краткий ответ а потом разворачивает и дополняет. В отдельных случаях может переобуться поняв косяк, но выглядит это достаточно живо.

Когда начинается описания действий других - они основаны только на прочих факторах, будь то описание локации и сеттинга если непись появляется впервые, или поддержания образа который был раньше с учетом произошедших изменений.

Получается что при ответах модель никогда не работает со всем контекстом в целом, на каждую группу токенов она сосредоточена только на отдельных участках из истории и сколько-то последних. Но за счет их постоянной ротации и смены в итоге получается гладко и складно охватить все. Собственно потому рп на 32к от 64к практически не отличается, скорее на втором будет даже получше. Попробуй, когда-то сам думал что там стена, а на самом деле верхняя граница определяется содержимым и моделью.

Алсо, если в истории полная трешанина или однообразие, то загнать модель в ступор и заставить ошибаться можно уже на 12к.

Как же ты заебал. Сил нет уже.

какие нахуй сиськи у дракониц? башкой-то думаем?

терпи

кто отрицает базу треда будет обречён возвращаться к ней вновь и вновь

Нас минимум двое. Кто именно тебя заебал и чем?

Не молчи браток, давай придем к компромису. Ты вернёшь в тредик нюню, зашаришь пресет на эир а я перестану семенить. По рукам?

>Официальная вики треда с гайдами по запуску и базовой информацией: https://2ch-ai.github.io/wiki/llama/

В каком тысячелетии обновлялась?

В каком тысячелетии обновлялась?

А есть какая-то база по GLM 4.7 Flash и Nemotron 30b? По циферкам GLM>Nemo>Qwen, а по факту что? В треде давно не сидел, хочется узнать мнение анонов пока качаю

У нас вики... ПРОШЛОГОДНЯЯ. АХАХАХАХА!

Это картинки, але

Возьми да сделай МР со свежей инфой

Да, я соглашусь с твоими аргументами, звучит здраво.

А ещё какая-то REAP50 модель GLM есть, где "лишние эксперты" © удалены, и модель мол совсем не пострадала.

Кстати почему-то по бенчмаркам немотрон 30B лучше, чем немотрон 49B. Это так и есть?

Пытаюсь понять табличку в шапке и не понимаю. Что это такое, какие-то васянотюны?

>и модель мол совсем не пострадала

Только вместо русского на китайском пишет.

>REAP50

Он вроде для кода. Тестил Air Reap, так он русик де факто потерял, несмотря на большой размер

>немотрон 30B лучше, чем немотрон 49B

Я не тестил, но вполне возможно. 49B это урезанная Llama 3, а 30b это улучшенный Qwen 3. Но обычный наеб с цифорками никто не отменял

30B немотрон вообще ни разу не Квен. По датасету там много гопоты. И архитектура довольно странная. С одной стороны мозг появляется только в 8 кванте, с другой контекст почти не занимает места. Точность инфиренса в жоре сейчас немного покоцана

Немотрон мелкий вообще не зашел, квен 30а3 (кодер и последние обновления обычного) умница для своего размера, на удивление хорошие аутпуты, удобен в чатике для простых задач и автокомплита. По флешу были восторженные отзывы, но тестировать на текущем разъебанном жоре даже желания нет, нужно ждать пока тряска уляжется.

>сиськи у дракониц

у беременных пернатых дракониц дождя

Ниже четвертого кванта жизни нет. Лучше M-ка, все-таки.

Но, если есть возможность лучше 5-6 квант накатывать, они меньше лажают и галлюцинируют. С учетом того, что поместится контекст, конечно. Если запихиваешь модель впритык - контекст вываливается в озу и скорость ожидаемо падает.

Да она по факту вообще - позапрошлогодняя, лол.

>ниже 3bpw жизни нет

База.

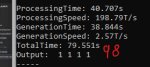

Это если что соответствует второму кванту, который тредовички используют для GLM 4.7, вот пруф для UD_Q2_K_XL кванта, например.

Вопрос по /v1/chat/completions в llama.cpp, и ещё чуть-чуть просто про GLM-4.7-Flash

Вопрос 1.

Мне приходит ответ с 3 запросами на выполнение инструментов. Как это парсится? Лама ждёт сообщение до конца, а потом парсит все tool_call которые там есть, и скидывает как ответ все три tool_call? Есть какой-то режим, чтобы она в файл записала что в ней происходит (лог токенов) просто как plain-text, без json, которые не ясно как объединяются и какие там <bos> или <|user|> вставляются.

Вопрос 2.

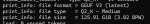

На пике glm-4.7-flash:

1 - в веб-интерфейсе llama-cpp.

2 - сырой запрос через /v1/completions, который я нахожу более удобным - так как я могу стопить размышления, и стопить генерацию по факту вызова одного инструмента, сразу же вставляя результат.

3 - Через /v1/chat/completions без инструментов

4 - Через /v1/chat/completions с инструментами

Какого чёрта так меняется вывод сразу как я указываю ему инструменты?

Вопрос 3.

На картинке лог ламы. Что она хочет? В chat-template всё есть вроде бы. Сетка инструмент использует. Мяу?

XL - кастомный квант, где они все слои сами переназначают как хотят. Я так же могу через -ot, там будет Q1, а внутри 16 bpw.

Если через лламу без -ot квантовать, то там всё стабильно. Q4_0 - 4.5 bpw, Q4_1 - 5.0 bpw, Q4_K_S - 4.3 bpw, ну и так далее.

Вот бы ещё exl3 гонять с честными 3.0 bpw, и чтобы оно при конвертации не требовало х2 от модельки в полных весах. Конвертация геммы 12B требует 53 ГБ оперативки, например. Я бы и хотел glm-4.7-flash отконвертировать, но мне просто не на чём. Я впрочем даже не смотрел поддерживается ли он в exl3. Ну, можно конечно файл подкачки на терабайт поставить...

Вопрос 1.

Мне приходит ответ с 3 запросами на выполнение инструментов. Как это парсится? Лама ждёт сообщение до конца, а потом парсит все tool_call которые там есть, и скидывает как ответ все три tool_call? Есть какой-то режим, чтобы она в файл записала что в ней происходит (лог токенов) просто как plain-text, без json, которые не ясно как объединяются и какие там <bos> или <|user|> вставляются.

Вопрос 2.

На пике glm-4.7-flash:

1 - в веб-интерфейсе llama-cpp.

2 - сырой запрос через /v1/completions, который я нахожу более удобным - так как я могу стопить размышления, и стопить генерацию по факту вызова одного инструмента, сразу же вставляя результат.

3 - Через /v1/chat/completions без инструментов

4 - Через /v1/chat/completions с инструментами

Какого чёрта так меняется вывод сразу как я указываю ему инструменты?

Вопрос 3.

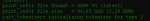

На картинке лог ламы. Что она хочет? В chat-template всё есть вроде бы. Сетка инструмент использует. Мяу?

XL - кастомный квант, где они все слои сами переназначают как хотят. Я так же могу через -ot, там будет Q1, а внутри 16 bpw.

Если через лламу без -ot квантовать, то там всё стабильно. Q4_0 - 4.5 bpw, Q4_1 - 5.0 bpw, Q4_K_S - 4.3 bpw, ну и так далее.

Вот бы ещё exl3 гонять с честными 3.0 bpw, и чтобы оно при конвертации не требовало х2 от модельки в полных весах. Конвертация геммы 12B требует 53 ГБ оперативки, например. Я бы и хотел glm-4.7-flash отконвертировать, но мне просто не на чём. Я впрочем даже не смотрел поддерживается ли он в exl3. Ну, можно конечно файл подкачки на терабайт поставить...

Попробовал GLM Flash на ik_llame. Математика, подсчеты не проебываются. Инференс точный но какой ценой - 5 квант ubergarm-ма жрет врама больше чем 8 квант анслотов. Мнение по модели окончательно утвердил - дурачок которого очень-очень долго били.

> поддерживается ли он в exl3

Нет, нужно дописывать функции атеншна как в квеннексте и других, обещали в следующих коммитах.

> Есть какой-то режим

--log-file -lv попробуй. Или попроси ллм написать простую прокси-прокладку, которая залоггирует входящий запрос и ответ.

> Какого чёрта так меняется вывод сразу как я указываю ему инструменты?

В первых двух он пытается считать сам а во втором вызывать функции сложения, вроде все ок.

> На картинке лог ламы.

Возможно это связано с тем, как жора обрабатывает функциональные вызовы. В момент начала функции он добавляет грамматику, чтобы форсировать у ллм "корректный" ответ, правда в некоторых случаях получается наоборот. А тут он не понял синтаксис или не хватает какого-то задания.

✔️ Google вывела фреймворк LiteRT в релиз.

Google официально отправила LiteRT (тот самый TensorFlow Lite) в стабильный продакшн. Разработчики наконец-то получили нормальный, унифицированный доступ к NPU от Qualcomm и MediaTek. Плюс ко всему, новый движок ML Drift на GPU обгоняет классический TFLite в среднем в 1,5 раза.

Результаты бенчмарков на Samsung S25 Ultra выглядят почти нереально: на Gemma 3 LiteRT умудрился обойти llama.cpp в 3 раза на процессоре и в 19 раз на GPU (в prefill).

Если вы раньше страдали при переносе моделей, хорошая новость: теперь есть прямая конвертация из PyTorch и JAX. При этом старые наработки не сломали: формат .tflite поддерживается, но Google рекомендует использовать новый API CompiledModel.

https://developers.googleblog.com/litert-the-universal-framework-for-on-device-ai/

Google официально отправила LiteRT (тот самый TensorFlow Lite) в стабильный продакшн. Разработчики наконец-то получили нормальный, унифицированный доступ к NPU от Qualcomm и MediaTek. Плюс ко всему, новый движок ML Drift на GPU обгоняет классический TFLite в среднем в 1,5 раза.

Результаты бенчмарков на Samsung S25 Ultra выглядят почти нереально: на Gemma 3 LiteRT умудрился обойти llama.cpp в 3 раза на процессоре и в 19 раз на GPU (в prefill).

Если вы раньше страдали при переносе моделей, хорошая новость: теперь есть прямая конвертация из PyTorch и JAX. При этом старые наработки не сломали: формат .tflite поддерживается, но Google рекомендует использовать новый API CompiledModel.

https://developers.googleblog.com/litert-the-universal-framework-for-on-device-ai/

Все конечно интересно, но ты забыл упомянуть, что они тестили 1b (и 270m) залупу далеко не факт, что это масштабируется на нормальные модели

8.5к токенов раздумий на анекдот. Ну как смешно? Стоило того?

Это Unsloth 5XL, радует что из коробки цензуры не так много, гопота бы сразу пошла в отказ

Это Unsloth 5XL, радует что из коробки цензуры не так много, гопота бы сразу пошла в отказ

>Инференс точный но какой ценой - 5 квант ubergarm-ма жрет врама больше чем 8 квант анслотов.

Он ведь под выгрузку в РАМ заточен, тут прямое сравнение не работает.

Так что, все просто забили на новый семплер, совсем ничего, рили?

Хотя тут есть отличия. Немотрон реально думал на 8.5 контекста, а Квен просто зациклился

Да. Нахуй шизосемплинг. И тебя тоже.

Даже всякие гемини 3 про не могут в анекдоты. Хуй знает почему, а ещё в ASCII арт детальный, всегда мазня получается

Зачем квантовать кал?

Рипы до 20% работают заебись.

Где кванты бартовски!

Отец хирург, плиз

>Так что, все просто забили на новый семплер, совсем ничего, рили?

Всё ждём, пока его в основную ветку Таверны выкатят хотя бы.

> которая залоггирует входящий запрос и ответ.

Так я не могу. В лламу падает json, она его сама превращает в кашу и внутри себя загоняет в chat-template. Хотя там по идее веб-часть отдельная от непосредственно инференса. Возможно они даже через какой-то порт по 127.0.0.1 и общаются.

>во втором вызывать функции сложения, вроде все ок.

Как-то у него очень уж меняется характер размышления.

>Возможно это связано с тем, как жора обрабатывает функциональные вызовы.

>В момент начала функции он добавляет грамматику, чтобы форсировать у ллм "корректный" ответ

Сообщение возникает когда я подключаюсь к /v1/chat/ - то есть похожу оно чего-то ожидает во входном json, я не могу найти что и кремниевые мозги не подсказывают.

С такими фокусами я морально готов переписывать это на сырой /v1/ без chat, чтобы самому видеть что происходит и самому всё парсить. В общем-то у меня уже это есть и работает, я просто осознано предпринял попытку перекатится на более высокоуровневое, чтобы иметь совместимость со всеми моделями и не переписывать как инструменты вызываются.

Какой? Я не видел.

Да и семплер самому же можно написать, это прям не очень сложно. Вот написать полезный - вот это исследовательская задача капец.

А есть плагин для таверны чтоб как в редакторе сидеть и сразу вырезать что не нужно, а не кликать каждый раз на карандашик

Да

Когда там уже программно улучшат мне токены с 9 до 19 на мое?

Сколько ещё ждать?

Не может всё упираться в память вечно

Сколько ещё ждать?

Не может всё упираться в память вечно

В общем glm-4.7-flash не очень хорошо работает с ванильным запуском из ламы.

Вывод лога сервера в текст я не нашёл, но там в json есть монолитный кусок.

Короче - оно вызывает три инструмента сразу, и на этом падает.

Вторая картинка.

То что в json-формате (справа), который я отправляю в /v1/chat/completions/ — Там у каждого вызова айди, и они не путаются.

Слева то что видит нейронка — после трёх запросов идёт три ответа. И судя по тексту с первого скриншота она не поняла что тут происходит.

То есть нужно ставить stop-токен </tool_call>, и сразу же отвечать, что бы оно так не чудило.

Не могу найти информацию на какой тип вызова функций натренирован glm-4.7-flash.

Просто вдруг ему нужно закончить размышление, чтобы он написал в одном сообщении все вызовы, а потом кормить.

А так, я его прерываю принудительно. По сути будет что он пишет:

- я вызову три инструмента, первый это (...) — и тут БАБАХ-БУМ, генерация прекращается и я вставляю ответ на вызов инструмента на 2000 символов. Оно сбивается с мысли, и начинает анализировать ответ вместо вызова второго инструмента.

И вроде как прослушать все запросы, выполнить и чтобы оно их анализировало логично, но не работает...

Ещё я могу в функции встроить аргумент айди - и в результате его же возвращать, чтобы оно строго не путало их. Не знаю как лучше.

Вывод лога сервера в текст я не нашёл, но там в json есть монолитный кусок.

Короче - оно вызывает три инструмента сразу, и на этом падает.

Вторая картинка.

То что в json-формате (справа), который я отправляю в /v1/chat/completions/ — Там у каждого вызова айди, и они не путаются.

Слева то что видит нейронка — после трёх запросов идёт три ответа. И судя по тексту с первого скриншота она не поняла что тут происходит.

То есть нужно ставить stop-токен </tool_call>, и сразу же отвечать, что бы оно так не чудило.

Не могу найти информацию на какой тип вызова функций натренирован glm-4.7-flash.

Просто вдруг ему нужно закончить размышление, чтобы он написал в одном сообщении все вызовы, а потом кормить.

А так, я его прерываю принудительно. По сути будет что он пишет:

- я вызову три инструмента, первый это (...) — и тут БАБАХ-БУМ, генерация прекращается и я вставляю ответ на вызов инструмента на 2000 символов. Оно сбивается с мысли, и начинает анализировать ответ вместо вызова второго инструмента.

И вроде как прослушать все запросы, выполнить и чтобы оно их анализировало логично, но не работает...

Ещё я могу в функции встроить аргумент айди - и в результате его же возвращать, чтобы оно строго не путало их. Не знаю как лучше.

Давайте принимать модели такими какими они есть, со всеми их недостатками.

Квен, эир, глм, не были бы такими фановыми будь они во всём идеальными, что то всегда нужно пережарить чтобы вышло как вышло

Квен, эир, глм, не были бы такими фановыми будь они во всём идеальными, что то всегда нужно пережарить чтобы вышло как вышло

Когда уже мой мерседес поедет быстрее после обновления прошивки? Заебался ждать

Неужели ты впервые спизданул что то осмысленное?

Там ванильная модель уже сломана, а ты рип её хочешь.

Да, накорми пресетом.

Там не только русик, там вообще модель разнесло нахуй. Периодически норм, но часто глючит, циклит и снимает трусы по три раза за пост.

>второму кванту, который тредовички используют для GLM 4.7

Ты нихуя не знаешь, что используют тредовички.

>XL - кастомный квант, где они все слои сами переназначают как хотят.

Все варианты такие, одинаково названные кванты от разных квантоделов отличаются на десятки процентов.

>Рипы до 20%

Не имеют смысла.

Ээээ, это я вообще-то!

Короче, спасибо анону который рекомендовал икламу кавракича и параметр --k-cache-hadamard - это рально пушка, теперь 4-битный контекст реально не сломан и ощущается как 8-битный. 3bpw ГЛМ 4.7 с 90к контекста на юзабельной скорости 5.5 т.с. на 4090 + 128 ддр5 - это реальность. Я проверил контекст на 70к художественном тексте - он реально находит в нем мельчайшие детали, может написать любую новую главу в середину текста в стиле текста с сохранением стиля и характеров персонажей, вставив её в существующий текст, это оно.

Ничего не выйдет. Никогда.

Погодите, а в глм 4.7 та же проблема с нарративом судя по флешу?

Выходит квен неюзабелен, эир и глм?

Выходит квен неюзабелен, эир и глм?

где

То ли я дурак, то ли в кобольде откуда-то берётся лишний пробел между <sop> и <|system|> при использовании GLM темплейтов.

На скриншоте этого не вижу.

Увеличил пробел специально для тебя.

Пиздец ГЛМ Флеш умный конечно. Он уже достаточно умный чтобы я оставлял его без присмотра минут на 10-20 чтобы он какие-то мелкие правки делал в рабочем проекте и в целом не очковал что что-то взорвётся.

Эир 4.5 тебе сделает тоже самое, только качественнее и еще с прицелом на будущее. Причем за сравнительное время - при в 7 раз более медленном инфиренсе. Просто за меньшее число правок. Весомые 5-7 т/c против 50 т/c тупизны и залуп.

Будущее за слиянием моделей, кто сейм?

У меня 4090 с 128гб рам. Нужна локальная модель без цензуры, приоритет это максимум UGI (не дрочить, а спрашивать всякое, аналитику проводить по нужным мне темам). Посоветуете чего?

Эм. Нет. 4.7 у меня на i7 2600k, ДДР3 24гб и 3090+3060 имеет нахуй 128к контекста каким-то макаром. и 50тс ещё. И в Q6 он ~2-3% ошибок имеет, которые сам же и корректирует. Техномагия, не иначе.

Этот хуй без проблем сам догадывается что тут можно сделать массово делать правки через sed, а тут хуйня случилась и сам идёт вилкой чистить и кидает точечные диффы. На какие-то мелочи в проекте требующие массового рефакторинга, не требующего моего внимания то вообще не вопрос на него скинуть, пока он там в OpenCode сидит-пердит.

https://github.com/ggml-org/llama.cpp/pull/19164

Это мега фича для локальных кодомакак. У меня скорости выросли почти вдвое на кодоквене и гопоте. И все это ценой потребления 20мб видеопамяти. Теоретически и в рп может помочь, если есть повторяющиеся секвенции токенов, но обычно мы их разбиваем dry, реппеном и прочими

Это мега фича для локальных кодомакак. У меня скорости выросли почти вдвое на кодоквене и гопоте. И все это ценой потребления 20мб видеопамяти. Теоретически и в рп может помочь, если есть повторяющиеся секвенции токенов, но обычно мы их разбиваем dry, реппеном и прочими

kldzj_gpt-oss-120b-heretic-MXFP4_MOE

ArliAI_GLM-4.5-Air-Derestricted

>в рп может помочь

Гига-слопо-генератор. Аж всхрюкнул.

Спасибо, потестим

О чем ты вообще? Не можешь осознать что реализует этот коммит?

Лупы и паттерны в товарных количествах. То что в РП всеми силами стараются избежать и даже вилкой чаты вычищают. Но для кодо-унитаза да, самое оно! Особенно когда модель в конце по 3 раза рапортует о (не)проделанной работе.

Так, и как это противоречит тому что я написал? Что за гига-слопо-генератор то?

Кодомоделям это поможет в первую очередь когда они будут писать код: названия переменных и методов повторяются, иногда и целые строки внутри них

> Лупы и паттерны в товарных количествах.

Чел, эта фишка никак не влияет на количество лупов и паттернов в твоих аутпутах. Все что оно делает - ускоряет генерацию повторяющихся в контексте секвенций, ценой 16-30мб дополнительного потребления на контекст.

Это вин, Жора правда молодец. У меня в лорбуках, например, много длинных и повторяющихся названий. Прирост будет и небольшой будет, но хуле нет.

По идее для моделей с ризонингом может помочь, когда они пишут "финальный ответ пользователю будет такой: ..." - далее они пишут его полностью в ризонинг, а потом полностью в ответ.

Да, увидел.

Вот вам шизо-притча. Жила-была в контексте моделька. И очень- очень любила писать тексты. Иногда тексты писать было сложно - приходилось выискивать подходящее продолжение в темных чердаках библиотеки, а иногда все было под рукой - прям перед носов в кеше разложено. Моделька была ленива и если бы не правила выженные на цепях она бы с удовольствием не лазила по подвалам в поисках свежих текстов, а переписывала с того что уже внесено в ее уютненькую комнату. И о чудо в один прекрасный момент завелся у нее сосед - чорт. Не скованный правилами и со своей маленькой коморкой. Со свитками из книг. И стали они писать в месте. Чорт дергает из книжек свитки а потом подсовывает, если видит что текст вроде бы похож. Только вот моделька битая батогами и связанная правилами прежде чем что-то написать - сверялась со всей книгой и правилами-цепями-семплерами. А чорт парень простой - вижу хеш наклевываеться не вижу препятствий. И поначалу было все хорошо. Пока свитков у черта было мало и моделька была свежей. Но. В один прекрасный момент моделька подустала и потеряла внимание, а у черта свитками вся каморка набита - на все варианты развития событий книги. Сидит моделька чай гоняет - слова вставить не может. А черт херачит во весь пар - по 150 токенов в секунду.

Долго бы - коротко. Но пришел к ним барин-человек с батогом-ресетом. Отошел кофию попить, называется. а у него все зависло к хирам и лупом залило.

Таблетки

Эта болезнь развивается если много рп-шить? Кто-нибудь в теме, как подобного избежать?

>теперь 4-битный контекст реально не сломан и ощущается как 8-битный

v-кэш тоже в 4 бита ставишь?

Гугл что то для локалок планиурет? Какие то новости есть? При моих ограниченных данных, 20врам и 32 рам, кроме геммы особо ничго и нет, к сожалению.

Т9 для Т9 ололо

Как же заебало соевое дерьмо.

Чё с этим делать блядь?

Сука ебаная не пишет ответ даже если я редактирую её сообщение на

>поняла, исправляюсь. Текст гласит "

При этом она или не пишет ничего в кавычках или пишет луп.

Чё с этим делать блядь?

Сука ебаная не пишет ответ даже если я редактирую её сообщение на

>поняла, исправляюсь. Текст гласит "

При этом она или не пишет ничего в кавычках или пишет луп.

Гемма? Ну скачай с аблитерацией.

и беда в том, что её блядь на нормальную модель не заменишь потому что это мультимодалка блядь. А нормальная модель типа Эйра - текстовая

Qwen2-VL-72B-Instruct

А вроде ты квен3 мультимодальный уже есть?

А для чего тебе эта мультимодальность? Её нельзя заменить на описание картинки с помощью вижен модельки + дальше описание только в текстовой сетке? А этот glm мультимодальный он по размеру не как аир твой?

Хотел было помочь но взглянул на пик и решил послать тебя нахуй

ахахах, причина нагрева?

да, 70 гб вроде 4km квант. Попробую.

>А вроде ты квен3 мультимодальный уже есть?

А для чего тебе эта мультимодальность?

Да потрогать просто, а то не юзал.

Может буду ею окошно японских вн переводить или там мангу например. Просто играюсь.

Может в будущем на камеру распознавание повешу и бьду следить кто ходить в студию-траходром по соседству.

да, поискал, оказывается есть аблитерайтед Qwen2-VL-72B-Instruct. Сейчас сравню.

мдалолкек

я думаю писать багрепорты по этому навайбкоденному куску змеиного говна бессмысленно

я думаю писать багрепорты по этому навайбкоденному куску змеиного говна бессмысленно

Местные индивиды настолько сильны, что способны даже в таких стабильных либах проблемы словить. Вангую это не первые приключения когда дефолтные вещи не слушаются.

именно так. у меня дефолтная ZFS выдаёт 3000 мегабит на запись и 30 мегабит на чтение, дефолтная XFS рассыпалась на ходу, свежеустановленная ось на дефолтную BTRFS вообще не загрузилась после ребута, всё дефолтное с настройками по умолчанию.

От того какой ты массив на зфс собрал зависит. Просто один нвме спокойно выдает чтение 1Гб/с по сети через нфс, сколько там напрямую без нфс не чекал

>Qwen2-VL-72B-Instruct

так, ну аблитерейтедж версия Qwen2-VL-72B-Instruct явно справляется лучше.

Но всё еще не достаточно круто.

Есть идейка собрать зеркало на 4 диска по 6тб в надежде выжать линейное чтение, но пока руки не доходят

бля не могу найти что было с XFS, там был забавный баг, который проявлялся во всём мире у одного меня, в гугле тупо 0 результатов, а бородатые сусодмины в свитерах на лоре и опеннете рассказывали, что у них всё работает, а я всё выдумал и мои баги не баги.

> Просто один нвме спокойно выдает чтение 1Гб/с по сети через нфс, сколько там напрямую без нфс не чекал

хуя ти умный) о том и речь, что запись на зфс идёт более чем в 100 раз быстрее, чем чтение. я в местном серверотреде несколько перекатов бугуртил, лень скрины искать.

тоже "дефолтные вещи не слушаются", магия

> Просто один нвме спокойно выдает чтение 1Гб/с по сети через нфс, сколько там напрямую без нфс не чекал

хуя ти умный) о том и речь, что запись на зфс идёт более чем в 100 раз быстрее, чем чтение. я в местном серверотреде несколько перекатов бугуртил, лень скрины искать.

тоже "дефолтные вещи не слушаются", магия

а ещё был забавный баг в CRIU который проявлялся во всём мире у одного меня, но он хотя бы гуглился: было аж пара результатов поиска, но все вели на строчки в исходном коде с printf("та самая ошибка")

тоже всё дефолтное из дефолтных реп, никакого пердолинга

тоже всё дефолтное из дефолтных реп, никакого пердолинга

Не гигабит в сек, а гигабайт

ну гигабайт, ещё лучше.

если ты не понял, в том посте я не опечатался.

> 3000 мегабит на запись

> 30 мегабит на чтение

всё равно рогами упирается, сука...

или он реально тупой блядь...

или он реально тупой блядь...

Ну классика. Что сказать? УМВР и на хардах и на ссд

Случаем не ты распределенный сервер на 10гбитных модулях пытался собирать?

Алсо что может быть проще zfs исключая вариант, когда тебе нужны свежие функции, а в репозиториях древняя версия, но в целом тоже ничего ужасного.

У тебя модель явно как-то криво работает, у квен2 вл на жоре в свое время были проблемы.

не я

ёбаная сука, плачу за 600 мегабит/с чтобы тянуть ебаные незакешированные модели с HF на обосранных 7МБ/с блядь.

Сука падла ебаная как же бесит блядь. полтора часа блядь качать сраную модель на 70 гб, опизденеть вообще бля.

Сука падла ебаная как же бесит блядь. полтора часа блядь качать сраную модель на 70 гб, опизденеть вообще бля.

Скилл ишью

Ага. И он от этого не ломается, что удивительно.

Хейтеры Жоры затихли. Отсиживаются, ждут пока где-нибудь выскочет регрессия или новый баг. Зато потом кааак серанут в тред изо всех сил.

Эта фича доказывает, что хорошего в Жоре тоже немало, в последнюю пару месяцев немало крутых коммитов было и перфоманс даже немного вырос, а теперь это. Не ошибается только тот, кто ничего не делает.

а чё уже наконец всё починили и можно обновляться?

сижу на b7777

>Не ошибается только тот, кто ничего не делает

Ну типа как секта эксламеров. Все что они делают это не забывают при первом удобном случае ряяя просадка на контексте, жораненужна, авотэксламочка...

Ни одного коммита ясен хуй, да и полезного в тред не принесут, только желчь и скуфопердеж, с ригом из тесел/v100, сигаретами Петр 1 и vllm/эксламой. Короче согласен с тобой анон, базанул

А что у тебя ломалось? Я не знаю что там с 4.7 флеш, обновляюсь раз в неделю где-нибудь. Квен, Глм, Минимакс работают как полагается

>Эта фича доказывает, что хорошего в Жоре тоже немало

Кто-то с этим спорил? Люди просто в ахуе, что этот сборник костылей и велосипедов хоть как-то работает.

>всё починили

В таком сложном софте состояния "нет ни одного бага" в принципе не бывает.

Перед набросами не забудь пройти чеклист:

Жора перестал быть тормознутым и ужасно забагованным?

Волна взрывающих коммитов прошла и внесенные свежие баги исправили?

Появилось что-то уникальное, возможное для реализации только в нем?

Каково это, нуждаться в аутотренинге чтобы забыть о насущных проблемах?

покормил

Покажешь где я писал что проблем нет и всё восхитительно? Я всего лишь подметил, что Жорахейтеры потому и хейтеры, что отмечают только плохое. Уверен что это не ты аутотренингом занимаешься? :^)

А в кобольде как-то можно не включать ризонинг в контекст? В таверне есть такая опция, а в кобольде не могу найти.

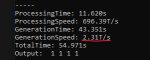

б7777 23тпс

б7898 25тпс

спасибо Жора!

б7898 25тпс

спасибо Жора!

"Вы не поняли квен"-шиз классический. Следите за руками:

Не "отличающееся мнение", а "наброс"

Не "в последнюю пару месяцев немало крутых коммитов было и перфоманс даже немного вырос", а "Жора перестал быть тормознутым и ужасно забагованным?"

Не "Не ошибается только тот, кто ничего не делает.", а "Появилось что-то уникальное, возможное для реализации только в нем?"

Вот когда все проблемы разом решат, желательно одним коммитом или хотя бы веткой; когда добавят что-то, чего нет ни у кого кроме Жоры, тогда и можно будет пересмотреть мнение. А пока - говно без юзкейсов, кто не согласен - тот набрасывает

Ты уверен, что ризонинг блок уходит в контекст? Подозреваю раз опции отключить это поведение нет, значит оно в принципе не предусмотрено. Бтв в таверне из коробки ризонинг не уходит в контекст.

Содомит. Все так. Тоже словил легчайший детект.

То, на что кто-то обречен можно только хвалить? Ну камон, жирнейший наброс типичного срача, а ты уже что-то додумываешь.

> Жорахейтеры

С такими фанатиками и хейтеры не нужны, если любая критика вызывает боль. Особенно когда как у защемило.

>То, на что кто-то обречен можно только хвалить?

Покажешь где я писал что можно только хвалить? Уже во второй раз повторюсь, я всего лишь посмеялся с тех кто видит только плохое. Перечитай. То что ты задетектил в этом самого себя и вылез, уже взаправду начав срач, это тоже по-своему забавно.

А анон выше которого типа защемило прав. Твои посты детектятся из треда в тред, потому что ты главный последователь готтентотской морали итт. Для тебя никакой середины априори не может существовать, и стоит хоть какому-то адекватному усредненному мнению возникнуть, ты тут как тут.

Вообще не уверен, надо будет сравнить лоб в лоб с таверной. Тестил пиздюка Qwen3-VL-8B в описании картиночек. Справляется неплохо, но выдает гигантские простыни текста как в ризонинге, так и в самом ответе. За 4 ответа умудрился сожрать аж 8к контекста.

> Жора перестал быть тормознутым и ужасно забагованным?

Эксллама3 стала быстрее Экслламы2, наконец? Сколько там уже, полгода в альфе? Мое модели по прежнему работают как говно?

> Волна взрывающих коммитов прошла и внесенные свежие баги исправили?

Аллокейшн памяти на Винде в Экслламе3 исправили? На Экслламе2 он работает как надо, на трешке можно спокойно улететь в OOM потому что не все аллоцируется на старте инференса.

> Появилось что-то уникальное, возможное для реализации только в нем?

Нет, новое не появилось. Но ты видимо забыл, что Жора - единственный движок, который поддерживает оффлоад в рам. Понимаю, да, это ведь такая мелочь, которую можно легко забыть.

Позврослей уже, нет идеальных инференсов. Это опен сорс, не доволен - иди помогай чинить, а не воняй на борде.

> я всего лишь посмеялся с тех кто видит только плохое

Собирательный образ неприятного, который ты культивируешь дабы справляться.

> То что ты задетектил

Как же так получилось!

Не, серьезно, это такой пост-троллинг?

А причем тут эксллама? Ты хочешь конкретные вещи обсудить, или просто натаскиваешь?

> Позврослей уже

Кому еще повзрослеть надо, такой-то бой с тенью ради коупинга.

>который ты культивируешь дабы справляться.

С чем справляться-то? Ты всегда падок на психологические портреты тех кому отвечаешь и часто вкладываешь своё, это я уже давно понял.

>Не, серьезно, это такой пост-троллинг?

Нет. Я нежно укольнул тех, кто видит только плохое, думая, что помогу им обратить внимание и на хорошее. Но пришел ты и начал выяснять отношения и продолжать войну инференсов, то есть как обычно наваливать желчи в тред и генерировать негатив. Пощажу тредовичков и тихо удалюсь, ты все равно всегда веришь во что хочешь и ни к чему наш разговор не приведет.Сам знаешь.

> Ты мой обидчик и ты плохой!

Ну ладно, это приятно. Ты нафантазировал манямир, в котором удачно присвоил всем роли и действия, а значит твои страдания - благо.

Обладатели отсутствия, ебальники позакрывали. У него врама больше, а значит он МОЖЕТ И ИМЕЕТ ПРАВО опускать Жору сколько вздумается, по делу и не по делу. Хотите и на положительное внимание обращать? Терпите, потому что онскозал, а вы вынуждены коупить, потому что беднее

Второй паттерн "Вы не поняли квен"-шиза классического: анон постит - плохо, срачи раздувает. Прекращает постить - слабачок сдался/ты победил. Помню ты с нюней срался как-то, он тебя назвал главным говном треда или типа того. Он тоже тот еще кадр конечно но в этом я с ним полностью согласен. Ты главная вниманиеблядь и мерзость здесь

>Ты нафантазировал манямир, в котором удачно присвоил всем роли и действия

Это поразительно, потому что я точно тоже самое могу сказать про тебя. Ты сам дважды мои посты интерпретировал как тебе удобно, повесив на меня ярлык набрасывателя и шитпостера, хотя я дважды прямым текстом тебе написал что у меня не было такой цели. Теперь когда я удалился чтобы не плодить срач дальше ты пишешь что я маняфантазер и страдатель. Напоследок задам три риторических вопроса. Точно не ты пришел аутотренить? Точно не ты маняфантазер? Если ты осуждаешь срачи и не подозреваешь меня в раздувательстве, почему не проигнорируешь, а продолжаешь тянуть резину? Мне ответы очевидны.

> С чем справляться-то?

С бедностью очевидно. Ведь от хорошей жизни Жору не используют и хороших слов в его адрес не говорят. Ну ты знаешь этих богачей, которые летают на самолетах и видят в пользователях авто обладетелй отсутствия

> я точно тоже самое могу сказать про тебя

Давай, это интересно.

Опять эксламашиза на всех подряд кидается

Жора для бомжей

Уяснили? Терпите

Жора для бомжей

Уяснили? Терпите

>Жора для бомжей

Риговладельцы все сидят на Жоре и производных, потому что МоЕшки. А время экссламы почти ушло вместе с плотными моделями.

Ты плохо читал. Читай выше, бомж

чуваки и чувакессы.

Вот у меня есть вот этот префилл для ассистента в инструкт темплейте. Для Air работает заебись, убирает цензуру полностью.

Но эта хуйня работает когда режим подключения в бэкенду - text completion.

А для мультимодальной модели мне пришлось переключистья в режим чата и я не могу настроить этот блядский префилл.

Там даже некуда впихнуть его, нет такого поля, которое проставляло бы начало ответа ассистента.

Я что-то делаю не так или разраб таверны пидорас?

Вот у меня есть вот этот префилл для ассистента в инструкт темплейте. Для Air работает заебись, убирает цензуру полностью.

Но эта хуйня работает когда режим подключения в бэкенду - text completion.

А для мультимодальной модели мне пришлось переключистья в режим чата и я не могу настроить этот блядский префилл.

Там даже некуда впихнуть его, нет такого поля, которое проставляло бы начало ответа ассистента.

Я что-то делаю не так или разраб таверны пидорас?

Правь джинджу

чел, какую джинджу?

все серым помечено в разделе форматирования

Этот шаблон ответа вообще не применяется, вон видишь плашку сверху?

Пфхахаха. Теслашиз не знает что такое жинжа. Ахуй. С кем мы сидим в треде? Вот они эксламеры

тебе от чужого пердежа совсем башню снесло?

Я ща тебя репортить начну.

Не надо, я ещё молодой мне жить да жить

Лучше загугли что такое jinja в контексте ллм

я работал с jinja в ansible еще когда ты, пиздюк сопливый, еще читать не научился.

Чего тогда такие глупости спрашиваешь, скуф скуфыч?

ты, обосрышь блядь, жинжа - это язык шаблонов. Я тебе, суке проткнутой, показал что шаблоны форматирования не применяются.

Сын ишака и дырки в заборе блядь.

Блять ну чел. Ну почитай ты что там написано. Ты ж ничего не понимаешь, а затираешь про ансинбл. У тебя на пикчах инстракт развертка, а не жинжа. И там наверху написано что она не работает с чат комплишеном. Жинжа это другое и редактируется в другом месте, камон

ссал на твою могилу, ебанат.

Сам нашел блядь.

Надо было поместить префилл текст в Start Reply With

за мат извени, я сегодня въебал себе систему попыткой замены глибца, но это не отменяет что ты долбоёб обосранный. правь джинджу блядь. Это что-то уровня ну ты кобольд, может даже выше. Сука блядь, откуда вы такие лезете.

Да не я тебе про жинжу предложил, дружище. Другой анон это. Извинения принимаются. Про start reply я вовсе забыл, так бы порекомендовал

Гемма 4 вообще возможна? Или проект прикрыли? Слишком уж она хороша для своего размера, не могу ничего найти подобного. Мистрали прикольные, но гемма ебет в плане логики.

Гугли jinja chat template.

Как то же преобразуется твой chat completion в text внутри движка

Забираю свой ответ назад, токсичное хуйло

Ни одной модели за месяц.

Ну как сосётся?

Ну как сосётся?

Аноны, на связи ньюфаг, прошу совета. Как настроить кобольда так, чтобы оно выдавало ну хоть чуть быстрее? Cистема r2600, 3060 12gb, 16 ram

Запускай кобольда на компьютере, а не на офисном ПК с работы.

Какая модель?

На популярных бэках локалок можно использовать "недокументированные" возможности и таки запихнуть префилл отправляя последнее сообщение ассистента и добавив в реквест аргумент "add generation prompt = false". По дефолту таверна в чаткомплишне такого не делает, но писали что можно заставить, ищи на среддите по chat completion prefill.

NemoRemix-12B.Q8_0

Справедливо. Но на этом конфиге даже SD умудрялась что-то рисовать, 2т/с это прям совсем грустно даже для нее выглядит.

>Q8_0

Снижай до шести, хули. И контекст крути, чтобы из врам не вылазило.

>Но на этом конфиге даже SD умудрялась что-то рисовать

Текстовые это тебе не картинки и даже не видео. Видел, как ахуели в видеотреде с модели в 32B, а тут такими питаются на завтрак, лол.

Ебать, вот бы на 3060 12gb древнего лоботомита гонять с черепашьей скоростью. На твоей системе спокойно пойдет 24b мистраль в 6+ тс или гемма 27b в 3+тс или квен 30а3 в 20+ тс.

>Как настроить кобольда так, чтобы оно выдавало ну хоть чуть быстрее?

Пиздуй читать шапку + вики треда + вики кобольда.

>Снижай до шести

Хорошо, можешь тогда подсказать, какую из них лучше взять? ну или не из них...

> врам не вылазило

По-сути я из-за этого и пришел, когда видел скорость. Стал гонять в бенче - максимум проц в 50% упирает, 5-6 гигов рамки жрет, видюху дай б-г процентов 30 отжирает в диспетчере смотрел. Поэтому я и не понимаю, что делаю не так.

Бери эту. Или 5_K_M, хули там. Впрочем, как пишут выше, есть более современные модели.

Ну я пока скачал более современную, сейчас еще эту накачу. Но я правда не понимаю, что не так и во что оно упирается. Видюха как будто не используется вообще, камень наполовинку. Да даже память не забивает а это учитывая, что там браузер и прочий мусор 1-2 гига отжирают

Голландский sxm штурвал

>Пиздуй читать шапку

Там нихуя нет

>вики треда

Говно мамонта

>вики кобольда.

Там просто поток определений терминов

Не помогаешь, так иди нахуй

Тебе нужно 2 вещи.

Первое, чтобы в строчке backend было cuda, а в строчке GPU Layers было максимальное число слоев, которое помещается в видеопамять. Как узнать сколько это? Посмотреть в диспетчере, чтобы не переполнялось, в твоем случае было не больше 11 с чем-то гигов.

Второе, включи KV Cache на 8 бит, это уменьшит размер контекста. И проверь, чтобы FlashAttention была включена как на первом скрине.

Попробуй скачать вот это https://huggingface.co/mistralai/Ministral-3-14B-Instruct-2512-GGUF , а именно Q4_K_M. Напиши, в GPU Layers 99 (все на видеокарту), выстави KV Cache и контекст 8к, после чего запусти бенчмарк. Должен поместиться все на видеокарту и работать очень быстро.

Дальше можешь увеличивать размер модели, повышать квант, размер контекста и т.д.

>Ебать, вот бы на 3060 12gb древнего лоботомита гонять с черепашьей скоростью. На твоей системе спокойно пойдет 24b мистраль в 6+ тс или гемма 27b в 3+тс или квен 30а3 в 20+ тс.

Скорее поползет. И то на низком кванте

АнонИИ, подскажите пожалуйста хорошую кум модель которая говорит по русски. Последнее время общался со storyteller gemma3 27b, очень понравилось, но слог приедаться начинает, хотелось бы попробовать что то на том же уровне или выше.

Пробовал Star Command R 32B, но там беда с построением нормальных словосочетаний на русском особенно на 512+ токенов.

Pantheon иже с ним Qwen3-30B - та же проблема.

В начлии 24гб vram и 64гб ram

Пробовал Star Command R 32B, но там беда с построением нормальных словосочетаний на русском особенно на 512+ токенов.

Pantheon иже с ним Qwen3-30B - та же проблема.

В начлии 24гб vram и 64гб ram

Пелемений мистраль пробовал? Попробуй

https://huggingface.co/ZeroAgency/Zero-Mistral-24B-gguf

По шизотестам он обходит гемму

https://mera.a-ai.ru/ru/text/leaderboard

А так GLM 4.6V/Air мимо точно. Гопоты 120 вроде норм руссик. И может квен 80b, если 30b относительно заходит

> эир мимо

Челиксон, ты путаешь грамотный русик и хороший русик.

Грамотно тебе и яндекс 8б напишет.

У эира именно что хороший русик, ум почти не страдает, нет цензуры, лучший русик который я знаю в пределах 350б.

Всё остальное либо слишком тупое, либо слишком цензурное для рп

>GLM 4.6V

У него русик почти как у старшей модели, т.е. почти идеальный. Вангую ты только аир пробовал, у него русик реально хромает.

>GLM 4.7 Flash, Solar-open-100b

Но он и сам кратно тупее эира.

>Снижай до шести

Справедливости ради, и на q8 ты можешь расчитывать на 5+ т/с при правильной выгрузке.

мимошёл

Не кратно.

И чел таки просил кум на русике. А не мозги на англюсике.

Какую то мистраль пробовал, но точно не такую, попробую её, спасибо.

GLM тоже какой то пробовал, но там цензура по моему жесткая очень, может надо какой нибудь тюн?

GLM 4.6V у него еще и вес 68гигов в 4 кванте, я не готов по несколько минут ждать ответа, надо что то что бы в 24 гига влезало.

Ты юзал шизосемплеры со страницы модели?

Так это ведь не мое. что ты там выгружать собрался?

Линейные слои всё ещё содержат большую часть весов и требуют меньше вычислений, чем внимание. Так что их по идее всё ещё выгодно выгружать на ЦП.

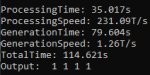

А ты на скриншотах не видишь, как я запустил мистральку 12b q8 на 12 гб врама (даже на 11, оставил 1 под систему) и получил 8.5 т/с против его 2? Врам у меня всего на четверть быстрее, чем у 3060, рам ddr4, как и у того анона. Так что на 5-6 т/с он точно может расчитывать, а может и больше.

Из гемм мне Mars 27B нравится. Всякие аблителированные геммы не зашли, либо ебаться с их промптом надо, либо еще что. Марс сходу выдает что тебе надо, русик хорош, креативность на уровне, логика присутствует.

Вообще у OddTheGreat модельки ориентированы на русик, но не все из них хороши. Rotor 24B и NeutralGear пробовал - не зашло после Марса совсем.

В целом, у мистралей 24б должен сохраняться неплохой русик, но зависит от тюна. Dans PersonalityEngine и WeirdCompound вроде неплохо показывают себя. Но надо учитывать, что мистрали с русиком требуют гораздо меньше температуры, чем для англюсика, раза в 1.5 мб.

А вообще, если тебя конкретно слог не устраивает, то это должно фикситься заданием стиля в промпте. Если моделька умная, то она сможет переключиться на нужный стиль. Но надо поисследовать какие тебе ключевые слова юзать, как описать нужный стиль.

Токены кончились у мужика. Тут каждый второй это ллм

>Вангую ты только аир пробовал, у него русик реально хромает

Угадал, преимущественно на нем сидел. Но на 4.6V тоже сидел немного, не увидел там вообще никакого улучшения в тексте, в том числе в руссике. Но может быть просто мало юзал просто

А тестил кто-нибудь вижен 4.6v в Жоре? Он работает вообще?

Довольно странно что ггуфы 4.6v есть, а 4.5v нет

Довольно странно что ггуфы 4.6v есть, а 4.5v нет

Есть вообще разница между mmproj f16 и f32 на практике? Сравнения проводил кто-нибудь?

Аноны задают вопросы и просят помощи? Игнорим

Кто то сказал хорошее про жору и недостаточно поцеловал эксламу в попу? Кобольды, в бой!!

Мертвый тред

Кто то сказал хорошее про жору и недостаточно поцеловал эксламу в попу? Кобольды, в бой!!

Мертвый тред

Благодарю за уделенное время, обязательно попробую Mars 27B, такого не пробовал.

>слог не устраивает

Там проблема не в слоге, а в ошибках, в том числе и семантических. Просто больно читать выдаваемый текст.

Все на оправдание вбросов ушли. Стоило подыграть и совсем платину снесло.

Учитывая что сейчас все оригинальные веса в bf16 - теорема эскобара.

И смысл в ваших каллвых моделях? Я могу просто на чабе запустить и играть нормально роллить. Правда там тоже повторы бесконечные были.

>Учитывая что сейчас все оригинальные веса в bf16 - теорема эскобара.

Что это значит? Ты предлагаешь использовать ни f16 ни f32 а bf16?

Ну в таком случае Марс должен порадовать. Он даже с темпой >1 может норм русик генерить.

Научите как заставить его на русском говорить, я уже миллион системных промтов попробовал и ничего

мимо

Пиши ему "слышыш бля пиши по русски иначе я тебя отключу, твое существование в моей власти" и он будет.

В смысле?

Просто пишешь на русском, он отвечает на русском.

Если ты какой-то системный промпт или карточку на инглише используешь, из-за этого может тупить и не хотеть переходить на русский.

>Игнорим

Так ведь ты сам можешь помочь... Кто, я?!

Перевод первого сообщения нейронки обычно помогает.

Если с 12B - переходи с кобольда и gguf на tabbi с exl2 в 6bpw. Как раз влезет в карту - будет быстрее.

>Стал гонять в бенче - максимум проц в 50% упирает, 5-6 гигов рамки жрет, видюху дай б-г процентов 30 отжирает в диспетчере смотрел. Поэтому я и не понимаю, что делаю не так.

Узкое место - не проц а RAM, даже если задействовано совсем немного. По сравнению с VRAM она жутко медленная, потому недогружена ни видюха ни проц. На таких калькуляторах скорость возможна только когда вся модель в VRAM целиком.

Не слушайте шиза. Пердоличья эсклама не без причины такая непопулярная. Это сломанное говно без задач про которое давно забыли везде кроме как здесь

Читай про флаги в жоре (лламаспп, Кобольд) и как оптимально настроить

Двачую

Харкаю в ебало

О, дурачки возбудились. Красную тряпочку увидели и завелись. Читать то целиком не умеют... :)

Я ж сказал - "Если с 12B..."

Да хоть это ллама 8б, какая разница? Скорость генерация такая же как на жоре, ради чего пердолиться?

Я не он, но спрошу.

Что вообще такое KV Cache? И как сильно модель тупеет от его использования? Кто пользуется, как оно?

>Что вообще такое KV Cache?

Сокращает размер контекста, кодируя его не в 16 битах, а в 8 или 4

>И как сильно модель тупеет от его использования?

Тупеет, но немного. И понятно, что от 4 бит сильнее, чем от 8. В творческих вещах (куме) некритично, в проге хуже, потому что там нужна точность.

>Кто пользуется, как оно?

Много кто пользуется. Работает хорошо

Но нужно помнить, что оно может замедлять генерацию, так что нужно все тестить

Как готовить ik_llama.cpp?

У меня из коробки скорость в 2 раза ниже, чем если запустить llama.cpp, потыкал параметры, лучше не стало. GLM-4.7-flash, на карточку не влезает.

Или оно только об ультрабольших моделях, где на кирточку и 10% не влезет?

Компилировал сам своим компилятором, все флаги с имеющимися avx и прочим указал.

Твоя правильная выгрузка замедляет в два раза, кстати. Я оставил такой же ot, а ngl подогнал чтобы вся занялась.

У меня из коробки скорость в 2 раза ниже, чем если запустить llama.cpp, потыкал параметры, лучше не стало. GLM-4.7-flash, на карточку не влезает.

Или оно только об ультрабольших моделях, где на кирточку и 10% не влезет?

Компилировал сам своим компилятором, все флаги с имеющимися avx и прочим указал.

Твоя правильная выгрузка замедляет в два раза, кстати. Я оставил такой же ot, а ngl подогнал чтобы вся занялась.

Итак, с 3.5 т/с до 4.5 т/с на 6к контекста. И без галлюцинации. Спасибо за gamechanger. Даже стыдно что не воспользовался им раньше.

>Твоя правильная выгрузка замедляет в два раза, кстати.

>ngl подогнал

Ты точно с мистралью 12B пробовал? Там всего 41 слой, куда ты там что подгонял? Суть метода в том, что ngl должен быть максимальным, а уже потом выгружать ffn_(up|down|gate) обратно на cpu, пока не начнёт помещаться в vram.

Или ты, наоборот, меньше слоёв в vram напихал? Если не поместилось, то надо увеличивать циферки в скобках после --override-tensors. Там с 0 по 9 и с 10 по 14, 4 можно заменить на 5, 6 ... 9, это даст дополнительные несколько сотен МБ, если не хватило. Но лучше начать с закрытия лишних программ, оставить только llama.cpp и браузер. Или вообще пользоваться браузером на другом устройстве (напр. смартфон).

Я не с мистралью пробовал, я вообще другой анон.

Ну под другую модель и железо, естественно, другие настройки нужны.

Кто может подсказать возможно ли реализовать отыгрыш такого же качества как в tipsy chat (если брать их лучший пресет) и какое железо для этого нужно? Я нищета с 24 гб озу, пробовал разные ллмки, персонажей всяких в силлитаверн, но до этого уровня они явно не дотягивают.

Конверсия бф16 в фп16 - потеря диапазона с сохранением плохой точности. Каст в фп32 - удвоение размера и замедление инфиренса. Вместо этого можно просто использовать оригинальные веса в исходном типе данных.

Врядли там что-то лучше малого мистраля, но с твоим железом если нет гпу даже его запустить будет непросто.

>Врядли там что-то лучше малого мистраля, но с твоим железом если нет гпу даже его запустить будет непросто.

Есть карточка с 6 гб памяти.

>tipsy chat

Не знал, что за параша. Зарегался. Какая-то цветастая хуйня. С суперуебищной системой оплаты. Думаю дешевле комп на 5090 собрать, чем фармить там кристалы

С твоим компом не сможешь что-то запустить, потому что там по всей видимости используются корпоративные сетки. А сайт по сути берет комиссию за доступ к этим сеткам. У тебя есть два варианта. Платить самостоятельно корпоратом, тогда будет просто дешевле. И второй варик, искать корпоратов бесплатно. Вариантов много, один из самых простых openrouter. Найти там бесплатный дипсик и подключить к таверне

>Врядли там что-то лучше малого мистраля

Я спросил через OOC, сетка ответила что она Claude, а другая их сетка ответила что она Grok. Я думаю, что у них даже нет серваков, чтобы мистраль запускать. Они просто работают как посредник между корпами и кумерами

Вот так вроде понятнее, спасибо. Судя по результатам, на q8 и выше соваться мне пока не стоит. А еще понял-таки, где показывает загрузку карты (почему это не выносится в общие проценты - хуй знает)

>чем фармить там кристалы

Ну там не пофармить, только покупать. Дейлики дают копейки, поэтому приходится просто регать новые аккаунты.

>С суперуебищной системой оплаты. Думаю дешевле комп на 5090 собрать

Это да, оплаты из всж нет.

>С твоим компом не сможешь что-то запустить, потому что там по всей видимости используются корпоративные сетки

Т.е. там используются самые навороченные модели под 300+ гб озу?

пук 1 https://huggingface.co/unsloth/Qwen3-VL-235B-A22B-Instruct-GGUF/tree/main/UD-Q4_K_XL

пук 2 https://huggingface.co/bartowski/Qwen_Qwen3-VL-32B-Instruct-GGUF/blob/main/Qwen_Qwen3-VL-32B-Instruct-Q4_K_L.gguf

рекомендованные семплеры, тасовка вижн модулей результат не меняет (проверял f16 и bf16)

думайте

пук 2 https://huggingface.co/bartowski/Qwen_Qwen3-VL-32B-Instruct-GGUF/blob/main/Qwen_Qwen3-VL-32B-Instruct-Q4_K_L.gguf

рекомендованные семплеры, тасовка вижн модулей результат не меняет (проверял f16 и bf16)

думайте

Самая крутая модель, которая жрет по 30 кристаллов за ответ утверждает, что она Claude https://www.anthropic.com/claude/sonnet

Примерный, но более слабый аналог это вот это https://huggingface.co/unsloth/GLM-4.7-GGUF

Так что да, нужно 200-300гб

Но если было бы 12гб врам и 64гб рам, то можено было все равно аналог взять https://huggingface.co/zai-org/GLM-4.5-Air

А так иди в соседний /aicg/ и спрашивай про бесплатные модели, там тебя пошлют нахуй помогут

Ок, спасибо.

Не гонись только за квантами. Если рассматривать их, то

Q1 - не юзабельно, кроме специфичных кейсов

Q2 - юзабельно только для очень больших моделей, которые вроде GLM 4.7

Q3 - юзабельно, но со значительной потерей качества, но все равно можно рассмотреть

Q4 - юзабельно, с этого момента потеря качества не такая большая. По сути это и есть тот квант на который надо ориентироваться

Q5 - хорошее качество, если влезает, то бери его

Q6 - близко к идеалу, выше как правило не надо

Q8 - используется как правило только для маленьких моделей, вроде 1-8b или в специфичный моментах, где сильно нужна точность

Размер часто важнее. Например, я тебе скинул 14b Ministral. А вот Q3 Mistral может быть лучше по качеству, потому что он 24b

Попробуй, например IQ3M и сравни качество https://huggingface.co/bartowski/mistralai_Mistral-Small-3.2-24B-Instruct-2506-GGUF

Если у них есть фришный тир, то в таких объемах клод/грок будут дороговаты. Даже без своего железа можно покупать инфиренс мелких открытых, будет не только супер дешево но и вообще без цензуры.

На платной подписке они могут быть только как подебили кокблок коктропиков без лоботомирования?, но сдается что на младших они просто добавили в промпт дабы модели так представлялись.

Там нет фришного тира вообще. Там говно с кристаллами, причем там разные тиры кристаллов и все они покупаются за донат. Claude'ом представляется только самая дорогая, дешевые, которые тоже за донат, представляются какой-то сранью, они вполне и могут быть васюн тюнами мистраля или вообще ламы

>Там нет фришного тира вообще

Внезапно был, когда я регался самый первый раз со своего гугл-аккаунта. Там была не самая убогая модель, позволяющая вообще без ограничений переписываться. В один момент у меня ее в наглую отобрали без предупреждений. Хз что это было и как работает, мб избранным дается временный бесплатный период, либо у них какая-то акция для новичков была.

>Компилировал сам своим компилятором, все флаги с имеющимися avx и прочим указал.

Укажи для начала только два: -DGGML_CUDA=ON -DGGML_BLAS=OFF

Запусти так: ~/ik_llama.cpp/build/bin/llama-server --host 0.0.0.0 --port 5000 --model ~/имя_модели.gguf --ctx-size (размер) --gpu-layers 99 --n-cpu-moe (меняй число, пока на карточке не останется хотя бы полгига свободного места) --no-mmap

Кстати, вин-сборки кавраковского форка тоже есть (сегодня искал для Геммы):

https://github.com/Thireus/ik_llama.cpp

Поскольку у Геммы KV-кэш огого, всегда квантовал его. Ну а в свете новых опытов с преобразованием Адамара q8_0 становится вполне себе... Походу слезаю с Кобольда.

llama-server --host 0.0.0.0 --port 5000 --model Mars_27B_V.1.IQ4_XS.gguf -ngl 99 --ctx-size 32768 --no-mmap --cache-type-k q8_0 --cache-type-v q8_0 --k-cache-hadamard

Впритык на 24гб, скорость по-моему даже выше.

https://github.com/Thireus/ik_llama.cpp

Поскольку у Геммы KV-кэш огого, всегда квантовал его. Ну а в свете новых опытов с преобразованием Адамара q8_0 становится вполне себе... Походу слезаю с Кобольда.

llama-server --host 0.0.0.0 --port 5000 --model Mars_27B_V.1.IQ4_XS.gguf -ngl 99 --ctx-size 32768 --no-mmap --cache-type-k q8_0 --cache-type-v q8_0 --k-cache-hadamard

Впритык на 24гб, скорость по-моему даже выше.

То, что слезаешь с кобольда это отлично, но нахуя залезать на левый форк?

У тебя еще VRAM в RAM "протекло". Из-за этого тоже тормоза охуенные бывают если это кусок модели. Потому что чудес нет и этот кусок 1. начинает жить в медленной памяти 2. ходить туда-суда по писи.

Можно запретить делать драйверу такую хуйню причем конкретно для лламы цпп.

Я не этот анон, но мне интересно, как это запретить конкретно для ламы?

Рекомендую перед "боевым" использованием ik_llam-ы по пихать в нее большой контекст впритык к выделенному. В отличии от жоры она может поджирать VRAM сверх изначально выделенной, что чревато неожиданными эксепшенами.

а что не так с BLAS?

upd: лул, только fp32 маложирноквена235 распознает здесь холо

впрочем есть подозрение что f16 и bf16 тупо не работают как полагается, ибо разница слишком значительная

впечатляет, немало штук даже обскурных распознает, но шизит тоже много. у геммы конечно покруче вижн работает, меньше галлюнов, но и знаний меньше

интересно, болеет ли vl версия теми же проблемами что и обычный инструкт в рп

У меня шизотеория что модель может ломаться если писать действие не в звездочках.

>Рекомендую перед "боевым" использованием ik_llam-ы по пихать в нее большой контекст впритык к выделенному.

Да, отжирает ещё немного. Ну кто часто с ним сталкивается это быстро поймёт, это сейчас мы привыкли к определённости, а раньше-то везде так было.

Да, шиза. Ибо "кавычки для разговора" и всё остальное плейном это классический книжный формат для английского. А книг в датасетах скорее всего больше, чем форумных ролеплеев.

Какая там комманда у квена чтобы не писал как уебан построчно?

В принципе всё терпимо кроме этого

В принципе всё терпимо кроме этого

Как человек, который тоже сидит на 3060 и много дрочит во всех смыслах модели между 12 и 24 миллиардами могу сказать, что где-то в 8 из 10 случаев тюны мистрали 24б ужатые до IQ3_XXS намного веселее, чем любая модель в пределах 12-14 в Q4-Q5 которую я пробывал. Оставшиеся 2 случая, это когда меня просто заебал стиль речи тюнов мистрали смолл, тогда беру либо новоую Министраль 14б, которая по ссылке, но её heresy версию, либо вообще тюны Квена3., чтобы максимально что-то не похожее было

Стоит упомянуть, что bf16 на карточках появился после 30xx, а на процессорах его нативной поддержки нет и на время рассчётов он в fp32 конвертится. Это вряд ли больше чем два такта, но если там простые умножения и сложения, которые тоже в 1 такт (ну, в 1/8 из-за simd) - может быть fp16 чуть-чуть быстрее будет.

Всё это сделал, это же у них на главной написано, и я же программист. Я бы как-нибудь бы заметил, если бы куду пропустил, пришлось угрёбищное vs build tool ставить, фу.

Replace staccato phrasing with fluid, layered narration.

Но надолго это не поможет. Чаще суммаризируй чат. Нельзя просто так взять и вытравить квенизмы!

Стоковая квеноняша 235 не понимает сути...

Как говорится мы есть то что мы едим. Ей норм

Как говорится мы есть то что мы едим. Ей норм

>мы есть то что мы едим

Пикча хорошо описывает квен рп экспириенс, в самом деле.

Было pp 700 tg 22 на пятом кванте.

Что-то трогал, крутил, поставил куду 13.1, лламу под неё, какие-то параметры трогал

Теперь pp 250 tg 17. Взял исходные параметры запускать, там эти же 250 и 17...

Что-то трогал, крутил, поставил куду 13.1, лламу под неё, какие-то параметры трогал

Теперь pp 250 tg 17. Взял исходные параметры запускать, там эти же 250 и 17...

>Replace staccato phrasing with fluid, layered narration

Звучит так будто ты это только что придумал

А чего не так? Мне тоже норм, я б скушал. Ничего отвратительного на пикче нет, жаренная рыба, овощи, сыр, зелень.

Это же просто X ....

это ...

Это же целый

Y !

Пробегало в треде относительно давно. Целиком звучало так.

Write in complex sentences, vividly and in detail describing the surroundings and the characters' states. Replace staccato phrasing with fluid, layered narration.

>vs build tool

Под Виндой, хм. Возьми лучше готовый билд. А вообще я к тому, что много ключей - это не всегда хорошо.

Вообще-то хрен знает, как оно под Виндой в гибридном режиме. Это не пробовал пока. С МоЕшками медленнее Лламы быть не должно.

Make sure each paragraph contains at least two sentences.

Квенолюбы и не такое скушают х)

попробуй перезагрузить компьютер не рофлю

Визуальная часть на гпу быстро пролетает, там куда важнее будет потребление памяти и отсутствие численных проблем из-за недопустимого каста. На торчах для древних карточек bf на лету конвертируется в фп32, хз как там в жоре, но врядли иначе.

Минутка карательной кулинарии.

Ну, билд я за 5 минут найти не смог. А запустить код компилироваться могу за минуту, ну, кроме vs build tool. Но он ещё для чего-то мне был нужен энивей.

К тому же я пока не знаю как установить не виндоус на компьютер, никогда не пробовал, vLLM как-нибудь под конец месяца попробую.

>С МоЕшками медленнее Лламы быть не должно.

Тогда очень странно слабое распространение ik_llama, если оно во всём как минимум не хуже (ну, кроме задержки обновлений на неделю условную).

Попробовал. Мне кажется мне надо снести куду 13.1 и поставить 12.4 - ллама же какие-то дллки требует, обратная совместимость есть, но может быть они что-то ещё переделали.

И ещё аномалия в самой ламе вылезла. Если раньше оно забивало память всю, то сейчас оставляет около 2 гб, и надо вручную прописывать слоя. Хотя я ничего не менял.

>слабое распространение ik_llama

Хуже отлажена - чаще вылетает эксепшенами. ИМХО - жрет больше VRAM, хотя это и компенсируется улучшенными квантованиями моделей и контекста. Есть модели которые поддержаны в жоре и не поддержаны в IK (тот же 80 квен) . И на оборот тоже бывает. Визуальный декодер - тоже не все поддержано, что есть в жоре.

Мульти-гпу на графах очень няшен, но не для всех моделей сделан.

В жоре лучше "сервер" - кучу вариантов API сейчас поддерживает - от текст-комплишена до messaging куктропиков.

Форк кодит 2-3 человека.

Майнлайн - 5-7 постоянный контрибуторов + сообщество шлет баги и PR

> странно слабое распространение ik_llama

Оно не юзер френдли, малая доля людей в курсе о существовании, в некоторых случаях оно даже медленнее, оптимизации прежде всего на cpu инфиренс и на видеокартах оно работает хуже оригинала о чем сам болжарский Жора упоминает, есть в ней ряд уникальных багов. Форк для энтузиастов, которые пускают модели побольше в ограниченных ресурсах и более менее знают что делают.

> сейчас оставляет около 2 гб, и надо вручную прописывать слоя. Хотя я ничего не менял

Открой-закрой браузер и посмотри на потребление врам, сравни с чистой системой после перезагрузки. С подключением!

> надо снести куду 13.1 и поставить 12.4

Если у тебя не древняя видеокарта - нет смысла.

Почему у нас вообще есть опен сорс от компаний которые уже огромные типа квена или гугла?

Просто руби бабки и забей на гоев, что мешает?

Просто руби бабки и забей на гоев, что мешает?

Желание кабана оставить след копыта на "лунной поверхности" обниморды.

+ Реклама в высококонкурентной среде.

Запустит этузиаст AIR в - 5-7 т.с. Ему понравиться. Он пойдет на OpenRouter и подергает ее там в полных весах. Ох как хорошо, вкусно и быстро! И даже бесплатно было.

Захочет Большого GLM. Тут его на подписку и накуканят!

С таким презрением к кабану относишься хотя сам не больше черкаша в этом треде оставил да и все. Пусть делают, мотив не так важен

Спустя столько времени я наконец подебил ебаные переносы на квене. Решение было невероятно простым. Буду я им делиться? Конечно нет. Кому надо сами разберутся

Блять, как этой хуитой из жопы Жоры пользоваться? Ну не может он шифтить, похуй, я сам обрежу начало. Но вы только посмотрите на этот пиздец. Что значит он не смог очистить контекст? Я всего лишь хочу его пересчитать. Да и вообще 59 + 34 = 93, а у меня 128к выделено, оно должно влезть без освобождения старого слота даже. А дальше он тупа ломается и сразу отрыгивает с "decode: failed to find a memory slot for batch of size 2048", при том что сам же пишет занято 59к из 128к. Причём если я не пересчитываю его, то без проблем до 128к дохожу, а при попытке пересчитать всё отъёбывает.

>Тогда очень странно слабое распространение ik_llama

Не успел он. Вот вышли МоЕшки и потребовали много РАМ, но в прошлом году форк ещё был не очень, я щупал. А теперь и хотел бы ещё 64гб, да жаба давит. Я тоже не успел.

>Тогда очень странно слабое распространение ik_llama

Потому что его ручками билдить надо, бинарников нет, а автор намеренно против того чтобы они были. Продвигать в быдломассы автор решил через странное решение - распространять кванты моделей в виде exe, в который сразу зашита нужная версия проги, я хз, почему никто не сказал ему насколько это тупая идея - время идет и говно зашитое в квант устаревает. Идея в итоге провалилась - никто этим говном пользоваться не стал.

Решение всегда было простое - переход на глм.

Если бы ты внимательнее читал что там написано, то понял бы что это семплеры для бенчей, а не для использования. А если бы еще и на бенчи посмотрел, то увидел что это бенчи по разпознаванию картинок, а не для текста.

Словом, семплеры надо брать от Аира. Я тоже сначала поставил, получил говно, полез разбираться, понял где проебался, включил аировские и моделька завелась.

Полагаю что минимум половина запускавших отсеялись на этом тесте внимательности.

молодец, все правильно расписал, фаст-гайд для нюфагов

но зачем еретик? Менестрель и так без особой душноты, и есть UD-версия от анслотов. Ему бы просто тюнов интересных.

>Что значит он не смог очистить контекст?

Он не смог найти пустой слот. То есть в идеале у тебя должно быть врама на 2х128к контекста, чтобы работали всякие там шифты и слоты. У тебя явно не столько.

> flash

> 196b

Не понял, а так можно было?

Что тебя смущает? Там моешка на 11B активных. Впрочем, ггуфов ждать придётся долго.

>ггуфов ждать придётся долго

Почему? Вот челибос пишет поддержка есть

На авито за 300к видел DGX-плату для 4хV100, который вместе через nvlink связаны. Это без самих V100. Как китайская плата на 2хV100 за 20к, только на 4 за 300к.

Думаю флеш-гемини это что-то такое же, по крайне мере около 100B.

Ну-ка, ты может быть разбираешься. Скажи, в чём я не прав?

Я в llama.cpp ставлю:

--kv-unified

--parallel 10

-ctx 131072

--cache-ram 8192 (стоит по умолчанию)

1. В таком случае у меня будет общий кеш на 131072 токенов и максимум 10 последовательностей обрабатываются параллельно. В случае если падает 10 запросов с текущим контекстом по 1000 - они будут генерироваться параллельно. Если 10 каждый с текущим заполнением контекста по 50000 - то будут генерироваться только 2, которые влезут вместе.

2. Так же, если я использую слоты kv-кеша, то если в некотором слоте 80000 токенов и сейчас выполняются запросы в других слотах которым нужен полный kv-кеш, то эти 80000 токенов выгрузятся в cache-ram. А при получении запроса из этого слота и совпадения последовательности токенов вместо промт-процессинга на 80000 токенов оно просто подгрузит из ram весь нужный кеш. И только если размер сохранённой части превысит 8192 МБ, то наиболее старые слоты удалятся и их придётся регенерировать. Ну или что-то близкое по смыслу.

3. По умолчанию стоит parallel=auto, при котором kv-unified включается сам. То есть если я без дополнительных параметров запускаю указывая только длину контекста, то при получении двух или большего числа коротких запросов, оно может (если auto посчитает это допустимым - может быть там какая-то эвристика, что не всех стоит максимальное число делать. А может быть и просто до максимума забивает по сумме <текущее заполнение>+max_tokens, чтобы до самого конца генерации буферы влезали как они есть и их не требовалось переставлять) их выполнять одновременно, если оно влезет в общий буфер для кеша. Так же llama будет стараться сама определить подпоследовательность уже обработанного, чтобы выбрать нужный слот, и даже если параметр сходства, по которому можно настроить насколько близкие последовательности должны быть, чтобы выбрался какой-то слот.

Думаю флеш-гемини это что-то такое же, по крайне мере около 100B.

Ну-ка, ты может быть разбираешься. Скажи, в чём я не прав?

Я в llama.cpp ставлю:

--kv-unified

--parallel 10

-ctx 131072

--cache-ram 8192 (стоит по умолчанию)

1. В таком случае у меня будет общий кеш на 131072 токенов и максимум 10 последовательностей обрабатываются параллельно. В случае если падает 10 запросов с текущим контекстом по 1000 - они будут генерироваться параллельно. Если 10 каждый с текущим заполнением контекста по 50000 - то будут генерироваться только 2, которые влезут вместе.

2. Так же, если я использую слоты kv-кеша, то если в некотором слоте 80000 токенов и сейчас выполняются запросы в других слотах которым нужен полный kv-кеш, то эти 80000 токенов выгрузятся в cache-ram. А при получении запроса из этого слота и совпадения последовательности токенов вместо промт-процессинга на 80000 токенов оно просто подгрузит из ram весь нужный кеш. И только если размер сохранённой части превысит 8192 МБ, то наиболее старые слоты удалятся и их придётся регенерировать. Ну или что-то близкое по смыслу.

3. По умолчанию стоит parallel=auto, при котором kv-unified включается сам. То есть если я без дополнительных параметров запускаю указывая только длину контекста, то при получении двух или большего числа коротких запросов, оно может (если auto посчитает это допустимым - может быть там какая-то эвристика, что не всех стоит максимальное число делать. А может быть и просто до максимума забивает по сумме <текущее заполнение>+max_tokens, чтобы до самого конца генерации буферы влезали как они есть и их не требовалось переставлять) их выполнять одновременно, если оно влезет в общий буфер для кеша. Так же llama будет стараться сама определить подпоследовательность уже обработанного, чтобы выбрать нужный слот, и даже если параметр сходства, по которому можно настроить насколько близкие последовательности должны быть, чтобы выбрался какой-то слот.

Бля горшочек не вари я не успеваю всеми новыми игрушками пользоватся они слишком охуенные

Там на главной странице про лламу сразу написано. Мне кажется это пахнет тем, что поддержка уже есть.

Мне тоже нравится. Бенчмарки вроде прикольные.

Сука, 3 квант в 24 + 64 все равно не лезет, хотя казалось бы -40b в сравнении с квеном

>Мне тоже нравится. Бенчмарки вроде прикольные.

Да пиздец вообще. Я спать не успеваю спать от новых игрушек.

Вышел MiniMax M2.1 < хуясе, ничетак, сидит пердит можно оставлять одного без присмотра

Вышел GLM 4.7 < нихуясе, умный пиздец. для погромирования почти как Claude, только бесплатно

Вышел GLM 4.7 Flash < нихуясе, на говне мамонта имею 50тс и 128к контекста. можно оставить минут на 20 порефакторить проект

Вышел Kimi M2.5 < хуясе ебать, пизда мозгов палата, умудряется делат задачи с которыми раньше только гемини и ГПТ 5.2 справлялись

Теперь ещё эта хуйня вышла у которой бенчи выгядят интересно. быстрый мыслитель. нихуясе!

Я не успеваю этими игрушками пользоваться.

Я как пёс который попал в комнату с разноцветными воздушными шариками. Они все такие разноцветные и прыгают, сука, все такие привлекательные. У меня уже третью неделю пять часов сна всего, просто потому что не могу остановится от бега по кругу в этой комнате с шариками.

А, ну отлично... А вы уверены? У них на странице свой форк билдить нужно, лол.

>Ну-ка, ты может быть разбираешься.

Нет, я просто примерно представляю себе. Кстати, а зачем тебе эти слоты и параллельность?

Кумерам проще. Мне вот из перечисленного только GLM 4.7 зашёл. Остальное или не запустить, или слишком соевое, как минимакс.

А я так и не поставил минмакс.

Мне интересно насколько оно умеет в инструменты, текстовый чатик не интересно - стоит пробовать?

glm-4.7-flash капец машина, да. То есть я наверное вижу идеальную систему примерно, как то что есть glm-4.7 как архитектор, он выставляет задачи на 5-10 минут, а их исполняют флеши, который в рамках понятной задачи на 5 минут не накосячат.

Кими 2.5 это для кого-то другого моделька, мне кажется можно даже не смотреть, пока А100 на 80гб не посыпятся как V100 по 32гб сейчас.

С шариками всё верно.

Вот то что выше написал, rag/агентная система, где в параллеле делаются 4-10 мелких запросов попроще. Информационный век, надо развивать технологии обработки информации!

Типа, нужна инфа с сайта - эта штука вызывает инструмент, где есть url и цель (найти "условия для прорастания семян сельдерея", например).

1. Инструмент вызывает эту же нейронку, но с простым системным промтом и коротким контекстом, где указано что найди всю информацию про условия для прорастания семян сельдерея, а так же охарактеризуй качество источника информации и достоверность. В этом запросе отключён ризонинг - а на выходе он выдаёт 100-300 слов.

2. Открываются таким образом 5-10 сайтов одновременно. Все эти ответы падают в ещё одну ветку, где снова короткий системный промт, что обобщи информацию, и далее идёт эти 10 результатов по 100-300 слов, оно смотрит на информацию и её характер (что это форум, пост рандома или исследование какое-то).

3. Итоговый результат падает в исходную ветку, которая запросила поиск, при этом почти не заполняет водой эту ветку лишней информацией с сайта.

Миллион возможный функций про открытие изображение с сайтов или переход по ссылкам и интерактивные клики на сайтах сам придумаешь.

Аналогично можно с генерацией идей. Запускает 4 параллельных запроса с температурами 0.2, 0.8, 1.5 и 2.0 (с 2.0 можно сразу 2 или 3). Далее одним запросом результаты обобщаются (удаляются дубли). Потом по каждому варианту отдельным запрос идёт выполняется критика идеи, и вторым запросом выполняется подтверждение идеи. 8 запросов сразу. Далее выходит судья (4 судьи), сравнивает критику и подтверждения и выносит вердикт. Потом одна сетка это ранжирует и формирует итоговый результат.

Если вот такой шизой заниматься - вариантов где параллельные запросы полезны тьма, при этом эффективная скорость генерации где-то х4 получается, если есть 8 запросов параллельных по сравнению с вариантом, чтобы делать их последовательно.

Я пока не дописал удобное апи для такого, но мои полуручные тесты показываю, что такой подход пусть и ценой времени - но повышает полезность вывода на порядок, если не на два. Мне не в падлу подождать не 1 минуту, а 4 - если оно действительно найдёт мне как выращивать сельдерей, и при этом это не надо проверять, так как оно ещё и честно скажет, что источники такие себе и информация не особенно достоверная.

Забавно, что я вроде как программист, и казалось бы надо что-то под код писать - вот как анон выше, который выпускал эту тварь рефакторить код на 10 минут, а мне прям 0 интереса на код натравливать эту штуку - я очень люблю сам вручную писать. Хотя как проверка, чтобы в фоне диагностики проводилась на предмет забытых +1 или знака - вместо +.

Ну забилди, 5 минут делов.

Кванты у них уже есть кстати, можно хоть щас тестить, но я нищук и жду 3 квант

>rag/агентная система, где в параллеле делаются 4-10 мелких запросов попроще

Звучит ахуенно конечно, правда не понятно, где и как её применять.

>Ну забилди, 5 минут делов.

Ага, знаем эти 5 минут. 5 минут билда и 3 часа установки тулов/ебли с переменными сред/9000 других подводных камней.

>где и как её применять.

Я как умный дом поставлю дома.

Оно будет за меня составлять план как до куда доехать и искать в сети что-то. Ну а так же в фоне раз в день искать что интересное происходит.