Блять, оппик затроллил всех кто углубляется в мл через ютуб, как делают во всех других сферах программирования.

Ну чо там, когда уже будет учебник по математике?

Я еще раз всем напомню: смысла в машобе нет никакого, если у вас нет топового математического образования.

В ближайшие 2 года ожидается массовый наплыв макак в машоб и датасаенс, и чтобы с ними конкурировать, придется иметь топовое образование.

В ближайшие 2 года ожидается массовый наплыв макак в машоб и датасаенс, и чтобы с ними конкурировать, придется иметь топовое образование.

Да мл сложный для макак и сейчас не на хайпе. Сейчас буйство веба.

> Я еще раз всем напомню: смысла в машобе нет никакого, если у вас нет топового математического образования.

Если нет топовой бамажки, чтобы продать дяде жопу подороже, ты хотел сказать. Если торговля жопой не рассматривается, то даже и бамажка не нужна.

Ну да, мы тут все хотим продать себя задороха

Как будто с образованием там что-то светит. Почитай ODS, раздел welcome - 99% историй о себе суть два варианта:

1) Я колхозник, бухгалтерша, продавец говна, хочу многа денех, нихуя не умею, изучаю МАШЫНХ ЛЕРНИГХ.

2) Я учился в топ вузе, но слишком тупой, чтобы идти в академическую науку, и слишком кривожопый чтобы уметь писать нормальный код. Поэтому я теперь МАШИН ЛЕРНЕР, пишу статьи, участвую в КАГГЛЕ и всячески пиарюсь среди аудитории под номером 1.

И те и другие так и не вкатываются?

Меня интересует варик про колхозников? Работаю инженером в газовой промышленности, хочу перекатится.

Сам-то как думаешь? Если ты разрешения у меня пришел спросить, то высылай биткоин - разрешу, так и быть. Вероятность твоего успеха посчитать трудно, но там много нулей сначала идет.

Я же не Миллером там работаю, а обычной обслугой, подготавливаю расходомеры к продаже. Платят 60 к, так что сплю и вижу как перекачуть в АЙТИ!

А как же ЗП 100+ на старте? Вот это вот все! Не?

Ты немного меня обрадовал. Может будут брать таких каких сейчас на всякие софт-проекты берут.

> матанопетушня

Кто-то успешно выкатился, кто-то пошел в науку и преподавание. Самые успешные сидят в ресерч отделах за огромные деньги

Сколько в треде дешёвых шлюх.

Ну да, но мы хотим себя подороже продать

Сделайте нейроночку для распознавания лиц с фетальным алкогольным синдромом. Сразу можно будет отсеять для себя большую часть неблагонадежных людей, например.

Так она тебя в первую очередь отсеет, илитарий мамин.

Sup /b/ /pr/

Вопрос на отсос: можно ли вкатиться если вместо видеокарты красная затычка прошлого десятиления, но 10-ядерный китайский зион вместо проца?

Я так посмотрел сколько времени обучается тот же WaveNet на видеокарте и приуныл, пересчитав на GFLOP/s процессора...

Вопрос на отсос: можно ли вкатиться если вместо видеокарты красная затычка прошлого десятиления, но 10-ядерный китайский зион вместо проца?

Я так посмотрел сколько времени обучается тот же WaveNet на видеокарте и приуныл, пересчитав на GFLOP/s процессора...

Бери последнию модель от хуанга в SLI в кредит, только так ты можешь стать ДАЙТА САЙНТИСТОМ.

Шо, все так плохо?

Алсо? шо за жопа у радиков (GCN1-2) с OpenCL и у нейронок опять же с ним же? Чо все на куде сидят?

Удвою этого Господина, у меня двоюродный брат проходил курсы от Билайна по анализу данных, уже ближе к концу учебы ему препод сказал что есть подработка связанная с расчетами, но нужен компьютер серьезный. Вообщем брат залез в кредиты и купил себе дорогой комп, сейчас с этой халтуры и отбивает кредит. По любому у проф аналитика должен быть вычислительный комп, иначе ты просто не сможешь работать. Ну либо облако, но там тоже платить надо за мощности, для разовых вычислений может и норм, но на постоянке это не выгодно.

>10-ядерный китайский зион

ниачом, ЦПУ безнадежно отстали. Жди выхода нового поколения жфорсов и бери самый топовый. 32Гб основной памяти должно быть еще как минимум.

Да ебись оно конем, что за танцы криворуких макак нахер. Radeon HD 7870 2,5 Терафлопса в single-precision может выдать, но блять нихуя ничего не пашет, сука. Ебанные зеленые с их ебанной кудой. Ебанные макаки, которые кроме куды ничего не осилили.

на прошлой неделе была на хабре статья про это, там вроде keras прикрутили к амудям

Оно в итоге через жопу и сливает в два раза менее производительной невидии.

Мне на поржать, поэтому и пытаюсь на старом говне запустить шоб работало

зависит от того, в какую сферу ты вкатываться будешь, для вкатывания в картиночки или звук облака и селерона вместо процессора хватит.

Анончик, помоги найти нормальный гуид по реинфорсмент лернинх. На англе можно. Я всё уже пересмотрел и либо нормального гайда тупо нет, либо он сразу с тензорфлоу и подобным. Мне нужно чтобы без сторонних библиотек, чтобы самому можно было написать. Например нейросеть я написал на питоне по гайду с хабра. И тут хочу так же разобраться до мелочей.

Reinforcement Learning: An Introduction

Book by Andrew Barto and Richard S. Sutton

Помедитируй над уравнениями Хебба, потом почитай про Q-learning. Дипреинфорсментлернинх не сложнее, просто там входные данные посложнее - скриншоты вместо простых векторов итд.

Придумайте название для AI проехта.

AIProject.

AiSeptima

S05AI

AIIAX

> Придумайте название для AI проехта.

SoyBoyProject

IskeustvennbIy InteJlJlekt

Денег на облако нет. Зато есть ведро старых Радиков и мешок китайзионов на любой вкус.

PlaidML оказывается на любом говне работает, пошел ставить катализд и вперде к нейроночкам

Edwood

Так звали моего паладина в вовне.

Интересно как его зовут на самом деле.

Ну а вообще грустная правда в том что пока мамины вкатывальщики рефлексируют на дваче, то вот такие роберты хуеберты просто и без задней мысли проходят пару курсов и никого не стесняясь рассылают сотню резюме, и вкатываются в ойти.

>Беларуси

>Роберт

Кек.

>роберты хуеберты просто и без задней мысли проходят пару курсов и никого не стесняясь рассылают сотню резюме, и вкатываются в ойти.

Какая-то прохладная история

Ага, еще и миллионы денег у пендосов получит на стартап, как тут недавно пролетала новость про белорусов.

А если постоит на шоссе с табличкой Кожу за еду - может сам тим кук прочистит очко и даст гейфон.

Не, это так не работает.

Вкатиться без хотя бы какого-нибудь математического образования – все равно что пососать хуй в долгосрочной перспективе. Чуть что изменится, появятся новые технологии, и ты сразу же сосешь хуй, потому что все твои знания ограничиваются на питоне с библиотеками и правилах умножения/сложения матриц

> Чуть что изменится, появятся новые технологии, и ты сразу же сосешь хуй, потому что все твои знания ограничиваются на питоне с библиотеками и правилах умножения/сложения матриц

Будто в машобчике было, есть или будет что-то кроме умножения или сложения матриц.

Новых технологий не появлялось с прошлого века

Ничего кроме пиздежа я там не увидел, я тоже могу написать что я прохожу курсы такие то и хочу вот вкатиться на стажировку, и есть пара идей. И что? дальше что? таких даунов у нас полный тред.

Ну вообще парень для своих 15 лет смышленый

Я тебя умоляю, ты же не знаешь как он проходит эти курсы и как учится, может он вкл видео и сидит в носу ковыряет... И думает о я мамкин махинлернер, а по факту ничего не умеет и не может. И таких даунов хватает даже после прохождения курсов и сертификатов.

Любой человек с IQ > 120 освоит всю математику, которая нужна для маш оба за пару месяцев. Это я тебе как выпускник примата говорю.

Для выпусника нормальной школы там вообще почти ничего осваивать не надо.

Ну так такие дауны обычно в возрасте 20-24 лет, а этот вон.

Какая конкретно математика нужна? Можно исчерпывающие названия разделов математики и / или типовых методов, применяемых в 95% машоба?

Ты не сильно умный, да?

Листал /pr, зацепился взглядом за обобщение "всей математики, которая нужна для машоба". Любопытно.

Подумай, какой раздел математики изучает арифметику.

Мат. анализ за первый курс, основы линейной алгебры, основы теор вера.

Только для работы требуют стронг математикал бэкграунд от топ100 универов мира.

сорь с работой ты в пролете))

Я в топ100 универов мира))

А я закончил 9 классов церковно-приходской, работаю дворником и покупаю железо б/у китайское.

мимовкатывающийся в машоб

Где? fit(), predict() и чистить данные вилкой и обезьяну можно научить. Свои маня-фантазии оставь себе.

Бэкграунд от топ100 универов мира в чем? В вычислении производных? Или умножении матриц?

Где найти работу на полставки? Везде от 30 часов требуют.

На стажировку Яндекса трудно попасть? Я увидел у них "выберите 3 статьи и расскажите о них" и испугался.

На стажировку Яндекса трудно попасть? Я увидел у них "выберите 3 статьи и расскажите о них" и испугался.

в том, что ты не напомоечник))

Машоб это и есть помойка для дебилов, которые пишут пятистрочные скрипты. Или занимаются математикой уровня курсовой работы бакалавара.

грят, сидя на помоечке ты видишь вокруг одну лишь помоечку, это правда?))

Да, я посидел какое-то время, теперь со стороны смотрю.

Идея есть. Мир перевернёт, создаст полный ИИ, все проблемы решит.

Нет, тогда ты сам всё сделаешь быстрее меня, потому что я необходимые сферы знаю плохо и работаю хуёво и медленно.

Какие есть нерешённые проблемы Reinforcement Learning сейчас? Почему алгоритм обучения не универсален до сих пор?

>Почему алгоритм обучения не универсален до сих пор?

Потому что наличие целевой функции предполагает, что к глобальному оптимуму всегда можно добраться по её градиенту либо что локальные оптимумы почти равны глобальным, а стохастические оптимизации предполагают, что с их помощью, всегда можно выпрыгнут из локальных оптимумов и продолжить движение по градиенту к глобальному оптимуму. От все большая недооценка топологии реальных пространств оптимизации.

назови решенные проблемы reinforcement learning

Хотите открою секрет? В этом треде нет никого кто работает дата саентистом или машин лерниром, короче вот с этим говном, и получает за это деньги. Скринте. Тут только мечтатели и вкатывальщики бесконечные с синдромом студента.

Пруфы в студию. ссылочку на рт

Да, ты прав.

Я вот только поступил и только начинаю вкатываться. Надеюсь на 4 курсе поступлю в шад, если конечно осилю математику и меня не отчислят раньше.

Мне надоело страдать. Вы хоть там думаете как создать ИИ и прийти к технологической сингулярности?

Без тебя нихера не получается.

Человеку будут перерезать спинной мозг, подключать его к нейроинтерфейсу, затем с помощью боли и психоактивных веществ будут тренировать его нейросеть до исчезновения эго и полного подчинения командам, приходящим по интерфейсу. Вот и будет тебе ИИ, там уже и сингулярность не за горами.

Sup /pr/

Может кто знаком с лекциями и курсами (мат.анализ, линейная алгебра, теория вероятностей) подготовленными преподавателями Математической лаборатории имени П.Л.Чебышева? Если знакомы, стоит углубляться для понимания сабжа или это пустая трата времени?

Важно ли место жительства? Я так понимаю найти работу проще если получил высшее образование в Москве, или СПб?

Может кто знаком с лекциями и курсами (мат.анализ, линейная алгебра, теория вероятностей) подготовленными преподавателями Математической лаборатории имени П.Л.Чебышева? Если знакомы, стоит углубляться для понимания сабжа или это пустая трата времени?

Важно ли место жительства? Я так понимаю найти работу проще если получил высшее образование в Москве, или СПб?

Спасибо, похоже на правду. А теории игр всякие для эвристических штук не нужны?

Не нужны. Кроме перечисленного очень редко нужны самые основы вариационного исчисления (функционалы и операторы), бывает такая нотация, например, у Вапника. Но современные хипстеры в неё сами не могут, так что в целом можно и не заморачиваться.

>эти фантазии о подчинении человека машинами

Человек это белковый мешок с говном, взять с него нечего, кроме пердежа, он слабый, тупой и неэффективный механизм.

> Человек это белковый мешок с говном, взять с него нечего, кроме пердежа, он слабый, тупой и неэффективный механизм.

На твоём примере это особенно заметно, чучелок. В целом же вся наука и техника со всеми её достижениями - продукт человека. Если лично ты кроме говна и спама тут ничего не производить, это не причина считать твои кукареканья про человека в целом чем-то серьёзным.

>продукт человека

Сколько тебе, лет 25 есть? Значит за свою жизнь ты произвел больше двух тонн говна. Про другие твои достижения я не в курсе, извини.

Разжую еще раз свою мысль: машина, превосходящая по интеллекту человека, или хотя бы равноценная ему, никогда не будет пытаться подчинить человека. Потому что человека долго и дорого растить, обучать, воспитывать, он слаб, ленив,, капризен и легко выходит их строя, особенно в неблагоприятных условиях. Интеллект человека масштабируется очень плохо. Человек машинам просто не нужен.

>попытки рассуждать в человеческих категориях про хуйню, которая не будет "мыслить" человеческими категориями.

Я писал о подчинении людям, на базе которых и будет сделан ИИ. А эффективность их повысится с помощью reinforcement learning.

Так себе инновации

Черт возьми, как же сложно читать книгу по Deep Learning. Нужно было хорошо учить математику в школе и посещать лекции по вышке в университете. А теперь время ушло, мда.

Нужно просто сесть и ботать, сесть и ботать, пока все не поймешь досконально. Это гораздо труднее, чем, пожалуй, любая другая тема в CS.

Попробуй учебник по квантовой механике всерьез разобрать, после этого ДЛБ легко пойдет, лол.

Да мне учебник по арифметике и алгебре для начала нужно открыть. Эх, время упущено.

На самом деле можно без квантовой механики, просто хороший учебник по линалу, например, Кадомцева.

мимо теорфизик

> человека долго и дорого растить, обучать, воспитывать, он слаб, ленив,, капризен и легко выходит их строя, особенно в неблагоприятных условиях.

Шаламова читал? Он 20 лет в гулаге пахал в таких условиях, что нескольких роботов списали бы уже.

Я работал и получал на 3 курсе. Через пол года заебало и уволился. Сейчас фулл стэком работаю. Закончил ПМИ если что.

Вкатываюсь в машинное обучение, изучаю сейчас сверточные нейронные сети, в книжке kernel описывается записью 1x2x3

Поясните за эти числа, первые два это длина и ширина ядра, а что показывает третье число?

Поясните за эти числа, первые два это длина и ширина ядра, а что показывает третье число?

Количество фильтров, либо третье измерение если это 3д свертка.

Скорее всего высота, ширина, кол-во цветов.

Значит сам фильтр это такая 2d матрица размерами 1 и 2, и таких фильтров 3 штуки (1x2x3) и вместе они образуют ядро?

Коллега, как же вы могли не узнать алгоритм Такеши Содо и Бориса Митина?

> постят несмешное

> выгоняют адекватов

> чому остались только вкатывальщики?

> выгоняют адекватов

> чому остались только вкатывальщики?

У этого массива будет еще одно измерение - размерность входных данных. Если у тебя, например, ч/б картинка с одним значением на пиксель, то на первом слое будет как ты написал. Если она цветная с тремя значениями RGB в пикселях, то весь массив фильтров будет 3х1х2х3, где каждый фильтр это массив 3х1х2.

А что случилось? Закончились интересные задачи?

За эти полгода разобрался абсолютно во всех разделах ML и после этого интерес полностью пропал. По факту ты на работе будешь писать 20ти строчные скрипты на питоне, одни чистят данные вилкой, другие перебирают фичи/learning rate/оптимизатор и т.д, перезапуская обучение. Ничего интересного в этом нету, математика мне пригождалась максимум для того, чтобы дебажить модели. С теорией я после того как начал работать разобрался очень быстро, математика там детская, особенно после семестра функ анализа, поэтому розовые очки, нацепленные мне яндексом и прочими долбоебами слетели быстро.

По факту я считаю, что любой выпускник ПМИ может за месяц разобраться во всем, что нужно, для того чтобы применять ML в индустрии и свободно идти работать кем угодно, фулл стэком, и в любой момент, когда задачу лучше решить с помощью ml он просто решает ее с помощью ml. Идти отдельно работать ДАТА САЕНТИСТОМ это то, что кто-то писал выше - либо слесарь, который услышал, что на этом можно поднять бабла, либо горе-выпусник топ вуза, который не смог нормально в код.

фулл стэком, например*

Потому что ты так вскукарекнул?

Чем занимаешься? Пятистрочные скрипты пишешь?))))

А, ну десятистрочные скрипты, сорь)))

Чё такое эс?

Не пробовал решить задачи которые не были решены ранее в ИИ? Ведь в данный момент довольно не плохо развивается dl.

>dl

Чё это такое? Вы можете не пользоваться сокращениями, которые никто не знает?

Распознавание негров и котов.

Не решены.

На каких языках нейроночки пишут?

Там за последний год прирост на 0.02%

Если ты помнишь эти модели являются предсказательными, т.е. работают с вероятностями. Нет смысла ждать что эти модели будут давать истинные ответы в 100% случаях. Мало вероятно то, что от ошибок удастся избавится полностью, так как мы не живём мире чистой математики, логики или идеи.

Слыш, анон, что думаешь о книге Хайкина "Нейронные сети"? Стоит ли с нее начинать свое знакомство с машинным обучением? Почему? Стоит ли ее читать в дальнейшем (например после deeplearningbook.org)? Почему?

deep learning

>Хайкина "Нейронные сети"

>1994г.

Сам догадаешься?

Ну у меня второе издание, 99-го, изданное на русском в 2006-м, может еще не потеряло актуальность? И есть еще третье - 2009.

Если ты упрашиваешь меня разрешить тебе читать эту книгу, то цена вопроса - 0.5 биткоина.

Деньги - не проблема. Как передать их тебе?

На мой адрес шли: 173FKTCmwDvvnuTZhexUjkYpbqfBhGbg7Z

Как будет 6 подтверждений, я тебе сразу распишу, почему эта книга - единственное, что стоит читать. И ты сможешь читать ее с чувством глубокого удовлетворения.

готово

Есть БД сервиса с миллионом юзеров, нужно построить предсказательную модель, которая будет определять кто скоро может отписаться. Вопрос: как грамотно запилить фичи, соответствующие каким-то активностям юзера в разные периоды времени? Я даж хз как это у вас называется, чтобы гугол запрос сформулировать

Чет ничего пока не пришло.

А ты у нас xgboost руками пишешь? Или что? Все машинное обучение - вызов двух методов из библиотек - fit, predict. То, что ты занимаешься какими-то маняврированиями для того, чтобы убедить себя в том, что ты чем-то заумным занят никак на этот факт не влияет.

Диблернинх - это процентов 5 задач машоба, а именно - распознавание негров и котов. Тот факт, что весь хайп и все развитие именно в этой области объясняется тем, что барину нужен цифровой ГУЛАГ - тотальная слежка за всеми, для чего нужна обработка терабайтов данных с камер итд, та самая бихдата. NLP также развивается только в этом направлении. Так вот, их идеал - электронный мусор типа пелевинского Порфирия, который сам и следить за вами будет, и дела шить. Только полный дегрод этого не видит, ещё и верует, что это единственный возможный машоб.

Хайкин точно не для начинающих. У него глава про перцептроны интересная, остальное можно не читать.

Хайкин точно не для начинающих. У него глава про перцептроны интересная, остальное можно не читать.

> Расслабь батоны, технологиями на нейронках ни хуя у них не выйдет

Китайцы уже пилят систему, которая присваивает человеку рейтинг благонадежности в зависимости от его поведения. В технологии цифрового ГУЛАГа миллиарды вкладываются, как минимум, весь прогресс машоба идёт только в этом направлении. Так что все у них выйдет, не сразу конечно.

> Опять нет, там тишь и благодать, особенно все что касается русского языка.

Весь прогресс NLP это контекстная реклама и всякий сентимент анализ, что тоже элементарно использовать для составления профиля на человека и потом классификация по благонадежности.

> Смотря что подразумевать под NLP, для меня это семантика, вся современная залупа называющая себя NLP фактически хайпожорство.

Ну да, семантика. Чтобы автоматически следить за всем, что люди пишут. Сейчас самая топовая по НЛП контора - пейсбук аи ресерш, word2vec, вот это все. До этих алгоритмов вообще не было возможности строить модели с миллиардами слов. И по чистой случайности у того же цукерберга самая крупная соцсеть в мире. Весь хайп в машобе направлен на технологии, позволяющие гебне глубже залезть в жопу гражданину, глупо отрицать факт. Другие области применения вообще не развиваются.

В фейсбуке все силы аи ресерш идут на то, чтобы заставить хомяков больше кликать на рекламу. Да и в гугле тоже. Качество сервиса там уже третьем месте.

У них основная метрика - доход от рекламы, поэтому развивается направление так однобоко.

У нашей гэбни метрика - количество посадок, они и без диплернинха тебя набутылят, так что не переживай.

Вот кстати, ютуб недавно проанализировал свою йобабигдату на кластере из 100500 GPU, и пришли к выводу, что рекламу нужно сделать неотключаемой. Доходы ютуба и владельцев каналов только вырастут. Гениально, блядь!

> Это говно мягко говоря работает только на аналитических недоязыках как англопараша.

Тыскозал? У них на сайте готовые модели на 137 что ли языках. Это не ты тот дебилок, создающий в пораше треды про наружность английского?

> там это, статистика, семантикой там и не пахнет

Будто в семантике есть что-то кроме статистики. Смысл слова - это его использование в определённом контексте (в окружении других слов), что word2vec и восстанавливает по имеющимся данным. Или у тебя магическое мышление какое-то? Что по твоему есть семантика?

Пиздец ты тупень. Впрочем, для этой подмывальни норм. Написал хуйню и рад, ещё и кукарекает про предметную область.

Сейчас бы что-то доказывать чучелу, которое не знает как вообще skipgram тот же работает и что делает. Пример выше - лучшее подтверждение.

Боже мой, какая сложна область! Столько математики и различных формул - ничего не понятно! Уууууу...

мдааа бля лучше стану обычным прогером

Зачем в автоэнкодере морды лица выход сравнивают с warped входом, а не с оригиналом? В чем подвох?

ВСЕ ИННОВАЦИИ,

ВСЕ НОВЫЕ ТЕХНОЛОГИИ,

ВСЕ ДЕНЬГИ,

В ИТ БЛИЖАЙШИЕ 20 ЛЕТ БУДУТ ИДТИ ТОЛЬКО ИЗ МАШОБА.

Анон, у меня вопросик. Я вот на питоне написал свою нейросеть. Просто обучаю ее решать XOR. Так вот с однослойной сетью всё нормально. Но если я делаю больше одного скрытого слоя, то получается вот такая картина и обучение не двигается. В чем собсна проблема? Надо намного больше ждать или я где то объебался? Может с SGD дип лёрнинх не работает?)

Да нет, видна веселая тенденция на примере толоки. Те кто должен пахать как сучки на заводе сейчас сидят в тепленьких домиках и под пивас обучают нейросети.

То есть например люди решат что они хотят жить в домах. Они садятся за пол года обучают класс роботов которые умеют строить дома. Все, человечество навсегда обеспечено домами. Потом люди решают что они хотят пить пиво. Садятся и обучают класс роботов, которые умеют варить пиво. Теперь люди живут в домах и пьют пиво и нихера болтше не делают. Круто же ну?

Сори, но на толоке они не зарабатывают прожиточный минимум. Они просто сидят на шее у родителей. Когда родителей не станет, а до пенсии будет еще 20-30 лет, тогда и посмотрим что там их ждет на толоконном рыночке. Органы своих детей продавать будут.

Счастливая долгов жизнь ооо...

И не надо будет умирать...

Слыште бля, ни разу не работал с этими вашими нейросетками, но принцип работы понимаю. Хочу сделать сетку, которая будет генерировать мемы обучаясь на мемы парсящиеся из контактика. В этих мемах при помощи библиотеки васяна считывается текст, а пикча ищется в картинках гугла, чтобы по этом, по ответу на то, что на ней изображено сетка сама смогла искать и парсить картинки с гугла. Чо тут у вас за среды юзаются и кауие специальные языки? Как я понял, тут они не дефолтные.

Попробуй вот тут http://www.machinelearning.ru/wiki/index.php?title=%D0%90%D0%BB%D0%B3%D0%BE%D1%80%D0%B8%D1%82%D0%BC%D1%8B%2C_%D0%BC%D0%BE%D0%B4%D0%B5%D0%BB%D0%B8%2C_%D0%B0%D0%BB%D0%B3%D0%B5%D0%B1%D1%80%D1%8B лекцию "оценка вероятности и среднего".

>Все машинное обучение - вызов двух методов из библиотек - fit, predict

Пиздец.

Спасибо! Я так понимаю, что видео доступно только для его студентов, есть только эта статья: https://bijournal.hse.ru/data/2014/04/15/1320713004/8.pdf

Не знаю, что там с видео случилось, я когда-то спокойно смотрел. Там было то же самое, что и в презентации.

Вся анатомия это всунул-высунул.

Вся физика это упавшее на голову яблоко.

Я работаю и получаю как сеньер-программист, но по факту не кожу нонстопом, а имею возможность отдохнуть - тут обучение нужно подождать, там нанял людей для сбора данных и тоже ждешь. Это приятно, когда смотришь на программистишек, которые вынуждены постоянно кодить, меняя свое время на еду. А у меня скрипты из 10 строчек.

При развитии любой области есть два крайних подхода, хипстерский-хайповый, когда рисуются золотые горы, и двачерский депрессивно-старперский - когда говорится о том, что новое нихуя не новое, нового не бывает и вообще мир идет не туда.

Не правы оба подхода, но на двачах, естественно, дохуя токсичных старперов, которым лишь бы повыебываться. Predict, fit, данные вилкой. Хуита и понты это все. При чем основной загон идет из того, что просто заниматься бизнес-задачами, как в любом соседнем треде, здесь обязательно зашквар. Слесари, хули.

Что могу сказать, что индустрия не кагл, это анти-кагл, датасеты важны, и чем больше у тебя железа, тем важнее именно датасеты. Но "чистить данные вилкой и обезьяну можно научить" - это чушь. Нельзя. Даже банальные глюки на неграх - это проеб в данных, что говорить о чем-то более сложном и нерегулярном. Если брать изображения, нужно знать computer vision, если звук - DSP, и так далее. Добыча датасета - отдельная история, может понадобиться парсер нахуячить с мульитредингом и асинхронностью, может стать организовать толпу макак (как минимум дать хорошее ТЗ манагеру), скорее всего и то, и то, сначала парсером качаешь ютуб, потом макакингом это дело размечаешь. Один раз мне пришлось отреверсинжинирить формат проприетарной библиотеки файлов одного коммерческого продукта. Это весело, веселее, чем лепить бесконечные круды и фронтэнд к ним.

>Я еще раз всем напомню: смысла в машобе нет никакого, если у вас нет топового математического образования.

Это чушь. В машобе не больше математики, чем в химии. То есть она есть, но хорошим химиком тебя математика не сделает. Нужна интуиция прежде всего. Она нарабатывается за счет IQ и опыта. При чем опыт это не только мысли, какую архитектуру выбрать, но и организация процесса исследования. Без опыта любая проблема кажется нерешаемой - загрузил датасет, нажал fit, а у тебя результат чуть лучше подбрасывания монетки. И что дальше?

>В ближайшие 2 года ожидается массовый наплыв макак в машоб и датасаенс, и чтобы с ними конкурировать, придется иметь топовое образование.

Как под копирку из перезвоним-треда о программировании в целом. Да и ИТТ пару лет назад те же самые разговоры были про СКОРО. Спойлер: нихуя не будет и это маняоправдания, лишь бы ничего не делать.

>Как будто с образованием там что-то светит. Почитай ODS, раздел welcome - 99% историй о себе суть два варианта:

Это даже не ошибка выжившего, это... не знаю, ошибка еще не летавшего?

Решены. Это вот типично старперский выебон. Стыдно быть таким.

>Диблернинх - это процентов 5 задач машоба, а именно - распознавание негров и котов.

Сейчас в весь машоб пропихиваются нейронки, потому что они способны давать фичи даже для банального knn. С нейронками веселее везде.

Еще обработка сигналов. Вон nvidia уже ускоряют рейтрейсинг, фильтруя шумное изображения с недостаточным числом лучей. Применений до жопы. Если в твоем городе работодатели делают очередной object detection, то можно посочувствовать. По мне лучший способ вкатиться - это уже работая на фирме предложить конкретное решение конкретной задачи фирмы.

> Сейчас в весь машоб пропихиваются нейронки, потому что они способны давать фичи даже для банального knn. С нейронками веселее везде.

Пропихивается только то, что нвидии продажи поднимет. Вопрос в другом - что дал диплернинх по сравнению с другими алгоритмами машоба в областях, не связанных с картинками, неграми и котами? Прогнозирование временных рядов, детекция отклонений в работе промышленного оборудования, анализ физиологических сигналов, ЭКГ там, это все, итд. Хуй да нихуя. Более того, существуют дегроды, которые веруют, что эти задачи и не нужны, нужно только распознавание с камер, сентимент анализ и прочие технологии цифрового ГУЛАГа.

>99% из которых это впаривание рекламы, 0.1% детектирование негров с хуевым результатом, 0.8% остальная нерабочая хуета,. Ты точно не школьник?

С дивана тебе конечно охуенно видна статистика.

>Вопрос в другом - что дал диплернинх по сравнению с другими алгоритмами машоба в областях, не связанных с картинками, неграми и котами

Вопрос в другом: что дал питон по сравнению с другими языками в областях, не связанных с вебом и машобом. Программирование атомных реакторов, игры для восьмибитных платформ, МК61. Хуй да нихуя.

Ты заебал с этой старперской демагогией, которая создана исключительно, чтобы щекотать твое ЧСВ. Ты - говно, запомни это.

Спасти. Манямирок. Любой. Ценой.

> Ты заебал с этой старперской демагогией, которая создана исключительно, чтобы щекотать твое ЧСВ. Ты - говно, запомни это.

Это не демагогия, это неприятная правда. Нынешний хипстерский хайп по впариванию продукции нвидия к машобу относится очень косвенно. За последние лет 5-10 весь прогресс - увеличение продаж нвидии на десятки % и улучшение распознавания негров на пару %. Дурочки же вроде тебя уверовали что нынешнее сойбойство это и есть весь возможный машоб и его вершина, а все остальное - устаревшая хуйня.

Что такое пятистрочник, мимо пробегал.

топовый совет: покупайте акции нвидии пока вся эта хуйня не ебнется - последний год +50% в далларах

>топовый совет: покупайте акции нвидии пока вся эта хуйня не ебнется - последний год +50% в далларах

Она сейчас уже децл подупадет из-за рейтрейсинга вместо попугаев, надо было на хайпе 2 года назад вкатывать.

За последние 10 лет на пару процентов? Манямирок не треснет? За последние 10 лет задача распознавания с уровня неюзабельная хуйня превратилась в решенную задачу. И только где-то с реснетов уже не представляет особого интереса. Потому что ее решили. И давно пошли вперед. Только чсвшным демагогам на это похуй, они старательно охраняют свой манямирок.

Демагог перешел на whataboutism. Как предсказуемо.

Игрушечный imagenet научились распознавать на 20% лучше, ебать достижение, апплодирую стоя. Ты наверное и сам понимаешь, что весь этот маняпрогресс - следствие увеличенных в разы вычислительных мощностей. Что в самих нейроночках улучшили? Релу вместо сигмоидов? Все это не более чем асимптотически-эффективные методы повышения качества, которые Вапник ещё в 60-х годах обоссал, ибо это математически обоснованный путь в никуда. Нвидии продажи поднимете, а негры так и будут бугуртить, что их гугл классифицирует как горилл.

>с уровня неюзабельная чепуха превратилась в решенную задачу

Но ведь это неправда. Я сейчас гоняю разные face detection на хорошем видео, обсираются абсолютно все.

нет, это не реальная задача, а никому не нужна ерунда (которая требует получения авторских прав, и которую без разрешения издательства даже выполнять нельзя) как и весь русский язык

Речь шла о распознавании негров, а не OCR. Поэтому то, что ты заявляешь, это whataboutism. Когда решат OCR, ты будешь ныть, что нейронки не распознают рукописный текст, написанный пьяным сантехником Васей на иврите.

>Речь шла о распознавании негров, а не OCR.

С неграми тоже все далеко от идеала.

карточка нвидиа просто считает матрицы, на которых ты можешь считать и свм, и деревья и новый метод, который ты придумаешь и который заменит нейронки хоть в одной из обозначенных тобою областей

Маняпрогресс - это твое нытье на протяжении нескольких лет.

Не "научились распознавать на 20% лучше", а уменьшили ошибку в 8.5 раз и довели ее до уровня ниже человеческого. По сравнению с тем, что было в 2011 (25% ошибок - ну получше, чем бросать монетку, да) - это пиздец какой прогресс.

>Что в самих нейроночках улучшили?

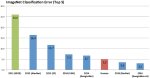

relu, inception (2014), residual connections (2015), batch normalization (2015), adam (2014) - это только по классификации, только то, что лежит на поверхности. С 2011 как минимум раз в год было крупное улучшение. Потом, после 2015, классификация перестала быть интересна - есть задача, составляй датасет и ебашь. Там эти проценты упираются в свойства самого датасета и дроч вокруг них. Это да, скучно. Но прогресс пошел в оптимизации под мобильные платформы, в смежных задачах типа object detection и segmentation и т. д.

>inception (2014)

Всякую хуйню под собачек и бананы разрисовывать - это в 2015 было, в июле. И в каком же месте это улучшение? Все, что ты про улучшения написал - это попытки подкрасить покойника, чтобы не так пиздецки выглядел. Это не решает главную проблему нейроночек -

>Все это не более чем асимптотически-эффективные методы повышения качества,

а просто немного замазывает ее.

>Но прогресс пошел в оптимизации под мобильные платформы, в смежных задачах типа object detection и segmentation и т. д.

Т.е. в область, актуальную только для цифрового гулага.

>Всякую хуйню под собачек и бананы разрисовывать

Вся суть. Для специалиста inception - это вид архитектуры, которая дает меньше параметров при том же перформансе (смотри пикрелейтед - архитектуры типа inception являются топовыми для заданного числа операций, дальнейший шаг - automl). А у тебя ассоциация - хайпожорские мемасики. Поэтому ты вокруг всех хайпожорами и называешь - реальных-то знаний ноль.

>Все, что ты про улучшения написал - это попытки подкрасить покойника, чтобы не так пиздецки выглядел.

Нет, это охуенные улучшения, которые ты не принимаешь, будучи цифровым луддитом. Каждое уменьшало ошибку ну хотя бы в два раза.

>Т.е. в область, актуальную только для цифрового гулага.

Confirmation bias

>Нет, это охуенные улучшения, которые ты не принимаешь, будучи цифровым луддитом. Каждое уменьшало ошибку ну хотя бы в два раза.

Ты просто не видишь в этом повторение старых попыток так же подмазать перцептроны, у Хайкина например хорошо описаны все эти optimal brain damage, optimal brain surgery и прочая уличная магия с оптимизацией структуры перцептронов. Все это тоже давало какие-то смешные % к качеству, и кто сейчас, в 2018 обо всех этих алгоритмах помнит кроме 1,5 читателей Хайкина? Сейчас то же самое с поправкой на масштабы, как я писал, барину нужен цифровой мусор, который будет следить за всеми, отсюда и гранты и финансирование и прочий хайп. Ты просто не можешь взглянуть на ситуацию со стороны.

Эта задача сложнее "распознавания негров", потому что негр распознается вне контекста feed forward нейронкой за один прием. Текст же воспринимается не так. Если тебе дать некачественный текст, разбить его на символы и дать его распознавать посимвольно в случайном порядке, ты соснешь, потому что ты, читая текст, видишь контекст - слово (а взрослый человек читает словами целиком) в предложении.

Поэтому для OCR нужна комбинация из CNN и RNN-сетки - а значит и языковые модели и много чего прочего. По уровню это примерно как научить младенца отличать кошку от собаки и научить его же читать слова кошка и собака. Если ты думаешь, что OCR - "это наиболее простая прикладная задача для кампутервижен", то, как я и писал выше, с дивана охуенно рассуждать.

>вот рекомендация хрючева рчередной потребляди это да, это огого

С чего ты взял, что recommender systems массово реализуются на нейронках?

что такое машоб?

>пиздецки нереально

>кетай уже реализовал

Правильно написать "кто об этом помнит, кроме меня, любимого, я круче вас, лошки-слесари". Ты просто не можешь взглянуть ситуацию за пределами своего охуевшего ЧСВ. А я могу, потому что мне в общем-то похуй. Если бы мне платили за гулаг, я бы работал на гулаг. Но мне не платят за гулаг, мне платят за другое. И предложения по работе падают за другое.

Я напишу тебе, что писал больше года назад: взял бы очередного нафталинового автора, нашел бы забытую магию, имплементировал ее и победил в ILSVRC. Однако за все эти несколько лет ты так нихуя и не сделал. И ответ на эту загадку: ты натягиваешь сову на глобус и тебе кажется, что люди писали об одном и том же, задним умом. На самом деле это нихуя не так. Какие-то общие предпосылки могут быть, но не конкретные вещи. У меня, например, в моей архитектуре используются формулы середины прошлого века для инициализации некоторых параметров. Значит ли это, что это не я придумал ноу-хау, а люди из середины прошлого века? Нет, не значит. А то так можно докопаться до того, что все придумал лично Фурье. Это демагогия. Любой научный прогресс на чем-то стоит, но из этого стояния не следует, что он отсутствует.

В общем, есть луддит, отрицающий промышленную революцию в Англии только из-за существования парового двигателя Герона. Факт в том, что Герон не додумался до промышленной революции, а в Англии до нее додумались. Дальше луддит рассуждает о том, что Герон-то охуенчик, только у него не было хорошей стали, а современная революция - это не революция вовсе, это так, хуйня. Вокруг между тем мир меняется стремительно, паровозы появляются, пароходы - хуевые, они не могут даже уголь перевезти, на котором едут, но луддит продолжает отрицать наличие какого-либо прогресса со времен Герона Александрийского.

это твоя помоечка

>Круто же ну?

Конечно, круто. Приходит барин и говорит, теперь на дома построенные роботами налог, а также налог на пиво и самих роботов, налог на видеокарты и вообще все потенциально опасные эвм надо регистрировать.

>Я напишу тебе, что писал больше года назад: взял бы очередного нафталинового автора, нашел бы забытую магию, имплементировал ее и победил в ILSVRC. Однако за все эти несколько лет ты так нихуя и не сделал.

Я тут неоднократно описывал не только забытую магию, но и свои идеи. А так же писал, что не осилю написать имплементацию. Никто не заинтересовался.

>В машобе не больше математики, чем в химии.

так-то да но в вакансиях в требованиях зачастую пишут

сильная математическая подготовка

или

высокая мат грамотность

чо они хотят?

чтоб я был ниибаца математиком?

или просто чтоб не был дата обезьяной?

> лудиты лудиты старперы вы все лудиты мам

Сколько бетховенов-то в семнадцатом купил, прогрессор?

Была бы востребована, были бы приложения хотя бы на правилах и opencv, а не один ABBYY. Даже Гугл бросил оцифровывать весь этот библиотечный фонд, так как везде копирайт, все достойные научные работы оцифрованы. Ни одного повода, зачем это нужно, кроме своих хотелок, ты никогда не приводил.

Если большая компания и хороший миддл, то хотят, чтобы ты в лстм мог расписать бэк-пропегейшн с батч-нормализацией - вопросы такого уровня, если джуниор, то просто не хуже интервьюера, особенно его любимую область, а это уровень от троечника в школе, до олимпиадника

это как с тянками - пока ты мнешься с ноги на ногу и не можешь ей признаться Роберт хватает её и просто ебёт

слишком толсто, попробуй ещё

Это хуйня, ты в итоге все равно будешь как даун пятистрочники писать, просто повод платить поменьше.

Сверху "получаю как синиор" написал, что большая часть кода - это обработка данных. И если ты посмотришь кернелы на каггле, там не 5-строчек, а в районе 100-500, но больше 1000-строк у меня, например, почти нет скриптов - это да. Но на питоне много все равно не пишут, в gensim word2vec.py - это 2000 строк.

Или ты хочешь сказать, что на Джанге прям много строк пишут?

Частично это объясняется крайней высокоуровневостью питона, так как не нужно писать фабрику фабрики классов и передавать указатель на указатель для хэллоуворлда, частично тем, что на Питоне не пишут десктоп и сложную бизнес-логику.

Ну, и вы надоели, был давным-давно нормальный тред - а теперь ерунда, даже на пикабу лучше машоб тред, чем здесь. Что вам мешает обсуждать не нейронки, а другие вапникоугодные методы, которыми решаются стоящие задачи и продемонстрировать их на гитхабе? Так сказать, просвятить массы. Если кто-нибудь продемонстрировал бы, что какая-нибудь фаззи-логика работала бы на практике лучше других методов, был бы хайп по ней (хотя по ней на самом деле по нечеткой логике был хайп, просто утята с тех пор не перестроились).

Ты понимаешь, что про глубокое обучение трубят из всех труб и это как бы огромная тема, а о существовании метода опорных векторов и нечеткой логики знают лишь "избранные".

К чему эти картинки?

>Ты понимаешь, что про глубокое обучение трубят из всех труб и это как бы огромная тема, а о существовании метода опорных векторов и нечеткой логики знают лишь "избранные".

Ты ебанулся. SVM проходится в любом курсе по ML до персептрона, не говоря уже о DL.

>Сверху "получаю как синиор" написал, что большая часть кода - это обработка данных. И если ты посмотришь кернелы на каггле, там не 5-строчек, а в районе 100-500, но больше 1000-строк у меня, например, почти нет скриптов - это да.

Ну у меня в model.py 251 строчка, один хрен это очень мало с точки зрения ментального здоровья программиста.

>Ну, и вы надоели, был давным-давно нормальный тред

Хуй знает, сколько ни заходил бы, всё время нытье об отсутствии прогресса. Это нормально для двачей и его публики.

>Если кто-нибудь продемонстрировал бы, что какая-нибудь фаззи-логика работала бы на практике лучше других методов,

Я в одном из предыдущих тредов постил ссылку на пейпер, в котором показано, что квантовая логика тривиально представима в виде нечеткой, даже менять ничего не нужно, просто соотнести термины. Т.е. квантовые вычисления, за которыми будущее - это просто другое название нечеткой логики.

Луддиту с мейлру-то виднее.

Кстати, по поводу Вапника и ДЛ, нашел прекрасные рассуждения здесь https://cs.stackexchange.com/questions/75327/why-is-deep-learning-hyped-despite-bad-vc-dimension

Приходит такой петушок со словом ХАЙП в заголовке вопроса, а в ответах его дружно кормят хуями, а он как попугай продолжает повторять, что ДЛ-сети не умеют обобщать. Напоминает местных экспертов с мировым именем.

Приходит такой петушок со словом ХАЙП в заголовке вопроса, а в ответах его дружно кормят хуями, а он как попугай продолжает повторять, что ДЛ-сети не умеют обобщать. Напоминает местных экспертов с мировым именем.

Ты дурак?

Любая домохозяйка слышала о DL. Любая ли домохозяйка слышала о SVM?

Ты понимаешь, что гуглом пользуется не только люди которые курсы проходили?

>Любая домохозяйка слышала о DL

Много домохозяек знаешь, которые сразу бегут гуглить хуйню от журнализдов?

>прекрасные рассуждения

>The answer why CNNs are used is simple: CNNs work much better than anything else.

>It's not really understood why deep learning works as well as it does,

>Приходит такой петушок со словом ХАЙП в заголовке вопроса, а в ответах его дружно кормят хуями

Рассказывая, что диблернинх это магия такая, никто не понимает как оно работает, но как-то вот работает. Это религия называется. И я уже сто раз писал, в какой области оно "лучше"-то? В распознавании негров?

Тебе на графике наглядно показали, что "фаззи-логика работала бы на практике лучше других методов, был бы хайп по ней (хотя по ней на самом деле по нечеткой логике был хайп, просто утята с тех пор не перестроились).". Хайп по нечеткой логике действительно был, ты просто тогда еще не родился, а с тех пор хайп ушел, потому что никаких прорывов она не дала.

Вот, например: https://old.computerra.ru/2001/415/198010/

Популярный бумажный компьютерный журнал пишет об этом в 2001 году.

>Рассказывая, что диблернинх это магия такая, никто не понимает как оно работает, но как-то вот работает.

В этом плане дипленинг как квантовая механика, он работает и все. Чтобы понять, как он работает, нужны столетия исследований manifold'ов. Это не религия, он достоверно и воспроизводимо работает на куче разных задач.

>И я уже сто раз писал, в какой области оно "лучше"-то?

А в какой он ХУЖЕ чего бы то ни было?

>Чтобы понять, как он работает, нужны столетия исследований manifold'ов

Наркоман ты что ли? Там нет ничего кроме умножения матриц, какие столетия исследований? Насчет "работала бы лучше всего остального", ты про "no free lunch theorem" что-нибудь слышал? Нет методов, работающих лучше всех во всех вообще применениях. Диплернинх лучше всех только в технологиях цифрового гулага, отсюда и хайп.

Хайп надо искать по arxiv, а не по трендам гугла

> Там нет ничего кроме умножения матриц, какие столетия исследований?

Лол. Есть - нелинейные операторы. Если бы там были одни матрицы, любая нейронка бы сводилась к линейному классификатору. А если ты это знал, то ты совсем того - посмотри на фрактал жулиа, может поймешь, какие красоты создает пара нелинейных действий.

> Насчет "работала бы лучше всего остального", ты про "no free lunch theorem" что-нибудь слышал?

Я-то слышал. А ты?

>Нет методов, работающих лучше всех во всех вообще применениях

Нет целевых функций, которые сходятся быстрее всех на всех датасетах. Из этого не следует ничего. Начиная с того, что дл это не целевая функция.

>Диплернинх лучше всех только в технологиях цифрового гулага, отсюда и хайп.

Confirmation bias. Я назову тебе кучу применений, которые никакого отношения к слежке не имеют, но ты в очередной раз это проигноришь.

да, хотя бы в распознавании негров, а еще в распознавании и синтезе речи, игре в атари и го, в синтезе изображений - области, на которых до сих пор держится основной хайп. Ты только зайди и посмотри автоматические субтитры на ютубе для английского.

раньше люди мечтали о том, чтобы распознавать негров, но почему-то не могли

http://www.image-net.org/challenges/LSVRC/2010/ILSVRC2010_NEC-UIUC.pdf

Вот тогда и поговорим/Вы находитесь здесь

Какие же отрицатели прогресса одинаковые

То есть прикол в чем, сейчас луддитам нужно, чтобы нейронка не делала ошибок как носитель языка. Не меньше. Не будет - вот тогда и поговорим. Тогда луддит будет вонять еще по какому-либо поводу - например что акцент не тот.

>То есть прикол в чем, сейчас луддитам нужно, чтобы нейронка не делала ошибок как носитель языка. Не меньше. Не будет - вот тогда и поговорим. Тогда луддит будет вонять еще по какому-либо поводу - например что акцент не тот.

Да ладно, хоть бы вообще что-то работоспособное было. Если все так заебись с синтезом речи, где можно послушать озвучивание текста например?

>ты про "no free lunch theorem" что-нибудь слышал?

бля ,чел ты хуйню сказал

определение-то правильное но в таком контексте....

пример включает докладчик ровно на 4 часу =/

> для синтеза есть простые и рабочие решения без нейроговна

Речь шла о том, что в области дл есть только инструменты слежки. Как только тебе дали что-то другое - ты сменил тему. То есть оказывается ты просто тупой и неадекватный хейтер.

Что касается аргумента "Нахуя нам паровоз, мы и на лошадях справляемся", то он такой же как "ну вот тогда и поговооим".

И Коско на ваш диплернинх помочился https://www.edge.org/response-detail/26200 он тоже луддит, да? Тезисно:

>Machines don't think. They approximate functions. They turn inputs into outputs.

>"Intelligent" machines approximate complex functions that deal with patterns.

>The real advance has been in the number-crunching power of digital computers. That has come from the steady Moore's-law doubling of circuit density every two years or so. It has not come from any fundamentally new algorithms. That exponential rise in crunch power lets ordinary looking computers tackle tougher problems of big data and pattern recognition.

>Punchline: Both of these popular AI algorithms are special cases of the same standard algorithm of modern statistics—the expectation-maximization (EM) algorithm. So any purported intelligence involved is just ordinary statistics after all.

>It's a good bet that tomorrow's thinking machines will look a lot like today's—old algorithms running on faster computers.

Машобчик никуда не ушел от классической статистики, и вряд ли вообще уйдет. Весь этот ваш диблернинх - частный случай expectation-maximization (EM) algorithm. Нет никакой магии, есть закон Мура, который позволяет наращивать вычислительные мощности для асимптотически-эффективных решений, поэтому негры в 2018 году распознаются существенно лучше, чем в 2010.

>Machines don't think. They approximate functions. They turn inputs into outputs.

>"Intelligent" machines approximate complex functions that deal with patterns.

>The real advance has been in the number-crunching power of digital computers. That has come from the steady Moore's-law doubling of circuit density every two years or so. It has not come from any fundamentally new algorithms. That exponential rise in crunch power lets ordinary looking computers tackle tougher problems of big data and pattern recognition.

>Punchline: Both of these popular AI algorithms are special cases of the same standard algorithm of modern statistics—the expectation-maximization (EM) algorithm. So any purported intelligence involved is just ordinary statistics after all.

>It's a good bet that tomorrow's thinking machines will look a lot like today's—old algorithms running on faster computers.

Машобчик никуда не ушел от классической статистики, и вряд ли вообще уйдет. Весь этот ваш диблернинх - частный случай expectation-maximization (EM) algorithm. Нет никакой магии, есть закон Мура, который позволяет наращивать вычислительные мощности для асимптотически-эффективных решений, поэтому негры в 2018 году распознаются существенно лучше, чем в 2010.

удачи

ты всех изрядно заебал

Продолжаем whataboutism. Будучи накормленным хуями по фактам луддит несет очередные черрипикнутые священные писания и предлагает побороться с копипастой.

А что не так-то? Или ты правда веруешь, что в машобчике есть что-то кроме аппроксимации функций?

У нас была тема разговора, к какому конкретно моему тезису ты это принес? Если ни к какому, не пытайся уводить тему.

>к какому конкретно моему тезису ты это принес?

К тому, что надо сотни лет изучать, как диплернинх работает, и ссылаться на какие-то ранние работы - это луддизм.

>expectation-maximization (EM) algorithm.

В каком месте?

Ну на фото либо негр, либо нет. Задача диплернинха в данном случае связать фичи, представляющие негра с соотв. тегом "негр".

>К тому, что надо сотни лет изучать, как диплернинх работает

Да и никакого контраргумента в статье по ссылке нет.

>ссылаться на какие-то ранние работы - это луддизм

Цитату. Ты ее не найдешь, потому что я такого не писал.

Ты кажется не понимаешь что такое EM

Вот мост. Конструктор когда его проектирует, максимизирует ожидание того, что мост не упадет. Вывод - вся инженерная деятельность это EM, а каждому статистику полагается миллион грантов и 72 девственницы.

> Весь этот ваш диблернинх - частный случай expectation-maximization (EM) algorithm.

Да, но какая разница? Дип лернинг есть, он работает для большого класса задач (да-да, негров и речь распознает лучше других методов) , магии нет, в чем проблема?

Вон внизу даже статья Хинтона

https://stats.stackexchange.com/questions/45652/what-is-the-difference-between-em-and-gradient-ascent

>лучше других методов) ,

Любимая мантра. Знаешь, почему лучше? Потому что его гоняют на топовых видюхах. Еще Лекун писал, что ленет может ровно то же, что и полносвязный перцептрон с той разницей, что перцептрон таких размеров любое железо раком поставит. И опять вспомню неприятный вопрос - а что насчет задач не связанных с неграми, временные ряды те же? На неграх он лучше работает только потому, что функция, представляющая негра (наборы фич) в разы сложнее, чем state-space представление временного ряда и для ее более-менее успешной аппроксимации нужен вот более сложный аппроксиматор.

и? если взять любой алгоритм с бесконечным количеством параметров и регуляризацией, то он сможет обучиться достаточно неплохо, но, как ты правильно заметил, это невозможно, поэтому приходиться использовать аппроксимации, а так как простые объекты уже изучили и решили аналитическими и эвристическими методами, остались только сложные, которые требуют соответствующих аппроксиматоров, которые можно обучить до тепловой смерти вселенной.

Звук - временной ряд, на котором нейронки работают лучше свм и деревьев и остальных альтернатив, если тебе не нравится

>лучше других методов) ,

Для длинных временных рядов решений пока нет, но их нет вообще, а не только среди нейронок, поэтому и сидят люди в ворлдквантах и придумывают сигналы, как в 90ых-2000ых делали для картинок и звука

гыгыгы бля лол хуета

Реально ли создать нейронку уровня /b/ одному?

Прогал на питоне, знания матана на данный момент слабоваты.

Прогал на питоне, знания матана на данный момент слабоваты.

ты и есть нейронка

>Реально ли создать нейронку уровня /b/ одному?

Легко, если ты понимаешь, как оно работает. Начни с теории. Как сможешь на бумаге расписать бекпропагейшн и все необходимые уравнение - напишешь на чем угодно за пару часов.

А можно вкатится без матана, просто почитав книжек по тензорфлов?

Биткоин плати и вкатывайся.

>Знаешь, почему лучше? Потому что его гоняют на топовых видюхах.

Но ведь ничто мешает гонять на топовой видюхе любой другой метод. Что, так твои убер-методы НЕ МАСШТАБИРУЮТСЯ для больших датасетов что ли, лол? Смешной ты))

Нет, всякие лесисто-дровяные изделия масштабируются, ну так они тоже в мейнстриме. При чем это леса лучше решают задачу по обработке контекстной рекламы и анализа профилей в социальных сетях (потому что нейронки лучше работают с непрерывными данными из-за своей природы), но раз организм велит нейронки хейтить, то хули тут думать.

То есть вот какая хуйня произошла, компьютеры стали более быстрыми, датасеты более большими, на них серьезные люди делают серьезные задачи разными методами, но хейтят именно нейронки. Почему? Потому что не в нейронках дело, а в том, что у кого-то бомбит на само явление хайпа. Нейронки хороши, но раз они так показательно хороши (задачи типа style transfer или генерации речи wavenet'ом с имитацией даже дыхания), то их нужно хейтить. Не потому что они плохо работают, а потому что о них много говорят. Фу такими быть.

>Еще Лекун писал, что ленет может ровно то же, что и полносвязный перцептрон

Неправильно, ленет может меньше, чем полносвязный перцептрон. Ведь у него меньше параметров. Это полносвязный перцептрон с соответствующим количеством слоев и нейронов может столько же - если ты сумеешь его обучить. Сумеешь ли?

>перцептрон таких размеров любое железо раком поставит.

Неправильно. LeNet это вход 28x28x1, затем сверточный слой 3х3х20, макспулинг, слой 3x3x50, макспулинг и полносвязный слой c 500 выходами.

То есть, можно трансформировать его в следующую нейронку:

Вход 28=28=784 нейронов, затем полносвязный слой из 202828=15680 нейронов, макспулинг, затем полносвязный слой из 501414=9800 нейронов, макспулинг и затем полносвязный слой из 500 нейронов. Ничего особенного, современное железо это тянет. Если подумать, можно и от пулинга избавиться, но мне лень.

В общем, архитектура такая будет возможна, но как этот перцептрон обучать? Все дело в том, что архитектура сверточных сетей содержит в себе регуляризацию, а именно, инвариантность к перемещению для всех слоев, кроме последнего. У полносвязной сети такого не будет - она не имеет такой информации о мире. Поэтому несмотря на то, что обученную LeNet можно конвертнуть в такой перспектрон и оно будет работать, обучить такой персептрон будет гораздо сложнее и дольше - потому что в его архитектуру не зашита эта самая инвариантность.

>И опять вспомню неприятный вопрос - а что насчет задач не связанных с неграми, временные ряды те же

Пошел опять whataboutism. Так это ты ответь, что насчет. Какой метод лучше нейронок при анализе временных рядов?

Нет такого. Твоя позиция барская - сел, ноги на стол и такой "несите-ка мне хуйню, которая позволит на бирже миллиарды зарабатывать, да побыстрее. Что, нейронки не могут это сделать? Ну так говно ваши нейронки". Подразумевая, что ты по старинке уже миллиарды на этой самой бирже заработал. Нихуя же не так, нейронки это state of art анализа временных рядов, а если они работают хуево (что, вообще говоря, не так - я работаю с одномерными данными, например), то остальные методы еще хуже.

>На неграх он лучше работает только потому, что функция, представляющая негра (наборы фич) в разы сложнее, чем state-space представление временного ряда и для ее более-менее успешной аппроксимации нужен вот более сложный аппроксиматор.

Я тебе сейчас объясню твою фундаментальную ошибку, как батя, а ты меня выслушаешь и проигноришь из-за когнитивных искажений, ну да похуй.

1. Сложность аппроксиматора особо неинтересна. Они уже все безумно сложны настолько, чтобы тупо запоминать датасет и это не предел. Сложный аппроксиматор легко оверфитится. Поэтому главное не универсальность аппроксиматора, а его способность к генерализации. И сверточные нейронки ввиду своей регуляризации очень хорошо генерализуют.

2. Самое главное достижение дипленинга - это переход специалистов от дизайна фич к дизайну архитектур. Раньше было как, сначала программистом пишется много скриптов с вычленением фич из негра или временного ряда, затем это все упаковывается в один многоменрый feature vector и скармливается простому линейному классификатору. Весь ML - в этом классификаторе, остальное - сложные алгоритмы типа SIFT. Это как-то работало. Сейчас фичи вычленяют верхние слои нейронки. Они делают это лучше, чем программисты. И ML теперь расширился уже и на область дизайна фич.

И если нейронки сосут на какой-то задаче, это не потому что аппроксиматор требуется более слабый, а потому что они хуже автоматически вычленяют фичи. Например, очевидно, что если в твоем временном ряде сильные временные зависимости, то без dilated convolutionов не обойдешься. Хуяк-хуяк, ты придумал wavenet.

Читай cs231n

> Но ведь ничто мешает гонять на топовой видюхе любой другой метод. Что, так твои убер-методы НЕ МАСШТАБИРУЮТСЯ для больших датасетов что ли, лол? Смешной ты))

Все масштабируется, уже просто потому, что любую функцию от многих аргументов можно представить через суперпозицию частных функций от двух например аргументов. Просто другие решениях тема нехайповая, никто этим не занимается. Сойбои же засмеют на коворкинге.

> Пошел опять whataboutism. Так это ты ответь, что насчет. Какой метод лучше нейронок при анализе временных рядов?

Они все примерно одинаковы. И диплернинх не даёт заметных преимуществ. Потому что все эти методы - универсальные аппроксиматоры. А сама система может очень отличаться от того, что мы имеем на ограниченном отрезке временного ряда. Поэтому даже минимальная экстраполяция не работает.

Спасибо

>Сойбои же засмеют на коворкинге.

Человек-мемасик рассказывает нам о том, кто кого засмеет. И это единственное, что он родил в ответ на 8 кб текста.

При этом человек-мемасик все знает - десятки тысяч ученых ошибались, развивая неправильную тему (не иначе, как всех запугали SJW), но он-то ого-го какой. И что же он предлагает?

>Все масштабируется, уже просто потому, что любую функцию от многих аргументов можно представить через суперпозицию частных функций от двух например аргументов.

Fin.

> десятки тысяч ученых ошибались, развивая неправильную тему

Десятки тысяч индусов и прочих смузихлебов. Учёных в этой теме три калеки. И почему неправильную, правильную же. Для цифрового ГУЛАГа.

Дело даже не только в мощностях, а тупо в громадном обьеме данных. Есть данные фейсбук/гугл/очень частные задачи - диплерненх "работает", нет - хуй сосешь.

Объём данных это вообще не показатель того, что с задачей справится только диплернинх. Word2vec не диплернинх, а работать может с очень большими объёмами данных. И для работы с ним даже не требуется башлять нвидии. Вот пример подхода здорового человека. А могли бы просто нахуярить слоёв.

>Они все примерно одинаковы.

Я тебя спросил, какой метод лучше. Ты не ответил, потому что не знаешь.

>Потому что все эти методы - универсальные аппроксиматоры.

Как я писал выше, но ты это проигнорировал из-за когнитивных искажений: "Я тебе сейчас объясню твою фундаментальную ошибку, как батя, а ты меня выслушаешь и проигноришь из-за когнитивных искажений, ну да похуй.

1. Сложность аппроксиматора особо неинтересна. Они уже все безумно сложны настолько, чтобы тупо запоминать датасет и это не предел. Сложный аппроксиматор легко оверфитится. Поэтому главное не универсальность аппроксиматора, а его способность к генерализации. И сверточные нейронки ввиду своей регуляризации очень хорошо генерализуют."

Почему ты уже несколько лет носишься с этими универсальными аппроксиматорами, не понятно.

Второй момент, мейнстримные сверточные нейросети универсальными аппроксиматорами не являются. Хотя бы из-за наличия downscaling слоев. Берем фотографию негра, на белом фоне, затем сдвигаем ее на 1 пиксель. Первую фотографию негра обзываем классом 0, вторую - классом 1. И все. Подобные два класса сети с max pooling'ом отличить не в состоянии. Даже в случае экстреального оверфитинга - просто потому что первый pooling слой сделает сигналы равными. Сверточные сети не являются универсальными аппроксиматорами, это аппроксиматоры, которые заточены под обработку сигналов, инвариантных вдоль 1, 2 или 3 измерений. Таких сигналов очень много.

>Сойбои же засмеют на коворкинге.

>Десятки тысяч индусов и прочих смузихлебов.

Человек-мемасик продолжает свои охуительные мемасики. А ты ведь самый главный сойбой тут.

>Учёных в этой теме три калеки.

В какой теме ученых больше?

>Кокие данные? Релевантность поиска у гугли говно, переводчик такой же

Чем же ты пользуешься?

То есть ты пользуешься гуглопоиском и гуглотранслейтом, потому что это лучшее, что есть, но так как ты брюзжащий старпер с клинической депрессией, тебе просто поныть охота.

>Дело даже не только в мощностях, а тупо в громадном обьеме данных.

То есть другим методам данных не нужно.

Ты-то блядь откуда знаешь?

>Решены. Это вот типично старперский выебон. Стыдно быть таким.

Ну да, а на пикрелейтед страус. Охуенно всё решено.

Каким образом?

И опять whataboutism пошел.

Ой блядь, два вопроса и опять общие ответы без конкретики. Ты наблюдаешь только за глюками в своей голове, а к МЛ-имеешь следующее отношение: твою мамку ебал пёс лекуна и так появился ты.

в переводчике яндекса тоже нейронки

Мне неприятно, что мои годные мысли засираются говном типа тебя, которое даже поспорить нормально не может - 2-3 демагогических приема, ходящих по кругу, ноль математики, ноль ссылок на статьи и т. д. Ты же одноклеточный спорщик, блевать тянет от такого.

Классической лстм тебе будет достаточно?

>Подобные два класса сети с max pooling'ом отличить не в состоянии

А что, других методов понижения размерности не существует?

А ну быстро сказали как робот управляемый ИИ будет производить прибавочный рподукт?

Мимо Атлант.

Мимо Атлант.

>и как робот управляемый ИИ будет производить прибавочный рподукт?

> А ну быстро сказали как робот управляемый ИИ будет производить прибавочный рподукт?

Быдло последовательно (сначала пролетариев - работников руками, потом инженеров и прочих интеллигентишек - работников мозгами, когда роботы сами себя смогут обслуживать и задачи ставить) уморят, капиталистическая илита сможет наконец зажить счастливой жизнью при коммунизме.

Сап, Анон. Подскажи, какие разделы математики и в каком порядке лучше задрочить? Сам пока думаю так: анализ, комбинаторика, теория графов, статистика, вероятности. С меня нихуя.

Точно так же как и любой другой станок. Прибавочный продукт = цена - себестоимость.

Анализ, теорвер, линейная алгебра местами.

Для макакинга: линал, анал, теор вер, больше тебе ничего не нужно. Для чего то большего фунан, топология, мат. программирование и один аллах знает, что там вылезет.

> топология,

Гамалогии забыл, кловн.

>Ты показывай рабочий пример, который прекрасен и с инженерной и с эстетической стороны.

Такие модели как правило являются основой технологического преимущества компании, в которой ты работаешь. И если ты не молодой шутливый "диплёнинх энтузиаст", то показать обычно нечего.

мимокрок

Работая с одномерными данными, пришел к тем же выводам.

LSTM как раз хороший пример того, что появилось с ускорением железа: идея изобретена в 90-е, с тех пор особо не менялась, широкое использование полносвязных слоев и сложно считаемых нелинейностей типа tanh и sigmoid. Идеи feedforward сети, которая ограниченно, смотрит в прошлое, типа wavenet, TCN и того, что предлагают они, намного симпатичнее, проще обучаются и вообще ня.

> идея изобретена в 90-е

Бля в 2000-е вообще что нибудь придумывали? Кто-нибудь в курсе о каком-нибудь алгоритме, который ждет своего часа?

В нулевые придумали, как обучать глубокие сети с помощью послойного предобучения без учителя. Это дало пинок исследованиям в нужную сторону, но теперь это уже не нужно.

> Кто-нибудь в курсе о каком-нибудь алгоритме, который ждет своего часа?

А вот тут тебе надо рыть как раз кернел методы - в нейронках все настолько горячее, что тысячи людей ковыряют все, что только можно. Вполне возможно, что через 10 лет у нейронок наступит очередная зима, а ты тут такой с древней статьей на мощном железе выстрелишь.

> А вот тут тебе надо рыть как раз кернел методы

А я разве не об этом не первый год пишу? Нет ни одного метода, настраивающего саму структуру кернела для конкретной задачи, функция ядра это всегда гиперпараметр. Хотя всем ясно, что это основа кернел методов как явления и тупо перекладывать эту задачу на пользователя.

>Нет ни одного метода, настраивающего саму структуру кернела для конкретной задачи

Есть. deep learning

Я не о том, как раз о ручном дизайне слоев - эти вещи могут работать интереснее и быстрее, чем аппроксимация кернелов нейронкой, как происходит сейчас.

Палю годноту, шпрехензи дойч необходимо.

Торопись, пока твоё место не заняли хачи-мигранты с ближнего востока.

Торопись, пока твоё место не заняли хачи-мигранты с ближнего востока.

>Палю годноту, шпрехензи дойч необходимо.

Нахера, они там все английский прекрасно знают и переводят, особенно в ит. Вот что действительно необходимо, так это китайский, половина всех статей по машобу написана на китайском, учитывая что там сейчас лучшее массовое мат.образование в мире, хз какая годнота там может быть заныка прямо сейчас, на вроде информационной геометрии у япошек в 90-х, о которой никто больше не знал до 00-ых.

> половина всех статей по машобу написана на китайском,

Ну и что? Маловероятно, что на китайском есть что-то важное, чего нет на английском. Любой понимает, что у статьи на английском будет больше читателей, чем на китайском, т.к английский образованные люди и на китаях знают, а вот в китайский вне Китая могут очень немногие.

>Маловероятно, что на китайском есть что-то важное, чего нет на английском.

Дэмэдж контролл американской тряпки от первой экономики мира.

>половина всех статей по машобу написана на китайском

На китайском? Не китайскими авторами на английском?

>лучшее массовое мат.образование в мире

Пруфы в студию.

Вы должны мне помочь! Сам не могу нихуя найти. Есть С или Го продвинутые свободные, и в то же время не сложные для разбора, для МЛ или диплёрнинх? Очень надо именно на этих языках. Ни как мне не поможет питон или джава и всякая такая хуйня.

И я забыл упомянуть что это не должен быть враппер, мне нужно конкретно засунуть это в го. Именно в го.

>диплёрненх

>го

Может ещё и блохчейн? А сам ты на гироскутере, в правой руке вейп, в левой смузи?

щас бы на go писать cudann код

На CPU нада.

Техническая необходимость, сойбой.

Не подходит ни для мой реки, ни для проекта.

В какой вуз идти учиться, чтобы в будущем заниматься машинным обучением и анализом данных?

Кроме очевидного физтеха, фкн вшэ и шада?

Кроме очевидного физтеха, фкн вшэ и шада?

В топ вуз.

>шада

Значение знаешь?

На С есть MXNet - диплернинх, все дела. На ПЩ нихуя нету кроме 1.5 враппера.

> Пруфы в студию.

Я тут давал ссылку на переводную на англ китайскую книшку про нечёткие множества, там написано, что автор преподает этот предмет в школе в Гонконге лет 10, а книшка такая годная, что её на английский перевели и в шпрингере издали. Так что предыдущий оратор прав - в китаях математику дрочат серьёзно, и правильно делают.

>В топ вуз

Это какой, если не мфти и вшэ?

мехмат мгу?

Меня забанили в гугле. Поэтому такой вопрос, дайте, пожалуйста, ссылку, где лучше всего показано как растет скорость выполнения программ с нейросетями, после того как взяли видеокарты Nvidia и стали на них ускорять программу?

Кто нибудь здесь понимает математику GRU? Вопрос есть.

прошел все курсы по матану от mit но что значит этот кал import slesarplow as sp

Всё также как и лстм, но называется по-другому. А математика для нейросетей - это что-то уровня Перельмана и теоретической квантовой физики, здесь таких не найдёшь.

А если я возьму pytorch и импортирую его в cython файл и скомпилирую в .so?

а чо она там есть? можно ссылочки на статьи?

> математика для нейросетей - это что-то уровня Перельмана и теоретической квантовой физики, здесь таких не найдёшь.

Математика для нейросетей это уровень оп пика с йобами.

Ты просто не знаешь о чём говоришь, это не математика, это сами сети. Математика для них просто ебааа.

Ну короче вопрос то не такой уж сложный, если человек знаком с GRU. Я не понимаю смысла домножения (1-zt) * ht. Типо это zt это же ворота, которые решают чё надо сохранить, а что обнулить. Я не понимаю какой смысл в том, что бы результат предыдущего шага нормально домножался на этот вектор, а текущий результат домнажался на то, что мы не пропустили. ( Ну тип 1-zt даст обратные значения относительно единицы). Короче кто сечет, поясните мне за эту логику.

Это интерполяция между старым значением и предложенным новым.

Не ебу, что за нотация и обозначения на твоей формуле, но оно подозрительно похоже на стохастическую аппроксимацию Роббинса-Монро. Т.е текущее значение = предыдущее домноженное на что-нибудь в зависимости от алгоритма.

Ты просто решил что твои вентили бинарные, но они интерполированные. Потому что бинарные нейроны - это двадцатый век.

Ну макака то может и не поймёт, что имелась ввиду функция активации, но настоящий сойбой всегда знает какие нейроны бинарные, а какие интерполированные.

Ты думаешь спиздил мои картинки и думаешь можешь троллить дальше? Чмо, тебя выдаёт вовсе не использование форсов или картинок. Я понял что это ты по тупым попыткам казаться умнее и упрекать сведущих в машобе людей. Знай, ты опять обосрался. Пока ты сидишь и выдумываешь как сегодня будешь верстать соцсети за 500 рублей на Авито, я уже закончил новую версию нейронки для топовой ай-ти компании, где мне платят в день больше чем твоей путане мамаше заплатили за всю её карьеру. Сейчас я еду на своей porsche spyder, а рядом со мной сидит супермодель и проигрывает с тебя, потому что даже она видит как неумело ты притворяешься человеком, который знает что такое мл. Ты, говно, только и можешь что потирать свой лоб тужась чтобы понять что такое сигмоид и плакать, когда сдаёшься и идёшь дальше скроллить зекач ради того, чтобы попытаться оскорбить уважаемых датасаентистов. Это все, что ты можешь.

> топовая ай-ти компания

> Porsche

> супермодель

> сидит на двачах

Да там так и написано было. Но прикладного смысла я не понял.

Верно, там сигмойда, но сути это не меняет, после вычита единицы значения интерполируются, и то, что раньше пропускалось теперь не пропускается и наоборот. В чем смысл этого применения к текущему результату я допереть не могу.

Нет, не вижу.

школьник детектед

Вы тут какие-то не серьезные. В языкотредах вон по хардкору поясняют.

вот на англицком философское объяснение

Let’s bring up the example about the book review. This time, the most relevant information is positioned in the beginning of the text. The model can learn to set the vector z_t close to 1 and keep a majority of the previous information. Since z_t will be close to 1 at this time step, 1-z_t will be close to 0 which will ignore big portion of the current content (in this case the last part of the review which explains the book plot) which is irrelevant for our prediction.

то бишь, если вектор h_{t-1} сильно большой и важный, то мы его не забываем, а забываем ту ерунду, что сейчас, и наоборот

в этом треде сидят одни дегенераты, которые весь день доказывают, что нейронки не нужны, вопросы советую задавать на реддите или stackoverflow

Неправда, если моча забанит пару человек, будет нормально

Потому что непонятно что вообще тебе нужно и спрашиваешь ты про то, что само нормально работает и импортируется изкаропки в любом фреймворке.

Если ты не можешь осмыслить правильный ответ, который я тебе дал сразу же: , то проблема на твоей стороне. У меня создалось впечатление, что ты просто смотришь на формулу, как баран на новые ворота, и даже не можешь сказать, что именно тебе непонятно. Это называется отсутствие бекграунда, и в этой беде тебе не поможет никто, ни здесь, ни на реддите, ни на стековерфлоу.

>то бишь, если вектор h_{t-1} сильно большой и важный, то мы его не забываем, а забываем ту ерунду, что сейчас, и наоборот

Да, ты даже ту статью нашел которую я читал. Я понял что тут было написано, но у меня встал вопрос, а что если оба шага важные? Или не важен ни один. Значения в векторе будут в районе 0.5?

Я пытаюсь понять внутреннюю механику архитектуры, что бы понимать как нужно её подкручивать, что бы добиваться желаемое результата.

Вот этот анон понял, что я имел ввиду. К слову бекграунд у меня и правда не так велик я занимаюсь этим всего месяц, но за это время успел разобрать механику обычных нейросеток, бп, рнн, бптт, проблему размытия градиента с формулами и осмыслением математики, щас вот над лстм и гру бьюсь. Пока до конца осознание не пришло.

>векторе будут в районе 0.5?

Разумеется имелся ввиду вектор ворот.

Анон, хочу сделоть OCR на джаве, т.к. на pure джаве OCR до сих пор почему-то нет. В связи с этим нужно понять чо читать и куда копать. Изначальное применение будет для тестирования UI, т.е. нужно распознать достаточно квадратные компуктерные буквы.

Делай нейронку на тф, в жабе ее загружай и гоняй. Как я тут делал: https://github.com/sorrge/wakabaYes

Но это медленно, т.к. на чистой жабе не поюзать ГПУ.

в z_t два набора весов - один для икса, другой для h_{t-1}, они решают, сколько старой информации оставить

> а что если оба шага важные? Или не важен ни один

Такое практически невозможно.

>на чистой жабе не поюзать ГПУ

Можно сгенерировать и серануть в гпу.

Спасибо за ссылку, посмотрю.

>щас вот над лстм и гру бьюсь

Начиная с этого момента идет большой скачок сложности. То, что ты до этого расписал, это совсем просто. А вот до конца разботать, как и почему ЛСТМ решает проблему забывания (и что это вообще за проблема), это гораздо сложнее. Читай Шмидхубера, реализуй все сам, смотри как работает, сверяйся с теорией. Не советую ГРУ брать для начала: он был разработан на базе ЛСТМ, как его упрощение, и там не все понятно. Скорее эмпирически был сделан/найден. А ЛСТМ основан на теории.

Двачую, давно пора пидорнуть этих дятлов.

>Вротентраххером

Бля, бротишь, можно ещё этих шутеек с нерусскими фамилиями? Так уморительно, чуть животик не надорвал.

>как и почему ЛСТМ решает проблему забывания

Он обучает каждый свой гейт отдельной нейросеткой в каких случаях что пропускать, а что нет. Так же параллельно он учится игнорить определенные сигналы, а перед выходом еще и отбирать самые достоверные. В итоге формируется особая память, лежащая в определенных коэфициентах весов и биасов этих гейтов. Затем, когда обученный гейт видит какой-то паттерн он уже знает как его надо отфильтровать что бы в нем осталась только нужная инфа по его мнению. Как-то так я это понял.

Да ну, например в обработке текстов из всего предложения важно может быть только пара слов. И Получается что GRU одно из этих слов посчитает важным и запишет в память. Нет так что ли?

Обучением на предыдущих примерах, где ты вручную указывал что важно.

>из этих слов

Имелось ввиду что из этих неважный слов которые могут идти друг за другом.

Ну кто-то это в любом случае делал. Ты мог взять готовое.

Ну бля, я об этом и говорю что между важными словами могут стоять дохуя неважных. А с этим интерполированием получается, что идет неважное потом важное потом снова не важное итд. Неееее, я явно чего-то не догоняю.

Да, так. Но это слово будет важнее другого. Иное невозможно. Это точно так потому что обучение не так работает, блять, когда ты обучаешь, оно ищет путь аппроксимации решения, так что предугадать это невозможно из-за бесконечного количества вариантов, но это в любом случае не алгоритм, она никогда не имеет конфликтов, решения обходят друг друга или дают малоразличимые данные.

Посаны, интересует нейросети использовать и пытаться усовершенствовать архитектуру в онлайн дрочильнях по типу доты и лол. Я так понял, что там уже архитектуры жрущие конские ресурсы , которые одному человеку не под силу достать. Остается только наблюдать со стороны?

Вот, все таки благодаря твоим разъяснениям и долгому залипанию в формулы я осознал нахуя нужна интерполяция. Все-таки я не учел, что все преобразования на текущем шаге задействуют данные с предыдущего. А интерполяция нужна, что бы обработать те данные, которые апдейт гейт не пропустил, ресет гейтом. Впрочем, это пока только интуитивное понимание.

Это все защитная постирония на тему того что птушники, наслушавшиеся в интернете про нейросети в принципе не могут осилить или что?