платиновый вопрос:

когда говорят о линуксе, какой уровень владения предполагают?

https://www.edx.org/course/introduction-linux-linuxfoundationx-lfs101x-0

когда говорят о линуксе, какой уровень владения предполагают?

https://www.edx.org/course/introduction-linux-linuxfoundationx-lfs101x-0

Кто-то делал сегментацию на нейроночках?

Не делал, но в статье с CRF в виде нейроночки показывают годные результаты.

А как же сегметируешь?

Интересная статья про торч7 и как его под вин устанавливать

http://dmandreev.github.io/2016/03/05/torch7-windows/

Скайнет для распознавания макакиной капчи уже написали?

могли бы знающие порекомендовать и добавить в фак чего-то по теме обзора области: откуда это всё появилось, почему так исторически сложилось и зачем используется

в каждой книге сразу методы шпарят

в каждой книге сразу методы шпарят

Объясните как луа и торч7 поставить на вин7 ?

Ребята, давайте постараемся скомпилировать торч7 под вин и выложить бинарники?!

https://github.com/torch/torch7/pull/287

https://github.com/torch/torch7/pull/287

так поставь себе линукс или чо там у него..

если жалко игр, сегментируй диск

cc

Большой проблемой является Linux. Может быть, я буду получать окликнул реальными CS или ML двачерами за эти слова, но блять, если это не трудно использовать Linux. На Ubuntu я попытался установить драйверы NVidia один раз (следуя инструкциям в точности) замуровали моей сборки, удалил их из режима восстановления, сделал это снова по-другому, а затем провел целых два дня с помощью Баш, чтобы загрузить десятки зависимостей, многие со своими зависимостями, с их собственных зависимостей. Иногда они порвали друг друга, иногда они сломали мою ОС. Я получил его на работу, но величина икота, когда они происходят оставляет меня за отвращение к Linix. Я также сделал тот же самый процесс на облаке сервер, который был проще, без GPU и может оставить проекты, работающие на центральный процессор сервера и до сих пор есть компьютер для использования.

Я получил Keras работать с Теано на Windows, с моей GPU, но большинство глубоких библиотек обучения не будет работать на Windows, в том числе tensorflow, CAFFE, а на самом деле просто ни о чем другом. Так что в основном я использую Linux и молиться нет бедствия пивоварения под капотом

Я получил Keras работать с Теано на Windows, с моей GPU, но большинство глубоких библиотек обучения не будет работать на Windows, в том числе tensorflow, CAFFE, а на самом деле просто ни о чем другом. Так что в основном я использую Linux и молиться нет бедствия пивоварения под капотом

> нет бедствия пивоварения под капотом

Спасибо, это помогло!

Не стоит, поверь. Заебешься дрочить вприсядку с бубном и не факт что все будет работать как надо. Гораздо проще установить бубунту и в ней все поставить по мануалам.

Википедия, что-то есть в Уоссерман "Нейрокомпьютерная техника" (по ней изучать вообще не советую, слишком обзорно там теория дается)

> в каждой книге сразу методы шпарят

ну почему же

в том же бишопе каждая глава начинается с мета-попиздонов вокруг темы

в нормальных учебниках всегда будет даваться подобная историческая мотивация

Поясните, можно сервер арендовать с линуксом, чтобы юзать его именно для обучения написанной нейросети? Или может есть какие-то облачные сервисы для этого?

для начинающего линух не нужен

арендованные облачные GPU-инстанцы на AWS - говно и виртуализация херит всю производительность

>что-то есть в Уоссерман

>Ф. Уоссермен. Нейрокомпьютерная техника: теория и практика. М. Мир - 1992.

>1992

Все что раньше 2015 года - старье и неактуально?

>GPU-инстанцы на AWS

>виртуализация

>откуда это всё появилось, почему так исторически сложилось и зачем используется

http://docs.aws.amazon.com/AWSEC2/latest/UserGuide/using_cluster_computing.html

> GPU instances run as HVM-based instances. Hardware virtual machine (HVM) virtualization uses hardware-assist technology provided by the AWS platform. With HVM virtualization, the guest VM runs as if it were on a native hardware platform, except that it still uses paravirtual (PV) network and storage drivers for improved performance. This enables Amazon EC2 to provide dedicated access to one or more discrete GPUs in each GPU instance.

>Часть - потому что важные куски типа параллелизации еще не выкачены в паблик.

Сколько еще будете копипастить это говно, которое уже неактуал

Надо бы кстати заняться. Хуй знает правда как цифры сегментировать.

А что нейроночка сама не может найти способ как сегментировать? Ты еще и сам за нее должен думать?

Ну-у, будь у меня кластер с топовыми теслами, я бы наверное попробовал скармливать капчу целиком. А так я думаю хуйня выйдет.

Аноны, покажите пример кода простейшей нейронки.

А на кой тебе код? Бери какой-нибудь готовый движок.

Какие тебе нейронки если ты в гугл не можешь?

На кой мне движок? Хочу посмотреть как оно работает.

А в яндекс можно?

Например код перцептрона.

сделайте нечоткий контроллер

чтоб на триггеры "Аноны," и "нейроночки" выдавал "платина"

функцияАктивации(входа * веса);

Вот если просто подумать головой и сложить 1 и 1.

1) четкое число - частный случай нечеткого, четкая логика - частный случай нечеткой.

2) теорема Байеса - частный случай нечеткой теоремы Байеса http://sipi.usc.edu/~kosko/Fuzziness_Vs_Probability.pdf

3) вероятность элементарно сводится к множествам (пруфы в статье выше).

4) четкие функции, отношения, аппроксимация функций частный случай своих более общих нечетких вариантов.

Разве из всего этого не следует очевидная тривиальность - нечеткие множества и нечеткая логика дает больше возможностей работать со всем вышеперечисленным?

Что касается вопроса сводимости нервной деятельности к нечетко-логическим операциям, поясните ,почему условный и безусловный рефлексы, доминанты, в общем сучае функциональные системы Анохина, нельзя рассматривать как нечеткие отношения, заданные на декартовых произведениях множеств стимулов и реакций? Из этого не следует ли сводимости любой нервной деятельности к множествам и операциям над ними? Повторюсь, четкое множество - частный случай нечеткого.

1) четкое число - частный случай нечеткого, четкая логика - частный случай нечеткой.

2) теорема Байеса - частный случай нечеткой теоремы Байеса http://sipi.usc.edu/~kosko/Fuzziness_Vs_Probability.pdf

3) вероятность элементарно сводится к множествам (пруфы в статье выше).

4) четкие функции, отношения, аппроксимация функций частный случай своих более общих нечетких вариантов.

Разве из всего этого не следует очевидная тривиальность - нечеткие множества и нечеткая логика дает больше возможностей работать со всем вышеперечисленным?

Что касается вопроса сводимости нервной деятельности к нечетко-логическим операциям, поясните ,почему условный и безусловный рефлексы, доминанты, в общем сучае функциональные системы Анохина, нельзя рассматривать как нечеткие отношения, заданные на декартовых произведениях множеств стимулов и реакций? Из этого не следует ли сводимости любой нервной деятельности к множествам и операциям над ними? Повторюсь, четкое множество - частный случай нечеткого.

for (int i = 0; i < input.size(); ++i)

out += input * weight;

out = 1 / (1 + exp(-out));

И всё штоле?

нечеткая логика не особенно полезно говорить о частичном знании. Если вы разрешили логике второго порядка, вы могли бы иметь нечеткие мета-предикаты, которые описывали вашу уверенность о хрустящих предикатами первого порядка. Но с первой логики заказа (на самом деле, где мы хотим сосредоточить наше внимание), нечеткая логика не является полезным для задач, где мы используем теорию вероятностей.

Смешная картинка, а петух-то почему не размытый, четкий?

wip

Это на каком языке?

а где тимочка-нейроночка?

дочитал свою хуйню и забыл о нас?(

дочитал свою хуйню и забыл о нас?(

Здесь обитает тот питух который ищет препа по матану?

>нужна математика?

>для начинающего ничего особого знать не нужно

что именоо, калькулусу/матан?

Или дефолтной школьной математики?

>для начинающего ничего особого знать не нужно

что именоо, калькулусу/матан?

Или дефолтной школьной математики?

> калькулусу

>будет ли ML нужен в ближайшие 10 лет, или это просто хайп?

>будет. хайп.

from corp import machinelearning

huita = machinelearning.done()

Аноны, как доказать что сеть не оверфитит датасет в статье? Кто с такой задачей сталкивался, дайте пару дои.

Господа, хочу услышать комментарии по поводу моего пика.

Питонист, заебало клепать сайты на Джанге, хочу вкатиться во что-то интересное не меняя язык (уж больно нравится он мне).

Питонист, заебало клепать сайты на Джанге, хочу вкатиться во что-то интересное не меняя язык (уж больно нравится он мне).

Короче слегка знаю питон(решаю c4 из егэ) и умею брать производные, можно вкатываться в машин лернинг и биг дата?

Ага, и рейтинг 100$ в час не забудь поставить. А если серьезно, то я бы на твоем месте сначала вышку нормальную выбрал с хорошей математикой и не ебланил на матане.

Мимо-

Можно, только курс какой-нибудь на курсере пройди сначала.

Да я тоже так думаю, самое забавное, что мне 22 уже(

Пробовал яндексовую специализацию, так там начали с линейной алгебры, матана(не школьного), у меня голова малость поплыла, посоветуешь курс попроще, чтобы хотя бы пощупать эту тему с минимумом вышмата.

>++i

что то из серии C/C++/C#

мимокрок

Ну а мне 24. И я как раз ебланил на матане. Теперь пожинаю плоды - учу матан самостоятельно. И да, дается тяжело. Думаю прогуляться по дереву, которое я запостил и посмотреть, что получится. А то фрилансить за 25 в час, делая однотипные задачи, уже порядком подзаебало. Жаль еще года три это делать придется.

Анон, главное не сдавайся. Если голова кипит, делай перерыв и возвращайся снова. Начальный курс линала, матана и тервера ну очень важен в дальнейшем обучении. Отмучаешься сейчас - потом будет легко и приятно

>Жаль еще года три это делать придется.

А потом чего, внезапно вылупишься в датасаентиста?

Можно завести отдельную рубрику с маняфантазиями: кем я буду через 5 лет и кому продавать свои навыки.

В большие компании, которых мало, нужны яйцеголовые уровня пхд, для применения алгоритмов уже есть/допилят удобные апи, чтобы пользоваться могла домохозяйка, а если учить для себя, то всё равно нужны будут ебовые вычислительные мощности и выгоднее использовать пункт2.

это крик души, можешь не воспринимать на свой счет

Восемь сотен пиздеть не будут.

Да, были у меня такие мысли. У машинного обучения есть куча возможностей, которые крупные компании на моей жизни не покроют.

Основная моя идея была неплохо показана в "Программируем коллективный разум". Есть куча данных, над которыми никто не работает, но которые реально можно неплохо использовать (в том числе и в коммерции).

Юзать API сервисов и ваять свои сайты - наше все.

> continuous distributions: poisson. чоблядь?

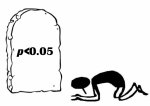

> p-value в 2016

> по бейсу толком ничего

> euclidean distance лол

> etc etc

Ок, буду пробовать еще.

Быть художником > быть маляром

Хороший маляр > художник средней руки

Аноны, а как превратить обычный многослойный перцептрон в рекуррентную нейроночку?

Делаешь вариационную аппроксимизацию, записываешь конволюцию с сигмоидом, потом уменьшаешь размерность интеграла (здесь поможет дельта функция дирака) как конволюция гауссовых распределений, и с обратной пробит-функцией маргинализируешься над постериором. Любой второкурсник справится. А если делать на МСМС — так задачка вообще на пять минут.

Никак, у тебя градиенты вырождаться начнут. Бери LSTM

Я не второкурсник.

>Делаешь вариационную аппроксимизацию, записываешь конволюцию с сигмоидом, потом уменьшаешь размерность интеграла (здесь поможет дельта функция дирака) как конволюция гауссовых распределений, и с обратной пробит-функцией маргинализируешься над постериором

Нахуя?

Странно, в книге написано из обычной MLP сделать реккурентную сеть и проанализировать взвешенный ряд.

А, тебе для книги...

>для начинающего ничего особого знать не нужно

Пиздаболия

Пиздаболия

Аноны, из перцептрона с 1 слоем, значит, можно сделать RNN, а из многослойного нельзя?

Блять, ебучий цирк.

Короче, у меня получилось взять результат с прошлой итерации, просто спиздив ее из функции.

Так дальше входы оказались массивом из 4 чисел, а выходы из 20, как прикажете их перемножать?

Или выходы надо сложить со входами?

Завтра ищешь в интернете книжку "Pattern recognition and machine learning". Похуй если ничего не поймёшь. Затем идешь на https://en.wikipedia.org/wiki/List_of_probability_distributions и изучаешь стандартные распределения от корки до корки. Потом зубришь, именно, сука, вызубриваешь теорему бейса - чтоб от зубов отскакивало. Когда напишешь свою первую иерархичскую модель, по пути изучив infer.net, поступаешь в нормальный университет, рекомендую Кембридж. Как переделаешь модель, чтобы выдавала по крайней мере 5 тысяч предсказаний в секунду, можешь идти дальше - тебя ждет увлекательный мир бейсовского вывода. Несопряжённые приоры, сверхбыстрое гамильтоновское монте карло, вариационный вывод. Отсос классико-макак / просто неудачников типа нечётко-питуха или сёрло-хуесосов, которые сосут хуй по жизни не заставит себя ждать и уже через пол года ты будешь получать такие суммы, что любая баба будет течь при одном упоминании твоей зарплаты.

> Ctrl+F

> Bayes

> нечётко-питухи сёрло-хуесосы

Ты ебанулся использовать шарп приблуду от мелкомягких?

Аноны, вот добавил я выходы к входам, как ее обучать?

То-есть, откуда я должен узнать таргеты? У меня по сути, в рекуррентной сети Джордана 40 входов, а должна быть 20 Так как размер входа - 20 нейронов

То-есть, откуда я должен узнать таргеты? У меня по сути, в рекуррентной сети Джордана 40 входов, а должна быть 20 Так как размер входа - 20 нейронов

Или мне взять входы, умножить на веса и все это умножить еще раз на контекст?

>в рекуррентной сети Джордана

Господи, где ты ее нашел-то? SNNS штоле? Если да - почитай мануал и посмотри примеры, там все разжевано по вопросу как правильно подкладывать данные.

Сеть Элмана дохуя лучше?

У меня в книге было написано взять выходы с шага -1 и умножить на веса.

Это сеть Джордана же.

>Сеть Элмана дохуя лучше?

Сорта, насколько я понял. И то и другое есть в SNNS, который портировали в R - пакет RSNNS. https://cran.r-project.org/web/packages/RSNNS/index.html http://dicits.ugr.es/software/RSNNS/index.php там подробно про все нейроночки, вт.ч. и рекуррентные эти.

Да я все понял, у меня только хуйня с np.sum() выходит, просто так он шлет меня нахуй, если np.sum((),axis = 0)), то в конце он пишет:

>Value Error: operands could not be broadcast together with shapes (10,2)(20,2)

Хотя у меня оба массива и входы и выходы размером 20,2

Может попробовать сделать сеть Элмана? Там с весов надо считывать после функции активации? И в многослойном перцептроне умножать после каждого слоя?

А все, понял, почему-то входы становятся размером в 10,2

Анон, поясни за профессию.

Мне очень интересна сфера ИИ, нейронных сетей и всего что с этим связано. Сейчас работаю прогером в иной сфере, но думаю через определённое время перекатиться.

Как дела в этой сфере со спросом/предложением? Грубо говоря, много ли платят? Не выходит ли так, что веб-макака (коей я пока что являюсь) получают столько же или больше?

> ИИ

"мелкомягкие" единственные кто просёк самое перспективное направление в мл

?

Если из многослойного перцептрона делать сеть Элмана, то:

Дополнительные входы должни быть только от первого слоя весов или от всех последовательно?

Дополнительные входы должни быть только от первого слоя весов или от всех последовательно?

https://ru.wikipedia.org/wiki/%D0%9D%D0%B5%D0%B9%D1%80%D0%BE%D0%BD%D0%BD%D0%B0%D1%8F_%D1%81%D0%B5%D1%82%D1%8C_%D0%AD%D0%BB%D0%BC%D0%B0%D0%BD%D0%B0

> Нейронная сеть Элмана — один из видов рекуррентной сети, которая так же как и сеть Джордана получается из многослойного перцептрона введением обратных связей, только связи идут не от выхода сети, а от выходов внутренних нейронов.

твоя личная нейроночка-гуглёрша-автоответчица

Не хочешь как-нибудь вместе потренить сеточки?

0.1

>а от выходов внутренних нейронов.

Всех выходов?

Я читал это уже не один раз.

хуй знает, из статьи неясно

твоя личная нейроночка-гуглёрша-автоответчица

Ну вот же, не надо за идиота считать, я гуглил дохуя и только потом пришел в тред.

Бля это сеточка женского рода

тупой кусок мяса

твоя личная нейроночка-гуглёрша-автоответчица

Эй гуглерша,лел, а сигнал в сети Элмана надо считывать до или после Функции активации?

Все ж нарисовано.

Пиздец, даже картинка не отправляется. Быдлосайт такой-то.

капча, значит, нормас?

Там для однослойного, а как с многослойным не нарисовали.

И еще не сказали, что делать после того, как я перемножил матрицы, как их привести в нормальный вид входов.

Да хоть для какого. Ты суть пойми. Ко входам просто добавляются выходы от промежуточных узлов. Это нужно для того чтобы нейроночкабыла типа с памятью. То же самое достигается более простыми методами, в частности, представлением данных в виде модели NARMAX или в виде матрицы Ганкеля. Что дает по-сути, тот же эффект, но специальных нейроночек для этого не требуется, можно использовать тот же перцептрон и вообще хоть что.

Да суть я понял, надо же это реализовать еще.

Данные от выходов надо как-то представить в одинаковой форме со входами, что пиздец нелегко.

Что делать со смещенной нодой, например?

Просто переложить весь массив в вертикальный?

Гугли матрицу Ганкеля. А входы можнонормировать же.

Рашкинская википедия написана тупым дауном.

Из мультиперцептрона, ага, блядь, что за даун это писал?

Сука, стоило зайти на английскую - все по человечески написано.

И в учебнике все так типа просто написано, в реальности же ошибок дохуя.

Из мультиперцептрона, ага, блядь, что за даун это писал?

Сука, стоило зайти на английскую - все по человечески написано.

И в учебнике все так типа просто написано, в реальности же ошибок дохуя.

айнепиздика

И как мне нормировать входы? Я на выходе получил массив из 60 чисел в 3 столбца и 20 строк.

И как мне сделать его таким, чтобы он был как входы? Если я добавлю ко входам его, то как мне обучать сеть?

Или рекуррентная сеть не умеет в задачу регрессии?

Ой блядь, надо же было добавлять после того, как высчитывал активацию.

Лол, прикиньте, оно заработало, на 1-м слою я беру значение с прошлых весов умножаю их параллельно и после того, как вычитываю активацию складываю.

Аноны, это же считается за реккурентную сеть?

Ведет она себя и правда по другому, я складываю прошлую и настоящую активации

Это тот датасет про выживших с титаника? Чего там решать-то, все решается rule mining'ом. Школьники, поди, такие задачи градиентным бустингом пердолят?

> rule mining'ом

дип лёрнингом?

Вовсе нет. Я об этом https://en.wikipedia.org/wiki/Association_rule_learning

К слову, тема довольно любопытная, а в этом ИТТ треде никогда не затрагивалась. http://www.rdatamining.com/examples/association-rules пример на R с титаником. Книжка по ссылке, к слову,довольно годная.

https://www.kaggle.com/mrisdal/titanic/exploring-survival-on-the-titanic

смотрите какая тяночка

уступили бы ей шлюпку?

смотрите какая тяночка

уступили бы ей шлюпку?

Шизофрения какая-то. Неравноположенные категории, да еще и включены совсем ебанутые.

Что думаете по поводу курса яндекса "введение в машинное обучение" ?

https://www.coursera.org/learn/vvedenie-mashinnoe-obuchenie/home/week/1

В данный момент читаю Бишопа, полёт нормальный. Стоит ли отвлекаться на этот курс?

https://www.coursera.org/learn/vvedenie-mashinnoe-obuchenie/home/week/1

В данный момент читаю Бишопа, полёт нормальный. Стоит ли отвлекаться на этот курс?

Урезанная версия курса Воронцова, в которую еще влит весь остальной дата сайенс для нубов.

бамп вопроса

Во всех курсах по ml для начинающих требования по линалу, матану, вероятности и статистики на уровне 2-ух лет технического вуза, так, что не надо мозги пудрить.

> линалу, матану, вероятности и статистики

и что в этом особого?

то что ты перечислил даётся в любом пту и знакомо большинству посетителей раздела уже много лет

Ну тогда так и напишите в шапке, для большинства людей ничего особого - это школьный уровень и это доска программистов, а не математиков.

Да и даваться оно может очень по разному, тут нужно реальное владение этими предметами и выебоны можешь свои засунуть себе в анус датасайнтист

Шлюпка не рассчитана на ее вес.

богиня тредика

конфа учим вместе cs http://qb0.ru/21

Зачем этому замечтаельному треду говноконфа с вебмакаками, изучающими пиздон?

Еще и называют это компуктер ссаенс

Объясните популярно, чем тут AR лучше деревьев?

Ты про какие деревья? Рандом форест штоле?

Про decision tree. Ensemble на выбор.

Поясните за албфабэта алгоритм в шахматах. Он прекращает перебор как только счёт окажется в пользу противника? То есть если он сначала бьёт фигуру противника и потом отдаёт свою, но не такую тяжёлую, то он углубление продолжает, а вот вариант сначала отдать свою не важную, а потом забрать у противника ценную фигуру он рассматривать не будет? Это глупость какая-то. Как правильно?

лол

Аноны, выходит что Радиальные сети - это сеть, с которой информация поступает в мозг от глаз.

Сверточная - это та, которая распознает образы.

Рекуррентная сеть - та, которая распознает звуки?

Сверточная - это та, которая распознает образы.

Рекуррентная сеть - та, которая распознает звуки?

ага

Аноны, нахуй нужны сплайны?

Есть у кого нибудь инфа или может ссылки на какие нибудь работы по алгоритмам обучения спайковых сетей? Нужно обучить именно спайковую сеть, но вот годных алгоритмов найти пока так и не удалось, двачну для любой инфы по этому поводу.

>спайковых сетей

Чем они лучше неспайковых? Где реализованы?

В любом случае, смотри в сторону разновидностей хеббовского обучения.

Лучше тем, что они быстрее и объемнее по количеству нейронов. А реализованы они в нейроморфных чипах и в мозге.

Есть такая штука - STDP, правило, которое является частным случаем как раз Хеббовского обучения. Но: 1 - этого правила по хорошему недостаточно, 2 - нужны либо рабочие примеры реализации обучения сети с таким правилом или хотя бы литература, поясняющая про подобное обучение.

>литература, поясняющая про подобное обучение.

У Коско http://gen.lib.rus.ec/book/index.php?md5=CCC0771774E761EB91EE2019A244305B в 4ой главе рассмотрено 4 основных варианта хеббовского обучения. Вообще, 1ая часть этой книжки очень годный взгляд на нейроночки в целом.

спасибо, посмотрим

Бамп вопросу.

Я не умею в ml и хочу сделать простые шахматы. Помоги.

Есть жи открытые шахматные движки, ковыряй-модифицируй https://ru.wikipedia.org/wiki/GNU_Chess

>Основан на модификации профессора Тони Марсланда, внесённой им в алгоритм альфа-бета минимакса, и называемой Поиском Основных Отклонений (Principal Variation Search — PVS). Этот алгоритм работает надёжно и достоверно.

> Совсем недавно произошёл возврат к идее, которую поддерживают разработчики GNU Chess: полный обсчёт конечных узлов

Он в лоб все возможные ходы перебирает.

Все возможные ходы он не переберет даже до японской пасхи. Это какая-то модификация основного алгоритма, поскольку у программы как-то получается неблохоиграть:

>блиц-рейтинг GNU Chess версии 5.04, работающей на компьютере на базе процессора Cyrix 166 MHz (эквивалент Pentium 200 MHz), с настройками по умолчанию превысил 2100 пунктов (рейтинги сильнейших шахматистов превышают 2700).

>Все возможные ходы он не переберет даже до японской пасхи

На ограниченную глубину же. Можешь прочитать как это работает и объяснить в каком случае он обрезает узел?

https://chessprogramming.wikispaces.com/Alpha-Beta

> Представим, что где-то в глубине дерева перебора мы обнаружили, что максимумы белых и черных сравнялись. Допустим, мы просчитываем позицию для белых. Если мы продолжим перебирать в данной позиции, то максимум для белых может еще увеличиться, а может остаться прежним, но он уже сравнялся с максимумом черных. Это значит, что когда программа вернется в точку (рекурсивно), в которой максимум для черных, результат будет отвергнут, т. к. он не превышает максимума для черных в этой позиции. Также это значит, что в данной позиции для белых мы можем прекратить перебор и вернуть полученный результат досрочно.

Что это значит? Помогите понять. Сделали например 2 бесполезных ходе где никто никого не побил. Их максимумы сравнялись. И дальше не имеет смысла проверять? А если поменялись фигурами равной цены. То максимумы снова сравнялись, но смысл продолжать есть т.к. обмен фигурами может продолжится. Тогда какой смысл выходить из перебора когда максимумы равны?

Что это значит? Помогите понять. Сделали например 2 бесполезных ходе где никто никого не побил. Их максимумы сравнялись. И дальше не имеет смысла проверять? А если поменялись фигурами равной цены. То максимумы снова сравнялись, но смысл продолжать есть т.к. обмен фигурами может продолжится. Тогда какой смысл выходить из перебора когда максимумы равны?

Как полному нубу вкатиться в machine learning? обоссыте, но не бейте

выбирает ход так чтоб минимизировать максимальную прибыль противника

непомню деталей, тут https://2ch.hk/pr/res/792098.html могут помочь

>выбирает ход так чтоб минимизировать максимальную прибыль противника

Это понятно. Я про условие выхода. Ведь если он прекращает перебор когда противник побеждает, то он понимает что по этой ветке идти не надо и выходит. Я всё понял пока печатал! Спасибо!

соус вебм?

>Group

Проигрываю с даунов из /pr/, которые находят какие-то базовые вещи, знание которых у чистых математиков является само собой разумеющимся, и дрочат на них.

Он на тетку дрочит, аутист.

>на тетку дрочит

Но зачем? Дали вам 2D-богинь, нет, не хочу богинь, буду на шлюх дрочить.

>обсуждают тян

>лезет умничать

у тебя загон есть в обосцае, пердолик

Чем же это тян интереснее идеалов и дивизоров? Поссал на биопроблемников.

Проигрываю с даунов из /sci/, которые реализуют какой-нибудь квиксорт, знание которого у чистых программистов является само собой разумеющимся, и дрочат на него. Пример из жизни.

что в ней божественного? мужиковатая технарка с вонючим ртом

Тащемта, для эффективности квиксорта надо к нему кучу улучшений дописать.

тащемта поебать, тащемта

обосцал квиксорт, капельки урины алсо попали на /sci/ долбоёбо-дегенерата

Слесарь вдруг начал махать руками и обосрался под себя.

Introduction to Statistical Learning и особенно An Elementary Introduction to Statistical Learning Theory -- 10/10

Почему? Чем лучше какого-нибудь Бишопа?

Бишоп - кусок говна.

Аноны, поясните за кубический сплайн.

Как он подбирает сколько необходимо иметь регионов и узлов?

Как он подбирает сколько необходимо иметь регионов и узлов?

Бишопа я не читал, с первого взгляда выглядит как обстоятельный учебник.

Elementary Introduction to Statistical Learning Theory -- 200 страниц, введение для нубов, покрывающее также базовый тервер и матстат. Introduction to Statistical Learning -- тоже самое, только на 400 страниц.

Объем ничего не значит.

Да и лучше прочитать книжку поменьше, но зато освоить, чем прочитать сотню страниц и забросить, не добившись никаких результатов.

Что здесь делает 7,8,9 и 13 строки?

Как они производят интерполяцию и как они делят на узлы? Не понимаю, как это вписывается в общую формулу αiΦi(x),

Как они производят интерполяцию и как они делят на узлы? Не понимаю, как это вписывается в общую формулу αiΦi(x),

ай ай ай, кое-кто ниасилил 100 страниц божественного бишопа и решил слегка взбугуртнуть в тред

но только слегка

но только слегка

>Объем ничего не значит.

Да я не думаю.

> Да и лучше прочитать книжку поменьше, но зато освоить, чем прочитать сотню страниц и забросить, не добившись никаких результатов.

Я согласен, поэтому и порекомендовал эти книжки как вводные.

Аноны, так никто не может пояснить?

Ты скинь нормально код.

Да это и есть весь код, кубический сплайн

Текстом.

import pylab as pl

import numpy as np

x = np.arange(-3,10,0.05)

y = 2.5 np.exp(-(x)2/9) + 3.2 np.exp(-(x-0.5)2/4) + np.random.normal(0.0, 1.0, len(x))

nParam = 2

A = np.zeros((len(x),nParam), float)

A[:,0] = np.exp(-(x)2/9)

A[:,1] = np.exp(-(x0.5)2/4)

(p, residuals, rank, s) = np.linalg.lstsq(A,y)

pl.plot(x,y,'.')

pl.plot(x,p[0]A[:,0]+p[1]*A[:,1],'x')

pl.show()

Ай лол,сейчас найду через кого скинуть

Все это по формуле

Аноны, ну так можете пояснить?

в чём собственно вопрос?

Как это все происходит? Интерполирование и выбор knotpoint, я никак не могу разобраться.

ручками подбираешь или выпуклой оптимизацией

это просто гиперпараметры

И как это все подбирается? Я не понимаю, на кой хуй здесь нужен

>(p, residuals, rank, s) = np.linalg.lstsq(A,y)

и

>pl.plot(x,p[0]A[:,0]+p[1]A[:,1],'x')

Особенно за 2-ю строку.

Ну ты че, тупой? Не можешь загуглить что делают функции exp, lstsq и plot?

Я знаю, что они делают, но не понимаю, нахуя.

Нахуй нам нужен этот np.linalg.lstsq(A,y)

И зачем мы умножаем x,p[0]A[:,0]+p[1]A[:,1]

Хорошо, на другом примере, если у меня есть некоторая обучающая выборка с зашумлением и я хочу ее интерполировать, то что мне делать?

Как мне построить ее модель? Если это, например, синусоида?

Хотел бы написать что-то для практики на Java. Вспомнил, как какой-то чувак в зк выкладывал свой код с использованием нейросетей и внезапно захотел себе тоже.

Поскольку это учебный проект, хотел бы всё сделать с нуля используя только стандарную библиотеку. Задачу думаю взять какую-то наглядную с обработкой изображений, например, распознавание рукописного текста (или хотя бы цифр).

Проблема в том, что знаний в области МЛ у меня почти никаких нет: спроектировать грамотно сеть и всё продумать я не смогу. Из МЛ я только прошёл курс китайца на курсере, да и то давно.

Идеально было бы найти какую-то статью где вся математика уже сделана, а мне остаётся только реализовать.

Взлетит или нет? Будет ли слишком медленно работать из-за того, что нет быстрых операций над матрицами/векторами?

Поскольку это учебный проект, хотел бы всё сделать с нуля используя только стандарную библиотеку. Задачу думаю взять какую-то наглядную с обработкой изображений, например, распознавание рукописного текста (или хотя бы цифр).

Проблема в том, что знаний в области МЛ у меня почти никаких нет: спроектировать грамотно сеть и всё продумать я не смогу. Из МЛ я только прошёл курс китайца на курсере, да и то давно.

Идеально было бы найти какую-то статью где вся математика уже сделана, а мне остаётся только реализовать.

Взлетит или нет? Будет ли слишком медленно работать из-за того, что нет быстрых операций над матрицами/векторами?

a sin(bx) + c

То-есть взять ту же самую модель синусоиды, сравнить ее с нашими данными, и получаем ту самую ошибку?

И потом берем ошибку и умножаем на модель данных, получая приближение к изначальной функции.

Только где тут интерполяция?

что за хуйню я читаю

Лол, заказал где-то год назад Бишопа с Амазона, какое-то копеечное издание из Индии по лицензии Springer. Пришла книжонка с неразрезанными плотными листами и хуёвейшей печатью.

Через полгода на NIPS в Канаде подвалил к представителю издательства и рассказал про то, как разрезал книгу, как графье в 19 веке, чувиха почему-то очень расстроилась.

P.S. Зашел в тред и не понимаю, как с вами, придурками тут общаться, если вы не можете разобраться ни в чем, и китаец вас ничему не научил?

Кстати, взял там же на NIPSe автограф у Ng

Посмотри в код, который я сбрасывал выше, он по учебнику дается и я нихуя не могу разобраться.

Обещали интерполяцию, а дали какую-то хуевую аппроксимацию с методом ошибки наименьших квадратов.

А не, в глаза долблюсь, лол.

мудило решил сэкономить двадцать долларов

результат - 700 страниц индийcкой туалетной бумаги

)

Так, ананасы, нужна помощь по теану. Увеличил я выход до 20-ти чтоб распознавать несколько цифр одновременно.

y = T.imatrix('y') теперь матрица а не вектор

layer3 = LogisticRegression(input=layer2.output, n_in=500, n_out=20) - 20 выходов

преобразовываем выход из 2д в 3д чтоб считать средние значения по десяткам

self.p_y_given_x = self.p_y_given_x.reshape((self.p_y_given_x.shape[0],2,10))

как правильно записать целевую функцию если раньше она была такой

def negative_log_likelihood(self, y):

logtmp=T.log(self.p_y_given_x)

return -T.mean(logtmp[T.arange(y.shape[0]), y])

y = T.imatrix('y') теперь матрица а не вектор

layer3 = LogisticRegression(input=layer2.output, n_in=500, n_out=20) - 20 выходов

преобразовываем выход из 2д в 3д чтоб считать средние значения по десяткам

self.p_y_given_x = self.p_y_given_x.reshape((self.p_y_given_x.shape[0],2,10))

как правильно записать целевую функцию если раньше она была такой

def negative_log_likelihood(self, y):

logtmp=T.log(self.p_y_given_x)

return -T.mean(logtmp[T.arange(y.shape[0]), y])

> средние значения

максимальное, т.е

Почаны, а для чего вы хотите использовать/используете машинное обучение?

Хочу бота состряпать для начала, а потом кое-что другое.

для того, чтобы опубликовать статьи и получать за это деньги.

Хитрючий пидор

Просто интересно. Хобби можно сказать.

Такое впечатление, что какой-то мимотурок, не слышавший про R, описал этот тред. Целый набор разнородной хуйни, которая давно есть в R, притом большей частью стандартно

To start with the machine learning libraries, install the basic and most important ones first, for example, numpy and scipy.

To see and do operations on data: pandas (http://pandas.pydata.org/)

For all kinds of machine learning models: scikit-learn (http://scikit-learn.org/stable/)

The best gradient boosting library: xgboost (https://github.com/dmlc/xgboost)

For neural networks: keras (http://keras.io/)

For plotting data: matplotlib (http://matplotlib.org/)

To monitor progress: tqdm (https://pypi.python.org/pypi/tqdm)

Вводятся граничные условия, в т.ч. на производные. Дальше хуярится СЛАУ и решается.

На R нет Tensorflow и Keras. Там вообще есть нейросети под GPU?

Так же под Python есть NLTK для NLP. Добавлю, что все умы в лабораториях хуярят на Python. Кто-то по старинке на Matlab, кто-то для тырпрайса на Java.

(Т.к. Deep Learning появился несколько лет назад)

>На R нет Tensorflow и Keras.

Tensorflow есть, пакет rFlow. Керас не знаючто это. Нейроночки сверточные? Если да, то есть MXNet, он не хуже тензорфлоу этого вашего.

>Там вообще есть нейросети под GPU?

Есть. MXNet можно собрать с поддержкой куды. Есть еще что-то, не помню названия. Из диплернинга есть еще всякие машины Больцмана и аутоенкодеры.

Меня удивляет почему это раньше еще никто не сделал, хотя бы на уровне бойлерплейта.

PCA + XGB + DL

насколько реально написать нейросеть, которая сможет рерайтить новости?

и реально ли это сделать с Java?

и реально ли это сделать с Java?

всё зависит от мощности твоего GPU-кластера

а клауд калькулэйшнс можно использовать?

На Амазоне есть инстансы с видюхами, в общем-то ничетак.

потому что R используют только выпускники факультетов статистики. У них мозги поломаны настолько, что они не приходят в ярость от этого языка. Но и кэггл код на R выигрывает редко.

>R используют только выпускники факультетов статистики. У них мозги поломаны настолько, что они не приходят в ярость от этого языка.

А от чего там можно приходить в ярость?

Вали нахуй со своим R, он нужен то паре аутистов.

Предлагаю банить нечеткопетухом и R-макак

ВЫ НЕ ПОНЯЛИ СУТИ ТРЕДА

ЗДЕСЬ ПАЦАНЫ УГОРАЮТ ПО ПИЗДОНУ И ЕБАШУТ МАТАН, ЛЮБОЙ PHD-ПЕТУХ ПОТЕЧЕТ ОТ УРОВНЯ ЗНАНИЙ, КОТОРЫЙ БУДЕТ ВАМ ДОСТУПЕН.

ВЫ РЕШИЛИ ПРИЙТИ К НАМ В ТРЕД СО СВОЕЙ ХУЙНЕЙ? ВЫ БУДЕТЕ ОПУЩЕНЫ, АУТИСТЫ, МЫ ВВЕДЕМ СВЯЩЕННУЮ ПИЗДОНОВОЙНУ

ЗДЕСЬ ПАЦАНЫ УГОРАЮТ ПО ПИЗДОНУ И ЕБАШУТ МАТАН, ЛЮБОЙ PHD-ПЕТУХ ПОТЕЧЕТ ОТ УРОВНЯ ЗНАНИЙ, КОТОРЫЙ БУДЕТ ВАМ ДОСТУПЕН.

ВЫ РЕШИЛИ ПРИЙТИ К НАМ В ТРЕД СО СВОЕЙ ХУЙНЕЙ? ВЫ БУДЕТЕ ОПУЩЕНЫ, АУТИСТЫ, МЫ ВВЕДЕМ СВЯЩЕННУЮ ПИЗДОНОВОЙНУ

Стоит ли изучать теорию меры или нет?

Я закончил учебник по терверу, но там было без теории меры, борелевских множеств и прочего говна. Вот думаю, а нужно ли вообще это все для ML или лучше забить и двигаться дальше, читать Бишопа или ISL/ESL?

Я закончил учебник по терверу, но там было без теории меры, борелевских множеств и прочего говна. Вот думаю, а нужно ли вообще это все для ML или лучше забить и двигаться дальше, читать Бишопа или ISL/ESL?

если мера не интерсна - читай бишопа, у него мер нет

мера позже может пригодиться, тогда и посмотришь если мл не заёбёт к тому времени xe xe

Как вы понимаете все эти формулы, пиздец.

Учили математику?

Множества и (что то же самое) логика - это то, с чего вообще начинались нейроночки. Я понимаю, что ИТТ кроме меня никто не читал ту самую статью МакКаллока и Питтса 1943 года, которая считается основополагающей в этом направлении, но факт остается фактом, взаимодействия между нейронами в этой статье рассматривается с позиции матлогики. Опять же, активность нейронов не только спайковая по типу "все или ничего" 1 или 0, true или false. Есть еще градуальные потенциалы, которые лежат в основе ЭЭГ, да вся сетчатка работает именно на них, без спайков как таковых. А градуальные потенциалы не сводимы к бинарной логике, там не только 0 или 1, но и весь интервал между нулем и единицей. Т.е. очевидно, что эту активность нейронов можно формализовать только нечетко-логическими операциями. Даже те же сигмоиды в нейроночках это типичные функции принадлежности, вероятность тут вообще не при чем.

Mnozhestva i (chto to zhe samoye) logika - eto to, s chego voobshche nachinalis' neyronochki. YA ponimayu, chto ITT krome menya nikto ne chital tu samuyu stat'yu MakKalloka i Pittsa 1943 goda, kotoraya schitayetsya osnovopolagayushchey v etom napravlenii, no fakt ostayetsya faktom, vzaimodeystviya mezhdu neyronami v etoy stat'ye rassmatrivayetsya s pozitsii matlogiki. Opyat' zhe, aktivnost' neyronov ne tol'ko spaykovaya po tipu "vse ili nichego" 1 ili 0, true ili false. Yest' yeshche gradual'nyye potentsialy, kotoryye lezhat v osnove EEG, da vsya setchatka rabotayet imenno na nikh, bez spaykov kak takovykh. A gradual'nyye potentsialy ne svodimy k binarnoy logike, tam ne tol'ko 0 ili 1, no i ves' interval mezhdu nulem i yedinitsey. T.ye. ochevidno, chto etu aktivnost' neyronov mozhno formalizovat' tol'ko nechetko-logicheskimi operatsiyami. Dazhe te zhe sigmoidy v neyronochkakh eto tipichnyye funktsii prinadlezhnosti, veroyatnost' tut voobshche ne pri chem.

Паста с фочана, раходимся

И наборы (само) логика - это где все это началось сетки настроение. Я понимаю, что в ITT, но меня никто не читает той же статье McCulloch и Pitts в 1943 году, считается важным в данном руководстве, но совершенно очевидно, что международное общаться между нейронами в этой статье обсуждается математическую логику ситуацию. Опять же, активность нейронов, а не только своего рода шип "или все" 1 или 0, истинным или ложным. Шаг за шагом потенциалы, основанные на ЭЭГ, но для Retina работает, так что шипом. Другие потенциалы, которые не могут быть сведены к бинарной логики, а не только 0 или 1, но в диапазоне от нуля до единицы. Они. Совершенно очевидно, что формальная нейронную активность может только нечеткие логические операции. Даже те, в функции сигмовидной сетки настроение обычного членства, кажется, ничего общего с.

И что тут такого?

Где ты достал силы, чтобы читать эти шифрованые манускрипты?

> Где ты достал силы, чтобы читать эти шифрованые манускрипты?

Психостимуляторы. Шучу, но лишь частично.

Конкретно по тому пику можешь почитать вот эту статью с цветными картинками:

http://colah.github.io/posts/2015-09-Visual-Information/

нейроночки - артисты в душе

https://vimeo.com/175540110

https://vimeo.com/175540110

О-па, анончики, вас то я и искал.

Как раз хотел бы работать с ИИ, нейросетями нк и возможно биоинформатикоф в общем. Но так как знаний в этой сфере (как и в знании ЯП) не больше, чем в статье википедии, думаю, что с вами у меня всё получится.

Как раз хотел бы работать с ИИ, нейросетями нк и возможно биоинформатикоф в общем. Но так как знаний в этой сфере (как и в знании ЯП) не больше, чем в статье википедии, думаю, что с вами у меня всё получится.

Блин, ток к вам пришёл, а уже обзмеился. У вас тут атмосфера хорошая

Блять, на этой фотографии она выглядит просто отлично, а на всех остальных.... meh

Зря гуглил. Это разбило мне мой манямирок.

Сука...

Она бы тебе все равно не дала.

Да я как бы и не хотел...

Аноны, можно ли нахуй забить в книге на часть с линейным дискриминантным анализом?

Или это очень важно и не стоит? Ну просто не интересно, пиздец, да я еще и не понимаю, нахуй он нужен?

Иду дальше по книге, нигде не вижу, чтобы к нему возвращались.

Вы используете сокращение размерности в ваших проектах? Оно вообще нужно?

Или это очень важно и не стоит? Ну просто не интересно, пиздец, да я еще и не понимаю, нахуй он нужен?

Иду дальше по книге, нигде не вижу, чтобы к нему возвращались.

Вы используете сокращение размерности в ваших проектах? Оно вообще нужно?

забивай всё что не интересно

А может оно дохуя нужно будет?

если будет нужно для чего нибудь интересного - посмотришь

алсо я хуй знает что у тебя там за книга

если бишоп то он нахуй ненужно, опускай всё до 4.3

если бишоп то он нахуй ненужно, опускай всё до 4.3

Stephen Marsland Machine Learning

Бля, а вообще удобно, взять матрицу, очистить от шума и расположить нормально.

Интересно, получается LDА или PCA нужны только для представления данных в визуальном виде и для того, чтобы нейроночка могла легче обучиться? Для чего еще на практике оно может пригодиться?

Жаль, что я хуево знаю матан и не могу понять все эти операции со скалярами и матрицами.

Где про все это можно почитать, чтобы для даунов было понятно, линейная алгебра, матрицы, скаляры, скалярное выражение.

Интересно, получается LDА или PCA нужны только для представления данных в визуальном виде и для того, чтобы нейроночка могла легче обучиться? Для чего еще на практике оно может пригодиться?

Жаль, что я хуево знаю матан и не могу понять все эти операции со скалярами и матрицами.

Где про все это можно почитать, чтобы для даунов было понятно, линейная алгебра, матрицы, скаляры, скалярное выражение.

визуализация да, сжатие данных, уменьшение размерности

нейроночки обожают пца

> Где про все это можно почитать, чтобы для даунов было понятно

конец списка

>конец списка

Какого списка?

а попробуй это

https://www.amazon.com/dp/0030105676/ref=pd_lpo_sbs_dp_ss_3/156-1403635-0712816?pf_rd_m=ATVPDKIKX0DER&pf_rd_s=lpo-top-stripe-1&pf_rd_r=R30CE539V7P4TB1RTS9R&pf_rd_t=201&pf_rd_p=1944687682&pf_rd_i=0980232716

буржуи все друг другу советуют, авось и тебе зайдёт

Сразу бы дал ссылку, где спиздить.

Как не русский прямо.

я латыш

в шапке ссылки есть

Мне оттуда до 5 главы читать только Включительно?

Так там про скаляры ничего вообще не написано.

Матрицы, Векторы, Векторное пространство, даже нейроночка с графами задета, а скаляров и скалярного выражения нету.

а не, я даун, все нормально.

до 6й включительно

SVD - самый сок PCA

У меня может быть платиновый вопрос.

Есть одна нейросеть. Взял исходники на JS и переписал их на Си++. В качестве активационной функции используется логистическая функция (то, что называют "сигмойд").

Как только взвешенная сумма с предыдущих нейронов и биаса переходит за число 37, процессор округляет получившееся число до единицы

https://www.wolframalpha.com/input/?i=(1%2Be%5E(-37))%5E-1

То есть если нужно посчитать саму e^(-sum), то сумма может дойти до ~700, и всё будет ок, но там число вида 0,9999999... которое проц хранить правильно не умеет.

Так как output = 1, то дельта (target x output x (1-output)) всегда равна нулю, и веса не исправляются.

Теперь вопрос: как с этим бороться? Единственное, что я придумал это проверять: если получившийся вес нейрона больше 0.99999, то я делаю именно такой вес.

Есть одна нейросеть. Взял исходники на JS и переписал их на Си++. В качестве активационной функции используется логистическая функция (то, что называют "сигмойд").

Как только взвешенная сумма с предыдущих нейронов и биаса переходит за число 37, процессор округляет получившееся число до единицы

https://www.wolframalpha.com/input/?i=(1%2Be%5E(-37))%5E-1

То есть если нужно посчитать саму e^(-sum), то сумма может дойти до ~700, и всё будет ок, но там число вида 0,9999999... которое проц хранить правильно не умеет.

Так как output = 1, то дельта (target x output x (1-output)) всегда равна нулю, и веса не исправляются.

Теперь вопрос: как с этим бороться? Единственное, что я придумал это проверять: если получившийся вес нейрона больше 0.99999, то я делаю именно такой вес.

Отнимай максимум от входящих значений, то есть если на вход вектор v, то делай v = v - max(v).

Там наоборот же дельта очень маленькая. Сам посчитай

target x (1-10^(-N)) x (1 - (1-10^(-N))) =

target x (1-10^(-N)) x 10^(-N) =

target x (1-10^(-N)) x 10^(-N) =

target x (10^(-N) - 10 ^ (-2N) ) =

target x ~(0.000001-0.000000000001)

А если дельта маленькая, то и change тоже

http://cs231n.github.io/neural-networks-1/#actfun

Sigmoids saturate and kill gradients. A very undesirable property of the sigmoid neuron is that when the neuron’s activation saturates at either tail of 0 or 1, the gradient at these regions is almost zero. Recall that during backpropagation, this (local) gradient will be multiplied to the gradient of this gate’s output for the whole objective. Therefore, if the local gradient is very small, it will effectively “kill” the gradient and almost no signal will flow through the neuron to its weights and recursively to its data. Additionally, one must pay extra caution when initializing the weights of sigmoid neurons to prevent saturation. For example, if the initial weights are too large then most neurons would become saturated and the network will barely learn.

> if the initial weights are too large then most neurons would become saturated

Я двумя способами инициализировал:

1. равномерно (-1; 1)

2. нормальное распределение с вершинами в -1 и 1 (и входящим только в тот же промежуток (-1; 1) ), и почти ничего не падает на ~0. Такой вариант распределение посоветовали на Швабре, мол, веса должны как можно сильнее отличаться от 0, чтобы их легче было обучать, потому что если на всех весах будут нули, то такую сеть не обучить.

Тогда какое мне распределение делать? Нормальное, но с вершинами в -0.75 и 0.75?

Кстати, ещё кое-что. Чтобы получить 37, можно сложить всего-то 1000 нейронов с взешенными значениями 0.037. Или 100 с 0.37. Или всего 74 со средним взвешенным значением 0.5; это же всего-ничего, мне не хватает столько нейронов на слое.

Аноны, а нейроночку можно использовать для рисования немного глубже?

Например, есть сфера, источник освещения и листы разного цвета.

По сути, надо выполнить задачу аппроксимации функции.

Скормлю нейроночке около десяти рисунков с различным положением источника освещения и сферы и нейроночка тогда научится сама подбирать тени?

Можно ли также научить ее делать анимацию материалов?

То-есть зайти в какой-нибудь Marvel, где просчитывается работа тканей и в зависимости от положения частей и их скорости, размера и плотности материала научить нейроночку линией рисовать то, как платье двигается?

Правда тут будут играть роль еще и складки, ведь ткань может быть завернута по разному, пришита, застегнута на молнии.

То-есть у меня программа, я рисую платье, нейроночка сама ставит на него тени, сама анимирует движения в зависимости от того, как двигается персонаж.

По сути научиться говорить с нейроночкой на 1-м языке, она видит форму, ищет штриховку или тени, сама найдет точки схода.

Например, есть сфера, источник освещения и листы разного цвета.

По сути, надо выполнить задачу аппроксимации функции.

Скормлю нейроночке около десяти рисунков с различным положением источника освещения и сферы и нейроночка тогда научится сама подбирать тени?

Можно ли также научить ее делать анимацию материалов?

То-есть зайти в какой-нибудь Marvel, где просчитывается работа тканей и в зависимости от положения частей и их скорости, размера и плотности материала научить нейроночку линией рисовать то, как платье двигается?

Правда тут будут играть роль еще и складки, ведь ткань может быть завернута по разному, пришита, застегнута на молнии.

То-есть у меня программа, я рисую платье, нейроночка сама ставит на него тени, сама анимирует движения в зависимости от того, как двигается персонаж.

По сути научиться говорить с нейроночкой на 1-м языке, она видит форму, ищет штриховку или тени, сама найдет точки схода.

> около десяти

>сотен

А для больших бликов должно вполне сработать и с 10.

Попробуй лучше гуглувскую адаптировать, там можно сделать так, чтобы стиль одной картинки применить к стилю другой.

Глубокие нейросети обучаются на примерно 10к изображений, причем на нихуевых видеокартах с кудой (на проце время прохода такой сети может быть несколько десятков секунд, и бэкпроп еще столько же, на видюхе для одного изображения все может примерно за секунду сделаться).

Есть идея сделать игру на нейронных сетях.

2-х мерную стрелялку или что-нибудь вроде этого.

Суть в том, что нейронная сеть будет просчитывать свет, поведение окружения, игровые условия.

Только интересно, как это по ресурсам будет?

почему именно на нейронных сетях?

как ты себе это представляешь?

Мне кажется, что так можно реализовать вообще все, что угодно, то-есть я могу обучить нейронную сеть алгоритму Вороного и при выстреле в стекло она будет просчитывать физику, свет и трещины.

То-есть игрок постоянно будет подавать информацию на входы уже обученной нейронной сети.

>почему именно на нейронных сетях?

Хуй знает, подход очень интересен.

Дохуя по ресурсам. Скорее всего даже успевать просчитывать все не будет.

Попроси свою мамау сворить борщь через нейронную сеть, дай на вход "мама, что на обед", а на выход обучи расбери пай сигналить на ноги с сервомотором поглаживать твой животик. Подход чень итересен.

А все это будет в 2D/3D редакторе.

И нейронная сеть будет генерировать уже заготовленную анимацию.

В том же юнити, например, нельзя нормально сделать дыры от пуль в стене, а где-нибудь в Блендере, с помощью сторонних скриптов можно.

Ну так беру и совмещаю без лишнего геморроя, и за образование трещин здесь будет отвечать уже не PhysX, а нейронная сеть, которая сгенерирует осколки, а PhysX будет обрабатывать уже физику для них.

Разве уже обученная сеточка не работает быстрее обычной?

>Разве уже обученная сеточка не работает быстрее обычной?

Че-т проиграл.

Кури короче основы нейросетей. Куча материалов в инете.

Если интонация в голосе не свидетельствует о серьезном уровне голода, просто симулировать жест роботизированной рукой, при помощи сервомоторов, который намекнет на желаемое время приготовления борща.

Да я уже вкурил.

Обученная сеточка же не требует трат ресурсов на алгоритм обучения, неужели тоже жрет так уж дохуя?

Ну ладно, тогда не помеха, пусть покупают больше видеокарт.

физикс не рисует осколки, он, как раз, генерирует их реальное положение, что как бы и есть "физика" в твоем понимании.

Физикс использует уже заранее сделанную анимацию, он не умеет в динамику вроде.

А вот считать, как и куда разлетятся осколки он умеет.

тебе нужно точно генерить осколки на основе окружающей среды, сеточкой ты можешь апроксимировать все случаи генерации(много наборов), но в итоге ты получишь убогую реализацию везде, не будет такой сеточки которая одинаково хорошо сгенерит поведение тел в разных средах.

физиксу вообще похуй на анимацию, он считает модель поведения тел в зависимости от окружающих факторов. Итог передается в карту на рендер.

Мне нужно лишь генерировать лишь карту осколков.

То-есть, когда пуля попадет в стекло, произойдет событие, все данные подаются на на входы сеточки и сеточка сгенерирует карту осколков, всем остальным занят физикс.

Я говорю про разрушаемые меши в физиксе.

А тот же самый Вороной и сам по себе жрет дохуя ресурсов.

И все данные можно очень даже редуцировать и разбить на классы, если подключить тот же поиск по дереву.

Чем теб мешает аплаить карту осколков через обычные темплейты? Любая дополнительная характеристика, типа углы соприкосновения пули со стеклом, лекто апплаятся через геометрически формулы. В чем проблема? Тебе нужно чтобы сеточка для тебя выучила все основы и себя не напрягать?

>Тебе нужно чтобы сеточка для тебя выучила все основы и себя не напрягать?

Да, хочу ебаться с сеточками.

У меня есть подозрение, что сеточка даст тебе дисторшн в поводении на уровне шакалов джепег. Ну еслиесть время глянь, потом расскажешь.

Да, больше и не надо, чтобы ресурсы лишние не жрать.

На самом деле она может выжрать даже меньше, чем сам Voronoi Fracture.

В любом случае попытаюсь что-нибудь с 2д редактором сделать интересного, а может и с куском ткани в 3д.

Мне кажется, что простейшая 2д физика и освещение не займет много ресурсов.

збс

как тренировать будешь? у тебя есть выборка данных?

если у тебя есть обученная модель, то почти не будет разницы в производительности с применением темплейтов, потомучто это почти одно и то же.

Ну в случае с тканями через меши, в случае с освещением есть несколько подходов.

Думаю пока через карты освещения, которых сгенерю целую кучу и нейроночка будет знать, что есть меш и он находится на таком-то расстоянии от источника света и будет генерировать наиболее подходящий свет.

Да, будет немного мыльновато, но у меня нет ресурсов разбирать HD.

>то почти не будет разницы в производительности с применением темплейтов

Так оно и хорошо.

Расскажите про возможности нейроночек в рисовании?

Эти фильтры мне понравились, а можно ли заставить нейроночку искать именно 1-н объект на рисунке и в зависимости от его состояния заменять его другим?

Эти фильтры мне понравились, а можно ли заставить нейроночку искать именно 1-н объект на рисунке и в зависимости от его состояния заменять его другим?

Чтобы конкретно рисовали еще не встречал нейроночки.

Есть нероночки, которые выдают границы объектов, есть нейроночки, которые полностью выделяют объекты своими цветами. Т.е. в этих случаях конкретно картинка получается. Вот что-то типа второго варианта тебе бы могло подойти, с условием, что замена будет выполняться каким-то отдельным алгоритмом.

Гугловская сеть же изначально заточена под простую классификацию, а те рисуночки делаются так: снимаются данные нейрончиков с одного из внутренних слоев и визуализируются.

Более 90% работы с любой нейроночкой - это сбор и подготовка данных. Если сможешь выбрать правильную нейроночку, собрать нужные данные и оформить их в пригодном для нейроночки виде, считай задача решена.

Куда тренд пропадает постоянно?

Засуньте его в прикреплённый

Засуньте его в прикреплённый

от местных закрепляющих дождёшся

я 3 года жду пока они рнр/js мразей в /wеb/ выкинут

Чем они тебе мешают-то? Не обращай внимания

ну ок

Бамп. Мне тоже интересно.

Ну, если у вас не хватает мозгов зайти в поисковик и пробить имеющееся предложение, то можете работать веб-макаками дальше.

Макаки больше, если ты не уберпроффинейронщик. Заебали тупить. Работа либо денежная, либо интересная. Се ля ви

Реально ли вкатываться на самообучении? С математикой дружу, но как конкурировать с задротами из топовых вузов? Или мест хватит всем?

Конкурировать где? Каких мест?

Конкурировать на места специалистов по ML.

Да нихера щас толкового еще не сделали на нейроночках, последнее че сделали - описание изображений естественным языком и все заглохло пока. Может скоро еще чем-то порадуют.

о, я как раз этим и занимаюсь. тут прикольно, вкатывайся к нам. могу переслать тебе пару параграфов из введения заявки на грант, которые я помог написать.

>на видюхе для одного изображения все может примерно за секунду сделаться

нет. обычно берут сразу батч изображений (64 или 128), один проход батча около 70 милисекунд. Посмотри сбенчмарки торча7. У меня сейчас в задаче 16 образцов за 1.8 секунд считает и в итоге эпоха около часа-полтора, а всего надо под 100-200 эпох. Я уже заебался с такими скоростями ждать.

А ты биоинформатег? Как туда вкатиться? Есть ли работа?

Покажи

Всем привет. Подскажите, пожалуйста, почему многие люди используют Lua для написания нейронных сетей? Чем он отличается от других скриптоязыков, таких как Руби или JS?

Привет

Как дела?

прив)

судя по хедхантеру или бластим вакансий очень мало и туда требуются скорее биологи с кодерскими скилламитипа как на фбб мгу и не ниже магистра

при уровне зарплат ниже процентов на 20-30

так дело обстоит?

Проснулся, умылся... Хотел пойти и познакомиться с одной тянкой, которая листовки у метро раздаёт и постоянно мне улыбалась, но когда сегодня подошёл - её там не было.

Хоть я и не расстроился, всё равно жаль немного. Мб завтра повезёт.

А у тебя?

Херово. Не рассказывает никто про lua.

Сам почитай.

Я пока учусь всему этому, так что подсказать не могу. Уверен, что если ты поищешь инфу самостоятельно, то узнаешь всё, что необходимо. Поверь мне

>Сам почитай.

Да искал я. Нигде не написано почему именно lua.

Удачи в обучении. Сам сейчас 2 года сижу в джава энтерпрайзе, думаю потиху начать перекат в ML. Да и тему для диплома в универе желательно хороший выбрать.

>хорошую

Блять, никогда не имел дело с книгами на ангельском такого рода. Мдэээмс

торч же на луе, не?

OpenFace на питоне.

Прост))

Без торча луа в мл мало кому нужен. Автор(ы) писали на луа для себя просто потомучто, ну и постепенно набралось на фреймворк.

А тут вообще нейронка внутре?

Можно же тупо сопоставлять со сдвинутым/наклонённым шаблоном.

В общем, я сделал так. Я раскидываю веса с нормальным распределением 97% значений в [-0.5; 0.5], а потом нормализую веса по алгоритму отсюда: https://habrahabr.ru/post/198268/

Получалось, что я каждый вес на втором слое умножаю на 0.02. К моему удивлению такие маленькие веса работали, и сеть обучалась

>то, что называют "сигмойд"

Никогда в этом слове и-краткой не было. https://ru.wiktionary.org/wiki/-%D0%BE%D0%B8%D0%B4

>Теперь вопрос: как с этим бороться?

Batch normalization layer. При прямом проходе он считает среднее арифметическое и дисперсию всего batch'a, далее вычитает среднее и делит на дисперсию. При обратном проходе градиент возьми отсюда https://kratzert.github.io/2016/02/12/understanding-the-gradient-flow-through-the-batch-normalization-layer.html

> At the moment there is a wonderful course running at Standford University, called CS231n - Convolutional Neural Networks for Visual Recognition

Кстати, очень рекомендую эти лекции.

https://www.youtube.com/playlist?list=PLkt2uSq6rBVctENoVBg1TpCC7OQi31AlC

В 5-6 лекциях объясняется batch normalization, различные функции активации, методы оптимизации и прочее.

А на ютубе есть что-то новое чего нет в их пдфках? Не люблю лекции как формат, туу слоу.

До здесь, мы видели только один недостаток в статистике частотной. Ну, это только начало.

20-й век увидел массивный рост в статистике частотной применяется к численным моделям, чтобы проверить, отличается ли от другого один образец, параметр является достаточно важным, чтобы быть в модели и variousother проявлений проверки гипотез. Но статистика страдала частотной некоторые большие недостатки в его конструкции и интерпретации, которые представляют собой серьезную озабоченность всех проблем реальной жизни. Например:

1. р-значения, измеренные с образца (фиксированный размер) статистики с некоторыми изменениями с намерением остановки изменения намерения и размер выборки. i.e Если два человека работают на тех же данных и имеют разные остановочный намерения, они могут получить два различных p- значения для одних и тех же данных, что нежелательно.

Например: Человек А может выбрать, чтобы остановить подбрасывание монеты, когда общее количество достигает 100 в то время как B останавливается на 1000. Для различных размеров выборки, мы получаем различные т-баллы и разные р-значения. Кроме того, намерение остановить может изменяться от фиксированного числа перестроек к общей продолжительности листать. В этом случае, мы обязаны получить различные р-значения.

2- доверительный интервал (C.I), как р-значение сильно зависит от размера выборки. Это делает остановки потенциал абсолютно абсурдно, так как независимо от того, сколько человек выполняют тесты на одних и тех же данных, результаты должны быть последовательными.

3- Доверительные интервалы (C.I) не являются распределения вероятностей, поэтому они не дают наиболее вероятное значение для параметра и наиболее вероятные значения.

Эти три причины достаточно, чтобы заставить вас идти в думать о недостатках в подходе и частотной почему существует потребность в байесовского подхода. Давайте найдем его.

Отсюда, мы сначала понять основы байесовской статистики.

20-й век увидел массивный рост в статистике частотной применяется к численным моделям, чтобы проверить, отличается ли от другого один образец, параметр является достаточно важным, чтобы быть в модели и variousother проявлений проверки гипотез. Но статистика страдала частотной некоторые большие недостатки в его конструкции и интерпретации, которые представляют собой серьезную озабоченность всех проблем реальной жизни. Например:

1. р-значения, измеренные с образца (фиксированный размер) статистики с некоторыми изменениями с намерением остановки изменения намерения и размер выборки. i.e Если два человека работают на тех же данных и имеют разные остановочный намерения, они могут получить два различных p- значения для одних и тех же данных, что нежелательно.

Например: Человек А может выбрать, чтобы остановить подбрасывание монеты, когда общее количество достигает 100 в то время как B останавливается на 1000. Для различных размеров выборки, мы получаем различные т-баллы и разные р-значения. Кроме того, намерение остановить может изменяться от фиксированного числа перестроек к общей продолжительности листать. В этом случае, мы обязаны получить различные р-значения.

2- доверительный интервал (C.I), как р-значение сильно зависит от размера выборки. Это делает остановки потенциал абсолютно абсурдно, так как независимо от того, сколько человек выполняют тесты на одних и тех же данных, результаты должны быть последовательными.

3- Доверительные интервалы (C.I) не являются распределения вероятностей, поэтому они не дают наиболее вероятное значение для параметра и наиболее вероятные значения.

Эти три причины достаточно, чтобы заставить вас идти в думать о недостатках в подходе и частотной почему существует потребность в байесовского подхода. Давайте найдем его.

Отсюда, мы сначала понять основы байесовской статистики.

Паста с форчана, расходимся

Up here, we saw only one flaw in the frequency statistics. Well, that's just the beginning.

The 20th century saw a massive increase applied to numerical models in the frequency statistics to check whether differs from another one sample parameter is important enough to be models and hypothesis testing variousother manifestations. But statistics frequency suffered some major weaknesses in its design and interpretation, which are a major concern to all the problems of real life. For example:

1. p-values measured with the sample (fixed size) statistics, with some modifications with the intention of stopping the change of intention and the sample size. i.e If two people are working on the same data and stopping have different intentions, they can get two different p- values for the same data, which is undesirable.

For example: A person may choose to stop the coin toss, when the total amount reaches 100 while B is stopped at 1000. For different sample dimensions, we obtain different m-points and different p values. In addition, the intention to stop can vary from a fixed number of modifications to the total duration of flipping. In this case, we have to get a different p-values.

2- confidence interval (C.I), as the p-value is heavily dependent on the sample size. It does stop potential is absolutely absurd, because no matter how many people carry out tests on the same data, the results should be consistent.

3 Confidence intervals (C.I) is not a probability distribution, so they do not give the most probable value for the parameter and the most probable values.

These three reasons enough to make you go to think about the shortcomings in the approach and frequency for some reason there is a need in the Bayesian approach. Let's find him.

Hence, we first understand the basics of Bayesian statistics

Имеет смысл вкатываться? Всегда нравилась статистика, но сейчас каждый первый абитуриент хочет заниматься дата сайнсом, это немного пугает.

> Имеет смысл вкатываться?

> Всегда нравилась статистика

да, имеет

> сейчас каждый первый абитуриент хочет заниматься дата сайнсом, это немного пугает

это тебя не должно волновать

Почему не должно волновать?

а почему должно пугать?

Потому, что задачи то специфические, много дата сайнтистов не надо, а у многих, кто идёт со мной в вузик планы заниматься именно этим. В итоге, когда мы все начнем искать работу, работы на всех не хватит. Хотя все равно буду в вкатываться, хоть мозги развивает.

Да и из того, что уже на этом сайте обсуждают ml, можно сделать некоторые выводы.

поддвачну - пускай лучше другие занимаются тем что меня интересует

я боюсь неопределённости, не хочу делится. поем лучше говна

я боюсь неопределённости, не хочу делится. поем лучше говна

>это мелкобуквенное проецирование

Ну что же ты, русский.

Чем делиться?

Он же написал - говном.

Не люблю неопределенность просто.

Deep learning for molecular biology and neuroscience

Deep learning (DL) is a new approach in the field of machine learning, that recently

gained momentum and sparked a lot of interest in the research community [1]. Unlike

previous, “shallow” approach, DL tries to learn hierarchical representation of the data in hand.

It alleviates the need for feature engineering and curse of dimensionality that limited

performance of a “shallow” approach.

Recently, DL was applied to biological data and yielded remarkable results in the

human splicing code prediction [2], identification of DNA- and RNA-binding motifs [3] and

predicting the effects of non-coding DNA variants at single nucleotide polymorphism precision

The key to successful application of deep learning to a problem is the presence of

hierarchical structure in the data and its spatial or sequential arrangement. Both of these

criteria are fulfilled in protein structures, therefore paving a way for future breakthrough in

computational drug design and protein structure and interaction prediction.

Deep learning field strongly influenced modern theories of brain activity. The most

stellar results were achieved in describing brain visual cortex. Before the DL gained

popularity, the models of visual cortex relied on fitting parameters to predict neural activities of

these areas [5]. However this approach failed to describe higher-level areas such as V4 and

IT. With the insight from machine learning an DL in particular new approach called goal-driven

networks became mainstream. According to this method a set of images is fed to the model,

that is optimized to predict the categories of depicted objects instead of direct prediction of

neural activities. This approach gave the first predictive model of the spiking responses in the

1. LeCun, Yann, Yoshua Bengio, and Geoffrey Hinton. "Deep learning." Nature 521.7553 (2015): 436-444.

2. Xiong, Hui Y., et al. "The human splicing code reveals new insights into the genetic determinants of

disease." Science 347.6218 (2015): 1254806.

3. Alipanahi, Babak, et al. "Predicting the sequence specificities of DNA-and RNA-binding proteins by deep

learning." Nature biotechnology (2015).

4. Zhou, Jian, and Olga G. Troyanskaya. "Predicting effects of noncoding variants with deep learning-

based sequence model." Nature methods 12.10 (2015): 931-934.

5. Decharms, R. Christopher, and Anthony Zador. "Neural representation and the cortical code." Annual

review of neuroscience 23.1 (2000): 613-647.

6. Yamins, Daniel LK, et al. "Performance-optimized hierarchical models predict neural responses in higher

visual cortex." Proceedings of the National Academy of Sciences 111.23 (2014): 8619-8624.

Хоть бы pastebin заюзал.

Прчитаю на досуге

Take up minimal space during anti-racism dialogues and protests.Protests and anti-racism discussions should always center on the oppression experienced by people of color. If you are an ally who always has the microphone or the bullhorn, you’re taking up too much space.

Stop contributing to gentrification and calling it “urban development.”Many white allies feel too comfortable talking about white privilege without pushing for their residential communities to legislate against gentrification, which is like reverse white flight at the expense of a mass POC eviction notice.Are you living in a redlining district without calling out the displacement of people of color? Are you content with advocating for POC as long as you don’t have to live in their neighborhood?

Listen when people call you on your microaggressions.Your intent to be anti-racist doesn’t necessarily mean you automatically fit the bill. If people call you on microaggressions, don’t argue—listen. If you knew a word or phrase was offensive, you probably wouldn’t have said it. Being an ally doesn’t mean you’re above being educated on racism.

Never invite POC to the table for the sake of claiming diversity.“Diversity” is now a buzzword and “diversity work” is a very profitable industry. Don’t invite POC to your events so you can say they personify diversity or to hit an organizational quota. Engage with diverse communities because you plan on being intentional about hearing our stories and letting us come to the table authentically.

Refrain from using your POC friends as your “urban dictionary.”If you are engaging in discussions about race, you won’t always understand cultural references. Your POC friends or colleagues are not your “urban dictionary.” (And yes, I’ve heard people ask me if they should look up words I’ve used in the urban dictionary.)You may have to do some research to participate in anti-racism work, and that’s okay. Just think; POC spend their entire lives learning about culture from a white supremacist perspective. A few minutes on Google won’t hurt you.

Stop lifting up non-confrontational POC as examples for what POC activism should be.Martin Luther King, Jr. was a great man—but he wrote more than his “I Have a Dream” speech. Few white folks quote his “Letter from a Birmingham Jail” to talk about King’s Legacy:“I have almost reached the regrettable conclusion that the Negro’s great stumbling block in his stride toward freedom is not the White Citizen’s Counciler or the Ku Klux Klanner, but the white moderate, who is more devoted to “order” than to justice…”

History through a white lens immortalizes the “safe,” diluted parts of liberation in hopes of POC seeking future liberation in similar ways. This framework centers the comfort of white folks and disregards the complexity of processing and rebelling against oppression.

Here’s the thing—experiencing racism is a lot more uncomfortable than experiencing a radical response to it. If you’re uncomfortable with expressions of emotional pain by the oppressed, you may want to work harder at dismantling their oppression.

Call your friends, family and co-workers out on racism—even if a POC isn’t in the room.I’ve had plenty of friends tell me stories about times their family members, friends, or colleagues said something racist. I usually wonder why they are telling me when most of their stories don’t end with them confronting the racism they encountered.How do you confront racism when the spotlight isn’t on you? Does it take a protest or a speech for you to call out racism? Can you address the racism of the people you love most?

Understand that all anti-racism work doesn’t look the same and advocate accordingly.Sometimes anti-racism work is about Black folks. Sometimes anti-racism work is about the entire African Diaspora. Sometimes anti-racism work is about Asian American folks. Sometimes anti-racism work is about Southeast Asian immigrants.“People of color” is an umbrella term that doesn’t address the complexities of the many people who experience racism. Understand that POC don’t go to bed in one-size-fits-all pajamas; our struggles and our liberations require nuanced thinking and action.

Realize that all discussions about race aren’t for you. And be okay with it.Should black people say the “n” word to each other? Should Beyoncé express her pain by calling someone Becky? Some conversations aren’t for white folks. They are intraracial critiques that don’t require an ally’s opinion. An anti-racist ally is like a guest at a family dinner. You’re invited to the table, but you should know what conversations require your abstention.

Recognize that you’re still racist. No matter what.Sometimes, anti-racist allies talk in an “us vs. them” framework when they discuss race, with the “us” being POC and anti-racist allies and the “them” being racist people. That’s an oversimplification of centuries of racism, and it also avoids one simple truth.White people always benefit from institutionalized racism, no matter how anti-racist your ideologies may be. You can’t disconnect yourself completely from the racism from which you benefit, and recognizing that is a large step in rejecting white privilege.

> 1488

збс!

>previous, “shallow” approach

Что ты имел в виду?

Мы такую хуйню в школе учили

а что race is a social construct и homosexuality is genetic тоже учили?

заставляли окончательно определяться с сексуальной ориентацией в 6 лет?

Я про 10-11 класс говорю. Там близкие темы затрагивались до пиздеца

линейные и около-линейные модели, типа деревьев, лесов,свм и тд.

И при чём тут МЛ или ДЛ?

Пиздатостью.

Похоже на то. Я спрашиваю, потому что видел несколько программа а ля http://bioinformaticsinstitute.ru/ , где учат конкретно алгоритмической биоинформатике, и непонятно, что потом после этого можно делать.

https://www.ted.com/talks/blaise_aguera_y_arcas_how_computers_are_learning_to_be_creative#t-407260

Для залётных нюфажин было бы интересно послушать

Для залётных нюфажин было бы интересно послушать

2 задачи:

1) классификация текста по трем категориям со сбалансированными классами

1) сентиментная классификация текста, с несбалансированными классами

Много ли смысла при N=1000 заниматься оптимизацией гиперпараметров и токенизатора?

1) классификация текста по трем категориям со сбалансированными классами

1) сентиментная классификация текста, с несбалансированными классами

Много ли смысла при N=1000 заниматься оптимизацией гиперпараметров и токенизатора?

Ну вот и мой момент славы. Только что смёрджили мой весьма серьёзный PR с фиксом, в очереди на мёрдж до релиза сентябрьского ещё 2-3 PR.

Чувствую себя прикольно, не знаю почему. Что скажете? Коммитили ли вы в апстрим когда-нибудь? Моё имя останется в списке коммитеров релиза навсегда :3

Чувствую себя прикольно, не знаю почему. Что скажете? Коммитили ли вы в апстрим когда-нибудь? Моё имя останется в списке коммитеров релиза навсегда :3

После какого курса я буду понимать математику ml, или лучше самому курить всякие курсы mit и учебники?

Математика там состоит из линала, поэтому читай его сразу.

Сап, Ибраим.

Я знаменит!

Ибраим

1-3 курс. Вообще на самом деле нужен только первый курс (На котором как сказали выше есть линал) и теория оптимизации. Но я думаю последнее ты можешь и заранее прочитать сам, это не сложный предмет. Я например об этом предмете узнал из корсеры, и только потом нам на третьем курсе его преподали.

Что по оптимизации можно почитать?

Бойдаboyd vandenberghe

Мне надо как можно быстрее сделать тестовое задание с использованием логистической регрессии с методом стохастического градиентного спуска, и все это на питоне с pandas и sklearn. дайте линков где можно про это прочитать за разумное время.

Только вкатываюсь в область, знаний по машин лернингу почти 0. Сейчас смотрю Нг на курсере, там что-то есть похожее, но именно стохастического градиентного спуска я у него не вижу.

Пока что самое близкое что мне надо нашел вот тут:

https://learningwithdata.wordpress.com/2015/04/30/tutorial-on-logistic-regression-and-optimization-in-python/

Только вкатываюсь в область, знаний по машин лернингу почти 0. Сейчас смотрю Нг на курсере, там что-то есть похожее, но именно стохастического градиентного спуска я у него не вижу.